Introducción a la Teor´ıa de la Información

Anuncio

Introducción a la Teorı́a de la Información

Segundo Parcial

27 de abril de 2015

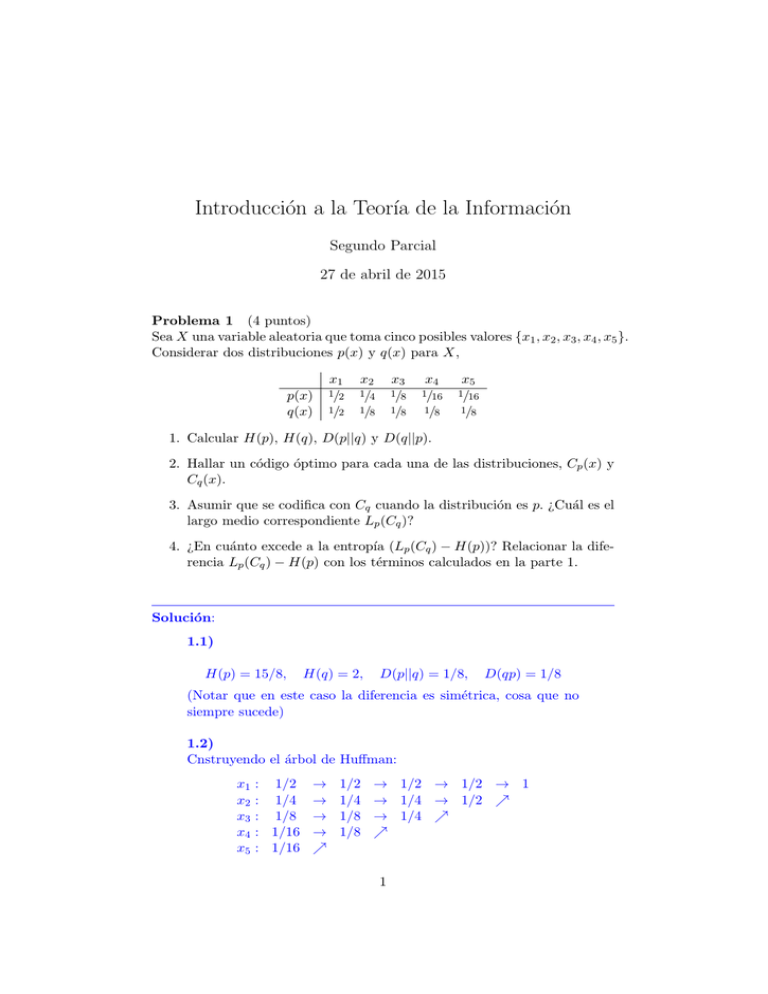

Problema 1 (4 puntos)

Sea X una variable aleatoria que toma cinco posibles valores {x1 , x2 , x3 , x4 , x5 }.

Considerar dos distribuciones p(x) y q(x) para X,

p(x)

q(x)

x1

1/2

x2

1/4

x3

1/8

x4

1/16

x5

1/16

1/2

1/8

1/8

1/8

1/8

1. Calcular H(p), H(q), D(p||q) y D(q||p).

2. Hallar un código óptimo para cada una de las distribuciones, Cp (x) y

Cq (x).

3. Asumir que se codifica con Cq cuando la distribución es p. ¿Cuál es el

largo medio correspondiente Lp (Cq )?

4. ¿En cuánto excede a la entropı́a (Lp (Cq ) − H(p))? Relacionar la diferencia Lp (Cq ) − H(p) con los términos calculados en la parte 1.

Solución:

1.1)

H(p) = 15/8,

H(q) = 2,

D(p||q) = 1/8,

D(qp) = 1/8

(Notar que en este caso la diferencia es simétrica, cosa que no

siempre sucede)

1.2)

Cnstruyendo el árbol de Huffman:

x1

x2

x3

x4

x5

: 1/2 →

: 1/4 →

: 1/8 →

: 1/16 →

: 1/16 %

1/2

1/4

1/8

1/8

→ 1/2 → 1/2 → 1

→ 1/4 → 1/2 %

→ 1/4 %

%

1

Un posible código se obtiene asignando el sı́mbolo 0 a las aristas

de arriba y 1 a las de abajo:

X

x1

x2

x3

x4

x5

cp (X)

0

10

110

1110

1111

`p (X)

1

2

3

4

4

Haciendo lo mismo con q(·) se llega a

X

x1

x2

x3

x4

x5

cq (X)

0

110

111

100

101

`q (X)

1

3

3

3

3

1.3)

P

El largo medio según p, Lp (Cq ) = i pi `q (xi ) = 2.

1.4)

La diferencia es 2 − 15/8 = 1/8. En este caso, por ser ambas

distribuciones distribuciones diádicas, dicha diferncia coincide

exactamente con D(p||q) (el desarrollo de abajo no era necesario, pero se incluye para hacer esto más ilustrativo):

D(p||q) = i pi log(pi /qi ) = i pi [log pi − log qi ]

P

P

= i pi log pi − pi log qi

P

P

= − i pi `p (xi ) + pi `q (xi )

= −Lp (Cp ) + Lp (Cq ) = Lp (Cq ) − H(p)

P

P

Problema 2 (4 puntos)

Una variable aleatoria X que toma m posibles valores tiene entropı́a H2 (X)

en bits. Se encuentra un código instantáneo ternario para X con largo medio

L=

H2 (X)

= H3 (X).

log2 3

1. Mostrar que cada sı́mbolo xi con i ∈ {1, . . . , m} tiene probabilidad de

la forma p(xi ) = 3−k para un cierto k.

2. Mostrar que m es impar.

2

Solución:

2.1)

Dado que se cumple la igualdad L = H3 , del teorema de Shannon

se desprende que los largos de código ideales `∗i = log3 pi , i =

1, . . . , m son enteros ki , por lo cual pi = 3−ki , ki = `i .

2.2)

P

`máx −`i = 3`máx .

De la desigualdad de Kraft tenemos que m

i=1 3

`

Claramente 3 máx es impar para `máx > 0, por lo tanto el lado

izquierdo de la igualdad también lo es. A su vez, éste es una

suma de términos todos impares, que sólo puede ser impar si la

cantidad de términos, es decir m es impar.

Problema 3 (4 puntos)

Sean X1 . . . Xn variables aleatorias i.i.d., Xi ∼ p(x), H = H(Xi ). Para el

conjunto tı́pico de secuencias

n

o

−n(H+)

A(n)

≤ p(x1 . . . xn ) ≤ 2−n(H−) ,

= x 1 . . . xn : 2

probar que

(n)

1. P {A } > 1 − , para n suficientemente grande,

(n)

2. |A | ≤ 2n(H+) .

Solución:

3.1)

(n)

n

o

P {A } = P x1 . . . xn : 2−n(H+) ≤ p(x1 . . . xn ) ≤ 2−n(H−)

= P {−n(H + ) ≤ − log p(x1 , x2 , . . . , xn ) ≤ −n(H − )}

P

= P {−n(H

+ ) ≤ − ni=1 log p(xo

i ) ≤ −n(H − )}

n

−1 Pn

=P | n

i=1 log p(xi ) − H| ≤ ≤1−

donde la tercera igualdad es porque el proceso es i.i.d., y la quinta por la ley de los grandes números aplicada a E[− log p(X)].

3

3.2)

1 ≥ xn ∈A(n) p(xn )

P

≥ xn ∈A(n) 2−n(H+e)

P

(n)

= |A |2−n(H+e)

(n)

y la desigualdad sale multiplicando A a ambos lados. El segundo paso sale de la definición de tipicalidad de xn .

Problema 4

(3 puntos)

1. Calcular la información mutua entre ambos lados de una moneda equilibrada.

2. Probar que I(X; f (Y )) ≤ I(X; Y ), para cualquier par de variables

aleatorias X, Y y función f . Qué condición en f () garantiza la igualdad?

Solución:

4.1)

Sean X e Y las variables aleatorias que indican si sale cara (X =

1, Y = 0) o cruz (Y = 1 , X = 0). La entropı́a de ambas para

una moneda equilibrada es h(1/2) = 1 bit. Dado que X e Y

son determinadas una a la otra, H(Y |X) = H(X|Y ) = 0 y su

información mutua es 1 bit.

4.2)

El resultado sale de aplicar la desigualdad de la información a la

cadena de Markov X → Y → f (Y ). Para garantizar la igualdad,

f () debe ser una función biyectiva.

4