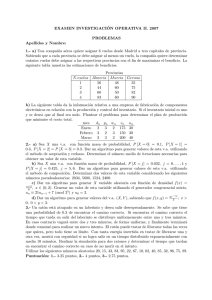

Sistema de Visión Estereoscópica para Navegación Autónoma de

Anuncio