Solución

Anuncio

Sistemas de comunicación

Práctico 6

Teorı́a de la Información

Cada ejercicio comienza con un sı́mbolo el cuál indica su dificultad de acuerdo a la siguiente

escala: ✦ básica, ★ media, ✷ avanzada, y ✹ difı́cil. Además puede tener un número, como 3.1-4

que indica el número de ejercicio del libro del curso, Communication Systems, 3th. edition.

Bruce A. Carlson.

✦ Ejercicio 1

Un teclado numérico tiene los números 0, 1, 2 . . . 9. Se asume que cada tecla es

utilizada en forma equiprobable. Calcule con qué cadencia deben ser oprimidas

las mismas para generar un flujo de información de 2 bit/s.

✦ Ejercicio 2

(15.1-2)

De un mazo de 52 cartas se elige una al azar.

(a) Hallar la información en bits que se tiene cuando se conoce que la carta

es:

de corazones

una figura

una figura de corazones

(b) Cuánta información se necesita para identificar la carta si, se sabe que es

roja.

✦ Ejercicio 3

(15.1-8)

Calcular la tasa de información de una fuente telegráfica que utiliza dos sı́mbolos,

el punto y la raya. El punto tiene una duración de 0.2s. La raya tiene el doble

de duración pero es la mitad de probable.

✦ Ejercicio 4

Para una fuente binaria:

(a) Mostrar que la entropı́a, H, es máxima cuando la probabilidad de enviar

un 1 es igual a la probabilidad de enviar un 0.

(b) Hallar el valor máximo de la entropı́a.

1

★ Ejercicio 5

Se tiene una fuente S con sı́mbolos {s1 , s2 , . . . , s6 }, con probabilidades 0.4, 0.3,

0.1, 0.1, 0.06 y 0.04 respectivamente.

(a) Hallar la entropı́a de la fuente.

(b) Considerar una codificación binaria con largo de palabra fijo. Indicar el

mı́nimo largo de palabra para que la codificación sea adecuada.

(c) Considerar una codificación de Huffman. Calcular el largo medio del código

obtenido.

✦ Ejercicio 6

Considerar un canal con la propiedad de que xi y yj son estadı́sticamente independientes para todo i, j. Mostrar que

H(X|Y ) = H(X) y I(X, Y ) = 0

★ Ejercicio 7

Canal Binario Simétrico. Considerar el modelo de un canal binario simétrico,

representado en la figura:

x1

1-alfa

y1

alfa

alfa

x2

y2

1-alfa

donde: P (x1 ) = p y P (y1 |x2 ) = P (y2 |x1 ) = α.

(a) Calcular la información mutua en función de p y α

(b) Discutir qué valores toma α cuando la potencia del ruido es muy pequeña

o muy grande.

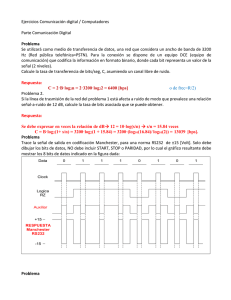

★ Ejercicio 8

Obtener analı́ticamente las caracterı́sticas de la figura siguiente, correspondiente a un canal analógico de ancho de banda B, contaminado con ruido blanco

gaussiano aditivo, de densidad espectral de potencia

G(f ) = η/2.

2

20

S/hR, dB

15

10

R=C

5

R>C

0

-1.6 dB

0.1

0.2

0.5

1

2

5

10

20

B/R

★ Ejercicio 9

(15.3-11)

Un ingeniero dice haber diseñado un sistema de comunicación analógico que

permite obtener:

(S/N )D = 60dB

cuando SR /(ηBT ) = 5dB y BT = 10W , donde BT es el ancho de banda del

canal usado y W es el ancho de banda de la señal a transmitir. ¿Usted le creerı́a?

¿Por qué?

★ Ejercicio 10

Se pretende transmitir imágenes de televisión digital a partir de una fuente que

genera una matriz de 480 × 500 elementos de imagen (pixels), donde cada pixel

puede tomar 32 valores de intensidad. Suponga que se generan 30 imágenes por

segundo. (Esta fuente de imágenes digitales es similar a los estándares adoptados

para TV digital.) Todos los pixels se consideran independientes, y los niveles de

intensidad equiprobables.

(a) Hallar la velocidad de transferencia de información R(bit/s).

(b) Suponer que la imagen de TV se transmitirá por un canal de 4, 5M Hz

de ancho de banda con una relación señal a ruido de 35dB. Hallar la

capacidad del canal (bit/s). (4, 5M Hz es el ancho de banda utilizado para

transmitir una imagen de TV analógica.)

(c) Discutir cómo pueden ser modificados los parámetros de la parte (a) para

permitir la transmisión de TV color sin incrementar el valor requerido de

R. (Nota: en TV cromática se debe enviar información de luminancia y

cromas; la luminacia es una señal que lleva la información de brillo y las

cromas son dos señales que llevan la información de color.)

3

Solución

Ejercicio 1

La tasa de sı́mbolos r se relaciona con la entropı́a H y con la tasa de información

R según la expresión:

R = rH

La probabilidad de cada una de las teclas es : P (T ecla) =

entropı́a de la fuente S={0,1,2, ... 9} es:

H(S) =

X

p(xi )log2

xi S

1

10 .

Por lo que la

X 1

1

=

log2 10 = log2 10 bits/simb

p(xi )

10

xi S

Despejando r se tiene:

r=

2 bits/seg

R

=

= 0, 6 simb/seg

H

log2 10 bits/simb

Ejercicio 2

(a)

de corazones

La probabilidad de una carta de corazones es

mación es I(corazones) = log2 4 = 2 bits.

13

52

=

1

4,

entonces la infor-

una figura

La probabiidad de una figura es

I(f igura) = log2 13

3 = 2, 1154 bits.

12

52

=

3

13 ,

entonces la información es

una figura de corazones

3

La probabidad de una figura de corazones es 52

, entonces la información

52

es I(f igura de corazones) = log2 3 = 4, 1154 bits.

(b) La información que se tiene al identificar la carta es log2 (52) bits. De

esta informacion sólo se conoce que la carta es roja y como P (roja) = 21 , la

información que se tiene es I = log2 2 = 1 bit.

Por tanto, la información que resta para conocer la carta es I(carta)−I(roja) =

log2 (52) − 1 = log2 (26) bits.

Otra forma de resolver el problema es considerando la probabilidad de la carta

1

. De esta manera llegamos

conociendo que es roja, es decir P (carta/roja) = 26

1

al mismo resultado I = log2 P (carta/roja) = log2 (26) bits

Ejercicio 3

La cadencia media de sı́mbolos esta dada por:

r=

seg 2

0, 2 simb

.3

1

30 simb

seg 1 =

8 seg

+ 0, 4 simb . 3

4

La entropı́a es:

H=

2

3 1

bits

log2 + log2 3 = 0, 9183

3

2 3

simb

Por tanto,

R = r.H = 3, 44

bits

seg

Ejercicio 4

(a) Sea p la probabilidad de enviar un uno. La probabilidad de enviar un 0

será entonces 1 − p, y la entropı́a queda planteada de la siguiente forma:

H(p) = p.log

1

1

+ (1 − p).log

p

1−p

Para saber cuándo es máxima sólo falta derivar respecto a p:

H ′ = log

1 p2

1

1−p

1−p

− log

= log

−

+ (1 − p).

p p2

1−p

(1 − p)2

p

En el máximo se debe cumplir H ′ = 0

log

Tenemos que

1−p

p

1−p

=0

p

= 1 y entonces:

p=

1

2

Falta verificar que efectivamente es un máximo (H ′′ < 0):

H ′′ (p) =

p −p − (1 − p)

−1

.

=

= −4

1−p

p2

(1 − p)p

(b)

1

1

bits

bit

H( ) = 2. .log2 = log2 2

=1

2

2

simb

simb

Ejercicio 5

(a)

H(S) = P1 log2 s11 + P2 log2

P6 log2 s16 = 2.1435 bits/sı́mbolo.

(b)

1

s2

+ P3 log2

1

s3

+ P4 log2

1

s4

+ P5 log2

1

s5

+

El mı́nimo largo de palabra de código para codificar 6 sı́mbolos es 3 bits.

(c)

Considerando la extensión que se muestra en el cuadro 1, el largo de

código resulta: L = 1 × 0.4 + 2 × 0.3 + 3 × 0.1 + 4 × 0.1 + 5 × 0.06 + 5 × 0.04 = 2.2

bits/sı́mbolo. Nótese que con este código se llega muy cerca de la entropı́a de

la fuente. Además, aunque la extensión no es única, el largo no depende de la

extensión elegida.

5

Fuente original

Sı́mbolos Prob. Código

s1

0.4

1

s2

0.3

00

s3

0.1

011

s4

0.1

0100

s5

0.06

01010*

s6

0.04

01011*

0.4

0.3

0.1

0.1

*0.1

S1

1

0

011

0100⋆

0101⋆

Fuente reducida

S2

S3

0.4 1

0.4 1

0.3 00

⋄0.3 00◦

⋆0.2 010⋄

0.3 01◦

0.1 011⋄

S4

◦0.6 0

0.4 1

Cuadro 1: Sı́ntesis de un código de Huffman.

Ejercicio 6

Aplicando la definición:

H(X|Y ) =

X

P (xi , yj ).log2

X,Y

1

P (xi |yj )

Como xi y yj son independientesse cumple queP (xi , yj ) = P (xi ).P (yj ) y que

P (xi |yj ) = P (xi ), por lo que:

H(X|Y ) =

XX

Y

P (xi )P (yj ).log2

X

X

X

1

1

=

P (yj )

P (xi ).log2

P (xi )

P (xi )

Y

H(X|Y ) =

X

P (xi ).log2

X

X

1

= H(X)

P (xi )

Para la segunda parte, aplicando la definición:

I(X, Y ) =

X

P (xi , yj ).log2

X,Y

I(X, Y ) =

X

P (xi )P (yj ).log2

P (xi |yj )

P (xi )

X

X

P (xi )

=

P (xi )P (yj ).0 =

0=0

P (xi )

X,Y

X,Y

X,Y

Ejercicio 7

(a)

I(X, Y ) =

X

P (xi , yj ).log2

X

P (yj /xi )

P (xi , yj )

=

P (xi , yj ).log2

P (xi )P (yj )

P (yj )

X,Y

X,Y

P (y1 ) = P (x1 )P (y1 /x1 ) + P (x2 )P (y1 /x2 ) = p(1 − α) + (1 − p)α

P (y2 ) = P (x1 )P (y2 /x1 ) + P (x2 )P (y2 /x2 ) = pα + (1 − p)(1 − α)

I(X, Y ) = P (x1 )P (y1 /x1 ).log2

...P (x1 )P (y2 /x1 ).log2

P (y1 /x1 )

P (y1 /x2 )

+ P (x2 )P (y1 /x2 ).log2

+ ...

P (y1 )

P (y1 )

P (y2 /x1 )

P (y2 /x2 )

+ P (x2 )P (y2 /x2 ).log2

P (y2 )

P (y2 )

6

Sustituyendo queda:

I(p, α) = p(1−α).log2

...pα.log2

(1 − α)

α

+(1−p)α.log2

+...

p(1 − α) + (1 − p)α

p(1 − α) + (1 − p)α

1−α

α

+ (1 − p)(1 − α).log2

pα + (1 − p)(1 − α)

pα + (1 − p)(1 − α)

(b) Si la potencia del ruido es muy grande, se tiene igual probabilidad de

recibir y1 o y2 (el ruido hace que lo recibido sea aleatorio e independiente de la

entrada). Por lo que en este caso α toma valores cercanos a 21 .

Si la potencia del ruido es muy pequeña, entonces cuando se envı́a un sı́mbolo

(por ej x1 ), siempre se recibe el mismo sı́mbolo en la recepción ya sea y1 o y2 .

En este caso α toma un valor cercano a 0 o a 1.

Ejercicio 8

La ley de Hartley-Shannon nos dice que:

C = B log2 (SN RR + 1)

donde C es la capacidad del canal, B es el ancho de banda del canal y SN RR

es la relación señal a ruido en la recepción.

Si consideramos que la tasa de transferencia de información es igual a la capacidad R = C, tenemos que:

R

= log2 (SN RR + 1)

B

S

donde SN RR = ηB

=

SR

Despejando ηR de :

S R

ηR B

R

S R

= log2 (

+ 1)

B

ηR B

Llegamos a la expresión graficada:

R

S

B

= (2 B − 1)

ηR

R

Ejercicio 9

Si el ancho de banda del mensaje es W y la relación señal a ruido en detección

es SN RD = 106 , la tasa de transferencia de información es:

R = W log10 (106 + 1) = W.6, 00 hartleys/seg

Por otro lado, la capacidad del canal esta dada por:

C = B log10 (SN R + 1)

C = 10W log10 (100.5 + 1) = W 6, 19 hartleys/seg

El sistema es factible. Podemos decir que cumple con las limitantes conocidas

de las predicciones teóricas.

7

Ejercicio 10

(a)

La velocidad de transferencia de información es:

R=5

(b)

pixel

cuadro

M bit

bit

× 480 × 500

× 30

= 36

pixel

cuadro

seg

seg

La capacidad de un canal analógico es:

C = B log2 (SN RR + 1) = 4, 5 M Hz log2 (103,5 + 1) = 52, 32

M bit

seg

Por lo que este ancho de banda serı́a suficiente para enviar TV blanco y negro

con 32 niveles por pixel.

(c) Los sistemas de compresión de video digitales utilizan la propiedad del

ojo de tener una cpacidad de resolución espacial del color mucho más baja que

del nivel del brillo. Ası́, se manda información de color para bloques de pixeles,

por ejemplo de 2x2.

En nuestro caso, una forma razonable de enviar imágenes color serı́a enviar 4

bits/pixel en vez de 5 de información de brillo. Ası́ se gana 1 bit por pixel para

el color, por lo que si se elige tomar bloques de 2x2, se dispone de 4 bits para

mandar la informacion de color. Esto nos darı́a una gama 16 colores, que es muy

poco, por lo que serı́a más razonable mandar información de color para cada

bloque de 3x3, perdiendo mas resolución espacial en el color, pero disponiendo

de 29 (512) colores diferentes.

8