Resumen de Teor´ıa de Matrices

Anuncio

Resumen de Teorı́a de Matrices

Rubén Alexis Sáez Morcillo

Ana Isabel Martı́nez Domı́nguez

1 de Octubre de 2004

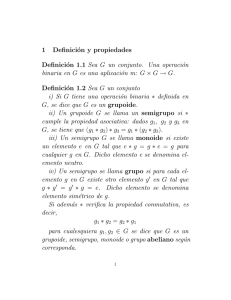

1.

Matrices. Generalidades.

Definición 1.1. Se llama matriz de orden m × n sobre un cuerpo K a un conjunto de (mn) escalares de

k ordenados en m filas y n columnas.

a11 a12 . . . a1n

a21 a22 . . . a2n

M= .

..

..

..

..

.

.

.

am1 am2 . . . amn m×n

Definición 1.2. Para matrices del mismo orden, Am×n y Bm×n , se define la matriz suma, Cm×n =

Am×n + Bm×n , de la siguiente forma:

∀i = 1, . . . , m, ∀j = 1, . . . , n.

cij = aij + bij ,

Definición 1.3. Dada la matriz Am×n y un escalar α ∈ K, entonces la matriz C = αA (producto de un

escalar por una matriz) se obtiene como

cij = αaij ,

∀i = 1, . . . , m, ∀j = 1, . . . , n.

Definición 1.4. Dadas dos matrices Bl×m y Am×n , se define la matriz producto Cl×n = Bl×m Am×n

como sigue

m

X

cij =

bir arj , ∀i = 1, . . . , l, ∀j = 1, . . . , n.

r=1

Nota 1.1 (Propiedades de la suma y producto por un escalar de matrices). Sean A, B ∈ Mm×n

y α, β ∈ R

a) La suma de matrices cumple que:

1. A + B = B + A.

2. A + (B + C) = (A + B) + C.

3. ∃ 0 ∈ Mm×n /A + 0 = A

∀A ∈ Mm×n .

4. ∀A ∈ Mm×n , ∃(−A) ∈ Mm×n /A + (−A) = 0.

b) El producto de una matriz por un escalar verifica que:

5. α(A + B) = αA + αB.

6. (α + β)A = αA + βA.

7. (αβ)A = α(βA).

8. ∃ 1 ∈ R/1 · A = A,

∀A ∈ Mm×n .

Nota 1.2. Que se cumplan estas ocho operaciones implica que el conjunto Mm×n de todas las matrices,

dotado de las operaciones suma y producto por un escalar, es un espacio vectorial. Además, dicho espacio

vectorial será de dimensión mn.

1

Nota 1.3 (Propiedades del producto de matrices). Sean A, B, C y D matrices de números reales

cualesquiera, tales que A ∈ Mm×p , B ∈ Mp×q y C, D ∈ Mq×n . El producto de matrices verifica que:

1. No es conmutativo.

2. (AB)C = A(BC).

3. ∃ Im , Ip , ∀A ∈ Mm×p /Im A = A, AIp = A.

4. Am×p 0p×s = 0m×s ,

0s×m Am×p = 0s×p .

5. B(C + D) = BC + BD.

6. rg(AB) ≤ mı́n {rg(A), rg(B)}.

1

2

7. Si rg(A) = r ≤ mı́n {m, p} =⇒ ∃ Cm×r

, Cr×p

/A = C 1 C 2 .

Definición 1.5. Dada una matriz Am×n , se dice que es cuadrada si m = n.

Definición 1.6. Dada una matriz cuadrada An , se dice que es la matriz identidad si verifica que:

0 si i = j

aij =

.

1 si i 6= j

Definición 1.7. Dada una matriz cuadrada An , se dice que la matriz cuadrada Bn es la inversa de la

matriz A si verifica que AB = BA = In , y se denota B = A−1 .

Proposición 1.1. Dada An×n se verifica que existe A−1 si, y sólo si, la matriz A es de rango completo,

esto es, rg(A) = n.

Nota 1.4 (Propiedades de la inversa de una matriz). Sean A, B ∈ Mn /rg(A) = rg(B) = n. Se

verifica que:

1. ∃ A−1 matriz inversa de A, y ésta es única.

2. (A−1 )−1 = A.

3. (AB)−1 = B −1 A−1 .

4. Si C ∈ Mn , rg(C) = n, AC = In =⇒ CA = In y C = A−1 . Recı́procamente, si CA = In =⇒ AC =

In y C = A−1 .

Definición 1.8. Dada una matriz cuadrada A de orden n, se define la traza de A, que se denota por

tr(A), como el valor de la suma de todos los elementos de la diagonal principal de A, es decir,

tr(A) =

n

X

aii .

i=1

Proposición 1.2. Se tiene que:

i) Sean An , Bn ∈ Mn y α ∈ R, entonces tr(A + B) = tr(A) + tr(B) y tr(αA) = αtr(A).

ii) Sean Am×n y Bn×m , entonces tr(AB) = tr(BA).

Nota 1.5. Cabe destacar que:

a) La aplicación tr : Mn −→ K es lineal.

b) No es cierto, en general, que la traza del producto de matrices sea equivalente al producto de las

trazas de dichas matrices (tomar A = B = In ).

c) Si A es una matriz invertible, no se que cumple que

tr(A−1 ) =

1

tr(A)

(tomar una matriz diagonal cuyos elementos de la diagonal principal sean no nulos).

2

Definición 1.9. Dada una matriz Am×n , se define la matriz traspuesta, Mn×m = At , como:

mij = aji ,

∀i = 1, . . . , n, ∀j = 1, . . . , m.

Proposición 1.3. Dadas A, B ∈ Mm×n , C ∈ Mn×p y α ∈ R se cumple que:

1. (A + B)t = At + B t y (αA)t = αAt .

2. (AC)t = C t At .

3. (At )t = A.

4. rg(A) = rg(At ).

5. Si A ∈ Mn =⇒ tr(A) = tr(At ) y |A| = |At |.

6. Si A ∈ Mn y es invertible =⇒ (A−1 )t = (At )−1 .

7. Si At A = 0n =⇒ A = 0n .

8. Si tr(At A) = 0 =⇒ A = 0n .

9. rg(A) = rg(At A) = rg(AAt ). En particular, si m > n y rg(A) = n, la matriz At A es no singular.

Definición 1.10. Sea An una matriz cualquiera, se denomina determinante de la matriz A, a la aplicación

f : Mn −→

R

,

A

−→ α ∈ R

y se denota por |A| o det(A).

Nota 1.6 (Propiedades de los determinantes). Dadas An , Bn , Cn ∈ Mn y α ∈ R, se verifica que

i) Si las matrices A, B y C difieren exclusivamente en los elementos de la columna j0 siendo los

elementos de esta columna para la matriz C la suma de los respectivos elementos de la columna j0

de las matrices A y B, entonces |A| + |B| = |C|. El mismo resultado se cumple cuando las tres

matrices difieren de igual forma en una fila.

ii) Si se multiplica sólo una fila (o columna) de A por un escalar α, el valor del determinante también

queda multiplicado por α.

iii) |αA| = αn |A|.

iv) Si A = 0n =⇒ |A| = 0.

v) Si A es una matriz con una fila (o columna) cuyos elementos son todos nulos, entonces |A| = 0.

vi) La suma de los productos de los elementos de una fila (o columna) de una matriz A por los adjuntos

de una fila (o columna) paralela diferente es igual a cero.

vii) Si en una matriz A a una de sus filas (o columnas) se le suma una combinación lineal de las filas

(o columnas) paralelas, el determinante de la matriz resultante es también |A|.

viii) Se tiene que:

a) |AB| = |A||B|.

b) |Ak | = |A|k ,

∀k ∈ N.

c) Si A es no singular, entonces |A−1 | =

1

|A| .

Definición 1.11. Dadas dos matrices, Am×n y Bm×n , se dice que son equivalentes si existen matrices

invertibles, Pm×m y Qn×n , tales que

A = P BQ

(B = P −1 AQ−1 ).

3

Definición 1.12. Dadas dos matrices, An y Bn , se dice que son semejantes si existe una matriz invertible

Qn tal que

A = QBQ−1 (B = Q−1 AQ).

Definición 1.13. Dada una matriz An , se dice que es triangular superior si aij = 0, ∀i > j, i, j = 1, . . . , n.

Se dice que An es triangular inferior si aij = 0, ∀i < j, i, j = 1, . . . , n.

Se dice que An es diagonal si aij = 0, ∀i 6= j, i, j, = 1, . . . , n.

Proposición 1.4. Dadas A, B ∈ Mm×n matrices triangulares superiores (inferiores) y α ∈ R, se verifica:

1) A + B y αA son triangulares superiores (inferiores).

2) AB es triangular superior (inferior).

3) Si A tiene inversa, A−1 es triangular superior (inferior).

4) El rango de A es siempre mayor o igual al número de elementos de la diagonal principal de A no

nulos.

Qn

5) |A| = i=1 aii

Nota 1.7. Se debe tener en cuenta que:

a) En general, el resultado que se indica en la cuarta propiedad no se verifica con igualdad.

b) De la cuarta propiedad se puede extraer la siguiente proposición:”A es regular o invertible ⇐⇒ aii 6=

0, ∀i = 1, . . . , n”.

c) Al verificarse la primera propiedad, el conjunto de las matrices triangulares superiores (inferiores,

diagonales) forman un subespacio vectorial sobre el cuerpo K.

Proposición 1.5. Toda matriz cuadrada se puede descomponer como producto de una matriz triangular

superior por una matriz triangular inferior.

Definición 1.14. Dada una matriz An , se dice que es simétrica si A = At . Por contra, se dirá que es

antisimétrica si A = −At .

Proposición 1.6. Sean las matrices An y Bn , y α ∈ R. Si A y B son simétricas, se verifica que:

1) A + B y αA son simétricas.

2) A es simétrica si, y sólo si, A = At .

3) Cuando AB = BA =⇒ AB es simétrica. Sin embargo, esto no es cierto si A y B no conmutan en

el producto.

4) Si A es invertible, entonces A−1 es simétrica.

5) Dada una matriz cualquiera Cm×n =⇒ CC t y C t C son simétricas.

Si A y B son antisimétricas, se cumple que:

6) A + B y αA son antisimétricas.

7) A es antisimétrica si, y sólo si, A = −At .

8) Cuando AB = BA =⇒ AB es antisimétrica. Sin embargo, esto no es cierto si A y B no conmutan

en el producto.

9) Si A es invertible, entonces A−1 es antisimétrica.

10) |A| = (−1)n |A| y, en particular, para n impar, |A| = 0.

Nota 1.8. Al cumplirse las propiedades primera y sexta, se tiene que las matrices simétricas o antisimétricas del mismo orden forman un subespacio vectorial sobre K.

4

Proposición 1.7. Toda matriz se puede expresar como suma de una matriz simétrica y una matriz

antisimétrica.

Proposición 1.8. Si An es una matriz antisimétrica, entonces xt Ax = 0, ∀x ∈ Kn .

Definición 1.15. Dada una matriz An , se dice que es hermı́tica si mij = m̄ji , i, j = 1, . . . , n, donde m̄ij

es el conjugado del número complejo mij .

Proposición 1.9. Sean An y Bn matrices hermı́ticas y α ∈ R. Entonces,

1) A + B y αA son hermı́ticas.

2) Si AB = BA, la matriz AB es hermı́tica. Sin embargo, si A y B no son conmutativas en el producto,

en general AB no es hermı́tica.

3) At es hermı́tica.

4) La matriz conjugada de A, esto es Ā, es hermı́tica.

5) Si A es invertible, su matriz inversa, A−1 , es hermı́tica.

6) El determinante de A es un número real.

Nota 1.9. Cabe destacar que

a) Por cumplirse la primera propiedad, el conjunto de matrices hermı́ticas forman un subespacio vectorial sobre el cuerpo K.

b) Los elementos de la diagonal principal han de ser números reales, ya que deben cumplir la definición

(a = ā =⇒ a ∈ R).

Definición 1.16. Dada una matriz Am×n , se dice que es no negativa si aij ≥ 0, ∀i, j. Se denota por

Am×n ≥ 0m×n .

Se dice que Am×n es semipositiva si aij ≥ 0, ∀i, j y Am×n 6= 0m×n . Lo denotaremos por Am×n > 0m×n .

Se dice que Am×n es positiva si aij > 0, ∀i, j. Se denota como Am×n >> 0m×n .

Nota 1.10. La suma de matrices no negativas sigue siendo una matriz no negativa del mismo tipo. Sin

embargo, esta propiedad no se verifica con el producto de matrices.

Proposición 1.10. Si An y Bn son positivas y α ∈ R+ , se tiene que:

1) A + B y αA son positivas.

2) AB es una matriz positiva.

3) ∀k ∈ N, Ak es positiva.

4) At es una matriz positiva.

Nota 1.11. Los coeficientes de las matrices no negativas siempre pertenecen al cuerpo de los números

reales, ya que en los complejos no está definido un orden total.

Definición 1.17. Dada una matriz An , se dice que es ortogonal si AAt = At A = In .

Proposición 1.11. Sean An y Bn matrices ortogonales, entonces

1) AB y BA son matrices ortogonales, pero en general, no lo son A + B y αA, α ∈ R.

2) El valor de |A| es igual a −1 ó 1.

3) El rango de A es n.

4) A es invertible, su inversa, A−1 , es ortogonal y A−1 = At .

5

5) Si C es una matriz cuadrada tal que CC t = In entonces, C t C = In y, recı́procamente, si C t C = In

se tiene también que CC t = In . Por tanto, basta que C cumpla una de las dos condiciones para que

sea ortogonal.

6) Si Cn es antisimétrica entonces, A = (In − C)(In + C)−1 es una matriz ortogonal.

7) Si ht h = 1 entonces, A = In − 2hht es una matriz ortogonal. Las matrices ası́ definidas se les

denomina matrices Householder.

Definición 1.18. Dada una matriz An , se dice que es

- idempotente si A2 = A.

- unipotente si A2 = In .

- nilpotente si A2 = 0n .

Proposición 1.12. Sean An y Bn

a) Si A y B son idempotentes, se verifica que

1. AB es idempotente siempre que AB = BA.

2. Dada cualquier Cn , si C t C = C, la matriz C es simétrica e idempotente.

3. El valor de |A| es 0 ó 1. Si |A| = 1 se tiene que A = In .

4. rg(A) = tr(A).

5. Si A es simétrica con rg(A) = r, entonces existe Cn×r con rg(C) = r tal que A = CC t y

C t C = Ir .

6. In − A es una matriz idempotente y rg(In − A) = n − rg(A). Sin embargo, A − In no es

idempotente.

7. Si Cn×k con k < n y rg(C) = k, entonces la matriz A = C(C t C)−1 C t es simétrica e idempotente, al igual que à = In − A.

b) Sea An una matriz unipotente, entonces se verifica que

8. |A| = 1 ó |A| = −1.

9. rg(A) = n y, por tanto, existe A−1 y, además, A−1 = A.

c) Sea An una matriz nilpotente, entonces se verifica que

10. |A| = 0 y, por tanto, nunca existe A−1 y rg(A) < n.

11. La matriz In − A es invertible y su inversa es (In − A)−1 = In + A.

Definición 1.19. Una matriz An ≥ 0 se dice que es estocástica si la suma de los elementos de cada fila

es igual a la unidad, es decir,

1

1

1 1

A . = . .

.. ..

1

1

Se dice que es doblemente estocástica si A y At son estocásticas.

Proposición 1.13. Si An y Bn son estocásticas (doblemente estocásticas) se verifica

1. AB es estocástica (doblemente estocástica).

2. ∀k ∈ N, Ak es estocástica (doblemente estocástica).

3. Cuando A es doblemente estocástica, At también lo es.

Definición 1.20. Una matriz An ≥ 0 se dice que es primitiva si existe k ∈ N tal que Ak >> 0.

6

Nota 1.12. Es obvio que si la matriz es positiva, también será primitiva.

Definición 1.21. Una matriz cuadrada, An , con coeficientes reales, se dice que tiene diagonal dominante

si

n

X

|ajj | >

|aij |, ∀j.

i=1,i6=j

2.

Autovalores y autovectores.

Definición 2.1. Un escalar λ ∈ K se dice que es un autovalor de la matriz An×n , si existe un vector

v, v 6= 0, tal que

Av = λv.

Al vector v se le denomina autovector o vector propio.

Nota 2.1. Cabe destacar que

a) El autovector v asociado a un autovalor λ no es único, ya que si Av = λv, entonces, ∀α ∈ K se

verifica que A(αv) = λ(αv) y, por tanto, αv es también un vector propio de A asociado a λ.

b) Si λ es una autovalor de A, el conjunto E(λ) = {v/Av = λv} es un subespacio vectorial no trivial,

E(λ) 6= {0}.

c) Un autovector está asociado a un único valor propio.

Proposición 2.1. Las siguientes condiciones son equivalentes:

i) λ ∈ K es autovalor de A.

ii) El sistema homogéneo (A − λIn )x = 0 es compatible indeterminado.

iii) |A − λIn | = 0.

Definición 2.2. Dada una matriz A cuadrada de orden n, se denomina polinomio caracterı́stico de A al

polinomio de orden n

Pn (λ) = |A − λIn |.

Siendo Pn (λ) = 0 la ecuación caracterı́stica de la matriz A.

Nota 2.2. Cabe tener en cuenta que

a) Es claro que los autovalores de una matriz A ∈ Mn son las raı́ces de su ecuación caracterı́stica

Pn (λ) = |A − λIn | = 0.

b) Si el polinomio caracterı́stico Pn (λ) de la matriz A se puede expresar en la forma Pn (λ) = (λ −

λi )r Qn−r (λ), siendo Qn−r (λ) un polinomio de orden n − r, (r < n) tal que Qn−r (λi ) 6= 0. Entonces,

se dice que λi es un autovalor de A con multiplicidad algebraica mi = r.

c) Dada una matriz A, si λ∗ es uno de sus autovalores, todos los vectores no nulos solución del sistema

homogéneo de n ecuaciones compatible indeterminado (A−λ∗ In )x = 0 serán autovectores asociados

a λ∗ .

d) Si Pn (λ) = |A − λIn | es el polinomio caracterı́stico de la matriz A ∈ Mn , entonces, para cualquier

B ∈ Mn no singular, se verifica que las matrices C = BAB −1 y D = B −1 AB tienen el mismo

polinomio caracterı́stico que A.

Teorema 2.1 (de Cayley–Hamilton). Toda matriz cuadrada An es raı́z de su polinomio caracterı́stico.

Proposición 2.2. Si A es una matriz de orden n, se tiene que

|A − λIn | = (−λ)n + (−λ)n−1 tr(A) + (−λ)n−2 tr2 (A) + (−λ)n−3 tr3 (A) + . . . + |A|,

siendo tri (A), i = 2, 3, . . . , n − 1, la suma de todos los menores de orden i que contienen en su diagonal

principal i elementos de la diagonal principal de A.

7

Nota 2.3. Si λ1 , λ2 , . . . , λn son las raı́ces de PA (λ) entonces,

PA (λ) = (−λ)n + (−λ)n−1 (λ1 + λ2 + . . . + λn ) + (−λ)n−2 tr2 (A) + . . . + (λ1 λ2 · · · λn ).

Además, los coeficientes de (−λ)n−k , k = 2, 3, . . . , n − 1, es la suma de los k productos distintos de las

raı́ces.

Proposición 2.3. Sean A ∈ Mn y B ∈ Mm dos matrices cuyos autovalores son los escalares λ1 , . . . , λn

y µ1 , . . . , µm , respectivamente. Estos autovalores pueden ser reales o complejos, iguales o distintos. Se

verifica que:

i) Los autovalores de At coinciden con los de la matriz A.

ii) El número de autovalores nulos de una matriz A de rango r < n es mayor o igual que n − r.

Qn

iii) |A| = i=1 λi .

Pn

iv) tr(A) = i=1 λi .

v) Los autovalores de la matriz αA, ∀α ∈ R (o C), con α 6= 0 son αλi , i = 1, . . . , n.

vi) Si A es no singular, entonces los autovalores de A−1 son

1

λi , i

= 1, . . . , n.

vii) Para cualquier número natural k no nulo, los autovalores de Ak son λki , i = 1, . . . , n.

viii) Si A es una matriz de orden n con elementos pertenecientes a R tal que sus autovalores λi , i =

1, . . . , n, son reales, entonces para todo p, número natural impar, los autovalores de A1/p son

1/p

λi , i = 1, . . . , n. Si p es par esta propiedad se verifica siempre que λi ≥ 0, i = 1, . . . , n.

ix) Si λi 6= −1, i = 1, . . . , n, entonces In + A es invertible, siendo 1 + λi , i = 1, . . . , n, sus autovalores

1

y 1+λ

, i = 1, . . . , n, los de su inversa.

i

Nota 2.4. Dadas dos matrices A y B de orden n, la suma de un autovalor de A con uno de B en general

no es un autovalor de A + B, a pesar de verificarse iv) y que tr(A + B) = tr(A) + tr(B).

Del mismo modo, aunque |AB| = |A||B| y se cumple la propiedad iii), no se verifica que si λ y µ son

autovalores de A y B, respectivamente, entonces λµ lo sea de AB.

Proposición 2.4. Sea A ∈ Mn , aij ∈ K con i, j = 1, . . . , n, una matriz de orden n cuyos

Prautovalores

son λ1 , . . . , λr ∈ K, con multiplicidades algebraicas m1 , . . . , mr , respectivamente, siendo i=1 mi = n.

Se verifica que

i) Los autovectores correspondientes a autovalores distintos son linealmente independientes.

ii) Si K = C y la matriz A tiene como autovalor λ ∈ C y su conjugado λ̄ entonces, el autovector v

asociado a λ es el conjugado del autovector w asociado a λ̄.

Proposición 2.5. Dada una matriz A de orden n triangular superior (respectivamente inferior o diagonal), se verifica que los autovalores de A son los elementos de su diagonal principal, es decir, aii , i =

1, . . . , n.

Proposición 2.6. Dada una matriz simétrica cuyos elementos son números reales y u, v son autovectores

de A asociados con autovalores λ, µ, (λ 6= µ) entonces, u, v son ortogonales (ut v = 0).

Proposición 2.7. Dada una matriz simétrica A, cuyos elementos son números reales, se verifica que sus

autovalores son números reales.

Proposición 2.8. Dada una matriz A cuadrada de orden n se verifica que

a) Si A es idempotente, entonces

1. Sus autovalores son iguales a 0 ó a 1.

2. tr(A) = rg(A).

8

3. Si m0 es la multiplicidad algebraica de λ = 0 y m1 la de λ = 1, entonces la dimensión de los

subespacios de vectores V (0) y V (1) es m0 y m1 , respectivamente.

b) Si A es unipotente, entonces

4. Todos sus autovalores son iguales a 1 ó −1.

c) Si A es nilpotente, entonces

5. Todos sus autovalores son nulos.

Proposición 2.9. Sea A = (aij ) con aij ≥ 0, es decir, una matriz semipositiva. Entonces se verifica que

i) A es estocástica si, y sólo si, λ = 1 es un autovalor de A con autovector asociado v = (1, . . . , 1)0 .

ii) A es doblemente estocástica si, y sólo si, λ = 1 es uno de los autovalores tanto de A como de At ,

siendo v = (1, . . . , 1)0 su autovector asociado.

Teorema 2.2 (del cı́rculo de Gershgorin). Si An es una matriz cuadrada de orden n y λ es un valor

propio de A entonces,

n

n

[

X

λ∈

Di con Di = z ∈ C/|z − aii | ≤

|aij |

i=1

j=1,j6=i

Corolario 2.1. Dada An una matriz cuadrada de orden n y λ un valor propio de A se verifica que

!

!

n

n

[

\ [

t

λ∈

Di

Di ,

i=1

donde los

Dit

i=1

t

son los Di de A .

Nota 2.5. Como consecuencia del Teorema del Cı́rculo

|λ| − |aii | ≤ |λ − aii | =⇒ |λ| ≤

n

X

|aij | = ri .

j=1

Es decir, a la anterior suma le añadimos el elemento aii por lo que ahora el valor absoluto de los λ lo

calcularemos sumando filas. De esta forma

|λ| ≤ máx {r1 , r2 , . . . , rn } = r∗ , ∀λ.

Si cogemos la suma más grande se cumplirá que todos los autovalores están en la bola de centro cero y

radio el valor de dicho máximo. Razonando de modo análogo, el resultado para las columnas serı́a

|λ| ≤ máx {c1 , c2 , . . . , cn } = c∗ , ∀λ.

Además, por el corolario del Teorema del Cı́rculo, se cumplirá que

|λ| ≤ mı́n {c∗ , r∗ }, ∀λ.

Como todas las bolas están centradas en el origen, nunca podemos descartar que λ = 0 sea autovalor (y,

por tanto, a priori no sabemos si tiene inversa). A este resultado se le conoce como Teorema de Fisher.

Nota 2.6. En las matrices con diagonal dominante

|λ| ≤ 2|aii | para algún i.

Y, por tanto, se tiene que

|λ| ≤ 2 máx {|a11 |, |a22 |, . . . , |ann |}.

Definición 2.3. Dadas dos matrices Am×n y Bm×n se dice que λ es un autovalor generalizado de A con

respecto a B si existe un vector v ∈ Rn (ó Cn ), v 6= 0, de modo que

Av = λBv.

Al vector v se le denomina autovector generalizado asociado a λ.

9

3.

Matrices semipositivas.

Definición 3.1 (permutaciones fila–columna). Se realiza una permutación fila–columna si al intercambiar la fila i con la fila j, i 6= j, a continuación se intercambia la columna i por la columna j.

Definición 3.2. Una matriz An×n se dice que es descomponible si mediante permutaciones fila–columna

se puede expresar de la forma

Ã11 Ã12

,

0

Ã22

donde Ã11 y Ã22 son submatrices cuadradas. En caso contrario, se dice que la matriz es indescomponible.

Proposición 3.1. Sea An×n , A ≥ 0 una matriz indescomponible y x > 0, entonces Ax > 0.

Nota 3.1. La anterior proposición se puede escribir como:”An×n ≥ 0 indescomponible =⇒ Ker(A)∩Rn+ =

{0}, donde Rn+ = {~x ∈ Rn /xi ≥ 0, ∀i}”, lo cual no implica que el núcleo sea cero, sino que en el núcleo

no hay vectores con todas las componentes no negativas.

Proposición 3.2. Si An×n ≥ 0 es indescomponible, entonces (αI + A)n >> 0, ∀α ∈ R+ , es decir,

(αI + A) es primitiva.

Corolario 3.1. Si An×n ≥ 0 es indescomponible y aii > 0, ∀i = 1, . . . , n, entonces An >> 0, es decir, A

es primitiva.

Nota 3.2. Del corolario anterior deducimos que una matriz descomponible jamás será primitiva.

Nota 3.3. Dada A = (aij )n×n llamamos aij (k) al término (i, j) de la matriz Ak .

Proposición 3.3. Si An×n ≥ 0, indescomponible, entonces para todo (i, j) existe una potencia k, tal que

aij (k) > 0.

Nota 3.4. Este resultado no implica que la matriz sea primitiva, sino que para una determinada potencia

el término (i, j) es positivo, pero nada nos asegura que en las potencias anteriores o siguientes lo sea.

Corolario 3.2. Si An×n ≥ 0 es primitiva, entonces es indescomponible.

Definición 3.3. Dada una matriz An×n , se llama espectro (o radio espectral) de A al número real

ρ(A) = máx {|λ|, λ autovalor de A}.

Teorema 3.1 (de Perron). Dada una matriz positiva, An×n >> 0, entonces posee un autovalor λ∗ > 0

tal que λ∗ posee asociado un autovector v ∗ >> 0 y λ∗ = ρ(A).

Corolario 3.3. En las condiciones del Teorema de Perron, se verifican las siguientes propiedades adicionales:

P1) λ∗ > |λ|, ∀λ autovalor de A, λ 6= λ∗ .

P2) Si B > A >> 0 entonces, λ∗B > λ∗A .

P3) Ningún autovalor λ 6= λ∗A posee asociado un autovector u > 0.

Proposición 3.4. Sea An×n ≥ 0, entonces

mı́n rj ≤ λ∗A ≤ máx rj ,

donde

rj =

n

X

k=1

10

ajk .

j = 1, . . . , n,

Nota 3.5. Como los autovalores son iguales para una matriz y su traspuesta, la proposición anterior

equivale a:”Sea An×n ≥ 0, entonces

mı́n cj ≤ λ∗A ≤ máx cj ,

donde

cj =

n

X

j = 1, . . . , n,

akj .”

k=1

Proposición 3.5. Sea An×n ≥ 0 una matriz estocástica, entonces λ = 1 es un autovalor de A, cuyo

autovector asociado es α(1, . . . , 1)0 , α ∈ R \ {0}. Además, λ∗ = 1.

Proposición 3.6. An×n ≥ 0 es estocástica si, y sólo si, λ∗A = 1 con v ∗ = (1, . . . , 1)0 .

Proposición 3.7. An×n ≥ 0 es doblemente estocástica si, y sólo si, λ∗A = 1 con v ∗ = (1, . . . , 1)0 autovector

asociado para A y At .

Proposición 3.8. Sea An×n ≥ 0 estocástica, si λ 6= 1 es autovalor de A, entonces

n

n

X

X

|λ| ≤ mı́n 1 −

mı́n aij ,

máx aij − 1 .

i

i

j=1

4.

j=1

Diagonalización de matrices cuadradas.

Definición 4.1. Una matriz cuadrada A de orden n, se dice diagonalizable si existe una matriz regular

Pn tal que A = P DP −1 , siendo Dn una matriz diagonal (D = P −1 AP ).

Proposición 4.1. Una matriz cuadrada A de orden n es diagonalizable si, y sólo si, posee una base de

autovectores.

Lema 4.1. Dada una matriz cuadrada A de orden n y λ autovalor de A, el subespacio vectorial Eλ =

{v ∈ Rn /Av = λv} verifica que 1 ≤ dim(Eλ ) ≤ multiplicidad de λ.

Proposición 4.2. Una matriz cuadrada A, de orden n, es diagonalizable si, y sólo si, ∀λ, λ autovalor de

A, se cumple que dim(Eλ ) =multiplicidad de λ.

Corolario 4.1. Si todos los autovalores de una matriz son simples, entonces es diagonalizable.

Nota 4.1. Si la matriz cuadrada de orden n, A, es diagonalizable, cabe destacar que:

1. At y αA, ∀α ∈ K, son diagonalizables.

2. Si A es no singular, A−1 es diagonalizable.

3. Que A y B sean diagonalizables no implica que también lo sean A + B y AB.

Definición 4.2. Dada una matriz cuadrada A de orden n, se denomina polinomio mı́nimo de A a un

polinomio en λ mónico, del menor grado posible, mA (λ) tal que mA (A) = 0n .

Proposición 4.3. Si p(λ) es un polinomio tal que p(A) = 0n , entonces p(λ) es múltiplo de mA (λ).

Corolario 4.2. El polinomio caracterı́stico de A es múltiplo del polinomio mı́nimo de A, es decir, pA (λ) =

q(λ)mA (λ).

Proposición 4.4. Dos matrices semejantes tienen el mismo polinomio mı́nimo.

Proposición 4.5. Si λi es un autovalor de A, entonces λi es raı́z de mA (λ).

Nota 4.2. El polinomio mı́nimo y el polinomio caracterı́stico no tienen por qué ser iguales. Si poseen el

mismo grado se verifica que mA (λ) = pA (λ) para grado par y mA (λ) = −pA (λ) para grado impar.

11

Definición 4.3. Se dice que dos polinomios son polinomios primos cuando no tienen divisores en común.

Proposición 4.6 (identidad de Bezout). Si p(x) y q(x) son polinomios primos, entonces existen

polinomios s1 (x) y s2 (x) tales que

s1 (x)p(x) + s2 (x)q(x) ≡ 1.

Proposición 4.7. Dada una matriz cuadrada A de orden n de manera que

pA (λ) =

s

Y

(λi − λ)βi .

i=1

Entonces, A es diagonalizable si, y sólo si, el polinomio mı́nimo es el de menor grado posible,

mA (λ) =

s

Y

(λ − λi ).

i=1

Proposición 4.8. Dada una matriz A cuadrada de orden n, se cumple que

1. Si A es simétrica cuyos elementos son reales, entonces es diagonalizable.

2. Si A es no nula e idempotente, entonces es diagonalizable.

3. Si A es no nula y nilpotente, entonces no es diagonalizable.

Definición 4.4. Dada una matriz cuadrada A de orden n y λ autovalor de A, se llama vector principal

de orden k asociado a λ a un vector v 6= 0 tal que

(A − λI)k v = 0

.

(A − λI)k−1 v 6= 0

En particular, un vector principal de orden uno es un vector propio.

Proposición 4.9. Si v es un vector principal de orden p > 1, entonces w = (A − λI)v es un vector

principal de orden p − 1.

Proposición 4.10. Sea v un vector principal de orden p > 1, entonces los vectores

vp = v

vp−1 = (A − λI)vp

vp−2 = (A − λI)vp−1 = (A − λI)2 vp

..

..

.

.

v1 = (A − λI)v2 = (A − λI)p−1 vp

son linealmente independientes.

Definición 4.5. Sea A una matriz cuadrada de orden n y λ autovalor de A. Se denomina w(λ) al

conjunto de vectores principales asociados a λ unión con el vector cero, es decir,

w(λ) = (vectores principales asociados a λ) ∪ {0}

= {v/(A − λI)p v = 0 para algún p}.

Proposición 4.11. Siempre existe una base de vectores principales.

12

5.

Formas cuadráticas.

Definición 5.1. Se denomina forma cuadrática a toda función f : Rn → R que se puede expresar en la

forma

n X

n

X

f (x1 , x2 , . . . , xn ) =

aij xi xj .

i=1 j=1

Proposición 5.1. Dada una forma cuadrática f (x1 , . . . , xn ) existe una matriz simétrica Sn×n , y sólo

una, tal que f (x) = xt Sx, donde x = (x1 , . . . , xn ). A esta matriz la llamaremos matriz de la forma

cuadrática.

Definición 5.2. Una forma cuadrática f (x1 , . . . , xn ) se dice que es

- definida positiva si f (x1 , . . . , xn ) > 0,

∀x ∈ Rn \ {0}.

- definida negativa si f (x1 , . . . , xn ) < 0,

∀x ∈ Rn \ {0}.

- semidefinida positiva si f (x1 , . . . , xn ) ≥ 0,

∀x ∈ Rn \ {0}.

- semidefinida negativa si f (x1 , . . . , xn ) ≤ 0,

∀x ∈ Rn \ {0}.

- indefinida si ∃ x̄, x̃/f (x̄) > 0 y f (x̃) < 0.

Nota 5.1. La anterior clasificación no es excluyente, una forma cuadrática definida positiva también es

semidefinida positiva.

Definición 5.3. Se llama modo canónico de una forma cuadrática a una expresión de la misma, donde

solo aparecen los cuadrados (no aparecen los dobles productos), es decir,

q(y) =

n

X

di yi2 ,

di ∈ R, i = 1, . . . , n.

i=1

Proposición 5.2. Una forma cuadrática expresada en modo canónico se dice

- definida positiva si di > 0, ∀i = 1, . . . , n.

- definida negativa si di < 0, ∀i = 1, . . . , n.

- semidefinida positiva si di ≥ 0, ∀i = 1, . . . , n.

- semidefinida negativa si di ≤ 0, ∀i = 1, . . . , n.

- indefinida si ∃ di , dj , i 6= j/di > 0, dj < 0.

Teorema 5.1 (espectral). Si An×n es simétrica, existe una matriz U ortogonal tal que A = U DU −1 =

U DU t , con D una matriz diagonal en cuya diagonal principal están ubicados los autovalores de A.

Corolario 5.1. Sea q(x) = xt Ax una forma cuadrática con matriz asociada A, cuyos autovalores son

λ1 , λ2 , . . . , λn . Entonces, se dice que q(x) es

- definida positiva si λi > 0, ∀i = 1, . . . , n.

- definida negativa si λi < 0, ∀i = 1, . . . , n.

- semidefinida positiva si λi ≥ 0, ∀i = 1, . . . , n.

- semidefinida negativa si λi ≤ 0, ∀i = 1, . . . , n.

- indefinida si ∃ λi , λj , i 6= j/λi > 0, λj < 0.

Definición 5.4. Dada una matriz An×n , se denominan menores principales de orden l, (l < n) a los

determinantes de las submatrices l × l donde se han eliminado las mismas filas y columnas. Se denotan

Hl .

13

Nota 5.2. A partir de este momento, haremos uso de los menores principales izquierda. Los denotaremos

por Dl , l = 1, . . . , n y se caracterizan por ser aquellos que se obtienen orlando a partir del elemento a11 .

Proposición 5.3. Dada la forma cuadrática q(x) = xt Ax, con A simétrica tal que los menores principales

D1 , D2 , . . . , Dn−1 son no nulos, entonces se verifica que

q(y) = D1 y12 +

D2 2 D3 2

Dn 2

y2 +

y3 + . . . +

y .

D1

D2

Dn−1 n

Corolario 5.2. Dada la forma cuadrática q(x) = xt Ax con Di 6= 0, i = 1, 2, . . . , n − 1, se verifica que si

q es definida (positiva o negativa), entonces |A| =

6 0.

Corolario 5.3. Si una forma cuadrática q(x) = xt Ax es definida (positiva o negativa), entonces Di 6=

0, ∀i = 1, . . . , n.

Corolario 5.4. Sea q(x) = xt Ax una forma cuadrática con matriz asociada A, cuyos menores principales

son D1 , D2 , . . . , Dn , con Di 6= 0, ∀i = 1, . . . , n − 1. Entonces, se dice que q(x) es

- definida positiva si D1 > 0 y

- definida negativa si D1 < 0 y

Di

Di−1

> 0, ∀i = 2, . . . , n.

Di

Di−1

- semidefinida positiva si D1 ≥ 0 y

- semidefinida negativa si D1 ≤ 0 y

< 0, ∀i = 2, . . . , n.

Di

Di−1

Di

Di−1

≥ 0, ∀i = 2, . . . , n.

≤ 0, ∀i = 2, . . . , n.

- indefinida si ∃ i, j, i 6= j/Di < 0 y Dj > 0.

Corolario 5.5. Sea q(x) = xt Ax una forma cuadrática tal que |A| = 0. Entonces, se verifica que

- q es semidefinida positiva si, y sólo si, Hl ≥ 0, ∀l.

- q es semidefinida negativa si, y sólo si, (−1)l Hl ≥ 0, ∀l.

Definición 5.5. Dadas las matrices An y Bm×n con m < n y rg(B) = m, se dice que la forma cuadrática

restringida

q(x) = xt Ax

sujeta a Bx=0

es

- definida positiva si, y sólo si, ∀x ∈ Rn , x 6= 0/Bx = 0, entonces q(x) > 0.

- definida negativa si, y sólo si, ∀x ∈ Rn , x 6= 0/Bx = 0, entonces q(x) < 0.

- semidefinida positiva si, y sólo si, ∀x ∈ Rn , x 6= 0/Bx = 0, entonces q(x) ≥ 0.

- semidefinida negativa si, y sólo si, ∀x ∈ Rn , x 6= 0/Bx = 0, entonces q(x) ≤ 0.

- indefinida si ∃ x1 , x2 , x1 6= 0, x2 6= 0/Bx1 = 0, Bx2 = 0, entonces q(x1 ) > 0, q(x2 ) < 0.

Nota 5.3. Si una forma cuadrática es definida positiva (negativa) cuando le añadamos restricciones

seguirá siendo definida positiva (negativa). Una matriz semidefinida positiva (negativa) bajo las restricciones puede conservar su carácter o pasar a ser definida positiva (negativa). Si fuese la forma cuadrática

indefinida, al someterla a restricciones no podemos asegurar nada de su carácter.

Proposición 5.4. Sea la forma cuadrática q(x) = xt Ax con x ∈ Rn tal que Bx = 0, donde Bm×n con

m < n y rg(B) = m. Si se denota por µ a las soluciones de la ecuación

0m

B B A − µIn = 0,

entonces se verifica que

14

i) la forma cuadrática restringida q es definida positiva (negativa) si, y sólo si, las soluciones de la

ecuación son positivas (negativas), µi > 0 (µi < 0).

ii) la forma cuadrática restringida q es semidefinida positiva (negativa) si, y sólo si, las soluciones de

la ecuación son no negativas, µi ≥ 0 (no positivas, µi ≤ 0).

iii) la forma cuadrática restringida q es indefinida si ∃ µ1 , µ2 tal que µ1 > 0 y µ2 < 0.

6.

Inversa generalizada.

Definición 6.1. Dada una matriz Am×n , se llama c–inversa de A a una matriz Bn×m tal que A = ABA.

Se denotará como Ac .

Proposición 6.1. Dada una matriz cuadrada A, de orden n, de manera que A es regular, la única

c–inversa de A es A−1 .

Proposición 6.2. Para toda matriz Am×n existe, al menos, una c–inversa.

Proposición 6.3. Dada una matriz Am×n y Ac una c–inversa de A, entonces cualquier c–inversa de A

es de la forma

M = Ac − Ac ABAAc + B,

siendo Bn×m una matriz cualquiera.

Nota 6.1 (Propiedades de las c–inversas). Se verifican las siguientes propiedades:

1. (Ac )t es una c–inversa de At .

2. Si

A=

A11

0

0

(A11 )c

, entonces

A22

0

0

(A22 )c

es una c–inversa de A (con los ceros del tamaño adecuado).

3. rg(Ac ) ≥ rg(A) y rg(A) = rg(AAc ) = rg(Ac A).

4. Dada la matriz Am×n y una c–inversa (Ac )n×m de A, las matrices AAc , Ac A, Im − AAc e In − Ac A

son idempotentes.

Definición 6.2. Dada una matriz Am×n , se llama g–inversa (Moore–Penrose) de dicha matriz a una

matriz Ag que verifica

1) AAg A = A;

2) Ag AAg = Ag ;

3) AAg es simétrica;

4) Ag A es simétrica.

Nota 6.2. Cabe tener en cuenta que:

a) Ag es una c–inversa, por lo que podemos calcular Ag y luego, mediante la fórmula dada en una

proposición anterior, obtener la familia de c–inversas.

b) Si A es regular, entonces Ag = A−1 .

Lema 6.1 (descomposición de rango completo). Dada una matriz Am×n tal que rg(A) = r, entonces

A = A1 A2 con (A1 )m×r , (A2 )r×n y rg(A1 ) = rg(A2 ) = r.

Lema 6.2. Dada una matriz Ar×n con rg(A) = r, se cumple que (AAt )r×r es regular.

Teorema 6.1 (de existencia de la g–inversa). Dada una matriz Am×n cualquiera, entonces siempre

existe Ag .

15

Teorema 6.2 (de unicidad de la g–inversa). La matriz g–inversa es única.

Nota 6.3. Se verifican las siguientes propiedades

1. Dada la matriz Am×n , si rg(A) = n, entonces A2 = I y A = A1 =⇒ Ag = (At A)−1 At . De forma

análoga, si rg(A) = m =⇒ Ag = At (At A)−1 .

2. (Ag )t = (At )g .

3. (Ag )g = A.

4. rg(A) = rg(Ag ).

5. 0g = 0.

6. (αA)g =

1

α Ag

7. Si A es simétrica, entonces (A2 )g = (Ag )2 .

8. Si A es simétrica e idempotente, entonces Ag = A.

No se cumplen en general

9. (AB)g = Bg Ag .

10. AAg = Ag A.

11. Si λ 6= 0 es autovalor de A, entonces

1

λ

es autovalor de Ag .

Definición 6.3. Dada una matriz cuadrada A de orden n, se llama inversa grupo de A a una matriz

A#

n×n que cumple

1. AA# A = A;

2. A# AA# = A# ;

3. AA# = A# A;

4. A2 A# = A;

5. A(A# )2 = A# .

Teorema 6.3 (de existencia de la inversa grupo). Dada una matriz cuadrada A de orden n, se

cumple que A# existe si, y sólo si, rg(A) = rg(A2 ).

Teorema 6.4 (de unicidad de la inversa grupo). La inversa grupo, si existe, es única.

Proposición 6.4. Si λ 6= 0 es autovalor de A, y existe A# , entonces se cumple que

A# .

1

λ

es autovalor de

Proposición 6.5. El sistema [S] es compatible si, y sólo si, AAc b = b, siendo Ac una c–inversa de A (y

la solución del sistema será x = Ac b).

Proposición 6.6. Si el sistema [S] es compatible, sus soluciones son todas de la forma

x = Ac b + (In − Ac A)d,

con d ∈ Rn un vector cualquiera.

Proposición 6.7. Dado un sistema compatible [S]Ax = b, existe una única solución de norma mı́nima

x∗ = Ag b.

Proposición 6.8. Dado el sistema [S]Ax = b, x∗ = Ag b es solución aproximada mı́nimo–cuadrática.

16