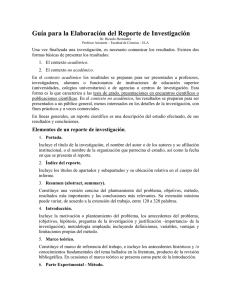

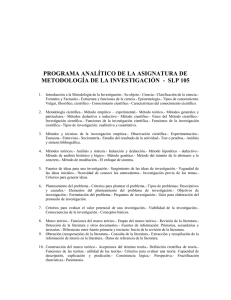

UN ENFOQUE SOBRE LA INVESTIGACIÓN CIENTÍFICA EN

Anuncio