Tema 2. Heterocedasticidad. 1 El modelo de regresión lineal

Anuncio

Tema 2. Heterocedasticidad.

1

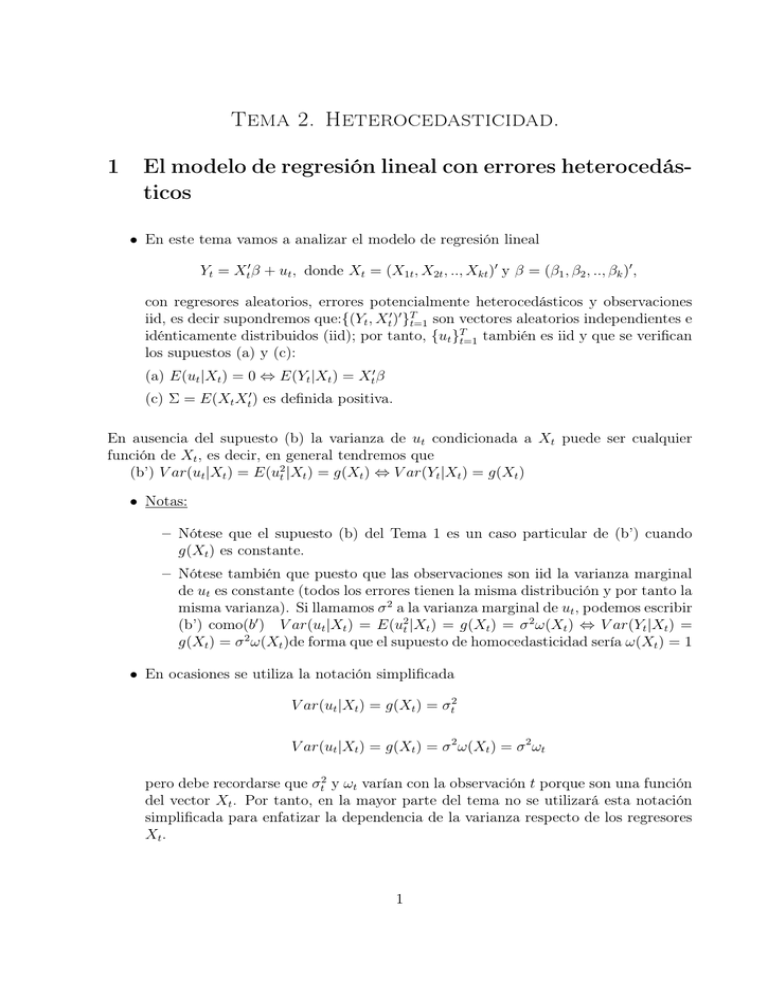

El modelo de regresión lineal con errores heterocedásticos

• En este tema vamos a analizar el modelo de regresión lineal

Yt = Xt0 β + ut , donde Xt = (X1t , X2t , .., Xkt )0 y β = (β1 , β2 , .., βk )0 ,

con regresores aleatorios, errores potencialmente heterocedásticos y observaciones

iid, es decir supondremos que:{(Yt , Xt0 )0 }Tt=1 son vectores aleatorios independientes e

idénticamente distribuidos (iid); por tanto, {ut }Tt=1 también es iid y que se verifican

los supuestos (a) y (c):

(a) E(ut |Xt ) = 0 ⇔ E(Yt |Xt ) = Xt0 β

(c) Σ = E(Xt Xt0 ) es definida positiva.

En ausencia del supuesto (b) la varianza de ut condicionada a Xt puede ser cualquier

función de Xt , es decir, en general tendremos que

(b’) V ar(ut |Xt ) = E(u2t |Xt ) = g(Xt ) ⇔ V ar(Yt |Xt ) = g(Xt )

• Notas:

– Nótese que el supuesto (b) del Tema 1 es un caso particular de (b’) cuando

g(Xt ) es constante.

– Nótese también que puesto que las observaciones son iid la varianza marginal

de ut es constante (todos los errores tienen la misma distribución y por tanto la

misma varianza). Si llamamos σ 2 a la varianza marginal de ut , podemos escribir

(b’) como(b0 ) V ar(ut |Xt ) = E(u2t |Xt ) = g(Xt ) = σ 2 ω(Xt ) ⇔ V ar(Yt |Xt ) =

g(Xt ) = σ 2 ω(Xt )de forma que el supuesto de homocedasticidad sería ω(Xt ) = 1

• En ocasiones se utiliza la notación simplificada

V ar(ut |Xt ) = g(Xt ) = σt2

V ar(ut |Xt ) = g(Xt ) = σ 2 ω(Xt ) = σ 2 ωt

pero debe recordarse que σt2 y ωt varían con la observación t porque son una función

del vector Xt . Por tanto, en la mayor parte del tema no se utilizará esta notación

simplificada para enfatizar la dependencia de la varianza respecto de los regresores

Xt .

1

• Como las observaciones son independientes, Podemos escribir (a) y (b’) condicionando en todas las observaciones y no sólo a la t-ésima, es decir, el supuesto (a)

equivale a

E(ut |X1 , X2 , ..XT ) = E(ut |X) = 0

y (b’) equivale a

V ar(ut |X1 , X2 , ..XT ) = V ar(ut |X) = E u2t |X = σ 2 ω(Xt )

Por tanto, en notación matricial podemos escribir (a) y (b’) como:

(a) E(u|X) = 0 ⇔ E(Y |X) = Xβ

(b’) V ar(u|X) = E(uu0 |X) = σ 2 Ω ⇔ V ar(Y |X) = σ 2 Ω, donde Ω es una matriz

diagonal cuyo elemento (t, t) es ω(Xt ). Es decir la matriz Ω es

ω(X1 )

0

···

0

0

ω(X2 ) · · ·

0

Ω =

..

..

..

..

.

.

.

.

0

2

···

0

ω(XT )

Estimación MCO en presencia de heterocedasticidad

Bibliografía: Alonso et al., 9.3 y 9.7; Greene, 12.2 y 11.2.5; Wooldridge, 8.1 y 8.2

2.1

Propiedades estadísticas en muestras finitas

• Insesgadez

Como ya vimos en el tema 1, si se verifican los supuestos (a) y (c) el estimador

MCO de β es insesgado (demostración en el Tema 1).

• Varianza del estimador MCO

Si se verifican los supuestos (a) y (c)

b

V ar(β|X)

= σ 2 (X 0 X)−1

T

X

!

ω(Xt )Xt Xt0 (X 0 X)−1

t=1

Demostración

h

i

h

i

0

b

b

b

V ar(β|X)

= E (βb − E(β|X))(

βb − E(β|X))

|X = E (βb − β)(βb − β)0 |X

= E (X 0 X)−1 X 0 uu0 X(X 0 X)−1 |X = (X 0 X)−1 X 0 E(uu0 |X)X(X 0 X)−1

2

= σ (X 0 X)−1 X 0 ΩX(X 0 X)−1

2

y puesto que

ω(X1 )

0

···

0

0

ω(X

)

·

·

·

0

2

X1 , X2 , ... , XT

X 0 ΩX =

..

..

..

..

.

.

.

.

0

0

· · · ω(XT )

X10

0

X2

ω(X1 )X1 , ω(X2 )X2 , ... , ω(XT )XT ..

=

=

.

0

XT

T

X

X10

X20

..

.

XT0

!

ω(Xt )Xt Xt0

t=1

tenemos que

b

V ar(β|X)

= σ 2 (X 0 X)−1

T

X

!

ω(Xt )Xt Xt0 (X 0 X)−1

t=1

Nota:

b

Puesto que V ar(β|X)

6= σ 2 (X 0 X)−1 , σ

b2 (X 0 X)−1 no es un estimador apropiado de

V ar(βbM CO ). Como consecuencia de este resultado, cuando los errores son heterocedásticos, ni los errores estándar, ni los contrastes que vimos en Econometría I son

\

válidos, ya que estaban basados en la matriz V ar(βbM CO ) = σ

b2 (X 0 X)−1 .

• El estimador MCO no es el estimador lineal e insesgado de mínima varianza

Si no se verifica el supuesto (b), el estimador MCO no es el estimador lineal e

insesgado de mínima varianza

2.2

Propiedades asintóticas

• Consistencia

Si las observaciones son iid y se cumplen los supuestos (a) y (c), como ya vimos en

el tema 1, el estimador MCO de β es consistente (demostración en el Tema 1).

• Normalidad asintótica

Si las observaciones son iid y se cumplen los supuestos (a) y (c), entonces

√

T (βb − β) →d N (0, Σ−1 σ 2 Ψ Σ−1 )

0

donde Ψ = E(ω(Xt )Xt Xt )

3

Demostración

√

T (βb − β) =

T

1X

Xt Xt0

T t=1

!−1

T

√ 1X

T

Xt u t

T t=1

Consideremos la sucesión de vectores aleatorios Zt = Xt ut , utilizando la ley de las

esperanzas iteradas

E(Zt ) = E(Xt ut ) = E(E(Xt ut |Xt )) = E(Xt E(ut |Xt )) = 0

utilizando de nuevo la ley de las esperanzas iteradas

V ar(Zt ) = V ar(Xt ut ) = E(Xt ut ut Xt0 )

0

0

0

= E(E(u2t Xt Xt |Xt )) = E(E(u2t |Xt )Xt Xt ) = σ 2 E(ω(Xt )Xt Xt ) = σ 2 Ψ

Puesto que los vectores Zt son iid y todos tienen media cero y varianza σ 2 Ψ, utilizando el Teorema Central del Límite

T

√ 1X

T

Xt ut →d N (0, σ 2 Ψ)

T t=1

(1)

Por otra parte, utilizando la ley de los grandes números

T

1X

Xt Xt0 →p Σ = E(Xt Xt0 )

T t=1

y puesto que Σ es definida positiva, utilizando el teorema de la función continua

!−1

T

1X

Xt Xt0

→p Σ−1

(2)

T t=1

y por tanto, utilizando (1) y (2)

√

T (βb − β) →d N (0, Σ−1 σ 2 Ψ Σ−1 )

• Estimación de la varianza límite del estimador MCO (Matriz de varianzas

de White)

Se puede demostrar que, bajo condiciones muy generales, la matriz

T

1X 2

e Xt Xt0 →p σ 2 Ψ

ST =

T t=1 t

donde et son los residuos MCO y por tanto,

!

0 −1

−1

T

XX

1X 2

X 0X

0

et Xt Xt

→p Σ−1 σ 2 Ψ Σ−1

T

T t=1

T

4

Así que, cuando los errores son heterocedásticos, la matriz

!

0 −1

−1

T

0

X

\

X

X

1

X

X

1

2

0

e Xt X t

V arW βbM CO =

T

T

T t=1 t

T

!

T

X

−1

−1

0

= (X X)

e2t Xt Xt0 (X 0 X) ,

t=1

es un estimador apropiado de la matriz de varianzas de βbM CO que se denomina

\

“estimador de White de la matriz de varianzas de βbM CO ”. V arW βbM CO también

se denomina matriz de varianzas estimada de βbM CO robusta a heterocedasticidad ya

que es un estimador apropiado de la matriz de varianzas de βbM CO tanto cuando los

errores son heterocedásticos como cuando son homocedásticos. Los errores estándar

basados en esta matriz se denominan errores estándar robustos a heterocedasticidad.

Como veremos a continuación, la matriz de varianzas estimada de βbM CO robusta

a heterocedasticidad permite realizar inferencia utilizando el estimador MCO sin

necesidad de especificar el tipo de heterocedasticidad.

• El estimador MCO no es asintóticamente eficiente

Si no se verifica el supuesto (b), el estimador MCO no es asintóticamente eficiente.

2.3

Contraste de hipótesis

• Contrastes de q restricciones lineales:

H0 : Rβ = r

H1 : Rβ 6= r

siendo R una matriz q × k y r un vector q × 1. Supondremos que las observaciones

son iid y que se cumplen los supuestos (a) y (c)

Hemos demostrado que bajo estos supuestos

√

T (βb − β) ' N (0, N (0, Σ−1 σ 2 Ψ Σ−1 ))

Multiplicando por la izquierda por R

√

T (Rβb − Rβ) ' N (0, RΣ−1 (σ 2 Ψ)Σ−1 R0 )

Bajo H0

√

T (Rβb − r) ' N (0, RΣ−1 (σ 2 Ψ)Σ−1 R0 )

(1)

Por otra parte tenemos que

!

0 −1

−1

T

\

XX

1X 2

X 0X

0

e t Xt Xt

= T V arW βbM CO →p Σ−1 (σ 2 Ψ)Σ−1

T

T t=1

T

5

Multiplicando por la izquierda por R y por la derecha por R0

\

T RV arW βbM CO R0 →p RΣ−1 (σ 2 Ψ)Σ−1 R0

(2)

Utilizando (1), (2) y el ejemplo 5 de convergencia en distribución (Tema 1), el

estadístico de contraste es

−1 √

√

\

0

b

b

W =

T (Rβ − r) T RV arW βM CO R0

T (Rβb − r)

0

= (Rβb − r)

−1

\

(Rβb − r) ' χ2q Bajo H0

RV arW βbM CO R0

y rechazaremos H0 a nivel α si W > χ2q,α . Nótese que el estadístico de contraste

es similar al que obtuvimos en el Tema 1. La diferencia es que ahora la matriz de

varianzas estimada del estimador MCO es la matriz de varianza de White, mientras

que en el Tema 1 la varianza estimada del estimador MCO era σ

b2 (X 0 X)−1

• Contrastes de una restricción lineal:

(a) H0 : Rβ = r (b) H0 : Rβ = r (c) H0 : Rβ = r

H1 : Rβ 6= r

H1 : Rβ > r

H1 : Rβ < r

Ahora R es un vector fila 1 × k y r es un escalar. En este caso, para el contraste

(a) podemos utilizar el estadístico W que acabamos de ver. Sin embargo, para los

contrastes (b) y (c) no podemos utilizar dicho estadístico.

Para los contrastes (b) y (c) (y también para el (a)) utilizando (1), (2) y el ejemplo

6 de convergencia en distribución (Tema 1) podemos construir el estadístico:

√

T (Rβb − r)

(Rβb − r)

t= q

=q

' N (0, 1) Bajo H0

\b 0

\b 0

T RV arW (β)R

RV arW (β)R

En este caso rechazaremos H0 a nivel α si

(a) : |t| > zα/2

(b) : t > zα

(c) : t < −zα .

En particular para contrastar

(a) H0 : βj = βj0 (b) H0 : βj = βj0 (c) H0 : βj = βj0

H1 : βj 6= βj0

H1 : βj > βj0

6

H1 : βj < βj0

todos los elementos del vector R son

q cero salvo el elemento j que es uno. Por

\b 0

\

\b 0

tanto, RV arW (β)R

= V arW (βbj ) y RV arW (β)R

= SEW (βbj ). El estadístico de

contraste es

βbj − βj0

t=

' N (0, 1) Bajo H0

SEW (βbj )

• Nota

Los estadísticos de contraste W y t que hemos obtenido en esta sección se denominan

estadísticos robustos a heterocedasticidad ya que pueden utilizarse tanto cuando los

errores son heterocedásticos como cuando son homocedásticos.

3

Contrastes de heterocedasticidad

Bibliografía: Alonso et al., 9.4;Greene, 12.3.1-12.3.3; Wooldridge, 8.3

3.1

Contraste de Breusch-Pagan.

• La versión original del contraste Breusch-Pagan asumía que los errores ut seguían

una distribución normal. Posteriormente se desarrolló una versión de este contraste

que no requiere normalidad. Debido a su mayor aplicabilidad, la que se expone a

continuación es la versión más reciente.

• La hipótesis nula del contraste de Breusch-Pagan es que los errores son homocedásticos, es decir

H0 : V ar(ut |Xt ) = E(u2t |Xt ) = σ 2

Por tanto, si la hipótesis nula no es cierta, E (u2t |Xt ) no será constante, sino que

será función de al menos una de las variables explicativas del modelo.

H1 : V ar(ut |Xt ) = E(u2t |Xt ) = g (Zt ) = σt2

0

donde Zt = (Z1t , ..., Zpt ) son algunas (o todas) las variables explicativas del vector

Xt y/o funciones conocidas de ellas. Por tanto, una forma de comprobar si la media

0

de u2t depende de ese subconjunto Zt = (Z1t , ..., Zpt ) de las variables explicativas es

mediante la regresión

u2t = δ0 + δ1 Z1t + ... + δp Zpt + vt ,

donde vt es un término de error que suponemos tiene esperanza cero dadas Z1t ,...,Zpt .

La hipótesis nula de homocedasticidad es

H0 : δ1 = ... = δp = 0,

7

• Si bien los errores ut , t = 1, 2, ..T, no son observables, podemos utilizar los residuos

MCO et , t = 1, 2, ..T, como estimaciones de los errores. Así, podemos estimar la

ecuación

e2t = δ0 + δ1 Z1t + ... + δp Zpt + errort

y contrastar la significatividad conjunta de Z1 , ..., Zp . El contraste de significatividad

conjunta puede realizarse con el estadístico de Wald, pero más generalmente se opta

por el estadístico de contraste llamado Multiplicador de Lagrange, cuyo fundamento

puede verse por ejemplo en Wooldridge (2006, C. 5).

• Los pasos para realizar el contraste Breusch-Pagan de heterocedasticidad son:

(1) Se estima por MCO Yt = Xt0 β + ut y se calculan los residuos (et ).

(2) A continuación se estima por MCO la ecuación

e2t = δ0 + δ1 Z1t + ... + δp Zpt + errort .

(3) El estadístico de contraste (Multiplicador de Lagrange) y su distribución

bajo H0 son

T R2 w χ2p

siendo R2 el coeficiente de determinación de la regresión del paso (2) y p el número

variables explicativas (excluyendo la constante) en la regresión del paso (2).

3.2

Contraste de White.

• Este contraste es un caso particular del contraste de Breusch-Pagan, para contrastar

homocedasticidad frente a una forma genérica de heterocedasticidad

H0 : V ar(ut |Xt ) = E(u2t |Xt ) = σ 2

H1 : V ar(ut |Xt ) = E(u2t |Xt ) = σ 2 ω (Xt )

donde ω (Xt ) es una función general no especificada.

• En el contexto de un modelo de regresión lineal, White probó que si u2t no está

correlacionado con ninguna de las variables independientes del modelo (Xjt ), ni con

2

sus cuadrados (Xjt

), ni con todos los productos cruzados (Xjt Xht , j 6= h), entonces

no hay necesidad de utilizar una matriz de covarianzas robusta a heterocedasticidad

en la estimación MCO.

• Pasos para realizar el contraste de White.

(1) Se estima Yt = Xt0 β + ut por MCO y se calculan los residuos et .

(2) Se estima por MCO la regresión de e2t sobre una constante, sobre los regresores del modelo original, sobre los cuadrados de estos regresores y sobre los

productos cruzados de los mismos.

8

(3) El estadístico de contraste es T R2 , donde R2 es el coeficiente de determinación de la regresión del paso (2). Bajo H0 , T R2 ' χ2p , donde p es el número total

de regresores (sin incluir la constante) de la regresión del paso (2).

• Intuitivamente, P

lo quePse hace es analizar si existe una heterocedasticidad del tipo

ω(Xt ) = α0 + kj=1 km=j αjm Xjt Xmt , puesto que la función desconocida ω (Xt )

siempre se puede aproximar de esta forma (es una aproximación de Taylor de segundo orden).

• Notas:

1. Aunque el modelo original no tenga constante, la regresión auxiliar del paso 2

siempre debe incluir una constante.

2. Se deben eliminar los elementos redundantes en la regresión auxiliar del paso 2.

• Poner dos ejemplos sencillos de cómo quedaría la regresión del paso 2: en un modelo

con tres variables explicativas (incluida la constante), y en el modelo Yt = β1 +

2

β2 X2t + β3 X2t

+ ut .

4

Estimación por Mínimos Cuadrados Generalizados

Bibliografía: Alonso et al., 9.5; Greene, 12.4; Wooldridge, 8.4

4.1

Heterocedasticidad conocida salvo por una constante multiplicativa. El estimador de Mínimos Cuadrados Generalizados

(MCG)

• En esta sección consideraremos el caso en el que la heterocedasticidad es conocida,

es decir el caso en el que ω(Xt ) es una función conocida del vector Xt , siendo

V ar(ut |Xt ) = σ 2 ω(Xt ). Vamos a ver que bajo este supuesto podemos transformar el

modelo de forma que el modelo transformado verifique todos los supuestos básicos,

y por tanto, el estimador MCO del modelo trasformado será el estimador lineal e

insesgado de mínima varianza.

p

• La transformación consiste en dividir todas las variables del modelo por ω(Xt ).

El modelo transformado es

Y

1

ut

p t

= (p

Xt )0 β + p

ω(Xt )

ω(Xt )

ω(Xt )

1

X2t

Xkt

ut

= β1 p

+ β2 p

+ ... + βk p

+p

,

ω(Xt )

ω(Xt )

ω(Xt )

ω(Xt )

9

t = 1, 2, ..., T

Si denotamos Yt∗ = √

Yt

,

ω(Xt )t

Xt∗ = √

1

Xt

ω(Xt )

y u∗t = √ ut

ω(Xt )

podemos escribir el

modelo transformado como

Yt∗ = Xt∗0 β + u∗t

Vamos a ver ahora que efectivamente el modelo trasformado verifica todos los

supuestos básicos

– {(Yt∗ , Xt∗0 )0 }Tt=1 son vectores aleatorios independientes e idénticamente distribuidos ya que (Yt∗ , Xt∗0 )0 es función de (Yt , Xt0 )0 y {(Yt , Xt0 )0 }Tt=1 son vectores aleatorios independientes e idénticamente distribuidos.

– Se verifica el supuesto (a)

!

ut

E(u∗t | Xt ) = E

p

ω(Xt )

| Xt

1

=p

E (ut | Xt ) = 0

ω(Xt )

– Se verifica el supuesto (b)

V ar(u∗t | Xt ) = V ar

ut

p

ω(Xt )

!

| Xt

=

1

1

V ar (ut | Xt ) =

σ 2 ω(Xt ) = σ 2

ω(Xt )

ω(Xt )

– Se verifica el supuesto (c) ya si E(Xt Xt0 ) tiene rango máximo entonces E(Xt∗ Xt∗0 )

también tiene rango máximo

• Se define el estimador de Mínimos Cuadrados Generalizados (MCG) como el estimador MCO del modelo transformado, es decir

X

−1 X

X

−1 X

0

Xt Yt

X

X

t

t

∗

∗0

∗

∗

βbM CG =

Xt X t

Xt Yt =

ω(Xt )

ω(Xt )

y su matriz de varianzas es

X

−1

0

X

X

X

t

t

2

∗

∗0

−1

2

V ar βbM CG X = σ (

Xt Xt ) = σ

ω(Xt )

También lo podemos escribir utilizando la notación simplificada como

X

−1 X

−1 X

X

Xt Xt0

X t Yt

∗ ∗0

∗ ∗

b

βM CG =

Xt Xt

Xt Yt =

ωt

ωt

X

−1

X X t Yt

Xt Xt0

=

σt2

σt2

X

−1

X

Xt Xt0

2

∗ ∗0 −1

2

b

V ar βM CG X = σ (

X t Xt ) = σ

ωt

X

−1

Xt Xt0

=

σt2

10

Puesto que el modelo transformado verifica todos los supuestos básicos, el estimador

MCG, que es el estimador MCO del modelo transformado, es el estimador lineal e

insesgado de mínima varianza de β. Por la misma razón, el estimador MCG es consistente y asintóticamente normal. Para contrastar restricciones lineales utilizando

el estimador MCG, podemos utilizar los contrastes asintóticos que vimos en el Tema

1. Además, si los errores son normales podemos utilizar los contrastes exactos bajo

normalidad que vimos en Econometría I.

• Notas:

– Obsérvese que se están ponderando las observaciones a la hora de construir el

estimador: Las observaciones con menor varianza tienen ahora un peso mayor

que las observaciones con una varianza mayor. El estimador MCG también se

denomina estimador de mínimos cuadrados ponderados.

– El supuesto de que la heterocedasticidad es conocida es conveniente ya que nos

permite corregirla mediante la trasformación que acabamos de ver, de forma

que podemos trabajar con modelo transformado que verifica todos los supuestos

básicos. El problema es que este supuesto es poco realista en la mayoría de las

aplicaciones.

• Poner algunos ejemplos y explicar al menos uno de ellos con detalle: V ar(ut |Xt ) =

2

σ 2 Xjt ; o bien V ar(ut |Xt ) = σ 2 Xjt

; etc.

4.2

Heterocedasticidad dependiente de un conjunto de parámetros desconocidos. El estimador de Mínimos Cuadrados Generalizados Factible (MCGF)

Bibliografía: Alonso et al., 9.6; Greene, 12.5; Wooldridge, 8.4

• En esta sección vamos a considerar el caso en el que la heterocedasticidad no es

completamente conocida, sino que ω es una función conocida de un número pequeño

de parámetros desconocidos. Es decir supondremos que V ar(ut |Xt ) = E(u2t |Xt ) =

g(Xt , δ) = σ 2 ω(Xt , α), siendo ω una función conocida y α un vector de parámetros

desconocidos. Veremos como podemos en ese caso estimar los parámetros desconocidos de ω(Xt , α) y utilizaremos los parámetros estimados para calcular una estimación de ω(Xt , α) que utilizaremos para trasformar el modelo de forma análoga al

caso en el que ω(Xt ) era completamente conocida.

• Para estimar α utilizaremos una regresión auxiliar basada en los residuos MCO del

modelo original. La regresión auxiliar depende del supuesto que hagamos sobre la

función ω(Xt , α) como ilustran los siguientes ejemplos.

11

α

– Ejemplo 1: σt2 = E(u2t |Xt ) = σ 2 Xjt

donde Xjt es uno de los regresores del

modelo.

Se estima por MCO la regresión auxiliar ln (e2t ) = ln (σ 2 ) + α ln Xjt + vt , lo

que permite obtener un estimador del escalar α, y a partir de ahí se obtiene

α

b

ω

bt = Xjt

.

– Ejemplo 2: σt2 = E(u2t |Xt ) = α0 Zt donde Zt es un subconjunto de los regresores

del modelo que incluye la constante.

Se estima por MCO la regresión auxiliar e2t = α0 Zt + vt , lo que permite obtener

un estimador del vector α, y a partir de ahí se obtiene σ

bt2 = (b

α 0 Zt )

– Ejemplo 3: σt2 = E(u2t |Xt ) = (α0 Zt )2 donde Zt es un subconjunto de los regresores del modelo que incluye la constante.

Se estima por MCO la regresión auxiliar | et |= α0 Zt + vt , lo que permite

α0 Zt )2

obtener un estimador del vector α, y a partir de ahí se obtiene σ

bt2 = (b

– Ejemplo 4: σt2 = E(u2t |Xt ) = exp (α0 Zt ) donde Zt es un subconjunto de los

regresores del modelo que incluye la constante.

Se estima por MCO la regresión auxiliar ln (e2t ) = α0 Zt + vt , lo que permite

obtener un estimador del vector α, y a partir de ahí se obtiene σ

bt2 = exp (b

α0 Zt )

• Una vez que hemos calculado ω

bt (o σ

bt2 ) utilizaremos estas estimaciones para transformar el modelo análogamente al caso en el que la heterocedasticidad era

√completamente

conocida

es

decir

dividiremos

todas

las

variables

del

modelo

por

ω

bt (o bien

p

2

por σ

bt ). El estimador MCO del modelo transformado se denomina en este caso

estimador de Mínimos Cuadrados Generalizados Factible (MCGF) y su expresión

es

X

X

0 −1 X

0 −1 X

X

Y

X

X

X

Y

X

X

t

t

t

t

t

t

t

t

=

.

βbM CGF =

ω

bt

ω

bt

σ

bt2

σ

bt2

• Bajo estos supuestos, el estimador MCGF tiene las mismas propiedades asintóticas que el MCG. Sin embargo, sus propiedades en muestras finitas son en general

desconocidas. Para contrastar restricciones lineales utilizando el estimador MCGF,

podemos utilizar los contrastes asintóticos que vimos en el Tema 1. Nótese que

aunque los errores sean normales los contrastes exactos bajo normalidad que vimos

en econometría I no son válidos.

12