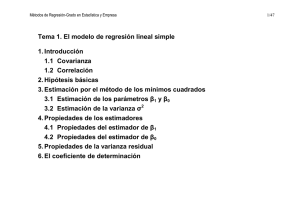

Demos Regresion Simple

Anuncio

Demostraciones de Regresión Simple. Estimación La distribución de y es y i ∼ Nβ 0 + β 1 x i , σ 2 Estimación Máximo Verosímil La función de verosimilitud, sabiendo que y i es una variable normal será n 2 1 exp − 1 y i − β 0 − β 1 x i 2 σ2 σ 2π ∏ L= i=1 ya que la densidad de y es: fy i = Tomando logaritmos 1 σ 2π exp − 12 y i −media 2 Varianza n log L = ∑− log 2π − 1/2 log σ 2 − 1/2 i=1 y i − β 0 − β 1 x i 2 σ2 Para calcular el los valores que maximizan L derivamos e igualamos a cero ∂ log L = ∂β 0 n ∑ −2y i − β 0 − β 1 x i = 0 # i=1 n ∂ log L = ∂β 1 ∑ −2x i y i − β 0 − β 1 x i = 0 # i=1 Resolviendo estas ecuaciones se obtienen los valores de β 0 y β 1 Estimación por mínimos cuadrados El error de predicción que cometemos con una observación será el valor observado menos el previsto e i = y i − y i = y i − β 0 + β 1 x i La suma de errores al cuadrado. S= n n i=1 i=1 ∑ e 2i = ∑y i − β 0 − β 1 x 2 Minimizamos la suma de errores al cuadrado: n n i=1 i=1 S = min∑ e 2i = min∑y i − β 0 − β 1 x 2 # ∂S = ∂β 0 ∂S = ∂β 1 n ∑ −2y i − β 0 − β 1 x = 0 i=1 n ∑ −2x i y i − β 0 − β 1 x = 0 i=1 Estas ecuaciones coinciden con las de máxima verosimilitud y se denominan Ecuaciones Normales. Se pueden expresar en función de los residuos como: ∑ ei = 0 ∑ eixi = 0 # # Los valores de los parámetros son: n ∑ i=1 y i − yx i − x covx, y β1 = = n varx x i − x 2 ∑ i=1 β0 = y − β1x Para estimar la varianza se utiliza la varianza residual. La varianza residual es la varianza de los residuos corregida por grados de libertad. Como los residuos tienen media cero (por la primera ecuación normal), la varianza residual será:: n ∑ i=1 e 2i 2 sR = n−2 Distribución de β 1 Como hemos visto β1 = n n y i − yx i − x y i x i − x ∑ i=1 ∑ i=1 = n n 2 ∑ i=1 x i − x ∑ i=1 x i − x 2 Siempre se cumple que la suma de desviaciones a la media de cualquier variable es cero: n ∑x i − x = 0 # i=1 n n n i=1 i=1 i=1 ∑x i − x = ∑ x i − ∑ x = nx − nx = 0 # La expresión de la varianza de x es: s 2x = n x i − x ∑ i=1 # n Por tanto β 1 se puede escribir como: β1 = n x i − x ∑ i=1 ns 2x yi # Sabemos que y i ∼ Nβ 0 + β 1 x i , σ 2 y por tanto Ey i = β 0 + β 1 x i y vary i = σ 2 β 1 es por tanto combinación lineal de variables aleatorias normales, por lo se distribuirá normalmente. Su media será: n x i − x ∑ i=1 Eβ 1 = E = n x i − x ∑ i=1 ns 2x ns 2x β 0 + β 1 x i = n x i − x ∑ i=1 = yi ns 2x n x i − x ∑ i=1 ns 2x Ey i n x i − x ∑ i=1 β0 + ns 2x # β1xi # El primer término es cero por ser suma de desviaciones a la media El numerador del segundo término de la expresión anterior puede escribirse como: n ∑x i − xx i = i=1 n ∑ x 2i − nx # i=1 Y el denominador: n ns 2x = ∑x i − x n 2 = i=1 n ∑ i=1 n x 2i + ∑ x − 2 ∑ xx i = n ∑ x 2i + ∑ x 2 − 2nx = i=1 n i=1 2 i=1 # i=1 n ∑ x 2i − nx # i=1 Por tanto Eβ 1 = β 1 # Vamos a calcular la varianza de β 1 varβ 1 = n x i − x 2 ∑ i=1 ns 2x 2 vary i = n x i − x 2 ∑ i=1 ns 2x 2 n x i − x 2 ∑ i=1 2 σ2 σ2 = = σ2 n n 2 2 2 ns x ∑ i=1 x i − x ∑ i=1 x i − x σ2 = # # Por tanto 2 β 1 ∼ Nβ 1 , σ 2 ns x # Además (No lo demostramos) n − 2 2 s R ∼ χ 2n−2 σ2 # Contrastes e intervalos Hemos demostrado que 2 β 1 ∼ Nβ 1 , σ 2 ns x # por tanto β1 − β1 ∼ N0, 1 σ/ ns 2x # La definición de una t de k grados de libertad es: tk = t n−2 = N0, 1 1 2 χ k k β 1 −β 1 σ/ ns x n−2 1 n−2 σ 2 2 sR # β − β1 = 1 s R/ n sx # Al término s R / n s x = SEβ 1 # se le denomina error estándar de β 1. Es el valor del error estándar que proporciona el ordenador. El ”contraste t” va a testear la posibilidad de que β 1 = 0. Es decir que el valor de verdad de la población sea realmente cero. Si esto fuera cierto la variable X no influiría sobre la variable Y. H0 : β1 = 0 H1 : β1 ≠ 0 Habíamos demostrado que β1 − β1 = t n−2 SEβ 1 Si se cumple la hipótesis nula de que β 1 = 0 resultará que β1 β1 − 0 = = t n−2 SEβ 1 SEβ 1 Por tanto si se cumple H 0 el valor de β1 SEβ 1 deberá ser de una t n−2 . Esta distribución si n>30 deja entre −2; +2 el 95% de probabilidad. Por tanto si obtenenemos un número en ese rango es posible que efectivamente β 1 = 0. Si por el contrario el número es mayor que 2 en valor absoluto pensaremos que β 1 ≠ 0 y, consecuentemente, diremos que la varible influye. Este es el fundamento teórico del contraste t que proporciona el ordenador. Intervalo de confianza Como sabemos que β 1 −β 1 SEβ 1 ∼ t n−2 podemos establecer β − β1 ≤ t α/2 = 1 − α P−t α/2 ≤ 1 SEβ 1 Pβ 1 − t α/2 SEβ 1 ≤ β 1 ≤ β 1 + t α/2 SEβ 1 = 1 − α # # Por tanto β 1 ∈ β 1 ± t α/2 SEβ 1 # con confianza 1-α. Si trabajamos con α = 0.05 y n>30, el intervalo se convierte en β 1 ∈ β 1 ± 2SEβ 1 Coeficiente de determinación Descomposición de variabilidad yi = y i + ei # restando y y elevando al cuadrado: y i − y 2 = y i − y 2 + e i 2 + 2 y i − ye i # sumando para todas las observaciones n n n n i=1 i=1 i=1 ∑y i − y = ∑y i − y 2 + ∑e i − y 2 + 2 ∑y i − ye i 2 i=1 # n El último término es cero, recordando que las ecuaciones normales indicaban que ∑ e i = 0 y i=1 n ∑ xiei = 0 i=1 n n n n n i=1 i=1 i=1 i=1 i=1 ∑y i − ye i = ∑ y i e i − ∑ ye i = ∑β 0 + β 1 x i e i − ∑ ye i n n n i=1 i=1 i=1 = β0 ∑ ei + β1 ∑ xiei − y ∑ ei = 0 Por tanto # # n n n i=1 i=1 ∑y i − y = ∑y i − y 2 + ∑e i − y 2 2 i=1 VT = VE + VNE # # n VT = ∑y i − y 2 # ∑y i − y 2 # ∑e i − y 2 # i=1 n VE = i=1 n VNE = i=1 Donde VT es la variación total VE es laVariación explciada y VNE es la variación no explicada. El coeficiente de determinación, R 2 , proporciona la cantidad de variabilidad de y que explica la x. Se define n R 2 = VE = VT ∑y i − y 2 i=1 n ∑y i − y 2 i=1 n = ∑y i − y 2 i=1 ns 2y