Document

Anuncio

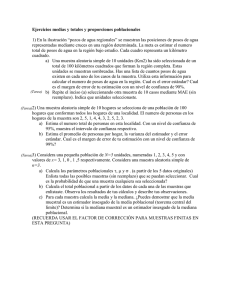

11. Muestreo 1 INFERENCIA ESTADÍSTICA Proceso y resultado de extraer conclusiones respecto a una población a partir de una o más muestras. obtención de la muestra conclusiones P M 2 ¿Cuántos peces hay en un lago? Pere Grima [email protected] Pesca-repesca / captura-recaptura Si pudiéramos ver lo que hay dentro... Pescamos, marcamos y los soltamos “Capturem un cert nombre de peixos, no ho fem pescant-los de la forma habitual, sinó que s’utilitzen tècniques normalment amb descàrregues elèctriques, que els deixa estabornits una estona i suren a la superfície, i se’ls pot agafar, marcar-los i deixar-los anar una altre vegada”. Pere Grima 15 peces Los peces marcados se dispersan... Volvemos a pescar Hipótesis. Cálculos Primera Muestra Segunda Muestra N: Número total de peces C: Capturados M: Marcados R: Aparecen marcados Estimación: M R = N C M·C N̂ = R 15·15 N̂ = 75 = 3 Si pudiéramos ver lo que hay dentro... La realidad: 2 1 5 14 12 3 4 16 8 11 32 41 42 24 9 18 25 43 30 44 37 26 47 55 66 62 65 58 63 54 59 48 19 20 57 64 61 56 52 46 53 36 17 10 35 23 67 60 51 34 29 13 7 50 40 28 22 15 6 39 33 27 21 31 38 45 49 Hay 67 peces. Error del 12% sobre el valor real. ¿Qué significa que N está “alrededor de” 75? ¿Tenemos un buen estimador? ¿Cuál es la calidad de la estimación si: N = 1000, M = 100, C = 100? ... Simulando 10.000 veces con Minitab: Peces que se hallan marcados en la repesca Frecuencia absoluta 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 23 3 14 35 141 279 533 860 1183 1378 1454 1202 1066 744 494 296 170 75 46 16 10 1 Porcentaje Porcentaje acumulado Estimación tamaño población 0,03 0,14 0,35 1,41 2,79 5,33 8,6 11,83 13,78 14,54 12,02 10,66 7,44 4,94 2,96 1,7 0,75 0,46 0,16 0,1 0,01 0,03 0,17 0,52 1,93 4,72 10,05 18,65 30,48 44,26 58,8 70,82 81,48 88,92 93,86 96,82 98,52 99,27 99,73 99,89 99,99 100 10000 5000 3333 2500 2000 1667 1429 1250 1111 1000 909 833 769 714 667 625 588 556 526 500 435 ≅ 80 % + 429 - 231 Haciendo gráficos 80% 1400 1400 1200 1200 1000 1000 800 600 800 600 400 400 200 200 0 0 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 Peces que se hallan marcados en la repesca 7 80% 1600 Frecuencia Frecuencia 1600 13 0 500 769 1000 1500 2000 Tamaño estimado 2500 3000 1429 M·C Es un estimador N̂ = R sesgado ECOLOGÍA CON NÚMEROS. Una introducción a la ecología con problemas y ejercicios de simulación Josep Piñol y Jordi Martínez-Vilalta. Lynx Edicions. Bellaterra (Barcelona), 2006(pág. 49) Marcaje y recaptura: Applet ¿Se puede mejorar? ¿Se puede calcular un estimador que no tenga sesgo? ¿Cómo varía la calidad del estimador al aumentar M y/o C? ¿Y si se hacen varias repescas? Charles J. Kreps: “Ecological Methodology”. Ed. Addison Wesley, 1999. “How Many Fish are in the Pond?” de Roger W Johnson (http://ts.rsscse.org.uk/gtb/contents.html ) (Selección de la revista Teaching Statistics). Editado por William J. Sutherland: “Ecological Census Techniques”. Con bolas.... ¿Cuantos garbanzos hay en 1 kg? • Contarlos • Pesar 100 y hacer la proporción • Pesca i repesca ¿Cuántos taxis hay en Barcelona? http://www.taxibarcelona.cat/tabid/308/Default.aspx Sin repesca.... ¡Los taxis están numerados correlativamente! Sólo con la intuición... Estás esperando un taxi bajo la lluvia. Ves como pasan 7 taxis ocupados con los siguientes números: 16 28 45 48 68 72 81 Suponiendo que los taxis están numerados de 1 a N, y que todos están en servicio. ¿Cómo usar la muestra anterior para estimar N, el número total de taxis en la ciudad? Tamaño de la población: N Media: N 2X − 1 = X Mediana: Ejemplo: 1, 2, 3, 4, 5, 6, 7, 8, 9, 10 Media = Mediana = 5,5 En nuestra muestra: 16 Mediana: 48 28 45 48 Estimaciones: 68 72 81 Nˆ 1 : 2 X − 1 = 2 ⋅ 51,14 − 1 ≅ 101 Media: 51,14 ¿Inconveniente de este método? Puede dar una estimación evidentemente falsa... Ejemplo: 3, 4, 6, 15 Media: 7 Mediana: 5 N̂ 1 : 2 X − 1 = 2 ⋅ 7 − 1 = 13 Solucionando el inconveniente Supongamos que los valores son: 8, 14, 22, 27, 35 ? 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 "calcular el promig de les distanciesventre observacions i afegir aquets promig a la última observació." 1 2 3 4 7 5 6 7 8 + 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 5 + 7 + 4 + 7 5 ¡Este es un estimador excelente! (UMVUE) = 6 El promedio de les diferencias es: X ( 1) : Primer valor, ordenados de menor a mayor X ( n ) : Último valor, ordenados de menor a mayor Por tanto: N̂ = X ( n ) + X( n ) n −1 Comprobemos que funciona 20 números al azar. ¿Cuántas papeletas? El mayor valor : Mejor estimación: 1101 + 1101 −1= 1155 20 Caso práctico 10.467 + 10.467 − 1= 10.989 20 Otras situaciones similares “Digital Dice” de P.L. Nahin. Capítulo 12 se titula: “How many runners in a Marathon” y trata este tema." Roger W. Johnson: «Estimating the Size of a Population». Teaching Statistics Iceberg y estadística • Calidad y costos Costos de la calidad Costos de la no calidad Costos totales de la calidad • El tratamiento de los costes en los proyectos Seis Sigma Hay mucho más de lo que se ve Porcentajes Sondeos electorales Medias Control de Calidad: ¿Qué podemos hacer para mejorar? Previsiones: ¿Cuánta electricidad se gastará mañana? Estudios sociològicos: ¿Qué quieren los jovenes? Investigación médica: ¿Es mejor una nueva medicina? Estudios de mercado: ¿Qué quieren los consumidores? Economía: ¿Cuánto aumentan los precios? Biologia: Animales en extinción Fiabilidad: Cada cuando se deben revisar las piezas de un avión? Epidemiología A finales de 1831 llega a Inglaterra una ola de cólera asiático. Los brotes de cólera ocurrieron 4 veces entre 1831 y 1854, y nada logró contener su propagación. En 1853 hubo brotes en ciudades industrializadas. Un total de 10.500 personas murieron de cólera. John Snow (1813-1858) obstetra, anestesiólogo y padre de la epidemiología moderna. El cólera es una enfermedad aguda, diarreica, provocada por por la bacteria Vibrio cholerae. Cólera Contagionistas Sostenían que el cólera se adquiría por el contacto con el enfermo o con sus vestidos y pertenencias. Teoría “miasmática” Postulaba que ciertas condiciones atmosféricas, en especial los vientos, transmitían de un lugar a otro las “miasmas” En 1849 John Snow postuló una innovadora hipótesis: el cólera se transmite mediante la ingestión de una “materia mórbida”. En 1854 estalla una epidemia en Londres. En el Soho, a finales de agosto en un pequeño sector llamado Golden Square , se produce el brote de cólera más violento. En tres días, 127 personas murieron. Hasta alcanzar los 500 el 19 de septiembre. La mortalidad hubiese sido mucho mayor si la población no hubiera huido. Snow solicitó una lista a la oficina del registro general para analizar las muertes por cólera para la semana que finalizó el 2 de Septiembre de 1854. Entrevistó a las familias de las víctimas, sobre el origen del agua de consumo y luego representó los casos que ocurrieron y la ubicación de las bombas de agua en un mapa . Su investigación lo llevó a una bomba de agua en la esquina de Broad Street y Cambridge Street como el epicentro de la epidemia. Muchas muertes habían tenido lugar a corta distancia de la bomba de la cual habitualmente consumían agua. Snow se dio cuenta que la mayoría de los casos habían ocurrido en un radio de 250 yardas de la bomba de agua de Broad Street. Mapa original del Dr. John Snow. Los puntos muestran los casos de cólera durante la epidemia ocurrida en Londres en 1854. Las cruces representan los pozos de agua de los que bebieron los enfermos. Solo se presentaron 10 muertes en casas situadas mas cerca de otras bombas de agua. “As soon as I became acquainted with the situation and extent of this irruption of cholera, I suspected some contamination of the water of the much-frequented streetpump in Broad Street, near the end of Cambridge Street…” “There were only ten deaths in houses situated decidedly nearer to another streetpump. In five of these cases the families of the deceased persons informed me that they always sent to the pump in Broad Street, as they preferred the water to that of the pumps which were nearer.” “In three other cases, the deceased were children who went to school near the pump in Broad Street...” “I had an interview with the Board of Guardians of St James's parish, on the evening of the 7th inst [Sept 7], and represented the above circumstances to them. In consequence of what I said, the handle of the pump was removed on the following day.” http://matrix.msu.edu/~johnsnow/index.php http://www.ph.ucla.edu/epi/snow/snowpub.html El pozo de Broad Street tenía 100 años de antigüedad. En 1850 el agua potable llegaba por tubería a todas las casas del área. El aporte era intermitente (2 horas diarias) y el agua debía acumularse en cisternas. El agua tenía mal sabor, y la población no tomaba agua de las cisternas. En cambio, el agua de la bomba de Broad Street era clara y de buen sabor. ¿Cómo se contaminó la fuente? Un caso fatal en un infante que residía en la casa más cercana a la bomba precedió a la epidemia. El párroco Henry Whitehead, asistente de Snow en la investigación, descubrió que los desechos fecales del bebé eran eliminados en una fosa séptica localizada a menos de 3 pies de la bomba. Una inspección reveló evidencia incontrovertible de transmisión de materia fecal de la fosa séptica hacia el pozo. Fue reparada y puesta en servicio de nuevo unos meses después. Hasta noviembre de 1866: una nueva epidemia determinó su cierre en forma definitiva... Experimentos realizados por Louis Pasteur demostraron que son microorganismos presentes en el ambiente y no miasmas los que producen enfermedades como el cólera. Tres décadas después de la muerte de Snow, Robert Koch aisló y cultivó Vibrio cholerae, “la materia mórbida”. Un principio epidemiológico que se ilustra en la investigación del Snow es que a pesar de que se desconocía el agente causal , la epidemia podía haberse prevenido al eliminar el vehículo de transmisión, esto es evitando el acceso al agua contaminada. Erradicación de la Viruela Intoxicación por metilmercurio Fiebre reumática y cardiopatía reumática. Enfermedades por deficiencia de yodo Tabaco, asbesto y cáncer de pulmón Fractura de cadera y falta de estrógenos «La epidemiología es algo más que el total de los hechos establecidos. Incluye el ordenamiento metódico de estos en cadenas de evidencia que se extienden mas allá de los limites de observación directa.» John Snow, 1854 Problema de estimación: ¿Por qué una encuesta de 1500 personas permite predecir bastante bien el resultado de una elección con 10 millones de votantes? ¿Cómo se consigue? ¿Cómo se mide la precisión del resultado? Problema de test de hipótesis: Las normas de calidad exigen que, en un lote de 5000 bombillas, a lo sumo el 3% pueden durar menos de 1000 horas. En un estudio de control de calidad de una fabrica de bombillas sería muy costoso examinar cada una. Se decide usar una muestra de 500 bombillas. Si obtenemos el 3,2% de bombillas defectuosas, ¿deberíamos declarar el lote completo defectuoso? 35 Problema de estimación: Se busca precisar una característica totalmente desconocida de la población a partir de los datos obtenidos sobre una muestra. Estimar el porcentaje de la población (20 millones) que votará al político gilipollas de turno a partir de una muestra de 1500 votantes. O estimar la duración promedio de las bombillas del lote de 5000, a partir de una muestra de 500. 36 Problema de test de hipótesis: Se busca comprobar alguna información sobre la población a partir de los datos obtenidos de una muestra. François Hollande obtendrá más del 65% de los votos. Menos del 3% de las bombillas del lote de 5000 duran menos de 1000 horas. Las bombillas duran más de 1000 horas en promedio. 37 Muestra aleatoria simple con reemplazo Supongamos una población de tamaño N donde cierta característica se distribuye como la variable aleatoria X. Una muestra aleatoria simple con reemplazo de n observaciones de la variable aleatoria X es un conjunto de variables aleatorias X1, X2, ..., Xn independientes e idénticamente distribuidas (iid). Cada una de ellas tiene la misma distribución de 38 probabilidad que la variable aleatoria X. Observa que las probabilidades de escoger cualquier elemento de la población para formar parte de la muestra son iguales (1/N) y que además las extracciones son independientes. Se puede escoger por azar varias veces al mismo elemento. Pero si la población N es muy superior al tamaño n de la muestra esa probabilidad es despreciable. En ese caso una muestra con reposición es equivalente a una muestra sin reposición. 39 Trabajaremos siempre con reposición. Ejemplo: Sea una población compuesta por 5 unicornios con las siguientes longitudes de cuerno: 6, 8, 10, 12 y 14. Escribamos todas las muestras aleatorias con reemplazo posibles de tamaño 2. En total serán: 52 = 25. Segundo elemento de la muestra Primer elemento de la muestra 6 8 10 12 14 6 6,6 6,8 6,10 6,12 6,14 8 10 8,6 8,8 8,10 8,12 8,14 10,6 10,8 10,10 10,12 10,14 12 12,6 12, 8 12,10 12,12 12,14 14 14,6 14,8 14,10 14,12 14,14 40 En el ejemplo la variable aleatoria X de la población puede tomar los valores 6, 8, 10, 12 y 14, cada uno con probabilidad 1/5. Es decir la variable aleatoria X tiene una densidad de probabilidad discreta uniforme. Una muestra consta de n = 2 observaciones de esa variable aleatoria X. Podemos interpretarla como una variable aleatoria bidimensional (X1, X2), donde X1 y X2 son independientes y están idénticamente distribuidas (iid). De hecho, cada una de ellas tiene la misma distribución de probabilidad que la variable aleatoria X. 41 Estadísticos Cualquier función de las variables aleatorias observadas se denomina estadístico: T ( X 1 , X 2 ,..., X n ) Los dos estadísticos mas conocidos son la media muestral y la varianza muestral. x s 2 La raíz cuadrada de la varianza muestral es la desviación estándar muestral. s 42 Los parámetros poblacionales son fijos, no aleatorios. Por ejemplo, la media de la población anterior es: µ = (6 + 8 + 10 + 12 + 14) / 5 = 10. Mientras que los estadísticos son variables aleatorias (su valor depende de la muestra seleccionada: los estadísticos calculados para distintas muestras darán, en general, resultados distintos). Por ejemplo, la media de la muestra (6, 6) es: x = (6 + 6) / 2 = 6. Y la media de la muestra (6, 12) es: x = (6 + 12) / 2 = 9. Etc... 43 Como estos estadísticos son variables aleatorias, podemos entonces hablar de sus distribuciones. Si tomamos una muestra de tamaño n y calculamos la media de esta muestra obtenemos un valor x determinado. Si repetimos este mismo experimento un gran número de veces obtendremos una gran cantidad de valores distintos para x . A partir de esta “variedad” de valores distintos obtenidos para la media muestral, podemos obtener la distribución de probabilidad de la misma: la distribución de la media muestral. 44 Calculemos para el ejemplo anterior todas las medias muestrales posibles de tamaño n=2: donde i = 1, ..., 25 es ahora el índice de las posibles muestras. Medias muestrales Primer elemento de la muestra Segundo elemento de la muestra 6 8 10 12 14 6 6 7 8 9 10 8 10 7 8 9 10 11 8 9 10 11 12 12 9 10 11 12 13 14 10 11 12 13 14 xi 45 La distribución de medias muestrales es: P 5/25 4/25 4/25 3/25 3/25 2/25 2/25 1/25 6 1/25 7 8 9 10 11 12 13 14 x 46 Como x es una variable aleatoria y ya conocemos su distribución, podemos calcular su esperanza, la media de medias muestrales: 25 1 250 E(x) = xi = = 10 ∑ 25 i =1 25 Y observa que coincide con la media poblacional: 6 + 8 + 10 + 12 + 14 = 10 E(x) = µ = 5 ¿Ocurre siempre? 47 Dada una muestra de tamaño n, el valor xi (i=1,...,n) será uno de los posibles valores que puede tomar la variable aleatoria Xi. ¿Cuál es su valor esperado? Como Xi se distribuye como X: E( X i ) = E( X ) = µ La distribución de la media muestral será: 1 n 1 n 1 n E(x) = E( ∑ X i ) = ∑ E( X i ) = ∑ µ = µ n i =1 n i =1 n i =1 De modo que: E (x ) = µ Cuando se cumple la igualdad, se dice que el estimador x de µ es insesgado. 48 Calculemos ahora para el ejemplo de los unicornios todas las varianzas muestrales posibles: 2 1 2 2 si = ∑ ( x j − xi ) 2 j =1 Varianzas muestrales Primer elemento de la muestra donde i = 1, ..., 25 es el índice de las posibles muestras. Segundo elemento de la muestra 2 i s 6 8 10 12 14 6 0 1 4 9 16 8 10 1 0 1 4 9 4 1 0 1 4 12 9 4 1 0 1 14 16 9 4 1 0 49 Hemos obtenido de nuevo una distribución, ahora la distribución de varianzas muestrales: P 8/25 5/25 6/25 4/25 2/25 0 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 s2 50 Como s2 es una variable aleatoria y ya conocemos su distribución, podemos calcular su esperanza, la media de las varianzas muestrales: 25 1 2 2 E (s ) = si =100 / 25 = 4 ∑ 25 i =1 La varianza poblacional es: Observa que ahora: E ( s ) ≠ σ 2 2 Decimos entonces que el estimador s2 de σ2 es sesgado. 51 Definamos el estimador cuasivarianza o seudovarianza muestral: n Solo se distingue 1 2 2 s* = (x j − x) de la varianza muestral n − 1 j =1 en dividir entre (n-1) en vez de n. Cuasivarianzas Segundo elemento de la muestra ∑ muestrales Primer elemento de la muestra 2 * 6 8 10 12 14 6 0 2 8 18 32 8 10 2 0 2 8 18 8 2 0 2 8 12 18 8 2 0 2 14 32 18 8 2 0 s 52 Tendremos ahora que: 25 1 2 2 E ( s* ) = s*i =200 / 25 = 8 ∑ 25 i =1 De modo que la cuasivarianza muestral es un estimador insesgado para la varianza poblacional: E (s ) = σ 2 * 2 53 Resumiendo: dada una población de tamaño N, tenemos como parámetros de una variable aleatoria X de nuestro interés a la media poblacional y la varianza poblacional. 1 1 N µ = E ( X ) = ( x1 + x2 + ... + xN ) = ∑ xi N N i =1 Sea una muestra con reposición de tamaño n de la población: La media muestral: será un estimador insesgado de la media poblacional. La varianza muestral: n 1 s 2 = ∑ ( x j − x )2 n j =1 será un estimador sesgado de la varianza poblacional. Y la cuasivarianza muestral: 54 será un estimador insesgado de la varianza poblacional. Muestreo desde una población normal Sea X una variable aleatoria que se distribuye en una población como una normal con media µ y varianza σ2, es decir N(µ, σ). Tomemos una muestra aleatoria de tamaño n de esta población normal. ¿Cuál será la varianza muestral de la distribución muestral de x ? Primero observemos que: Var ( X i ) = Var ( X ) = σ 2 De modo que la varianza de la distribución de la media muestral será: 1 n 2 σ2 1 n 1 n Var ( x ) = Var ∑ xi = 2 ∑Var ( xi ) = 2 ∑ σ = n i =1 n n i =1 n i =1 Var (aX + b) = a 2Var ( X ) Y además suponemos independencia entre las variables Xi 55 Si la muestra aleatoria x1, x2, ..., xn se toma a partir de una población normal con media µ y varianza σ2, la media muestral tendrá distribución normal con media µ y varianza σ2/n, N(µ, σ/√n). Vemos entonces que la distribución de la media muestral tiene una dispersión menor alrededor de la media poblacional y cuanto más grande es la muestra, menor es la varianza. Nota: La desviación típica de la distribución muestral suele ser denominada: error típico de tal estadístico (v.g., “error típico de la media”, etc.) Veamos varios ejemplos en los que iremos variando el tamaño n de las muestras. 56 Distribución muestral de la media. Ejemplo 1 Distribución poblacional subyacente (dist. Normal): 400 La línea (en este y sucesivos ejemplos) es una curva normal Media = 100 Varianza = 225 300 Desv. típica = 15 200 100 Desv. típ. = 4.75 Media = 99.9 Distribución muestral de la media: Tamaño muestral =10 N = 3600.00 0 0 6. 11 .0 4 11 .0 2 11 .0 0 11 .0 8 10 .0 6 10 .0 4 10 .0 2 10 .0 0 10 .0 98 .0 96 .0 94 .0 92 .0 90 .0 88 .0 86 .0 84 .0 82 N10 En este y sucesivos gráficos: Número de muestras de tamaño n, extraídas de la distribución poblacional Media = 100 Varianza = 225/10 =22.5 Desv.típica = 22.5 = 57 4.74 Distribución muestral de la media. Ejemplo 2 Distribución poblacional subyacente (dist. Normal): 500 Media = 100 Varianza = 225 400 Desv. Típica = 15 300 200 Distribución muestral de la media: 100 Desv. típ. = 3.36 Tamaño muestral = 20 Media = 100.0 N = 3600.00 0 0 4. 11 0 2. 11 0 0. 11 0 8. 10 0 6. 10 0 4. 10 0 2. 10 0 0. 10 .0 98 .0 96 .0 94 .0 92 .0 90 .0 88 N20 Media = 100 Varianza = 225/20 = 11.3 Desv. típica = 3.35 58 Distribución muestral de la media. Ejemplo 3 Distribución poblacional subyacente (dist. Normal): 700 Media = 100 600 Varianza = 225 500 Desv. Típica = 15 400 300 Distribución muestral de la media: 200 Desv. típ. = 2.12 100 Media = 99.95 N = 3600.00 0 25 9. 10 25 7. 10 25 5. 10 25 3. 10 25 1. 10 5 .2 99 5 .2 97 5 .2 95 5 .2 93 N50 Tamaño muestral = 50 Media = 100 Varianza = 225/50 = 4.5 Desv. típica = 2.12 59 Distribución muestral de la media Supongamos ahora que la distribución poblacional subyacente es arbitraria, pero que seguimos conociendo la media poblacional µ y la varianza poblacional σ 2 . En este caso, también la media de la distribución muestral de medias es µ 2 /n σ Y la varianza de la distribución muestral de medias es La forma de la distribución muestral de la media también tiende a ser normal. En concreto, la distribución de la media muestral se acercará más y más a la distribución normal (con media µ y varianza σ2/n) a medida que aumenta el tamaño n de cada muestra. 60 Veamos aparecer la distribución normal a partir de una población uniforme • Aunque una variable aleatoria no posea distribución normal, ciertos estadísticos/estimadores calculados sobre muestras elegidas al azar sí que poseen una distribución normal. • Es decir, tengan las distribución que tengan nuestros datos, los ‘objetos’ que resumen la información de una muestra, posiblemente tengan distribución normal. • Como ilustración mostramos una variable aleatoria poblacional que presenta valores distribuidos más o menos uniformemente sobre el intervalo 150-190. Como es de esperar la media es cercana a 170. El histograma no se parece en nada a una distribución normal con la misma media y desviación típica (curva en negro). 61 • A continuación elegimos aleatoriamente muestras de n = 10 observaciones de la población y calculamos el promedio. • Para cada muestra de n = 10 obtenemos entonces una nueva medida, la media muestral. • Observa que las nuevas cantidades están más o menos cerca de la media de la variable original que era 170. • Repitamos el proceso un número elevado de veces y pintemos la distribución de la nueva variable aleatoria «media muestral», como hicimos en anteriores ejemplos. Muestra 1ª 2ª 3ª 185 190 179 174 169 163 167 170 167 160 159 152 172 179 178 183 175 183 188 159 155 178 152 165 152 185 185 175 152 152 173 169 168 … 62 • La distribución de las medias muestrales es aproximadamente normal. • La media de esta nueva variable (promedio o esperanza muestral) es muy parecida a la de la variable original. • Las observaciones de la nueva variable están menos dispersas. Además la desviación típica es aproximadamente ‘raíz de 10’ veces más pequeña. Llamamos error estándar a la desviación típica de esta nueva variable. 63 Distribuciones para muestras grandes y teorema central del límite Cuando el tamaño de la muestra es grande, independientemente de que la variable aleatoria de nuestro interés en la población se distribuya o no como una normal, podemos derivar un número de propiedades gracias al TEOREMA CENTRAL DEL LIMITE. Dada una v.a. cualquiera, si extraemos muestras de tamaño n, y calculamos los promedios muestrales, entonces: Dichos promedios tienen distribución aproximadamente normal. La media de los promedios muestrales es la misma que la de la variable original. La desviación típica de los promedios disminuye en un factor “raíz de n” (error estándar). Las aproximaciones anteriores se hacen exactas cuando n tiende a infinito. Este teorema justifica la importancia de la distribución normal. Sea lo que sea lo que midamos, cuando se promedie sobre una muestra 64 grande (n > 30) nos va a aparecer de manera natural la distribución normal. Teorema central del límite Sea x1, x2, ..., xn una muestra aleatoria de observaciones tomadas de la misma distribución y sea E(Xi) = µ y Var(Xi) = σ2. Entonces la distribución muestral de la variable (x − µ) aleatoria: Zn = σ/ n converge a la normal standard N(0, 1) cuando n tiende a infinito. El TCL se cumple aún cuando la distribución desde la que se toman las observaciones no sea normal. Esto significa que si nosotros nos aseguramos que el tamaño de la muestra es grande, entonces podemos usar la variable Zn para responder preguntas acerca de la población de la cual provienen las observaciones. 65 Distribución muestral de la media. Ejemplo 4 q p p −1 − qx f ( x) = x e , x≥0 Γ( p ) Distribución poblacional subyacente (dist. Gamma): Media = 100 Varianza = 100 E[ X ] = p q p Var[ X ] = 2 q 0.045 0.04 0.035 0.03 0.025 0.02 0.015 0.01 0.005 0 80 85 90 95 100 105 110 115 120 66 Distribución muestral de la media. Ejemplo 4 Distribución poblacional subyacente (dist. GAMMA): 500 Media = 100 Varianza = 100 400 300 200 Distribución muestral de la media: 100 Desv. típ. = 3.12 Tamaño muestral = 10 Media = 100.0 N = 3600.00 0 0 0. 11 0 8. 10 0 6. 10 0 4. 10 0 2. 10 0 0. 10 .0 98 .0 96 .0 94 .0 92 .0 90 DISGAMMA Media = 100 Varianza = 100/10 = 10 Desv. típica = 10 = 3.16 67 Distribución muestral de la media. Ejemplo 5 Distribución poblacional (dist. EXPONENCIAL): Media = 0.1 = 1/λ Varianza = 0.01 = 1/λ2 12 10 8 6 4 2 0 0 0.1 0.2 0.3 0.4 0.5 0.6 68 Distribución muestral de la media. Ejemplo 5a Distribución poblacional (dist. EXPONENCIAL): 400 Media = 0.1=1/λ Varianza = 0.01 = 1/λ2 300 200 100 Desv. típ. = .03 Distribución muestral de la media: Media = .100 N = 3600.00 0 44 .2 31 .2 19 .2 06 .2 94 .1 81 .1 69 .1 56 .1 44 .1 31 .1 19 .1 06 .1 94 .0 81 .0 69 .0 56 .0 44 .0 31 .0 EXPON10 Observad que la dist. muestral se aproxima a la normal Tamaño muestral = 10 Media = 0.1 Varianza = 0.01/10 = 0.001 Desv. típica = 0.03 69 Distribución muestral de la media. Ejemplo 5b 500 Distribución poblacional (dist. EXPONENCIAL): 400 Media = 0.1 = 1/λ Varianza = 0.01 = 1/λ2 300 200 100 Desv. típ. = .02 Media = .099 N = 3600.00 0 94 .1 81 .1 69 .1 56 .1 44 .1 31 .1 19 .1 06 .1 94 .0 81 .0 69 .0 56 .0 44 .0 EXPON20 Observad que la distribución muestral se aproxima más a la normal (al elevar el tamaño muestral). Distribución muestral de la media: Tamaño muestral = 20 Media = 0.1 Varianza = 0.01/20 = 0.0005 Desv. típica = 0.022 70 Algunas distribuciones usadas en inferencia Distribución Ji-Cuadrado o Chi-cuadrado o χ2 de Pearson con “n” grados de libertad. Sean X1 , X2 , ... ,Xn n variables aleatorias continuas independientes tal que Xi = N (0,1) con i = 1, ..., n (i.i.d.). Definamos la variable aleatoria: n Y = ∑ Xi ≡ χ 2 i =1 Su densidad de probabilidad será: 2 n fY ( y ) = y n y −1 − 2 2 e n 2 Γ 2 n 2 , x≥0 71 La función gamma es: ∞ α −y ( ) Γ α + 1 = ∫ y e dy 0 1. E [Y ] = n Var [Y ] = 2n 2. ϕY (t ) = (1 − 2it ) n − 2 fY ( y ) Var [Y ] = 2n E [Y ] = n y 72 TABLA DE χ2 orden percentílico n 0.99 0.975 1 2 3 4 5 grados de libertad 0.025 0.01 p χ 2n valores acumulados de χ2n 73 ( 1 ) n − s Distribución muestral del estadístico 2 σ 2 * Cuando las distribución de la que obtenemos la varianza muestral es normal, el estadístico anterior se distribuye según la distribución chi-cuadrado con n -1 grados de libertad. Es fácil de demostrar 74 Si X se distribuye como N ( µ , σ ) Tipificando n 2 X χ ≡ ∑ i n i =1 2 ⇒ x−x σ se distribuye como N (0,1) ( x − x) ⇒ 2 σ 2 se distribuye como χ1 2 n n 1 2 2 2 2 (x − x ) ⇒ ∑ (x − x ) = (n − 1)s* s* = ∑ n − 1 i =1 i =1 (n − 1) s 2 * σ2 se distribuye como χ n2−1 75 Otra distribución que aparece en inferencia es la t-Student, tn Student era el seudónimo de W.S. Gosset, un pionero estadista que trabajó en la Cervecería Guiness de Dublín. Sea X v.a.c. tal que X ~ N (0,1) Y v.a.c. tal que Y ~ χ2n Con función de densidad de probabilidad: t2 n + 1 Γ 1 + n 2 f T (t ) = n πnΓ 2 E [t ] = 0 − X tn ≡ Y n n +1 2 , t ∈ℜ n Var [t ] = n−2 76 TABLA DE LA DISTRIBUCION DE t (Student) orden percentílico n 1 2 3 4 5 t.55 t.60 t.99 t.995 valores acumulados de tp grados de libertad tp 77 x−µ Distribución muestral de s/ n Cuando la distribución de la que obtenemos las medias muestrales es normal, el estadístico anterior, se distribuye según la distribución t de Student con tn-1 grados de libertad. Cuando la distribución de la que obtenemos las medias muestrales no es normal, el estadístico anterior, se distribuye como una normal tipificada para valores de n > 30. Nota: comparar con el teorema central del límite. 78 La distribución F de Fisher o F-Snedecor es otra distribución que aparece con frecuencia en inferencia: sea X v.a.c. tal que X ~ χ2n Y v.a.c. tal que Y ~ χ2m independientes X Definamos Z = n Y m ≡ F (n, m) n+m n m Γ n −1 n+m − 2 2 f Z ( z) = z ( n + m) 2 , n m Γ Γ 2 2 n/2 n/2 z≥0 79 m E [Z ] = m−2 2m ( n + m − 2) V [Z ] = 2 n( m − 2) ( m − 4) 2 (m,n) 80 Distribución muestral del estimador s /σ s /σ 2 x* 2 y* 2 x 2 y Cuando las distribuciones de la que obtenemos las varianzas muestrales son normales: N (µ x ,σ x ) y N (µ y ,σ y ) y extraemos dos muestras de tamaño n y m respectivamente. El estadístico anterior se distribuye según la distribución F de Fisher con n - 1 grados de libertad en el numerador y m -1 grados de libertad en el denominador, Fn-1, m-1. 81 Estimación Sea θ una característica, un parámetro poblacional cuyo valor se desea conocer a partir de una muestra. Sea θˆ un estadístico ( función de la muestra ) que utilizamos para estimar el valor de θ . Observa que el estadístico: θˆ = T ( X 1 , X 2 ,..., X n ) es una función que depende de la muestra y lo llamaremos estimador. El valor concreto de θˆ es la estimación. Hay dos tipos básicos de estimación: puntual y por intervalo de confianza. 82 -Estimación puntual Provee un solo valor, un valor concreto para la estimación. Un estimador puntual es simplemente un estadístico (media aritmética, varianza, etc.) que se emplea para estimar parámetros (media poblacional, varianza poblacional, etc.). Por ejemplo, cuando obtenemos una media aritmética a partir de una muestra, tal valor puede ser empleado como un estimador para el valor de la media poblacional. Algunos autores comparan los estimadores con los lanzamientos en una diana: el círculo central sería el valor real del parámetro. 83 -Por intervalo Determina dos valores (límites de confianza) entre los que acepta puede estar el valor del estimador. Hablaremos de nivel de confianza 1-α cuando en el intervalo se encuentre el valor del estimador con probabilidad 1-α. – Observa que la probabilidad de error (no contener al parámetro) es α. – En general el tamaño del intervalo disminuye con el tamaño muestral y aumenta con 1-α. – En todo intervalo de confianza hay una noticia buena y otra mala: • La buena: hemos usado una técnica que en % alto de casos acierta. • La mala: no sabemos si ha acertado en nuestro caso. 84 Métodos de estimación puntual Hemos visto que un estimador de la media poblacional es la media muestral y de la varianza poblacional es la cuasivarianza muestral. Pero, ¿cómo determinar un estimador cuando no se trata de la media o la varianza? Por ejemplo, supongamos una población con función densidad: f ( x) = θ 1+θ (1 + x) x ≥ 0, θ > 0 ¿Cómo estimar el parámetro θ? Método de los momentos Método de máxima verosimilitud Método de mínimos cuadrados (Lo veremos más adelante en el tema de regresión) 85 Método de los momentos Si una distribución tiene k parámetros, el procedimiento consiste en calcular los primeros k momentos muestrales de la distribución y usarlos como estimadores de los correspondientes momentos poblacionales. La media poblacional µ es el primer momento de la distribución alrededor del origen. La media muestral x es el promedio aritmético de las observaciones muestrales x1, x2, ..., xn. El método de los momentos toma a la media muestral como una estimación de la media poblacional. De la misma manera, la varianza de una variable aleatoria es σ2 y se denomina segundo momento alrededor de la media. La cuasivarianza muestral s2* se usa como un estimador de la varianza poblacional de la distribución. 86 Recordemos que el momento muestral centrado en el origen de orden r se define como: n 1 mr = ∑ xir n i =1 Para el ejemplo anterior, los momentos de primer orden centrados en el origen de la población y la muestra son respectivamente: θ Igualando: 1 ∫−∞ x (1 + x)1+θ dx = θ − 1 1 1 n = ∑ xi ⇒ n θ − 1 n i =1 1 m1 = ∑ xi n i =1 n ˆ θ = n +1 Luego podemos usar como estimador: ∑ xi +∞ i =1 87 Método de máxima verosimilitud Sea X una variable aleatoria cuya distribución de probabilidad depende del parámetro desconocido θ. Sea la función de densidad de probabilidad de la población f(x, θ). Se toma una muestra aleatoria x1, x2, ..., xn de observaciones independientes y se calcula la densidad conjunta de la muestra: la función de verosimilitud y se expresa como: L(x1,...,xn , θ ) = f(x1, θ ) ⋅ f(x2 , θ ) ⋅ ... ⋅ f(xn , θ ) n L(x1,...,xn , θ ) = ∏ f ( xi , θ ) i =1 88 Si de una población cualquiera hemos obtenido una muestra particular, es razonable pensar que la muestra obtenida era la que mayor probabilidad tenía de ser escogida. L Función máxima verosimilitud θˆ MV θˆ Valor del estimador máxima verosimilitud 89 Si los valores posibles de θ son discretos, el procedimiento es evaluar L(x,θ) para cada valor posible y elegir el valor de θ para el cual L alcanza su máximo. Por otro lado, si L(x,θ) es diferenciable se puede maximizar L sobre el rango de valores posibles de θ obteniéndose condiciones de primer y segundo orden. En la práctica es más fácil maximizar el logaritmo de la función de verosimilitud. Como la función logaritmo es una transformación monótona, maximizar L(x,θ) es equivalente a maximizar Ln(L(x,θ)). 90 Ejemplo: Sea una urna con bolas rojas y blancas en proporciones desconocidas. Extraemos 10 bolas con reemplazo (n = 10) y obtenemos 3R y 7B. Llamemos p a la proporción de R en la urna. L( p ) = p (1 − p ) PR 3 7 10 3, 7 10! = p (1 − p ) 3!7! 3 7 ∂L( p ) 10! 2 6 = p (1 − p ) (3 − 10 p ) =0 ∂p 3!7! Soluciones: p=0 Imposible porque hemos extraído 3R p=1 Imposible porque hemos extraído 7B p = 3/10 Que además hace máxima la función L(p) ∂ 2 L( p ) ∂p 2 <0 91 p =3 / 10 Volvamos al ejemplo: f ( x) = i =1 1+θ (1 + x) θn n L(x1,...,xn , θ ) = ∏ f ( xi , θ ) = θ n ∏ (1 + x ) 1+θ x ≥ 0, θ > 0 Construimos la función verosimilitud i i =1 n Ln L(x1,...,xn , θ ) = nLnθ − (1 + θ )∑ Ln(1 + xi ) i =1 Extraemos logaritmos a ambos lados ∂Ln L(x1,...,xn , θ ) n n Derivamos e igualamos = − ∑ Ln(1 + xi ) = 0 ∂θ θ i =1 a cero para encontrar el máximo de la función n ⇒ θˆ = n Observemos que no Ln(1 + xi ) ∑ i =1 coincide con el estimador que nos propone el método ∂ 2 Ln L(x1,...,xn , θ ) n =− 2 <0 2 de los momentos. ˆ ∂θ θ 92 θ =θˆ 95 96 Propiedades deseables en los estimadores Los dos procedimientos que repasamos hace un momento (más el método de mínimos cuadrados que veremos luego) eligen a la media muestral como estimador del parámetro µ. Sin embargo, otras veces obtenemos estimadores distintos para el mismo parámetro, como ocurre con σ2. O como hemos visto para el caso del parámetro θ del ejemplo. En esos casos, ¿cuál es el mejor estimador? 1. Ausencia de sesgo 2. Consistencia 3. Eficiencia 4. Suficiencia 97 1. Estimador insesgado. Diremos que θ es un estimador insesgado de θ si: [] E θˆ = E [T ( X 1 ,..., X n )] = θ Vimos que la media muestral es un estimador insesgado de la media poblacional. Vimos que la varianza muestral no es un estimador insesgado de la varianza poblacional, es sesgado. b(θ ) = E [θˆ]− θ se llama sesgo de θˆ Recuerda que construimos la cuasivarianza, que sí es un estimador insesgado de la varianza poblacional. 98 Sea una población N(µ, σ) y construyamos los estimadores de varianza: varianza muestral y cuasivarianza muestral. n 1 2 2 ˆ θ1 = s = ∑ ( x j − x ) n j =1 n 1 2 θˆ2 = s*2 = ( ) x x − ∑ j n − 1 j =1 Vimos que si la población es normal, entonces el estimador: (n − 1) s*2 σ2 se distribuye como χ n2−1 E[θˆ2 ] = E[ s*2 ] = σ2 n −1 E[ χ n2−1 ] = σ 2 2 − − σ 1 1 n n 2 2 ˆ ˆ σ =σ − E[θ 2 ] = E[θ1 ] = n n n sesgo 99 Propiedades en muestras grandes Muchos estimadores no tienen buenas propiedades para muestras pequeñas, pero cuando el tamaño muestral aumenta, muchas de las propiedades deseables pueden cumplirse. En esta situación se habla de propiedades asintóticas de los estimadores. Como el estimador va a depender del tamaño de la muestra, vamos a expresarlo utilizando el símbolo θˆn Por ejemplo, el sesgo puede depender del tamaño de la muestra. Si el sesgo tiende a cero cuando el tamaño de la muestra crece hasta infinito, decimos que el estimador es asintóticamente insesgado. 100 Ausencia de sesgo asintótico Definición: Un estimador θˆn se dice que es asintóticamente insesgado si: lim E[ θˆn ] = θ n →∞ o equivalentemente: lim [ E[θˆn ] − θ ] = 0 n →∞ 101 2. Consistencia. Se dice que un estimador es consistente si se cumple que ( ) lim P θˆn − θ > ε = 0 n →∞ o ( ) lim P θˆn − θ ≤ ε = 1 n →∞ E[θˆn ] → θ Var[θˆn ] → 0 Es decir, a medida que se incrementa el tamaño muestral, el estimador se acerca más y más al valor del parámetro. La “consistencia” es una propiedad asintótica. Tanto la media muestral como la cuasivarianza son estimadores consistentes. La varianza muestral también es un estimador consistente de la varianza poblacional, dado que a medida que el tamaño muestral n se incrementa, el sesgo disminuye. 102 Ejemplo: supongamos que la población es no normal y de media desconocida. Construyamos estadísticos media muestral: Para cada tamaño muestral n tenemos: E ( xn ) = µ Var ( xn ) = σ2 n Por el teorema de Chebychev: ( ) 1 P xn − E ( xn ) ≤ k Var ( xn ) ≥ 1 − 2 k σ2 P( xn − µ ≤ ε ) ≥ 1 − 2 ⇒ lim P ( xn − µ ≤ ε ) = 1 n →∞ nε con k = n σ ε La media muestral es un estimador 103 consistente de la media poblacional. 3. Eficiencia. Idea: Utilizar las varianzas de los estimadores insesgados como una forma de elegir entre ellos. La varianza de una variable aleatoria mide la dispersión alrededor de la media. Menor varianza para una variable aleatoria significa que, en promedio, sus valores fluctúan poco alrededor de la media comparados con los valores de otra variable aleatoria con la misma media y mayor varianza. Menor varianza implica mayor precisión y entonces el estimador que tenga menor varianza es claramente más deseable porque, en promedio, está mas cerca del verdadero valor de θ. [] Si E θˆ = θ , decimos que θˆ es un estimador insesgado eficiente o de varianza mínima para θ , si cualquier otro ~ estimador insesgado de θ , digamos θ , verifica que: ~ ˆ Var (θ ) ≤ Var (θ ) 104 Sean θˆ1 y parámetro θ. θˆ2 dos estimadores insesgados del Si Var ( θˆ1) < Var ( θˆ2 ) decimos que eficiente que θˆ2 . θˆ1 es más El cociente Var ( θˆ1) / Var ( θˆ2 ) se llama eficiencia relativa. Entre todos los estimadores insesgados de θ, el que tenga menor varianza es el estimador insesgado de mínima varianza. Pero, ¿cómo podemos encontrarlo? 105 Cota de Cramér-Rao: Sea una población con densidad de probabilidad f(x, θ), entonces se cumple que: Var [θˆ] ≥ − (1 + b' (θ ) ) ∂ 2 ln f ( x, θ ) nE 2 ∂ θ 2 Si un estimador tiene una varianza que coincide con la cota de Cramér-Rao se dice que es un estimador eficiente. Si además en insesgado, se dice que es un estimador de eficiencia absoluta o completa. 106 Ejemplo: Sea una población que se distribuye normalmente con desviación típica conocida y media desconocida. Como estimador utilizaremos la media muestral. Sabemos que la distribución del estimador es también una normal con la misma media µ y varianza σ 2 / n . Luego el estimador es insesgado: b(θ) = 0. Calculemos la cota de Cramér-Rao (CCR). ( x − θ )2 1 1 ( x − θ )2 exp− − f ( x, θ ) = ; Ln f ( x, θ ) = Ln 2 2 σ σ 2 2 σ 2π σ π 2 1 ∂Ln f ( x, θ ) x − θ ∂ 2 Ln f ( x, θ ) = 2 ; =− 2 2 σ σ ∂θ ∂θ ∂ 2 Ln f ( x, θ ) 1 1 = − = − E E 2 2 σ 2 θ σ ∂ σ2 −1 ; Var ( x ) = CCR = CCR = 2 n ∂ ln f ( x, θ ) nE 2 θ ∂ 107 Eficiencia asintótica Cuando trabajamos con estimadores consistentes, el rango de valores de θ para el cual un estimador es más eficiente que otro, disminuye a medida que n crece. En el límite cuando n tiene a infinito la distribución de todos los estimadores consistentes colapsa en el verdadero parámetro θ. Entonces deberíamos preferir aquel estimador que se aproxime más rápidamente (es decir, aquel cuya varianza converge más rápido a cero) 108 En términos intuitivos, un estimador consistente es asintóticamente eficiente, si para muestras grandes su varianza es menor que la de cualquier otro estimador consistente. Definición: un estimador consistente θˆ1 se dice que es asintóticamente eficiente si para cualquier otro estimador θˆ2 el Var (θˆ2 ) lim >1 n → ∞ Var (θ ˆ1 ) ∀θ 109 4. Suficiencia. Diremos que θ es un estimador suficiente del parámetro θ si dicho estimador basta por sí solo para estimar θ. Si el conocimiento pormenorizado de los elementos la muestra no añade ninguna información sobre θ. Ejemplo: Supongamos una población binomial de la que desconocemos la proporción θ = p. Extraemos una muestra de tamaño n = 50. 1 si es éxito xi = 0 si es fracaso 50 T1 ( X ) = ∑ xi = 35; T2 ( X ) = max{ xi } = 1 i =1 Estimador suficiente, p aprox. 35/50. 110 Error cuadrático medio (ECM) Consideremos dos estimadores, uno insesgado y el otro sesgado pero con una varianza bastante menor, de modo que en promedio puede estar más cerca de la verdadera media que el estimador insesgado. En esta situación podríamos admitir algo de sesgo con la intención de obtener una mayor precisión en la estimación (menor varianza del estimador). Una medida que refleja este compromiso (“trade off”) entre ausencia de sesgo y varianza es el ECM. 111 El error cuadrático medio de un estimador se define como ECM (θˆ) = E[( θˆ - θ )2] . Esto es la esperanza de la desviación al cuadrado del estimador con respecto al parámetro de interés. Si θˆ1 , θˆ2 son dos estimadores alternativos de θ y ECM ( θˆ1) < ECM ( θˆ2 ) entonces θˆ1 se dice que es eficiente en el sentido del ECM comparado con θˆ2 . Si los dos son insesgados, entonces θˆ1 es más eficiente. Entre todos los posibles estimadores de θ, aquel que tenga el menor ECM es el llamado estimador de mínimo error cuadrático medio. ECM = Var( θˆ) + sesgo2. es decir que el ECM es igual a la suma de la varianza más el sesgo al cuadrado. 112 ( ) 2 ECM (θˆ) = E[(θˆ − θ ) ] = E θˆ − E (θˆ) + E (θˆ) − θˆ = 2 Constante Variable aleatoria 0 2 2 ˆ ˆ ˆ E[(θ − E (θ ) ) ] + E[(E (θ ) − θ ) ] + 2(θˆ − E (θˆ) )E[ E (θˆ) − θ ] constante 2 ˆ ˆ = Var (θ ) + [b(θ )] θˆ1 θˆ2 E (θˆ2 ) θ = E (θˆ1 ) sesgo θ2 Compromiso entre varianza y sesgo de los estimadores. 113 Ejemplos: Supongamos una población de la que conocemos la media y la varianza (= 100). Tomemos muestras n = 10. Consideremos los dos estimadores de la media siguientes: n n 1 1 θˆ1 = x = ∑ xi ; θˆ2 = xi ∑ n i =1 n + 1 i =1 2 100 σ ˆ ( ) ⇒ ECM θ = = = 10 1 2 n 10 n 1 σ ˆ ˆ Var (θ1 ) = 2 ∑ Var (θ1 ) = n i =1 n n 1 E[θˆ1 ] = ∑ E[ xi ] = µ n i =1 2 2 2 + 1000 µ σ µ n + ˆ ( ) = θ ECM ⇒ = 1 2 2 n ( 1 ) 121 n + 1 σ n Var (θˆ2 ) = Var (θˆ1 ) = 2 ∑ (n + 1) i =1 (n + 1) 2 n 1 n = [ ] µ E[θˆ2 ] = E x ∑ i n +1 n + 1 i =1 Dependiendo de la media de la población nos interesará tomar un estimador 114 u otro. Propiedades de los estimadores de máxima verosimilitud Los estimadores máximo verosímiles son: Asintóticamente insesgados Asintóticamente normales Asintóticamente eficientes Invariantes bajo transformaciones biunívocas Si ∃ estimador suficiente, θˆMV es suficiente 115 116 117 118 119 120 121 122 123 Pregunta: ¿Qué porcentaje de hogares españoles tienen ordenador con conexión a Internet? ¿Definición clara?: ¿Qué es un hogar? ¿Piso de estudiantes? ¿Apartamento en la playa?... ¿Muestra representativa? Resultado: 42,8 % Estimación puntual 42,8 % ¿Si volviéramos a realizar el estudio, volvería a salir 42,8%? ± 3,2 % Margen de error Intervalo de confianza del 95 % Dice la verdad el 95 % de les veces ¡Empate técnico! El País, 18 febrer 2006. Pàgina 18 «Però curiosament, sembla que les persones que redacten els titulars no entenen el significat d’aquests conceptes clau. Per exemple, aquí el titular destaca que el PP redueix la seva distancia al PSOE a 1,6 punts... Però el text diu que l’error és del 2%, i això vol dir que, amb la confiança que ho han calculat, el valor real podria estar 2 punts amunt o 2 punts avall del que ha sortit. Que l’error sigui del 2% vol dir que si ho tornessin a fer, perfectament podria sortir 1 punt el PP per davant del PSOE. El titular correcte seria que no s’han detectat diferències significatives entre el PP i el PSOE». Pere Grima Consumo de cannabis El País, 7 febrer 2003 «El consum de cànnabis ha augmentat en un 0,5% (que queda dins el mar- ge d’error). Realment no podem afirmar que hagi augmentat, potser s’ha mantingut o fins i tot ha disminuït una mica!» Pere Grima ¿Aumenta el consumo? «El artículo periodístico anterior está basado en este estudio. Que dice que el margen de error es de ±2,36%. ¡Y el consumo de éxtasis, heroína, cocaína y tabaco se ha reducido menos de un 1%, según el diario!» Pere Grima Tamaño de la muestra Tamaños de muestra para estimación de proporciones con una confianza del 95 % Tamaño de la población ±1% Márgen de error ±2% ±3% ±4% 500 1.000 1.500 2.000 2.500 476 906 1.298 1.656 1.984 414 706 924 1.092 1.225 341 517 624 696 748 3.000 3.500 4.000 4.500 5.000 2.286 2.566 2.824 3.065 3.289 1.334 1.425 1.501 1.566 1.623 6.000 7.000 8.000 9.000 10.000 3.693 4.049 4.365 4.647 4.899 15.000 20.000 25.000 50.000 100.000 500.000 1.000.000 1.500.000 2.000.000 50.000.000 ±5% ± 10 % 273 376 429 462 485 218 278 306 323 333 81 88 91 92 93 788 818 843 863 880 501 513 522 530 536 341 347 351 354 357 94 94 94 95 95 1.715 1.788 1.847 1.896 1.937 906 926 942 954 965 546 553 559 563 567 362 365 367 369 370 95 95 95 96 96 5.856 6.489 6.939 8.057 8.763 2.070 2.144 2.191 2.291 2.345 997 1.014 1.024 1.045 1.056 578 583 587 594 597 375 377 379 382 383 96 96 96 96 96 9.423 9.513 9.543 9.558 9.602 2.390 2.396 2.398 2.399 2.401 1.065 1.066 1.067 1.067 1.068 600 600 600 601 601 384 384 385 385 385 97 97 97 97 97 p = q = 0,5. Valores redondeados por exceso. «Un dels aspectes més destacats d’aquesta taula és que la grandària de la mostra no augmenta proporcionalment amb la grandària de la població. Fixem-nos per exemple en un marge d’error del 4%: si la població és de 1.000 individus necessitem una mostra de 376, però si multipliquem per 10 la grandària de la població, la de la mostra no es multiplica ni per 2, i si a continuació multipliquem la població per 100, la mostra es queda pràcticament igual. A moltes persones els hi costa entendre això. No entenen perquè es necessita la mateixa grandària de mostra per una població de 500.000 individus que per una de 50 milions». Pere Grima Tamaño de la muestra Cuchara para catar la sopa a diario Olla para la sopa a diario Cuchara para catar la sopa con invitados Olla para la sopa con invitados Asegurar la representatividad Estimación por intervalos de confianza. En este caso, en lugar de indicar simplemente un único valor como estimación del parámetro poblacional θ, lo que haremos es ofrecer un intervalo de valores en el que se tiene cierta probabilidad (confianza) de que se encuentre el verdadero valor de θ. θˆ − ε < θ < θˆ + ε Intervalo de confianza: Es el intervalo de las estimaciones (probables) sobre el parámetro. Límites de los intervalos de confianza: Son los dos valores extremos del intervalo de confianza. Amplitud del intervalo o margen de error... 131 Ahora bien, ¿cuán grande debe de ser el intervalo de confianza? Evidentemente, si decimos que el intervalo de confianza va de menos infinito a más infinito, seguro que acertamos...Pero eso no es muy útil. El caso extremo contrario es la estimación puntual, donde la amplitud del intervalo es nula. La idea es crear unos intervalos de confianza de manera que sepamos en qué porcentaje de casos el valor del parámetro poblacional estará dentro del intervalo crítico. Es decir, dar una medida de bondad de la estimación, la probabilidad de que el valor real θ se encuentre dentro del intervalo. Coeficiente P (θˆ − ε < θ < θˆ + ε ) = 1 − α o grado de confianza Nivel de significación (N. S.) 132 ¿Y cómo fijamos tal probabilidad? Usualmente se asume un porcentaje del 95%. Al calcular un intervalo de confianza al 95%, ello quiere decir que el 95% de las veces que repitamos el proceso de muestreo (y calculemos el estadístico), el valor del parámetro poblacional estará dentro de tal intervalo. A ese usual nivel de significación se le denomina confianza casi significativa. Otros casos usuales son: confianza significativa: 99%. confianza muy significativa: 99.5% 133 134 Intervalos de confianza para la media: Supongamos que la población sigue una distribución normal, con cierta media µ y cierta desviación típica σ. Utilizaremos como estimador puntual para la media poblacional la media muestral x . Sabemos que: (1). La media de la distribución muestral de medias es la media poblacional µ. (2). La varianza de la distribución muestral de medias es σ2/n. O lo que es lo mismo, la desviación típica de la distribución muestral de medias es σ /√n. Veremos dos casos para calcular intervalos de confianza: (1) Conocemos la desviación típica σ y (2) no la conocemos. 135 (1) La población es normal y conocemos σ : 1 n x = ∑ xi n i =1 ( x ≡ N µ ,σ / n ) Sabemos cómo se distribuye la variable aleatoria muestral y a partir de esa distribución podemos determinar el intervalo de confianza. Tipificamos la variable: x−µ z= ≡ N (0,1) σ/ n Supongamos que deseamos tener un nivel de significación α. 136 N (0,1) α/2 α/2 1-α -zα/2 0 zα/2 x−µ < zα / 2 = 1 − α P − zα / 2 < σ/ n σ σ P x − zα / 2 < µ < x + zα / 2 = 1 − α n n 137 Así, una estimación puntual de la media poblacional µ se obtendría de una muestra de n elementos haciendo la media muestral. Mientras que un intervalo de confianza con nivel de significación α sería: x− σ n zα / 2 < µ < x + σ n zα / 2 Nota: Observa que podemos determinar el tamaño necesario de una muestra para obtener una amplitud del intervalo de confianza determinada. σ n = zα / 2 ε 2 Semiamplitud del 138 intervalo Ejemplo: n = 100 x = 20 σ = 5 Confianza = 0.95 ⇒ α = 0.05 Buscamos en las tablas N(0,1) los valores de z que dejan 0.05 / 2 = 0.025 de probabilidad por abajo y 0.05 / 2 = 0.025 de probabilidad por arriba: − z0.025 = −1.96 y z0.025 = +1.96 x− x+ σ n σ n zα / 2 zα / 2 5 = 20 − 1.96 = 19.02 100 5 = 20 + 1.96 = 20.98 100 ⇒ µ ∈ (19.02; 20.98) 139 Observemos cómo a medida que el tamaño muestral aumenta, la amplitud del intervalo disminuye. (Evidentemente, esto es general, no sólo para la media.) Veamos, un ejemplo. Supongamos que deseamos 1 - α = 0.95: Caso 1. Media muestral =10, varianza poblacional = 4, tamaño muestral =12. 2 2 P 10 + (−1.96) ⋅ < µ < 10 + 1.96 ⋅ = = ) 0.95 P ( 8.87 < µ < 11.13 12 12 Caso 2. Media muestral =10, varianza poblacional = 4, tamaño muestral = 20. 2 2 < µ < 10 + 1.96 ⋅ = = P 10 + (−1.96) ⋅ ) 0.95 P ( 9.12 < µ < 10.88 20 20 140 Supongamos ahora que deseamos que 1 - α = 0.99. En tal caso, tendremos más seguridad de que el parámetro de interés se halle en los límites del intervalo. El problema es que incrementar la confianza aumenta la amplitud del intervalo. Caso 1. Media muestral = 10, varianza poblacional = 4, tamaño muestral = 12. Intervalo al 95% 2 2 P 10 + (−1.96) ⋅ < µ < 10 + 1.96 ⋅ = = ) 0.95 P ( 8.87 < µ < 11.13 12 12 Caso 2. Media muestral = 10, varianza poblacional =4, tamaño muestral = 12. Intervalo al 99% 2 2 P 10 + (−2.57) ⋅ < µ < 10 + 2.57 ⋅ = = ) 0.99 P ( 8.52 < µ < 11.48 12 12 141 (2) Población normal y desconocemos σ : Por el tema anterior sabemos que la distribución muestral del estadístico: x−µ s/ n no es una distribución normal, sino una distribución t de Student con n -1 grados de libertad. x−µ P − tα / 2 < < tα / 2 = 1 − α s/ n s s P x − tα / 2 < µ < x + tα / 2 = 1 − α n n 142 En definitiva, para la media (cuando conocemos la varianza poblacional), tenemos : x− σ n zα / 2 < µ < x + σ n zα / 2 Pero si no conocemos la varianza poblacional (el caso realista), tenemos como intervalo: s s x− tα / 2 < µ < x + tα / 2 n n 143 Distribución de la población desconocida y n > 30 Si n es grande (n > 30), la distribución del estadístico x−µ s/ n será prácticamente una distribución normal N(0,1). Y el intervalo de confianza será: x− σ n zα / 2 < µ < x + σ n zα / 2 Nota: Observa, en particular, que para n > 30 la distribución t de Student es prácticamente una normal. 144 Intervalo de confianza para las varianzas: Población ≅ N ( µ , σ ) n 1 2 2 Estimador : s* = ( xi − x ) ∑ n − 1 i =1 (n − 1) s Vimos que σ 2 * 2 ≡χ 2 n −1 Intervalo de confianza: (n − 1) s χ 2 * 2 n −1;α / 2 ≤σ ≤ 2 (n − 1) s χ 2 * 2 n −1;1−α / 2 145 Ejemplo: χ2 30 ; 0.975 n = 31 ↓ n -1 = 30 s* = 4 α = 0.05 = 47.0 ; χ 302 ; 0.025 = 16.8 de las tablas de χ 2 2 × 30 × 4 2 30 4 ≤σ 2 ≤ ⇒ 10.21 ≤ σ 2 ≤ 28.57 47.0 16.8 Si se desea estimar σ = √σ2 ⇒ 3.20 ≤ σ ≤ 5.35 146 Resumen: Procedimiento para determinar el intervalo de confianza 1. Fijar el nivel de significación ⇒ α 2. Conociendo la distribución f (θˆ) en el muestreo de θˆ una estimación puntual, hallar los percentiles x α/2 y x f (x ) y poseyendo 1- α/2 de f (θˆ) 0.4 α /2 α /2 θˆ LCi d 0.2 θ =αb/ 2 α /2 d LCs Si f (θˆ) es simétrica el intervalo de confianza es simétrico en x y en probabilidad. 0.0 0.0 θˆ 1.5 3.0 4.5 Si f (θˆ) es asimétrica el intervalo de confianza es simétrico en probabilidad solamente. 147 Intervalo 148 149 Si Si ¿Se conoce valor de σ? No ¿Es grande n? n>30 No Si ¿Es aproximadamente normal la población? Si No No ¿Se conoce valor de σ? Usar s de la muestra para estimar σ X ± zα / 2 σ n X ± zα / 2 Usar s de la muestra para estimar σ s n X ± zα / 2 σ n X ± tα / 2 s n Aumentar tamaño de la muestra para determinar un estimado de intervalo 151 152 153 154 155 156 157 158 159 160 161 162 163 Intervalo de confianza para diferencia de medias muestrales 164 165 166 167 Intervalo de confianza para σ12/σ22. 168 169 Intervalo de confianza para la proporción poblacional. 170 171 173 174 175 Aleatoriedad D. J. Bennett (pág. 88): 176 encuestas con respuesta aleatorizada y encuestas sesgadas pag.189-190 margen de error: cap. 11 177 Aleatoriedad D. J. Bennett (pág. 97): 178