Tema 6 Algunos modelos de distribuciones discretas.

Anuncio

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

Tema 6

Algunos modelos de distribuciones discretas.

Una vez expuesta la teorı́a general sobre variables aleatorias y sus distribuciones de probabilidad, vamos a describir algunas distribuciones particulares que han demostrado, empı́ricamente,

ser modelos apropiados para situaciones que ocurren en la vida real. A pesar de ello tales distribuciones presentan un carácter teórico en el sentido de que sus funciones de probabilidad o

de densidad se deducen matemáticamente en base a ciertas hipótesis que se suponen válidas

para los fenómenos aleatorios.

La elección de una distribución de probabilidad para representar un fenómeno de interés

práctico debe estar motivada tanto por la comprensión de la naturaleza del fenómeno en sı́,

como por la posible verificación de la distribución seleccionada a través de la evidencia empı́rica.

En todo momento debe evitarse aceptar de manera tácita una determinada distribución de

probabilidad como modelo de un problema práctico.

Una distribución de probabilidad está caracterizada, de forma general, por una o más cantidades que reciben el nombre de parámetros de la distribución. Un parámetro puede tomar

cualquier valor de un conjunto dado y, en ese sentido, se define una familia de distribuciones

de probabilidad que tendrán la misma función genérica de probabilidad o función de densidad.

En este tema estudiaremos varias distribuciones de tipo discreto de gran utilidad en aplicaciones. En cada caso, se expondrá detalladamente cómo surgen (el modelo probabilı́stico

subyacente) y se deducirán sus momentos, función generatriz de momentos y otras caracterı́sticas de interés

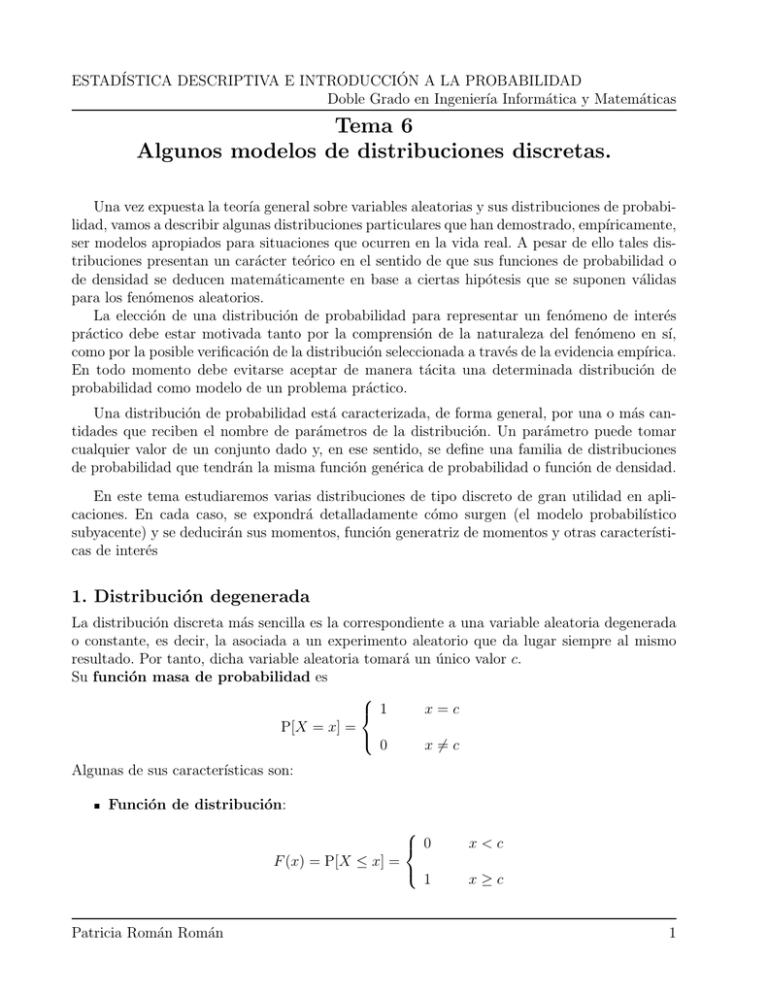

1. Distribución degenerada

La distribución discreta más sencilla es la correspondiente a una variable aleatoria degenerada

o constante, es decir, la asociada a un experimento aleatorio que da lugar siempre al mismo

resultado. Por tanto, dicha variable aleatoria tomará un único valor c.

Su función masa de probabilidad es

x=c

1

P[X = x] =

0

x 6= c

Algunas de sus caracterı́sticas son:

Función de distribución:

F (x) = P[X ≤ x] =

0

x<c

1

x≥c

Patricia Román Román

1

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

Momentos no centrados:

mk = E[X k ] = ck P[X = c] = ck ,

k = 1, 2, · · ·

Y, en particular, la MEDIA

E[X] = c.

Momentos centrados:

µk = E[(X − c)k ] = 0,

k = 1, 2, · · ·

Y, en particular, la VARIANZA

Var[X] = 0.

Esta propiedad caracteriza a las distribuciones degeneradas; es decir, una variable aleatoria tiene varianza cero si y solamente si es degenerada en un punto (Propiedades de la

varianza).

Función generatriz de momentos:

M (t) = E[etX ] = etc

∀t ∈ R.

Notas

Si una variable aleatoria tiene función generatriz de momentos

MX (t) = e5t

∀t ∈ R

entonces, dado que la f.g.m. determina de forma única la distribución de la variable, X tiene

una distribución degenerada en el punto 5, es decir

P[X = 5] = 1

Si una variable aleatoria tiene función generatriz de momentos

MX (t) = 1

∀t ∈ R

entonces, dado que la f.g.m. determina de forma única la distribución de la variable, X tiene

una distribución degenerada en el punto 0, es decir

P[X = 0] = 1

Patricia Román Román

2

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

2. Distribución uniforme discreta

Esta es la distribución de probabilidad de una variable aleatoria discreta que toma un número

finito de valores que son equiprobables y se utiliza para modelizar variables aleatorias asociadas a experimentos aleatorios que tienen un número finito de posibles resultados que son

equiprobables. Su función masa de probabilidad es

1

, i = 1, 2, · · · , n

n

Se dice entonces que la variable aleatoria X se distribuye uniformemente sobre los puntos

x1 , x2 , · · · , xn y se notará X ∼ U (x1 , x2 , . . . , xn ).

P[X = xi ] =

Ejemplo

La variable aleatoria asociada al experimento aleatorio de lanzar un dado al aire (tiene seis

resultados posibles y equiprobables si el dado está bien construido)

1

P [X = i] = , i = 1, 2, · · · , 6

6

Algunas de sus caracterı́sticas son:

Función de distribución:

0

1

i

F (x) = (Número de valores xi ≤ x) =

n

n

1

si x < x1

si xi ≤ x < xi+1 , i = 1, . . . , n − 1

si x ≥ xn

Momentos no centrados:

n

1X k

mk = E[X ] =

x ,

n i=1 i

k

k = 1, 2, · · ·

Y, en particular, la MEDIA

n

1X

E[X] =

xi = x̄.

n i=1

Momentos centrados:

n

1X

µk = E[(X − EX) ] =

(xi − x̄)k ,

n i=1

k

Patricia Román Román

k = 1, 2, · · ·

3

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

Y, en particular, la VARIANZA

n

1X

(xi − x̄)2 .

Var[X] =

n i=1

Función generatriz de momentos:

n

M (t) = E[etX ] =

1 X txi

e

n i=1

∀t ∈ R.

En el caso particular xi = i, i = 1, 2, . . . , n

E[X] =

1

n

E[X 2 ] =

Pn

1

n

Var[X] =

i=1

Pn

i=

i=1

1 n(n+1)

n

2

i2 =

(n+1)(2n+1)

6

=

n+1

2

1 n(n+1)(2n+1)

n

6

−

(n+1)2

4

=

=

(n+1)(2n+1)

6

n2 −1

12

3. Distribución de Bernoulli

Supongamos un experimento aleatorio que da lugar, únicamente, a dos posibles resultados

que son mutuamente excluyentes y exhaustivos. Los dos posibles resultados se denotan como:

- éxito (E), que será el suceso objeto de estudio, y

- fracaso (F ), que es el complementario de E.

Evidentemente

E, F ⊂ Ω,

E ∪ F = Ω,

E ∩ F = ∅.

A este tipo de experimentos aleatorios se les llama experimentos o pruebas de Bernoulli.

Asociado a un experimento o prueba de Bernoulli y a su correspondiente espacio muestral

Ω = {E, F }, se define la variable aleatoria con distribución de Bernoulli como

si ocurre el suceso E

1

X=

0

si no ocurre el suceso E (ocurre F )

Si se denota por p a la probabilidad del suceso éxito (E) y, por tanto, la probabilidad del

suceso fracaso será 1 − p, la función masa de probabilidad de esta variable aleatoria será

P[X = 1] = p

P[X = 0] = 1 − p

o bien,

Patricia Román Román

4

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

P[X = x] = px (1 − p)1−x ,

x = 0, 1; 0 < p < 1

y se notará como X ∼ B(1, p). (Los casos p = 0 y p = 1 dan lugar a variables degeneradas)

Ejemplos

- La variable aleatoria asociada al experimento aleatorio de lanzar una moneda (si la moneda

está bien construida p = 1/2)

- La variable aleatoria asociada a contabilizar ocurrencias, por ejemplo si una persona es

votante de un partido o no, si una pieza manufacturada es defectuosa o no (variables indicadoras).

Algunas de sus caracterı́sticas son:

Función de distribución

F (x) =

0

x<0

1−p

0≤x<1

1

x≥1

Momentos no centrados:

mk = p,

k = 1, 2, · · ·

Y, en particular,

E[X] = p,

E[X 2 ] = p

Momentos centrados:

µk = (1 − p)k p + (−p)k (1 − p),

k = 1, 2, · · ·

Y, en particular,

Var[X] = E[X 2 ] − (E[X])2 = p − p2 = p(1 − p)

Función generatriz de momentos:

M (t) = pet + (1 − p)

Patricia Román Román

∀t ∈ R

5

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

Nota

Si una variable aleatoria tiene función generatriz de momentos

MX (t) = 0,8et + 0,2

∀t ∈ R

entonces, dado que la f.g.m. determina de forma única la distribución de la variable, X tiene

una distribución B(1, 0,8).

Ejemplo.- Un agente de seguros dedicado a la venta de seguros de vida, realiza visitas a posibles

clientes con el fin de contratar un seguro de vida. Se sabe de su trayectoria como agente que

en el 60 % de las visitas logra contratar un seguro. Definir la variable aleatoria asociada a este

experimento aleatorio y obtener su media y varianza.

Tenemos un experimento aleatorio o prueba de Bernoulli que consiste en realizar una visita a

un cliente e intentar contratarle un seguro. Los dos posibles resultados serán:

- El cliente contrata el seguro, suceso éxito.

- El cliente no contrata el seguro, suceso fracaso.

La variable aleatoria asociada al experimento se define como

si el cliente contrata el seguro (ocurre el suceso E)

1

X=

0

si el cliente no contrata el seguro (no ocurre el suceso E)

En este caso la probabilidad de éxito es p = 0,6 y de aquı́ que la función masa de probabilidad

de la variable aleatoria X es

P[X = 1] = P (E) = 0,6 = p

P[X = 0] = P (E) = 0,4 = 1 − p

La media y la varianza son

E[X] = p = 0,6

Var[X] = p(1 − p) = 0,6 · 0,4 = 0,24

4. Distribución binomial

Una generalización de la distribución de Bernoulli se obtiene cuando:

- El experimento o prueba de Bernoulli se repite n veces de forma independiente.

- La probabilidad de éxito p permanece constante en cada repetición del experimento.

Se define ahora una variable aleatoria X como el número de éxitos en las n repeticiones independientes del experimento que puede tomar los valores k = 0, 1, · · · , n. Calculemos la probabilidad

de que dicha variable tome cada uno de esos valores; esto es, P[X = k], k = 0, 1, · · · , n, o lo

que es lo mismo, la probabilidad de obtener k éxitos (o realizaciones del suceso E) en las n

pruebas de Bernoulli.

Una de las posibles formas de obtener k éxitos en las n pruebas serı́a que se realizara E en

las k primeras pruebas y Ē en las n − k restantes

Patricia Román Román

6

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

EE · ·

k)

E Ē Ē · ·

n−k)

Ē

Al ser las pruebas independientes, la probabilidad de la intersección de los n sucesos anteriores

será el producto de las probabilidades de cada uno de los sucesos; esto es

pp · ·

k)

p(1 − p)(1 − p) · ·

n−k)

(1 − p) = pk (1 − p)n−k

Ahora habrá que multiplicar esta probabilidad por el número de posibles ordenaciones de los

k éxitos y los n − k fracasos, que es el número de permutaciones de n elementos con repetición

de k elementos de un tipo y n − k de otro

n!

n

=

k!(n − k)!

k

Por tanto

n x

P[X = x] =

p (1 − p)n−x ,

x

x = 0, 1, · · · , n

Definición.- Se dice que una variable aleatoria X sigue una distribución binomial de

parámetros n y p, n ∈ N, p ∈ (0, 1) si modeliza el número de éxitos en n repeticiones independientes de un ensayo de Bernoulli con probabilidad p de éxito, manteniéndose ésta constante

en las n repeticiones del experimento; o bien, si su función masa de probabilidad es

n x

P[X = x] =

p (1 − p)n−x ,

x = 0, 1, · · · , n.

x

Se notará como X ∼ B(n, p).

Nota.-Observemos que la distribución de Bernoulli no es más que un caso particular de la

distribución binomial con n = 1.

Probemos que, en efecto, es una función masa de probabilidad. En primer lugar, son valores

mayores o iguales que cero y, en segundo lugar, su suma vale uno. En efecto, teniendo en cuenta

el binomio de Newton

n

X

n X

n x

P[X = x] =

p (1 − p)n−x = [p + (1 − p)]n = 1

x

x=0

x=0

Ejemplo: Número de caras al lanzar una moneda n veces de forma independiente.

Aplicaciones

Sus principales áreas de aplicación incluyen control de calidad, ventas, mercadotecnia, medicina,

investigación de opiniones y otras.

Patricia Román Román

7

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

- Número de unidades defectuosas en un proceso de fabricación. En un proceso de manufactura se produce un determinado producto en el que algunas unidades son defectuosas. Si la

proporción de unidades defectuosas producidas por este proceso es constante durante un periodo razonable y si, como procedimiento de rutina, se seleccionan aleatoriamente un determinado

número de unidades, entonces el número de artı́culos defectuosos en dicha muestra se puede

modelizar mediante el empleo de la distribución binomial.

- En aplicaciones de publicidad para la venta de un artı́culo, también puede considerarse

la distribución binomial, si se supone que la probabilidad de venta es constante para todas las

personas consideradas.

- En Medicina, por ejemplo, para estudiar el número de individuos que contraen una enfermedad, si para un grupo determinado de la población la probabilidad de contraer tal enfermedad

se mantiene constante.

Algunas de sus caracterı́sticas son:

Función de distribución:

F (x) = P[X ≤ x] =

0

x<0

P[X = 0] + . . . P[X = i]

i ≤ x < i + 1; i = 1, 2, . . . , n − 1

1

x≥n

o bien,

0

[x] X

n k

F (x) =

p (1 − p)n−k

k

k=0

1

x<0

0≤x<n

x≥n

donde [x] denota la parte entera de x. Dicha función de distribución es una función

escalonada con n + 1 saltos en los puntos 0, · · · , n de longitudes P[X = 0], . . . , P[X = n]

Función generatriz de momentos

M (t) = (pet + (1 − p))n

∀t ∈ R

En efecto

Patricia Román Román

8

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

n

tX X

tx n

px (1 − p)n−x

=

e

M (t) = E e

x

x=0

=

n X

n

x=0

x

(pet )x (1 − p)n−x = [pet + (1 − p)]n

Momentos: Dado que la variable está acotada, existen los momentos de todos los órdenes,

pero nos limitaremos a calcular hasta los de orden dos.

Media

E[X] = np

lo cual se puede probar, o bien a partir de la función generatriz de momentos o bien,

directamente. Veamos la obtención directa

n

n

X

X

n x

n!

n−x

px (1 − p)n−x =

E[X] =

x

p (1 − p)

=

x

x!(n − x)!

x

x=0

x=0

n

X

x=1

n

X

(n − 1)!

n!

x

n−x

p (1 − p)

= np

px−1 (1 − p)n−x

(x − 1)!(n − x)!

(x − 1)!(n − x)!

x=1

Tomando y = x − 1 y m = n − 1, entonces

E[X] = np

m

X

y=0

m!

py (1 − p)m−y = np

y!(m − y)!

dado que los términos de la última suma corresponden a la función masa de probabilidad

de una B(m, p) y, por tanto, suman uno.

Varianza

Var[X] = np(1 − p)

dado que el momento no centrado de orden dos es m2 = E[X 2 ] = n(n − 1)p2 + np. Este se

puede obtener a partir de la función generatriz de momentos o bien directamente. Veamos

esta última forma

E[X 2 ] = E[X(X − 1)] + E[X]

Dado que E[X] ya es conocida, obtengamos la otra

Patricia Román Román

9

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

n

X

n

X

n x

n!

n−x

px (1 − p)n−x

E[X(X − 1)] =

x(x − 1)

p (1 − p)

=

x(x − 1)

x!(n − x)!

x

x=0

x=0

n

X

x=2

n

X

n!

(n − 2)!

x

n−x

2

p (1 − p)

= n(n − 1)p

px−2 (1 − p)n−x

(x − 2)!(n − x)!

(x − 2)!(n − x)!

x=2

Tomando ahora y = x − 2 y m = n − 2, de forma análoga a la media , se obtiene

E[X(X − 1)] = n(n − 1)p

2

m

X

y=0

m!

py (1 − p)m−y = n(n − 1)p2

y!(m − y)!

dado que los términos de la última suma corresponden a la función masa de probabilidad

de una B(m, p) y, por tanto suman uno.

Propiedad de simetrı́a.- Si X ∼ B(n, p), entonces la variable aleatoria que contabiliza

el número de fracasos, Y = n − X ∼ B(n, 1 − p) y, además

P[X = x] = P[Y = n − x]

Se puede probar calculando la función generatriz de momentos.

n

n

MY (t) = E[et(n−X) ] = etn MX (−t) = etn pe−t + (1 − p) = (1 − p)et + p .

Cálculo de probabilidades y representaciones gráficas

(Ver apuntes y scripts de R, y applets de Java con Geogebra)

EJERCICIOS

1.- Un club nacional de automovilistas comienza una campaña telefónica con el propósito de

aumentar el número de miembros. En base a experiencia previa, se sabe que una de cada 20

personas que reciben la llamada se une al club. Si en un dı́a, 25 personas reciben la llamada

telefónica, ¿cuál es la probabilidad de que por lo menos dos de ellas se inscriban al club? ¿Cuál

es el número esperado?

Solución: Si cada persona que recibe la llamada se une o no al club, independientemente del

resto, entonces,

X : Número de personas que se unen al club de las 25 llamadas

Patricia Román Román

10

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

X ∼ B(25, 1/20)

P[X ≥ 2] = 1 − P[X < 2] = 1 − [P[X = 0] + P[X = 1]] =

" 1 24 #

0

25

25

1

19

25

1

19

=1−

+

= 0.3576

0

20

20

1

20

20

1

= 1.25

20

2.- Un representante realiza cinco visitas cada dı́a a los comercios de su ramo y, por experiencia

anterior, sabe que la probabilidad de que le hagan un pedido en cada visita es 0.4. Calcular

E[X] = np = 25

a) La distribución del número de pedidos por dı́a.

b) Media y varianza del número de pedidos por dı́a.

c) Probabilidad de que el número de pedidos que realiza durante un dı́a sea 4.

d) La probabilidad de que realice por lo menos dos pedidos.

e) La probabilidad de que el número de pedidos que realiza durante un dı́a esté comprendido

entre 1 y 3.

Solución: Supuesto que en cada visita se hace un pedido o no independientemente de lo que se

haga en otra visita:

a) X : Número de pedidos diarios ∼ B(5, 0.4)

b) E[X] = 5 × 0.4 = 2, V ar[X] = 5 × 0.4 × 0.6 = 1.2

c) P (X = 4) = 54 0.44 0.61 = 0.0768.

Con R, dbinom(4,5,0.4)=0.0768.

d) P (X ≥ 2) = 1 − P (X < 2) = 1 − P (X ≤ 1) = 1 − (P (X = 0) + P (X = 1)) = 0.66304.

Con R, 1-pbinom(1,5,0.4)=0.66304, o bien, dado que P (X ≥ 2) = P (X > 1),

pbinom(1,5,0.4,lower.tail=FALSE)=0.66304.

e) P (1 ≤ X ≤ 3) = P (X = 1)+P (X = 2)+P (X = 3) = 51 0.41 0.64 + 52 0.42 0.63 + 53 0.43 0.62 =

0.2592 + 0.3456 + 0.2304 = 0.8352.

Con R, sum(dbinom(1:3,5,0.4))=0.8352, o bien, pbinom(3,5,0.4)-pbinom(0,5,0.4)=0.8352.

3.- Se envı́an 20 invitaciones a los representantes estudiantiles para asistir a una conferencia.

De experiencias anteriores se sabe que la probabilidad de aceptar la invitación es 0.8. Si las

decisiones de aceptar estas invitaciones son independientes, determinar la probabilidad de que

como mı́nimo 17 estudiantes acepten la invitación.

Solución:

X : Número de representantes que aceptan la invitación ∼ B(20, 0.8)

Patricia Román Román

11

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

P (X ≥ 17) = P (X = 17) + P (X = 18) + P (X = 19) + P (X = 20)

Con R, pbinom(16,20,0.8,lower.tail=FALSE)=0.4114489.

5. Distribución de Poisson

Esta distribución sirve para representar el número de ocurrencias de un determinado suceso durante un periodo de tiempo fijo o en una región fija del espacio, cuando el número de

ocurrencias sigue unas determinadas pautas:

El número de ocurrencias en un intervalo o región especificada debe ser independiente del

número de ocurrencias en cualquier otro intervalo o región.

Si se considera un intervalo de tiempo muy pequeño (o una región muy pequeña), la

probabilidad de una ocurrencia es proporcional a la longitud del intervalo (al volumen de

la región) y la probabilidad de dos o más ocurrencias es prácticamente nula (despreciable).

Definición: Una variable aleatoria X tiene distribución de Poisson de parámetro λ (λ > 0) si

su función masa de probabilidad es

P[X = x] = e−λ

λx

,

x!

x = 0, 1, . . .

Se nota X ∼ P(λ).

Probemos que en efecto es una función masa de probabilidad. En primer lugar, son valores

mayores o iguales que cero y, en segundo lugar, su suma vale uno. En efecto, teniendo en

cuenta el desarrollo de la exponencial

∞

X

x=0

P[X = x] =

∞

X

e−λ

x=0

∞

X

λx

λx

= e−λ

= e−λ eλ = 1

x!

x!

x=0

Aplicaciones

Esta distribución sirve para representar, por ejemplo:

- Número de accidentes que ocurren durante un determinado espacio de tiempo en una

determinada carretera.

- Número de llamadas telefónicas a una oficina (en un determinado intervalo de tiempo).

- Número de bacterias en un cultivo.

En general, las situaciones reales en las que se usa la distribución de Poisson se caracterizan

porque la probabilidad del suceso cuyo número de ocurrencias se contabiliza es pequeña y por

ello suele denominarse la LEY DE LOS SUCESOS RAROS.

Algunas de sus caracterı́sticas son:

Patricia Román Román

12

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

Función de distribución

F (x) =

0

x<0

[x]

k

X

−λ λ

e

k!

x≥0

k=0

donde [x] denota la parte entera de x.

Función generatriz de momentos

M (t) = eλ(e −1)

t

∀t ∈ R

En efecto

M (t) =

∞

X

x

tx −λ λ

e e

x=0

x!

−λ

=e

∞

X

(et λ)x

x=0

x!

= e−λ ee λ = eλ(e −1)

t

t

Media

E[X] = λ

lo cual se puede probar o bien directamente, o a partir de la función generatriz de momentos. Veamos la obtención directa

E[X] =

∞

X

x=0

xe−λ

∞

X

λx

λx−1

= λe−λ

= λe−λ eλ = λ

x!

(x

−

1)!

x=1

Por tanto, el parámetro λ de la distribución es el número medio de ocurrencias en el

intervalo de tiempo o región del espacio considerada.

Varianza

Var[X] = λ

Razonando de forma análoga a la binomial y calculando E[X(X − 1)]

E[X(X − 1)] =

∞

X

x=0

−λ λ

x(x − 1)e

x

x!

2 −λ

=λ e

∞

X

λx−2

= λ2 e−λ eλ = λ2

(x

−

2)!

x=2

se obtiene E[X 2 ] = λ2 + λ, de donde se deduce el valor de la varianza.

Patricia Román Román

13

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

Relación entre las distribuciones binomial y de Poisson

La distribución de Poisson se puede obtener como lı́mite de una distribución binomial: Consideramos una variable que modeliza el número de sucesos ocurridos en un intervalo de tiempo,

y dividimos dicho intervalo en n subintervalos tan pequeños de forma que en cada uno de ellos

pueda ocurrir a lo sumo un suceso con probabilidad no nula, a la que llamaremos p. De esta

forma el número de sucesos que ocurren en cada subintervalo tiene una distribución B(1, p) y,

al ocurrir los sucesos de forma independiente en los subintervalos, el número de sucesos en el

intervalo es una B(n, p).

Claramente, cuando n aumenta, p disminuye ya que al aumentar n disminuye la amplitud

de los intervalos y, por tanto, la probabilidad de que ocurra un suceso en él.

En consecuencia, considerando un número n grande de pruebas de Bernoulli independientes,

con probabilidad de ocurrencia p pequeña, y tomando λ = np, se obtiene la distribución de

Poisson como lı́mite de la binomial cuando n → ∞. Es decir, si n → ∞, p → 0 y np → λ la

distribución binomial tiende a una Poisson, es decir

x

n x

n−x

−λ λ

x = 0, 1, · · ·

lı́m

p

(1

−

p)

=

e

n→∞

x!

x

p→0

np→λ

En efecto,

n x

n!

(np)x

P[X = x] =

p (1 − p)n−x =

(1 − p)n−x =

x

x

x!(n − x)! n

(np)x n(n − 1) · · · (n − x + 1)

(1 − p)n−x

x

x!

n

Ahora tomando lı́mites cuando n → ∞, p → 0 de forma que np → λ, se tiene

n x

e−λ λx

n−x

lı́m

p

(1

−

p)

=

n→∞

x

x!

p→0

=

np→λ

dado que

lı́m

np→λ

lı́m

n→∞

(np)x

λx

=

x!

x!

n(n − 1) · · · [n − (x − 1)]

=1

nx

lı́m (1 − p)n−x = elı́m(n−x)(−p) = e−λ

n→∞

p→0

Cálculo de probabilidades y representaciones gráficas

(Ver apuntes y scripts de R, y applets de Java con Geogebra)

Patricia Román Román

14

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

EJERCICIOS

1.- En una cierta empresa constructora el número de accidentes es por término medio de 3 por

mes. Calcular:

a) La probabilidad de que no ocurra ningún accidente en un mes dado.

b) La probabilidad de que ocurran menos de 5 accidentes en un mes dado.

c) La probabilidad de que ocurran más de 3 accidentes en un mes dado.

d) La probabilidad de que ocurran exactamente 3 accidentes en un mes dado.

Si suponemos que los accidentes cuando ocurren son independientes unos de otros y además,

que ocurren con una tasa de ocurrencia constante, la variable aleatoria número de accidentes

en un mes dado tiene una distribución de Poisson. Dado que el número medio de accidentes al

mes es 3 y el parámetro λ de una Poisson es el valor medio (λ = 3), la distribución considerada

es una P(3). Las probabilidades solicitadas son

a) P[X = 0] =

30 −3

e

0!

= 0.0498

Con R, dpois(0,3)=0.04978707.

b) P[X < 5] = P[X ≤ 4] = P[X = 0] + P[X = 1] + P[X = 2] + P[X = 3] + P[X = 4] =

0

−λ λ

=e

0!

+e

1

−λ λ

1!

−λ λ

+e

2

2!

−λ λ

+e

3

3!

4

−λ λ

+e

4!

=

= 0.0498 + 0.1494 + 0.2240 + 0.2240 + 0.1680 = 0.8152.

Con R, ppois(4,3)=0.8152632.

c) P[X > 3] = 1 − P[X ≤ 3]

Con R, 1-ppois(3,3) o ppois(3,3,lower.tail=FALSE)=0.3527681.

d) P[X = 3] = 0.2240.

Con R, dpois(3,3)=0.2240418.

2.- Desde el año 1980 el número medio de empresas, con más de 100 trabajadores, que han

presentado suspensión de pagos ha sido de 6.8 por año, y admitimos que el número de empresas

con más de 100 trabajadores, X, que han presentado suspensión de pagos durante un periodo

determinado de tiempo sigue una distribución de Poisson. Obtener

a) La probabilidad de que ninguna empresa de más de 100 trabajadores presente suspensión de

pagos durante un trimestre.

b) La probabilidad de que por lo menos dos empresas de más de 100 trabajadores presenten

suspensión de pagos durante un determinado año.

La distribución que sigue X, el número de empresas con más de 100 trabajadores que han

presentado suspensión de pagos durante un periodo de tiempo es una Poisson de parámetro λ.

a) Como las empresas de mas de 100 trabajadores presentan suspensión de pagos a razón de

6.8 por año, en un trimestre será

Patricia Román Román

15

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

6.8

= 1.7

4

Luego la variable Y , número de empresas con más de 100 trabajadores que han presentado

suspensión de pagos durante un trimestre es una Poisson de parámetro λ = 1.7 y la probabilidad

pedida

P[Y = 0] = e−1.7

1.70

= 0.1827

0!

Con R, dpois(0,1.7)= 0.1826835.

b) Para obtener ahora la probabilidad de que por lo menos dos empresas de más de 100 trabajadores presenten suspensión de pagos durante un determinado año consideraremos la variable

aleatoria X ∼ P(6.8). Luego

P[X ≥ 2] = 1 − P[X = 0] − P[X = 1] = 1 − 0.0011 − 0.0076 = 0.9913

Con R, ppois(1,6.8, lower.tail=FALSE)=0.9913126, o bien 1-ppois(1,6.8).

3.- A una calculadora le fallan, por término medio en cada hora de trabajo, dos transistores. Se

sabe que el número de fallos de los transistores sigue una distribución de Poisson. La calculadora

deja de funcionar cuando se le averı́an seis o más transistores. Calcular la probabilidad de que

una operación de tres horas se pueda realizar sin averı́a.

X: Número de fallos en tres horas ∼ P(6)

Se pide

P(X < 6) = P(X ≤ 5) =

5

X

x=0

P (X = x) =

5

X

x=0

e−6

6x

= 0.0025 + 0.0149 + 0.0446 + 0.0892 +

x

0.1339 + 0.1606 = 0.4457

Con R, ppois(5,6)=0.4456796.

6. Distribución binomial negativa

Consideremos ahora un experimento aleatorio consistente en repeticiones independientes de

ensayos de Bernoulli con probabilidad de éxito constante, hasta que aparezca el éxito k-ésimo. Es decir, en lugar de fijar el número de ensayos y observar el número de éxitos en esas n

realizaciones, se repiten las realizaciones hasta obtener un número determinado de éxitos y contabilizamos los fracasos. Definimos la variable aleatoria con distribución binomial negativa

como aquella que modeliza el número de fracasos antes de que aparezca el éxito k-ésimo.

Nota.- Si en vez de contabilizar el número de fracasos antes del k-ésimo éxito se contabiliza

el número de pruebas necesarias (variable aleatoria Y = X + k), se obtiene la distribución de

Pascal que verifica

Patricia Román Román

16

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

P[Y = n] = P[X = n − k].

La variable aleatoria X puede tomar los valores x = 0, 1, 2, . . . y k debe ser un entero

positivo, es decir, k = 1, 2, . . . .

Calculemos la función masa de probabilidad de la variable aleatoria binomial negativa; esto

es,

P[X = x], x = 0, 1, 2, . . .

Uno de los posibles sucesos para el cual ocurre {X = x} serı́a que en las x primeras

repeticiones apareciera “fracaso”, en las k − 1 siguientes “éxito” y en la ultima “éxito”

E .x). . E|E k−1)

. . . E|E

y como las repeticiones de las pruebas de Bernoulli son independientes, la probabilidad del

suceso anterior será

h

i

x)

k)

P E .x). . EE .k). . E = P(E) · · · P(E) · P(E) · · · P(E) = (1 − p)x pk

Pero la obtención de los x fracasos y los k − 1 éxitos se pueden obtener de tantas maneras como

las permutaciones con repetición de x + k − 1 elementos en los que hay iguales x y k − 1, es

decir

x+k−1

(x + k − 1)!

=

x!(k − 1)!

x

Por tanto, la función masa de probabilidad de esta variable aleatoria es

P[X = x] =

x+k−1

(1 − p)x pk ,

x

x = 0, 1, 2, · · · (k = 1, 2, · · · ; 0 ≤ p < 1)

y se notará como X ∼ BN (k, p).

Comprobemos que es, en efecto, una función masa de probabilidad. Para ello tengamos en

cuenta lo siguiente

∀α ∈ R, α0 = 1

∀α ∈ R, x ∈ N, αx = α(α−1)···(α−x+1)

x!

P

α x

(1 + t)α = ∞

|t| < 1, ∀α ∈ R

x=0 x t ,

Propiedad:“Para cualquier número real α > 0

−α

r α+r−1

= (−1)

”

r

r

Patricia Román Román

17

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

En primer lugar, es evidente que P[X = x] ≥ 0, x = 0, 1, 2, . . . y

∞

X

P[X = x] =

x=0

=

∞ X

k+x−1

x

x=0

(1 − p)x pr

∞ X

−k

[−(1 − p)]x pk = pk [1 − (1 − p)]−k = pk p−k = 1

x

x=0

Observemos que, de hecho, otra expresión de la función masa de probabilidad de la binomial

negativa es

−k

P[X = x] =

[−(1 − p)]x pk

x

Ejemplos

- Número de preguntas falladas en un examen tipo test antes de tener el décimo acierto.

- Número de unidades defectuosas antes de obtener un número concreto de correctas.

Algunas de las caracterı́sticas de la distribución binomial negativa son:

Función de distribución:

F (x) = P[X ≤ x] =

0

x<0

[x] X

i+k−1

(1 − p)i pk

i

x≥0

i=0

Función generatriz de momentos:

M (t) =

p

1 − (1 − p)et

k

∀t < −ln(1 − p)

En efecto,

tX

E e

=

∞

X

tx

e P[X = x] =

x=0

∞

X

e

tx

x=0

−k

(−(1 − p))x pk

x

que converge si |et (−(1 − p))| < 1 ⇔ et (1 − p) < 1 ⇔ t < −ln(1 − p)

=

∞ X

−k

x=0

x

t x k

(−(1 − p)e ) p = p

k

∞ X

−k

x=0

x

(−(1 − p)et )x

= pk (1 − (1 − p)et )−k

Patricia Román Román

18

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

Momentos: Existen todos dado que existe la función generatriz de momentos. Nos limitaremos

a obtener los momentos de primer y segundo orden.

Media

E[X] =

k(1 − p)

p

Veamos la obtención de forma directa:

∞

∞

X

X

(−k)(−k − 1) · · · (−k − x + 1)

−k

x k

k

x

(−(1 − p))x =

E[X] =

x

(−(1 − p)) p = p

x(x − 1)!

x

x=1

x=0

∞

X

−k − 1

k(1 − p)

(−k)

p (−(1 − p))

(−(1 − p))x−1 = k(1 − p)pk (1 − (1 − p))−k−1 =

x−1

p

x=1

k

Varianza

Var[X] =

k(1 − p)

p2

Razonando de forma análoga al caso binomial, se obtiene

E[X 2 ] =

k(k + 1)(1 − p)2 k(1 − p)

+

,

p2

p

de donde se deduce la expresión de la varianza.

Relación entre las distribuciones binomial y binomial negativa

Si X es una variable aleatoria con distribución BN (k, p), el suceso {X = x} significa la intersección de los sucesos

A = {se han obtenido k − 1 éxitos en los primeros k + x − 1 ensayos

de una serie de pruebas independientes de Bernoulli}

B = {se ha obtenido un éxito en el siguiente ensayo de la serie}

El suceso A equivale a {Y = k − 1}, con Y ∼ B(k + x − 1, p), y el segundo es independiente

del primero y ocurre con probabilidad p. Entonces

P[X = x] = P[Y = k − 1] · p

Caso particular: Distribución Geométrica

La distribución geométrica es un caso particular de la distribución binomial negativa para

el caso de k = 1. Es decir, modeliza el número de fracasos antes del primer éxito en repeticiones independientes de ensayos de Bernoulli con probabilidad de éxito p. Su función masa de

probabilidad es

Patricia Román Román

19

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

P[X = x] = (1 − p)x p,

x = 0, 1, 2, · · · (0 < p < 1)

y se notará como X ∼ G(p).

Sus caracterı́sticas más relevantes son

Función de distribución:

F (x) = P[X ≤ x] =

0

x<0

[x]

X

(1 − p)i p

x≥0

i=0

Pero como

1

[x]

X

[x]

X

1 − (1 − p)[x]+1

i

= 1 − (1 − p)[x]+1

(1 − p) p = p

(1 − p) = p

1 − (1 − p)

i=0

i=0

i

se puede reescribir la función de distribución como

F (x) = P[X ≤ x] =

0

x<0

1 − (1 − p)[x]+1

x≥0

Función generatriz de momentos:

M (t) =

p

1 − (1 − p)et

∀t < −ln(1 − p)

Media:

E[X] =

1−p

p

Varianza:

Var[X] =

1

1−p

p2

Recordemos que la suma de los n términos de una progresión geométrica an de razón r es

Sn =

Patricia Román Román

a1 − an · r

1−r

20

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

Propiedad de olvido o falta de memoria:

Esta propiedad se formula de la siguiente forma: Si X es una variable aleatoria con

distribución geométrica de parámetro p, G(p), entonces se verifica que

P[X ≥ h + k|X ≥ h] = P[X ≥ k],

h, k = 0, 1, 2, . . .

“Si se ha realizado la h-ésima repetición del experimento o prueba de Bernoulli y no se

ha obtenido ningún éxito, entonces la probabilidad de que se realicen por lo menos otras

k repeticiones sin que se presente ningún éxito, es decir que se realicen por lo menos h + k

repeticiones, es la misma que si consideramos que la primera repetición es la h + 1-ésima;

es decir, esa probabilidad es la misma que la probabilidad de que realicemos al menos k

repeticiones sin obtener el primer éxito, y por consiguiente se olvidan las h repeticiones

realizadas inicialmente.

Vamos a demostrarla, si X ∼ G(p)

P[X ≥ x] = 1 − P[X < x] = 1 − F (x − 1) = 1 − (1 − (1 − p)x ) = (1 − p)x .

Por tanto, si k, h, ∈ N

P[X ≥ h + k|X ≥ h] =

P[X ≥ h + k, X ≥ h]

=

P[X ≥ h]

P[X ≥ h + k]

(1 − p)h+k

=

= (1 − p)k = P[X ≥ k]

P[X ≥ h]

(1 − p)h

Esta propiedad, además, caracteriza a la distribución geométrica como la única entero

valuada (positiva) que la cumple.

La distribución de probabilidad geométrica se aplica frecuentemente en el estudio de la distribución de la duración de tiempos de espera. Ası́ pues, si las repeticiones del experimento se realizan

a intervalos regulares de tiempo, entonces la variable aleatoria con distribución geométrica nos

dará el número de intervalos de tiempo transcurridos hasta que aparezca el primer éxito.

EJERCICIOS

1.- Un examen de Estadı́stica consta de 20 preguntas tipo test y se conoce de experiencias

anteriores que un alumno tiene probabilidad 0.7 de contestar bien cada pregunta. Obtener:

a) La probabilidad de que la primera pregunta que contesta bien sea la cuarta.

b) Sabiendo que para aprobar el examen es necesario contestar bien a 10 preguntas, ¿cuál es la

probabilidad de que apruebe al contestar la pregunta duodécima?

a) X= Número de fallos antes del primer éxito, X ∼ G(0.7)

Patricia Román Román

21

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

P[X = 3] = (0.3)3 0.7 = 0.0189

Con R, dgeom(3,0.7)=0.0189.

b) X= Número de fallos antes del décimo éxito, X ∼ BN (10, 0.7)

2 + 10 − 1

11

2

10

P[X = 2] =

(0.3) (0.7) =

(0.3)2 (0.7)10 .

2

2

Con R, dnbinom(2,10,0.7)=0.1398252.

Esta probabilidad se puede obtener mediante la relación con la binomial Y = Número de éxitos

en las 11 primeras pruebas, Y ∼ B(11, 0.7)

P [X = 2] = P [Y = 9] · 0.7

2.- Una máquina dedicada a la fabricación de piezas de alta precisión produce las piezas de una

en una, siendo independiente la fabricación de cada pieza. La probabilidad de fabricar una pieza

defectuosa es 0.15. Obtener

a) La probabilidad de que la primera pieza defectuosa durante ese dı́a sea la número 40.

b) Sabiendo que en la fabricación de cada pieza se tardan 20 segundos ¿cuál será el tiempo

medio que hay que esperar hasta que sea producida la primera pieza defectuosa?

c) Probabilidad de que las ocho primeras piezas fabricadas sean todas buenas.

a) X= Número de piezas buenas antes de la primera defectuosa, X ∼ G(0.15)

P [X = 39] = (0.85)39 · 0.15

Con R, dgeom(39,0.15)= 0.000265112.

= 00..85

= 5.666. que es el número medio de piezas buenas antes de la primera

b) EX = 1−p

p

15

defectuosa. Por tanto, el tiempo pedido es 20 × (5.666 + 1) = 133.33 segundos.

c) P [X ≥ 8] = 1 − F (7) = 1 − P [X ≤ 7]

Con R, 1-pgeom(7,0.15) o pgeom(7,0.15, lower.tail=FALSE)= 0.2724905.

Si consideramos Y = Número de piezas buenas en las 8 primeras, Y ∼ B(8, 0.85)

P [Y = 8]

Con R, dbinom(8,8,0.85)= 0.2724905.

7. Distribución hipergeométrica

Se denomina población a cualquier colección de individuos, objetos o elementos arbitrarios

y una muestra de tamaño n de esa población es cualquier subconjunto con n elementos.

El procedimiento de selección de muestras de una población se denomina muestreo y éste

puede realizarse de distintas formas, dando lugar a distintos tipos de muestras de las que

aquı́ vamos a distinguir las dos siguientes (suponiendo una población finita):

Patricia Román Román

22

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

MUESTRA ALEATORIA CON REEMPLAZAMIENTO (CON DEVOLUCIÓN O SIMPLE).

Se selecciona al azar un elemento de la población (suponiendo que todos tienen la misma

probabilidad de ser seleccionado), se devuelve a la población (después de anotar las caracterı́sticas de interés) y se selecciona otro también de forma aleatoria; se continua el proceso hasta

completar el tamaño muestral deseado.

Notemos que una muestra aleatoria con reemplazamiento puede contener elementos repetidos y, en ciertas ocasiones, esto no es conveniente (incluso puede no ser posible, por ejemplo,

al estudiar la duración de vida de cierto tipo de bombillas).

MUESTRA ALEATORIA SIN REEMPLAZAMIENTO (SIN DEVOLUCIÓN).

Se selecciona al azar un elemento de la población (suponiendo que todos tienen la misma

probabilidad de ser seleccionado); a continuación, sin devolverlo a la población, se selecciona

otro suponiendo que los restantes tienen la misma probabilidad de ser elegidos y ası́ sucesivamente.

Notemos que ahora todos los elementos de la muestra serán distintos.

El muestreo sin reemplazamiento es útil en muchas situaciones prácticas. Por ejemplo, consideremos una población con N individuos que deben elegir entre dos candidatos A y B a cierto

puesto. Con objeto de realizar un sondeo de opinión antes de la elección se efectúa un muestreo

de n individuos para ver su preferencia. En una situación de este tipo parece lógico hacer un

muestreo sin reemplazamiento, que proporcionará más información sobre la intención de voto

al tener todos los individuos diferentes.

Observemos que si en la población hay N1 votantes de A y la muestra se elige con reemplazamiento, cada elemento de la muestra tiene probabilidad N1 /N de ser votante de A. Por tanto,

la selección de la muestra equivale a la repetición de n pruebas de Bernoulli independientes con

probabilidad constante de éxito (ser votante de A) y la variable X: Número de votantes de A

en la muestra ∼ B(n, NN1 )

Por el contrario, si el muestreo se realiza sin reemplazamiento, la probabilidad de éxito varı́a

después de cada selección y las pruebas de Bernoulli no son independientes:

La probabilidad de que el primer individuo seleccionado vote al candidato A es

N1

N

La probabilidad de que el segundo individuo seleccionado vote al candidato A depende

de lo que haya ocurrido en la primera prueba

P (2A/1A) =

N1 − 1

,

N −1

P (2A/1B) =

N1

.

N −1

Por tanto, la variable X: Número de votantes de A en la muestra, no tiene ahora una

distribución binomial, sino que su distribución es la denominada HIPERGEOMÉTRICA.

Antes de introducir formalmente esta distribución notemos que, a efectos de calcular probabilidades, el muestreo sin reemplazamiento equivale a la selección simultánea de n elementos

Patricia Román Román

23

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

de la población, suponiendo que todos los subconjuntos de n elementos tienen la misma probabilidad de ser elegidos.

En efecto, si la selección se realiza simultáneamente no cabe distinguir entre dos muestras

que tengan los mismos elementos (no se tiene en cuenta el orden) y hay en total Nn muestras distintas y la probabilidad de elegir una cualquiera de ellas (esto es, que n individuos

determinados formen parte de la muestra) es N1 .

(n)

Por otra parte, si la selección se realiza elemento a elemento, dos muestras con los mismos

elementos en distinto orden serán distintas y, en total, hay N (N − 1) · · · (N − n + 1) muestras

distintas; la probabilidad de que una muestra esté formada por n individuos concretos es

n!

1

= N

N (N − 1) · · · (N − n + 1)

n

que es igual a la anterior.

Definición

Supongamos una población de N individuos divididos en dos categorı́as de N1 y N2 (=

N − N1 ) individuos cada uno. Se elige una muestra de n individuos de la población (sin reemplazamiento o simultáneamente). La variable aleatoria X que contabiliza el número de individuos de la primera categorı́a en la muestra se dice que tiene distribución hipergeométrica de

parámetros N , N1 y n y se nota

X ∼ H(N, N1 , n),

n, N1 , N ∈ N − {0}, n, N1 ≤ N

Función masa de probabilidad

Evidentemente, un valor de la variable X debe ser un número natural (debe incluirse el

cero) verificando

máx(0, n − (N − N1 )) ≤ x ≤ mı́n(n, N1 )

pues como hay N1 elementos en la primera subpoblación y N2 en la segunda subpoblación se

tiene que cumplir

x ≤ n, x ≤ N1 ⇒ x ≤ mı́n(n, N1 )

x ≥ 0, n − x ≤ N2 ⇒ x ≥ máx(0, n − N2 )

Obtengamos la función masa probabilidad de dicha variable aleatoria, esto es la P[X = x],

para los diferentes valores posibles de x.

P{X = x} =

N1 N −N1

( x )( n−x )

(Nn )

−(x−1) N −N1 N −N1 −1

n

N1 N1 −1

· · · NN1−(x−1)

· · · N −NN1 −(n−x−1)

N

N

−1

N

−x

N

−x−1

−n+1

x

N1

N −N1

= ( x )(Nn−x )

(n)

Patricia Román Román

Muestra simultánea

(Regla de Laplace)

Muestra con reemp.

24

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

Luego la función masa de probabilidad de esta variable aleatoria será

N1 N −N1

P[X = x] =

x

n−x

N

n

máx(0, n − (N − N1 )) ≤ x ≤ mı́n(n, N1 )

Probemos que es una función masa de probabilidad. En efecto, las probabilidades son no negativas y además 2

mı́nX

(n,N1 )

P[X = x] =

x=máx(0,n−(N −N1 ))

mı́nX

(n,N1 )

x=máx(0,n−(N −N1 ))

N1

x

N −N1

n−x

N

n

=

N1 +N −N1

n

N

n

N

n

N

n

=

=1

Ejemplos y/o aplicaciones

La distribución hipergeométrica se aplica en el control estadı́stico de calidad de una fabricación en serie. Ası́ pues, si el lote bajo control contiene N1 elementos buenos y N2 = N − N1

elementos defectuosos, cuando tomamos una muestra de tamaño n sin reemplazamiento estaremos interesados en saber el número de elementos buenos que han aparecido en la muestra de

tamaño n para ası́ determinar la calidad del proceso de fabricación.

En sondeos de opinión también tiene aplicación la distribución hipergeométrica. Podemos

realizar una encuesta para intentar conocer si los individuos de una población tienen o no

intención de votar en las próximas elecciones de tal manera que el número de individuos,

de una muestra sin reemplazamiento, que tienen intención de votar sigue una distribución

hipergeométrica.

Algunas de sus caracterı́sticas son:

2

Usando que dados dos números cualesquiera a y b y un entero positivo n, se verifica

n X

a

b

a+b

=

x n−x

n

x=0

aunque realmente, dado que xa = 0 si x > a al haber un término nulo en a(a − 1) · · · (a − x + 1) se debe tomar

b

x ≤ a, y dado que n−x

= 0 si n − x > b se debe tomar x ≥ n − b. Por tanto la suma parte de máx(0, n − b) y

llega a mı́n(n, a) y realmente se tiene

mı́n

(n,a)

X

x=máx(0,n−b)

Patricia Román Román

a

b

a+b

=

x n−x

n

25

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

Función de distribución:

x < máx(0, n − (N − N1 ))

0

P

N (1−p)

Np

[x] ( i )( n−i )

F (x) =

N

i=0

(n)

1

máx(0, n − (N − N1 )) ≤ x ≤ mı́n(n, N1 )

x > mı́n(n, N1 )

Función generatriz de momentos:

Existe ∀t ∈ R porque la variable toma un número finito de valores.

mı́nX

(n,N1 )

MX (t) =

e

N1

tx x

x=máx(0,n−(N −N1 ))

N −N1

n−x

N

n

No se conoce una forma funcional especı́fica.

Media:

E[X] = n

N1

N

En efecto,

mı́nX

(n,N1 )

EX =

x

N1

x

x=máx(0,n−(N −N1 )

N −N1

n−x

N

n

=

mı́nX

(n,N1 )

1

N

n

x=máx(1,n−(N −N1 )

N1 − 1 N − N1

N1

=

x−1

n−x

haciendo x − 1 = k

N1

= N

n

mı́n(n−1,N

X 1 −1)

k=máx(0,(n−1)−(N −N1 )

N − N1

N1 N − 1

nN1

N1 − 1

= N

=

k

(n − 1) − k

n−1

N

n

Varianza:

Var[X] =

n(N − n)N1 (N − N1 )

N 2 (N − 1)

Para ello, calculemos en primer lugar el momento no centrado de orden dos; es decir

E[X 2 ] = E[X(X − 1)] + E[X]

Patricia Román Román

26

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

mı́nX

(n,N1 )

E[X(X − 1)] =

x(x − 1)

N1

x

x=máx(2,n−(N −N1 )

mı́nX

(n,N1 )

N1 (N1 − 1)

=

N

n

x=máx(2,n−(N −N1 )

N −N1

n−x

N

n

=

N1 − 2 N − N1

=

x−2

n−x

haciendo x − 2 = k

N1 (N1 − 1)

=

N

n

mı́n(n−2,N

X 1 −2)

k=máx(0,(n−2)−(N −N1 )

N1 − 2

N − N1

=

k

(n − 2) − k

n(n − 1)N1 (N1 − 1)

N1 (N1 − 1) N − 2

=

=

N

n−2

N (N − 1)

n

E[X 2 ] =

n(n − 1)N1 (N1 − 1) nN1

+

N (N − 1)

N

de donde se deduce la expresión de la varianza.

V ar[X] =

n(n − 1)N1 (N1 − 1) nN1 n2 N12

n(N − n)N1 (N − N1 )

+

−

=

2

N (N − 1)

N

N

N 2 (N − 1)

EJERCICIOS

1.- Sea una baraja de 40 cartas. De ella se toma una muestra de 5 cartas sin reemplazamiento.

Obtener la probabilidad de obtener al menos dos ases.

Tenemos 40 cartas, de las cuales 4 son ases y se realiza un muestreo de tamaño 5 sin

reemplazamiento.

X: Número de ases en la muestra ∼ H(40, 4, 5)

y se pide

4 36

4 36

P[X ≥ 2] = 1 − P[X = 0] − P[X = 1] = 1 −

0

5 −

40

5

1

4

40

5

= 0,06899

Con R los parámetros de la distribución hipergeométrica son: tamaño de la primera subpoblación (N1 ), tamaño de la segunda subpoblación (N2 ) y tamaño de la muestra. Ası́, la

probabilidad pedida se calcula mediante phyper(1, 4,36,5,lower.tail=FALSE)=0.06899004.

2.- Una determinada empresa quiere aumentar su plantilla de vendedores en 20 personas y se

presentan 40 personas al proceso de selección. Determinar la probabilidad de que, después de

Patricia Román Román

27

ESTADÍSTICA DESCRIPTIVA E INTRODUCCIÓN A LA PROBABILIDAD

Doble Grado en Ingenierı́a Informática y Matemáticas

realizar todas las pruebas de selección, entre las 20 personas seleccionadas estén los 10 mejores

de las 40 personas que se presentaron.

Consideramos la variable aleatoria X: Número de los mejores vendedores entre los 20 seleccionados.

X ∼ H(40, 10, 20)

Nos piden

10

10

30

10

P[X = 10] =

40

20

= 0,000217

Con R, dhyper(10,10,30,20)=0.0002179599.

Patricia Román Román

28