Introducción a los Procesos de Poisson*

Anuncio

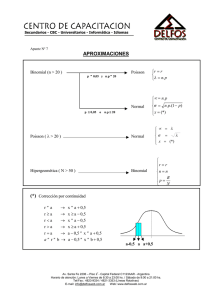

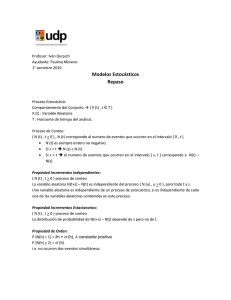

Introducción a los Procesos de Poisson* Victor M. Pérez Abreu C. Departamento de Probabilidad y Estadística, CIMAT David Reynoso Valle Licenciatura en Matemáticas, DEMAT, Universidad de Guanajuato 22 de julio del 2010 Índice 1. Introducción 2 2. Propiedades de la distribución de Poisson 2.1. Aproximación de Poisson . . . . . . . . . . . . . . . . . . . . . . 2.2. Distribución de Poisson . . . . . . . . . . . . . . . . . . . . . . . 2 2 2 3. Proceso de Conteo 6 4. Proceso de Poisson Homogéneo 6 5. Algunas variables aleatorias de interés 5.1. Tiempos de llegada . . . . . . . . . . . 5.2. Tiempos entre llegadas . . . . . . . . . 5.3. Tiempo de próxima ocurrencia . . . . 5.4. Tiempo desde última falla . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 7 7 9 13 15 6. Simulación de un Proceso de Poisson 16 7. De…nición equivalente 16 8. Combinación de Procesos de Poisson 20 9. Proceso de Poisson compuesto 20 10.Proceso de Poisson no homogéneo 22 * Notas de la Primera Parte del curso impartido durante el Segundo y Tercer Verano de Probabilidad y Estadística, en julio de 2009 y 2010. 1 1. Introducción En estas notas se compila parte del material que se cubrió en el curso de Probabilidad I de las Licenciaturas en Matemáticas y en Computación de la Universidad de Guanajuato, en el semestre agosto-diciembre del 2008. Estas notas son un complemento al material de la primera parte del Curso de Procesos de Poisson del III Verano de Probabilidad y Estadística. Contienen material básico sobre Procesos de Poisson, el cual aparece en la mayoría de los textos que tratan este tema. El énfasis en estas notas es en el rigor de las de…niciones y las demostraciones detalladas de las principales propiedades de estos procesos, usando conceptos y resultados sencillos de probabilidad. Los autores agradecen de antemano los comentarios que los participantes puedan tener. Nuestro objetivo es terminar pronto una Notas de Introducción al Tema de Procesos de Poisson, dirigidas a alumnos que han tomado un primer curso de probabilidad en licenciatura. 2. 2.1. Propiedades de la distribución de Poisson Aproximación de Poisson La distribución de Poisson es un caso límite de la distribución binomial B (n; pn ) cuando la probabilidad de éxito es variable. Si una variable aleatoria X modela el número de éxitos obtenidos luego de n ensayos Bernoulli con probabilidad de éxito p > 0, entonces la probabilidad de tener k éxitos en n ensayos está dada por P (X = k) = n k p (1 k n k p) . Se dice entonces que X tiene distribución binomial de parámetros n y p (X B (n; p)). Si = E(X) = np se mantiene constante cuando n y p varían, tenemos que k para toda r ( ) = l m P (X = k) = n!1 ke (1) k! 0. (notemos que cuando n crece, p decrece). Ejercicio 1 Probar (1). Sugerencia: Recordar que l mn!1 1 + 2.2. x n n = ex . Distribución de Poisson De…nición 1 Una variable aleatoria X tiene distribución de Poisson P ( ) si toma valores enteros positivos y P (X = k) = k ( )= 2 ke k! k 0 donde puede tomar cualquier valor Ejercicio 2 Probar que si X > 0. P( ) 1. E (X) = . 2. V ar (X) = . 3. La función generadora de momentos de X P( ) t (t) = e (e 1) . En ocasiones es útil extender la de…nición de P ( ) para incluir los casos extremos 0 e 1. P (0) sería la distribución concentrada en el 0 P (X = 0) = 1, y P (1) la distribución concentrada en +1 P (X = +1) = 1. Una de las propiedades más importantes de la distribución de Poisson es su aditividad. Teorema 1 Si X y Y son variables aleatorias independientes con distribuciones P ( 1 ) y P ( 2 ), entonces X + Y P ( 1 + 2 ). Demostración. Ejercicio. Por inducción, podemos ver fácilmente que este resultado es cierto para cualquier suma …nita de variables aleatorias independientes. Además se tiene la siguiente propiedad importante. Ejercicio 3 Probar que la distribución de Poisson es in…nitamente divisible, esto es, dada una variable aleatoria X con distribución Poisson P ( ), para toda n > 0 podemos encontrar n variables aleatorias independientes X1 ; : : : ; Xn Pn con distribución Poisson P ( 1 ) ; : : : ; P ( n ) tales que i=1 Xi P ( ). 1 Teorema 2 (Teorema de Aditividad Numerable) Sea fXj gj=1 una sucesión de variables aleatorias independientes, donde Xj P ( j ) j = 1; 2; : : :. Si 1 X = j j=1 converge, entonces S= 1 X Xj j=1 converge con probabilidad P1 1 y S P ( ). Por otro lado, si j=1 j diverge, entonces S diverge con probabilidad 1. 3 Demostración. Por el Teorema 1, tenemos que Sn = n X Xj n X j. j=1 tiene distribución P ( n) donde n = j=1 Es fácil ver que 8n 1 fSn fS rg fSn+1 1 \ rg = rg, de donde fSn n=1 rg y por tanto1 P (S r) = = = = l m P (Sn lm n!1 lm n!1 r X k=0 Si n ! < 1, por ser r r) n!1 r X P (Sn = r) k=0 r X k ( n) k ( n) . k=0 lm n!1 ( ) continua tenemos que P (S r) = r X k ( ) k=0 y P (S = r) = r ( ). Por lo tanto S es …nita con distribución P ( ). Si n ! 1, P (S r) = r X k ( ) k=0 = e n r X k=0 k n k! ! 0. Entonces P (S > r) = 1. 1 Si An 2 F , n 1 y An # A, entonces P (A) = l mn!1 P (An ) 4 Como este resultado es cierto 8r probabilidad 1. 0, podemos concluir que S diverge con Luego de este resultado parece más natural haber de…nido P (0) y P (1). Con esta convención, si tenemos variables aleatorias independientes PXj con distribuciones P ( j ) respectivamente, su suma tiene distribución P ( j ), y esto es cierto sin importar que haya un número in…nito de ellas, incluso si algunos j son 0 o 1. Supongamos que X1 ; : : : ; Xn son variables aleatorias independientesPcon Xj P ( j ). Entonces S = X1 + +X j, Pn tiene distribución P ( ) con = y entonces, si r1 ; : : : ; rn son tales que rj = s tenemos que P (X1 = r1 ; : : : ; Xn = rn j S = s) = n Y rj j e e s! rj ! j=1 = s j s! r1 ! r1 1 rn n rn ! . Estas son las probabilidades de una distribución multinomial M (s; p1 ; : : : ; pn ), con pi = i . Para el caso en el que n = 2, tenemos que si X y Y son variables aleatorias Poisson independientes (X P ( 1) y Y P ( 2 )), dado que X + Y = m, la distribución condicional de X es B (m; p), donde p= E (X) . E (X) + E (Y ) Hay un resultado muy útil, que parecería ser el converso del anterior. Supongamos que N P ( ) ; y que la distribución condicional de M dado N es B (N; p) para alguna constante p. Esto es P (M = t j N = s) = Entonces, para m; k P (M = m; N s t p (1 t s t p) . 0, M = k) = = = = = = P (N = m + k) P (M = m j N = m + k) m+k e (m + k)! m+k m p (1 m p) k m+k e (m + k)! m k p (1 p) (m + k)! k!m! 1 m k e p e (1 p) m k p (1 p) k!m! k e p m pm e (1 p) k (1 p) m! k! m k p (1 p) e ( p) e ( (1 p)) . m! k! 5 Así, M y N M son variables aleatorias independientes Poisson con medias p y (1 p) respectivamente. 3. Proceso de Conteo De…nición 2 (Proceso de Conteo) Se dice que un proceso estocástico fN (t) ; t es un proceso de conteo si representa el número de eventos ocurridos hasta el tiempo t, esto es, satisface: i) N (0) 0. ii) N (t) toma valores enteros. iii) Es no decreciente, i.e. si s < t, entonces N (s) iv) Para s < t, N (t) el intervalo (s; t]. N (t). N (s) es igual al número de eventos que ocurrieron en La trayectoria de un proceso de conteo es la grá…ca (t; N (t)) para t 0: Las trayectorias se toman de tal forma de que sean continuas por la derecha y que tengan límite por la izquierda. 4. Proceso de Poisson Homogéneo De…nición 3 (Proceso de Poisson homogéneo) Una colección de variables aleatorias fN (t) ; t 0g (de…nidas en un espacio de probabilidad ( ; F; P)) se llama proceso de Poisson (homogéneo) con intensidad > 0 si satisface las siguientes propiedades: i) P(N (0) = 0) = 1, esto es, N (0) es siempre 0. ii) 8 (t 0<s<t s). N (t) N (s) tiene distribución de Poisson de parámetro iii) 8 0 t1 < < tn ; n 1 (es decir, para todo conjunto …nito de tiempos), las variables aleatorias N (tn ) N (tn 1 ); : : : ; N (t2 ) N (t1 ); N (t1 ), son independientes. Esta propiedad se conoce como propiedad de incrementos independientes. Observemos que 8t 0, la variable aleatoria N (t) tiene distribución de Poisson de parámetro t. Por (ii) tenemos que N (t) N (0) P ( (t 0)), y por (i) tenemos que N (0) 0, lo que nos dice que N (t) P ( t). Ahora, 80 < s < t tenemos por (ii) que N (t) N (s) P ( (t s)) y por lo anterior, N (t s) P ( (t s)): Podemos darnos cuenta entonces que la 6 0g distribución del incremento N (t) N (s) y la de la variable aleatoria N (t es la misma. Además esto nos dice que P(N (t) N (s) 0) = 1, pues P(N (t) N (s) 0) = 1 X P(N (t) s) N (s) = k) = 1, k=0 esto es, la distribución sólo depende de la longitud del intervalo t s. Esta propiedad se conoce como propiedad de incrementos estacionarios. Notemos además que esta propiedad nos garantiza que el proceso es no decreciente. 5. Algunas variables aleatorias de interés 5.1. Tiempos de llegada Podemos darnos ahora una idea de cómo se ven las trayectorias de un proceso de Poisson, y una pregunta que debemos hacernos es ¿qué distribución tienen los tiempos de llegada del proceso?, entendiendo por tiempos de llegada los tiempos en los que ocurre un éxito. Para poder ver la distribución de los tiempos de llegada, es necesario asociarles una variable aleatoria. Queremos que el tiempo del primer éxito sea el t más pequeño para el que N (t) = 1, esto es, podemos de…nir el tiempo del primer éxito como T1 = nf ft 0; N (t) = 1g . Ahora, queremos que dado un m 1 el m-ésimo tiempo de llegada sea el t más pequeño para el que N (t) = m, entonces podemos de…nir el tiempo del m-ésimo éxito de la misma forma que antes, pues el proceso es no decreciente, Tm = nf ft 0; N (t) = mg . La pregunta ahora es ¿son T1 ; T2 ; : : : ; Tm ; : : : variables aleatorias? Proposición 1 8t 0 y 8m > 0 tenemos que fTm tg = fN (t) mg. Demostración. Recordemos que fN (t) mg = f! 2 : N (t)(!) mg y fTm tg = f! 2 : Tm (!) tg. Sean t 0 y m > 0. Por de…nición Tm = nf fk 0 : N (k) = mg, esto es, para un ! 2 dado tenemos que Tm (!) = nf fk 0; N (k)(!) = mg. En particular N (Tm (!))(!) = m. Sea ! 0 2 fN (t) mg. Entonces N (t)(! 0 ) m ) N (t)(! 0 ) N (Tm (! 0 ))(! 0 ). Luego, como N (t) es no decreciente, tenemos que t fTm tg. ) fN (t) mg fTm tg. 7 Tm (! 0 ), es decir ! 0 2 Sea ! 0 2 fTm tg. Entonces Tm (! 0 ) es decir, ! 0 2 fN (t) t ) N (Tm (! 0 ))(! 0 ) ) m N (t)(! 0 ) ) fTm tg fN (t) mg. ) fTm tg = fN (t) mg N (t)(! 0 ) mg: Corolario 1 8m > 0 tenemos que Tm es una variable aleatoria.2 Ahora que ya vimos que los tiempos de llegada son variables aleatorias, veamos qué distribución tiene el primer tiempo de llegada. Proposición 2 T1 tiene distribución exponencial de parámetro Demostración. Como fT1 tg = fN (t) t) P(T1 lo que nos dice que T1 1g, = P(N (t) = 1 = 1 = 1 > 0.3 1) P(N (t) = 0) e t ( t)0 0! e t, E( ). Corolario 2 El tiempo esperado de la primera llegada es E(T1 ) = 1 . Proposición 3 La v.a. Tm tiene distribución G m; fTm (t) = 1 (m) m 1 e 0 2 Recordar t 1 . si t 0 . de otra forma de…nición de variable aleatoria. que Runa variable aleatoria X tiene distribución exponencial de parámetro > 0 si P (X x) = 0x f (t) dt, con f (t) = e t . 3 Recordemos 8 Demostración. De la proposición 1 tenemos t) P(Tm = P(N (t) = 1 = m) P(N (t) m X1 1 m 1) P(N (t) = k) k=0 = m X1 ( t)k 1 t e k! k=0 Derivando obtenemos fTm (t) d dt = = e m X1 k=0 = t e e ( t) k! m X1 ( t)k k! k=0 m 1 t = e = 1 (m) ( t) (m 1)! m m 1 t ! t m X1 k 1 k k=1 k k=0 = ( t)k k! ( t)k k! m X1 t e m X1 k=0 t e t m X1 ( t) k! ! k 1 ( t) (k 1)! k=1 ! m X2 ( t)k k! k=0 e que es la función de densidad de una v.a. con distribución G m; 5.2. . Tiempos entre llegadas De…nición 4 (Tiempo entre llegadas) t 4 = nf fs > t : N (s) Teorema 3 8n 1, las v.a. 1 , distribución exponencial E( ). 2, : : :, n N (t) = 1g son independientes y con la misma Demostración. Veamos primero el caso cuando n = 2. Queremos demostrar que 80 < s1 < s2 < 1 se tiene que P( 4 (¡!) 1 1 s1 ; 2 < s2 ) = P( Checar que esté bien de…nido... 9 1 s1 )P( 2 s2 ). P( 1 s1 ; 2 s2 ) = P(T1 s1 ; T2 T1 = P(T1 s1 ; T2 s2 + T1 ) = P(T1 s1 ; T2 s1 + s2 ) = P(N (s1 ) 1; N (s1 + s2 ) 2) 1 X P(N (s1 ) = k1 ; N (s1 + s2 ) = k1 =1 1 X = k1 =1 1 X P(N (s1 ) = k1 ; N (s1 + s2 ) = k2 ) 1 X P(N (s1 ) = k1 ; N (s1 + s2 ) = k2 ) k1 =1 k2 =k1 +1 1 1 X X = 2) k2 =2 k1 <k2 1 X = s2 ) P(N (s1 ) = k1 ; N (s1 + s2 ) N (s1 ) = k2 k1 =1 k2 =k1 +1 por incrementos independientes P( 1 s1 ; 2 1 X s2 ) = 1 X P(N (s1 ) = k1 )P(N (s1 +s2 ) N (s1 ) = k2 k1 ) k1 =1 k2 =k1 +1 usando la propiedad de incrementos estacionarios P( 1 s1 ; s2 ) 2 1 X = 1 X P(N (s1 ) = k1 )P(N (s2 ) = k2 k1 =1 k2 =k1 +1 1 1 X X k1 ) P(N (s1 ) = k1 )P(N (s2 ) = k2 ) = k1 =1 k2 =1 = 1 X ! P(N (s1 ) = k1 ) k1 =1 = (1 = 1 P(N (s1 ) = 0) (1 e s1 1 1 X P(N (s2 ) = k2 ) k2 =1 ! P(N (s2 ) = 0) s2 e Hasta ahora hemos demostrado que 80 < s1 < 1 y 80 < s2 < 1 P( s1 ; 1 pero ya sabemos que T1 P( 1 s1 ; 2 s2 ) = 1 e s1 1 s2 e , (2) E( ), entonces 2 s2 ) = P(T1 s1 ) 1 e s2 = P( s1 ) 1 e s2 10 1 . k1 ) Del lado izquierdo de (2) tenemos l m P( 1 s1 "1 s1 ; s2 ) = P( 2 s2 ), 2 y como l m P(T1 s1 ) = 1, s1 "1 tenemos que P( s2 ) = 1 2 ) s2 e 80 < s1 < 1 E( ). 2 Entonces P( esto es, E ( ). 1 1 y 1 s1 ; 2 s2 ) = P ( s1 ) P ( 1 son independientes y tienen la misma distribución exponencial 2 Veamos ahora el caso para n 2. Supongamos que 1 ; 2 ; : : : ; n son independientes y que i n, esto es, 8 0 < s1 < s2 < < sn < 1 tenemos que P( 1 si ; 1 i n) = n Y ( n Y si ) = i i=1 Queremos demostrar que E( ). Sean 0 < s1 < s2 < P( s2 ) , 2 i s1 ; 1 i n + 1) 1; Ti = P (Ti 0 si + Ti = = P @Ti si ; 1 i n + 1) ;1 i n + 1) 1 i 1 X i X i sj ; 1 0 1 i X P @N @ sj A j=1 X <kn+1 X <kn+1 X <kn+1 11 0 i; 1 P @N @ 0 i X j=1 i 1 sj A 0 1 i X P @N @ sj A 0 1 n + 1A n + 1A i 0 n+1 1 j=1 0 1 k1 < sj ; 1 j=1 P @Ti 1 k1 < = 1 si + 0 1 k1 < = . 2 ; : : : ; n ; n+1 son independientes y que < sn < sn+1 < 1. Entonces P (Ti = si e i=1 = = 1 E( ) para i j=1 0 1 i X P @N @ sj A j=1 1 n + 1A ki ; 1 ki ; 1 i i 1 n + 1A n + 1A 0 1 i 1 X N@ sj A j=1 1 ki i 1 X j=1 kj ; 1 i 1 n + 1A por incrementos independientes P( s1 ; 1 i i n+1 Y X n+1) = 1 k1 < <kn+1 i=1 por incrementos estacionarios P( s1 ; 1 i i 0 0 1 i X P @N @ sj A n + 1) = j=1 P @N (si ) <kn+1 i=1 1 k1 < haciendo cambio de variable P( s1 ; 1 i i n + 1) = j=1 0 n+1 Y X 0 1 i 1 X N@ sj A 1 X n+1 Y ki j=1 P (N (si ) k1 ;:::;kn+1 =1 i=1 n+1 Y = 1 X i=1 n+1 Y = 1 kj A ki ) ! P (N (si ) k) k=1 (1 i 1 X P (N (si ) = 0)) i=1 n+1 Y = 1 si e i=1 Hemos demostrado hasta ahora que P( si ; 1 i i n + 1) = n+1 Y 1 si e i=1 y como por hipótesis tenemos que P( si ; 1 1 i n) = n Y 1 si e i=1 entonces P( i si ; 1 i n Y n + 1) = P( i ! si ) i=1 1 e sn+1 . Tomando límites de ambos lados l m P( s !1 i i si ; 1 i n + 1) = lm s !1 i n Y P( 1 i n i=1 1 i n P( n+1 sn+1 ) = 12 1 e sn+1 . i si ) 1 e sn+1 ki i 1 X j=1 1 kj A Por lo tanto, 8 n 1, las variables aleatorias 1 ; : : : ; tienen la misma distribución exponencial E ( ). n son independientes y No es difícil convencerse de que Tm = m X k, (3) k=0 entonces, como E ( ) = G 1; 1 y la suma de n variables aleatorias independientes con la misma distribución G (k; ) tiene distribución G (nk; ), tenemos que 1 Tm G m; . Ejercicio 4 Probar (3). 5.3. Tiempo de próxima ocurrencia De…nición 5 (Tiempo de próxima falla) Dado un tiempo t queremos estudiar el tiempo que tardaremos en tener otra falla. De…namos t := nf fs 0 ; N (s + t) N (t) = 1g como el tiempo de la primera falla a partir del tiempo t. Proposición 4 t tiene distribución exponencial E( ) independiente de t. Demostración. Sea g(s) = 1 P ( t s) = P ( t > s). Observemos que f t > sg = f t > t + sg 8 s < t. g(s + h) = P( t > s + h) = P( t > t + s + h) = P( t > t + s ; N (t + s + h) N (t + s) = 0) . El evento f t s + tg depende de lo que pasa hasta el tiempo t + s5 y por la propiedad de incrementos independientes, es independiente de lo que ocurre en el intervalo (t + s; t + s + h]. Esto nos dice que f t s + tg, y fN (t + s + h) N (t + s) = 0g son independientes, y por lo tanto f t > s + tg yfN (t + s + h) N (t + s) = 0g también lo son6 . Entonces tenemos g (s + h) = P( t > t + s) P (N (t + s + h) = P( t > s) P (N (h) = 0) = g(s)e h N (t + s) = 0) . 5 Esto es lo que se conoce como tiempo de paro. que si dos eventos A y B son independientes, entonces AC y B son independientes, A y B C son independientes y AC y B C son independientes. 6 Recordemos 13 Así, h g(s) e g(s + h) g(s) = h h y tomando límites nos queda que g 0 (s) = lm h g(s) e 1 h h!0 h e = g (s) l m 1 h h!0 = 1 g (s) . Sabemos que las únicas soluciones para g 0 (s) = s g (s) = ke g (s) son de la forma k 2 R; y también que g (0) = P ( t > 0) = 1. Entonces P( t s > s) = e , por lo tanto P( Esto es, 8t t t s) = 1 s e s > 0. tiene distribución exponencial E ( ). Proposición 5 Una variable aleatoria X con distribución exponencial de parámetro > 0, tiene la propiedad de pérdida de memoria. Esto es P (X > t + s j X > s) = P (T > t) . Demostración. Observemos que 8 t 0 t P (X > t) = e , pues tenemos que P (X Sean s; t t) = 1 t e . 0. Entonces P (T > t + s j T > s) = = = P (T > t + s ; T > s) P (T > s) P (T > t + s) P (T > s) (t+s) e = e s e t = P (T > t) . Por lo tanto X E ( ) tiene la propiedad de pérdida de memoria. 14 Proposición 6 Un proceso de Poisson de parámetro de pérdida de memoria. 5.4. > 0, tiene la propiedad Tiempo desde última falla De…nición 6 (Tiempo desde última falla) Dado un tiempo t queremos estudiar el tiempo que ha pasado desde la última falla. De…namos lt := nf fs 0 : N (t) N (t s) = 0g como el tiempo desde que ocurrió la última falla. Proposición 7 La distribución de lt es la siguiente: P (lt = t) = e P (lt s) = 1 t . e s 80 s < t. Demostración. Se deja como ejercicio checar que lt esté bien de…nida y es variable aleatoria. En el primer caso tenemos que P (lt = t) = P (N (t) N (t t) = 0) = P (N (t) = 0) = P (T1 = e t . En el segundo caso tenemos que si 0 P (lt t) s) = P (N (t) s<t N (t s) 1) y P (lt > s) = P (N (t) N (t s) = 0) = P (N (s) = 0) = P (T1 = e s s) , entonces P (lt s) = 1 e s Observemos que la distribución de la proposición anterior es tal que tiene un salto en t y de otra forma tiene densidad. Es un ejemplo de una distribución que tiene una parte discreta y otra parte continua. 15 6. Simulación de un Proceso de Poisson Proposición 8 Sean U U (0; 1) y > 0. Entonces 1 ln (1 x x 0 0. U) E ( ). Demostración. Queremos demostrar que 1 P 1 P ln (1 ln (1 U) x U) 1 0 = x x e = P (ln (1 U) x) = P 1 U e x = P U 1 e x . Recordemos que x 0 FU (x) = 0 x 1 en otro caso, entonces P U como queríamos. Por lo tanto 1 ln (1 1 U) e x = 1 0 e x x x 0 0, E ( ). La proposición anterior nos muestra un método para simular en una computadora una variable aleatoria con distribución E ( ) usando un generador de números aleatorios uniforme en (0; 1). Entonces, como en un proceso de Poisson Pm de parámetro > 0, m E ( ) y Tm = k=0 k , podemos simular los tiempos de llegada como una suma de variables aleatorias exponenciales E ( ). 7. De…nición equivalente De…nición 7 (Proceso de Poisson homogéneo) Una colección de variables aleatorias fN (t) ; t 0g es un Proceso de Poisson homogéneo de parámetro > 0 si: 1. P (N (0) = 0) = 1. 2. N (t) tiene incrementos estacionarios. 3. N (t) tiene incrementos independientes. 4. Para h pequeña: a) P (N (t + h) N (t) = 1) = h + o (h). 16 b) P (N (t + h) N (t) > 1) = o (h). Observaciones: La condición 4.a nos dice que la probabilidad de que ocurra exactamente un evento en un intervalo de tiempo pequeño, es "proporcional.a la longitud del intervalo. La condición 4.b nos dice que la probabilidad de que ocurran dos o más eventos en un intervalo de tiempo pequeño es despreciable. Teorema 4 Las de…niciones 3 y 7 son equivalentes. Demostración. Veamos primero que (3))(7). En la sección 4 vimos que de acuerdo con la de…nición 3, un proceso de Poisson homogéneo tiene la propiedad de incrementos estacionarios, esto es (3))(7.2) Falta ver que (3))(7.4). a) P (N (t + h) N (t) = 1) = P (N (h) = 1) = ( h) e = h h+ h e h 1 Luego, como lm h h e 1 h h!0 = lm e h h!0 1 = 0, tenemos que P (N (t + h) N (t) = 1) = h + o (h) . b) P (N (t + h) N (t) > 1) = P (N (h) > 1) 1 h X k e = ( h) k! k=2 y como k e lm h!0 ( h) hh k! h tenemos que lm h!0 esto es, = l m hk k! h!0 1 X k ( h) k=2 P (N (t + h) 1 e hk =0 k h e k! = 0, N (t) > 1) = o (h) . 17 2 Por lo tanto (3))(7). Veamos ahora que (7))(3). Falta ver que (7))(3.ii). De…namos una función f (t; n) := P (N (t) = n) . Veamos que f (t; 0) = e f (t + h; 0) h . = P (N (t + h) = 0) = P (N (t) = 0 ; N (t + h) = P (N (t) = 0) P (N (t + h) = f (t; 0) (1 P (N (t + h) = f (t; 0) (1 (P (N (t + h) = f (t; 0) (1 (( h + o (h)) + o (h))) = f (t; 0) (1 ( h + o (h))) = f (t; 0) (1 h + o (h)) . N (t) = 0) N (t) = 0) N (t) 1)) N (t) = 1) + P (N (t + h) Tenemos entonces lm h!0 f (t + h; 0) h f (t; 0) f 0 (t; 0) = f (t; 0) ( lm h!0 = h + o (h)) h f (t; 0) , de donde f (t; 0) = e t . Notemos que 8n > 1 d f (t; n) = dt (f (t; n 18 1) f (t; n)) . N (t) > 1))) f (t + h; n) = P (N (t + h) = n) n X = P (N (t) = n k ; N (t + h) = k=0 n X P (N (t) = n N (t) = k) k) P (N (t + h) N (t) = k) k=0 = P (N (t) = n) P (N (t + h) N (t) = 0) + P (N (t) = n n X + P (N (t) = n k) P (N (t + h) N (t) = k) 1) P (N (t + h) k=2 = f (t; n) (1 P (N (t + h) N (t) 1 X e t n k o (h) ( t) + (n k)! 1)) + f (t; n 1) ( h + o (h)) k=2 = f (t; n) (1 (P (N (t + h) + h f (t; n = f (t; n) (1 N (t) = 1) + P (N (t + h) N (t) > 1))) 1) + o (h) (( h + o (h)) + o (h))) + h f (t; n = f (t; n) + h (f (t; n 1) 1) + o (h) f (t; n)) + o (h) . Entonces lm h!0 f (t + h; n) h f (t; n) d f (t; n) dt Veamos ahora que 8n d dt n+1 ( t) e t (n + 1)! = = lm h (f (t; n 1) f (t; n)) + o (h) h h!0 (f (t; n 1) t n e 0, f (t; n) = ( t) n! f (t; n)) . . n+1 = d n+1 t e (n + 1)! dt t n+1 = = (n + 1)! ( t) n (n + 1) tn e t e n! t n+1 ( t) tn+1 e t e t (n + 1)! Luego, por el Teorema de Existencia Unicidad de solución de ecuaciones diferenciales, tenemos el resultado. Por lo tanto fN (t) ; t 0g es un Proceso de Poisson de parámetro (de acuerdo con las de…nición (3). ) Las dos de…niciones son equivalentes. 19 N (t) = 1) 8. Combinación de Procesos de Poisson Teorema 5 Sean fN1 (t) ; t 0g y fN2 (t) ; t 0g procesos de Poisson independientes con parámetros 1 y 2 respectivamente. Sea N (t) = N1 (t) + N2 (t) ; t 0. Entonces fN (t) ; t 0g es un proceso de Poisson de parámetro 1 + 2. Demostración. ClaramentePN (0) 0. Pn n Recordemos que si Sn = i=1 Xi y Xi P ( i ), entonces Sn P ( i=1 i ). Entonces 8t 0 tenemos que N (t) P (t ( 1 + 2 )). Recordemos también que si tenemos fAi g y fBi g dos sucesiones de variables aleatorias independientes, independientes entre sí, entonces fAi + Bi g es una sucesión de variables aleatorias independientes. Esto nos dice que N (t) tiene incrementos independientes, pues dados t0 = 0 < t1 < t2 < < tn tenemos que fNi (tj ) Ni (tj 1 ) ; j = 1; : : : ; ng i = 1; 2 son independientes, y por tanto N (tj ) N (tj 1 ) ; j = 1; : : : ; n también lo son. Por lo tanto fN (t) ; t 0g es un Proceso de Poisson de parámetro 1 + 2 . Corolario 3 Sean fN1 (t) ; t 0g ; fN2 (t) ; t 0g ; : : : ; fNn (t) ; t 0g procesos de Poisson con parámetros 1 ; 2 ; : : : ; n respectivamente. Pindependientes n Sea N (t) = N (t) ; t 0. Entonces fN (t) ; t 0g es un proceso de k=1 kP n Poisson de parámetro k=1 k . 9. Proceso de Poisson compuesto De…nición 8 (Proceso de Poisson Compuesto) Sea fXi gi 1 una sucesión de variables aleatorias independientes idénticamente distribuidas e independientes del proceso de Poisson fN (t) ; t 0g de parámetro . El proceso N (t) X (t) = X Xi i=1 se llama proceso de Poisson compuesto. Teorema 6 Sea fN (t) ; t 0g un proceso de Poisson de parámetro . Supongamos que cada llegada es de tipo 1 con probabilidad p1 o de tipo 2 con probabilidad p2 = 1 p1 , independiente de las demás llegadas. Sea Ni (t) el número de llegadas del tipo i hasta el tiempo t. Entonces fN1 (t) ; t 0g y fN2 (t) ; t 0g son procesos de Poisson independientes con parámetros p1 y p2 respectivamente. 20 Demostración. Sea f k gk parámetro p1 . Entonces 0 una sucesión de variables aleatorias Bernoulli de N (t) N1 (t) = X k k=1 y N (t) N2 (t) = X (1 k) = N (t) N1 (t) . k=1 Es claro que N1 (t) y N2 (t) tienen incrementos independientes y estacionarios, pues N (t) los tiene. Además también es fácil darse cuenta de que P (Ni (t + h) o (h), pues P (N (t + h) N (t) > 1) = o (h) y Ni (h) = s ) N (t) s. Veamos que para h pequeña P (N1 (t + h) N1 (t) = 1) = p1 h + o (h). 0 1 N (t+h) N (t) X X A P (N1 (t + h) N1 (t) = 1) = P @ k k =1 0 k=1 k=1 1 N (t+h) = P@ X = 1A k N (t)+1 = P (N (t + h) N (t) = 1 ; = P (N (t + h) 0g y fN2 (t) ; t ( h + o (h)) p1 = p1 h + o (h) . s1 ; N2 (t) s2 ) = 1) k = 1) N2 (t) = 1) = p2 h + o (h). 0g son Procesos de Poisson con parámetros p1 y p2 . Veamos ahora que son independientes. Sea t P (N1 (t) k N (t) = 1) P ( = Similarmente podemos ver que P (N2 (t + h) ) fN1 (t) ; t Ni (t) > 1) = = = s1 X 0 y s1 ; s2 2 R. P (N1 (t) = k1 ; N2 (t) k1 =0 s1 X s2 X s2 ) P (N1 (t) = k1 ; N2 (t) = k2 ) k1 =0 k2 =0 como sabemos que N1 (t) + N2 (t) = N (t) P (N1 (t) = k1 ; N2 (t) = k2 ) = P (N1 (t) = k1 ; N2 (t) = k2 j N (t) = k1 + k2 ) P (N (t) = k1 + k2 ) y P (N1 (t) = k1 ; N2 (t) = k2 j N (t) = k1 + k2 ) = 21 k1 + k2 k1 k2 p1 p2 k1 entonces P (N1 (t) s1 ; N2 (t) s2 ) s2 s1 X X = = = = e t k1 + k2 k1 k2 k +k p1 p2 ( t) 1 2 k1 (k1 + k2 )! k1 =0 k2 =0 s2 s1 X X k1 =0 k2 =0 s2 s1 X X k1 =0 k2 =0 s2 s1 X X 1 k k pk1 ( t) 1 pk22 ( t) 2 e k1 !k2 ! 1 ( p1 t) k1 p1 t e k1 ! = P (N1 (t) = k1 ) k1 =0 = k2 e p2 t k2 ! P (N1 (t) = k1 ) P (N2 (t) = k2 ) k1 =0 k2 =0 s1 X ( p2 t) (p1 +p2 )t P (N1 (t) ! s1 ) P (N2 (t) Por lo tanto fN1 (t) ; t 0g y fN2 (t) ; t dependientes con parámetros p1 y p2 . s2 X ! P (N2 (t) = k2 ) k2 =0 s2 ) . 0g son procesos de Poisson in- Corolario 4 Sea fN (t) ; t 0g un proceso de Poisson de parámetro . Sea 1 fXk gk=1 una sucesión de variables aleatorias independientes con la misma disn tribución discreta fpk gk=1 . Supongamos que cada llegada es de tipo i con probabilidad pi , independiente de las demás llegadas. Sea Ni (t) el número de llegadas del tipo i hasta el tiempo t. Esto es N (t) Ni (t) = X i Xk k=0 donde ij = 0 1 si i 6= j si i = j. Entonces fN1 (t) ; t 0g ; : : : ; fNn (t) ; t 0g son procesos de Poisson independientes con parámetros p1 ; : : : ; pn respectivamente. 10. Proceso de Poisson no homogéneo De…nición 9 (Proceso de Poisson no homogéneo con intensidad (t)) Una colección de variables aleatorias fN (t); t 0g se llama proceso de Poisson no homogéneo con intensidad (t) si satisface las siguientes propiedades: a) P(N (0) = 0) = 1. 22 b) N (t) tiene incrementos independientes. k e c) 8 0 < s < t se tiene que P (N (t) N (s) = k) = ( (t) (s)) k = 0; 1; 2; : : :. Esto es N (t) N (s) P ( (t) (s)), donde decreciente y (0) = 0. ( (t) (s)) k! (t) es no Veamos la distribución del tiempo del primer evento (T1 ) en un proceso de Poisson de intensidad (t). P (T1 t) = P (N (t) = 1 P (N (t) = 0) 1) = 1 e (t) FT1 (x) = 1 e (t) . Esto es Si (t) es diferenciable en t con derivada fT1 (t) = (t) e . (t), entonces (t) . Notemos que un Proceso de Poisson homogéneo es un caso particular de un Proceso de Poisson no homogéneo, tomando (t) = t. En general es usual proponer Z t (t) = (s) ds, 0 donde (s) 0 8 s. 23