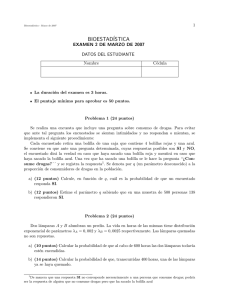

La-interpretacion-de-los-datos-Una-introduccion-a-la-estadistica-aplicada-pdf

Anuncio