Notas sobre convergencia y funciones generatrices

Anuncio

Notas sobre convergencia y funciones generatrices

Universidad Carlos III de Madrid

Abril 2013

Para modelar un fenómeno aleatorio que depende del tiempo, podemos considerar sucesiones

de variables X1 , X2 , . . . donde Xi modela el estado del fenómeno a tiempo i. El conjunto de ı́ndices

puede representar unidades de tiempo, iteraciones de un proceso, etc. Es natural que en este tipo

de situaciones, si queremos tener una información que no dependa del tiempo, nos preguntemos

acerca del comportamiento de Xn cuando n → ∞. Antes de formalizar esta idea consideremos el

siguiente ejemplo.

Ejemplo. Supongamos que lanzamos un dado n veces, n un número muy grande, y observamos

que el promedio de los números observados es an = 3,500867. Al comparar este valor con el

valor esperado de la variable aleatoria que modela el número observado al lanzar un dado al azar,

1

6 (1 + 2 + . . . + 6) = 3,5, podemos ver que están muy cerca. Es natural conjeturar que

an → 3,5 cuando

1.

n→∞

Desigualdad de Chebyshev y Ley de Grandes Números

Varios resultados de la teorı́a de probabilidad establecen condiciones para probar conjeturas del tipo ”si repetimos un experimento muchas veces entonces el promedio de los resultados se aproxima

al valor esperado”.

Teorema (Desigualdad de Markov). Sea X una variable aleatoria y g una función positiva entonces, para todo ε > 0,

E(g(X))

P(g(X) ≥ ε) ≤

ε

Prueba. Supongamos que X es continua, el caso discreto es similar.

Z

Z

E(g(X)) =

g(x) f (x)dx +

{x:g(x)≥ε}

≥

Z

g(x) f (x)dx

{x:g(x)≥ε}

≥ ε

g(x) f (x)dx

{x:g(x)<ε}

Z

f (x)dx

{x:g(x)≥ε}

= εP(g(X) ≥ ε)

1

Un caso particular de la desigualdad de Markov es la súper conocida Desigualdad de Chebyshev.

Corolario. Si X es una variable aleatoria con E(X) = µ entonces

1

P(|X − µ| ≥ ε) ≤ 2 Var(X)

ε

Prueba

P(|X − µ| ≥ ε) = P(|X − µ|2 ≥ ε2 ) ≤

1

1

E((X − µ)2 ) = 2 Var(X)

2

ε

ε

Esta desigualdad es muy útil para aproximar cuán concentrada está una variable alrededor de

su valor esperado.

Sean X1 , X2 , . . . , Xn variables i.i.d. con E(Xi ) = µ y Var(Xi ) = σ2 . Denotemos el promedio muestral por

Sn X1 + X2 + . . . + Xn

Xn =

=

.

n

n

Ya que

E(X n ) = E(

y

X1 + X2 + . . . + Xn

1

) = nµ

n

n

σ2

1

Var(X

+

X

+

.

.

.

+

X

)

=

,

n

1

2

n2

n

usando la desigualdad de Chebyshev se tiene que

Var(X n ) =

1 σ2

ε2 n

Decimos que Xn converge en probabilidad a X si para todo ε > 0,

P(|X n − µ| ≥ ε) ≤

P(|Xn − X| ≥ ε) −→ 0 cuando n −→ ∞.

Teorema (Ley Débil de Grande Números). Sean X1 , X2 , . . . , Xn variables i.i.d. con E(Xi ) < ∞,

entonces el promedio muestral X n converge en probabilidad a µ.

La Ley Débil de Grandes Números ofrece un potente método de estimación conocido como el

Método de Monte Carlo. El siguiente ejemplo ilustra la idea básica del método.

Ejemplo. Sea (X,Y ) un vector aleatorio distribuı́do uniformemente en el rectángulo B = [0, a] ×

[0, b]. Sea A un área contenida en B, ası́,

|A|

ab

Para estimar p, generamos puntos (X1 ,Y1 ), . . . , (Xn ,Yn ) i.i.d. U[0, a] × [0, b] y consideramos la v.a.

Bernoulli

p = P((X,Y ) ∈ A) =

Zi = 1 si (Xi ,Yi ) ∈ A

= 0 en caso contrario

Es fácil verificar el promedio Z n converge en probabilidad a p.

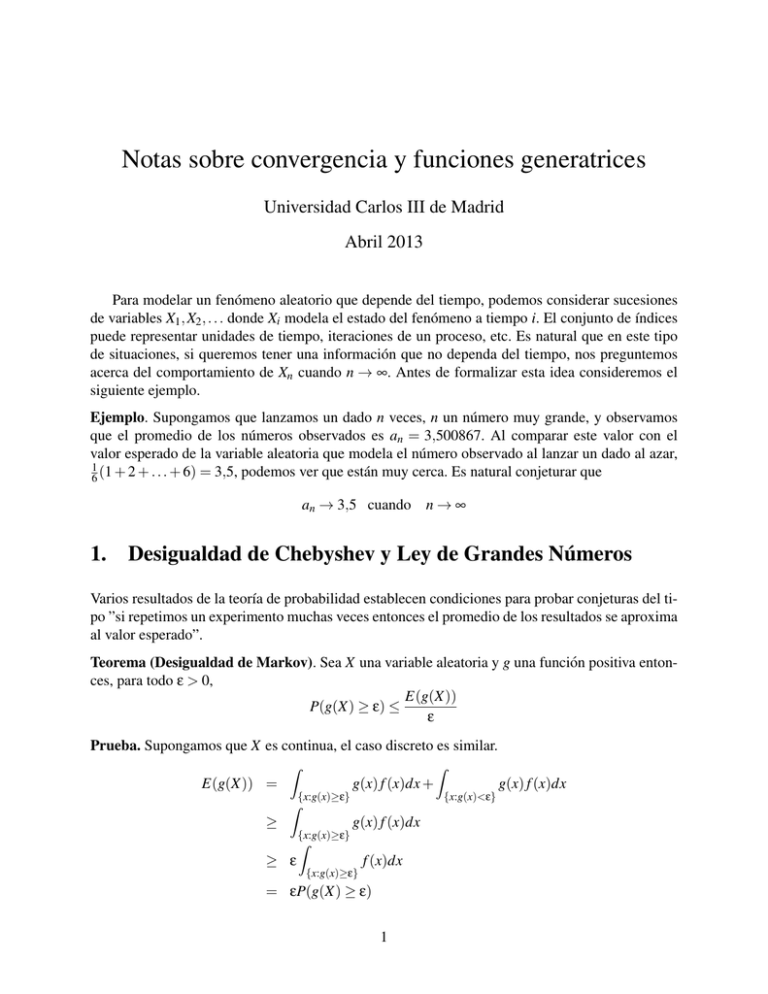

2

6

0.6

5

0.5

0.4

4

3.5

0.3

3

0.2

2.

0

100

2,5

0

200

100

200

Función generatriz de momentos

Hemos visto que la esperanza y la varianza dan información acerca de la v.a. Para obtener esta

información necesitamos calcular E[X] y E[X 2 ]. El momento de orden k no es más que la extensión

de esta idea para tener más información acerca de la variable.

Definición. El momento de k-ésimo orden de una v.a. X es E[X k ] siempre y cuando E[|X|k ] < ∞.

Ejemplo: Si X tiene distribución Gamma(n, β) entonces el momento de orden k es

k

Z ∞

E[X ] =

0

n(n + 1) . . . (n + k − 1)

βn −βx

e dx =

x

Γ(n)

βk

k

Ejemplo: Si X tiene distribución Cauchy entonces

k

Z ∞

E[X ] =

xk

−∞

1

dx

π(1 + x2 )

En vista de que la integral no converge en valor absoluto para ningún k ≥ 1 decimos que la distribución de Cauchy no tiene momentos.

Un criterio útil para garantizar la existencia de momentos es:

E[|X|k ] < ∞ implica E[|X|r ] < ∞ para 1 ≤ r ≤ k

En particular, cuando digamos que Var(X) < ∞, estaremos diciendo que los momentos de primer

y segundo orden existen.

Si lo que estamos buscando es obtener información de una variable; formalmente de la distribución de probabilidad; a través de sus momentos, parece natural construir una función que

reproduzca el valor de todos los momentos si es que existen.

Definición. La función generatriz de momentos de una v.a. X es la función

MX (t) = E[e−tX ] para todo t para el cual la esperanza existe

Ejemplo: Si X tiene distribución Gamma(n, β) entonces

n

β

MX (t) =

para t ≤ β

β−t

3

Ejemplo: Si X tiene distribución Cauchy entonces MX (t) sólo está definida para t = 0.

Ejemplo: Si X tiene distribución Normal(µ, σ2 ) entonces

MX (t) = eµt+σ

2 t 2 /2

para todo t ∈ R

Ejemplo: Si X tiene distribución Poisson(λ) entonces

t

MX (t) = e−λ(1−e ) para todo t ∈ R.

Volviendo a nuestro problema, ¿cómo reproducir los momentos de una v.a. a partir de su función generatriz?. El siguiente teorema responde la pregunta.

Teorema. Si MX existe en un entorno de 0, entonces para cualquier k ≥ 1

E[X k ] =

dk

MX (0)

dt k

La prueba formal de este teorema se escapa del alcance de estas notas. La idea básica es la siguiente:

La esperanza es una sumatoria o una integral dependiendo cual sea el caso que estemos estudiando. Estos operadores (sumatoria e integral) conmutan, bajo condiciones de regularidad, con el

operador derivada (¿puede el lector construir ejemplos concretos donde esto ocurre?). Ası́ resulta

que

dk

dk

d k tX

tX

M

(t)

=

E[e

]

=

E[

e ] = E[X k etX ]

X

dt k

dt k

dt k

evaluando la identidad anterior en t = 0 obtenemos el resultado del teorema.

Más que reproducir los momentos de una distribución, la función generatriz provee una manera

de caracterizar distribuciones de probabilidad, tal y como lo expresa el siguiente teorema.

Teorema. Si MX existe en un entorno de 0, entonces hay una única distribución con función generatriz MX . Además, bajo esta condición todos los momentos existen, no importa el orden, y el

desarrollo de Taylor de la función generatriz es

tk

∞

MX (t) =

∑ E[X k ] k!

k=0

Del teorema anterior podemos observar que no basta conocer todos los momentos para caracterizar una distribución, es necesario que la serie

∞

∑ E[X k ]

k=0

tk

k!

converja en un entorno de cero, tal como aparece en la hipótesis del teorema.

La prueba de este teorema se basa en propiedades de la transformada de Laplace y la omitiremos, sin embargo, su aplicación es de gran utilidad al conectarla con las siguientes propiedades:

4

Para números a, b se tiene

MaX+b (t) = E[e(aX+b)t ] = ebt E[eatX ] = etb MX (at)

Si X,Y son independientes entonces

MX+Y (t) = E[et(X+Y ) ] = E[etX etY ] = E[etX ]E[etY ] = MX (t)MY (t)

Usando recursivamente la propiedad anterior, si X1 , . . . , Xn son independientes, entonces

MX1 +...+Xn = MX1 . . . MXn

Ejemplo: Sean X1 , . . . , Xn v.a.i.i.d. Exponenciales(β). ¿Cuál es la distribución de la suma Sn =

X1 + . . . + Xn ?. Sabiendo que la función generatriz de una exponencial es

MX1 (t) =

β

para t ≤ β

β−t

podemos usar las propiedades enunciadas y verificar que

n

β

MSn (t) =

para t ≤ β

β−t

que corresponde a la función generatriz de una Gamma(n, β). Usando el teorema anterior podemos

concluir que la suma de n exponenciales i.i.d de parámetro β tiene distribución Gamma(n, β).

El lector puede usar esta técnica para probar los siguientes resultados:

sumas de normales independientes es normal

sumas de Poisson independientes es Poisson

En general, pruebe que si (MX (t))1/n es la función generatriz de una v.a. Z, entonces sumas de

n réplicas independientes de Z se distribuye como X.

3.

Función caracterı́stica

Como vimos, la función generatriz ofrece un poderoso método para identificar distribuciones

de probabilidad. El problema es que la función generatriz no siempre existe, como es el caso de

la Cauchy. La clase de distribuciones para la cual no existe es suficientemente grande como para

necesitar una alternativa. Usando la fórmula de Moivre

√

eiω = cosω + isenω, con i = −1

es fácil ver que

MX (iω) = E[cos(ωX)] + iE[sen(ωX)]

Ya que las funciones coseno y seno son acotadas, la función

φX (ω) = MX (iω)

5

siempre existe y tiene propiedades equivalentes a las de la función generatriz. Por lo cual conviene

introducir la siguiente definición

Definición. La función caracterı́stica de una v.a. X es la función

φX (ω) = E[eiωX ]

En estas notas, suponemos que el lector no está familiarizado con el cálculo en variable compleja.

Para calcular φX (ω) = E[eiωX ], se puede usar la identidad

φX (ω) = MX (t) para t = iω

cuando MX (t) existe.

Ejemplo: Si X tiene distribución Gamma(n, β) entonces

n

β

φX (ω) =

β − iω

Cuando MX (t) no existe, por ejemplo para el caso Cauchy, el uso de tablas para la transformada de fourier puede ser muy útil. Casi cualquier función caracterı́stica ya ha sido tabulada. En

particular, si X es Cauchy,

1

φX (ω) = e−|ω|

2

El hecho de que la función caracterı́stica siempre exista simplifica el criterio de caracterización

análogo al que estudiamos para la función generatriz de momentos.

Teorema. Las v.a. X,Y tienen la misma distribución sı́ y sólo sı́ φX (ω) = φY (ω) para todo ω. Aún

más, si X es continua con densidad de probabilidad f , la siguiente fórmula puede ser usada para

recobrar f a partir de la función caracterı́stica

1

f (x) =

2π

Z +∞

−∞

e−iωx φX (ω)dω

Esta fórmula no es más que la inversa de la transformada de fourier, observando que la función

caracterı́stica

Z +∞

φX (ω) =

e−iωx f (x)dx

−∞

es la transformada de fourier de f .

Para terminar, enunciamos algunas propiedades que el lector puede probar sin dificultad, siguiendo las pruebas análogas para la función generatriz.

Para números a, b se tiene

φaX+b (ω) = eiωb φX (aω)

Si X,Y son independientes entonces

φX+Y (ω) = φX (t)φY (ω)

Usando recursivamente la propiedad anterior, si X1 , . . . , Xn son independientes, entonces

φX1 +...+Xn = φX1 . . . φXn

6

4.

Convergencia en distribución y Teorema Central del Lı́mite

Cuando consideramos sucesiones de variables aleatorias X1 , X2 , . . . es natural preguntarse acerca del comportamiento de Xn cuando n → ∞. En particular, sobre la distribución de probabilidades

de Xn cuando n → ∞. Antes de formalizar esta idea observemos el siguiente ejemplo:

Consideremos la sucesión de variables aleatorias X1 , X2 , . . . con P(Xn = 1n ) = 1. Es decir, con

probabilidad 1, Xn = n1 . Lo natural serı́a que {Xn } converja a una v.a. X que tiene probabilidad 1

de valer 0. Veamos que pasa con las funciones de distribución de estas v.a.

1

n

1

= 1 si x ≥

n

Fn (x) = P(Xn ≤ x) = 0 si x <

F(x) = P(X ≤ x) = 0 si x < 0

= 1 si x ≥ 0

Por otro lado

lı́m Fn (x) = 0 si x ≤ 0

n→∞

= 1 si x > 0

Es decir, con la excepción de 0, que es un punto de discontinuidad de F,

lı́m Fn (x) = F(X).

n→∞

Este ejemplo muestra que los puntos de discontinuidad de la distribución lı́mite deben ser ignorados, lo cual nos lleva a la siguiente definición.

Definición. Consideremos la sucesión de v.a. X1 , X2 , . . . con funciones de distribución F1 , F2 , . . .

respectivamente. Sea X una v.a. con función de distribución F. Diremos que Xn converge en distribución a X, o que Xn → X en distribución, si

lı́m Fn (x) = F(X)

n→∞

para todo x donde F sea continua.

Ejemplo: Considere el mı́nimo Un de n variables i.i.d. uniformes en (0,1). Es fácil intuir que pasa

con Un cuando n → ∞. Ahora bien, ¿qué pasa con nUn cuando n → ∞?. Primero que nada, como

Un ∈ (0, 1), entonces nUn ∈ (0, n) y

x

P(nUn ≤ x) = P Un ≤

para x ∈ (0, n)

n

Usando la definición del mı́nimo y la independencia, la probabilidad anterior puede escribirse

como

h x

x in

1 − P(nUn > x) = 1 − P Un >

= 1− P X >

n

n

7

con X uniforme en (0,1). Sustituyendo,

x n

P(nUn ≤ x) = 1 − 1 −

para x ∈ (0, n)

n

Usando el hecho de que si nan → a entonces

lı́m(1 − an )n = ea

(1)

se obtiene

x n

= 1 − e−x para x ∈ (0, ∞)

lı́m P(nUn ≤ x) = lı́m 1 − 1 −

n

que corresponde a la distribución de una variable exponencial de parámetro 1. Es decir, si X1 , X2 , . . .

son v.a.i.i.d. uniformes sobre (0,1), entonces

nUn → exp(1) en distribución.

Cuando las variables toman valores enteros la convergencia en distribución se reduce a la convergencia de la funciones de masa. El lector no tendrá dificultad en probar la siguiente proposición.

Proposición 1. Si X, X1 , X2 , . . . toman valores enteros y para todo k

lı́m P(Xn = k) = P(X = k)

entonces Xn → X en distribución.

Ejemplo. Considere la sucesión de v.a. {Xn } con Xn binomial(n, pn ). Supongamos que pn → 0

con npn → λ > 0. Es decir, para n grande, Xn es una binomial con muchas repeticiones de un

experimento que tiene muy poco chance de éxito. Podemos probar

lı́m P(Xn = 0) = e−λ

y que

lı́m

P(Xn = k + 1)

= λ(k + 1)

P(Xn = k)

Usando recurrencia, vemos que

lı́m P(Xn = k) = e−λ

λk

k!

que es la función de masa de una Poisson(λ). Es decir,

Xn → Poisson(λ) en distribución.

Los dos ejemplos anteriores muestran la dificultad de probar convergencia en distribución por

definición. El siguiente teorema ofrece un método sencillo de hacerlo

Teorema de continuidad: Sean X1 , X2 , . . . v.a. y φ1 , φ2 , . . . sus respectivas funciones caracterı́sticas. Si

lı́m φn (ω) =: φ(ω) para todo ω ∈ R

8

y φ(ω) es continua en ω = 0, entonces φ es la función caracterı́stica de una v.a. X tal que Xn → X

en distribución.

La prueba de este teorema exige de conocimientos avanzados de análisis matemático, sin embargo el teorema en sı́ es fácilmente intuible, a excepto de la condición técnica φ continua en cero.

Ejemplo: Usar el teorema para probar la convergencia a Poisson del ejemplo anterior. Debemos

probar que

lı́m φn (ω) =: φ(ω) para todo ω ∈ R

Para el ejemplo anterior

φn (ω) = qn + pn eiω

n

iω )

y φ(ω) = e−λ(1−e

Ası́,

lı́m φn (ω) = lı́m qn + pn eiω

n

n

= lı́m 1 − pn (1 − eiω )

n

λ

iω

= lı́m 1 − (1 − e )

n

iω )

= e−λ(1−e

La aplicación por excelencia del teorema de continuidad es el muy famoso

Teorema del Lı́mite Central. Sean X1 , X2 , . . . v.a.i.i.d. con varianza finita σ2 . Denotemos por µ la

esperanza común de las variables. Entonces

X1 + . . . + Xn − nµ

√

→ N(0, σ2 ) en distribución

n

5.

Problemas

1. El número de llamadas que llegan a la central telefónica de Sartenejas en un minuto, es, en

promedio, 102 . La central puede manejar un máximo de 103 llamadas, colapsando si recibe

más de este número de llamadas en un minuto. Usar la desigualdad de Chebyshev para

estimar la probabilidad de que la central colapse en un minuto dado.

2. En el problema de la fábrica del capı́tulo anterior, supóngase que los amplificadores con

Γ < 7,5 × 103 seg−1/2 son rechazados por control de calidad.

(a) Use la desigualdad de Chebyshev para estimar el % de amplificadores rechazados.

(b) Calcule la misma probabilidad de la parte (a) usando la tabla de la distribución normal.

Explique la discrepancia de los resultados.

3. A través de una encuesta se quiere estimar la fracción p de adultos de la población que se

interesarı́a en un nuevo producto. Se interroga a n personas de la población, y se estima p

como p̃ = X/n, siendo X el número de personas encuestadas que manifiestan interés en el

9

producto. Utilizando el Teorema del Lı́mite Central, y suponiendo que el verdadero valor de

p es 0.35, encuentre, aproximadamente, el menor valor de n para el cual p̃ y p difieren en

menos de 0.02, con probabilidad mayor que 0,9. ¿Como resolverı́a el problema en el caso

(realista) en que p es desconocido?

4. Tomamos 50 números al azar (uniformemente) en el intervalo (1,3).

Utilize la desigualdad de Chebyshev para estimar la probabilidad de que el promedio

X de estos números se encuentre entre 1,9 y 2,1.

Utilize el Teorema del Lı́mite Central para aproximar la misma probabilidad de la parte

(a) Según la aproximación que nos dá el T.L.C., ¿Cuánto debe ser ε para que X se

encuentre en el intervalo (1 − ε, 1 + ε) con probabilidad 0,95.

5. Use la función generatriz para calcular el momento de tercer orden de una Normal(µ, σ2 ).

2.- Sean {Xn } v.a.i.i.d. y N una v.a. a valores enteros positivos independiente de {Xn }. Calcule la función generatriz de momentos de X1 + . . . + XN y deduzca la esperanza y varianza

de esta v.a.

6. {Xn } v.a. con

P Xn =

k

n+1

=

1

para k = 1, . . . n

n

Pruebe que Xn → U(0,1) en distribución.

7. Suponga que Xn tiene

√ distribución Gamma(n, 1). Calcule la función generatriz de momentos

de Zn = (Xn − n)/ n y demuestre que

lı́m MZn (t) = et

¿Qué concluye?.

10

2 /2