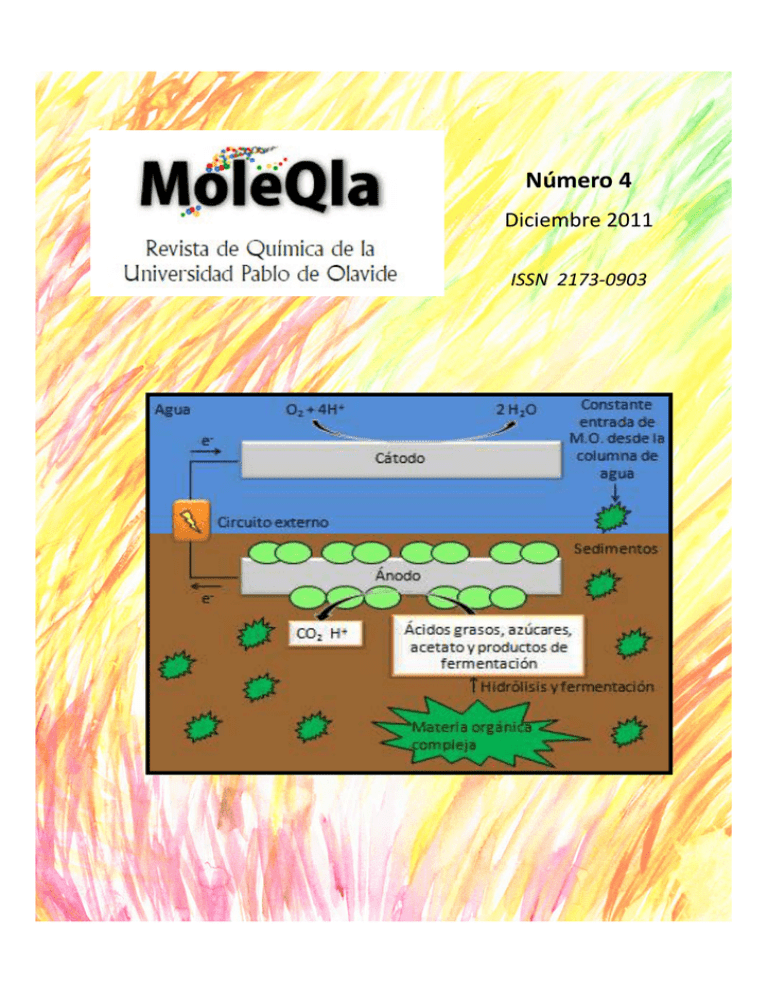

Número Cuatro - Universidad Pablo de Olavide, de Sevilla

Anuncio