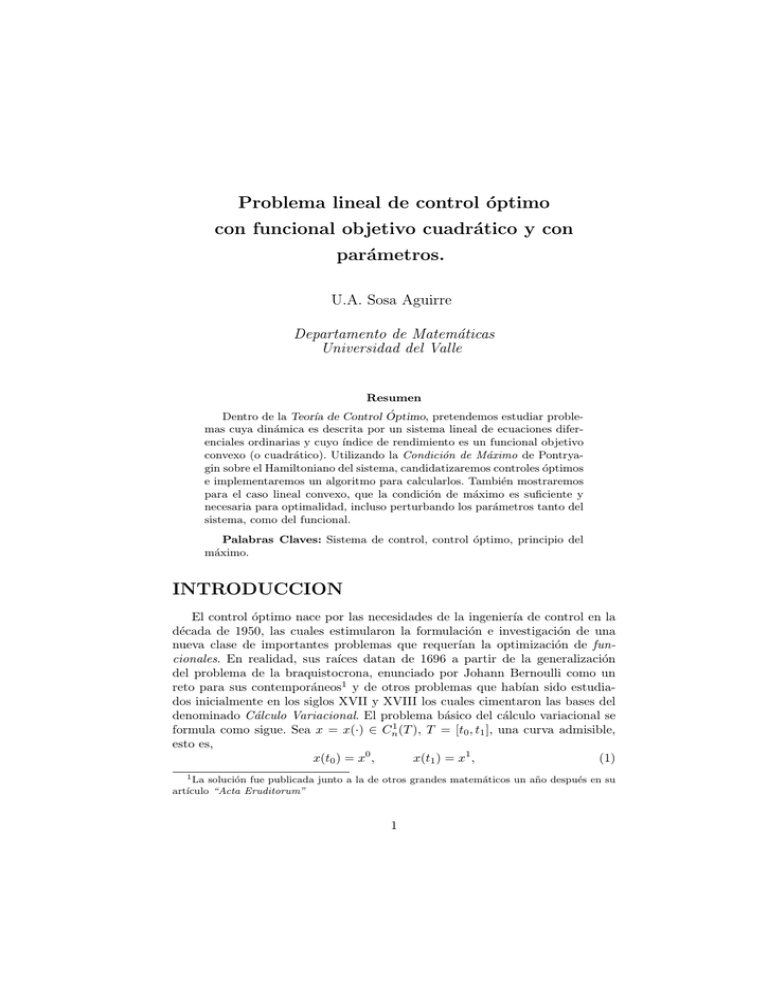

Problema lineal de control óptimo con funcional objetivo cuadrático

Anuncio

Problema lineal de control óptimo

con funcional objetivo cuadrático y con

parámetros.

U.A. Sosa Aguirre

Departamento de Matemáticas

Universidad del Valle

Resumen

Dentro de la Teorı́a de Control Óptimo, pretendemos estudiar problemas cuya dinámica es descrita por un sistema lineal de ecuaciones diferenciales ordinarias y cuyo ı́ndice de rendimiento es un funcional objetivo

convexo (o cuadrático). Utilizando la Condición de Máximo de Pontryagin sobre el Hamiltoniano del sistema, candidatizaremos controles óptimos

e implementaremos un algoritmo para calcularlos. También mostraremos

para el caso lineal convexo, que la condición de máximo es suficiente y

necesaria para optimalidad, incluso perturbando los parámetros tanto del

sistema, como del funcional.

Palabras Claves: Sistema de control, control óptimo, principio del

máximo.

INTRODUCCION

El control óptimo nace por las necesidades de la ingenierı́a de control en la

década de 1950, las cuales estimularon la formulación e investigación de una

nueva clase de importantes problemas que requerı́an la optimización de funcionales. En realidad, sus raı́ces datan de 1696 a partir de la generalización

del problema de la braquistocrona, enunciado por Johann Bernoulli como un

reto para sus contemporáneos1 y de otros problemas que habı́an sido estudiados inicialmente en los siglos XVII y XVIII los cuales cimentaron las bases del

denominado Cálculo Variacional. El problema básico del cálculo variacional se

formula como sigue. Sea x = x(·) ∈ Cn1 (T ), T = [t0 , t1 ], una curva admisible,

esto es,

x(t0 ) = x0 ,

x(t1 ) = x1 ,

(1)

1 La solución fue publicada junto a la de otros grandes matemáticos un año después en su

artı́culo “Acta Eruditorum”

1

x0 y x1 dados. Sea además el conjunto funcional

X = {x(·) ∈ Cn1 (T ) : x(t0 ) = x0 , x(t1 ) = x1 },

y definamos el funcional

Z

t1

F (x, ẋ, t)dt,

J = J(x) =

t0

sobre X, donde F (x, ẋ, t) está definida y es continua respecto a cada uno de sus

argumentos, junto con sus derivadas parciales respecto a (x, ẋ, t). El problema

es entonces obtener x∗ (·) ∈ X tal que:

x∗ : J(x) → mı́n

(2)

en cuyo caso x∗ es una minimal, en el sentido que minimiza al funcional J.

La idea central para resolver el problema básico del cálculo variacional es

dar una condición necesaria para las funciones candidatas a ser extremales del

funcional J, denominada condición de Euler-Lagrange, y que afirma lo siguiente: todo mı́nimo débil del problema básico de cálculo variacional satisface la

ecuación de Euler-Lagrange

d F (x, ẋ, t)

∂F (x, ẋ, t)

−

= 0.

∂x

dt

∂ ẋ

Ahora bien si x(·) ∈ Cn1 (T ), la función escalar F (x, ẋ, t) tiene derivadas parciales

continuas en sus variables hasta de segundo orden y asumimos adicionalmente

que dichas funciones están acotadas por las restricciones

gi (x, ẋ, t) = 0

i = 1, 2, ..., m,

m < n,

(3)

con gi (x, ẋ, t) con derivadas parciales continuas en sus variables hasta de segundo

orden, entonces (1) - (3) es un problema restringido de cálculo variacional o

problema Lagrangiano. Finalmente introducimos el Lagrangiano

L(λ(t), x(t), ẋ(t), t) = F (x(t), ẋ(t), t) + hλ(t), g(x(t), ẋ(t), t)i

(4)

donde λ = (λ1 , λ2 , ..., λm ) son funcionales denominados multiplicadores de La1

grange, λ(·) ∈ Cm

(T ), h· , ·i denota producto escalar y el funcional Lagrangiano

Z t1

L(λ, x) =

L(λ, x, ẋ, t)dt

t0

está definido sobre el conjunto funcional

1

Y = {x(·) ∈ Cn1 (T ), λ(·) ∈ Cm

(T ) : x(t0 ) = x0 , x(t1 ) = x1 },

y formulamos el problema

L(λ, x) → mı́n,

(λ, x) ∈ Y.

2

(5)

Obviamente si la solución (λ∗ , x∗ ) de (5) existe, satisface

∂L(x, ẋ, t) d L(x, ẋ, t)

−

= 0,

∂x

dt

∂ ẋ

∂L(x, ẋ, t)

= gi = 0,

∂λi

∂L(x, ẋ, t)

= 0,

∂ λ̇i

i = 1, ..., m.

Tomando este conjunto de ecuaciones se puede implementar un método práctico

de resolver el problema restringido del cálculo variacional (1) -(3), y estamos

interesados en un caso particular que conlleva al problema a exponer en el

presente trabajo, el problema básico de control óptimo.

1.

Introducción a la Teorı́a de Control Optimo

La teorı́a de control óptimo refleja el estado actual del desarrollo del cálculo

variacional, al enfrentar problemas de tipo variacional pero que no encajaban

enteramente en los problemas clásicos variacionales. Considere el sistema

x(t0 ) = x0

ẋ = f (x, u, t),

(6)

donde x(t) ∈ Rn es el estado del sistema en el tiempo t ∈ T = [t0 , t1 ], u(t) ∈ U ⊆

Rm , t ∈ T , es la función de control y ẋ = dx

dt . El par (u(t), x(t)) es denominado

Proceso de Control y cuando obtenemos el “mejor”proceso (u∗ (t), x∗ (t)), en un

sentido por definir, diremos que el proceso es óptimo. Ahora bien, un problema

de control se caracteriza por:

1.

La dinámica del objeto controlado es un sistema de ecuaciones diferenciales

ordinarias (6).

Rt

2. Un funcional J = J(u) = t01 F (x, u, t)dt, llamado a veces ı́ndice de

rendimiento del sistema que está por minimizarse. .

Ası́, resolver el problema de control óptimo significa hallar una función de control

u∗ (t), t ∈ T que minimice el ı́ndice de rendimiento J.

Ahora bien, en el caso que u(t) ∈ U = Rm , x(·) ∈ Cn1 (T ) podemos resolver

este problema como uno de cálculo variacional acotado. Definiendo λ(t) = ψ(t),

ψ(·) ∈ Cn1 (T ) e introduciendo la función hamiltoniana

H(ψ, x, u, t) = hψ(t), f (x, u, t)i − F (x, u, t).

podemos escribir el lagrangiano en la forma

L(ψ, x, ẋ, u, t) = hψ(t), ẋi − F (x, u, t),

las ecuaciones de Euler se escriben entonces como

ẋ = f (x, u, t),

ψ̇ = −

∂H(ψ, x, u, t)

,

∂x

∂H(ψ, x, u, t)

= 0,

∂u

t ∈ T,

y la solución pertenece a la clase de controles u = u(t) continuos y estados

suaves x = x(t). Por otro lado, sea U ⊂ Rm un conjunto cerrado y acotado.

3

Una función u = u(t) que toma valores en U para t ∈ [t0 , t1 ] es un control

admisible. El control admisible u(t) y su correspondiente trayectoria x(t), t ∈ T

que satisface (6) forman un par o proceso admisible para el problema de control

óptimo. Considerando entonces el funcional

Z t1

F (x, u, t)dt → mı́n,

(7)

J(u) = ϕ(x(t1 )) +

t0

tenemos que (6) y (7) conforman el problema de control óptimo, donde ϕ(x) y

F (x, u, t) son continuamente diferenciables respecto a x. Ası́ pues, las diferencias

entre los problemas de cálculo variacional y los problemas de control óptimo son

esencialmente el tipo de función de control y las restricciones sobre el mismo,

0

pues es usual requerir del control que u(·) ∈ P Cm

(T ), ya que este espacio es

mas adecuado para modelar sistemas automáticos de control. Por lo anterior,

tenemos que con

0

u(·) ∈ P Cm

(T ),

u(t) ∈ U ⊆ Rm ,

(8)

el problema deja de ser variacional y por tanto el algoritmo lagrangiano derivado

de las ecuaciones de Euler-Lagrange no aplica, esencialmente puesto que dado

el carácter discontinuo de u sobre T no tiene sentido implementar

∂H(ψ, x, u, t)

= 0,

t ∈ T,

∂u

en su lugar se escribe la Condición de Máximo de Pontryagin para el Hamiltoniano H(ψ, x, u, t) del sistema con respecto al control u(t) ∈ U . Para este tipo

de problemas L.S. Pontryagin en 19532 formuló el denominado Principio del

Máximo, como condición necesaria de mı́nimo para el funcional J. Este resultado ha sido fundamental en el desarrollo de la teorı́a de control óptimo y el

elegido para nuestro trabajo en el estudio de la mejor forma de controlar un

objeto cuya dinámica obedece al sistema lineal en x y en u.

ẋ = f (x, u, t) = A(t)x(t) + B(t)u(t) + h(t)

2.

PRINCIPIO DEL MAXIMO

Hemos formulado realmente en (6) - (8) el denominado problema de control

óptimo con restricciones directas sobre el control, ó problema básico de control

óptimo. Ahora damos condiciones bajo las cuáles el principio del máximo de

Pontryagin aplica. Estas condiciones se denominan P-condiciones, y son:

f es continua respecto a cada uno de sus argumentos (x, u, t) y satisface

una condición tipo Lipschitz para alguna constante L

||f (x + ∆x, u, t) − f (x, u, t)|| ≤ L||∆x||

respecto a x para todo u(t) ∈ U y t ∈ T .

2 Aunque fue dado a conocer a la comunidad internacional en un congreso en el año de

1956, tres años después.

4

Las funciones ϕ, F son continuas respecto a sus argumentos junto con

∂F (x,u,t)

1 ))

y ∂ϕ(x(t

∂x

∂x(t1 ) .

Es de anotar que, de la teorı́a fundamental de las ecuaciones diferenciales ordinarias, bajo las P-condiciones el Problema de Cauchy (6) tiene una única

1

solución definida sobre T , perteneciente a la clase de funciones P Cm

(T ), para

cualquier control admisible u = u(t).

2.1.

Formulación general.

El principio del máximo para dominios acotados se formula como sigue:

Teorema 2.1 (Principio del Máximo de Pontryagin.) Suponga que en el

problema básico de control óptimo las P-condiciones son válidas y el proceso admisible (u∗ (t), x∗ (t)) es óptimo. Entonces para todo t ∈ T éste proceso satisface

la condición de Máximo de Pontryagin

H(ψ ∗ (t), x∗ (t), u∗ (t), t) = máx H(ψ ∗ (t), x∗ (t), ũ(t), t),

ũ∈U

c.p.t. t ∈ [t0 , t1 ] (9)

donde ψ ∗ (t) es solución del sistema conjugado:

ψ̇ = −

∂H(ψ, x, u, t)

,

∂x

ψ(t1 ) = −

∂ϕ(x(t1 ))

∂x(t1 )

(10)

Demostración. La demostración está basada en la fórmula de incremento

del funcional objetivo, definida abajo, y en el uso de las denominadas variaciones aculeiformes, de donde a partir del término dominante del incremento

del funcional J se obtiene la condición de máximo como condición necesaria de

optimalidad.

2.2.

Fórmula para el incremento diferencial del funcional

objetivo.

Considere los procesos admisibles (u, x) y (ũ = u + ∆u, x̃ = x + ∆x), es claro

que ∆x satisface

∆ẋ = ∆f (x, u, t),

∆x(t0 ) = 0

donde ∆f (x, u, t) = f (x̃, ũ, t) − f (x, u, t) y para el funcional J tenemos,

Z

t1

∆J(u) = ∆ϕ(x(t1 )) +

Z

t1

hψ(t), ∆ẋ − ∆f (x, u, t)i dt,

∆F (x, u, t) dt +

t0

t0

donde por el momento ψ(t) ∈ Rn es una función arbitraria no trivial para todo

t ∈ T . Introduciendo el Hamiltoniano (ó Función de Pontryagin),

H(ψ, x, u, t) = hψ(t), f (x, u, t)i − F (x, u, t)

5

se puede mostrar que al definir ψ = ψ(t) como solución del problema conjugado

(10) la fórmula de incremento del funcional de costo está dada por

Z

t1

∆J(u) = −

∆ũ H(ψ, x, u, t) + ηũ

t0

donde

Z

t1

ηũ = oϕ (||∆x(t1 )||) −

Z

t0

y el termino dominante −

de optimalidad.

2.3.

t1

oH (||∆x(t)||)dt −

h∆ũ

t0

R t1

t0

∂H(ψ, x, u, t)

, ∆x(t)idt.

∂x

∆ũ H(ψ, x, u, t) dt determina la condición necesaria

El principio del máximo y los sistemas lineales.

Considere el problema de controlar objetos cuya dinámica es descrita por

un sistema lineal de ecuaciones diferenciales ordinarias y restricciones sobre el

control

ẋ = A(t)x + B(t)u + h(t),

x(t0 ) = x0 ,

u(t) ∈ U,

t ∈ T = [t0 , t1 ]

(11)

con funcional objetivo cuadrático

Z

1 t1

[hx(t), P (t) x(t)i + hu(t), Q(t) u(t)i] dt → mı́n, (12)

J(u) = hc, x(t1 )i +

2 t0

donde A(t)n×n , B(t)n×m , h(t)n×1 , son funciones matriciales cn×1 una matriz

constante, P (t) es una matriz simétrica n × n definida no negativa y Q(t) es una

matriz simétrica m × m definida positiva, todas continuas en [t0 , t1 ] y tomamos

U ⊆ Rm . Ahora bien, debido a la convexidad tanto de la parte terminal como de

la parte integral, podemos mostrar que para el problema (11 - 12), denominado

de ahora en adelante problema lineal convexo de control óptimo, el Principio

del Máximo de Pontryagin provee una condición necesaria y suficiente de optimalidad.

Teorema 2.2 (Principio del Máximo para sistemas lineales.) Es claro que

las P-condiciones se satisfacen para el problema lineal de control óptimo. Entonces la condición de máximo (9) para cierta función ψ ∗ = ψ ∗ (t) que satisface

el sistema conjugado es condición necesaria y suficiente de optimalidad del proceso admisible (u∗ (t), x∗ (t)), para casi todo t ∈ [t0 , t1 ].

Demostración. Necesidad se sigue del teorema (2.1). Probaremos suficiencia.

Nuestro Hamiltoniano para el problema lineal convexo o cuadrático de control

óptimo toma la forma

H(x(t), ψ(t), u(t), t) = hψ(t), A(t)x + B(t)u + h(t)i − F (x(t), u(t), t),

6

donde

1

(hx(t), P (t) x(t)i + hu(t), Q(t) u(t)i)

2

y denotando F1 (x, t) = hx(t), P (t) x(t)i y F2 (u, t) = hu(t), Q(t) u(t)i podemos

mostrar que

∂H

, ∆x(t) = 0,

∆ū

∂x

y

oH (||∆(x)||) = −oF1 (||∆(x)||),

F (x, u, t) =

puesto que

∂H(x(t), ψ(t), u(t), t)

= AT (t) ψ(t) − P T (t) x(t).

∂x

Por otra parte la convexidad de F1 (x, t) y la linealidad de ϕ(x(t1 )) = hc, x(t1 )i

implican

oF1 (||∆(x)||) ≥ 0, ∀t ∈ T,

oϕ (||∆x(t1 )||) = 0,

de donde

Z

t1

∆J(u) = −

t1

Z

∆ũ H(ψ, x, u, t)dt +

t0

oF1 (||∆x(t)||)dt.

t0

Ası́, para algún proceso admisible (u∗ (t), x∗ (t)) que satisfaga la condición de

máximo

∆ũ H(ψ ∗ , x∗ , u∗ , t) ≤ 0

tenemos que

∆J(u∗ ) = −

Z

t1

∆ũ H(ψ ∗ , x∗ , u∗ , t)dt +

t0

Z

t1

oF1 (||∆x(t)||)dt ≥ 0,

t0

y por tanto

∆J(u∗ ) = J(ũ) − J(u∗ ) ≥ 0,

la desigualdad anterior confirma la optimalidad del proceso (u∗ (t), x∗ (t)). Ahora bien en dirección a solucionar el problema lineal convexo de control

óptimo, tenemos que hacer uso de la condición de Máximo de Pontryagin para

candidatizar controles admisibles como controles óptimos; dado que hemos visto

que con u(t) ∈ U, t ∈ T un conjunto compacto convexo, en general u(·) ∈

0

P Cm

(T ) y entonces no es permitido utilizar

∂H(ψ ∗ , x∗ , u∗ , t)

=0

∂u

para candidatizar extremos del funcional H(ψ ∗ , x∗ , u∗ , t). Por tanto recurrimos

nuevamente a los incrementos parciales

7

∆ũ H(ψ ∗ , x∗ , u∗ , t) = H(ψ ∗ , x∗ , u∗ + ∆u, t) − H(ψ ∗ , x∗ , u∗ , t),

1

= hB(t) ψ(t) − Q(t)u∗ , ∆ui − hQ(t)∆u , ∆ui

2

siendo Q(t) simétrica definida positiva

∆ũ H(ψ ∗ , x∗ , u∗ , t) ≤ hB(t) ψ(t) − Q(t)u∗ , ∆ui

y ası́ como U es un conjunto convexo, se puede mostrar como condición necesaria

para que u∗ sea maximal la desigualdad

hB(t) ψ(t) − Q(t)u∗ , ∆ui ≤ 0.

Luego la condición necesaria y suficiente de optimalidad en nuestro caso es hallar

u∗ : hW (t), ūi → máx, ∀ū ∈ U, t ∈ T,

donde W (t) = B(t) ψ(t) − Q(t)u∗ .

3.

Método de solución del problema lineal convexo de control óptimo.

Consideremos el problema de minimización del funcional objetivo

1

J(u) = hc, x(t1 )i + hx(t1 ), Q x(t1 )i +

2

1

2

Z

(13)

t1

[2hg(t), x(t)i + 2hd(t), u(t)i + hx(t), P (t) x(t)i + hu(t), Q(t) u(t)i] dt → mı́n,

t0

sujeto al sistema de ecuaciones diferenciales ordinarias

ẋ = A(t)x + B(t)u + C(t)p + h(t),

x(t0 ) = q,

t ∈ T = [t0 , t1 ]

(14)

donde las matrices A, B, P y Q son como antes, Qn×n es una matriz constante, c = (c1 , c2 , ..., cn ), p = (p1 , p2 , ..., pn ) y q = (q1 , q2 , ..., qn ) son los

parámetros. El control óptimo u∗ del problema (13) - (14) satisface el principio de Máximo de Pontryagin para cualquier valor fijo de los parámetros

α = (c, p, q), el cual es establecido mediante incrementos parciales como

u∗ (t) = Q−1 (t)B T (t)ψ(t) − Q−1 (t)d(t),

posteriormente determinamos las soluciones del problema de Cauchy (14) y del

sistema conjugado

ψ̇ = −AT (t)ψ(t) − P T (t)x,

(15)

utilizando el denominado algoritmo de sı́ntesis [1] para la región de control

U = Rm .

8

A saber, el problema de valor inicial (14) y su sistema adjunto (15) se reescribe

ẋ = A(t)x + B(t)Q−1 (t)B T (t)ψ − B(t)Q−1 (t)d(t) + C(t)p + h(t), x(t0 ) = q,

ψ̇ = −AT (t)ψ + P T (t)x + g(t),

ψ(t1 ) = −c.

(16)

Para simplificar introducimos la siguiente notación

z(t) = (x(t), ψ(t)) ∈ R2n ,

A(t)

B̄(t)

C(t) 0

2n×2n

Ā(t) =

∈

R

,

C̄(t)

=

∈ R2n×2m ,

P (t) −AT (t)

0

0

B̄ = B(t)Q−1 (t)B T (t) ∈ Rn×n ,

p̄ = (p, 0) ∈ R2n ,

b = (q, −c) ∈ R2n ,

ĥ(t) = h(t) − B(t)Q−1 (t)d(t) ∈ Rn , f (t) = (ĥ(t), g(t)) ∈ R2n ,

In×n 0

0

0

L0 =

∈ R2n×2n ,

L1 =

∈ R2n×2n .

0

0

0 In×n

El problema de valor inicial (16) se puede escribir como

ż = Ā(t)z + C̄(t)p̄ + f (t)

L0 z(t0 ) + L1 z(t1 ) − b = 0

(17)

Para representar la solución de (17) en forma analı́tica podemos

usar el análogo

Z11 (t) Z12 (t)

de la fórmula de Cauchy [2], y en ese caso digamos que Z(t) =

,

Z21 (t) Z22 (t)

es la matriz fundamental de soluciones del sistema homogéneo correspondiente

a (17), donde las Zij (t), (i, j = 1, 2.) son submatrices de dimensión n × n.

∗

Ası́ mismo sean Zij

(t) submatrices de dimensión n × n de la matriz Z −1 (t),

entonces la solución del problema de valor inicial

ż = Ā(t)z + C̄(t)p̄ + f (t),

z(t0 ) = z 0

con z 0 arbitrario puede presentarse como

Z t

0

z(t) = Z(t)z +

Z(t)Z ∗ (τ )C̄(t)p̄ + f (τ ) dτ

(18)

t0

según la fórmula de Cauchy. Para resolver el problema de valor inicial (17) debemos encontrar la solución z̄ 0 del sistema no homogéneo de ecuaciones algebráicas

z̄ 0 : L0 z 0 + L1 z(t1 ) − b = 0.

(19)

La existencia de la solución del sistema (19) y en consecuencia la condición de

solubilidad del problema (17) tendrá la forma

det[L0 + L1 z(t1 )] 6= 0.

9

De (18) y (19) se sigue que

Z t

0

−1

∗

z̄ = (Λ)

b − L1 Z(t1 )

Z (τ )C̄(t)p̄ + f (τ ) dτ ,

t0

donde Λ = L0 + L1 z(t1 ). Reemplazando este valor en la fórmula de Cauchy (18)

llegamos al análogo de la fórmula de Cauchy

Z t1

z(t) = Z(t)(Λ)−1 b − Z(t)(Λ)−1 L1 Z(t1 )

Z ∗ (t)C̄(t)p̄ + f (t) dt

(20)

Z

t0

t

Z ∗ (τ )C̄(t)p̄ + f (τ ) dτ

+Z(t)

t0

Después de verificar la condición de solubilidad del problema, se puede mostrar

que el subvector ψ(t) de la solución z(t) del problema (16) representado según

(20) toma la forma

∗

ψ(t) = [Z21 (t) − Z22 (t)Θ1 ]q − Z22 (t)Z21

(t1 )c

(21)

Z t1

Z t

∗

∗

∗

−Z21 (t)Z22 (t)Z22

(t1 )

Z11

(t)C(t)p dt + Z21 (t)

Z11

(τ )C(τ )p dτ

t0

t1

Z

−Z22 (t)

t0

∗

Z21

(t)C(t)p dt + Z22 (t)

t0

Z

t

∗

Z21

(τ )C(τ )p dτ + N (t)

t0

donde N (t) es un término que depende de Zij (t) y f (t).

Al sustituir ψ = ψ(t) calculado según (21) en la ley de control óptimo

u∗ (t) = Q−1 (t)B T (t)ψ(t) − Q−1 (t)d(t),

obtenemos la fórmula explı́cita de sı́ntesis paramétrica,

u∗ (t) = M (t)q + N (t)c + P (t)p + η(t)

(22)

donde

M (t) = Q−1 (t)B T (t)[Z21 (t) − Z22 (t)Θ1 ],

N (t) = −Q−1 (t)B T (t)Z22 (t)Θ,

Z t

Z

∗

∗

P (t) = Q−1 (t)B T (t) Z21 (t)

Z11

(τ )C(τ ) dτ +Z22 (t)[−Z22

(t1 )Z21 (t1 )

t0

Z

t1

−

t0

∗

Z21

(t)C(t) dt +

t1

∗

Z11

(t)C(t) dt

t0

Z

t

∗

Z21

(τ )C(τ ) dτ ] + N (t),

t0

h

i

η(t) = Q−1 (t)B T (t) Z21 (t)y (1) (t) + Z22 (t)[y (2) (t) − Θ1 y (1) (t1 ) − y (2) (t1 )] .

Aquı́ y (1) (t) y y (2) (t) son solución de los problemas vectoriales de valor inicial

∗

∗

ẏ (1) (t) = Z11

(t)ĥ(t) + Z12

(t)g(t),

y (1) (t0 ) = 0

∗

∗

ẏ (2) (t) = Z21

(t)ĥ(t) + Z22

(t)g(t),

y (2) (t0 ) = 0

10

Ahora bien, aunque (22) determina el control óptimo de forma compleja,

existe un caso particular del problema que conlleva una forma del control mas

simple, dicho problema se denominará problema lineal convexo de control óptimo con parámetros,

ẋ = A(t)x + B(t)u + C(t)p,

x(t0 ) = q,

t ∈ T = [t0 , t1 ]

u(t) ∈ Rm ,

(23)

(24)

y con funcional objetivo cuadrático

Z

1 t1

hu(t), Q(t) u(t)i dt → mı́n,

J(u) = hc, x(t1 )i +

2 t0

(25)

es claro que el problema (23) - (25) es obtenido de (13) - (14) haciendo que

h(t) = g(t) = d(t) ≡ 0 y Q = P (t) = 0. Por lo tanto en este caso

M (t) ≡ 0,

P (t) ≡ 0,

η(t) ≡ 0

y de aquı́ tenemos la ley de control Robusto,

u∗ (t) = N (t)c

en el sentido que solo depende del parámetro c, para todo q = x(t0 ) y todo p.

Algoritmo de sı́ntesis para el problema (23) - (25) simplificado.

En primer lugar utilizaremos el algoritmo de sı́ntesis y el principio del máximo para el problema lineal convexo de control óptimo simplificado

ẋ = B(t)u + C(t)p,

x(t0 ) = q,

t ∈ T = [t0 , t1 ]

(26)

donde A(t) es la matriz nula y el funcional cuadrático es

J(u) = hc, x(t1 )i +

1

2

Z

t1

[hu(t), Q(t) u(t)i] dt → mı́n,

(27)

t0

Entonces

1

H(ψ, x, u, t) = hψ(t), B(t)u + C(t)pi − hu(t), Q(t) u(t)i

2

y es claro que

u∗ (t) = Q−1 (t)B T (t)ψ(t).

Por otro lado del sistema conjugado

ψ(t1 ) = −c

ψ̇(t) = 0,

11

(28)

tenemos

ψ ≡ −c,

t∈T

y entonces

u∗ (t) = −Q−1 (t)B T (t) c.

Ahora verificamos que u∗ satisface la condición de máximo de Pontryagin. En

efecto, se tiene que,

1

H(ψ ∗ , x∗ , u∗ , t) = −hψ(t), B(t)u∗ (t) + C(t)pi − hu∗ (t), Q u∗ (t)i

2

1

c, B(t) (−Q−1 (t)B T (t) c) − hc, C(t)pi

2

y similarmente para ũ = u∗ + ∆u,

=

1

H(ψ ∗ , x∗ , u∗ +∆u, t) = hψ(t), B(t)u∗ +B(t)∆ui+hψ(t), C(t)pi− hu∗ +∆u, Q(t) (u∗ +∆u)i

2

1

1

c, B(t) (−Q−1 (t)B T (t) c) − hc, C(t)pi − h∆u, Q(t)∆u)i

2

2

se comprueba finalmente que

H(ψ ∗ , x∗ , ũ, t) =

1

∆ũ H(ψ ∗ , x∗ , u∗ , t) = H(ũ, t)−H(u∗ , t) = − h∆u, Q(t)∆ui ≤ 0,

2

c.p.t t ∈ T, ∀ũ ∈ Rm .

Ahora resta verificar que el proceso (x∗ , u∗ ) es óptimo. Para ello note que, del

sistema (26) y el Hamiltoniano (28) tenemos que

ẋ =

∂H

= −B(t) (−Q−1 (t)B T (t) c) + C(t)p

∂ψ

de donde

Z

t1

x(t1 ) = −

B(t) (−Q−1 (t)B T (t) c) + C(t)p dt + q

t0

luego el funcional de rendimiento es dado por

Z

1 t1 ∗

J(u∗ ) = hc, x(t1 )i +

hu (t), Q(t) u∗ (t)i dt

2 t0

Z

= c,

t1

t0

Z

1 t1 −1

−1

T

hQ (t)B T (t) c, B T (t)ci dt

B(t) (−Q (t)B (t) c) + C(t)p dt + q +

2 t0

y ası́

1

J(u∗ ) = − hc ,

2

Z

t1

B(t) (−Q−1 (t)B T (t))c dti + hc ,

t0

Z

t1

C(t)p dti + hc , qi.

t0

12

Por otro lado

Z

∗

t1

−1

J(u +∆u) = −hc,

B(t) (−Q

Z

T

t1

(t)B (t)) c dti+hc ,

t0

B(t)∆u+C(t) p dt+qi

t0

Z

t1

−hc ,

t0

Z

1

B(t)∆u dti +

2

t1

h∆u, Q(t)∆ui dt.

t0

Ası́ pues,

1

∆J(u ) = J(u + ∆u) − J(u ) =

2

∗

∗

∗

Z

t1

h∆u, Q(t)∆ui dt ≥ 0, ∀ũ ∈ U

t0

puesto que Q(t) es una matriz simétrica definida positiva en T , y de esta manera

hemos mostrado que el proceso (u∗ , x∗ ) es el mejor en el sentido que minimiza

el funcional J y satisface la condición de máximo de Pontryagin.

En segundo lugar, para el caso en que la región de controles admisibles U es

elegida compacta convexa, como por ejemplo el paralelepı́pedo m-dimensional

definido por,

U = {u(t) ∈ Rm : |ui (t)| ≤ `i , t ∈ T, i = 1, 2, 3, ...m., ` > 0},

(29)

mostraremos que el proceso (u∗ , x∗ ) sigue siendo óptimo para nuestro problema lineal convexo simplificado (26) - (27), para ello verificamos como antes la

condición de máximo y la minimización del funcional J, nuevamente utilizando

el resultado obtenido con el algoritmo de sı́ntesis y teniendo en cuenta que la

restricción impuesta equivale a tener

|(−Q−1 (t)B T (t) c)i | ≤ `i ,

i = 1, ..., m,

` = (`i , ..., `m ).

Ası́ pues note que si u(t) = ` entonces

1

H(ψ ∗ , x∗ , `, t) = −hc, B(t) ` + C(t)pi − h` , Q(t)`i

2

y

1

H(ψ ∗ , x∗ , `+∆u, t) = −hc, B(t) `+B(t)∆u+C(t)pi−h` , Q(t)∆ui− h∆u , Q(t)∆ui

2

de donde obtenemos

1

∆ũ H(ψ ∗ , x∗ , `, t) = H(ũ, t)−H(`, t) = −hB T (t)c+Q(t) ` , ∆ui− h∆u , Q(t)∆ui

2

(30)

y observamos que ∆ũ H(ψ ∗ , x∗ , `, t) ≤ 0 dependiendo de sign hB T (t)c+Q(t) ` , ∆ui.

Ahora bien analizando nuestro funcional J,

Z t1

Z

1 t1

J(`) = c ,

[B(t) ` + C(t) p ] dt + q +

h` , Q(t)`i dt

2 t0

t0

13

y su incremento

Z

J(`+∆u) = c ,

t1

Z

[B(t) ` + C(t) p ] dt + q +hc ,

t1

B(t)∆u dti+

t0

t0

Z

t1

h∆u , Q(t) `i dt +

+

t0

1

2

Z

1

2

Z

t1

h` , Q(t)`i dt

t0

t1

h∆u, Q(t)∆ui dt

t0

note que

1

∆J(`) = J(` + ∆u) − J(`) = hB T (t)c + Q(t) ` , ∆ui + h∆u , Q(t)∆ui (31)

2

lo cual implica que como en (30), ∆J(`) ≥ 0 depende de sign hB T (t)c +

Q(t) ` , ∆ui, lo cual sugiere que apartir de (30) - (31) podemos definir nuestro control óptimo u∗ (t) = (u∗i (t), ..., u∗m (t)), donde cada u∗i (t) es dado por

(−Q−1 (t)B T (t) c)i ,

si |(−Q−1 (t)B T (t) c)i | ≤ `i , t ∈ T,

u∗ (t) =

−1

T

sign(−Q (t)B (t) c)i `i , si |(−Q−1 (t)B T (t) c)i | > `i , t ∈ T.

(32)

Finalmente se analizará si una vez obtenido un par óptimo (x∗ (t), u∗ (t)) para

nuestro sistema (23) y funcional (25), éste continuará siendo óptimo una vez se

ha perturbado mediante α = (c, p, q), es decir, nos preguntamos si

u∗ = v(t, α)

sigue siendo un control óptimo para nuestro problema lineal convexo perturbado

y con restricciones directas sobre el control, como las formuladas en (28), o mas

generales. Más aún, deseamos verificar si sobre T , podemos definir el control

óptimo como un hı́brido entre control bang-bang y nuestro control (32) obtenido

del algoritmo de sı́ntesis.

Referencias

[1] E.A. Lutkovskaya, A method for contructing a parametric synthesis for

a linear-quadratic optimal control problem, Sizv. Vyssh. Uchebn. Zaved.

Mat. 1999, No. 12, 71-73; translation in Russian Math. (Iz. VUZ), No. 12,

67-69(2000).

[2] O.O. Vasilieva, Two parameter algorithm for optimal control problems

with boundary conditions, Saitama Mathematical Journal, Vol. 20 (2002),

45-62.

[3] O.V. Vasiliev,Optimization Methods, Advanced series in mathematical

science and engineering WFP, 1996.

[4] L.D. Berkovitz, Optimal Control Theory, Springer-Verlag, 1974.

14

[5] V.G. Boltyanskii, Mathematical methods of optimal control, Holt, Rinehart and Winston, Inc. 1971.

[6] R. Gabasov, F. Kirillova, Methods of optimization, Optimization Software, Inc., 1988.

[7] V.I. Arnold, Ordinary Differential Equations, MIT Press. E.U.A., 1978.

15