Estimación de Parámetros

Anuncio

Estimación de Parámetros

Germán Bassi

9 de septiembre de 2010

Estimación de la Media

r

1.

µˆX =

do

Dada la variable aleatoria X, podemos estimar el valor esperado de la misma

mediante la siguiente fórmula:

N

1 X

1

X(i) = 1T X.

N i=1

N

rra

Ambas representaciones son iguales pero, en ciertas circunstancias, conviene utilizar

una antes que la otra.

Una propiedad importante en un estimador es el valor esperado del mismo. Se

denomina sesgo de un estimador a la diferencia entre dicho valor y el verdadero

valor del parámetro a estimar. Es deseable que un estimador sea insesgado, es decir,

que su sesgo sea nulo por ser su esperanza igual al parámetro que se desea estimar.

En nuestro caso,

#

"

N

N

N

1 X

1 X

1 X

X(i) =

E[X(i)] =

µX = µX .

E[µˆX ] = E

N i=1

N i=1

N i=1

Bo

Esto significa que el estimador de la media presentado es insesgado.

Otra caracterı́stica que nos da una idea de la bondad del estimador es la varianza del mismo. Nuevamente, es deseable que la varianza disminuya conforme el

número de muestras tomadas por el estimador aumente. Se dice que un estimador es

consistente cuando éste converge a su valor verdadero cuando el número de datos

de la muestra tiende a infinito. En nuestro caso,

Var[µˆX ] = E (µˆX − µX )2

"

2 #

1 T

= E

1 (X − µX )

N

1 T

T

= E

1 (X − µX ) (X − µX ) 1

N2

1 T

=

1 CX 1.

N2

La operación 1T CX 1 resulta en la sumatoria de todas las componentes de la matriz

2

CX . Dado que dichas componentes están acotadas en valor absoluto por σX

, la

1

Apuntes de Procesos Estocásticos

Estimación de Parámetros

2.

do

r

2

sumatoria no puede exceder el valor σX

N 2 . En el imposible caso lı́mite, donde la

2

covarianza de la variable aleatoria fuese σX

para cualquier retardo, la varianza de

2

la estimación serı́a σX . Sin embargo, para los procesos normales y no periódicos, en

donde la función de covarianza tiene un máximo en el origen y siempre disminuye

a medida que tendemos a infinito, el valor de la sumatoria de las componentes de

CX aumenta más lentamente que N 2 . Como resultado, el estimador de la media es

consistente.

En el caso de que las realizaciones de X estén descorrelacionadas entre sı́, la

2

matriz CX resulta σX

I. De esta manera, podemos reescribir la ecuación anterior a

una más sencilla:

σ2

(1)

Var[µˆX ] = X .

N

Aquı́ vemos claramente que la varianza de la estimación tiende a cero a medida que

aumenta el número de muestras tomadas.

Estimación de la Varianza

rra

Dada la variable aleatoria X, podemos estimar la varianza de la misma mediante

la siguiente fórmula:

N

2

1 X

2

ˆ

σX =

Xi − µˆX .

N − 1 i=1

A diferencia del estimador de la media, este estimador posee un factor de escalado

igual a 1/(N − 1), denominado corrección de Bessel. En el caso de que las muestras

sean independientes entre sı́, este factor permite obtener un estimador insesgado de

la varianza.

Demostración.

#

N

2

1 X

Xi − µˆX

N −1

i=1

"N

#

X

2

1

E

Xi − µX + µX − µˆX

N −1

i=1

"N

#

N

N

X

2

X

X

2

1

E

Xi − µX − 2 µˆX − µX

Xi − µX +

µˆX − µX

N −1

i=1

i=1

i=1

#

"N

!

PN

X

2

2

1

i=1 Xi

E

Xi − µX − 2 µˆX − µX N

− µX + N µˆX − µX

N −1

N

i=1

"N

#

X

2

2

2

1

E

Xi − µX − 2N µˆX − µX + N µˆX − µX

N −1

i=1

"N

#

X

2

2

1

Xi − µX − N µˆX − µX

E

N −1

i=1

)

(N

h

X h

2 i

2 i

1

− N E µˆX − µX

E Xi − µX

N −1

Bo

"

h i

2 =E

E σˆX

=

=

=

=

=

=

i=1

2

Apuntes de Procesos Estocásticos

Estimación de Parámetros

En el primer término de la ecuación anterior se encuentra la fórmula analı́tica para la

varianza de una variable aleatoria, mientras que en el segundo término, encontramos

la varianza del estimador de la media. En el caso de variables i.i.d., este último

término resulta el encontrado en (1). Por lo tanto,

!

N

h i

2

X

σ

1

1

2

2

2

2

2

σX

−N X =

N σX

− σX

= σX

.

E σˆX

=

N − 1 i=1

N

N −1

r

La distribución de probabilidad de los valores del estimador de la varianza sigue

una distribución χ2 . Es por esto que la derivación de la varianza del estimador resulta

compleja y no se tratará en este apunte. Sin embargo, dejamos el resultado a modo

descriptivo:

do

h i (N − 1)2 (N − 1)(N − 3) 2

2

Var σˆX

=

E (X − µX )4 −

σX .

3

N

N3

Debido a que la dependencia de la varianza con respecto al número de muestras es

∼ 1/N , podemos ver que este estimador también es consistente.

3.

Estimación de la Autocorrelación

rra

La función de autocorrelación de un proceso es, de manera informal, la similitud

entre las observaciones de dicho proceso en función del tiempo de separación entre

ellas. Dado el proceso estocástico Xn podemos estimar su función de autocorrelación

mediante la siguiente fórmula:

ˆ(i)

RX (k) =

N −k

1 X

Xi Xi+k ,

N − k i=1

Bo

para 0 < k < N . Este estimador es insesgado como vemos a continuación:

ˆ(i)

E RX (k) =

N −k

1 X

E[Xi Xi+k ]

N − k i=1

N −k

1 X

=

RX (k)

N − k i=1

= RX (k).

Sin embargo, el estimador anterior tiene un inconveniente. A medida que el valor

de k aumenta, la sumatoria anterior contiene cada vez menos términos, lo que provoca

un promedio más ruidoso. El efecto es más notorio en los extremos del vector de

muestras, cuando k → N . Dado que la función de autocorrelación tiende a cero en

tiempo infinito1 , el resultado del estimador nos provee de información inválida en

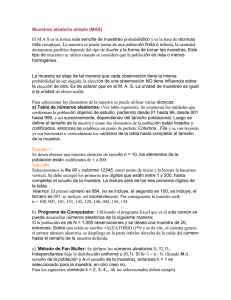

esta zona, como se aprecia en la Figura 1(a).

1

En el caso de un proceso de media nula y que no sea periódico. Si el proceso tiene media, la

autocorrelación tiende a un valor fijo igual a µ2X .

3

Apuntes de Procesos Estocásticos

Estimación de Parámetros

1,5

1

0,5

-200

0

k

200

400

do

-0,5

-400

r

0

(a) Estimación insesgada de la autocorrelación.

1,2

rra

0,8

0,4

0

-200

Bo

-400

0

k

200

400

(b) Estimación sesgada de la autocorrelación.

Figura 1: Comparación de los estimadores de la autocorrelación para ruido blanco

Gaussiano Xn ∼ N (0, 1) para N = 390.

En el caso de que el proceso sea de media nula, una manera de remediar el

problema mencionado es utilizando un estimador sesgado:

N −k

1 X

ˆ(s)

Xi Xi+k .

RX (k) =

N i=1

El objetivo de este nuevo estimador es anular las colas en la estimación. Vemos a

continuación que, para valores de k > 0, el estimador sesgado es simplemente una

4

Apuntes de Procesos Estocásticos

Estimación de Parámetros

versión escalada del estimador insesgado:

N −k

N −k 1 X

ˆ(s)

RX (k) =

Xi Xi+k

N − k N i=1

N −k

k

1 X

=

1−

Xi Xi+k

N N − k i=1

k

ˆ(i)

RX (k).

=

1−

N

4.

rra

do

r

El escalado resulta por el producto entre el valor insesgado y una ventana triangular.

Si el intervalo donde la autocorrelación verdadera posee valores no nulos es mucho

menor que el largo de las muestras N , el sesgo puede despreciarse.

En las Figuras 1(a) y 1(b), podemos apreciar los dos estimadores de la autocorrelación para la misma realización de un mismo proceso. Éste consiste de 390

muestras de un ruido blanco Gaussiano de media nula y varianza unitaria. En el

caso del estimador insesgado, Figura 1(a), es notorio el efecto de las pocas muestras

en la estimación en los lı́mites del intervalo. Incluso, los valores allı́ son superiores

al de k = 0. Por el contrario, en la Figura 1(b), el estimador sesgado nos provee de

información más exacta acerca de la dinámica del proceso.

La distribución de probabilidad de los valores del estimador de la autocorrelación

es similar al caso del estimador de la varianza. Es decir, este estimador, en cualquiera

de sus dos versiones, es consistente. Por esta razón, necesitamos muchas muestras

para que el valor del estimador en cada uno de los retardos tenga poco error. Como

vemos en los gráficos, los valores cercanos a k = 0 poseen bastante aleatoriedad

debido a las pocas muestras utilizadas.

Estimación de la Densidad Espectral de Potencia

Bo

La densidad espectral de potencia de una señal SX (ω) es una función matemática

que nos informa de cómo está distribuida la potencia de dicha señal en las distintas frecuencias que la forman, es decir, su espectro. Según el teorema de WienerKhinchin, en el caso de los procesos estocásticos tenemos que:

SX (ω) = F{RX (k)},

donde F{·} es la transformada de Fourier. Por simplicidad, a continuación sólo

tendremos en cuenta el caso discreto y utilizaremos la siguiente notación:

X̃(ω) = F{Xn } =

N

−1

X

Xi e−2πωi .

i=0

El estimador de la densidad espectral de potencia más utilizado es el del periodograma de la señal

|X̃(ω)|2

.

ŜX (ω) =

N

5

Estimación de Parámetros

i=

m

m

−

i

−

i=

0

−

(N

−

1)

Apuntes de Procesos Estocásticos

N −1

m

do

0

r

m

−

i=

N

−

1

N −1

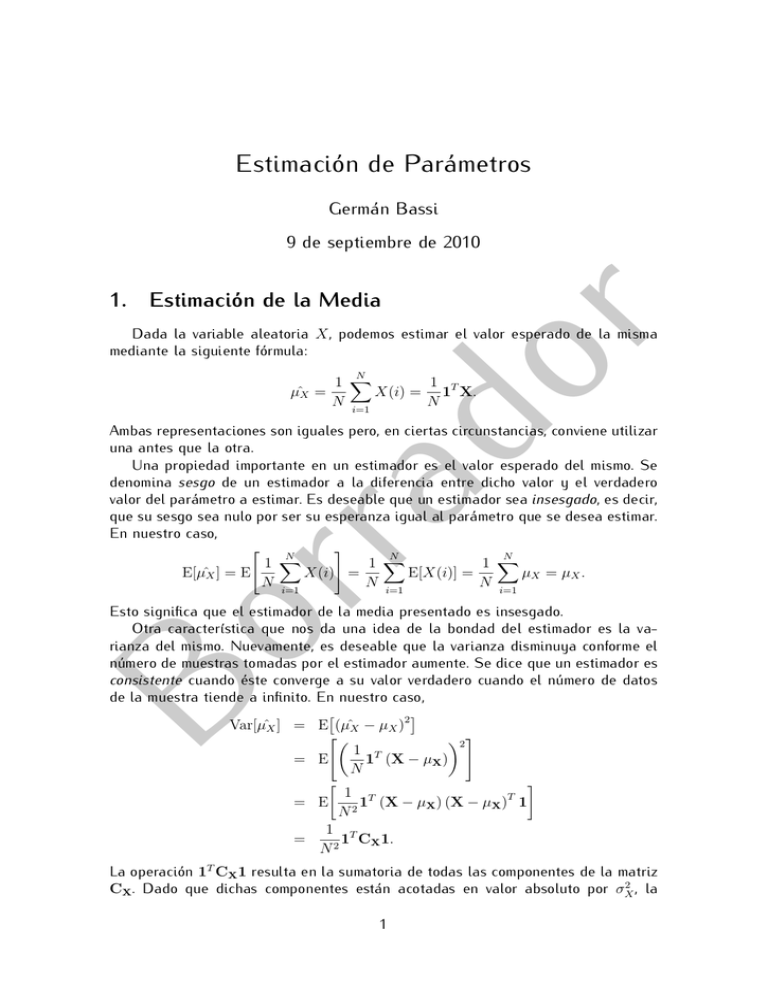

Figura 2: Representación gráfica de las sumatorias de (2). Los puntos grises corresponden a los términos de las sumatorias.

rra

Desarrollando la esperanza de este estimador podemos ver de dónde proviene:

i

h

i

1 h

E X̃(ω)X̃ ∗ (ω)

E ŜX (ω) =

N "

#

N

−1

N

−1

X

X

1

=

E

Xm e−2πωm

Xi e2πωi

N

m=0

i=0

N −1 N −1

1 XX

E[Xm Xi ] e−2πω(m−i)

N m=0 i=0

=

Bo

N −1 N −1

1 XX

=

RX (m − i)e−2πω(m−i) .

N m=0 i=0

(2)

La Figura 2 muestra los rangos y la cantidad de términos que poseen las sumatorias

de esta ecuación. Asimismo, notemos que los términos en las diagonales m0 = m − i

son todos iguales pero no ası́ su cantidad. Si tenemos en cuenta estos factores,

simplificamos la esperanza anterior de la siguiente manera:

h

i

E ŜX (ω) =

=

1

N

N

−1

X

0

(N − |m0 |) RX (m0 )e−2πωm

m0 =−(N −1)

N

−1

X

m0 =−(N −1)

|m0 |

0

1−

RX (m0 )e−2πωm .

N

(3)

El resultado anterior nos muestra dos aspectos de la esperanza del estimador de

la densidad espectral. Primero, los lı́mites de la sumatoria no son ±∞, y segundo, el

término entre paréntesis representa el mismo sesgo que el estimador de la función

de autocorrelación. En resumen, este estimador es sesgado. Sin embargo, a medida

6

Apuntes de Procesos Estocásticos

Estimación de Parámetros

que N → ∞, el término entre paréntesis tiende a uno, y los lı́mites de la sumatoria

tienden a ±∞, por lo tanto,

h

i

E ŜX (ω) −−−−−−−→ SX (ω).

N →∞

Importante: En (3) podemos ver que el periodograma es equivalente a tomar la

Transformada de Fourier del estimador sesgado de la autocorrelación, es decir,

ŜX (ω) =

N

−1

X

ˆ(s)

RX (k)e−2πωk .

r

k=−(N −1)

do

Al igual que en los casos anteriores, debemos analizar el comportamiento de la

varianza de este estimador para ver si es consistente. La derivación de esta varianza

es compleja y varı́a dependiendo del proceso Xn en particular. Sin embargo, de

realizar estos análisis verı́amos que la varianza del estimador no tiende a anularse a

medida que el número de muestras aumenta. De manera general, el comportamiento

de la varianza es:

h

i

Var ŜX (ω) = α SX (ω)2 .

En la Figura 3(a), vemos la estimación de la densidad espectral para el proceso

Wn + Wn−1

,

2

rra

Xn =

Bo

donde Wn es ruido blanco Gaussiano de media nula y varianza unitaria. Aquı́ apreciamos claramente el comportamiento de la varianza enunciado anteriormente. Dado

que el proceso Xn es un promediador, sus componentes espectrales están en las

bajas frecuencias. Allı́, donde los valores son altos, también lo es la varianza del

estimador. Por otro lado, en el lı́mite de la alta frecuencia, ±π, la densidad espectral

de potencia es nula y la varianza del estimador, mı́nima.

Para combatir este problema, recurrimos a un segundo estimador de la densidad

espectral:

L−1

1X

(ave)

ŜX,l (ω).

ŜX (ω) =

L l=0

Este nuevo estimador es el promedio de L periodogramas distintos del proceso Xn ,

con lo que logramos suavizar las variaciones de los mismos.

La esperanza del estimador resulta igual al caso anterior ya que sólo estamos

promediando varias estimaciones:

L−1

L−1

h

i

i

1X h

1X

(ave)

E ŜX (ω) =

E ŜX,l (ω) −−−−−−−→

SX (ω) = SX (ω).

N →∞

L l=0

L l=0

Y por último, dado que las distintas realizaciones del estimador son independientes entre sı́2 , la varianza del estimador suavizado tiende a cero a medida que el

2

Esto surge del análisis de la varianza del estimador, ver [1].

7

Apuntes de Procesos Estocásticos

Estimación de Parámetros

10

8

6

4

-4

-3

-2

-1

0

1

2

3

4

do

0

r

2

(a) Periodograma del proceso Xn .

1,4

Estimada

Teórica

1,2

rra

1

0,8

0,6

0,4

Bo

0,2

0

-4

-3

-2

0

-1

1

2

3

4

(b) Periodograma suavizado del proceso Xn .

Figura 3: Comparación de los estimadores de la densidad espectral de potencia para

el proceso Xn = (Wn + Wn−1 )/2, donde Wn ∼ N (0, 1) i.i.d..

número de bloques crece:

h

i

(ave)

Var ŜX (ω) =

L−1

h

i

1 X

Var

Ŝ

(ω)

X,l

L2 l=0

1

L α SX (ω)2

L2

α

=

SX (ω)2 −−−−−−−→ 0.

L→∞

L

=

En la Figura 3(b), vemos el estimador suavizado donde podemos apreciar cómo

8

Apuntes de Procesos Estocásticos

Estimación de Parámetros

r

éste sigue más fielmente el valor teórico de la densidad espectral de potencia del

proceso Xn . Para esta simulación el tamaño de los bloques fue N = 1024 y la

cantidad de bloques promediados, L = 64. En el caso de la Figura 3(a), la cantidad

de muestras utilizadas para el periodograma simple fue N = 1024 × 64.

En este segundo estimador, el número de muestras necesario para la estimación

es N × L, N muestras por periodograma y L periodogramas promediados. Dado que

uno dispone de una cantidad determinada de muestras, debemos elegir en cuántos

bloques de N muestras dividiremos nuestro total. Si elegimos un valor de L muy

grande para disminuir el error de estimación, el valor de N será chico, y por consiguiente, la discriminación en frecuencia que logramos con la Transformada de Fourier

será poca. Por el contrario, si tomamos un valor de N grande para tener una gran

discriminación en frecuencia, el error de estimación será más notorio.

do

Referencias

[1] Leon-Garcia, Alberto: Probability and Random Processes for Electrical Engineering, 2da edición. Massachusetts: Addison-Wesley, 1994.

[2] Papoulis, Athanasios: Probability, Random Variables and Stochastic Processes,

3ra edición. New York: McGraw-Hill, 1991.

Bo

rra

[3] Wolfram MathWorld: Sample Variance Distribution from Wolfram MathWorld. http://mathworld.wolfram.com/SampleVarianceDistribution.html

(consultado el 27 de agosto de 2010).

9