Estadística II

Unidad 4. Análisis de regresión

Objetivo. El alumno aplicará modelos de comportamiento multivariado y matricial para la

obtención de la recta de mejor ajuste, obtendrá sus intervalos de confianza e identificará

diferentes esquemas de análisis de regresión no lineal.

4.1 Conceptos

Se iniciará esta unidad con un breve repaso del modelo de regresión lineal simple.

Modelo de regresión lineal simple

𝑌𝑖 = 𝛽0 + 𝛽1 𝑋𝑖 + 𝜀𝑖 − − − (𝑎)

𝑌̂ = 𝑏0 + 𝑏1 𝑋

La suma de los cuadrados de los errores es

𝑆 = ∑𝑛𝑖=1 𝜀𝑖2 = ∑𝑛𝑖=1(𝑌𝑖 − 𝛽0 − 𝛽1 𝑋𝑖 )2

Modelo matricial de regresión lineal simple

Sean 𝑌 el vector de observaciones 𝑌𝑖 , 𝑋 la

matriz de variables predictoras, 𝛽 el vector de

parámetros a estimar, 𝜀 el vector de errores y 1

un vector de unos.

𝑌1

Minimizando la suma de los cuadrados de los

𝑌2

errores:

𝑌=[ ]

⋮

𝜕𝑆

𝑌

𝑛

𝑛

= −2 ∑𝑖=1(𝑌𝑖 − 𝛽0 − 𝛽1 𝑋𝑖 )

𝜕𝛽

1

1

𝑋=[

⋮

1

𝜀1

𝜀2

𝜀=[⋮]

𝜀𝑛

1

1 = [ 1]

1

1

0

𝜕𝑆

= −2 ∑𝑛𝑖=1 𝑋𝑖 (𝑌𝑖 − 𝛽0 − 𝛽1 𝑋𝑖 )

𝜕𝛽1

Los estimadores 𝑏0 y 𝑏1 se obtienen al resolver el

siguiente sistema de ecuaciones:

∑𝑛𝑖=1(𝑌𝑖 − 𝑏0 − 𝑏1 𝑋𝑖 ) = 0

∑𝑛𝑖=1 𝑋𝑖 (𝑌𝑖 − 𝑏0 − 𝑏1 𝑋𝑖 ) = 0

𝛽0 + 𝛽1 𝑋1

𝛽0 + 𝛽1 𝑋2

𝑋𝛽 = [

]

⋮

𝛽0 + 𝛽1 𝑋𝑛

𝑋1

𝛽

𝑋2

] 𝛽 = [ 0]

⋮

𝛽1

𝑋𝑛

𝛽0 + 𝛽1 𝑋1 + 𝜀1

𝛽0 + 𝛽1 𝑋2 + 𝜀2

𝑋𝛽 + 𝜀 = [

]

⋮

𝛽0 + 𝛽1 𝑋𝑛 + 𝜀𝑛

En su forma normal, las ecuaciones toman la De este modo, (𝑎) puede expresarse como 𝑌 =

forma

𝑋𝛽 + 𝜀. Aplicando el procedimiento de mínimos

cuadrados, se tendría que encontrar una

𝑏0 𝑛 + 𝑏1 ∑𝑛𝑖=1 𝑋𝑖 = ∑𝑛𝑖=1 𝑌𝑖

expresión matricial equivalente a (𝑏):

(𝑏) − − − {

𝑏0 ∑𝑛𝑖=1 𝑋𝑖 + 𝑏1 ∑𝑛𝑖=1 𝑋𝑖2 = ∑𝑛𝑖=1 𝑋𝑖 𝑌𝑖

1 1

… 1

𝑋 ′ = [𝑋 𝑋 … 𝑋 ]

Por conveniencia de cálculo, se usan las

1

2

𝑛

∑𝑛𝑖=1 𝑋𝑖

𝑛

siguientes expresiones:

′

𝑋𝑋=[ 𝑛

]

∑𝑖=1 𝑋𝑖 ∑𝑛𝑖=1 𝑋𝑖2

𝑆𝑋𝑌 = ∑(𝑋𝑖 − 𝑋̅)(𝑌𝑖 − 𝑌̅) = ∑ 𝑋𝑖 𝑌𝑖 − 𝑛𝑋̅𝑌̅

∑𝑛𝑖=1 𝑌𝑖

′

𝑋

𝑌

=

[

]

2

2

2

̅

̅

𝑆𝑋𝑋 = ∑(𝑋𝑖 − 𝑋) = ∑ 𝑋𝑖 − 𝑛𝑋

∑𝑛𝑖=1 𝑋𝑖 𝑌𝑖

2

2

2

𝑆𝑌𝑌 = ∑(𝑌𝑖 − 𝑌̅) = ∑ 𝑌𝑖 − 𝑛𝑌̅

𝑏1 = 𝑆𝑋𝑌 ⁄𝑆𝑋𝑋

Con esto, (𝑏) se puede escribir como 𝑋 ′ 𝑋𝑏 = 𝑋′𝑌.

Entonces 𝑏 = (𝑋′𝑋)−1 𝑋′𝑌, siempre que exista

𝑏0 = 𝑌̅ − 𝑏1 𝑋̅

∑ 𝑋𝑖2 − ∑ 𝑋𝑖

1

−1

(𝑋′𝑋)

=

[

].

2

2 ⁄

𝑛 ∑(𝑋𝑖 −𝑋̅)2 − ∑ 𝑋

∑(𝑌̂𝑖 − 𝑌̅) = 𝑆𝑋𝑌

𝑆𝑋𝑋

𝑛

𝑖

61

Estadística II

ANOVA del modelo de regresión lineal simple. Considérese la siguiente identidad:

𝑌𝑖 − 𝑌̂𝑖 = (𝑌𝑖 − 𝑌̅) − (𝑌̂𝑖 − 𝑌̅)

Al seguir el procedimiento de análisis de varianza visto en la unidad anterior se tiene:

∑(𝑌𝑖 − 𝑌̅)2 =

2

∑(𝑌̂𝑖 − 𝑌̅) +

2

∑(𝑌𝑖 − 𝑌̂𝑖 )

Suma de

cuadrados

alrededor

de la media

Suma de

cuadrados

debidos a la

regresión

Suma de

cuadrados

debidos

al error

Con esto, se llega a la tabla ANOVA del modelo de regresión lineal simple:

Fuente

Debido a la

regresión

Sobre la regresión

(residuales)

Total

df

SS

1

𝑆𝑆(𝑏1 |𝑏0 ) = ∑

𝑛

𝑛−2

∑

∑

MS

2

(𝑌̂𝑖 − 𝑌̅)

𝑖=1

2

(𝑌𝑖 − 𝑌̂𝑖 )

𝑖=1

𝑛

𝑛−1

𝑛

𝑀𝑆𝑟𝑒𝑔

𝑆𝑆⁄(𝑛 − 2) = 𝑆 2

(𝑌𝑖 − 𝑌̅)2

𝑖=1

Tarea. Estudiar la definición de los grados de libertad del ANOVA del modelo de regresión

lineal en el libro de Draper (página 30).

62

Estadística II

Estadístico 𝑹𝟐 . Mide el ajuste del modelo como una proporción de la variación total

̅ 2

̂

𝑆𝑆𝑟𝑒𝑔𝑟𝑒𝑠𝑖ó𝑛

∑(𝑌 −𝑌)

alrededor de la media (𝑌̅) explicada por la regresión: 𝑅 2 = 𝑆𝑆

= ∑(𝑌𝑖−𝑌̅)2 .

𝑡𝑜𝑡𝑎𝑙

𝑖

63

Estadística II

Significancia de la regresión. Bajo los supuestos conocidos del análisis de varianza

para los residuales del modelo (comportamiento de 𝜀𝑖 como ruido blanco gaussiano), se

puede construir un test 𝐹 para medir la significancia de la regresión. La hipótesis nula

sería 𝐻0 : 𝛽1 = 0 contra 𝐻𝑎 : 𝛽1 ≠ 0. El estadístico de prueba estaría definido por 𝐹 =

𝑀𝑆𝑟𝑒𝑔

𝑆2

y

se compararía con los valores de la distribución 𝐹1,𝑛−2 .

Intervalos de confianza para los parámetros del modelo. Bajo el supuesto de que los

residuales del modelo se comportan como ruido blanco gaussiano, se pueden establecer

límites de confianza para 𝛽0 y 𝛽1 , respectivamente:

1⁄2

∑ 𝑋2

𝑏0 ± 𝑡(𝑛 − 2, 1 − 𝛼 ⁄2) { ∑(𝑋 𝑖 ̅ )2 }

𝑛

Tarea.

Demostrar

que

𝑡(𝑛−2,1−𝛼⁄2)𝑆

̅ )2 }1⁄2

𝑖 −𝑋

𝑆

𝑖 −𝑋

𝑏1 ± {∑(𝑋

𝜎2

𝜎2

=

, 𝐸(𝑏1 ) = 𝛽1 , 𝐸(𝑏0 ) = 𝛽0 , 𝑉𝑎𝑟(𝑏0 ) =

̅ )2

𝑆𝑋𝑋

𝑖 −𝑋

𝑉𝑎𝑟(𝑏1 ) = ∑(𝑋

∑ 𝑋𝑖2

𝜎2.

𝑛 ∑(𝑋𝑖 −𝑋̅)2

Correlación entre 𝑿 e 𝒀. Cuando la correlación 𝑟𝑥𝑦 no es cero, existe una asociación

lineal entre los valores específicos 𝑋𝑖 y 𝑌𝑖 . En el modelo de regresión lineal simple

⁄

∑(𝑌 −𝑌̅)2 1 2

𝑏1 = {∑(𝑋𝑖−𝑋̅)2 }

𝑖

𝑟𝑥𝑦

𝑆

𝑏1 = 𝑆𝑌 𝑟𝑥𝑦

𝑋

Como puede apreciarse, 𝑏1 y 𝑟𝑥𝑦 están relacionados, pero conducen a diferentes

interpretaciones. 𝑟𝑥𝑦 mide la asociación lineal entre 𝑋 e 𝑌, libre de escalas y medidas; en

tanto, 𝑏1 mide el tamaño del cambio que se da en 𝑌 cada vez que 𝑋 sufre cambio en una

unidad. 𝑅, llamado coeficiente de correlación múltiple, resulta ser la correlación entre 𝑌 y

𝑌̂, es decir, 𝑟𝑌𝑌̂ .

̂ . Se puede demostrar que 𝐶𝑜𝑣 (𝑌̅, 𝑏1 ) = 0, es decir, 𝑌̅ y 𝑏1 son

Error estándar de 𝒀

variables aleatorias no correlacionadas. Con 𝑏0 = 𝑌̅ − 𝑏1 𝑋̅, el modelo 𝑌̂ = 𝑏0 + 𝑏1 𝑋 se

puede escribir como 𝑌̂ = 𝑌̅ + 𝑏1 (𝑋 − 𝑋̅). Dado un valor específico de 𝑋, dígase 𝑋0 , es

posible predecir la respuesta media 𝜇𝑌|𝑋0 en 𝑋 = 𝑋0 : 𝑌̂ − 𝑌̅ = 𝑏1 (𝑋0 − 𝑋̅). Dado que 𝑋0 y 𝑋̅

2

̅ 2 2

(𝑋0 −𝑋) 𝜎

𝜎

son fijos y 𝐶𝑜𝑣 (𝑌̅, 𝑏1 ) = 0 ⇒ 𝑉𝑎𝑟(𝑌̂0 ) = 𝑉𝑎𝑟(𝑌̅) + (𝑋0 − 𝑋̅)2 𝑉𝑎𝑟(𝑏1 ) = 𝑛 + ∑(𝑋

. Como

−𝑋̅)2

𝑖

⁄

(𝑋 −𝑋̅)2 1 2

1

consecuencia, el error estándar de 𝑌̂0 es 𝑆 { + ∑(𝑋0 ̅ )2 } .

𝑛

𝑖 −𝑋

Con base en lo anterior, el intervalo de confianza para la respuesta media 𝜇𝑌|𝑋0 es 𝑌̂0 ±

1

⁄

(𝑋 −𝑋̅)2 1 2

𝑡(𝑛 − 2, 1 − 𝛼 ⁄2) {𝑛 + ∑(𝑋0 −𝑋̅)2 }

𝑖

𝑆.

Es más común interesarse en la predicción de una observación individual y no tanto de la

respuesta media. En este caso se desea conocer el error estándar de 𝑌̂0 − 𝑌 para

encontrar su correspondiente intervalo de confianza. Por una parte, 𝐸(𝑌̂0 − 𝑌) =

𝐸[𝛽0 + 𝛽1 𝑋0 − (𝑏0 + 𝑏1 𝑋0 + 𝜀0 )] = 0. Por otro lado, dado que 𝑌 es independiente de 𝑌̂,

64

Estadística II

2

̅ 2 2

̅ 2

(𝑋0 −𝑋) 𝜎

(𝑋 −𝑋)

𝜎

1

𝑉𝑎𝑟(𝑌̂0 − 𝑌) = 𝑉𝑎𝑟(𝑌̂0 ) + 𝑉𝑎𝑟(𝑌) = 𝑛 + ∑(𝑋

+ 𝜎 2 = 𝜎 2 (1 + 𝑛 + ∑(𝑋0 −𝑋̅)2 ).

−𝑋̅)2

𝑖

𝑖

De

este

modo, el intervalo de confianza para la predicción de una observación individual es:

̅ 2 1⁄2

(𝑋 −𝑋)

1

𝑌̂0 ± 𝑡(𝑛 − 2, 1 − 𝛼 ⁄2) {1 + 𝑛 + ∑(𝑋0 −𝑋̅)2 }

𝑖

𝑆

Los coeficientes de regresión estandarizados definen la ecuación de regresión cuando

ésta se obtiene después de estandarizar las variables originales. En este caso, 𝛽1 =

𝑏1 (𝑆𝑥 ⁄𝑆𝑦 ) y entonces 𝛽1 coincide con el coeficiente de correlación de Pearson.

Tarea. Realizar los siguientes ejercicios del texto de Draper, con apoyo de R: A (1 a 7), B

(1, 2, 3, 4), C, E (1 a 6), F (1 a 3), G (1 y 2), H y K (1 a 8). En todos los casos donde se

genere un modelo, se deben comprobar los supuestos teóricos.

65

Estadística II

66

Estadística II

67

Estadística II

68

Estadística II

69

Estadística II

4.2 La situación general de regresión

En esta sección se generaliza el modelo de regresión lineal para el caso en el que existen

dos o más variables independientes. Supóngase que se tiene bajo consideración el

modelo 𝑌 = 𝑋𝛽 + 𝜀, en donde

𝑌 es un vector de observaciones (𝑛 𝑥 1)

𝑋 es una matriz (𝑛 𝑥 𝑝)

𝛽 es un vector de parámetros (𝑝 𝑥 1)

𝜀 es el vector de errores (𝑛 𝑥 1)

Se establecen también las siguientes suposiciones: 𝐸(𝜀) = 0, 𝑉𝑎𝑟(𝜀) = 𝐼𝜎 2 y los

elementos de 𝜀 son no correlacionados (es decir, se trata de ruido blanco). Dado que

𝐸(𝜀) = 0, 𝐸(𝑌) = 𝑋𝛽.

Como en el caso del modelo de regresión lineal simple, se utilizará el método de mínimos

cuadrados para estimar los parámetros. Dado que la aplicación de dicho método se

aplicará sobre vectores y matrices, será necesario repasar algunos resultados de álgebra

y cálculo matriciales.

Transposición de matrices. La transpuesta de una matriz 𝐴 de dimensión 𝑚 𝑥 𝑛 es la

matriz 𝐴′ de dimensión 𝑛 𝑥 𝑚 obtenida al intercambiar las filas y las columnas de 𝐴. Esta

operación posee algunas propiedades interesantes:

(𝐴′ )′ = 𝐴

Si 𝐴 y 𝐵 son matrices de la misma dimensión, (𝐴 + 𝐵)′ = 𝐴′ + 𝐵′

Si 𝑐 es una constante, (𝑐𝐴)′ = 𝑐𝐴′

Si 𝐴 y 𝐵 son matrices cuyas dimensiones permiten el producto 𝐴𝐵, (𝐴𝐵)′ = 𝐵′ 𝐴′

Definición (derivada de un vector). Dada 𝑓 una función de 𝑛 variables que se pueden

𝜕𝑓

identificar con un vector 𝑥 de ℛ 𝑛 , se define la derivada de 𝑓 respecto a 𝑥, 𝜕𝑥 , como un

𝜕𝑓

vector cuyas componentes son (𝜕𝑥 ) .

𝑖

𝑖

Definición (derivada de una matriz). Dada 𝑓 una función de 𝑛𝑝 variables que se pueden

𝜕𝑓

identificar con una matriz 𝑥𝑛,𝑝 , se define la derivada de 𝑓 respecto a 𝑥, 𝜕𝑥 , como una

𝜕𝑓

)

𝜕𝑥𝑖𝑗

matriz cuyos componentes son (

.

𝑖𝑗

Método de mínimos cuadrados para estimar los parámetros del modelo de

regresión. La suma de los cuadrados de los errores se escribe como

𝜀 ′ 𝜀 = (𝑌 − 𝑋𝛽)′ (𝑌 − 𝑋𝛽)

= 𝑌 ′ 𝑌 − 𝑌 ′ 𝑋𝛽 − 𝛽 ′ 𝑋 ′ 𝑌 + 𝛽 ′ 𝑋 ′ 𝑋𝛽

= 𝑌 ′ 𝑌 − 2𝑌 ′ 𝑋𝛽 + 𝛽′𝑋′𝑋𝛽

70

Estadística II

El estimador de mínimos cuadrados de 𝛽 es el valor 𝑏, el cual, sustituido en la ecuación

anterior, minimiza 𝜀 ′ 𝜀. Diferenciando 𝜀 ′ 𝜀 con respecto a 𝛽:

𝑌 ′ 𝑋𝛽 = ∑𝑛𝑖=1 𝑌𝑖 𝛽0 + ∑𝑛𝑖=1 𝑌𝑖 𝑋𝑖1 𝛽1 + … + ∑𝑛𝑖=1 𝑌𝑖 𝑋𝑖,𝑝−1 𝛽𝑝−1

𝜕(𝑌 ′ 𝑋𝛽)

= ∑𝑛𝑖=1 𝑌𝑖 , ∑𝑛𝑖=1 𝑌𝑖 𝑋𝑖1 , … , ∑𝑛𝑖=1 𝑌𝑖 𝑋𝑖,𝑝−1 (vector transpuesto)

𝜕𝛽

𝜕(𝑌 ′ 𝑋𝛽)

=[

𝜕𝛽

Tarea. Comprobar que

1

1

𝑋11 𝑋21

⋮ ⋮

𝑋1,𝑝−1 𝑋2,𝑝−1

𝑌1

… 1

… 𝑋𝑛1

𝑌2

⋱ ⋮ ] [ ⋮ ] = 𝑋′𝑌

… 𝑋𝑛,𝑝−1 𝑌𝑛

𝜕(𝛽 ′ 𝑋 ′ 𝑋𝛽)

= 2𝑋′𝑋𝛽.

𝜕𝛽

Igualando a cero y sustituyendo a 𝛽 por 𝑏, se llega nuevamente a las ecuaciones

normales

(𝑋 ′ 𝑋)𝑏 = 𝑋 ′ 𝑌 − − − (𝑎)

Si las 𝑝 ecuaciones de (𝑎) son independientes, entonces 𝑋 ′ 𝑋 es no singular y existe

(𝑋′𝑋)−1 , de tal suerte que 𝑏 = (𝑋′𝑋)−1 𝑋 ′ 𝑌. La solución obtenida, 𝑏, tiene las siguientes

propiedades:

i.

ii.

iii.

Es un estimador insesgado y de mínima varianza de 𝛽.

Minimiza la suma de los cuadrados de los errores, 𝜀 ′ 𝜀, independientemente de las

propiedades de dichos errores (es decir, el supuesto de normalidad de los

residuales no se requiere para calcular 𝑏, pero sí para hacer tests del tipo 𝑡 o 𝐹, o

para obtener intervalos de confianza).

Si los errores se distribuyen como ruido blanco gaussiano, entonces 𝑏 resulta ser

también el estimador de máxima verosimilitud de 𝛽.

Asumiendo que 𝐸(𝜀) = 0, 𝑉𝑎𝑟(𝜀) = 𝐼𝜎 2 , siendo 𝜀𝑖 normalmente distribuido o no:

1. Los valores ajustados de 𝑌 se obtienen por 𝑌̂ = 𝑋𝑏

2. El vector de residuales es 𝜀 = 𝑌 − 𝑌̂

3. Los residuos no se correlacionan con las variables explicativas:

𝑋 ′ 𝑌 = 𝑋′𝑋𝛽

𝑋 ′ 𝑌 − 𝑋 ′ 𝑋𝛽 = 0

𝑋 ′ (𝑌 − 𝑋𝛽) = 0 ⇒ 𝑋 ′ 𝜀 = 0 (porque 𝑌 = 𝑋𝛽 + 𝜀)

4. 𝑉𝑎𝑟(𝑏) = (𝑋′𝑋)−1 𝜎 2 es una matriz cuya diagonal principal indica las varianzas de

los estimadores 𝑏; los demás elementos de la matriz son las covarianzas de 𝑏.

5. Sea 𝑋0′ tal que 𝑌̂0 = 𝑋0′ 𝑏 = 𝑏′𝑋0 es el valor ajustado sobre una posición definida por

𝑋0 . Entonces 𝑉𝑎𝑟(𝑌̂0 ) = 𝑋0′ 𝑉𝑎𝑟(𝑏)𝑋0 = 𝑋0′ (𝑋′𝑋)−1 𝑋0 𝜎 2 .

6. La tabla ANOVA básica del modelo queda como (obsérvese que no hay

corrección):

71

Estadística II

Fuente

Regresión

Residual

Total

df

𝑝

𝑛−𝑝

𝑛

SS

𝑏′𝑋′𝑌

𝑌 ′ 𝑌 − 𝑏′𝑋′𝑌

𝑌′𝑌

MS

𝑀𝑆𝑟𝑒𝑔𝑟𝑒𝑠𝑖ó𝑛

𝑀𝑆𝑟𝑒𝑠𝑖𝑑𝑢𝑎𝑙

Estadístico 𝑹𝟐 . Es el cuadrado del coeficiente de correlación múltiple 𝑅, y se define por

̅ 2

̂

∑(𝑌 −𝑌)

𝑅 2 = ∑(𝑌𝑖−𝑌̅)2 . 𝑅 2 es el cuadrado de la correlación entre 𝑌 y 𝑌̂ y toma valores en el

𝑖

intervalo [0, 1].

𝑹𝟐 ajustada. Supóngase que 𝑝 es el número total de parámetros en el modelo ajustado,

incluyendo 𝛽0 . Se define el estadístico 𝑅 2 ajustada como una medida del monto de la

𝑛−1

variación alrededor de la media explicada por la ecuación: 𝑅𝑎2 = 1 − (1 − 𝑅 2 ) (𝑛−𝑝). El

ajuste está en la incorporación en la ecuación anterior de los grados de libertad de las

sumas de cuadrados totales y residuales, según la tabla ANOVA.

Contrastes 𝒕 y 𝑭. Si los residuos se comportan como ruido blanco gaussiano, se puede

utilizar el habitual contraste 𝐹 para probar la hipótesis de regresión:

𝐻0 : todas las 𝛽′s (excepto 𝛽0 ) son cero

𝐻𝑎 : al menos una de las 𝛽′s (sin considerar 𝛽0 ) es diferente de cero

Por otro lado, el contraste 𝑡 se emplea para evaluar la significancia de cada 𝛽 en forma

independiente.

Límites de confianza. Con 𝜀~𝑁(0, 𝜎 2 ), se pueden establecer los siguientes límites de

confianza para el verdadero valor medio de 𝑌 en 𝑋0 (𝑆𝑣2 es el estimador de 𝜎 2 ):

𝑌̂0 ± 𝑡(𝑛 − 𝑝, 1 − 𝛼 ⁄2)𝑆𝑣 √𝑋0′ (𝑋′𝑋)−1 𝑋0

Por otro lado, bajo la hipótesis de ruido blanco gaussiano para los residuos,

𝑏~𝑁(𝛽, (𝑋 ′ 𝑋)−1 𝜎 2 ) y se establece el siguiente límite de confianza para cada coeficiente

de regresión:

2

𝑏𝑖 ± 𝑡(𝑛 − 𝑝, 1 − 𝛼 ⁄2)√(𝑋 ′ 𝑋)−1

𝑖𝑖 𝜎

72

Estadística II

4.3 Métodos de selección de variables (práctica)

En equipos de tres a cinco personas utilice un paquete estadístico para realizar las

siguientes actividades:

1. Resuelva los problemas A y B contenidos en la página 170 del libro de Draper.

Compruebe en cada caso los supuestos del modelo de regresión.

2. Indague los métodos de selección de variables para un modelo de regresión lineal

múltiple y la forma como se implementan en R.

3. La tabla proporciona información sobre la resistencia a la ruptura de un fusible (𝑦),

la altura del dado (𝑥1 ), la altura del poste (𝑥2 ), la altura del rizo (𝑥3 ), la longitud del

alambre (𝑥4 ), el ancho de la unión con el dado (𝑥5 ) y el ancho de la unión con el

poste (𝑥6 ).

73

Estadística II

𝒚

8.0

8.3

8.5

8.8

9.0

9.3

9.3

9.5

9.8

10.0

10.3

10.5

10.8

11.0

11.3

11.5

11.8

12.3

12.5

𝒙𝟏

5.2

5.2

5.8

6.4

5.8

5.2

5.6

6.0

5.2

5.8

6.4

6.0

6.2

6.2

6.2

5.6

6.0

5.8

5.6

𝒙𝟐

19.6

19.8

19.6

19.4

18.6

18.8

20.4

19.0

20.8

19.9

18.0

20.6

20.2

20.2

19.2

17.0

19.8

18.8

18.6

𝒙𝟑

29.6

32.4

31.0

32.4

28.6

30.6

32.4

32.6

32.2

31.8

32.6

33.4

31.8

34.2

31.4

33.2

35.4

34.0

34.2

𝒙𝟒

94.9

89.7

96.2

95.6

86.5

84.5

88.8

85.7

93.6

86.0

87.1

93.1

83.4

94.5

83.4

85.2

84.1

86.9

83.0

𝒙𝟓

2.1

2.1

2.0

2.2

2.0

2.1

2.2

2.1

2.3

2.1

2.0

2.1

2.2

2.1

1.9

2.1

2.0

2.1

1.9

𝒙𝟔

2.3

1.8

2.0

2.1

1.8

2.1

1.9

1.9

2.1

1.8

1.6

2.1

2.1

1.9

1.8

2.1

1.8

1.8

2.0

a. Ajuste un modelo de regresión utilizando todas las variables

independientes.

b. Utilice la regresión por pasos con un nivel de significancia de ingreso 0.025

y un nivel de significancia de eliminación de 0.05.

c. Utilice todos los modelos de regresión posibles y compare sus respectivos

valores de 𝑅 2 , 𝑅 2 ajustada y Durbin Watson.

d. Compruebe los supuestos teóricos de regresión para el modelo definitivo.

e. Argumente sus resultados.

4.4 Comprobación de los supuestos del modelo de regresión lineal

A partir de las secciones anteriores, se pueden listar las siguientes premisas del análisis

de regresión:

1.

2.

3.

4.

5.

La relación entre la respuesta y los regresores es aproximadamente lineal

El error 𝜖 tiene media cero

El error 𝜖 tiene varianza 𝜎 2 constante

Los errores no están correlacionados

Los errores se distribuyen normalmente (este supuesto es necesario para probar

hipótesis y estimar intervalos de confianza).

El análisis de regresión no termina con la estimación de los parámetros del modelo y el

análisis de significancia de los mismos individualmente y en conjunto. Es necesario

analizar la validez de los cinco supuestos anteriormente planteados.

Como se recordará, el vector de residuales está definido por 𝜀 = 𝑌 − 𝑌̂ y su varianza se

estima con 𝑀𝑆𝑟𝑒𝑠𝑖𝑑𝑢𝑎𝑙 . Los valores 𝑒𝑖 = 𝑌𝑖 − 𝑌̂𝑖 se llaman residuales no tipificados. El

74

Estadística II

modelo es 𝑌 = 𝑋𝛽 + 𝜀 y las ecuaciones normales son 𝑋 ′ 𝑋𝑏 = 𝑋′𝑌 con solución 𝑏 =

(𝑋 ′ 𝑋)−1 𝑋′𝑌 (siempre que 𝑋 ′ 𝑋 sea no singular). Los valores ajustados son 𝑌̂ = 𝑋𝑏 =

𝑋(𝑋 ′ 𝑋)−1 𝑋 ′ 𝑌 = 𝐻𝑌 y entonces 𝑒 = 𝑌 − 𝑌̂ = 𝑌 − 𝐻𝑌 = (𝐼 − 𝐻)𝑌.

Tarea. La matriz 𝐻 = 𝑋(𝑋 ′ 𝑋)−1 𝑋 ′ es llamada “matriz sombrero” y resulta de utilidad para

el trabajo de análisis de residuales. Compruebe que tanto 𝐻 como (𝐼 − 𝐻) son simétricas

e idempotentes.

Dado que 𝐸(𝑌) = 𝑋𝛽 y que (𝐼 − 𝐻)𝑋 = 0, 𝑒 − 𝐸(𝑒) = (𝐼 − 𝐻)(𝑌 − 𝑋𝐵) = (𝐼 − 𝐻)𝜀. De este

modo, la matriz de varianzas y covarianzas de 𝑒 queda definida por

𝑉𝑎𝑟(𝑒) = 𝐸{[𝑒 − 𝐸(𝑒)][𝑒 − 𝐸(𝑒)]′} = (𝐼 − 𝐻)𝐸(𝜀𝜀 ′ )(𝐼 − 𝐻)′

Bajo el supuesto de que 𝐸(𝜀) = 0, 𝐸(𝜀𝜀 ′ ) = 𝑉𝑎𝑟(𝜀) = 𝐼𝜎 2 , y con las condiciones de

simetría e idempotencia para (𝐼 − 𝐻), 𝑉𝑎𝑟(𝑒) = (𝐼 − 𝐻)𝜎 2 . Así, 𝑉𝑎𝑟(𝑒𝑖 ) es el 𝑖-ésimo

elemento de la diagonal principal de (𝐼 − 𝐻)𝜎 2 , es decir, (1 − ℎ𝑖𝑖 )𝜎 2 , en tanto 𝐶𝑜𝑣(𝑒𝑖 , 𝑒𝑗 ) =

−𝜎 2 ℎ𝑖𝑗 ; con esto, la correlación entre 𝑒𝑖 𝑦 𝑒𝑗 se calcula como 𝜌𝑖𝑗 =

−ℎ𝑖𝑗

[(1−ℎ𝑖𝑖 )(1−ℎ𝑗𝑗 )]

1⁄2

𝐶𝑜𝑣(𝑒𝑖 ,𝑒𝑗 )

[𝑉𝑎𝑟(𝑒𝑖 )𝑉𝑎𝑟(𝑒𝑗 )]

1⁄2

=

. Es de destacar que los residuales tienen distintas varianzas y además

están correlacionados (esto debido a que en la regresión sólo hay 𝑛 − 𝑝 grados de

libertad). Aunque esto parece echar por tierra a priori los supuestos del modelo de

regresión, más adelante se verá bajo qué condiciones el comportamiento de los

residuales se considera “satisfactorio”.

En general, trabajar con algunas transformaciones de los residuales es de utilidad, por

ejemplo, para identificar valores atípicos cuyo análisis ayude a mejorar el ajuste del

modelo.

Los residuales estandarizados (tipificados), 𝑑𝑖 , se calculan dividiendo a cada residual

entre la raíz de sus cuadrados medios: 𝑑𝑖 = 𝑒𝑖 ⁄√𝑀𝑆𝑟𝑒𝑠𝑖𝑑𝑢𝑎𝑙 , 𝑖 = 1, 2, … , 𝑛. Los residuales

estandarizados tienen media cero y varianza aproximadamente unitaria. Bajo el supuesto

de normalidad, se esperaría que aproximadamente el 95% de los residuos se concentrara

en el intervalo [−1.96, 1.96] y el 99% en [−3, 3]. Un residual estandarizado mayor que 3,

indicaría un potencial valor atípico.

Es de suponer que si se utiliza la desviación estándar exacta del 𝑖-ésimo residual en lugar

de sólo dividirlo entre la raíz de 𝑀𝑆𝑟𝑒𝑠𝑖𝑑𝑢𝑎𝑙 , se obtendrá mayor precisión en la

transformación. De este modo, los residuales estudentizados, 𝑟𝑖 , se calculan como 𝑟𝑖 =

𝑒𝑖

, 𝑖 = 1, 2, … , 𝑛. Cuando el modelo está lo suficientemente ajustado, estos

√(𝑀𝑆𝑟𝑒𝑠𝑖𝑑𝑢𝑎𝑙 )(1−ℎ𝑖𝑖 )

residuales tienen varianza constante igual a 1.

Tarea. Averiguar los conceptos residuales PRESS y R de Student, así como su aplicación

a la detección y al tratamiento de datos atípicos.

75

Estadística II

Existen diferentes gráficas de los residuales del modelo que ayudan a su análisis. En el

histograma se aprecia si la distribución de los residuales se ajusta a la forma de una

normal.

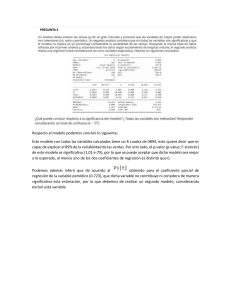

La gráfica de probabilidad normal está diseñada para que la distribución normal

acumulada parezca una línea recta. El énfasis del análisis se dirige hacia los puntos

centrales más que a los extremos. La siguiente figura muestra diferentes formas de esta

gráfica.

a) Forma ideal. b) Curvas que van

bruscamente hacia arriba y hacia

abajo, indicando colas de

distribución gruesas (no normales).

c) Aplanamiento en los extremos,

característico de distribuciones más

delgadas que la normal. d) Patrón

de asimetría positiva. e) Patrón de

asimetría negativa.

La gráfica de los residuales 𝑒𝑖 en función de los valores ajustados correspondientes 𝑦̂𝑖 es

útil para detectar ciertos tipos de inadecuaciones del modelo. La razón por la que se

grafica 𝑒𝑖 contra 𝑦̂𝑖 y no contra los valores observados 𝑦𝑖 es que los residuales se

correlacionan con la variable dependiente, no así con los valores ajustados.

a) Los residuales se pueden encerrar en

una banda horizontal, por lo que no hay

defectos obvios en el modelo. b)

Residuales en forma de embudo indican

varianza creciente. c) Distribución de los

residuales en forma de doble arco se

presenta cuando 𝑦 es una proporción entre

0 y 1; en este caso, la varianza de la

proporción más cercana a 0.5 es mayor

que una cercana a 0 ó a 1. d) Residuales

en forma curva suponen un defecto por no

linealidad.

Las gráficas de regresión parcial consideran el papel marginal del regresor 𝑥𝑗 respecto a

los demás regresores que ya están en el modelo. En esta gráfica se determina la

regresión de la variable de respuesta 𝑦 y el regresor 𝑥𝑗 respecto a los demás regresores

en el modelo, y de los residuales obtenidos para cada regresión. Estas gráficas sólo

sugieren posibles candidatos regresores a incluirse en el modelo, pero podrían dar

información inadecuada en presencia de variables mal especificadas o multicolinealidad.

76

Estadística II

Para corroborar el supuesto de no correlación de los errores se utiliza el test de DurbinWatson. Dicho test proporciona una medida de la correlación serial entre los errores, es

decir, a partir de una secuencia de residuales, ordenada en el tiempo, se verifica si la

correlación entre los errores es la misma cada 𝑠 pasos, 𝑠 = 1, 2, …

A partir de un modelo de regresión, se establece la hipótesis nula 𝐻0 : 𝜌𝑠 = 0, ∀𝑠 = 1, 2, …

contra la hipótesis alternativa 𝐻1 : 𝜌𝑠 = 𝜌 𝑠 , 𝜌 ≠ 0, |𝜌| < 1. El estadístico de Durbin-Watson

es 𝑑 = ∑𝑛𝑢=2(𝑒𝑢 − 𝑒𝑢−1 )2⁄∑𝑛𝑢=1 𝑒𝑢2 . La distribución de 𝑑 toma valores entre 0 y 4 y es

simétrica alrededor de 2. De este modo, si 𝑑 es muy próximo a 2 no se rechaza la

hipótesis nula de no correlación.

Tarea. Leer el capítulo 7 de Draper para profundizar en el test de Durbin-Watson.

Como es sabido, el análisis gráfico es útil en estadística, pero no tan contundente como

una prueba de hipótesis. Por ello, se presentan aquí dos test ampliamente utilizados para

comprobar la homogeneidad de la varianza de los errores, el de Bartlett y el de Levene.

2

Test de Bartlett. Sean 𝑆12 , 𝑆22 , … , 𝑆𝑚

estimaciones de 𝜎 2 a partir de 𝑚 grupos con

2

𝑛

𝜈1 , 𝜈2 , … , 𝜈𝑚 grados de libertad, respectivamente, con 𝑆𝑗2 = ∑ 𝑗 (𝑌𝑗𝑢 − 𝑌̅𝑗 ) ⁄(𝑛𝑗 − 1). Sea

𝑢=1

2

2

2

2 )⁄

(𝜈

𝑆𝑒 = 1 𝑆1 + 𝜈2 𝑆2 + ⋯ + 𝜈𝑚 𝑆𝑚 𝜈, con 𝜈 = 𝜈1 + 𝜈2 + ⋯ + 𝜈𝑚 . Se define la constante 𝐶 =

−1

1 + (𝜈1−1 + 𝜈2−1 + ⋯ + 𝜈𝑚

− 𝜈 −1 )⁄{3(𝑚 − 1)}. El estadístico de prueba es

𝐵=

𝑚

2

2

{𝜈𝑙𝑛𝑆𝑒 − ∑𝑗=1 𝜈𝑗 𝑙𝑛𝑆𝑗 }⁄𝐶 , el cual, bajo la hipótesis nula de igualdad de varianzas, se

2

distribuye aproximadamente como una 𝜒𝑚−1

.

Test de Levene. Considere en el 𝑗-ésimo grupo las desviaciones absolutas de las 𝑌′s

respecto a las medias de los grupos: 𝑧𝑗𝑢 = |𝑌𝑗𝑢 − 𝑌̅𝑗 |, 𝑢 = 1, 2, … , 𝑛𝑗 . Compare los

cuadrados medios “entre grupos” con los cuadrados medios “dentro de grupos” a través

2

de un test cuyo estadístico estaría dado por 𝐹 =

𝑛

∑𝑚

𝑗=1 𝑛𝑗 (𝑧̅ 𝑗 −𝑧̅ ) ⁄(𝑚−1)

𝑛𝑗

2

, en donde 𝑧̅𝑗 =

𝑚

∑𝑚

𝑗=1 ∑𝑢=1(𝑧𝑗𝑢 −𝑧̅ 𝑗 ) ⁄∑𝑗=1(𝑛𝑗 −1)

𝑛

𝑗

𝑗

𝑚

∑𝑢=1

𝑧𝑗𝑢 ⁄𝑛𝑗 , 𝑧̅ = ∑𝑚

𝑗=1 ∑𝑢=1 𝑧𝑗𝑢 ⁄∑𝑗=1 𝑛𝑗 . Este estadístico se compara con el valor en tablas

(cola superior) de 𝐹{𝑚 − 1, ∑𝑚

𝑗=1(𝑛𝑗 − 1)}.

Mientras que el test de Bartlett es muy sensible al problema de no normalidad, el de

Levene no tiene este problema, sin embargo, posee menos potencia.

Tarea. Profundice en los test de Bartlett y Levene. Estudiar con profundidad el capítulo

sobre corrección de inadecuaciones del modelo en el texto de Montgomey.

Créditos

El material aquí presentado es un extracto de:

Draper, N. R. & Smith. (1998). Applied regression análisis. USA: Wiley.

Montgomery, D. C., Peck, E. A. y Vining, G. G. (2006). Introducción al análisis de

regresión lineal. México: CECSA.

77