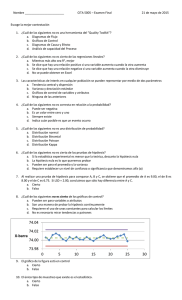

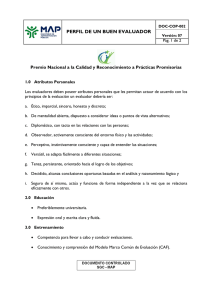

ESCUELA SUPERIOR POLITECNICA DE CHIMBORAZO . Ensayo, Validación de datos 2022 Carrera de Ingeniería Industrial Docente: Ing. Gloria Miño Ph.D Integrantes: Jheferson Miguel Guilcapi Acan 6984 Alex Jefferson Guaman Leon 6648 Jhon Jairo Morocho Tene 6908 Pablo Sebastian Amaguayo Garcia 6934 1 MÉTODO DE VALIDACIÓN DE DATOS MEDIANTE ALFA DE CRON BACH, V DE AIKEN Y COEFICIENTE KAPPA DE COHEN INTRODUCCIÓN El siguiente trabajo de investigación se desarrolla con la finalidad de dar a conocer distintos métodos de validación de datos los cuales nos ayudara a evaluar por medios de cálculos estadísticos y a su vez de herramientas de recolección de datos ya sea cualitativa o cuantitativa dependiendo a su vez del medio en el cual se va aplicar, ayudando a mejorar la fiabilidad de información que se llega a recolectar en los campos de su aplicación a diferentes ámbitos de trabajo como el marketing, ingeniería, medicinan entre otros. A partir del anterior trabajo planteamos la siguiente pregunta de investigación: ¿Cómo deben aplicar los métodos de la recolección de datos en los ámbitos de trabajo? El objetivo de este trabajo es, identificar cada método para su debida aplicación con base en el desarrollo de las presiones conceptuales sobre la mezcla de los datos estadísticos y metodológicos, y como debe ser llevado a los diferentes medios de trabajo y a la vida misma de cada individuo. Para llevar a cabo el objetivo de estudio se ha estructurado en 3 apartados. El primer apartadose hace referencia a la metodología usada para la recolección de datos. El segundo apartado determina las técnicas e instrumentos utilizados para el desarrollo del mismo, seguida del desarrollo de los diferentes métodos y su aplicación en los distintos ámbitos laborales. El tercer apartado son las conclusiones que buscan responder la pregunta de investigación y llevar acabo el objetivo. 1 DESARROLLO 1.0 MÉTODO DE VALIDACIÓN DE DATOS 1.1 Definición Los métodos de validación de datos sirve para comprobar la validez de un instrumento de medición ayudándose de herramientas recolectoras de información los mismos que pueden ser test o encuestas, estos métodos son utilizados en áreas investigativas científicas y de tesis por lo que harán que sus trabajos comprendan de confiabilidad pues se sabe muy bien que al no poseer un instrumento de recolección de datos el análisis o estudio de la investigación son escuetos y sin valor científico, por eso la importancia de la veracidad de dicha recolección de datos y la aplicación de metodologías para su verificación (1). 2.0 TIPOS DE MÉTODOS DE VALIDACIÓN DE DATO: Como bien lo sabes existe una variedad grande de formas, métodos y tipos de maneras que ayudan a poder garantizar de la mejor manera la fiabilidad de adjuntar una gran variedad de datos, los mismos que lo realizamos con tres métodos característicos los cuales son los siguientes: 2.1 MÉTODO DE VALIDACIÓN DE DATOS MEDIANTE ALFA DE CRONBACH 2.2 Definición Para una aplicación efectiva del alfa de Cron Bach no puede perderse la perspectiva de que este coeficiente debe considerarse dentro de la problemática más amplia del análisis de 2 confiabilidad. En particular en estos momentos es inevitable tener en cuenta para la interpretación y aplicación del Alfa de Cron Bach el trabajo de Bruno D. Zumbo (Zumbo, et al., 2007) y las consideraciones en relación con su aplicación al utilizar escalas de respuesta ordinal o escalas de Likert” (Oliden & Zumbo, 2008). Al emplear un método estadístico, de uso frecuente, debe tomarse en cuenta que el procedimiento de estimación por defecto se basa en el uso de las correlaciones producto-momento de Pearson. 2.3 Aplicación del método En el siguiente ensayo para tener claro sobre este método de Alpha de Cron Bach, realizaremos el siguiente ejemplo: 1) Calcular el índice de consistencia interna de fiabilidad, cuando estamos utilizando escalas de tipo Likert. 3 Como primer punto, sacaremos la sumatoria de las varianzas. Calculamos la sumatoria de cada ítem. 4 Aquí ya tendríamos todos los elementos del cálculo, del Alpha de Cron Bach Podemos concluir diciendo que, tenemos como 0,854 el valor de Alpha de Cron Bach de los 10 ítems de una muestra piloto, de 20 personas entonces podemos decir que 0,854 esta en un rango muy alto, significa que existe una alta fiabilidad en el instrumento de recolección de datos. 5 3.0 MÉTODO DE VALIDACIÓN DE DATOS MEDIANTE LA V DE AIKEN 3.1 Definición La V de Aiken (Aiken, 1985) es un coeficiente que permite cuantificar la relevancia de los ítems respecto a un dominio de contenido a partir de las valoraciones de N jueces. Este coeficiente combina la facilidad del cálculo y la evaluación de los resultados a nivel estadístico, un instrumento de recolección de datos debe medir correctamente las variables que ha puesto en la investigación esas variables que van a estar ligadas a indicadores deben estar correctamente y el instrumento de recolección de datos tienen que estar en relación con esas variables e indicadores. 3.2 Ejemplos de Desarrollo del método Calcular la V de Aiken una vez que los jueces han emitido las calificaciones de acuerdo conlos ítems, como lo podemos observar en la siguiente tabla. 7 jueces han evaluado 11 ítems 6 Es la suma de los 7 jueces y su puntuación Para resolver la V de Aiken, aplicamos la siguiente formula 7 Por lo tanto, diremos que, el coeficiente V de Aiken es 0,94, quiere decir que el instrumentode recolección de datos tiene excelente validez, el coeficiente tiene un valor que va desde 0 hasta 1; mientras más de acerque a la unidad, mejore la validez de contenido tendrá el instrumento, en este caso el Cuestionario evaluado. 4.0 MÉTODO DE VALIDACIÓN DE DATOS MEDIANTE COEFICIENTE KAPPA DE COHEN 4.1 Definición El Coeficiente kappa de Cohen es una medida estadística que ajusta el efecto del azar en la proporción de la concordancia observada para elementos cualitativos (variables categóricas). En general se cree que es una medida más robusta que el simple cálculo del porcentaje de concordancia, ya que κ tiene en cuenta el acuerdo que ocurre por azar. Algunos investigadores han expresado su preocupación por la tendencia de κ a dar por seguras las frecuencias de las categorías observadas, lo que puede tener el efecto de subestimar el acuerdo para una categoría de uso habitual; por esta razón, κ se considera una medida de acuerdo excesivamente conservadora. 4.2 Descripción del método Otros discuten la afirmación de que kappa "tiene en cuenta" la posibilidad de acuerdo. Para hacerlo con eficacia se requeriría un modelo explícito de cómo afecta el azar a las decisiones de los observadores. El llamado ajuste por azar del estadístico kappa supone que, cuando no están absolutamente seguros, los evaluadores simplemente aventuran una respuesta (un escenario muy poco realista). Kappa mide el grado de concordancia de las evaluaciones nominales u ordinales realizadas por múltiples evaluadores cuando se evalúan las mismas muestras. 8 4.3 Ejemplos de Desarrollo del método Por ejemplo, dos médicos diferentes examinan a 45 pacientes para determinar si tienen una enfermedad específica. ¿Con qué frecuencia coincidirá el diagnóstico de los médicos con respecto a la enfermedad (positivo o negativo)? Otro ejemplo de evaluaciones nominales son las clasificaciones de los defectos encontrados en pantallas de televisores por varios inspectores. ¿Concuerdan consistentemente los inspectores en su clasificación de burbujas, cavidades y sucio? 4.4 Formulas y tablas para el cálculo del Coeficiente kappa de Cohen 4.5 Descripción de la formula Donde Pr(a) es el acuerdo observado relativo entre los observadores, y Pr (e) es la probabilidad hipotética de acuerdo por azar, utilizando los datos observados para calcular las probabilidades de que cada observador clasifique aleatoriamente cada categoría. Si los evaluadores están completamente de acuerdo, entonces κ = 1. Si no hay acuerdo entre los calificadores distinto al que cabría esperar por azar (según lo definido por Pr (e)), κ = 0. Clasificación de los índices de kappa utilizados para poder interpretar los resultados obtenidos de los coeficientes kappa. Tabla 1. Coeficientes de kappa 9 Por otra parte los autores, Landis & Koch (1977), propusieron una escala de valoración de índice de kappa dividida en seis clasificaciones para facilitar su interpretación. Los valores de k van desde 0.00 a 1.00, en la siguiente Tabla 3 se muestra las seis clasificaciones 4.6 Tabla 2. Coeficientes de Kappa 4.7 Aplicación del método en el ámbito laboral Se tiene un grupo de 50 personas que presentan una solicitud de subvención. Cada propuesta de subvención es analizada por dos evaluadores que anotan un "Sí" o un "No", según acepten o rechacen, respectivamente, la solicitud. El resultado del análisis de cada solicitud genera la tabla siguiente, en la que A y B denotan a cada uno de los dos evaluadores: B Solicitud De Sí No Sí 20 5 No 10 15 subvención A Tabla 3. Tabla de datos 10 4.8 Descripción de la aplicación Los datos situados en la diagonal formada por los valores 20 y 15, representan el número de solicitudes en el que hay concordancia entre ambos evaluadores. Mientras que la diagonal formada por los valores de 10 y 5, representan los casos en los que hay discordancia entre los evaluadores. Ahora pues, teniendo en cuenta que de las 50 solicitudes, 20 fueron aceptadas y 15 rechazadas por ambos evaluadores. El porcentaje de acuerdo observado es: Para calcular Pr (e), es decir, la probabilidad de que el acuerdo entre evaluadores se deba al azar, se advierte que: El evaluador A acepta (dice "Sí") 25 solicitudes y rechaza (dice "No") 25. Es decir, el evaluador A dice "Sí" el 50% de las veces. El evaluador B acepta (dice "Sí") 30 solicitudes y rechaza (dice "No") 20. Es decir, el evaluador B dice "Sí" el 60% de las veces. Por lo tanto, la probabilidad de que ambos evaluadores digan "Sí" al azar es: Y la probabilidad de que ambos lectores digan "No" al azar es: Teniendo en cuenta lo anterior, el valor de Pr (e) se calcula como la suma de las probabilidades de decir "Sí" y "No" al azar: Aplicando los valores de Pr(a) y Pr (e) en la fórmula de Kappa de Cohen se obtiene: 11 4.9 Caso excepcional al aplicar el método Un caso que a veces se considera un problema con la Kappa de Cohen se produce al comparar las Kappas calculadas para dos pares de evaluadores, ambos pares de evaluadores tienen el mismo porcentaje de acuerdo, pero los evaluadores de uno de los pares tienen una distribución de calificaciones similar, mientras los evaluadores del otro par tienen una distribución de calificaciones muy diferente. 7 Por ejemplo, en las dos tablas siguientes el acuerdo entre A y B es similar (en ambos casos, 60 de cada 100), por lo tanto cabría esperar que los valores correspondientes de Kappa reflejaran esta similitud. Sin embargo, al calcular Kappa para cada tabla: Sí No Sí 45 15 No 25 15 Sí No Sí 25 35 No 5 35 Encontramos que muestra mayor similitud entre A y B en el segundo caso, en comparación con el primero. Esto se debe a que mientras el porcentaje de acuerdo es el mismo, el porcentaje de acuerdo que ocurriría "por casualidad" es significativamente mayor en el primer caso (0,54 comparado con 0,46). 12 5.0 CONCLUCIÓNES Llegamos a la conclusión que al aplicar los diferentes tipos de métodos anteriormente descritos ayudan al conocimiento, tanto teórico y estadístico, debido a la aplicación extensa que existe en los campos de trabajo, junto a la demostración en los amplios debates sobre la metodología, la estrategia de investigación realizada y los problemas de significación en los distintos campos de conocimiento. Como pudimos comprobar en el siguiente ensayo el saber identificar cada método para su debida aplicación ayuda al desarrollo de las presiones conceptuales con respecto a los datos estadísticos y metodológicos, y la forma de cómo debe ser llevado a los diferentes medios detrabajo. 13 6.0 BIBLIOGRAFÍA: Oliden, P. E., & Zumbo, B. D. (2008). Coeficientes de fiabilidad para escalas de respuestacategórica ordenada. Psicothema, 20(4), 896‐901. Zumbo, B. D., Gadermann, A. M., & Zeisser, C. (2007). Ordinal versions of coefficientsalpha and theta for Likert rating scales. Journal of Modern Applied Statistical Methods, 6(1), 4. Aiken, L. R. (1985). Three coefficients for analyzing the reliability and validity of ratings.Educational and psychological measurement, 45(1), 131-142. 14