Probabilidades y Estadística

Cuarto resumen de esta serie. :D

Esta es la última gran unidad de lo que corresponde a la teoría básica de probabilidades que

debemos dominar.

En este resumen veremos distribuciones conjuntas de probabilidad.

Tal como en cálculo vimos primero el caso de una variable y todas las herramientas básicas (límite,

derivación e integración) para luego dar el salto y hacer los mismos estudios con varias variables,

aquí en probabilidades se hace lo mismo.

Los dos últimos capítulos fueron un estudio detallado de las distribuciones univariantes ahora

extenderemos nuestro estudio a las distribuciones multivariantes o conjuntas como quieran

llamarles.

Nuevamente hay dos divisiones, las discretas y las continuas, veremos extensiones de las

distribuciones que ya conocíamos al caso multidimensional.

Como podrán suponer, cualquier extensión a un nivel mayor de complejidad es, obviamente, más

complejo, so beware.

Espero no haya errores de tipeo o dislexia. xD

Porque no revisaré el resumen de nuevo. xD

Let’s begin! :D

Brian Keith N.

Distribuciones Conjuntas

La razón por la cual estudiamos varias variables aleatorias creo que es obvia, analizar más cosas

siempre nos permite tener una mayor precisión (a la expensa de simplicidad).

Por ejemplo podemos tener dos variables que midan características de un objeto y queremos

calcular la probabilidad que un objeto cualquiera satisfaga ciertos requerimientos para ambas

variables.

Distribuciones bivariantes discretas

Empezaremos con el caso de dos variables porque es más simple y graficable.

Supongamos tenemos 3 posibles casos y queremos medir la probabilidad del primer caso y el

segundo caso, denotemos cada uno por X e Y.

Si llevamos a cabo una serie de experimentos, digamos 4, ¿Cuál es la probabilidad que salgan 3 del

primer caso y 0 del segundo?

Bueno, es obvio que cada variable por separado sigue una distribución binomial (Éxito o fracaso).

Sin entrar al detalle numérico les dejo el gráfico de la distribución conjunta de ambas variables.

Si queremos por ejemplo

simplemente buscamos e intersectamos. :D

Para responder la pregunta inicial, la probabilidad que salgan 3 del primer caso y 0 del segundo es

cosa de intersectar en el gráfico igual. :D

Noten que es imposible tener 3 del primer caso y 2 del segundo caso, porque nuestra cantidad de

experimentos fue 4.

Pero bueno, vamos a la definición formal.

(

)

∑∑

(

)

(

)

(

)

Bueno, lo primero es lógico pues no existen probabilidades negativas.

El segundo implica que la suma de todas las probabilidades es 1, por supuesto, esto es obvio igual.

(Pueden comprobarlo en el ejemplo de recién)

El tercero es simplemente una forma de notación y significa que la probabilidad de que X e Y

tengan cierto valor viene dada por la función probabilidad.

Como podrán ver no es más que la extensión lógica de lo de una variable.

So let’s move on!

Distribuciones marginales discretas

Bueno, si tenemos las probabilidades conjuntas podemos calcular las probabilidades

independientes. (Llamadas marginales)

Podemos sumar cada columna (o fila según corresponda) para obtener las probabilidades de cada

variable de forma independiente.

El ejemplo anterior queda…

Por ejemplo si queremos la probabilidad que

sin importar el valor de y viene dada por esto:

(

)

(

)

(

)

Se entiende la idea, sumamos toda la columna 3. :D

Por otro lado nosotros ya sabíamos que X e Y eran binomiales, y por lo tanto no es necesario hacer

esto, en este caso al menos.

Podemos deducir las distribuciones marginales tanto de la distribución conjunta como del

planteamiento y características del problema.

La fórmula formal para decir “suma toda la columna/fila/cosa correspondiente” es:

( )

(

)

(

∑

)

( )

(

)

Donde Rx denota todos los elementos para los cuales

∑

(

)

, equivalentemente para el caso Y.

Podemos encontrar el promedio y la varianza para una variable aleatoria usando tanto la

distribución conjunta como la distribución marginal.

( )

∑

( )

∑(

( )

∑

)

( )

(

∑(

)

)

(

)

R denota todas las posibilidades.

Si pueden obtener la distribución marginal de forma simple la verdad no veo razón para usar la

formula maligna con la conjunta.

Por ejemplo como sabemos que son binomiales en el ejemplo de recién basta usar la fórmula

para el promedio de cada variable, pero si queremos usar la sumatoria maligna

tendríamos que hacer un proceso maligno de sumas y multiplicaciones con mucho riesgo de

equivocarnos en tonteras.

Recuerden siempre escoger el método que tiene menos riesgos de equivocación. ¬¬

Distribuciones condicionales discretas

Bueno, notarán del ejemplo que he estado llamando a cada rato que las variables son

dependientes la una de la otra.

Por ejemplo si x vale 3 entonces y solo puede valer 1 ó 0.

Esto nos lleva una nueva distribución, la distribución condicional!

Recordemos la definición de probabilidad condicional:

(

)

( | )

( )

Entonces la distribución condicional viene dada por:

(

)

| ( )

Esta distribución nos da la probabilidad que Y tome un cierto valor dado que X ya tomo un valor!

Se cumplen las siguientes cosas:

| ( )

∑

|

( )

|

(

)

| ( )

Es decir es una distribución común y corriente. xD

Un gráfico que muestra la probabilidad de cierto valor de y dado que x ya tomó un valor.

Noten que cada columna suma 1.

Podríamos hacer el mismo análisis para X dado un Y, pero sería por fila, obviamente ese gráfico

solo es válido para Y dado X. xD

La media condicional viene dada por:

( | )

|

∑

|

( )

Que no es más que una modificación de la fórmula para medias con los subíndices adecuados. xD

La varianza condicional viene dada por:

( | )

|

∑(

|

)

|

( )

∑

|

( )

|

Como pueden ver no es más que una modificación de la fórmula de varianza con los subíndices

adecuados. xD

Muy simple no? :D

Independencia

¿Cómo podemos determinar si dos sucesos son independientes?

Bueno, responder esa pregunta es lo que haremos ahora. :P

Comparemos la distribución conjunta de X e Y con la probabilidad condicional de Y dado X.

La de la derecha es la condicional, noten que cada columna tiene las mismas probabilidades.

Esto se puede expresar formalmente.

Existen cuatro formas equivalentes de decir que X e Y son independientes.

(

)

( ) ( )

(

)

(

)

(

)

(

)

|

( )

|

( )

(

) | ( )

| ( )

(

)

(

) (

)

Cada una de esas expresiones significa lo mismo.

La primera nos dice que si son independientes podemos separar la probabilidad conjunta en una

probabilidad “multiplicada” por así decirlo.

La segunda y tercera nos dicen que el valor de X o Y no afecta las probabilidades de la otra

variable.

La cuarta es una extensión de la primera a cualquier evento (subconjunto de posibilidades) A y B.

Si alguna de estas propiedades falla, aunque sea una vez, las variables aleatorias son

dependientes.

Es decir, si queremos demostrar independencia tenemos que probar para TODOS los posibles

valores que alguna de las cuatro propiedades se cumple. (Si se cumple una se cumplen todas)

Noten además que la forma de la distribución es un rectángulo, si no se forma un rectángulo

inmediatamente podemos concluir que las variables son dependientes, pues el saber el valor de

una modifica “corta” las posibilidades de la otra. (Como en el primer ejemplo)

En cambio, si forma un rectángulo, no podemos decir nada, tenemos que probar alguna de las

cuatro propiedades.

Distribuciones multivariantes discretas

Bueno, ahora extenderemos todos los conceptos que vimos recién a varias variables.

Espero que esto no les duela mucho. xD

Si quieren sáltense esta parte y vayan directo a la distribución multinomial, y vean esto cuando ya

estén un poco más acostumbrados a trabajar con esto. xD

Mientras avanzamos revisen los conceptos equivalentes para dos variables y quizás lo

comprendan mejor. :P

La distribución se escribe así para p variables aleatorias:

(

)

(

Para todos los puntos (

) en el rango de

)

.

La distribución marginal es una simple extensión de la que obtuvimos con la bivariante.

( )

(

Donde

)

∑

(

)

denota todos los puntos para los cuales

.

La varianza y el promedio pueden calcularse con las marginales o con la conjunta, para la conjunta

es una simple extensión:

( )

∑

( )

∑(

(

)

)

(

)

Donde R representa todas las posibilidades.

Miren una distribución tridimensional a la derecha.

Puede que estemos interesados en las probabilidades de K variables aleatorias.

Para eso podemos encontrar esta especie de punto medio entre las marginales y la conjunta.

Si tenemos p variables aleatorias y queremos la probabilidad de k variables…

(

)

(

)

(

)

Donde

∑

(

)

corresponde a todos los puntos de

.

para los cuales se cumple

Ya es un poco maligno, pero considérenlo un punto medio entre las distribuciones marginales y la

distribución conjunta total. (La marginal es 1 variable, la conjunta P variables y esta K variables,

donde K es menor que P)

Lo que hay que hacer es sumar todos los puntos en que se cumplan las condiciones, no es tan

maligno en realidad. (Dudo que usemos más de 4 variables así que es relativamente simple)

La distribución condicional para el caso multivariante es una extensión muy fácil de hacer.

Por ejemplo para 5 variables.

|

(

)

(

)

Eso nos dice la probabilidad conjunta de

(

)

dados

.

La independencia es muy fácil de extender:

( )

( )

(

)

( )

Para TODOS los puntos.

Si no se cumple, aunque sea en único punto, entonces no son independientes.

Como pueden ver la independencia simplifica mucho las cosas, pues basta multiplicar las

marginales. xD

En fin, con eso tenemos la teoría general de las multivariantes, vamos por un caso particular muy

importante.

La extensión de la binomial a varias dimensiones!

Distribución multinomial

En el caso binomial teníamos dos categorías: Éxito y fracaso.

Ahora con la multinomial tendremos K categorías, por ejemplo: Excelente, bueno, regular, malo.

De forma general veámoslo.

Un experimento aleatorio de n pruebas en el que:

Cada resultado del experimento se clasifica como una de las k categorías.

La probabilidad de que una prueba genere cierto resultado es constante a lo largo de las pruebas.

Las pruebas son independientes.

Las variables aleatorias

denotan la cantidad de pruebas que obtuvieron un resultado

en la clase 1, 2,…, o k respectivamente tienen una distribución multinomial.

La función probabilidad es:

(

)

⏟

⏟

Recordarán de las técnicas de conteo la fórmula de la izquierda y la probabilidad individual viene

de la independencia.

Lo que hacemos es multiplicar la cantidad de formas en que puede ocurrir un suceso por la

probabilidad individual de ese suceso.

Se cumple además:

Todas las categorías suman la cantidad total de intentos. (Las categorías son mutuamente

exclusivas)

Todas las probabilidades suman 1 entre ellas, es obvio, pues la multinomial toma en cuenta todas

las opciones.

Si k vale 1 no tiene sentido usar esto. xD

Si k vale 2 estamos frente a una binomial.

Cada variable aleatoria que compone la multinomial tiene una distribución marginal binomial.

Por lo tanto de ahí se desprende lo siguiente:

( )

( )

(

)

Por ejemplo si tengo un producto que viene en 5 colores, los colores y sus probabilidades son:

Negro con 0.2, Blanco con 0.4, Rojo con 0.1, Azul con 0.2 y Verde con 0.1.

¿Cuál es la probabilidad de sacar 7 y obtener 3 azules, 2 verdes y el resto blancos?

(⏟

⏟

⏟

⏟

⏟

)

(

Entonces desarrollamos las operaciones y nos queda finalmente…

(⏟

⏟

Fácil, no? :D

⏟

⏟

⏟

)

) (

) (

) (

) (

)

También podemos “fusionar” probabilidades, por ejemplo puede que yo quiera evaluar de otra

forma la muestra, por ejemplo: {Negro} {Blanco} y {Rojo, Azul, Verde}.

Calculamos las probabilidades de cada evento y construimos una nueva distribución multinomial.

Bueno, con esto hemos terminado el estudio de distribuciones discretas, vamos por las continuas!

Distribuciones bivariantes continuas

Al igual que antes es mucho más fácil empezar con el caso de dos variables aleatorias.

Bueno, esto no es difícil, es la extensión lógica de las discretas al continuo, o de las continuas

univariantes al espacio superior.

Podrán suponer que en vez de sumatorias ahora nos enfrentaremos a integrales múltiples.

De hecho, la probabilidad viene dada por el volumen bajo la función.

Así que espero que no le tengan miedo a las integrales múltiples porque aquí se nos vienen

mucho, y versión impropias!

La función densidad viene dada por cumple con las siguiente cosas.

(

)

(

)

(

∫ ∫

([

]

)

)

∬

(

)

Se asume que la función densidad vale 0 para cualquier punto en la cual no este específicamente

definida.

La primera propiedad es obvia.

La segunda es la equivalente a la doble sumatoria de las discretas bivariantes y a la integral simple

de las continuas univariantes.

Vean los gráficos, bonito no? :D

El segundo gráfico representa que el volumen bajo la superficie es la probabilidad de que las

variables se encuentren en esa región.

Entonces si nos dan una función densidad y nos dicen que quieren la probabilidad de que X e Y

estén en una cierta región solo tenemos que integrar sobre esa región! :D

Cuidado con los límites de integración, recuerden que esa es la parte más “complicada” cuando se

trata de integrales múltiples. :P

Distribuciones marginales continuas

Para obtener las distribuciones marginales de la conjunta podemos usar estas fórmulas:

( )

(

∫

)

( )

(

∫

)

Donde

representa todos los puntos del rango de (

la otra variable.

) para los que

Una probabilidad que involucra una sola variable, por ejemplo, (

usando al distribución marginal o la distribución conjunta.

)

Con la conjunta se tiene que (

(

podemos integrar con esos límites la función densidad. :)

(

)

(

∫ ∫

)

, análogamente para

) puede encontrarse

), es decir que

( )

∫

La mayoría de los problemas son simples, so don’t worry.

El promedio viene dado por:

( )

( )

∫

∬

(

( )

∬(

)

La varianza viene dada por:

( )

∫ (

)

)

(

)

Noten que hay dos formas de calcularlas, con la distribución marginal y con la distribución

conjunta.

Distribuciones condicionales continuas

Bueno aquí la fórmula es idéntica a la de discretas. xD

(

)

| ( )

Recordando que esta distribución condicional no es más que una distribución común y corriente

tenemos:

| ( )

∫

|

(

( )

|

)

∫

|

( )

La media condicional viene dada por:

( | )

∫

|

( )

La varianza condicional viene dada por:

( | )

∫ (

|

)

|

( )

∫

|

( )

|

Noten que son solo modificaciones con los subíndices y límites de integración apropiados. :D

Independencia

Para determinar la independencia de las variables en el caso continuo recurrimos a los mismos

axiomas que en el caso discreto.

Por comodidad los repetiré.

(

)

( ) ( )

(

)

(

)

(

)

(

)

|

( )

|

( )

(

) | ( )

| ( )

(

)

(

) (

)

Lo más importante es que podemos separar las probabilidades en series de productos.

Y otra cosa, se cumple lo del rectángulo, si la distribución conjunta no tiene forma rectangular las

variables son dependientes. xD

Distribuciones multivariantes continuas

Bueno, la última extensión!

Vamos ahora al caso multivariante!

La función densidad cumple con:

(

)

(

∫ ∫

∫

([

(

]

)

)

)

∫∫

∫

(

)

Se asume que en los puntos que la función no está explícitamente definida esta vale 0.

Como pueden ver es exactamente lo mismo de siempre. xD

En el caso especial que la función sea constante en cierta región R y 0 en todo otro lugar se tiene:

∫ ∫

([

∫

(

]

)

)

∫∫

∫

(

)

(

)

( )

Este caso especial es una distribución uniforme.

Noten que si estamos en una dimensión la formula se convierte a cantidad de casos favorables

dividido en casos posibles.

La razón por la que se usa intersección de B con R arriba es porque B puede tener partes fuera del

conjunto que es posible. xD

Por ejemplo si las posibilidades van del 0 al 3, 4 al 5 y 0 al 10 para 3 variables aleatorias diferentes

yo puedo pedirles que calculen las probabilidades de 1 al 4, 3 al 6 y 1 al 3.

Ahí habría que calcular los volúmenes de cada cosa y aplicar división.

Also, volumen se usa para denotar cualquier resultado de integración múltiple de dimensiones

altas, puede que no sea un volumen tal como lo conocemos, sino un hipervolumen de quien sabe

cuántas dimensiones, pero por simplicidad, les llamamos volúmenes. xD

La probabilidad marginal se calcula con la siguiente integral maligna.

( )

∫ ∫

∫

(

)

Noten que nos saltamos el diferencial que pertenece a la variable que queremos marginalizar.

Con esto podemos calcular probabilidades que involucren una sola variable.

También podemos usar la distribución conjunta haciendo una integral. xD

) como lo siguiente:

Podemos reescribir (

(

Todos los límites al infinito excepto los de la variable que queremos medir. xD

La media y la varianza vienen dados por las siguientes fórmulas que no son más que extensiones

lógicas.

( )

∫ ∫

∫

( )

∫ ∫

∫ (

(

)

)

(

)

Son fáciles de memorizar. xD

Si queremos encontrar la distribución conjunta de un subconjunto de variables podemos usar lo

siguiente.

Si tenemos P variables y queremos analizar un conjunto de K variables entonces:

(

)

∫

∫

∫

(

)

Maligno, no?

Pero es simple en realidad, no es más que una integración. xD

Noten que los diferenciales toman las variables que no queremos contabilizar!

Bueno, por último, la idea de probabilidad condicional puede ser extendida a varias variables…

Usando el mismo ejemplo que usamos para discretas se tiene:

|

(

)

(

)

(

)

Finalmente, varias variables aleatorias continuas son independientes si y solo si para todos los

posibles valores:

( ) ( )

(

)

( )

Esta idea se puede extender a subregiones…

(

)

(

) (

)

(

Para regiones cualesquiera

en el rango de las variables

respectivamente.

Bueno, ya pasamos la parte más maligna de todas.

Ahora vamos a cosas relativamente simples y fáciles.

So let’s continue!

)

Covarianza

Ahora nuestro objetivo es analizar la relación entre dos variables aleatorias.

Para eso inventamos la covarianza.

Pero primero debemos definir el valor esperado de una función de dos variables aleatorias, esto

no es más que una extensión del caso de una variable, así que no teman. xD

Sea (

) una función cualquiera de variables aleatorias entonces…

∑∑ (

[ (

)

(

)

)]

) (

)

∬ (

{

Este resultado representa el promedio esperado de la función si repetimos el experimento muchas

veces.

La covarianza para tanto variables discretas como continuas está definida por:

[(

( )

)(

)]

La covarianza es una medida de relación LINEAL.

Si la covarianza es positiva los datos forman una recta con pendiente positiva, análogamente si es

negativa.

Si la covarianza es cero, la única conclusión es que no se forma una recta.

Miren los siguientes gráficos, cada punto tiene igual probabilidad.

Noten que se forma una “recta”.

Ahora miren estos casos de covarianza nula.

Es obvio que en primero hay una relación, pero la covarianza NO es capaz de medirla.

Interesante, no? :D

Correlación

Otra medida de relación es la correlación.

(

)

√ ( ) ( )

La covarianza y la correlación comparten el mismo signo. (Si una es positiva la otra igual, etc...)

Se tiene además:

La correlación simplemente hace un ajuste de escala dividiendo por las desviaciones estándar.

Además con esto logra que la magnitud quede SIN UNIDADES.

Así que con esto podemos medir la relación entre variables aleatorias con diferentes unidades sin

preocuparnos de estas.

Dos variables con una correlación distinta a cero se les dices correlacionadas.

Al igual que la covarianza la correlación solo mide relaciones lineales.

Se tiene que si X e Y son variables independientes, entonces:

Lo cual es obvio, pues al ser independientes no existe NINGUNA relación entre ellas.

Calculemos la covarianza y correlación de esta distribución continua:

Tenemos que encontrar E(XY), E(X) y E(Y).

(

)

∫ ∫

( )

∫ ∫

( )

∫ ∫

Entonces la covarianza viene dada por:

(

)

( ) ( )

Al ser 0 la covarianza, la correlación también debe ser 0.

Por último, si bien la covarianza y correlación son nulas, NO se puede concluir que las variables son

independientes.

Lo único que probamos es que no existe una relación LINEAL entre ellas.

El ejemplo del gráfico con forma de círculo era un buen ejemplo de eso. xD

Así que recuerden, si las variables son independientes entonces covarianza y correlación nulas,

pero no al revés!

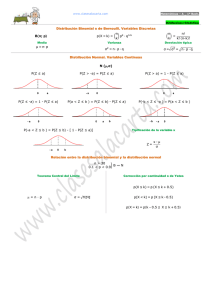

Distribución normal bivariante

Una extensión importante es la normal bivariante.

Como podrán suponer extiende el concepto de distribución normal a dos variables.

En muchas aplicaciones nos enfrentaremos a dos variables normales DEPENDIENTES.

Esta distribución se encarga de ellas! :D

Ya, lloren con la fórmula. xD

(

) (Si, muchos parámetros xD) es igual a…

La función

(

)

(

)(

) (

)

{

[

]}

(

)

√

Oh dios tuyo, que horror. D:

Los rangos de las variables:

Los rangos de los parámetros:

Hermoso no?

Y si integran esa cosa en todo su rango obtenemos el valor 1.

Do it, if you dare. :D

Algunos ejemplos de gráficos de distribuciones normales bivariantes y de sus curvas de nivel.

(Espero que recuerden curvas de nivel ¬¬)

El centro de las elipses es el punto (

). Si

entonces el eje mayor tiene pendiente

positiva, si

el eje mayor tiene pendiente negativa, y si

el eje mayor está alineado con

alguno de los ejes coordenados.

Un caso especial de la distribución normal bivariante es esta:

(

)

En este caso los parámetros son:

Es como una extensión de la distribución normal estándar.

Su gráfico está aquí:

Noten que sus curvas de nivel son circunferencias (caso especial de elipse).

Las distribuciones marginales que se desprenden de una normal bivariante son obviamente

distribuciones normales comunes y corrientes. xD (Eso implica que podemos estandarizarlas y

todo ese blablá)

Es obvio por la notación que

son los parametros de la distribución marginal de X,

análogamente para Y.

Además, se tiene que la correlación entre ambas variables viene dada por .

Notarán que la correlación no puede tomar los valores -1 ó 1, esto se debe a que la distribución se

indefine, pero además, a medida que la relación se acerca más a uno de esos valores la elipse se

inclina hasta quedar convertida en una recta cuando alcanza los valores -1 y 1, y entonces la

probabilidad que algo caiga fuera de la recta formada es nula y la distribución muere. xD

De forma general les dije que si la correlación era 0 no podíamos concluir independencia, pero en

el caso de estar frente variables relacionadas con una distribución normal bivariante, entonces

correlación nula IMPLICA independencia.

Si X e Y tienen una distribución normal bivariante con

, X e Y son independientes.

Bueno, otra cosa, como sabrán si queremos encontrar una probabilidad hay que integrar la

función densidad sobre la región de interés, pero en el caso de la bivariante, generalmente no hay

solución bonita y hay que utilizar malignos métodos numéricos para obtener el resultado.

Bueno terminamos con eso. :D

Combinación lineal de variables aleatorias

Algunas variables aleatoras suelen definirse como combinaciones lineales (CL) de otras variables

aleatorias, por ejemplo el perímetro de un objeto cuyo ancho y largo son variables aleatorias.

Recordarán de álgebra lineal la definición de CL, pero en todo caso, aquí la definición:

Sea Y una variable aleatoria tal que:

Se dice que Y es una CL de

.

Se puede demostrar que la media de una CL viene dada por:

( )

( )

( )

( )

La varianza por otro lado viene dada por:

( )

(

)

(

)

(

)

∑∑

(

)

Si cada una de los componentes de Y son independientes se tiene que la varianza es:

( )

( )

( )

( )

Noten que desaparece la maligna doble sumatoria del mal.

Ahora veremos un caso particular que nos será bastante útil en estudios posteriores.

Si tenemos un “promedio” de variables aleatorias con el mismo promedio y varianza, es decir:

̅

(Noten que no es un promedio normal en la forma que hemos visto hasta ahora, sino que es un

promedio en la forma más simple que puede existir)

Se cumple por los requisitos de que tengan el mismo promedio que ( )

.

Entonces, obviamente, ( )

.

Es obvio porque todas las variables tienen el mismo promedio. xD

Se tiene además que las varianzas son idénticas ( )

.

Entonces ( )

.

Todo esto se puede probar usando las propiedades de las CL’s y las fórmulas dadas hace 1 página.

Por último, una propiedad importante de las CL’s de variables normales independientes se llama

propiedad reproductiva y dice lo siguiente:

Si

para

son variables aleatorias normales con promedio ( )

se tiene que la CL:

y varianza ( )

Es una variable aleatoria normal con promedio dado por:

( )

La varianza es dada por:

( )

Un ejemplo simple y listo.

Supongamos tenemos unos cuantos envases de bebida y estos se llenan por una maquina, el

promedio es 12.1 y la desviación estándar es 0.1. Asume que cada llenada es independiente y que

son variables aleatorias normales. ¿Cuál es la probabilidad que el llenado promedio de 10 vasos

sea menor que 12?

Denotamos los vasos por

y el promedio ̅ se define como dijimos más arriba.

Entonces…

( ̅)

( ̅)

Usando la transformación Z…

̅

̅

(̅

)

[

̅

Desarrollando…

(̅

)

[

Buscamos en la tabla.

(̅

)

Listo! :D

Muy fácil, no?

√

]

]

Fin

Bueno, con esto terminamos el cuarto capítulo. :D

Ya estamos listos con los temas principales de probabilidades.

Aún nos quedan algunos detalles, pero ya vimos la parte principal de la materia, de cualquier

forma haré un último resumen de probabilidades para los pocos detalles que nos faltan. :D

Nos vemos! :D

Brian Keith N.