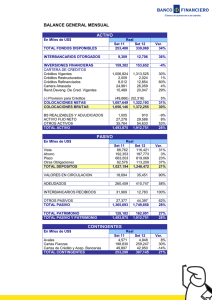

COMPARISON OF STUDENT EVALUATIONS OF TEACHING 1 Comparación de las evaluaciones de los estudiantes de la enseñanza con la administración en línea y en papel Claudia J. Stanny1 and James E. Arruda2 1 Center for University Teaching, Learning, and Assessment, University of West Florida 2 Department of Psychology, University of West Florida Nota del autor La recopilación de datos y el análisis preliminar fueron patrocinados por la Oficina del Preboste y el Grupo de Trabajo de Evaluación de la Instrucción de los Estudiantes. Parte de estos resultados se presentaron en forma de póster en el Instituto Nacional de Enseñanza de Psicología 2016, St. Pete Beach, Florida, Estados Unidos. No tenemos ningún conflicto de intereses que revelar. La correspondencia relativa a este artículo debe dirigirse a Claudia J. Stanny, Center for University Teaching, Learning, and Assessment, University of West Florida, Building 53, 11000 University Parkway, Pensacola, FL 32514, United States. Email: [email protected] COMPARISON OF STUDENT EVALUATIONS OF TEACHING 2 Resumen Cuando las instituciones administran las evaluaciones de la enseñanza de los estudiantes (SET) en línea, las tasas de respuesta son más bajas en relación con la administración en papel. Analizamos las puntuaciones promedio de SET de 364 cursos impartidos durante el trimestre de otoño en 3 años consecutivos para determinar si al administrar los formularios de SET en línea para todos los cursos del 3er año se modificaba la tasa de respuesta o la puntuación promedio de SET. Para controlar las características del instructor, basamos el análisis de los datos en los cursos en los que el mismo instructor enseñó el curso en cada uno de los tres trimestres de otoño sucesivos. Las tasas de respuesta de las clases presenciales disminuyeron cuando la administración de SET se realizó sólo en línea. Aunque los puntajes promedio de SET fueron confiablemente más bajos en el tercer año que en los dos años anteriores, la magnitud de este cambio fue mínima (0,11 en una escala de cinco puntos similar a la de Likert). Discutimos las implicaciones prácticas de estos hallazgos para la interpretación de las EEF y el papel de las EEF en la evaluación de la calidad de la enseñanza. Palabras clave: enseñanza universitaria, evaluación de la enseñanza por parte de los estudiantes, administración en línea, tasa de respuesta, evaluación COMPARISON OF STUDENT EVALUATIONS OF TEACHING 3 Comparación de las evaluaciones de los estudiantes de la enseñanza con la administración en línea y en papel Las calificaciones de los estudiantes y las evaluaciones de la instrucción tienen un largo historial como fuentes de información sobre la calidad de la enseñanza (Berk, 2013). Las evaluaciones de la enseñanza por parte de los estudiantes (SET) a menudo juegan un papel importante en las decisiones de alto riesgo sobre la contratación, promoción, titularidad y premios de la enseñanza. En consecuencia, los investigadores han examinado las propiedades psicométricas de las SET y el posible impacto de variables como la raza, el género, la edad, la dificultad del curso y las prácticas de calificación en las calificaciones promedio de los estudiantes (Griffin et al., 2014; Nulty, 2008; Spooren et al., 2013). También han examinado la forma en que los responsables de la adopción de decisiones evalúan las puntuaciones de las pruebas de aptitud física (Boysen, 2015a, 2015b; Boysen et al., 2014; Dewar, 2011). En los últimos 20 años, se ha prestado considerable atención a las consecuencias de la administración de las EEF en línea (Morrison, 2011; Stowell et al., 2012) porque las bajas tasas de respuesta pueden tener implicaciones en la forma en que los responsables de la toma de decisiones deben interpretar las EEF. Administración en línea de las evaluaciones de los estudiantes La administración de SET en línea crea múltiples beneficios. La administración en línea permite a los instructores dedicar más tiempo de clase a la instrucción (frente a la administración de formularios en papel) y puede mejorar la integridad del proceso. Los estudiantes que no están presionados por el tiempo de clase tienen más probabilidades de reflexionar sobre sus respuestas y escribir comentarios más detallados (Morrison, 2011; Stowell et al., 2012; Venette et al., 2010). Dado que la agregación electrónica de las respuestas evita la larga tarea de transcribir los comentarios (a veces escritos con una letra difícil), los instructores pueden recibir datos resumidos y comentarios textuales poco después del cierre del trimestre en lugar de semanas o meses después del trimestre siguiente. COMPARISON OF STUDENT EVALUATIONS OF TEACHING 4 A pesar de los numerosos beneficios de la administración en línea, los instructores y estudiantes han expresado su preocupación por la administración en línea de los SET. Los estudiantes han expresado su preocupación por el hecho de que sus respuestas no sean confidenciales cuando deben utilizar su número de identificación de estudiante para ingresar en el sistema (Dommeyer et al., 2002). Sin embargo, las violaciones de la confidencialidad pueden producirse incluso con la administración en papel. Por ejemplo, un instructor podría reconocer la letra de los estudiantes (una de las razones por las que algunos estudiantes no escriben comentarios en los formularios en papel), o un instructor podría permanecer presente durante la administración del SET (Avery et al., 2006). En clase, la administración basada en papel crea expectativas sociales que pueden motivar a los estudiantes a completar los SET. Por el contrario, los estudiantes que se preocupan por la confidencialidad o no comprenden cómo los instructores y las instituciones utilizan los resultados de la ETA para mejorar la enseñanza podrían ignorar las solicitudes de completar una ETA en línea (Dommeyer et al., 2002). A su vez, a los instructores les preocupa que las bajas tasas de respuesta reduzcan la validez de los hallazgos si los estudiantes que no completan una EET difieren de manera significativa de los estudiantes que sí la completan (Stowell et al., 2012). Por ejemplo, los estudiantes que no asisten a clase con regularidad suelen faltar a clase el día en que se administran las EET. Sin embargo, todos los estudiantes (incluidos los que no asisten) pueden completar los formularios cuando se administran en línea. El profesorado también teme que los resultados de la evaluación SET basada en una muestra de baja respuesta estén dominados por estudiantes de categorías extremas (por ejemplo, estudiantes con rencores, estudiantes con actitudes extremadamente favorables), que pueden estar particularmente motivados para completar las evaluaciones SET en línea y, por lo tanto, que los resultados de la evaluación SET representen inadecuadamente la voz de los estudiantes promedio (Reiner y Arnold, 2010). Efectos del formato en las tasas de respuesta y en los puntajes de evaluación de los estudiantes COMPARISON OF STUDENT EVALUATIONS OF TEACHING 5 En la bibliografía publicada se ha examinado la posibilidad de que los hallazgos de SET sesgados se asocien con bajas tasas de respuesta. En los resultados que van en contra de los temores del profesorado de que las evaluaciones en línea de ETA puedan estar dominadas por estudiantes de bajo rendimiento, Avery y otros (2006) encontraron que los estudiantes con promedios de puntos de grado (GPA) más altos tenían más probabilidades de completar las evaluaciones en línea. Asimismo, Jaquett y otros (2017) informaron de que los estudiantes que tenían experiencias positivas en sus clases (incluida la obtención de la calificación que esperaban obtener) tenían más probabilidades de presentar evaluaciones de cursos. Las instituciones pueden esperar tasas de respuesta más bajas cuando administran las ETA en línea (Avery y otros, 2006; Dommeyer y otros, 2002; Morrison, 2011; Nulty, 2008; Reiner y Arnold, 2010; Stowell y otros, 2012; Venette y otros, 2010). Sin embargo, la mayoría de los investigadores han descubierto que la calificación media de los SET no cambia significativamente cuando comparan los SET administrados en papel con los completados en línea. Estos hallazgos se han replicado en múltiples entornos utilizando diversos métodos de investigación (Avery y otros, 2006; Dommeyer y otros, 2004; Morrison, 2011; Stowell y otros, 2012; Venette y otros, 2010). Las excepciones a este patrón de diferencias mínimas o no significativas en los puntajes promedio de SET aparecieron en Nowell y otros (2010) y Morrison (2011), que examinaron una muestra de 29 cursos de negocios. Ambos estudios informaron de puntuaciones medias más bajas cuando los SET se administraron en línea. Sin embargo, también encontraron que las puntuaciones de SET para los elementos individuales variaban más dentro de un instructor cuando los SET se administraban en línea que en papel. Los estudiantes que completaron los SET en papel tendieron a registrar la misma respuesta para todas las preguntas, mientras que los estudiantes que completaron los formularios en línea tendieron a responder de manera diferente a las diferentes preguntas. Ambos grupos de investigación argumentaron que las puntuaciones obtenidas en línea podrían no ser directamente COMPARISON OF STUDENT EVALUATIONS OF TEACHING 6 comparables a las obtenidas mediante los formularios en papel. Aconsejaron que las instituciones administraran los SET totalmente en línea o totalmente en papel para garantizar evaluaciones coherentes y comparables entre los profesores. Cada universidad presenta un entorno y una cultura únicos que podrían influir en la seriedad con la que los estudiantes se toman las SET y en la forma en que responden a las decisiones de administrarlas en línea. Aunque existen algunos estudios a gran escala sobre el impacto de la administración en línea (Reiner y Arnold, 2010; Risquez et al., 2015), una réplica local responde a las preguntas sobre las características exclusivas de esa institución y genera pruebas sobre la posibilidad de generalizar los hallazgos existentes. Propósito del presente estudio En el presente estudio se examinaron las pautas de respuesta de las puntuaciones de la prueba SET en línea y en papel en una universidad integral de tamaño medio y regional de los Estados Unidos. Hicimos dos preguntas: En primer lugar, ¿cambia la tasa de respuesta o el promedio de la puntuación SET cuando una institución administra los formularios SET en línea en lugar de en papel? En segundo lugar, ¿cuál es la tasa de respuesta mínima necesaria para producir puntuaciones medias estables de SET para un instructor? Mientras que muchas investigaciones anteriores se basaban en pequeñas muestras a menudo limitadas a un solo departamento académico, nosotros reunimos los datos de SET en una gran muestra de cursos (N = 364) que incluía instructores de todas las universidades y todos los niveles de cursos durante 3 años. Controlamos las diferencias individuales en los instructores limitando la muestra a los cursos impartidos por el mismo instructor en los 3 años. La universidad ofrece casi el 30% de las secciones de los cursos en línea en cualquier término dado, y estos cursos siempre han administrado SETs en línea. Esto nos permitió examinar los efectos combinados del cambio del método de administración de SET (en papel a online) para las clases tradicionales y el cambio de un método mixto de administración de SET (en papel para las clases tradicionales y online para las clases online en COMPARISON OF STUDENT EVALUATIONS OF TEACHING 7 los 2 primeros años de recogida de datos) a un uso uniforme de formularios online para todas las clases en el último año de recogida de datos. Método Muestra Las tasas de respuesta y las calificaciones de evaluación se recuperaron a partir de los datos de evaluación de cursos archivados. El archivo de los datos de evaluación de cursos no incluía información sobre las características personales del instructor (sexo, edad o años de experiencia docente) y no se proporcionaba a los estudiantes ningún incentivo sistemático para completar las versiones impresas o en línea de la evaluación de cursos. Se extrajeron datos sobre las tasas de respuesta y las calificaciones de evaluación de 364 cursos que habían sido impartidos por el mismo instructor durante tres trimestres de otoño consecutivos (2012, 2013 y 2014). La muestra incluía profesores que enseñaban en cada uno de los cinco colegios de la universidad: 109 instructores (30%) enseñaban en el Colegio de Ciencias Sociales y Humanidades, 82 (23%) enseñaban en el Colegio de Ciencias e Ingeniería, 75 (21%) enseñaban en el Colegio de Educación y Estudios Profesionales, 58 (16%) enseñaban en el Colegio de Salud y 40 (11%) enseñaban en el Colegio de Negocios. Cada instructor proporcionó datos sobre un curso. Aproximadamente 259 instructores (71%) proporcionaron calificaciones para los cursos presenciales, y 105 (29%) proporcionaron calificaciones para los cursos en línea, lo que refleja con precisión la proporción de cursos presenciales y en línea ofrecidos en la universidad. La muestra incluía 107 cursos (29%) a nivel de licenciatura inicial (estudiantes de 1er y 2º año), 205 cursos (56%) a nivel de licenciatura avanzada (estudiantes de 3º y 4º año) y 52 cursos (14%) a nivel de posgrado. Instrumento El instrumento de evaluación del curso fue un conjunto de 18 elementos desarrollados por el sistema universitario estatal. Los primeros ocho ítems fueron diseñados para medir la calidad del COMPARISON OF STUDENT EVALUATIONS OF TEACHING 8 instructor, concluyendo con una calificación global de la calidad del instructor (Ítem 8: "Evaluación global del instructor"). Los ítems restantes pedían a los estudiantes que evaluaran los componentes del curso, concluyendo con una calificación global de la organización del curso (Ítem 18: "En general, calificaría la organización del curso"). No se dispone de datos formales sobre las propiedades psicométricas de los ítems, aunque todos los ítems tienen una validez facial evidente. Se pidió a los estudiantes que calificaran a cada instructor como pobre (0), regular (1), bueno (2), muy bueno (3) o excelente (4) en respuesta a cada ítem. Posteriormente, se calcularon las calificaciones de evaluación para cada curso e instructor. Se calculó una calificación mediana cuando un instructor enseñó más de una sección de un curso durante un trimestre. La institución limitó nuestro acceso a los datos del SET durante los 3 años de datos solicitados. Obtuvimos puntajes para el ítem 8 ("Evaluación general del instructor") para los 3 años pero pudimos obtener puntajes para el ítem 18 ("En general, calificaría la organización del curso") sólo para el año 3. Calculamos la correlación entre las puntuaciones del ítem 8 y del ítem 18 (a partir de los datos del curso registrados en el 3º año solamente) para estimar la consistencia interna del instrumento de evaluación. Estos dos ítems, que sirven como resúmenes compuestos de los ítems anteriores (Ítem 8 para los Ítems 1-7 y Ítem 18 para los Ítems 9-17), estaban fuertemente relacionados, r(362) = .92. Feistauer y Richter (2016) también informaron de fuertes correlaciones entre los ítems globales en un amplio análisis de las respuestas del SET. Diseño Este estudio aprovechó un experimento natural creado cuando la universidad decidió administrar todas las evaluaciones de los cursos en línea. Se solicitaron los datos del SET para los semestres de otoño de los dos años anteriores al cambio, cuando los estudiantes completaron los formularios SET en papel para los cursos presenciales y los formularios SET en línea para los cursos en línea, y los datos para el semestre de otoño del año de aplicación, cuando los estudiantes completaron COMPARISON OF STUDENT EVALUATIONS OF TEACHING 9 los formularios SET en línea para todos los cursos. Utilizamos un diseño factorial de 2 × 3 × 3 en el que el método de impartición del curso (presencial y en línea) y el nivel del curso (principiante, avanzado y de posgrado) eran factores entre materias y el año de evaluación (Año 1: 2012, Año 2: 2013 y Año 3: 2014) era un factor de medidas repetidas. Las medidas dependientes fueron la tasa de respuesta (medida como porcentaje de la matrícula de la clase) y la calificación del punto 8 ("Evaluación general del instructor"). El análisis de los datos se limitó a las puntuaciones del punto 8 porque la institución aceptó revelar datos sobre este punto solamente. Los datos de las puntuaciones del ítem 18 se pusieron a disposición de los formularios SET administrados en el tercer año para responder a las preguntas sobre la variación de las respuestas entre los ítems. La fuerte correlación entre las puntuaciones del ítem 8 y las puntuaciones del ítem 18 sugería que el ítem 8 podía utilizarse como sustituto de todos los ítems. Estos dos ítems eran de particular interés porque el profesorado, los presidentes de departamento y los comités de revisión frecuentemente se basan en estos dos ítems como indicadores independientes de la calidad de la enseñanza para las evaluaciones anuales y las revisiones de titularidad y promoción. Resultados Tasas de respuesta Las tasas de respuesta se presentan en el cuadro 1. Los resultados indican que las tasas de respuesta de los cursos presenciales fueron mucho más altas que las de los cursos en línea, pero sólo cuando las evaluaciones de los cursos presenciales se administraron en el aula. En la administración del tercer año, cuando todas las evaluaciones de los cursos se administraron en línea, los índices de respuesta de los cursos presenciales disminuyeron (M = 47,18%, SD = 20,11), pero siguieron siendo ligeramente superiores a los de los cursos en línea (M = 41,60%, SD = 18,23). Estos hallazgos produjeron una interacción estadísticamente significativa entre el método de impartición del curso y el año de evaluación, F(1,78, 716) = 101,34, MSE = 210,61, p < 0,001. La fuerza del efecto de la interacción COMPARISON OF STUDENT EVALUATIONS OF TEACHING 10 general fue de .22 (ηp2). Pruebas sencillas de efectos principales revelaron diferencias estadísticamente significativas en las tasas de respuesta de los cursos presenciales y los cursos en línea para cada uno de los 3 años de observación. Las mayores diferencias se produjeron durante el Año 1 (p < .001) y el Año 2 (p < .001), cuando las evaluaciones se administraron en papel en el aula para todos los cursos presenciales y en línea para todos los cursos en línea. Aunque la diferencia en la tasa de respuesta entre los cursos presenciales y en línea durante la administración del tercer año fue estadísticamente fiable (cuando tanto los cursos presenciales como en línea fueron evaluados con encuestas en línea), el efecto fue pequeño (ηp2 = .02). Por lo tanto, hubo una diferencia mínima en la tasa de respuesta entre los cursos presenciales y los cursos en línea cuando las evaluaciones se administraron en línea para todos los cursos. Ningún otro factor o interacción incluido en el análisis fue estadísticamente fiable. Calificaciones de evaluación El mismo análisis 2 × 3 × 3 del modelo de varianza se utilizó para evaluar las calificaciones medias de los SET. Este análisis produjo dos efectos principales estadísticamente significativos. El primer efecto principal implicó el año de evaluación, F(1,86, 716) = 3,44, MSE = 0,18, p = .03 (ηp2 = .01; véase la nota 1). Las calificaciones de evaluación asociadas a la administración del Año 3 (M = 3,26, SD = 0,60) fueron significativamente más bajas que las calificaciones de evaluación asociadas tanto a la administración del Año 1 (M = 3,35, SD = 0,53) como a la del Año 2 (M = 3,38, SD = 0,54). Por lo tanto, todos los cursos recibieron puntuaciones SET más bajas en el Año 3, independientemente del método de impartición del curso y del nivel del mismo. Sin embargo, el tamaño de este efecto fue pequeño (la mayor diferencia en la calificación media fue de 0,11 en una escala de cinco elementos). El segundo efecto principal estadísticamente significativo implicó el modo de entrega, F(1, 358) = 23,51, MSE = 0,52, p = .01 (ηp2 = .06; véase la nota 2). Los cursos presenciales (M = 3,41, SD = 0,50) recibieron calificaciones medias significativamente más altas que los cursos en línea (M = 3,13, SD = COMPARISON OF STUDENT EVALUATIONS OF TEACHING 11 0,63), independientemente del año de evaluación y del nivel del curso. Ningún otro factor o interacción incluido en el análisis fue estadísticamente fiable. Estabilidad de las calificaciones El diagrama de dispersión que se presenta en la figura 1 ilustra la relación entre las puntuaciones de SET y la tasa de respuesta. Aunque la correlación entre las puntuaciones de SET y la tasa de respuesta fue pequeña y no estadísticamente significativa, r(362) = 0,07, la inspección visual de la gráfica de puntuaciones de SET sugiere que las puntuaciones de SET se volvieron menos variables a medida que la tasa de respuesta aumentaba. Realizamos la prueba de Levene para evaluar la variabilidad de las puntuaciones de SET por encima y por debajo de la tasa de respuesta del 60%, que varios investigadores han recomendado como un umbral aceptable para las tasas de respuesta (Berk, 2012, 2013; Nulty, 2008). La variabilidad de las puntuaciones por encima y por debajo del umbral del 60% no era estadísticamente fiable, F(1, 362) = 1,53, p = 0,22. Discusión La administración en línea de los SET en este estudio se asoció con tasas de respuesta más bajas, pero es curioso que los cursos en línea experimentaron un aumento del 10% en la tasa de respuesta cuando todos los cursos fueron evaluados con formularios en línea en el tercer año. Los cursos en línea habían sufrido tasas de respuesta crónicamente bajas en años anteriores, cuando las clases presenciales continuaron utilizando formularios en papel. El beneficio de las tasas de respuesta observadas en los cursos en línea cuando todos los formularios del SET se administraron en línea podría atribuirse al aumento de las comunicaciones que alentaban a los estudiantes a completar las evaluaciones de los cursos en línea. A pesar de esta mejora, las tasas de respuesta de los cursos en línea siguieron siendo inferiores a las de los cursos presenciales. Las diferencias en las tasas de respuesta de los cursos presenciales y en línea podrían atribuirse a las características de los estudiantes que se inscribieron o a las diferencias en la calidad de la participación de los estudiantes creadas en cada modalidad de COMPARISON OF STUDENT EVALUATIONS OF TEACHING 12 aprendizaje. Avery y otros (2006) constataron que los estudiantes de mayor rendimiento (definidos como los estudiantes con un promedio de calificaciones más alto) tenían más probabilidades de completar las clases en línea. Aunque el promedio de la clasificación SET fue significativamente más bajo en el Año 3 que en los dos años anteriores, la magnitud de la diferencia numérica fue pequeña (las diferencias oscilaron entre 0,08 y 0,11, sobre la base de una escala de 0 a 4 de tipo Likert). Esta diferencia es similar a las diferencias que Risquez y otros (2015) informaron para las puntuaciones de SET después de ajustar estadísticamente la influencia de varias variables de confusión potenciales. Una literatura sustancial ha discutido la interpretación apropiada e inapropiada de las puntuaciones SET (Berk, 2013; Boysen, 2015a, 2015b; Boysen et al., 2014; Dewar, 2011; Stark & Freishtat, 2014). Los profesores han planteado a menudo preocupaciones acerca de la posible variabilidad de los resultados de la prueba SET debido a las bajas tasas de respuesta y, por lo tanto, al pequeño tamaño de las muestras. Sin embargo, nuestro análisis indicó que las clases con altas tasas de respuesta producían puntuaciones SET tan variables como las clases con bajas tasas de respuesta. Los revisores deben tener un cuidado extra cuando interpretan las puntuaciones de SET. Los responsables de la toma de decisiones a menudo ignoran las preguntas sobre si las medias derivadas de muestras pequeñas representan con precisión la media de la población (Tversky & Kahneman, 1971). Los revisores frecuentemente tratan todas las diferencias numéricas como si fueran igualmente significativas como medidas de las verdaderas diferencias y les dan credibilidad incluso después de recibir advertencias explícitas de que estas diferencias no son significativas (Boysen, 2015a, 2015b). Dado que las bajas tasas de respuesta producen tamaños de muestra pequeños, esperábamos que las puntuaciones del SET basadas en muestras de clases más pequeñas (es decir, cursos con bajas tasas de respuesta) fueran más variables que las basadas en muestras de clases más grandes (es decir, cursos con altas tasas de respuesta). Aunque los investigadores han recomendado que las tasas de respuesta COMPARISON OF STUDENT EVALUATIONS OF TEACHING 13 alcancen el criterio del 60%-80% cuando se utilicen los datos del SET para las decisiones de alto riesgo (Berk, 2012, 2013; Nulty, 2008), nuestros hallazgos no indicaron una reducción significativa de la variabilidad de la puntuación del SET con tasas de respuesta más altas. Implicaciones para la práctica Mejora de las tasas de respuesta del SET Cuando los encargados de la adopción de decisiones utilizan los datos de las EEF para tomar decisiones de alto nivel (contrataciones de profesores, evaluaciones anuales, titularidad, ascensos, premios de enseñanza), las instituciones harían bien en adoptar medidas para garantizar que las EEF tengan tasas de respuesta aceptables. Los investigadores han examinado estrategias eficaces para mejorar las tasas de respuesta para las EET (Nulty, 2008; véase también Berk, 2013; Dommeyer y otros, 2004; Jaquett y otros, 2016). Estas estrategias incluyen la oferta de incentivos validados empíricamente, la creación de sistemas técnicos de alta calidad con buenas características de factores humanos y la promoción de una cultura institucional que apoye claramente el uso de los datos de las EEF y otra información para mejorar la calidad de la enseñanza y el aprendizaje. Los programas e instructores deben discutir por qué la información de las EEF es importante para la toma de decisiones y proporcionar a los estudiantes pruebas tangibles de cómo la información de las EEF orienta las decisiones sobre el mejoramiento de los planes de estudio. La institución debe proporcionar a los estudiantes pruebas convincentes de que el sistema de administración protege la confidencialidad de sus respuestas. Evaluando las puntuaciones del SET Además de asegurar tasas de respuesta adecuadas en las EEF, los encargados de la adopción de decisiones deberían exigir múltiples fuentes de pruebas sobre la calidad de la enseñanza (Buller, 2012). Las decisiones de alto riesgo nunca deberían basarse exclusivamente en datos numéricos de las EEF. Los revisores suelen tratar las clasificaciones de las EEF como un sustituto de una medida del impacto que tiene un instructor en el aprendizaje de los estudiantes. Sin embargo, un meta-análisis reciente (Uttl et COMPARISON OF STUDENT EVALUATIONS OF TEACHING 14 al., 2017) cuestionó si las puntuaciones de SET tienen alguna relación con el aprendizaje de los estudiantes. Los revisores necesitan pruebas además de las calificaciones SET para evaluar la enseñanza, como pruebas de la experiencia del instructor en el contenido disciplinario, su habilidad en la gestión de la clase, su capacidad para hacer participar a los alumnos en conferencias u otras actividades, el impacto en el aprendizaje de los estudiantes o el éxito en los esfuerzos por modificar y mejorar los cursos y las estrategias de enseñanza (Berk, 2013; Stark & Freishtat, 2014). Al igual que con otras formas de evaluación, cualquier medida puede ser limitada en cuanto a la calidad de la información que proporciona. Por lo tanto, las medidas múltiples son más informativas que una sola medida. Un conjunto de pruebas puede informar mejor las decisiones de alto riesgo (Berk, 2013). Los portafolios pueden incluir resúmenes de las observaciones de la clase por parte del profesorado superior, el presidente y/o los compañeros. Los ejemplos de tareas y exámenes pueden documentar el rigor del aprendizaje, especialmente si van acompañados de muestras redactadas de los trabajos de los estudiantes. Los planes de estudio de los cursos pueden identificar los resultados previstos del aprendizaje; describir estrategias de instrucción que reflejen el rigor del curso (asignaciones obligatorias y prácticas de calificación); y proporcionar otra información sobre el contenido del curso, el diseño, las estrategias de instrucción y las interacciones del instructor con los estudiantes (Palmer et al., 2014; Stanny et al., 2015). Conclusión La psicología tiene una larga historia de diseño de estrategias creativas para medir lo "no medible", ya sea que la variable objetivo sea un proceso mental, una actitud o la calidad de la enseñanza (por ejemplo, Webb et al., 1966). Además, los psicólogos han documentado diversas heurísticas y sesgos que contribuyen a la mala interpretación de los datos cuantitativos (Gilovich et al., 2002), incluidas las puntuaciones SET (Boysen, 2015a, 2015b; Boysen et al., 2014). Estos conocimientos permiten a los COMPARISON OF STUDENT EVALUATIONS OF TEACHING 15 psicólogos ofrecer múltiples soluciones al reto que plantea la necesidad de evaluar objetivamente la calidad de la enseñanza y el impacto de la enseñanza en el aprendizaje de los estudiantes. La administración en línea de los formularios de SET presenta múltiples características deseables, entre ellas la rápida retroalimentación a los instructores, la economía y el apoyo a la sostenibilidad ambiental. Sin embargo, las instituciones deberían adoptar procedimientos de aplicación que no menoscaben la utilidad de los datos reunidos. Además, las instituciones deberían tener cuidado de no hacer hincapié en procedimientos que producen altas tasas de respuesta sólo para adormecer a los profesores en la creencia de que los datos de la ETA pueden ser la principal (o única) medida utilizada para las decisiones de alto riesgo sobre la calidad de la enseñanza del profesorado. En cambio, los encargados de adoptar decisiones deberían esperar utilizar múltiples medidas para evaluar la calidad de la enseñanza del profesorado. COMPARISON OF STUDENT EVALUATIONS OF TEACHING 16 Referencias Avery, R. J., Bryant, W. K., Mathios, A., Kang, H., & Bell, D. (2006). Electronic course evaluations: Does an online delivery system influence student evaluations? The Journal of Economic Education, 37(1), 21–37. https://doi.org/10.3200/JECE.37.1.21-37 Berk, R. A. (2012). Top 20 strategies to increase the online response rates of student rating scales. International Journal of Technology in Teaching and Learning, 8(2), 98–107. Berk, R. A. (2013). Top 10 flashpoints in student ratings and the evaluation of teaching. Stylus. Boysen, G. A. (2015a). Preventing the overinterpretation of small mean differences in student evaluations of teaching: An evaluation of warning effectiveness. Scholarship of Teaching and Learning in Psychology, 1(4), 269–282. https://doi.org/10.1037/stl0000042 Boysen, G. A. (2015b). Significant interpretation of small mean differences in student evaluations of teaching despite explicit warning to avoid overinterpretation. Scholarship of Teaching and Learning in Psychology, 1(2), 150–162. https://doi.org/10.1037/stl0000017 Boysen, G. A., Kelly, T. J., Raesly, H. N., & Casner, R. W. (2014). The (mis)interpretation of teaching evaluations by college faculty and administrators. Assessment & Evaluation in Higher Education, 39(6), 641–656. https://doi.org/10.1080/02602938.2013.860950 Buller, J. L. (2012). Best practices in faculty evaluation: A practical guide for academic leaders. JosseyBass. Dewar, J. M. (2011). Helping stakeholders understand the limitations of SRT data: Are we doing enough? Journal of Faculty Development, 25(3), 40–44. Dommeyer, C. J., Baum, P., & Hanna, R. W. (2002). College students’ attitudes toward methods of collecting teaching evaluations: In-class versus on-line. Journal of Education for Business, 78(1), 11–15. https://doi.org/10.1080/08832320209599691 COMPARISON OF STUDENT EVALUATIONS OF TEACHING 17 Dommeyer, C. J., Baum, P., Hanna, R. W., & Chapman, K. S. (2004). Gathering faculty teaching evaluations by in-class and online surveys: Their effects on response rates and evaluations. Assessment & Evaluation in Higher Education, 29(5), 611–623. https://doi.org/10.1080/02602930410001689171 Feistauer, D., & Richter, T. (2016). How reliable are students’ evaluations of teaching quality? A variance components approach. Assessment & Evaluation in Higher Education, 42(8), 1263–1279. https://doi.org/10.1080/02602938.2016.1261083 Gilovich, T., Griffin, D., & Kahneman, D. (Eds.). (2002). Heuristics and biases: The psychology of intuitive judgment. Cambridge University Press. https://doi.org/10.1017/CBO9780511808098 Griffin, T. J., Hilton, J., III, Plummer, K., & Barret, D. (2014). Correlation between grade point averages and student evaluation of teaching scores: Taking a closer look. Assessment & Evaluation in Higher Education, 39(3), 339–348. https://doi.org/10.1080/02602938.2013.831809 Jaquett, C. M., VanMaaren, V. G., & Williams, R. L. (2016). The effect of extra-credit incentives on student submission of end-of-course evaluations. Scholarship of Teaching and Learning in Psychology, 2(1), 49–61. https://doi.org/10.1037/stl0000052 Jaquett, C. M., VanMaaren, V. G., & Williams, R. L. (2017). Course factors that motivate students to submit end-of-course evaluations. Innovative Higher Education, 42(1), 19–31. https://doi.org/10.1007/s10755-016-9368-5 Morrison, R. (2011). A comparison of online versus traditional student end-of-course critiques in resident courses. Assessment & Evaluation in Higher Education, 36(6), 627–641. https://doi.org/10.1080/02602931003632399 Nowell, C., Gale, L. R., & Handley, B. (2010). Assessing faculty performance using student evaluations of teaching in an uncontrolled setting. Assessment & Evaluation in Higher Education, 35(4), 463– 475. https://doi.org/10.1080/02602930902862875 COMPARISON OF STUDENT EVALUATIONS OF TEACHING 18 Nulty, D. D. (2008). The adequacy of response rates to online and paper surveys: What can be done? Assessment & Evaluation in Higher Education, 33(3), 301–314. https://doi.org/10.1080/02602930701293231 Palmer, M. S., Bach, D. J., & Streifer, A. C. (2014). Measuring the promise: A learning-focused syllabus rubric. To Improve the Academy: A Journal of Educational Development, 33(1), 14–36. https://doi.org/10.1002/tia2.20004 Reiner, C. M., & Arnold, K. E. (2010). Online course evaluation: Student and instructor perspectives and assessment potential. Assessment Update, 22(2), 8–10. https://doi.org/10.1002/au.222 Risquez, A., Vaughan, E., & Murphy, M. (2015). Online student evaluations of teaching: What are we sacrificing for the affordances of technology? Assessment & Evaluation in Higher Education, 40(1), 210–234. https://doi.org/10.1080/02602938.2014.890695 Spooren, P., Brockx, B., & Mortelmans, D. (2013). On the validity of student evaluation of teaching: The state of the art. Review of Educational Research, 83(4), 598–642. https://doi.org/10.3102/0034654313496870 Stanny, C. J., Gonzalez, M., & McGowan, B. (2015). Assessing the culture of teaching and learning through a syllabus review. Assessment & Evaluation in Higher Education, 40(7), 898–913. https://doi.org/10.1080/02602938.2014.956684 Stark, P. B., & Freishtat, R. (2014). An evaluation of course evaluations. ScienceOpen Research. https://doi.org/10.14293/S2199-1006.1.SOR-EDU.AOFRQA.v1 Stowell, J. R., Addison, W. E., & Smith, J. L. (2012). Comparison of online and classroom-based student evaluations of instruction. Assessment & Evaluation in Higher Education, 37(4), 465–473. https://doi.org/10.1080/02602938.2010.545869 Tversky, A., & Kahneman, D. (1971). Belief in the law of small numbers. Psychological Bulletin, 76(2), 105–110. https://doi.org/10.1037/h0031322 COMPARISON OF STUDENT EVALUATIONS OF TEACHING 19 Uttl, B., White, C. A., & Gonzalez, D. W. (2017). Meta-analysis of faculty’s teaching effectiveness: Student evaluation of teaching ratings and student learning are not related. Studies in Educational Evaluation, 54, 22–42. https://doi.org/10.1016/j.stueduc.2016.08.007 Venette, S., Sellnow, D., & McIntyre, K. (2010). Charting new territory: Assessing the online frontier of student ratings of instruction. Assessment & Evaluation in Higher Education, 35(1), 101–115. https://doi.org/10.1080/02602930802618336 Webb, E. J., Campbell, D. T., Schwartz, R. D., & Sechrest, L. (1966). Unobtrusive measures: Nonreactive research in the social sciences. Rand McNally. COMPARISON OF STUDENT EVALUATIONS OF TEACHING 20 Tabla 1 Medios y desviaciones estándar de las tasas de respuesta (Método de entrega del curso por año de evaluación) Año de administración Curso presencial Curso online M SD M SD Año 1: 2012 71.72 16.42 32.93 15.73 Año 2: 2013 72.31 14.93 32.55 15.96 Año 3: 2014 47.18 20.11 41.60 18.23 Nota. Las evaluaciones de la enseñanza de los estudiantes (SET) se administraron en dos modalidades en los años 1 y 2: en papel para los cursos presenciales y en línea para los cursos en línea. Las SET se administraron en línea para todos los cursos en el tercer año. COMPARISON OF STUDENT EVALUATIONS OF TEACHING Figura 1 Diagrama de dispersión que muestra la correlación entre los índices de respuesta y los índices de evaluación Nota. Las calificaciones de las evaluaciones se hicieron durante el curso académico de otoño de 2014. 21