Espacios vestoriales euclídeos. Proyecciones ortogonales. Mínimos cuadrados.

5. ESPACIOS VECTORIALES EUCLÍDEOS.

PROYECCIONES ORTOGONALES. MÍNIMOS

CUADRADOS.

SUMARIO:

INTRODUCCIÓN

OBJETIVOS

INTRODUCCIÓN TEÓRICA

1.- Espacio vectorial euclídeo.

2.- Ortogonalidad. Propiedades.

3.- Norma. Propiedades.

4.- Proyecciones en espacios euclídeos.

5.- Método de los mínimos cuadrados

6.- Ajuste de datos con el método de los mínimos cuadrados.

PROBLEMAS RESUELTOS.

BILIOGRAFÍA

MATEMÁTICAS I

159

Guerra, N.; López, B.; Quintana, M.P.; Suárez, A.

INTRODUCCION

La estructura de espacio vectorial despliega una gran capacidad

operativa cuando incorpora los conceptos de distancia y ángulo entre sus

elementos. Para integrar estas dos cualidades métricas en un espacio

vectorial es preciso definir en él un producto escalar, el cual otorga a

dicho espacio el calificativo de euclídeo, de modo que a todo espacio

vectorial dotado de un producto escalar se le denominará espacio

vectorial euclídeo.

Si se dota al espacio vectorial de un producto escalar se va a poder

trasladar, al terreno de lo abstracto, las nociones de longitud y ángulo, en

especial el concepto de ortogonalidad, sin que éstas pierdan las

propiedades generales que les son inherentes.

Antes de comenzar con el estudio de los espacios vectoriales euclídeos es

preciso matizar que, en este curso, dicho estudio se limitará únicamente

al caso de productos escalares sobre espacios vectoriales reales.

Basándonos en la idea de ortogonalidad y proyección ortogonal,

estudiaremos el método de los mínimos cuadrados, para resolver de

forma aproximada sistemas de ecuaciones lineales incompatibles.

OBJETIVOS

•

Reconocer en una forma bilineal un producto escalar y manejar

adecuadamente sus propiedades.

•

Definir la norma asociada a cada producto escalar y demostrar sus

propiedades.

•

Obtener para cada vector del espacio su norma, módulo, y para cada

par de vectores el ángulo que forman a partir del producto escalar.

160

MATEMÁTICAS I

Espacios vestoriales euclídeos. Proyecciones ortogonales. Mínimos cuadrados.

•

Reconocer diferentes expresiones para un producto escalar al

considerarlo en bases diferentes.

•

Encontrar una base del espacio en la cual un producto escalar dado

adopte la expresión más simple (expresión canónica).

•

Conocer y utilizar con soltura el método de ortonormalización de

Gram-Schmit.

•

Determinar el complemento ortogonal de un subespacio.

•

Entender y calcular la proyección ortogonal de un vector sobre un

subespacio.

•

Comprender y manejar el método de los mínimos cuadrados.

MATEMÁTICAS I

161

Guerra, N.; López, B.; Quintana, M.P.; Suárez, A.

INTRODUCCION TEORICA

1. Espacio vectorial euclídeo.

Un conjunto E es un espacio vectorial euclídeo n-dimensional si es un

espacio vectorial real de dimensión n en el que se ha definido una

operación:

f : E × E ———— \ , verificando las siguientes propiedades:

1. f ( x , y ) = f ( y , x ) ,

∀x , y ∈ E

2. f ( λ x + µ y , z ) = λ f ( x , z ) + µ f ( y , z ) ,

∀λ , µ ∈\ y ∀x , y , z ∈ E

3. f ( x , λ y + µ z ) = λ f ( x , y ) + µ f ( x , z ) ,

∀λ , µ ∈\ y ∀x , y , z ∈ E

4. f ( x , x ) > 0, ∀x ≠ 0, x ∈ E

Esta operación recibe el nombre de producto escalar y la notación que

vamos a utilizar es : f ( x , y ) = x D y

1.1 Matriz Asociada al Producto Escalar

Si B = {e1 , e2 ,…, en } es una base del espacio vectorial euclídeo E ,

entonces la matriz asociada al producto escalar respecto a dicha base

viene dada por:

⎛ e1 D e1 e2 D e1

⎜

e De e De

A=⎜ 2 1 2 2

⎜ "

"

⎜⎜

⎝ en D e1 en D e2

como

el

producto

ei D e j = e j D ei , ∀i, j

" e1 D en ⎞

⎟

" e2 D en ⎟

≡ MATRIZ DE GRAM

"

" ⎟

⎟

" en D en ⎟⎠

escalar

es

conmutativo,

sucede

que

y de ahí se obtiene que la matriz A es simétrica,

es decir:

162

MATEMÁTICAS I

Espacios vestoriales euclídeos. Proyecciones ortogonales. Mínimos cuadrados.

⎛ e1 D e1

⎜

e De

t

A= A =⎜ 1 2

⎜ "

⎜⎜

⎝ e1 D en

e2 D e1 " en D e1 ⎞

⎟

e2 D e2 " en D e2 ⎟

"

"

" ⎟

⎟

e2 D en " en D en ⎟⎠

2. Ortogonalidad

2.1 Vectores ortogonales.

Sea E un espacio vectorial euclídeo.

Dos vectores u

y v son

ortogonales si y sólo si u D v = 0 .

2.2 Proposición

El vector 0 es el único vector ortogonal a todos los vectores del espacio.

2.3 Vector ortogonal a un subespacio.

Un vector u es ortogonal a un subespacio S de E si y sólo si, ∀ x ∈ S ,

u D x = 0.

2.4 Proposición

Un vector u es ortogonal a un subespacio S de E si y sólo si es

ortogonal a todos los vectores de una base de S .

2.5 Subespacios ortogonales.

Dos subespacios V y W de E son ortogonales si

∀ x ∈ V , ∀y ∈ W ⇒ x D y = 0 .

2.6 Proposición

Para que dos subespacios V

y W sean ortogonales es necesario y

suficiente que los vectores de una base de V sean ortogonales con los

vectores de una base de W .

2.7 Propiedades de la relación de ortogonalidad.

MATEMÁTICAS I

163

Guerra, N.; López, B.; Quintana, M.P.; Suárez, A.

Las principales propiedades de la relación de ortogonalidad son las

siguientes:

1. Si S = {u1 , u2 ," , uk } es un sistema de vectores ortogonales dos a

dos, ui ≠ 0 , ∀i = 1, 2,…, k , entonces S es un sistema libre.

2. Si V1 , V2 son dos subespacios de E ,tal que V1 ⊂ V2 , V1 ≠ V2 entonces

existe un vector no nulo de V2 ortogonal a todo el subespacio V1 .

3. Si V es un subespacio vectorial de E de dimensión k < n , todo

sistema libre formado con vectores de V tiene como máximo k

vectores ortogonales dos a dos.

4. Si V es un subespacio de E , de dimensión k < n , el conjunto de

todos los vectores ortogonales a V es un subespacio de dimensión

n − k . Dicho subespacio se denomina suplementario ortogonal o

complemento ortogonal de V y se representa por V ⊥ .

5. Si V es un subespacio de E entonces V ∩ V ⊥ = {0}.

6. Si V es un subespacio de E entonces V ⊕ V ⊥ = E.

3. Longitud, norma o módulo de un vector.

Se llama longitud, norma o módulo de un vector u , y se representa por

u ó u a la raíz cuadrada positivo del producto escalar u D u , es decir,

u = + u Du

⋅ : E ------------ \ +

u ------------ u = + u D u

NOTA: Si u = 1 , se dice entonces que el vector u es unitario.

164

MATEMÁTICAS I

Espacios vestoriales euclídeos. Proyecciones ortogonales. Mínimos cuadrados.

3.1 Propiedades de la norma.

1.

u > 0, ∀u ≠ 0

2.

u = 0 ⇐⇒ u = 0

3.

λ u = λ u , ∀u ∈ E, ∀λ ∈ \ .

4. ∀u ∈ E, u ≠ 0, u , es un vector unitario en la dirección de u.

u

5. Desigualdad de Schwarz, ∀u , v ∈ E : − u v ≤ u D v ≤ u v

6. Desigualdades triangulares, ∀u , v ∈ E :

a.

u +v ≤ u + v

b.

u −v ≥ u − v

3.2 Angulo que forman dos vectores.

Sean

u , v ∈ \n , u D v

el

producto

escalar

usual,

es

decir,

n

u D v = u t v = ∑ ui vi

i =1

El ángulo α que forman dos vectores u y v se define por medio de la

expresión:

cos (α ) = u D v

u v

3.3 Proposición.

Sean u , v ∈ \ n ; u , v ≠ 0

a) u y v son ortogonales ( u ⊥ v ) ⇐⇒ cos (α ) = 0 ⇐⇒ u t v = 0.

b) u y v son paralelos ( u // v ) ⇐⇒ cos (α ) = 0 ⇐⇒ u t v = ± u v .

3.4 Bases ortogonales y ortonormales.

Una base de un espacio vectorial euclídeo es ortogonal si sus vectores

MATEMÁTICAS I

165

Guerra, N.; López, B.; Quintana, M.P.; Suárez, A.

son ortogonales dos a dos.

Una base ortonormal es una base ortogonal de vectores unitarios.

3.5 Método de ortogonalización de Gram-Schmidt.

Este método nos permite construir una base ortonormal a partir de una

base cualquiera del espacio.

Si B = {e1 , e2 ,…, en } es una base de E , los vectores que se obtienen de la

forma:

c1 = e1

c De

c2 = e2 − c1 D c2 c1

1

c3 = e3 −

1

c1 D e3

c1 D c1

c De

c1 − c2 D c3 c2

2

2

""""""""""""""""""

c De

c De

c De

cn = en − c1 D cn c1 − c2 D cn c2 − .... − − c n−1D c n cn −1

1

1

2

2

n−1

constituyen una base ortogonal. Entonces B∗ =

n−1

{

c

c1 c2

,

,…, n

c1 c2

cn

} es una

base ortonormal.

4. Proyecciones en Espacios Euclídeos.

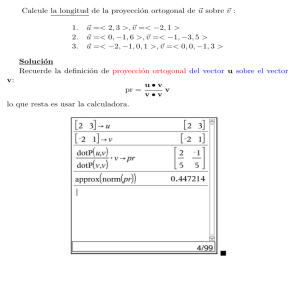

4.1 Proyección ortogonal de un vector sobre otro.

Sea v ∈ E, v ≠ 0 . Todo vector u ∈ E se descompone como:

u = uv DDvv v + w.

siendo el vector w un vector ortogonal a v .

El vector

u Dv

v Dv

v es la proyección ortogonal de u sobre v .

4.2 Proyección Ortogonal de un vector sobre un subespacio S.

Sea S un subespacio de E. Todo vector u

166

de E se descompone de

MATEMÁTICAS I

Espacios vestoriales euclídeos. Proyecciones ortogonales. Mínimos cuadrados.

manera única de la forma u = s + w , siendo s ∈ S y w ortogonal a S .

El vector s es la proyección ortogonal de u sobre S .

4.3 Expresión matricial del vector proyección sobre un subespacio.

Sea u ∈ E . Sea S = L {a1 , a2 ," , ak } ( ai , linealmente independientes ) un

subespacio de E , y sea A la matriz cuyas columnas son las coordenadas

de los vectores ai en una base B de E . El vector proyección, s , del

vector u sobre S viene dado por:

s = A( At A ) At u

−1

NOTAS:

1. La existencia de la matriz

( A A)

t

−1

queda garantizada por ser

linealmente independientes los vectores ai , para i = 1, 2,…, k .

2. Obsérvese que en el caso particular de dim( S ) = 1 , S = L {v } , la

expresión del vector proyección

s

de u

sobre

S

sería:

s = uv DDvv v = v (v t v ) −1 (v t u )

que corresponde a la forma s = A( At A ) At u tomando A la matriz

−1

columna de las coordenadas de v . En este caso v D v = At A

y

u D v = At u .

4.5 Matriz Proyección asociada a un subespacio S.

Sea S un subespacio de E y B = {a1 , a2 ," , ak } una base de dicho

subespacio. Sea A la matriz cuyas columnas son las coordenadas de los

vectores ai en una cierta base de E . La matriz proyección para el

subespacio S es la matriz:

MATEMÁTICAS I

167

Guerra, N.; López, B.; Quintana, M.P.; Suárez, A.

PS = A( At A) −1 At .

El producto PS u

para cualquier vector

u ∈ E nos proporciona la

proyección ortogonal de u sobre el subespacio S .

4.6 Teorema.

Sea S un subespacio vectorial de E y BS = {a1 , a2 ," , ak } una base del

mismo. Sea B una base de E y A la matriz n × k , cuyas columnas son

las coordenadas de los vectores ai respecto a la base B .

La matriz proyección:

PS = A( At A) −1 At

es la única matriz con la propiedad de que para todo vector u ∈ E , el

vector PS u es la proyección de u sobre S .

NOTA: El teorema anterior nos dice que la matriz proyección es única,

independiente de la base elegida en el subespacio.

4.7 Propiedades de la matriz proyección.

La matriz proyección PS satisface:

7. ( PS ) 2 = PS , es decir, PS es idempotente.

8. ( PS )t = PS , es decir, PS es simétrica.

4.8 Caracterización de las matrices proyección.

La condición necesaria y suficiente para que una matriz n × n sea una

matriz proyección es que sea idempotente y simétrica. En este caso, la

matriz es la matriz proyección para el subespacio generado por sus

columnas.

4.9 Matriz proyección utilizando bases ortonormales.

Si A es una matriz n × k de columnas ortonormales, At A es la matriz

168

MATEMÁTICAS I

Espacios vestoriales euclídeos. Proyecciones ortogonales. Mínimos cuadrados.

identidad. En esta propiedad simplifica en gran medida la expresión de

la matriz proyección.

Sea E un subespacio vectorial de dimensión n , S un subespacio y

B = {a1 , a2 ," , ak } una base ortonormal del mismo. Si A es la matriz

cuyas columnas son los vectores ai , entonces la matriz proyección para

el subespacio S , al ser At A = I , es PS = AAt .

5. Método de los Mínimos Cuadrados

5.1 Planteamiento del Problema.

Trataremos de aplicar el estudio realizado sobre las proyecciones a

problemas de análisis de datos, que nos conducen a sistemas con mayor

número de ecuaciones que de incógnitas (sistemas sobredeterminados)

que, normalmente, son incompatibles. A pesar de la no existencia de

solución exacta en dichos sistemas. Los sistemas incompatibles surgen en

situaciones reales y hay que intentar encontrar la ”mejor” solución

posible. El problema será encontrar un vector que minimice el error que

cometemos al suponer que dicho vector es la solución del sistema.

5.2 Método de los Mínimos Cuadrados.

Sea el sistema Ax = b , siendo A una matriz m × n , con m > n , cuyas

columnas son linealmente independientes, es decir, rang ( A) = n . Si b

no es combinación lineal de las columnas de A , el sistema lineal anterior

Ax = b es incompatible. Se trata entonces de encontrar un vector x *

que minimice el vector error Ax − b que para nosotros significará

minimizar su norma euclídea:

MATEMÁTICAS I

169

Guerra, N.; López, B.; Quintana, M.P.; Suárez, A.

Ax − b = ( d1 , d 2 ,…, d m ) = + d12 + d 22 + …+ d m2 .

Pero minimizar su norma es equivalente a minimizar su norma al

cuadrado, es decir,

Ax − b

2

= d12 + d 22 + …+ d m2 .

Esta es la razón del nombre del método de los mínimos cuadrados.

Para todo vector x , el vector Ax pertenece al subespacio S generado

por las columnas de A ; además, el error Ax − b es la distancia de b a

Ax . Entonces, buscar la mejor solución x * del sistema con el método

de los mínimos cuadrados, equivale a encontrar el vector x * , tal que la

distancia de Ax * a b sea la menor posible.

De todos los vectores Ax de S , el que minimiza Ax − b es el vector

proyección de b sobre S , es decir el vector A( At A) −1 At b , el vector x *

lo obtendremos de resolver:

Ax = A( At A) −1 At b .

Multiplicando la igualdad anterior por At queda:

At Ax = ( At A )( At A ) At b = At b = At b ,

−1

Es decir x * , es la solución del sistema lineal compatible y determinado:

At Ax = At b

(Nota: El sistema anterior es compatible y determinado ya que la matriz

At A es una matriz cuadrada de orden n, regular).

La solución del sistema anterior, al ser A de rango máximo, es

x * = ( At A ) At b , que nos da la ”solución óptima” del sistema Ax = b ,

−1

170

MATEMÁTICAS I

Espacios vestoriales euclídeos. Proyecciones ortogonales. Mínimos cuadrados.

en el sentido de mínimos cuadrados.

NOTA: Si A ∈ M m×n tiene columnas ortonormales, la solución del

sistema Ax = b por el método de los mínimos cuadrados es x * = At b , al

ser At A = I

6. Ajuste de datos con el método de mínimos cuadrados

6.1 Recta de ajuste de datos en el plano.

Supongamos que partimos de una colección de datos

( xi , yi ) ,

i = 1, 2,…, m , que nos proporcionan un conjunto de puntos en el plano. El

objetivo es hallar una función lineal y = f ( x) , que represente lo mejor

posible dichos valores. Geométricamente, significa que la gráfica de la

función y = f ( x) debe aproximarse lo más posible a la colección de

puntos.

El problema será determinar los valores de a y b tales que la recta

y = f ( x) = a + bx , denominada recta de ajuste, se adapte lo mejor posible

a nuestros datos. Sustituyendo ( xi , yi ) en la anterior igualdad se obtiene:

yi = a + bxi , ∀i = 1, 2,…, m.

Salvo en el caso de que los datos estén sobre una recta del plano, se

obtiene un sistema sobredeterminado incompatible que se puede expresar

matricialmente:

⎛

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎝

y1 ⎞⎟

⎟

⎟

2 ⎟

⎟

⎟

⎟

⎟

⎟

m⎠

⎛

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎝

1 x1 ⎞⎟

⎟

1 x2 ⎟⎟ ⎛ a ⎞

=

⇔ y = Ax ⇔ Ax = y

⎟

#

# # ⎟⎟ ⎜⎝ b ⎟⎠

⎟

y

1 x4 ⎟⎠

y

MATEMÁTICAS I

171

Guerra, N.; López, B.; Quintana, M.P.; Suárez, A.

La solución que minimiza el error en términos de mínimos cuadrados es

la solución del sistema At Ax = At y , que es: x * = ( At A) −1 At y

NOTA: ( At A) es invertible siempre que las columnas de A sean

linealmente independientes, que, en este caso, equivale a decir que los

valores xi no sean todos iguales, es decir, que los puntos ( xi , yi ) no estén

todos en una recta vertical.

6.2 Ajuste de datos en \ n +1 por una función lineal.

Cuando los datos tienen más de dos componentes, se obtienen sistemas

con más de dos incógnitas por lo general sobredeterminados.

Supongamos que tenemos los datos:

( xk1 , xk 2 ,…, xkn ; yk ) ,

k = 1, 2,…, m,

m > n +1

y se quieren ajustar por la relación lineal y = s0 + s1 x1 + " + sn xn .

Se obtiene entonces el sistema:

yk = s0 + s1 xk1 + " + sn xkn , k = 1, 2,…, m.

Matricialmente se expresa como:

⎛

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎝

y1 ⎞⎟

⎟

⎟

2 ⎟

⎟

⎟

⎟

⎟

⎟

m⎠

y

#

y

=

⎛

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎝

x1n ⎞⎟ ⎛⎜ s0 ⎞⎟

1

x11 "

1

x21 " x2 n ⎟⎟ ⎜⎜ s1 ⎟⎟

⎟⎜

⎟

⎟⎜

⎟

" " " " ⎟⎟ ⎜⎜ # ⎟⎟

⎟⎜

⎟

1 xm1 " xmn ⎟⎠ ⎜⎝ sn ⎟⎠

de forma abreviada y = As ≡ As = y .

Si rang ( A) = n + 1 , estamos ante un problema que se puede resolver con

el método de los mínimos cuadrados, siendo la solución óptima la

solución del sistema At As = At y , que es s * = ( At A ) At y .

−1

6.3 Otras funciones de ajuste.

172

MATEMÁTICAS I

Espacios vestoriales euclídeos. Proyecciones ortogonales. Mínimos cuadrados.

En algunas ocasiones hay que recurrir a otras funciones, como las

polinómicas o las exponenciales, para que la curva y = f ( x) sea la que

mejor se adapte a un conjunto de datos ( xi , yi ) .

Así, por ejemplo, si el ajuste se realiza por una función polinómica

y = f ( x) = c0 + c1 x + c2 x 2 + " + cn x n ,

al sustituir los datos ( xi , yi ) en la igualdad anterior se obtiene el sistema:

yi = c0 + c1 xi + c2 xi2 + " + cn xin ,

k = 1, 2,…, m.

Matricialmente se expresa como:

⎛

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎝

y1 ⎞⎟

⎟

y2 ⎟⎟

⎟

⎟

⎟

⎟

⎟

m⎠

#

y

=

⎛

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎝

1

x1

1

x2

x12 " x1n ⎞⎟ ⎛⎜ c0 ⎞⎟

⎟⎜

⎟

x22 " x2n ⎟⎟ ⎜⎜ c1 ⎟⎟

⎟⎜

⎟

" " "

" ⎟⎟ ⎜⎜ # ⎟⎟

⎟⎜

⎟

1 xm xm2 " xmn ⎟⎠ ⎜⎝ cn ⎟⎠

⇔ y = Ac ⇔ Ac = y

siendo la solución óptima por el método de mínimos cuadrados la

solución del sistema At Ac = At y , que es c = ( At A ) At y .

*

MATEMÁTICAS I

−1

173

Guerra, N.; López, B.; Quintana, M.P.; Suárez, A.

PROBLEMAS

1. Dado el espacio vectorial V de los polinomios de grado menor o

igual que 1 y el producto escalar:

1

p1 ( x) • p2 ( x) = ∫ p1 ( x) p2 ( x)dx .

Calcular

la

matriz

asociada

al

0

producto escalar respecto de la base B = {1, x}

SOLUCIÓN:

Un producto escalar es un caso particular de forma bilineal simétrica, por

lo tanto existe una matriz simétrica A, asociada al producto escalar,

respecto de cualquier base B = {u , v } de V . Dicha matriz vendrá dada

⎛u Du

por: ⎜

⎝u Dv

u Dv ⎞

⎟.

v Dv ⎠

En este caso particular tenemos que: u = 1 y que v = x .

Tal y como se ha definido el producto escalar, lo que sabemos es que:

1

1

0

0

1 D 1 = ∫ 1.1dx = ∫ dx = 1

1

1

0

0

1 D x = ∫ 1. xdx = ∫ xdx = 1/ 2

1

1

0

0

x D x = ∫ x. xdx = ∫ x 2 dx = 1/ 3

Luego, la matriz asociada al producto escalar en la base {1, x} es:

⎛ 1 1/ 2 ⎞

⎜

⎟

⎝1/ 2 1/ 3 ⎠

2. De un producto escalar definido en \ 2 respecto de la base

174

MATEMÁTICAS I

Espacios vestoriales euclídeos. Proyecciones ortogonales. Mínimos cuadrados.

B = {u , v } , se sabe que:

i) u D u = 2

ii ) u D (3u + v ) = 5

iii ) v D v = 5(u D u )

a) Calcular la matriz asociada al producto escalar.

b) Calcular (2, 3) D (1, 4)

SOLUCIÓN:

a)

⎛u Du

A=⎜

⎝u Dv

u Dv ⎞

⎟

v Dv ⎠

Tenemos que:

u Du = 2

u D (3u + v ) = 5 ⇒ 3(u D u ) + u D v = 5 ⇒ 6 + u D v = 5 ⇒ u D v = −1

v D v = 5(u D u ) = 10

⎛ 2 −1⎞

La matriz asociada al producto escalar es: A = ⎜

⎟

⎝ −1 10 ⎠

b)

⎛1⎞

⎛ 2 −1 ⎞ ⎛ 1 ⎞

(2, 3) D (1, 4) = ( 2, 3) A ⎜ ⎟ = ( 2, 3) ⎜

⎟ ⎜ ⎟ = 113

⎝ 4⎠

⎝ −1 10 ⎠ ⎝ 4 ⎠

3. Sea E un espacio vectorial euclídeo de dimensión n y U un

subespacio vectorial de E ,

U ⊥ , el subespacio complemento

ortogonal de U , calcular:

a) dim(U ∩ U ⊥ )

b) dim(U + U ⊥ )

SOLUCIÓN:

MATEMÁTICAS I

175

Guerra, N.; López, B.; Quintana, M.P.; Suárez, A.

a) Sabemos que la suma de U y U ⊥ es directa, por tanto U ∩ U ⊥ = {0}

con lo cual dim(U ∩ U ⊥ ) = 0.

b) Además de ser suma directa se tiene que, U ⊕ U ⊥ = V , directamente

se obtiene que dim(U + U ⊥ ) = dim(V ) = n.

4.

Sea

F = {( x, y, z ) ∈ \ 3 / 2 x + y − z = 0} , calcular

una

base

ortonormal de F.

SOLUCIÓN:

Primero hallaremos una base de F, si es ortogonal, bastaría con

normalizar y el problema estaría resuelto, sino aplicaremos el método de

Gram-Schmidt para transformarla en otra base de F que sea ortonormal.

F = {( x, y, z ) ∈ \ 3 / 2 x + y − z = 0} = {( x, y, z ) ∈ \ 3 / z = 2 x + y} =

= {( x, y, 2 x + y ) ∈ \ 3 / x, y ∈ \} =< (1, 0, 2), (0,1,1) >

⎛1⎞ ⎛0⎞

Una base para F es B1 = {⎜⎜ 0 ⎟⎟ , ⎜⎜ 1 ⎟⎟} = {u1 , u2 } que sus vectores no son

⎜ 2⎟ ⎜1⎟

⎝ ⎠ ⎝ ⎠

⎛0⎞

ortogonales ya que u ⋅ u2 = (1, 0, 2) ⎜⎜ 1 ⎟⎟ = 2 ≠ 0

⎜1⎟

⎝ ⎠

t

1

Aplicamos el método de Gram-Schmidt

⎛1⎞

⎜ ⎟

v1 = u1 = ⎜ 0 ⎟

⎜ 2⎟

⎝ ⎠

176

MATEMÁTICAS I

Espacios vestoriales euclídeos. Proyecciones ortogonales. Mínimos cuadrados.

⎛ 0 ⎞ ⎛ 1 ⎞ ⎛ − 52 ⎞

u ⋅v

⎜ ⎟ ⎜ ⎟ ⎜ ⎟

v2 = u2 − 1 v1 = ⎜ 1 ⎟ − 52 ⎜ 0 ⎟ = ⎜ 1 ⎟

v ⋅v1

⎜1⎟ ⎜ 2⎟ ⎜ 1 ⎟

⎝ ⎠ ⎝ ⎠ ⎝ 5 ⎠

t

1

t

1

⎛ 1 ⎞ ⎛ − 52 ⎞

⎜ ⎟ ⎜ ⎟

B2 = {⎜ 0 ⎟ , ⎜ 1 ⎟} es una base ortogonal de F y normalizando los

⎜ 2⎟ ⎜ 1 ⎟

⎝ ⎠ ⎝ 5 ⎠

vectores de B2 se obtiene B3

⎛

⎜

⎜

= {⎜

⎜

⎜

⎝

⎛

1 ⎞ ⎜

5⎟ ⎜

⎟ ⎜

0 ⎟,⎜

2 ⎟ ⎜

⎟

5 ⎠ ⎜⎜

⎝

−2 ⎞

⎟

30 ⎟

5 ⎟}

30 ⎟

⎟

1 ⎟

⎟

30 ⎠

que es una base ortonormal

de F.

5. Sea F ⊂ \ n , B1 una base ortonormal de F , B2 una base

ortonormal de

F ⊥,

demostrar que

B = B1 ∪ B2 es una base

ortonormal de \ n .

SOLUCIÓN:

Sabemos que F ∩ F ⊥ = {0}, como el vector nulo no pertenece a ninguna

base, los vectores de B1 son linealmente independientes con los de B2 . Si

la dim(V ) = k entonces dim(V ⊥ ) = n − k , luego una base de F unida con

una base de F ⊥ son k + (n − k ) = n vectores linealmente independientes

de \ n , por tanto forman una base de \ n .

Por otra parte los vectores de B1 son ortonormales, es decir, todos tienen

norma igual a 1 y son ortogonales entre si, lo mismo ocurre con los

vectores de B2 y los vectores de B1 respecto de los de B2 también son

ortogonales ya que los de B1 son vectores de F y los de B2 lo son de

MATEMÁTICAS I

177

Guerra, N.; López, B.; Quintana, M.P.; Suárez, A.

F ⊥.

En definitiva los vectores de B están normalizados y son todos

ortogonales entre si, forman una base ortonormal de \ n .

6. Dados los subespacios de \ 3

x − y − 3z = 0⎫

⎧

F1 = ⎨( x, y, z ) ∈ \ 3 /

⎬y

y − z = 0⎭

⎩

F2 = {( x, y, z ) ∈ \ 3 / x + y + z = 0}

Calcular dim( F1⊥ ∩ F2 )

SOLUCIÓN:

⎛ 1 −1 − 3 ⎞

dim( F1 ) = 3 − rango ⎜

⎟ = 3 − 2 = 1;

⎝ 0 1 −1 ⎠

dim( F2 ) = 3 − rango (1 1 1) = 3 − 1 = 2;

BF1 = {(4,1,1)} = {w1}

BF2 = {(−1,1, 0), (−1, 0,1)} = {v1 , v2 }

F1⊥ = {x ∈ \ 3 / x t ·w1 = 0} = {( x, y, z ) ∈ \ 3 / 4 x + y + z = 0}

BF ⊥ = {(1, 0, −4), (0,1, −1)} = {u1 , u2 }

1

Sabemos que

178

MATEMÁTICAS I

Espacios vestoriales euclídeos. Proyecciones ortogonales. Mínimos cuadrados.

⊥

1

dim( F ∩ F2 ) = dim( F1⊥ ) + dim( F2 ) − dim( F1⊥ + F2 )

= 2 + 2 − rango(u1 u2 v1 v2 ) =

⎛1

⎜

= 4 − rango ⎜ 0

⎜ −4

⎝

⎛1

⎜

= 4 − rango ⎜ 0

⎜0

⎝

0 −1 −1⎞

⎟

1 1 0 ⎟=

−1 0 1 ⎟⎠

0 −1 −1 ⎞

⎟

1 1 0 ⎟ = 4−3 =1

0 −3 −3 ⎟⎠

= 4−3 =1

7.

Un

producto

escalar

\3

en

B′ = {(1, 0,1) , ( 2,1, 0 ) , ( −1, 0,1)}

con

tiene

por

respecto

a

matriz

la

base

asociada

⎛ 2 1 2⎞

⎜

⎟

G = ⎜ 1 3 1 ⎟ , calcular la norma del vector v que en la base

⎜ 2 1 4⎟

⎝

⎠

canónica tiene por coordenadas

( 4,1, −1)

SOLUCIÓN:

Lo primero que tenemos que hacer es expresar el vector v respecto a la

base B′ . Sabemos que la relación entre las coordenadas de un vector

respecto de ambas bases es x = Px´

Sabemos que la matriz P cambio de base de B ' a la base canónica es:

⎛ ′⎞

⎛ 4 ⎞ ⎛ 1 2 −1⎞ ⎜ x ⎟

⎛ 1 2 −1 ⎞

⎜ ⎟ ⎜

⎟⎜ ⎟

⎜

⎟

P = ⎜ 0 1 0 ⎟ , por lo tanto, se cumple que: ⎜ 1 ⎟ = ⎜ 0 1 0 ⎟ ⎜⎜ y′ ⎟⎟

⎜ −1⎟ ⎜ 1 0 1 ⎟ ⎜⎜⎜ z′ ⎟⎟⎟

⎜1 0 1 ⎟

⎝ ⎠ ⎝

⎠⎝ ⎠

⎝

⎠

siendo ⎛⎜⎝ x′ , y ′ , z ′ ⎞⎟⎠ las coordenadas de v respecto a la base B ' .

Por lo tanto:

MATEMÁTICAS I

179

Guerra, N.; López, B.; Quintana, M.P.; Suárez, A.

⎛

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎝

−1

x′ ⎞⎟ ⎛ 1 2 −1⎞ ⎛ 4 ⎞

⎟

⎜

⎟ ⎜ ⎟

y′ ⎟⎟ = ⎜ 0 1 0 ⎟ ⎜ 1 ⎟ =

⎟

z′ ⎟⎟⎠ ⎜⎝ 1 0 1 ⎟⎠ ⎜⎝ −1⎟⎠

⎛ 12

⎜

⎜ 0

⎜− 1

⎝ 2

−1

1

1

⎞ ⎛ 4 ⎞ ⎛ 12 ⎞

⎟⎜ ⎟ ⎜ ⎟

0⎟⎜ 1 ⎟ = ⎜ 1 ⎟

⎟ ⎜− 3 ⎟

1 ⎟⎜

2 ⎠ ⎝ −1 ⎠

⎝ 2⎠

1

2

Una vez que tenemos expresado el vector v respecto de la base B , su

norma será:

v = v D v = v t Gv =

8. Si V

{

( 12

⎛ 2 1 2 ⎞ ⎛ 12 ⎞

⎜

⎟⎜ ⎟

1 − 32 ) ⎜ 1 3 1 ⎟ ⎜ 1 ⎟ =

⎜

⎟⎜ 3 ⎟

⎝ 2 1 4⎠⎝ − 2 ⎠

⎛ 12 ⎞

( −1 2 −4 ) ⎜⎜ 1 ⎟⎟ =

⎜ 3⎟

⎝− 2 ⎠

es un espacio vectorial de dimensión

}

W = x ∈ V : Ax = 0

n=5

y

es un subespacio vectorial de V . Justificar

cuales de las siguientes afirmaciones son verdaderas y cuales falsas:

a) W

es el núcleo de la aplicación lineal

f : V → V definida por

f ( x ) = Ax .

b) dim(W ⊥ ) coincide con el rango de A .

c) Todas las filas de la matriz A pertenecen a W

⊥

d) Si dim(W ) = 2 , el rango de A es 2.

SOLUCIÓN:

Sabemos que:

i ) Al estar W definido como solución de un sistema de ecuaciones

homogéneo, dim(W ) = dim(V ) − rango( A) = n − rango( A) = 5 − rango( A)

ii ) dim(W ) + dim(W ⊥ ) = dim(V )

a) Verdadera

Para verlo, basta considerar la definición de núcleo de una aplicación

lineal:

180

MATEMÁTICAS I

15

2

Espacios vestoriales euclídeos. Proyecciones ortogonales. Mínimos cuadrados.

Si tenemos la aplicación lineal: f : V → V definida por f ( x ) = Ax , por

definición

de

núcleo

{

} {

se

tiene

que:

}

Ker ( f ) = x ∈ V / f ( x ) = 0 = x ∈ V / Ax = 0 = W .

b) Verdadera

Tenemos que:

dim(W ) + dim(W ⊥ ) = dim(V ) ⇒ dim(W ) + dim(W ⊥ ) = n ⇒

⇒ dim(W ⊥ ) = n − dim(W ) = n − (n − rango( A)) = rango( A)

c) Verdadera

Sabemos que para cada w ∈ W , entonces:

Aw = 0 , por lo tanto, al

multiplicar cada fila de la matriz A por w , el resultado es 0 . En realidad

esto es equivalente a decir que cada vector fila de la matriz A

multiplicado por el vector w , usando el producto escalar usual, nos da 0,

es decir que cada vector fila de la matriz A es ortogonal a todos los

vectores de W , por lo tanto cada vector fila de la matriz A pertenece a

W ⊥.

d) Falsa

El subespacio vectorial W se puede ver como el núcleo de la aplicación

f : V → V definida por f ( x ) = Ax . Por la fórmula de las dimensiones

sabemos que:

dim(V ) = dim( Ker ( f )) + dim( Im( f )) .

y también sabemos que

dim( Im( f )) = rango( A).

Luego, como dim(V ) = 5

y

dim(W ) = dim( Ker ( f )) = 2 , entonces

dim( Im( f )) = 5 − 2 = 3 luego rango( A) = 3.

MATEMÁTICAS I

181

Guerra, N.; López, B.; Quintana, M.P.; Suárez, A.

9. Sea V un espacio vectorial euclídeo y U un subespacio vectorial

de V , U ⊥ el subespacio complemento ortogonal de U . Justificar

cuales de las siguientes afirmaciones son verdaderas y cuales falsas:

a) dim(U ) = dim(U ⊥ )

b) dim(U ∩ U ⊥ ) = 0

c) dim(U ∩ U ⊥ ) = dim(V )

{}

d) (U ⊥ ) ⊥ = 0

SOLUCIÓN:

a) Falso

Veamos el siguiente contraejemplo.

Consideramos V = \3 , espacio vectorial euclídeo con el producto escalar

( x1, x2 , x3 ) ⋅ ( y1 , y2 , y3 ) = x1 y1 + x2 y2 + x3 y3 ,

usual,

y

el

subespacio

U = (1, 0,1) . Veamos cuál es su complemento ortogonal:

U ⊥ = {( x, y, z ) ∈ \ 3 : ( x, y, z ) ⋅ (1, 0,1) = 0, con ⋅ el producto escalar usual} =

= {( x, y, z ) ∈ \ 3 : x + y = 0} = {( x, y, z ) ∈ \ 3 : x = − y} = (1, −1, 0 ) , ( 0, 0,1)

dim(U ) = 1 y sin embargo dim(U ⊥ ) = 2 ≠ 1

b) Verdadera

Una de las propiedades del subespacio complemento ortogonal nos dice

que:

U ⊕U ⊥ = V

de

donde

se

deduce

inmediatamente

que

{}

U ∩ U ⊥ = 0 , o equivalentemente: dim ⎛⎜⎝U ∩ U ⊥ ⎞⎟⎠ = 0

c) Falsa

182

MATEMÁTICAS I

Espacios vestoriales euclídeos. Proyecciones ortogonales. Mínimos cuadrados.

{}

Sabemos que U ∩ U ⊥ = 0 , por lo tanto la dimensión de esta

intersección nunca puede ser igual a la dimensión de V porque se parte

de la hipótesis de que el espacio vectorial V es no nulo.

d) Falsa.

(U ⊥ ) ⊥ = U , por lo tanto, siempre que U sea distinto del subespacio

{}

nulo, (U ⊥ ) ⊥ ≠ 0 .

10. El vector v = (1,1, 0 ) ∉ F , siendo F = ( 0,1,1) , (1, 3, −1) . Calcular el

vector de F que mejor se aproxima a v en el sentido de mínimos

cuadrados.

SOLUCIÓN:

El vector que mejor se aproxima a v en el sentido de mínimos cuadrados

es su proyección ortogonal sobre F, dicha proyección ortogonal viene

dada por w = A( At A ) At v siendo A la matriz cuyas columnas son los

−1

vectores de la base que genera al subespacio F .

NOTA : Una condición necesaria para que exista la matriz

( A A)

t

−1

es

que los vectores que definen las columnas de la matriz A sean

linealmente independientes, es decir, no basta con que generen a F , es

necesario que sean base de F .

w = A( At A ) At v

−1

−1

⎛0 1 ⎞⎡

⎛ 0 1 ⎞⎤

⎛1⎞

⎜

⎟ ⎢⎛ 0 1 1 ⎞ ⎜

⎟⎥ ⎛ 0 1 1 ⎞ ⎜ ⎟

= ⎜ 1 3 ⎟ ⎢⎜

⎟ ⎜ 1 3 ⎟⎥ ⎜

⎟⎜1⎟ =

⎜ 1 −1⎟ ⎢⎝ 1 3 −1⎠ ⎜ 1 −1⎟ ⎥ ⎝ 1 3 −1⎠ ⎜ 0 ⎟

⎝

⎠⎣

⎝

⎠⎦

⎝ ⎠

MATEMÁTICAS I

183

Guerra, N.; López, B.; Quintana, M.P.; Suárez, A.

⎛ 0 1 ⎞ 11

⎜

⎟⎛

= ⎜ 1 3 ⎟ ⎜ 181

⎜ 1 −1⎟ ⎝ − 9

⎝

⎠

⎛0 1 ⎞ 1

⎜

⎟⎛ −

= ⎜ 1 3 ⎟ ⎜ 19

⎜ 1 −1⎟ ⎝ 9

⎝

⎠

⎛1⎞

− 19 ⎞ ⎛ 0 1 1 ⎞ ⎜ ⎟

⎟ 1 =

1 ⎟⎜

3 −1⎠ ⎜⎜ ⎟⎟

9 ⎠⎝1

⎝0⎠

5

18

2

9

⎛1⎞

⎞⎜ ⎟

⎟ 1 =

− 92 ⎠ ⎜⎜ ⎟⎟

⎝0⎠

13

18

⎛ 1 ⎞

⎜ 3 ⎟

⎛0 1 ⎞ 1

⎜

⎟

⎛

⎞

⎜

⎟

= ⎜ 1 3 ⎟ ⎜ 16 ⎟ = ⎜ 7 ⎟

⎜ 1 −1⎟ ⎝ 3 ⎠ ⎜ 6 ⎟

⎝

⎠

⎜⎜ − 1 ⎟⎟

⎝ 6⎠

Otra forma de enfocar y resolver el problema es sabiendo que el vector

v = (1,1, 0 ) ∉ F , siendo F =< ( 0,1,1) , (1, 3, −1) >=< u1 , u2 > , quiere decir

que el sistema:

⎛0⎞

⎛ 1 ⎞ ⎛1⎞ ⎛ 0 1 ⎞ ⎛ ⎞ ⎛1⎞

⎜α ⎟

⎜ ⎟

α1 ⎜ 1 ⎟ + α 2 ⎜⎜ 3 ⎟⎟ = ⎜⎜ 1 ⎟⎟ ⇒ ⎜⎜ 1 3 ⎟⎟ ⎜⎜ 1 ⎟⎟ = ⎜⎜ 1 ⎟⎟

⎜1⎟

⎜ −1⎟ ⎜ 0 ⎟ ⎜ 1 −1⎟ ⎜⎝ α 2 ⎟⎠ ⎜ 0 ⎟

⎝ ⎠

⎝ ⎠ ⎝ ⎠ ⎝

⎠

⎝ ⎠

es un sistema incompatible. Se plantea y resuelve el sistema

At Aα = At v , obteniéndose

⎛

⎜

⎜

⎜⎜

⎝

α1 ⎞⎟ ⎛ 16 ⎞

⎟ = ⎜ ⎟ que son las coordenadas de la

α2 ⎟⎟⎠ ⎝ 13 ⎠

proyección ortogonal de v sobre F, el vector proyección de v sobre F

es por tanto

Aα = ( u1 u2 )

⎛

⎜

⎜

⎜⎜

⎝

1⎞ 1

⎛ 13 ⎞

⎟⎛ ⎞ ⎜ ⎟

3 ⎟ ⎜ 16 ⎟ = ⎜ 76 ⎟ .

⎟⎝ 3 ⎠ ⎜ − 1 ⎟

⎝ 1 −1⎠

⎝ 6⎠

⎛0

α1 ⎞⎟ ⎜

⎟ = 1

α 2 ⎟⎟⎠ ⎜⎜

11. Sea el espacio vectorial \ 3 , y el subespacio W = (1, 0,1) , ( 0,1,1) .

184

MATEMÁTICAS I

Espacios vestoriales euclídeos. Proyecciones ortogonales. Mínimos cuadrados.

Si u = ( 4, 3, 0 ) ∈ \ , u ∉ W . Calcular el vector de W que mejor se

3

aproxima a u en el sentido de mínimos cuadrados.

SOLUCIÓN:

El vector de W que mejor se aproxima a u en el sentido de mínimos

cuadrados es su proyección ortogonal sobre W . Dicha proyección

ortogonal viene dada por la siguiente expresión:

x = A( At A ) At u , siendo

−1

A

la matriz cuyas columnas son las

coordenadas de un sistema generador, linealmente independiente de W .

Por lo tanto, se tiene que:

−1

⎛1 0⎞ ⎡

⎛ 1 0 ⎞⎤

⎛ 4⎞

−1 t

⎜

⎟ ⎢⎛ 1 0 1 ⎞ ⎜

⎟ ⎥ ⎛ 1 0 1⎞ ⎜ ⎟

t

x = A( A A ) A u = ⎜ 0 1 ⎟ ⎢⎜

⎟ ⎜ 0 1 ⎟⎥ ⎜

⎟⎜ 3⎟ =

⎜ 1 1 ⎟ ⎢⎝ 0 1 1 ⎠ ⎜ 1 1 ⎟ ⎥ ⎝ 0 1 1 ⎠ ⎜ 0 ⎟

⎝

⎠⎣

⎝

⎠⎦

⎝ ⎠

⎛1 0⎞

⎛ 4⎞

−1

⎜

⎟ ⎛ 2 1 ⎞ ⎛ 1 0 1⎞ ⎜ ⎟

= ⎜0 1⎟ ⎜

⎟ ⎜

⎟⎜ 3⎟ =

⎜ 1 1 ⎟ ⎝ 1 2 ⎠ ⎝ 0 1 1⎠ ⎜ 0 ⎟

⎝ ⎠

⎝

⎠

⎛1 0⎞ 2

⎜

⎟⎛

= ⎜ 0 1 ⎟ ⎜ 31

⎜1 1⎟⎝ − 3

⎝

⎠

⎛5⎞

⎛ 4⎞ ⎜ 3 ⎟

− 13 ⎞⎛ 1 0 1⎞ ⎜ ⎟ ⎜ 2 ⎟

⎟ 3 = ⎜ ⎟

2 ⎟⎜

1 1⎠ ⎜⎜ ⎟⎟ ⎜ 3 ⎟

3 ⎠⎝0

⎝0⎠ ⎜ 7 ⎟

⎜ ⎟

⎝3⎠

x+ y

= 0⎫

⎪

12. Dado el sistema: − x + y = 1 ⎬ , calcular la mejor solución por

2 x + 3 y = 1 ⎭⎪

mínimos cuadrados.

SOLUCIÓN:

MATEMÁTICAS I

185

Guerra, N.; López, B.; Quintana, M.P.; Suárez, A.

Si llamamos A a la matriz de los coeficientes y b a la matriz de los

términos independientes del sistema anterior, como las columnas de A

son linealmente independientes, sabemos que la mejor solución por

mínimos cuadrados viene dada por:

−1

⎡

⎛ 1 1 ⎞⎤

⎛0⎞

−1 t

⎢ ⎛ 1 −1 2 ⎞ ⎜

⎟ ⎥ ⎛1 −1 2 ⎞ ⎜ ⎟

t

x = ( A A ) A b = ⎢⎜

⎟ −1 1 ⎟ ⎥ ⎜

⎟ 1 =

1 1 3 ⎠ ⎜⎜

1 1 3 ⎠ ⎜⎜ ⎟⎟

⎝

⎝

⎟

⎢⎣

⎝ 2 3 ⎠ ⎥⎦

⎝1⎠

⎛0⎞

−1

⎛ 6 6 ⎞ ⎛1 −1 2 ⎞ ⎜ ⎟ ⎛ 11

30

=⎜

⎟ ⎜

⎟⎜1⎟ = ⎜ − 1

6

11

1

1

3

⎝

⎠ ⎝

⎠⎜ ⎟ ⎝ 5

⎝1⎠

Luego, la mejor

⎛0⎞

− 15 ⎞ ⎛1 −1 2 ⎞ ⎜ ⎟

⎟ 1 =

1 ⎟⎜

1 3 ⎠ ⎜⎜ ⎟⎟

5 ⎠ ⎝1

⎝1⎠

solución por mínimos cuadrados es:

⎛ − 13 ⎞

⎜ 30 ⎟

⎜ 3⎟

⎝ 5⎠

x = − 13

30

e

y= 3.

5

13. Utilizando el método de los mínimos cuadrados, calcular una

⎧2 x + y = 3

⎪

solución aproximada del sistema de ecuaciones ⎨ x − 2 y = 0

⎪

⎩ 3 x − y = −2

SOLUCIÓN:

La matriz de los coeficientes del sistema es

⎛2 1 ⎞

⎜

⎟

A = ⎜ 1 −2 ⎟ ,

⎜ 3 −1 ⎟

⎝

⎠

rango( A) = 2.

⎛ 3⎞

La matriz de los términos independientes es b = ⎜⎜ 0 ⎟⎟ .

⎜ −2 ⎟

⎝ ⎠

186

MATEMÁTICAS I

Espacios vestoriales euclídeos. Proyecciones ortogonales. Mínimos cuadrados.

El sistema no tiene solución ya que

3⎞

⎛2 1

⎜

⎟

rango( A∗ ) = rango( A | b) = rango ⎜ 1 −2 0 ⎟ = 3 ≠ 2 = rango( A)

⎜ 3 −1 −2 ⎟

⎝

⎠

⎛ x⎞

Tenemos el sistema: Ax = b , siendo x = ⎜ ⎟ .

⎝ y⎠

La solución óptima del sistema en el sentido de los mínimos cuadrados,

es la solución del sistema At Ax = At b como la matriz A es de rango

máximo, viene dada por: x * = ( At A ) At b

−1

Es decir:

−1

⎛

⎛2 1 ⎞⎞

⎛ 3⎞

⎜⎛ 2 1 3 ⎞⎜

⎟⎟ ⎛ 2 1 3 ⎞⎜ ⎟

*

x = ⎜⎜

⎟ ⎜ 1 −2 ⎟ ⎟ ⎜

⎟⎜ 0 ⎟ =

1

2

1

1

2

1

−

−

−

−

⎝

⎠

⎝

⎠ ⎜ −2 ⎟

⎜ 3 −1 ⎟ ⎟

⎜

⎝

⎠⎠

⎝ ⎠

⎝

⎛2

⎜ 25

⎜1

⎝ 25

1 ⎞

25 ⎟ ⎛ 2

14 ⎟ ⎜ 1

75 ⎠ ⎝

⎛ 3⎞

3 ⎞⎜ ⎟

⎟ 0 =

−2 −1⎠ ⎜⎜ ⎟⎟

⎝ −2 ⎠

1

x1 + x2

14. Dado el sistema −3 x1 + x2

− x1 + x2

⎛1⎞

⎜5⎟

⎜ 14 ⎟

⎜ ⎟

⎝ 15 ⎠

=

0⎫

⎪

= −1⎬ calcular la solución por

= 1 ⎪⎭

mínimos cuadrados.

SOLUCIÓN:

⎛ 1 1⎞

La matriz de coeficientes del sistema es A = ⎜⎜ −3 1⎟⎟ , rango( A) = 2.

⎜ −1 1 ⎟

⎝

⎠

MATEMÁTICAS I

187

Guerra, N.; López, B.; Quintana, M.P.; Suárez, A.

⎛1 1 0⎞

⎜

⎟

La matriz ampliada es A = ⎜ −3 1 −1⎟ , rango( A∗ ) = 3,

⎜ −1 1 1 ⎟

⎝

⎠

∗

por tanto el sistema es incompatible, luego no tiene solución exacta.

Se plantea el nuevo sistema A Ax = A b, siendo x =

t

t

⎛

⎞

⎜ 1⎟

⎜

⎟

⎜⎜

⎟⎟

⎝ 2⎠

x

x

⎛0⎞

y b = ⎜⎜ -1⎟⎟ ,

⎜1⎟

⎝ ⎠

para encontrar solución aproximada al sistema por el método de mínimos

cuadrados, el nuevo sistema a resolver es:

⎛ 1 1⎞ ⎛ ⎞

⎛0⎞

⎛1 −3 −1⎞ ⎜

⎟ ⎜⎜ x1 ⎟⎟ ⎛1 −3 −1⎞ ⎜ ⎟

⎜

⎟ ⎜ −3 1⎟ ⎜⎜ x ⎟⎟ = ⎜

⎟ ⎜ −1 ⎟

⎝1 1 1 ⎠ ⎜

⎝1 1 1 ⎠ ⎜ ⎟

⎝ 2⎠

⎟

⎝ −1 1⎠

⎝1⎠

11x1 − 3 x2

−3 x1 + 3 x2

= 2⎫

1

1

⎬ cuya solución exacta es x1 = , x2 = .

4

4

= 0⎭

15. Calcular la recta que mejor se ajusta en el sentido de mínimos

cuadrados

al

conjunto

de

puntos

siguiente

{(−2, 2), (−1, 0), (0, −1), (1, 4)}

SOLUCIÓN:

Buscamos la recta, y = mx + n, que mejor se ajuste al conjunto de

puntos, primero se intentará encontrar una recta que contenga a los cuatro

puntos, si no existe, se buscará la que menor error cuadrático cometa.

(−2, 2) → 2

(−1, 0) → 0

(0, −1) → −1

(1, 4) → 4

188

= −2m + n ⎫ −2m + n

= −1m + n ⎪⎪

−m + n

⎬≡

n

= 0m + n ⎪

m+n

1m + n ⎪⎭

=

= 2⎫

= 0 ⎪⎪

⎬;

= −1⎪

= 4 ⎪⎭

MATEMÁTICAS I

Espacios vestoriales euclídeos. Proyecciones ortogonales. Mínimos cuadrados.

⎛ −2

⎜

−1

∗

A =⎜

⎜0

⎜⎜ 1

⎝

1 2⎞

⎟

1 0⎟

, si hallamos una forma escalonada equivalente de A∗

1 −1 ⎟

⎟

1 4 ⎟⎠

⎛ −2

⎜

0

obtenemos ⎜

⎜0

⎜⎜

⎝0

1 2 ⎞

⎟

1 −1 ⎟

, directamente se observa que rango( A) = 2 y

0 − 12 ⎟

⎟

0 0 ⎟⎠

rango( A∗ ) = 3 ⇒ Sistema incompatible, no hay una recta que pase por

los cuatro puntos.

Se plantea el nuevo sistema At Ax = At b.

⎛ −2

⎜

−1

Siendo A = ⎜

⎜ 0

⎜⎜ 1

⎝

1⎞

⎛2⎞

⎟

⎜ ⎟

1⎟

0

⎛ m⎞

, x = ⎜ ⎟ y b = ⎜ ⎟ y nos queda:

⎜ −1⎟

1⎟

⎝n⎠

⎟

⎜ ⎟⎟

⎟

⎜

1⎠

⎝4⎠

6m − 2n = 0 ⎫

3

1

⎬ cuya solución exacta es m = 2 , n = 2 .

−2 m + 4 n = 5 ⎭

La recta es por tanto y = 1 x + 3

2

2

MATEMÁTICAS I

189

Guerra, N.; López, B.; Quintana, M.P.; Suárez, A.

Bibliografía

[1] BURGOS, J. ”Álgebra Lineal y Geometría Cartesiana”. McGrawHill. Madrid, 1999.

[2] DE LA VILLA, A. ”Problemas de Álgebra”. Clagsa. Madrid, 1994.

[3] GROSSMANN, S.I. ”Álgebra Lineal con aplicaciones”. McGrawHill. México, 1996.

[4] GUERRA, N.; LÓPEZ, B. ”Problemas resueltos tipo test de Álgebra

Lineal (Con esquemas teóricos)”. El Libro Técnico. Las Palmas de G.C.,

1999.

[5] LAY DAVID C. ”Algebra lineal y sus aplicaciones”. Addison

Wesley Longman. México 1999.

[6] NOBLE, B.; DANIEL, J.W. ”Álgebra Lineal Aplicada”. PrenticeHall, Inc. México, 1989.

190

MATEMÁTICAS I