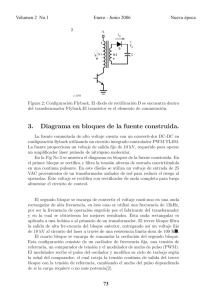

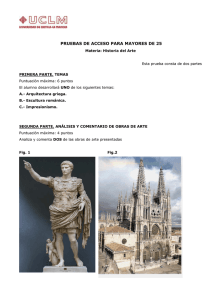

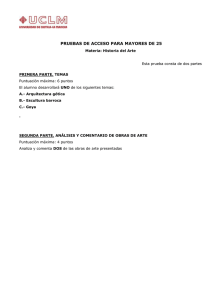

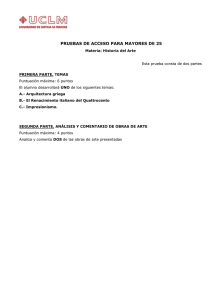

Enero 2014 Revista Técnica Edición No. 10 (ISSN 1390 – 5074) TÍTULO SISTEMAS ELÉCTRICOS DE POTENCIA DETERMINACIÓN DE LOS LÍMITES DE ESTABILIDAD ESTÁTICA DE ÁNGULO DEL SNI................... LA GENERACIÓN DISTRIBUIDA: RETOS FRENTE AL MARCO LEGAL DEL MERCADO ELÉCTRICO ECUATORIANO........................................................................................................................................ IDENTIFICACIÓN DE FALLAS CRÍTICAS EN EL SNI Y DISEÑO DE UN ESQUEMA PROTECCIÓN SISTÉMICA............................................................................................................................................... OPTIMIZACIÓN DE LA OPERACIÓN DE LAS UNIDADES DE LA CENTRAL MAZAR EN FUNCIÓN DE LA CABEZA NETA................................................................................................................................. ANÁLISIS PARA EL INICIO DEL RESTABLECIMIENTO DE LA ZONA 4 DEL SNI POSTERIOR A UN BLACK OUT CON EL ARRANQUE EN NEGRO DE LAS UNIDADES DE LA CENTRAL MAZAR......... EFICIENCIA ENERGÉTICA DISEÑO Y CONSTRUCCIÓN DE UN EQUIPO PARA SEGUIMIENTO SOLAR AUTOMÁTICO E IMPLANTACIÓN DE UN SOFTWARE DE SUPERVISIÓN PARA UN SISTEMA MÓVIL FOTOVOLTAICO...................................................................................................................................... GENERACIÓN EÓLICA EN ECUADOR: ANÁLISIS DEL ENTORNO Y PERSPECTIVAS DE DESARROLLO......................................................................................................................................... ANÁLISIS DE FACTIBILIDAD PARA LA IMPLEMENTACIÓN DE LA GESTIÓN DE LA DEMANDA DEL SECTOR INDUSTRIAL............................................................................................................................ ANÁLISIS DE PARÁMETROS TÉCNICOS EN EFICIENCIA DE ILUMINACIÓN PARA EL EDIFICIO MATRIZ DE LA EMPRESA ELÉCTRICA REGIONAL CENTRO SUR..................................................... TECNOLOGÍA E INNOVACIÓN EVALUACIÓN DE LA VULNERABILIDAD DEL SISTEMA ELÉCTRICO DE POTENCIA EN TIEMPO REAL USANDO TECNOLOGÍA DE MEDICIÓN SINCROFASORIAL...................................................... INCORPORACIÓN DE DISPOSITIVOS FACTS EN EL SNI....................................................................... FORMULACIÓN DE UNA ARQUITECTURA TÉCNICA Y FUNCIONAL Y EL DESPLIEGUE DE UNA PRUEBA DE CONCEPTO PARA MEJORAR LA SUPERVISIÓN, OPERACIÓN Y ANÁLISIS POST OPERATIVO DEL SNI.............................................................................................................................. INFORMACIÓN OPERATIVA EN DISPOSITIVOS MÓVILES..................................................................... ANÁLISIS DE ESTABILIDAD DE PEQUEÑA SEÑAL UTILIZANDO MEDICIONES SINCROFASORIALES – PMU................................................................................................................. ARQUITECTURAS DE RED LAN PARA LA AUTOMATIZACIÓN DE SUBESTACIONES, BASADAS EN LA NORMA IEC 61850 (RSTP Y PRP)..................................................................................................... OPERACIÓN REMOTA DE LA DISTRIBUCIÓN BASADA EN LA SUPERVISIÓN Y CONTROL REMOTOS DE RECONECTADORES..................................................................................................... DISEÑO E IMPLEMENTACIÓN DEL SISTEMA DE CONTROL DE UN INVERSOR MULTINIVEL DE FUENTES INDEPENDIENTES, POR MEDIO DE MODULACIÓN VECTORIAL ESPACIAL.................. ESTUDIO DE COORDINACIÓN DE PROTECCIONES POR MÉTODOS COMPUTACIONALES APLICADOS A UNA SUBESTACIÓN....................................................................................................... BREAKER DC BASADO EN CONVERTIDORES CONTROLADO POR MODOS DESLIZANTES........... DISEÑO E IMPLEMENTACIÓN DE UN REGISTRADOR DE DISTURBIOS DE FRECUENCIA PARA ANÁLISIS DINÁMICO DE SISTEMAS ELÉCTRICOS DE POTENCIA.................................................... MONITOREO DE LAS OSCILACIONES DE BAJA FRECUENCIA DEL SNI A PARTIR DE LOS REGISTROS EN TIEMPO REAL............................................................................................................. ANÁLISIS DEL SISTEMA DE ALARMAS DEL EMS DEL CENACE........................................................... MARCO DE REFERENCIA PARA LA FORMULACIÓN DE UN PLAN DE CONTINUIDAD DE NEGOCIO PARA TI, UN CASO DE ESTUDIO......................................................................................... FORMULACIÓN DE UN MARCO DE CONVERGENCIA IT/OT.................................................................. AUTOR Pág. Dr. Jaime Cepeda – Ing. Pablo Verdugo 5 Ing. Fernando Durán 13 Ing. Verónica Flores - Ing. Javier Iza 28 Ing. Vicente Llivichuzhca - Ing. José GallardoIng. 35 Ing. Miguel Maldonado - Ing. Vicente Llivichuzhca 43 Ing. Javier Almeida – Ing. Paúl Ayala 49 Ing. Antonio Barragán 58 Ing. Pablo Méndez 67 Ing. Fernando Durán – Ing. Miguel Dávila 83 Dr. Jaime Cepeda – Dra. Delia Colomé Ing. Fernando Chamorro - Ing. Pablo Verdugo 91 102 Ing. Juan Vallecilla – Ing. Hugo Ortiz Ing. Carlos Del Hierro - Ing Roberto Sánchez 108 Ing. Ángela Quinaluiza – Ing. Diego Echeverría 123 Ing. Ana Zurita - Ing. Gioconda Rodríguez 133 Ing. Carlos Landázuri 142 Ing. Juan Galarza – Ing. Fausto Quizhpi 151 Ing. Cindy Palacios Ing. Juan Valladolid – Ing. Pedro Navarrete 159 167 Ing. Miguel Dávila – Ing. Carlos Landázuri 173 Dr. Jaime Cepeda – Ing. Aharon De La Torre Ing. Wilmer Gamboa – Ing. Christian Erazo 181 Ing. Marco Bautista Ing. Germán Pancho – Ing. Fernanda Galarza 200 117 191 208 La Revista Técnica “energía” de la Corporación CENACE, es publicada anualmente y su distribución no tiene costo alguno para las Empresas, las Instituciones Nacionales e Internacionales vinculadas al Sector Eléctrico, Colegios Profesionales e Institutos de Educación Superior. Se ha constituido en el medio para compartir criterios, experiencias técnicas y difundir los Artículos que son de responsabilidad de sus Autores; y, no necesariamente corresponden a aquellos sostenidos por el CENACE. DIRECTOR EDITORIAL Gabriel Argüello CONSEJO EDITORIAL Ing. José Medina R. Ing. Michelle Nieto Ing. Sonia Peña Ing. Paulina Vásquez Ing. Hermógenes Flores Ing. Eduardo Colmachi Ing. Gustavo Araque Ing. Vicente Quizanga Srta. Katherine Correa GRUPO TÉCNICO DE EVALUACIÓN DE TRABAJOS Ing. Luis Tapia Ing. Marco Valencia Ing. Edgar Muela Ing. Raul Moreno Ing. Freddy Campoverde Ing. Marco Tulio Aguilar Ing. Verónica Quintanar Ing. Erick Zbinden Ing. Pablo Mendez Ing, Jorge Luis Rojas Ing. Julio Cesar Zambrano Ing. Diego Chacon Ing. Mauricio Samper Dr. Andres Rosales Ing. Paul Ayala Ing. Victor Hugo Hinojosa Edición No. 10 Enero 2014 Evaluación: Cada trabajo técnico fue evaluado por dos profesionales, nacionales y extranjerosque pertenecen a reconocidas instituciones educativas, instituciones públicas y privadas del sector eléctrico. La selección de los trabajos a ser publicados se basó en el promedio de las dos calificaciones enviadas por los evaluadores y que superó la referencia adoptada de 70/100. EDITORIAL energía, la revista técnica de la Corporación CENACE apareció en su primera versión, en enero de 2005, como un esfuerzo institucional para difundir, los diferentes análisis, aplicaciones e investigaciones de la ingeniería para la administración técnica y comercial del Sistema Nacional Interconectado del Ecuador. Ésta edición, la décima, constituye un hito especial en la vida de la Corporación. energía, registra la historia científica y analítica de la actividad de CENACE en éstos últimos diez años, a la cual se han adherido aportes de ingenieros de las Empresas del Sector Eléctrico y de la Academia. Efectivamente, con la interconexión con Colombia en marzo del 2003, aparecieron nuevos retos técnicos a ser enfrentados y a ser resueltos, lo que demandó la incorporación de tecnologías en el campo de planeamiento operativo energético, estudios eléctricos en estado dinámico, el control automático de generación y del intercambio, protecciones sistémicas, etc. Esa experiencia ha quedado registrada en artículos técnicos de la revista energía a lo largo de estos años. CENACE enfrenta en el cercano futuro nuevos retos caracterizados por el manejo de una matriz de generación predominantemente hidroeléctrica, así como la inclusión de las energías renovables eólica y la solar. En el lado de la demanda se trabaja en eficiencia energética, la inclusión de las cocinas de inducción, la generación distribuida; lo que en conjunto configura un escenario altamente aleatorio en la cadena generación-demanda, lo que exige la incorporación de nuevas técnicas de gestión y control. En este contexto, las oportunidades para mejorar la calidad y seguridad del suministro se basan en la incorporación de nuevas tecnologías en medición, comunicaciones, control y electrónica de potencia. Hay necesidad de disponer mayor visibilidad del estado instantáneo del sistema de potencia, para monitorear el movimiento del sistema y mantenerlo dentro de zonas seguras. La red WAM que procesa mediciones provenientes de 22 unidades de medición fasorial, PMUs, instaladas en el Sistema Nacional Interconectado, es una realidad en el país a la vez que es un evento histórico de incorporación de alta tecnología. La puesta en operación de un sistema computarizado de protección sistémica en este año y la de FACTS en los próximos años, configurarán una red con mayor resiliencia, más segura y eficiente, para lo cual se requiere técnicas avanzadas para supervisión y control. El sistema de potencia cambió, el paradigma del flujo unidireccional de la generación a la carga ya no existe, el determinismo de corto plazo ya no existe, la sociedad es más exigente del servicio, la construcción de redes de transmisión se hace cada vez más restrictiva, se considera la huella de carbono, existen nuevos protagonistas o grupos de interés. Si aceptamos que el mundo y el sistema de potencia cambiaron, los que integramos el sector eléctrico debemos cambiar más rápido para adaptar nuestra acción al nuevo entorno. Los países y las instituciones exitosas son las que pueden mantener el vertiginoso ritmo del desarrollo tecnológico de la era actual, para atender eficientemente a la sociedad. En esta entrega, la edición No. 10, de la revista energía, se introducen varios temas que van hacia este nuevo entorno energético y eléctrico y vemos con beneplácito el avance que progresivamente va teniendo la ingeniería nacional. Felicitaciones a quienes hicieron posible estos diez años de luz y de esperanza. GABRIEL ARGÜELLO RÍOS Director Ejecutivo La Revista Técnica “energía” ha sido evaluada y aceptada para formar parte de las bases de datos de “EBSCO Information Services”, información que se puede acceder en el portal http://www.ebscohost.com/. ICONTEC Miembro de la Organización Internacional ISO Certificó que el Sistema de Calidad de la CORPORACIÓN CENTRO NACIONAL DE CONTROL DE ENERGÍA CENACE fue evaluado y aprobado con respecto a la Norma Internacional ISO 9001, el 24 de septiembre de 2003 - Certificado No. 1694-1 Determinación de los Límites de Estabilidad Estática de Ángulo del Sistema Nacional Interconectado J. C. Cepeda P. X. Verdugo Centro Nacional de Control de Energía, CENACE Resumen— La diferencia angular de los voltajes de barra de un sistema eléctrico de potencia (SEP) es una medida directa del estado de congestión del sistema. En este sentido, su continuo monitoreo brinda al operador una señal de alerta de posibles estados de congestión del SEP, cuando las diferencias angulares superan límites de seguridad pre-establecidos (límites de estabilidad estática de ángulo). Con el desarrollo de la tecnología de medición sincrofasorial, el monitoreo de la diferencia angular ha adquirido un nuevo enfoque, puesto que se independiza del estimador de estado, lográndose mayor robustez y rapidez. El operador del Sistema Nacional Interconectado, CENACE, dispone actualmente de un sistema de medición sincrofasorial, administrado por la plataforma WAProtector. Este software dispone de una aplicación que permite el monitoreo de la diferencia angular de voltajes de barra del sistema, usando técnicas de visualización avanzada. Este artículo presenta una introducción a la tecnología de medición sincrofasorial, así como una reseña del sistema WAMS del CENACE. Posteriormente, una propuesta metodológica para determinar los límites de estabilidad estática de ángulo, es presentada. Estos límites servirán como base referencial para el monitoreo en tiempo real. by the WAProtector platform. This software has an application that allows for monitoring the system’s busbar phase angle voltage difference using advanced visualization techniques. This paper provides an introduction to synchrophasor measurement technology, as well as an overview of the CENACE’s WAMS system. Then, a methodological proposal for determining phase angle steady-state stability limits is presented. Such limits act as a referential basis for real-time monitoring. Index Terms— Phase Angle Difference, Steadystate Angle Stability, PMU, WAMS, Power Transfer, DIgSILENT Power Factory. 1. INTRODUCCIÓN Los Sistemas Eléctricos de Potencia (SEP) han sido operados cada vez más cerca de sus límites físicos debido, por ejemplo, a la inclusión de principios de desregularización en el mercado eléctrico, la interconexión con sistemas regionales, la diversificación de las fuentes primarias de energía e incluso nuevas restricciones de tipo ambiental. Bajo estas condiciones, ciertas perturbaciones imprevistas podrían causar la violación de los límites de seguridad del SEP, poniéndolo en riesgo de un eventual colapso total o parcial [1], [2]. En este sentido, la supervisión de la seguridad estática y dinámica del SEP en tiempo real presenta un rol fundamental dentro de las aplicaciones empleadas en los Centros de Control. Este monitoreo en tiempo real tiene como objetivo brindar una alerta temprana (early-warning) al operador del sistema con el objetivo de llevar a cabo acciones adecuadas de control que mitiguen los posibles estados de estrés del sistema. En este contexto, además de las funcionalidades de los sistemas SCADA/EMS, se requieren innovaciones tecnológicas complementarias a fin de evaluar y mejorar la seguridad del sistema en tiempo real. Parte de estas tecnologías corresponde a los denominados sistemas de medición sincrofasorial (PMU/WAMS). Palabras clave— Diferencia Angular, Estabilidad Estática de Ángulo, PMU, WAMS, Transferencia de Potencia, DIgSILENT Power Factory. Abstract— The phase angle difference between busbar voltages in an electric power system (EPS) is a direct measurement of the system’s congestion state. In this manner, a constant monitoring alerts the operator of possible congestion problems among the EPS when phase angle differences exceed pre-established limits (steady-state angle stability limits). With the development of synchrophasor measurement technology, monitoring the phase angle difference has taken on a new focus, given that it is analysed separate from the State Estimator, achieving improved speed and strength. The National Interconnected System’s operator, CENACE, currently uses a synchrophasor measurement system managed Las unidades de medición fasorial (PMUs) son dispositivos que permiten estimar sincrofasores de las ondas sinusoidales de corriente y voltaje AC. La alta precisión, velocidad de respuesta y sincronización de tiempo hacen de las PMUs equipos apropiados para el 5 monitoreo global en estado estable y dinámico, así como para aplicaciones en protección y control, como parte básica de un sistema de monitorio de área extendida (WAMS – Wide Área Measurement System) [3]. Una ecuación sinusoidal pura: (1) donde ω es la frecuencia de la señal en radianes por segundo, φ es el ángulo de fase en radianes y Xm es la amplitud pico de la señal, puede ser expresada a través de un número complejo que gira a la velocidad angular ω. Este número es conocido como representación fasorial o simplemente fasor, como se muestra en la ecuación (2) [5]: Una de las aplicaciones de los sistemas WAMS es permitir la supervisión del estado de congestión de los diferentes vínculos que conforman el SEP, a través de, por ejemplo, el monitoreo de la diferencia angular entre los voltajes de barra del sistema. La Corporación Centro Nacional de Control de Energía (CENACE) actualmente dispone de un sistema WAMS compuesto por 18 PMUs ubicadas a lo largo del Sistema Nacional Interconectado (SNI) y de un concentrador de datos (PDC) basado en software, ubicado en las instalaciones de CENACE. El PDC es administrado por la aplicación WAProtectorTM de la firma eslovena ELPROS. Este software dispone, además, de algunas aplicaciones que permiten el monitoreo de la seguridad estática y dinámica del SNI. Entre estas aplicaciones se encuentra una estructura para monitorear la diferencia angular entre los voltajes de las barras donde se encuentran instaladas las PMUs. donde de la señal. (2) es el valor RMS (root mean square) La Fig. 1 ilustra la representación fasorial de una ecuación sinusoidal pura dada por (1). (a) Esta aplicación brinda, al operador, alerta temprana de posibles estados de congestión del SEP, a través de una interfaz gráfica, basada en técnicas de visualización avanzada (gráficos de contorno dinámico). Con el objetivo de especificar la referencia de alerta temprana, es necesario configurar los límites de seguridad relacionados con la diferencia angular (definidos como los límites de estabilidad estática de ángulo). (b) Figura 1: Representación fasorial de sinusoides: (a) función sinusoidal, (b) representación fasorial Un sincrofasor o fasor sincronizado se define en [6] como “un fasor calculado a partir de datos muestreados usando una señal de tiempo estándar como la referencia para la medición”. La referencia angular es una onda coseno de frecuencia nominal, sincronizada con el tiempo UTC (Coordinated Universal Time) a través de GPS [6]. Este artículo presenta, en primer lugar, una introducción a la tecnología de medición sincrofasorial, así como una reseña del sistema WAMS del CENACE. Posteriormente, se presenta una propuesta metodológica para determinar los límites de estabilidad estática de ángulo. Estos límites servirán como la base referencial para el monitoreo en tiempo real de posibles estados de congestión del sistema. Las unidades de medición sincrofasorial (PMUs) son dispositivos que permiten estimar sincrofasores de las ondas sinusoidales de corriente y voltaje AC, en diferentes nodos de un SEP [6]. Para calcular un sincrofasor la PMU utiliza un algoritmo de estimación fasorial. Estos algoritmos utilizan un número N de muestras en el tiempo para efectuar la estimación del fasor. El algoritmo más comúnmente utilizado es la transformada discreta de Fourier [7]. 2. TECNOLOGÍA DE MEDICIÓN FASORIAL Un fasor constituye la representación analítica de ondas sinusoidales en estado estacionario a la frecuencia fundamental más comúnmente aplicada. Los fasores se utilizan como la herramienta matemática básica del análisis de circuitos de corriente alterna [4] Las PMUs forman parte indispensable de los sistemas WAMS, los cuales permiten disponer 6 de mediciones distribuidas en el SEP. Para esto, además de PMUs, se requieren algoritmos avanzados de procesamiento digital de señales, sistemas de comunicación especializados y una infraestructura capaz de proporcionar información dinámica del sistema en tiempo real. Esta tecnología incluye aplicaciones de supervisión y control de la operación del SEP en tiempo real. Los sistemas WAMS están constituidos principalmente por PMUs, concentradores de datos (PDC) y sistemas de comunicación [8]. potencia (alerta temprana). • Disponer de información y herramientas más precisas para realizar los análisis eléctricos de estabilidad del sistema y determinar la presencia de modos de oscilación poco amortiguados. La utilización de las PMUs permite obtener medidas directas de los fasores de voltaje y corriente a través de la red completa, eliminando, de forma ideal, la necesidad esencial de los estimadores de estado. Las PMUs entregan información en intervalos de milisegundos, por lo que permiten el monitoreo del comportamiento estático y dinámico del SEP. Pueden ser usadas para detectar separaciones del sistema, monitorear congestión, analizar oscilaciones en tiempo real, e incluso desarrollar sistemas de control de lazo cerrado. [9]. Figura 2: Diagrama unifilar del SNI con la ubicación de las PMUs • Disponer de información adecuada para realizar la evaluación post - operativa del comportamiento eléctrico del sistema luego de un evento e identificar las oportunidades de mejora en los procesos de restablecimiento. • Ajustar y sintonizar los estabilizadores del sistema de potencia (PSS) y validar los modelos de los sistemas de control asociados a los generadores. 3. WAMS EN ECUADOR La Corporación CENACE, como ente encargado de la administración técnica y comercial del Sector Eléctrico Ecuatoriano, ha emprendido, desde el año 2010, un proyecto para estructurar un sistema WAMS que facilite el monitoreo y supervisión en tiempo real del Sistema Nacional Interconectado (SNI) a partir de mediciones sincrofasoriales. Actualmente, CENACE ha concluido la primera fase del proyecto, consistente en la instalación de 18 dispositivos PMUs que será complementada con la instalación de 4 PMUs adicionales. El objetivo es aumentar la granularidad de la observabilidad del sistema eléctrico mediante el monitoreo de aquellas zonas que tienen una alta relevancia operativa. Esto, con el propósito de realizar una evaluación precisa y fiable del rendimiento del sistema, especialmente en términos de su respuesta dinámica. La Fig. 2 muestra el diagrama unifilar del Sistema Nacional Interconectado y la respectiva ubicación física de las 18 PMUs. Para llevar a cabo las aplicaciones de análisis del sistema de potencia en tiempo real utilizando las mediciones sincrofasoriales, CENACE adquirió el M software WAProtectorT desarrollado por la empresa ELPROS de Eslovenia. WAProtector adquiere los datos fasoriales de las PMUs a través de la red de comunicaciones intranet estándar. En el servidor del software WAProtector, se realiza el análisis de datos en tiempo real y la evaluación de la seguridad del sistema eléctrico. En el mismo servidor se encuentran instalados tanto el PDC como las aplicaciones. El servidor PDC se conecta directamente con los PMUs instalados en las Subestaciones del SNI. utilizando el protocolo IEEE C37.118 [6]. El muestreo en la transmisión de información de los PMUs es 60 muestras por segundo. Además, este software tiene la funcionalidad para desarrollar nuevas aplicaciones y mejorar el monitoreo de la estabilidad del sistema eléctrico. Los principales objetivos que se persiguen con el proyecto WAMS son los siguientes: • Otorgar a la supervisión en tiempo real del SNI, las herramientas que le permitan realizar una acción preventiva y con mayor oportunidad, ante riesgos de inestabilidad del sistema de 7 Las aplicaciones disponibles en WAProtector son: donde VA y VB son las magnitudes de voltaje de las barras A y B, respectivamente, θA y θB representan los ángulos del voltaje de las barras A y B, respectivamente, x es la impedancia del vínculo entre las barras A y B, y r es la resistencia del vínculo entre las barras A y B. • Estabilidad Estática de Ángulo (Diferencia Angular) • Estabilidad de Voltaje de Corredores de Transmisión • Estabilidad Oscilatoria • Detección de Islas • Información de Armónicos del Sistema • Análisis de Información Histórica • Eventos del Sistema Considerando que en un SEP, a nivel de alto voltaje, x >> r, la expresión anterior se reduce a (4), cuya representación gráfica se muestra en la Fig. 5. 4. ESTABILIDAD ESTÁTICA DE ÁNGULO (4) Idealmente el límite máximo de transferencia de potencia, se presenta en el punto más alto de la curva cuando se cumple que, sin(θA–θB) = 1; es decir, cuando θA–θB = 90°. La estabilidad angular se refiere a la habilidad de las máquinas sincrónicas de un sistema de potencia interconectado, para permanecer en sincronismo, luego de que el sistema ha sido sometido a una perturbación. Para mantener el sincronismo es necesario mantener o recuperar el equilibrio entre los torques: mecánico y electromagnético de cada máquina sincrónica del sistema [10]. La diferencia angular entre dos barras del sistema de potencia es una medida directa de la capacidad de transmisión entre estos nodos. La Fig. 3 ilustra dos áreas (A y B) de un sistema de potencia interconectadas por un conjunto de vínculos eléctricos. Figura 5: Curva Potencia – Ángulo Sin embargo, debido a la complejidad del sistema de potencia, que puede causar congestión de la red de transmisión, existen otros factores que no permiten alcanzar este límite ideal. Bajo la premisa que en sistemas de potencia estables θA–θB corresponde a un valor pequeño, el flujo de potencia por el vínculo equivalente es directamente proporcional a esta diferencia angular. Figura 3: Transferencia de potencia entre dos barras del sistema Asumiendo el modelo “π” para el vínculo equivalente entre las dos áreas, presentado en la Fig. 4, la transferencia de potencia entre el área A y el área B está dada por la expresión (3). (5) En este sentido, el límite de transferencia de potencia entre las barras A y B es íntimamente dependiente del límite máximo de diferencia angular entre dichos nodos y viceversa. Por lo tanto, para determinar el límite máximo de la diferencia angular entre las barras A y B (definido como límite de estabilidad estática de ángulo) se debe llegar al límite la transferencia de potencia por el vínculo. Por tanto, el monitoreo de la diferencia angular entre las barras del sistema brinda al operador una señal de alerta de congestión del sistema. Figura 4: Equivalente “π” de vínculos de sistemas de potencia (3) 8 WAProtector dispone de una función que permite el monitoreo de la diferencia angular de los voltajes de las barras monitoreadas por PMUs, a través de aplicaciones gráficas de visualización avanzada. La Fig. 6 presenta un ejemplo de la visualización gráfica, a través de diagramas de contorno, de la diferencia angular en tiempo real. Es posible apreciar cómo el contorno adquiere un tono rojo obscuro en función del incremento de la congestión de la red, reflejada en el incremento de la diferencia angular. Esta visualización brinda al operador una alerta rápida del incremento de la congestión en el sistema. (a) mecanismo de análisis planteado consiste en simular, mediante un software de análisis de SEP (DIgSILENT Power Factory en este caso), el comportamiento de la transferencia de potencia bajo diferentes condiciones operativas (condiciones de alta y baja hidrología con escenarios de baja, media y alta demanda), incluyendo análisis de contingencias y el incremento paulatino de carga. Así, se plantea como alternativa metodológica la presentada en la Fig. 7. (b) Figura 6: Contorneo dinámico de diferencias angulares: (a) demanda baja, (b) demanda media Adicionalmente, WAProtector permite configurar los valores límite de separación angular entre barras, con el objetivo de brindar al operador una señal de alerta, en caso de la violación de dichos límites. Estos valores corresponden a los límites de estabilidad estática de ángulo, los cuales deben ser determinados adecuadamente. En este sentido, el presente artículo propone una metodología para determinar dichos límites en el SNI. Figura 7: Propuesta metodológica para determinar los límites de estabilidad estática de ángulo 5. DETERMINACIÓN DE LOS LÍMITES DE ESTABILIDAD ESTÁTICA DE ÁNGULO La metodología inicia con la definición de los escenarios de análisis. La primera actividad de esta etapa requiere de la revisión de las bases de datos del programa DIgSILENT Power Factory para verificar que se encuentren actualizadas conforme al período de análisis. Posteriormente, se preparan los casos de estudio que incluyan las condiciones operativas que se requieren analizar. Se presenta una metodología, cuyo objetivo es definir los valores límite de alerta y alarma de la diferencia angular entre las barras donde están instaladas las PMUs respecto de la subestación Molino (tomada como la referencia). Esto, con el propósito de entregar al operador una referencia operativa que brinde alerta temprana del riesgo de congestión, bajo la premisa de mantener la seguridad estática del sistema. A través de un análisis de contingencias N – 1, de diferentes elementos de transmisión, asociado a incrementos paulatinos de carga en zonas específicas, llevado a cabo con la ejecución de un script incluido en Power Factory mediante el lenguaje DPL (DIgSILENT Programming Language), se crean condiciones de alto estrés en el sistema de transmisión Con este objetivo, se propone realizar estudios estáticos que permitan evaluar las condiciones más críticas de transferencia de potencia en el SNI, considerando la posible ocurrencia de contingencias N-1 y el aumento paulatino de carga en zonas particulares del Sistema. El 9 ecuatoriano, lo que permite determinar los límites máximos de separación angular entre las barras de 230 kV del SNI. La Fig. 8 presenta la pantalla del script estructurado mediante el lenguaje DPL angulares entre Pascuales y Molino para escenarios de alta hidrología y baja hidrología, respectivamente. Figura 9: Histograma de diferencias angulares entre las barras de Pascuales y Molino para escenarios de alta hidrología Figura 8 : Pantalla del script DPL En este sentido, y a manera de ejemplo, para determinar el límite de diferencia angular entre Molino y Pascuales, se producen incrementos paulatinos de carga en la zona de Guayaquil, con lo que se incrementa la transferencia en los corredores de transmisión que enlazan Molino y Pascuales. Al asociar estos incrementos con contingencias en elementos de transmisión, la diferencia angular se incrementa aún más, hasta que el sistema alcanza un punto de no convergencia. El script permite almacenar los ángulos de las barras del SNI justo antes de alcanzar este punto de inestabilidad estática. Figura 10: Histograma de diferencias angulares entre las barras de Pascuales y Molino para escenarios de baja hidrología Como se puede observar a través del análisis estadístico, realizar una distinción entre escenarios hidrológicos resulta fundamental, ya que el despacho de generación presenta drásticas alteraciones y con ello también, los flujos a través de las líneas de transmisión del sistema. Resulta necesario realizar una distinción entre los escenarios hidrológicos del SNI para determinar los límites de diferencias angulares, para cada estación, a través de un análisis estadístico determinando la media y la desviación estándar de las diferencias angulares obtenidas para todos los casos previstos en cada escenario hidrológico. Las Figuras 11 y 12 muestran, por su parte, los histogramas correspondientes a las diferencias angulares entre Molino y Santa Rosa, la barra más representativa de la zona norte del SNI. El valor medio (µ) de las diferencias angulares máximas establecidas, constituye el límite de alerta. Por otra parte, el límite de alarma corresponde a la suma entre el valor medio y una desviación estándar (σ) de la muestra. Esto se basa en el criterio de que al menos el 50% de los valores analizados deberían quedar incluidos dentro del intervalo de la desviación estándar en torno de la media (µ ± σ), conocido como la desigualdad de Chebyshev [11]. Figura 11: Histograma de diferencias angulares entre las barras de Santa Rosa y Molino para escenarios de alta hidrología De forma ilustrativa, las Figuras 9 y 10 presentan histogramas de los resultados de diferencias 10 puesto que se constituyen en la herramienta básica de monitoreo y control del sistema de transmisión moderno. Una de las aplicaciones del sistema WAMS es permitir el monitoreo de la congestión del sistema, mediante por ejemplo, la supervisión de la diferencia angular de los voltajes de barra del sistema. Parte indispensable del monitoreo es el disponer de una adecuada referencia (límites de seguridad), que brinde alerta temprana al operador cuando las zonas seguras de operación sean sobrepasadas. Figura 12: Histograma de diferencias angulares entre las barras de Santa Rosa y Molino para escenarios de baja hidrología Utilizando el mismo análisis estadístico, se logra determinar los límites, de alerta y alarma, de la diferencia angular entre todas las barras de 230 kV del SNI, que se encuentran bajo monitoreo, y Molino. Estos límites se presentan en las Tablas 1 y 2. A través de la metodología propuesta en el presente artículo, se lograron determinar los valores límites de diferencia angular entre las barras de 230 kV del SNI en las cuales se encuentran ubicadas PMUs. Puesto que la metodología considera diferentes estados operativos y varias contingencias, los resultados se presentan mediante histogramas, los cuales han sido interpretados a través de funciones de distribución de probabilidades, determinándose los límites definitivos en función de la desviación estándar y el criterio dado por la desigualdad de Chebyshev. Tabla 1: Límites de diferencia angular entre las barras de 230 kV del SNI con respecto a la barra de la subestación Molino en escenarios de alta hidrología En base a los resultados se puede notar que los límites de separación angular entre las barras de 230 kV del SNI con respecto a la subestación Molino son mayores en escenarios de alta hidrología. Esto se debe, principalmente, a que en este escenario se presenta un elevado despacho de generación de la central Paute, lo que ocasiona que se incremente la congestión a través de las líneas de transmisión desde la subestación Molino hacia los centros de carga más grandes del país, Guayaquil y Quito Tabla 2: Límites de diferencia angular entre las barras de 230 kV del SNI con respecto a la barra de la subestación Molino en escenarios de baja hidrología REFERENCIAS BIBLIOGRÁFICAS [1] Amin M. (2000). “Toward Self-Healing Infrastructure Systems”, Electric Power Research Institute (EPRI), IEEE. [2] Kerin U., Bizjak G., Lerch E., Ruhle O. & Krebs R. (2009). “Faster than Real Time: Dynamic Security Assessment for Foresighted Control Actions”, IEEE Power Tech Conference, June 28th - July 2nd, Bucharest, Romania. vvv 6. CONCLUSIONES Y RECOMENDACIONES [3] Martinez C., Parashar M., Dyer J. & Coroas J. (2005). “Phasor Data Requirements for Real Time Wide-Area Monitoring, Control and Protection Applications”, CERTS/EPG, White Paper – Final Draft. El desarrollo tecnológico actual en sistemas informáticos, electrónica y telecomunicaciones, ha permitido vislumbrar una nueva perspectiva en la operación del SEP, mediante la cual se pretende automatizar la respuesta del sistema con el objetivo de estructurar una red inteligente. Los sistemas WAMS forman parte fundamental de esta tendencia 11 [4] Phadke A. G. (1993). “Synchronized phasor measurements in power systems”, IEEE Computer Applications in Power, vol.6, no.2, pp.10-15. [11] Han J. & Kamber M. (2006). “Data Mining: Concepts and Techniques”, second edition, Elsevier, Morgan Kaufmann Publishers. [5] Phadke A. & Thorp J. (2008). “Synchronized Phasor Measurements and Their Applications”, Virginia Polytechnic Institute and State University, Springer Science + Business Media. Jaime Cristóbal Cepeda.- Nació en Latacunga en 1981. Recibió el título de Ingeniero Eléctrico en la Escuela Politécnica Nacional en 2005 y el de Doctor en Ingeniería en la Universidad Nacional de San Juan en 2013. Entre 2005 y 2009 trabajó en Schlumberger y en el CONELEC. Colaboró como investigador en el Instituto de Energía Eléctrica, Universidad Nacional de San Juan, Argentina y en el Instituto de Sistemas Eléctricos de Potencia, Universidad Duisburg-Essen, Alemania entre 2009 y 2013. Actualmente, se desempeña como Jefe de Investigación y Desarrollo del CENACE. Sus áreas de interés incluyen la evaluación de vulnerabilidad en tiempo real y el desarrollo de Smart Grids. [6] IEEE Power Engineering Society (2011). “IEEE Standard for Synchrophasors for Power Systems”, IEEE Std. C37.118.1-2011. [7] Cimadevilla R. (2009). “Fundamentos de la Medición de Sincrofasores”, ZIV P+C - España, XIII ERIAC, Puerto Iguazú, Argentina. [8] Juárez C. & Colomé D. (2009). “Tendencias en la Supervisión en Tiempo Real de la Estabilidad de Pequeña Señal de Sistemas de Potencia”, XIII ERIAC, Puerto Iguazú, Argentina. Pablo Verdugo Rivadeneira.- Nació en la ciudad de Quito en 1987. Realizó sus estudios secundarios en el Colegio Nacional Experimental Juan Pío Montufar y sus estudios superiores en la Escuela Politécnica Nacional, donde se gradúo de Ingeniero Eléctrico en el año 2012. Actualmente trabaja en la Dirección de Planeamiento del Centro Nacional de Control de Energía. [9] Savulescu S. C., et al. (2009). “Real-Time Stability Assessment in Modern Power System Control Centers”, IEEE Press Series on Power Engineering, Mohamed E. El-Hawary, Series Editor, a John Wiley & Sons, Inc.. [10] Kundur P., Paserba J., Ajjarapu V., et al. (2004). “Definition and classification of power system stability”, IEEE/CIGRE Joint Task Force on Stability: Terms and Definitions. IEEE Transactions on Power Systems, Vol. 19, Pages: 1387-1401. 12 La Generación Distribuida: Retos frente al Marco Legal del Mercado Eléctrico Ecuatoriano E. Fernando Durán Empresa Eléctrica Regional Centro Sur C.A. - Universidad de Cuenca Resumen— El análisis de la normativa enfocada en el concepto de la Generación Distribuida, la evolución en tecnologías, la importancia de la seguridad energética y la diversificación de la matriz con energías renovables, la necesidad de reducir la dependencia en combustibles fósiles, exige que se fomenten en el Ecuador nuevos proyectos de recursos renovables no convencionales. La GD debe ser parte del modelo de negocio a la par del advenimiento de las redes inteligentes, esta evolución exige la revisión y estudio detenido y especializado de normas de concesión, impactos en la red, medidas para de mitigación de riesgos. Los vehículos eléctricos híbridos, dispositivos de almacenamiento, micro redes inteligentes, podrán ser realidad si se parte de la experiencia y lecciones aprendidas de países que van a la delantera. 1. INTRODUCCIÓN Los países en la región y el orbe, han producido un importante incremento en el número de instalaciones de Generación Distribuida (GD). Con ello han surgido nuevos requerimiento en los SD: el incremento o reducción de las pérdidas, la necesidad de reforzar la capacidad de las líneas y subestaciones (centros de transformación) para dar espacio a los nuevos flujos de potencia inyectados por la GD o a la inversa, podría requerirse la reducción del volumen de inversiones en repotenciar en las redes (generar en puntos cercanos a la demanda reduce los flujos de energía). La conexión de estos generadores en los niveles más bajos del esquema jerárquico altera dicho esquema, planteando una serie de problemas de naturaleza técnica y regulatoria. Palabras clave— Mercado Eléctrico, Matriz Energética, Generación Distribuida (GD), Sistema de Distribución (SD), Inrerconexión Electrica. Las actuales y regulaciones en la mayoría de los países de América Latina no tienen la madurez y sobre todo los elementos legales, técnicos y económicos que incorporen las tarifas y medidas que permitan el acceso con costos preferenciales o eventualmente contar con normas para el libre uso de las redes para la inyección de nueva generación. Abstract— An analysis on the regulations regarding the concept of Distributed Generation, technology developments, the importance of energy security and diversification of the energy matrix with renewable energy, and the need to reduce dependency on fossil fuels, all demand that Ecuador develop new non-conventional projects for renewable energy sources. The DG should be part of the business model together with the coming of smart grids, and such developments call for a careful and specialized study and review of concession regulations, energy grid impacts, and risk mitigation measures. Electric hybrid vehicles, storage devices, and smart micro grids could become a reality if based on the experience and lessons learned by leading countries. Aún en países que han realizado estudios previos, no se dan criterios uniformes de la interconexión de la Generación Distribuida, es un modelo que requiere mucha apertura en la negociación de las partes para que se consigan los beneficios en ambas direcciones. Se buscan establecer los posibles efectos adversos que encuentra la GD e identificar los desafíos a superar y obstáculos de la regulación para adopción de la configuración de la red de distribución y los estudios para identificar las señales que permitan calificar y evaluar aquellos proyectos de Generación Distribuida que buscan su espacio en el sistema eléctrico, en un entorno regulatorio los más claro y consistente y respaldado del correspondiente análisis técnico-económico. Index Terms— Electricity Market, Energy Matrix, Distributed Generation (GD), Distribution System (SD), Electric Power Interconnection. 13 2. DEFINICIÓN DE DISTRIBUIDA [1] LA GENERACIÓN El concepto y desarrollo de la denominada “Generación Distribuida (GD)” no es nuevo, pero hoy en día se orienta al uso estratégico de unidades modulares, las que pueden ser proyectadas para instalarse aisladas de la red o mejor operar interconectadas a la red próxima a los puntos de consumo. Varias definiciones se dan en las referencias [2][3][6][8] El crecimiento del mercado eléctrico y el progreso técnico, han impulsado a que el tamaño óptimo de la generación disminuya en relación al tamaño del mercado y a la capacidad financiera privada. Figura 1: SEP con Generación Distribuida (Embebida) [7] 2.1. Clasificación de la GD Por variaciones en las definiciones, las distintas acepciones se discuten por medio de una clasificación para completar el amplio concepto de la generación distribuida: Actualmente se disponen de tecnologías que producen la energía eléctrica primaria utilizando generadores pequeños y a menor costo $/MW generado. A. B. C. D. E. F. G. H. La GD por sus dimensiones y ubicación puede conectarse a la red de distribución (subtransmisión) y su energía será consumida en el lugar; evitando o difiriendo costos de inversión en transporte, como también las pérdidas de energía que se producirían si tal red se ampliara. [4] No existe una definición universalmente aceptada sobre que es Generación Distribuida y en que la diferencie de la generación centralizada, algunos de los atributos que la caracterizan son [3]: • • • • El propósito; La localización u ubicación; Calificación por rango de capacidad; Área de entrega de potencia; Tecnologías; Impacto ambiental; Modo de Operación; La penetración de generación distribuida. No es centralmente planificada. No siempre es centralmente despachada. Usualmente conectada a la red de distribución. Menor a 50 MW. La definición más difundida es la de IEEE (Institute of Electrical and Electronic Engineers): "Generación Distribuida corresponde a la producción de energía eléctrica mediante instalaciones suficientemente pequeñas en relación con la generación centralizada, de manera que permiten la interconexión en cualquier punto de la red, siendo un subconjunto de recursos distribuidos del sistema de distribución”. Figura 2: Localización por Crecimiento del nivel de Tensión en el SD y rango de la GD Se describirán las cualidades más representativas. B. Localización La ubicación es virtualmente cualquiera en la red de distribución y hacia la subtransmisión, con limitaciones prácticas de tensión en función de la potencia como se muestra en la Fig. 2. En la Fig. 1 se representa el sistema eléctrico de potencia en el ámbito de la subtransmisión (transmisión regional) y en especial en las redes de distribución. 14 (2) 2.3. Criterios de Integración La integración de la GD al SEP requiere aspectos más allá de los técnicos y económicos: tecnología, modo de operación, propietario, etc. El impacto de la integración para superar la incertidumbre en los aspectos de la localización y el dimensionamiento, consiste adoptar ciertas consideraciones de prioridad por carga: Figura 3: Rango de capacidades de la GD [12 C. Definición GD por el rango de capacidad MW [3] Instalación de GD en las barras de carga: Se requieren las normas de conexión y de transformación para la operación segura de las unidades. 2.2. Indicadores de integración de la GD [10][11] sificación de la GD Una caracterización cuantitativa de la Integración se puede hacer conociendo la definición de la cantidad y capacidad de las fuentes de generación. Nivel de Penetración [11] La definición del El Nivel de Penetración de la GD (% Nivel GD), interpreta la fracción de la carga/ demanda total del sistema (PLoad) que va a ser suplida por la GD, siendo definida o evaluada por la expresión (1): (1) Figura 4: Modelos de interacción con la red por el modo de interconexión de la GD [11] Donde de PGD es: Potencia producida por la Generación Distribuida. Prioridad de integración: Faltan acuerdos e incentivos sobre ello, según los intereses del consumidor o del operador de la red. Un posible escenario, se basa en que la instalación se sirve para satisfacer parte de la carga local y el saldo para exportar. Baja Penetración: menor al 30%, mercado conservador con barreras económicas y técnicas. Semi-Ideal: penetración del 50% de la carga total instalada en el sistema. Escenario Ideal: una penetración total (100%). GD = carga del sistema. Un mercado de completa competencia. Escenario Utópico: GD instalada superior a la carga, para la exportación de energía. Despacho de la Unidad: Un caso posible será que sea despachada como la fracción de la carga local conectada y el nivel global de penetración y dispersión planteado en un escenario. Nivel de Dispersión [11] 2.4. Clasificación por tecnología de las Fuentes de GD El Nivel de Dispersión de la generación distribuida (%Dispersión GD), es la razón del número de nodos con inyección de GD (#BusGD) y el número de nodos con Demanda (2): En la Tabla 3, se presenta un resumen de las tecnologías con su rango típico de aplicación o disponible por módulo de generación. Los principios de conversión en las tecnologías empleadas para la Generación Distribuida, que más representativas son: El nivel de Dispersión GD es 0% si sólo existe potencia generada desde el sistema centralizado o el otro extremo, si la GD se aplica en todos los nodos donde existe demanda de potencia (100%). 15 • • • • Máquinas Térmicas Celdas de Combustible Sistemas de conversión de energía del viento Sistemas de conversión de energía del sol. 2.7. Potencial de instalación de GD en el Ecuador La situación actual del abastecimiento de energía eléctrica requiere una especial atención, pues a pesar de la disponibilidad de recursos hídricos en el País, durante la última década la disponibilidad de generación hidroeléctrica se ha mantenido, con un alto componente de la generación termoeléctrica, y como también dependencia de la energía importada de Colombia. 2.5. Sistemas de almacenamiento / sistemas de UPS Los sistemas de almacenamiento de energía intercambian energía en periodos cortos. Se aplican para compensar el voltaje, y minimizar perturbaciones: sag, flicker y surges. Los mismos se emplean como fuente ininterrumpida de energía (UPS). La solución técnica de almacenaje de energía también se aplica y define como fuente de energía distribuida, su estado actual es en desarrollo. 2.6. Cogeneración una forma de Generación Distribuida [12] La cogeneración se define como la generación simultánea de dos formas de energía útil a partir de una fuente de energía primaria. La generación eléctrica convencional desecha el calor residual, lo que no pasa con las tecnologías de Generación Distribuida (GD), debido a su tamaño y a la ubicación cercana a la carga, permitiendo la recuperación del calor. El usuario final puede generar tanto energía térmica como eléctrica en (CHP) un solo sistema ubicado próximo a sus instalaciones, con eficiencia de hasta el 90%. Figura 6: Estructura Sectorial q’ con la Inclusión de GD El Gobierno actual se ha empeñado en revertir esta condición, mediante la construcción de proyectos hidroeléctricos, así como la instalación de generación termoeléctrica eficiente y el aprovechamiento de importantes fuentes de energía renovable. Para el cambio en el esquema de la nueva Ley, se recomienda que la GD sea parte activa, a través de incorporarse en los niveles de Tensión Baja, Media y Subtransmisión, de la siguiente manera: Es necesario impulsar el uso de las diferentes opciones de fuentes de generación alterna y de energías renovables no convencionales (ERNC), apuntando a la definición de políticas energéticas y para desarrollar una planificación que incluya las siguientes acciones: • Diversificar la matriz energética con energías renovables como la eólica, biomasa, biogás, fotovoltaica, geotérmica y micro centrales hidroeléctricas. • Desarrollo del marco jurídico para incentivar el uso de biocombustibles. • Promover el uso racional de la energía e introducir como política de Estado el concepto de eficiencia energética. • Plantear las regulaciones “específicas” que permitan la incursión en proyectos embebidos en la redes de distribución (GD), tanto por parte de las Empresas de Distribución como Figura 5: Cogeneración eléctrica –térmica. Un sistema Integrado localizado está muy próximo al edificio o industria y provee al menos una porción de la energía eléctrica que éste requiere y procede a reciclar la energía térmica el acondicionamiento o climatización de los diferentes ambientes Calor / Enfriamiento, como también en el proceso de producción e incluso se aplica para control de la humedad del ambiente. 16 de la empresa privada o en alianza estratégica de ambas. Se evalúan los nodos de carga se contabilizan el total de subestaciones de las distribuidoras que potencialmente recibirán generación distribuida, con niveles de tensión de subtransmisión 69/13,8kV y 69/22kV, que alcanzan a 273. 2.8. Evaluación penetración de la GD en Ecuador. Fuentes de energía convencional [16] Los dos criterios principales que permiten evaluar el grado de integración de la GD, para modelar la oferta de Generación Distribuida son: Utilizando como fuente de información el documento “Estadística del sector Eléctrico Ecuatoriano 2009-2010” se han evaluado la cantidad de nodos de carga. Nivel o Grado de penetración de la GD% y Nivel o Grado de dispersión de la GD% Como ejemplo se simula con demanda pico del País en el 2010 que alcanza a 3.036 MW. (3) De la simulación realizada, el resultado denota valores de Baja Dispersión, con un nivel menor al 30%; lo cual puede ser un caso algo común. Para evaluar la potencia firme instalada se toma un escenario: Es decir la generación distribuida aun no habría sido instalada ni en la mitad de los nodos con carga, por lo que no se avizora un mercado atractivo para que los consumidores empiecen a recibir incentivos para la conexión de generación distribuida en forma local, sin embargo como se observa en 3.1 recientemente se han generado algunas bases legales, pero no lo suficiente para una confianza y seguridad para el inversor no son lo fuertes, para tomar el riesgo. Tabla 1: Grado de Penetración % 2010 El valor de 39,35% corresponde a un escenario de Baja Penetración, lo que se permite estimar que se establece en un mercado conservador con muchas barreras económicas y técnicas, que hacen deducir que la incorporación de GD sería parte de un proceso que tomaría algún tiempo. La GD no se orienta al aprovechamiento de estas economías de escala, y para que tenga sentido económico, deben identificarse otros intereses relevantes que la hagan conveniente. Los casos potencialmente favorables a la generación distribuida al menos son: Nivel de Dispersión.- Para establecer un primer escenario algo simple, se considera un área del sistema de potencia que refleje el número de puntos en la red para describir este índice en donde se tenga conectada GD, por el total de centrales menores instaladas y conectadas al SNI en las 19 Distribuidoras y las empresas autogeneradoras que se han conectado a estos sistemas de subtransmisión: • La posibilidad de ahorros en distribución, por reducción de las inversiones y la disminución de las pérdidas en las redes. • El aprovechamiento de fuentes de energía primaria, renovables, cuya escala y localización sólo permite la aplicación de la generación distribuida. • La generación en pequeña escala puede tener un impacto económico positivo si permite el aprovechamiento de insumos y mano de obra nacional. Tabla 2: Grado de Penetración % 2010 La generación eléctrica convencional, identificada en el país por dos aspectos: está • Proyectos que se encuentran en ejecución (incluyendo algunos que se han paralizado por diversas circunstancias), y por otro lado 17 los que han obtenido su contrato o certificado de permiso o concesión, o se encuentran en trámite en el CONELEC. • Para el primer caso se presenta el resumen de cada uno de los proyectos en ejecución, y en forma detallada su estado de avance en la referencia. [3] no se ha logrado determinar por cuanto no hay evaluaciones, excepto el caso del proyecto de Pichicay/Santa Ana del Municipio de Cuenca (1,8 MW), que en función de un convenio entre la Empresa Municipal de Aseo de Cuenca (EMAC) y una compañía internacional, en fase de desarrollo. 2.10. Proyectos de GD Economía y Mercados 2.9. Potencial de GD proveniente de Fuentes Renovables No Convencionales (ERNC) [14] [15] 2.9.1 La utilización de GD tiene entre otras las siguientes ventajas económicas: Para clientes regulados, con consumos altos de calor, se pueden producir ambos tipos de energía (como el caso en países Europeos) lo que incentiva la competencia en el suministro dejando de la elección la fuente de abastecimiento a los clientes. Recursos de Energía Solar La utilización práctica de la energía solar, un recurso renovable y limpio, para generación eléctrica, tiene como objetivos principales: la contribución a la reducción de la emisión de gases de efecto invernadero, la posibilidad de llegar con electricidad a zonas alejadas de las redes de distribución. Mientras estos cambios han afectado a todos los generadores, la GD se ve más fuertemente afectada debido a su tamaño más pequeño y costos proporcionadamente más altos de transacción, ello se ha debido principalmente a las siguientes situaciones: La necesidad de contar con un documento técnico que cumpla con esta exigencia a fin de impulsar el uso masivo de la energía solar como fuente energética motivó al CONELEC a publicar, en agosto de 2008, el “Atlas Solar del Ecuador con fines de Generación Eléctrica”, el mismo que fue elaborado por la Corporación para la Investigación Energética, CIE. 2.9.2 • Competencia. • Contratos Bilaterales. • Adquisición de Potencia de Reserva. Recursos de Energía Eólica 2.11. Impacto de la GD en la explotación de la Red de Distribución [5] Las zonas localizadas sobre la línea ecuatorial no son ricas en vientos, pero en el Ecuador existen zonas de alto interés eólico por la presencia de Los Andes y su cercanía al Océano Pacifico. Cuando se presente un incremento de penetración de la GD conectada a la red superior al requerimiento interno del consumidor, la energía puede transferirse a la inversa hacia la distribución y transmisión aguas arriba. Como parte de una evaluación del impacto de las redes de distribución se deben considerar aspectos como: Los sistemas eólicos requieren de diversos parámetros relativos al viento que son fundamentales para dimensionarlos; como por ejemplo la velocidad, las variaciones diarias, mensuales y estacionales de la misma para los sitios que presentan condiciones favorables. • En la región amazónica no se han detectado velocidades de viento que permitan pensar en proyectos de generación de electricidad factibles. 2.9.3 Las capacidades y congestión de las redes en los diferentes niveles de tensión de su incursión. Las pérdidas son de los efectos que mayor resistencia puede presentar, en especial cuando se cree que el impacto es negativo en temas como: Recursos de Biomasa • • • • • • • • El potencial de biomasa en el Ecuador es de gran importancia, por ser tradicionalmente agrícola y ganadero, actividades que generan desechos que son aprovechados en forma aislada energéticamente. En lo que se refiere al tratamiento de desechos sólidos urbanos con fines energéticos, su potencial 18 Corrientes de cortocircuito. Selectividad de las protecciones. Robustez de la red. Perfiles de voltaje. Estabilidad del sistema. Islanding (operación en isla). Equilibrio y reserva del sistema. Calidad de la energía. Toda GD que pueda integrarse en las redes eléctricas, está interrelacionada con los efectos en ella, no sólo en las condiciones de operación, sino también en la transmisión aguas arriba. Para lo cual e indispensable considerar los casos siguientes: • • • • Se cree que el éxito de la GD depende o está asociado, al éxito de las comunicaciones, los sistemas de gestión y control de potencia como también de la capacidad de los diseñadores para aprovechar al máximo de los grados de libertad de los sistemas electrónicos e inteligentes que hoy se ofrecen en términos de flexibilidad y rapidez de respuesta a los cambios la red. Efectos dinámicos. Efectos del estado dinámico. Efectos del análisis de contingencia. Efectos de protección. La estrategia que aplican las compañías distribuidoras, cuando no está presente la acción de los entes reguladores, es que se asuma a la GD como recursos desfavorables, es decir como pequeñas fuentes parásitas, a imponer reglas estrictas, con muchos requisitos que afectarían al rendimiento y la seguridad del sistema. Por ello los sistemas de distribución deberán someterse a profundos cambios en términos de diseño, desarrollo y filosofía de operación. 2.12. Cambios en la Operación del Sistema La regulación puede ser desarrollada en el sistema de distribución bonificando las reducciones de pérdidas que podría, incentivar al ingreso de GD, con una buena ubicación, que puede ayudar en la regulación de tensión en nodos donde se lo necesite. Varios países de Latinoamérica, a más de los de la Comunidad Europea de Naciones, están promoviendo una revisión de éstas a estrategias. 3.1. Revisión Normativa que aplique a la Generación Distribuida en el Ecuador El desarrollo eficiente de la GD en un sistema eléctrico de distribución, requiere que las regulaciones proporcionen los incentivos adecuados, esto es que reconozcan los beneficios y costos reales que la GD impone al sistema. Los recursos de la GD reducirán las pérdidas en las redes solamente si se localiza y opera en forma adecuada. Lo mismo ocurre con el potencial para regular el voltaje en la red o para aumentar la confiabilidad en el suministro. Figura 7: Nuevo concepto para Operar la Red [13] La Generación Distribuida (GD) a pesar de ser de alguna manera, un agente del mercado eléctrico ecuatoriano, requiere que se postulen normativas especiales y específicas para una mejor integración entre los distintos agentes. Para que la GD evolucione deben generarse los cambios correspondientes en el marco normativo por medio de las Leyes que fomenten y aseguren un proceso claro y consistente para regular la generación eléctrica y principalmente con energías renovables no convencionales. Una nueva metodología para el control de tensión en redes con GD es la que se muestra en la Fig. 7, la cual permite el control en forma dinámica, para que la GD proporcione una forma adicional de control de tensión en las redes de distribución. La conexión de varios generadores distribuidos en la red y un control de despacho inteligente brinda gran flexibilidad en el manejo de la energía reactiva y el control de tensión. El CONELEC, ha emitido varias regulaciones que permiten la incorporación y dan algún impulso a las ERNC [14]: 3. PERSPECTIVAS DE LA GD Y EVALUACIÓN DE LA NORMATIVAS ACTUALES 1) Regulación N° CONELEC-006/08.- Reglas comerciales de funcionamiento del mercado, el cálculo y la aplicación de los pliegos tarifarios. Entre los motivadores para el surgimiento de la GD, están temas sobre la conservación de los recursos naturales, la protección al medio ambiente y la reducción de las emisiones de gases de efecto invernadero, uno de más sensibles es el de la producción de energía. 19 2) Regulación N° CONELEC-013/08.Normativa de contratos regulados del mercado, las transacciones de corto y largo plazo, las liquidaciones del mercado; los planes de expansión del SNT y el uso ERNC. 3) Regulación N° CONELEC 001/09.Participación del auto - productor, (auto - generador con cogeneración), en la comercialización de la energía. Fomento de cogeneración. 4) Regulación No. CONELEC 009/08.Registro de Generadores Menores a 1 MW, procedimiento para ejecutar proyectos menores a 1 MW, su operación no sea de emergencia. 5) Regulación No. CONELEC 002/11.Principios de excepción para la participación privada en párrafo 2, artículo 2 de la Ley del Régimen del Sector Eléctrico. renovables fotovoltaicos e hidráulicos con el límite de potencia de 50MVA. Por el momento se lo que se conoce es que se aplica el mismo pliego de condiciones de conexión al sistema nacional de trasmisión por lo que hay problemas de decisión por las distribuidoras, pues no hay reglas completas para establecer los contratos de conexión, al dar libre acceso sobre las instalaciones no se establecen con procesos y detalles sobre las responsabilidades del inversor y del distribuidor beneficiado/ afectado. El tratamiento preferente de generador no convencional le permite el emprendedor acogerse a pecios especiales en la Resolución CONELEC 072012 a la Reg. CONELEC 04-11(Tabla 1 actualizada), y en base al Contrato estarán vigentes por 15 años, lo que permite evaluar financieramente los proyectos. Proyectos nuevos por excepción menores a 50MW y que no constaren en el PME *Plan Maestro de Electrificación del CONELEC; Calificados como necesario y adecuado para satisfacer el interés público, principalmente destinados a cubrir la demanda y la reserva de generación. La concesión mediante contratos y por un proceso público, con al menos los siguientes requisitos: La normativa de mercado debe conceder un despacho preferente, pero con el límite de hasta en un 6% de la capacidad operativa de la generación, lo cual está fijando metas en la capacidad de absorción del mercado eléctrico de esta producción con tarifas superiores a la media. 3.2. Estado de aprovechamiento del concepto de la GD en Ecuador • Estudios presentados sean a nivel de pre factibilidad. • El proyecto propuesto no conste en el Plan Maestro de Electrificación PME. • Optimizar el recurso natural para generación eléctrica y no se afecten los proyectos en el PME. • El costo de los proyectos no sea superior a los costos promedios en los contratos regulados, según la tecnología. • Que el cálculo de la energía firme o energía garantizada esté técnicamente sustentado. Se han emitido algunas señales para una política energética que apoya el desarrollo de la GD renovable, pero aún se deben implementar regulaciones específicas a nivel técnico, que atraigan al inversor y sobre todo reconozcan los costos y beneficios reales de la GD. El aprovechamiento y la situación de la generación distribuida en el escenario nacional ecuatoriano se podrían resumir en los siguientes aspectos: 6) Regulación No. CONELEC 003/11.Determinación de los plazos y precios en proyectos de generación y autogeneración de iniciativa privada, incluyendo los de energías renovables. 7) Regulación No. CONELEC 004/11.Energía producida con Recursos Energéticos Renovables No Convencionales (ERNC). Requisitos, precios, vigencia, y forma de despacho al SNI. • Ecuador es un Mercado eléctrico pequeño, por ende como modelo de negocio que se lo ha planteado para una integración vertical en función de la economía de escala de un país ´pequeño. • Hay la creciente necesidad de aumentar la eficiencia de las inversiones, pues el modelo que se ha implementado es de un negocio con subsidiados. • Siendo innegable su valor social, no se comete un error al tomar el riesgo de mantener con subsidios al uso de los combustibles y servicios como el de energía eléctrica, pues esto impulsa y aumenta el uso ineficiente. No se ha podido identificar una legislación específica sobre la Generación Distribuida en Ecuador, excepto por las resoluciones, que impulsan la incursión de algunos proyectos de energías 20 • Sin embargo de lo anterior, la utilización de la GD como alternativa factible para la planificación de la expansión de la red y de diferimiento de inversiones es perfectamente viable. Es posible destacar algunas formas por las cuales la GD puede ejercer una influencia efectiva y generar la confianza en su aplicación y desarrollo: • Aumentando la calidad de la energía y asegurando suministro sin interrupciones. La GD puede contribuir para en la calidad de la energía en áreas congestionadas, al extremos de redes con tramos largos, y en zonas donde se exige una elevada calidad de energía. • Se puede proveer capacidad de generación local bajo el control de clientes que demandan condiciones de servicio con cero interrupciones, algo difícil de conseguir por la vulnerabilidad natural de los sistemas en especial si predominan las redes aéreas. 4. REQUISITOS DE NORMAS ESPECÍFICAS LEGALES, TARIAFARIAS Y DE INTERCONEXIÓN DE GD EN EL ECUADOR Un proyecto de GD que se lo desarrolle en base a la regulación vigente de Ecuador, parte con algunas barreras, al no disponerse de estudios completos de las potencialidades de las fuentes de energías renovables, no así por el lado hidráulico, pues sus potencialidades identificadas, son muy grandes, pero con proyectos que tienen dificultades de desarrollo, pues las fuentes no siempre están cercanas a los centros de carga y con ello, pierden la calificación de GD, por lo su elevada inversión para conexión. La GD puede desempeñar también un papel importante como generación de emergencia en el caso de interrupciones debido a accidentes naturales, evitando largos periodos sin suministro de energía El modelo de negocio y el análisis financiero en base a los estudios técnicos y los precios preferentes, permitirá definir la viabilidad de los proyectos, sin embargo en el momento de analizar modelos de integración por servicios auxiliares adicionales, ya no se dan preferencias o señales de estímulo. 4.3. Condición de protecciones interconexión y de las Para los aspectos técnicos de interconexión se ha establecido el libre acceso, pero todos los estudios de conexión y costos de inversión relacionados son a su cargo, sobre todo si no hay capacidad disponible en la red, estos adicionales incrementan los costos del activo y marginales. 4.1. Calidad y Condiciones Técnicas Las principales condiciones técnicas de la GD están en relación con la confiabilidad y calidad del suministro, así como con las protecciones, la medición, y los protocolos de funcionamiento de la conexión y desconexión en isla y como también la gestión de la potencia reactiva. La regulación de voltaje, parpadeo (flicker), los armónicos y tensiones de inyección de corriente continua, son claves para determinar la calidad del suministro. Figura 8: Posible ubicación de GD o punto común de acoplamiento (PCA) En referencia a la interconexión de la GD con el SD se encuentra la siguiente acepción (IEEE P 1547): Generación Distribuida (GD) es la Generación eléctrica conectada a un área de sistemas de potencia a través de un PCC (Punto de conexión de consumidor), como un subconjunto de los recursos distribuidos RD. 4.2. La GD y la Confiabilidad [2] Las protecciones merecen un análisis por separado, pues su objetivo es la protección del sistema de potencia. Hay tres puntos de vista a considerar en búsqueda de la confianza de la Generación Distribuida: La conexión de GD a una red de distribución introduce una fuente de energía y ello puede aumentar el "nivel de falla" en la red lo que puede complicar la detección y aislamiento de fallas. En una red urbana • El punto de vista de cada cliente individual • El de un grupo de clientes y la distribuidora • El del mercado y los operadores del sistema. 21 típica, la GD puede estar conectada a niveles de tensión que van desde la baja tensión (120-240 V monofásica) hasta los valores de subtransmisión (69 kV y otros). • El interruptor de circuito en el punto de interconexión con la red, será capaz de interrumpir la corriente máxima de falla disponible. • Por seguridad se deberá proveer a su sistema de un dispositivo manual de desconexión, bloqueado en la posición de abierto y accesible para el personal de la distribuidora • La instalación de interconexión no deberá comprometer la calidad de servicio del sistema eléctrico y las tecnologías asociadas. Las condiciones de conexión en la subtransmisión son complejas, pero son analizadas previamente, mientras que las conexiones a baja y media tensión (en el orden de cientos de voltios y los kilovoltios), pueden ser más difíciles de resolver, sobre todo si implican inyecciones netas en la red. (Ver Fig. 9). El objetivo del estudio de las protecciones, en presencia de GD es para mantener el nivel preexistente de fiabilidad de la red, así como la seguridad y la calidad, con un respaldo de seguridad razonable. 4.5. Requisitos generales de interconexión La GD debe acatar los procedimientos formales, lo que asegurará una base técnica sólida para la interconexión activa propuesta. Los procedimientos técnicos y aplicación siguientes se resumen como los principales: 1. 2. Figura 9: Complejidad e interacción entre la GD y el SEP 3. 4. 4.4. Normas técnicas de interconexión GD. Principios fundamentales [13] 5. 6. Las condiciones de interconexión se rigen por uno o más de los siguientes principios: 7. • Evitar todo riesgo para la seguridad al público y estará equipado con equipo de protección que evite que el generador de esté conectado a un circuito sin tensión de la distribuidora. • La instalación de la GD no debe comprometer la confiabilidad o limitar la capacidad operativa del sistema eléctrico de la distribuidora que la acoge. • El equipo de protección impedirá disparos intempestivos de los interruptores del sistema de distribución que afecte a la fiabilidad del mismo. • Deberá estar dotada de equipo de protección que impida el intento de conexión y funcionamiento en paralelo y operar dentro de los límites normales. • Para fines operacionales, la distribuidora puede requerir que esté instalado un sistema de comunicación. Por un medio establecido de mutuo acuerdo. Disponer de diseños del proyecto en su etapa planificación (factibilidad) y del diseño definitivo aprobado y presupuesto de equipos y los de interconexión. La aprobación de dichos estudios por la entidad competente, según lo señale el ente regulador. Permisos de inicio de construcción. La construcción de la interconexión según la planificación y el registro de planos durante la fase de aplicación del proyecto. Verificación de las pruebas y puesta en marcha de pruebas de la fase de construcción completa. Acuerdos con el distribuidor y puesta en funcionamiento de la interconexión. Prácticas de operación (Manual de operación) y mantenimiento, y el registro del desempeño del sistema de interconexión, durante la vida útil. 4.6. Requisitos para interconexión de la GD por las Distribuidoras Las regulaciones y normativas desarrollan unos requisitos de conexión referidos a: a) Sobre Regulación de tensión: contar con equipos y procesos que permiten al operador del sistema de distribución mantener una tensión más o menos constante a pesar de las variaciones que se producen normalmente por cambios en las cargas, variabilidad de las fuentes primarias. b) Integración con la puesta a tierra de la red de distribución: las unidades de GD deben estar conectadas a tierra siguiendo las 22 recomendaciones que les sean de aplicación para evitar sobretensiones a lo largo de la línea. c) Desconexión del sistema ante interrupciones en la red eléctrica distribuida: en caso de que se produzca un suceso de estas características, el equipo de GD no puede suministrar corriente, y en consecuencia, energizar la línea de la compañía de distribución. d) Sistema de sincronización de la GD con la red. e) El equipo de GD, no puede inyectar armónicos, ni corriente continua, por encima de unos umbrales definidos. 4.8. Estrategias para impulsar la GD. El Marco Legal y de interconexión planteado. [17][19] Con la estructuración en un mercado único por el Mandato 15, se deben generar las disposiciones que faciliten la incursión en proyectos de GD. • Está establecido el Libre acceso a las redes (Decreto Ejecutivo 1626 publicado en R.O. No. 365 de 10 de julio de 2001) • Están definidas unas tarifas de energía (Reg. 04/2011 y sus resoluciones de actualización). • Las señales Tarifarias están dadas (las regulaciones deben ser actualizadas y detalladas en conjunto con disposiciones organizadas). • En este nuevo ambiente puede crecer el interés por la generación distribuida, pero faltan incentivos desde el punto de vista de la política de gobierno, es decir generar las seguridades a la inversión. Contratos a plazo (se acaba de emitir la Regulación 04/2011- Resolución 23012 contrato Compra venta Plazo 15 años) • Pero no hay reglas definidas para reconocer la conexión y uso de la red punto de entrega, como sus estudios de impacto, por lo que deben ser implementadas. 4.7. La Regulación Técnica de la GD en Ecuador [15] La normativa vigente para conexión es orientada a la conexión en el sistema de transmisión, se requiere una normativa específica para los medios que aspiran a la conexión en los sistemas de subtransmisión(S/T) y distribución (SD). Para los medios de generación <1MW se simplifica el proceso de registro de permisos de conexión, pues la regulación es simple y no señala que se conectará al sistema de distribución más cercano, pero no se establecen las condiciones y que políticas guiarán los estudios técnicos de penetración, dispersión y condiciones técnicas de interconexión. Por lo analizado, los posibles requisitos que un marco regulatorio incorpora para transparentar los aspectos de una concesión de medios de generación distribuida mediana y pequeña, son: • Se debe empezar por redefinirla desde el punto de vista de recurso de energía distribuido (DER). • También deberá prepararse una regulación que defina exactamente los recursos de energía distribuida (DER) o generación distribuida (GD). • Hará diferencia entre la conexión a media tensión o subtransmisión. • Establecer los rangos de potencia mediante estudios y simulaciones técnicas de acuerdo a la realidad de los sistemas de subtransmisión y distribución • La Definición puede incluir la operación, así como los objetivos y alcance de las normativas de conexión, con todos los requisitos de protección, confiabilidad y calidad de energía. Figura 10: : Diagrama: Análisis Estratégico para Estructurar La GD [16]. No debe escapar al inversor el tener la información de las características del sistema de distribución para que el impacto sea positivo tanto que los beneficios superen a las barreras que se le presentarán al proyecto. Con ayuda del diagrama de la Fig. 10, se sugieren los pasos de cómo hacer un análisis estratégico y financiamiento, el cual puede verse que parte de políticas del gobierno, no solo serán para el impulsar la iniciativa, sino también para brindar las señales de confianza al inversor. 23 4.8.1 Características relevantes del Modelo de Negocio de la GD Tabla 3: Rango y Costos de inversión por unidad GD Todos los agentes involucrados en las empresas del sector industrial y residencial, las comunidades y las instituciones financieras, deben estar conscientes de la necesidad de identificar todas las instancias que requiere el desarrollo de un proyecto de GD. El crecimiento del mercado y evolución técnica mundial en los generadores aplicados a la GD, y la oferta–demanda, impulsan una importante disminución de los precios. En la evaluación económica para el ingreso de tecnología de GD hay que tener en cuenta: 4.9. Barreras que encuentra la GD Conocer las barreras típicas que encuentra la GD, permitirá identificar las acciones que se deben emprender, agrupadas de la siguiente manera: • Precio de la energía producida por la GD versus el de venta al distribuidor o al Mercado. • Ventajas de la reducción de costos de la GD y el riesgo asociado con consumo de energía. • El precio por servicios auxiliares ofertados, el incentivo a la reducción de congestión en la red de distribución y los costos de inversión en la red al introducir unidades de GD. • Precios de mercado y la flexibilidad de tecnologías que se pueden emplear en GD. • Establecer el monto y % del valor de otros servicios que puede ofrecer la GD a los consumidores, incluyendo la confiabilidad en suministro. • • • • Regulatorias y Normativas Barreras Técnicas Económicas y Financieras Sociales 4.10. Acciones y desafíos para la investigación y regulación [17][20] Para dar soluciones consistentes y en especial a las de tipo regulatorio, se recomiendan acciones como: • Implementar un nuevo modelo de expansión del sistema eléctrico, no solamente centrado en los grandes proyectos hidroeléctricos. • Revisar y simplificar la Normatividad Ambiental. • Promover Políticas Estatales de Fomento a la cogeneración (CHP) y eliminar restricciones legales. • Racionalizar y simplificar los procedimientos para la obtención de la concesión. • Utilizar sistemas modernos de Supervisión y Control y racionalizar los programas de mantenimiento. • Revisar, Actualizar y Aprobar las tarifas de servicios públicos y los incentivos regulatorios para adaptarse al nuevo modelo de energía distribuida. • Establecer la solución de controversias para acelerar los procesos para proyectos de generación distribuida. • Definir y detallar las condiciones necesarias para que el derecho a interconectarse, para todos los actores y en condiciones convenientes para las partes (Definiciones y modelos de la GD, Norma de Interconexión, Contrato de Conexión, Calidad de servicio). ANÁLISIS ECONÓMICO Se procede a realizar un análisis del valor económico actual (expresada Tasa interna de retorno TIR). Los datos o entradas podrían ser: Ubicación, tamaño, vida útil, precio de instalación (lleve en mano) Tabla 3, tarifa – prima (Feed-in Tariff), Descuento relación de rendimiento, perdida/descuento de rendimiento anual de la tarifa, Costos O&M, costos de seguro, impuestos y la tasa de descuento. El ahorro en los sistemas de transmisión y distribución con la GD, es amplio y de $2,00 a $60,00 que también genera señales en la inversión por cada MWh evitado de producir, y también redunda en la postergación de entrada de nuevas subestaciones. Por otro lado, estudios aplicados a los sistemas de transmisión y distribución, detectan pérdidas técnicas entre 4 y 7%. El potencial ahorro en la inversión para expansión en los sistemas de transmisión y distribución con la GD es de entre 2,30 y 3,15 dólares economizados por cada MWh producido 24 Los beneficios destacados del Proyecto: 4.11. El futuro del SEP y la integración con la GD En el futuro las redes eléctricas irán hacia las Smart Grids, para lo que irán evolucionando de ser solamente un concepto, a ser una realidad y adoptar nuevas tecnologías para luego con los nuevos desarrollos en interconexión ofrecer las mejores ventajas en la operación, para la óptima solución de condiciones de aporte de energía al SEP. • Contribuye a cubrir la demanda, con la vertiente occidental. • Es un aporte seguro de producción energética para el mercado eléctrico. • Contribuye en la reducción de los precios de energía. Los estudios de impacto en las redes de distribución de la CENTROSUR incluyen: La red debe maximizar su capacidad de transporte, no por el simple hecho de repotenciarla, sino asumiendo los retos frente a nuevos escenarios que se le ofrecen. La evolución de un concepto que partiendo de la gestión y mejora tecnológica llega a optimizar la operación de la red. • Análisis de flujos de potencia. • Contingencias para diferentes escenarios • Perfiles de tensión en los modos principales del sistema de S/T. • Escenarios con demanda máxima y mínima para determinar impacto de las pérdidas en el Sistema de Distribución. Estos impulsores son parte de un concepto que apuntan a definir la realidad de tener embebida la generación de energía eléctrica en la red. 4.13. Resultados para el año de entrada en operación de Ocaña Las tecnologías a desarrollar para evolucionar hacia una automatización y control, que comprende lo siguiente: Ocaña ocasiona un incremento de 0,84% en las pérdidas de la CENTROSUR, llegando a un total de 8,14%, valor que estaría por encima del comprometido en sus metas del año 2012. La inclusión de la línea Sinincay-Cañar, ocasionó que el incremento llegue sólo al 0,24%, dando un total de 7,54%, que influiría levemente en el performance de la empresa. • Desarrollo de sensores para la operación de la red. • Sensores para la automatización del mantenimiento en las redes. • Contadores inteligentes con comunicación bidireccional. Las pérdidas originadas por la inclusión de Ocaña pudieron representar un costo anual adicional de $440.366 dentro del rubro compra de energía y corresponde al monto que la CENTROSUR debía pagar por compra adicional de energía (a 57,7$/MWh), esto en el caso de que no se construya la línea Sinincay – SE 18 Cañar. 4.12. Interconexión al Sistema de Distribución de la central Ocaña Puesta en operación en 2012, ELECAUSTRO S.A. Características básicas de la Mini Central: • Ubicación: Provincia Cañar, cotas 845 y 458 msnm. • Captación: Diseñada para un caudal 8,20 m3/s. • Tubería presión: Superficial de longitud de 1.085 m. • Casa de Máquinas: Caída neta 373 m. • Capacidad de la Central: 26 MW (2 x 13 T. Pelton). Considerando que la entrada de Ocaña se retrasó y por los problemas imprevistos en su sistema de conducción, la operación se redujo a 5 meses durante 2012, lo que representó un monto de pérdidas de: 183.485 $/año Posteriormente, con la inclusión de la línea SinincayS/E 18, este valor se estableció en 126.824 $/año, obteniéndose una reducción de $313.542/ año Tabla 4: Energía generada y factor de planta. 5. CONCLUSIONES Y RECOMENDACIONES El modelo de GD varía de país en país, dependiendo de sus necesidades y características, lo que depende del propio sistema. Hay variaciones en cuanto a tamaños, fuentes y niveles de voltaje. 25 La GD es parte del nuevo modelo de negocio lo exige que se revisen temas como: modelos de concesión, impactos en la red, medidas para de mitigación de riesgos, los vehículos eléctricos híbridos, dispositivos de almacenamiento, micro redes inteligentes. Ecuador ha recurrido a los incentivos de precio, a través de la feed-in tariff, siendo, que al tener un mercado de precio fijo, será el mercado que asuma la diferencia de costos, al tener un fuerte componente hidráulico de bajo costo, no hay afectación al usuario. Un marco regulatorio que no reconozca y especifique las diferencias entre la generación centralizada y la generación distribuida, no reconoce el valor agregado de la GD, ello dificultará que ésta prospere. Los estudios realizados para analizar el impacto a la red, tanto en el caso de la subtransmisión (Central Ocaña) como de media tensión (Biogás EMAC), permiten destacar que un aumento del nivel de penetración, impacta en los voltajes, cumpliendo la característica de linealidad y superposición de los circuitos eléctricos. La GD puede llegar a ser el insumo y aporte necesario para a mejorar la fiabilidad de la red, aumentar la reserva de suministro de la energía, reducir los costos, aumentando el número y los tipos de generadores disponibles e incluyendo el desarrollo de los recursos no contaminantes de energía alternativa. En el caso práctico de Ocaña el % de Penetración, tiene un alto impacto en las perdidas obligando a la distribuidora a buscar mecanismos para reforzar su sistema de subtransmisión, con aporte mínimo del generador, e importante y positivo por el transmisor que ha facilitado la nueva posición para inyección al SNI. La integración en gran escala de generación distribuida en la red de distribución crea un problema técnico, económico y regulatorio complejo que requiere soluciones innovadoras y debe buscar establecer reglas claras desde un inicio. El resultado del impacto de las pérdidas en el caso de Ocaña, es negativo en las pérdidas, no así en cuanto a la tensión que impacta positivamente pero con riesgo de sobre elevación. Al incorporar GD en el sistema de Distribución, el nivel de dispersión mejora y de acuerdo a la carga conectada a las barras de la red, se puede generar una distribución equitativa de la inyección de potencia, originando un comportamiento equilibrado del sistema en sus perfiles de tensión, más la disminución en la las pérdidas. En el Proyecto Pichacay de Biogás, el nivel de penetración bordea el 50%, que significa un impacto positivo en pérdidas y en nivel de tensión. Resta por ver que cumpla que la interconexión no afecte la estabilidad del sistema en condiciones normales y de contingencia; pues al no haber normas específicas en el país cabe la aplicación de normas internacionales. La fijación de filosofías y esquemas de protección, del SEP pueden variar debido a la introducción de GD y al impacto de la GD en el sistema eléctrico de distribución: Flujos de potencia, pérdidas, variaciones de tensión, niveles de fallo, etc. REFERENCIAS BIBLIOGRÁFICAS [1] J. M. A. J. B.-A. J. Y. L. J. D. N. A.A. Bayod Rújula, Definitions for Distributed Generation: a revision, Zaragoza: Department of Electrical Engineering Centro Politécnico Superior, University of Zaragoza. El panorama de los requisitos de interconexión seguirá siendo un reto en los próximos años, la normativa de IEEE es un instrumento de alto nivel técnico y puede ser adoptado ampliamente por las empresas y la industria, al no contar con estudios técnicos y normativa local. [2] I. (. E. Agency), DG in Liberalised Electricity Markets, 2002. Con el advenimiento de sistemas de control inteligentes integrados en nuevas unidades de GD, las tareas de control en los centros de operación de la distribución serán más simples. [3] W. G. 3. CIGRE, Impact of Increasing Contribution of Dispersed Generation on the Power System, 1999. [4] N. A. R. C. P. y. S. G. Jenkins, "Embedded Generation” The Institution of Electrical Engineers., 2000. La integración de una creciente proporción de la GD en la red de distribución requiere una comprensión y aceptación completa, de todos los actores de su impacto en la distribución y su interacción con las cargas. 26 [5] R. D. M. P.P. Barker, Determining the impact of DG on power systems. I. Radial distribution, Proceedings of the Power Engineering Society Meeting IEEE, vol. 3, 2000, pp. 1645–1656. [16] CONELEC, Inventario de recursos Energéticos del Ecuador con fines de Generación Electríca, www. [email protected], 2009. [17] h. A J Wright & J R Formby, “Overcoming barriers to scheduling embedded generation to support distribution networks”. [6] ]. G.-L. a. C. Fortoul., “Review of Distributed Generation Concept: Attempt of Unification” International Conference on Renewable Energies and Power Quality (ICREPQ´05), España, 16-18 March 2005. [18] C. Richard, Regulatory Assistance Project on Distributed Resource Policies “Distributed resources and electric system reliability”, septiembre 2001. . [7] K. Angelopoulos, Integration of Distributed Generation in Low Voltage Networks: Power Quality and Economics, Glasgow, 2004. [19] J. M. a. G. B. G.W. Ault, Strategic analysis framework for evaluating distributed generation and utility strategies IEE Proc.Gener. Transm. Distrit.. Vol 150, No. 4, July 2003. [8] A. G. S. L. A. Thomas, Distributed generation: a definition, Electric Power Syst. Res. 57 (3), (2001) 195–204.. [20] B. P. J. C. S. U. d. C. Prof. Roberto C. Lotero Unioeste Foz de Iguaçú, Incentivos a la Generación Distribuida en la Planificación de la Red de Distribución, España, 17 de junio de 2009. [9] I.-S. S. Board, IEEE 1347 Standard for Interconnecting Distributed Resources with Electric Power Systems Standards, IEEE-SA Standards Board, Approved 12 June 2003. [10] 1001, IEEE Standard, “Guide of Interfacing Dispersed Storage and Generation Facilities with Electric Utility Systems”,, New York., (1988).. Edgar Fernando Durán Contreras.Jefe de Departamento de Distribución Zona 1 - EE CENTROSUR, Universidad de Cuenca: Ingeniero Eléctrico. Master en SEP; Docente en la Universidad Politécnica Salesiana - Facultad de Ingeniería Eléctrica; dicta las materias de SEP I, Diseños de Sistemas de Distribución I y II, Electrotecnia I y II, Circuitos Eléctricos I y II, Luminotecnia. Docente de Seminarios de Distribución para ECUACIER. [11] F. Gonzalez-Longatt, UNEFA, Universidad Nacional Experimental Politécnica de la Fuerza Armada Nacional, Departamento de Ingeniería Eléctrica Núcleo Maracay,, 2122 Maracay (Venzuela) e-mail: [email protected],, 2008. [12] P. Dunsky, Cogeneration and On-Site Power Production. COSPP,, (2000). [13] M. I. M. V. I. T. D. L. I. C. M. I. R. M. I. R. C. Dr. Ing. Gonzalo Casaravilla, PROYECTO PDT S/C/ OP/16/04 ”Generacion Distribuida En El Uruguay: Evaluacion De Fortalezas, Oportunidades Y Tratamiento Regulatorio, Ute, Ursea: Iie-Udelar, Junio de 2006. [14] www.conelec.gob.ec. [15] C. N. d. Electricidad, Plan Maestro de Electrificación,Quito-Ecuador www.conlec.gob.ec, 2009-2020. 27 Identificación de Fallas Críticas en el Sistema Nacional Interconectado del Ecuador y Diseño de un Esquema de Protección Sistémica V. Flores J. Iza Centro Nacional de Control de Energía, CENACE En el proceso de planificación de la operación para el corto y mediano plazo, se determinan los límites operativos, mediante análisis estáticos y dinámicos, asegurando que en operación normal el despacho de generación abastezca toda la demanda, mantenga la reserva rodante de generación requerida, que los valores de los voltajes y frecuencia de operación se mantengan dentro de los límites establecidos, y que los flujos de potencia por los elementos de transmisión no superen los límites de operación normal declarados por los propietarios. Resumen— En el presente documento se presentan los criterios y metodología utilizados para evaluar las contingencias simples y dobles en el sistema eléctrico ecuatoriano que opera interconectado con el sistema eléctrico colombiano, e identificar aquellas contingencias que pueden provocar la pérdida de estabilidad. Con la finalidad de mantener la estabilidad del sistema eléctrico ecuatoriano, ante la ocurrencia de fallas críticas, evitando que se produzcan colapsos totales o parciales en el Sistema Nacional Interconectado, en el presente trabajo se describe la conceptualización para el diseño del Sistema de Protección Sistémica SPS. Desde el punto de vista de seguridad del sistema eléctrico de potencia, y considerando que los mismos están conformados por un gran número de elementos, es importante el análisis de contingencias, con la finalidad de determinar los efectos que se producen sobre el sistema, ante la salida intempestiva de elementos y su capacidad para encontrar un nuevo punto de operación estable. Palabras clave— Sistema de Protección Sistémica, contingencia, estabilidad, sistema de transmisión, seguridad, flujos de potencia.z Abstract— This paper presents the criteria and methodology used to evaluate simple and double contingencies in the Ecuadorian electrical power system,which operates interconnected with the Colombian power system, and to identify those contingencies that could lead to a loss of stability. 2. OBJETIVOS DEL ESTUDIO • Identificar las contingencias críticas en el Sistema Nacional Interconectado Ecuatoriano S.N.I. y las causas de la pérdida de estabilidad, considerando la operación interconectada con el sistema eléctrico colombiano. • Minimizar los riesgos de colapsos totales y parciales en el sistema eléctrico ecuatoriano ante contingencias N-1 y N-2. • Diseñar un Sistema de Protección Sistémica a ser implementado en el sistema eléctrico ecuatoriano, que permita mejorar la confiabilidad y seguridad del mismo, aprovechando el desarrollo de nuevas tecnologías. This study describes the design concept for the Systemic Protection Scheme (SPS) proposed to maintain the Ecuadorian power system’s stability during potential critical faults, preventing a total or partial collapse of the National Interconnected System. Index Terms— Systemic Protection Scheme, Contingency, Stability, Transmission System, Security, Power Flows 1. INTRODUCCIÓN 3. DEFINICIONES El crecimiento de la demanda y la lenta expansión de los sistemas de transmisión y generación, han provocado que los sistemas eléctricos de potencia operen cerca de sus límites de estabilidad, lo que implica una operación con riesgo desde el punto de vista de la seguridad y calidad eléctrica. 3.1. Contingencia Se entiende por contingencia al evento en el cual uno o más elementos del sistema eléctrico de potencia (líneas, transformadores, generadores, cargas) son retirados o salen de manera súbita de servicio por causas imprevistas. 28 3.2. Análisis de Contingencias 3.7. Sistema de Protección Sistémica (SPS) En el análisis de contingencia se determinan los efectos de un evento sobre el sistema eléctrico y su capacidad de encontrar un nuevo punto de operación estable, considerando la salida intempestiva de uno o más elementos, mediante el análisis de la cargabilidad por las líneas de transmisión y transformadores de potencia, los voltajes en las barras, las desconexiones de carga, corrientes de cortocircuito excesivas, entre otras [1]. Se define como SPS a un sistema automático, integrado por un conjunto de elementos de protección, control y redes de comunicaciones, que actúa ante la ocurrencia de eventos predefinidos (la salida intempestiva de uno o más elementos de un sistema eléctrico), mediante acciones de desconexión de carga, disparo de generación, cambios topológicos, etc., con la finalidad de evitar o mitigar problemas de inestabilidad. 3.3. Fallas Críticas Considerando que los problemas de inestabilidad pueden producirse en un tiempo muy corto (en el orden de milisegundos), el SPS se caracteriza por los tiempos de respuesta sumamente rápidos [2]. Se califican como fallas críticas a aquellas contingencias que provocan uno o más de las siguientes condiciones en el sistema eléctrico: • Inestabilidad del sistema eléctrico. • Eventos en cascada. • Violación de los límites de voltaje emergencia. • Violación de los límites de cargabilidad líneas de transmisión y transformadores potencia. • Desconexiones de carga inaceptable en sistema eléctrico. 4. ANÁLISIS DE CONTINGENCIAS E IDENTIFICACIÓN DE LAS FALLAS CRÍTICAS de 4.1. Consideraciones de de • Las contingencias a ser analizadas se seleccionan bajo los siguientes criterios: • Salida intempestiva de un circuito de las líneas del anillo de 230 kV del SNI. • Salida intempestiva de un transformador del anillo de 230 kV del SNI. • Salida intempestiva de dos circuitos de las líneas del anillo de 230 kV que comparten la misma torre. • Salida intempestiva de un circuito del corredor Santa Rosa – Vicentina – Mulaló – Ambato - Totoras de 138 kV. • Los límites de voltaje de operación normal y de emergencia vigentes para el sistema eléctrico ecuatoriano [3]: el 3.4. Operación Normal Es un régimen de operación permanente que satisface los requerimientos de calidad de servicio, sin poner en riesgo las instalaciones y seguridad del sistema, y que responde a los planes operativos de corto plazo elaborados por el CENACE. [1] 3.5. Sistema Nacional Interconectado (SNI) Es el sistema integrado por los elementos del sistema eléctrico ecuatoriano, conectados entre sí, el cual permite la producción y transferencia de potencia eléctrica entre centros de generación y centros de consumo, dirigido a la prestación del servicio público de suministro de electricidad. [1] Tabla 1: Límites de voltajes vigente 3.6. Sistema Nacional de Transmisión (SNT) Corresponderá al conjunto de instalaciones de transmisión del SNI, incluyendo el equipamiento de compensación, transformación, protección, maniobra, conexión, control y comunicaciones, tanto existentes como aquellas que se incorporen como resultado de expansiones efectuadas en los términos del Plan de Expansión aprobado por el CONELEC, destinadas al servicio público de transporte de energía eléctrica, operado por la empresa única de transmisión. [1] • Los límites de operación normal y de emergencia para las líneas y transformadores del sistema de transmisión declarados por CELEC EP TRANSELECTRIC [4]. • Los ajustes del Esquema de Separación de Áreas en el enlace de Interconexión Colombia – Ecuador [5]. 29 4.2. Metodología Tabla 2: Contingencias Simples • El análisis de contingencias N-1 y N-2 se realiza en estado estable, para los escenarios de generación de alta y baja hidrología, para los períodos de demanda mínima, media y máxima. • Se analizan los resultados, con énfasis en las contingencias cuyos valores de voltaje y/o de los flujos de potencia violan los límites de emergencia. • Se identifican las contingencias cuyo flujo de potencia no tiene convergencia en estado estable. • Se realiza el análisis dinámico de las contingencias en las cuales se presentan violaciones de los límites de emergencia de voltaje y/o cargabilidad, de los elementos del sistema eléctrico ecuatoriano, y en las contingencias en las que no existe solución en estado estable. • Con los resultados de los análisis dinámicos, se determinan las contingencias simples o dobles que producen violaciones a los límites de voltaje y/o cargabilidad de los elementos de transmisión, y a también la pérdida de estabilidad del sistema eléctrico ecuatoriano, exponiéndole a colapsos totales o parciales. A este grupo de contingencias se les denominan “Fallas críticas”. 4.3. Herramienta para el Análisis de Contingencias Para la validación eléctrica de la planificación de la operación del sistema eléctrico ecuatoriano, operando sincronizado con el sistema eléctrico colombiano, la Corporación Centro Nacional de Control de Energía - CENACE, utiliza el programa computacional DigSilent PowerFactory, en el que se modelan los dos sistemas eléctricos, por lo que se selecciona como la herramienta de análisis de contingencias simples y dobles, tanto en estado estable como dinámico. A continuación se listan las contingencias simples y dobles analizadas: 30 Tabla 3: Contingencias Dobles 4.4. Resultados del Análisis de Contingencias 5. DISEÑO DE UN SISTEMA DE PROTECCIÓN SISTÉMICO - SPS De los resultados del análisis de contingencias N-1, se verifica que en ningún caso se presentan violaciones a los límites de emergencia de voltaje o de la cargabilidad de líneas de transmisión o de transformadores, que no pueda ser solucionado con la intervención del Operador en tiempo real. Para evitar el colapso del sistema eléctrico ecuatoriano ante la ocurrencia de las contingencias N-2, fallas críticas, indicadas en la tabla anterior, se requiere realizar el diseño e implementación de un Sistema de Protección Sistémica, que sea capaz de prevenir la actuación del Esquema de Separación de Áreas, de corregir bajos voltajes, de eliminar la sobrecarga de los elementos del Sistema Nacional Interconectado y evitar la condición de fuera de paso entre los sistemas eléctricos colombiano y ecuatoriano. Del análisis de contingencias N-2, en estado estacionario, se identifica las contingencias en las cuales se presentan violaciones a los límites de voltaje y/o cargabilidad de elementos de transmisión, o la falta de convergencia; mediante análisis dinámico se confirma la presencia de problemas operativos ante la contingencia N-2 y se determinan los problemas eléctricos que ocasionan en el SNI. La apertura del anillo de 230 kV, producto de la salida intempestiva de una línea de transmisión en el norte del país, da lugar a altas transferencias por los elementos del corredor Totoras – Ambato- Pucará – Mulaló –Vicentina 138 kV, que a la vez provoca la salida por sobrecarga de la línea de transmisión Ambato – Totoras 138 kV, bajos voltajes en todo el sistema y la separación angular entre los sistemas eléctricos ecuatoriano y colombiano. A continuación se listan las contingencias N-2, fallas críticas, que ante su ocurrencia generan problemas de estabilidad en el sistema eléctrico ecuatoriano, y por lo tanto se requiere que sean integradas en un Sistema de Protección Sistémica. Tabla 4: Fallas críticas De los análisis realizados se concluye que los efectos negativos descritos, son posibles de mitigar o eliminar, al disminuir la generación de la central hidroeléctrica Paute y/o de la central hidroeléctrica San Francisco; y, con la finalidad de mantener el balance de generación – carga y evitar las bajas frecuencias, se hace necesaria la desconexión automática de carga, estratégicamente seleccionada para cada una de las contingencias, fallas críticas. El éxito de la actuación del SPS se alcanza, siempre y cuando se logre mantener interconectado el sistema eléctrico ecuatoriano con el sistema eléctrico colombiano, evitando en todo instante la actuación del Esquema de Separación de Áreas - ESA (se considera que el ajuste de tiempo por bajo voltaje de ésta protección es de 500 milisegundos). El SPS, considerando las acciones de verificación y envío de comandos para ejecutar las acciones de mitigación, en varios casos no será capaz de evitar que se presenten sobrecargas en los elementos de transmisión de manera transitoria, por lo que las protecciones por sobrecarga de los elementos de transmisión no deben actuar antes que el opere el SPS. El tiempo de actuación del Sistema de Protección Sistémica, debe ser menor al tiempo crítico para cada una de las contingencias, el mismo que se determina en el punto 5.2. 31 Las acciones de mitigación para cada falla crítica se determinan en base a la formulación de un algoritmo (polinomio), que puede depender del flujo de potencia del o los elementos que salen de servicio en forma intempestiva y/o de otros elementos de la red de transmisión, formulación a partir de la cual se determina la cantidad de carga a ser desconectada y/o el rechazo de generación necesaria, para llevar el sistema a un nuevo punto de operación estable. A continuación se resumen las acciones de mitigación para cada una de las contingencias. Tabla 5: Acciones de mitigación para cada falla crítica Figura 1: Arquitectura del SPS 5.2. Características del Sistema de Protección Sistémica • El SPS debe actuar ante la ocurrencia de las contingencias predefinidas. • Una vez ocurrida una de las contingencias ante la cual el SPS actúa, el tiempo de ejecución de las acciones de mitigación debe ser menor a la pérdida de estabilidad del sistema, y al tiempo de actuación del ESA, es decir menor al tiempo crítico definido. • Para el sistema eléctrico ecuatoriano, el tiempo crítico de actuación del SPS se ha determinado en aproximadamente 200 milisegundos. Este valor se determina en base a: el tiempo de la actuación de la protección del elemento una vez ocurrida la falla, el tiempo que le toma al relé de monitoreo recibir la señal del elemento, el tiempo de retardo en el envío de datos de los relés de monitoreo al sistema central, el tiempo de procesamiento del sistema central, el tiempo para el envío de datos del sistema central a los relés de mitigación, el tiempo de envío de la señal de disparo de los relés de mitigación y la desconexión de los elementos de generación y carga 5.1. Arquitectura General del SPS El Sistema de Protección Sistémica debe estar integrado por dispositivos de control y protección en las subestaciones (relés de monitoreo y mitigación), sistemas de control centralizados (toma de decisiones) y redes de comunicación, todas de manera redundante. En Fig. 1 se presenta el diagrama general de la arquitectura del SPS. En la Fig. 2 se presenta gráficamente la cadena de distribución de tiempo de operación del SPS. 32 • El sistema de protección sistémica no reemplaza la expansión de los sistemas de transmisión y generación, este es una solución de corto plazo para los problemas de la red. • El diseño del sistema de protección sistémica propuesto considera en su arquitectura la dinámica de los sistemas eléctricos de potencia y permite modificaciones, considerando cambios topológicos como resultado de la expansión del sistema. • El sistema de protección sistémica analizado, considera algoritmos en base a la red extendida, anillo troncal de 230 kV del SNI, no considera algoritmos para áreas locales. Fuente: Special Protection System Specification Document Quanta Figura 2: Distribución del tiempo del SPS REFERENCIAS BIBLIOGRAFICAS 6. OPERABILIDAD DEL SPS [1] REGULACIÓN No. CONELEC - 003/08, “Calidad del Transporte de Electricidad y del Servicio de Transmisión y Conexión en el Sistema Nacional Interconectado • Dada la criticidad del correcto funcionamiento del SPS, se requiere de redundancia dual, de tal forma que la falla de alguno de sus componentes no afecten el desempeño total del SPS. • Los relés instalados en las subestaciones de monitoreo adquieren cada segundo, de manera constante, los datos de las corrientes, voltajes, estado de interruptores de los elementos de las contingencias predefinidas y son enviados al sistema central. • Los relés instalados en las subestaciones de mitigación, cada segundo adquieren los datos de las corrientes, voltajes, estado de interruptores, de los elementos que forman parte de las acciones de mitigación, y son enviados al sistema central. • Para cada contingencia, con los datos monitoreados en las subestaciones, el sistema central resuelve los algoritmos predefinidos y calcula la potencia de generación y de carga que debe desconectar automáticamente, y determina de manera automática las unidades y las cargas que va a desconectar. • Cuando ocurre una de las contingencia definidas en el SPS, el equipamiento de monitoreo informa al sistema central, y el sistema central con las soluciones calculadas en el segundo anterior, envía las decisiones de apertura al equipamiento de mitigación de las subestaciones respectivas. [2] Shimo Wang, George Rodriguez, Smart RAS (Remedial Action Scheme), IEEE. [3] Informe del CENACE, “Revisión de las Bandas de Variación de Voltaje en Barras y Factores de Potencia en Puntos de Entrega del Sistema Nacional de Transmisión (SNT)”. [4] http://www.transelectric.com.ec [5] GENERACIÓN DE SEGURIDAD Y LÍMITES DE TRANSFERENCIA DE POTENCIA ENTRE LOS SISTEMAS ELÉCTRICOS DE COLOMBIA Y ECUADOR DICIEMBRE 2012 – DICIEMBRE 2013 [6] Rafael Ernesto Salao Paredes, Julio Fernando Masache Masache, Cristóbal Mera, Análisis de contingencia del sistema nacional interconectado. [7] 7. CONCLUSIONES Y RECOMENDACIONES • La implementación del Sistema de Protección Sistémica dará mayor confiabilidad al sistema eléctrico ecuatoriano, minimizando el riesgo de experimentar colapsos totales o parciales. 33 Quanta Technology, Estudios de soporte, análisis, diseño y especificaciones del sistema de protección sistémica para el sistema nacional interconectado del Ecuador. Edison Javier Iza Chango, nació en Quito, Ecuador, en 1972. Recibió su título de Ingeniero Eléctrico de la Escuela Politécnica Nacional de Quito, 2001. Realizó estudios de MBA con mención en Calidad y Productividad en la Universidad Católica de Quito y al momento se encuenctra desarrollando la tesis de maestría. Desde el 2000 a 2003 se desempeñó como ingeniero operador de generación y transmisión y del 2003 al 2011 como Supervisor de Operaciones en el Área Centro de Operaciones del CENACE. Actualmente trabaja como Ingeniero de Estudios Eléctricos de la Dirección de Planeamiento del CENACE. Sus áreas de interés son los estudios eléctricos enfocados a la Operación y Estabilidad de SEP. en Quito, Ecuador en 1982. Recibió su título de Ingeniero Eléctrico de la Politécnica Nacional en 2007; se desempeña desde el 2008 como Operador de Generación / Transmisión en la Sala de Control del CENACE. María Verónica Flores Soria. Nació en Latacunga, Ecuador. Recibió su título de Ingeniera Eléctrica de Escuela Politécnica Nacional en el 2000, de Máster en Economía y Regulación de Servicios Públicos de la Universidad de Barcelona, especialidad Energía, España en 2004, Especialista en Dirección de Empresas mención Finanzas, de la Universidad Andina 2007, Máster en Dirección de Empresas de la Universidad Andina en 2009. Actualmente se desempeña en el cargo de Gerente Técnica del Proyecto SPS en el Centro Nacional de Control de Energía. Sus áreas de mayor interés incluyen estabilidad de sistemas eléctricos de potencia, sistemas de acción remediales. 34 Optimización de la Operación de las unidades de la Central Mazar en Función de la Cabeza Neta V. A. Llivichuzhca J. V. Gallardo Corporación Eléctrica del Ecuador CELEC E.P., Unidad de Negocio HIDROPAUTE Resumen— Para optimizar la operación de la central hidroeléctrica Mazar en el corto plazo, en este artículo se desarrolla un modelo no lineal basado en los puntos de máxima eficiencia técnica en la operación de una turbina Francis, que dependen de la cabeza neta y la descarga de agua y la potencia generada. found, as a quadratic function of the net head and the water discharge. For this model three hydrological scenarios are used: Dry, medium and humid, with hourly solving through a deterministic analysis. The results obtained a non-supplied power for Mazar according to scheduled demand, given that the analysis uses the optimization criteria of the maximum technical efficiency, without including restrictions for satisfying demand. This is done in order to understand the effects of the reservoir level on operations of the generating units of the Mazar power plant at maximum efficiency. La curva de colina entregada por el fabricante de la turbina es el diagrama de partida para el desarrollo de esta investigación, y mediante una regresión no lineal bi-variable se encuentra la representación de la eficiencia técnica de la turbina Francis como una función cuadrática de la cabeza neta y la descarga de agua. Index Terms— Net Head, Hill Curve, Technical Efficiency, Design Point, Maximum Efficiency Para el modelo, se evalúa tres escenarios hidrológicos seco, medio y húmedo con resolución horaria a través de un análisis determinístico. De los resultados se obtuvo una potencia no suministrada por Mazar de acuerdo a la demanda programada, debido que el análisis utiliza el criterio de optimización de máxima eficiencia técnica, sin la inclusión de la restricción de satisfacer la demanda; esto se realizó con la intención de comprender los efectos que causa en el nivel del embalse al operar las unidades de generación de la central Mazar a máxima eficiencia. 1. INTRODUCCIN A mediados del año 2010 la central Mazar que pertenece al complejo hidroeléctrico Paute inició su proceso de operación con las dos unidades que la conforman. En este periodo se ha registrado información de diferentes parámetros operativos que nos ha permitido observar el comportamiento de la producción de la planta más aún en las diferentes temporadas del año hidrológico (lluvioso y seco) en donde el comportamiento del nivel del embalse influye marcadamente en la eficiencia de la operación de las unidades de generación. Palabras clave— Cabeza neta, curva de colina, eficiencia técnica, punto de diseño, máxima eficiencia. Con este antecedente y debido que uno de los aspectos que resulta prioritario en la operación de un sistema eléctrico de potencia es el uso eficiente de los recursos energéticos, es importante modelar sus particularidades para aprovechar de manera adecuada sus características operativas, más aún, las compañías de generación que tienen a su cargo centrales hidroeléctricas; la gestión de estos recursos hídricos es un eje fundamental para las mismas, ya que recae en las propias empresas buscar herramientas adecuadas y adaptarlas a sus necesidades particulares para optimizar sus recursos. Abstract— In order to optimize operation of the Mazar hydroelectric power plant, in the short term, this paper develops a non-linear model based on maximum technical efficiency points for operation of a Francis turbine generator, which depend on net head, water discharge and generated power. The hill curve given by the turbine manufacturer is a diagram to be used as a starting point for the development of this research, and though a non-linear bi-variable regression, the technical efficiency representation of the Francis turbine is 35 Esta investigación busca establecer un modelo de las unidades de generación, para que en función de la cabeza neta, se obtenga un uso eficiente del recurso hídrico almacenado en su embalse. Bajo la consideración de que la potencia de salida de las unidades de generación hidroeléctrica, depende básicamente de tres variables: la cabeza neta, el caudal de turbinamiento y la eficiencia técnica del conjunto turbina-generador. Por lo tanto al considerar la variación de la cabeza neta, la no linealidad de la descarga dentro de la función de producción de potencia generada en la central hidroeléctrica puede tener un efecto significativo. por las turbinas, se descarga a una cola inferior. Las turbinas convierten la energía potencial gravitacional en energía mecánica accionando sus ejes conectados a los generadores, los cuales suministran energía eléctrica en sus terminales [2]. 2.1. Función de producción de potencia La función de la producción de potencia en una unidad de generación hidroeléctrica depende del producto del caudal de turbinamiento o descarga de agua por la turbina, la cabeza neta y la eficiencia del grupo turbina-generador [1], [3], [4]. Por lo tanto es necesario que los parámetros y/o las características de la central hidroeléctrica sean expresados adecuadamente más aún cuando los efectos que causa la variación de la cabeza neta y la descarga en las plantas hidroeléctricas son significativos. La potencia hidráulica total de una unidad de generación hidroeléctrica se puede expresar como: En este documento, es preciso mencionar, que se trata de presentar un avance de la investigación que se está desarrollando para la optimización de los recursos hídricos en el complejo hidroeléctrico Paute, por lo que los resultados mostrados en este documento son preliminares enfocados únicamente en el modelo de la central Mazar. Este estudio por lo tanto es el inicio de esa “búsqueda” del uso eficiente de los recursos energéticos del complejo hidroeléctrico Paute. Donde ηj representa la eficiencia del grupo turb ina-generador, qj el caudal de turbinamiento, hj la cabeza neta. Tomando como punto partida la información del fabricante y la estadística registrada hasta el momento y basados en la literatura sobre el tema del MSc. principalmente en la tesis doctoral Francisco Javier Díaz [1]; se busca establecer un modelo que nos permita determinar a través del punto de diseño los puntos máximos de la eficiencia técnica de las unidades para diferentes valores de cabeza neta dentro de la curva colinar de la turbina; permitiendo tener una generación eficiente en la central y un mejor aprovechamiento del recurso hídrico, que se verá reflejado en el almacenamiento del embalse que a su vez se manifiesta en un ahorro de energía hidroeléctrica. 1 2.2. La caída bruta La caída o cabeza bruta, en la operación de una planta de generación hidroeléctrica, se define como la caída topográfica, es decir, la diferencia de cotas entre el nivel del embalse aguas arriba, en la captación de agua, y el nivel aguas abajo en el canal de descarga. La citada cota aguas arriba es una función del volumen almacenado en el embalse [1], [5]. A su vez, la cota aguas abajo es una función de la descarga defluente, d, conformada por la descarga total turbinada en la planta, Q, más el vertimiento, qv, (según el diseño de la planta), y más el aporte lateral del río Mazar tal que, d=(Q+qv+ql) durante un período de tiempo de duración ∆t, puede definirse mediante la expresión (2). Logrando finalmente determinar una función de producción de la generación basados en la eficiencia técnica de las unidades, por lo que se utilizará como criterio de optimización, la máxima eficiencia técnica en la operación de las unidades en la central Mazar. 2. MARCO TEORICO En las unidades de generación hidroeléctrica, la producción de electricidad se presenta, en forma simplificada, como la transformación de la energía potencial gravitacional del agua almacenada en el embalse en energía eléctrica por medio de las unidades generadoras (conjunto turbina-generador). El agua que se capta a una cota determinada, después de pasar 1 (1) (2) Donde Nsupj (vj) es una función de la cota aguas arriba del embalse de la planta, y Ninfj (Q+qv+ql) es una función de la cota aguas abajo del canal de descarga de la planta que relaciona el valor de esta cota, la descarga defluente, el vertimiento y el aporte lateral del rio Mazar. “Optimización de la operación y evaluación de la eficiencia técnica de una empresa de generación hidroeléctrica en mercados de corto plazo”. Tesis doctoral, Universidad Nacional de Colombia, 2011, Francisco Javier Díaz. 36 2.2.1 Las pérdidas hidráulicas nominal con la descarga de agua turbinada, según sus propias especificaciones de diseño, logrando su máxima eficiencia. En los estudios de medio y de largo plazo, por lo general, la eficiencia se considera constante e igual al valor promedio de todos los grupos turbina - generador de la central hidroeléctrica. Sin embargo, en horizontes de más corto plazo, como es el caso de la programación de la operación hidroeléctrica, será conveniente una representación más detallada y precisa del comportamiento de la turbina, ya que de esta manera se posibilitaría la realización de un despacho óptimo más exacto y podría ayudar a evitar la presencia de comportamientos operativos indeseables” [1], [5], [8]. No todo el potencial energético referente a la altura de la caída bruta es aprovechado por la turbina. Durante la conducción del agua se presentan pérdidas de energía hidráulica por fricción, referentes al efecto de piezas y dispositivos intercalados en los conductos, tales como rejas, portones, válvulas y codos. De acuerdo a las especificaciones del fabricante en las unidades de la central Mazar, las pérdidas de carga en el circuito hidráulico de aducción, desde la sección de la entrada del túnel de carga (toma de agua) hasta la sección de la salida del túnel de descarga son calculadas por las expresiones. (3) (4) Las condiciones de operación de una turbina hidráulica suelen representarse mediante gráficas a través de curvas características, cuya obtención debe hacerse experimentalmente, “in situ” o mediante ensayos de laboratorio en modelos reducidos [1]. Para una adecuada representación del comportamiento físico de la eficiencia de una turbina se debe tener en cuenta, básicamente, dos variables: la altura de la caída o cabeza neta y la descarga de agua. Esta interrelación es bastante compleja y generalmente se expresa mediante curvas que representan la eficiencia de la turbina a diferentes niveles, dependiendo de las citadas dos variables. Estas curvas colinares o “hill diagrams”, generalmente son entregadas por los fabricantes de las turbinas y tienen la forma que se ilustra en la Fig. 1. A continuación, se analiza el comportamiento de la turbina de reacción tipo Francis de la central Mazar. 2.2.2 La cabeza neta La altura de la cabeza neta a la que está sometida una turbina se define como la diferencia de cotas entre el nivel del embalse y el nivel en el canal de descarga y menos las pérdidas hidráulicas [1], [6]. (5) Donde Perj (Qj,qj) representa las pérdidas de energía hidráulica por fricción. 2.3. La eficiencia técnica del grupo turbina generador La eficiencia o rendimiento hidráulico de la turbina, ηt se define como el cociente entre el salto útil, o energía por unidad de masa transmitida al generador, y el salto neto, o energía por unidad de masa disponible a la entrada del rodete. El porcentaje de la energía mecánica transmitida al rotor de la máquina que se transforma en energía eléctrica se conoce como la eficiencia del generador ηg Esta eficiencia del generador suele englobarse dentro del término de eficiencia ηj=ηt*ηg , considerada como la eficiencia global del grupo turbina-generador [1], [2], [7]. La eficiencia ηg para este estudio, se consideró una constante. “La cuantificación de la eficiencia técnica de una unidad de generación hidroeléctrica es función de su punto de operación. Cuando la turbina opera en las condiciones de diseño, ésta gira con el número de rotaciones especificado y desarrolla su potencia Figura 1: Diagrama Colinar de las unidades de la central Mazar. 37 Toda turbina está proyectada para operar con sus parámetros nominales o de diseño: cabeza neta, hd, y descarga de agua, qd. Que por lo general la pareja (hd, qd) es llamado "punto de diseño". En el diagrama colinar de la Fig. 1, estos parámetros se encuentran dentro de una zona que no se especifica un punto de diseño máximo, pero para fines demostrativos se puede tomar uno de los puntos que garantizan la eficiencia media ponderada que toma valores de 146 m y 57,8 m3/s, aproximadamente, donde la turbina obtiene su "máxima eficiencia" (punto B) o su rendimiento óptimo, al 95,5%. Además, para cualquier punto de operación de la región factible asociado con la pareja (h, q), donde h representa la cabeza neta y q la descarga de agua, es posible leer la eficiencia de la turbina [1], [6]. El procedimiento estadístico desarrollado consistió en tomar una muestra conformada por los puntos disponibles de la curva de colina entregada por el fabricante y con el uso de una herramienta de cálculo matemático, se encontraron los coeficientes βj de la ecuación de regresión ajustada, de (6). La interdependencia entre las tres citadas variables, la cabeza neta, la descarga de agua y la eficiencia técnica se describe a continuación, y se ilustra en la Fig. 1. Suponiendo que la turbina está operando en el punto A con una cabeza neta de 150 m y una descarga de 34 m3/s, en la curva colinar se lee una eficiencia de 88% y una potencia de salida en la turbina de 44 MW. Al aumentar la descarga desde el punto A al punto C; la potencia de salida de la turbina es creciente desde 44 MW en A, hasta aproximadamente 85 MW en C con una cabeza neta de 140 m y una descarga de 66 m3/s. En la Fig. 1 se puede observar que en la trayectoria operativa ABC ilustra la interdependencia entre la cabeza neta, la descarga de agua y la potencia generada. Figura 2: Puntos de muestreo de la curva de colina de las unidades de la central Mazar. En la Fig. 2 se encuentra graficados los puntos de muestreo y en la Fig. 3 se muestra el modelo ajustado. Figura 3: Curva de Colina ajustada para las unidades de la central Mazar. Mediante estas consideraciones puede verificarse que el funcionamiento de la unidad en condiciones operativas diferentes a su “punto de diseño” (cercano al punto B, en este caso) causa ineficiencias en el proceso de producción de energía eléctrica. Ahora bien, la descarga óptima, para una cabeza neta dada, puede hallarse, mediante optimización, al igualar a cero la derivada parcial de la función de eficiencia con respecto a la descarga, ∂η/∂q=0 (para lo cual, h se toma como una constante), y resolviendo la ecuación resultante, para la descarga, q, como una función de la cabeza neta, h. En el caso de (6), se tiene (7) de la cual puede expresarse q como una función lineal de h, como se hace en (8). 2.4. La eficiencia como una función cuadrática de la cabeza neta y la descarga de agua Con el objetivo de facilitar el análisis del sistema y su aplicación en la toma de decisiones, se realiza un trabajo estadístico a partir del diagrama de “Curvas de Colina” para representar la eficiencia de la turbina como una función, no lineal, de dos variables: la cabeza neta y la descarga de agua [1], [5], [8], [9]. El procedimiento estadístico desarrollado en este trabajo consiste en la formulación de una regresión no lineal múltiple de la forma de (6). (7) (8) La eficiencia técnica de una turbina Francis, ha sido aproximada mediante un modelo cuadrático bi-variable, como se especifica en (6), a partir del cual y mediante análisis matemático, se ha llegado a una función lineal que permite hallar la descarga (6) 38 de máxima eficiencia relativa asociada a una determinada cabeza neta. Para esta pareja (cabeza neta, descarga de agua) es posible calcular tanto la eficiencia de la turbina como la potencia de salida y la energía generada, es decir, puede estimarse el nivel de potencia a máxima eficiencia relativa. Esta descarga de máxima eficiencia relativa ofrece información útil a una empresa de generación hidroeléctrica como ayuda para la toma de decisiones relacionadas con la asignación de sus unidades de generación o autodespacho de sus unidades una vez que se ha realizado el despacho por el operador del sistema [5], [8]. con la potencia en función de la máxima eficiencia de las unidades. Posteriormente se indica un ejemplo de aplicación en un contexto determinístico para fines ilustrativos. 3.1. Potencia de las unidades de la Central Mazar con el criterio de máxima eficiencia técnica La eficiencia técnica de las unidades de la central Mazar se ha aproximado de acuerdo a (6) es decir a un modelo cuadrático bi - variable, que a partir de este, permite encontrar el turbinamiento o descarga de máxima eficiencia relativa asociada a una determinada cabeza neta. Logrando posteriormente estimar el nivel de potencia de salida de la turbina a máxima eficiencia; en la Fig. 4 se muestra los resultados de este análisis donde se aprecia la curva resultante de potencia a máxima eficiencia, la curva a máxima potencia de la turbina, y la limitación por inflexibilidad declarada de las unidades de generación de la central Mazar. Continuando el análisis matemático, mediante un procedimiento similar al utilizado para hallar la descarga de máxima eficiencia relativa para una determinada cabeza neta; igualando a cero la derivada parcial de la eficiencia, esta vez con respecto a la cabeza neta, ∂η/∂h=0 (tomando la descarga q como una constante), se obtiene: (9) De los anteriores análisis, se tiene el sistema de dos ecuaciones lineales simultáneas, con dos variables, formado por (7) y (9), cuya solución debe reproducir el punto de diseño del “diagrama colinar”, que para el caso de Mazar este punto toma los valores de 145,5m y 60 m3/s. Figura 4: Curva de potencia a máxima eficiencia y curva a máxima potencia de la turbina La ventaja de disponer de una función analítica de este tipo consiste en la posibilidad de desarrollar un procedimiento matemático para su optimización y para la toma de decisiones relacionadas, por ejemplo, con la descarga óptima a realizar en los procesos operativos diarios u horarios donde puede conocerse, con una buena aproximación, la cabeza neta, la cual podría irse actualizando, para cada uno de los períodos de tiempo, mediante un proceso iterativo, de tal manera que permita la programación de la operación diaria u horaria a máxima eficiencia de las unidades de generación[1], [5], [9]. 3.2. Análisis del modelo determinístico en un contexto En este apartado se realiza un análisis determinístico en un periodo de una semana, utilizando los registros horarios históricos de caudales de ingreso y producción de la planta, para un escenario de hidrología seca, en la Fig. 5 se presenta el esquema utilizado para él ejemplo. 3. ANALISIS DEL MODELO DE LA CENTRAL MAZAR El objetivo de este análisis es mostrar el comportamiento del modelo para la central Mazar con la consideración de la variabilidad de la cabeza neta a máxima eficiencia, logrando obtener curvas de algunos parámetros que permitan dilucidar las ventajas de una función no lineal de la eficiencia técnica en periodos de muy corto plazo [2]. En primera instancia se muestra de manera general la trayectoria de potencia de la unidad en comparación Figura 5: Esquema de la central Mazar Para mostrar la funcionalidad del modelo se analiza comparativamente los valores de potencia del registro histórico con los resultados del modelo con la consideración única que se debe suministrar la demanda programada por la planta; los resultados que se indican en la Fig. 6 muestran que el modelo tiene 39 una buena aproximación en relación a los valores reales registrados, por lo que se puede establecer que el modelo se encuentra brindando resultados valederos para el caso de suministrar únicamente la demanda sin considerar ningún criterio de optimización. Las curvas de eficiencia para el caso en estudio se presentan en la Fig. 8. Figura 8: Curvas de eficiencia real vs el modelo con el criterio de máxima eficiencia. Continuando con el análisis en la Fig. 9 se muestra el efecto representativo al trabajar las unidades de la central Mazar a máxima eficiencia misma que produce un incremento en el almacenamiento de agua en el embalse al final del periodo analizado, por lo tanto al trabajar con la unidades de Mazar con este criterio produciría un “ahorro de energía hidroeléctrica” visto como almacenamiento de agua en el embalse. Figura 6 : Curvas de potencias real vs modelo. 3.2.1 Análisis con el criterio de máxima eficiencia Los efectos que trae al utilizar el criterio de descarga a máxima eficiencia en las unidades de Mazar en el periodo de operación analizado se presentan en la Fig. 7 y Fig. 8; de la Fig. 7 se extrae que las unidades de la central Mazar en ciertos periodos no alcanzan a cubrir la demanda total requerida, esto es debido que al aplicar el criterio de descarga a máxima eficiencia el modelo trata de ajustarse a la programación de demanda pero está limitado al valor de máxima eficiencia de la descarga en función de la cabeza neta en el periodo estudiado, por lo tanto no está sujeto al cubrimiento total de la misma, esta particularidad ayuda a comprender los efectos que causa en el nivel del embalse al operar las unidades de generación de la central Mazar a máxima eficiencia, esto se mostrará más adelante. Figura 9: : Curvas de nivel del embalse real vs el modelo con el suministro de demanda programada y con el criterio de máxima eficiencia. Si se considera que la potencia no suministrada por Mazar al sistema la podría absorber la central Molino en lugar del parque generador térmico es un planteamiento de la investigación que se está desarrollando actualmente para validar el criterio a máxima eficiencia. Adicional al análisis presentado anteriormente, se evaluó para esta presentación el modelo con dos escenarios hidrológicos adicionales, un escenario medio y otro de alta hidrología para la misma demanda, para estos escenarios en la Fig. 10 se muestran los resultados obtenidos. Figura 7 : Curvas de potencia real vs el modelo con el criterio de máxima eficiencia. Figura 10: Curvas del nivel del embalse con escenario húmedo, medio y seco con el criterio de optimización a máxima eficiencia. 40 Del ejemplo para el escenario de hidrología alta existe una estimación de generación a la semana mayor que la demanda base del estudio, esto es un indicativo que ayudaría a establecer en un rango más ajustado la potencia efectiva a máxima eficiencia que podría alcanzar las unidades en temporada seca, es pertinente señalar en la actualidad por las características técnicas de la planta la potencia efectiva de las unidades va disminuyendo cuando los niveles del embalse se encuentran en cotas bajas. En la Fig. 11 se muestra de manera gráfica el resultado de potencia del escenario de hidrología alta. la presencia de comportamientos operativos indeseables tales como pulsaciones, vibraciones en la turbina, etc., y permitiría definir de una mejor manera los límites de inflexibilidad de las unidades en función de la cabeza neta. • Cuando la turbina Francis opera para una determinada cabeza neta en un punto menos eficiente en comparación que a una descarga a máxima eficiencia, esta pérdida de eficiencia, en la turbina significa un mayor uso del recurso hídrico que es necesario para generar la potencia determinada • El operar una unidad de Mazar, o en general, el operar una turbina Francis con el criterio de máxima eficiencia para una determinada cabeza neta es un indicador que debe ser analizado en detalle para contestar la pregunta ¿Será necesario en la actualidad ó a futuro que las unidades de la central Mazar o algunas otras del país generen a una potencia máxima o a una potencia de máxima eficiencia? • Debido a la particularidad de la descarga de Mazar se debe buscar un mejor ajuste de la curva no lineal, para representar ciertas variaciones que se producen en la altura de la descarga cuando se producen vertimientos o incrementos del caudal del rio Mazar. Figura 11: Potencia de las unidades de la central para el ejemplo de hidrología alta con el criterio de optimización a máxima eficiencia. Es propicio recalcar que este documento presenta los resultados de la fase inicial de la investigación que actualmente se está desarrollando para el complejo hidroeléctrico Paute que básicamente es desarrollar un modelo que involucre la optimización de las centrales y embalses en cascada. Es decir con la optimización se tratará de encontrar un punto adecuado entre satisfacer la demanda y a la vez ser eficientes. Con los resultados del estudio global se podría validar el criterio de optimización a máxima eficiencia para el complejo hidroeléctrico Paute. REFERENCIAS BIBLIOGRÁFICAS [1] Díaz Francisco J., “Optimización de la operación y evaluación de la eficiencia técnica de una empresa de generación hidroeléctrica en mercados de corto plazo”. Tesis doctoral, Universidad Nacional de Colombia, 2011. [2] Vukosavić, D. Divac, Z. Stojanović, B. Stojanović, D. Vučković “Several Hydropower Production Management Algorithms” Journal of the Serbian Society for Computational Mechanics Vol, 3 No. 1, 182-209, 2009. 4. CONCLUSIONES Y RECOMENDACIONES • Representar la eficiencia técnica con un modelo analítico de las unidades de generación de la central Mazar como una función cuadrática de la cabeza neta y la representación de la no linealidad del nivel de la descarga de agua en el modelo facilita un tratamiento matemático para encontrar una operación óptima en la generación hidroeléctrica de la unidades en el muy corto plazo. • De los resultados preliminares al utilizar el criterio de máxima eficiencia en un escenario de sequía al modelo puede significar un ahorro de los recursos hidráulicos de la cuenca, y por lo tanto en energía hidroeléctrica que es acumulada como agua en los embalses. • En el escenario de corto plazo un adecuado manejo de la producción ayudaría a evitar [3] Catalão, J., S. Mariano, V. Mendes y L. Ferreira, “Scheduling of Head-Sensitive Cascaded Hydro Systems: A Nolinear Approach", IEEE Transactions on Power Systems, Vol. 24 Nº 1, pp. 337-345, Febrero 2009. [4] Mendes V., L. Ferreira y S. Mariano, "ShortTerm Hydro Schedule with Head-Dependent Approach by a Nonlinear Model", 8th Portuguese-Spanish Congress on Electrical Engineering, 257-263, Vilamoura, Portugal, Jul. 3-5, 2003. 41 [5] Díaz Javier, "La eficiencia técnica como un nuevo criterio de optimización para la generación hidroeléctrica a corto plazo," DYNA, vol. 76, no. 157, pp. 91-100, 2009 Vicente Alejandro Llivichuzhca P.- Nació en Cuenca en 1980. Recibió su título de Ingeniero Eléctrico de la Universidad Politécnica Salesiana en 2006. Realizó sus estudios de Maestría en Sistemas Eléctricos de Potencia en la Universidad de Cuenca, y sus áreas de interés e investigación se encuentran relacionadas con la Operación económica, planificación con procesos de optimización, operación de centrales hidroeléctricas. Actualmente labora en la Unidad de Negocio Hidropaute de CELEC EP. [6] Finardi, E. C. and Da Silva, D. A. “Solving the unit commitment problem of hydropower plants via Lagrangian Relaxation and Sequential Quadratic Programming”. Computational & Applied Mathematics, vol. 24, pp. 317-341, 2005. [7] Ni, E., X. Guan y R. Li, "Scheduling Hydrothermal Power Systems with Cascaded and Head-Dependent Reservoirs", IEEE Transactions on Power Systems, 14(3), 11271132(1999). José Vicente Gallardo T.- Nació en Machala en 1980. Recibió su título de Ingeniero Eléctrico de la Universidad de Cuenca en 2007. Actualmente se encuentra egresado de la Maestría en Administración de Empresas en la Universidad del Azuay, y sus áreas de interés se encuentran relacionadas con la Gestión de Proyectos y la Operación de centrales Hidroeléctricas. Actualmente labora en la Unidad de Negocio Hidropaute de CELEC EP. [8] Díaz Francisco J., Líevano Federico, “Modelo No Lineal para la Óptima Generación Hidroeléctrica a Máxima Eficiencia. Un enfoque a Corto Plazo” [9] Perez J, Wilhelmi J. "Nolinear Self-Scheduling of a Single Unit Small Hydro Plant in the DayAhead Electricity Market", Departamento de Ingenieria Civil: Hidraulic y Energetic, University of Madrid. 42 Análisis para el Inicio del Restablecimiento de la Zona 4 del S.N.I. posterior a un “Black-out” considerando el Arranque en Negro de las Unidades de la Central Mazar M. A. Maldonado V. A. Llivichuzhca Corporación Eléctrica del Ecuador CELEC E.P., Unidad de Negocio Hidropaute Resumen— El presente documento tiene por objeto realizar un estudio para el inicio del restablecimiento de la zona 4 a través de la energización de los servicios auxiliares de las unidades de generación de la central Molino mediante las unidades de la central Mazar, a través del circuito 2 de la línea de transmisión Zhoray – Molino a 230 kV. To determine the proposal’s feasibility, relevant tests were carried out in coordination with the CENACE to simulate the Black-out condition, and it was found that approximately 6 minutes is needed to synchronize a dead busbar and energize busbar 2 of the Zhoray substation. The AT2 autotransformer energizing test was not carried out due to equipment problems in the Molino Substation. Para esto es necesario primeramente energizar la subestación Zhoray, posteriormente energizar la Subestación Molino y consecuentemente el Centro de Fuerza Molino de 13,8 kV a través del devanado terciario de los Autotransformadores AT2. Index Terms— Black out, Black Start, Energizing, Auxiliary Services. 1. INTRODUCCIÓN Los sistemas eléctricos de potencia tienen como función suministrar energía a los consumidores con altos niveles de calidad, seguridad y confiabilidad. Al estar conformados por una gran cantidad de componentes que pueden fallar en un determinado momento y de manera aleatoria, el sistema puede enfrentarse a problemas que pueden conllevar un colapso parcial o total del mismo, en el Ecuador también ha sucedido este tipo de colapsos en su sistema por ejemplo en la última década se ha presentado dos ocasiones en los años 2003 [1] y 2004 [2]. Para poder determinar la factibilidad de la propuesta, se realizaron las pruebas pertinentes, en coordinación con el CENACE, para simular la condición de un Black-out, donde se pudo apreciar que el tiempo necesario para sincronizar una unidad en barra muerta y energizar la barra 2 de la subestación Zhoray es de 6 minutos aproximadamente. Cabe señalar que la prueba de energización del autotransformador AT2 no se realizó debido a problemas presentados en uno de los equipos de la subestación Molino. Por tal razón es necesario contar con un plan de emergencia para resolver este tipo de contingencias en el menor tiempo posible. El CONELEC a través de la Regulación No. CONELEC-006/00 [3] establece los procedimientos básicos a seguir ante este tipo de sucesos, así como las jerarquías entre las instituciones encargadas de la coordinación y ejecución de maniobras necesarias para el restablecimiento del mismo. Palabras clave— Black-out, Arranque en negro, Energización, Servicios auxiliares. Abstract— The purpose of this paper is to study the start of restoring processes of the Zone 4 by energizing auxiliary services of the Molino power plant generating units, through the Mazar power plant units, through Circuit 2 of the ZhorayMolino 230 kV transmission line. Entre los procedimientos básicos a seguir se encuentra la conformación de islas eléctricas, dentro de las cuales existen centrales de generación cuyas unidades tienen la característica de “arranque en negro”, además, se establecen los niveles de frecuencia, tensión y circuitos que deben ser considerados ante estas contingencias por parte de los agentes encargados de iniciar el restablecimiento del sistema. In order to do this, it would be necessary firstly energize the Zhoray substation, followed by energizing the Molino substation, and finally the Molino 13.8 kV power supply center through the tertiary windings of the AT2 Autotransformers. 43 En la actualidad la Central Molino al ser la central con mayor potencia de generación, es prioritario que después de un Black-out, se realice la energización de su Centro de Fuerza que alimenta a todos los auxiliares de la Central sin embargo, sus limitaciones tecnológicas actuales incorporan tiempos de arranque en negro considerables (de 20 a 30 min); no así la Central Mazar que con sus características tecnológicas y operativas reduciría estos tiempos a 6 minutos, si se dispone de una unidad lista para arrancar y 13 minutos si se considera la parada y arranque de la unidad, cabe recalcar que estos tiempos son considerados únicamente para la sincronización de barra muerta, a estos tiempos hay que incorporarles el necesario para la ejecución de las maniobras de energización de la subestación Molino y por consiguiente los servicios auxiliares de la central Molino. Tabla 1 : Zona No.4 Molino – Riobamba – Milagro. Fuente: Regulación No. CONELEC-006/00 [3] Procedimientos de despacho y operación Adicionalmente, a más de poseer la característica de arranque en negro, para dar inicio al restablecimiento de la zona, se requiere que las unidades posean sistemas de control de tensión y frecuencia en una red aislada, características que poseen las unidades de la central Mazar, en las cuales los reguladores de velocidad pueden operar en esta cualidad conmutando su modo de control a operación en “Red Aislada” y de esta forma se puede alimentar el centro de fuerza de la central Molino con niveles de tensión y frecuencia adecuados. Figura 1 : Conformación del Subsistema o Zona 4 del SNI [4] Dentro de esta zona la principal central que tiene unidades con capacidad de arranque en negro es la central Paute-Molino unidades que serían las utilizadas para el restablecimiento de la Zona 4 en el caso de presentarse un colapso total del sistema. Como es evidente dentro de este procedimiento no se incluyen las unidades de la central Mazar, que también poseen la característica de arranque en negro y se encuentran junto con la subestación Zhoray dentro de la zona geográfica que abarca la Zona 4. Por lo tanto el presente análisis pretende poner a consideración del CENACE y CONELEC, los procedimientos desarrollados en este estudio para que, de ser pertinente, sean incorporados dentro de los procedimientos para el restablecimiento del SNI después de un colapso total. 2. REVISION DE LA NORMATIVA VIGENTE La Regulación No. CONELEC-006/00 [3] publicada por el Consejo Nacional de Electricidad CONELEC, establece los procedimientos básicos para la restauración del SNI después de un colapso parcial o total, dentro de la misma se establece las disposiciones que los diferentes actores deben cumplir. El Centro Nacional de Control de Energía (CENACE) será el encargado de valorar la situación y coordinar con el COT y COs los pasos o maniobras para el inicio del restablecimiento. El principal objetivo de este procedimiento es conseguir el restablecimiento del SNI en el menor tiempo posible, garantizando la seguridad del personal, equipos y continuidad del servicio, para esto, el CENACE ha definido la conformación de 4 Subsistemas o Zonas Eléctricas, dentro de las cuales deben existir centrales que posean unidades con la característica de arranque autónomo o arranque en negro y que puedan realizar control de frecuencia en forma manual, para el presente estudio la zona de interés es la zona 4, la cual está conformada de la siguiente manera:.Figura 1 : Diagrama del sistema CDI 3. CENTRAL MAZAR La central hidroeléctrica Paute-Mazar a partir del año 2010 inicio su proceso de operación con las dos unidades que la conforman, brindando estas un importante aporte al sistema nacional interconectado. 44 los diferentes parámetros necesarios para garantizar adecuados niveles de tensión, frecuencia, etc. mismos que se describen brevemente a continuación 3.1. Arranque en Negro “Black Start” La Central Mazar posee diferentes fuentes de alimentación para los servicios auxiliares, las cuales son conmutadas de acuerdo a la lógica establecida en SDSC; en condiciones normales, es decir, con la(s) unidades sincronizadas los servicios auxiliares se alimenta de esta(s), o de lo contrario si las unidades se encuentran en reposo, estos se alimentan de las líneas de transmisión a 13,8 kV Presa-Mazar1 o PresaMazar2 provenientes del centro de fuerza de la Presa Daniel Palacios como se muestra en la Fig.2. Control de tensión y potencia reactiva El sistema de excitación de las unidades de la central Mazar permiten realizar el control de la tensión en bornes del generador o la potencia reactiva del mismo a través de su Interfaz Hombre – Máquina (IHM) o desde el SDSC para el control de la tensión, manteniendo los parámetros dentro de los establecidos por la curva de capabilidad del generador. Adicionalmente, desde el SDSC se puede controlar directamente la tensión de la barra correspondiente en la Subestación Zhoray, considerando siempre los márgenes de operación segura del generador. [5] Control de frecuencia y potencia activa. Las unidades de la Central Mazar poseen diferentes tipos de control en el sistema de regulación de velocidad, en el IHM del tablero de control del regulador de velocidad se puede seleccionar cada uno de los diferentes tipos de control, estos se describe brevemente a continuación. Figura 2 : Diagrama unifilar de los servicios auxiliares de la central Mazar Regulación de apertura.- Este modo de control solo es posible con la unidad sincronizada, es decir con el interruptor cerrado y la velocidad dentro de los límites permitidos. La regulación de apertura actúa directamente en el bucle de regulación de posición para los alabes directrices, el valor establecido en la consigna es comparado con el límite de apertura establecido y fija el menor de los dos. [6] En el caso de ocurrencia de un colapso total BlackOut donde no se dispondría de la auto alimentación por medio de las unidades, ni de las líneas provenientes del centro de fuerza de la Presa Daniel Palacios, Presa1 y Presa2, se dispone de un generador de emergencia a diesel GED cuya potencia es de 1MVA con una tensión de 480V, el cual arranca automáticamente 10 segundos después de haber detectado que no hay presencia de tensión en las demás fuentes de alimentación e inicia la toma de carga 30 segundos después. Regulación de potencia.- En este modo de operación, la consigan de potencia es enviada al regulador de velocidad, el cual a través de la curva característica de la turbina (curva de colina) determina la apertura de los alabes directrices para alcanzar la potencia deseada rápidamente, pero debido a las variaciones posibles en la altura neta, no siempre se alcanza la potencia deseada con precisión, por lo cual automáticamente corrige la desviación que pudiera presentarse, este modo de operación se encuentra presente durante la operación normal de las unidades. [6]. Luego del arranque del generador de emergencia y de la confirmación de que exista la presencia de tensión en los servicios auxiliares de la central se podrá realizar el arranque autónomo de la unidad “Black start”. Para la operación del generador de emergencia se dispone de un tanque de reserva de diesel de 5000 galones, que permite garantizar la disponibilidad de combustible para la operación de dicho generador. Detección de red aislada.- Este modo de operación permite monitorear cualquier falla en la red, ya que en régimen interconectado, el regulador de velocidad monitorea constantemente la frecuencia de la red y si se verifica que la turbina está abandonando la banda de velocidad, conmuta automáticamente a este modo y mantiene la velocidad dentro de los parámetros 3.2. Operación Aislada de las Unidades de la Central Mazar. Para la operación aislada de las unidades de la central Mazar se requiere de sistemas que permitan controlar 45 establecidos. Este modo también puede ser colocado por el operador desde el IHM del regulador de velocidad en cuando sea necesario, por lo tanto este modo permite mantener la frecuencia dentro de los parámetros que han sido establecidos en el mismo. 4. SIMULACIÓN DE BLACK-OUT Y PRUEBAS DE SINCRONIZACIÓN DE LA CENTRAL MAZAR Con la finalidad de energizar el Centro de Fuerza Molino para que las unidades de dicha central puedan disponer de una fuente de alimentación para sus servicios auxiliares que les permitan garantizar su proceso de parada y/o re-arranque de sus unidades y continuar con el restablecimiento de la zona 4 del SNI en el menor tiempo posible, se realizaron en semanas anteriores un simulacro coordinado con los diferentes actores para verificar el planteamiento indicado anteriormente. bloqueo, que lleva a las unidades al paro total, debido a la actuación de las protecciones por causas externas, de tal forma que al momento de salir de sincronismo la unidad, la falla desaparezca permitiendo el rearme de las protecciones. De ser el caso, previo a un nuevo arranque de una unidad, la misma debe alcanzar el estado de Unidad Aislada ya que el sistema no permite realizar “re-arranque” cuando se ha presentado la actuación de uno de los relés de bloqueo. Para esto se requiere de un tiempo mínimo de 7 minutos (parada), de acuerdo con estudios realizados, y más el tiempo necesario para el arranque, el tiempo total para sincronizar en barra muerta una unidad oscilaría alrededor de 13 minutos. Luego de energizar una de las barras de la S/E Zhoray, el CENACE y Transelectric coordinan las maniobras de energización de la línea Zhoray – Molino 2, con la intensión de energizar la barra 2 en 230 KV de la Subestación Molino, para esta maniobra se procedió a disminuir al mínimo la tensión del generador 13,1 kV, y debido a las condiciones de configuración de la red fue necesario modificar los setting del regulador de tensión a 94% de la tensión nominal, alcanzando un valor mínimo de 12,9 kV en bornes del generador, maniobra requerida durante la prueba para lograr un valor de tensión adecuado al nivel de barra de alta tensión. 4.1. Energización del Centro de Fuerza Molino, a Través del Circuito 2 de la Línea de Transmisión Zhoray – Molino de 230 Kv. La alternativa planteada considera el circuito 2 de la línea de transmisión que une las subestaciones Zhoray y Molino a 230 kV, el uso del circuito 2, se debe a lo establecido en el Procedimiento de Despacho y Operación, donde se indica que dichos circuitos deben ser usados para el restablecimiento del sistema ya que los circuitos 1 poseen protección de sobrevoltaje. Para esto se energiza la subestación Zhoray, posteriormente se energiza la Subestación Molino y consecuentemente el Centro de Fuerza Molino de 13,8 kV a través del devanado terciario de los Autotransformadores AT1 y/o AT2, el diagrama de interconexión se presenta en la Fig. 3. Previo a energizar la línea Mazar – Zhoray 2, el CENACE, COT y CELEC, realizaron las maniobras necesarias para simular la condición de Black-out en las instalaciones involucradas [7]. Figura 3 : Diagrama de interconexión entre la Central Mazar y el Centro de Fuerza Molino a través de la red de 230 kV Cabe señalar finalmente que debido a ciertos inconvenientes presentados en uno de los interruptores de la subestación Molino la prueba no pudo ser terminada en su totalidad, quedando pendiente para un posterior ensayo verificar y validar el procedimiento de energización de uno de los autotransformadores de la subestación Molino alimentados desde la central Mazar. El tiempo necesario para sincronizar una de las unidades en barra muerta dependerá de las condiciones previas a la ocurrencia del Black-Out, las pruebas se realizaron con las 2 unidades en reposo previo a la simulación y lista para arrancar, en esta condición el tiempo necesario para la sincronización fue de 6 minutos. En el escenario, de que las dos unidades se encuentren sincronizadas al sistema previo a la ocurrencia de la falla y en el instante que se presente la misma se presenta la actuación de uno de los relés de Es importante indicar que la prueba mencionada anteriormente facilito identificar ciertos puntos de mejora en diferentes sistemas de la planta, puntos 46 que fueron analizados, adecuados o mejorados posteriormente, entre estos podemos indicar: • Las maniobras necesarias para energizar la barra 2 de la Subestación Zhoray y la línea de transmisión Zhoray- Molino 2 se realizaron exitosamente. La energización de la barra 2 de 230 kV de la Subestación Molino y de su Autotransformador AT2 no se realizaron debido a inconvenientes presentados durante la prueba. • Determinar si el tiempo de estabilización de la frecuencia del generador es adecuado o de lo contrario realizar los ajustes para mejorar la respuesta del regulador de velocidad, ó a su vez analizar si el rango de frecuencia en estado de emergencia es el apropiado en la normativa. • Realizar los estudios de estabilidad cuando una unidad de la central Mazar se interconecte con la central Molino con baja carga y confirmar que la energización del AT2 de la Subestación Molino desde Mazar no presentaría problemas de ferro-resonancia mediante un análisis eléctrico. • Se debe coordinar con los diferentes actores la realización de nuevas pruebas las que sean necesarias para verificar o validar procedimientos, e identificar puntos de mejora. • Con la validación de las pruebas de arranque en negro de las unidades de la central Mazar y energización de los auxiliares de la central Molino a través de la L/T Zhoray-Molino 230 kV circuito 2 se plantearía este procedimiento como una alternativa para el inicio del restablecimiento de la zona 4 en estado de emergencia. • En el sistema SDSC se desarrolló tres lógicas que permiten al operador mejorar su respuesta ante la presencia de un Black-out en el sistema: • Lógica para detectar condiciones de Blackout en el sistema, la cual presenta al operador una alarma en el despliegue de control de unidades, de tal manera que el operador pueda ser alertado de tal situación. • Lógica para la detección automática de Barra Muerta que permita al operador confirmar esta condición vía comando y realizar el sincronismo de la unidad en Barra Muerta. • Lógica que envía una señal al regulador de velocidad para que este sistema conmute automáticamente a modo de Red Aislada inmediatamente después del cierre del interruptor principal en condición de barra muerta. • Verificación de los setting de los relés de sobre voltaje de las unidades los mismos se encuentran ajustados de acuerdo a las recomendaciones del fabricante 110% 5 seg -130% 0,1 seg para las dos unidades, cabe señalar que el relé de bajo voltaje no se encuentra habilitado. • Se realizaron pruebas de sincronismo en barra muerta de las unidades de generación para verificar la respuesta de los reguladores de velocidad. Se ha determinado que la Unidad 01 presenta mejores condiciones para el control de frecuencia en Red Aislada. La unidad 02 presenta oscilaciones en el control de frecuencia. AGRADECIMIENTOS Agradecemos la colaboración del personal de CENACE, TRANSELECTRIC, HIDROPAUTE por la cooperación brinda durante las pruebas. 5. CONCLUSIONES Y RECOMENDACIONES • Se confirmó la validez de los procedimientos desarrollados para la sincronización en barra muerta de las unidades, y se adecuaron mejoras para confirmar "Barra Muerta" previo a la orden de sincronización desde el SDSC que es inmediato. • El tiempo necesario para arrancar y sincronizar la unidad en barra muerta, bajo el escenario de reposo de la misma durante la falla alcanzó los 6 minutos • Se aprecia que el tiempo necesario para que se estabilice la frecuencia en los valores recomendados es relativamente largo. • La absorción de reactivos durante la energización de los diferentes elementos se realizó con normalidad sin llegar a límites de inestabilidad de la unidad. REFERENCIAS BIBLIOGRÁFICAS [1] Supervisión de Operación Molino., “Informe de falla IF01-2003”. Central Molino. [2] Supervisión de Operación Molino., “Informe de falla IF02-2004”. Central Molino. [3] CONELEC, Regulación No. CONELEC – 006/00, Procedimiento de despacho y operación, 2000. [4] TRANSELECTRIC, SISTEMA NACIONAL DE TRANSMISION, disponible en línea http://190.90.144.25/real/INDEX. asp?zoom2=1 47 [5] Alstom, Manual de Operación y Mantenimiento del Regulador de Tensión, 2010. Vicente Alejandro Llivichuzhca P.- Nació en Cuenca en 1980. Recibió su título de Ingeniero Eléctrico de la Universidad Politécnica Salesiana en 2006. Realizó sus estudios de Maestría en Sistemas Eléctricos de Potencia en la Universidad de Cuenca, y sus áreas de interés e investigación se encuentran relacionadas con la operación económica, planificación con procesos de optimización, operación de centrales eléctricas. Actualmente labora en el área de operación en la Unidad de Negocio Hidropaute de CELEC EP [6] Voith-Siemens, Manual de Operación y Mantenimiento del Regulador de Velocidad, 2010. [7] CENACE, Ficha de Moniobras CENACE No. 101 - 2013, 2013. Miguel Ángel Maldonado O.Nació en Atahualpa – El Oro en 1982. Recibió su título de Ingeniero Eléctrico de la Universidad de Cuenca en 2011. Se encuentra realizando sus estudios de Maestría en Administración de Empresas en la Universidad de Especialidades Espíritu Santo. Actualmente labora en el área de operación en la Unidad de Negocio Hidropaute de CELEC EP. 48 Diseño y Construcción de un equipo para seguimiento solar automático, e implementación de un software de supervisión para un sistema móvil fotovoltaico J. Almeida P. Ayala Escuela Politécnica del Ejercito - ESPE Resumen— El proyecto se basa en habilitar un sistema móvil fotovoltaico, el mismo que cuenta con 3 paneles solares que generan una potencia efectiva de 300W. Se diseñó y construyó un dispositivo de seguimiento solar automático con dos grados de libertad, implementando un software de supervisión el cual sirve para llevar un histórico, que permite obtener las curvas características de funcionamiento y operatividad de los parámetros que intervienen dentro del sistema solar fotovoltaico. Este proyecto aprovecha la energía producida por las células fotovoltaicas, transformando la energía solar en electricidad, que es utilizada en el consumo local y abastecimiento del propio sistema, volviéndose un equipo autónomo. Se implementaron circuitos conversores DC-DC que permiten obtener las curvas características y el correcto funcionamiento del seguidor. El sistema opera con el algoritmo perturbar y observar (Maximum Power Point Tracking, MPPT) para el seguimiento del punto de máxima potencia del sistema fotovoltaico. Index Terms— DC-DC Converter, Maximun Power Point Tracking (MPPT), Mobile Photovoltaic System, Characteristic Curves Palabras clave— Convertidor DC-DC, Algoritmo perturbar y observar (MPPT), Sistema móvil fotovoltaico, Curvas características. El principio físico que rige el funcionamiento de una célula fotovoltaica, puede ser explicado tomando como base una unión p-n de material semiconductor (normalmente silicio) sensible a la luz solar. Cuando ésta incide sobre la unión (generalmente sobre el lado n), los fotones que la constituyen suministran la cantidad de energía necesaria a los electrones de valencia del semiconductor, para romper el enlace que los mantenía unidos a sus átomos respectivos. 1. INTRODUCCIÓN El sol es considerado una de las fuentes de energía más prometedoras, pues se considera una fuente inagotable, debido a esto las tecnologías de aprovechamiento de energía solar han tenido un gran auge en el mercado, donde la tecnología que mayor ha impactado es la fotovoltaica, la cual convierte directamente la energía solar en electricidad [1]. El problema actual es que esta energía sigue siendo aún costosa, ya que la eficiencia de la conversión luz solar - energía eléctrica es aproximadamente entre 9 y 17% en los paneles más comunes del mercado, tomando en cuenta que la eficiencia cambia a lo largo del día, dependiendo de la irradiancia y la temperatura del panel solar. Ambas variables son fundamentales en la generación de energía por dicho panel. Abstract— This project is based on activating a mobile photovoltaic system with 3 solar panels that generates an effective power of 300 W. An automatic solar tracker was designed and built with two degrees of freedom, implementing a monitoring software which keeps a historic record and allows for the creation of characteristic operating and performance curves for the parameters involved in the photovoltaic solar power system. This project makes use of the energy produced by the photovoltaic cells to transform solar energy into electricity, which is consumed locally and supplies the system itself, making it an autonomous system. DC-DC converter circuits were installed to achieve characteristic curves and proper tracker functioning. The system operates with the Perturb and Observe algorithm (Maximum Power point Tracking, MPPT) for tracking the photovoltaic system’s maximum power point. Las celdas fotovoltaicas tienen curvas características V-I que definen el comportamiento de las mismas ante diferentes condiciones de operación. La potencia de una celda solar está dada por el producto de la corriente y el voltaje de la misma. El punto de máxima potencia (MPPT, Maximum Power Point Tracking) es el producto del voltaje en el punto máximo (VMPPT) y corriente en el punto máximo (IMPPT) para los cuales la potencia extraída del arreglo fotovoltaico es máxima (PMPPT). El punto de máxima potencia varía continuamente, pues depende de factores como la temperatura de la celda solar y de las condiciones de irradiancia [2]. 49 Los algoritmos de seguimiento del punto de máxima potencia (MPPT) se utilizan en sistemas fotovoltaicos para maximizar la energía entregada por los mismos, dicho seguimiento se realiza básicamente variando el valor de ciclo útil de un convertidor de potencia. Existen gran variedad de algoritmos de seguimiento de punto de máxima potencia como por ejemplo [3]: perturba y observa, basados en lógica difusa, basado en redes neuronales artificiales, RCC (Ripple Correlation Control) [4], conductancia incremental (INC) [5, 6, 7] entre otros. La juntura entre la capa N (red de carga negativa) y P (red de carga positiva) crea el efecto de un diodo. Cuando la celda fotovoltaica recibe la irradiación solar se obtiene una fuente de corriente constante y las pérdidas eléctricas internas son representadas por una resistencia fig. 3. En los sistemas fotovoltaicos existe la posibilidad de implementar un dispositivo adicional con el fin de aumentar la captación de radiación solar y por ende la energía suministrada por la instalación, tal dispositivo es un seguidor solar. Figura 3: Circuito Eléctrico equivalente de la celda PV [Eckstein, 1990] La fuente de corriente IL es unidireccional y es función de la radiación incidente, temperatura y voltaje. La juntura P-N es representada por el diodo en paralelo con la fuente de corriente, que es atravesado por una corriente interna unidireccional ID que depende de la tensión en las terminales de la celda y la temperatura, la resistencia en serie RS representa las pérdidas eléctricas interna en la celda [8]. Un seguidor solar fig. 1, es un equipo conformado por una parte fija y una móvil, que consta de 2 grados de libertad, cuya finalidad es la de proporcionar una mayor captación de la radiación solar, permitiendo que los paneles se encuentren de manera perpendicular con los rayos de sol durante el día y dentro del rango de movimiento. Una única célula, es capaz de proporcionar una tensión de apenas 0,5V y una potencia entre 1 y 2W. Para elevar la potencia suministrada, las células se conectan en serie y en paralelo, dando lugar a lo que se denomina panel o módulo fotovoltaico. La expresión (1) describe la relación que existe entre la tensión (V) y la corriente (I) entregada por el módulo [9], donde nP y nS son las células conectadas en paralelo y en serie; RP y RS las resistencias intrínsecas paralelo y serie asociadas a la célula, K es la constante de Boltzman (1.38 * 10-23 J/K) y q es la carga del electrón. El factor A determina la desviación de las características de una unión p-n ideal, e IS la corriente inversa de saturación. IL representa la corriente generada por la radiación solar (G). Dicha corriente exhibe una relación respecto de la radiación y la temperatura. Figura 1: Diseño de Seguidor Solar 2. DESARROLLO 2.1. Modelo panel solar El circuito equivalente de una celda PV, tiene su configuración física y sus características eléctricas fig. 2. Figura 2: Esquemático de la celda PV [Townsend, 1989] 50 (1) (2) (3) (4) La expresión (1) (considerando la dependencia de los parámetros con T y G), proporciona las curvas características de I-V de un panel fotovoltaico, y su producto entrega la potencia suministrada. Se muestra en la fig. 4 las curvas de un panel determinado, así como la dependencia de las variables con la temperatura y la radiación solar. En la curva se representa el punto de máxima potencia (Vmppt), indicando el punto óptimo de operación, para un uso eficiente del panel. Puntos importantes de esta curva son la tensión a circuito abierto (Voc) y la corriente de cortocircuito (Isc). La tensión en circuito abierto representa la máxima tensión que proporciona el panel a corriente cero (sin carga), la corriente máxima en cortocircuito representa la máxima corriente que se puede extraer del panel (carga en cortocircuito). Figura 5: Algoritmo Perturbar y Observar. 2.1.2 Análisis Transitorio Se utiliza un convertidor DC-DC para modificar la potencia a la salida de los paneles fotovoltaicos, esta energía será almacenada en un banco de baterías y se utilizará para él funcionamiento del seguidor solar y un conversor DC-AC. SEPIC (Single Ended Primary Inductor Converter) se ha utilizado esta topología porque el voltaje de salida puede ser más alto o más bajo que la entrada, además la salida no es invertida como en el caso de la topología Ćuk. Figura 4: Características I-V y P-V de un panel fotovoltaico. 2.1.1 Algoritmo “Perturbar y Observar (P&O)” El algoritmo de perturbar y observar funciona bajo el siguiente criterio, si el voltaje de operación V, del arreglo fotovoltaico se perturba en cierta dirección y la potencia del mismo incrementa significa que el punto de operación se ha movido hacia el MPPT, por lo que el voltaje de operación deberá perturbarse en la misma dirección, de otra forma si la potencia extraída del arreglo fotovoltaico disminuye, el punto de operación se ha movido en dirección opuesta de la ubicación del MPPT, por lo tanto deberá ser perturbado en dirección contraria a la que tenía [6]. Figura 6: Circuito equivalente de Thevenin de un panel solar conectado a un conversor En la fig. 5 se muestra el diagrama de flujo del algoritmo P&O utilizado, donde la potencia medida (pact) es comparada con la potencia anterior (pant), esto determina si aplica la misma perturbación (pert es una variable binaria que indica la dirección de la perturbación) o se deberá invertir en el siguiente ciclo. La variable step representa el tamaño de la perturbación y pwm es el valor del ciclo útil utilizado. Figura 7: Diseño del conversor Sepic El circuito Sepic fig.7 funciona en modo de corriente del inductor discontinuo (DICM) o el modo de tensión del condensador (DCVM). Este tipo de convertidor tiene la particularidad que la resistencia de entrada 51 es proporcional a la conmutación de frecuencia. Por lo tanto, mediante el ajuste del ciclo de trabajo del interruptor principal, se puede hacer que la resistencia de entrada del convertidor sea igual a la salida, obteniendo una salida equivalente a la del panel. Esto asegura la máxima transferencia de potencia. En la fig.6 el convertidor que está conectado al panel solar es un SEPIC operando en DICM o DCVM [10], [11]. El diodo se encuentra polarizado en sentido inverso, por lo que la corriente a través del mismo es , y la tensión entre sus terminales es Mientras que el transistor al estar activo posee una tensión VQ = 0 una corriente igual a la del inductor de entrada L1 iQ =iL1 . Este circuito, se analiza entre los dos estados de conducción del transistor Mosfet, en estado encendido y estado apagado. Para eso, se tendrá en cuenta el ciclo útil de trabajo de la señal PWM que es usada para disparar el transistor en los diferentes modos de conducción. Estado del Mosfet apagado (DT < t < T) El siguiente paso es analizar cuando el transistor está apagado, obteniendo el circuito que se muestra en la fig.9. Durante este momento, las corrientes a través de los inductores L1 y L2 actúan como fuentes de corriente obligando al diodo a polarizarse en forma directa. Estado del Mosfet encendido (0 < t <DT) Durante este periodo de trabajo, el transistor es activado, obteniendo el circuito equivalente que se muestra en la fig.8, con sus respectivas tensiones y corrientes. Durante este proceso, el inductor L1 es cargado con la tensión de la fuente de entrada, mientras que el inductor L2 es cargado con la energía almacenada por el condensador C1. Adicionalmente la carga se encuentra aislada de la tensión de entrada y es alimentada con la energía almacenada en el condensador de salida C2: Figura 9: Sepic transistor apagado La tensión en las terminales del inductor L2 es igual a La tensión a través del inductor L1 está determinada por la relación (5) La tensión que aparece a través del inductor L2 es igual a (6) (10) Una vez obtenido el voltaje en el condensador en términos de tensiones más conocidas, se halla el valor de la tensión en el inductor L1, recordando que la tensión de un condensador no puede cambiar de manera abrupta. Por medio de la ley de conservación de energía aplicada en la primera malla, la ecuación resultante es: Finalmente, la corriente que circula sobre el condensador de salida es igual a (9) Recordando que la tensión media en un inductor es igual a cero durante un ciclo en régimen permanente, hallamos la tensión del inductor en el estado encendido (que es el mismo del condensador C1) en términos de alguna tensión más conocida del circuito: Figura 8: Sepic transistor activado (8) (7) 52 (11) Y recordando que la tensión media de un inductor es cero durante un ciclo en régimen permanente, llegamos a la expresión: A partir del valor mínimo de corriente sobre el inductor podemos calcular la inductancia mínima para que el circuito opere en modo de corriente continua, hallando así el límite en el que puede operar el circuito entre modo continuo y discontinuo. Para eso, el mínimo valor de corriente que puede tener el inductor es cero, despejando allí la inductancia mínima: (12) (13) Usando la expresión anterior, es fácil ver que se pueden simplificar algunas tensiones ya obtenidas, dando como resultado que El siguiente valor a calcular es el inductor L2, el cual debemos asegurarnos que también trabaje en modo corriente continua por simplicidad del circuito. Procedemos a calcular primero el valor medio de corriente sobre el mismo. Si recordamos, durante el ciclo de encendido, la corriente sobre L2 es la misma del condensador C1 pero en sentido inverso, es decir iL2 = -iC1, y en estado de apagado, la corriente es igual a iL2 = -iD - iC1, donde además la corriente en el diodo es igual iD = -iC2 + i0 a como se ve a la salida del circuito de la fig.9. Recordando que la corriente promedio a través de un condensador es igual a cero, es fácil llegar a deducir que la corriente promedio del inductor L2 es igual a la corriente promedio de la carga, en otras palabras IL2 = I0. Por lo que los valores máximo y mínimo de la corriente son: (14) Al encontrarse el transistor apagado, la corriente por el mismo es igual iQ = 0 mientras que la tensión entre sus terminales es igual a (15) La corriente de polarización en el diodo depende de las corrientes de los dos inductores L1 y L2, y por medio de la ley de corrientes en un nodo es igual a i = i +i . La tensión sobre el diodo en este estado L1 L2 D es igual a VD = 0 en el caso ideal, suponiendo que no cae ninguna tensión sobre el diodo cuando se polariza en directo. La corriente promedio del inductor de entrada L1 es igual a la corriente promedio de entrada del circuito o entregada por la fuente de alimentación IL1 = II . Considerando que en el sistema no existen perdidas, la potencia de entrada es igual a la potencia de salida, por lo que se puede obtener: (18) Donde fS es la frecuencia de conmutación del transistor. Claramente se ve que para calcular esta inductancia mínima, se debe considerar la carga que entregue el mínimo valor de corriente de salida sin llegar al caso extremo de circuito abierto, así como el valor de ciclo útil que pueda ser crítico. De donde se despeja la función de transferencia de la función, es decir: (17) (19) Realizando el mismo procedimiento para L1, la corriente mínima la igualamos a cero para calcular el valor mínimo del inductor L2: (16) Y con el valor anterior, se calcula los valores máximo y mínimo de la corriente sobre el inductor L1: (20) Donde RL es la carga de salida que se colocara a la salida del convertidor. 53 La forma de onda de corrientes y tensiones de todos los elementos se observa en la fig. 10. (23) Por lo que el condensador es igual a: (24) El circuito Sepic, es usado en aplicaciones de corrección de factor de potencia, sin embargo posee gran ventaja sobre este último en que la tensión de salida puede llegar a ser menor que la tensión de entrada, lo que lo hace muy llamativo para la aplicación de cargador de baterías. Presenta una fácil implementación y aislamiento entre la entrada y la salida, y un menor rizado de corriente de entrada a altas frecuencias. Sin embargo, una mejora de este circuito puede ser obtenida acoplando los dos inductores vistos bajo un mismo núcleo, teniendo la posibilidad de aumentar la eficiencia en un 2% y reduciendo la emisión de ruido, lo que conlleva a simplificar el filtro de entrada del convertidor. 3. SIMULACIÓN Se utilizó el programa de matlab para realizar la simulación del convertidor en cuestión. Figura 10: Formas de Onda De la fig.10, se calcula los valores de los condensadores a partir de las áreas que se muestran. Comenzamos calculando el valor del condensador C1, recordando que durante el ciclo de apagado del transistor, la corriente sobre C1 es la misma que circula por L1. Si observamos que el área de corriente de C1 durante el ciclo de apagado del transistor es un trapecio con alturas iguales al valor mínimo y máximo de la corriente del inductor L1, el diferencial de carga que es el área bajo esta curva es igual a: Y recordando la definición de capacitancia despejando C1 se tiene el valor de: (21) Figura 11: Sistema Fotovoltaico con control MPPT , (22) Finalmente, para el condensador de salida C2, durante el estado de encendido del transistor, la corriente sobre C2 es la misma de la carga pero en sentido inverso, luego el diferencial de carga obtenido es igual a Figura 12: Circuito conversor SEPIC 54 644pa. El bobinado se lo realizó con el cable Litz, un cable de 100 hilos esmaltados con capacidad de 7 [A] en bobina. Figura 13: Respuesta de Voltaje Figura 16: Modelo Arnold MS-226060-2 Cable Litz Estos tipos de cables se utilizan fundamentalmente para: conversión de energía, emisión y recepción en alta frecuencia, electrónica de potencia, detectores de proximidad inductiva, etiquetas electrónicas, equipos de transmisiones telefónicas múltiples, uniones flexibles para relais, bobinas, transformadores, motores, etc. Figura 14: Respuesta de Corriente Figura 15 : Respuesta de Potencia Se usó un panel fotovoltaico Isofotón I-110, que tiene una tensión nominal 12V, una potencia máxima de 110W, corriente de cortocircuito 6.54A, tensión de circuito abierto 21.6V, corriente de máxima potencia 6.1A, tensión de máxima potencia 17.4V. Figura 17 : Inductor bobinado con cable Litz Montaje: De lo dispuesto en la simulación se consideró el capacitor de 50[V]. Además transistores mosfet IRFB52N15D con sus respectivos disipadores, diodos ultrarápidos hfa15tb60, la resistencia de carga es el cargador de baterías, ya que la energía entregada por el panel se implementa para cargar la batería. Inductor L1 = 1mF, L2 = 300uF, C1=100uF, C2=1000uF, frecuencia de 73 kHz y ciclo de carga del 50% regulado por el control de MPPT. 4. IMPLEMENTACIÓN 4.1. Convertidor SEPIC DC-DC Para la implementación del prototipo del convertidor se han seleccionado los componentes basados en el estudio y desarrollo de la simulación de tal forma que los componentes son los siguientes: Bobina: Se utilizó un toroide de núcleo de hierro pulverizado fig.16 por sus características para trabajar en altas frecuencias (máx. 500 kHz), ya que trabaja a una frecuencia de 73Khz entregada por el AVR Figura 18 : Implementación del convertidor DC-DC Sepic 55 4.2. Control MPPT Este comportamiento es una ventaja, ya que el panel es una fuente variable de energía, y cuando existe una caída de tensión se regula la salida, para que el sistema no exija más energía de la que puede entregar el panel y en cambio se alimente de las baterías. Para la implementación del control se hizo por separado de la etapa de potencia, el circuito permite la activación de los mosfet, mediante el uso del integrado tlp250, por otro lado, se tiene una pantalla gráfica TFT HY32D 3.2” donde se muestran las curvas de funcionamiento del panel, tanto en voltaje, corriente y potencia. En el circuito de potencia del conversor se tiene un sensor de corriente ACS715-20 que contiene un circuito de acondicionamiento entregando una señal de 0 [V] a 5 [V] captada por el microcontrolador AVR, el mismo que contiene el control de la pantalla. La correcta implementación de un convertidor DCDC en este caso Sepic facilitó el funcionamiento del sistema, tanto para el almacenamiento de energía como para el consumo. Una ventaja del convertidor Sepic es que puede trabajar en voltaje o en corriente, dependiendo las características del sistema. Una ventaja de utilizar el control MPPT (Seguidor del Punto de Máxima Potencia), es que este varía en función de los parámetros de funcionamiento del panel, otorgando una eficiencia mayor al sistema y disminuyendo las pérdidas. Una desventaja del circuito Sepic es su eficiencia, ya que varía entre el 70% y 90%, esto básicamente es por los elementos de trabajo y por el período de conmutación del sistema. Figura 19: Placa de control y pantalla gráfica 4.3. Montaje Completo El tener un sistema de posicionamiento manual, os permite observar la variación de la potencia entregada en el panel solar, a una determinada hora y ubicación, a diferencia de un sistema estático. Se observa en la fig. 20, el montaje en su totalidad del controlador, este posee una pantalla para visualizar el comportamiento de las curvas, adicional se almacenan en una tarjeta Sd card la cual entrega un registro de los datos, posee un sistema de seguimiento manual, implementado mediante un joystick el que nos permite seleccionar el movimiento y que eje es el que va a moverse, esto se visualiza en el Lcd 16x2. El almacenamiento de datos, permite al usuario, tener una referencia real, del funcionamiento del sistema en determinado periodo de tiempo o en todo el tiempo, dependiendo el requerimiento del usuario. El sistema es muy amigable y fácil de utilizar, no requiere mucho conocimiento, adicionalmente como es autónomo no necesita energía externa. 6. REFERENCIAS BIBLIOGRÁFICAS [1] Rashid Muhammad H. and Lana Char “Solar Power Conversion” Power Electronics Handbook, Capítulo 26, pp. 661 – 672, Academic Press, Segunda edición, 2007. Figura 20: Sistema Adquisidor y control del Seguidor Fotovoltaico [2] N. Femia, G. Petrone, G. Spagnuolo and M. Vitelli “Optimizing Duty-cycle Perturbation of P&O MPPT Techinque” Power Electronics Especialists Conference, 2004. PESC 2004. 35th Annnual. vol. 3, pp 1939 – 1944, 20 –25 Junio 2004. 5. CONCLUSIONES Y RECOMENDACIONES El voltaje y corriente de salida del convertidor está en función de la variación del ciclo de trabajo de la señal que conmuta los transistores y sólo de ese valor, de tal forma que para D < 0.5 se comporta como reductor y para D > 0.5 se comporta como elevador. 56 [3] Trishan Esram and Patrick L. Chapman “Comparision of Photovoltaic Array Maximum Power Point Tracking techniques”, IEEE Transactions on energy conversion, vol 22 (2), Junio de 2007. [9] J.A. Grow, C.D. Manning : “Development of a photovoltaic array model for use in powerelectronics simulation studies”. IEE Proc. On Electric Power Applications, vol. 146, no. 2, pp, 193-200, March 1999. [10] Lin and Y. Lee, “Power-factor correction using Cuk converters in dis-continuous-capacitorvoltage mode operation,” IEEE Trans. Ind. Electron., vol. 44, pp. 648-653, Oct. 1997. [11] D. Maksimovic and S. Cuk, “A unified analysis of PWM converters in discontinuous modes,” IEEE Trans. Power Electron., vol. 6 pp. 476490, Mar. 1991. [4] Trishan Esram and Patrick L. Chapman “Comparision of Photovoltaic Array Maximum Power Point Tracking Arrays Using Ripple Correlation Control” IEEE Transactions on Power Electronics, vol. 21 (5), Septiembre 2006. [5 ] Chad Alberts, Justin Brown, Rpbert Button, Anna Flower and Srinivasa Vemuru “Solar Array Peak Power Tracker”, American Socierty, 31 Marzo de 2006 – 1 Abril 2006. Edison Javier Almeida Baroja.Egresado de la carrera de Ingeniería en Mecatrónica Universidad de las Fuerzas Armadas (ESPE). [6] Dezso Sera, Tamas Kerekes, Remus Teodorescu and Frede Blaabjerg “Improved MPPT algorithms for rapidly changing enviromental conditions”, Power Electronics and Motion Control Conference, 2006. EPE-PEMC 2006, pp 1614–1619, 12th International. 30 Agosto 2006 1 Septiembre 2006. [7] J. Kouta, A. El-Ali, N. Moubayed, and R. Outlib “Improving the incremental conductance control method of a solar energy conversion system”, International Conference on Renewable Energy and Power Quality (ICREPQ'08), Santander, Spain, March 12-14 2008. [8] Castro, Energias Renováveis e Producao Descentralizada, Introducao a energía fotovoltaica, Rui M.G. Castro, Universidad Técnica de Lisboa, 2004. Jaime Paúl Ayala Taco.Ingeniero Electrónico graduado en la Escuela Politécnica del Ejército (ESPE) en 1997, obtuvo su MBA en la ESPE en 2000 y su maestría en Mecatrónica en la Universidad Politécnica de Cataluña-España en 2004. Actualmente es candidato a Doctor en Ciencias en Automática y Controles por la CUJAE Cuba. Su campo de investigación se encuentra en los accionamientos estáticos y control avanzado e inteligente en aplicaciones de electrónica de potencia.. 57 Generación Eólica en Ecuador: Análisis del Entorno y Perspectivas de Desarrollo E. A. Barragán Universidad Politécnica Salesiana - Universidad Católica de Cuenca Resumen— Se investiga cuáles son los factores clave para propiciar el desarrollo de la generación eólica en el Ecuador, para ello se analizaron las condiciones financieras y económicas locales. Se determina si los precios de generación no convencional, establecidos en el Ecuador para la energía eólica son atractivos para que un proyecto de este tipo pueda ser financieramente sostenible en el tiempo. La estimación se la realiza utilizando los índices financieros como el Valor Actual Neto y la Tasa Interna de Retorno. Además se hace un análisis de sensibilidad para determinar cómo se modifican estos índices al variar el precio de la energía, el factor de planta o la tasa de descuento, entre otros. termoeléctrica. A más de ello, la creciente posibilidad de financiar proyectos vinculados a las energías renovables a través del Mecanismo de Desarrollo Limpio (MDL), hacen ver un posicionamiento cada vez más interesante de las fuentes de generación no convencionales en el Ecuador. En el caso de la energía eólica, se encuentran en construcción y evaluación varios proyectos que entrarán a despachar energía en el Sistema Nacional Interconectado (SNI) en los próximos años. En los registros estadísticos mundiales referentes a potencia eólica disponible, se indica que mientras en el año 1992 se tenían 2 278 MW instalados, en el 2012 esta cifra subió a 282 275,300 MW. Estos datos demuestran que esta tecnología está siendo considerada en los horizontes energéticos de los países desarrollados. En el caso Latinoamericano, Brasil, México y Costa Rica, tienen la mayor cantidad de potencia, sin embargo todavía no es comparable con los países que tienen los primeros puestos en potencia instalada, como Estados Unidos, China y Alemania [1]. La potencia instalada existente en Latinoamérica, aunque marginal en comparación al total mundial, contrasta con el potencial posible de instalar, y con los proyectos que se encuentran en diferentes fases de desarrollo. Por ello se prevé un importante incremento de la generación eólica en Latinoamérica, y en particular en el Ecuador. La Fig. 1, indica el posicionamiento a nivel mundial de diversos países en relación a la potencia instalada. Palabras clave— Energías renovables, energía eólica, análisis financiero, sostenibilidad energética. Abstract— Local financial and economic conditions were analysed in order to research the key factors for favouring the development of wind power generation in Ecuador. This determines whether the non-conventional generation prices, established in Ecuador, for wind energy are attractive enough for a project of this type to be financially sustainable over time. The estimate is performed using financial indices such as the Net Present Value and the Internal Return Rate. A sensitivity analysis was also performed to determine how these indices are modified with variations in the energy price, plant factor or discount rate, among others. Index Terms— Renewable Energies, Wind Energy, Financial Analysis, Energy Sustainability. 1. INTRODUCCIÓN En el Ecuador se están dando pasos para que la matriz de generación de energía eléctrica se diversifique. Según el Ministerio de Electricidad y Energía Renovable del Ecuador (MEER), hasta el año 2020, se prevé un escenario de potencia instalada de al menos 80% de hidroelectricidad, complementado por un 10% de otro tipo de energías renovables (solar, eólica, geotérmica, etc.) y el resto por generación Figura 1: Comparativa de la potencia instalada en el año 2012] 58 permitirán garantizar la continuidad de funcionamiento de la central eólica. La metodología utilizada se la conoce como "Método Dinámico de Selección de Inversiones", y considera el valor del dinero con el paso del tiempo. De esta manera se establecen parámetros que permiten comparar una inversión en términos del valor actual. Así, se comparan todos los beneficios con todos los costos en los que se incurrirá a lo largo de la vida útil del proyecto. Desde un punto de vista financiero, la central debería realizarse sólo si los beneficios son mayores que los costos. 2. JUSTIFICACIÓN DEL TRABAJO La energía de las centrales de generación, con fuentes consideradas como no tradicionales, en Ecuador tienen un precio preferencial [2]. En este trabajo se analiza si los precios de energía para la generación eólica son atractivos, y mediante un análisis de sensibilidad, se determinan los factores que influyen al momento de realizar un proyecto de este tipo. Estos estudios son comunes, tal como se indica en [3] y [4], sin embargo es indispensable realizar una particularización para la realidad local. Como los costos y beneficios varían año a año, estos son actualizados a una misma tasa de descuento al primer año del proyecto. Esta metodología utiliza los siguientes conceptos [5], [6], [7]: En España, por ejemplo, se ha definido que los costos por kW instalado de potencia eólica han tenido un descenso significativo básicamente por tres factores: • Tasa de descuento (r): es una medida financiera que se aplica para determinar el valor actual de un pago futuro. Puede ser real o nominal, según se considere o no la inflación. • Valor actual neto (VAN): Es la diferencia entre el valor actual y el desembolso inicial, dada por (1). • Economía de escala: fabricación en serie de aerogeneradores. • Tamaño de las unidades: aerogeneradores con mayor potencia por turbina, permiten una mejor ocupación del terreno, menor peso específico de los equipos u otros factores que significan menos costes por kW instalado. • Aumento de la oferta tecnológica: mayor cantidad de marcas dan lugar a una mayor competencia, y a mayor gama de soluciones, que a la larga permiten rentabilizar mejor un proyecto. (1) Donde A, es el desembolso inicial; Qi, son los flujos de caja en un periodo i; r, es la tasa de descuento. Una inversión será aceptada si el VAN es mayor o igual a cero (punto en el cuál la inversión devuelve la tasa deseada). Mientras mayor es el VAN, más atractivo es el proyecto en términos financieros. El Ecuador aunque no es fabricante de estas infraestructuras, puede ser beneficiario de la reducción de costos en la construcción y operación de las mismas. Para potenciar el desarrollo de estas tecnologías, es ineludible determinar convenientemente los precios de la energía, para que los inversores tengan asegurada una rentabilidad o para definir si es necesario mecanismos que viabilicen estos proyectos. • 3. METODOLOGÍA UTILIZADA Tasa interna de retorno (TIR): es la tasa de descuento que hace que el VAN sea igual a cero. Una tasa de descuento será aceptada si es mayor o igual al costo de oportunidad del dinero (es decir el mejor uso alternativo si no se invierte en el proyecto). 4. CONDICIONES PARA EL ANÁLISIS FINANCIERO DE UNA CENTRAL EÓLICA EN EL ECUADOR El estudio financiero de todo proyecto se realiza con el fin de orientar la decisión de ejecutarlo o no. Básicamente corresponde a un análisis de costos y beneficios, que ocurren en diferentes periodos de tiempo. A este análisis se lo conoce como Evaluación Financiera de Proyectos y va de la mano con una evaluación económica, ambiental, institucional y legal [5], [6], [7]. Para la evaluación financiera se requiere identificar los costos, beneficios y los años en que se efectúan cada uno de ellos, así como los incentivos que considera la normativa ecuatoriana. Sin duda la falta de datos puede ocasionar errores en los resultados que se obtengan. A continuación se indican los datos y las fuentes utilizadas, tratando de que sean lo más reales, para evitar distorsión en el análisis. El análisis financiero, permite determinar el flujo real de dinero que se requiere para el proyecto y busca prever si se recuperará o no la inversión, pagándose además los costos de operación y mantenimiento que 59 25% aceptable y superior a 30% bueno [7]. El factor de planta (FP) para generación eólica se lo puede relacionar con la velocidad del viento, utilizando las curvas de potencia de los aerogeneradores. El FP por tanto es crucial para determinar la viabilidad de un proyecto, pues es un indicador de la energía que una central eólica podría generar. Además se puede considerar una disponibilidad técnica entre 90% y 95%, y pérdidas por los circuitos en las líneas y transformador del 4 %, además de pérdidas por el efecto sombra (si se colocan las turbinas en conjunto) de alrededor del 5 % [7], [9], [10]. 4.1. Tiempo de vida útil El tiempo de vida útil de un aerogenerador es de 20 a 25 años, sin considerar repotenciación [3], [5], [7], [8]. 4.2. Potencia instalada Un parque eólico puede estar formado por un gran número de aerogeneradores, siendo el límite principal la potencia que se instale y el recurso existente. La Regulación CONELEC 004/11 (“Tratamiento para la Energía Producida con Recursos Energéticos Renovables No Convencionales), establece que en el caso de las tecnologías no renovables, como las centrales eólicas, se reconocerá un precio de energía preferencial para centrales de generación, salvo para la energía hidroeléctrica para la cual se define un límite de potencia (50 MW). 4.6. Precio de la energía La Regulación CONELEC 004/11, establece los precios de energía de la generación eólica en 9,130 ¢USD/kWh. La vigencia de los precios será de 15 años a partir de la fecha de suscripción del título habilitante, (31 de diciembre de 2012, según la regulación utilizada). Cumplido el periodo de vigencia, las centrales renovables no convencionales operarán con un tratamiento similar a cualquier central de tipo convencional, de acuerdo a las normas vigentes a esa fecha. Sin embargo se anota como particularidad que el precio de venta de la energía de estas centrales después de concluido el periodo de precios preferente, podrá negociarse según la normativa que esté vigente. Considerando esto se asumen dos precios en el análisis, uno hasta los primeros 15 años, y luego se establece un precio estimado después de este periodo. El segundo precio se considera como 4,680 ¢USD/kWh; obtenido a partir del precio promedio vigente en el año 2011 , y considerando que se ha incrementadoexclusivamente por la influencia de la inflación (3,330 % para el año 2010). 4.3. Costo del kW instalado El costo instalado de una central eólica depende de varios factores, por ejemplo en Europa, el costo de potencia instalada por kW varía dependiendo del país y está comprendido entre 1 000 €/kW a 1 350 €/kW . El rango de variación además depende de la tecnología, tamaño de las máquinas, complejidad geográfica y topográfica o distancia a la red [3]. 2 Los costos de los proyectos eólicos en el Ecuador varían en un rango amplio, por ello no es fácil establecer un costo promedio para el caso ecuatoriano, y más bien los datos reales dependen del análisis que se efectúen en cada caso [9]. 3 4.4. Tiempo en la ejecución del proyecto La construcción de un parque dependerá de varios factores. En el caso ecuatoriano los proyectos analizados de 5 a 50 MW, tienen un tiempo de ejecución entre uno y dos años [9]. 4.7. Pago adicional por transporte En la Regulación 004/11, no se consideran pagos adicionales de transporte. Sin embargo, se efectúa el análisis de sensibilidad asumiendo, que, a los precios fijados para la energía medida en el punto de entrega, se sumará un pago adicional por transporte, únicamente en el caso de requerirse la construcción de una línea de transmisión. Esta consideración se la hace tomando en cuenta que las anteriores regulaciones incluían un pago adicional por transporte de 0,060 ¢USD/kWh/ km, con un límite máximo de 1,500 ¢USD/kWh [2]. 4.5. Factor de planta Es la relación entre la energía producida en un determinado periodo, respecto a la potencia asignada al generador en dicho periodo. Se debe anotar que los factores de planta de los aerogeneradores en operación suelen estar entre el 30% a 40%, siendo mayor a 1 2 Para la elaboración de este documento se consideró esta regulación, y no la Regulación para la Participación de los Generadores de Energía Eléctrica producida con Recursos Energéticos Renovables No Convencionales (Regulación No. CONELEC 001/13), actualmente vigente. 3 Los costos presentados son mencionados en el informe “The Economics of Wind Energy”, de la Asociación Eólica Europea, del año 2009. 60 Los costos medios de generación vienen dados por resoluciones emitidas por el CONELEC. Por ejemplo según la Resolución Nº 013/11, del 17 de marzo de 2011, el costo medio de generación para el periodo enero – diciembre 2011 fue de 4,653 ¢USD/kWh. además se asume un incremento anual del 3,330%, por la inflación. Hay otras referencias en las cuáles se indica que los costos son del 20% de la facturación anual [6]. 4.8. Ingresos por el Mecanismo de Desarrollo Limpio (MDL) El MDL, contenido en el Artículo 12 del Protocolo de Kyoto, permite a los gobiernos o entidades privadas de países industrializados implementar proyectos de reducción de emisiones en países en desarrollo, y recibir créditos en la forma de "certificados de reducción de emisiones", o CREs, los cuáles pueden ser contabilizados dentro de sus objetivos nacionales de reducción. 4.10. Impuesto a la renta Según el Código de la Producción , en el artículo 24, numeral 2, se establece que a los sectores que contribuyan al cambio de la matriz energética, se reconocerá la exoneración total del impuesto a la renta (IR) por cinco años a las inversiones nuevas que se desarrollen en estos sectores. Según la disposición reformatoria segunda a la Ley Orgánica del Régimen Tributario Interno, se indica que esta exoneración contará desde el primer año en el que se generen ingresos atribuibles directa y únicamente en lo correspondiente a la nueva inversión. Su aplicación se la realizará, entre otros, a los sectores económicos prioritarios en los cuáles se incluye a las energías renovables. 6 Si se considera que el proyecto es aplicable para ser aprobado como un proyecto MDL, podrá ser financiado con créditos de carbono. El aporte que se recibirá estará determinado por la cantidad de dióxido de carbono equivalente (CO2eq) que es capaz de desplazar. El financiamiento se lo calcula en función de las toneladas de CO2eq, evitadas que tienen una correspondencia en CREs, siendo cada tonelada igual a un CRE. 4 Se debe estimar la reducción de emisiones de CO2, producidas por la generación que entre a operar en el SNI. El objetivo es determinar las toneladas de CO2, con un factor de emisión (FE), como se indica en (2): RE=FE ×E El artículo 9 de la Ley de Régimen Tributario Interno anota que las instituciones públicas serán exentas al pago del IR. Mientras que para sociedades , el Código de la Producción, indica que el IR será de 22 % sobre la base imponible. 7 (2) 4.11. Amortización Donde RE, son las reducciones evitadas de CO2; en toneladas; FE , es el factor de emisión en toneladas de CO2/MWh. E; es la energía que se espera que genere la central eólica en MWh. Con el propósito de determinar la base imponible sujeta al IR, se deducen los gastos que se efectúen con el propósito de obtener, mantener y mejorar los ingresos de fuente ecuatoriana que no estén exentos. 5 Luego con el valor de los CREs se puede calcular el total de ingresos por este concepto. Así se aplican una serie de deducciones, entre las cuáles se tiene la depreciación y amortización, conforme a la naturaleza de los bienes, a la duración de su vida útil, a la corrección monetaria, a la técnica contable así como a las que se conceden por obsolescencia. Estableciéndose para instalaciones, maquinarias, equipos y muebles un 10 % anual, o lo que equivale a una depreciación de 10 años, en valores constantes (Inversión / 10)8. 4.9. Costes de explotación Los costes de explotación pueden incluir seguros, impuestos, alquiler de terrenos, gestión administrativa, operación, mantenimiento y/u otros. La experiencia en el Ecuador con respecto a los valores de estos costos es prácticamente nula, por lo que se utiliza información de fuentes bibliográficas. Estos costos se suelen presentar en USD/kWh o en porcentaje de la inversión. En el primer caso puede estar en el rango de 0,014 a 0,018 $USD/kWh [3], [7]. En el segundo caso, se estima que representa entre el 3,3% al 5% de la inversión en cada año [5]. Esta última estimación, sin embargo, considera que los costos son independientes del régimen de operación de la central. Se considera el primer caso para realizar el estudio financiero, 4 5 Entre las reformas que introduce el Código de la Producción, a la Ley Orgánica de Régimen Tributario Interno, se indica que la depreciación y amortización que corresponda, entre otras a la adquisición de mecanismos de generación de energía de fuentes renovables (solar, eólica o similares) y a la reducción de emisiones de gases de efecto invernadero, se 6 7 El CO2eq, representa la equivalencia en CO2 de cualquier otro gas de efecto invernadero En el caso ecuatoriano para el periodo 2007-2009, se estimó el FE del SNI para proyectos eólicos en 0,629 toneladas CO2/MWh 8 61 R. O. 351, del 29 de diciembre de 2010 Personas jurídicas que realizan actividades económicas que pueden ser privadas o públicas, de acuerdo al documento de creación. Fuente: www.sri.gob.ec Artículo 25. Reglamento para la Aplicación de la Ley Orgánica de Régimen Tributario Interno. Decreto N°1051, R. O. 337 de 15 de mayo de 2008. deducirán con el 100% adicional, previo existir una autorización por parte de la autoridad competente. Además se indica que no podrá superar un valor equivalente al 5% de los ingresos totales. la tasa de interés activa, y adicionalmente se considera el efecto de la inflación. Es decir se emplea la tasa de interés real que se determina mediante (4) [12]. 4.12. Impuesto al valor agregado (4) donde ia, es la tasa de interés (activa); π, es la inflación.r, es la tasa de interés real. La Ley del Régimen Tributario Interno9, artículo 56, indica que el servicio público de energía eléctrica está gravado con tarifa cero, en lo que al Impuesto de Valor Agregado (IVA ) se refiere. Además, en el Reglamento de Aplicación de la Ley del Régimen Tributario , se estipula en el artículo 177 que se comprende como servicio de energía eléctrica entre otras fases a la generación. La tasa ia, para este tipo de proyectos es preferible que no sea la que da la banca privada ecuatoriana , pues suele ser mayor si se compara con las que dan los organismos internacionales de crédito. Por ejemplo el Banco Interamericano de Desarrollo (BID), ofrece tasas de alrededor del 5% . 4.13. Tasa de descuento 4.15. Apalancamiento La tasa de descuento utilizada en un flujo financiero corresponde a la rentabilidad que un inversionista exige a una inversión, al renunciar a un uso alternativo de los recursos. La Superintendencia de Compañías del Ecuador, la define como el tipo de interés que se utiliza para calcular el valor actual de los flujos de fondos que se obtendrán en el futuro. Cuanto mayor es la tasa de descuento, menor es el valor actual neto. El apalancamiento es el uso de endeudamiento para financiar una operación (Deuda Financiera Neta/ [Patrimonio Neto + Deuda Financiera Neta]). Esto implica que el proyecto no se realiza necesariamente con recursos propios. 10 14 11 15 5. ANALISIS DE SENSIBILIDAD La técnica contable estipula la valoración anual, que se muestra en la Tabla 1, con el fin de determinar los flujos de caja desde el año en que se comienza la producción. Para calcular la tasa de descuento, se determina el costo ponderado de capital (Weighted Average Cost of Capital, WACC) , que es un promedio de los costos relativos a cada una de las fuentes de fondos del proyecto, y se define por (3) [11], [12]: 12 Tabla 1: Rubros considerados en el Flujo de Caja (3) Donde E/A , es el porcentaje de capital propio utilizado en el proyecto; D/A, es el porcentaje de préstamo utilizado en el proyecto; kd, es el costo de la deuda, y se debe al hecho de que el préstamo deberá desembolsarse en una fecha futura. 13 4.14. Tasa de interés La tasa de interés es el porcentaje al que está invertido un capital en una unidad de tiempo. Se utiliza para determinar los pagos que se deberán hacer anualmente en un periodo determinado (se asumen 10 años para este estudio) a la entidad que financie el parque eólico. En el caso de un préstamo se considera 9 R.O. 242, 29 de diciembre de 2007 10 El impuesto al valor agregado (IVA), grava al valor de la transferencia de dominio o a la importación de bienes muebles de naturaleza corporal, en todas sus etapas de comercialización, y al valor de los servicios prestados 14 En el año 2010, las tasas activas oscilaron entre el 8,640 % al 9,130 %.. 15 Las tasas de interés del BID, están basadas con la Tasa de Interés Basada en LIBOR 11 Decreto Ejecutivo 1051, R.O.15 de mayo de 2008. 12 La Regulación CONELEC 003/11, indica también la forma de cálculo del CPPC, ó Costo Promedio Ponderado de Capital. 13 E, es el patrimonio, D es la Deuda, y A=E+D (siglas del inglés “London Interbank Offered Rate”), y es el tipo de interés promedio diario en el mercado interbancario de Londres. Fuente: www.iadb.org, www.bce.fin. ec.. 62 El análisis financiero se lo realiza variando los siguientes parámetros: tasa de descuento, incremento anual de costos, costos de explotación, factor de emisión del sistema nacional interconectado, precio de los CRES, precio por transporte, precio de la energía de los primeros 15 años, precio de la energía después de los 15 años, FP, intereses, inversión, potencia y apalancamiento. El caso base (sector público, sin considerar utilidades e IR en el flujo de caja) considera los parámetros presentados en la Tabla 2. Para determinar la sensibilidad de los parámetros, a cada uno se le hace variar un ±10 %, de su valor base. Figura 2: Variación porcentual del VAN, pendiente positiva En la Fig. 2, se refleja que el precio de la energía en los primeros 15 años, así como el FP son los parámetros más sensibles; variaciones porcentuales de ±30 % implican hasta un ±50 % de variación del VAN. Por lo tanto, un mayor precio de energía o una mayor energía generada significarían mayor rentabilidad financiera. Tabla 2: Datos de entrada del caso base En la Fig. 3, el parámetro más sensible es el costo de inversión por kW de un parque eólico (un determinado porcentaje de variación de la inversión resulta en una variación de un poco más del doble del VAN), seguido por la potencia (para un determinado porcentaje de variación de la potencia, el VAN varía en el mismo porcentaje); en otras palabras a menor costo de inversión o menor potencia del parque, el VAN aumenta, lo que haría más rentable el proyecto. 5.1. Sensibilidad del VAN La sensibilidad financiera del proyecto definida por el VAN, se puede apreciar en la Fig. 2 y Fig. 3. En dichas figuras, se observa cuál es la variación frente a los supuestos anteriormente citados. Los resultados indican que a medida que el factor de emisión, el precio de los CREs, pago por transporte, precio de la energía y el FP se incrementan, la variación del VAN también; es decir, tienen una pendiente positiva (Fig. 2). Para el resto de parámetros la pendiente es negativa (costos de explotación, incremento anual de costos, tasa de descuent o, interés, potencia y apalancamiento), esto se ve reflejado en la Fig. 3. En otras palabras, a medida que disminuye del valor base, el VAN se incrementa. Figura 3: Variación porcentual del VAN: pendiente negativa 5.2. Sensibilidad de la TIR Una TIR igual o superior a la tasa de descuento “base” indica que la inversión es aceptable. En la Fig. 4 y Fig. 5, se muestra cuál es la TIR para el caso base, y los resultados obtenidos para las variaciones porcentuales de los parámetros analizados. En general, salvo para casos extremos de variación del precio de la energía en los primeros 15 años, el FP, así como la inversión, presentan condiciones favorables para la inversión. 63 En la Fig. 4, se muestra que conforme se incrementa la variación porcentual de los parámetros indicados (factor de emisión, precio de CERs, pago de transporte, precio de energía y FP) la TIR también lo hace. El FP es el parámetro más sensible seguido del precio de energía en los primeros 15 años (con variación porcentual de +70%, se llega hasta un 550% de variación de la TIR). o tecnológicos pasando por la idiosincrasia y escepticismo por parte de los promotores locales. En Europa, la Comisión Europea destaca que aún existen barreras administrativas, inconvenientes en el acceso y conexión a la red; por ello se han planteado políticas para favorecer a las energías renovables [13]. Para llegar a la definición de los factores claves, que condicionan o no el desarrollo de la industria eólica, se utiliza el modelo desarrollado por Espinoza J. y Vredenburg H. [14]. El modelo establece que los indicadores económicos son insuficientes para explicar el desarrollo de esta industria considerada como “sostenible”. Además se utilizó parte de la metodología para realizar escenarios descrita en [15] y [16]. Mediante el modelo y la metodología mencionada se determinó, en función de percepciones de técnicos del sector energético nacional , cuáles son los aspectos que se debe dar prioridad al momento de establecer políticas u hojas de ruta para la promoción de la energía eólica. 16 Para determinar cuáles son los factores que inciden en el desarrollo de esta industria, se planteó un modelo que considera que no solo los factores macroeconómicos son importantes variables al momento de describir el éxito de la industria, sino hay que considerar otros factores como los institucionales y específicos de un proyecto [14]. Figura 4: Variación porcentual de la TIR; pendiente positiva Con el fin de definir la importancia de cada uno de los factores mencionados se generó una escala de valoración. El análisis de estos factores, y su importancia pueden permitir establecer políticas para la promoción de este tipo de tecnologías. Como se observa en la Fig. 6 el componente financiero y el estado de la economía según los técnicos nacionales, son claves para posibilitar el desarrollo de la industria, pero hay otros que deben ser considerados para crear un marco favorable. Figura 5: Variación porcentual de la TIR: pendiente negativa En el caso de una pendiente negativa (Fig. 5) a medida que los parámetros se incrementan la TIR disminuye. La inversión resulta ser el parámetro más sensible, así un -30% de variación modifica incluso un 500% la TIR, en menor proporción se tiene los costos de explotación, el interés así como el resto de parámetros analizados. . 6. EL DESARROLLO DE LA INDUSTRIA EÓLICA EN EL ECUADOR El impulso de la industria eólica en el Ecuador sin duda depende del modelo de desarrollo que se implemente. Al ser una tecnología que debe entrar en competencia con las tecnologías existentes afronta dificultades para su penetración, estas dificultades van desde aspectos financieros, regulatorios, económicos Figura 6: Desarrollo de la industria eólica: Caso Ecuador 16 Las entrevistas fueron realizadas en las ciudades de Cuenca, Loja, Quito y Guayaquil, la mayoría de ellas se las efectuó personalmente.. 64 Según el modelo descrito en [14], el componente económico (rentabilidad) resultó ser el que más influiría en el desarrollo de la industria eólica. Sin embargo, existen otros factores que se deben considerar al momento de formular políticas que incentiven la industria eólica en el Ecuador. 7. CONCLUSIONES Y RECOMENDACIONES Para la evaluación financiera se necesita una serie de datos de entrada. La falta de datos precisos puede hacer que se incurra en errores en los resultados que se obtengan. Más allá de extender los resultados a un proyecto específico, la investigación trató de definir mediante un análisis de sensibilidad, qué datos de entrada son más críticos para la evaluación financiera en este tipo de proyectos. El precio de la energía convencional no recoge los costos externos ambientales y sociales. Es decir los costos asociados a la remediación de los procesos contaminantes, a la salud o impacto visual. Estas externalidades, sin duda son difíciles de cuantificar, pero son factores, que favorecerían la elección de la tecnología eólica, al momento de compararla con otras tecnologías. En el caso ecuatoriano es deseable, por ejemplo, que los apoyos vía precios, se estimen en función del ahorro de los combustibles fósiles que se dejarían de importar. El análisis de sensibilidad consistió en variar 13 parámetros. Se realizó la sensibilidad considerando que el proyecto lo realiza el sector público. Puesto que en el sector público no se consideran las utilidades, tanto la TIR como el VAN, tienen mejores resultados si se compara con el desarrollo de un proyecto eólico por un promotor privado. Si se varía exclusivamente la inversión o el precio de la energía los primeros 15 años, se pueden llegar a resultados financieros atractivos. Los otros parámetros no afectarían significativamente al financiamiento. Sin duda, al variar dos o más parámetros a la vez se puede tener resultados de TIR y VAN favorables. 8. AGRADECIMIENTOS Los resultados expuestos reflejan (para los supuestos considerados) que financieramente los proyectos eólicos no serían atractivos en el Ecuador. Los resultados de la investigación indican que para tener una TIR mayor al 7%, con una VAN positiva, se necesitaría como máximo una inversión de 900 USD/ kW (40% menos del costo considerado como base), o un precio de energía a 0,150 USD/kWh (60%, más con respecto al precio base). La variación individual del resto de parámetros no alteran significativamente la TIR y el VAN. Con ello se concluye que la normativa desarrollada en el país no promueve proyectos sino tecnologías. REFERENCIAS BIBLIOGRÁFICAS Al profesor Juan Leonardo Espinoza, por permitirme conocer otras posibilidades de análisis. A la Universidad Politécnica Salesiana, por la confianza depositada. [1] WWEA. (2010). World Wind Energy Report 2012. World Wind Energy Association, pp 1819 Disponible (on line) en: h t t p : / / w w w. w w i n d e a . o r g / w e b i m a g e s / WorldWindEnergyReport2012_final.pdf [2] CONELEC, (2000; 2002; 2004; 2006). “Precios de energía eléctrica proveniente de centrales de energía renovable no convencional”. Regulaciones CONELEC-008/00; 003/02; 004/04; 009/06. Quito, Ecuador: A pesar de la falta de rentabilidad financiera, hay razones para que se incentive el desarrollo de la industria eólica. En el caso particular del Ecuador, su fomento estaría ligado a la necesidad de ampliar la matriz energética, evitar en el futuro la dependencia externa, la generación de electricidad a partir de fuentes limpias, reducción de la contaminación, reducción del éxodo rural, reducción del consumo de combustibles fósiles, incremento de la seguridad de abastecimiento, y el fomento de la investigación y desarrollo. [3] Moreno, J., Mocarquer, S., & Rudnick, H. (2010). “Generación eólica en Chile: Análisis del entorno y perspectivas de desarrollo”. Systep Ingeniería y Diseños, pp. 1-10. Disponible (on line) en: http://www.systep.cl/documents/Articulo%20 P235-MorenoMocarquerRudnick.pdf [4] Olmos Garcia, V., Romero, Z. J., Benavides Gonzales, B. (2000). “Análisis económico de un parque eólico”. Energía: Ingeniería energética y medioambiental. Vol 26, pp. 2541. De los mecanismos de promoción y financiamiento vigentes en el Ecuador, el conocido como el Feed-in Tariff, o de tarifa regulada es el que tiene más impacto en la promoción de la energía eólica. 65 [5] Creus Solé, A. (2008). Aereogeneradores (Primera Edición ed.). España: Editorial Técnica. [14] Espinoza, J. L., Vredenburg H.. (2010). ”Towards a model of wind energy industry development in industrial and emerging economies”. Global Business and Economics Review, Vol. 12, pp 203-229. [6] Escudero, J. M. (2008). Manual de energía eólica. Mundi Prensa, 2da Edición, Madrid, España. [15]Dyner, I. (2009). Mercados Eléctricos. Universidad de Cuenca, Apuntes de Clase, Maestría en Sistemas Eléctricos de Potencia, Cuenca. [7] Rodríguez, J. L., Burgos, J. C., Arnalte, S. (2003). Sistemas eólicos de producción de energía eléctrica. Editorial Rueda, 1ª Edición, Madrid, España: [16] Smith, R., Vesga, D., Cadena, A., Boman, U., Larsen, E., Dyner, I. (2005). “Energy scenarios for Colombia”. Futures, vol 37, pp 1-17. [8] Ackermann, T. (2005). Wind power in power systems. John Wiley & Sons Inc, Gran Bretaña [9] MEER, Folletos de los proyectos eólicos: Salinas, Villonaco, Chinchas, Ducal. Quito, Ecuador. Antonio Barragán Escandón.Nació en Cuenca, Ecuador en 1975. Recibió su título de Ingeniero Eléctrico en la Universidad de Cuenca, Cuenca 2002; Máster en Energías Renovables de la Universidad de León, España; Máster en Sistemas Eléctricos de Potencia por la Universidad de Cuenca. Además, tiene posgrados en redes de telecomunicación, auditorías de gestión de la calidad y medio ambiente. Es consultor independiente en el sector eléctrico y profesor universitario. Sus temas de interés son: el Desarrollo Energético Sostenible, Mercados Energéticos y Energías Renovables, particularmente la Energía Eólica. [10] González Velasco, J. (2009). Energías renovables, Editorial Reverté, 1ª Edición, Barcelona, España. [11] Sapag Chain, N., Sapag Chain, R. (1995). Preparación y evaluación de proyectos. McGraw Hil, 3ª Edicicón, Bogotá, Colombia: [12] Dumrauf, G. L. (2003). Finanzas corporativas. Buenos Aires, Grupo Guía S.A. Argentina: [13] Espinoza, J. L, Barragán, E., (2013). “Renewable Energy Policy and Legitimacy: a Developing Country Case”. International Conference on Renewable Energies and Power Quality, vol 11, pp. 306, Bilbao, España. 66 Análisis de Factibilidad para la Implementación de la Gestión de la Demanda del Sector Industrial P. A. Méndez Santos Empresa Eléctrica Regional Centro Sur C.A. - Universidad de Cuenca. Resumen— El presente trabajo realiza un análisis de factibilidad de aplicación que tendría la “Gestión de la Demanda de Energía Eléctrica” (GD) en el sector industrial que es atendido por la Empresa Eléctrica Regional Centro Sur C.A. -CENTROSUR- de la ciudad de Cuenca, para esto se utiliza como caso piloto a la industria Cartones Nacionales S.A. -CARTOPEL-. CARTOPEL (National Cardboard Industry) has been used as a pilot project. The analysis begins with the characterization of the production process and the determination of the factory load distribution. Then, by using measurement statistics, the industry’s daily electrical power consumption is determined along with the load that can be managed. Such results allow for an economic assessment on what CARTOPEL could save on its electricity supply costs, as well as the economic impact of load management on the utility’s load pattern. El análisis inicia con la caracterización del proceso de producción y la determinación del balance de carga de la fábrica, luego, con el uso de las estadísticas de medición, se determina el patrón de consumo diario de energía eléctrica que hace la industria y la carga en capacidad de ser gestionada. Estos resultados permiten la evaluación económica del ahorro que podría tener CARTOPEL sobre sus costos de abastecimiento eléctrico. Así como también el impacto económico que tendría la gestión de carga sobre el patrón de demanda de la distribuidora. To conclude, the current Regulations in Ecuador, related to the subject of efficient energy use and energy reduction for industrial clients, are reviewed and analysed in order to evaluate the calculation methods and results when applied to CENTROSUR. Based on this information, some modifications and characteristics, for a load management in the industrial sector Regulation, are proposed. Finalmente se efectúa una revisión y análisis de la Regulación vigente en el Ecuador relacionada con la temática de reducción y uso eficiente de energía para clientes industriales, con el objetivo de evaluar sus metodologías de cálculo y resultados de aplicación sobre la CENTROSUR y en base a esto proponer las modificaciones y características que debería contener una Regulación sobre gestión de la demanda de energía eléctrica para el sector industrial. Index Terms— Load Management, Electric Power Auditing, Energy Efficiency, Energy Supply, Load Curve, Electric Power Regulation, Electric Power Rates, Smart Grid. 1. INTRODUCCIÓN El alto costo de generar, transportar y distribuir la electricidad, y el incesante incremento de la demanda de energía eléctrica, actualmente obliga a todos los agentes del sector eléctrico (Ministerios, organismos de regulación, control y supervisión, empresas de generación, transmisión y distribución) a realizar año tras año mayores esfuerzos e inversiones para lograr abastecer el requerimiento de energía de toda la población. Palabras clave— Gestión de la demanda, auditoría eléctrica, eficiencia energética, abastecimiento energético, curva de carga, regulación eléctrica, tarifas eléctricas, red i nteligente. Abstract— This article presents an applied feasibility study for “Energy Load Management” (LM) in the industrial sector served by the Empresa Eléctrica Regional Centro Sur C.A.CENTROSUR (The South Central Regional Electric Utility) in the city of Cuenca. For this purpose, the Cartones Nacionales S.A. industry, – Los planes de eficiencia energética comúnmente suelen estar orientados hacia la reducción del consumo por medio del uso de máquinas, artefactos y electrodomésticos eficientes, no obstante estos planes 67 tienen como desventaja un largo período de análisis e implementación ya que involucran el remplazo de toda o la mayor parte de la carga ineficiente. Acciones de más rápida implementación y con resultados que podrían verse en el corto plazo son los relacionados con la gestión de la demanda. Estos procesos en conjunto con la división ONDUTEC conforman los sistemas de producción de la fábrica. Por otra parte se encuentran los sistemas de soporte a la producción, los cuales tienen una participación transversal en la fabricación pues son los que brindan servicios de apoyo como servicios auxiliares de aire comprimido, iluminación, etc. Con el fin de alcanzar un suministro eficiente y un aprovechamiento óptimo de los limitados recursos energéticos, la gestión de la demanda de energía eléctrica (GD) ha venido siendo aplicada en varios países del mundo, por ello y siendo el distribuidor/ comercializador el agente del sector que se encuentra en mayor contacto con el usuario final de la energía, es que en el presente trabajo se decidió realizar un análisis de factibilidad de aplicación de la GD en la Empresa CENTROSUR de la ciudad de Cuenca. El segmento de análisis se centra en el sector industrial debido a su alta intensidad de uso de energía eléctrica y su relativamente pequeño número de usuarios en relación con los segmentos residencial y comercial, con lo cual potencialmente se pueden obtener grandes reducciones de consumo gestionando una cantidad moderada de clientes. Como caso piloto de análisis se seleccionó al cliente de mayor demanda de energía eléctrica en la región, en este caso la empresa CARTOPEL de la ciudad de Cuenca, la cual tiene una demanda que bordea los 3,2 MWh mensuales, lo que representa aproximadamente el 5% del consumo de energía total del sistema de la CENTROSUR. Figura 1 : Esquema de los sistemas eléctricos de CARTOPEL 2.1. Balance energético Con base en la esquematización de los subprocesos productivos y su organización por sistemas se aplicó la siguiente metodología para encontrar el balance energético de la planta: 2. LA DEMANDA DE ENERGÍA ELÉCTRICA EN LA EMPRESA CARTOPEL CARTOPEL es una industria dedicada a la fabricación de papel y cajas de cartón, internamente se encuentra organizada en dos divisiones: • División Molino: cuyas instalaciones producen bobinas de papel para la exportación y/o utilización en la fabricación de cajas de cartón. • División Ondutec: instalación que produce cajas de cartón corrugado para la venta a otras empresas de manufactura de productos varios. • La primera es en donde efectivamente se produce el papel y tiene los siguientes procesos: • Recolección y almacenamiento de la materia prima • Preparación de la pasta • Limpieza de la pasta • Refinamiento • Formación, secado, prensado y bobinado • Línea de conversión • Recopilación de los datos de mediciones de corrientes y tensiones de línea, potencia trifásica y factores de potencia de cada tablero de control y equipo. • Análisis estadístico de la frecuencia, porcentajes acumulados e histograma de valores de potencia más probables de ocurrencia para cada tablero. • Cálculo de la potencia media de cada equipo utilizando los datos de corriente promedio, tensión nominal de alimentación y factor de potencia promedio. • Estimación del tiempo efectivo de funcionamiento anual a través de relacionar los tiempos informados por el personal de operación con el porcentaje de datos válidos encontrados en el histórico de mediciones de cada equipo en particular. • Estimación del tiempo real de funcionamiento de la carga de cada tablero en análisis para determinar la cantidad de horas anuales que el tablero opera con la potencia más probable encontrada en el análisis estadístico. • Finalmente, con los datos de potencia más probable y horas anuales de operación, se 68 determinó la energía media anual de cada tablero y equipo. Tabla 1 : Porcentajes de responsabilidad de carga Con lo cual se tiene que alrededor del 92% del consumo de energía eléctrica es responsabilidad de los sistemas de producción de la planta, mientras que el restante 8% se encuentra en los sistemas de soporte. El mayor porcentaje de consumo se encuentra en el proceso de Refinamiento, seguido de la etapa de Formación, prensado, secado y bobinado, entre estos dos procesos se tiene casi la mitad del consumo de energía de la totalidad de la planta. Una característica importante del proceso de producción de papel en CARTOPEL es que cada etapa tiene una dependencia directa de la etapa o proceso precedente, esto significa que si una de las etapas sufre una paralización todas las etapas posteriores deberán suspender su tarea ya que no tendrán un suministro de material que permita realizar su trabajo. Esta particularidad obliga a asumir que sus porcentajes de responsabilidad de carga también permanecen constantes a lo largo del día. 2.3. Comportamiento típico de la carga de CARTOPEL Figura 2 : Consumo referencial de energía eléctrica por sistemas de la planta de CARTOPEL De los datos históricos de consumo de energía eléctrica de CARTOPEL, recopilados durante los años 2010, 2011 y 2012 se ha obtenido un perfil típico de consumo diario para esta empresa. Figura 4 : Curva promedio de carga diaria de CARTOPEL Figura 3 : Consumo referencial de energía eléctrica por procesos productivos de la planta de CARTOPEL La mayor probabilidad de ocurrencia de la demanda máxima se presenta en el horario comprendido entre las 02:00 y las 04:15, luego de lo cual se da un descenso sostenido del consumo entre las 06:00 y las 07:15 aproximadamente. En el período de demanda media, de 08:00 a 18:00 dentro de este período se presenta la demanda mínima la cual se da hacia las 12:15, luego los valores de la curva son superiores al promedio desde las 12:45. Durante el período de demanda pico, de 18:00 a 22:00, la demanda de energía comienza nuevamente a incrementarse, presentándose un aumento sostenido a partir de las 19:15. Estas características de la curva de demanda de CARTOPEL se repiten para los tres años en mención, situación que permite deducir que para 2.2. Factores de responsabilidad de carga Si se relaciona la energía estimada por el censo de carga para cada proceso de producción, con la energía de consumo total de la planta, los porcentajes de responsabilidad de carga son: 69 futuros períodos de tiempo, la forma de la curva no variará sustancialmente a excepción de los valores de demanda, los cuales se irán incrementando en función del aumento de consumo o maquinaria instalada. Estos porcentajes indican una banda de variación máxima en más o menos alrededor de la media del horario base para los años analizados, si estos valores se señalan en las correspondientes curvas de duración de la demanda se encuentra que los valores que sobrepasan los referidos porcentajes de variación apenas representan el 1,064% del total de tiempo en horas del año 2010. Para los años 2011 y 2012 el comportamiento de la demanda es similar a lo anteriormente anotado, teniendo porcentajes del 2,29 y 0,39% respectivamente, lo cual refleja la variabilidad que tienen los valores de demanda máxima y que con una adecuada supervisión y control de la demanda se podría alcanzar un uso más uniforme de la potencia y por lo tanto generar ahorros importantes en los pagos del rubro de demanda. 2.3.1 Comportamiento de la demanda máxima Para los años 2010, 2011 y 2012, los registros mensuales de demanda máxima observan valores superiores a la media aritmética del horario base de las curvas de carga diaria típica correspondientes, este hecho permite deducir que a pesar del comportamiento bastante regular de consumo que tiene CARTOPEL existe un margen representativo de carga que puede ser gestionado. Tabla 2 : Valores de demanda máxima de CARTOPEL - año 2012 Figura 5 : Curva de duración de carga de CARTOPEL, año 2012 *Potencia media registrada en horario base para el año 2012 Como se puede observar en la tabla 2, en promedio mensualmente existe un sobrepaso del 17,01% al valor medio registrado durante todo el año para la demanda máxima de horario base, de igual manera se corrobora el hecho de que la demanda máxima ocurre con mayor frecuencia en este horario debido a que en 10 de los 12 meses el pico de demanda se presenta en el horario comprendido entre las 02:00 y las 05:45 3. LA DEMANDA DE ENERGÍA ELÉCTRICA DEL SISTEMA DE DISTRIBUCIÓN DE CENTROSUR De acuerdo a las estadísticas del CONELEC correspondientes al año 2009, el total de clientes de la CENTROSUR representa aproximadamente el 8% del total de usuarios a nivel nacional. En cuanto a la magnitud de energía, la demanda de esta empresa representa aproximadamente el 4,5% del total de energía a nivel nacional. De este consumo un 95% se encuentra en las provincias de Azuay y Cañar. 2.3.2 Duración de la carga La duración de los valores de demanda de CARTOPEL, muestran que aproximadamente durante un 60% del tiempo, la carga de la empresa se encuentra por encima del valor promedio más alto encontrado en el horario base, no obstante en función de los registros de demanda de la empresa se tiene que las desviaciones estándar se encuentran en valores comprendidos entre 600 y 900kW, con lo cual el porcentaje de variación esperado es de alrededor del 15% de la media aritmética del horario base. 3.1. Características de la demanda atendida por CENTROSUR Para el mes de diciembre de 2010, esta empresa contaba con un total de 300.480 clientes, los datos de la década 2000-2010, muestran que en promedio cada año un 89,1% del total de clientes de la CENTROSUR pertenecen a la categoría Residencial, mientras que cerca del 7,62% son Comerciales, y un 2,05% son Industriales, quedando un 1,24% repartido entre todo el resto de categorías tarifarias. Tabla 3 : Estadística de demanda base - 2010, 2011 y 2012 70 La categoría residencial, es la que más contribuye en la demanda eléctrica, sin embargo una de las características de este tipo de demanda es su alta dispersión, tanto numérica como geográfica, es decir un gran consumo repartido en una gran cantidad de usuarios lo cual da como resultado un consumo promedio individual muy reducido. Figura 8: Consumo de energía por categoría tarifaria de la CENTROSUR a junio 2012 4. FACTIBILIDAD DE APLICACIÓN DE PLANES DE GESTIÓN DE LA DEMANDA EN CARTOPEL La evaluación del grado de factibilidad de aplicación de la gestión de la demanda en CARTOPEL requiere que en primera instancia se determine el porcentaje de carga y los equipos y/o maquinaria gestionables. Figura 6 : Demanda de energía eléctrica según las principales categorías tarifarias atendidas por CENTROSUR Características opuestas se presentan en las demandas comerciales e industriales, las cuales de manera global tienen consumos menores que el segmento residencial pero que al estar repartidas en un número menor de clientes presentan una menor dispersión y un mayor consumo promedio individual. 4.1. Carga con capacidad de gestión Debido a la alta interdependencia de los procesos de producción de esta empresa, el patrón diario de demanda resultante presenta un estrecho margen de variación comprendido entre los 300 y 400kW. Considerando esta característica, un plan de gestión de la demanda de CARTOPEL debería considerar dos enfoques: Este comportamiento permite deducir que las acciones sobre la eficiencia y uso racional del recurso energético podrían tener alto impacto si se direccionan sobre el segmento industrial ya que concentra una alta intensidad energética en un relativamente reducido número de clientes (2,05% del total del clientes en la zona de concesión), de los cuales la mayor parte se encuentran concentrados en una misma zona geográfica como lo es la ciudad de Cuenca. • Gestión de la demanda orientada hacia mejorar el uso de la energía eléctrica y reducir los costos de abastecimiento eléctrico. • Gestión de la demanda orientada hacia la modificación del patrón de demanda eléctrica con fines de solventar restricciones de orden técnico y/o económico del sistema de distribución. En el primer enfoque lo que se persigue es una modificación del patrón de demanda eléctrica minimizando los efectos sobre la normal producción, para alcanzar este objetivo son útiles las estrategias de desplazamiento de actividades productivas hacia rangos horarios de menor costo económico tanto de energía como potencia, así como también la mejora en la eficiencia de funcionamiento de equipos y maquinaria. Figura 7: Número de clientes de la CENTROSUR a junio 2012 En el segundo enfoque, la modificación del patrón de demanda suele requerir de importantes disminuciones de potencia y energía en función del 71 requerimiento del sistema de la distribuidora, en este caso la única estrategia viable es la desconexión de carga, no obstante la gestión de demanda ayudará a determinar un orden prioritario de desconexiones tratando de salvaguardar en lo posible la capacidad productiva sin llegar a una desconexión total de la demanda de la industria. En función de los datos recopilados en la auditoría eléctrica, se conocen los tiempos aproximados de operación de los equipos, este dato es fundamental para determinar la potencia efectiva que se podría reducir al interrumpir su operación, la potencia efectiva de interrupción para cada equipo ha sido determinada multiplicando el porcentaje de tiempo de uso por la potencia del equipo. 4.1.1 Gestión para mejora de eficiencia de consumo Tabla 5: Determinación de las potencias interrumpibles efectivas en función del tiempo de operación aproximado Se ha determinado que a través de variaciones operativas en el proceso de refinamiento y en la etapa de conversión, es posible disminuir hasta 370kW de demanda a través de las siguientes acciones: En el proceso de refinamiento se utilizan un total de cuatro refinadores con una potencia efectiva de aproximadamente 850kW, no obstante no todos los refinadores aportan con la misma cantidad de pasta, esto debido a que dentro de la técnica de elaboración de la hoja de papel se tienen dos tipos de hojas que se juntan para crear la hoja final, estos dos tipos de hojas se denominan “Top” y “Back” con un aporte al peso final de la hoja del 30 y 70% respectivamente. En función de esta característica de fabricación y conociendo que para cada hoja se utilizan dos refinadores, es posible concluir que posiblemente para la hoja Top pueda utilizarse solamente uno de estos equipos. Los resultados de la auditoría eléctrica indican que es posible prescindir de un refinador el cual tiene una potencia efectiva de 207,10kW. En la etapa de conversión, es posible reprogramar las actividades de manera que no se desarrollen en el horario de mayor coste económico, esto es entre las horas de las 18:00 a 22:00, con esta acción se estarían retirando aproximadamente 163kW del horario pico de demanda. Como se observa existen cargas cuyo tiempo de operación es muy reducido por lo que en caso de requerirse una reducción de demanda, su desconexión no representaría un aporte significativo, no siendo de interés incluirlas dentro del grupo prioritario de interrupción. Para el caso de las cargas identificadas se excluyen del grupo de interrupción aquellas que tienen un porcentaje de tiempo de uso inferior al 15%, con lo cual la potencia interrumpible se reduce a 611,74kW, es decir aproximadamente el 10% de las demandas máximas de los tres últimos años. 4.2. Evaluación del efecto de gestión sobre la carga de CARTOPEL Una evaluación del efecto que tendría la gestión de la demanda sobre CARTOPEL es posible cuantificarla únicamente para la gestión de mejora de la eficiencia de consumo ya que su efecto será permanente sobre la curva de demanda, en el caso de la gestión por restricción del sistema de distribución el efecto dependerá del rango horario y el tiempo de duración de la interrupción solicitada por la distribuidora. 4.1.2 Gestión por restricción del sistema de distribución Del análisis de los procesos de fabricación se encontró que existe un total de carga interrumpible de aproximadamente 729,18kW, la cual puede ser prescindible sin comprometer los niveles de producción de la planta, esta carga se encuentra agrupada en los siguientes procesos y equipos: 4.2.1 Modificación del patrón de consumo diario Analizando las curvas promedio se observa que los valores de demanda en los diferentes rangos horarios cambian de la siguiente forma: Tabla 4: Cargas y potencia interrumpible identificada en Tabla 6: Reducción de los valores de demanda máxima en cada rango horario CARTOPEL que generan un mínimo impacto sobre la producción 72 La salida de operación de la etapa de conversión durante el horario pico mejora sustancialmente la relación de la demanda pico a la demanda máxima, en la tabla 7 se observan los valores de la referida relación si la medida hubiera sido adoptada desde el año 2010. Para la suspensión de funcionamiento de la etapa de conversión la evaluación del efecto económico se realiza únicamente para el costo anual de energía ya que su efecto sobre la demanda es nulo en razón de que la demanda máxima de CARTOPEL se presenta en el horario base, mientras que la referida suspensión se presentaría en horario pico. Tabla 7: Relaciones de demanda pico a demanda máxima estimadas Tabla 9: Costos anuales evitados por demanda con la suspensión de operación en la etapa de Conversión durante el horario pico Estos valores muestran que es posible reducir la demanda pico en alrededor del 3,4%, sin embargo esto no es suficiente para evitar la penalización del 20% por demanda pico, alcanzándose solamente un ahorro por los 207kW reducidos al sacar de funcionamiento uno de los refinadores. Los resultados muestran que con las acciones de mejora operativa sería posible tener un ahorro anual promedio de $123.424,24, valor que es referencial ya que depende directamente de las horas de operación estimadas del refinador a retirar de servicio así como de la coincidencia con la demanda máxima mensual. 4.2.2 Efecto económico sobre el costo de abastecimiento de energía 4.3. Evaluación del efecto de gestión sobre la carga de la distribuidora CENTROSUR La reducción de 207kW puede ser evaluada para la totalidad de tiempo de un año en función de que su eliminación es permanente al estar originada en la eliminación de uno de los equipo de refinamiento, para el caso de los 163kW de la etapa de conversión, la evaluación deberá considerar el cálculo solamente durante el horario de 18:00 a 22:00 todos los días del año. Con base en lo anterior, el efecto económico sobre el costo anual de energía para la acción de reducir 207kW se determina como: La gestión de la demanda de CARTOPEL indudablemente tiene un efecto sobre la demanda de energía de CENTROSUR, sin embargo en función de los resultados obtenidos se observa que este no es muy apreciable en razón de que se toma como caso de estudio tan solo a un cliente. Modificación del patrón de consumo diario (1) Realizando una comparación de la demanda de CARTOPEL con la de la distribuidora se encuentra que su porcentaje de participación promedio es del 5,30%, si se recuerda que la demanda máxima de esta industria se presenta en el horario base, específicamente entre las 02:00 y las 4:15, y de que la curva diaria promedio presenta reducciones de demanda entre las 19:00 y 19:15 se determina que esta no tiene incidencia en la demanda pico de CENTROSUR. Por lo tanto el único efecto de la gestión de demanda que podría ser considerado en una evaluación económica para la distribuidora, sería la reducción por consumo de energía en los períodos en los cuales se aplique la gestión para solventar restricciones técnicas y/o económicas del sistema de distribución. En donde RCE es la reducción de costo por energía, HOp.A representa la cantidad de horas de operación anuales estimadas para el refinador que se retirará de funcionamiento, los subíndices i del 1 al 4 representan los rangos horarios de la tarifa eléctrica aplicada a esta industria, Hi la cantidad de horas anuales cada uno de los períodos horarios y Prci el correspondiente precio del kWh. Para el caso del efecto sobre el costo de la demanda, se ha realizado el producto del costo del kW por la potencia reducida, con estas consideraciones los resultados obtenidos son: Tabla 8: Costos anuales evitados por energía y demanda con la reducción de 207kW del proceso de refinamiento 73 valor de 449.922kWh, esta energía valorada a precio medio de compra para los años 2009 al 2012 da una reducción promedio mensual de costos de $23.553,42. Tabla 11: Reducción de costos por compra de energía con la salida de operación de la carga interrumpible de CARTOPEL Figura 9 : Porcentajes de participación de la demanda de la subestación N°4 y de CARTOPEL en la demanda de CENTROSUR Efecto económico abastecimiento de energía 4.3.1 sobre el costo Los resultados económicos obtenidos muestran que el mejor escenario para la gestión de la demanda es su aplicación con miras a solventar restricciones del sistema de distribución, no obstante para que esta opción sea viable deberá tener un adecuado incentivo económico para el cliente, de forma que éste perciba los beneficios de consumir eficientemente y prescindir de cargas no esenciales en condiciones emergentes, así como también no impactar negativamente en la economía de la distribuidora. de La gestión de 370kW tiene el carácter de ser permanente en el tiempo, lo cual resulta en una reducción de 266.400 kWh mensuales, es decir una reducción promedio del 0,39% de la demanda energética anual típica de la distribuidora, esta disminución de consumo energético, valorada a precio medio de compra da como resultado una reducción de alrededor del 0,39% de los costos totales de compra de energía. 1 5. ANÁLISIS DEL MARCO REGULATORIO VIGENTE Si bien en el Ecuador no existe un marco regulatorio específico para la aplicación de la gestión de la demanda, se pueden considerar los siguientes que actualmente se encuentran vigentes: Tabla 10: Evaluación económica de reducción de costos por compra de energía con gestión de demanda en CARTOPEL • La regulación sobre generación emergente durante eventos de déficit de abastecimiento. • Esquemas tarifarios horarios que establecen costos diferentes para el kWh en función de la hora a la cual se presenta el consumo de energía. Los resultados de la evaluación muestran que la reducción de costos es mínima en comparación con los costos de abastecimiento de la totalidad del sistema de distribución, por otra parte es importante mencionar que el impacto económico que tendría la gestión de la demanda sobre el agente distribuidor dependerá en gran medida de los precios de la energía en el mercado mayorista y del esquema transaccional aplicado. En el caso de la gestión para solventar restricciones de abastecimiento de energía del sistema de distribución, para el cual se determinó un valor aproximado de 611,74kW en posibilidad de ser interrumpidos sin afectar mayormente el proceso productivo, la potencia total gestionada considerando la ya gestionada por mejora del proceso productivo suma un valor de casi 982kW. 5.1. Esquema tarifario con incentivo consumo eficiente por rango horario La tarifa aplicada a los clientes industriales introduce señales económicas que incentivan el uso eficiente y el desplazamiento de la demanda hacia períodos que no coincidan con el de mayor requerimiento energético del sistema, las señales de incentivo, según se analizó en puntos anteriores, se basan en precios horarios para la energía y una penalización de hasta el 20% en función del factor de demanda del cliente. Para las condiciones de déficit de energía, experimentadas durante el último trimestre del año 2009, con la carga interrumpible de CARTOPEL saliendo fuera de operación durante el período de baja carga de esta industria, esto es por un período de hasta 10 horas diarias desde las 06:00 hasta las 16:00, la reducción mensual de energía asciende hasta un 1 para La aplicación de este esquema tarifario, específicamente en lo referente al rubro de demanda, para el caso de la CENTROSUR, ha dado como resultado que en promedio aproximadamente un cuarto de los clientes industriales con demanda horaria se encuentran penalizados cada mes. El precio medio de compra es obtenido como la relación entre, el total de costos de compra en contratos regulados y mercado spot, y el total de energía consumida por el sistema de distribución. Para los años 2010, 2011 y 2012 los precios medios de compra de energía, para la CENTROSUR, fueron de 5,36, 5,12 y 4,76 ctv.USD/kWh respectivamente. 74 que se pretendía dar a los usuarios pues en realidad el precio pagado fue de $0,0931/kWh, es decir casi un 38% inferior a lo que se mencionaba en el texto de la Regulación. La aplicación de la Regulación CONELEC 006/09 abarcó el período comprendido entre el mes de noviembre de 2009 y el mes de febrero de 2010, durante los referidos meses la contribución de energía alcanzó los 2.110,82MWh, valor que representó un 4,77% del total de energía demandada por los clientes calificados. Figura 10: Porcentajes promedio de clientes penalizados por demanda 5.2. Esquemas de generación emergente para eventos de déficit de abastecimiento nacional Durante la crisis energética experimentada en el año 2009, el CONELEC emitió la Regulación 006/09 sobre generación emergente de clientes calificados para aliviar la demanda de los sistemas de distribución, sin embargo este esquema solamente está previsto en caso de déficit de abastecimiento energético del sistema. La condición técnica básica establecida por el CONELEC para el ingreso dentro del esquema de generación emergente es la de contar con un equipo de generación de una potencia mínima de 100 kW, así como también el poseer un sistema de medición que permitiera registrar la producción de energía. La calificación depende de un proceso de verificación e inspección de las instalaciones del generador por parte de la empresa de distribución. En el aspecto operativo, el esquema establece que la coordinación del funcionamiento de los generadores emergentes debe efectuarse en conjunto con la empresa de distribución, la cual, en este aspecto, queda libre de solicitar cuando y durante que períodos de tiempo se requiere de la generación de estos equipos, obligando a reportar al CENACE los valores proyectados de demanda autoabastecida. Figura 11: Porcentaje de aporte mensual de la energía autogenerada a la demanda total de los clientes calificados 5.2.1 Regulación CONELEC 006/09 Esta regulación fue emitida en noviembre del año 2009 y fue aplicada hasta el mes de febrero de 2010, luego fue derogada en el año 2010 siendo reemplazada por la CONELEC 003/10. En el ámbito comercial, esta regulación fijó en $ 0,15/kWh la remuneración que recibiría el cliente calificado por la actividad de generación, los cuales se pagaban en forma de descuento del valor total de la factura por el servicio eléctrico del mes correspondiente, no obstante, en el cálculo de la energía consumida por el cliente se incluyó también la energía autoabastecida con el generador de emergencia. Esta forma de evaluar comercialmente la energía producida por los clientes, distorsionó la señal de incentivo económico Figura 12: Porcentajes de la composición del abastecimiento energético de la CENTROSUR durante el periodo de aplicación de la Regulación CONELEC 006/09 Con respecto a la composición de abastecimiento de la demanda del sistema de distribución, la energía producida por los generadores de emergencia representó en promedio el 0,91% del total de energía requerida por el sistema de distribución. La mayor parte de las compensaciones pagadas por la distribuidora correspondieron a generación de los horarios de 08:00 a 18:00 y 22:00 a 08:00, observándose porcentajes superiores al 80% entre los dos períodos. 75 Tabla 13: Precios medios en centavos de dólar por kWh de la generación térmica en el mercado eléctrico mayorista Figura 13: Composición porcentual de los costos por generación emergente pagada por la distribuidora a los clientes calificados, en función del rango horario de generación. Como se puede apreciar en las tablas precedentes, el precio unitario del kWh autogenerado fue en promedio apenas superior al precio del kWh generado por un productor térmico (1,06ctv./ kWh), si se considera que el enfoque comercial y de negocio de un cliente industrial y/o comercial no gira en torno a la producción eléctrica, es posible deducir que el precio fue insuficiente para compensar los costos de operación y mantenimiento de unidades que no se encuentran diseñadas para producción continua. El hecho de que los costos disminuyeran para el período pico (18:00 a 22:00) y consecuentemente la generación, tiene relación con el hecho de que la tarifa más alta se tenga para este horario, si bien podría pensarse que el autoabastecerse durante el período donde la energía es más cara sería la mejor estrategia por parte de los clientes, debido al esquema comercial de la Regulación, la energía generada en hora pico también se incluiría como energía provista por la distribuidora y por lo tanto sería tarifada en la planilla eléctrica al más alto costo, por este motivo es que la generación y los costos disminuyen en este período. 5.2.2 Regulación CONELEC 003/10 La Regulación 003/10 “Operación Técnica – Comercial de Grupos Electrógenos de Emergencia en Períodos de Déficit y/o Racionamiento de Energía Eléctrica” en lo referente a los objetivos, requisitos técnicos, procedimientos de calificación y operación, establece similares condiciones y características que la 006/09, sin embargo introduce cambios sustanciales en la liquidación comercial de la energía generada con los grupos de emergencia, entre los cuales se pueden mencionar: El único mes en el cual se observar un cambio en este comportamiento es en el mes de enero situación que corresponde con el más alto aporte de la generación de Continental Tire Andina al ser el único con capacidad de generación sincronizada con el sistema de distribución y de forma más continua que el resto de clientes. Si bien el incentivo económico para que los clientes se autoabastezcan, estableció un precio de $0,15/kWh, debido al esquema comercial de la Regulación, el precio real promedio reconocido terminó siendo de $0,0931/kWh, si se compara este valor con los precios promedio pagados a la generación térmica durante el período de crisis, se observa que en realidad este no fue un incentivo eficaz y en términos generales pudo incluso generar pérdidas económicas para los clientes. • Establecimiento del concepto de Factor de Operatividad. • Establecimiento de dos precios para la generación eléctrica de emergencia. • Procedimiento para liquidación comercial en períodos atípicos de facturación. • Procedimiento para la liquidación comercial de la generación de consumos. propios de agentes autogeneradores y generación emergente de agentes generadores calificados por el CONELEC. Tabla 12: Precios medios reales pagados por la autogeneración emergente En contraparte, la similitud que comparten las dos regulaciones en el tema comercial, radica en la conservación de la característica de sumar la energía generada a la energía suministrada por la distribuidora para efectos de facturación. 76 El factor de operatividad establece una tasa o porcentaje de funcionamiento del grupo electrógeno comparado con un horizonte de tiempo que se asume de un mes, se tienen dos tipos de factores: En donde: L: Liquidación de la energía del período correspondiente M2: Energía producida por el grupo electrógeno FOm=Hr/Ht FO=Hop/Ht (2) En donde: FOm: Factor de operatividad mínimo FO: Factor de operatividad real Hr: Cantidad de horas de racionamiento que afecten al cliente calificado durante un mes o período de facturación Hop: Cantidad de horas reales de funcionamiento del grupo electrógeno durante un mes o período de facturación Ht: Cantidad de horas totales del mes o período de facturación La nueva forma de liquidación comercial, establece dos valoraciones económicas diferentes para la energía producida en función de si la producción del grupo electrógeno excedió o no el factor de operatividad mínimo, los precios establecidos se determinan como: Escenario 2: Cliente genera durante más horas que la duración de los períodos de racionamiento, es decir FO es mayor que FOm. Lreal=(M2*PEGEE1)-(M2*Th) (5) En donde Lreal es la valoración económica real del kWh generado considerando el hecho de que esta energía tiene que sumarse al consumo energético suministrado por la distribuidora y por lo tanto se valora a la tarifa regulada vigente (Th). En donde: PEGEE: Precio de energía generada por grupos electrógenos de emergencia. CO&M: Costo de operación y mantenimiento, excepto combustible, en (cUSD/kWh), se considera el precio promedio que facturan por el servicio empresas especializadas en el mercado local para el generador tipo. Cc: Costo de combustible a precio de mercado local incluido el transporte (cUSD/kWh) M: Margen adicional determinado por el CONELEC, de acuerdo al costo de oportunidad del mercado eléctrico, revisado por el regulador anualmente. (Adimensional < 1). Mientras que para el escenario 2: FOm<1 FO<1 Lreal=(M2*FOm*PEGEE1) +[M2*(FO-FOm)*PEGEE2] -(M2*Th) (6) Expresión en la cual se observa que la valoración de la energía al precio PEGEE1 se ve penalizada al multiplicarse por FOm, este factor de operatividad, de acuerdo a su expresión de cálculo siempre será un valor decimal inferior a la unidad. En el caso de la energía valorada a PEGEE2 la penalización es aún mayor al multiplicarse por la diferencia de FO y FOm siendo ambos factores de operatividad número decimales inferiores a la unidad. Con base en el factor de operatividad la liquidación comercial de la energía generada por el grupo electrógeno es de dos tipos: si FO≤FOm L=(M2*FOm*PEGEE1) +[M2*(FO-FOm) *PEGEE2] si FO>FOm Escenario 1: Cliente genera solamente durante las horas de racionamiento, es decir el FO es menor o igual a FOm. Para el escenario 1 se tendría: PEGEE1=CO&M+Cc FO≤FOm PEGEE2=PEGEE1*(1+M) FO>FOm (3) L=M2*PEGEE1 Como se puede observar, el esquema comercial establecido hace que la valoración económica de la energía producida por el grupo electrógeno de emergencia del cliente calificado dependa en gran medida del factor de operatividad (FO), sin embargo analizando los posibles escenarios de producción para un cliente se tiene: En razón de lo analizado se observa que la regulación penaliza la valoración de la energía generada por el cliente si éste produce más allá de las horas de racionamiento, en otras palabras no incentiva (4) 77 la participación de los clientes para autoabastecerse en condiciones de déficit de energía del sistema, sino que hace exactamente lo opuesto. de energía y así aprovechar un potencial recurso que hasta ahora no ha sido considerado en la operación de los sistemas de distribución. No obstante lo anterior, se cree que el instrumento regulatorio sobre GD debería considerar como aspectos básicos los siguientes: Hasta la fecha las condiciones operativas del sistema nacional no han requerido la activación del esquema propuesto por la regulación 003/10, sin embargo por la forma de valoración económica, el incentivo para el cliente depende del precio PEGEE1 fijado por el CONELEC, el cual para el año 2010 fue establecido en 15ctv.USD/kWh. 6.1.1 Condiciones y características de la demanda No en todos los casos, la aplicación de la GD será conveniente desde las perspectivas técnicas y comerciales de la distribuidora y del cliente, esto en primera instancia orienta el trabajo regulatorio hacia las características que debe cumplir un cliente industrial para ser incluido en esquemas de GD, las cuales deberían como mínimo considerar: Si actualmente el sistema requiriese la activación de la regulación 003/10, se estima que el precio PEGEE1 no superaría los 10ctv.USD/kWh ya que los costos variables de producción de las unidades tipo motor de combustión interna con diesel actualmente disponibles en el mercado eléctrico mayorista del Ecuador, muestran un valor promedio de 8,026ctv. USD por kWh, valor que, de acuerdo a la regulación CONELEC 003/03 incluye los costos de adquisición y transporte de combustible. • La demanda media mensual o anual de potencia y energía. • La forma y variación de la curva promedio de demanda diaria. • Para esto es indispensable contar con un sistema de medición que posibilite obtener los datos de consumo de energía totales del cliente industrial con suficiente grado de resolución y precisión. La experiencia del presente estudio indica que es adecuado tener registros cuartohorarios de consumos de energía activa y reactiva de los últimos tres años para con estos datos obtener las curvas promedio de demanda diaria así como la duración anual de carga, esto permite visualizar el patrón típico de consumo, el rango de variación de demanda y las posibilidades de gestionar carga. 6. PROPUESTAS Y RECOMENDACIONES DESDE LA PERSPECTIVA REGULATORIA Los resultados obtenidos del análisis de la demanda de CARTOPEL, la gestión de demanda propuesta en el presente trabajo y el análisis realizado de las regulaciones vigentes en el Ecuador relacionadas con la temática expuesta; permiten deducir dos condiciones fundamentales que posibilitarían una correcta implementación de la gestión de la demanda en el país: 6.1.2 Aspectos técnicos de aplicación a) Contar con un instrumento regulatorio que permita explotar la capacidad gestionable de la demanda de energía eléctrica del sector industrial, el cual establezca las condiciones técnicas y comerciales de aplicación. b) Reestructurar los incentivos tarifarios vigentes para el sector industrial, así como también la actual Regulación sobre generación emergente para períodos de déficit y/o racionamiento eléctrico. La aplicación de la gestión de la demanda industrial debería abordar: • La definición de una metodología para la ejecución de auditorías eléctricas. • La tecnología de medición, supervisión y monitoreo. • El diseño de la metodología permitirá sistematizar el levantamiento, consolidación y análisis de la información de las cargas y del proceso productivo, con el objetivo de determinar, con suficiente grado de aproximación, el balance energético de la planta y con ello establecer los procesos de producción y las cargas que forman parte del porcentaje gestionable de demanda que no incide, o que afecta mínimamente, la producción de la industria. Del estudio aplicado a CARTOPEL se puede extraer que un aspecto clave que aporta exactitud y eficacia a la elaboración del balance energético es contar 6.1. Consideraciones para una Regulación sobre Gestión de Demanda y Generación Emergente para períodos de déficit de abastecimiento La elaboración de una Regulación sobre GD debe partir de un profundo y consciente análisis del consumo de energía que hacen las grandes industrias en el país, el cual permita plasmar en el documento final herramientas técnicas y comerciales efectivas que incentiven un mejor y más inteligente consumo 78 • • • • • con los registros de las mediciones de voltaje, corriente y potencia en los principales cuadros eléctricos y/o en las diferentes cargas y etapas del proceso productivo; mientras mayor sea la base de datos de mediciones mayor será el grado de exactitud y más eficaces las decisiones y acciones de gestión a implementarse. Dentro del contexto de aplicación efectiva de la GD, el aspecto de tecnología de medición, supervisión y monitoreo se vuelve esencial en razón de que su efectividad como recurso en la operación del sistema de distribución radicará en la capacidad de medir y cuantificar exactamente las reducciones de demanda solicitadas por la distribuidora al cliente, este aspecto en la actualidad puede ser solventado con la definición de los requerimientos de: cantidad de canales de medición, precisión, medios de comunicación, tipos de reportes y medios de almacenamiento de la información. Estos temas pueden ser cubiertos a través de la implementación de sistemas AMR o AMI y la visualización de la información de los medidores en el SCADA del centro de control de la distribuidora. Aspectos comerciales y remunerativos El análisis de la aplicación del esquema de generación emergente durante la crisis energética del año 2009 determinó que la remuneración económica recibida por los clientes calificados llegó a ser insuficiente para compensar los costos incurridos por la actividad de autogeneración. La aplicación de la GD como recurso en casos de restricción de abastecimiento energético, puede ser más efectiva para la distribuidora y más rentable para el cliente, esto en base a los resultados obtenidos de la evaluación realizada a la gestión con CARTOPEL en los cuales se determinó que la energía reducida con GD es comparable a la energía autogenerada por varios clientes calificados durante el período de crisis energética, con esto es plenamente viable que el regulador remunere este servicio al cliente. Con base en lo anterior es posible definir que la Regulación de GD deberá establecer parámetros para: Tratamiento de los costos de implementación de la GD, los cuales podrían ser cubiertos tanto por el cliente como por la distribuidora, tentativamente podría definirse que la auditoría tenga que ser pagada por el cliente, mientras que la implementación del sistema de control, supervisión y monitoreo por parte de la distribuidora. • Reducción tarifaria durante un período de tiempo fijo, con el objeto de incentivar al cliente industrial a ser considerado dentro del esquema de GD. • Remuneración de la actividad de GD para el cliente en la fase de activación, podrían ser analizados los esquemas de remuneración a precio fijo por kWh interrumpido, de forma similar a la establecida en la Regulación CONELEC 003/10, o también a precio marginal horario del mercado mayorista. • Posibilitar la recuperación por parte de la distribuidora, de los costos de implementación de la GD como por ejemplo el sistema de medición, supervisión y monitoreo, así como también el incentivo tarifario, dentro de las cuentas de reposición e instalación de nuevos medidores y déficit tarifario respectivamente. 6.2. Reformulación del factor de corrección por demanda La metodología actualmente aplicada para la determinación del factor de corrección por demanda para los clientes industriales con demanda horaria en media tensión, penaliza con un 20% de recargo económico si la relación entre demanda pico y máxima tiene un valor superior a 0,9, esta forma de cálculo incentiva el desplazamiento de la demanda hacia períodos horarios fuera de las horas pico del sistema (18:00 a 22:00), sin embargo esta metodología no puede ser aplicada a todos los clientes en razón de que su efectividad depende en gran medida de la forma que tenga la curva de carga típica del proceso productivo de la industria. La forma de cálculo del factor de corrección por demanda ha dado como resultado, para el caso de CENTROSUR, que casi un tercio del total de clientes industriales con demanda horaria en media tensión no sean capaces de modificar su curva de demanda, esta cantidad casi no ha variado a lo largo de los últimos tres años lo que demuestra que para ellos no es posible por condiciones técnicas y/o económicas modificar su patrón de consumo eléctrico. Es por lo tanto indispensable que el organismo regulador rediseñe esta metodología de forma que incluya parámetros técnicos sobre el tipo de industria y consumo de energía que requiere para ejecutar sus procesos de producción. 79 • Las estadísticas de la demanda y de los clientes atendidos por la distribuidora muestran que aproximadamente un tercio de la demanda de energía es de responsabilidad del segmento industrial, este tipo de clientes representa apenas el 2% del total de clientes de la distribuidora, el 90% de la energía del segmento industrial se concentra en 590 clientes, estos datos justifican la consideración y análisis de la GD como un recurso energético con el potencial de constituirse en apoyo eficaz al sistema de distribución para solventar problemas de abastecimiento ya que un efecto apreciable podría ser alcanzado trabajando con un número muy reducido de clientes. • La regulación vigente sobre la Operación de Grupos Electrógenos de Emergencia (CONELEC 003/10) es la única que incentiva la modificación del patrón de consumo de energía de los clientes industriales durante períodos de déficit y/o racionamiento energético, sin embargo el mecanismo de cálculo de la compensación económica para el cliente en lugar de incentivar esta actividad termina por penalizarla. Para que su aplicación sea efectiva en su propósito de convertir a la demanda industrial en un efectivo recurso en situaciones de contingencia del sistema eléctrico, es indispensable que su forma de cálculo sea revisada en su totalidad. • Para que la aplicación de la GD sea efectiva es necesario que se flexibilice el cálculo del factor de corrección por demanda para los clientes industriales y que se incluya la variable del tipo de demanda o patrón de consumo en su determinación. • La principal barrera que dificulta la aplicación de la gestión de la demanda es la ausencia de un marco regulatorio que la conciba como un efectivo recurso energético del sistema eléctrico, • La evaluación de la GD para el caso del cliente CARTOPEL muestran que ésta puede ser tan o más eficiente que la generación de emergencia para escenarios de contingencia, por ello se recomienda que la operación de grupos electrógenos de emergencia sea incluida como una forma de alcanzar los porcentaje de GD solicitados en un determinado momento por la distribuidora o por el operador del sistema, es decir que sea el cliente quien determine si mediante la autogeneración puede reducir aún más su curva de demanda en función de lo requerido por el sistema y así alcanzar mayores proporciones de compensación por gestión de demanda. • Es recomendable que la introducción de la gestión de la demanda en el país, comience con un proceso de concientización y socialización 7. CONCLUSIONES Y RECOMENDACIONES • La gestión de demanda sobre la carga de CARTOPEL es posible, sin embargo se ve fuertemente afectada por la forma del patrón de consumo que tiene el proceso productivo, los resultados del presente estudio muestran que las cargas con posibilidades de gestión suman alrededor de 982kW, valor que en comparación con la demanda máxima del sistema de distribución puede ser insignificante. Resultados más significativos podrían ser alcanzados si el esquema de gestión es aplicado en mayor cantidad de usuarios industriales que presenten un mayor potencial de carga gestionable. • La aplicación de la gestión de demanda en el sector industrial requiere de un esquema regulatorio claro y específico que establezca las condiciones técnicas y comerciales de implementación. La normativa nacional sobre implementación de planes de GD debería estar orientada hacia el uso eficiente de la energía por parte del cliente, y a su ejecución como recurso energético en condiciones de crisis de abastecimiento por parte de la distribuidora. • La evaluación de la potencial reducción de carga y su impacto económico tomó como base los históricos de demanda de la industria y de la distribuidora para caracterizar el patrón diario de consumo, sin embargo la evaluación de la aplicación real de un esquema de GD debe contemplar la instalación de sistemas de medición inteligente con capacidad de adquisición remota de los datos de consumo de energía del cliente, esto es indispensable con el objeto de monitorear y realizar una evaluación técnica y económica exacta. • La GD y sus potenciales resultados de aplicación muestran que puede ser mucho más efectiva que los esquemas de generación emergente para satisfacer condiciones de déficit y/o racionamiento de energía, el presente estudio muestra que la potencia con capacidad de interrupción, para el caso de CARTOPEL, “produce” una energía de 449.922kWh mensuales calculados para un tiempo de desconexión medio diario de 10 horas; esta reducción de energía comparada con la energía generada por todos los clientes durante el mes de mayor contribución de los generadores emergentes representa el 58,88%, este resultado indica que un solo cliente con un adecuado plan de GD tiene el potencial de generar ahorros comparables que los obtenidos al aplicar la generación de emergencia. 80 con los clientes industriales, este proceso debe ser liderado por el organismo regulador así como por las distribuidoras dentro de su zona de concesión. • Se recomienda la implementación de proyectos piloto como una forma de incentivar la participación del segmento industrial, estos proyectos permitirán tanto al regulador como a la distribuidora hacer evaluaciones preliminares y comparar los resultados con las expectativas iniciales del proyecto, estos pilotos deberán incluir clientes de gran demanda de energía. • Para que la implementación de la GD sea efectiva, un aspecto de suma importancia lo constituyen la medición, resolución, adquisición y análisis de los datos de demanda eléctrica del “cliente gestionable”, por esto se recomienda que la información se encuentre disponible en tiempo real tanto para la distribuidora como para el usuario, esta característica del sistema permitirá evaluar técnica y económicamente el impacto de la GD solicitada a los clientes además de brindar al usuario la posibilidad de controlar sus consumos de energía así como el costo económico de su abastecimiento energético. • El requerimiento de contar con equipos de medición de una precisión y resolución elevadas para la aplicación de la GD, hace recomendable que se vaya considerando la opción de migrar desde la tarifa fija por período horario hacia tarifas horarias que reflejen efectivamente el costo de la energía, con esto se lograría que la demanda eléctrica al fin sea flexible ante los precios de la oferta, con lo cual se podría alcanzar un uso más eficiente de energía por parte de los consumidores. [4] MAURER L., “Tariff Schemes to Foster Demand Response (DR)=Energy Efficiency (EE) and Demand Side Management (DSM)”, Presentation for “International Seminar on Electricity Tariff Structure”, Brazilian Electricity Regulatory Agency, Brasilia, june 2009. [5] KÄRKKÄINEN S., “DSM Experiences in Nordic Countries”, Presentation for “TAIEX Workshop on Demand Side Management in Energy Efficiency”, Technical Assistance Information Exchange Instrument (TAIEX), European Commission, Ankara, november 2007. [6] LEE S. / LEE HC. / YOO TH. / NOH JW. / NA YJ. / PARK JK. / MOON SI. / YOON YT., “Demand Response Prospect in the South Korean Power System”, Korea Electr. Eng. & Sci. Res. Inst. (KESRI), IEEE -Power and Energy Society General Meeting, Minneapolis, MN, 2010. [7] VINTIMILLA, PALADINES, “Auditoria Eléctrica a la Fábrica de Cartones Nacionales CARTOPEL S.A.I.”, Tesis de grado Ingeniería Eléctrica, Universidad Politécnica Salesiana, Cuenca, 2012. [8] CONSEJO NACIONAL DE ELECTRICIDAD – CONELEC, “Plan Maestro de Electrificación 20092020”, Dirección Ejecutiva CONELEC, Quito – Ecuador, 2009. [9] CONSEJO NACIONAL DE ELECTRICIDAD – CONELEC, “Análisis de Costos para las Empresas Eléctricas Sujetas a Regulación de Precios”, Dirección de Tarifas CONELEC, Quito – Ecuador, marzo 2011. REFERENCIAS BIBLIOGRÁFICAS [1] TASK VIII: DEMAND-SIDE BIDDING IN A COMPETITIVE ELECTRICITY MARKET, “A Practical Guide to Demand-Side Bidding”, International Energy Agency Demand-Side Management Programme, United Kingdom. 2003, www.ieadsm.org [2] DG DE INDUSTRIA, ENERGÍA Y MINAS, “Guía Básica de la Gestión de la Demanda Eléctrica”, Comunidad de Madrid, 2007, www.madrid.org [10] CONSEJO NACIONAL DE ELECTRICIDAD –CONELEC, “Estadística del Sector Eléctrico Ecuatoriano Año 2008”, Dirección Ejecutiva Interina CONELEC, Quito – Ecuador, abril 2009. [11] CONSEJO NACIONAL DE ELECTRICIDAD –CONELEC, “Regulación CONELEC 006/09 -Generación de Emergencia”, Dirección Ejecutiva CONELEC, Quito – Ecuador, 2009. [12] CONSEJO NACIONAL DE ELECTRICIDAD –CONELEC, “Regulación CONELEC 003/10 -Operación Técnica-Comercial de Grupos Electrógenos de Emergencia en Períodos de Déficit y/o Racionamiento”, Dirección Ejecutiva CONELEC, Quito – Ecuador, 2010. [3] FARUQUI A. / HLEDIK R. / WIKLER G. / GHOSH D. / PRIJYANONDA J. / DAYAL N., “Bringing Demand-Side Management to the Kingdom of Saudi Arabia –Final Report”, The Brattle Group Inc., 2011. 81 [13] CONSEJO NACIONAL DE ELECTRICIDAD –CONELEC, “Pliego Tarifario para Empresas Eléctricas, Año 2012”, Dirección de Tarifas CONELEC, Quito – Ecuador, 2011. Pablo Méndez Santos.- Nació en Cuenca en 1979. Recibió el título de Ingeniero Eléctrico en la Universidad Politécnica Salesiana en 2004 y el título de Magister en Sistemas Eléctricos de Potencia por la Universidad de Cuenca en 2013. Actualmente se encuentra laborando en la Dirección de Comercialización de la Empresa Eléctrica Regional Centro Sur en el área de Mercado Eléctrico y Grandes Clientes y es docente de la carrera de Ingeniería Eléctrica en la Universidad Politécnica Salesiana de Cuenca. 82 Análisis de parámetros técnicos en eficiencia de iluminación para el edificio matriz de la Empresa Eléctrica Regional Centro Sur. M. A. Dávila E. F. Durán Universidad Politécnica Salesiana Resumen— Análisis energético realizado en las instalaciones de la Empresa Eléctrica Regional Centro Sur C.A. de la ciudad de Cuenca. Alternativas de ahorro para disminuir el consumo energético en iluminación. Incidencia del reemplazo de lámparas T8 por T5 sobre el índice de eficiencia energética de la instalación. para aplicar los criterios de ahorro. En el capítulo III se aplican los criterios de ahorro en iluminación, en cargas puntuales y la utilización de sensores de movimiento. Se aplican los diferentes criterios de eficiencia y se obtiene el ahorro económico generado En el capítulo IV se resume los resultados obtenidos al aplicar los sistemas y criterios de ahorro y se realiza un análisis económico de la alternativa de cambiar las lámparas T8 por T5 y su incidencia en el índice de eficiencia energética de la instalación de iluminación. Palabras clave— Eficiencia Energética, Eficiencia en Iluminación, Lámparas fluorescentes, Índice de eficiencia energética. 2. INSTALACIONES DE ILUMINACIÓN PRESENTES EN EL EDIFICIO Abstract— An energy analysis was performed on the facilities of the Empresa Eléctrica Regional Centro Sur. S.A. (Central South Regional Electrical Company) in Cuenca city. Savings alternatives to reduce energy consumption from lighting. The incidence of replacing T8 lamps with T5 lamps on the location’s energy efficiency index. Index Terms— Energy Efficiency, Fluorescent Efficiency Index. Las instalaciones de iluminación del edificio de la CENTROSUR, está predominado por luminarias fluorescentes con boquilla tipo T8. Para obtener un ahorro energético considerable, se analizará la opción de sustituir las lámparas fluorescentes T8 por lámparas fluorescentes T5 (fig.1). Efficiency, Lighting Lighting, Energy 1. INTRODUCCIÓN La Empresa Eléctrica Regional Centro Sur, como ejemplo para sus clientes y para la sociedad, siempre se ha preocupado de disminuir el consumo energético durante sus actividades, y así evitar la mala utilización de recursos. Para esto, se han realizado varios análisis dentro del edificio matriz, con el objeto de determinar los puntos de consumo energético ineficientes o sobreutilizados. Figura 1: Diferencia entre lámparas T12, T8 y T5 [8] Como un complemento a estos de estudios, en el presente documento, se presenta un análisis enfocado en el sistema de iluminación, y la utilización de equipos de oficina como computadores e impresoras. El análisis presentado, pretende encaminar un procedimiento de auditoría energética dentro de la empresa, para lograr los menores índices de consumo. Para dicho análisis, se seleccionó la planta baja del edificio matriz para el cálculo referencial. Esta selección se realizó por las siguientes características: • La planta baja es dedicada a la atención al cliente • En esta planta se ubica el cuarto de telecomunicaciones. • En este piso se encuentran departamentos de vital importancia, tal es el caso del En el capítulo II se indica la situación actual del sistema de iluminación de la empresa y se realiza una simulación para obtener los parámetros requeridos 83 Departamento de Supervisión y Operación, el Centro de Operación de la Distribución, oficinas de alumbrado público, puntos de pago, etc. que debemos analizar es la eficacia de iluminación en cuanto se refiere a la iluminación directa o indirecta. 2.1. Situación actual en iluminación En el análisis lumínico, se utilizó el software DIALUX con el modelo en tres dimensiones de la instalación (fig.2). Utilizando los datos presentes en el levantamiento previamente realizado por la empresa HRG, Ingeniería y servicios; y, mediante una inspección en sitio, se identificaron cuatro tipos de luminarias existentes en la instalación (tabla 1). Figura 3: Distribución isolumínica actual Tabla 3: Resultados de la simulación: Iluminancias medias Para esto se debe tener en cuenta que en una instalación eficaz y eficiente, siempre se preferirá la iluminación directa al puesto de trabajo, o al área en la que se requiera dicha iluminación. La iluminación indirecta constituye pérdidas, pues no influye directamente en la comodidad visual del usuario. En la tabla 4 se muestra la eficacia de iluminación de la instalación, junto con las pérdidas lumínicas establecidas. Figura 2: Modelo tridimensional Tabla 1: Luminarias existentes en la planta baja Tabla 4: . Eficacia de iluminación existente Con estos valores, se realizó la simulación del sistema de iluminación actual en la CENTROSUR. Esto se realizó con luminarias virtuales de gran similitud a las utilizadas en la instalación real (tabla 2) Con estos valores, podemos proceder al cálculo de las potencias consumidas en la instalación, y la energía consumida que tendrá su repercusión directa en la planilla de pago. En la tabla 5 observamos las potencias consumidas por cada tipo de luminaria existente en la instalación. Tabla 2: . Lista de luminarias simuladas Tabla 5: . Potencia total consumida existente Una vez ubicadas todas las luminarias, se realizó la simulación con lo cual se pudo obtener la distribución lumínica en la edificación (fig. 3). Como podemos observar en la tabla 3, la luminancia media está dentro de los límites establecidos . Otro factor importante 84 Costo mensual=$450.68/mes Costo anual=$5408.13 Otro factor importante es el cumplimiento del UGR (Índice de deslumbramiento unificado), el cual debe cumplir con la norma UNE 12464-1, cuyos límites máximos en oficinas se muestran en la tabla 6 3. ANÁLISIS DE CONSUMO DE ENERGÍA EN OFICINAS Y SOLUCIONES ENERGÉTICAS Tabla 6: . Límite de iluminancias y UGR en oficinas [2] Los sistemas principales de consumo energético en las instalaciones en edificios de oficinas son: • Iluminación • Equipamiento específico: Ordenadores, Impresora, etc. • Equipamiento general: neveras, cafeteras, etc. • Se empezó por el inventario de los equipos existentes, la potencia nominal de cada uno de ellos y su utilización. Este último parámetro permite determinar el factor de simultaneidad en cada una de las etapas de la jornada laboral. El propósito es conocer la potencia máxima que realmente se utiliza, y establecer si modificando el régimen de funcionamiento de determinados equipos, puede disminuirse el consumo energético (tabla 8). Con la simulación en Dialux se observa que se cumplen los requerimientos de la norma. (UGR=17 y Em=505). Es decir, la instalación existente cumple con el diseño lumínico requerido para actividades de escritura y tratamiento de datos. 2.2. Consumo energético de luminarias La CENTROSUR, al ser una empresa privada al servicio de la ciudadanía, labora normalmente desde las 8h00 hasta las 16h30, pero además el personal encargado de atención de reclamos, y el personal de mantenimiento del edificio laboran fuera de horarios normales de oficina, siendo esto un porcentaje considerable (tabla 7). Tabla 8: Principales consumidores energéticos dentro del edificio Tabla 7: . Datos de utilización de las instalaciones de iluminación del edificio matriz de la CENTROSUR Por lo tanto, se utilizarán aproximadamente 4 horas más de iluminación además de las presentes en el horario de atención normal, es decir: Horas de uso por día=13 horas Días de uso al mes=24 días En general, las instalaciones de la CENTROSUR son eficientes energéticamente, pero este panorama puede mejorar tomando en cuenta ciertas modificaciones como el uso de luminarias fluorescentes tipo T5. Otro análisis que se debe realizar es la utilización de sensores de movimiento o presencia en pasillos y gradas, pues en horarios fuera de oficina, las luminarias en estos sectores permanecen encendidas innecesariamente. Con estos valores calculamos el consumo mensual de la instalación con la ecuación 1. Consumo mensual (1) Consumo mensual=5633.47Kwh/mes 3.1. Control de equipos ofimáticos Teniendo en cuenta un costo de $0.08 por kwh, se tiene: Siempre que sea posible, se deben adquirir equipos con sistemas de ahorro de energía (por ejemplo “Energy Star”) que incorporan un modo de “stand by” o espera, que se activa cuando el equipo lleva un tiempo programable sin ser utilizado. En este modo, Costo mensual=consumo mensual*costo por Kwh (2) 85 el consumo de energía es hasta un 17% inferior al que se produce en modo normal [9]. tipo de luminaria u otra, debemos analizar los factores que diferencian a ambos tipos de luminarias (tabla 10). En la CENTROSUR recientemente se adquirieron equipos LEXMARK, los cuales cuentan con la opción del ECO-MODE, es decir, que pueden entrar en modo de bajo consumo luego de un tiempo de inactividad. Además, se pueden tomar medidas de corrección en otros equipos para disminuir el consumo de energía: Tabla 10: Comparación de lámparas fluorescentes T8 y T5 [3,4,6] • Apagado de computadores mediante direccionamiento IP. • Activación del modo ecológico en todos los equipos que permitan esta configuración • Utilizar un salvapantallas de color negro en todos los monitores. Debido a que las lámparas T5 tienen un mejor rendimiento lumínico superior a las lámparas T8, las potencias utilizadas pueden ser menores y alcanzar una iluminancia media igual. En este caso se hicieron las siguientes modificaciones: 3.2. Aplicación de soluciones de eficiencia en iluminación Algunas medidas que se pueden tomar para la disminución del consumo energético en iluminación [3] son: • Lámpara de 32W T8 sustituida por lámpara de 28W T5 • Lámpara de 18W T8 sustituida por lámpara de 14W T5 • Colocar detectores de presencia en pasillos o garajes. • Iluminar directamente los puestos de trabajo (iluminación localizada). • Aprovechar al máximo la luz natural, empleando sensores de luz ubicados cerca de las ventanas. Con estos cambios se realizó la simulación respectiva, con lo que se obtuvo el plano isolumínico (fig.4). Los resultados de estas soluciones de ahorro energético se pueden observar en la tabla 9. Tabla 9: Opciones de mejoras en iluminación [4] En el presente análisis, no se considera el cambio de lámparas incandescentes por lámparas compactas fluorescentes pues después de un recorrido por el edificio, se observó que actualmente todas las instalaciones que requieren de una bombilla incandescente ya han sido reemplazadas por una lámpara compacta. Figura 4: Distribución isolumínica con lámparas t5 Las luminarias utilizadas en la simulación tienen las características mostradas en la tabla 11 y los resultados de la simulación se muestran en la tabla 12. Tabla 11: Características de las luminarias T5 Las luminarias tipo T5 son una alternativa para la eficiencia energética de edificios, pero su costo aún es muy elevado en comparación con las luminarias tipo T8. Normalmente se cree que el cambio de T5 a T8 beneficiará inmediatamente al rendimiento de la instalación, pero no siempre es así. Para optar por un 86 Tabla 12: Iluminancias medias con lámparas T5 Tabla 15: Cotización de los materiales involucrados para el cambio de luminarias en la planta baja En la tabla 13 se muestra la eficacia de iluminación de la instalación proyectada, junto con las pérdidas lumínicas establecidas. Tabla 13: . Eficacia de iluminación proyectada Como podemos observar, la solución es cinco veces más costosa que el pago total de iluminación de la zona de análisis durante un año. Como podemos observar, no existe mayor diferencia entre las luminancias obtenidas con luminarias T8 y con las obtenidas con luminarias T5 de menor potencia. En la tabla 14 observamos las potencias consumidas por cada tipo de luminaria proyectada en la instalación. Es una norma europea que establece las exigencias básicas de calidad, seguridad y habitabilidad de los edificios y sus instalaciones, emitida mediante el Real Decreto 314/2006. Para un proyecto de mejoras, se deben verificar los siguientes parámetros: • Cálculo del valor de eficiencia energética de la instalación VEEI • Comprobación de la existencia del sistema de control y regulación que optimice el aprovechamiento de luz natural • Verificación de la existencia de un plan de mantenimiento • Para cada zona debe figurar, junto con los cálculos justificativos, la siguiente información: Índice del local (K) utilizado en el cálculo, número de puntos considerados, factor de mantenimiento previsto (Fm), Iluminancia media mantenida (Em), índice de deslumbramiento unificado (UGR), índice de rendimiento del color (Ra), el valor de eficiencia energética de la instalación y las potencias de los conjuntos formados por lámpara más equipo auxiliar. Tabla 14: Eficacia de iluminación proyectada Utilizando los mismos parámetros calculados anteriormente, el consumo energético se calcula mediante las ecuaciones 1 y 2. Consumo mensual = 4893.41Kwh/mes Costo mensual = $391.47/mes Costo anual = $4697.67 Por lo tanto, las luminarias T5 son $710.46 más económicas en un año que las luminarias T8, es decir, un 13% de ahorro. El VEEI es el valor definido como la potencia de iluminación que se induce en una superficie específica [10] (Ecuación 3). El cambio de lámparas T8 por T5, como se ha mencionado anteriormente tiene un valor elevado. Para tener una referencia del costo por cambio del conjunto lámpara-soportes-balasto, los costos unitarios y totales (tomando en cuenta el cambio total de las lámparas de la planta baja) por concepto de materiales son los mostrados en la tabla 15. (3) Para el caso actual, es decir, con lámparas tipo T8, se tiene: 87 : (4) recalcar que todas las soluciones son aproximaciones de ahorro, pues los análisis están basados en potencias promedio de consumo en cuanto a equipos de oficina, y a iluminancias promedio dadas por las lámparas T5. En caso de sustituir todas las lámparas T8 por tipo T5, sería: 4.1. Ahorro en iluminación con sustitución de lámparas fluorescentes T8 por T5 El análisis realizado por la sustitución de lámparas fluorescentes tipo T8 por lámparas T5, constituye un ahorro sustancial, debido a las características mejoradas de las lámparas T5 (Tabla 17). (5) Para este valor se establecen unos valores mínimos, diferenciándose en los edificios dos tipos de zona. Las de representación y las de no representación [10]. “Se entienden por zonas de representación aquellas donde el criterio de diseño, imagen o estado anímico que se quiere transmitir al usuario con la iluminación, son preponderantes frente a los criterios de eficiencia energética. Por el contrario, zonas de no representación son aquellas donde los criterios como el nivel de iluminación, confort visual, seguridad y eficiencia energética son más importantes que cualquier otro criterio” [10]. En el caso de la CENTROSUR, se requiere cumplir con los criterios de las zonas de no representación, para las cuales el VEEI límite está dado por los valores presentes en la tabla 16. Tabla 17: Ahorro energético mediante sustitución de lámparas T8 por T5 4.2. Ahorro en iluminación con sustitución de balastos magnéticos por balastos electrónicos. Como se mencionó en puntos anteriores, el uso de balastos electrónicos en cada luminaria, constituye un ahorro sustancial de aproximadamente el 20% [3,4] del consumo de potencia de las lámparas, y además disminuye el “parpadeo” de los tubos fluorescentes, lo que mejora la comodidad visual de los usuarios (tabla 18). Tabla 16: Valores límites de eficiencia energética de la instalación [10] Tabla 18: Ahorro energético considerando las posibilidades lámpara-balasto 4.3. Ahorro en consumo de energía en equipos de oficina Por lo tanto, el valor de VEEI alcanzado con las luminarias T5 se aproxima de mejor manera a los valores límites establecidos. En los equipos de oficina, la opción más recomendable para lograr un ahorro energético, es actuar sobre el equipamiento específico, obteniendo un control sobre la hora de apagado de los mismos, así también como la activación de los modos de ahorro energético disponibles. Considerando un ahorro del 17% [3,4] del consumo, se obtuvieron los datos mostrados en la tabla 19. 4. RESUMEN DE ACTIVIDADES A REALIZAR PARA DISMINUIR EL CONSUMO ENERGÉTICO Una vez realizado el análisis de propuestas de ahorro energético, a continuación se resumirán cada solución con su respectivo aporte (ahorro en planilla). Cabe 88 Utilizando las opciones energéticas adicionales que se plantearon en el documento se obtienen los datos mostrados en la tabla 22: Tabla 19: Ahorro energético considerando un control de apagado, y modos económicos para los equipos de oficina Tabla 22: Amortización con lámparas T5, balasto electrónico y control de equipos de oficina 5. RESULTADOS PROYECTADOS En la tabla 20, se muestran las opciones de ahorro energético descritas en el presente documento. Se puede observar el consumo anual y mensual que se tendría con cada una de las opciones, y al final se observa el ahorro final con la solución más eficiente estudiada, es decir, sustituyendo las lámparas T8 por T5, utilizando balastros electrónicos en cada luminaria, y realizando un control en el horario de encendido y apagado en los equipos de oficina. 6. CONCLUSIONES Y RECOMENDACIONES La eficiencia energética en edificios de oficinas es un factor de ahorro muy importante, pues mediante pequeñas modificaciones en la utilización de equipos, o mediante cambios en las instalaciones de iluminación, se pueden lograr ahorros considerables. En el presente trabajo se analizó únicamente la instalación de iluminación, y ciertos parámetros de las instalaciones de fuerza, pero debe ser complementado con estudios de aislamiento térmico, ventilación, entre otros, para lograr la maximización en la eficiencia energética del edificio de la CENTROSUR. Tabla 20: Resultados proyectados Por lo tanto el ahorro sustancial es de $2,705.97, que mediante la inversión inicial de $5432.08, se pagará en aproximadamente 2 años. Los puntos tratados en el proyecto son los siguientes: Sustitución de luminarias tipo T8 por luminarias tipo T5 para disminuir potencias consumidas y aumentar valores de iluminancias en cada zona, utilización de balastos electrónicos de alta frecuencia en las luminarias, con el objetivo de disminuir la potencia y el efecto estroboscópico, y el control de modos ecológicos presentes en equipos de impresión y computadores. Estos pequeños cambios pueden significar un ahorro de $2705.97 en comparación con la situación actual de la instalación. El análisis realizado se enfocó únicamente a la primera planta baja del edificio matriz de la Empresa Eléctrica Regional Centro Sur C.A. en la ciudad de CuencaEcuador. Dicho estudio debe extenderse a la totalidad del edificio realizando las consideraciones específicas de cada puesto de trabajo. 5.1. Rentabilidad Realizando la amortización de los costos de consumo, y mantenimiento de las lámparas T5, se obtienen los datos mostrados en la tabla 21: Tabla 21: Amortización con cambios T8-T5 REFERENCIAS BIBLIOGRÁFICAS [1] “Guía de ahorro y eficiencia energética en oficinas y despachos”. Dirección General de Industria, Energía y Minas de la comunidad de Madrid. Madrid, España, 2007. 89 [2] “Norma Española UNE-EN 12464-1. Iluminación en los lugares de trabajo Parte 1: Lugares de trabajo en interiores”. Madrid, España, 2003 [10] “Sección HE3 Eficiencia energética de las instalaciones de iluminación”. Código Técnico Español. Madrid, España, 2010 [3] “Guía de auditorías energéticas en edificios de oficinas en la Comunidad de Madrid”. Dirección General de Industria, Energía y Minas de la comunidad de Madrid. Madrid, 2007. Edgar Fernando Durán Contreras.Universidad de Cuenca: Ingeniero Eléctrico. Universidad Politécnica Salesiana: Docente en la facultad de Ingeniería Eléctrica en las materias de Sistemas Eléctricos de Potencia, Sistemas de Distribución, Electrotecnia I y II, Circuitos Eléctricos I y II, Luminotecnia, Diseño I. Docente de Seminarios de Distribución para ECUACER. Superintendente del sistema de Operación y Distribución de la Empresa Eléctrica Regional Centro Sur C.A. [4] “Guía del consumo y facturación de energía eléctrica. Cliente regulado bt5 residencial”. Ministerio de Energía y Minas. Lima, 2012. [5] “Real decreto 1890/2008: Reglamento de eficiencia energética en instalaciones de alumbrado exterior y sus instrucciones técnicas complementarias EA-01 a EA-07”. Ministerio de Industria, Turismo y Comercio. Madrid, 2008 Miguel Alberto Dávila Sacoto.Nació en Cuenca en 1988. Recibió su título de Ingeniero Electrónico con mención en Sistemas Industriales y Telecomunicaciones de la Universidad Politécnica Salesiana en 2012. Egresado de la carrera de Ingeniería Eléctrica de la Universidad Politécnica Salesiana Actualmente se desempeña como docente de Instalaciones Eléctricas de Interior, Automatismos y Cuadros Eléctricos, Instalaciones Automatizadas en Viviendas y Edificios en la Unidad Educativa Técnico Salesiano. [6] “Informe técnico: Iluminación LED, Tubos luminosos, Equivalencia Fluorescentes”. Grupo Sólydi. 2012 [7] “Libro verde sobre la eficiencia energética o cómo hacer más con menos”. Comisión de las Comunidades Europeas. Bruselas, 2005. [8] “Thin is in: The Skinny on T5 Linear Lighting”. The Green Savings Company (2011). Documento en línea disponible en http:// greensavingsco.com/2011/04/thin-is-in-theskinny-on-t5-linear-lighting/ [9] “Proactive approach drives further improvement of environmental performance of products”. Lexmark Incorporated. 2011. Documento en línea disponible en http://www.lexmark. com/en_GB/about-us/newsroom/newsreleases/2011/09-12-lexmark-reinforcesenvironmental.shtml 90 Evaluación de la Vulnerabilidad del Sistema Eléctrico de Potencia en Tiempo Real usando Tecnología de Medición Sincrofasorial J.C. Cepeda† D. G. Colomé‡ †Centro Nacional de Control de Energía Instituto de Energía Eléctrica, Universidad Nacional de San Juan ‡ Resumen— Este trabajo presenta una metodología innovadora para evaluar, en tiempo real, la vulnerabilidad post-contingencia del sistema eléctrico de potencia (SEP). Usando como datos de entrada señales registradas en unidades de medición sincrofasorial (PMU), se determinan indicadores que brindan alerta temprana del riesgo de ocurrencia de colapsos. La evaluación de vulnerabilidad post-contingencia se estructura considerando cuatro tipos de inestabilidades (transitoria, oscilatoria, de frecuencia, y de voltaje de corto plazo) y posibles sobrecargas. La propuesta permite evaluar las dos tareas involucradas en el concepto de vulnerabilidad: i) valoración del estado de seguridad del sistema, y ii) análisis de la tendencia del sistema a cambiar sus condiciones a un estado crítico. La metodología de evaluación se aplica al sistema de prueba de New England. Los resultados resaltan una alta eficacia del esquema integral de evaluación para brindar alerta temprana de riesgos de eventos en cascada del SEP, valorando las dos tareas involucradas en el concepto de vulnerabilidad. system. The results highlight the comprehensive assessment scheme’s high level of effectiveness for providing early warnings about EPS cascading risk events, analysing the two tasks involved in the vulnerability concept. Index Terms— Data mining, stability, vulnerability assessment, PMU, security, overload. 1. INTRODUCCIÓN La inclusión de mercados desregulados, la falta de inversión, la operación con líneas de transmisión congestionadas, y otras razones técnicas, como restricciones de tipo ambiental, han llevado a operar los sistemas de potencia (SEP) peligrosamente cerca de sus límites físicos. Bajo estas condiciones, ciertas perturbaciones críticas pueden disparar eventos en cascada que eventualmente conduzcan al sistema a colapsos [1]. En tal sentido, se plantea la necesidad de desarrollar metodologías de protección del SEP que no solo resguarden a equipos y personas sino que permitan mantener la seguridad y continuidad del servicio eléctrico. Por esto, sistemas de protección especiales (SPS) son diseñados para detectar condiciones anormales del sistema y efectuar acciones correctivas que mitiguen las posibles consecuencias. Sin embargo, las condiciones que llevan al sistema a la posibilidad de un colapso, es decir, que lo vuelven vulnerable, no son fáciles de determinar, debido a que el proceso de un colapso depende de múltiples interacciones [1]. Palabras clave— Data mining, estabilidad, evaluación de vulnerabilidad, PMU, seguridad, sobrecarga. Abstract— This work presents an innovative methodology for assessing the post-contingency vulnerability of electric power system (EPS) in real time. By using post-contingency electric signals recorded by phasor measurement units (PMU) as input data, the approach determines early-warning indicators about potential collapse hazards. The post-contingency vulnerability assessment considers four types of instability (transient, oscillatory, frequency and short-term voltage) and possible overloads. The proposal allows for assessing two tasks involved in the vulnerability concept: i) system security status assessment, and ii) analysis of the system’s tendency to change its conditions to a critical state. The assessment methodology is applied to the New England test Este contexto ha establecido la necesidad de desarrollar modelos matemáticos y herramientas prácticas que permitan diseñar una red inteligente (Smart Grid) auto-curable (Self-Healing Grid), capaz de llevar a cabo funciones de reconfiguración y control de área extendida en tiempo real [1]. La evaluación de la vulnerabilidad dinámica (DVA) del sistema en tiempo real constituye una parte fundamental de este objetivo ya que permite decidir y coordinar las acciones de control correctivo en tiempo real, dependiendo de la evolución del evento [1]. 91 En la actualidad, modernas tecnologías tales como los medidores sincrofasoriales (PMUs) y los sistemas de monitoreo de área extendida (WAMS) facilitan el diseño de mecanismos capaces de realizar DVA luego de ocurrida una contingencia. Los resultados podrían establecer indicadores que disparen la actuación de SPSs en tiempo real, permitiendo mejorar el desempeño de las acciones de control correctivo [2]. 2.2. Síntomas de vulnerabilidad del SEP La vulnerabilidad del SEP está caracterizada por cuatro diferentes síntomas de estrés: inestabilidad de ángulo, inestabilidad de voltaje, inestabilidad de frecuencia y sobrecargas [5]. De estos síntomas, el presente artículo se enfoca en analizar cinco fenómenos que ocurren en el llamado “corto plazo”, que se limita a 15 o 20 segundos luego de ocurrida una perturbación. Estos fenómenos incluyen: estabilidad transitoria, estabilidad oscilatoria, estabilidad de voltaje de corto plazo, estabilidad de frecuencia de corto plazo, y sobrecargas post-contingencia. Este trabajo presenta una novedosa metodología que permite realizar DVA, tomando en consideración cinco diferentes síntomas de alerta, tales como: inestabilidad transitoria, inestabilidad oscilatoria, inestabilidad de voltaje de corto plazo, inestabilidad de frecuencia de corto plazo, y sobrecargas. La propuesta permite evaluar las dos tareas involucradas en el concepto de vulnerabilidad: i) valoración del estado de seguridad del sistema (seguridad estática y dinámica), y ii) análisis de la tendencia del sistema a cambiar sus condiciones a un estado crítico llamado “estado al borde del colapso”. 2.3. Sistema de medición sincrofasorial Las unidades de medición sincrofasorial (PMUs) son dispositivos que permiten estimar sincrofasores (fasores que tienen como referencia angular a una onda coseno de frecuencia nominal, sincronizada con el tiempo UTC (Universal Time Coordinated) de las ondas sinusoidales de corriente y voltaje AC, en diferentes nodos de un SEP [6]. Para calcular un sincrofasor la PMU utiliza un algoritmo de estimación fasorial. Estos algoritmos utilizan un número N de muestras en el tiempo para efectuar la estimación del fasor. El algoritmo más comúnmente utilizado es la transformada discreta de Fourier [6]. La alta precisión, velocidad de respuesta y sincronización de tiempo hacen de las PMUs equipos apropiados para el monitoreo global en estado estable y dinámico, así como para aplicaciones en protección y control, como parte básica de un sistema de monitorio de área extendida (WAMS – Wide Area Measurement System) [7]. Las principales contribuciones presentadas en este trabajo son: i) un novedoso método para estimar el estatus de vulnerabilidad dinámica post-contingencia del sistema basado en minería de datos, y ii) una metodología para evaluar vulnerabilidad en tiempo real basada en varios índices de desempeño. 2. MARCO TEÓRICO REFERENCIAL 2.1. Vulnerabilidad del Sistema de Potencia Un sistema vulnerable opera con un reducido nivel de seguridad que lo vuelve débil a los efectos acumulados de una serie de disturbios. La vulnerabilidad es un indicativo esencial de que el sistema se dirige a fallas en cascada [3]. El concepto de vulnerabilidad involucra al nivel de seguridad estática y dinámica del SEP y la tendencia a cambiar sus condiciones a un estado crítico [4], denominado “estado al borde del colapso” [5]. 2.4. Herramientas matemáticas relevantes 2.4.1 Simulación de Montecarlo Tradicionalmente, los análisis de contingencias del SEP se han estudiado a través de metodologías deterministas. Estos métodos ignoran la naturaleza estocástica o probabilística de los SEP reales, y por lo tanto ciertas perturbaciones graves, que podrían llevar el sistema a potenciales condiciones de inseguridad, podrían ser ignoradas [1]. Por el contrario, técnicas de análisis probabilístico, como la simulación de Montecarlo (MC), ofrecen la posibilidad de obtener resultados más realistas, ya que evita el uso de modelos simplificados [1]. Un área vulnerable es una sección específica del sistema en la que la vulnerabilidad comienza a desarrollarse. La ocurrencia de una contingencia severa en las áreas vulnerables, bajo una condición de operación de alto estrés, define al sistema en el “estado al borde del colapso”. La evaluación de la vulnerabilidad es una tarea fundamental dentro de la estructura de una red autocurable ya que tiene la función de detectar la necesidad de llevar a cabo acciones de control de área extendida. El método de Montecarlo es un procedimiento repetitivo que consiste en evaluar, en cada iteración, 92 la respuesta del sistema a través de una función de incertidumbre, utilizando un conjunto de variables de entrada que se generan al azar a través de sus funciones de distribución de probabilidad (PDF), con el fin de obtener valores numéricos aleatorios de salida [1]. Este trabajo aplica simulaciones basadas en MC con el objetivo de generar datos estáticos o dinámicos post-contingencia del sistema de potencia. hiperplano óptimo (OH), la cual se determina por una pequeña parte del conjunto de entrenamiento denominado los vectores soporte (SV) [9]. Con esta finalidad, SVM emplea una función de mapeo definida mediante las denominadas funciones de kernel, las cuales pueden ser de diferentes tipos, tales como: lineales, polinomiales, gaussiana (radial basis -RBF-), entre otras. Este artículo aplica la RBF kernel puesto que esta función es capaz de manejar las posibles relaciones no lineales existentes entre las etiquetas y los individuos. SVM resulta ser más robusto para evitar problemas de sobre entrenamiento [9]. 2.4.2 Funciones empíricas ortogonales Funciones empíricas ortogonales (EOF) son el resultado de aplicar la descomposición en valores singulares (SVD) a datos de series de tiempo [8]. EOF es una técnica de minería de datos para series de tiempo que permite descomponer una función en el tiempo discreta f(t) (tales como el ángulo o la magnitud del voltaje, o la frecuencia eléctrica) en una suma de un conjunto de funciones patrones discretas (las EOFs). La transformación EOF se utiliza con el fin de extraer los componentes individuales más predominantes de la forma de onda de una señal compuesta (similar al análisis de Fourier), que permiten revelar los principales patrones inmersos en la señal. Tanto la aplicación de clasificación (SVC), como la de regresión (SVR) son empleadas en este trabajo con el objetivo de procesar la información fasorial en tiempo real y obtener algún tipo de conocimiento que brinde indicadores del nivel de vulnerabilidad del SEP. 3. PROPUESTA METODOLÓGICA El presente trabajo propone una metodología completa para evaluar la vulnerabilidad dinámica post-contingencia (DVA) del sistema de potencia en tiempo real mediante el uso de mediciones PMU como datos de entrada. La metodología de evaluación es capaz de dar alerta temprana sobre posibles colapsos del sistema. El procedimiento de evaluación en tiempo real se describe esquemáticamente en la Fig. 1. Así, una función discreta fk puede ser escrita como la suma de varias funciones (vj) que son naturalmente ortogonales (pues constituyen vectores propios ortonormales obtenidos de la aplicación de SVD a la matriz de todas las funciones discretas F), afectadas por coeficientes dados por números reales (1) Donde λj1/2 es el j-ésimo valor singular de F asociado a los vectores propios uk y vj obtenidos de aplicar SVD a F. Siendo que vj representa la j-ésima EOF y su coeficiente corresponde al llamado “EOF score”. El número de EOFs escogidas depende de la variabilidad explicada que se desee, de acuerdo a (2) 2.4.3 Máquinas de soporte vectorial Figura 1: Estructura metodológica de evaluación en tiempo real Las máquinas de soporte vectorial (SVM) forman parte de las herramientas de minería de datos basadas en aprendizaje. SVM está diseñada para solucionar problemas de clasificación (C) y regresión (R) [9]. El esquema comienza con la adquisición de datos de las PMU en cada período de actualización. Estos datos son recibidos y pre-procesados en el centro de control con el fin de filtrar el ruido y depurar los posibles valores atípicos (este artículo supone que esta etapa de pre-procesamiento ha sido previamente realizada). La estructura de SVM se basa en resolver un problema de optimización cuya solución constituye una función de decisión óptima denominada 93 En tiempo real, el SEP se divide en zonas eléctricas coherentes a través de una herramienta matemática que analiza la coherencia de los datos dinámicos de las PMUs. Posteriormente, cinco índices de vulnerabilidad, que reflejan el desempeño del sistema en cuanto a sus síntomas de estrés (dividido en dos tipos de fenómenos: “lentos” y “rápidos”), se calculan para cada área eléctrica, con el propósito de identificar las áreas vulnerables. Estos índices tienen inmerso la valoración de las dos tareas involucradas en el concepto de vulnerabilidad. para determinar aproximadamente la distribución espacial de las DVRs. Posteriormente, un clasificador de soporte vectorial (SVC) permite estimar el estatus de vulnerabilidad dinámica post-contingencia del SEP. Esto, con el objetivo de determinar si el estado de operación actual del sistema se encuentra o no dentro de la región “vulnerable”, con lo cual se logra evaluar la tendencia del sistema a cambiar sus condiciones a un estado crítico respecto de fenómenos TVFS. La metodología comprende varias etapas de aprendizaje fuera de línea. Tres subprocesos conforman la entrada de esta estructura inteligente: i) PMUs adecuadamente instaladas según se especifica en [10], ii) modelos dinámicos del SEP validados (a través, de por ejemplo, la metodología descrita en [11]), y iii) preparación de datos (funciones de distribución de probabilidades -PDF-) para simulación de MC. Las DVRs se determinan empíricamente a través de la minería de los datos post-contingencia registrados por PMUs. Como alternativa a la limitada disponibilidad de estadísticas de mediciones dinámicas, simulaciones probabilísticas de MC de contingencias N-1 permiten obtener respuestas dinámicas que representen las registradas por PMUs en tiempo real, a través de evaluar la respuesta del sistema en el dominio del tiempo [1]. El proceso de aprendizaje pretende establecer una estructura de reconocimiento de patrones (basada en minería de datos) que permita estimar la tendencia del sistema de cambiar sus condiciones a un estado al borde del colapso. La Fig. 2 representa la estructura general de las etapas de aprendizaje fuera de línea propuestas. Una vez estructurada la base de datos dinámica, ésta se analiza usando EOFs para determinar las DVRs del sistema, sobre la base de los patrones asociados a los tres fenómenos TVFS. Los correspondientes “EOF scores” conforman vectores de números reales que representan patrones del comportamiento dinámico post-contingencia del sistema. Estos vectores de patrones permiten el mapeo espacial de las DVRs en el sistema de coordenadas formado por las EOFs. Adicionalmente, con el objetivo de evitar que valores numéricos grandes den una errónea interpretación de las regiones de vulnerabilidad, se sugiere normalizar a los vectores patrón antes de mapear las DVRs. En este trabajo de investigación, se adopta una normalización lineal en el rango de [0, 1]. 3.1.1 Reconocimiento de DVRs post-contingencia Se propone un novedoso enfoque para estimar regiones de vulnerabilidad dinámica post-contingencia (DVRs), teniendo en cuenta tres fenómenos de estabilidad de corto plazo (estabilidad transitoria, de voltaje y de frecuencia -TVFS-). Las DVRs están constituidas por dos áreas: la región “vulnerable” y la “no vulnerable”, delimitadas por un hiperplano. Cada vector patrón tiene asociada una “etiqueta de clase” específica en función del estatus de vulnerabilidad resultante en la simulación. Estas etiquetas de clase podrían corresponder a un caso no vulnerable (etiqueta 0) o a un caso vulnerable (etiqueta 1), dependiendo de si uno o más de los relés de protección locales asociados a los fenómenos en estudio (relé de pérdida de sincronismo -OSR-, relé de baja y alta frecuencia -FR-, relés de bajo y alto voltaje -VR-) se han disparado durante el progreso del evento. Usando los vectores de patrones resultantes y sus correspondientes etiquetas de clase de estado de vulnerabilidad, las DVRs pueden ser numéricamente mapeadas en el sistema de coordenadas formado por las principales EOFs. Un método de reconocimiento de patrones basado en funciones empíricas ortogonales (EOFs) se utiliza Con el fin de capturar adecuadamente la respuesta del sistema para los diferentes fenómenos de Figura 2: Estructura metodológica de evaluación en tiempo real 3.1. Predicción del Estatus de Vulnerabilidad para Fenómenos Rápidos TVFS 94 estabilidad TVFS, varias ventanas de tiempo (TW) tienen que ser definidas. Estas ventanas de tiempo se establecen en función de las estadísticas de los tiempos de disparo de los relés, resultantes de la simulación de MC, influenciados por el retraso de tiempo por comunicación de los sistemas WAMS (tdelay). Cada elemento de los conjuntos de entrenamiento y prueba contiene un “valor objetivo” (etiqueta de clase) y varios “atributos” (vectores de patrones que mejor representan las DVRs para cada TW). Sobre la base de las dos regiones asociadas a las DVRs, un clasificador de dos clases se adopta con el fin de especificar el estatus de vulnerabilidad, ya sea como un caso no vulnerable o como un caso vulnerable. En primer lugar, el mínimo tiempo de disparo de la simulación de MC (tmin) tiene que ser determinado. Este tiempo representa el retardo máximo admisible para el accionamiento de cualquier acción de control correctiva, el cual tiene que ser afectado por tdelay. Hay dos aspectos esenciales a tener en cuenta para entrenar el SVC: (3) • Elección de apropiados vectores de patrones, que muestren la evolución de los fenómenos específicos. En este sentido, se necesita un procedimiento para la extracción y selección de la información más relevante. Así, un método que emplea árboles de decisión (DT), originalmente introducido en [13], en combinación con una determinada variabilidad explicada (superior a 97%), ha sido empleado para resolver este problema. • Identificación de los mejores parámetros del SVC. Con este objetivo, se ha definido un identificador paramétrico orientado a la maximización de la precisión de clasificación, el cual se basa en la optimización de mapeo media-varianza en su versión enjambre (MVMOS), algoritmo presentado inicialmente en [11]. Donde tOSRi, tVRi y tFRi son los tiempos de disparo de los relés OSR, VR y FR, respectivamente, resultantes de las N repeticiones de MC. Dado que los datos post-contingencia comprenden las muestras tomadas inmediatamente después del despeje de la falla, la primera ventana de tiempo (TW1) se define por la diferencia entre tmin y el tiempo de despeje (tcl). (4) El resto de las ventanas de tiempo se definen basándose en el concepto de intervalo de confianza estadística relacionado con la desigualdad de Chebyshev [12], el cual especifica que al menos el 89% de los datos se encuentran dentro de tres desviaciones estándar (3σ). 3.1.3 Implementación de la evaluación en tiempo real Para la aplicación en tiempo real, los SVC entrenados fuera de línea serán encargados de clasificar el estatus de vulnerabilidad dinámica postcontingencia del SEP, usando los fasores de voltaje y frecuencias post-contingencia de PMUs como los datos de entrada. (5) Donde std{.} representa la desviación estándar (σ) de los tiempos de disparo del relé que más interseque la correspondiente ventana de tiempo TWk. 3.1.2 Predicción del estatus de vulnerabilidad En primer lugar, estas señales dinámicas deben ser transformadas a sus correspondientes vectores de patrones (EOF scores) normalizados. Para este propósito, los datos tienen que ser multiplicados por los EOFs determinados en el entrenamiento fuera de línea y almacenados en el procesador del centro de control. A continuación, EOF scores serán los datos de entrada para los SVC previamente entrenados, los cuales indicarán automáticamente si el sistema se encuentra dentro de las regiones “vulnerable” (etiqueta 1) o “no vulnerable” (etiqueta 0) asociadas a fenómenos TVFS. Las DVRs son utilizadas para especificar la posición relativa del estado dinámico real del SEP con respecto a su hiperplano límite, lo que se puede lograr mediante el uso de un clasificador inteligente. Este artículo emplea un clasificador de soporte vectorial (SVC). El SVC necesita de un aprendizaje preliminar fuera de línea. Esta tarea se lleva a cabo usando la base de datos post-contingencia obtenida de la simulación de MC y los correspondientes DVRs asociados. Los datos se dividen en conjuntos de entrenamiento y prueba. 95 Un índice de estabilidad transitoria en tiempo real (TSI) se determina a través de la predicción de los ángulos de rotor de área referenciados al centro de inercia (COI) utilizando mediciones PMU como datos de entrada. Este índice brinda una cuantificación rápida del nivel actual de estabilidad transitoria del SEP. 3.2. Evaluación de la vulnerabilidad en tiempo real La evaluación completa de vulnerabilidad en tiempo real propuesta está orientada a determinar las áreas vulnerables del SEP y evaluar la vulnerabilidad de cada una de ellas, tomando en cuenta los dos aspectos implicados en el concepto de vulnerabilidad: i) la evaluación de la tendencia a llegar a un estado crítico, y ii) la valoración del nivel de seguridad actual del SEP. El método utiliza regresores inteligentes que permiten estimar los ángulos de rotor referenciados al COI en tiempo real. Para esto se emplean regresores de soporte vectorial (SVR). De manera similar al SVC, antes de entrenar un SVR se requiere identificar los parámetros óptimos del regresor. En este sentido, MVMOS es también aplicado para determinar los parámetros óptimos del SVR. 3.2.1 Identificación de áreas coherentes El objetivo de partir al SEP en áreas coherentes en tiempo real es determinar las áreas vulnerables en las que existe la posibilidad de ocurrir eventos en cascada. En la implementación en tiempo real, los regresores previamente entrenados estimarán los ángulos de rotor referenciados al COI por cada área asociada a los PMUs, usando como entradas los datos de los fasores de voltaje post-contingencia medidos en las PMUs. Estos ángulos de rotor son luego utilizados para calcular un índice de estabilidad transitoria (TSI) para cada área eléctrica k, así: La barra donde cada PMU ha sido previamente ubicada representa el “centroide” de un área eléctrica “asociada a la PMU”. Puesto que las áreas coherentes pueden cambiar dependiendo del estado de operación y la contingencia que se presente [8], es necesario analizar las diferentes posibilidades de coherencia existente entre las áreas asociadas a las PMUs. El objetivo es unir dos o más áreas asociadas a las PMUs en “zonas”, cuando se detecte coherencia entre ellas. En este sentido, el método recursivo de agrupación por coherencia presentado en [8] y [14] es empleado para este propósito. Así, matrices de disimilaridad se construyen a partir de los datos medidos en cada PMU. El algoritmo de agrupación C-means difuso (FCM) [14] es luego aplicado a estas matrices para determinar los grupos de PMUs que presentan coherencia eléctrica. Entonces, las zonas coherentes estarán formadas por aquellas áreas asociadas a las PMUs que hayan sido agrupadas. (6) son el índice de estabilidad Donde TSIk, y transitoria y el ángulo de rotor referido al COI en radianes de la k-ésima área. Debido a que el TSI está concebido para dar alerta temprana, no es necesario calcularlo cuando los ángulos del rotor están dentro de un rango de operación normal. Por tanto, el máximo valor admisible de los ángulos de rotor referidos al COI para estabilidad estática (es decir, el máximo ángulo determinado por restricciones de estado estable -δlim-) es usado como el límite inferior de cómputo. 3.2.2 Caracterización de la vulnerabilidad para fenómenos rápidos TVFS En esta sección se describe el cómputo de tres índices, en el rango [0, 1], que reflejan el nivel de seguridad del SEP respecto de los fenómenos TVFS. Estos índices son luego combinados con los resultados de la predicción del estatus de vulnerabilidad presentado en 3.1 con el objetivo de evaluar los dos aspectos que conforman el concepto de vulnerabilidad. B. Índice de desviación de voltaje (VDI) Basado en la operación de los relés locales de bajo y sobre voltaje, se define un índice de desviación de voltaje (VDI). VDI refleja las características de funcionamiento de este tipo de relés, que se activan cuando el voltaje cae por debajo de un límite inferior Vlower (o supera un valor umbral superior Vupper) durante más de un período predefinido de tiempo (tvmax). VDI es calculado para cada barra donde las PMUs están localizadas, como sigue: A. Índice de estabilidad transitoria (TSI) 96 Donde Vlower y Vupper son los límites inferior y superior de voltaje, tvmax es el periodo máximo predefinido antes de que los relés de voltaje se disparen, y tn es el periodo en el cual V < Vlower o V > Vupper. alerta sobre la tendencia del sistema a cambiar sus condiciones a un estado crítico (es decir, cuando la predicción del estatus de vulnerabilidad adquiere el valor de “1”). Con el fin de incrementar la seguridad, esta penalidad se aplica únicamente si el índice TVFS correspondiente ha excedido un valor mínimo previamente especificado. Luego, el VDI para cada área eléctrica k es determinado por la siguiente expresión: 3.2.3 Caracterización de la vulnerabilidad para fenómenos lentos (7) (8) Dos de los síntomas de vulnerabilidad se caracterizan por presentar rangos de tiempo que varían entre segundos a varios minutos, e incluso horas. Estos síntomas corresponden a la estabilidad oscilatoria y a sobrecargas de componentes del sistema. C. Índice de desviación de frecuencia (FDI) La desviación de la frecuencia respecto de su valor nominal es un claro indicador del efecto dinámico producido por una contingencia [14]. Bajo esta consideración, se define un índice de desviación de frecuencia (FDI) para cada PMU como sigue: A. Índice oscilatorio (OSI) En tiempo real, señales eléctricas registradas con PMUs pueden ser descompuestas en sus modos de oscilación, utilizando algún algoritmo de identificación modal [14]. En este sentido, análisis Prony se usa en este trabajo para estimar la frecuencia y el amortiguamiento de los modos dominantes que son observables en una señal eléctrica en tiempo real [14]. Así, se pueden identificar aquellos modos que presentan valores de amortiguamiento pobres o negativos, llamados modos críticos. (9) Donde |Δfi| es la variación de frecuencia medida en la PMU i, y Δfmax es la desviación máxima admisible del sistema. Note que Δfmax cambia dependiendo del fenómeno. Esto es, si Δfi < 0 ==> Δfmax corresponde al límite de baja frecuencia; en tanto que, si Δfi > 0 ==> Δfmax corresponde al límite de sobre frecuencia del sistema. Una vez que los modos críticos se han identificado para cada área, se calcula un índice que representa los posibles problemas de amortiguamiento en el sistema. Para esto, se define un límite de amortiguamiento (ζlim) bajo el cual el sistema se considera en cierto nivel de problema oscilatorio. Este artículo considera que ζlim es del 5% y la señal eléctrica elegida es la potencia activa medida por la PMU. Así, un índice oscilatorio (OSI) para el modo menos amortiguado se define por (11). Luego, el FDI para cada área eléctrica k es determinado por la siguiente expresión: (10) D. Evaluación completa de vulnerabilidad para fenómenos TVFS Los índices para fenómenos TVFS anteriormente definidos (TSI, VDI, y FDI) se combinan con los resultados obtenidos de la predicción del estatus vulnerabilidad, descrito en el literal 3.1, con el objetivo de llevar a cabo las dos tareas involucradas en el concepto de vulnerabilidad. (11) Donde ζi = min{ζ de los modos de la potencia i} es el modo más pobremente amortiguado obtenido de la aplicación de análisis Prony a la señal de potencia activa i en cada PMU i, y ζlim es el límite de amortiguamiento aceptable para el SEP. Para este propósito, una “penalidad” se incluye a los índices en función del resultado obtenido a partir de la predicción del estatus de vulnerabilidad, teniendo en cuenta la ventana de tiempo en la que el estatus de vulnerabilidad se ha estimado y arreglos adecuados de compuertas lógicas. Esta penalidad tiene el objetivo de forzar al índice TVFS correspondiente al valor de “1”, cuando el estatus de vulnerabilidad resultante del reconocimiento de patrones brinde una Luego, el OSI para cada área eléctrica k es determinado por la siguiente expresión: 97 (12) Luego, el OVI para cada área eléctrica k es determinado por la siguiente expresión: B. Índice de sobrecarga (OSI) Los flujos de potencia a través de las ramas del sistema pueden variar después de una contingencia debido a la modificación topológica de la red. Altas corrientes eléctricas pueden entonces provocar sobrecargas, lo que podría incrementar el problema de vulnerabilidad [14]. Para evaluar posibles sobrecargas, este artículo usa factores de distribución estadísticos (SDFs) con el objetivo de predecir el cambio del flujo de potencia por los vínculos luego de producida una contingencia. El SDF se define por la media de los factores de distribución ac (ac-DF) resultantes de una simulación de MC [15]. Los ac-DFs pueden ser: factor por cambio de inyección (ac-ψiek) o factor por salida de un vínculo (ac-ς(eq)ek). 4. RESULTADOS DE SIMULACIONES La metodología propuesta se prueba en el sistema IEEE New England de 39 barras, ligeramente modificado con el fin de satisfacer el criterio de seguridad N-1, y en el cual previamente se han ubicado PMUs de acuerdo a los resultados presentados en [8]. La Fig. 3 muestra el diagrama unifilar del sistema de prueba, con la respectiva ubicación de las PMUs. Donde k, q son vínculos, fek es el flujo de potencia aparente post-contingencia, fekpre-c es el flujo de potencia aparente pre-contingencia, ΔSi es el cambio de potencia aparente de inyección en la barra i, acDFjk es el factor de distribución ac (ψiek o ς(eq)ek) del vínculo k provocado por la continencia j y n es el número de escenarios. Figura 3: Diagrama unifilar del sistema de prueba Las simulaciones consisten en varias contingencias aleatoriamente provocadas a través del método de Montecarlo. Para esto, flujos óptimos de potencia (OPF), que permiten determinar estados operativos realistas, son primero simulados con el paquete MATPOWER. Estos estados operativos son las entradas al análisis de contingencias estáticas o dinámicas, simuladas en DIgSILENT Power Factory a través de su programación DPL. Los SDFs resultantes permiten estructurar un algoritmo de estimación de sobrecarga postcontingencia en tiempo real basado en tablas previamente establecidas. Para esto, en tiempo real, un clasificador SVC multiclase orienta la selección de los mejores SDF dependiendo del estado real del SEP. Posteriormente, los SDFs seleccionados de la tabla permiten estimar el nivel de sobrecarga en cada vínculo ek del SEP. Finalmente, un índice de sobrecarga (OVI) se calcula para cada vínculo de acuerdo a (16). (17) Un total de 10.000 casos han sido simulados, de los cuales 7.600 son TVFS estables o "no vulnerables" y 2.400 son inestables o "vulnerables": 1.308 corresponden a inestabilidad transitoria, 682 son inestables por frecuencia, y 410 son inestables por voltaje. Adicionalmente, 84 casos de los 7600 casos TVFS no vulnerables corresponden a casos inestables por oscilaciones. En todos estos casos se analiza además las posibles sobrecargas por los vínculos de transmisión. (16) La Fig. 4 presenta la respuesta dinámica postcontingencia registrada en cada PMU para una de las iteraciones de Montecarlo correspondiente a un caso de inestabilidad transitoria. Donde Slower y Supper son los límites inferior y superior de una banda de riesgo de sobrecarga determinada para cada vínculo en función del análisis de sus límites térmico, de estabilidad de ángulo y de estabilidad de voltaje. 98 Tabla 1: Precisión de clasificación de los SVCs entrenados La evaluación completa de vulnerabilidad TVFS es luego estructurada combinando los resultados de la estimación del estatus de vulnerabilidad (salida de los SVCs) con los índices TSI, VDI, y FDI. Para esto, arreglos de compuertas lógicas son estructurados para introducir la penalidad en los respectivos índices. A manera de ejemplo, la Fig. 6 muestra el arreglo correspondiente a las ventanas de tiempo TW1 o TW2. Figura 4: Oscilogramas de PMUs - caso inestabilidad transitoria Usando como entrada las señales de las PMUs, se determinan las diferentes DVRs, de acuerdo a lo descrito en el apartado 3.1. Para esto, 5 diferentes ventanas de tiempo han sido determinadas. La Fig. 5 presenta la distribución tridimensional de los vectores de patrones obtenidos del análisis realizado a las señales post-contingencia correspondientes al ángulo de voltaje, con ventana TW1. Figura 6: Esquema de compuertas lógicas para TW1 v TW2 Seguidamente se realiza la evaluación de vulnerabilidad completa, para lo cual primero se determina, en tiempo real, la coherencia entre PMUs con el objetivo de definir las zonas eléctricas vulnerables del sistema. La Fig. 7 muestra los resultados de los índices TVFS para el caso de inestabilidad transitoria presentado en Fig. 4. Note como TSI presenta un punto de inflexión a los 0,48 s causado por la actuación de la penalidad. Esto hace que TSI llegue al valor de “1” a los 0,5 s lográndose predecir el problema de inestabilidad transitoria 480 ms antes de que se produzca la pérdida de sincronismo; la cual, de acuerdo a los resultados de la simulación, ocurre a los 0.9854 s. La Tabla 2 presenta los resultados de la evaluación completa de vulnerabilidad para fenómenos TVFS en tiempo real, donde se utilizan los conceptos de dependabilidad y seguridad para evaluar el desempeño de la metodología. Figura 5: DVRs para el ángulo de voltaje con TW1 Posteriormente, usando como entrada los DVRs se procede al entrenamiento de los correspondientes SVCs. La precisión de la clasificación de los SVCs para cada TW se presenta en la Tabla 1, que además incluye la precisión de otros clasificadores tales como: clasificador de árbol de decisión (DTC), red de reconocimiento de patrones (PRN), análisis discriminante (DA) y redes neuronales probabilísticas (PNN). Es posible observar que SVC supera a todos los otros clasificadores en términos de precisión de clasificación (CA). Además, SVC es el único clasificador que permite la obtención de más de 99% de precisión para todos los TW. Adicionalmente, la estimación de sobrecargas y su correspondiente evaluación de vulnerabilidad, así como el seguimiento en tiempo real de la estabilidad oscilatoria se aplican al sistema de prueba. La Tabla 3 muestra un resumen del número de los 84 casos oscilatorios, localizados en tres rangos de OSI. En la mayor parte de los casos OSI brinda una adecuada alerta temprana respecto de la ocurrencia real de riesgo oscilatorio, alcanzando un valor de “1”. 99 5. CONCLUSIONES Y RECOMENDACIONES Figura 7: Índices TVFS para el caso de inestabilidad transitoria Figura 7: Índices TVFS para el caso de inestabilidad transitoria Tabla 2: Desempeño de la metodología de evaluación TVFS Tabla 3: OSI por PMU - resumen del número de casos En 83 casos al menos una PMU proporciona un OSI igual a 1, lo que pone de manifiesto el excelente desempeño de OSI para alertar sobre inestabilidad oscilatoria. En el único caso en el que los OSI no alcanzan el valor de 1, el índice de PMU 5 llega al valor de 0,5006, lo que también brinda una alerta temprana. Con el objetivo de estructurar una red inteligente auto curable, el control del sistema se debería ajustar dependiendo del progreso en tiempo real de los eventos. Bajo este concepto, la evaluación de la vulnerabilidad dinámica en tiempo real (DVA) se convierte en una tarea fundamental dentro de esta estructura. En este sentido, el presente artículo introduce un nuevo enfoque para evaluar vulnerabilidad a través de la partición de la red eléctrica en áreas, y la valoración de su nivel de vulnerabilidad mediante índices de desempeño. Los índices permiten evaluar cinco diferentes fenómenos: inestabilidad transitoria (TSI), inestabilidad de voltaje de corto plazo (VDI), desviaciones de frecuencia fuera de límites (FDI), oscilaciones eléctricas poco amortiguadas (OSI), y sobrecargas (OVI). Estos índices son conjugados con una metodología que permite estimar el estatus de vulnerabilidad post-contingencia del sistema, basada en reconocimiento de patrones a través de minería de datos. Esto, con el objetivo de brindar alerta temprana mediante la evaluación de los dos aspectos que componen el concepto de vulnerabilidad. A partir de los resultados del presente trabajo de investigación, es posible plantear trabajos futuros que involucren el diseño de acciones de control correctivo que usen como entrada los resultados de la evaluación de la vulnerabilidad planteada. REFERENCIAS BIBLIOGRÁFICAS Asimismo, la Tabla 4 presenta un resumen de los resultados del análisis de sobrecargas de vínculos para los casos en los que se presentó riesgo de sobrecarga de ciertas líneas de transmisión (OVI > 0). La mayoría de los casos muestran una excelente precisión en la estimación, principalmente en el rango (0,5; 1] en el que podrían ser necesarias medidas de control correctivo. Tabla 4: OVI por vínculo - resumen del número de casos [1] Cepeda J., Rueda J., Erlich I. & Colomé G. (2012). “Recognition of Post-contingency Dynamic Vulnerability Regions: Towards Smart Grids”, IEEE PES General Meeting, San Diego-California. [2] Cepeda J. & Colomé G. (2011). “Mediciones PMU para la Evaluación de la Seguridad Dinámica y Vulnerabilidad de los SEP”, XIV ERIAC, Ciudad del Este, Paraguay. [3] Huang Z., Zhang P., et al (2009). “Vulnerability Assessment for Cascading Failures in Electric Power Systems”, IEEE PES Power Systems Conference and Exposition, Seattle, WA. [4] Fouad A., Qin Zhou & Vittal V. (1994). “System vulnerability as a concept to assess power system dynamic security”, IEEE Transactions on Power Systems, pp. 10091015. 100 [5] McGillis D., El-Arroudi K., Brearley R. & Joos G. (2006). “The Process of System Collapse Based on Areas of Vulnerability”, Conference on Power Engineering, pp. 35 – 40, Halifax, NS. [14] Cepeda J. & Colomé G. (2012). “Vulnerability Assessment of Electric Power Systems through identification and ranking of Vulnerable Areas”, International Journal of Emerging Electric Power Systems, Volume 13, Issue 1. [6] Cimadevilla R. (2009). “Fundamentos de la Medición de Sincrofasores”. XIII ERIAC, Puerto Iguazú, Argentina. [15] Cepeda J., Ramírez D. & Colomé G. (2012). “Probabilistic-based Overload Estimation for real-time Smart Grid Vulnerability Assessment”, IEEE T&D-LA, Montevideo, Uruguay. [7] Martinez C. Parashar M., Dyer J., & Coroas J. (2005). “Phasor Data Requirements for Real Time Wide-Area Monitoring, Control and Protection Applications”, White Paper – Final Draft. [8] Björnsson H. & Venegas S. (1997). A Manual for EOF and SVD Analyses of Climatic Data. C2GCR Report No. 97-1, McGill University. [9] Cepeda J., Colomé G. & Castrillón N. (2011). “Dynamic Vulnerability Assessment due to Transient Instability based on Data Mining Analysis for Smart Grid Applications”, IEEE PES ISGT-LA, Medellín, Colombia. [10] Cepeda J., Rueda J., Erlich I. & Colomé G. (2012). “Probabilistic Approach-based PMU placement for real-time power system vulnerability assessment”, IEEE PES ISGTEU, Berlin, Germany. [11] Cepeda J. & J. Rueda (2013). “Identificación de equivalentes dinámicos mediante optimización de mapeo media-varianza en ambiente DIgSILENT Power Factory”, Revista Técnica Energía, Nº 9. [12] Han J. & Kamber M. (2006). Data Mining: Concepts and Techniques. Second edition, Elsevier, Morgan Kaufmann Publishers. [13] Teeuwsen S. P. (2005). “Oscillatory Stability Assessment of Power Systems using Computational Intelligence”. Tesis de Doctorado, Universität Duisburg-Essen, Germany. Jaime Cristóbal Cepeda.Recibió el título de Ingeniero Eléctrico en la Escuela Politécnica Nacional en 2005 y el de Doctor en Ingeniería en la Universidad Nacional de San Juan en 2013. Entre 2005 y 2009 trabajó en Schlumberger y en el CONELEC. Colaboró como investigador en el Instituto de Energía Eléctrica, Universidad Nacional de San Juan, Argentina y en el Instituto de Sistemas Eléctricos de Potencia, Universidad Duisburg-Essen, Alemania entre 2009 y 2013. Actualmente, se desempeña como Jefe de Investigación y Desarrollo del CENACE. Sus áreas de interés incluyen la evaluación de vulnerabilidad en tiempo real y el desarrollo de Smart Grids Delia Graciela Colomé.- Obtuvo el título de Ingeniera Electrónica en 1985 y el de Doctora en Ingeniería Eléctrica en 2009, ambos de la Universidad Nacional de San Juan, Argentina. Desde 1983, ha sido investigadora y profesora en el Instituto de Energía Eléctrica, Universidad Nacional de San Juan. Durante este tiempo, ha trabajado como directora de proyectos y como ingeniera senior en numerosos proyectos de asistencia técnica en Argentina y varios países de América Latina. Sus áreas de especialidad son el control y supervisión de SEP, y el modelado y simulación de SEP. 101 Incorporación de Dispositivos FACTS en el Sistema Nacional Interconectado N. F. Chamorro P. X. Verdugo Centro Nacional de Control de Energía, CENACE Resumen— Ante el desarrollo de los diferentes proyectos de generación hidrotérmicos y los actuales problemas de capacidad de la red de transmisión, resulta necesario evaluar los reforzamientos del sistema de transmisión del país, de acuerdo al crecimiento de la demanda y el ingreso de los nuevos proyectos de generación. CENACE con el fin de cumplir con su rol de suministrar energía al país bajo las mejores condiciones de economía y calidad, analizó, de maner a conjunta con la empresa norteamericana Quanta Technology, la factibilidad de incluir en el sistema de transmisión, dispositivos de respuesta rápida que garanticen la calidad y continuidad del suministro eléctrico. En este trabajo, a través de un análisis de contingencias en estado estable, se realiza la caracterización del Sistema Nacional Interconectado para el año 2017, con lo que se logra identificar las contingencias más críticas para el sistema. Posteriormente, mediante un análisis dinámico resulta posible categorizar las contingencias asociadas con problemas de estabilidad de voltaje. Estas contingencias son evaluadas de forma individual para determinar el requerimiento de compensación reactiva dinámica en diferentes zonas del SNI. Palabras clave— FACTS, Estabilidad de Voltaje, SVC, DIgSILENT Power Factory, Sistema Nacional Interconectado. Abstract— Due to the development of different hydrothermal generation projects and the current problems related to the transmission network’s capacity, it comes necessary to assess the national transmission system’s reinforcements, according to the demand growth and the start-up of new generation projects. In order to fulfill its role in supplying Ecuador’s electrical power with the highest level of quality and cost-effectiveness, CENACE, along with the North American company Quanta Technology, studied the feasibility of including fast-response devices, in the transmission system, which guarantee quality and continuity in the electrical power supply. In this study, through a stable-state contingencies analysis, a characterization of the National Interconnected System for the year of 2017 is made. This allows identifying the system’s most critical contingencies. Later on, through a dynamic analysis, it is possible to categorize the contingencies associated with voltage stability problems. Such contingencies are evaluated individually in order to determine the dynamic reactive compensation requirement in different areas of the SNI. Index Terms— FACTS, Voltage Stability, SVC, DIgSILENT Power Factory, National System 1. INTRODUCCIÓN La estabilidad de un sistema eléctrico de potencia se puede definir como la propiedad que le permite mantenerse en un estado de equilibrio operacional bajo condiciones normales de operación y de regresar a un estado aceptable de equilibrio tras sufrir una perturbación [1]. Históricamente, la estabilidad transitoria se ha considerado como el problema de estabilidad más importante en la mayoría de los sistemas; sin embargo con la evolución de los sistemas de potencia a través de crecientes interconexiones, uso de nuevas tecnologías y la operación en condiciones de alto estrés, han aparecido diferentes formas de inestabilidad [2]. El presente trabajo tiene como objetivo fundamental realizar una caracterización del SNI, identificando las contingencias que puedan ocasionar un colapso total o parcial en el sistema, considerando los proyectos de expansión de transmisión y generación previstos hasta el año 2017. Esto se logra a través de un análisis de contingencias en estado estable. Posteriormente, a través de simulaciones dinámicas, se determina cuáles de estas contingencias se encuentran asociadas con problemas de inestabilidad de voltaje. Estas contingencias son evaluadas de forma individual para evaluar la necesidad de incorporar dispositivos de compensación reactiva de rápida actuación, que garanticen la operación segura del Sistema Nacional Interconectado. El dimensionamiento de los FACTS (Flexible AC Transmission System) propuestos se 102 determina a través de una serie de simulaciones y sensibilidades que permiten observar el comportamiento de estos dispositivos en respuesta a diversas contingencias en el SNI. El estudio se realiza en base a las siguientes consideraciones: • Existencia de un SVC en la S/E Chorillos, que se considera fuera de servicio en las simulaciones, para determinar los requerimientos reales de compensación reactiva en el SNI. • Los LTCs de los transformadores no funcionan de forma automática. • Se asume una característica de control PV en los generadores del SNI que cuentan con esta capacidad de regulación en tiempo real. • La barra slack corresponde al sistema colombiano y se considera una conexión permanente entre los sistemas eléctricos de Ecuador y Colombia. Adicionalmente se considera en servicio el Esquema de Separación de Áreas ESA. • Las simulaciones se realizan bajo la premisa de la operación del Sistema de Protección Sistémica (SPS), la cual se estima estará en operación en el año 2014, este esquema se encuentra diseñado para evitar problemas de inestabilidad angular en el SNI. de elementos de transmisión. Este análisis requiere examinar la respuesta no lineal del sistema durante un período de tiempo lo suficientemente grande, como para considerar el desempeño y la interacción de motores, transformadores y los limitadores de corriente de los generadores. Este período puede extenderse desde unos pocos segundos hasta decenas de minutos [2]. Considerando la complejidad del modelo del sistema de potencia interconectado Ecuador - Colombia, y la necesidad de abarcar todos los casos que requieren ser analizados, en este estudio se emplean tiempos de simulación de 10 segundos. Uno de los temas de interés en el análisis de estabilidad de voltaje corresponde al fenómeno de recuperación lenta de voltaje por falla inducida, FIDVR por sus siglas en inglés, en el cual se produce una pérdida temporal del control de voltaje en un área. Este evento ratifica la necesidad de contar con una modelación especial de ciertas cargas en el sistema. Es necesario indicar que la caída progresiva de voltaje en las barras de un sistema puede, también, estar coligada con la inestabilidad de ángulo de rotor de las máquinas sincrónicas [1]. Y a su vez, algunos de los problemas asociados con inestabilidad angular, pueden ser fácilmente relacionados con problemas de bajo voltaje en diferentes zonas del sistema. 2. ESTABILIDAD DE VOLTAJE 3. DISPOSITIVOS FACTS La estabilidad de voltaje corresponde a la habilidad de un sistema de potencia para mantener voltajes estables en todas las barras del sistema luego de ser sometido a una perturbación a partir de una condición inicial dada [2]. Una condición de operación normal corresponde al abastecimiento continuo de la demanda de las cargas del sistema a través de la potencia de las unidades de generación. De aquí, se establece que, usualmente, las cargas son las causantes de la inestabilidad de voltaje [3]. En este sentido, dentro del desarrollo de este estudio, se ha considerado necesario realizar la modelación de distintas cargas especiales en el Sistema Eléctrico Ecuatoriano. Los dispositivos de electrónica de potencia han tenido un impacto revolucionario en los sistemas eléctricos de potencia alrededor del mundo. La disponibilidad y aplicación de los tiristores ha permitido el nacimiento de dispositivos de rápida actuación denominados FACTS, utilizados en operaciones de control [4]. La inestabilidad de voltaje puede ocasionar la pérdida de carga en un área del sistema y el disparo de líneas de transmisión por la actuación de sus sistemas de protección inherentes, ocasionando con esto eventos en cascada y la pérdida de sincronismo de varios generadores. Cuando esta secuencia de eventos en cascada conduce a un apagón en una o varias partes del sistema, se habla de un colapso de voltaje. El enfoque de este trabajo se centra en la estabilidad de voltaje ante grandes perturbaciones, como pérdida Una de las mayores causas de inestabilidad de voltaje es el límite de potencia reactiva de un sistema de potencia. Mejorando la capacidad de manejo de potencia reactiva de un sistema a través de dispositivos FACTS se puede prevenir la inestabilidad de voltaje y por ende un eventual colapso de voltaje [5]. 4. MODELAMIENTO DE CARGA Un estudio de estabilidad de voltaje enfocado a la aplicación de un controlador FACTS, típicamente, requiere un modelado detallado de la carga. En este tipo de estudios la carga es representada a través de diferentes tipos como motores grandes y pequeños, la corriente de excitación de transformadores y modelos de carga estática. 103 El modelo utilizado por CENACE consiste esencialmente en una carga de potencia constante. Con el fin de representar de la mejor manera, tomando en consideración las condiciones más críticas, se realizaron sensibilidades incluyendo modelos de potencia, impedancia y corriente constante. Los resultados muestran solamente una mayor depresión en el perfil de voltaje, mas no se evidencia un colapso de voltaje, o la presencia de un evento FIDVR, ocasionado por la absorción de corriente de grandes motores durante contingencias. Tabla 2: Contingencias Dobles Críticas 5. SIMULACIONES Mediante el procedimiento indicado para determinar los requerimientos de compensación reactiva dinámica en el Sistema Nacional Interconectado, se realizaron simulaciones en estado estable y dinámico en el programa computacional DIgSILENT Power Factory. 5.1. Simulaciones en Estado Estable Las simulaciones se realizan considerando escenarios de alta y baja hidrología para los períodos de demandas: mínima, media y máxima, con el fin de caracterizar al sistema eléctrico ecuatoriano. Dentro de las simulaciones se incluyen contingencias simples y dobles en todo el SNI. En las tablas siguientes se indican las contingencias simples y dobles para las cuales se presentan condiciones de no convergencia en el sistema. Cabe indicar que las tablas presentan también, dentro de la descripción, el aporte de la evaluación dinámica, ya que al no obtener una condición de convergencia en el flujo de potencia en estado estable, no es posible realizar ninguna evaluación. 5.2. Simulaciones en Estado Dinámico A continuación se presentan los resultados de las simulaciones dinámicas para las contingencias que están relacionadas con problemas de voltaje. La simulación incluye un corto circuito trifásico, el despeje del mismo y la apertura del o los circuitos de la línea de transmisión, según amerite el caso. a) Salida de un circuito de la L/T Zhoray – Sinincay 230 kV Tabla 1: Contingencias Simples Críticas En base a los resultados presentados en las Tablas 1 y 2, se establece que tanto la contingencia simple de la L/T Zhoray – Sinincay 230 kV como la contingencia doble de la L/T Chorrillos – Refinería del Pacífico deben ser sujetas a un análisis dinámico particular. Para las demás contingencias, a través de un análisis general, se establece que su tratamiento está enmarcado en una actualización del SPS y de un reforzamiento de la red eléctrica de la zona donde estos circuitos están localizados. Figura 1: Disparo de L/T Zhoray – Sinincay 230 kV Esta contingencia produce bajos voltajes en la subestación Sinincay 230 kV; sin embargo esto puede ser solucionado con la conexión de elementos de compensación mecánicos como capacitores. Además se cree conveniente realizar un análisis del factor de potencia de la carga asociada a esta barra. 104 b) Salida de los dos circuitos de la L/T Chorillos – Refinería del Pacífico 230 kV El caso de Refinería del Pacífico es especial, debido a que en esta barra está prevista, para el año 2017, la toma de aproximadamente 375 MW de carga. Además, de acuerdo a información proporcionada por esta entidad [6], tomando en consideración la sensibilidad de los equipos instalados en la refinería que permiten la realización de los procesos internos, se ha establecido que los voltajes no pueden alcanzar valores por debajo de 0,9 p.u. por más de 200 ms. A continuación se presenta un gráfico, en el que se puede observar la respuesta en el tiempo del voltaje en las barras de la zona de Refinería del Pacífico, ante la salida intempestiva de la L/T Chorrillos – Refinería del Pacífico 230 kV. El SVC propuesto contiene un TSC (Thyristor Switched Capacitor) que puede ser conectado con un retardo de 20 ms y un TCR (Thyrstor Controlled Reactor) que será empleado para proveer un control fino, no discreto, de potencia reactiva. Cabe indicar que considerando el elevado tiempo de conexión de los MSCs (Mechanical Switched Capacitor), éstos no han sido considerados como una opción aceptable. La Tabla 3 muestra las alternativas estudiadas para identificar la mejor opción en cuanto a la capacidad reactiva inductiva, correspondiente al TCR, del dispositivo FACTS propuesto. Tabla 3: Sensibilidades del SVC propuesto en Refinería del Pacífico Se concluye a través de estos resultados, considerando la observación de ciertas condiciones oscilatorias en algunos casos, que la mejor alternativa consiste en la instalación de un SVC de -100/250 MVAr. Considerando la instalación de este SVC, la Fig. 3 muestra la respuesta del sistema ante la contingencia doble de la línea de transmisión de 230 kV Chorrillos – Refinería del Pacífico. Se puede observar que a través de la compensación propuesta se logra mantener un perfil de voltaje adecuado en la barra de Refinería del Pacífico. Figura 2: Disparo de L/T Chorrillos – Refinería del Pacífico 230 kV Como se puede observar, ante esta contingencia el voltaje en la barra de Refinería del Pacífico, alcanza valores por debajo de 0,9 p.u. (207 kV), por lo que, de acuerdo a lo indicado anteriormente, se requiere algún tipo de mecanismo de compensación que garantice la operación segura de los equipos instalados en esta empresa. c) Localización y tamaño del SVC en Sistema Nacional Interconectado En base a los resultados anteriores y tomando en consideración los requerimientos de suministro eléctrico de la carga de Refinería del Pacífico se llevan a cabo una serie de simulaciones que permitan determinar la compensación reactiva requerida en esta barra. A través de este proceso se establece la necesidad de instalar 250 MVAr de compensación reactiva capacitiva en la barra de Refinería del Pacífico. Figura 3: Respuesta del sistema ante el disparo de L/T Chorrillos – Refinería del Pacífico 230 kV con la instalación de un SVC de -100/250 MVAr Con el fin de observar el comportamiento del SVC, antes, durante y después de la contingencia, se presenta en la Fig. 4 la respuesta dinámica de este dispositivo, incluyendo la potencia reactiva de compensación, ángulo de disparo de 105 los tiristores y el número de capacitores conectados para satisfacer los requerimientos de compensación reactiva. Para todos estos casos se observó la operación conjunta de los dos SVC, para lo cual se consideró siempre la incorporación de un SVC de -100/250 en Refinería del Pacífico y de -30/120 en Chorrillos. Para los tres casos se concluye que la presencia de estos dispositivos permite evitar el colapso por voltaje de las zonas afectadas y el voltaje logra tener una recuperación favorable. 6. CONCLUSIONES Y RECOMENDACIONES De los análisis realizados se concluye la necesidad de incorporar un SVC de -100/250 MVAr en la barra de 230 kV de Refinería del Pacífico, considerando la magnitud y las características de la carga de esta subestación. Figura 4: Respuesta del SVC ante el disparo de L/T Chorrillos – Refinería del Pacífico 230 kV Tomando en cuenta que CELEC EP TRANSELECTRIC, ha previsto la instalación, para el año 2017, de un SVC en la S/E Chorrillos de una capacidad de -30/120 MVAr, se realizan simulaciones adicionales con el fin de evidenciar la interacción entre este equipo y el SVC propuesto para Refinería del Pacífico. La Tabla 4 muestra la operación de los dos SVCs, considerando la salida de la L/T ChorrillosRefinería del Pacífico 230 kV. Tabla 4: Operación de los SVCs de Chorrillos y Refinería del Pacífico ante la salida intempestiva de la L/T Chorrillos – Refinería del Pacífico 230 kV Con el fin de identificar las condiciones más críticas para la operación del SNI, fueron considerados diferentes modelos de carga; sin embargo, únicamente se evidenció una mayor depresión en los perfiles de voltaje y en ninguno de los casos se detectó la presencia del efecto FIDVR, que se ve representado por una caída de voltaje progresiva. Considerando las características críticas y especiales de la industria de refinación, para el área de Refinería del Pacifico, se requiere la instalación de un dispositivo de rápida actuación como un TSC; sin embargo, con el fin de permitir un control de reactivos más fino se recomienda la incorporación de un SVC. De la tabla anterior se puede observar que los voltajes post falla son aceptables y se establece que con la operación de los dos SVCs, de Chorrillos y Refinería del Pacífico, los voltajes en las zonas afectadas, debido a severas contingencias en el sistema, alcanzan una recuperación favorable. Adicional a los resultados revisados hasta el momento, se realizaron simulaciones para las mismas condiciones, pero considerando la indisponibilidad de los siguientes elementos: • Central Trinitaria (133MW) • L/T Chorrilos - Tisaleo 500kV • L/T El Inga - Tisaleo de 500 kV. Se prevé garantizar la seguridad del SNI, en el año 2017, a través de la aplicación conjunta del Sistema de Protección Sistémica, SPS, y la incorporación de un SVC, con el fin de solucionar problemas relacionados con la estabilidad angular y la estabilidad de voltaje respectivamente. Desde una perspectiva del sistema, todas las simulaciones realizadas indican que no es necesario incluir un TCR para compensar el efecto de sobrepico en el voltaje ocasionado por la conexión de un TSC. Sin embargo si se requiere un control más fino del voltaje se recomienda incluir en el SVC una parte reactiva. Con el fin de mejorar las condiciones operativas en la zona de Refinería del Pacífico se recomienda que, de manera conjunta con el ingreso de esta planta, se promueva la implantación de una central de generación. Esto permitirá también contar con una fuente de compensación reactiva dinámica y además una descongestión en elementos de transmisión considerando la inyección de potencia activa en la zona. De contar con el aporte de esta central de 106 generación, es necesario reevaluar los requerimientos de potencia reactiva en esta barra. [6] Quanta Technology, “Technical and economic evaluations of FACTS, Final Report”, 01 de Abril de 2013. Los estudios realizados se encuentran fundados en el ingreso de elementos de transmisión y centrales de generación previstas para el año 2017, conforme constan en los respectivos planes de expansión. Por lo que de presentarse algún cambio importante, se recomienda realizar una actualización de los mismos. [7] Static VAR Compensation (SVC) Quanta Technology, SIEMENS, North Carolina, 22 de Febrero 2013. [8] John E., “SVC Introduction. Presented to Quanta Technology”, ABB FACTS North America, North Carolina, 22 de Febrero 2013. REFERENCIAS BIBLIOGRÁFICAS [1] Kundur P., “Power System Stability and Control”, McGraw – Hil, 1994. [2] Kundur P., Paserba J., Ajjarapu V., et al. (2004). “Definition and classification of power system stability”, IEEE/CIGRE Joint Task Force on Stability: Terms and Definitions. IEEE Transactions on Power Systems, Vol. 19, Pages: 1387-1401. [3] Nguegan Y., “Real-time identification and monitoring of the voltage stability margin in electric power transmission systems using synchronized phasor measurements”, Tesis doctoral, Kassel University, 2009. [4] Das T., Jetti S., Venayagamoorthy G., “Optimal Design of a SVC Controller Using a Small Population Based PSO”, Real-Time Power and Intelligent Systems Laboratory, University of Missouri- Rolla. [5] Kamarposhti M., Alinezhad M., “Comparison of SVC and STATCOM in Static Voltage Stability Margin Enhancement”, International Journal of Electrical and Electronics Engineering 4.5, 2010. Fernando Chamorro Chulde.Nació en Quito, en 1973. Recibió su título de Ingeniero Eléctrico de la “Escuela Politécnica Nacional” en 1999. Egresado de la Maestría en Ciencias de Ingeniería Eléctrica de la “Escuela Politécnica Nacional”. Trabajó como ingeniero de diseño para DYCONEL. Actualmente se desempeña como Ingeniero de Operaciones en el Centro de Control del CENACE. Su principal área de interés es la Optimización de la Operación del Sistema Nacional Interconectado. Pablo Verdugo Rivadeneira.Nació en la ciudad de Quito en 1987. Realizó sus estudios secundarios en el Colegio Nacional Experimental Juan Pío Montufar y sus estudios superiores en la Escuela Politécnica Nacional, donde se gradúo de Ingeniero Eléctrico en el año 2012. Actualmente trabaja en la Dirección de Planeamiento del Centro Nacional de Control de Energía.. 107 Formulación de una Arquitectura Técnica Funcional y Despliegue de una Prueba de Concepto para mejorar la Supervisión, Operación y Análisis Post-Operativo del Sistema Nacional Interconectado J. C. Vallecilla† H. Ortiz‡ † Centro Nacional de Control de Energía, CENACE ‡ Escuela Politécnica del Ejército - ESPE Resumen— Actualmente el sistema EMS del CENACE no dispone de información en tiempo real proveniente de la mayoría de los generadores comprendidos entre 1 y 5 MW, debido a que estas centrales no cuentan con equipos asociados como UTRs o gateways que permitan el envío de información, ni de canales dedicados de comunicaciones hasta alguno de los concentradores remotos (FE) del CENACE. A fin de incorporar esta información al sistema EMS, se diseña una arquitectura de adquisición de datos que permita disponer de esta información en tiempo real utilizando los medidores de energía instalados en estos generadores y como medios de comunicación el Internet y/o canales ya existentes con el CENACE, permitiendo así mejorar los procesos de supervisión y operación en tiempo real al igual que los procesos post operativos del SNI. Palabras clave— Gateway, medidores, generadores, enlaces WAN, Internet, protocolos de comunicaciones. Abstract— The CENACE’s Energy Management System - EMS currently does not have real-time information from the majority of generators from 1 to 5 MW, given that such power stations are not equipped with RTUs or Gateways that send this type of information, through a dedicated communication channel to one of the CENACE’s remote concentrators (FE). In order to include such information in the EMS, a data acquisition architecture was designed which makes having this type of information possible in real-time by using energy meters installed on these generators and using the Internet and/or current channels as a communication medium with CENACE, thus improving the real-time supervision and operations processes as well as the SNI post-operative processes. Index Terms— Gateway, Meters, Generators, WAN links, Internet, Communications Protocol. 1. INTRODUCCIÓN El Sistema Nacional Interconectado del Ecuador (SNI) tuvo, a finales del año 2012, una demanda aproximada de 3200 MW, 42 subestaciones de transmisión, 18 empresas de distribución, 84 centrales de generación y 3000 km. de líneas de transmisión, siendo el Centro Nacional de Control de Energía (CENACE) el encargado de la coordinación y operación del SNI al igual que la administración de las transacciones técnicas y financieras del Mercado Eléctrico Mayorista (MEM) del Ecuador, para lo cual cuenta con varios sistemas que permiten el cumplimiento de estas funciones. Para la operación en tiempo real del SNI, el CENACE cuenta con un sistema para la Administración de Energía (Energy Managment System - EMS), provisto por la empresa Ventyx ABB, cuyo nombre comercial es Network Manager, el cual recopila, procesa y administra la información proveniente de las subestaciones, centrales de generación y distribuidoras de todo el país, información que es enviada desde Unidades Terminales Remotas (UTRs), gateways o sistemas SCADA, utilizando canales dedicados hacia los cuatro servidores de comunicaciones de tipo Front End (F.E.) remotos, distribuidos geográficamente en Quito, Guayaquil, Quevedo y Zhoray. La transmisión se realiza a través de cualquiera de los tres protocolos seriales disponibles en estos equipos: DNP3.0, IEC 870-5-101 y RP 570. Actualmente el CENACE no cuenta con la información en tiempo real de los generadores comprendidos entre 1 y 5 MW, razón por la cual estos datos son registrados manualmente por los operadores, de acuerdo a un horario preestablecido y utilizando para el efecto llamadas telefónicas o correo electrónico, situación que provoca los siguientes perjuicios: 108 • Tiempo subutilizado por los operadores de las centrales de generación y del CENACE, durante el ingreso horario de esta información. • Desconcentración de los operadores del CENACE en la supervisión del SNI, debido a la atención que deben dedicar a la tarea de registro manual de datos en el sistema. • Posibles errores en la digitación de la información ingresada por los Operadores del CENACE. • Posibles errores en la entrega de información al CENACE por parte de los Agentes Generadores. • En caso de presentarse una falla eléctrica en el SNI, estas llamadas resultan inoportunas ya que el operador requiere el recurso telefónico y concentración, a fin de restablecer y normalizar el sistema eléctrico de potencia. • Falta visibilidad en tiempo real de un número importante de centrales entre 1 – 5 MW. La arquitectura planteada en este trabajo otorgaría viabilidad para complementar la Regulación 005-08, relativa a “La Entrega de Información”, permitiendo incorporar la información de nuevas centrales de generación comprendidas entre 1-5 MW al sistema EMS del CENACE El planteamiento no solo resuelve una necesidad actual, sino que también tiene una perspectiva de futuro, ya que a través de esta arquitectura sería posible incorporar al centro de control de CENACE, varios proyectos de pequeñas centrales de tipo Hidroeléctricas, Eólicas, Solar, etc. las cuales se encuentran en el rango de potencia instalada entre 1-5 MW. datos, obtenidos del sistema ECS para entrenamiento de los operadores del CENACE, conforme el diagrama de red de la Fig. 1. Figura 1: Diagrama de red sistema EMS CENACE [4] 2.2. Front Ends Remotos La adquisición de datos del sistema EMS del CENACE, está compuesta por cuatro Front Ends remotos distribuidos en puntos estratégicos del país, los cuales disponen de un anillo de fibra óptica para la comunicación con el sistema central, sobre la infraestructura de Fibra Óptica de Transelectric como se muestra en la Fig. 2. 2. MARCO CONCEPTUAL Para la incorporación de la información proveniente de los medidores de energía, instalados en las centrales de generación al sistema EMS del CENACE, se plantea colocar un equipo Gateway que permita la adquisición de la información desde los medidores, ya sea en protocolo DNP3.0 sobre TCP/IP o Modbus sobre TCP/IP y reenvíe esta información al sistema EMS del CENACE. 2.1. Sistema EMS CENACE El sistema EMS se encuentra conformado por: los sub sistemas Energy Control System (ECS), que adquiere, procesa y almacena la información enviada desde los equipos SCADA, Gateways y UTRs, instalados en campo; el sistema Program Development Sysytem (PDS) que permite realizar el mantenimiento, modelación, actualización y pruebas de aplicaciones del sistema EMS antes de ser puestas en funcionamiento; y, el sistema Dispacher Training Simulator (DTS) que permite crear ambientes de simulaciones en base a Figura 2: Diagrama de comunicaciones F. E. CENACE Para comunicarse desde los Front End Remotos con las RTU o gateways instalados en las generadoras y subestaciones del SNI, se utilizan canales dedicados mediante los protocolos de comunicaciones seriales disponibles en los F. E. que son el IEC 870-5-101, DNP3.0 y RP 570 conforme se muestra en la Fig. 3. Esta información es recibida por los servidores de adquisición de datos del sistema EMS, denominados RDAS (Ranger Data Acquisition Server). 109 3. LEVANTAMIENTO DE INFORMACIÓN 3.1. Levantamiento de información Centrales de Generación de las Tomando como base los medidores disponibles en el Sistema de Medición Comercial y el archivo en el que los operadores realizan el ingreso manual de información de forma horaria, correspondiente a las generadoras de las que no se dispone información en el sistema EMS, se tienen el listado de generadores mostrados en las Tablas 1 a la 7 y la Fig. 5, correspondientes a centrales que conformarían el grupo de generación entre 1 a 5 MW. Las tablas contienen el nombre de la central, ubicación geográfica, potencia instalada, tipo de generación de la central, medio de comunicación y el protocolo que utiliza el medidor para el envío de información al Gateway del CENACE. Tabla 1: Centrales de Generación Empresa Eléctrica Emelnorte Figura 3: Esquema de comunicaciones con los F. E. CENACE 2.3. Medidores de Energía Tabla 2: Centrales de Generación Empresa Eléctrica Quito Estos equipos se encuentran instalados en las centrales de generación y almacenan la información de manera cuarto horaria, para ser posteriormente adquirida y procesada por el Sistema de Medición Comercial (SIMEC) y utilizada para la liquidación comercial de las empresas generadoras. El esquema de comunicaciones utilizado por este sistema, para la conexión con los medidores, puede ser mediante Internet o enlaces WAN dedicados entre el CENACE y las empresas de la CELEC EP, EEQ o Transelectric como se indica en la Fig. 4. Figura 4:Esquema de comunicaciones SIMEC 110 Tabla 3: Centrales de Generación CELEC Esmeraldas • La central Miraflores tiene distribuidos en distintos puntos geográficos 10 unidades de generación de 2MW. • Se tiene un total de 10 medidores que se conectan mediante Internet. • Se tiene 2 medidores que se conectan mediante la red WAN de la EEQ. • Se tiene 9 medidores que se conectan mediante la red WAN de la CELEC. • La potencia efectiva total de estas centrales es de 60,9 MW. • Todos los medidores disponen del protocolo de comunicaciones DNP 3 sobre TCP/IP. Tabla 4: Centrales de Generación Empresa Eléctrica Riobamba Tabla 5: Centrales de Generación Empresa Eléctrica Ambato 3.2. Levantamiento de información del proceso de supervisión Tabla 6: Centrales de Generación Empresa Eléctrica Cotopaxi El CENACE cuenta con tres consolas para los procesos de supervisión y control del SNI: la consola de supervisión encargada del re-despacho y la supervisión de las conexiones internacionales con Colombia y Perú; la consola de generación encargada de supervisar toda la generación del SNI; y, la consola Transmisión encargada de supervisar las S/E y líneas de trasmisión del SNI, funciones que realizan las 24 horas de día, 7 días a la semana los 365 días del año. A fin de complementar la información que no se dispone en el sistema EMS del CENACE, los operadores realizan el ingreso manual de manera horaria. Para esto se tiene creadas plantillas las cuales corresponden a un desarrollo realizado por la Dirección de Operaciones, permitiendo ingresar esta información a la BD historiador sin pasar por la BD SNAPSHOT o de tiempo real conforme la Fig. 6, teniendo un tiempo estimado de 15 minutos desde el inicio de cada hora hasta el final de esta actividad, la misma que se describe conforme el diagrama de proceso de la Fig. 7. Figura 5: Distribución de medidores en el Ecuador Del levantamiento realizado, se desprende lo siguiente: • Se tiene un total de 11 Centrales de Generación. • Se dispone de 6 centrales de generación hidráulica y 5 centrales de generación térmica. • Todos los medidores instalados en estas centrales son de una misma marca. 111 Figura 6: Almacenamiento – HIS [3] considerables para estas pequeñas centrales de generación y tomando en cuenta que la regulación del CONELEC 005/08 no indica el esquema para la adquisición de datos de la generación menor a 5 MW, se plantea incorporar esta información al sistema de tiempo real, mediante el aprovechamiento del equipamiento de medición comercial ya instalado en estas centrales de generación, el cual permite enviar la información en tiempo real mediante el protocolo DNP3.0 sobre TCP/IP, sobre el puerto Ethernet que utiliza el sistema de medición comercial, tomando como primicia que estos equipos ya cuentan con un medio de comunicación hasta el CENACE. Figura 7: Diagrama de proceso recolección de datos En función de que el operador tiene que estar ejecutando esta actividad cada hora, y tomando en cuenta que esta toma aproximadamente 15 minutos, al cabo de 1 día se tendría 6 horas para esta actividad, en un mes se tendría 186 horas y en un año se requeriría aproximadamente 2190 horas o 91.25 días por persona para el ingreso de información al sistema EMS del CENACE. Los servidores denominados RDAS (Ranger Data Adquisition Server) son los encargados de la adquisición de datos del sistema central, el cual cuenta con 8 puertos seriales que pueden manejar los protocolos DNP 3.0, RP-570 e ICE 870-5-101. Para la incorporación de información al sistema EMS de los medidores instalados en las centrales de generación, se lo realizará mediante un equipo que funcione como Gateway, el cual se comunicará con los servidores RDAS mediante uno de los puertos seriales disponibles y con los medidores utilizando el protocolo DNP 3.0 sobre TCP/IP o Modbus conforme la Fig. 8. 3.3. Levantamiento de información del proceso Post Operativo El área Post Operativa coteja la información de los datos ingresados de forma horaria por parte de los operadores, con datos que son enviados posteriormente por parte de los agentes, a fin de validar tiempos de ingresos y cuantificar la generación de las centrales de manera horaria; sin embargo, el tiempo de este proceso de validación puede aumentar de manera considerable, ya que se puede tener errores en el proceso de digitación por parte de los operadores, escuchar mal un dato enviado telefónicamente o los operadores de las centrales pueden visualizar o entregar de forma errónea la información de generación, lo cual involucra mayores tiempos hasta poder validar y encontrar los posibles errores en la información. 4. DISEÑO DE LA ARQUITECTURA DE DATOS Debido a que las pequeñas centrales de generación no disponen de equipos como gateways o UTRs, para la recolección de información ni de canales dedicados que permita la comunicación con los F. E. remotos del CENACE, lo cual involucraría inversiones económicas Figura 8: Diagrama de la Arquitectura Planteada 5. DEFINICIÓN CONCEPTO DE LA PRUEBA DE En función de la arquitectura planteada y a fin de tener una adecuada mejora en el proceso que se ejecuta de manera horaria, para la toma de datos por parte de los operadores del CENACE, para la definición de la prueba de concepto se escogió todos los medidores que se conectan por medio de las redes WAN de la CELEC y EEQ, las mismas que corresponden a las centrales de generación de la Empresa Eléctrica Quito 112 y CELEC-EP TERMOESMERALDAS y todos los medidores publicados al Internet. Adicionalmente a las centrales levantadas en las tablas 1 - 6 correspondiente a la generación entre 1 y 5 MW, también se considera la incorporación del medidor instalado en la S/E móvil colocada en Quininde, a fin de disponer de la supervisión de esta posición en el SNI. Tabla 7: Centrales y S/E prueba de concepto el caso del medidor instalado en la móvil de la S/E Quinindé, este equipo disponía de un extensor que permite ingresar señales digitales, con lo cual se tiene datos de seccionadores y alarmas de esta S/E. 6.2. Configuración Firewall Conforme la arquitectura planteada, el Gateway se encuentra instalado en la infraestructura de Data Center del CENACE y a fin de que este equipo tenga la seguridad necesaria para la publicación al Internet, esta se la realiza mediante el Firewall de Data Center, apresurándose los puertos: 20000 para la conexión con los medidores en el protocolo DNP3 sobre TCP/IP, el puerto 502 para la conexión en el protocolo Modbus sobre TCP/IP y el protocolo ICMP para pruebas de conectividad con los equipos. Adicionalmente, este firewall presta seguridad para las conexiones provenientes de los medidores que se encuentran en las redes WAN de la CELEC – Transelectric y de la Empresa Eléctrica Quito. 6.3. Configuración del Gateway El CENACE cuenta con un Gateway que permite la configuración del protocolo DNP3.0 en modo master, para la comunicación con los medidores y modo esclavo para la comunicación con el sistema EMS. 6. CONFIGURACIÓN Y PUESTA EN MARCHA DE LA PRUEBA DE CONCEPTO 6.1. Configuración Medidores Para la configuración de los medidores se utiliza el programa ION Setup V3.0, el cual permite la conexión con los medidores mediante el puerto 7700, para la configuración de los distintos parámetros del medidor. Una vez ingresado al medidor en la sección de comunicaciones se dispone de una pestaña para configuración del protocolo DNP 3.0, en el cual se ingresa los datos requeridos que son la IP del Master, el ID que va a tener el equipo y la configuración del tipo de datos analógico que se va a utilizar. Para la configuración del Gateway con los medidores se requiere el ID, la dirección IP y los números de los registros que se van a leer del medidor. Esta configuración es ingresada en el driver DNP3.0 master el cual se asocia a la tarjeta de red del equipo. Adicionalmente se programó para que realice el polling de los datos cada 4 segundos. Para la configuración con el sistema se determinan los parámetros del puerto RS232, se ingresa el ID con el cual va a preguntar el sistema, y se crea todos los TAGS analógicos y digitales que serán enviados al EMS del CENACE. Esta configuración es ingresada en el driver DNP3.0 slave y se la asocia al puerto RS232 del equipo. Adicionalmente, para el paso de información del driver, que recolecta la información de los medidores al driver, que entrega la información al sistema, se realiza una programación en Ladder la que es similar a la que se realiza en Visual Basic. De estos equipos se está obteniendo las señales de Potencia activa, reactiva, frecuencia y voltaje. En 113 6.4. Configuración del Sistema El equipo Gateway se conecta directo a un puerto serial de los servidores (RDAS), para lo cual se configura en el sistema el puerto en función de lo colocado en el driver de DNP3.0 slave y generándose una base de datos con un total de 92 señales analógicas y 23 señales digitales correspondiente a las 13 centrales de generación y a la S/E Quinindé. Adicionalmente, se elaboró los respectivos despliegues que permita utilizar esta información por parte de los operadores de sala de control del CENACE. Esta información al ser parte del sistema, es historizada en los servidores HIS del sistema. 7. VALIDACIÓN Y PRUEBAS 7.1. Conexión con los medidores y tiempos de respuesta Mediante esta variable se programó en ladder una alarma, que permite indicar al sistema EMS si existe algún problema de conexión con el medidor y por ende si el dato es válido o no como se indica en la Fig. 11; sin embargo, debido a los posibles problemas que puede ocasionarse en el medio de transmisión, ya que es posible que se presenten intermitencias, para declarar a un medidor “fallado” debe pasar la variable con un valor negativo durante 6 segundos, para lo cual se realiza una programación adicional en ladder. Con esto se evita tener una intermitencia en la alarma de comunicaciones del equipo que es desplegada en el sistema EMS. En función de los resultados, el medidor de la Central San Miguel de Car, que se encuentra publicado al Internet, tiene la mayor latencia con un tiempo de 719ms. Sin embargo a pesar de esto se tiene una respuesta adecuada en la actualización de los datos en el equipo Gateway y sistema EMS del CENACE. A fin de validar si existe conectividad desde el Gateway hasta los medidores, el equipo tiene un driver que permite enviar un paquete icmp hacia los medidores y el retardo del tiempo generado es almacenado en mili segundos en una variable como se muestra en la Fig. 9, en caso de que no se tenga respuesta desde el medidor el equipo regresa un valor negativo de la variable como se muestra en la Fig. 10. Figura 11: Indicación problemas de transmisión de datos 7.2. Validación de datos provenientes del campo Figura 9: Respuesta de Ping Figura10: Respuesta negativa de Ping Para la contrastación de información se realizó la validación mediante la aplicación ION Setup 3.0, que permite visualizar en tiempo real la información del medidor, comparándola con la información que se dispone en ese instante en el sistema EMS del CENACE, de cada una de las variables que es obtenida por cada medidor. Otra forma de contrastar la información es comparando la información que despliega los medidores vía WEB con lo que se 114 dispone en ese instante en el sistema. • Mediante la incorporación de estos datos se evita errores que se podría tener, debido a una mala lectura de la información desde el campo por parte de los operadores de las centrales o en la digitación de los datos al realizar el ingreso manual de los datos al sistema por parte del Operadores del CENACE. • Se tiene mayor concentración por parte de los operadores del CENACE para la operación y supervisión del sistema, al evitar la acción de ingresar los datos de manera horaria. • Se evitan interrupciones durante la ejecución de maniobras en el SNI, especialmente durante emergencias o restablecimiento ante fallas presentadas en el SNI, al no tener interrupciones de llamadas telefónicas generadas por parte de los operadores de las centrales, para la entrega de información de manera horaria. • Se optimiza los tiempos del proceso post operativo, al contar con una fuente de información confiable, evitando demoras por posibles errores de la información ingresada manualmente. • Por otra parte se recomienda: • Utilizar la arquitectura planteada para el ingreso de futuras centrales de generación entre 1 y 5 MW al sistema EMS del CENACE, en especial las centrales no convencionales como pueden ser eólicas o solares. • Complementar la regulación del CONELEC 005/08 referente a la entrega de información al CENACE para las centrales menores a 5 MW. • Utilizar este equipo para la integración, presentación y envío de información al Sistema EMS del CENACE de otro tipo de información como puede ser el proyecto de Eficiencia Energética y Energías Renovables que se está llevando a cabo en el CENACE. Una vez validada la correspondencia de todos los valores entre el medidor y el sistema, se puede utilizar esta información para la operación y supervisión, la misma que está contenida en un despliegue tabular creado en el sistema conforme la Fig. 12. Figura 12: Despliegue en el sistema EMS de las Centrales de Generación 1-5 MW 8. CONCLUSIONES Y RECOMENDACIONES La arquitectura planteada permite realizar la adquisición en tiempo real de las centrales de generación menor a 5MW, utilizando los medidores de energía ION del sistema de Medición Comercial del CENACE. Con la incorporación de esta información en tiempo real al sistema EMS del CENACE, se tiene los siguientes beneficios en la operación y supervisión del SNI: • Reducción del tiempo asignado al ingreso manual de datos de forma horaria, correspondiente a las centrales de generación entre 1 – 5 MW. • Se mejora la supervisión en tiempo real del sistema ya que mediante esta arquitectura se incorpora aproximadamente 60,9 MW al sistema EMS del CENACE. • Se optimiza el consumo de recurso telefónico por parte de las centrales de generación, al evitar llamadas al CENACE para entregar los datos de generación vía telefónica o envío de correos electrónicos de manera horaria. • Se optimiza el consumo de recurso telefónico por parte de los Operadores del CENACE, al evitar realizar llamadas a las centrales de generación, para la recolección de datos vía telefónica de manera horaria. REFERENCIAS BIBLIOGRÁFICAS 115 [1] Burton J. (2012) TWinSoft & Tbox Trainning [2] ABB. (Febrero de 2011). DNP3 Communication Protocol Manual. Obtenido de http://www05. abb.com/global/scot/scot354.nsf/veritydispl ay/5b0552a1511e3d9ac125783a004549d7/$ file/1mrk511241-uen_-_en_communication_ protocol_manual__dnp___650_series__iec. pdf [3] Cubillo, R., & Barba, R. (2009). SISTEMA PARA LA ADQUISICIÓN Y PROCESAMIENTO DE DATOS PARA EL ANÁLISIS DE LA OPERACIÓN DEL S.N.I. A PARTIR DE LA APLICACIÓN PI DEL SISTEMA NETWORK MANAGER. Revista Energía CENACE [4] Vallecilla, J. C. (2006). INSTALACIÓN, PRUEBAS Y MANTENIMIENTO DEL SISTEMA DE ADQUISICIÓN DE DATOS eLAN PARA EL MONITOREO Y CONTROL DEL CENTRO NACIONAL DE CONTROL DE ENERGÍA (CENACE). QUITO. [5] Schneider Electric. (2006) TECHNICAL NOTE Multiport DNP 3.0 and ION Technology Actualmente se desempeña como Ingeniero de Telecomunicaciones en la Dirección de Sistemas de Información. Sus áreas de interés se relacionan con los protocolos de transmisión SCADA y redes de comunicaciones. Hugo Ortiz Tulcán.- Nació en Quito en 1965. Recibió su título de Ingeniero en Electrónica y Control en la Escuela Politécnica Nacional en 1990. Su formación de postgrado incluye una especialidad en Control Automático en la Universidad de Tel Aviv y una Maestría en Gestión de la Productividad en la Escuela Politécnica del Ejército. Sus áreas de interés están relacionadas con la Innovación Tecnológica, la Automática y los Sistemas de Gestión. Juan Carlos Vallecilla Mosquera.Nació en Quito, Ecuador en 1981. Recibió su título de Ingeniero Electrónico de la Escuela Politécnica del Ejército en el 2006. Egresado de la Maestría en Redes de Información y Conectividad de la Escuela Politécnica del Ejército en 2008. 116 Información Operativa en Dispositivos Móviles C. Del Hierro R. Sánchez Centro Nacional de Control de Energía, CENACE Resumen— El avance tecnológico en dispositivos móviles, se han convertido en una herramienta importante para desplegar información tanto a nivel gerencial y operativo. El presente articulo describirá la implementación de los sistemas IODM (Información Operativa en Dispositivos Móviles) en la corporación CENACE y algunas aplicaciones web como parte de la iniciativa de observar información operativa en cuasi tiempo real de mediciones e indicaciones del Sistema Nacional Interconectado con una frecuencia de actualización de 5 segundos; y en el caso de datos provenientes de los PMUs en una frecuencia de 1 segundo para dispositivos móviles a través de internet. Palabras clave— IODM (Información Operativa en Dispositivos Móviles), Adquisición de Datos, PI (Plant Information), interfaces, Scalable Vector Graphics SVG, HTML5. Abstract— Recent technological advances in mobile devices have turned them into important tools for displaying information at both management and operational levels. This article will describe the implementation of OIMD (Operating Information on Mobile Devices) systems in CENACE as well as some web applications as part of an initiative to observe operative information (measurements and signals in the National Interconnected System), in mobile devices over the internet, in quasi-real time with an updating frequency of 5 seconds, and 1 second for data coming from PMUs. Index Terms— OIMD (Operative Information on Mobile Devices), Data Acquisition, PI (Plant Information), Interfaces, Scalable Vector Graphics SVC, HTML5. 1. INTRODUCCIÓN El objetivo de este artículo es presentar el proceso de implementación del sistema de información operativa y gerencial en dispositivos móviles el cual tiene cubierto el siguiente alcance de presentación: • Nivel de información estratégica gerencial; en la cual la disponibilidad de esta información en dispositivos móviles facilitará la toma de decisiones concernientes a los ámbitos tácticos de responsabilidad del CENACE • Nivel de información estratégica operativa; en la cual la disponibilidad de esta información en dispositivos móviles facilitará la toma de decisiones operativas en el sistema eléctrico ecuatoriano. 2. DESCRIPCIÓN DE LOS SERVICIOS DE INFORMACIÓN EN DISPOSITIVOS MÓVILES PARA EL CENACE 2.1. Adquisición de datos La adquisición de datos para los servicios de Información en Dispositivos Móviles se lo realiza a través de las arquitecturas existentes para los sistemas: “Energy Managment System” (EMS) y “Wide Area Monitoring System” (WAMS) del CENACE. Para el primer caso se lo realiza a través de las Unidades Terminales Remotas (UTRs); y para el segundo caso a través de las Unidades de Medición Fasorial (PMUs). A través de los sistemas EMS y WAMS, se realiza la adquisición de datos de: las variables eléctricas (voltajes, frecuencia, potencia, etc.), estados de equipos (seccionadores, interruptores, alarmas de transformadores, etc.) y las mediciones fasoriales de las variables eléctricas del Sistema Nacional Interconectado (SNI). 117 Cada sistema tiene una arquitectura de adquisición de datos diferente; para el caso del SCADA del EMS, la Fig. 1 muestra la conexión de las UTRs a los 4 Front Ends (concentradores de datos) ubicados estratégicamente en el país, de manera que se logra una arquitectura de comunicaciones distribuida. Los 4 Front Ends permiten la integración de los datos de provenientes de las UTRs con los centros de control de CENACE y CELEC EP TRANSELECTRIC. Una de las capacidades de esta infraestructura es la integración y la consulta de datos históricos y/o en tiempo real de diferentes fuentes de información. Figura 3 : Esquema de conexiones de la Plataforma PI corporativa En la fig. 3, se observa la conexión que tiene la plataforma PI con el sistema EMS y WAMS. En el caso de la integración de información 1 del EMS, la conexión se da a través de los servidores PI (HIS) del EMS y los PI servers corporativos. Figura 1 : Sistema de Adquisición de Datos del S.N.I Para el caso de WAMS, en la Fig. 2 se muestra la ubicación de los diferentes PMUs existentes en el S. N. I. Cada PMU se conecta al Phasor Data Concentrator (PDC) y al servidor de interfaces de PI del CENACE. Debido a la necesidad de alta disponibilidad de datos de los PMUs, la configuración de la red de estos dispositivos es tipo anillo. Para el caso de WAMS, la conexión se la realiza a través del servidor de interfaces (PI-Interfaces), donde se utiliza la interfaz PI - IEEE C37.118 para la comunicación con los PMUs, luego los datos recopilados son almacenados en el PI server de WAMS. En consecuencia, a través de los servidores PI se puede compartir y/o integrar la información de distintas fuentes, de manera que otras plataformas de desarrollo puedan usar la información integrada para mostrarla en dispositivos móviles. 2.3. Servicios de Información implementados La Dirección de Sistemas de Información del CENACE realizó la implementación de los siguientes sistemas de información para celulares: • Roambi: Muestra información histórica, estadística de los procesos corporativos. • Visual KPI - Transpara2: Muestra los Indicadores Clave de Desempeño (KPI) estratégicos de la corporación. • IODM - Peep3 : Permite visualizar en tiempo real información operativa del SCADA-EMS. Figura 2 : Conexiones de PMUs en el S.N.I. 2.2. Integración de la información Los datos provenientes tanto a través del EMS, como de WAMS son integrados a través de la plataforma corporativa PI (Plant Information1) del CENACE. 1 El sistema PI es una infraestructura operativa, de evento y administración de datos en tiempo real. 2 Visual KPI es el producto principal de Transpara. Es una aplicación de software empresarial diseñado para BI móvil, control de operaciones, cuadros de mando y alerta. 3 Peep es una plataforma para la visualización dinámica de vectores gráficos, alimentados por información en tiempo real, desde dispositivos móviles. 118 • WAMS Apps: Monitoreo en tiempo real de la información fasorial, a través de la interfaz PI IEEE C37.118. Motivo de análisis para este artículo son aquellos relacionados con la publicación de información operativa del S.N.I a través de: Peep – IODM, Visual KPI, WAMS Apps. 3. INFORMACIÓN OPERATIVA DISPOSITIVOS MÓVILES EN Como se menciona en 2.3, los sistemas de interés para este artículo son: Visual KPI-Transpara, WAMS Apps, IODM-Peep. 3.1. Visual KPI Muestra los Indicadores Clave de Desempeño (KPI) estratégicos de la corporación. Los indicadores al momento implementados en el sistema, son aquellos relacionados con: Nivel de embalse y caudal de las centrales hidroeléctricas, voltaje en barra de las Subestaciones del S.N.I, y frecuencia del sistema. Una señal proveniente de campo se convierte en un indicador cuando se le establece límites operativos, así por ejemplo: Tabla 1 : Diseño de un KPI Figura 4 : Presentación de los KPIs en Visual KPI Para el caso de aquellos indicadores KPI a los cuales se le puede asignar una referencia geográfica, es válido también obsérvalos en un geo-mapa. La fig. 5, muestra el ejemplo de visualización de los KPIs relacionados con el perfil de voltaje en el país. Un color identificativo de la zona en la que se encuentra la medición permitirá a quien visualice la información, una rápida detección de aquellos indicadores que están fuera del rango normal. El código de colores adoptado por CENACE para los indicadores del sistema Visual KPI es mostrado en la tabla 1. Cada KPI tiene su particularidad. En el sistema: se analiza el KPI a implementar, se le asigna los límites relativos, se le asocia a la categoría a la que pertenece y finalmente se establece la identidad (punto de medida - tag) con la que se va a conectar al PI corporativo. Las definiciones mencionadas por cada KPI permiten la visualización los KPIs, la fig. 4 muestra ejemplos de la visualización de los KPIs. Figura 5 : Visualización de KPIs referenciados Geográficamente El sólo hecho de poder observar los KPIs agrupados permite al usuario identificar la categoría que requiere de análisis, y a través del menú, el usuario puede ingresar a observar un histórico del elemento de análisis. El usuario tiene la posibilidad de observar el indicador de interés en diferentes periodos de tiempo. La fig. 6 muestra el 119 KPI asociado a la medición de voltaje en barra de la subestación Orellana. • Zona Santo Domingo Quevedo • Central Villonaco En cada uno de estos se puede visualizar información en cuasi tiempo real de las variables de voltaje potencia activa y reactiva por las líneas y voltajes de barra como también la posición de interruptores en las distintas subestaciones de Sistema Nacional Interconectado Ecuatoriano. Además los elementos de potencia mencionados en el párrafo anterior tienen configurado la funcionalidad de coloreo dinámico dependiendo de los niveles de voltaje y estado del interruptor. En la fig. 8 se muestra el desarrollo del despliegue que permite la visualización de la información operativa en tiempo cuasi real del anillo de 230 kV del S.N.I Figura 6 : Tendencia de voltaje S/E Orellana 138kV 3.2. IODM – Peep Permite visualizar en tiempo real información operativa del sistema SCADA-EMS. Los despliegues a mostrarse en este sistema son diseñados en Processbook4 , las identidades (mediciones, estados) son asociadas al momento del diseño, la fig. 7 muestra el ambiente de desarrollo de PI Processbook: Figura 8 : Anillo de 230 kV del S.N.I Ecuatoriano Por otra parte la implementación de la primera central eólica en el Ecuador Continental, proyecto Villonaco, permitió la adquisición de datos de otras variables de proceso tales como son la velocidad y dirección del viento y su relación directa con la generación de potencia eléctrica. En la fig. 9 se muestra el despliegue que permite la visualización de las variables de proceso de la central Villonaco. Figura 7 : Ambiente PI Process Book Los despliegues diseñados pueden ser de diferentes tipos, al momento el sistema posee los siguientes despliegues: • • • • • • • Anillo S.N.I de 230 kV Frecuencias S.N.I Zona Colombia Zona Molino Milagro Zona Oriental Zona pascuales Trinitaria Zona Santa Rosa Totoras Figura 9 : Despliegue con Datos de Proceso de la Central Eólica Villonaco 3.3. WAMS Apps 4 Es una interface gráfica para el diseño de HMIs de proceso, herramienta propia del sistema PI. Monitoreo en tiempo real de la información fasorial, a través de la interfaz de PI - IEEE C37.118. 120 Como se menciona en la sección 2 de este artículo, los datos de los PMUs son almacenados en el servidor PIWAMS, las mediciones fasoriales de voltaje y potencia son muestreadas a una tasa de 20 muestras por segundo a través de la interface IEEE C37.118 de PI, sin embargo para la visualización en celulares sólo basta con tomar una de sus muestras por segundo. 4. ESQUEMAS DE PUBLICACIÓN La visualización de WAMS para dispositivos móviles fue desarrollada en Visual Studio, utilizando las tecnologías de HTML5, C#, Javascript y Ajax. Una de las ventajas de desarrollar estas aplicaciones web en HTML5 es su compatibilidad con dispositivos móviles actuales. El listado de su compatibilidad se puede ver en el link: http://mobilehtml5.org/. El esquema 1 fue concebido para la publicación de información relacionada con las unidades de mediciones fasoriales PMUs. El periodo de actualización de datos es de 1 segundos utilizando un servidor PI, un servidor de interfaces, un servidor de desarrollo de aplicaciones Web y un servidor Web. La fig. 11 muestra el esquema mencionado. La publicación de información para dispositivos móviles se lo hace a través de servidores web, cada uno con sus particularidades, a continuación se presentan los dos esquemas empleados para la publicación de información a los dispositivos móviles: La fig. 10 muestra la visualización de los fasores de voltaje en diferentes subestaciones del Sistema Nacional Interconectado. Figura 11 : Arquitectura para publicación de información de WAMS El esquema 2 mostrado en la fig. 12 esta relacionado con las variables de proceso del Sistema Nacional Interconectado y cuya rata de actualización es de 5 segundos. Para este esquema se utiliza el PI Corporativo de CENACE que se comunica interactivamente con los sistemas EMS, TRANSPARA y PEEP compartiendo la información recolectada en campo para presentarla a través de internet a los dispositivos móviles. Figura 10 : Visualización del fasor de voltaje en distintas Subestaciones La figura 11 muestra la diferencia angular entre fasores de voltaje de las Subestaciones del Sistema Nacional Interconectado pero mostradas de manera geo referencial. Los aplicativos corren javascripts para su actualización gráfica dentro del dispositivo cliente, mientras que los datos que alimentan cada aplicación son adquiridos mediante AJAX. Este desarrollo fue realizado dentro del área de Sistema de Tiempo Real del Sistema de Información del CENACE, el ámbito de investigación fue dentro del ámbito del diseño de aplicaciones Web de Visual Studio. Figura 12 : Arquitectura para publicación de información del EMS A través de TECSO Y TRANSPARA Ambos esquemas son integrados a través de la plataforma de PI, y su publicación queda definida en tres servidores web: Tecso, Transpara y servidor Web del PI corporativo (sicomb). Como se muestra en las Fig. 12 y 13. 121 5. CONCLUSIONES Y RECOMENDACIONES 5.1. Conclusiones La información disponible a ser desplegada en el sistema IODM tiene una estrecha relación con los esquemas de adquisición de datos implementados en campo, por esta razón es muy importante la correcta instalación y pruebas realizadas en campo, de esta manera se evitará ver información distorsionada. A nuestros compañeros de las distintas direcciones del CENACE que participaron el desarrollo de los despliegues e índices KPI y su colaboración en las distintas definiciones en las plataformas: Hugo Paredes, Pablo Salazar, Aharon de la Torre, Lourdes Farinango, Gabriel Rivera, Gioconda Rodríguez. REFERENCIAS BIBLIOGRÁFICAS [1] W3C Standars, World Wide Web Consortium, 1994 Para poder realizar la implementación de estos sistemas fue necesario el conocimiento de varias herramientas de desarrollo Web (Visual Studio), configuradores de base de datos y el dominio en el sistema PI. De la experiencia adquirida se puede observar que seguir la normativa de W3C en cuanto a diseño de aplicaciones es la mejor opción en este tipo de desarrollos. La presentación de una forma resumida y amigable de la información operativa del S.N.I e indicadores claves de desempeño convierten a estos servicios de información en una herramienta poderosa y aliada para la toma de decisiones; además que su compatibilidad con dispositivos móviles tales como tabletas y teléfonos inteligentes permite el fácil acceso a información táctica y estratégica. Luego de las pruebas realizadas a los diferentes sistemas, vemos la necesidad de tener un portal web que integre el acceso a los diferentes servicios implementados. 5.2. Recomendaciones Se recomienda la elaboración de una encuesta a nivel de usuario para verificar su satisfacción sobre la información presentada como también conocer nuevos requerimientos. Se recomienda socializar esta herramienta con organismos del sector eléctrico como el MEER, CELEC, agentes privados, para que con el acceso a la información disponible del S.N.I puedan mejorar sus procesos de operación. AGRADECIMIENTOS Al CENACE y a sus autoridades; en especial a la Direccion de Sistemas de Información por permitirnos participar en la implementación y desarrollo de estos proyectos. [2] HTML5 (HyperText Markup Language, versión 5) http://www.w3.org/TR/html51/ [3] AJAX, Asynchronous JavaScript And XML, http://api.jquery.com/jQuery.ajax/ Carlos del Hierro Cadena.- Nació en Quito, Ecuador en 1978. Recibió su título de Ingeniero Electrónico con especialidad en Automatización y Control de la Escuela Politécnica del Ejército en 2001. Como experiencia profesional ha desarrollado actividades en el campo de la industria de fabricación de sanitarios, pastas alimenticias, sistemas de seguridad y control vehicular. Al momento, es parte de la Dirección de Sistemas de Información del CENACE en el área de Sistema Remoto y también participando en las actividades relacionadas con e Proyecto de “Gestión y Control de Combustibles en el Sector Eléctrico”. Roberto Gonzalo Sánchez.- Nació en Quito en 1986. Obtuvo el título de bachiller técnico industrial en la especialización de electrónica en el 2004. Recibió su título de Ingeniería Electrónica en Automatización y Control en el 2010. Actualmente es parte del área de Sistema de Tiempo Real en la Dirección de Sistemas de Información del CENACE y en el Proyecto de “Gestión y Control de Combustibles en el Sector Eléctrico”. A nuestros compañeros de la Dirección de Sistemas de Información que acompañaron y dieron su soporte técnico y moral en las distintas actividades que surgieron en la implementación del Proyecto. 122 Análisis de Estabilidad de Pequeña Señal Utilizando Mediciones Sincrofasoriales PMU A. F. Quinaluiza † D. E. Echeverría‡ † Escuela Politécnica Nacional ‡Centro Nacional de Control de Energía, CENACE Resumen— Con el acelerado crecimiento de la demanda en los últimos años, las transferencias de potencia a largas distancias entre diferentes empresas de energía han ido aumentando constantemente, razón por la cual la seguridad y confiabilidad de los Sistemas Eléctricos de Potencia -SEP- pueden verse seriamente comprometidas, especialmente por el alto riesgo de violación de los límites de seguridad del sistema eléctrico. This utilizes data from PMU’s that are strategically located throughout the SNI to perform lowfrequency oscillation analysis, applying one of the modal parameter estimation techniques known as the Prony Analysis Method. Uno de los desarrollos más importantes e innovadores en el área de monitoreo y control de los SEP está orientado a las Unidades de Medición Fasorial (PMU). Esta tecnología permite realizar el monitoreo de oscilaciones de baja frecuencia del Sistema Nacional Interconectado -S.N.I.- en tiempo real. 1. INTRODUCCIÓN En el presente trabajo se utiliza la información de las PMU’s, las cuales se encuentran estratégicamente ubicadas en el SNI, para realizar el análisis oscilatorio de baja frecuencia, mediante la aplicación de una de las técnicas de estimación modal conocida como Análisis Prony. Palabras claves— Estabilidad de pequeña señal - Mediciones Sincrofasoriales – PMU – Prony WAMS. Abstract— Given the accelerated growth in demand over the last few years, long-distance power transfers between different energy companies have been steadily increasing, which means that the safety and reliability of Electric Power Systems (EPS) could become seriously compromised, especially given the high risk of violating the electricity system’s security limits. One of the most important and innovative developments in the area of EPS control and monitoring involves Phasor Measurement Units (PMU). This technology enables real-time monitoring of low-frequency oscillations in the Sistema Nacional Interconectado - SNI (National Interconnected System). Index Terms— Small-signal stability – Synchrophasor Measurements – PMU – Prony – WAMS. La estabilidad de ángulo del rotor de un SEP puede verse interrumpido debido a la pérdida de sincronismo de las máquinas después de haber sido el sistema eléctrico sometido a una perturbación, el problema de estabilidad de ángulo del rotor involucra el estudio de las oscilaciones electromecánicas inherentes a los sistemas de potencia. La metodología que se usa en el presente trabajo para la identificación de modos oscilatorios de baja frecuencia presentes en el SEP se basa en el procedimiento de mediciones sincrofasoriales registradas por los equipos PMU’s. El presente artículo técnico se organiza de la siguiente manera, en la sección 2 se presenta las características de la medición sincrofasorial. La sección 3 presenta las metodologías usadas para la detección de los modos oscilatorios, en la que destaca el método de estimación modal conocido como Análisis Prony. En la sección 4 se simula el sistema de dos áreas y se realiza el análisis Prony de las señales simuladas. La sección 5 presenta lineamientos con respecto a la definición de la ventana de análisis con el fin de obtener resultados confiables de los modos oscilatorios. En la sección 6 se realiza un análisis de un evento registrado en el S.N.I., finalmente en la sección 7 se presenta las conclusiones del trabajo. 2. TECNOLOGÍA DE SINCROFASORIAL (PMU) MEDICIÓN Un fasor constituye la representación analítica de ondas sinusoidales en estado estacionario a frecuencia fundamental. Los voltajes y corrientes de 123 la red eléctrica son ondas sinusoidales que vienen representadas, de forma genérica, por la siguiente ecuación [1]: (1) Donde ω es la frecuencia de la señal en radianes por segundo, φ es el ángulo de fase en radianes y Xm es la amplitud pico de la señal. El fasor puede ser representado por un número complejo que gira a la velocidad angular ω, conocido como su representación fasorial o simplemente fasor, como se observa en la ecuación (2) [1]: (2) Donde: X_m/√2 es el valor RMS de la señal. 2.2. Sistemas de Medición Fasorial Jerárquico La mayoría de datos de los fasores son utilizados en centros alejados de las PMU’s por lo que es necesario un sistema de comunicaciones y concentradores de datos (PDC) que permitan el traslado de la información a los centros de control para aprovechar los beneficios del sistema de medición [1], en la arquitectura de transmisión de datos de los fasores los dispositivos que siguen a la PMU en nivel jerárquico son los concentradores de datos (PDC). Los PDC son dispositivos que se encargan de recibir, filtrar, procesar y almacenar los datos de los fasores provenientes de las PMU’s con su respectiva estampa de tiempo y en algunos casos de otros PDC’s para crear un conjunto de datos fasoriales de una gran parte del sistema o de todo el sistema [4]. Un sincrofasor o fasor sincronizado se define como “un fasor calculado a partir de datos muestreados usando una señal de tiempo estándar como referencia para la medición”. La referencia angular es una onda coseno de frecuencia nominal, sincronizada con el tiempo UTC (Coordinated Universal Time) a través de GPS [12] Para la transferencia de datos desde las PMU’s hasta los PDCs, se requiere una red apropiada de comunicación, que puede ser de fibra óptica, tecnologías de comunicación telefónica, digital y Ethernet, la transmisión de datos se realiza bajo protocolos de comunicación [5]. 2.1. Unidades de Medición Fasorial (PMU) 2.3. Sistema de Medición de área Amplia (WAMS) Las PMU’s son dispositivos que permiten estimar los sincrofasores de las ondas sinusoidales de corriente y voltaje alternos, en diferentes barras de un SEP [2], todas las medidas que se obtienen de las PMU’s son sincronizadas con un mismo tiempo de referencia, a través del sistema GPS. La Fig. 1 presenta las funciones principales de la PMU. Los sistemas WAMS son aquellos que permiten disponer de mediciones distribuidas en el SEP. Se componen principalmente de equipos de medición fasorial (PMU), concentradores de datos (PDC), sistemas de comunicaciones de alta capacidad que permite tomar con gran precisión lecturas sincronizadas de las condiciones de la red en puntos estratégicos del sistema [6]. Las PMU’s entregan información en intervalos de milisegundos en comparación con el tradicional sistema SCADA. Tabla 1: Mediciones PMU vs mediciones SCADA [2] Figura 1: Funciones principales de la PMU [2] La estructura de una PMU genérica se compone de un sistema de adquisición de datos PDC, cuenta con: filtro anti-aliasing, módulo conversor análogo-digital, oscilador de sincronización de fase, microprocesador, y receptor de GPS [3]. 124 2.3.1. WAMS en el Ecuador [2] La Corporación CENACE (Centro Nacional de Control de Energía) ha estado trabajando, desde el año 2010, con iniciativas para la implementación y estructuración del sistema WAMS con el objetivo de monitorear y supervisar en tiempo real las oscilaciones presentes en el S.N.I. Actualmente se encuentran instalados 18 dispositivos PMU’s en las principales subestaciones del S.N.I. mediante el uso de métodos como: análisis modal o identificación modal. El problema de estabilidad de ángulo del rotor involucra el estudio de las oscilaciones electromecánicas inherentes a los sistemas de potencia, para mantener o restaurar el equilibrio entre el torque eléctrico y el torque mecánico de cada máquina del sistema, la dependencia del tipo de perturbación permite clasificar el problema de estabilidad angular en dos tipos: estabilidad transitoria (Gran Señal) y estabilidad oscilatoria (Pequeña Señal), Gran Señal cuando se analiza cambios grandes en el sistema que pueden ser debido a cortocircuitos, pérdida de una línea o unidad de generación y Pequeña Señal cuando se analiza cambios pequeños en el sistema debido a variaciones entre la carga y generación las cuales producen pequeños cambios en el ángulo del generador, velocidad y potencia. La estabilidad oscilatoria del sistema de potencia depende de la existencia de las componentes del torque sincronizante y torque de amortiguamiento para cada máquina sincrónica. Figura 2: Ubicación física de las PMU's en el S.N.I [7]. 2.4. Aplicaciones de la PMU [5] [8] Las PMU's permiten una serie de aplicaciones para incrementar la confiabilidad de la red “basada en mediciones” en lugar de modelos matemáticos del sistema de potencia. A continuación se presenta las principales aplicaciones de los sistemas WAMS: La inestabilidad de pequeña señal puede darse por: • Incremento monótono del ángulo del rotor debido a la falta de suficiente torque sincronizante Ts (negativo). Este da origen a un modo de inestabilidad no oscilatoria. • Oscilaciones del rotor de amplitud creciente debido a la falta de suficiente torque de amortiguamiento Td (negativo). El mismo que da origen a un modo de inestabilidad oscilatoria. Supervisión del sistema eléctrico de potencia en “tiempo real”. Mejora la estimación de estado. Mejora la confiabilidad de las acciones de control, disminuyendo incertidumbres en la toma de decisiones. • Supervisión del comportamiento del ángulo, potencia, frecuencia y voltaje de los SEP's. • Sistemas de protección avanzado de los SEP’s. • Detección más precisa del punto de falla. • Detección de oscilaciones Inter-áreas. 3. METODOLOGÍAS PARA MONITOREO DE OSCILACIONES DE BAJA FRECUENCIA EN TIEMPO REAL UTILIZANDO PMU [9] Las perturbaciones en los SEP, producen oscilaciones en el sistema que pueden ser identificadas a través del análisis de estabilidad de pequeña señal, (3) 3.1. Oscilaciones del Sistema de Potencia Las oscilaciones son caracterizadas mediante los denominados modos de oscilación que pueden clasificarse en forma general, en los siguientes [9]: Los modos inter-área, los cuales son causados por interacciones entre grandes grupos de generadores oscilando entre ellos, estos modos presentan rangos de frecuencia entre 0,1 a 0,7 Hz. Los modos locales, se asocian con oscilaciones entre rotores de un grupo de generadores cercanos unos a otros, estas oscilaciones presentan frecuencias en el rango de 0,7 a 2,0 Hz. Los modos de control, se asocian con el control de las unidades de generación y equipos, Los modos torsionales, se presentan cuando los controles, 125 interactúan con la dinámica del sistema eje-turbinagenerador de las unidades generadoras. Este tipo de oscilaciones presentan un rango de frecuencias asociadas bastante amplio. 3.2. Métodos de Análisis de Oscilaciones de Baja Frecuencia Los métodos de análisis permiten estimar los modos oscilatorios presentes en el sistema de potencia a partir de métodos basados en modelo del sistema (análisis modal) y métodos basados en mediciones sincrofasoriales obtenidas de las Unidades de Medición Fasorial (PMU). 3.2.1 Método basado en modelo del sistema (Análisis Modal) [9] La técnica matemática conocida como análisis modal, considera que ante pequeñas perturbaciones las ecuaciones diferenciales que representan la dinámica del sistema pueden ser linealizadas alrededor de un punto de operación. Esta herramienta permite luego determinar la frecuencia y el amortiguamiento de los modos oscilatorios a través del cómputo de los valores propios (λ) de la matriz de estado del sistema. 3.2.2 Métodos de estimación modal basado en mediciones Dentro de las técnicas más empleadas de identificación modal se encuentran: la Transformada de Fourier, Análisis Prony, Transformada de HilbertHuan, Filtro de Kalman, Transformada de Wavelet, entre otras. Estos algoritmos matemáticos permiten la estimación de los modos oscilatorios a partir de mediciones PMU’s. 3.3. Metodología de Análisis Prony [10] Esta técnica descompone la señal de interés en una suma de funciones exponenciales, cada una de las cuales está caracterizada por los siguientes parámetros: amplitud, fase, frecuencia y amortiguamiento. La señal y(t) consiste de N muestras y(tk) que son uniformemente espaciadas por una cantidad Δt. Donde n ≤N, es el subconjunto de modos a ser determinado, los tiempos de muestreo tk, por lo tanto la Ecuación 5 puede ser replanteada en forma discreta. (4) Los valores propios complejos se dan en pares conjugados y cada par corresponde a un modo oscilatorio donde la parte real (σ) es una medida de amortiguamiento del modo y la parte imaginaria (ω) da una medida de la velocidad angular del modo de oscilación, es decir, la frecuencia de oscilación del modo, (ωn) representa la velocidad angular del modo de oscilación y (ξ) razón de amortiguamiento del modo de oscilación, la Fig. 3 presenta una clasificación de los modos de oscilación según la ubicación en el plano complejo. (5) (6) (7) Donde: los Zi son las raíces del polinomio. 3.3.1 Algoritmo de Prony El algoritmo de análisis Prony para la obtención de las incógnitas requiere de algunos pasos que se detallan a continuación: Paso 1.- Colocar los elementos seleccionados del registro de mediciones y(tk) en una matriz de datos Toeplitz, la cual es una matriz con una diagonal constante en la que cada diagonal descendente de izquierda a derecha es constante [14]. Paso 2.- Ajustar los datos con un modelo de Predicción Lineal (PL) discreto. Figura 3: Ubicación de los autovalores en el plano, estabilidad [13]. Paso 3.- Encontrar las raíces del polinomio característico asociados con el modelo de PL del paso 1, encontrar los coeficientes de predicción que originarán las estimaciones de factor de amortiguamiento y frecuencia sinusoidal de cada término exponencial. 126 (8) Paso 4.- Con las raíces encontradas en el paso3, se obtiene una segunda ecuación lineal, con la cual es posible estimar la amplitud de la exponencial y la fase inicial de la sinusoidal, el objetivo inmediato es encontrar los Ri y zi que produzcan ŷ(t). En base a este procedimiento se diseña un algoritmo a seguir para el método Prony que se muestra en la Fig. 4. y amplitud (MW) de los modos de baja frecuencia y pobre amortiguamiento. 4.1.1 Sistema de dos aéreas sin control de excitación Tabla 2: Modos oscilatorios, simulados en Power Factory. Tabla 3: Análisis Prony, modos en la señal de potencia activa. Figura 4: Algoritmo general de Prony [11] 4. APLICACIÓN DEL ANÁLISIS PRONY 4.1. Sistema de dos Áreas A continuación se simula el sistema de potencia de prueba de dos áreas en el programa computacional Power Factory de DigSILENT y se aplica el análisis Prony a las señales de potencia, voltaje y frecuencia en los diferentes nodos del sistema, con el objetivo de determinar la señal que brinda mayor observabilidad de los modos inmersos en las señales analizadas. 4.1.2 Sistemas de dos áreas con AVR (Automatic Voltage Regulator) Tabla 4 : Modos oscilatorios, simulados en Power Factory Tabla 5 : Análisis Prony, modos en la señal de voltaje con AVR Figura 5: Sistemas de dos aéreas interconectadas en 230 kV [9] En las Tablas 2, 4 y 6 se observa los resultados de los modos oscilatorios obtenidos mediante el programa Power Factory, mientras que en las Tablas 3, 5 y 7 se observa los modos oscilatorios obtenidos al aplicar el análisis Prony a diferentes señales mediante el uso del programa DSI Toolbox [2]. Se muestran los valores de frecuencia (Hz), amortiguamiento (ξ%) 127 4.1.3 Sistema de dos aéreas con PSS (Power System Stabilizer) Tabla 6 : Modos oscilatorios, simulados en Power Factory a través de la red de comunicaciones intranet estándar y realizar el monitoreo de las oscilaciones presentes en el SNI en tiempo real. Se tiene como premisa del análisis realizado en la Sección 4, que la señal de potencia activa brinda mayor observabilidad de los modos, razón por la cual la señal eléctrica de análisis en WAProtector por definición es la potencia activa del vínculo asociado a la PMU. Con el fin de mostrar la influencia de la longitud de las ventanas se aplica el análisis Prony a la señal de potencia activa registrada en la PMU: QUEV-PASC1-230, instalado en la S/E Quevedo, ante el disparo de la posición Calope de la subestación Quevedo 69 KV, ocurrido el 3 de agosto del 2013 a las 17:29:31. La Fig. 6 se muestra la señal de potencia registrada en la PMU y las ventanas seleccionadas para el análisis. Tabla 7 : Análisis Prony, modos en la señal de frecuencia con PSS Al aplicar el análisis Prony a las señales seleccionadas se observa la presencia de tres modos oscilatorios de baja frecuencia inmersos en la señal, un modo Inter-área con una frecuencia alrededor de (f=0,53 Hz), presentes en todas las señales analizadas, y dos modos locales con frecuencias alrededor de (f=1,079 Hz y f=1,717 Hz) presente solo en la señal de potencia activa, mientras que en las señal de voltaje y frecuencia solo se observa la presencia del modo local, esto se debe a que la amplitud que presentan los modos son muy bajos y no aportan a la reconstrucción de la señal en el análisis Prony, por lo tanto se concluye que la señal que brinda mayor información y precisión de los modos oscilatorios de baja frecuencia presentes en el sistema analizado es la señal de potencia activa. Al analizar el sistema de dos aéreas para diferentes casos como: 1) sin control de excitación, 2) con AVR y 3) con PSS se observa la influencia que tiene cada elemento en el sistema de potencia y como contribuye al efectivo control del amortiguamiento de oscilaciones, para mejorar la estabilidad del sistema ante la presencia de perturbaciones que ocurren en los SEP. Figura 6 : Potencia activa registrada en la PMU: QUEV_ PASC1_230 Se aplica el análisis Prony a la señal de potencia activa de interés en diferentes ventanas de tiempo (pre-contingencia, durante la contingencia y postcontingencia) con el fin de determinar los modos oscilatorios inmersos en la señal. 5.1. Pre-Contingencia 5.1.1 Análisis Prony. Ventana antes del disturbio, 2 s de análisis (17:29:27- 17:29:29) 5. VENTANA DE ANÁLISIS La precisión en la estimación de los modos oscilatorios mediante el uso del análisis Prony depende de la selección y longitud de la ventana de tiempo de análisis considerada. Para llevar a cabo el análisis oscilatorio aplicando el método Prony en el S.N.I. se utiliza las mediciones sincrofasoriales registradas en las PMU’s. La Corporación CENACE adquirió el software WAProtector, este permite adquirir los datos fasoriales de las PMU’s 128 Tabla 8: Modos oscilatorios. Ventana 2 s de análisis 5.1.2 Análisis de Prony. Ventana antes del d isturbio, 4 s de análisis (17:29:27-17:29:31) Tabla 9: Modos oscilatorios. Ventana 4 s de análisis 5.2. Ventana Durante el Disturbio (17:29:2917:29:32) Figura7 : Análisis Prony. Ventana 3 s durante el disturbio Tabla 10 : Modos oscilatorios. Ventana 3 s durante el disturbio Se observa en las Tablas 8 y 9 los resultados de los modos oscilatorios presentes en la señal de análisis, para la ventana de tiempo de 2 s los modos de baja frecuencia no pueden ser detectados mediante el análisis Prony, en cambio en las ventanas de 4 s y 10 s se aprecia el modo Inter-área y los modos locales, para la ventana en la que incluye el transitorio se tiene como resultados modos oscilatorios altamente inestables, observados en la Tabla 10. Las ventanas de análisis que permiten obtener buenos resultados de los modos oscilatorios son las ventanas en donde se analiza al menos dos veces el periodo del modo de interés, para este caso son las ventanas de tiempo de 4 s y 10 s. Además, el resultado de los modos al aplicar el análisis Prony también depende del lugar de elección de la ventana de análisis, de forma que se debe evitar analizar las ventanas cercanas o que contenga el disturbio ya que presentan altas no linealidades en las señales y el análisis de Prony es un método donde los datos se ajusta de forma óptima a un modelo de Predicción Lineal. Las ventanas de tiempo que deben ser analizadas para obtener buenos resultados de los modos es la parte final del transitorio. 6. DETECCIÓN DE MODOS OSCILATORIOS EN EL SNI 5.3. Post-Contingencia 5.3.1. Análisis Prony. Ventana después del disturbio, 4 s de análisis (17:29:32 - 17:29:36) Tabla 11: Modos oscilatorios. Ventana 4 s de análisis A continuación se presenta un ejemplo de análisis de estabilidad oscilatoria utilizando la información de los PMU’s. Para determinar los modos oscilatorios poco amortiguados en el S.N.I., ante la ocurrencia de un evento, se aplica el análisis Prony a la señal de potencia activa registrada en la PMU: POMA_JAM3_230 instalada en la S/E Pomasqui, luego del disparo de 550 MW de generación en la central Chivor en el sistema colombiano, ocurrido 21 de agosto del 2013 a las 21:11:31. En la Fig. 9 se presenta la señal registrada por la PMU 5.3.2. Análisis Prony. Ventana después del disturbio, 10 s de análisis (17:29:32-17:29:42) Tabla 12: Modos oscilatorios. Ventana 10 s de análisis Figura 8 : Señal de potencia activa registrada en la PMU: POMA_JAM3_230 Al presentarse un disturbio en los sistemas ecuatoriano o colombiano, este afecta directamente a los dos sistemas de potencia, por ejemplo en el caso de perder generación en el sistema colombiano, el efecto general es una disminución en el valor frecuencia sobre el 129 valor nominal de 60 Hz, debido al desbalance entre carga-generación. Este desbalance produce la actuación instantánea de todos los generadores del sistema que tratan de encontrar nuevos estados de operación estable, produciendo oscilaciones de potencia ocasionadas por los intercambios de energía entre las máquinas. Las oscilaciones generadas por causa del evento pueden traer problemas de inestabilidad oscilatoria por lo cual es indispensable conocer los modos poco amortiguados que pueden volver al sistema inestable. 6.1. Ventana después del disturbio, 4 s de análisis (21:11:33 - 21:11:37) Los resultados obtenidos al aplicar el análisis Prony a la señal analizada se puede apreciar en la Tabla 13 y 14 donde se observa la presencia de tres modos un Inter-área y dos locales para cada caso, el modo Interárea presenta amortiguamiento negativo de (ξ=-5,507% a ξ=-2,007%) símbolo de inestabilidad en el sistema, mientras el modo local varia su amortiguamiento (ξ=6,021% a ξ=3,339%), también se observa que los modos inmersos en la señal tiende a amortiguarse con el tiempo. Debido a la magnitud del evento el sistema no puede mantener el balance entre carga–generación por lo que trae consecuencias en el SNI como: • Actuación del primer paso de alivio de carga por baja frecuencia. • Baja frecuencia en el SNI • La importación de Ecuador a Colombia vario de 150,16 MW a 15,96 MW. Se tenía programado una importación de 152 MW 7. CONCLUSIONES Y RECOMENDACIONES Figura 9 : Análisis Prony. Ventana 4 s de análisis Tabla 13 : Modos oscilatorios. Ventana 4 s de análisis (21:11:27 - 21:11:31) 6.2. Ventana después del disturbio, 4 s de análisis (21:11:33 - 21:11:37) Figura 10 : Análisis Prony. Ventana 4 s de análisis Tabla 14 : Modos oscilatorios. Ventana 4 s de análisis (21:11:33 - 21:11:37). En la Fig. 8 se observa el comportamiento dinámico de la señal durante el evento, esta presenta oscilaciones crecientes con poco amortiguamiento que podrían llevar al sistema a la inestabilidad. Los resultados obtenidos al aplicar el análisis Prony a los eventos registrados por las PMU’s muestran que el método usado permite estimar con precisión los modos de las oscilaciones de baja frecuencia, sin embargo, para estimar los modos oscilatorios mediante el análisis Prony se debe tomar en cuenta varios aspectos como: selección de la señal para el análisis, longitud de la ventana de análisis, se debe evitar tomar ventanas de tiempo cercanas o que contengan el transitorio, ya que presentan modos altamente inestables debido a que los transitorios causados por disturbios provocan distorsiones muy fuertes en la señal, la ventana de tiempo que debe ser analizada para obtener buenos resultados de los modos es la parte final del transitorio ya que no presentan distorsiones fuertes o pronunciadas. Al estimar los modos inmersos en las señales analizadas se tiene como resultado modos con diferente frecuencia y amortiguamiento, esto se debe a que los valores de cada modo son dependientes del tipo de disturbio que se presente en el sistema de potencia, por lo que a diferentes disturbios se excitan diferentes componentes modales. En el sistema de prueba de dos áreas se observa que el AVR presenta lazos de control con ganancias muy altas, estas ganancias se ajustan con el objetivo de mejorar los límites de estabilidad luego de fallas transitorias pero ante pequeñas perturbaciones contribuye de forma negativa al amortiguamiento de oscilaciones dando como resultado un sistema inestable con amortiguamiento negativo (ξ=2,57%), mientras que los PSS aporta con amortiguamiento positivo (ξ=14,2%) a las oscilaciones que se presentan en el sistema, por lo tanto la combinación de los AVR y PSS 130 contribuyen de forma efectiva al amortiguamiento de las oscilaciones de baja frecuencia. La implementación de las WAMS en los sistemas eléctricos de potencia ayuda a la toma de medidas preventivas y de control inmediatas ante riesgos de inestabilidad que se producen en el sistema, las medidas sincronizadas en el tiempo obtenidas de las PMU’s permite observar la dinámica del sistema, la tasa de actualización de datos de las PMU’s es de 10-60 muestras por segundo en comparación con el tradicional SCADA cuya tasa de actualización de datos es 1 muestra cada 2 a 5 s. REFERENCIAS BIBLIOGRÁFICAS [1] Phadke A.G; Thorp, J.S, Synchronized Phasor Measurements and Their Applications. 1st Edition. M.A. Pai, University of Illinois at Urbana-Champaing, Urbana. Illinois, Alex Stankovic, Northeastern University, Boston, Massachusetts. U.S.A., 2008. [2] Colomé Delia, Sistemas de Medición WAMS. Curso de perfeccionamiento para profesionales de la Corporación CENACE, 10 al 12 de abril del 2013. [3] Borda Carlos; Díaz, Hernando; Olarde, Andrés, Identificación de Parámetros de Líneas de Transmisión y Transformadores. Universidad Nacional de Colombia, Primera edición, 16 de abril del 2010. [4] Lozano Carlo; Castro, Ferley; Ramirez, Sindy, Unidades de Medición Fasorial PMU, Noviembre, 2011. [5] Araque G.J; Barba, R, Unidades de Medición Fasorial – PMU. Corporación Centro Nacional de Control de Energía CENACE. [6] Ohrn Marina; Sen, Amitava, Convergencia en la Sala de Control. Integración de Sistemas de Trasmisión Distribución y Gestión de Interrupciones, Revista ABB, 2005. [7] Cepeda J, Echeverría. D, Argüello. G, Tecnología de Medición Sincrofasorial en el Desarollo de una Red de Transmisión Inteligente. Corporación Centro Nacional de Control de Energía – CENACE, información confidencial. [8] Cárdenas Jorge; Menéndez, David. Extensión del uso de los Sincrofasores para 131 Facilitar la Integración de las EE.RR en el Sistema Eléctrico. GE imagination at Word, FUTURED, 24 de marzo del 2011. [9] P Kundur. Power System Stability and Control. 1st Edition, the EPRI Power System Engineering Series, McGraw-Hill Inc., New York NY, U.S.A., 1994. [10] Power System Dynamic Performance Committee, Identification of Electromechanical Modes in Power Systems, IEEE Task Force Report, Special Publication TP462, June 2012. [11] García Salvador. Implementación de un Medidor con Microcontrolador para la Detección de Oscilaciones de Baja Frecuencia. Escuela Superior de Ingeniería Mecánica y Eléctrica, Sección de Estudios de Posgrado e Investigaciones, México, Diciembre, 2011. [12] IEEE Power Engineering Society, “IEEE Standard for Synchrophasors for Power Systems”, IEEE Std. C37.118-2005, March 2006. [13] CENACE Análisis de Estabilidad de Pequeña Señal. Periodo Noviembre 2012-Abril 2013, informe final Noviembre 2012, información confidencial. [14] http://es.wikipedia.org/wiki/Matriz_de_ Toeplitz. Ángela Fernanda Quinaluiza Pillajo, Nació en Machachi, el 1 de marzo. Sus estudios secundarios los realizó en Institutito Técnico Superior Aloasí. Obteniendo el título de Bachiller Técnico Industrial con especialidad Electricidad. Sus estudios superiores los realizó en la Escuela Politécnica Nacional en la Carrera de Ingeniería Eléctrica Diego E. Echeverría Jurado nació en 1982 en la ciudad de Puyo, Ecuador. Recibió su título de Ingeniero Eléctrico de la Escuela Politécnica Nacional de Quito, en 2006. Desde 2008, ha estado realizando sus estudios de Doctorado en Ingeniería Eléctrica en el Instituto de Energía Eléctrica (IEE), de la Universidad Nacional de San Juan, Argentina como parte de una beca de 4 años financiada a través del Programa Regional del Servicio de Intercambio Alemán (DAAD, por sus siglas en alemán). Actualmente trabaja en el Centro Nacional de Control de Energía CENACE del Ecuador en la Dirección de Operación. Sus áreas de interés son: Estabilidad de Sistemas de Potencia en Tiempo Real, Sistemas de medición sincrofasoriales PMU’s y Control de Emergencia de Sistemas de Potencia. 132 Arquitecturas de red LAN para la automatización de subestaciones, basadas en la norma IEC 61850 (RSTP, PRP y HSR) A. F. Zurita† G. G. Rodríguez‡ † CELEC EP - TRANSELECTRIC ‡ CENACE Resumen— La norma IEC 61850 es la base en la implementación de subestaciones eléctrica automatizadas, permite que los equipos de protección, control y medición de diferentes fabricantes puedan trabajar en una misma red Ethernet. Dependiendo de la disponibilidad requerida para cada subestación, se adoptan esquemas y protocolos de protección en las redes Ethernet, los cuales incrementan la disponibilidad del sistema. Actualmente para esta protección se utiliza el protocolo RSTP (Rapid Spanning Tree Procotol), sin embargo para subestaciones principales, es necesario el empleo de nuevos esquemas de protección, que disminuyan e incluso eliminen el tiempo de indisponibilidad, en el caso de una falla en algún segmento de la red, esto se consigue a través de los protocolos PRP (Parallel Redundancy Protocol) y HSR (High-availability Seamless Redundancy. El presente documento incluye una introducción a la norma IEC 61850, el análisis de los protocolos de protección de las redes LAN empleados para la conexión de los IEDs y switches: RSTP, PRP y HSR, y su comparación, concluyendo finalmente con criterios de selección de uno u otro dependiendo del diseño de la subestación a ser construida. Palabras clave— IEC 61850, RSTP, PRP HSR, Ethernet. Abstract— The IEC 61850 standard has become the foundation for implementing automated electric substations, and it permit protection, control and measuring equipment from different manufacturers to work in the same Ethernet network. Depending on the availability required for each substation, different protection schemes and protocols are adopted for the Ethernet networks, which increase system availability. Currently is used the RTSP protocol (Rapid Square Spanning Tree Protocol), however for substations with more bay connection, it is necessary to use new protection schemes that diminish and even eliminate periods of unavailability. In the event of a failure in one segment of the network, the PRP Protocols (Parallel Redundancy Protocol) and the HSR (High-availability Seamless Redundancy) will come into play. This paper gives an introduction to the IEC 61850 Standard, and an analysis of the protection protocols for LAN networks used for the IED connections and switches: RSTP, PRP and HSR, and their respective comparisons, concluding selection criteria for one or the other depending on the substation design. Index Terms— IEC 61860, RSTP, PRP HSR, Ethernet. 1. INTRODUCCIÓN En la actualidad la mayoría de las subestaciones eléctricas son diseñadas mediante sistemas de automatización, que incluyen equipamiento electrónico inteligente (IEDs por sus siglas en inglés) y computadores, interconectados a través de switches y fibra óptica, de tal forma que la administración sea más fácil, y que la intervención del hombre en éstas subestaciones vaya disminuyendo. La norma IEC 61850 fue introducida en el año 2004 con el fin de ser el marco de referencia para lograr la interoperabilidad de los equipos que forman parte de los sistemas de automatización de las subestaciones eléctricas, y para lo cual adoptó estándares y tecnologías ampliamente utilizados a nivel mundial como TCP/IP y Ethernet, XML, aplicaciones cliente – servidor, nodos lógicos, etc. 133 En el caso de las redes LAN utilizadas para la conexión de dispositivos de un sistema de automatización la primera versión de la norma no estableció la arquitectura, ni los protocolos que permitan la protección de estas redes. Sin embargo, el desarrollo tecnológico incluyó al protocolo RSTP para este fin. 2.1.2 Switches La versión 2 de la norma publicada en el año 2010 introduce dos protocolos para la protección de redes LAN dentro de los sistemas de automatización, estos son el PRP y HSR. Cada uno de estos protocolos cuenta con sus particularidades que los hacen adecuados a un determinado tipo de subestación, dependiendo de la disponibilidad requerida. Considerando las excelentes características técnicas como son: gran ancho de banda, baja atenuación de la señal, integridad, inmunidad a interferencias electromagnéticas, alta seguridad y larga duración, en las redes Ethernet de una subestación automatizada se utiliza fibra óptica como el medio de transmisión de la información entre los equipos que la conforman. 2. LA NORMA IEC 61850 2.1.4 Equipo Primario La norma IEC 61850 está conformada por diez partes, las tres primeras definen ideas generales relacionadas con la norma. La parte 4 los requerimientos para la instalación de una subestación utilizando la norma IEC 61850. La parte 5 especifica los parámetros requeridos para la implementación física de la subestación. La parte 6 define el lenguaje XML para la configuración de los IEDs. La 7 detalla los conceptos lógicos y está dividida en cuatro subpartes. En la parte 8 se conceptualiza el mapeo interno de los objeto para la presentación en capas y para los enlaces de capa Ethernet. La parte 9 define el mapeo de los valores muestreados de medición para conexiones punto a punto Ethernet. La última parte detalla las instrucciones para las pruebas de conformidad [1]. La información que en una subestación convencional anteriormente era enviada a través de cable de cobre, uno por cada señal, hacia la sala de control de la subestación, ahora puede ser enviada por un par de hilos de fibra óptica. Para esto el equipamiento de patio debe contar con los conversores (internos o externos) que le permitan esta funcionalidad. 2.1. Componentes físicos de la red Ethernet 2.2. Arquitectura de red de la Subestación En términos generales la norma incluye como partes físicas de la red Ethernet: equipo primario, IEDs, switches, computadores y la fibra óptica como medio de transmisión de la información. La arquitectura de red una subestación está conformada por dos buses (swiches de conexión); los equipos de patio forman parte del bus de proceso, los equipos de subestación (IEDs) y computadores forman parte del bus de subestación. En la Fig. 1 se puede observar la arquitectura básica de una subestación: 2.1.1 DEI, Dispositivo Electrónico Inteligente Un IED (por sus siglas en inglés) es un equipo instalado en una subestación que recibe y envía datos de control o protecciones desde y hacia una fuente externa, es básicamente un computador, con lógicas digitales específicas, para la ejecución de procesos específicos [2]. Dispone de puertos de entradas y salidas, digitales y analógicas, puertos de comunicación Ethernet, USB, etc. Es además el dispositivo en el cual se almacenan los objetos lógicos. Un switch es un equipo que permite la comunicación entre los IEDs y demás dispositivos que forman parte de la red Ethernet, dentro de una subestación. 2.1.3 Fibra óptica 2.1.5 Computadores Para las funciones de monitoreo y configuración de la subestación, así como para el almacenamiento de eventos, se requieren computadores que también forman parte de la red Ethernet. Estos equipos pueden conectarse a la red Ethernet a través de cable de cobre en lugar de fibra óptica. Red WAN Computador de Configuración local Computador de monitoreo de la SE Router Gateway Bus de Subestación Equipo de Control A Equipo de Protección A Equipo de Proceso A Equipo de Proceso B Equipo de Control B Equipo de Protección B Scada Nivel de Subestación Nivel de Subestación Bus de proceso Equipo de Proceso Z Nivel de Proceso Figura 1: Arquitectura Básica de una subestación 134 En el esquema presentado se puede observar que la conexión de todos los equipos que conforman el sistema de automatización de la subestación se realiza a través de switches. De tal forma que la información requerida entre cada uno de los equipos puede ser transmitida sin la necesidad de conexión independiente por cada señal. Cada función depende de uno o varios equipos físicos, los cuales contienen los nodos lógicos. Los nodos lógicos se encuentran enlazados por conexiones lógicas. La Fig. 2 presenta la relación entre estos conceptos. También se distinguen tres niveles principales, así el nivel de proceso que corresponde al equipo primario instalado en el patio de la subestación, el nivel de bahía está relacionado con los IEDs ubicados generalmente en las casetas de patio, y el nivel de subestación correspondiente a los computadores ubicados en las salas de control. Las interacciones entre los equipos que forman parte del sistema de automatización principalmente se dividen en tres categorías: 1. Configuración y obtención de datos 2. Monitoreo y reporte de datos 3. Registro de eventos Figura 2. Estructura de intercambio de información Un dispositivo físico puede contener varios nodos lógicos, y cada nodo lógico puede contener a su vez varios Objetos de Datos. Cada Objeto de Datos está conformado por atributos de datos, y por los componentes de los atributos de datos. La Figura 3 muestra lo descrito anteriormente. IED Dispositivo Físico Para poder realizar estas interacciones la norma define una estructura de comunicación compleja que incluye cinco perfiles de comunicación, los cuales se detallan a continuación: 4. ACSI (Abstract Communication Service Interface): comunicación cliente – servidor. 5. GOOSE (Generic Object Oriented Substation Event): comunicación rápida dentro del bus de la subestación. 6. GSSE (Generic Substation Status Event): prove una vía para el intercambio del estatus del nivel de subestación. 7. SMV (Sampled Measured Value Multicast): provee una vía para el intercambio de información en el bus de proceso. 8. Señales de sincronismo 2.3. Estructura de Intercambio de Información Físicamente cada IED tiene una conexión hacia la red LAN de la subestación, lógicamente existe intercambio de información desde cada uno de los nodos lógicos que se encuentran en los IEDs. Un nodo lógico es la parte más pequeña de una función que intercambia información entre IEDs, definiéndose en él sus datos y atributos. Dispositivo Lógico Nodo Lógico Objeto de Datos Atributos Figura 3: Estructura de conformación de datos 3. REQUERIMIENTOS DE COMUNICACIONES Los sistemas de automatización de las subestaciones tienen dos características indispensables propias de sistemas de tiempo real: a) la sincronización de tiempo y b) la redundancia del sistema. Los requerimientos para la sincronización de tiempo quedan cubiertos con el uso del protocolo SNTP (simple network time protocol) con estrictas exigencias establecidas en el estándar IEEE 1588 [2]; y en relación a la redundancia del sistema la segunda edición de la norma IEC 61850 incluye dos protocolos que cumplen en su totalidad con los requerimientos y que son aplicables 135 a subestaciones de cualquier tamaño y topología: PRP (Parallel Redundancy Protocol) y HSR (High-availability Seamless Redundancy), estos protocolos proveen un tiempo de cero = no interrupción en la conmutación por falla de enlaces o dispositivos de la red. 3.1. Redundancia En una subestación, la comunicación de la red Ethernet industrial de datos y sus componentes es de vital importancia para la operación de todos los elementos, demandando requerimientos exigentes y distintos de tiempo para el nivel de supervisión del bus de la subestación y el bus de proceso, los mismos que definen los requerimientos de redundancia en la topología de red a implementar. El funcionamiento de la redundancia en toda la red debe ser chequeado periódicamente desde un nodo de operación de la red con frecuencias menores a 1 minuto al igual que los errores de configuración. 3.1.1 Métodos de Redundancia Redundancia Dinámica (standby o serial): Esta redundancia no participa de forma activa en el control, sino una conmutación lógica es quien decide insertar la redundancia y ponerla en funcionamiento. La Tabla 1 muestra las principales características de éste método. Redundancia Estática (activa o paralela): Esta redundancia participa de forma activa en el control, la red escoge el elemento operativo en que confiar. La Tabla 1 muestra las principales características de este método [3]. Tabla 1: Métodos de Redundancia 3.2. Topología de red de Alta Disponibilidad Parámetros como la confiabilidad y disponibilidad son determinantes en la definición de una red de alta redundancia y desempeño. La disponibilidad es la fracción de tiempo de operación o estado "activo" de un sistema, se expresa en porcentaje que representa el “ciclo de trabajo" o capacidad de operación del sistema, por ejemplo, 99,99%. La disponibilidad de un sistema se incrementa con la implementación de esquemas de redundancia, se consideran la inserción automática de redundancia ante fallas (sistemas tolerantes a fallas) y la reinserción automática después del restablecimiento, siendo el retardo de conmutación para el restablecimiento el factor más limitante en los sistemas tolerantes a fallas. 3.3. Requerimientos de Tiempo en una SE En una red redundante el parámetro más importante es el tiempo de restablecimiento requerido para normalizar la operación después de un evento de falla, en este sentido los protocolos PRP y HSR garantizan un tiempo “cero = no interrupción” para este restablecimiento El tiempo en el cual la subestación tolera una salida del sistema de automatización se denomina “tiempo de gracia”, para instalaciones eléctricas el tiempo de gracia es de 5 mseg, los tiempos de restablecimiento de la red deben ser menores a este tiempo de gracia. La Tabla 2 resume los tiempos de restablecimiento dados por el Comité Técnico IEC 57 (TC57) – grupo de trabajo 10 (WG10). Tabla 2: Requerimientos de Tiempos de Restablecimiento 136 estas dos redes están separadas a fin de asegurar independencia ante fallas pudiendo tener topologías diferentes y no solo de anillo, ambas redes operan en paralelo como se ejemplifica en la Fig. 4. 4. PROTOCOLOS DE COMUNICACIONES 4.1. RSTP (Rapid Spanning Tree Protocol) 4.1.1 Arquitectura El protocolo Rapid Spanning Tree se usa en topologías donde se cuenta con enlaces redundantes, y su funcionamiento principal es evitar los lazos dentro de la red. Un lazo dentro de una red Ethernet se presenta cuando se tiene una doble conexión entre dos switches, la presencia de un lazo dentro de la red hace que el tráfico no tenga salida y se vaya incrementando rápidamente hasta saturar y bloquear los switches y demás equipos que conforman la red, para evitar este fenómeno el protocolo RTP activa solo una de las dos conexiones. La topología en la que puede ser empleado RSTP es estrella o anillo. 4.1.2 Modo de Operación El Protocol Spanning Tree maneja varios conceptos que le permiten determinar el camino para enviar la información y el camino de respaldo. Cuando se cuenta con un par de conexiones la decisión es simple, sin embargo, cuando el número de switches y enlaces aumenta la decisión del camino principal y redundante requiere realizar cálculos y tomar decisiones las cuales se manejan a través del protocolo. El análisis que realizan los switches para la definición de los caminos de transmisión requiere de algunos segundos en el caso del protocolo STP, el protocolo RSTP presenta mejoras al STP de tal forma que el tiempo de definición o estabilización se reduzca. Cuando uno de los switches de la red falla, se requiere detectar la falla y reconfigurar los caminos de configuración. Esta función se realiza enviando mensajes a los equipos que conforman la red para detectar cual es el enlace con problemas y realiza la reconfiguración. El tiempo de establecimiento para RSTP puede estar en el orden de 5 ms por cada switch Ethernet que conforma la red, dependiendo del número de equipos con que cuente la red esta recuperación puede tomar varios segundos. El detalle de la operación del protocolo se encuentra en [4]. 4.2. PRP (Parallel Redundancy Protocol) 4.2.1 Arquitectura Figura 4: Arquitectura de Red Redundante PRP La red PRP se compone de nodos DANP (doubly attached node with PRP) y SAN (simple attached node); los nodos DANP se conectan a las dos redes LAN independientes operando de forma paralela por éstas, es decir que los equipos requieren de dos puertos Ethernet para el uso del protocolo PRP; en tanto que los nodos SAN (no-PRP) o nodos simples de conexión (ejemplo: ordenadores, impresoras, etc.) se conectan a una de las redes teniendo comunicación únicamente con los dispositivos DANP o SAN de esa misma red. En caso de requerirse redundancia para los nodos SAN se debe utilizar un equipo de adaptación denominado RedBox que gestiona los protocolos redundantes. La Fig. 5 muestra el esquema de operación de este protocolo. 4.2.2 Modo de Operación Una red PRP establece dos caminos activos independientes para la conexión entre dispositivos [5]. En una red PRP los nodos DANP usan los dos puertos para el envío simultáneo de las tramas Ethernet por ambas redes usando retardos de transmisión diferentes para cada una de las redes, e incluyendo la información necesaria para asegurar el adecuado tratamiento de las mismas (número de secuencia, identificadores de redundancia, etc.). En condiciones libres de errores, los nodos destino toman la primera trama recibida y descartan los duplicados, en caso de recibir una sola trama se determina la ocurrencia de una falla en una de las redes, manteniéndose la comunicación por la segunda red. Este protocolo establece un nivel de redundancia basado en una topología compuesta por dos redes de área local (LANs) independientes y paralelas; 137 no requiere de dos switches, sin embargo todos los nodos del anillo deben ser nodos de conmutación que dispongan de dos puertos integrando un elemento de conmutación preferentemente de hardware. Es posible establecer enlaces entre dos anillos HSR con el uso de elementos de conexión denominados QuadBoxes, estos permiten la conexión entre dos HSR sin un solo punto de falla, como muestra la Fig.6 Figura 5: Modo de Operación PRP El PRP garantiza tiempos de “cero = no interrupción” en el restablecimiento de comunicaciones de la red ante fallas y un chequeo continuo de la redundancia de la red que disminuye la ocurrencia de fallas, basándose en el uso de los nodos dobles PRP (DANP) conectados a ambas redes para garantizar el nivel de disponibilidad requerido. Los nodos chequean y detectan duplicaciones con secuencias numéricas que se introducen en las tramas después del paquete de información “payload”, esto permite una transparencia total de nodos PRP y NO PRP. El protocolo PRP puede ser ejecutado de forma completa vía software. La falla de nodos no está cubierta por el PRP, pero los nodos duplicados pueden ser conectados vía red PRP. EL PRP es implementado en los dispositivos terminales, por lo cual es posible utilizar switches de red convencionales que no requieren conocer de este protocolo. 4.3. HSR (High-availability Redundancy) Seamless Figura 6: Arquitectura red redundante HSR 4.3.1. Modo de Operación Para cada trama enviada, un nodo DANH envía dos tramas una sobre cada puerto, ambas tramas circulan en direcciones opuestas sobre el anillo y cada nodo reenvía las tramas que recibe desde uno de los puertos hacia el otro. Cuando el nodo originario recibe una trama enviada por él mismo la descarta para evitar lazos, es así que no es necesario un protocolo especial de anillo, como se muestra en la Fig. 7. 4.3.1 Arquitectura El protocolo HSR es producto del desarrollo de PRP, sin embargo las funciones de HSR principalmente son las de un protocolo que crea medios redundantes, mientras que PRP crea redundancia de la red. HSR a diferencia del PRP está básicamente diseñado para el uso de topologías de anillo, en ambos protocolos se utilizan dos puertos de red, pero HSR incorpora el nodo DANH (Doubly Attached Node for HSR) que conecta sus dos interfaces a una misma red conformando una topología de anillo como se muestra en la Fig. 6 El protocolo HSR aplica los principios de operación paralela del PRP sobre un anillo simple, tratando las dos direcciones de cada dispositivo como dos redes LAN virtuales, esto permite una reducción significativa en costos de hardware ya que 138 Leyenda Figura 7 Figura 7: Modo de Operación HSR Para detectar duplicaciones las tramas Ethernet incluyen una secuencia numérica incrementada por la fuente de cada trama enviada, contrariamente al PRP, la secuencia numérica se inserta en la cabecera y no después del paquete de información “payload”, así el elemento de conmutación puede reconocer la duplicación antes de recibir completamente una trama, de esta manera son posibles operaciones de “cut-through” o reenvío sin necesidad de recepción de una trama completa en tiempos menores a 5 useg por nodo. Al usar un anillo simple el tráfico de bus casi se duplica, pero el promedio de tiempo de propagación se reduce permitiendo al anillo soportar un número similar de dispositivos que un anillo redundante. Adicionalmente nodos simples (SAN) como laptops e impresoras solo pueden conectarse al anillo usando una caja de redundancia que les permite actuar como un elemento del anillo. En cuanto a tiempos de conmutación, HSR se comporta como PRP: enviando tramas desde ambos puertos de una conexión HSR, en el caso de ocurrir una falla una trama continuará siendo transmitida a través de cualquier camino disponible de la red, esto significa que la redundancia funciona con tiempo de conmutación cero y, a diferencia de PRP, no requiere dos redes paralelas. Se debe considerar que la transmisión duplicada de tramas por ambas direcciones implica que sólo el 50% del ancho de banda de la red está efectivamente disponible para el tráfico de datos. el protocolo PRP cuenta con el 100% del ancho de banda disponible en cada enlace a diferencia de los otros dos protocolos. 5.1. Ventajas RSTP: • RSTP utiliza una red simple para la conexión de nodos. • Tolera la falla de cualquier componente simple de red (con un tiempo relativamente corto de indisponibilidad de la red) • No depende de protocolos de capa superior • Esta altamente difundido en el mercado, existen varios fabricantes que utilizan este protocolo en sus equipos de red • Es un protocolo probado en subestaciones a nivel mundial • Implementación económica. 5.2. Desventajas RSTP: • Ante fallas en la red la reconfiguración puede tomar varios segundos; en casos extremos. • No cumple con los niveles de disponibilidad requeridos en las subestaciones, durante la reconfiguración por falla o inicio de equipos. • Tiene un número máximo de equipos que pueden formar parte de la red 5.3. Ventajas de PRP 5. COMPARACIÓN DE PROTOCOLOS RSTP, PRP Y HSR La elección del protocolo de protección utilizado en de la red Ethernet depende de varios factores entre los principales: la disponibilidad establecida para la subestación, el presupuesto, la escalabilidad a futuro, entre otras. En la Tabla 3 se presenta una comparación de varias características que deben ser analizadas para la elección de uno y otro protocolo de protección. De esta comparación se puede destacar que los protocolos HSR y PRP permiten contar con un mayor nivel de disponibilidad, y no presentan tiempo de recuperación ante la presencia de alguna falla en un enlace. La habilitación del protocolo PRP es la de mayor costo. Y el RSTP es el de más difusión en el mercado. El crecimiento de la red es más fácil de implementar cuando se utilizan protocolos PRP y HSR, así también el protocolo RSTP no requiere de una fuente de sincronismo, a diferencia de los otros dos protocolos. Por último se debe notar que 139 • PRP permite la conmutación sin interrupciones (tiempos cero) y sin pérdida de tramas; lo cual lo hace adecuado para la mayoría de sistemas de tiempo crítico. • Puede usarse en variedad de topologías de red: anillo, estrella, etc. • Cumple con todos los requisitos de automatización de subestaciones de acuerdo a la norma IEC 61850. • Tolera fallas de cualquier componente simple de red. • No depende de protocolos de capa superior. • Es compatible con RSTP • Permite el uso de nodos (SAN) que no están equipados para redundancia, que pueden operar en la misma red. • Puede usarse fuera de la plataforma de componentes de red: herramientas, controladores, switches y enlaces. • Soporta precisión para la sincronización de tiempo de acuerdo con la IEEE 1588. • Es un protocolo probado para subestaciones de alta tensión. • Es transparente para la aplicación. • PRP reduce la tasa de pérdidas durante su operación normal. • Usa métodos de chequeo periódico de nodos, que le permite identificar los nodos que participan y no en el protocolo Tabla 3: Comparación de protocolos 5.4. Desventajas de PRP • Duplicación de costos en la red • Los nodos simples (SAN) de una red LAN no pueden comunicarse directamente con nodos SAN de otra LAN. • El tamaño de trama debe ser limitado para prevenir que se conviertan en tramas más largas que las máximas establecidas en IEEE 802.3 5.5. Ventajas de HSR • HSR usa una red simple para la conexión de nodos. • HSR es un protocolo transparente adecuado para aplicaciones críticas, costos eficientes. • HSR permite la conmutación sin interrupciones con tiempos de conmutación cero y sin pérdida de tramas; lo cual lo hace adecuado para la mayoría de sistemas de tiempo crítico. • Cumple con todos los requisitos de automatización de subestaciones de acuerdo a la norma IEC 61850. • Tolera la falla de cualquier componente simple de red. • No depende de protocolos de capa superior. • Es compatible con RSTP y PRP • Permite el uso de nodos (SAN) que no están equipados para redundancia, que pueden operar en la misma red. • Soporta precisión para la sincronización de tiempo de acuerdo con la IEEE 1588. • Es un protocolo probado para subestaciones de alta tensión. • HSR chequea la presencia de nodos usando supervisión periódica de tramas que también identifican los nodos que participan y no en el protocolo 6. CONCLUSIONES Y RECOMENDACIONES La norma IEC 61850 demanda ampliar los conceptos eléctricos utilizados hasta ahora para la puesta en marcha de una subestación, integrando conceptos que en la actualidad se utilizan en gran medida y que están relacionados con las ramas de telecomunicaciones, redes e informática. Los protocolos PRP y HSR permiten la conmutación sin interrupción ante la falla de un elemento simple de la red, esto permite que la disponibilidad global de la subestación se incremente. La implementación del protocolo PRP requiere la habilitación de una red totalmente redundante, convirtiendo esta solución en una opción costosa, y resultando HSR más conveniente. La elección de uno u otro protocolo de protección depende de varios factores, entre estos la disponibilidad requerida para la subestación, el presupuesto, existencia de equipos que cumplan los protocolos, etc., no es necesario que todas las subestaciones manejen el mismo protocolo de protección. Los esquemas PRP y HSR representan un reto para la sincronización de tiempo debido a que los retardos sobre las dos redes redundantes son diferentes y demandan la mejora de la robustez y precisión del reloj del sistema. REFERENCIAS BIBILIGRÁFICAS 5.6. Desventajas de HSR • Solo soporta topología de red en anillo, y anillos de anillos. • Dispositivos doblemente conectados requieren un desarrollo inicial con costo (hardware) • Para la conexión de nodos simples, SAN, se debe usar un dispositivo de conexión adicional: “RedBoxes” 140 [1] Liang Y. & Campbell R. (2009), “Understanding and Simulating the IEC 61850 Standard”, Department of Computer Science University of Illinois at Urbana-Champaig, pp 1-5. [2] McDonald, J. “Substation automation. IED integration and availability of information”. (2003), Power and Energy Magazine, pp 22– 31. [3] Kirrmann H. (2012), “Highly Available Automation Networks Standard Redundancy Methods” ABB Switzerland Ltd, Corporate Research. [4] Oñate E. “Rapid Spanning Tree Protocol Shortest Path, extension a RSTP” Universidad Técnica Federico Santa María, pp. 1-6. [5] Kirrmann H. (2012), “Seamless Redundancy”, ABB Switzerland Ltd, Corporate Research, pp. 55-61. Ana Francisca Zurita Zaldumbide.- Nació en Quito, Ecuador en 1980. Recibió su título de Ingeniera en Electrónica y Telecomunicaciones de la Escuela Politécnica Nacional en el año 2004. Es egresada de la Maestría en Redes y Networking de la Universidad Católica de Quito, y su campo de investigación se encuentra relacionado con temas de telecomunicaciones para el sector eléctrico. Gioconda Guanacaury Rodríguez Pazmiño.- Nació en Quito, Ecuador en 1974. Recibió su título de Ingeniera en Telecomunicaciones del Instituto Superior Politécnico José Antonio Echeverría, de la ciudad de La Habana, Cuba en el año 1998, y su campo de investigación se encuentra relacionado con temas de telecomunicaciones para el sector eléctrico. 141 Operación Remota de la Distribución basada en la Supervisión y Control remotos de Reconectadores C. E. Landázuri Empresa Eléctrica Regional Centro Sur C. A. Resumen— Una de las tareas históricas de la Operación de los sistemas eléctricos de distribución ha sido garantizar la continuidad y calidad del suministro de energía eléctrica. La tendencia de los años recientes ha sido aprovisionar las redes de distribución con equipos de maniobra y protección “inteligentes” con funcionamiento autónomo pero aislado. Los Centros de Control, con sus componentes tales como los SCADAs, han sido otro pilar en la optimización de la Operación. Actualmente, con el apoyo de las nuevas tecnologías de la Informática y las Telecomunicaciones, el siguiente paso, casi obligatorio, es articular estas dos herramientas en una solo instrumento para la Operación de la Distribución. Esta integración puede no ser sencilla. Factores como la ubicación de los equipos de maniobra y protección, los sistemas de supervisión y control disponibles, el grado de avance de las telecomunicaciones, influyen en la adopción de la solución más apropiada. Es decir, la realidad de cada Sistema Eléctrico de Potencia condiciona fuertemente la adopción de la plataforma de control y automatización de dichas redes. La solución sugerida en el presente trabajo se enfoca como una guía general para la aplicación en la mayoría de realidades. El caso práctico de éxito de una empresa distribuidora del país confirma la premisa. Palabras claves— Operación, Distribución, SCADA, Reconectadores, Telecomunicaciones. Abstract— One of the historical operation tasks of electric power distribution systems has been to guarantee electric power supply quality and continuity. The trend in recent years has been to provide distribution networks with “smart” protection and switching equipment, which works in an automated and isolated manner. The Control Centres, with their components such as SCADA, have been another pillar of Operation Optimization. Currently, with the support of new Information and Telecommunications Technology, the new and almost compulsory step is to combine these tools into a single Distribution Operation instrument. Such integration might not be easy. Factors such as protection and switching equipment location, available control and supervision systems, and telecommunications development, all influence the adoption of the most appropriate solution. This means that the reality of each Electric Power System strongly influences the control and automation platform for such networks. The solution proposed in this paper acts as a guideline for application in the majority of current situations. The success story of one of the Ecuador’s distribution companies confirms this premise. Index Terms— Operation, Distribution, SCADA, Reclosers, Telecommunications 1. INTRODUCCIÓN Una de las preocupaciones permanentes de las empresas eléctricas de Distribución es la planificación e implantación de programas para la mejora continua de los índices de calidad del producto (FMIK y TTIK), y que esta mejora se vea reflejada en el cumplimiento de las expectativas tanto de los clientes como del órgano regulador. Con los crecientes avances de las áreas tecnológicas (especialmente de la Informática y las Telecomunicaciones), se ha desplegado un abanico extenso y variado de oportunidades de mejora de los procesos de distribución y comercialización de la energía eléctrica. Específicamente en el ámbito de la gestión y operación de las redes eléctricas existe un potencial enorme de evolución y hace falta solo un impulso para desbocar todo ese potencial. La introducción de la tecnología en la operación de los sistemas eléctricos de potencia puede ser ese impulso. Con este marco de referencia en mente, las empresas eléctricas de Distribución deben apostar por la introducción de mejoras tecnológicas en sus redes de distribución de media tensión y la implantación de sistemas para supervisión, control y automatización (centralizado o distribuido) de dichas redes. Estos 142 elementos permiten hacer más eficiente la operación de los sistemas eléctricos, reduciendo por un lado la cantidad de interrupciones del servicio, y por otro lado mejora los tiempos de restablecimiento de éste, además de la cantidad de información que aportan para el modelamiento y planificación de los sistemas eléctricos. Como se puede esperar, los caminos son diversos, pero en el tiempo la mayoría convergen en soluciones tipo SCADA (Supervisory Control and Data Acquisition), DMS (Distribution Management System), OMS (Outage Management System) y otros sistemas complementarios para la gestión y operación de las redes eléctricas. Dado el grado de madurez de estas plataformas, se han constituido en soluciones altamente probadas y aceptadas entre las empresas de distribución. Todo este conjunto de sistemas junto con el equipamiento inteligente de las redes eléctricas y redes de telecomunicaciones adecuadas nos llevan a la Automatización de la Distribución (DA – Distribution Automation). El próximo horizonte, no muy lejano, luce desafiantemente la consolidación de las Redes Inteligentes “Smart Grids”. Generalmente el primer paso es la implantación de un sistema SCADA. Este sistema colecta la información de campo, particularmente de subestaciones eléctricas, y la procesa de forma centralizada, usualmente en un Centro de Control, para que un operador pueda tomar decisiones operativas sobre el sistema eléctrico de potencia. Los otros sistemas, como DMS y OMS, se pueden ir agregando sobre la base constituida por el SCADA (a manera de un modelo de capas), para ir ensamblando una plataforma más completa y compleja. Indiscutiblemente, el camino más corto sería implantar toda la solución de una sola vez. Pero requiere que las empresas estén bien preparadas, tanto en infraestructura, equipamiento y talento humano. Lo recomendable es que exista el asesoramiento y acompañamiento de entidades o profesionales con mayor experticia. La plataforma SCADA debe soportarse sobre una arquitectura robusta de adquisición y control de información, conformada por dispositivos que están prácticamente en contacto directo con los elementos de campo que se pretende monitorear, y que históricamente han estado circunscritos dentro de las subestaciones eléctricas (transformadores de potencia, interruptores, seccionadores, etc.). El escenario del presente trabajo se enmarca dentro de esta arquitectura o plataforma que sustenta el SCADA, y pretende encontrar y plantear una solución efectiva para el manejo y la expansión de la operación remota de las redes de distribución de media tensión, mediante el telecontrol de reconectadores. 2. ALCANCE La presente investigación expone una guía fundamental y esquematiza una solución general para implantar un sistema para la operación remota de una red de distribución bajo el escenario de que ésta se encuentra elementalmente equipada con dispositivos “inteligentes” de protección y maniobra, como reconectadores. Como caso práctico de éxito se expondrá la experiencia de una de las empresas Distribuidoras del país en el telemando de reconectadores basado en las ideas explicadas en este documento. 3. REDES DE DISTRIBUCIÓN CON RECONECTADORES: ESCENARIO BASE Como estrategia para mejorar la confiabilidad de los sistemas eléctricos de media tensión y elevar su grado de protección ante fallas se ha hecho práctica común la instalación de equipos de protección con reconexión automática en las redes de distribución, conocidos comúnmente como reconectadores. Este es un dispositivo de control y protección capaz de detectar una sobrecorriente, interrumpirla y reconectar automáticamente para reenergizar la línea. Por lo tanto son equipos de flexibilización de la red, que permiten proteger circuitos aéreos de media tensión de forma que ante una falla (corto circuito, sobrecarga, etc.) no se vea afectada la integridad física de la red eléctrica. El procesamiento lógico o “inteligencia” de estos reconectadores yace generalmente en un elemento independiente al equipo de potencia, que procesa las funciones de control, protección y comunicación. Para el presente trabajo es de interés particular las funciones de comunicación, ya que son las que facultan al reconectador, mediante un “leguaje lógico”, a intercambiar información con otros sistemas. Esta circunstancia sugiere un escenario absolutamente ventajoso para extender las habilidades de operación centralizada de un Centro de Control a las redes equipadas con reconectadores. 143 4. ETAPAS DE INVESTIGACIÓN Procurando los mejores resultados del estudio, la investigación se esquematizó en las siguientes fases: • Análisis del entorno: Identificación de las necesidades y todos los elementos involucrados en el desarrollo de la investigación. • Consideraciones Técnicas: Evaluación de los criterios técnicos-teóricos a considerar para el diseño de la solución más óptima. • Solución y Aplicación Práctica: Diseño de la solución y exposición de un caso práctico de éxito. 4.1. Análisis del entorno Para el inicio del estudio se establecerán las condiciones elementales que una empresa distribuidora debe tener. Considerando los criterios de la sección (3), el análisis es abordado desde tres elementos fundamentales en la Operación basa en reconectadores: CENTRO DE CONTROL TRANSPORTE DE DATOS RECONECTADORES Figura 1: Elementos para operación de una red de distribución (equipada con reconectadores) Este esquema sintetiza los bloques funcionales para la operación de la media tensión a través de reconectadores. 4.1.1 El Centro de Control El Centro de Control es el conjunto de instalaciones (infraestructura, equipamiento, personal, etc.) donde se centraliza la operación y gestión de un sistema eléctrico. Una de las plataformas fundamentales para el funcionamiento de un Centro de Control es un sistema SCADA. Los sistemas SCADA permiten recolectar variables de campo y presentarlas a través de una Interface Humano-Máquina. Generalmente las empresas eléctricas utilizan su SCADA para supervisar las subestaciones eléctricas. Dado el alto costo de estos sistemas, invertir en un SCADA para operación exclusiva de reconectadores no es viable. Lo óptimo es aprovechar los recursos disponibles de los sistemas existentes (que generalmente están dimensionados para un amplio crecimiento), unificando además en una sola plataforma la operación de la subtransmisión y la distribución (al menos en la primera “capa” SCADA). Por estas razones, y para fines prácticos en nuestro estudio, se partirá de la premisa de la existencia de sistemas SCADA en los Centros de Control. Respecto de los protocolos de telecontrol, los SCADA manejan varios formatos de tramas, pero entre las más usadas están el IEC60870-5-101/104 y el DNP3. Estas tramas pueden ajustarse a diferentes tecnologías de transporte de datos. 4.1.2 Sistemas de Telecomunicaciones Automatización y Telecontrol para Una apropiada infraestructura de Telecomunicaciones juega un rol estratégico para el éxito de los esquemas de Automatización y Telecontrol de la Distribución. Así, la operación remota de reconectadores requiere de una adecuada red de telecomunicaciones para el transporte de datos desde el SCADA hacia los equipos en campo y viceversa. Las redes de telecomunicaciones usadas deben garantizar una alta disponibilidad mayor al 98%, excelentes tiempos de respuesta (latencia), seguridad, y buen ancho de banda. La tendencia es contar con redes IP para el transporte de los datos por su ubicuidad y su relativo bajo costo, sin embargo este tipo de redes puede presentar colisiones y congestión en momentos en los que se presentan avalancha de datos. Es aquí donde las redes de telecomunicaciones tienen el reto de ser lo suficientemente inteligentes para permitir la priorización de los datos importantes (por ejemplo datos de tiempo real) y retardar el envío de los datos menos importantes (por ejemplo datos no operativos como los diagramas de oscilografía). La elección de la tecnología adecuada es una tarea que depende de muchos factores, y en la mayoría de los casos siempre habrán varias opciones elegibles. Desde factores internos, como la economía de cada empresa eléctrica, sus objetivos institucionales, la experticia de sus técnicos, hasta externos como el grado de penetración de las empresas de telecomunicaciones, la cobertura y tecnología de las operadoras móviles, etc., aportan criterios válidos para la selección. Sería tema de otro estudio la elección adecuada, y en ningún caso se podría generalizar totalmente para una realidad nacional, de forma que nos limitaremos a exponer un caso práctico para una de las empresas Distribuidoras del país. 144 4.1.3 Reconectadores De acuerdo a los criterios de la sección (3), partiremos de la necesidad de tele operar una red de distribución de media tensión equipada principalmente con reconectadores. Sin embargo los principios de funcionamiento de la solución son igualmente válidos y aplicables para un sistema de distribución más complejo que tenga switches, bancos de condensadores, reguladores de tensión, indicadores de falla, equipos de medición, etc. Los reconectadores debe cumplir básicamente el requisito de poseer funciones de comunicación mediante algún protocolo interpretable y asimilable por el SCADA. Generalmente el elemento con la circuitería electrónica que maneja las funciones de control y protección del reconectador también maneja sus funciones de comunicación. Los protocolos que deben estar disponibles, para la mayoría de sistemas abiertos, son el IEC60870-5-101/104 o DNP3. En ciertos equipos ya se está empezando a implementar el protocolo IEC61850. Algunos fabricantes proporcionan una solución completa y compacta que incluye dispositivos de telecomunicaciones propietarios dedicados. Estas soluciones por lo general son muy específicas y no son compatibles con redes de telecomunicaciones que manejan estándares abiertos. Sin embargo, dada la confiablidad y nivel de integración que garantiza el fabricante, pueden ser aplicables para casos prácticos particulares, tales como pequeños esquemas de automatización no centralizados. En general, para una solución integral de telecontrol y automatización, se recomienda analizar exhaustivamente el sistema de telecomunicaciones a utilizar antes de solicitar que los reconectadores, u otros equipos, incluyan los dispositivos de telecomunicaciones. Se debe considerar además que los reconectadores desplegados sobre una red de distribución pueden ser de distintos fabricantes. 4.2. Consideraciones técnicas para el diseño de la solución Los sistemas SCADA utilizan protocolos de comunicación para intercambiar información con los equipos de campo y crear secuencias de automatización. Estos protocolos cumplen entonces la función de establecer un “lenguaje común” entre los dispositivos, que permita el envío de información exacta y unívocamente interpretable. Gran parte de la carga de procesamiento de los equipos informáticos de un SCADA está relacionada con la adquisición de datos. La adquisición se realiza mediante exploraciones o interrogaciones periódicas de todos los dispositivos (esclavos) conectados directamente al SCADA (maestro). Estas interrogaciones son realizadas mediante los protocolos de comunicación. En algunos casos, y dependiendo del protocolo, la información es adquirida mediante mensajes “espontáneos” (sin necesidad de una petición del SCADA) enviados por parte los dispositivos esclavos. Consideremos aquí dos factores críticos: • A mayor cantidad de dispositivos de campo conectados a un SCADA, mayor será el tiempo para completar un ciclo entero de interrogaciones, y mayor la carga de procesamiento de información. • El SCADA y el dispositivo de campo deben utilizar el mismo protocolo de comunicación para un intercambio efectivo de datos. Dependiendo de los recursos informáticos del SCADA, el primer factor puede no ser crítico. Sin embargo, desde el punto de vista de una arquitectura jerárquica, los dispositivos que interactúan directamente con las variables de campo (tales como los IEDs – Intelligent Electronic Devices) no deben estar integrados directamente a un SCADA. Por ejemplo, en el caso de subestaciones, los IEDs establecen comunicaciones verticales con un concentrador local (ubicado en la misma subestación) para que entonces éste reenvíe la información hacia el SCADA, con lo cual se establece una jerarquía SCADA – Concentrador - IED. En sistemas actuales basados en IEC61850 los IEDs también pueden ejecutar comunicaciones horizontales peer-to-peer, generalmente para ejecución de enclavamientos. Por otro lado, si el SCADA está limitado respecto de los tipos de protocolos que puede interpretar, se producirá un conflicto de “leguaje” entre éste y los dispositivos de campo si no manejan exactamente el mismo protocolo. Esta situación puede ser superada con el uso de un dispositivo “interprete” que traduzca de un protocolo a otro. 4.3. Diseño de la solución La operación remota de un sistema de media tensión equipado con reconectadores requiere esencialmente la integración de éstos equipos al sistema SCADA del Centro de Control. En función del análisis del entorno 145 realizado en la sección (4.1) y teniendo en cuenta las consideraciones técnico-teórico de la sección (4.2), se sintetizaron las siguientes directrices para el diseño de la solución del sistema: • Se asumirá la existencia de una plataforma SCADA en el Centro de Control, que se utilizará para el procesamiento (adquisición y control, base de datos, IHM) de la información de los reconectadores. • Para mantener un diseño general que sea aplicable a la mayoría de los entornos de adquisición y control, se introducirá un sistema intermedio (entre SCADA y reconectadores) para realizar la concentración de datos y la traducción de protocolos. Para referencia en adelante se dará la denominación de Gateway a este sistema. El Gateway garantizará la interoperabilidad entre los reconectadores y el sistema SCADA, independientemente del tipo o fabricante de reconectadores y de la plataforma SCADA. Además liberará al SCADA de la carga de interrogar y concentrar a decenas de dispositivos dispersos geográficamente. • El Gateway asumirá la responsabilidad de manejar las comunicaciones con los reconectadores, indistintamente de la tecnología de la red de telecomunicaciones utilizada. • El sistema de telecomunicaciones para el transporte de datos reconectadores – SCADA no puede ser definido de forma genérica dada la gran cantidad de opciones perfectamente apropiadas y la dependencia de un sinnúmero de factores particulares para cada realidad. Sin embargo, se recomienda en forma general procurará que la red de telecomunicaciones sea primordialmente de tecnología TCP/IP. • Los reconectadores deben estar preparados, o en su defecto adecuarse, para su interconexión a la red de telecomunicaciones utilizada. Sobre la base de estas directrices, la arquitectura general de un sistema para integración SCADA de reconectadores (u otros dispositivos) de una red de media tensión, debe ser como la que se ilustra en la Fig. 2. Figura 2: Arquitectura General de un Sistema para Telecontrol de Reconectadores La arquitectura plantea la comunicación entre el SCADA y los reconectadores a través de un dispositivo Gateway que actúa como maestro frente a los reconectadores (esclavos), y al mismo tiempo actúa como esclavo frente al SCADA (maestro). El Gateway interpreta el protocolo de comunicación usado por sus esclavos (reconectadores u otros dispositivos), tal como DNP3 o IEC60870-5-101/104, y luego “mapea” los mensajes al protocolo utilizado con el sistema SCADA, ejecutando de esta forma la traducción entre los protocolos. Además, al encargarse de las interrogaciones, el Gateway libera al SCADA de la responsabilidad de procesar uno por uno la información de los reconectadores. En su lugar, el SCADA interroga y procesa los datos de un solo elemento, en este caso el Gateway, que contiene la información de todos los reconectadores. Esta característica proporciona al Gateway la función de concentrador. El sistema es independiente de la red de telecomunicaciones utilizada entre los reconectadores y el Gateway, pudiendo ser microonda, fibra óptica, GSM/GPRS, etc., siempre que proporcione la información en formato TCP/IP. 4.4. Aplicación práctica: Operación a distancia de la red de media tensión de la Empresa Eléctrica Regional Centro Sur La Empresa Eléctrica Regional Centro Sur es una empresa de distribución y comercialización de energía eléctrica, cuya área de concesión cubre los territorios de las provincias del Azuay, Cañar y Morona Santiago. El sistema de media tensión de Centro Sur está conformado por alimentadores a 22 kV y 6,3 kV equipados con 17 reconectadores tripolares OVR de la marca ABB, y está en curso la instalación de 146 58 equipos tripolares, suministrado por la firma SIEMENS, y 10 equipos monopolares de la firma NOJA. Tabla 1 : Característica de reconectadores para Automatización Los tres tipos de reconectadores poseen el protocolo DNP3 para integración SCADA. 4.4.1 Alcance del proyecto Característica para automatización Mediante la aplicación de la arquitectura modelo propuesta en la sección (4.3), la Centro Sur logró implantar un esquema de operación remota de su red de media tensión mediante el tele control y supervisión de sus diferentes tipos de reconectadores. El sistema permite a los operadores del Centro de Control interactuar en tiempo real, a través de una Interfaz Humano-Máquina, con las principales variables de los reconectadores, permitiendo realizar la supervisión de esta información y el control a distancia del equipo. Controlador Interfaces de comunicación Este SCADA utiliza el protocolo de telecontrol IEC60870-5-101 encapsulado sobre TCP/IP para interrogación de la información hacia los equipos remotos. PCD Power ControlerDevice 3AD Siemens Argus 7SR224 Puerto posterior COM2a R232/ RS485/FO con DNP3 Puerto posterior COM3 RS232 con DNP3 Puerto frontal RS232 para telegestión Puerto posterior COM1 RS485 para telegestión Puerto Ethernet RJ45 con COM3 y COM2 encapsuladas 4.4.2 Centro de control El Centro de Control está ubicado en la ciudad de Cuenca, y está equipado con la solución SCADA Sherpa de la firma ELIOP (aunque está previsto en el 2014 realizar la renovación de este sistema). Originalmente el sistema supervisaba doce subestaciones eléctricas. OVR ABB Fuente AC No 110 VAC 400 W Fuente DC 12 VDC 10 W No disponible para equipos externos 4.4.4 Las Telecomunicaciones en Centro Sur La estructura de la red se está conformada por 196 nodos de telecomunicaciones basada en los siguientes elementos: • Backbone: Tecnología inalámbrica de microondas jerarquía PDH con equipamiento Siemens SRAL en las bandas de 8,2 – 8,5 GHz y 7,1 – 7,4 GHz. • Accesos o última milla: Tecnología inalámbrica de espectro ensanchado (spread spectrum) FHSS en la banda de 5800 MHz con equipos Alvarion y Ubiquiti. • Sistema de Gestión y administración de red: Sistema de gestión NetViewer para los elementos de red del backbone SRAL y el sistema Castle Rock para el resto de equipos de red. La administración se realiza de forma remota y centralizada. • Elementos de conectividad: La conectividad hacia los diferentes puntos terminales de red (agencias, oficinas, puntos de recaudación y subestaciones) utiliza el estándar IEEE 802.3 Ethernet a través de switches para accesos. 4.4.3 Reconectadores utilizados en el sistema de distribución El sistema de distribución de Centro Sur está equipado con reconectadores tripolares de las marcas ABB y SIEMENS, y monopolares marca NOJA. Todos los dispositivos están dotados de un gabinete de control que les habilita realizar las funciones de protección, control y comunicaciones. Desde el punto de vista de automatización, las características principales de los reconectadores instalados se listan en la Tabla 1. La capacidad de la red de transporte (backbone) es de 100Mpbs. Una de las circunstancias observables de 147 este sistema es que la red de acceso inalámbrica trabaja en las bandas no licenciadas 5,7 – 5,9 GHz, lo que la hace vulnerable a las interferencias, especialmente en las áreas urbanas donde existe gran concentración de sistemas difusores en las mismas frecuencias. Con esta consideración, será fundamental el continuo monitoreo, gestión y mantenimiento sobre los enlaces de última milla a fin de detectar, anticipar y corregir de forma oportuna los inconvenientes derivados del uso de estas bandas, y otros que puedan presentarse. Superada la observación anterior, las características de desempeño y cobertura de la red de telecomunicaciones propia de Centro Sur se consideran apropiadas para proveer del servicio de transporte de datos para telecontrol de los reconectadores. Por lo tanto la utilización de esta infraestructura para el transporte de datos entre el SCADA y los reconectadores tiene la prioridad sobre otras opciones, procurando limitar el uso de estas últimas a casos puntuales. 4.4.5 Características del Sistema de Integración La solución, de acuerdo a las recomendaciones de la sección (4.3), consiste en la implementación de un “Gateway” para recolectar la información de los reconectadores utilizando el protocolo DNP3 LAN/ WAN y enviar esta información al SCADA a través del protocolo IEC-60870-5-101 (encapsulado en TCP/IP) de acuerdo al perfil del SCADA Sherpa de ELIOP. El Gateway seleccionado es una aplicación de software llamado “SCADA Data Gateway” (SDG) de la marca Triangle Microworks ® instalado sobre un servidor HP Proliant DL360G7. La arquitectura específica seleccionada se ilustra en la Fig. 3. El Gateway se incorpora directamente a la red LAN del SCADA a través de dos interfaces Ethernet 10/100/1000baseT en configuración redundante. Los protocolos de telecontrol, tanto DNP3 LAN/WAN como IEC60870-5-101 encapsulado, son transmitidos simultáneamente a través de la interfaz activa hacia la LAN del SCADA. En el caso de los mensajes DNP3, estos son enviados por el router SCADA hacia la red de telecomunicaciones, y transportados finalmente a cada uno de los reconectadores. Las tramas IEC608705-101 se quedan dentro de la LAN, siendo su destino final los servidores del SCADA Cuenca1 y Cuenca2, según la Fig. 3. Figura 3: Arquitectura del sistema de integración de reconectadores de Centrosur La Fig. 4 muestra un reconectador telecontrolado instalado sobre un alimentador urbano de 22 kV. El equipo está asociado a un sistema de telecomunicaciones instalado en el mismo sitio del reconectador y le permite la conexión al SCADA del Centro de Control. Esta disposición de equipamiento es replicada para otros reconectadores montados en la red de media tensión. El equipo de reconexión está montado en el poste del lado izquierdo de la imagen de la Fig. 4, el sistema de telecomunicaciones basado en una radio OFDM está desplegado en el poste de la derecha de la imagen. Figura 4: Reconectador SIEMENS Av. Cacique Chaparra supervisado y controlado desde el Centro de Control La Fig. 5 muestra los diagramas unifilares de operación desde el SCADA para un arreglo de dos reconectadores en un alimentador (un equipo para protección y otro para transferencia). El diagrama sinóptico permite al operador maniobrar el equipo desde el Centro de Control, ejecutando la apertura/ cierre del equipo, cambiar su grupo de ajustes, bloquear funciones de protección/recierre/etc., y supervisar las principales medidas eléctricas (corrientes, tensiones, potencias) del segmento o punto de la línea de distribución donde se ubica el reconectador. 148 Mejora en la calidad del servicio: Las funciones de operación remota inciden principalmente en el tiempo total de interrupción TTIK, por lo que se estima obtener mejoras en este indicador. Reducción de los costos de operación (personal y equipo) y destinación de los recursos a otras tareas. 6. CONCLUSIONES Y RECOMENDACIONES Figura 5: Diagrama unifilar SCADA para operación de reconectadores de un alimentador de la Centrosur 5. BENEFICIOS DE LA OPERACIÓN REMOTA DE RECONECTADORES DE LA RED DE MEDIA TENSIÓN La capacidad de tele controlar y supervisar los reconectadores deriva en varios beneficios inmediatos, principalmente operativos, y otros de mediano plazo, que se estima se evidencien en los índices de calidad.: y del monitoreo más preciso del estado del Sistema Eléctrico de Potencia. Entre los más representativos tenemos: Reducción del tiempo de identificación de falla, de decenas de minutos o incluso horas a unos pocos minutos: La información en tiempo real permite al operador conocer el estado del sistema de distribución inmediatamente después de una falla, en contraposición con el tiempo considerable que requeriría obtener los reportes de las cuadrillas luego de recorrer un alimentador. Reducción del tiempo de reposición del servicio: Los tiempos de ejecución de maniobras pueden ser reducidos mediante el control a distancia del reconectador, realizándose apenas se ha despejado o reparado una falla, evitando el tiempo de movilización de una cuadrilla hacia la ubicación del reconectador, que en alimentadores rurales tomaría varias decenas de minutos o incluso horas. Asistencia y seguimiento a los procedimientos de mantenimiento en campo: Con la información centralizada en el Centro de Control, es posible guiar más efectivamente a las cuadrillas de mantenimiento y dar apoyo en las maniobras remotamente. Agilitar la toma de acciones para garantizar la continuidad del servicio: El conocimiento del panorama completo del sistema de distribución desde el SCADA (con los reconectadores integrados al mismo) permite la toma de decisiones más adecuadas y oportunas ante contingencias del Sistema Eléctrico de Potencia. La socialización, principalmente entre el personal operativo y de ingeniería de las áreas de mantenimiento y operación de los sistemas de distribución, de las funciones de operación remota de reconectadores implantadas en el Centro de Control permite garantizar la operación segura de los equipos y del sistema, sin comprometer la integridad física del personal en campo. Es fundamental incorporar a los procedimientos de operación del sistema eléctrico aquellas tareas automatizadas, en este caso el telecontrol de reconectadores, para extraer el mayor beneficio que éstas nos pueden proporcionar en la coordinación y eficiencia operativa, garantizando finalmente la continuidad del servicio eléctrico. La supervisión y control remotos es una de las características funcionales de la Automatización de la Distribución (DA) más requeridas por las empresas eléctricas, y la primera en implementarse la mayoría de las veces. El telecontrol de los reconectadores por lo tanto permite dar un primer paso en el mundo de DA, y también una primera experiencia para mirar casa adentro de las empresas distribuidoras y visualizar la realidad y nivel de preparación, en aspectos de talento humano y tecnológicos, para incursionar definitivamente en las tendencias mundiales de DA y Smart Grids. Es importante reforzar los sistemas tecnológicos informáticos y de telecomunicaciones, que son la columna vertebral por medio de la cual se transportan, procesan y almacenan los datos operacionales y no operacionales, y de estas depende en gran medida el éxito del desarrollo de las tecnologías de DA y Smart Grids. En el caso práctico de la Centro Sur y con 35 equipos integrados hasta el momento, se observa que las condiciones de performance y cobertura de la red de telecomunicaciones propia de esta empresa son bastante estables para el telecontrol, por lo que la búsqueda de otras soluciones para el transporte de datos entre el SCADA y los reconectadores no es 149 prioridad, utilizándose la infraestructura propia para la totalidad de los casos hasta el momento. Sin embargo es crítico contar con un recurso humano dedicado a la atención de esta red de datos para mantener el nivel de confiabilidad exigido por las aplicaciones del sistema eléctrico. El grado de flexibilidad de la ubicación de un reconectador es determinante para su integración al Centro de Control. Para facilitar el despliegue de una red de acceso de datos es indispensable que el estudio de ubicación óptima establezca una tolerancia o rango de movilidad en la ubicación, de forma que la posición definitiva sea ajustada, dentro de esa tolerancia, en función de la factibilidad de los enlaces de telecomunicaciones y del montaje del equipo. La inspección en sitio es, por lo tanto, una fase crítica en la decisión final y en el levantamiento de información para el diseño del montaje, diseño de la red de acceso, etc. 7. REFERENCIAS BIBLIOGRÁFICA [1] Northcote-Green, James & Wilson, Robert. (2007). “Control and Automation of Electrical Power Distribution Systems”. Boca Raton FL: CRC Press. [2] Patiño, Raúl. (2007). “Telecontrol y telegestión de reconectadores con tecnología GSM/GPRS”. III CONGRESO CIER DE LA ENERGÍA CONCIER, Medellín, Colombia. [3] Departamento de Operaciones, Dirección de Telecomunicaciones – CENTROSUR. (2012). “Diagramas de Red FODETEL I y II”. Cuenca, Ecuador. [4] Triangle Microworks, Inc. (2012). “SCADA Data Gateway Implementation Guide, Software Release Version 2.54”. Raleigh, North Carolina. [5] ABB. (2004). “PCD Power Control Device Instruction Book IB38-737-5 Issue E”. [6] SIEMENS. (2009). “Data Communications 7SR224 Recloser Controller”. [7] Departamento de Supervisión y Operación – CENTROSUR (2012 - 2013). “Archivos y registros proyecto Integración de Reconectadores al SCADA”. Cuenca, Ecuador. Carlos Emilio Landázuri Paredes.- Nació en Quito, Ecuador en 1979. Recibió su título de Ingeniero en Electrónica de la Universidad Politécnica Salesiana en 2004. Actualmente se encuentra en proceso de obtención de su título de Master en Telemática en la Universidad de Cuenca. Su campo de investigación está relacionado con el área de control y telecomunicaciones para sistemas SCADA, automatización de subestaciones eléctricas y automatización de los sistemas eléctricos de distribución. 150 Diseño e Implementación del Sistema de Control de un Inversor Multinivel de Fuentes Independientes, por medio de Modulación Vectorial Espacial J. Galarza F. Quizhpi Universidad Politécnica Salesiana Resumen— El presente trabajo muestra los pasos seguidos, para la implementación del sistema de control de un inversor multinivel. El estudio parte de la topología de fuentes independientes utilizada, luego se describe la implementación del algoritmo de consideraciones geométricas usado y los sistemas de monitoreo y protección en una placa basada en FPGA. Por último se presentan los resultados de la puesta en funcionamiento del sistema completo, con las mediciones de la tensión y la frecuencia obtenidas a la salida del inversor, y el THD en la corriente y tensión en la carga, el cual fue alrededor del 7% con una carga resistiva, e inferior al 3% en un motor asíncrono. Palabras clave— Inversor, FPGA, modulación, vector, espacial, algoritmo, VHDL. Abstract— This study shows the steps to be taken to implement a multilevel inverter control system. The study is based on the topology of independent sources used, and later describes implementation of the algorithm with geometric considerations used, and the monitoring and protection systems in an FPGA-based board. In the end, it presents results for start-up of the entire system, with the voltage and frequency measurements obtained at the inverter output, and the THD in the current and load voltage, which was around 7% of the resistive load, and less than 3% in an induction motor. Index Terms— Inverter, FPGA, modulation, vector, space, algorithm, VHDL. 1. INTRODUCCIÓN Desde la introducción de los convertidores CD/ CA ya hace varios años, su estudio y utilización se han venido incrementando debido a sus diversas aplicaciones, que van desde variadores de frecuencia para motores eléctricos hasta para sistema de corrección del factor de potencia y/o para la compensación de corrientes reactivas, etc. Estos conversores CD/CA también llamados inversores, tienen la función de convertir una tensión fija de corriente continua a una tensión simétrica de corriente alterna con frecuencia y tensión deseada. La frecuencia y tensión pueden ser ajustables según se desee en ciertos casos. La tensión simétrica alterna se consigue al conectar la carga a la fuente de alimentación en un sentido u otro, por medio de interruptores de potencia. El estudio de los inversores en los últimos años se ha venido incrementando, debido al adelanto en los interruptores de potencia, ya que los mismo se han vuelto más rápidos y con una mayor potencia, con lo que se han creado algoritmos de control más robusto y rápidos. Todo esto acompañado con el abaratamiento de los FPGA y DSP, han permitido estudiar de una manera más detallada el comportamiento de algoritmos de control, en especial los algoritmos de modulación vectorial espacial. Un caso de estos es el algoritmo de consideraciones geométricas descrito en [1], el mismo que se implementó en un sistema FPGA, y se probó sobre un motor asíncrono, verificando su comportamiento. 2. TOPOLOGÍA INDEPENDIENTES DE FUENTES Existen varias topologías para inversores multinivel, que van desde la utilización de una solo fuente, hasta las que requieren varias fuentes para generar los distintos niveles de tensión necesarios para la salida del inversor. Estas topologías se pueden ver en [1]. En este trabajo se utilizó la topología de fuentes independientes de 4 niveles, que se basa en la unión de 1 puente trifásico y 3 puentes monofásicos, como se muestra en la Fig. 1. 151 R1=R2=R3 ( 2) VR1=2⁄3 V ( 3) VR2=-1⁄3 V ( 4) VR3=-1⁄3 V ( 5) Figura 1: Convertidor Trifásico de Puentes en Cascada de 4 Niveles Todos los demás estados y niveles de tensión, se pueden ver en el apéndice A de [2], de los cuales, la mayor parte son redundantes. Por este motivo se eligió los estados que requieran un menor número de conmutaciones cuando exista un cambio de estado, los mismos se pueden ver en la tabla 3.3 de [2]. 2.1. Estados del inversor de fuentes independientes de 4 niveles 3. IMPLEMENTACIÓN DEL ALGORITMO DE CONTROL Los estados del convertidor, hacen referencia al nivel de tensión en cada fase del mismo, cuando está conectada una carga y teniendo una combinación determinada de ramas conectadas a +VDC o –VDC, según el esquema de la Fig. 1. El algoritmo de control se describió en lenguaje VHDL, sobre un módulo de desarrollo “MicroBlaze Development Kit Spartan-3E 1600E” manufacturado por Digilent [3]. Este sistema está basado en un FPGA “Spartan 3E”, el mismo que brinda la posibilidad de realizar cambios en el algoritmo de control, sin la necesidad de cambios físicos en el circuito. En total existen 2n posibles combinaciones del convertidor, en donde n es el número de ramas, que en este trabajo son 9, por lo tanto el número de combinaciones es: 2n=29=512 posibles combinaciones ( 1) Al cerrar los distintos interruptores, es decir conectar cada rama a +VDC o –VDC, y conectar una carga equilibrada en estrella en los terminales del inversor, como se muestra en la Fig. 2, se puede calcular las tensiones en la carga, lo que equivale a un estado del inversor multinivel. Además al ser un sistema basado en FPGA, la implementación del algoritmo se puede realizar en pequeños bloques, los mismos que se pueden ejecutar en paralelo o en serie según las necesidades. Para el circuito de potencia se utilizaron los módulos de IGBTs del laboratorio de Electrónica de Potencia de la Universidad Politécnica Salesiana, sus características y/o partes constitutivas, al igual que su conexión está detallados en la sección 3.3 de [2]. 3.1. Algoritmo de consideraciones geométricas El algoritmo de consideraciones geométricas es un método de modulación del tipo vectorial espacial. Los métodos de modulación vectorial espacial permiten generar una tensión y frecuencia de salida establecida con una gran precisión y poca carga armónica a la salida. Figura 2: Estado 100000000 del convertidor de 4 niveles En el caso del estado 100000000 de la Fig. 2, los valores de tensión son: Los métodos de modulación vectorial espacial se basan en la consideración, que la terna [a, b, c] de voltajes en un instante de tiempo, se pueden transformar a un sistema d-q, de un vector de magnitud proporcional al voltaje de la terna y de frecuencia de giro igual a la frecuencia de la terna, a esto se le conoce como transformada de Clark [4]. Con el vector y los estados del inversor también transformados al plano d-q, se calculan las conmutaciones necesarias 152 del sistema para aproximar la onda de salida a la onda senoidal requerida. El algoritmo de consideraciones geométricas descrito en [1] y [2], busca generar una secuencia de conmutación de las ramas, en cada tiempo de muestreo Tm, estableciendo cuales son los estados a utilizar y los tiempos en los cuales permanecen activos. Las ventajas de este algoritmo son: (1) se puede implementar para cualquier número de niveles y su carga computacional es la misma, (2) no se necesita el cálculo de funciones trigonométricas y (3) no necesita almacenar datos en memorias o tablas para su funcionamiento. Este algoritmo de consideraciones geométricas, se realiza en 7 pasos los mismos que son descritos a continuación y con más detalle en [2]: 3.1.1 Normalizar el vector de referencia En este paso se transforma la terna [a, b, c] al plano d-q, y al mismo tiempo el vector obtenido se normaliza para que el algoritmo sea independiente de la tensión de las fuentes de alimentación. 3.1.2 Achatar el espacio vectorial Se multiplica el componente q del vector de referencia por 1/√3, con lo que se elimine la necesidad del cálculo de ángulos y funciones trigonométricas, y se facilita el cálculo de los tiempos y los estados de conmutación del algoritmo. 3.1.3 Elección de la zona en la que se encuentra el vector de referencia Divide el espacio vectorial en 3 zonas y establece en cual se encuentra el vector de referencia. 3.1.4 Cálculo de las coordenadas del vértice de un sector triangular Divide las 3 zonas en estados y establece una terna para cada estado, al mismo tiempo divide el espacio vectorial en sectores en forma de cuadriláteros. Luego establece cual es la terna del estado más cercano al vector de referencia. Figura 3: Diagrama del sistema de control del inversor 3.1.5 Orientación del sector triangular Divide cada cuadrilátero en dos triángulos y calcula en cuál de los 2 triángulos se encuentra el vector de referencia. 3.1.6 Cálculo de los tres vectores más cercanos al vector de referencia Establece cuales son los estados del triángulo en el que se encuentra el vector de referencia. 3.1.7 Cálculo de los tiempos de conmutación de los vectores activos Por simples adiciones y sustracciones entre los componentes del vector de referencia y los estados del triángulo en el que se encuentra el vector de referencia se calcula los tiempos y estados de conmutación del inversor. En la tabla 2.1 de [2] se muestra un resumen de los estados de conmutación y los tiempos en las distintas regiones en el plano complejo d-q. 3.2. Diagrama de bloques del algoritmo de control Como se ve en la Fig. 3 el sistema de control tiene como entradas el voltaje RMS de fase y la frecuencia que se desea obtener a la salida del inversor, estos valores son establecidos por el operario del sistema por medio de pulsantes. 153 Los parámetros son guardados en un bloque de Almacenamiento y selección de parámetros del inversor, otra entrada de este bloque es la tensión de las fuentes para establecer el voltaje máximo que puede entregar el inversor sin saturarse. A partir de las corrientes de la carga acopladas por sensores de efecto Hall y cuantificadas por ADC’s de 12 bits manejados por el bloque de Censado de las corrientes en la carga, y el voltaje de las fuentes de tensión cuantificados por otros ADC’s de 12 bits en configuración diferencial y adquiridos por el bloque de Censado de la tensión de las fuentes, se establece que no existe sobre-corriente en la carga o una bajada de tensión drástica en las fuentes en el bloque del Sistema de protección del inversor, si es así se da una señal de control afirmativa, caso contrario una señal negativa y una señal de error la salida de mensaje de error. Los parámetros del inversor almacenados en el bloque de Almacenamiento y selección de parámetros del inversor y el voltaje de las fuentes de tensión adquiridos por el bloque de Censado de la tensión de las fuentes son visualizados por medio del bloque de Visualización de los parámetros del inversor, y si existe un mensaje de error se visualiza el mismo. A partir de la frecuencia almacenada se calcula el vector de referencia u* en el bloque del Generador del vector de referencia. A este bloque se le proporciono algoritmos de corrección de errores, permitiendo conseguir un inversor con un error en frecuencia calculado de 0,00004% a 60Hz, insignificante en comparación al ±0,004% de error del reloj montado en la placa del FPGA, el mismo que es necesario para el funcionamiento del algoritmo sobre el FPGA y que influye en la misma cantidad a la frecuencia obtenida a la salida. Luego el vector u*, conjuntamente con el voltaje de las fuentes de tensión adquirido por el bloque de Censado de la tensión de las fuentes, entran al bloque de Normalización y achatamiento del vector de referencia, en donde se realiza el paso 1 y paso 2 del algoritmo de consideraciones geométricas descrito en la sección 2.1.3 de [2], en un tiempo dado, siempre y cuando la señal de control sea afirmativa, caso contrario no se calcula el siguiente vector de referencia. El vector normalizado y achatado entra al bloque de Cálculo de los estados y tiempos de conmutación en donde se realizan los pasos 3, 4, 5, 6 y 7 del algoritmo de consideraciones geométricas descrito en la sección 2.1.3 de [2], en donde se calculan los tiempos y estados de conmutación. Los tiempos y estados de conmutación calculados en el bloque Cálculo de los estados y tiempos de conmutación ingresan al bloque de Conmutación de los estados en un tiempo de muestreo Tm, en donde a partir de los tiempos y estados de conmutación se encienden los interruptores de potencia del inversor que entregan voltaje a la carga, si es que la señal de control es afirmativa, caso contrario los interruptores se apagan y a la carga le llega cero voltios. Una descripción más detallada del diagrama de bloques y los bloques que lo componen se encuentra en la sección 2.2 de [2]. 4. RESULTADOS Para pruebas de funcionamiento del algoritmo, se cargó la descripción hecha en VHDL sobre la placa basada en FPGA y para el circuito de potencia se utilizó 4 fuentes independientes y puentes formados con IGBT's. Las pruebas se realizaron con 3 tipos de cargas. Los valores de tensión se midieron con un osciloscopio de 20Ms/s y la corriente con sensores de efecto Hall acoplados al mismo osciloscopio. Los resultados de las pruebas se muestran a continuación. 4.1. Prueba con carga resistiva Las características de la prueba fueron: • Tensión de las fuentes de alimentación: 38,56v. • Carga resistiva en estrella: 312Ω • Voltaje fase-neutro deseado a la salida: 14,36Vrms. • Frecuencia de salida: 60Hz. En la Fig. 4 se muestra la tensión fase neutro de 2 de las fases del inversor, en donde se pueden ver que se están utilizando 3 de los niveles del inversor, y en la Fig. 5 la medida de la frecuencia que está alrededor de 60,61Hz, que no es exactamente la frecuencia de salida del inversor, porque es la medición entre 2 puntos muestreados por el osciloscopio. 154 También se calcula el RMS de la corriente por medio de Matlab que es de 45,68mA, que es bastante parecido al valor calculado en el osciloscopio, como se muestra en la Fig. 7. Este valor de corriente coincide aproximadamente con el valor calculado por medio de la ley de Ohm. (6) Figura 4: Tensiones fase neutro medidas en 2 de las fases Con los valores de tensión de fase, se calcula el valor RMS por medio de Matlab, dando un resultado de tensión de 15,86V, este es un valor diferente al que se estableció en la tensión deseada a la salida, pero este error se debe principalmente a la velocidad de adquisición del osciloscopio y a la calidad de los ADC utilizados para la medición de la tensión de las fuentes, los mismos que no son de una gama alta. Figura 7: Corriente en una de las fases con una carga R 4.2. Pruebas con carga resistiva inductiva en serie. Para esta prueba se eligieron los siguientes parámetros: • Carga R-L en estrella: R=300Ω y L=0,8H • Tensión de las fuentes de alimentación: 38,56V. • Voltaje de salida deseado: 42Vrms. • Frecuencia: 60Hz. Figura 5: Frecuencia de salida con una carga resistiva de 312Ω En la Fig. 6 se muestra el espectro de la onda de tensión, calculada por medio de LabVIEW, en donde la onda fundamental está a 60Hz y se encuentra alrededor de los 13V, también se pueden ver que existen componentes armónicas, las mismas que están por debajo de 0,25V. Con esto se calcula el THD que en el voltaje y la corriente es de alrededor de 7,52%. Figura 8: Frecuencia y tensión fase neutro en la onda de tensión de salida con carga RL El valor RMS calculado en Matlab fue de 39,07V y el de THD calculado mediante LabVIEW es de 4,77%. Figura 6 : Espectro de la onda de tensión con una carga de 312Ω 155 • Voltaje fase-neutro, de salida: 46,96v. • Frecuencia de salida del inversor: 60Hz. • Motor de 4 polos conectado en estrella. En la Fig. 13 se muestra la tensión fase neutro en el motor y en la Fig. 14 se muestra su tensión línea- línea del inversor. Figura 9: Espectro de la onda de tensión con una carga RL En la Fig. 11 se muestra la onda de corriente en una de las fases que es de 121mA, según lo calculado por el osciloscopio, y por cálculo de Matlab es de 120,61mA, en cambio el nivel de THD es de tan solo 1,62%. Figura 13: Tensión fase neutro del motor a 60Hz Figura 10: Espectro de la onda de corriente con una carga RL Figura 14: Tensión línea- línea del motor a 60Hz El valor RMS de la tensión de fase es de 46,2V según lo mostrado en el osciloscopio y el de línea es de 79,7V; que es aproximadamente igual a la transformación de tensión de línea a fase 46,2V.√3=80V≈79,7V Figura 11: Corriente de fase con una carga RL ( 7) El THD de la tensión de fase es igual a 3,29% y de 3,06% en la de línea, según lo calculado por medio de LabVIEW. En la Fig. 15 en cambio se muestra la corriente que circula por el motor, el valor rms es de 293mA, y su THD es de 2,82%. Figura 12: Tensión de fase y corriente de fase con carga RL 4.3. Prueba de un motor asíncrono a 60Hz. Los parámetros del motor fueron: • Voltaje de alimentación: 38,6v. Figura 15: Corriente del motor a 60Hz 156 El método de modulación vectorial espacial, según lo investigado y puesto en funcionamiento fue la mejor opción a la hora implementar un sistema de control para un inversor multinivel por su bajo THD a la salida del inversor y facilidad de ajuste de tensión y frecuencia a la salida. Figura 16: Espectro de la onda de corriente, con el motor a 60Hz Para comprobar el resultado de la frecuencia, se mide la velocidad del motor que fue de 1776rpm y se calcula la frecuencia que debe entregar el inversor para producir esta velocidad. El algoritmo de consideraciones geométricas implementado fue muy eficiente a la hora de elegirlo como método de modulación, ya que el mismo no necesito el cálculo de funciones trigonométricas o la necesidad de iteraciones para el cálculo de los tiempos y estados, lo que simplifico en gran medida la descripción del algoritmo de control en el FPGA. (8) (9) La implementación del algoritmo de control en un sistema basado en FPGA, fue de gran ayuda porque al ser un sistema que funciona en paralelo, el sistema de control se pudo dividir y describir en partes, y que cada una funcione en paralelo. Por tanto cada parte dedica todos los recursos asignados para cumplir con su propósito. La frecuencia dada por el cálculo es de 59,2Hz, pero al ser un motor asíncrono esta no es la frecuencia real del campo magnético o frecuencia síncrona, por tanto se puede establecer que la frecuencia obtenida si esta alrededor de 60Hz. Con la implementación de algoritmos de corrección de errores se consiguió un sistema de control muy preciso en frecuencia ya que su error de alrededor del 0,00004% a 60Hz, es despreciable en comparación al error del reloj de la placa que es de 0,004%. En la Fig. 17 se muestra la tensión de fase y la corriente que se midieron en el motor al ser conectado al inversor. El THD, cuando se utilizó 3 niveles fue de alrededor del 7%, aun alto para las normativas vigentes, pero cuando se utiliza todos los niveles el THD fue menor al 3% en tensión y corriente que es un valor aceptable, según las normativas. Cuando el algoritmo se probó con un motor asíncrono, su THD fue de 2,82% y 2,3%, para tensión y corriente respectivamente, lo que nos indica que no se necesita un filtro pasivo para la eliminación de armónicos, lo que se vio en el espectro de frecuencias calculado y en sí en el funcionamiento del motor ya que el mismo no tuvo un funcionamiento anormal, como vibración o recalentamiento. Figura 17: Tensión de fase y corriente del motor a 60Hz 5. CONCLUSIONES Y RECOMENDACIONES El uso de la topología de fuentes independientes fue de gran utilidad a la hora de generar del sistema de potencia, porque esta topología no necesita un control estricto de la tensión de las fuentes. También esta topología al tener niveles redundantes, se pudo elegir los que menos conmutaciones necesiten entre cambios de estado. Por otro lado esta topología tiene la desventaja que se necesitan fuentes independientes, que en este caso fueron 4, que para ciertas aplicaciones pueden resultar muy costosas, pero a la final, el algoritmo implementado solo necesita cambios mínimos en el bloque de conmutación, para ser utilizado con otras topologías. También la tensión obtenida a la salida del inversor es muy parecida a la deseada, con un error de alrededor del 2%. Una mayor precisión se puede obtener utilizando componentes de mayor precisión como los ADC, o aumentado la frecuencia de muestreo para la activación y desactivación de los interruptores de potencia. El sistema de protección, que fue implementado tiene una velocidad de respuesta muy rápida de apenas 16µs desde que se detecta el error, lo que lo hace bueno para un sistema que manejan motores. 157 REFERENCIAS BIBLIOGRÁFICAS [1] Martín M. (2003). “Nuevas técnicas de modulación vectorial para convertidores electrónicos de potencia multinivel”. Tesis de Doctorado. Universidad de Sevilla, ISBN 8468972371, Sevilla, España. Disponible (online) en: http://fondosdigitales.us.es/media/thesis/214/ DT248.pdf [2] Galarza J. (2012). “Diseño e implementación del sistema de control de un inversor multinivel de fuentes independientes, por medio de modulación vectorial espacial”. Tesis de Pregrado. Universidad Politécnica Salesiana, Cuenca, Ecuador. Disponible (online) en: Flavio Alfredo Quizhpi Palomeque.Nació en Cuenca-Ecuador, en 1969. Recibió el Título de Ingeniero Electrónico en la Universidad Politécnica Salesiana en el 2003, Licenciado en Ciencias de la Educación en la Universidad Politécnica Salesiana en el 1999, Especialista en Educación Superior en la Universidad del Azuay en el 2002. Actualmente cursando el programa Doctoral en Ingeniería Eléctrica en la Universidad Simón Bolívar de Venezuela. Dedicado al área de investigación de los Sistemas Eléctricos de Potencia, Confiabilidad, FACTs e Inversores Multinivel. http://dspace.ups.edu.ec/ bitstream/123456789/4438/1/UPS-CT002631. pdf [3] Xilinx. (2007). “MicroBlaze Development Kit Spartan-3E 1600E Edition User Guide”. Manual de Usuario v1.1. [4] González F. (2004). “Entendiendo la Transformación de Park”. Venezuela. Disponible (online) en: http://www.fglongatt.org/Reportes/RPT200401.pdf Juan Carlos Galarza Galarza.- Nació en el cantón de Chordeleg, Ecuador, el 16 de Septiembre de 1988. Recibió el título de Ingeniero Electrónico en la Universidad Politécnica Salesiana en el 2013, Tecnólogo Electrónico en la Universidad Politécnica Salesiana en el 2010. Actualmente estudia Ingeniería Mecánica en la Universidad Politécnica Salesiana. Le interesa sistemas mecatrónicos, mecánicos, sistemas SCADA y sistemas de control numérico computarizado, electrónica de potencia . 158 Estudio de Coordinación de Protecciones por Métodos Computacionales Aplicados a una Subestación C. Palacios Centro Nacional de Control de Energía, CENACE Resumen— El presente trabajo propone la utilización de herramientas computacionales para realizar estudios de flujo de potencia, análisis de cortocircuito así como analizar y mejorar el sistema de protección de una subestación y sus alimentadores. Además se expone la ventaja de utilizar un dispositivo electrónico inteligente (IED) para mejorar la confiabilidad de la red y cómo una herramienta computacional se complementa para ajustar y coordinar las protecciones. El estudio de flujo de potencia es necesario para el ajuste de los elementos de protección y el análisis de cortocircuito sirve para realizar la coordinación de los mismos. on the experience of engineers in the electricity distribution field and in the pertinent analysis of the system’s mathematical equations Index Terms— Power Flow, Short-Circuit Analysis, Protective Devices Coordination, Intelligent Electronic Device (IED). 1. INTRODUCCIÓN La coordinación de protecciones se define como el proceso para determinar los ajustes de los dispositivos de protección en una subestación eléctrica, de esta coordinación dependerá el buen o mal funcionamiento del sistema. [1] Este trabajo puede servir de guía al momento de realizar un estudio de coordinaciones de protecciones para una subestación con características específicas; ya que se utilizan suposiciones prácticas y teóricas basadas en la experiencia de ingenieros del área de distribución eléctrica y en el análisis pertinente de las ecuaciones matemáticas del sistema. La utilización de Métodos Computacionales para el análisis de la coordinación de las protecciones si bien en un principio fue aplicado a una subestación específica, puede ser utilizada para otras subestaciones del país con características similares. Palabras claves— Flujo de potencia, análisis de cortocircuito, coordinación de protecciones, dispositivo electrónico inteligente, IED. • Tener un transformador de potencia trifásico reductor con refrigeración tipo ONAN/ONAF y conexión Δ / Ү. • El patio de los alimentadores debe tener configuración de Barra Principal y Barra de Transferencia. • Alimentadores de tipo radial. • Sistema de puesta a tierra de tipo mallado. Abstract— This work proposes using computational tools to perform power flow studies and short-circuit analyses, as well as for analysing and improving the protection system of a substation and its feeders. It also presents the advantage of using an intelligent electronic device (IED) to improve network reliability and to adjust and coordinate protections as a complementary computational tool. The power flow study is necessary for adjusting certain protection elements and the short-circuit analysis is used to coordinate them. This work might be used as a guide when performing a study of protective devices coordination for a substation with specific characteristics, as it uses practical and theoretical assumptions based Las características de la subestación en estudio tienen que ser las siguientes: 2. ESTUDIO DEL FLUJO DE POTENCIA El flujo de potencia del sistema se utiliza para analizar gráficamente condiciones operativas y resultados. Los criterios que deben ser considerados cuando se realiza un estudio de flujo de potencia son: Flexibilidad Operacional, Nivel de Confiabilidad, Niveles de Sobrecarga y una Regulación de Voltaje del más o menos 2,5% ante cualquier contingencia operativa. [2] 159 El estudio de flujo de potencia fue realizado para condición de máxima demanda y mínima demanda; para lo que se necesita datos de voltaje, capacidad nominal e impedancia del transformador de potencia así como de los conductores de los alimentadores. Este estudio es necesario para realizar el ajuste de los dispositivos de protección. Para el análisis de ambos casos se utilizó el programa POWER WORLD versión 14, los datos del sistema que se ingresen deben estar en por unidad [p.u.], para ello debemos referir las impedancias de las líneas y transformadores a una misma base, por ejemplo una base de 100 MVA. El análisis del flujo de potencia muestra lo siguiente: • • • • • Voltaje en barras con magnitud y ángulo. Consumo de las alimentadoras. Factor de potencia. Requerimientos de potencia Reactiva. Ajustes de TAPS de los Transformadores. 4. AJUSTES Y COORDINACIÓN El estudio de flujo de potencia y el análisis de cortocircuito son la base para los ajustes y coordinación de cualquier sistema de protección. Para realizar la coordinación se utilizó el programa CYMTCC 4.5R13 donde se ingresaron los datos de los dispositivos de protección utilizados y de los elementos presentes en la subestación de distribución, ya que la base de datos del programa es extensa y contiene información de varios fabricantes. Esta herramienta computacional es muy útil porque nos permitió corregir los diagramas de protección, cambiar la secuencia de operación y realizar análisis de fallas. Además, presenta en una sola gráfica tiempo vs. corriente las curvas de operación de los dispositivos de protección y de los elementos a proteger como: • Curvas de arranque de motores. • Curvas de daño térmico de cables y conductores. • Curvas de resistencia, puntos de corrientes de arranque y térmicos de transformadores. 3. ANÁLISIS DE CIRCUITO Se realiza análisis de Cortocircuito para seleccionar y determinar la coordinación de los equipos de protección, los cuales son establecidos considerando el sistema en condiciones de falla. Para este análisis debe considerarse condiciones anormales de operación que podrían causar fenómenos indeseables como flujos de corrientes que puedan dañar equipos, caídas de voltaje y creación de condiciones peligrosas para la seguridad del personal. [3] Para el análisis de las corrientes de Cortocircuito, en las barras de la subestación, se utilizó el programa POWER WORLD versión 14, con similares consideraciones utilizadas en el estudio de flujo de potencia. Conociendo la característica de aterrizamiento de la subestación en estudio, el análisis de cortocircuito se lo puede realizar para las siguientes fallas: • • • • Falla trifásica a tierra. Falla de fase a tierra. Falla de fase a fase. Falla de dos fases a tierra. Para el cálculo de las corrientes de falla en los alimentadores pueden utilizarse las ecuaciones de corriente de fase a tierra y de corriente de fase a fase [3], ya que estas dos son la máxima y mínima corriente en un sistema de distribución. Otra ventaja que presenta el programa CYMTCC es que puede ser instalado como un aplicativo dentro del simulador CYMDIST, programa utilizado para simular flujos de potencia en la mayoría de las empresas eléctricas de distribución del país, con esto el usuario puede diseñar esquemas de coordinación y efectuar análisis que realiza el CIMDIST, todo en una única plataforma. [4] A continuación se va a hablar de los dispositivos de protección usados por las empresas eléctricas. Un dispositivo de protección para el transformador de potencia es un relé digital que contenga como función principal la protección diferencial. Uno comúnmente usado es el relé digital TPU-2000R de marca ABB, este está orientado a la protección de transformadores trifásicos de transmisión y distribución de energía, también sirve de protección de respaldo de sobrecorriente para fallas externas. El TPU-2000R tiene restricción armónica, e impide la operación con irrupción o flujo magnetizante y sobreexcitación. [5] Las funciones de este relé y las más usadas en la protección de una subestación eléctrica de distribución son: • Protección diferencial • Protección de sobrecorriente de tiempo inverso • Protección de sobrecorriente instantánea • Protección de desbalance 160 Otros dispositivos de protección presentes en una subestación de distribución para protección de los alimentadores son los reconectadores y el relé de frecuencia, este último es usado para desconexión de carga por baja frecuencia en el sistema nacional interconectado. Tabla 2:Clasificación de transformadores de corriente usados para medición MEDICIÓN Fuera de las subestaciones de distribución para protección de ramales o bancos de capacitores se usan normalmente fusibles. En ocasiones se puede utilizar Intellirupters [6] para seccionamiento de la troncal o para protección de alguna carga importante o sensible en alguno de los alimentadores. Un detalle que influye en este análisis es la selección de los transformadores de corriente, en [7] se recomienda que los transformadores de corriente (TC) debe ser elegido de tal forma que la corriente en su secundario se aproxime a 5 A para la máxima corriente de carga y menor a 100 A para la máxima corriente de falla, con el fin de evitar que se produzca una diferencia de potencial muy grande que lo sature. En [8] se definen los rangos de selección para los transformadores de corriente cuando se los utiliza para protección y/o medición, a continuación se muestra en las Tablas 1 y 2 los rangos de transformadores de acuerdo a: d 2500/1 A 15 VA 5P 20 d 500/5 A 20 VA CL 0,5 F S3 4.1.1 Protección de porcentaje diferencial para el transformador (87T) Para realizar el ajuste es necesario determinar: 1) El desfase del transformador de potencia entre los lados de alto y bajo voltaje. 2) Las corrientes nominales del transformador de potencia para los lados de alto y bajo voltaje. 3)Las corrientes nominales referidas al secundario del transformador de corriente previamente seleccionado. 4) La corriente de restricción (IR) usada en el relé luego de la compensación interna, esta última es dada por el fabricante. PROTECCIÓN c c Para que los datos de ajustes de los dispositivos de protección que se ingresan al programa CYMTCC 4.5R13 sean los apropiados, es necesario considerar los siguientes criterios. Tabla 1:Clasificación de transformadores de corriente usados para protección b b 4.1. Ajustes a: Su razón de transformación. b: Su potencia de precisión. c: Su clase de precisión. d: Características dependientes de su saturación. a a La condición de operación del relé debe ser: Iop>K*IR (1) Donde K es un coeficiente que evita que la protección diferencial opere incorrectamente cuando no hay falla interna. [9] La selección de la pendiente de esta protección depende del análisis de los errores en los instrumentos de medición, desfases de ángulos, porcentaje de desajuste M que se halla en (2) y de operaciones del 161 transformador de potencia por ejemplo arranque, cambios de TAPs o funcionamiento en vacío. La pendiente representa la suma de todos estos porcentajes. En [9] se recomienda que en relés diferenciales para protección de transformadores un buen porcentaje de error debe estar entre 20% y 60%, para proveer un amplio margen de seguridad. Fórmula para calcular el desajuste por errores [9]: (2) Donde: Ih e Il: son valores de corriente nominal referida a los secundarios de los transformadores de corriente para el lado de alto y bajo voltaje respectivamente. Th y Tl: son la relación de transformación de los transformadores de corriente para los lados de alto y bajo voltaje respectivamente. 4.1.2 Protección de sobrecorriente de tiempo inverso para los alimentadores (51P) La protección de sobrecorriente de tiempo inverso opera cuando la corriente que mide el relé supera el umbral de ajuste de disparo con un tiempo de retardo, dependiendo de la magnitud de la corriente. 4.1.4 Protección de sobrecorriente de tiempo inverso para los alimentadores (51N) Esta protección se la puede ajustar entre el 20% y el 40% de la corriente nominal del transformador de potencia [10]; sin embargo en subestaciones de distribución los niveles de desbalance esperados son altos por pérdida de carga debido a despeje de fallas en ramales, por lo que se recomienda que este ajuste debe ser entre 35% y 40%. 4.1.5 Protección de sobrecorriente de secuencia negativa para los alimentadores (46) En subestaciones de distribución la protección de sobrecorriente de secuencia negativa es usada como alarma por una posible condición de falla de línea a línea, donde Ia = Ib e Ic = 0 y la corriente de secuencia negativa es igual al 58% de Ia. [5] Ia, Ib e Ic son corrientes de línea. Esta protección tiene un ajuste menor al de la función 51, ya que para condiciones normales de carga balanceada las componentes de secuencia negativa en este caso son cero. 4.1.6 Protección de baja frecuencia para los alimentadores (81) Para el ajuste de la corriente de operación del relé se utiliza la máxima corriente de carga referida al secundario del transformador de corriente respectivo, y multiplicado por un factor que impida la incorrecta operación por una posible condición de sobrecarga. [9] El CENACE implementa esquemas de alivio de carga por baja frecuencia en cumplimiento de lo establecido en la Regulación No. CONELEC 006/00 “Procedimientos de Despacho y Operación” y debe ser implementado en el ajuste del relé de protección de baja frecuencia por las Empresas Distribuidoras del país. El último tiene vigencia para el período estacional lluvioso de Octubre 2013 a Marzo 2014 y se presenta a continuación [11]: 4.1.3 Protección de sobrecorriente instantáneo para los alimentadores (50P) Tabla 3: Esquema de alivio de carga por baja frecuencia del CENACE. La protección de sobrecorriente instantánea opera de forma inmediata abriendo el interruptor principal del transformador cuando se supera el valor de ajuste de disparo en cualquiera de las fases. El ajuste de esta protección se la realiza en base a la máxima corriente de falla referida al secundario del transformador de corriente respectivo, y es un múltiplo de la corriente de operación de la protección de sobrecorriente de tiempo inverso 51P. [9] 162 Porcentajes de Desconexión de Carga Paso Frecuencia (Hz) Tiempos de actuación (ciclos) Desconexión de carga (%) Desconexión acumulada de carga (%) 1 59,4 12 6% 6% 2 59,2 12 6% 12% 3 59,1 12 6% 18% 4 59,0 12 6% 24% 5 58,8 12 6% 30% 6 58,6 12 7% 37% 7 58,5 12 8% 45% La implementación del tiempo de actuación debe considerar la temporización del relé más el tiempo de apertura del interruptor principal. • La corriente nominal del fusible debe ser igual o mayor que la máxima corriente de carga, incluyendo sobrecargas y armónico sostenidos, en el punto de ubicación del fusible. • El valor nominal de interrupción simétrico debe ser igual o mayor que la máxima corriente de falla calculada del lado de la carga del fusible. 4.1.7 Ajuste de reconectadores para protección de los alimentadores En una línea aérea de distribución sólo un 10% de las fallas son de carácter permanente, por tal motivo es necesario el uso de reconectadores ya que estos tienen la característica de volver a conectarse de modo automático si la falla es temporal y permiten aislar los cuatro circuitos de salida de la subestación; además sirven de protección de respaldo para fallas en ramales. [12] Además debe considerarse otros factores que afectan el tiempo de fusión de los fusibles como son [12]: • Las corrientes generadas por conexión de carga incrementan la temperatura de los fusibles y disminuyen su tiempo de fusión. • Temperaturas ambiente mayores a 30 °C en la ubicación del fusible reducen el tiempo de fusión y temperaturas ambiente menores a 20 °C pueden incrementar el tiempo de fusión de los fusibles. • Las corrientes de fallas menores de corta duración pueden fundir parcialmente al fusible provocando una reducción significativa del tiempo de fusión de estos. El ajuste de la mínima corriente de operación del reconectador debe ser igual o mayor que la máxima corriente de carga del alimentador. Sin embargo, para realizar el ajuste se debe analizar posibles transferencias de carga entre alimentadores, así como, que la mínima corriente de falla puede ocurrir al final de la línea y que el reconectador debe censar e interrumpir la falla. En la selección de los reconectadores algunos factores que deben considerarse son [12]: • El voltaje nominal del reconectador debe ser igual o mayor al voltaje del sistema. • La capacidad nominal de interrupción del reconectador debe ser igual o mayor que la máxima corriente de falla. • El reconectador debe coordinar con otros dispositivos de protección tanto para el lado de la fuente como del lado de la carga. 4.2. Selección de Fusibles Los fusibles son usados, en los ramales de los alimentadores, para protección de los transformadores de distribución y bancos de capacitores. 4.2.1 Fusibles para protección de transformadores de distribución La selección de un fusible para protección de carga depende de tres componentes que son [12]: Existen tablas dadas por los fabricantes y normas que ayudan en la selección de fusibles para la protección de los transformadores de distribución, estos varían de acuerdo a sus capacidades nominales y del tipo de carga que alimentan. [13] 4.2.2 Fusibles para protección de bancos de capacitores Los fusibles para protección de los bancos de capacitores, los cuales se encuentran ubicados en varios puntos de los alimentadores, son escogidos según los criterios establecidos por EEI-NEMA basados en las curvas de ruptura del tanque. [12] 4.3. Coordinación Para comenzar se debe diferenciar las zonas a proteger y establecer los criterios de coordinación, a continuación se muestra un ejemplo del diagrama unifilar de una subestación de características antes definidas. • El voltaje nominal del fusible debe ser igual o mayor que el voltaje de fase del sistema, además debe ser considerado que el nivel básico de aislamiento sea el adecuado. 163 Si las curvas están muy cercanas puede que el reconectador dispare sin que el fusible haya despejado la falla. Tabla 4: Factores K usados para desplazar la curva rápida de operación del reconectador en el tiempo. Figura 1: Zonas de Protección Para realizar la coordinación en el programa CYMTCC debe seguirse el siguiente orden y los criterios expuestos a continuación. La coordinación se la realiza desde la carga hacia la fuente, en este caso la fuente es el transformador de poder en la subestación de distribución. Una vez seleccionados los fusibles para protección de ramales, estos deben coordinar con los reconectadores que se encuentran a la salida de la subestación para cada alimentador; esto es, la zona 3 debe coordinar con la zona 2. Los fusibles tienen dos curvas características de operación de mínimo tiempo de fusión y de máximo tiempo de fusión; los reconectadores tienen varias curvas de operación las cuales se difieren en los tiempos de actuación. Las reglas que deben ser consideradas para la coordinación de estos elementos son [12]: 1) La curva de mínimo tiempo de fusión debe ser mayor que el tiempo de despeje de la curva rápida de operación del reconectador multiplicada por un determinado factor para la máxima corriente de falla en el punto de ubicación del fusible. Este factor permite que exista mayor tiempo de operación entre las dos curvas con el fin de evitar que el fusible se fatigue o se dañe y le da tiempo para que este se enfríe. Además este factor depende del tiempo de reconexión y la secuencia de operación del reconectador. En la Tabla 4 se presentan estos factores. 2) La curva de máximo tiempo de fusión no debe superar el tiempo de operación de la curva lenta del reconectador para la mínima corriente de falla porque la idea es que el fusible se queme despejando la falla antes que el reconectador opere (de la orden de interrumpir la corriente). Una operación rápida Dos operaciones rápidas Tiempo del reconectador (ciclos) Promedio Máximo Promedio Máximo 25 - 30 1,3 1,2 2 1,8 60 1,3 1,2 1,5 1,35 90 1,3 1,2 1,5 1,35 120 1,3 1,2 1,5 1,35 Para el caso de que se deba coordinar un intellirupter con un reconectador, se lo realiza como que fuese otro reconectador ya que sus características de operación son similares; esto es, el intellirupter debe operar y despejar la falla antes que el reconectador actué y desconecte toda la carga del alimentador. Se debe tener precaución al escoger el tiempo de operación, ya que como son de diferente marca podrían operar simultáneamente. El siguiente paso es coordinar los reconectadores con el relé de protección del transformador de potencia, zona 2 con zona 1. El principio de coordinación es que la suma de todas las operaciones del reconectador debe ser más rápida que la curva de operación del relé. Para la máxima corriente de falla en la ubicación del reconectador, la curva de operación del relé referida al lado de la carga del transformador, debe ser mayor que el tiempo promedio de despeje de falla de la curva lenta de operación del reconectador, en un intervalo de coordinación de 0,2 a 0,25 segundos. [14] El relé y los reconectadores deben coordinar para la mínima y máxima corrientes de falla, y verificar que no exista problema alguno con la corriente de magnetización del transformador. Para protección de todos los cables y conductores hay que tener presente que sus curvas de daño estén por encima de las curvas de operación de los diferentes elementos de protección. 5. DISPOSITIVO ELECTRÓNICO INTELIGENTE (IED) Los ajustes y coordinación expuestos en el presente artículo aseguran que los elementos del sistema serán protegidos. Sin embargo, cuando 164 ocurren fallas produciendo apagones, las empresas eléctricas en ocasiones no detectan dichos apagones hasta recibir reclamos de los consumidores, y para determinar las zonas afectadas de la red es necesario un desplazamiento físico del personal de la empresa. Un avance tecnológico para mejorar el sistema de protección y la confiablidad de la red es utilizar un dispositivo electrónico inteligente (IED), lo que permitirá a las empresas eléctricas conocer lo que ocurre con la operación de las subestaciones en tiempo real, además se podrá detectar fácilmente la ocurrencia de fallas, limitando la duración de los apagones y evitando posibles disparos innecesarios en la subestación; características que no poseen los relés convencionales como el TPU-2000R. Una opción que se presenta para protección diferencial de transformadores de potencia es el relé SEL-487E que cumple con la norma IEEE C37.118 de medición sincrofasorial para ángulos de fase, corrientes y voltajes. Este relé tiene la posibilidad de ser programado y de guardar seis diferentes configuraciones de ajustes, por ejemplo para una condición de operación con sobrecarga, transferencias de carga por mantenimiento de una subestación, por variaciones de carga debido a cambio de estaciones de clima o por una condición emergente de operación. El relé SEL-487 tiene algunas funciones similares a las del relé TPU-2000R, sin embargo presenta protecciones adicionales como [12]: • Protección para sobre o baja frecuencia. • Protección para sobrecalentamiento transformador. • Regulación de voltaje – frecuencia. Los dispositivos electrónicos inteligentes como el SEL-487E mejoran el sistema de protección reduciendo falsos disparos y proporcionando una advertencia temprana de inestabilidad potencial de la red, ya que permiten conocer lo que ocurre en tiempo real. El relé SEL-487E puede ser modificado de forma remota desde un solo cuarto de control, permitiendo tener comunicadas todas las subestaciones que tengan este relé, con lo cual se enmarca dentro de las “Redes Inteligentes”. Cuando se utilizan relés convencionales dentro de una subestación de distribución, se recomienda realizar mantenimientos preventivos de todos los dispositivos de protección a fin de evitar errores de medición, falsos disparos, entre otros. del El programa CYMTCC puede ser utilizado para configurar el relé con seis diferentes ajustes y secuencias de operación, ya que este programa permite modificar los parámetros en línea. La programación del relé se la realiza en forma local o remota de tal manera que se tiene un dispositivo inteligente. 6. CONCLUSIONES Y RECOMENDACIONES La protección de los elementos de un sistema de distribución está asegurada, si los criterios de ajustes y coordinación expuestos en este artículo son utilizados. La utilización de la herramienta computacional CYMTCC 4.5R13 presenta ventajas para coordinación de protecciones ya que permite corregir los diagramas de protección, cambiar la secuencia de operación, realizar análisis de fallas y simulaciones con valores reales de la red. 165 REFERENCIAS BIBLIOGRÁFICAS [1] Stanley H. Horowitz, (2008). “Power System Relaying”, Jhon Wiley & Sons Ltd, 3ra Edición, West Sussex, Inglaterra. [2] Jhon J. Grainger y William D. Stevenson Jr., (1996). “Análisis de Sistemas de Potencia”, Editorial McGRAW-HILL/ Interamericana de México, 1ra Edición en Español, México. [3] Layana José, (2010). “Análisis de Falla en los Sistemas Eléctricos de Potencia”, Editorial Centro y Difusión de Publicaciones ESPOL, 1ra Edición, Guayaquil, Ecuador. [4] Cooper Power Systems, (2011). "CYMTCC, Coordinación de los dispositivos de protección". CYME International, disponible (online) en: http://www.cyme.com/es/software/cymtcc/ B1100-09002S-CYMTCC.pdf [5] ABB, (2002). "Unidad de Protección para distribución ABB 2000r. Manual de instrucciones". ABB IB 7.11.1.7-4. Disponible (online) en: http://www05.abb.com/global/ scot/scot229.nsf/veritydisplay/51a7be14b9 9f695c852571fc004aedd5/$file/IB7.11.1.74E(Spanish).pdf [6] S&C Electric Company, (2013). "S&C IntelliRupter PulseCloser. Specifications". S&C Specification Bulletin 766-31. Disponible (online) en: [7] Norma C57.13-1993 ANSI/IEEE Standard, ”Requirements For Instrument Transformers”. [14] Castro G., Galarza C., Palacios C., (2013). “Estudio de la Coordinación de las Protecciones por Métodos Computarizados Aplicados a la Subestación Alborada 1”, ESPOL, Ecuador. [8] Schneider Electric España S.A., (2001). "Transformadores de intensidad: errores de especificación y soluciones". Cuaderno Técnico Schneider n° 195. Disponible (online) en: http://download.schneider-electric. com/files?p_File_Id=16911340&p_File_ Name=CT195.pdf [9] J. Lewis Blackburn, (2006). “Protective Relaying Principles and Applications”, Taylor & Francis Group Ed, 3ra Edición, Florida, USA. [10] Ramírez Carlos, (2003). “Subestaciones de Alta y Extra Alta Tensión”, Editorial Impresoras Gráficas Ltda. Colombia. [11] CENACE (2013). “Informe de determinación del esquema de alivio de carga por baja frecuencia para el S.N.I.”, Quito, Ecuador. [12] McGraw-Edison Power Systems Division, “Distribution System protection manual”, McGraw Hill – Edison Company, Pittsburgh, USA. [15] SCHWEITZER ENGINEERING LABORATORIES, (2012). "SEL-487E Transformer differential Relay" Schweitzer Engineering Laboratories, Inc. Disponible (online) en: https://www.selinc.com/SEL487E/ Cindy Palacios.- Nació en 1989 en la ciudad de Shell, Ecuador. Realizó sus estudios secundarios en la Unidad Educativa San Vicente Ferrer y sus estudios superiores en la Escuela Superior Politécnica del Litoral, donde obtuvo el título de Ingeniera en Electricidad especialización Potencia en abril del 2013. Actualmente trabaja en la Dirección de Transacciones Comerciales del Centro Nacional de Control de Energía. [13] Reproel: Tablas de aplicación, sistemas de baja y media tensión, disponible (online) en: http:// www.dimater.com.ar/public/images/archivos/ tabla_aplicacion.pdf 166 Breaker DC basado en convertidores controlado por modos deslizantes J. D. Valladolid P.X. Navarrete Universidad Politécnica Salesiana, Cuenca Resumen— En este documento se presenta una propuesta de control para un dispositivo de seguridad dedicado a corriente continua basada en la filosofía de los convertidores de CC (boost - elevador), al mismo que se le aplicará una técnica de control, denominada, control por modo deslizante (Sliding Control ), para esto se propone un modelo promediado del convertidor para después aplicar una estrategia de control con una superficie de deslizamiento, que tiene como fin disminuir la corriente directa de carga al minimo posible y así poder realizar la desconexión segura del circuito, esta propuesta también reduce el TVR (Transient Recovery Voltage) cercano a cero. La simulación del comportamiento de nuestro diseño ha sido desarrollado sobre la plataforma de Matlab y Simulink. Palabras Clave— Breaker DC, Control Deslizante, Boost, Microgrid, TRV (Transient Recovery Voltage). Abstract— This paper presents a control proposal for a direct current safety device based on the philosophy of CC converters (boost – elevator) which will receive a control method known as sliding control mode. An averaged converter model is proposed for this so that a control strategy with a sliding surface can later be applied, in order to reduce direct load current to the absolute minimum possible and thus perform safe circuit disconnection. This proposal also reduces the TVR (Transient Recover Voltage) to close to zero. The behavior simulation of our design has been developed on the Matlab and Simulink Platform. Index Terms— DC Circuit Breaker, Sliding Control, Boost, Microgrid, TRV (Transient Recovery Voltage). 1. INTRODUCCIÓN La importancia del uso de energía renovable a llevado a la ingeniería eléctrica y electrónica a enfocar estudios sobre este tipo de energía “ilimitada” pudiendo esta ser generada por fuentes inagotables como generación fotovoltaico, eólico, solar, térmica etc. [1]siendo estas, cada vez más accesibles a un nivel local permitiendo aportar energía limpia a la red. Esto lleva a una gestión de múltiples fuentes de energía para su utilización posterior Fig. 1, este es el concepto de las micro redes eléctricas (microgrids) [2]. Figura 1: Microgrid estructura básica La principal motivación es aportar con investigación para la protección de estas redes, de manera particular en el bus de corriente directa, es decir entre la generación y la conversión DC/AC. Uno de los principales problemas para el diseño de un breaker para corriente directa es el no cruce natural de cero, como es el caso de la corriente alterna, por lo que, al interrumpirla de manera abrupta esta generara una serie de problemas asociadas con la generación de armónicos conocido como TVR, siendo este un parámetro decisivo que limita la capacidad de interrupción de un disyuntor o tiristor provocando perdida de aislamiento y forzando a un reencendido del circuito[14]. Una propuesta presentada se basa en la utilización de superconductores [3] , teniendo una problemática en la implementación, el acceso al nitrógeno liquido para la obtención de un superconductor y a algunos gases que disminuyen el arco provocado por la desconexión, es limitada. Ante una corriente de falla (cortocircuito, sobre corriente ) es primordial llevar a la corriente a un valor mínimo seguro antes de la desconexión, ante esto existe la propuesta de un breaker de corriente directa de estado sólido con una estrategia de control basada en lógica difusa y redes neuronales [4] que controla un circuito a base de tiristores para garantizar un apagado seguro 167 del breaker ante una corriente de falla. Basados en este principio se ha propuesto utilizar la teoría de convertidores elevadores DC-DC para forzar a la corriente de falla, provocada en la carga, a cero o a un valor seguro, apoyados en una estrategia de control de modo deslizante, estableciendo así, una superficie de deslizamiento de la corriente y un tiempo mínimo para su descenso. Finalmente se evaluaran algunos resultados obtenidos en el diseño y simulación. [6]. A la corriente directa se la forzara a un cruce por cero Fig. 3., análogamente, en la corriente alterna la desconexión se la realiza en el cruce por cero. 2. CONVERTIDORES ELEVADORES DC-DC (BOOST) Este tipo de convertidores son usados para aplicaciones en donde se requiere que la tensión de salida sea mayor a la tensión de la fuente. Su principio de funcionamiento se da por la combinación de inductor capacitor que actúan como elementos acumuladores de energía Fig. 2. Figura 3: Corriente de Falla y voltaje de Recuperación 3.1. Circuito Propuesto y Modelado Matemático El modelo (Breaker DC de estado sólido) propuesto para el control de la corriente de falla en circuitos de corriente continua, el cual está basado en la teoría de los convertidores en conmutación, a este modelo se le incluye adicionalmente un filtro de salida [7], que disminuye el rizado de la salida y está compuesta por los elementos L2 y C2 Fig. 4. Para completar el modelo se incluye la R de carga que se denomina impedancia de carga ya que no se la restringirá a ser únicamente resistiva y finalmente la fuente Vp que representa la fuente principal de tensión que será protegida. Figura 2: Configuracion Basica del Convertidor Boost 2.1. Principio de funcionamiento El interruptor S Fig. 2., consiste en un elemento de conmutación rápida generalmente se usa tecnología Mosfet o IGBT por ser elementos que trabajan a frecuencias altas. El elemento D es un diodo de rápida recuperación, más rápida que el periodo de conmutación del control, este diodo también actúa como una barrera que impide que la energía acumulada en el capacitor C se devuelva, además permite que la energía almacenada en el inductor L se la suministre al capacitor C, cada vez cargándolo a un nuevo nivel de tensión en los intervalos de apertura y cierre del elemento de conmutación [5]. Figura 4: Modelo propuesto como breaker DC Para el modelado matemático del circuito. Se comienza por describir el sistema mediante ecuaciones diferenciales siendo [iL1 iL2 Vc1 Vc2 ] equivalentes a [X1 X2 X3 X4 ] respectivamente. 3. CONTROL MODO DESLIZANTE DEL CONVERTIDOR BOOST COMO BREAKER DC DE ESTADO SÓLIDO La propuesta de control es forzar a la corriente de falla a una disminución para que alcance un nivel bajo que asegure una desconexión confiable. De la misma manera la tensión se recuperará en el tiempo en que la pendiente lleve a la corriente al mínimo[4] 168 Por lo que el sistema queda representado como: Al ser un sistema de estructura variable, es decir con dos comportamientos según el valor del control u sea 1 o sea 0 para esto el sistema podrá ser representado mediante un modelo de espacio de estado promediado [8],[9] combinando los dos resultados en una única ecuación que represente el sistema total. Estado ON: (1) Estado OFF:: (2) para conseguir una ecuación que contenga todo el periodo [8][9] se tiene: Idealmente se expresa como: (5) (6) Siendo (6) la condición de invarianza [10], por lo tanto en control equivalente se la puede expresar de la siguiente manera: (7) Para que el sistema pueda alcanzar el régimen deslizante sería necesario que S(x)(Bx+γ) Vsea diferente de 0, a esta condición se la denomina condición de transversalidad. Aplicando la formula se tiene: (3) Para simplificar esta ecuación: siendo X3 la tensión de salida: Tomando en consideración que (4) Para f(x); X2 y X4 son estados resultante de un filtro de la salida del sistema, se propone reducir el sistema de 4 estados a 2, con X1 la corriente y X4 la tensión de salida. Aplicando las mismas condiciones de transversalidad en el sistema anterior, se llega a la conclusión de la señal de control para el sistema. Para f(x); (8) Reemplazando en el estado X2 y llevándolo al equilibrio con un valor de X1 deseado, K se tiene: 3.2. Superficie de Deslizamiento y condición de transversalidad Para este caso particular es importante que la tensión de salida no sea constante sino que vaya evolucionando de tal forma que permita el descenso de la corriente de la fuente Vp Fig. 4. Para definir esta superficie estableceremos la condición de superficie de deslizamiento [10]. (9) (10) Despejando K que es valor de la corriente X_1 en el inductor se tiene: (11) En la Fig. 3. se requiere que la corriente disminuya de forma lineal con pendiente negativa, esto supone que la tensión a la salida del circuito diseñado se incremente de manera lineal con pendiente positiva 169 Fig. 5., por lo que X2 d (X2 deseado) se expresara de la forma: La configuración del diseño usa el siguiente set de valores: If=10, 15 y 20A, para diferentes pruebas R=3Ω, Vp=60V, L1=2mH, L2=20uH, C1=100uf y C2=20pf. Se muestra la forma del comportamiento de las señales en diferentes puntos de la simulación. Figura 5: Trayectoria establecida para la tension de salida (12) Siendo t el eje del tiempo y T el tiempo estimado en alcanzar el objetivo, If será la corriente de falla a la que se quiere controlar. Finalmente la ecuación de la superficie se presenta de la siguiente manera: (13) Figura 8: Corriente en L1, corriente de falla de 10A IL1, Fig. 8., tiene forma cuadrática, la misma forma que se define en (13), cumpliendo así el seguimiento por parte del control deslizante. 3.3. Simulación y Resultados. El circuito y ecuaciones diferenciales referentes a la Fig. 4. se lo ha desarrollado sobre la plataforma de Matlab y simulink. El esquema Fig. 6. muestra que la retroalimentación del sistema de control es la corriente pese a que la acción es la de la tensión, esto se denomina control indirecto [10], [11]. Figura 9: Salida de tension VC2 La tensión de salida VC2 Fig. 9. se incrementa de forma lineal como se establece en (12) y Fig. 5., el control indirecto de esta variable se ajusta al planteamiento inicial, el tiempo para alcanzar el objetivo es de t = 20ms. Figura 6: Esquema general de control La frecuencia de muestreo de nuestro modelo se establece en 80Khz, se aplica la superficie K(13) en el diseño estudiado. La señal de control u Fig. 7. estará referida a la conmutación del mosfet, cambiando su estado de 0 a 1 según sea el requerimiento de la estrategia de control. La corriente de falla provocada por efectos desconocidos desde Vp, se la ha considerado para la primera simulación de 10A, el algoritmo alcanza su objetivo a un tiempo, que puede ser modificable, en este caso de 20ms, alcanzando el objetivo en este punto, la apertura de los tiristores principales puede ejecutarse, minimizando al máximo cualquier posible transitorio a la red y obteniendo una óptima recuperación de la tensión Fig. 10. Figura 7: Senal de control u, frecuencia de muestreo 80 Khz 170 4. CONCLUSIONES Y RECOMENDACIONES: Figura 10: Control de corriente de falla 10A en 20mS Así también se tiene un TRV en valores mínimos que no comprometan a los tiristores. [4] Fig. 11. y 12. El valor de la tensión de salida VC2 se ajusta de manera aceptable, esto abre una posibilidad de manejar el tiempo t, disminuyéndolo o ampliándolo, para alcanzar el valor deseado. Tomando en cuenta que nuestro objetivo de control es el de protección, el tiempo no deberá ser muy grande. Aunque al disminuir ese tiempo al mínimo exigiría una mayor cantidad de energía en los elementos electrónicos. Gracias a las simulaciones realizadas con varios objetivos de tiempo, se puede estimar que un tiempo optimo será 20ms y el mismo no afectara a los elementos electrónicos. El control en modo deslizante es bastante versátil y robusto, sin embargo un problema asociado a este tipo de control es el problema de un fenómeno denominado Chattering [12], que a medida que aumenta la corriente, este fenómeno se hace más notable, pudiendo provocar inestabilidad al sistema al incrementarse la If de manera desmesurada. Una solución propuesta es la del filtro de salida L2 y C2, al ser un filtro pasa bajo minimiza este fenómeno. Por otro lado se tiene que al aumentar la frecuencia de muestreo también disminuye el Chattering [12], desafortunadamente se tiene restricciones para esta solución, al estar sujetos a los limites de los elementos de conmutación y frecuencia de muestreo. Figura 11: TRV voltaje de salida Figura 12: TRV GTO Variando la I de falla a 15A Fig. 13. y a 20A fig. 14. se observa que los resultados no varían, el tiempo en el que se alcanza el objetivo es similar a los 20mS. Existen otros métodos para minimizar este fenómeno desde el lado del control deslizante que es el control extendido [10],[12] que en trabajos posteriores se tratará como mejora del algoritmo. REFERENCIAS BIBLIOGRÁFICAS Figura 13: Corriente de falla 15A, desconexion cercana a 20mS Figura 14: Corriente de falla 20A, desconexion cercana a 20mS 171 [1] Pedro Gómez Vidal “ENERGÍAS RENOVABLES LA NECESIDAD DE UN CAMBIO ENERGÉTICO” SUMUNTÁN Nº 23 (2006); [2] Michael R. Lavelle, P.E “Micro-Grid Applications "Exploring micro-grids for building energy applications Solving the alternative energy management problem 2010 [3] Yukinaga Morishita, Tatsuya Ishikawa, Iwao Yamaguchi, Shigemitsu Okabe “Applications of DC Breakers and Concepts for Superconducting Fault-Current Limiter for a DC Distribution Network”. IEEE TRANSACTIONS ON APPLIED SUPERCONDUCTIVITY, VOL. 19, NO. 4, AUGUST 2009. [4] Minchala, L., Garza, L., and Calle, E. (2012). An intelligent control approach for designing a low voltage dc breaker. Number 4, pages 163–166. [13] [7] Lorenzo Pujol. “Implementación de control digital mediante Linealización Entrada-Salida para convertidor conmutado elevador con filtro de salida”. Septiembre 2003. [8] L. Martinez-Salamero, A. Cid-Pastor, A. El Aroudi, R. Giral, J. Calvente, and G. RuizMagaz “Sliding-Mode Control of DC-DC Switching Converters”.Preprints of the 18th IFAC World Congress Milano (Italy) August 28 - September 2, 2011. [9] Middlebrook, R.D. and Cuk, S. “A General Unified Approach to Modeling Switched Power Stages”, IEEE PESC Record, pp. 18-34 (1976) [10] Francklin Rivas-Echeveria,Richard Márquez, Orestes Llanes Santiago. “Control de Sistemas no Lineales”.2005. [11] María Isabel Arteaga Orosco. “Control no Lineal de Convertidores conmutados CC/CC”. Tesis Doctoral noviembre 2006. Processing MATLAB and and [14] Dr. Bruce Mork “Effects of Transient Recovery Voltages on Circuit Breaker Ratings ”EE5220 - Power System Transients. 2008. [5] Freddy Fernando Valderrama, Henry Moreno C, Héctor Manuel Vega “Análisis, simulación y control de un convertidor de potencia dcdc tipo boost”.Septiembre de 2011 [6] J. Shullaw. “DC Power Circuit Breaker Basics”. IEEE HVCB Subcommittee Meeting October 12, 2011 Nashville. MathWorks, “Signal Communications with Simulink”,2010. Juan Diego Valladolid.- Nació en Cuenca Ecuador, en 1984. Recibió su título de Ingeniero electrónico en la Universidad Politécnica Salesiana, Cuenca 2010. Egresado de la Maestría en Control y Automatización industrial en la Universidad Politécnica Salesiana en 2012. Se desempeña como Asistente Administrativo en la Empresa Eléctrica Centro Sur. Docente en el instituto Tecnológico Superior “Francisco Febres Cordero” en las materias de Programación III, Programación IV e Ingeniería del Software. Sus áreas de interés están enmarcadas en: Sistemas de control Moderno, Energía renovable, sistemas embebidos, Electrónica de Potencia. Pedro Xavier Navarrete.- Nació en Cuenca Ecuador, en 1984. Recibió su título de Ingeniero electrónico en la Universidad Politécnica Salesiana, Cuenca 2010. Egresado de la Maestría en Control y Automatización industrial en la Universidad Politécnica Salesiana en 2012. Se desempeña como Electricista en la Dirección de Distribución en la empresa Eléctrica Centro Sur. Sus áreas de interés están enmarcadas en: Sistemas Embebidos, RNAs, Control Moderno, Energía renovable, Electrónica de Potencia. [12] Orestes Llanes Santiago, Alberto Prieto Moreno. “Control discontinuo dinámico para control activo de vibraciones mecánicas". Revista Cubana de Ingeniería, 1(1), 19-28, 2010. 172 Diseño e implementación de un Registrador de Disturbios de frecuencia para análisis dinámico de sistemas eléctricos de potencia M. D. Dávila C. E. Landázuri Universidad Politécnica Salesiana Resumen­— Diseño e implementación de un equipo de precisión para registrar la frecuencia de la red eléctrica en la Empresa Eléctrica Regional Centro Sur de la ciudad de Cuenca. Descripción de las aplicaciones relacionadas con el equipo en el análisis dinámico de sistemas eléctricos de potencia y en redes de medición de frecuencia. Palabras Clave— Red de medición de Frecuencia, Registrador de Disturbios de Frecuencia, Diseño electrónico, Análisis dinámico de Sistemas de Potencia Abstract­— The design and implementation of a precision recorder to be used for the electric network of the Empresa Electrica Regional Centro Sur (Regional South Center Electricity Company) in the city of Cuenca is presented in this paper. A description of the equipment applications for dynamic analysis of electric power systems and grid frequency measurement is also depicted. Index Terms— Grid Frequency Measurement, Frequency Disturbance Recorder, Electronic Design, Dynamic Analysis of Power Systems. Por último, en el tercer capítulo se revisará las aplicaciones de equipos similares en redes inteligentes de medición de frecuencia, las cuales se aplican en mercados eléctricos en competencia, y en sistemas de más de un generador que puedan controlar la frecuencia del sistema. Se describen de las aplicaciones referentes al diseño logrado como son: Medición de frecuencia para la red de distribución de la Centro Sur, aplicación para una red de medición de frecuencia nacional, esquemas de alivio de carga en base a datos en tiempo real, análisis de frecuencia inter-área. 2. DISEÑO ELECTRÓNICO DE HARDWARE, FIRMWARE Y SOFTWARE El diseño del Registrador de Disturbios de frecuencia constituye un desarrollo a medida, basado en la necesidad de la empresa de la medición de frecuencia en la red de distribución. Los frecuencímetros comerciales analizados no cumplen con las características de precisión y visualización requeridas, por lo que se realizó un diseño integral para esta aplicación. Los aspectos más importantes del diseño se tratarán a continuación. Los requerimientos de diseños planteados por la CENTROSUR fueron los siguientes: • Diseño de un equipo de medición y registro de frecuencia de precisión en la red eléctrica en baja tensión. • El equipo debe comunicarse con un software de aplicación mediante el protocolo USB11, y registrar la frecuencia en un dispositivo de memoria. • El equipo debe mantener un registro de frecuencia con información sobre la hora y fecha de la medición. Esta información horaria debe obtenerse mediante un GPS22. • El equipo debe diseñarse teniendo en cuenta la optimización de recursos, y alcanzar el menor costo posible de construcción e implementación. 1. INTRODUCCIÓN En el presente ensayo se tratará el diseño eléctrico y electrónico de un prototipo registrador de disturbios de frecuencia para la red de distribución de la Empresa Eléctrica Regional Centro Sur C.A. de la ciudad de Cuenca. En el primer capítulo se tratará el diseño electrónico tanto a nivel de software como de firmware y hardware, el diseño del equipo en función de las necesidades de la empresa, partiendo de la condición de construir un equipo de precisión, con características superiores a las ofrecidas en el mercado y de bajo costo. En el segundo capítulo se revisa el diseño del software de control y visualización del equipo, así también como las características de análisis diseñadas para el caso. Se realiza un análisis descriptivo de las características de precisión y operación logradas con el diseño planteado. Con estos requisitos en consideración, se diseñó el prototipo del registrador de frecuencia (fig.1). El cual 1 Universal Serial Bus o bus serial universal 2 Global Positioning System o sistema de posicionamiento global 173 5 6 Light Emitting Diode o diodo emisor de luz. Real Time Clock o reloj de tiempo real. Es un circuito integrado de memoria que graba la hora y fecha. Secure Digital. Memoria extraíble de uso común en dispositivos electrónicos de consumo. El firmware es el código de programación que se utiliza en los microcontroladores. 174 18F452 uC principal FT232R módulo USB-serial 30F4011 uC secundario (cruce por cero) C 3 4 Z GPS-10920 Módulo GPS serial 12 El diseño del firmware en el equipo se lo realizó en dos microcontroladores cada uno programado en lenguaje Basic para la fácil comprensión y mantenimiento del personal encargado. I 2.1. Diseño de Firmware6 Memoria SD SP El diseño del registrador de frecuencia se basa en dos circuitos principales, uno de control y comunicación, y otro dedicado a la adquisición de la señal, detección de cruce por cero para la medición de frecuencia, y filtrado. El circuito de control tiene dos microcontroladores encargados del funcionamiento total del equipo. El microcontrolador principal permite la comunicación del equipo con el computador, además realiza la labor de adquisición de datos del GPS y la escritura en la memoria SD. El diseño de firmware en ambos microcontroladores se detalla a continuación: EM-100 módulo ethernet 96 Ser 00 ial b/ 8b it • Visualización de frecuencia mediante una matriz de LEDs. • Comunicación mediante Ethernet y USB. • Obtención de hora y fecha mediante GPS • Registro de hora y fecha con RTC4. • Registro de frecuencia en memoria SD5. Serial 9600b/8bit El circuito electrónico diseñado consta de las siguientes características principales: El microcontrolador que actúa como principal en el equipo es el PIC18F452 de Microchip [1] (de ahora en adelante llamado U1). Se encuentra funcionando a 20MHz, y es el encargado de controlar la comunicación con los módulos USB, Ethernet, GPS, RTC y SD. Además interviene en la comunicación con el microcontrolador de cruce por cero. El diseño se basa en un diagrama de conexiones en estrella (fig.2) y la comunicación utilizada entre los módulos es del tipo serial. El firmware utilizado en el microcontrolador principal coordina las tareas de comunicación del equipo (fig.3), para lo cual se programaron subrutinas de lectura de frecuencia y lectura de los datos del GPS y del RTC, la escritura y lectura de la memoria SD, el control del módulo Ethernet, y del módulo USB. Serial 9600b/8bit /par Figura 1: Registrador de frecuencia instalado en el centro de contacto de la CENTROSUR a) Microcontrolador Principal 96 Ser 00 ial /p b/8b ar it consta de dos partes: La caja de control donde se alberga el circuito electrónico y los elementos de comunicación, y una matriz de LEDs3 para la visualización de la frecuencia del sistema. DS-1307 Real Time Clock Figura 2: Diagrama de conexiones entre el microcontrolador principal y los módulos de comunicación enviar datos entre el microcontrolador principal y la aplicación de control en LabView. INICIO Leer Frecuencias y comparar con límites Leer hora y fecha del GPS Escribir en memoria 3D Figura 5: Diagrama de conexión básico del FTDI FT232R [3] USB ¿conectado? El microcontrolador secundario utilizado es el DsPIC30F4011 de microchip [4] (de ahora en adelante nombrado U2), el cual funciona a 80MHz. U2 se encarga de capturar la frecuencia de la red mediante múltiples entradas tanto analógicas como digitales. Al funcionar a altas frecuencias, permite una resolución óptima para la aplicación puntual requerida. U2 tiene solamente dos tareas dentro del diseño, capturar la frecuencia en todas sus entradas obteniendo el promedio de las mismas, y enviar el dato de frecuencia por su puerto serial a U1 (fig.6). b) Microcontrolador secundario FIN Figura 3: Diagrama de flujo principal Cruce 4 Cruce 3 Analog 1 an aló . Cruce 2 gic ital dig Para la actualización automática de la hora y fecha utilizada para los históricos de frecuencia, se utilizó un Módulo GPS-10920 Venus [2] (fig. 4). Este módulo permite la adquisición de datos de hora y fecha en formato NMEA7 de manera serial, con lo que el usuario puede interpretar directamente la trama requerida para la programación. o digital ital gi ta di Cruce 5 Cruce 6 UI Figura 4: Módulo GPS-10920 [2] Para la comunicación USB entre el equipo y un computador, se utilizó un conversor serial-USB FT232R [3] (fig.5). Es un módulo ampliamente utilizado en el mercado, por lo que el mantenimiento del mismo se puede realizar fácilmente. Es un conversor serial-USB transparente, permitiendo 7 30F4011 uC secundario (cruce por cero) l dig digital Enviar datos por USB Serial 9600b/par Leer límites Programados Enviar datos por ethernet National Marine Electronics Association. Es un formato de datos utilizado en módulos GPS donde se expresa la hora, fecha, y posición del equipo. Figura 6: Diagrama de conexión del microcontrolador secundario U2 El firmware utilizado en el microcontrolador secundario coordina las tareas de medición de cruces por cero mediante una entrada analógica y una digital, compara los resultados de ambas entradas y obtiene un promedio de la frecuencia medida (fig.7). 175 INICIO Leer Frecuencia canal analógico Leer Frecuencia canal digital Figura 9: Ubicación del módulo GPS en la placa de control Promedio frecuencia b) Comunicación Ethernet El modulo Ethernet se conecta a U1 mediante un Puerto serial por hardware, además se provee al usuario de LEDs de visualización para observar el correcto funcionamiento del módulo (fig.10). Enviar datos por serial FIN a) Comunicación USB Figura 7: Diagrama de flujo para el microcontrolador U2 2.2. Diseño de hardware La placa de control se diseñó en función de las hojas de aplicación de los diferentes integrados utilizados. Se procuró mantener el diseño con un factor de forma de placa de entrenamiento, es decir, dejando los pines de microcontroladores y módulos conectados a peinetas, lo cual permite el posterior análisis de las señales utilizadas (fig.8). La comunicación de U1 con el módulo USB se realiza mediante un puerto serial virtual creado en el compilador. Se utiliza una peineta de configuración para medir las señales de comunicación (fig.11). Figura 10: Ubicación del módulo Ethernet-serial en la placa de control Figura 8: Placa de control A continuación se explicarán los esquemas en bloques más importantes. a) Comunicación GPS El módulo GPS se conecta al microcontrolador principal mediante un puerto serial virtual creado en el compilador y se cuenta con una batería de respaldo para el arranque rápido del módulo. El diseño de la placa de control se realizó considerando la conexión de una antena externa (fig.9). Figura 11: Ubicación del módulo serial-USB b) Comunicación con la memoria SD Con el objetivo de almacenar históricos de frecuencia, se utiliza una memoria SD, la cual se comunica con U1 mediante un puerto serial por hardware. Se utilizan además dos circuitos integrados para la conversión de niveles lógicos de 3.3 voltios (LVTTL) a 5 voltios (TTL) (fig.12). 176 • Reloj de tiempo real incorporado • Recopilación de históricos de frecuencia mediante memoria SD • Precisión de +/-15mHz • Software de visualización en tiempo real, y de análisis de históricos en LabView 3. APLICACIONES EN REDES DE MEDICIÓN DE FRECUENCIA Figura 12: Ubicación de la interfaz con la memoria SD 2.3. Diseño del software de control El frecuencímetro permite la comunicación con un software de control en el computador. El software se diseñó en LabView 2010, permitiendo una interfaz de usuario de altas prestaciones (fig.13). Nos permite visualizar los límites de frecuencia, alarmas, frecuencia medida y hora del equipo. Además el software es la herramienta de análisis encargada de visualizar los históricos de frecuencia guardados en la memoria SD del equipo (fig.14). En los sistemas eléctricos de potencia el control de frecuencia es una actividad fundamental para mantener la estabilidad del sistema y evitar un apagón general en el caso de variaciones de carga. Para el control de la frecuencia se utilizan equipos de medición en cada unidad de generación con el fin de responder a dichas variaciones de carga compensando la alimentación de la máquina síncrona. Para tener una idea global de las aplicaciones de un equipo de medición de frecuencia con las características del prototipo diseñado en este ensayo debemos conocer las implicaciones de la variación de frecuencia en pequeña escala. El conocimiento general que tenemos del SNI8. nos indica que la frecuencia es la misma en todo el sistema, y es dictada por la central hidroeléctrica Hidropaute. Además conocemos que existen pequeñas variaciones de frecuencia (fig.15), las cuales se compensan con el AGC9 existente y el control primario de frecuencia de las máquinas síncronas. Estas variaciones de frecuencia se encuentran en el orden de los milihercios, y normalmente no interfieren con la estabilidad del SNI pues si las frecuencias entre generadores son muy grandes, el control de frecuencia hace que las unidades de menor potencia sean las que se desconecten primero. Figura 13: Ventanas del software de monitoreo Figura 14: Ventana análisis 2.4. Características Técnicas finales El diseño a medida del registrador de disturbios de frecuencia de la Empresa Eléctrica Regional Centro Sur C.A. de la ciudad de Cuenca tiene las siguientes características técnicas: • Microcontrolador principal: PIC18f452 a 20MHz • Microcontrolador para cruce por cero: DSPIC30F4011 a 80MHz • Comunicación USB mediante módulo FTDI FT232R • Comunicación Ethernet mediante módulo Tibbo Em-100 • Sincronización de hora y fecha mediante módulo GPS Figura 15: Variaciones de frecuencia comunes en un sistema eléctrico de potencia [5] Este escenario cambiar cuando la central hidroeléctrica Coca Codo Sinclair entre en funcionamiento pues tendríamos dos grandes generadores disputando el control de frecuencia, es decir, podríamos pensar en un AGC de dos áreas principales. Así, por la cercanía, Hidropaute podría influir de mayor manera en la frecuencia de la zona 8 9 177 Sistema Nacional Interconectado Control Automático de Generación sur del país, mientras que Coca Codo Sinclair podría tener mayor influencia en la zona norte. Por lo tanto las frecuencias inter-área (o en este caso se puede analizar como inter-generadores) deben permanecer muy próximas para evitar la salida de sincronismo de las maquinas. a la inercia de las masas rotóricas de los generadores, la frecuencia disminuye a niveles normales (60.03Hz) pero las variaciones duran aproximadamente 10 segundos, lo que ocasiona la salida de sincronismo de varios generadores. El efecto de tener múltiples generadores de gran potencia que pueden disputar el control de frecuencia, es que momentáneamente existan varias frecuencias dentro de un mismo sistema nacional interconectado [5]. Esto no quiere decir que el sistema funcione en frecuencias muy separadas unas de otras, sino que conforme añadimos más precisión a los sistemas de medición, se observa una variación de frecuencia considerable (fig. 16). En la figura 16 se muestra la distribución de las diferentes frecuencias a las que trabaja el sistema nacional interconectado de Estados Unidos []. La frecuencia nominal es de 60Hz, pero como se observa existen sectores que trabajan desde 59.98Hz (azul) hasta 60.02Hz (rojo), es decir, existe una diferencia de 0.04Hz entre diferentes sectores del sistema. Aunque esta variación no parezca significativa, estudios realizados en el sistema de Estados Unidos [5] demuestran que estas variaciones se dan en eventos como el apagón general del 2011 en la Costa Este (fig. 17). Figura 17: Variación de frecuencia de los generadores en el apagón del 2011 en la Costa Este de Estados Unidos [8] Por lo tanto, las variaciones muy pequeñas de frecuencia que no sean adecuadamente informadas al centro de control de energía pueden ocasionar inestabilidad en el sistema de potencia. Este comportamiento del sistema es un estudio nuevo, por lo que, las principales aplicaciones de equipos de medición y registro de frecuencia como el diseñado en el presente ensayo, son las siguientes: a) Medición de frecuencia local En cuanto a la realidad del sistema de distribución de la ciudad de Cuenca, se tienen dos conexiones al Sistema Nacional Interconectado, pero si estas conexiones fallan, el sistema de distribución funciona como isla. Para el control de frecuencia en esta situación la Empresa Eléctrica Regional Centro Sur C.A. (CENTROSUR) optó por el diseño del prototipo de monitoreo y registro de frecuencia tratado en este ensayo. Pero esta aplicación es la más simple que se puede tratar con un equipo de las características Figura 16: Mapa de frecuencias del sistema de potencia nacional interconectado de Estados Unidos [6] b) Red de frecuencia Como se puede observar en la figura 17, el evento que inicia el apagón causa un aumento de frecuencia (60.170Hz), en ese momento el control primario varía las alimentaciones de las máquinas síncronas logrando una disminución de la frecuencia de los generadores, pero debido a la naturaleza de los sistemas de control y En el caso del Ecuador, al mantener una estructura de monopolio en generación, transmisión y distribución, la comunicación de parámetros de frecuencia se realiza directamente sobre la red de telecomunicaciones existente (radiofrecuencia y fibra óptica), donde las mediciones se realizan 178 en generadores y en subestaciones del sistema de transmisión. En sistemas muy grandes o que funcionan en competencia de generación (como en el caso de Estados Unidos), se utilizan equipos de medición de frecuencia distribuidos en las redes de cada proveedor, los cuales envían la información sobre dicha medición al centro de control de energía de cada país, es decir, la infraestructura de comunicación es independiente una de otra para cada zona del AGC. Esto ocasiona un inconveniente, pues la información sobre parámetros eléctricos como la frecuencia, pueden demorar mucho tiempo en llegar al centro de control, ya que dependen del despliegue y desempeño de las redes de telecomunicaciones de los proveedores. Este problema ha causado apagones generales por variaciones muy pequeñas de frecuencia. Para solucionar dicho inconveniente, se creó una red de registradores de frecuencia conocida como FNET (Frequency Monitoring Nertwok o Red de monitoreo de Frecuencia), la cual utiliza la red de telecomunicaciones local [5], es decir, utiliza las plataformas de acceso a internet de la población (fig.18). Figura 19: Registrador de disturbios de frecuencia [5] Este modelo de red de medición presenta una ventaja muy importante pues por experiencia las redes de comunicación de las empresas de generación y transmisión pueden fallar en momentos críticos, mientras que la probabilidad de que los sistemas de telecomunicaciones para usuarios privados fallen es muy baja. c) Esquemas de alivio de carga con información en tiempo real Los esquemas de alivio de carga permiten recuperar la frecuencia nominal ante variaciones grandes de carga en el SNI. Estos esquemas se realizan en base a simulaciones del comportamiento del sistema y mediante históricos, lo cual introduce una posibilidad de error. Este error podría disminuirse con un monitoreo en tiempo real del sistema, logrando tomar decisiones con datos instantáneos. Una red de frecuencia distribuida en el país, permitiría la obtención de datos instantáneos de frecuencia para mejorar el histórico en función del sector donde se vaya a aplicar el esquema de alivio de carga, es decir, consistiría en una herramienta de diseño, corrección y planificación para el ingeniero encargado de establecer los esquemas. Figura 18: FNET diseñada para el monitoreo de frecuencia del sistema de potencia estadounidense Esto implica que los equipos de medición de frecuencia se conectan en la red de baja tensión, lo que permite la obtención de parámetros directamente en la carga del sistema, y además logra que se mantenga una independencia del estado de la plataforma de telecomunicaciones de cada proveedor, migrando la comunicación de parámetros a las redes públicas y privadas para servicio de internet [5]. El equipo utilizado recibe el nombre de FDR (Frequency Disturbance Recorder o Registrador de Disturbios de Frecuencia) el cual se diferencia de los PMU (Phasor Measurement Unit o Unidades de Medición de Fasores) pues utiliza la red de internet pública para la comunicación (fig. 19). 4. CONCLUSIONES Y RECOMENDACIONES El registrador de disturbios de frecuencia diseñado cumple con las características solicitadas por la Centrosur, con lo que el Departamento de Supervisión y Operación cuenta con un instrumento para monitorear la frecuencia de la red eléctrica en caso de funcionamiento como isla. Se observó que la técnica de medición de cruce por cero utilizada, logró una precisión de +/-15mHz, lo cual es aceptable para la aplicación requerida, pero insuficiente para análisis más avanzados. El diseño planteado, permite la medición de frecuencia de la red eléctrica, sin la dependencia del anillo de fibra óptica, o equipos de comunicación propios de la empresa, los cuales en base al historial analizado no siempre cumplen con los criterios de confiabilidad requeridos para un correcto análisis 179 dinámico de frecuencia. Por lo tanto, la transmisión de datos de medición de frecuencia a través de internet, lograría la transmisión en tiempo real del estado del sistema en el punto de carga, sin la necesidad de una red de comunicación propia. información de sistemas de potencia de la universidad de Tennessee. Virginia, Estados Unidos. [6] Laboratorio de tecnología de información de sistemas de potencia de la universidad de Tennessee (2013). “U.S. Frequency Gradient Map”. Documento en línea disponible en http://fnetpublic.utk.edu/gradientmap.html El diseño tiene características de comunicación que permiten hacer uso de la información adquirida para su utilización dentro de una red inteligente de medición de frecuencia remota directamente en el usuario final. Una red inteligente de frecuencia permite al operador del sistema eléctrico, tomar decisiones de control, basado en el comportamiento dinámico instantáneo del sistema. Las mediciones de frecuencia en la red de baja tensión, permiten un acercamiento más real al comportamiento del sistema, lo que logra un control más apropiado en estudios de esquemas de alivio de carga, y comportamiento dinámico antes de un apagón general (blackout).. [7] Laboratorio de tecnología de información de sistemas de potencia de la universidad de Tennessee (2013). “World-Wide Frequency Map”. Documento en línea disponible en http://powerit.utk.edu/worldmap/ [8] Laboratorio de tecnología de información de sistemas de potencia de la universidad de Tennessee (2013). “Southwest blackout”. Documento en línea disponible en http:// fnetpublic.utk.edu/eventsamples/20110908. jpg REFERENCIAS BIBLIOGRÁFICAS [1] Microchip Technology Incorporated (2006). “PIC18FXX2 Data Sheet: High-Performance, Enhanced Flash Microcontrollers with 10-Bit A/D”. Estados Unidos. [2] Sparkfun Electronics (2013). “Venus GPS Logger with SMA Connector”. Documento en línea disponible en https://www.sparkfun.com/ products/10920 [3] Future Technology Devices International Ltd (2010). “FT232R USB UART IC Datasheet Version 2.10”. Documento en línea disponible en http://www.ftdichip.com/Support/ Documents/DataSheets/ICs/DS_FT232R.pdf. Estados Unidos. [4] Microchip Technology Incorporated (2005). “DSPIC30F4011/4012 Data Sheet: High Performance Digital Signal Controllers”. Documento en línea disponible en http:// ww1.microchip.com/downloads/en/ devicedoc/70135c.pdf. Estados Unidos. [5] Zhan Zhong (2005). “Power Systems Dynamic Monitoring System Design and Applications”. Tesis para la obtención del título de Doctor en Filosofía (PhD) en ingeniería eléctrica y computación. Laboratorio de tecnología de Carlos Emilio Landázuri Paredes.- Nació en Quito, Ecuador en 1979. Recibió su título de Ingeniero en Electrónica de la Universidad Politécnica Salesiana en 2004. Actualmente se encuentra en proceso de obtención de su título de Master en Telemática en la Universidad de Cuenca. Su campo de investigación está relacionado con el área de control y telecomunicaciones para sistemas SCADA, automatización de subestaciones eléctricas y automatización de los sistemas eléctricos de distribución. Miguel Alberto Dávila Sacoto.Nació en Cuenca, el 4 de julio de 1988. Ingeniero Electrónico con mención en Sistemas Industriales y Telecomunicaciones de la Universidad Politécnica Salesiana en 2012. Egresado de Ingeniería Eléctrica de la Universidad Politécnica Salesiana sede Cuenca. Actualmente se desempeña como docente de Instalaciones Eléctricas de Interior, Automatismos y Cuadros Eléctricos, e Instalaciones Automatizadas en Viviendas y Edificios en la Unidad Educativa Técnico Salesiano. 180 Monitoreo de las oscilaciones de baja frecuencia del Sistema Nacional Interconectado a partir de los registros en tiempo real J. C. Cepeda A. B. De La Torre Centro Nacional de Control de Energía, CENACE Resumen— La determinación de los modos oscilatorios, en tiempo real, brinda al operador una alerta temprana en caso de presentarse riesgo de inestabilidad oscilatoria en el sistema de potencia. Con el desarrollo de la tecnología de medición sincrofasorial, nuevos algoritmos de identificación modal han sido perfeccionados con el objetivo de aplicarlos en tiempo real. Actualmente, CENACE dispone de un sistema de monitoreo de área extendida (WAMS), administrado por la aplicación WAProtector, la cual dispone de un algoritmo propietario de identificación modal. Esta aplicación brinda al operador la posibilidad de monitorear oscilaciones del Sistema Nacional Interconectado (SNI) en tiempo real y adicionalmente entrega información valiosa que permite caracterizar al SNI a través de adecuados análisis post-operativos. Este artículo presenta un marco conceptual del problema de estabilidad oscilatoria, así como una descripción del objetivo de la identificación modal. Adicionalmente, se describe una propuesta metodológica que, a través de análisis estadístico de los modos oscilatorios, permite procesar la información obtenida de WAProtector con el objetivo de caracterizar los modos críticos existentes en el SNI. Asimismo, se resalta la versatilidad de las herramientas gráficas de WAProtector para analizar eventos oscilatorios que se presentan en tiempo real. Palabras clave— Estabilidad oscilatoria, PMU, WAMS, identificación modal. Abstract— The real-time identification of oscillatory modes gives the operator early warning in the event of an oscillation instability risk in the power system occurs. With the development of synchrophasor measurement technology, new modal identification algorithms have been perfected for real-time application. CENACE currently has a wide area monitoring system (WAMS) that is managed by the WAProtector application, which uses a modal identification proprietary algorithm. This application gives the operator the possibility of monitoring oscillations in the National Interconnected System (SNI) in real time and also provides valuable information to characterize the SNI through adequate post-operative analysis. This paper presents a conceptual framework of the oscillation instability problem, as well as a description of the modal identification objective. In addition, a methodological proposal that allows WAProtector information to be processed in order to characterize the critical modes that exist in the SNI is described. This approach is based on a statistical analysis of oscillation modes. In the same manner, the versatility of WAProtector graphic tools to analyse oscillation events that occur in real time, is highlighted throughout the article. Index Terms— Oscillatory WAMS, Modal Identification. Stability, PMU, 1. INTRODUCCIÓN La operación moderna de los sistemas eléctricos de potencia (SEP) se encuentra atravesando varios retos asociados a las crecientes complejidades e incertidumbres en la planificación y gestión operativa. Bajos estas condiciones, el SEP es más susceptible a atravesar condiciones de estrés en las cuales, la ocurrencia de oscilaciones electromecánicas de baja frecuencia, con poco amortiguamiento, podrían conducir a una situación de vulnerabilidad que eventualmente provoque un colapso del sistema [1]. En este contexto, varias estrategias operativas han sido consideradas con el objetivo de mejorar la seguridad oscilatoria del sistema, tales como el re-despacho de generación [2], o el manejo de congestión mediante la transferencia de flujos entre vínculos (a través, de por ejemplo, dispositivos FACTS) [3], [4]. Otras soluciones consideran el cálculo de flujo óptimo de potencia con restricciones de seguridad oscilatoria [5], o el adecuado ajuste de estabilizadores del sistema de potencia (PSS) [4], [6]. Sin embargo, todas estas soluciones se basan en estudios fuera de línea, los cuales podrían ignorar ciertas condiciones críticas que eventualmente lleven al sistema a eventos en cascada y subsecuentes colapsos. Por lo tanto, se presenta la necesidad de poseer una herramienta de evaluación, en tiempo real, de los modos oscilatorios críticos, de manera que el operador tenga información suficiente para decidir acciones sobre el SEP cuando se presenten oscilaciones que puedan ser perjudiciales para la estabilidad del sistema [7]. 181 En la actualidad, modernas tecnologías tales como los medidores sincrofasoriales (PMU – Phasor Measurement Unit) y los sistemas de monitoreo de área extendida (WAMS – Wide Area Measurement System) ofrecen una novedosa estructura que facilita el diseño de mecanismos capaces de evaluar la estabilidad oscilatoria del sistema en tiempo real [7]. En tiempo real, oscilaciones electromecánicas de baja frecuencia pueden ser identificadas a través del procesamiento de señales eléctricas, obteniendo sus modos de oscilación y su amortiguamiento, con métodos de identificación modal [7]. Actualmente, la Corporación Centro Nacional de Control de Energía (CENACE), como organismo operador del Sistema Nacional Interconectado (SNI), dispone de un sistema WAMS, y de una aplicación de identificación modal en tiempo real (a través del software WAProtector de ELPROS). La aplicación WAProtector posee un algoritmo propietario que entrega resultados de la composición modal de señales de potencia activa. Estos datos requieren de un adecuado procesamiento con el objetivo de obtener información valiosa del comportamiento oscilatorio del sistema que permita caracterizarlo adecuadamente. La caracterización oscilatoria del SNI servirá como base de referencia para la estructuración de acciones de control preventivo (despacho programado de generación o calibración de PSSs), así como acciones de control correctivo (re-despacho de unidades de respuesta rápida o modificaciones topológicas), que permitirán mejorar la seguridad operativa del SEP. Este trabajo presenta una propuesta metodológica que permite caracterizar el comportamiento oscilatorio del SNI, basada principalmente en el análisis estadístico de los modos oscilatorios pobremente amortiguados. 2. MARCO TEÓRICO REFERENCIAL 2.1. Estabilidad Oscilatoria Al producirse variaciones de carga o generación en sistemas de potencia, los generadores tratan de encontrar nuevos estados de operación estable, produciéndose oscilaciones de potencia y frecuencia ocasionadas por los intercambios de energía eléctrica entre dichas unidades. Las oscilaciones son caracterizadas mediante los denominados modos de oscilación que pueden clasificarse, en forma general, en los siguientes [8]: Los modos locales se asocian con oscilaciones entre rotores de un grupo de generadores cercanos unos a otros. Estas oscilaciones presentan frecuencias en el rango de 0,7 a 2,0 Hz. Los modos inter-área, por el contrario, son causados por interacciones entre grandes grupos de generadores oscilando entre ellos. Estos modos presentan rangos de frecuencia entre 0,1 a 0,7 Hz. Existen dos tipos de modos oscilatorios adicionales, causados por controladores de diferentes tipos de componentes (llamados modos de control), o por oscilaciones que ocurren en los sistemas rotacionales de los sistemas turbina-generador de las unidades generadoras (denominados modos torsionales). Este tipo de oscilaciones presentan un rango de frecuencias asociadas bastante amplio. Dentro de los modos de control existen unos de muy baja frecuencia (0,01 Hz – 0,1 Hz) que aparecen en sistemas con alta penetración hidráulica y que están asociados a la inadecuada sintonización de los controladores de velocidad de las unidades de generación hidráulicas. Este tipo de modo de control se ha detectado en el sistema ecuatoriano. El análisis modal [8] es la herramienta más utilizada para analizar las oscilaciones en un SEP. Consiste en la determinación de los modos de oscilación y el análisis de sus correspondientes frecuencias modales complejas (es decir, de los valores propios de cada modo: σi ± jωi). La estabilidad oscilatoria se cumple cuando todos los modos presentan un amortiguamiento positivo. La frecuencia y el amortiguamiento de la oscilación pueden determinarse a partir del valor propio de la siguiente manera: (1) (2) Donde fi y ζi son la frecuencia de oscilación y la razón de amortiguamiento del i-ésimo modo, respectivamente. El análisis modal se basa en la modelación matemática completa del SEP, lo que involucra altos tiempos de cómputo para grandes sistemas. Esto constituye una limitación para aplicarlo en tiempo real [7]. Con el objetivo de superar esta limitante, se han estructurado diferentes propuestas para evaluar las oscilaciones en tiempo real. Un enfoque utiliza modelos y herramientas computacionales inteligentes (como redes neuronales artificiales) para estimar el riesgo oscilatorio del SEP [6], mientras que una alternativa, con mayor robustez por sus facilidades de aplicación propone el uso de mediciones sincrofasoriales y su consiguiente procesamiento a través de algoritmos de identificación modal [7]. 2.2. Sistema de medición sincrofasorial Las unidades de medición sincrofasorial (PMUs) son dispositivos que permiten estimar sincrofasores (fasores 182 que tienen como referencia angular a una onda coseno de frecuencia nominal, sincronizada con el tiempo UTC -Universal Time Coordinated) de las ondas sinusoidales de corriente y voltaje AC, en diferentes nodos de un SEP [9]. Para calcular un sincrofasor la PMU utiliza un algoritmo de estimación fasorial. Estos algoritmos utilizan un número N de muestras en el tiempo para efectuar la estimación del fasor. El algoritmo más comúnmente utilizado es la transformada discreta de Fourier [9]. La alta precisión, velocidad de respuesta y sincronización de tiempo hacen de las PMUs equipos apropiados para el monitoreo global en estado estable y dinámico, así como para aplicaciones en protección y control, como parte básica de un sistema de monitorio de área extendida [10]. La aplicación de estas herramientas es de especial relevancia en la operación del sistema eléctrico, con el fin de permitir a los operadores del sistema estar al tanto de los potenciales problemas de estabilidad oscilatoria. Esto puesto que la razón de amortiguamiento asociada a los modos dominantes del sistema puede variar significativamente dependiendo de diferentes factores, tales como la robustez de la red, el punto de operación de los generadores, condiciones de carga y las transferencias de energía asociadas a la congestión de la red [6]. Por lo tanto, la evaluación continua del amortiguamiento del sistema debe ser realizada con el fin de alertar aquellas condiciones de operación que podrían conllevar riesgos de estabilidad oscilatoria. 2.3. Algoritmos de identificación modal 3. EVALUACIÓN DE OSCILACIONES CON WAPROTECTOR Las oscilaciones pueden ser identificadas en señales eléctricas (medidas mediante PMUs adecuadamente distribuidas en el SEP), después de haberse producido una perturbación. Estas señales eléctricas se pueden descomponer en sus modos de oscilación utilizando técnicas de identificación modal, lo que es quizás la opción más apropiada para estimar rápidamente los parámetros asociados a los modos críticos del sistema, permitiendo tener una imagen clara del amortiguamiento real del sistema. En este sentido, se ha llevado a cabo un importante desarrollo de diferentes tipos de estimadores modales, que se pueden agrupar en métodos Ringdown (lineales), los llamados medidores de modo, y los métodos de análisis no lineal o no estacionario [1]. Los métodos Ringdown (como por ejemplo, el análisis Prony [7]) se basan en la suposición de que la señal bajo análisis puede ser representada por una suma de sinusoides amortiguadas. Ese tipo de señal puede ser registrada después de una gran perturbación (por ejemplo, añadir o eliminar grandes cargas, disparo de generadores, o cortocircuitos graves). Por el contrario, los medidores de modo están diseñados principalmente para datos “ambientales”, que resultan de pequeñas variaciones aleatorias del sistema alrededor de estados de equilibrio. Los medidores de modo se subdividen en métodos paramétricos y no paramétricos, procesamiento de bloques, y recursivos. Por otra parte, los métodos de análisis no lineal o no estacionarias, tales como, por ejemplo, la transformar Hilbert-Huang o transformada wavelet continua (CWT) [1], [7], [11], o incluso otros algoritmos desarrollados para este propósito, como el algoritmo propietario de WAProtector, pueden ser empleados para el seguimiento continuo de los atributos variables en el tiempo de los parámetros modales. Esta característica, los vuelve más robustos para su aplicación en tiempo real. WAProtector permite monitorear, en tiempo real, la composición modal de las señales de potencia activa registradas por cada una de las PMUs, a través de la aplicación de un algoritmo propietario de estimación modal. Esto con el objetivo de brindar al operador señales de alerta temprana que le permitan visualizar la ocurrencia de condiciones vulnerables para el sistema por inestabilidad oscilatoria. La Fig. 1 presenta los resultados de la aplicación de estabilidad oscilatoria de WAProtector para la señal de potencia activa registrada en la PMU instalada en la S/E Quevedo luego del disparo de la L/T Quevedo - San Gregorio de 230 kV ocurrido el 19 de abril de 2013 a las 18:56. Luego de este evento se registraron oscilaciones de potencia de gran amplitud entre las 18:56:54 y las 19:15:38, período en el cual estuvo desconectada la L/T. Figura 1: Evento Oscilatorio registrado por WAProtector Utilizando la aplicación de identificación modal se determinan los modos oscilatorios inmersos en la señal de potencia activa durante el periodo del evento, observándose la aparición de un modo local con una frecuencia de 1,918 Hz, un 183 amortiguamiento de 0.3% y una gran amplitud, del orden de 9,71 MW, el cual se resalta con rojo en la Fig. 1. Por tanto, este evento causó un fenómeno oscilatorio sostenido que fue alertado a los operadores a través del sistema WAMS. Adicionalmente, WAProtector permite realizar el cálculo promedio horario de los modos oscilatorios dominantes en amplitud, de acuerdo a su rango de frecuencia. El presente artículo presenta un análisis estadístico de la información obtenida a partir de estos datos, con el objetivo de caracterizar el comportamiento oscilatorio del SNI, el cual se presenta en las siguientes subsecciones. 3.1. Lineamientos básicos para el análisis de estabilidad oscilatoria WAProtector permite recuperar información de la frecuencia, el amortiguamiento y la amplitud de los modos oscilatorios en cada una de las PMUs. Esta información se procesa mediante herramientas que recopilan y organizan los datos por cada PMU y en cada hora. Con el objetivo de realizar un análisis sistémico de los modos oscilatorios en cada hora, éste debe contemplar a todas las áreas coherentes del sistema (puesto que en cada área coherente pueden presentarse modos particulares). Por tanto, es necesario analizar la información oscilatoria en todas las PMUs que se disponen en el sistema, en primera instancia; o en su defecto, determinar aquellas PMUs que brindan información redundante (es decir que están ubicadas en la misma área coherente) y analizar únicamente las que permiten observar modos diferentes. Esta información permitirá evaluar adecuadamente el comportamiento oscilatorio global del sistema. Del total de la información, se analizan únicamente los modos que presenten un amortiguamiento inferior al límite que establezca el estudio correspondiente. Sobre la base de este criterio, se ha usado como referencia aquellos modos que presentan valores inferiores al 5% (límite de alerta) y al 3% (límite de alarma). Así, se identifican y se resumen los modos cuyo amortiguamiento es inferior 3% o 5%, la hora en la que ocurrieron estas oscilaciones y la PMU que permitió su observación. De estos modos, se resaltan como referencia, aquellos cuyas amplitudes son de más de 1 MW (los valores de amplitud correspondientes para cada modo de oscilación se determinan posteriormente a través de un análisis estadístico, como se presenta más adelante). Es posible ahora identificar, según el rango de frecuencias, los modos poco amortiguados que mayormente se presentan, dónde son observables y en qué periodos de demanda se presentan como dominantes. Este análisis permite identificar aquellos modos que evidencian amortiguamientos bajos e incluso negativos, y que podría eventualmente conllevar a problemas de estabilidad del sistema, además de determinar la influencia en la excitación de estos modos de ciertas centrales hidráulicas, térmicas y estados operativos. Una vez determinados los modos oscilatorios más críticos, se procede a realizar un análisis más detallado de éstos, en las horas en las que las oscilaciones hayan sido determinadas. Por tanto, se requiere una búsqueda más exhaustiva, usando las aplicaciones gráficas de WAProtector, que permita encontrar un evento que dispare una oscilación, incluso cuando esta oscilación no sea de magnitud considerable. Resulta apropiado, además, determinar las centrales cuya desconexión dispara cierto tipo de oscilaciones en el sistema. 3.2. Análisis de estabilidad oscilatoria para la semana del 12 al 18 de agosto 2013 Con propósitos ilustrativos, se presenta el análisis estadístico de la información correspondiente al período del 12 al 18 de agosto de 2013. Del total de información, se analizan únicamente los modos que presentan un amortiguamiento horario promedio inferior al 5%, el cual se considera como el límite permitido de amortiguamiento para las oscilaciones que se presentan en el sistema nacional interconectado. Dentro de estos modos poco amortiguados se han determinado modos de control (0.01 – 0.1 Hz y mayores a 4 Hz), modos inter-área (0.1 – 0.7 Hz) y modos locales (0.7 Hz – 2.0 Hz). 3.2.1 Modos de control de muy baja frecuencia Se ha determinado, en el período de análisis, la existencia de modos de control poco amortiguados, ubicados en el rango de frecuencias entre 0.011 Hz y 0.099 Hz. Cabe destacar la presencia de diez modos que presentaron amortiguamientos negativos (resaltados con contorno rojo en la Fig. 2), indicando posibles riesgos de estabilidad oscilatoria en el sistema. 184 Tabla 1: Modos de control con amortiguamiento inferior al 3% Figura 2: Modos de control con amortiguamiento inferior al 5% Adicionalmente, se realiza un análisis estadístico de las amplitudes que alcanzaron los modos de control poco amortiguados durante el período de análisis. Los resultados arrojan que en el 48.54 % de los casos la amplitud es mayor a 2.84 MW y que la mayor amplitud fue de 6.84 MW. La Fig. 3 presenta el histograma de las amplitudes correspondientes a los modos de control en el período de análisis. 3.2.2 Modos de control de alta frecuencia En la Fig. 4 se observan modos oscilatorios en el rango de frecuencia 5.79 Hz – 5.87 Hz, particularmente en la zona de Quevedo, se estima que estos modos están asociados con modos de control producidos por la generación de la zona, lo cual se encuentra bajo análisis. Figura 3: Histograma de amplitudes de los modos de control poco amortiguados. La Tabla 1 presenta un resumen de los modos cuyo amortiguamiento fue inferior al valor crítico de 3%, la fecha y hora en la que ocurrieron estas oscilaciones, así como la PMU que permitió su observación. Es factible apreciar que estos modos de control se presentan especialmente en horas de demanda media, pero están presentes también en demanda máxima y mínima. Figura 4: Modos de control de alta frecuencia con amortiguamiento inferior al 5% La Fig. 5 presenta el histograma obtenido del análisis estadístico de las amplitudes que alcanzaron los modos de control de alta frecuencia poco amortiguados durante el período de análisis. De los 185 resultados se observa que en el 87.5 % de los casos, la amplitud es mayor a 0.25 MW y que la mayor amplitud fue de 0.35 MW. La Fig. 7 presenta el histograma obtenido del análisis estadístico de las amplitudes que alcanzaron los modos inter-área poco amortiguados durante el período de análisis. De los resultados se observa que en el 75.05 % de los casos, la amplitud es mayor a 1.34 MW y que la mayor amplitud fue de 5.56 MW. Figura 5: Histograma de amplitudes de los modos de control de “alta frecuencia” poco amortiguados La Tabla 2, presenta un resumen de los modos cuyo amortiguamiento fue inferior al valor de 3%. Es factible apreciar que estos modo de control de alta frecuencia, se presentan especialmente en horas de demanda media, y son observables solamente en la zona de Quevedo. Tabla 2: Modos de control de “alta frecuencia” con amortiguamiento inferior al 3 % Figura 7: Histograma de amplitudes de los modos inter-área poco amortiguados La Tabla 3 presenta un resumen de los modos interárea con valores de amortiguamiento inferiores al 2.1% (menores al 3% existen 264 modos). En esta tabla, se aprecia que el “modo inter-área” se presenta el día 18 de agosto del 2013, en horas de demanda baja y media, y son observables en la zona norte (Pomasqui, Santa Rosa y Totoras), por la presencia de oscilaciones entre el sistema ecuatoriano y el sistema colombiano, además es observable también en Milagro, lo que sugiere una posible partición interna del SNI en dos áreas eléctricas. Tabla 3: Modos inter-área con amortiguamiento inferior al 2.1% 3.2.3 Modos inter-área Se determina la existencia de modos inter-área poco amortiguados en el rango de frecuencia de 0.42 Hz – 0.62 Hz, como se observa en la Fig. 6. Figura 6: Modos inter-área con amortiguamiento inferior al 5% 186 3.2.4 Modos locales Tabla 4: Modos locales con amortiguamiento inferior al 5% En el período de estudio, se determina la presencia de 21 modos locales poco amortiguados, con una frecuencia de 0.93 a 1.85 Hz, como muestra la Fig. 8. La Fig. 9 presenta el histograma obtenido del análisis estadístico de las amplitudes que alcanzaron los modos locales poco amortiguados durante el período de análisis. De los resultados se observa que en el 95.23 % de los casos, la amplitud es mayor a 4.08 MW y que la mayor amplitud fue de 15.85 MW. 3.2.5 Análisis de resultados En el período de análisis, se ha determinado que en el SNI existen cuatro tipos de modos oscilatorios poco amortiguados: de control de muy baja frecuencia, de control de alta frecuencia, inter-área y locales. Los modos oscilatorios son dominantes en determinados períodos del día, de la siguiente forma: Figura 8 Modos locales detectados Modo de control de muy baja frecuencia: períodos de demanda media. Modos de control de alta frecuencia: períodos de demanda media. Figura 9: Histograma de amplitudes de los modos locales poco amortiguados La Tabla 4 presenta un resumen de los modos locales con valores de amortiguamiento inferiores al 5% (no existieron modos con amortiguamiento menor al 3%). En esta tabla, se aprecia que el “modo local” se presenta el día 17 de agosto del 2013, en horas de demanda media, pero están presentes también en demanda baja con amplitudes altas. Modos inter-área: períodos de demanda baja y media. Modos Locales: períodos de demanda media. Figura 10: Modos Locales PMU Totoras-Santa Rosa, para el 17-08-2013 187 Debido a que las PMUs no se encuentran instaladas en las subestaciones de generación, no es posible observar totalmente el comportamiento dinámico de las unidades ubicadas en la zona de influencia de los modos de oscilación. Adicionalmente, ya que el evento presentado en la Fig. 10 se caracterizó por oscilaciones sostenidas por alrededor de 20 min, se ha considerado usar los datos del histórico del EMS con el objetivo de determinar las fuentes de oscilación, puesto que las oscilaciones se debieron registrar al menos a manera de variaciones bruscas en las potencias de generación inyectadas. La Fig. 11 presenta los datos obtenidos del SCADA correspondientes a las potencias de generación, en por unidad, de las Centrales Agoyán, San Francisco y Paute. Es posible apreciar que las Centrales Agoyán y Paute oscilan entre ellas. La central San Francisco, no participó del evento oscilatorio. En este sentido, el evento oscilatorio local registrado se debió a un modo de la Central Agoyán, excitado luego de la apertura del ATT de Totoras debido al incremento de la impedancia entre Agoyán y el SNI. La información estadística de modos oscilatorios se utiliza, adicionalmente, para determinar los límites de amplitudes que serán utilizados como referencia de alerta temprana (early-warning) para la supervisión en tiempo real. Esta información será usada como entradas de la aplicación de monitoreo en tiempo real como límites de alerta y alarma. Con la información estadística descrita en el apartado 3.2, se determinan los límites de amplitudes en base a los valores medios (µ), la desviación estándar (σ) y el criterio de que al menos el 50% de los valores analizados deberían quedar incluidos dentro del intervalo de la desviación estándar en torno de la media (µ ± σ), mientras que el 75% de los valores analizados deberían quedar incluidos dentro del intervalo abarcado por el doble de la desviación estándar (µ ± 2σ). Este criterio se conoce como la desigualdad de Chebyshev [12]. Así, se han determinado los siguientes valores como límites de alerta y alarma para la magnitud de las oscilaciones registradas en el SNI, para los modos de control de baja frecuencia, inter-área y locales, los cuales se presentan en la Tabla 5. Para el caso de los modos de control de alta frecuencia, su origen se encuentra actualmente en análisis, por lo que no se ha definido aún los correspondientes límites de seguridad. Figura 11: Oscilaciones de potencia de las Centrales Agoyan, San Francisco y Paute para el 17-08-2013 de 5:55 a 6:15 Tabla 5: Límites de amplitud de oscilaciones para el SNI El día 18 de agosto no se programa importación de energía desde el sistema colombiano, pero se exportó 1792 MWh hacia el sistema colombiano por el enlace de 230 kV y Paute operó con 9 máquinas disponibles. Este día se observa que durante el período que se exporta a Colombia, la excitación del modo inter-área presenta oscilaciones sostenidas con amortiguamientos menores al 3% y amplitudes de hasta 5.56 MW. Adicionalmente, el estado operativo del SNI fue 76 % de generación hidráulica, 24 % generación térmica. La Fig. 12 presenta el evento oscilatorio inter-área descrito Fi g Figura 12: Modos Inter-área PMU: Pomasqui-Jamondino 2, para el 18-08-2013 3.3. Parametrización de los límites para las amplitudes de los modos oscilatorios 4. CONCLUSIONES Y RECOMENDACIONES Con la implementación del sistema WAMS y los análisis post-operativos realizados, ha sido posible identificar el comportamiento dinámico del sistema, determinar zonas coherentes de influencia oscilatoria, máquinas que participan en las oscilaciones, estados operativos que influyen los modos de oscilación y ciertos comportamientos dinámicos que antes no eran visibles con el tradicional sistema SCADA/EMS. Esto marca el inicio del proceso de caracterización del sistema de potencia, lo que permitirá definir los límites reales de alertas y alarmas para los diferentes módulos de detección. Estos análisis conducirán a la determinación de recomendaciones operativas sobre cómo actuar al presentarse ciertos eventos en el SNI, con el objetivo 188 de mejorar considerablemente los criterios y forma de operar y mejorar así la seguridad en su operación. Con la disponibilidad actual de PMUs impide observar totalmente el comportamiento de las unidades de generación ubicadas en ciertas zonas de influencia de los modos de oscilación, por lo que se recomienda incluir nuevas PMUs, definiendo su ubicación, sobre la base de los criterios técnicos y los análisis realizados. Los análisis han permitido observar en la zona de Quevedo, la presencia de modos poco amortiguados de control de alta frecuencia. Para determinar su origen, se está realizando un análisis multi-variante, en base al despacho real diario de las máquinas, de tal manera de determinar patrones que permitan identificar la participación de estas en la excitación de los diferentes modos oscilatorios, con el fin de determinar su origen y sugerir acciones de control adecuadas, como pueden ser la revisión de los reguladores de voltaje de las unidades de las centrales y la activación de PSSs en centrales de generación de la zona. Los resultados se presentarán en trabajos futuros. Se ha observado que ciertos estados operativos y topológicos, excitan determinados modos oscilatorios, como por ejemplo la exportación a Colombia, los porcentajes de generación hidroeléctrica y térmica, la operación de ciertas máquinas, la apertura de ciertos elementos del SNI, entre otros. Análisis más especializados (como el multi-variante) permitirán identificar estados operativos potencialmente peligrosos y sugerir recomendaciones para la planificación y operación del SNI. Futura investigación es necesaria para llegar a término este objetivo. REFERENCIAS BIBLIOGRÁFICAS [1] IEEE PES Power System Dynamic Performance Committee (2012). “Identification of Electromechanical Modes in Power Systems”. [2] Hoballah, A. & Erlich, I. (2012). “Online marketbased rescheduling strategy to enhance power system stability”, IET Generation, Transmission & Distribution, pp. 30–38. [3] Li, Y. & Venkatasubramanian, V. (2004). “Coordination of transmission path transfers”, IEEE Transactions on Power Systems, pp. 16071615. 189 [4] Rueda J., Guamán W., Cepeda J., Erlich I. & Vargas A. (2013). “Hybrid Approach for Power System Operational Planning with Smart Grid and Small Signal Stability Enhancement Considerations”, IEEE Transactions on Smart Grid, March 2013. [5] Condren, J. & Gedra, T. W. (2006). “Expectedsecurity-cost optimal power flow with smallsignal stability constraints”, pp. 1736-1743. [6] Teeuwsen, S. P. (2005). “Oscillatory Stability Assessment of Power Systems using Computational Intelligence”. Tesis de Doctorado, Universität Duisburg-Essen, Germany. [7] Juárez C. & Colomé D. (2009). “Tendencias en la Supervisión en Tiempo Real de la Estabilidad de Pequeña Señal de Sistemas de Potencia”, XIII ERIAC, mayo de 2009, Puerto Iguazú, Argentina. [8] Kundur P. (1994). “Power System Stability and Control”, McGraw-Hill, Inc. [9] Cimadevilla R. (2009). “Fundamentos de la Medición de Sincrofasores”. XIII ERIAC, Puerto Iguazú, Argentina. [10] Martinez C. Parashar M., Dyer J., & Coroas J. (2005). “Phasor Data Requirements for Real Time Wide-Area Monitoring, Control and Protection Applications”, White Paper – Final Draft, for: EIPP – Real Time Task Team. [11] Rueda J., Juárez C. & Erlich I. (2012). “Waveletbased Analysis of Power System Low-Frequency Electromechanical Oscillations,” IEEE Transactions on Power Systems, pp. 118 – 133. [12] Han J. & Kamber M. (2006). “Data Mining: Concepts and Techniques”, second edition, Elsevier, Morgan Kaufmann Publishers. Jaime Cristóbal Cepeda.- Recibió el título de Ingeniero Eléctrico en la Escuela Politécnica Nacional en 2005 y el de Doctor en Ingeniería en la Universidad Nacional de San Juan en 2013. Entre 2005 y 2009 trabajó en Schlumberger y en el CONELEC. Colaboró como investigador en el Instituto de Energía Eléctrica, Universidad Nacional de San Juan, Argentina y en el Instituto de Sistemas Eléctricos de Potencia, Universidad DuisburgEssen, Alemania entre 2009 y 2013. Actualmente, se desempeña como Jefe de Investigación y Desarrollo del CENACE. Sus áreas de interés incluyen la evaluación de vulnerabilidad en tiempo real y el desarrollo de Smart Grids. Aharon Bhawan De La Torre.Recibió el título de Ingeniero Eléctrico en la Universidad Politécnica Salesiana en 2013, entre 2012 y 2013 trabajó en el Área de Sistemas de Tiempo Real en la Dirección de Sistemas de Información de la Corporación CENACE, en la implementación del sistema WAMS del S.N.I. Actualmente se desempeña como administrador funcional del sistema WAMS y forma parte del Área de Análisis de la Operación en la Dirección de Operaciones de la Corporación CENACE, encargado del desarrollo y actualización de los procedimientos para la inclusión de la información del sistema WAMS en los procesos del área.. 190 Análisis del sistema de alarmas del EMS del CENACE W.P. Gamboa C.S. Erazo Centro Nacional de Control de Energía, CENACE Resumen— El propósito del siguiente artículo es investigar sobre las normativas relacionadas con el manejo y gestión del sistema de alarmas, para con esa base realizar una comparación con el sistema de alarmas del EMS del CENACE. Las normativas EEMUA 191 y la ANSI/ISA-18.2 recomiendan metodologías para la gestión de las alarmas y proporcionan índices referenciales de desempeño. Para calcular esos índices se realizó el análisis estadístico de las alarmas desplegadas al operador del CENACE por un lapso de 30 días y al compararlos con los índices recomendados se determinó que el EMS del CENACE está fuera de los límites que recomiendan las normas anteriormente citadas. Por lo que se propone ciertas sugerencias para la reducción del número de alarmas desplegadas y así encaminarse a las buenas prácticas de ingeniería recomendadas en la normativa de referencia. Palabras clave— Alarmas, EMS, inundación de alarmas. Abstract— The purpose of this article is to investigate regulations related to alarm system use and management, in order to perform a comparison with the CENACE’s EMS alarm system. Regulations EEMUA 191 and ANSI/ISA-18.2 recommend methodologies for alarm management and provide referential performance indexes. In order to calculate such indexes, a statistical analysis of CENACE alarms was performed over a period of 30 days and upon comparison with recommended indexes, it was determined that the CENACE’s EMS alarms were not within the aforementioned recommended limits. Therefore, certain suggestions were proposed for reducing the number of deployed alarms and thus meet the good engineering practices recommended by the referenced regulations. Index Terms— Alarms, EMS, Alarm Flood. 1. INTRODUCCIÓN Uno de los factores en común entre las industrias petroleras, químicas, farmacéuticas, mineras, generadoras de energía eléctrica, de gas, refinerías, entre otras, es que tienen un centro de control donde el operador está monitoreando los procesos y presto para responder a las alarmas que puedan presentarse y retornar a condiciones normales el o los procesos que tienen alguna perturbación. Pero estas alarmas, si no son manejadas adecuadamente, en vez de ayudar a la supervisión de la planta dan lugar a que el operador ante una gran cantidad de alarmas pase por alto la alarma que está originando el problema y con esto las acciones remediales tomen un tiempo mayor al establecido, provocando daños y pérdidas cuantiosas. La explosión en la refinería Texaco en Milford Haven en 1994 o el accidente ocurrido en la planta de gas Longford de Esso en 1998 son algunos ejemplos de incidentes donde el sistema de alarmas fue determinante que en el desenvolvimiento de los hechos que terminaron en destrucción de las instalaciones de la planta, afectación al medio ambiente, pérdidas económicas y pago de multas. Por ejemplo los operadores de Milford Haven descuidaron el sistema de alarmas debido a que este representaba más un obstáculo que una ayuda [6]. Los centros de control de energía eléctrica no están exentos del monitoreo de variables y el manejo de alarmas y estos son de suma importancia ya que la identificación y una reacción oportuna a cierta alarma puede evitar el colapso de varias subestaciones y disminuir el tiempo de corte del suministro eléctrico a la ciudadanía y reducir todos los problemas y costos que ocasionan los apagones. 2. NORMATIVA RELACIONADA La gestión de alarmas es un tema de importancia para las industrias indicadas anteriormente, por lo que se han realizado varias investigaciones utilizando técnicas como de árboles de decisión, ontologías, lógica difusa, sistemas expertos entre otros con la finalidad de conseguir un manejo óptimo de alarmas. Adicionalmente los organismos pertinentes estaban en busca de una estandarización de temas referentes al manejo de alarmas, por lo que en 1999 en Europa la EEMUA (Engineering Equipment and Material Users Association) emite su norma EEMUA 191 Alarm Systems, A Guide to Desing, Management and Procurement con una revisión en el año 2007. Mientras 191 que para el año 2009 ISA (International Society of Automation) en Estados Unidos se da a conocer la norma ANSI/ISA-18.2-2009 Management of Alarm Systems for the Process Industries. • En número de alarmas durante los primeros 10 minutos de una perturbación debe ser inferior a 10. • La distribución recomendada en la asignación de prioridades en las alarmas debe ser: 5% para alta prioridad, 15% para prioridad media y 80% para baja prioridad. • El promedio de alarmas permanentes debe ser menor a 10. 2.1. Descripción breve de la norma EEMUA 191 EEMUA 191 es un conjunto de directrices para la gestión de alarmas, pero sus recomendaciones no son obligatorias. Sin embargo, el documento describe buenas prácticas y es utilizado por varios organismos reguladores. [1] En [2] se indican ciertos fundamentos básicos que sigue esta normativa, en ellos se destaca que las alarmas tienen atributos clave como los siguientes • • • • Deben alertar, informar y guiar. Deben ser útiles y relevantes Cada alarma debe tener una respuesta definida Deben tener un tiempo adecuado para permitir que el operador realice la respuesta definida. • El sistema de alarmas debe ser diseñado tomando en cuenta las limitaciones humanas. También recomienda las características que debe cumplir una buena alarma, y estas son • Relevante, que no se muestren alarmas falsas o de bajo nivel. • Única, que no existan alarmas duplicadas. • Oportunas, que no se presenten alarmas muy anticipadamente al tiempo necesario para responder o que se presenten alarmas muy tarde cuando ya no se puede hacer nada para controlarla. • Priorizadas, que indique la importancia para que el operador sepa a cuál reaccionar primero. • Entendible, que se muestre un mensaje claro y fácil de entender. • Capacidad de diagnóstico, que identifique el problema que está sucediendo. • Asesore, que indique la acción que el operador debe tomar. • Enfoque, que llame la atención sobre los temas más importantes. 2.1.1 Indicadores de la norma La EEMUA 191 propone los siguientes indicadores para la evaluación del sistema de alarmas. • El promedio de alarmas a largo plazo en la operación continua debe ser menor a una alarma cada 10 minutos. Si se contabiliza una mayor cantidad de alarmas a las mencionadas en los anteriores indicadores se dice que se tiene una inundación de alarmas. Los periodos de inundación de alarmas arrancan cuando se tiene más de 10 alamas en 10 minutos y termina en el periodo cuando se tenga 5 o menos alarmas en 10 minutos. Las inundaciones pueden durar horas y abarcar miles de alarmas [11]. EEMUA ofrece una metodología asequible para la gestión de alarmas, donde se debe seguir los siguientes pasos [1]. 2.1.2 Patrón de referencia Primero se debe recopilar la información referente a las alarmas desplegadas en el centro de control para su posterior análisis estadístico. Se debe medir el número promedio de alarmas en una hora y el número máximo de alarmas en una hora para graficarlos y determinar el patrón de gestión de alarmas. También se deben realizar las mediciones para evaluar los índices detallados en 2.2.1. Una vez reunida toda la información para la evaluación e identificación del actual sistema de alarmas se pueden tomar las medidas y estrategias para llevar al sistema de alarmas a un nivel adecuado. 2.1.3 Desarrollo de un concepto de alarmas Debe existir o crear un documento en el cual se defina la metodología y las reglas de constitución de las alarmas y el esquema de priorización. Este documento también debe describir claramente las funciones y la asignación de las responsabilidades de los operadores ante la ocurrencia de una alarma. 2.1.4 Supresión de alarmas molestas Se llama alarmas molestas a las alarmas que no cumplen con los atributos o con las características de una 192 alarma que se detallaron anteriormente, en resumen son las alarmas que no presentan ningún valor al operador. Al identificar y eliminar estas alarmas moletas se puede reducir considerablemente la cantidad de alarmas, ya que las alarmas molestas por lo general son las que se despliegan con mayor frecuencia. No todas las alarmas molestas deben ser eliminadas, algunas pueden pasar a formar parte de los eventos. 2.1.5 Racionalización de alarmas Se debe realizar una revisión a las alarmas para verificar que cumplan con lo estipulado en el concepto de alarmas que se realizó en 2.2.3. Con esto se puede modificar los ajustes de cada alarma como límites, bandas muertas, cambio de prioridad, entre otros. En EEMUA 191 se propone una metodología para la valoración general de alarmas como se muestra en la Fig. 1, en donde se evalúan las alarmas y se determinan si necesitan modificaciones en sus ajustes, cambio de nivel de prioridad o la eliminación de la base de alarmas. 2.1.6 Mejora continua Debido a que las condiciones en las plantas son variables y sufren cambios que afectan a los procesos se debe evaluar constantemente el sistema de alarmas y vincular esta evaluación a los procedimientos que se manejen habitualmente en los centros de control. 2.2. Descripción breve de la norma ANSI/ISA18.2 En 2003 ISA inició la investigación para el desarrollo de una normativa para los sistemas de alarmas con la participación de muchas empresas y finalmente publicó la normativa 18.2 en el 2009. Figura 1: Valoración general de alarmas EEMUA 191 [2] generally accepted good engineering practices) además que está basado en los aportes de otras normas y directrices como EEMUA 191, NAMUR NA 102 y ASM. En esta normativa se define a una alarma como: es un medio audible y/o visible para indicar al operador de un mal funcionamiento de un equipo, la desviación de un proceso o una condición anormal que requiere una respuesta [4]. La gestión del sistema de alarmas es un proceso que requiere una continua atención y para esto la ISA-18.2 propone la metodología de los ciclos de vida de la alarma, que están divididos en 10 pasos como se muestra en la Fig. 2. 2.2.1 Filosofía de alarmas Es el documento que especifica los objetivos y los requerimientos y reglas para la desarrollar la gestión del sistema de alarmas. En el mismo deben incluirse: ISA-18.2 proporciona un marco para un satisfactorio diseño, implementación, operación y gestión de los sistemas de alarmas para plantas de proceso [3]. Y es considerada como RAGAGEP (recognized and 193 • Definición de alarma, clasificación de alarmas, determinación de prioridades. • Roles y responsabilidades de los involucrados con el manejo de alarmas • Requisitos de la racionalización de alarmas. • Diseño de las alarmas. • Reglas para el almacenamiento y eliminación de alarmas. • Requerimientos para el sistema de monitoreo de alarmas • Definiciones de la gestión de cambio. • Entrenamiento. En la creación de la filosofía de alarmas debe estar los involucrados con el manejo de alarmas y formar un comité y de ser posible con la participación de un experto en el tema. • Determinar el adecuado punto de calibración, condición lógica, bandas muertas y límites de la alarma. • Determinar la correcta prioridad de la alarma. • Documentar alguna especificación especial para el diseño de una alarma. • Determinar el número mínimo de puntos de alarma para mantener el proceso seguro y bajo control. • Documentar cualquier capacidad avanzada de alarmas que se desea para cierta alarma. • Documentar información relevante como: causa, acción recomendada para el operador, el tiempo razonable de acción del operador, consecuencias de la falta de respuesta oportuna del operador para cada alarma. Se realizarán varios borradores hasta que surja el documento final, que periódicamente debe ser revisado para posibles modificaciones de mejora. 2.2.2 Identificación Esta etapa trata de los diferentes métodos existentes que ayuden a identificar la necesidad de una alarma para cierto proceso. Las fuentes para la detección de estas potenciales alarmas pueden ser: las revisiones de procedimientos de operación, recomendaciones de investigaciones de incidentes, auditorías o de estudios especiales como Análisis de Procesos Peligrosos (PHA), Análisis de Protección por Capas (LOPA) y Análisis de modo falla y sus efectos (FMAE), entre otros. Luego de todas las evaluaciones se debe volver a verificar que las prioridades de las alarmas están alineadas con las consecuencias de la falta de reacción del operador, los límites de las alarmas permite que haya tiempo adecuado para la respuesta del operador y si se ha identificado la acción razonable y observable del operador. 2.2.4 Diseño detallado Este ciclo está dedicado al entendimiento de las capacidades y limitaciones del sistema de control de los procesos. Se puede dividir en el diseño básico de alarmas, el diseño de la interfaz Hombre – Máquina HMI y el diseño avanzado de alarmas. En el diseño básico se puede configurar las bandas muertas para una alarma, los tiempos de espera antes de mostrar una alarma, la optimización de alarmas desplegadas al configurarlas como grupo y de más opciones de fácil programación que tenga implementado el sistema de control. Figura 1: Valoración general de alarmas EEMUA 191 [2] 2.2.3 Racionalización La racionalización es un conjunto de evaluaciones aplicadas a las alarmas existentes y las potenciales alarmas para determinar si cumple con su función. Las principales actividades dentro de la racionalización de alarmas son:. • Asegurar que la alarma cumpla con los criterios planteados en la filosofía de alarmas. • Justificar la necesidad de esta alarma. • Señalar las alarmas que se van a eliminar, pues no deberían existir ya que no necesitan respuesta del operador o están duplicadas. • Determinar apropiadamente el tipo y la clase de alarma. El diseño del HIM debe ser de tal forma que ayude al operador a detectar, diagnosticar y responder ante una alarma en un tiempo prudencial. Por lo que el uso de colores, fuentes, dibujos debe ser el adecuado para que no afecte el desempeño del operador. Igualmente se debe diseñar el esquema de alarmas audibles ya que para diferente alarma puede haber un sonido característico y en otros casos no presentarse ninguno. También se debe tomar en cuenta la manera como las alarmas se van a mostrar en relación a su prioridad y clase, la forma de reconocimiento de las alarmas así como su método de archivo y presentación de las alarmas de equipos fuera de servicio. 194 Para el diseño avanzado de alarmas se utiliza técnicas que ayuden a mejorar el rendimiento del sistema de alarmas y así garantizar que al operador se le van a presentar alarmas solo cuando estas sean relevantes. Estas técnicas mediante programación, modelamiento y uso de capas lógicas modifican dinámicamente los atributos de las alarmas para ocultarlas y mostrar las relevantes. Dentro de estos métodos avanzados de alarmas se puede indicar entre otros los siguientes: alarmas basadas en modelos, matriz de estado y en lógica, supresión de alarmas basado en agrupamiento, por limitación de tiempo, por conteo y por modificación lógica de atributos. 2.2.5 Implementación En esta sección se trata acerca de las actividades a realizarse por la implementación de un nuevo sistema de alarmas o la implementación de los cambios determinados en las etapas anteriores. Las actividades a desarrollarse son dos, las pruebas y verificación de los cambios realizados en el sistema de alarmas. Y la segunda es el entrenamiento a los operadores para que se familiaricen con los cambios o nuevas técnicas implantadas y con esto se promueva la confianza de los operadores en el sistema de alarmas. Estas dos actividades deben ser adecuadamente documentadas. 2.2.7 Mantenimiento Es el estado cuando una alarma sale fuera de servicio para repararla, reemplazarla o por pruebas. La norma indica los procedimientos y la documentación necesaria para sacar de servicio una alarma y las pruebas previas para su vuelta en servicio. Adicionalmente como medida de seguridad se requiere que el sistema sea capaz de mostrar una lista con todas las alarmas en mantenimiento, para que el operador antes de poner en funcionamiento un equipo verifique que las alarmas del mismo se encuentran en servicio. 2.2.8 Seguimiento y evaluación En esta parte se describe como analizar el desempeño del sistema de alarmas en comparación con los indicadores recomendados por la norma, estos se muestran en la Tabla 1. En resumen en una base de por lo menos 30 días se contabiliza el número de alarmas que se presentan en 10 minutos, una hora y en el día. Y se estipula un número aceptable y máximo de alarmas para que un operador pueda responder de manera adecuada y si esta cantidad supera los valores referenciales se considera que existe una inundación de alarmas. 2.2.6 Operación Tabla 1: Mediciones de desempeño de alarmas ISA-18.2 [3z La norma indica las herramientas recomendadas para el manejo de las alarmas durante la operación. Una de esta es el archivo de alarmas que permite al operador ocultar momentáneamente alarmas de menor categoría para quedarse con las importantes y luego de un tiempo establecido estas alarmas archivadas vuelven a aparecer para la gestión del operador. Para esta etapa debe estar disponible del procedimiento de respuesta a alarmas, documento que fue realizado en la racionalización y contiene información de la causa, acción recomendada, consecuencia de la inacción y el tiempo de respuesta del operador ante una alarma. Esta información de preferencia debería poder ser desplegada en línea. Finalmente dentro de la operación se recomienda un plan de entrenamiento para refrescar conocimientos y procedimientos en el tema de manejo de alarmas. También se recomienda que solo existan tres o cuatro niveles de prioridades, para el caso de tres sería: 80% prioridad baja, 15% prioridad media y 5% prioridad alta. Mientras si se tiene cuatro niveles estas se distribuiría en: 80% baja, 15% media, 5% alta y menor al 1% súper alta prioridad. 195 Con el análisis estadístico se puede determinar cuáles alarmas están saliendo en mayor cantidad para investigarlas y catalogarlas como alarmas falsas, fugases u obsoletas que pueden ser eliminadas con facilidad siguiendo la metodología de esta norma. Por ejemplo para la potencia aparente en los transformadores se indica que la alarma está configurada al 95% del valor de operación continua declarado por el agente, que tendrá una histéresis de 2 MVA, una prioridad 1, se mostrará en color rojo y con sonido. 2.2.9 Gestión de cambio Para el caso de voltajes de barra de 230 kV se cuenta con dos niveles de alarma, para alto voltaje High 1 en el valor del voltaje nominal (Vn) y el High 2 en 1,03Vn. Mientras que para bajo voltaje el nivel Low 1 está al 0,96Vn y el Low 2 al 0,95Vn. Estas alarmas están en prioridad 2, con sonido y los niveles High 1 y Low 1 se mostrarán en color amarillo mientas que los niveles High 2 y Low 2 están en color rojo. Determina el uso de herramientas y procedimientos para garantizar que las modificaciones al sistema de alarmas queden revisadas y aprobadas antes de su implementación. El HMI debe permitir visualizar un registro histórico de los cambios realizados a los parámetros de las alarmas donde se informe la fecha, el número de cambios, los valores de configuración y el usuario que realizó esta actualización. Con esto se asegura que solo el personal autorizado realice los cambios y se pueda detectar si otro usuario realizó un cambio. 2.2.10 Auditoría Es la última parte del ciclo de vida de las alarmas, aquí se realizan periódicamente una revisión global del sistema de alarmas, de todos los documentos, procedimientos formulados a lo largo del ciclo de vida y la manera en que estos están siendo aplicados se ciñen a las condiciones cambiantes de la planta. Las novedades encontradas en la auditoría serán reflejadas en la modificación de la filosofía de alarmas y así empieza nuevamente el proceso de mejora continua en el sistema de alarmas. 3. DIAGNOSTICO DEL SISTEMA DE ALARMAS DEL CENTRO DE CONTROL DEL CENACE El EMS del CENACE cuenta con un sistema de alarmas que tiene la capacidad de 8 niveles de prioridades de los cuales se utiliza 5 niveles, se tiene 9 clases de alarmas y cuatro tipos de categorías de alarmas. En lo referente a la presentación en el HMI las alarmas se muestran en colores de acuerdo a su clase, categoría y prioridad. Se cuenta con un historiador de alarmas donde se puede buscar y filtrar de acuerdo al requerimiento necesario. En [10] se tiene una referencia de como están configuradas las alarmas del EMS del CENACE. En este se definen las prioridades, número de límites, histéresis, color y sonido de la alarma a mostrarse, valor de la alarma. Las alarmas referidas al AGC (Control Automático de Generación) pueden estar en prioridad 1 y 2, las dos se desplegarán en color azul y solo la prioridad 1 tiene sonido. Para la apertura de disyuntores se clasifica de dos formas: automática y manual. Si la apertura es automática, es decir, debido a la actuación de las protecciones la prioridad es 1, color rojo y tiene sonido. Mientras que si la apertura es dada vía comando o manual desde el patio su prioridad es 2, en color celeste y sin sonido. Y así el documento detalla las alarmas para el resto de elementos del sistema eléctrico de potencia. Debido a que el documento es antiguo (2007) y no se ha dado el seguimiento del caso, lo escrito en el mismo dista mucho del actual sistema de alarmas. Por ejemplo en [10] se indica solo un nivel de alarmas para la potencia aparente en los puntos de entrega mientras que en la actualidad se tiene 3 niveles. Otro es que lo estipulado para la apertura de disyuntores no se está cumpliendo, las aperturas manuales o automáticas tienen igual prioridad, color y sonido. También no se han ejecutado los cambios solicitados, por ejemplo se pide que no se desplieguen las alarmas de prioridad 8 a los operadores, actualmente se tiene habilitada esta prioridad que llena la pantalla de con alarmas inútiles al operador. 3.1. Acción de mejora Una vez detallado de forma rápida el sistema de alarmas se propone seguir las recomendaciones brindadas por las normas EEMUA 191 y ANSI/ISA-18.2 y que son aplicables a un centro de control del sistema eléctrico de potencia. Las actividades propuestas serían. 196 • Medición del patrón de referencia. • Creación del concepto o filosofía de alarmas. • Identificación y racionalización. • • • • • Diseño e implementación. Operación y mantenimiento. Seguimiento y evaluación. Gestión de cambio. Auditoría. El alcance del presente artículo es exponer las mediciones realizadas a las alarmas que se muestran en el centro de control y proponer ciertas pautas para la filosofía de alarmas en busca de reducir la cantidad de alarmas desplegadas. 3.2. Medición del patrón de referencia Se ha recopilado la información necesaria para encontrar el patrón de gestión de alarmas y luego calcular los índices recomendados. Los resultados del análisis realizado para los 30 días del mes de agosto de 2013 se muestran a continuación. Figura 4: Número de alarmas por día La norma ISA-18.2 recomienda que se tenga de manera aceptable 6 alarmas y como máximo 12 en un hora. Pero se halló que las alarmas por hora son mucho mayores que ese valor, el valor mínimo es de 224 muy lejano de 12. En la Fig. 5 se muestra lo descrito. Número promedio de alarmas por hora 100000 10000 6000 IMPOSIBLE Sobre cargado 1000 600 100 Reactivo 60 10 6 1 Robusto Estable Figura 5: Número de alarmas por hora Predictivo 10 600 6000 100 1000 10000 Máximo número de alarmas por hora Punto de operación del sistema de alarmas 6 100000 Figura 3: Patrón de gestión de alarma para el CENACE Finalmente para el índice de número de alarmas cada 10 minutos los resultados no varían como se ve en la Fig. 6 y se tiene valores considerablemente mayores a los recomendados por la norma que son 1 y máximo 2. El valor mínimo encontrado es de 19. En la Fig. 3 se muestra el patrón de gestión de alarmas propuesto por la EEMUA 191, donde se puede observar que el sistema de alarmas del CENACE está más cerca del lado imposible de responder a las alarmas que del lado robusto o estable que es manejable. Con esta información se debe tomar medidas para la reducción de alarmas y tratar que el punto de operación del sistema de alarmas esté entre robusto y predictivo que es la recomendación de la EEMUA 191. Otro indicador que se calculó es el número de alarmas mostradas por día. La ISA-18.2 recomienda que las alarmas sean 150 como aceptables y hasta 300 como máximo manejable. En la Fig. 4 se muestra la contabilidad de las alarmas en el día y se observa que nunca se tiene los valores recomendados, el valor mínimo contabilizado es de 10 620 alarmas. Figura 6: Número de alarmas por cada 10 minutos Otro valor recomendado por ambas normas es el porcentaje asignado a cada prioridad. En el EMS del CENACE se utilizan 3 prioridades (1, 2 y 3) y una adicional que es la 8 para información del EMS que no se utiliza en la operación. En la Fig. 7 se indica los resultados. 197 • Se debe agrupar las alarmas para que en el caso de la actuación de un esquema de protección sistémico (EPS) que abra varias posiciones la alarma que aparezca sea la actuación del EPS y no todas las posiciones abiertas. Y si alguna posición no actúa como indica el EPS también debería salir como alarma. • Igualmente se debería zonificar las alarmas de voltaje, ya que ante una falla considerable la zona aledaña es la que se ve afectada en el voltaje, así si todas las subestaciones censan voltaje fuera de rango se tendría una alarma zonal que indica la falla y no varias alarmas de cada subestación a causa de la misma falla. • Las aperturas y cierres de disyuntores que se dan debido a la coordinación de maniobras, es decir, son vía comando desde el centro de control o de forma manual desde el patio de una subestación no deben ser consideradas alarmas sino eventos de la operación normal del sistema. La misma consideración se la debería de dar para maniobras en el AGC. • Los límites de voltaje en las barras debe estar en concordancia con el estudio “Informe de bandas de voltaje SNT” que anualmente realiza DPL. • Documentar el plan de acción por parte de los operadores y supervisor ante la ocurrencia de una alarma. • Definir una filosofía de alarmas para que esta sea aplicada en la actualización del EMS. Figura 7: Proporción de prioridades Finalmente se realizó un estudio para ver que subestación o instalación es la que genera mayor cantidad de alarmas. En la Fig. 8 se ve que con 4 subestaciones se generaron el 56% de las alarmas. Figura 8: S/E con alarmas más frecuentes 3.3. Sugerencias para la filosofía de alarmas En base al análisis anterior se puede dar las siguientes sugerencias para que formen parte de la filosofía de alarmas. • Conformar un grupo permanente que esté encargado del seguimiento del sistema de alarmas, este grupo debería estar conformado principalmente por personal de la sala de control y del área de tiempo real. • Revisar las subestaciones que generan más alarmas para identificar que alarma de estas es la que genera la avalancha de alarmas. • Se debe cambiar los límites máximos a las barras donde se conecta generación, ya que en periodos de demanda media y máxima se maximiza la potencia reactiva de estas centrales y se tiene gran cantidad de alarmas de alto nivel de voltaje. • Cuando una posición salga a mantenimiento debería ser posible que sus alarmas salgan también fuera de línea, ya que en estas posiciones se hace pruebas de apertura y cierre lo que genera alarmas falsas. • En algunas subestaciones se tiene mediciones redundantes por lo que para una misma maniobra se generan tres o cuatro alarmas, se debería suprimir estas alarmas duplicadas. 4. CONCLUSIONES Y RECOMENDACIONES Debido a la importancia que tienen las alarmas en las plantas de proceso se han creado normas que fomentan buenas prácticas de ingeniería con el fin de mantener los procesos dentro de sus límites establecidos ante el reconocimiento, diagnóstico y respuesta a las alarmas por parte del operador y así evitar accidentes que afecten a las personas, instalaciones y el medio ambiente. Si bien las normativas EEMUA 191 y ANSI/ISA18.2 se refieren a plantas industriales de procesos donde se produce bienes, los centros de control de sistemas de potencia no estarían excluidos de esas normativas, ya que la respuesta adecuada y oportuna ante las contingencias hace que el suministro eléctrico se mantenga o se reponga lo antes posible para el desarrollo de la mayoría de actividades productivas y cotidianas de las personas. No se ha dado el seguimiento adecuado al sistema de alarmas del EMS del CENACE, ya que no se cuanta con un documento actualizado del sistema de alarmas y los cambios solicitados no han sido implantados. 198 Del análisis realizado se encontró que el sistema de alarmas del EMS del CENACE no está dentro de los índices recomendados por las normas EEMUA 191 y ANSI/ISA-18.2. [9] Wright J. (2011). “Alarm Management Standards and Best Practices”, Rockwell Automation. Chicago, USA [10] Zabre E., Gómez O. (2012). “Panorama de la racionalización de alarmas en el sector industrial y eléctrico”, Boletín IIE jul – sep 2012. México. Se recomienda generar un grupo permanente de trabajo que tenga bajo su responsabilidad la gestión del sistema de alarmas del EMS del CENACE. [11] Aizpurúa O., Galán R., Jiménez A., (2009) “Una nueva metodología para el análisis de alarmas masivas en sistema de potencia basada en sistemas cognitivos”, energética Vol. XXX No.3/2009. Se recomienda modificar los procedimientos para que en estos se considere los principios dotados por las normas EEMUA 191 o ANSI/ISA-18.2 para la gestión del sistema de alarmas. REFERENCIAS BIBLIOGRÁFICAS [12] DOP – DSI (2007), “Acta de reunión de trabajo 1 del Proyecto definición de alarmas”, 16-04-2007. [1] Hollender M., Beuthel C. (2007). “Sistema Inteligente de Alarmas”, Revista ABB 1/2007, pp. 20-23. [13] deBarr (2013), “Análisis de alarmas – CENACE” [2] “Introducing 2nd edition EEMUA 191” (2007). Disponible (online) en: Christian Erazo Pazmiño.- Nació en Quito, Ecuador en 1982. Recibió su título de Ingeniero Eléctrico de la Politécnica Nacional en 2007; desde el 2008 se desempeña como Operador de Generación y Transmisión en la sala de control del CENACE. [3] http://www.eemua.org/pdf/EEMUA191Presentations.pdf [4] “Setting a new standard in alarm management: How to follow the ISA 18.2 alarm management standard to create a safer and more productive plant.” (2010). Disponible (online) en: http:// www.usa.siemens.com/process [5] Hollifield B.(2010). “ Understanding and Applying the ANSI/ISA 18.2 Alarm Management Standard” Disponible (online) en: Wilmer Gamboa Naranjo.- Realizó sus estudios en la Escuela Politécnica Nacional en donde obtuvo su el título de Ing. Eléctrico en el año 2001, Diplomado en Planificación Estratégica en el año 2008 y Técnico de Energía Solar: Térmica y Fotovoltaica en el año 2009. [6] http://www.pas.com [7] ISA (2007). ”Alarm Management: Current State and Direction for Alarm Management Guidelines”. ISA EXPO 2007, Houston, USA . [8] HSE Books (1995). “The Explosion and Fires at the Texaco Refinery, Milford Haven, 24 July 1994”, Sudbury, U.K. (1995). Se desempeña como Operador de Sistema de Generación y Transmisión de CENACE desde el año 2001 199 Marco de Referencia para la Formulación de un Plan de Continuidad de Negocio para TI, un caso de estudio M. Bautista Corporación Centro Nacional de Control de Energía, CENACE Resumen— El propósito de un Plan de Continuidad de Negocio (Business Continuity Plan, BCP por sus siglas en inglés) es proporcionar procedimientos para mantener en funcionamiento los servicios críticos de la organización a causa de una interrupción de los mismos mientras se realiza la recuperación, en caso de un desastre natural o causado por humanos. En la actualidad, la iniciativa de implantación de un BCP/DRP tiene una prioridad alta para la mayoría de las organizaciones, es una necesidad estratégica que puede constituirse en el elemento diferenciador entre subsistir o desaparecer del Mercado. La práctica ha demostrado que existen situaciones en las cuales aparentemente un “simple” mantenimiento de hardware puede dejar a una organización sin su principal herramienta de trabajo, causando el malestar de sus usuarios internos/externos, sanciones disciplinarias/ regulatorias, pérdida de imagen y dependiendo de la gravedad hasta el despido de sus representantes con las respectivas acciones judiciales por daños y perjuicios; simplemente por no contar con procesos, procedimientos e instructivos que identifiquen las acciones previas y posteriores ante un escenario de desastre. El presente trabajo pretende proponer un marco de referencia que permita a las organizaciones formular un Plan de Continuidad de Negocio para TI o Plan de Recuperación de Desastres, a través de la aplicación de principios claros y esenciales expresados en un lenguaje natural. Finalmente, se realizará la aplicación del marco de referencia propuesto en el caso de estudio para el DRP del Sistema de Medición Comercial SIMEC del CENACE. Palabras clave— Gobierno de TI, Análisis de Riesgos, Plan de continuidad de negocios, Plan de recuperación de Desastres, Análisis de impacto de negocio. Abstract— The purpose of the Business Continuity Plan (BCP) is to provide procedures to maintain the operation of an organization’s critical services in the event of an interruption, while recovery work is still in process, such as in the event of a natural disaster or human error. There is currently a BCP/DRP initiative which has been classified as high priority by the majority of organizations, as it is a necessary strategy that could become the defining element between remaining on the market, or from disappearing from the market. The practice has shown that there are situations in which an apparently “simple” hardware maintenance procedure could leave an organization without its main work tool, causing problems for its internal/external users, disciplinary/regulatory fines, damage to reputation and depending on the seriousness of the issues, even the laying off of its representatives with legal consequences for damage claims – all due to a lack of proper processes, procedures and instructions which identify the actions to be taken before and after a disaster scenario. This study attempts to propose a framework that would allow organizations to formulate a Business Continuity Plan for TI or a Disaster Recovery Plan, through the application of clear and essential principles expressed in everyday language. To conclude, the proposed framework will be applied to the study case – the DRP of the CENACE’s SIMEC Commercial Measurement System. Index Terms— TI Government, Risk Analysis, Business Continuity Plan, Disaster Recovery Plan, Business Impact Analysis. 1. INTRODUCCIÓN Un desastre es un incidente causado por la naturaleza o por seres humanos, que afecta negativamente a las organizaciones y su entorno llevando a grandes daños, destrucción y devastación a la vida y su propiedad [1]. 200 Los desastres naturales pueden ser causados por: terremotos, inundaciones, tornados, tormentas eléctricas severas e incendios; mientras que los desastres causados por los seres humanos se deben a actos de terrorismo, ataque de hackers, sabotajes, empleados disgustados, entre otros. Existe otro tipo de interrupciones como la pérdida del suministro de energía eléctrica, telecomunicaciones y gas natural que igualmente pueden provocar eventos fatales; así como también, pueden darse otro tipo de incidentes como: eliminación accidental de la información, ataques de negación de servicios, virus, que si bien no pueden generar desastres, pero si pueden llevar a eventos de alto riesgo que pudieran interrumpir el normal desenvolvimiento de una organización. interactivo que es diseñado para identificar los procesos de misión crítica del negocio y desarrollar políticas, planes y procedimientos para asegurar la continuidad de estos procesos en el caso de un evento imprevisto [2]. Cada organización compromete el uso de sus recursos, el capital humano y la ejecución de las actividades diarias con el propósito de permanecer en el mercado, lograr estabilidad y rentabilidad. La mayor parte de ellas poseen bienes tangibles como: insumos, maquinarias, empleados y sistemas computarizados; y bienes intangibles como: procesos, tecnología, información, prestigio, entre otros, la afectación o daño de cualquiera de ellos podrían causar la paralización de actividades. Mientras mayor sea el tiempo de indisponibilidad de estos recursos, mayor será la posibilidad el sufrir un daño irreversible, y en algunos casos se ha visto la desaparición de varias organizaciones por su incapacidad de recuperación ante un evento de desastre. 3. RECUPERACIÓN DE DESASTRES A continuación se presentan algunas razones por las cuales es indispensable recuperar las actividades de un negocio: • Valor de la empresa, por naturaleza toda empresa busca generar mayor rentabilidad para sus propietarios y accionistas en función de sus capacidades. • Presión de los competidores, ante la indisponibilidad de los productos o servicios de una empresa, es la competencia la que adquirirá mayor presencia en el mercado. • Demandas del mercado, cada vez los requerimientos de los clientes son más exigentes y en tiempos de respuesta menores. • Disposición de los reguladores, el cumplimiento de la normativa dispuesta por los entes de regulación y control obliga a tomar medidas preventivas a fin de evitar sanciones. 2. CONTINUIDAD DEL NEGOCIO En el nivel más básico, el Plan de Continuidad de Negocio (Business Continuity Planning, BCP por sus siglas en inglés) puede ser definido como un proceso El BCP es responsabilidad de la Alta Gerencia debido a que se encarga de la protección de los activos y la viabilidad de la organización, de manera concomitante a lo definido en sus políticas. El BCP es generalmente ejecutado por las unidades de negocio y soporte, a fin de proveer un reducido pero suficiente nivel de funcionalidad en las operaciones, inmediatamente después de detectarse una interrupción mientras las actividades de recuperación se llevan a cabo. El DRP (Disaster Recovery Planning, por sus siglas en inglés) es el proceso de evaluación de los riesgos que enfrenta una organización, para luego desarrollar, documentar, implementar, probar y mantener procedimientos que ayudan a la organización a retornar rápidamente a las operaciones normales y reducir al mínimo las pérdidas después de un desastre [3]. Un DRP está enfocado a los sistemas de información, diseñado para restablecer la operación de los servicios informáticos críticos específicos (hardware y software), con instalaciones, infraestructura y procedimientos alternos, en caso de una emergencia; el responsable del DRP es el departamento de TI de la organización. Es por ello que el DRP debería estar alineado con la estrategia de la organización; la criticidad de los diferentes sistemas de información depende de la naturaleza del negocio, así como también, del valor que cada aplicación aporta al negocio. Debido a que cada organización tiene su identidad, cultura, clima organizacional, relaciones con sus clientes, socios de negocios y el público en general. Estas relaciones deberían conducir a una organización en el emprendimiento de una iniciativa de planificación de recuperación de desastres. 4. RELACIÓN ENTRE EL BCP Y DRP El alcance de un DRP está generalmente limitado a un conjunto definido de sistemas e infraestructura de TI, cuyo objetivo final es la recuperación oportuna, completa, dentro de un plazo de tiempo definido y con la mínima pérdida de datos. El proceso para la determinación de qué sistemas de TI son necesarios incluir en un DRP, es generalmente manejado por el departamento de TI, con los aportes de los propietarios de las aplicaciones quienes pueden o no ser parte del departamento. 201 En contraste, el alcance del BCP puede ser toda la empresa, con el objetivo final de recuperar las funciones principales y de misión crítica del negocio para asegurar su supervivencia, considerando aspectos como la infraestructura física y el personal necesario. Las funciones de negocio a ser recuperadas en un BCP se extienden más allá de los sistemas de TI como se muestra en la Tabla 1. • Identificación de áreas de oportunidad y alternativas de operación durante el desastre. • Cálculo de pérdidas aproximadas por inoperancia de procesos críticos. • Ventaja competitiva frente a otras organizaciones. • Prevención ante la aplicación de sanciones económicas por incumplimiento de requerimientos regulatorios. 6. PROCESOS DE LA RECUPERACIÓN DE DESASTRES Tabla 1: Alcance del DRP frente al BCP Como cada organización es única, así también lo es cada BCP de TI que lo pertenece. El proyecto de recuperación de desastres es un proyecto solo o como parte de una iniciativa de BCP. Los procesos para la planificación de recuperación de desastres pueden ser divididos en las siguientes fases del ciclo de vida como se muestran en la Fig. 1. 5. BENEFICIOS DE CONTAR CON UN DRP Dado el caso de una interrupción real, las organizaciones actualmente dependen en gran medida de la interacción e interdependencia con otros colaboradores en el entorno de su negocio. Incluso el contar con un DRP es un objetivo que beneficiará a las organizaciones de muchas maneras; pero que no garantiza que las mismas sean capaces de recuperarse íntegramente de un desastre. La efectividad en la ejecución de este plan se debe basar en asumpción de varios supuestos como contar con: la infraestructura y recursos para recuperar los sistemas críticos, los técnicos idóneos, centros de funcionamiento alternos, entre otros. La organización que tenga implementado un DRP, independientemente de prevenir y minimizar las pérdidas para el negocio, debe garantizar que cuenta con una respuesta planificada ante una interrupción importante que pueda poner en riesgo su subsistencia, aspecto que debería ser considerado muy seriamente para su instauración en todas las organizaciones independientemente del sector, actividad o tamaño que tuvieren. Entre otros beneficios se tiene: • Diseño de medidas para reducción de riesgos identificados. • Determinación de procesos críticos y vulnerables dentro del negocio. • Operación de procesos críticos de un negocio durante el desastre. Figura 1: Ciclo de Vida de la Planificación de Recuperación de Desastres 6.1. Planificación del Proyecto Se parte de la premisa que el proyecto cuenta con el auspicio y financiamiento necesario por parte de la Alta Gerencia de la empresa como un requisito primario e indispensable. Esta fase comprende la identificación de las actividades que deben realizarse en forma previa para comenzar el proyecto, es decir, qué se va a hacer y por qué. Los objetivos del proyecto de la planificación de recuperación de desastres son: obtener un entendimiento del actual y futuro ambiente de TI de la organización, definir el alcance, desarrollar la programación y la identificación de riesgos del proyecto, mediante la ejecución de las siguientes tareas: 202 • Nombrar el coordinador de recuperación de desastres. • Crear la política de recuperación de desastres. • Realizar la planificación del proyecto. 6.2. Análisis de Impacto de Negocio – BIA El análisis BIA es un paso crítico en el desarrollo de una estrategia de recuperación de desastres, consiste en evaluar los procesos críticos (y los componente de TI que los soportan) de la organización y determinar los plazos, prioridades, recursos e interdependencias, como resultado de la paralización de una o varias actividades. el RTO se refiere al período de tiempo después de un incidente en el que un producto, actividad o servicio debe ser reanudado, o un recurso debe ser recuperado. El RPO se refiere al punto más reciente en el cual los sistemas pueden ser recuperados; por tanto, constituye un indicador de la cantidad de información que una organización puede permitirse perder sin que afecte al negocio. En la Fig. 3 se ilustra la relación entre el RTO, RPO y el MTD ante la ocurrencia de un evento de desastre. Una vez recopilada la información, su análisis se realiza en base a dos factores de costos independientes que pueden ayudar a tomar la mejor decisión: • Costo de tiempo de inactividad, en el corto plazo tiene un valor bajo, sin embargo, a medida que el tiempo avanza tiende a crecer rápidamente hasta llegar a un punto de estabilización que representa que el negocio ya no puede funcionar. • Costo medidas alternativas correctivas, que iniciando con un valor alto empiezan a decrecer en función del tiempo objetivo de recuperación. Una vez identificados los dos costos y la suma de los mismos como se muestra en la Fig. 2 la organización podría identificar el punto en el cual el costo total puede ser minimizado. Cada punto en la curva en su conjunto, representa una posible estrategia, que a su vez tiene su respectivo costo, normalmente los objetivos de recuperación de tiempos cortos son a su vez los más costosos. Figura 3: Localización del RTO, RPO y MTD en el tiempo ante la presencia de un evento de desastre 6.3. Evaluación de Riesgos y Análisis El análisis de riesgos es un proceso sistemático que consiste en identificar las amenazas sobre estos activos y su probabilidad de ocurrencia, las vulnerabilidades asociadas a cada activo y el impacto que las citadas amenazas pueden provocar sobre la disponibilidad de los mismos. Existen varias metodologías de análisis de riesgos, de igual manera soluciones de software que permiten automatizar dicho proceso, sin embargo, todas se basan en el siguiente esquema de funcionamiento: • Identificar los activos. • Identificar y evaluar las amenazas. • Identificar y valorar las vulnerabilidades. Calcular el riesgo como la probabilidad de que se produzca un impacto determinado en la organización. Figura 2: Costo de Inactividad vs. Costo de Medidas Alternativas El tiempo máximo permitido de interrupción (Max Time Disruption, MTD) que puede ser soportado por la organización hasta que las pérdidas no sean asumibles, junto con el tiempo de recuperación objetivo (Recovery Time Objective, RTO) y el punto de recuperación objetivo (Recovery Point Objective, RPO) son parámetros que están vinculados directamente con la recuperación, y son los principales resultados del BIA. Específicamente, Hay múltiples formas de tratar un riesgo: evitar las circunstancias que lo provocan, reducir las posibilidades de que ocurra, acotar sus consecuencias, compartirlo con otra organización (contratando un servicio o un seguro de cobertura), o en última instancia, aceptando que pudiera ocurrir y previendo recursos para actuar cuando sea necesario. 203 6.4. Medidas Preventivas En función de los resultados del BIA y el análisis de riegos, se deben identificar y aplicar las medidas de seguridad necesarias para evitar que se produzcan incidentes que al no ser tratados de manera adecuada active el plan de recuperación de desastres. Las medidas deben permitir reducir la probabilidad de ocurrencia de interrupciones en las actividades críticas, la duración, limitando el impacto que pueda provocar en la organización y así fortalecer al negocio mediante la eliminación de puntos de fallo. Para ello se elabora un plan que incluye acciones que la organización debe adoptar para prevenir y evitar dentro de lo posible los riesgos que afectan la disponibilidad de las operaciones. 6.5. Estrategia de Recuperación En base a los resultados del BIA y del análisis de riesgos, el objetivo que se persigue en esta fase es identificar las alternativas de recuperación de los servicios críticos de la organización en concordancia con los tiempos definidos y acordados. La elección de las diferentes alternativas de recuperación depende de las necesidades de la organización: tiempos de recuperación objetivo (RTO), costos, recursos, seguridad, entre otros; cada plataforma de TI que soporte una función crítica de negocio, deberá contar con una estrategia de recuperación. A continuación se muestran algunas alternativas: • Hot Sites, normalmente está configurado con todo el hardware y el software requerido para iniciar la recuperación a la mayor brevedad. • Warm Sites, esta opción no incluye servidores específicos de alta capacidad. • Cold Sites, esta opción sólo tiene el ambiente básico (aire acondicionado, cableado eléctrico, enlaces de telecomunicaciones, y otros). • Mirror Sites, se procesa cada transacción en paralelo con el sitio principal. • Acuerdos recíprocos con otras organizaciones. • Múltiples centros de procesamiento. 6.6. Desarrollo e Implantación del Plan Una vez que las estrategias han sido definidas, deben identificarse los métodos, plazos, personas, recursos y tareas necesarias para implementarlas, así como también, la puesta en marcha por los encargados de la recuperación de desastres de la organización. Un DRP es un conjunto estructurado de procesos y procedimientos destinados a proporcionar una respuesta rápida al desastre y a los esfuerzos de recuperación. El plan debe documentarse y escribirse en un lenguaje simple que sea entendible para todos los equipos de recuperación. De igual manera se deben establecer las estructuras organizacionales, perfiles de los cargos y los procesos, que darán sostenibilidad a la continuidad del servicio de TI. La definición de roles y responsabilidades es uno de los aspectos más importantes del DRP, ya que es aquí donde se determina cada una de las actividades a cumplir antes, durante y después del desastre por los responsables de la ejecución del plan. 6.7. Pruebas y Actualización del Plan La efectividad del DRP en situaciones de emergencia se puede valorar si existe un plan de prueba que se lleve a cabo en condiciones reales. La fase de prueba debe contener las actividades más importantes que requieran comprobación y certeza en su funcionamiento futuro. Se debe probar dentro de un ambiente que simule las condiciones que serían aplicables en una emergencia verdadera. Es también importante que las pruebas se lleven a cabo por las personas que serían responsables de esas actividades en una crisis. El DRP debe ser mantenido a través de un ciclo de mejora continua. Cualquier cambio a nivel organizativo, operacional o técnico puede impactar en el negocio y por tanto en el plan de recuperación. En el caso de que se evidencien cambios que afecten a la organización y que tengan impacto en los procesos críticos de negocio y sus servicios de TI, puede ser necesario revisar el BIA y el análisis de riesgos para ver en qué medida dichos cambios pueden provocar desajustes en las estrategias y los procedimientos. De esta forma, la organización puede disponer de ciertas garantías sobre la efectividad de su plan de recuperación de desastres. 7. CASO DE APLICACIÓN - SISTEMA DE MEDICIÓN COMERCIAL SIMEC El Sistema de Medición Comercial (SIMEC) permite gestionar la medición de los registros cuarto-horarios de energía y otros parámetros eléctricos, en los puntos de generación/entrega del Sistema Nacional Interconectado (SNI). La información generada en el SIMEC constituye el principal insumo para los procesos de liquidación y facturación del Mercado Eléctrico Mayorista Ecuatoriano. 204 Dentro de los procesos de la cadena de valor de la Corporación CENACE está el proceso “Administrar y Liquidar las Transacciones del MEM y de las TIE” que utiliza como principal insumo para la ejecución de sus procesos internos la información de los registros de energía cuarto-horarios procedentes del SIMEC. 1. Perdida del enlace comunicación CENACE CNT Desde el punto de vista de los parámetros utilizados en el BIA, el SIMEC tiene la siguiente configuración: • RTO: 24 horas • RPO: 24 horas b) Evaluación de Riesgos En la Fig. 4 se presenta un ejemplo de la matriz de riesgos resultante del análisis del sistema SIMEC, tomando como referencia la metodología OCTAVE. 3 3 A 3. Corrupción de la base de datos del SIMEC 3 4 E Aceptar Compartir A Evitar 3 Respuesta al riesgo Reducir 3 2. Actualización de la configuración del sistema operativo Ante la incompleta o inexistente información fuente, los procesos de liquidación y facturación simplemente no pueden ejecutarse, de allí que, el SIMEC es considerado como un componente crítico dentro del portafolio de servicios que actualmente dispone el CENACE. La Regulación No. CONELEC 005/006 estipula, “es responsabilidad del Agente propietario de los equipos de medición publicar diariamente en el portal de Internet del concentrador primario de medidas del CENACE, los archivos de información generados exclusivamente a partir de lecturas TPL, para cada uno de sus puntos de medición. La hora máxima para realizar esta remisión es hasta las 09:00 del día posterior al de operación”. En función de este requerimiento normativo, para el SIMEC el tiempo máximo de interrupción está en el orden de horas, considerado como un nivel urgente de recuperación. Nivel de riesgo a) Análisis de Impacto de Negocio Impacto Eventos de riesgo Probabilidad Riesgo Inherente Con base al marco de referencia previamente analizado, se procede con la aplicación a manera ejemplificativa del ciclo de vida de algunos procesos de la planificación de recuperación de desastres aplicados al SIMEC. Respuestas/ actividades de control Contratar de un enlace de datos adicional con otro proveedor X X X Adquirir los servicios de soporte especializado del fabricante Implementar una solución de backups automatizada Figura 4: Matriz de Riesgos SIMEC c) Medidas Preventivas A continuación se listan algunas medidas preventivas a fin de prevenir la ocurrencia de incidentes no deseados: • Establecer un enlace de comunicaciones redundante con un proveedor distinto para la publicación de los portales Web del SIMEC. • Instalación de un software antivirus en todos los servidores de la plataforma Microsoft. d) Estrategia de Recuperación En base a los resultados del BIA, el análisis de riesgos, la naturaleza e importancia del proceso que se lleva a cabo en el sistema SIMEC, la estrategia que luce más adecuada para su recuperación es contar con un Hot Site, que permitiría al CENACE continuar con la operación del SIMEC dentro de los períodos de tiempo requeridos (inclusive con tiempos menores) ante la ocurrencia de un evento disruptivo. Este planteamiento sería la opción deseable desde la óptica conceptual indicada en el numeral 6.5. Al momento el SIMEC cuenta con las siguientes medidas para asegurar en gran parte su operación diaria y disponibilidad: 205 • Implementación de Clusters, a nivel de los servidores de base de datos se utiliza la configuración activo/pasivo. Otros componentes como los servidores de registradores, aplicaciones y otros componentes de capa media utilizan clusters bajo la modalidad activo/activo sobre una arquitectura de servidores virtualizados, de manera que ante la caída de un servidor guest virtual el mismo sea arrancado en otro servidor host. En la Fig. 5 se muestra la arquitectura física y virtual del SIMEC. • Almacenamiento, el SIMEC guarda toda su información en una solución de almacenamiento de la gama corporativa, posibilitando la creación de arreglos de discos virtuales que manejan redundancia del tipo 0, 1, 5 y 6. • Ejecución de backups, es una tarea automatizada que se realizada a través de un robot de cintas, con esquemas de backup diarios tipo full e incremental. 8. CONCLUSIONES Y RECOMENDACIONES • El DRP / BCP involucran procesos complejos que pueden ser los salvavidas de una organización, el contar con procedimientos, infraestructura y recursos para acometer un proceso de recuperación antes de registrarse pérdidas graves, serán la garantía para restaurar la funcionalidad de los servicios de información claves de manera controlada y con la menor pérdida en caso de una interrupción. • Es vital el conocimiento de la organización y su naturaleza de negocio de parte del equipo de recuperación, pues de ello dependerá la identificación acertada de los procesos críticos sobre los cuales se establecerán las estrategias más convenientes para su implementación, permitiendo además una estimación correcta de los recursos necesarios. • El SIMEC es un componente crítico para la Corporación CENACE con requerimientos de funcionalidad y disponibilidad establecidos por normativa, que al momento han sido cubiertos satisfactoriamente, sin embargo, existen estrategias de recuperación de desastres alternativas que podrían ayudar a mejorar aún más los niveles objetivo de recuperación, basados en soluciones como Hot Site o el uso de tecnologías emergentes conocidas bajo el nombre de Recuperación como Servicio (Recovery as a Service - RaaS). • El presente artículo constituye un breve ensayo de lo que sería la aplicación de un plan de recuperación de desastres, es evidente que en un corto plazo este tipo de iniciativas deben ser complementadas a fin de lograr un marco de referencia de acuerdo a la realidad y necesidades propias de CENACE. Figura 5: Arquitectura SIMEC • Las configuraciones previamente indicadas cuentan con sus respectivos instructivos y procedimientos documentados, mismos que constituyen en primera instancia la documentación de recuperación de los componentes del SIMEC. • Soporte, iniciando desde el hardware de servidores, dispositivos de red, software de base, y culminando con el propio sistema, el CENACE cuenta con el respectivo soporte de los proveedores y con los niveles de respuesta acordes al nivel de exigencia y disponibilidad del sistema. REFERENCIAS BIBLIOGRAFÍCAS Finalmente, la operación del SIMEC está bajo la responsabilidad de varios equipos de trabajo interdisciplinarios agrupados en los siguientes roles: Usuarios Operadores, Administradores de Infraestructura y Redes, Bases de Datos y Coordinadores. 206 [1] EC-Council (2010). “Introduction to Disaster Recovery & Business Continuity”, pp. 8-14, EEUU. [2] Nickolett, Chip; Schmidt, Jason (2008). “Business Continuity Planning Description and Framework”, Comprehensive Solutions, EEUU. [3] Erbschloe, M. (2003). Guide to Disaster Recovery. Boston, Massachusetts: Thomson, Course Technology. [4] ISACA. (2012). CISA Review Manual 2012. 22nd Ed. United States of America. [5] ISACA. (2012). COBIT 5: Enabling Processes. United States of America. [6] Alberts, C.y Dorofee A. (2001). OCTAVESM Method Implementation Guide Version 2.0. Pittsburgh: Carnegie Mellon University. Marco Antonio Bautista Salazar.Nació en Ambato, Ecuador, en 1976. Recibió su título de Ingeniero en Sistemas Informáticos y de Computación de la Escuela Politécnica Nacional en el 2001, actualmente está desarrollando la tesis de grado para la obtención de su título de Magister en Gerencia de Sistemas y Tecnologías de Información. Sus áreas de interés están relacionadas con la Administración de Bases de Datos Corporativas, Arquitecturas Orientadas a Servicios, Inteligencia de Negocios, Planes de Continuidad de Negocios y Recuperación de Desastres. Actualmente desempeña las funciones de Coordinador del Área de Informática (Encargado) de la Corporación CENACE. 207 Formulación de un Marco de Referencia de Convergencia IT/OT G. Pancho † F. Galarza ‡ † Universidad de las Américas ‡ Corporación Centro Nacional de Control de Energía, CENACE Resumen— La convergencia entre las tecnologías operacionales y de información, está determinando cambios importantes en los modelos de negocio de las empresas de la vertical de Utilities, que van desde la formulación de nuevos procesos de gestión técnica, la redefinición de estructuras organizacionales, hasta nuevas orientaciones en la estrategia de desarrollo de aplicaciones y servicios. Desde una perspectiva más amplia, la convergencia IT-OT, ha sido la habilitadora de la tendencia que está determinando el futuro del servicio de electricidad: Smart Grids. El presente artículo presenta los conceptos e impulsores más relevantes de la convergencia ITOT, a partir de lo cual se formula un marco de referencia que identifica los modelos, disciplinas y procesos que deben ser considerados para una evolución ordenada. Palabras clave— Convergencia IT-OT, Marco de Referencia, CENACE, Gobierno IT/OT, Estándares, Mejores Prácticas. Abstract— In the convergence between operations and information technologies, important changes are determined in the business models of vertically integrated Utility companies, which range from the formulation of new technical management processes and the redefining of organizational structures, to new directions for the strategic development of applications and services. From a wider perspective, the IT-OT convergence has enabled the trend which is changing the future of electricity services: Smart Grids. This article presents the concepts and driving forces which are most relevant to the ITOT convergence, from which a framework is formulated that identifies models, disciplines and processes that should be considered during an orderly development process. Index Terms— IT-OT Convergence, Framework, CENACE, IT/OT Government, Standards, Best Practices. 1. INTRODUCCIÓN La integración de la tecnología operacional y de información es una exigencia que permitirá a las empresas la generación de oportunidades de crecimiento en varias aristas. El aporte de esta investigación tiene que ver con una mejor conceptualización del gobierno de los temas IT/OT, la homogenización y optimización de procedimientos, estándares y prácticas especialmente en el lado OT, donde en el caso de CENACE, se soportan sistemas de misión crítica como el EMS, WAM y futuro SPS1 . 2. CONCEPTOS E IMPULSORES La Tecnología Operacional, en adelante OT (por sus siglas en inglés: Operational Technology) ha sido tradicionalmente un enfoque asociado a sistemas de tecnología e información que actúan sobre procesos físicos, en los que coexisten máquinas, sensores y actuadores; con una dinámica de procesamiento en tiempo real, con intervención en el lado de usuarios u operadores, en los que su competencia se relaciona en áreas de ingeniería, eléctrica, electrónica, industrial, entre otras. OT- Operational Technology se define como “el equipamiento, dispositivos, sensores y software utilizados para controlar o monitorear activos físicos y procesamiento en tiempo real con el propósito de mantener la integridad del sistema”. Como ejemplo se pueden citar a los sistemas clínicos y equipamiento médico en empresas de salud, equipamiento automatizado utilizado en manufactura, sistemas de transmisión eléctrica, sistemas SCADA, sistemas de control, entre otros. Por su parte la Tecnología de Información, en adelante IT (por sus siglas en inglés: Information Technology) se ha referido a soluciones informáticas transaccionales que interoperan sobre motores de bases de datos, con arquitecturas lógicas multicapa que extienden su aplicación a redes LAN-WAN. 1 208 EMS: Energy Management System. WAM: Wide Area Measurement, SPS: Systemic Protection System IT – Information Technology se define como el “conjunto de recursos, procedimientos y técnicas utilizadas en el procesamiento, almacenamiento y transmisión de la información, denominados sistemas de información” [1]. La responsabilidad de aquello incluye, entre otros aspectos, la administración de red, desarrollo de software, la gestión y planeamiento del ciclo de vida de la tecnología dentro de la organización, etc. Como ejemplo se pueden citar los sistemas ERP, sistemas de gestión de contenido SCM, etc. A continuación se despliega un cuadro comparativo entre sistemas IT y OT: IT OT Propósito Gestión de información, Automatización de procesos de negocio Manejo de activos, Procesos de Control Arquitectura Transaccional o Batch, bases de datos relacionales o texto Tiempo Real, Software embebido Interfaces Navegador web, Terminales y teclado Sensores, Displays codificados Propietario CIO, Ingenieros de Informática, Finanzas, Adquisiciones Ingenieros técnicos, Gerentes de línea de negocios Red Corporativa, basada IP Redes de control (en incremento redes IP y wireless) ERP, SCM, CRM, E-mail SCADA, PLCs, Sistemas de Control, Modelamiento Conectividad Ejemplos y prestaciones del entorno IT para responder a las exigencias de la computación de alto desempeño (HPC: High Performance Computing). Esta convergencia IT-OT no solo se refleja en la estandarización del uso de tecnologías para todo propósito, sino también en el homogenización de las prácticas de gestión. El enfoque hacia la gestión de servicios, con un ciclo que va desde lo estratégico hasta lo operacional, el gobierno de IT y la gestión de proyectos, se constituyen en elementos transversales. La integración IT-OT no es opcional, es una realidad de aplicación mandatoria, para que las inversiones en proyectos OT sean viables y óptimas y para que la operación de soluciones sea sustentable en términos de eficiencia y eficacia. El impacto de esta convergencia ha determinado en la industria incluso el replanteamiento de los modelos de negocio por parte de algunos proveedores representativos de OT, con estrategias de compra de empresas de IT para incorporarlas en sus procesos de I&D&i. El aparecimiento de las redes inteligentes (en inglés: Smart Grids), es la evidencia más notoria de la inmersión de IT en la tecnología operacional a todo nivel, que sustenta el proceso industrial que a su vez soporta el servicio de la electricidad. 3. MARCO DE REFERENCIA PARA DESPLEGAR LA INTEGRACIÓN IT – OT Figura 1: Cuadro comparativo IT/OT Fuente: Gartner Son varios los tipos de industrias que históricamente han creado una separación entre IT y OT, como una forma de especialización natural y de priorización, desde la organización departamental, hasta los procesos y las prácticas de gestión y los perfiles de los profesionales a cargo. De hecho los sistemas OT eran creados como sistemas propietarios, con base a tecnología específica, normalmente más costosa, que responda a estándares operativos de mayor exigencia. El incremento exponencial de los últimos 5 años en cuanto a capacidad de procesamiento, comunicación de datos, velocidad de redes, y la introducción de nuevas tecnologías tales como: Internet oh things, in memory computing, fabric, cloud computing, entre otras, han determinado un nuevo entorno de capacidades La convergencia IT-OT es una realidad que se robustece con el desarrollo integrado e interoperable de las nuevas tecnologías y las nuevas prácticas, que plantea también un desafío a las empresas clientes: ¿cómo realizar una adopción estructurada, a la medida de cada realidad?. La mejor aproximación de respuesta es formular un Marco de Referencia de Integración IT-OT. Un Marco de Referencia, por concepto se constituye en una guía y una referencia para la aplicación de una disciplina, con una naturaleza flexible por no ser prescriptiva en su aplicación, pero que a su vez considera los elementos esenciales, para que su aplicación sea efectiva, con orientación hacia la calidad y con control de los riesgos. La figura que se presenta a continuación ilustra los elementos esenciales del Marco de Referencia de Integración IT-OT. 209 cambio la identificación de procesos, funciones y roles, así como las habilidades y competencias son en realidad los elementos centrales del problema a resolver. Tecnología, Aplicaciones e Información Gobierno y Arquitectura Empresarial Convergencia IT-OT Alistamiento Organización y Procesos Figura 2: Marco Referencia – Integración IT-OT El Marco de Referencia referido pretenderá responder a las siguientes incógnitas: • ¿Cuáles serían los procesos de gestión de infraestructuras IT-OT? • ¿Cuál sería un modelo organizacional de una Unidad Técnica a cargo de la gestión de infraestructuras IT-OT? • ¿Cuáles serían los elementos para asegurar la integración e interoperabilidad de una infraestructura IT-OT? • ¿Cómo identificar el nivel de alistamiento y madurez de una organización en cuanto a aplicar la integración IT-OT y sus posibles niveles de evolución? • ¿Cómo el Gobierno y la Arquitectura empresarial puede facilitar la integración de IT-OT? Figura 3: Marco Referencia – Integración IT-OT Fuente: Gartner Algunas premisas de base que se constituyen en criterios de referencia para formular una organización y sus procesos se indican a continuación: Procesos integrados y transversales para la gestión de infraestructura IT-OT: data center, redes, networking, etc. • Despliegue de la función de mesa de servicio (helpdesk) con SLAs diferenciados, uno para la función informática estándar y otro para los servicios de misión crítica, en el que se incluya a los servicios derivados de los sistemas OT. • Despliegue de una PMO única (del inglés: Project Management Office), responsable de la administración de iniciativas IT-OT, que estandarice las prácticas a través de grupos procesos estandarizados para el gobierno de proyecto: inicio, planificación, ejecución, seguimiento y control y cierre. Pero para el caso de iniciativas OT, mantenga las particularidades y buenas prácticas de la ingeniería de campo. • Creación de áreas de aplicaciones con exclusividad de personal en el tema OT, a fin de que procesos técnicamente sensibles, dispongan de una atención dedicada en cuanto a gestión de cambios y configuración. 3.1. Organización y Procesos La organización de las Unidades de Gestión de Tecnología, o denominaciones equivalentes, afrontan ahora mismo una reingeniería, a fin de afrontar su nuevo rol: de amplificador de la estrategia empresarial a través del uso inteligente de las tecnologías. Los estándares y nuevas prácticas con este propósito son múltiples, así ITIL, COBIT, ISO 20000, ISO 27000, entre otros, son ejemplos reales, sin contar con instrumentos propios que han ido conceptualizando las grandes corporaciones, proveedoras de soluciones. Una estructura organizacional bien diseñada se basa en principios de base claros formulados a partir de buenas prácticas. La orientación de diseño basada en servicios es una alternativa que otorga visibilidad y flexibilidad de la organización de IT-OT. El gráfico que se despliega a continuación sugiere que es menos importante encontrar un organigrama, pero, en En forma previa a un rediseño organizacional y a la definición de posiciones, es indispensable introducir los conceptos de funciones y roles. Las funciones representan la manera como la organización de IT-OT asegura que exista una asignación clara de procesos. Cada función tiene el aporte de profesionales que ejercen un conjunto de roles asociados, y a su vez, cada rol una serie de responsabilidades. Aunque 210 el número de funciones pueden variar dependiendo de cada caso, en la industria se han identificado 7 principales. La siguiente tabla ilustra además las funciones y la naturaleza del trabajo de cada área2 : Tabla 1: Función y procesos IT – OT 3.2. Alistamiento En base a lo sustentado, es claro que la integración IT-OT no solo es un concepto, sino también un proceso de evolución y una estrategia de alineamiento, cuya adopción requiere de habilitadores que se los construye de manera secuencial. El modelo de alistamiento, representa una contextualización de estos habilitadores. La siguiente figura ilustra lo indicado. Alistamiento Gestión Proyectos Alistamiento Equipos de Trabajos Alistamiento Procesos Alistamiento Gestión Portafolio Alistamiento Roles - Funciones Sobre esta base se definen algunas “buenas prácticas”: • Separar las funciones con actividades planificadas de aquellas de tipo no estructuradas (con interrupciones). • Enfocarse a la automatización de actividades planificadas y repetitivas. • Asignar al personal adecuado en los roles adecuados. • Empoderar al personal, quién es a su vez responsable de rendir cuentas por el cumplimiento de las responsabilidades asignadas. • Combinar las funciones y roles según sea apropiado, para tener una aproximación de las posiciones. 2 • • Funciones: la forma en que la organización de IT opera para asegurar que los trabajos necesarios son realizados mediante asignaciones específicas a un responsable, quién rinde cuentas por lo ejecutado. Responsabilidad: los detalles del trabajo que debe ser realizado por un rol tipo. Rol: conjunto de responsabilidades. Dependiendo del tamaño de la organización de IT, varios roles puedes ser realizados por una persona, o un rol específico puede tener asignación de múltiples profesionales. Gestión Cambio Organizacional Alistamiento Empresarial Conocimientos y Habilidades Figura 4: Elementos de Alistamiento El alistamiento es una medida de la brecha que existe entre la situación actual y una deseada, en términos de conocimientos, habilidades, procesos, organización, personas y cultura para evolucionar a una integración ITOT. El alistamiento puede evaluarse en varios niveles, desde lo empresarial, a equipos de trabajo e individuos. En lo empresarial, el alistamiento se refiere a la capacidad de formular estrategias organizacionales, gestión de portafolios y proyectos, que enfrenten a las iniciativas de IT-OT en forma integral, con un mapa de ruta de desarrollo de mediano plazo. En el nivel de equipos de trabajo, se refiere a la capacidad de que los profesionales de IT y OT profesionalicen la gestión de proyectos y la operatividad en forma estructurada en base a roles y funciones, que tomen en cuenta estándares de dirección y gestión aceptados por la industria. Finalmente, los procesos y la estructura orgánica son elementos transversales del modelo de alistamiento. 211 3.3. Tecnología de base, aplicaciones e información La tecnología de base que incluye a la infraestructura de procesamiento, redes, almacenamiento, seguridad y monitoreo, tiene desde hace varios años una convergencia IT-OT. Los sistemas propietarios no forman parte de las soluciones actuales OT. Es más, existe la perspectiva de una mayor utilización de la computación en nube y arquitecturas híbridas como parte de los sistemas de misión crítica. En cambio en lo relativo a la tecnología de base que soporta la capa de instrumentación y actuación sobre los procesos físicos, aún se mantienen particularidades que no son extensivas hacia lo IT (referencia estándar IEC 61850). La integración IT-OT a nivel de la aplicaciones está condicionado a lo que los proveedores realicen. En las suites asociadas a la gestión de energía y de la distribución, predominan aplicativos de core que son desarrollados en base a una arquitectura tradicional, enfocado a lo especializado en OT, sin considerar enfoques de SOA, ESB y BPM. No obstante, la tendencia es que las soluciones vayan migrándose a estos nuevos enfoques; sin embargo, el segmento donde más es visible la integración IT-OT son las aplicaciones de inteligencia de negocios y en los servicios de movilidad. Para implementar un gobierno de negocio/IT efectivo y confiable, se recomienda nombrar un representante en el grupo de directivos claves, que asuma la visión de la convergencia IT-OT en la empresa, involucrando a las áreas de IT, OT y otros potenciales interesados. A fin de integrar la tecnología digital, estándares y conexiones, se debe tener la flexibilidad de aceptar las variaciones entre arquitecturas IT-OT, pero con un planeamiento integrado, derivado de la arquitectura empresarial modular e interoperable. Con el propósito de desplegar un gobierno de información y procesos de negocio, debe entenderse a esta como práctica de nivel estratégico y no como una cuestión de tecnología. 4. CASO DE APLICACIÓN: CENACE A fin de aplicar el marco de referencia descrito en secciones previas, se ha considerado el caso de CENACE en donde coexisten sistemas y procesos IT-OT a los que se puede aplicar una estrategia de convergencia, tal como se indica continuación. Tabla 2: Identificación de Sistemas IT Finalmente en lo relativo datos e información, se experimenta una transición desde los motores de base de datos de tipo propietarios a los de tipo comercial, aquello en función de los niveles de confiabilidad y rendimiento que actualmente tienen estas tecnologías. Sistemas representativos: SIREM La integración del Gobierno de IT - OT es un factor crítico de éxito para construir una empresa conectada, con una gestión por procesos, que evite silos funcionales. Estos objetivos de control se sustentan en bases sólidas, tal como se ilustra en la siguiente figura. EMS WAM ERP SIMEC SIVO SICOMB ePSR 3.4. Gobierno y Arquitectura Empresarial OT BOSNI-SAM SPS Y otros 50 aplicativos Tabla 3: Identificación de Unidades Organizacionales IT OT DSI-EMS DSI - Sistema Remoto Gobierno de información y procesos del negocio DSI-Informática DSI - SMEC DSI - SICOM DOP - WAM Integrar tecnología digital, estándares y conexiones DPL - DOP - SPS a) Organización y Procesos (criterios de rediseño) Gobierno de negocio /IT efectivo y confiable • • • • Figura 5: Integración de gobierno IT/OT Fuente: Gartner 212 Gestión transversal de infraestructura y redes. Gestión transversal de bases de datos Gestión especializada de aplicaciones OT: EMS+WAM+SPS • SIMEC+SICOMB+Sistema Remoto • Gestión especializada de aplicaciones BMS: ePSR+SIMEM+SIVO+BOSNI+SAM • Gestión transversal de aplicativos IT. Gestión transversal de proyectos a través de una PMO IT-OT b) Alistamiento actual • A nivel de empresa: alistamiento bajo • A nivel de portafolios y proyectos: alistamiento medio. • A nivel de equipos de trabajo: alistamiento medio. • A nivel de roles y funciones: alistamiento bajo. • A nivel de procesos: alistamiento medio. • A nivel de cambio organizacional: alistamiento bajo. c) 5. CONCLUSIONES Y RECOMENDACIONES Actualmente no existe iniciativa o proyecto de tecnología empresarial en la vertical de Utility que no requiera de una convergencia IT-OT en la conceptualización, planificación, implantación, despliegue y operación de las soluciones. El desarrollo histórico de OT fuera del ámbito de la organización de IT es un obstáculo para reconocer el potencial estratégico de inversiones en tecnología. La convergencia IT/OT genera en las empresas grandes oportunidades para: • Reducir costos operacionales, de soporte, de adquisición de software, entre otros. • Disminuir silos en las unidades de negocio. • Reducir el riesgo en el ámbito de cybersecurity y de fallas debido a un inadecuado manejo de software OT. • Incrementar el desempeño, unificando equipos de proyecto con las habilidades idóneas. • Incrementar madurez en los mecanismos de gobierno TI y OT • Optimizar el modelo de negocio Tecnología de base, aplicaciones e información Tabla 4: Tecnología, aplicaciones e información El marco de referencia IT/OT permite encontrar enfoques estructurados hacia la eficiencia, la reducción de riesgos operacionales y una mejor gestión de proyectos combinados IT/OT. Para el caso de CENACE la convergencia IT-OT se considera: • Por fortalecer, desde el punto de vista de organización y procesos. • Respecto al alistamiento con un nivel global entre medio y bajo. • En lo relativo a infraestructura, aplicaciones e información, casi listo, debido a la adecuada estrategia de modernización de los nuevos sistemas IT-OT. • Desde el punto de vista de gobierno y arquitectura empresarial, se debe dar continuidad en la adopción de estándares. Gobierno y Arquitectura Empresarial: • Desplegar la aplicación de los siguientes estándares IT-OT: ITIL, COBIT, ISO 27000, ISO 22301. • Desplegar la aplicación de los siguientes estándares OT: NERC-CIP, IEC 61850, CIM • Formular una arquitectura futura basada en SOA con base a un ESB. • Rediseño de procesos en base a BPM. REFERENCIAS BIBLIOGRÁFICAS 213 [1] Wikipedia: Information Technology, http:// en.wikipedia.org/wiki/Information_technology [2] Artículos Gartner: a) IT and OT Intersection and Collaboration, b) Why Should I Care About Operational Technology?, c) The Value of IT and OT Integration, d) The Management Implications of IT OT Convergence, e) Architecting the Convergence of OT and IT Germán Pancho Carrera.- Ingeniero en Electrónica y Control otorgado por la Escuela Politécnica Nacional (EPN-1996). Master en Gerencia de Sistemas obtenido en la Escuela Politécnica del Ejército (ESPE2003). Su actividad profesional se ha enfocado a la docencia universitaria y al desarrollo de proyectos de tecnologías de información. Actualmente ejerce las funciones de Director de la Maestría en Gerencia de Sistemas de la Universidad de las Américas y de Subgerente de Planificación y Gestión de la Empresa Estratégica COCASINCLAIR EP. Fernanda Galarza Herrera, nació en Quito en el año 1980, recibió su título de Ingeniera de Sistemas y Computación de la Pontificia Universidad Católica del Ecuador en Quito en año 2005; y su título de Diplomado de Gestión de Servicios de la Tecnología de Información en el Instituto Tecnológico y de Estudios Superiores de Monterrey en el año 2008. Sus áreas de investigación están en el ámbito de la Gestión de Tecnologías de Información. Actualmente ejerce sus funciones como Ingeniera de Informática en la Corporación CENACE. 214 Evolución del Centro de Operaciones Una Propuesta de Esquema a las Nuevas Tendencias y Desafíos en Ecuador Roberto Barba Barba Centro Nacional de Control de Energía, CENACE Resumen— Se propone un esquema para el equipo de turno en la sala de control del CENACE, que responda a la evolución de los sistemas de potencia y las nuevas tendencias tecnológicas aplicadas a estos sistemas. Este artículo está divido en cuatro secciones: En la sección 1 se hace una breve reflexión sobre la importancia de la misión del equipo de trabajo que coordina, supervisa y controla la operación del Sistema Nacional Interconectado – SNI; en la sección 2 se realiza un análisis retrospectivo – cualitativo de la evolución de la estructura del Centro de Operaciones del Sistema Nacional Interconectado, considerando el esquema del equipo de turnos y la definición de las responsabilidades; en la sección 3 se analizan los nuevos retos en la operación del sistema nacional interconectado, considerando el aumento en la complejidad del mismo y las nuevas tecnologías para la operación de sistemas eléctricos de potencia; en la sección 4 se propone la estructura del equipo de turno y sus responsabilidades para operación adecuada del sistema para poder enfrentar los retos futuros. Palabras clave— Estructura de Equipo de Turno, Operación del Sistema Nacional Interconectado. Abstract— A new scheme is proposed for the shift work team in the CENACE control center, which would respond to the on-going development of power systems and the new technological trends applied to these systems. This article is divided into four parts: Part 1 is a brief reflection on the importance of the mission held by the work team in charge of coordinating, supervising and controlling operations of the National Interconnected System (SNI for its acronym in Spanish). Section 2 is a qualitative-retrospective analysis of the National Interconnected System Control Centre’s structural development, considering the shift work and the responsibilities definition. Section 3 is an analysis of the new operation challenges for the national interconnected system, considering its increased complexity and new technologies in place for electrical power system operations. Section 4 proposes a new shift work team structure and assigns corresponding job responsibilities for an adequate system operation that is prepared to face future challenges. Index Shift— Work Team Structure, National Interconnected System Operations. 1. INTRODUCCIÓN - IMPORTANCIA DEL EQUIPO DE OPERADORES DEL SNI Y SU ESQUEMA DE GESTIÓN Se entiende por Centro de Operaciones – CO de una empresa, como la estructura organizacional encargada de coordinar la operación de su sistema; considera una estructura jerárquica (clara definición de responsabilidades), el talento humano con capacidades y competencias en el conocimiento especializado de su sistema, con un empoderamiento formal para la toma de decisiones en tiempo real, tanto en condiciones normales como de emergencia. En las instituciones proveedoras de servicios en línea o tiempo real, el Centro de Operaciones, Centro de Despacho, Centro de Control - CO, o como se lo conozca, representa la instancia directa en la relación entre la institución y el cliente final; el servicio público de electricidad no es la excepción. El Centro de Operaciones es el ente que debe velar por el correcto suministro del servicio eléctrico, garantizando el cumplimiento de los parámetros normativos de seguridad, calidad y economía, de manera permanente, durante las 24 horas del día, los 365 días del año. Existen varios factores clave a considerar para que estos parámetros del servicio eléctrico se cumplan a cabalidad: la competencia y capacidad del equipo de operadores de turno, la tecnología disponible para supervisión y control del sistema, y por último, la estructura del equipo definido para la ejecución de esta gran tarea; esquema definido por la estructuración de las responsabilidades y el número 215 preciso de profesionales para el cumplimiento cabal de estas responsabilidades. Pues no sería lo mismo operar el SNI con la estructura actual, que con la estructura del esquema de turnos que se tenía en la década de los 70, sería prácticamente imposible Figura 1: Sala de Control CENACE 2. ANÁLISIS RETROSPECTIVO LA ESTRUCTURA DEL CENTRO OPERACIONES DEL ECUADOR [1] DE DE • Partamos de la década de los 70 en la cual a lo largo y ancho del país existían subsistemas eléctricos aislados, a cargo de las empresas eléctricas de distribución de las ciudades respectivas, para dotar de energía a los habitantes de las principales ciudades del Ecuador. • Bajo esta estructura del servicio eléctrico, la operación del sistema se la realizaba en varios esquemas: centros de operaciones locales, en otros casos lo realizaban los propios operadores de las centrales de generación, quienes de manera manual y por la percepción de su visión, tomaban las acciones para el seguimiento de la demanda de energía. • En esta década, específicamente en el año 1977, inicia la operación del Sistema Nacional Interconectado, “con el suministro de servicio eléctrico a la zona norte del país, sirviendo a los sistemas de la Empresa Eléctrica Quito, INECEL - Latacunga y Empresa Eléctrica Ambato. Esta operación inició con el ingreso de la central termoeléctrica de Guangopolo con 30.6 MW y luego ingresó en 1978, la hidroeléctrica de Pucará con 73 MW” (1). Con este hito se crea por primera vez el Centro de Operaciones del Ecuador, conocido como Despacho de Carga, encargado de la supervisión y coordinación de la operación de varios subsistemas interconectados, contaba con un despachador, cuyo perfil académico era de tecnólogo. 216 • Interconexión de Quito y Guayaquil. En el año de 1980 se produce un gran hito en la historia del servicio eléctrico ecuatoriano, se interconecta la capital de la república (Quito) con el centro industrial del país (Guayaquil) con un sistema de transmisión cuyo voltaje era de 138 kV. Bajo este contexto crecen las responsabilidades, las necesidades de competencia para el entendimiento correcto del comportamiento de los fenómenos eléctricos, y el esfuerzo para la operación del sistema de potencia; la división de estas responsabilidades se las maneja con el criterio de subdespacho de carga, ubicado en la ciudad de Guayaquil. • Cambio de voltaje en la interconexión Quito – Guayaquil e ingreso de la Fase AB de la central Paute. El cambio de voltaje de la interconexión Quito – Guayaquil a 230 000 voltios (1982) y el ingreso a operación de la fase AB de la central Paute de 500 MW (1983), generaron un cambio radical en la operación del Sistema Nacional Interconectado, pues se presenta una redistribución completa en los flujos de potencia en todo el Sistema Nacional de Transmisión, especialmente desde el gran nodo de generación hacia los nodos concentradores de carga, Quito y Guayaquil; las exigencias en competencias para la operación del sistema aumentan. En este contexto se define la necesidad de incluir un Operador Ayudante al Despachador, quien se encargara de la relación con las empresas de distribución y de otros aspectos logísticos de la operación, sobre la base de las disposiciones emitidas por el tecnólogo despachador. • Ingreso del SCADA/EMS. En 1995 ingresa a operación el SCADA/EMS SPIDER, del Centro de Operaciones del Sistema Nacional Interconectado. La correcta visión de las autoridades se orientó a cambiar la estructura de competencias, que se requerían para el máximo aprovechamiento de esta nueva tecnología, pues era necesario conocimientos a nivel de ingeniería, para el entendimiento y uso correcto de las nuevas herramientas, de manera particular el aprovechamiento cabal de las funciones de aplicación. • Bajo este contexto, el equipo de operación de turnos del SNI, pasó a conformarse de un ingeniero eléctrico y un tecnólogo. • Durante la segunda mitad de la década de los 90, para cubrir la expansión del sistema con el ingreso de varias centrales de generación y crecimiento de la demanda, inicia un proceso de fortalecimiento de la estructura de turnos. El equipo de operadores • • • • del sistema nacional interconectado cambia a tres ingenieros, uno responsable de la Coordinación del turno, otro ingeniero encargado del despacho y control de la generación y un tercero encargado de la supervisión y control de la transmisión y la coordinación con las empresas distribuidoras. Ingreso de la interconexión con Colombia. En el año 2003 ingresa la interconexión con Colombia, dos circuitos a 230 kV, con una capacidad de 250 MW de transferencia. El comportamiento eléctrico del sistema vuelve a cambiar radicalmente, por varios aspectos, la presencia de fenómenos eléctricos que no se habían registrado, la necesidad de operar el Control Automático de generación en modo Control de Intercambio y frecuencia – TLB, exigencia fundamental para la coordinación de la operación internacional, de la interconexión de los sistemas eléctricos de potencia de Ecuador y Colombia. En este contexto, aumentaron las responsabilidades y exigencias de la coordinación para la operación del sistema, se mantuvo la misma estructura del equipo de operadores de turno: El ingeniero Supervisor asumió la operación y despacho de la interconexión con Colombia, mientras que el ingeniero operador de generación asumió la operación del Control Automático de Generación, y el ingeniero operador de transmisión tuvo que maximizar sus esfuerzos, para enfrentar el nuevo comportamiento de los parámetros de calidad del sistema, comportamiento completamente diferente de los perfiles de voltaje y grandes cambios en los flujos de potencia en el SNT, debido a las modificaciones repentinas en el despacho de la interconexión internacional. Cabe indicar que en el año 2008 ingresó la segunda interconexión con Colombia, completando 4 circuitos de 230 kV, que permiten una transferencia de hasta 500 MW, incrementando las exigencias en la coordinación internacional de la operación interconectada, siendo la más saliente el aparecimiento de modos de oscilación, debido a las grandes transferencias de potencia. En el año 2012 se implementa en el SNI el sistema de monitoreo de área amplia – WAMS, el cual establece un nuevo hito en la operación de sistema eléctricos de potencia, pues ya es posible supervisar el comportamiento dinámico del sistema de potencia y de sus componentes, a través de la información fasorial en tiempo real, facilidad que anteriormente era posible únicamente con un análisis posoperativo. • El ingeniero operador de Transmisión es el encargado de realizar estas actividades de supervisión y análisis de la información fasorial. Con esta reseña histórica se puede identificar la evolución del esquema del equipo de turno para la operación del SNI, y de la evolución de las responsabilidades asignadas a los miembros de este equipo. Se pueden identificar cambios relevantes en las responsabilidades del equipo de turno, teniendo una particular característica las responsabilidades del ingeniero operador de transmisión, pues actualmente es el encargado de la supervisión y control del SNT, responsable de la coordinación con las empresas de distribución y operación de las interconexiones con los sistemas eléctricos de estos sistemas, y responsable de la supervisión del comportamiento dinámico del sistema y sus componentes, a través de la información fasorial del sistema WAMS. Si bien esta estructura funciona a cabalidad en condiciones normales, en condiciones de emergencia para grandes eventos, las responsabilidades y acciones se multiplican, haciendo insuficiente el recurso humano para la coordinación de la operación, en todos sus aspectos. 3. NUEVOS RETOS Y REQUERIMIENTOS En el corto y mediano plazo se tienen previstos nuevos cambios en varios aspectos relativos a la operación del sistema de potencia, tanto en el ámbito tecnológico, como en la expansión del sistema. A continuación, se presenta un breve análisis de los futuros cambios y de su impacto previsto en el comportamiento del sistema de potencia y en los requerimientos para la estructura del equipo de operación del sistema. 3.1. Expansión del sistema • Sistema Nacional de Transmisión a 500 kV. Para el año 2016 se tiene previsto el ingreso, en etapas, a operación del sistema de transmisión de extra alto voltaje a 500 kV, para poder evacuar la energía producida por el ingreso de la central Coca Codo Sinclair de 1500 MW. Como impacto en la operación del sistema, se prevé el cambio radical del comportamiento del sistema eléctrico y lógicamente en la operación del mismo, desde las 217 condiciones de perfil de voltaje, redistribución de flujos de potencia, hasta los fenómenos dinámicos ante cambios en el estado de estos elementos, tanto por operación programada, como por eventos de falla; para este último caso el esfuerzo operativo será totalmente exigente. Lógicamente la operación de este nuevo sistema de transmisión será responsabilidad del ingeniero operador de transmisión. • Expansión de la red de 230 kV. En el mediano plazo, CELEC EP TRANSELECTRIC tiene previsto el reforzamiento de ciertas zonas del SNT, generándose en algunas zonas corredores de transmisión en anillos a 230 kV, lo cual exigirá un mayor esfuerzo en la supervisión y operación del sistema. • Ingreso de la central Coca Codo Sinclair. Para el año 2016 se tiene previsto el ingreso a operación comercial de la central Coca Codo Sinclair de 1500 MW. • Se prevé el cambio completo en el comportamiento de todo el SNI, al producirse una redistribución de los flujos de potencia, pues el nuevo nodo principal suministrador de energía será esta central. • Para este último caso el esfuerzo operativo será totalmente exigente. El impacto en el cambio en la matriz de responsabilidades afectará a todo el equipo de operadores de turno, siendo evidente el aumento en las actividades para los ingenieros operadores de generación y transmisión. • Impacto similar, aunque en una menor escala, se tendrá con el ingreso de 7 nuevos proyectos hidroeléctricos restantes. • Integración latinoamericana. Considerando la visión del Gobierno Central – de convertir al Ecuador en exportador de energía eléctrica – concomitantemente con los planes regionales de integración eléctrica, con el ingreso de sistemas interconectados a 500 kV, se producirá un nuevo impacto en la matriz de actividades y responsabilidades del equipo de operadores del sistema, tanto en el ámbito de la supervisión y control propiamente dicho, como en las exigencias de coordinación, en este caso, internacional. • • • • • • 3.2. Avances Tecnológicos • Sistema de Monitoreo de Red de Área Amplia – WAMS y Operación coordinada con Colombia. Como se mencionó en el numeral anterior, en el 2012 entró a operar el sistema para monitoreo del sistema de potencia, a través de las mediciones fasoriales en puntos estratégicos de este sistema; además, en el presente año (2013) se prevé el intercambio de información fasorial entre 218 • los sistemas WAMS de Ecuador y Colombia, adicional al intercambio de información de tiempo real vigente. Aparte del aumento ya registrado en el esfuerzo de supervisión de esta información, el intercambio de información con el sistema colombiano generará exigencias adicionales en la coordinación internacional de la operación y en la supervisión de variables adicionales del sistema colombiano. Esquema de Protección Sistémica – SPS. Para finales del año 2014 se tiene previsto el ingreso del Esquema de Protección Sistémica para el Sistema Nacional Interconectado ecuatoriano. Este es un esquema inteligente, adaptativo de actuación muy ágil, en el orden de los 200 ms luego de haberse registrado una falla, que censa las condiciones operativas del sistema de potencia, para la definición de una matriz de acciones remediales, tal que al verificar el cambio de estado de las líneas de transmisión en el anillo troncal de 230 kV – la ocurrencia de una doble contingencia – realiza el deslastre de carga y generación en valores precisos, para mantener la estabilidad del Sistema Nacional Interconectado. Este sistema al ser dinámico en la auto - evaluación y definición de la matriz de acciones remediales, requiere de una supervisión permanente de todos los parámetros y variables considerados en su configuración. El impacto será un aumento considerable de actividades delicadas de supervisión de variables en tiempo real; nuevamente responsabilidad directa del ingeniero operador de transmisión. Fortalecimiento en la Gestión con el usuario Final: Uno de los problemas registrados en la coordinación de la operación en el SNI se ubica en las redes de Distribución, en la realización de maniobras para la ejecución de mantenimientos o para el restablecimiento del sistema luego de una falla. En estos escenarios, se han registrado varios errores operativos que han generado problemas en el servicio eléctrico al usuario final o que han agravado los ya existentes: maniobras como la energización de un parte del sistema eléctrico, cuando aún no se ha retirado la puesta a tierra; la verificación no oportuna de sobrecargas en el sistema de distribución, ha producido el disparo de elementos de dicho subsistema, generando eventos de mayor magnitud. Con el objeto de minimizar el riesgo de ocurrencia de estos problemas, al menos en los factores referidos a la coordinación directa entre CENACE y las Distribuidoras, que pueden afectar la operación de la zona de influencia, el operador de transmisión, responsable directo de la coordinación con los actores de distribución, debería enfatizar su función en la coordinación con los CO de distribución, se podría considerar este apoyo en la supervisión de los sistemas de subtransmisión de las empresas, aprovechando la factibilidad de intercambio de información de los sistemas de distribución hacia el EMS de CENACE, vía ICCP. 4. PROPUESTA DE UNA ESTRUCTURA DE RESPONSABILIDADES Y COMPETENCIAS PARA EL EQUIPO DE OPERACIÓN DEL SISTEMA Con los antecedentes repasados, en el sentido que mientras evoluciona el sistema eléctrico de potencia, con el ingreso de más generación y de mayor tamaño, con el aumento de la complejidad en el sistema de transmisión, inclusive con el avance de la tecnología aplicada a la operación y supervisión del sistema de potencia, es necesario dotar al Centro de Operaciones de una estructura más sólida y a los profesionales de la operación, de mejores competencias para poder ir a la par con este desarrollo y mitigar los riesgos que se generan por la sobrecarga en responsabilidades asignadas. A continuación se presenta una propuesta de la estructura del equipo de operación de los turnos en el CO para atender la operación del Sistema Nacional Interconectado. La descripción de las responsabilidades no es exhaustiva, pero se pretende evidenciar las responsabilidades más importantes de esta misión. • • • • • • • • • • Generación • Supervisor Extra y alto voltaje Subtransmisión Distribución • • Figura 2: Propuesta Esquema de Turno • Supervisor de Turno, Responsable de: • La coordinación general de la operación: que las acciones y toma de decisiones que se generen en el Centro de Operaciones, por parte de los ingenieros Operadores del sistema, sean 219 • • coherentes, óptimas y seguras; tanto en el sistema de transmisión, sistema de subtransmisión, las unidades generadores, la coordinación con las empresas distribuidoras, las interconexiones internacionales, el control de la frecuencia. La coordinación general, con sus respectivas contrapartes en los países interconectados, para la ejecución de las maniobras necesarias en las interconexiones internacionales. La definición oportuna de las mejores estrategias durante la operación del sistema en condiciones de emergencia. Responsable de la orientación y guía al equipo de operadores del sistema. La modificación del despacho de las unidades generadoras, en caso de requerirse. Operador de Generación. Responsable de. La ejecución del despacho económico o redespacho de las unidades generadoras, a través de la adecuada coordinación con todos los actores generadores del sistema nacional interconectado. Del control de la frecuencia y del intercambio internacional, a través de la correcta operación del Control Automático de Generación. La operación segura de las unidades generadoras, dentro de los parámetros definidos por cada una de las empresas respectivas. Operador de Transmisión e interconexiones Internacionales. Responsable de: La operación segura y confiable del Sistema Nacional de Transmisión de extra alto voltaje (500 kV) y de los subsistemas de transmisión de 230 kV. La supervisión permanente de las variables del sistema WAMS, identificando oportunamente tendencias que señalen deterioro de las condiciones de estabilidad del sistema. La correcta operación del Sistema de Protección Sistémica, identificando malfuncionamiento del sistema o riesgo en la operación del mismo, a través de los subsistemas que reflejan la coherencia operativa del mismo; las señales y alarmas que se identificarán en el HMI (interface humano-máquina). Operador de Subtransmisión y relación con las Empresas Distribuidoras. Responsable de: La operación segura y confiable del sistema de Subtransmisión 138 kV. La coordinación operativa con las diferentes Empresas de Distribución. El apoyo activo a los actores de distribución, en las maniobras en su sistema de subtransmisión, en condiciones de mantenimiento y de manera especial en condiciones de emergencia, con énfasis en la realización segura de las maniobras requeridas. REFERENCIAS BIBLIOGRÁFICAS [1] Argüello G., Otros. (2013). “Testimonios de Sueños y Realidades”, CENTRO NACIONAL DE CONTROL DE ENERGÍA. 5. CONTRIBUCIONES 1. 2. Se evidencia la necesidad de fortalecer oportunamente la estructura del equipo de turnos del Centro de Operaciones del Sistema Nacional Interconectado, cuando existen cambios radicales en la operación del mismo. Propuesta de una estructura fortalecida del equipo de operadores de turno para la operación del sistema, haciendo énfasis en las responsabilidades de cada uno de ellos, considerando los cambios recientes y los nuevos retos que se darán en los siguientes años. 6. CONCLUSIONES Y RECOMENDACIONES Es necesario reforzar el esquema del equipo de operadores de turno del SNI, considerando el ingreso de un cuarto operador que pueda encargarse de las responsabilidades de la supervisión y operación de los subsistemas de subtransmisión del Sistema Nacional Interconectado y que de manera preponderante se encargue de una relación y coordinación estrecha y dinámica con los centros de operación de las empresas Distribuidoras del país. Roberto Barba Barba.- Nació en Quito, Ecuador, en 1968. Obtuvo el título de Ingeniero Eléctrico en la Escuela Politécnica Nacional del Ecuador en 1996, recibió el grado de Magister en Investigación Operativa en la Escuela Politécnica Nacional en el 2004 y el grado de Magister en Administración de Empresas en la Universidad Católica del Ecuador en el año 2011. Es el Coordinador Titular del Centro de Operaciones del CENACE. Actualmente es el Gerente de los siguientes proyectos: Implementación de un sistema de Monitoreo de banda Ancha - WAMS para el Sistema Nacional Interconectado; Implementación de un Esquema de Protección Sistémico - SPS para la operación estable del Sistema Nacional Interconectado. Es necesario realizar un análisis a detalle del estado de asignación de las responsabilidades de cada uno de los miembros del equipo de operadores de turno del Sistema Nacional Interconectado, para validar la conclusión principal de este artículo. El análisis de las responsabilidades y carga de trabajo de los ingenieros miembros del equipo de turno para la operación del SNI, debe realizarse en condiciones de emergencia del sistema, condición en la que se puede evidenciar el verdadero requerimiento del contingente humano de operadores del sistema. 220 Responsabilidad Socio - Ambiental en Proyectos Hidroeléctricos: El Caso Río Zamora – Santiago P. Martínez L. Ochoa J. L. Espinoza Corporación Eléctrica del Ecuador CELEC E.P., Unidad de Negocio HIDROPAUTE Resumen— CELEC EP-HIDROPAUTE, opera las centrales hidroeléctricas Mazar (170 MW), Molino (1075 MW), supervisa la construcción del proyecto Sopladora (487 MW) y administra la ejecución de los estudios Cardenillo (593 MW) y Río ZamoraSantiago (>5500 MW prefactibilidad). El Gobierno Nacional, a través del Ministerio de Electricidad y Energía Renovable-MEER, establece como política que los proyectos de generación eléctrica deberán impulsar el desarrollo sostenible de las comunidades vecinas, asegurando la calidad, seguridad, gestión ambiental y responsabilidad social. Durante los estudios del Proyecto Hidroeléctrico Río Zamora-Santiago (PHRZS), se identificaron 94 comunidades donde se aplicaron encuestas, asambleas, visitas domiciliarias y entrevistas, lo que permitió el contacto con líderes comunitarios y la población en general para informar y recibir sus expectativas. La mayor expectativa que genera un proyecto de este tipo tiene que ver con la satisfacción de necesidades básicas insatisfechas. Se determinó que el 42% de la población tiene como prioridad el desarrollo de servicios básicos, entre los cuales destaca el servicio de energía eléctrica. La Gestión Socio-ambiental de HIDROPAUTE, considera la implementación de proyectos de desarrollo territorial, tales como agua potable, alcantarillado y electrificación. Para el caso del PHRZS se ha contemplado la ejecución de proyectos de electrificación rural y alumbrado público, a través de convenios con la empresa distribuidora, CENTROSUR. Hasta julio de 2013 se incorporan 205 nuevos clientes, 820 beneficiarios. Se tiene previsto una segunda etapa que incluyen 120 nuevos clientes y alrededor de 500 beneficiarios. Los proyectos de generación eléctrica, si bien pueden cumplir la normativa vigente, no garantizan un adecuado desarrollo de los territorios donde éstos se asientan, mientras que las comunidades exigen mejoras en su nivel de vida. Ello demanda acciones públicas, con un enfoque intersectorial, que trasciende la responsabilidad de “construir un proyecto” y lleva a los promotores a involucrarse en procesos de desarrollo a través de la prestación de servicios básicos. Palabras clave— Generación hidroeléctrica, responsabilidad social, servicios básicos. Abstract— CELEC EP-HIDROPAUTE operates the Mazar Hydroelectric Power Plant (170 MW) and the Molino Hydroelectric Power Plant (1,075 MW), oversees construction of the Sopladora Project (487 MW) and manages studies for the Cardenillo Project (593 MW) and the Rio Zamora Santiago Project (>5,500MW pre-feasibility). The National Government, acting through the Ministerio de Electricidad y Energía Renovable – MEER (The Ministry of Electricity and Renewable Energy) has made it a policy that electric power generation projects should stimulate the sustainable development of neighbouring communities, ensuring quality, security, environmental management and social responsibility. During studies for the Rio Zamora-Santiago Hydroelectric Project (PHRZS), 94 local communities were identified and contacted through surveys, meetings, domestic visits, and interviews, making it possible to contact community leaders and the population in general to inform them about the project and understand their expectations. The highest expectation created by a project of this nature involves satisfying basic unmet needs. It was determined that 42% of the population considers the development of basic utilities to be a priority, and electrical power has been emphasized in particular. Social and Environmental Management of the HIDROPAUTE Business Unit has planned 221 the implementation of certain development projects, such as drinking water, sewerage, and electrification. Where PHRZS is concerned, the execution of rural electrification and public lighting has been planned through agreements reached with CENTROSUR, the energy distribution company. As of July 2013, 205 new clients and 820 beneficiaries have been incorporated. A second stage is expected to follow, which will include 120 new clients and around 500 beneficiaries. While such electric power generation projects may very well comply with current regulations, they do not guarantee an adequate development of the areas where they are implemented, given the demand of local communities to improve their standard of life. This requires public incentive, with a cross-sector focus, which goes beyond the responsibility of “building a project” and leads its developers to become involved in the development process through the provision of basic utility services. Index Terms— Hydroelectric power generation, social responsibility, basic utilities. 1. INTRODUCCIÓN seguridad y que se rijan por criterios de inclusión y responsabilidad social. Por otro lado el Consejo Nacional de Electricidad CONELEC, elaboró el Plan Nacional de Electrificación con sustento en cuatro ejes, uno de ellos el Eje Inclusivo, tiene como uno de sus objetivos “Armonizar el desarrollo y operación de la infraestructura del sector eléctrico con las expectativas de las comunidades”. La Empresa Pública Estratégica Corporación Eléctrica del Ecuador (CELEC EP) está a cargo de la generación y transmisión de energía eléctrica dentro del país. Una de sus Unidades de Negocio, CELEC EP – HIDROPAUTE, opera las centrales hidroeléctricas Mazar (170MW), Molino (1075MW), supervisa la construcción del proyecto Sopladora (487MW) y administra la ejecución de los estudios Cardenillo (593MW) y Río Zamora Santiago (>5500MW, según prefactibilidad). CELEC EP – HIDROPAUTE paralelamente con el avance de los estudios, la ejecución y operación de los proyectos de generación a su cargo promueve el desarrollo sustentable de los territorios ejecutando planes con la participación de las diferentes autoridades, actores sociales, entidades estatales y públicas, de tal forma que se brinde atención a las comunidades de las áreas de influencia de sus proyectos. En este artículo se describe como CELEC EP contribuye a garantizar el acceso universal al servicio de electrificación en dichas comunidades. Una de las estrategias establecidas por el Estado ecuatoriano para promover el desarrollo del país es el cambio de la Matriz Eléctrica. Para ello, el Ministerio de Electricidad y Energía Renovable – MEER, entre los principales aspectos de su gestión, fomenta el incremento de la participación de energías renovables y la soberanía energética, lo cual se refleja en la construcción de 8 centrales hidroeléctricas, el primer parque eólico del Ecuador continental; ejecución de 5 proyectos de energías renovables para las islas Galápagos y estudios de proyectos de generación hidroeléctrica y geotérmica. 2. POLITICAS DE GESTIÓN AMBIENTAL Y RESPONSABILIDAD SOCIAL DE CELEC EP-HIDROPAUTE Con ello se proyecta, a partir del 2016, transformar la matriz eléctrica, actualmente con un peso similar de hidroelectricidad y termoelectricidad, a una con un aporte de energías renovables superior al 90%, básicamente hidroelectricidad. Eje 1: Apoyo al Desarrollo Territorial Para una implementación integral de todos estos proyectos, el MEER establece como política que las empresas promotoras de proyectos eléctricos deberán impulsar el desarrollo sostenible de las comunidades de la región en donde se implanten, con normas relacionadas a sus procesos para asegurar la calidad, gestión ambiental, CELEC EP- HIDROPAUTE consciente de la responsabilidad de implementar procedimientos para el cuidado del Ambiente y el desarrollo de los territorios del área de influencia de sus proyectos, considera 4 componentes en su cadena de valor que conforman los ejes de la Gestión Ambiental y Responsabilidad Social de la Empresa. Una de las estrategias fundamentales de la inversión pública está encaminada a satisfacer la dotación de bienes y servicios esenciales, dotación que permite mejorar y salvaguardar las capacidades de la sociedad en su conjunto y de los individuos que la conforman. En el desarrollo de los proyectos hidroeléctricos a su cargo, CELEC EP-HIDROPAUTE ha establecido acciones encaminadas al fortalecimiento de las comunidades del área de influencia. 222 Eje 2: Educomunicación para el Desarrollo Sostenible Las líneas de acción establecidas son: • Fortalecimiento a los procesos productivos comunitarios • Apoyo a cantones y parroquias del área de influencia de los proyectos hidroeléctricos • Proyectos de electrificación y alumbrado público El objetivo de estas acciones es contribuir al desarrollo socioeconómico de las comunidades del área de influencia, a través de: • Fomentar y fortalecer la organización micro empresarial y la modernización de la producción en el área de influencia • Apoyar el desarrollo de tecnologías de producción amigables con el ambiente • Mejorar los sistemas de infraestructura sanitaria de las comunidades • Mejorar el acceso a los servicios básicos Este eje busca fortalecer y diversificar las capacidades y potencialidades individuales y sociales, y promover una ciudadanía participativa y crítica. En coordinación con el Ministerio de Educación, CELEC EP-HIDROPAUTE realiza actividades encaminadas a la capacitación y constante información de los habitantes de su área de influencia en biodiversidad, gestión de desechos, cuidado de recursos naturales entre otros. La interacción con la población a través de la educomunicación permite complementar y afianzar los proyectos de desarrollo socio ambiental y orientar sobre el manejo de los proyectos hidroeléctricos. Entre las principales actividades desarrolladas se encuentran: educación ambiental, mejoramiento del nivel de ciencias en educación, capacitación técnica comunitaria, e implementación de centros de información. Para el cumplimiento de lo planteado, HIDROPAUTE ha implementado programas con las comunidades y organizaciones, del área de influencia de sus proyectos hidroeléctricos. La fotografía 1 muestra una visita desarrollada por líderes comunitarios de las comunidades del Proyecto Hidroeléctrico Río Zamora-Santiago para conocer los proyectos productivos desarrollados alrededor del Proyecto Paute-Mazar Fotografía 2: Taller “Usos de la Energía”. Escuela Albino del Curto. Cantón Limón Indanza. Fuente: PHRZS Fotografía 1: Visita al proyecto comunitario de truchas Arcoiris. Proyecto Hidroeléctrico Mazar. Fuente: PHRZS Para la ejecución de los proyectos de electrificación, que se detallan más adelante, se han firmado convenios de cooperación interinstitucional con la empresa eléctrica distribuidora de energía Centro Sur, encargada de brindar el servicio en las áreas donde se desarrollan los proyectos hidroeléctricos. Fotografía 3: Visita de estudiantes al Centros de Información Cantón Limón Indanza. PHRZS. Fuente: PHRZS Eje 3: Manejo de la Subcuenca Hidrográfica Encaminado a la protección de los recursos hídricos en las áreas de influencia de los proyectos. Sus acciones fundamentales, con la participación comunitaria, son: 223 • Revegetación y reforestación de las franjas de amortiguamiento de los embalses y en la cuenca hidrográfica • Acuerdos comunitarios para el cuidado de bosques primarios y páramos • Apoyo en el manejo de parques nacionales colindantes con las áreas de los proyectos • Monitoreo y limpieza de embalses • Investigación en recursos hídricos y cambio climático Como parte de la metodología para el desarrollo del proyecto se han establecido mecanismos de comunicación muy cercanos a la comunidad, esto con la finalidad de informar sobre los alcances y avances del proyecto además de solventar inquietudes y temores que surgen alrededor de los mismos. En los trabajos de socialización y levantamiento de información se identificaron 94 comunidades en las cuales se aplicaron: • 565 fichas de encuesta a la población dentro del área de influencia directa de los ríos Zamora y Namangoza. • 680 fichas de encuesta a la población dentro del área de entorno inmediato (área de influencia social). • 130 talleres comunitarios • Fichas de descripción comunitarias. • Fichas de actores sociales • Entrevistas no estructuradas Eje 4: Sistema de Calidad Ambiental Tiene como objetivos fundamentales: colaborar en la implementación y mantenimiento de los Sistemas Integrados de Gestión; implementar los procesos para el cumplimiento de la Legislación Ecuatoriana y asesorar y monitorear los procesos de estudios y construcción de proyectos hidroeléctricos. 3. EL ACCESO AL SERVICIO PÚBLICO DE ENERGIA A PARTIR DE UN PROYECTO DE GENERACIÓN Como se indicó anteriormente, CELEC EP HIDROPAUTE tiene a cargo el Proyecto Hidroeléctrico Río Zamora-Santiago, que se encuentra en etapa de estudios. El proyecto está ubicado en la provincia de Morona Santiago, que cuenta con el 63,9% de viviendas con servicio de energía eléctrica. Figura 1: Mapa de ubicación del Proyecto Hidroeléctrico Río Zamora – Santiago. Fuente: PHRZS La aplicación de las diferentes estrategias nombradas y su complemento con información secundaria permitió realizar un diagnóstico de la situación social y económica del área de estudio. 3.1. Expectativas comunitarias frente al Proyecto Hidroeléctrico El proceso de levantamiento de información y socialización del proyecto permitió el contacto con líderes comunitarios, la realización de asambleas, visitas domiciliarias, reuniones con organizaciones, etc., donde se informa a la comunidad y también se reciben sus expectativas locales de desarrollo y sus inquietudes y comentarios, entre los que se destaca aquel de que “el proyecto es bueno para el país pero la electricidad y los servicios no llegan a sus comunidades”. Tal y como lo expresa el eje inclusivo del Plan Nacional de Electrificación es necesario “Armonizar el desarrollo y operación de la infraestructura del sector eléctrico con las expectativas de las comunidades”. Se ha creído muy enriquecedor poder compartir algunas expresiones textuales de los habitantes del área del proyecto y un resumen de sus expectativas principales alrededor del mismo. 224 Esta información es relevante para responder a la pregunta de por qué una empresa generadora debía involucrarse en la electrificación de las comunidades del área de influencia de sus proyectos: al igual que con otros proyectos de servicios básicos (agua potable, alcantarillado, etc.) el acceso al servicio de electrificación rural es un derecho reclamado durante años por los habitantes de la zona quienes ven a los desarrolladores de proyectos eléctricos como los llamados a satisfacer esa demanda, sin importar si tienen la competencia legal para hacerlo. El no involucrarse en este aspecto puede poner en riesgo las relaciones con la comunidad y, por ende, el éxito mismo del proyecto de generación. Del trabajo de socialización en 70 de las 94 comunidades del área de influencia se ha obtenido una priorización de las principales necesidades expuestas que solicitan sean atendidas durante el desarrollo del proyecto. La Fig. 2 muestra en porcentajes la priorización de expectativas realizada por las comunidades. Necesidades priorizadas por las comunidades Servicios básicos 3%º Atención en salud 10% Crédito 6% 42% 11% 1% 10% Infraestuctura Capacitación Empleo Comercialización 17% Asesoramiento Agrícola Figura 2: Priorización de necesidades comunitarias. Fuente: PHRZS Se muestra que el 42% de las comunidades tiene como prioridad el desarrollo de servicios básicos, entre los cuales está el servicio de energía eléctrica. Fotografía 4: Taller de socialización del Proyecto Hidroeléctrico Río Zamora-Santiago. Cantón San Juan Bosco. Fuente: PHRZS 3.2. La Electrificación Rural desde la Gestión Socio-Ambiental. Una de las estrategias fundamentales de la inversión pública está encaminada a satisfacer la dotación de bienes y servicios esenciales, como es el caso de la electricidad, dotación que permite mejorar y salvaguardar las capacidades de la sociedad en su conjunto y de los individuos que la conforman. Los proyectos de generación eléctrica, con sus respectivos planes de manejo y medidas compensatorias, ejecutados de forma aislada, si bien pueden cumplir con la normativa vigente no garantizan un adecuado desarrollo de los territorios donde se asientan dichos proyectos. Lo paradójico es que las comunidades exigen a los promotores de proyectos mejoras en su nivel de vida. Ello demanda acciones públicas, con un enfoque intersectorial y de derechos, que trasciende la responsabilidad de “construir un proyecto” y lleva a los promotores a involucrarse en procesos de desarrollo a través de la prestación de servicios integrales e integrados. Las intervenciones coordinadas y respetando el ámbito de competencias, pueden ser realizadas en las diferentes etapas de estudio, construcción y operación de los proyectos. 225 Dentro del Eje 1 de Gestión Ambiental de CELEC EP HIDROPAUTE “Apoyo al Desarrollo Territorial” se considera la implementación de proyectos de desarrollo comunitario como aquellos relacionados a la electrificación. Para el caso del Proyecto Hidroeléctrico Río Zamora-Santiago se ha contemplado la ejecución de proyectos de electrificación rural dentro de su área de influencia, a través de la firma de convenios de cooperación entre CELEC EP y la empresa distribuidora de energía, Empresa Eléctrica Regional CENTROSUR. En una primera etapa se contemplaron 8 proyectos de alumbrado público y 12 proyectos de electrificación rural, brindando servicio a 17 comunidades. Se debe indicar que para la selección de los proyectos a ser ejecutados se involucró a los representantes de los Gobiernos Autónomos Descentralizados y aun cuando los proyectos superaron los límites de financiamiento1 , se los consideró viables debido a la necesidad de cubrir un déficit histórico en las comunidades que deben contar con el servicio de energía eléctrica. El siguiente gráfico muestra, en síntesis, los pasos para la construcción de los proyectos de electrificación rural: Levantamiento de línea base (situación actual) de comunidades de área de influencia. Expectativas comunitarias. Fotografía 5: Iluminación de cancha deportiva de Santiago de Panantza. Cantón San Juan Bosco. Fuente: PHRZS Fotografía 6 :Usuario de proyecto de electrificación. Parroquia Bomboa. Cantón San Juan Bosco. Fuente: PHRZS Revisión conjunta con empresa eléctrica distribuidora de las mejores condiciones técnicas para servicio eléctrico (Red Eléctrica o Panel Solar) La Tabla 1 muestra las comunidades atendidas con los proyectos de electrificación en la provincia de Morona Santiago: Priorización de obras con Gobiernos Autonomos Descentralizados. Priorización con líderes comunitarios. Selección de proyectos. Tabla 1:Lista de Proyectos de electrificación PHRZS Convenio de cooperación y ejecución con Empresa Eléctrica Distribuidora. Cumplimiento de requisitos legales. Asignación de recursos CELECCENTROSUR Recepción de obra y puesta a servicio de la comunidad. Los 20 proyectos ejecutados hasta julio de 2013 incorporan 205 nuevos clientes, 820 beneficiarios en total. Se tiene previsto además una segunda etapa donde se estiman 120 clientes y 500 beneficiarios. 1 De conformidad con los criterios vigentes para la selección de proyectos FERUM 226 REFERENCIAS BIBLIOGRÁFICAS 4. CONCLUSIONES Y RECOMENDACIONES Hoy en día en el Ecuador, los proyectos de generación eléctrica, en cualquiera de sus etapas (estudios, construcción u operación) no pueden ser ejecutados de forma aislada, cumpliendo únicamente la normativa vigente, sin considerar la interacción con los territorios donde se asientan dichos proyectos. Las comunidades involucradas demandan mejoras en su nivel de vida lo cual lleva a los promotores de los proyectos a involucrarse en los procesos de desarrollo territorial por medio de intervenciones directas o coordinadas, respetando el ámbito de competencias institucionales. Es importante para una empresa de generación, contar con una estructura definida y un equipo técnico suficiente que haga frente a las demandas comunitarias, respondiendo a una política de responsabilidad socioambiental claramente establecida. En el caso de CELEC EP – HIDROPAUTE y su proyecto Río Zamora -Santiago, queda claro que la responsabilidad socioambiental de la Empresa se vio abocada a responder a una demanda específica: el acceso de la comunidad al servicio de electrificación. La atención oportuna de esta demanda, que es a su vez un derecho de la población, no solo que mejora las relaciones con la comunidad sino además permite desarrollar el proyecto principal en un ambiente de mayor confianza, incrementando su posibilidad de éxito del proyecto. Así, a la pregunta de por qué una empresa generadora debería involucrarse en la electrificación de las comunidades del área de influencia de sus proyectos, a pesar de no ser su competencia, se podría responder con lo siguiente: al igual que con otros servicios básicos (agua potable o alcantarillado) el acceso al servicio de electrificación a más de una necesidad es un derecho de las personas, y son las comunidades quienes tienen el poder de legitimar (o no) al proyecto en desarrollo, en la medida que dicho proyecto aporte a satisfacer esas necesidades. [1] Constitución de la República del Ecuador. [2] Plan Nacional del Buen Vivir 2009-2013. [3] CONELEC (2010) Plan Electrificación 2009-2020. Maestro de [4] Albornoz, E., (2012) Presentación MEER. Visión del Sector Eléctrico Ecuatoriano. [5] Guzmán, P. y Espinoza, J.L. (2010), Gestión Socio-Ambiental en el Proyecto Mazar, Revista Interconexiones, Diciembre, No. 75 Año XX: 5053. México. Luis Alberto Ochoa Pesantez (1976) es ingeniero eléctrico graduado en la Universidad de Cuenca y posee una Maestría en Administración de Empresas de la Universidad del Azuay Ecuador y un Diplomado en Gestión de Proyectos Gubernamentales de la UNAM Ha trabajado como profesor en la Facultad de Ingeniería Eléctrica en la Universidad Politécnica Salesiana, ingeniero de la Dirección de Planificación de la Empresa Eléctrica CENTROSUR, coordinador del Proyecto Hidroeléctrico Minas- Jubones (300 MW), Director de Gestión Técnica Corporación Eléctrica del Ecuador CELEC S.A, 2010-2012, subgerente de Planificación y Procesos de la Unidad de Negocio HIDROPAUTE – CELEC EP y actualmente Director Proyecto Hidroeléctrico Río Zamora-Santiago. Ha realizado investigación para la optimización en diferentes aspectos de los Sistemas Eléctricos de Potencia. Expositor investigador en “Seminarios de Distribución y Comercialización de Energía Eléctrica”, organizados por la ECUACIER 227 Paul Esteban Martinez Mosquera (1972) es ingeniero eléctrico graduado en la Universidad de Cuenca y posee una Maestría en Gestión Tecnológica y un Diplomado en Auditorías Ambientales. Ha trabajado como Gerente del Proyecto Unidades Educativas del Milenio del Ministerio de Educación, Director Ejecutivo de la Unidad Educativa CEDFI, Gerente de Electrónica Control y Sistemas Cía. Ltda. Además, ha trabajado como consultor técnico en el sector privado. Actualmente trabaja como Especialista Ambiental de la Unidad de Gestión Ambiental de HIDROPAUTE, Proyecto Hidroeléctrico Río ZamoraSantiago. Juan Leonardo Espinoza, (1967) es ingeniero eléctrico graduado en la Universidad de Cuenca, tiene una Maestría en Energía y Ambiente del Programa de la Universidad de Calgary y la OLADE. Obtuvo su Ph. D. en la Universidad de Calgary, Canadá, con doble especialidad en Desarrollo Sustentable/Gestión Ambiental y Estrategia. Del 2005 al 2009, trabajó en el Municipio de Cuenca como Director de la Comisión de Gestión Ambiental. En el 2009 fue Subsecretario de Energía Renovable y desde el 2010 laboró en CELEC EP – HIDROPAUTE, donde ocupó el cargo de Gerente de febrero 2011 a junio de 2013. Ha dictado cursos, principalmente de postgrado, sobre Energía, Gestión Ambiental y Estrategia en la OLADE, Universidad de Calgary y en diferentes universidades nacionales. Sus publicaciones y trabajos de investigación han sido presentados en eventos académicos en varios países. Actualmente, es profesor principal en la Facultad de Ingeniería de la Universidad de Cuenca. 228 Revista Técnica “energía” se despliega en un entorno global, patrocina la investigación y fomenta el intercambio de ideas encaminadas al beneficio y desarrollo del Sector Eléctrico, trata sobre avances científicos y tecnológicos, así como, experiencias de alto nivel en Sistemas Eléctricos de Potencia, Mercados Eléctricos y en las Interconexiones Internacionales de Electricidad. La revista cumple una década y marca un hito importante en la publicación sobre el desarrollo técnico, no solo del Sector Eléctrico, sino del país. En las 10 ediciones de la revista se han recopilado 182 trabajos técnicos sobre investigaciones y desarrollos tecnológicos de interés institucional y trascendencia a nivel del Sector Eléctrico. En las tres primeras ediciones, los autores participantes fueron únicamente funcionarios de CENACE; a partir de la cuarta edición se invitó a personas relacionadas con el Sector Eléctrico; y a partir de el año 2008 se premiaron a los mejores trabajos de cada edición. El presente anexo contiene una recopilación de aquellos trabajos galardonados en las ediciones anteriores, y constituye una conmemoración por el décimo aniversario de la revista. Estos trabajos no forman parte de la edición N° 10. 2008 PRONÓSTICO DE DEMANDA PARA SISTEMAS DE SUMINISTRO DE ENERGÍA ELÉCTRICA UTILIZANDO ALGORITMOS EVOLUTIVOS Y RAZONAMIENTO INDUCTIVO FUZZY – DESARROLLO DE LA PLATAFORMA GRÁFICA MERLYN Víctor Hinojosa Investigación y Desarrollo Wladimir Llanos ESPE En efecto, el pronóstico de demanda es fundamental para: RESUMEN En este trabajo se muestra el problema del Pronóstico de Demanda que es necesario para la Planificación de la Operación de corto plazo (horizonte semanal y diario) y muy corto plazo (horizonte diario) en los Sistemas de Suministro de Energía Eléctrica (SSEE). Los modelos y algoritmos desarrollados consideran las incertidumbres asociadas, principalmente a variables climáticas como la temperatura, debido a la correlación que tiene en el corto plazo con la demanda de un Sistema Eléctrico. Los principales puntos que se resuelven en este trabajo: 1. Consideración de un modelo de pronóstico no lineal, basado en Inteligencia Artificial, 2. Planteamiento de un Modelo Multivariable sin necesidad de complejas modelaciones, 3. Obtención de un Modelo Único de Pronóstico válido para distintos horizontes de pronóstico; y, 4. Determinación óptima de las entradas al Modelo de Pronóstico. PALABRAS CLAVE: Pronóstico, Series de Tiempo, Correlación, Razonamiento Inductivo Fuzzy, Algoritmos Evolutivos. 1. INTRODUCCIÓN El pronóstico de demanda hoy en día es una de las tareas más importantes en lo que respecta a responsabilidad y complejidad en Sistemas de Suministro de Energía Eléctrica (SSEE), ya que las sobrestimaciones de la demanda real ocasionan sobrecostos en el despacho económico y las subestimaciones provocan imprevisiones de la Reserva Rotante (Regulación Secundaria de Frecuencia) que pueden ocasionar problemas de estabilidad en el caso de contingencias. El problema del Pronóstico de Demanda que es necesario para la Planificación de la Operación de mediano, corto y muy corto plazo se desarrolla en detalle en esta publicación. 230 71 1) Calcular los balances eléctricos y energéticos. 2) Planificar la programación y ejecución de la operación. 3) Elaborar los planes de expansión, inversiones y reemplazos. 4) Estimar las transacciones de compra y venta de energía y servicios. 5) Presupuestar los ingresos y egresos por dichas transacciones. 6) Calcular el margen de pérdidas y ganancias esperado por el agente. Por tales razones, es muy importante que el pronóstico de demanda minimice todas las incertidumbres, considerando los dramáticos cambios estructurales que se están presentando en los Mercados Eléctricos y la introducción de competencia entre actores como resultado de la desregulación normativa, donde entran en juego intereses económicos que pueden ser afectados por la ineficiencia del pronóstico, por lo que los Agentes y el propio Operador del Sistema deben trabajar con el mayor nivel de eficiencia posible. La demanda eléctrica, al ser una función no lineal de las variables intervinientes, hace que el pronóstico de demanda sea básicamente un problema no lineal. En el corto plazo las condiciones meteorológicas (temperatura, velocidad del viento, humedad, etc.) causan variación en la demanda. Además se debe incluir otras variables exógenas como: tipo de día (laboral o fin de semana), estación del año, día feriado, hora etc., para disminuir la varianza del pronóstico, ya que la demanda presenta zonas de bajo consumo (poca actividad asociada a las horas: de la noche, de un día feriado o fines de semana), zonas de consumo muy pronunciado (zonas de mucha actividad simultánea de diferentes sectores) y zonas intermedias. La organización de la publicación se presenta de la siguiente manera: en la segunda sección se muestra el Estado del Arte, en la tercera sección se discute la descripción del problema, en la cuarta sección se presenta el desarrollo de la plataforma gráfica. Los resultados y las distintas comparaciones matemáticas se dan en la quinta sección, el resumen final y las conclusiones del trabajo se enuncian en la sección sexta y en la última sección se detallan los respectivos agradecimientos. 2. MARCO TEÓRICO Y ESTADO DEL ARTE [4] El razonamiento humano ha sido entendido como un proceso mental de simulación debido a que los humanos somos capaces de tomar decisiones aún sin tener el conocimiento total del fenómeno sólo reconociendo los patrones pudiendo así analizar el comportamiento del sistema. 2.1. Razonamiento Inductivo Fuzzy – FIR La metodología Fuzzy Inference Reasoning (FIR) es una implementación de la metodología de análisis general de sistemas “General System Problem Solver (GSPS)”, que posibilita estudiar los modos conceptuales de comportamiento de sistemas dinámicos. Fue reimplementada por F. Cellier de la Universidad de Arizona. Mediciones Fuzzy fueron añadidas a la metodología de modelación para tratar las incertidumbres de los límites, donde también se incluye el tratamiento de valores perdidos y las mediciones para estimar la predicción del error. Fuzzyficación (Fuzzy Recoding) El objetivo de este proceso es aumentar drásticamente la velocidad de optimización. Si tenemos una relación entre n entradas y una salida, en lugar de realizar la búsqueda en el espacio continuo n-dimensional para encontrar el óptimo patrón de entrada/salida, la búsqueda es limitada al espacio discreto c-dimensional de los valores clase. Este proceso convierte los datos cuantitativos que describen el comportamiento del sistema (series temporales: demanda y temperatura y variables auxiliares: tipo de día, etc.) a una trayectoria triple cualitativa. El primer elemento de la variable triple se llama “valor clase” (class value) y representa una discretización gruesa de los valores originales de la variable. El segundo elemento se llama “valor de membresía fuzzy” (fuzzy membership value) y denota el nivel de confianza expresado en el valor clase elegido para representar un particular valor cualitativo. El tercer elemento se llama “valor del flanco” (side value), el cual indica si el valor cuantitativo está a la derecha o a la izquierda del valor pico de la función de membresía fuzzy asociada. El valor del flanco que es particular de la metodología FIR (no es comúnmente utilizado en la lógica fuzzy), es responsable de preservar el completo conocimiento del valor original cuantitativo. Modelación Cualitativa (Qualitative Modeling) En la Figura 1 se muestran las cuatro etapas de la metodología. FIR ModelaciónCualitativa Entradas del Sistema Salidas del Sistema Matrizde datos Cuantitativos delsistema Pronóstico Cuantitativo delsistema Fuzzyficación Defuzzyficación Regeneración Datos Cualitativos (triples) Pronóstico Cualitativo (triples) Identificacióndela máscaraóptima Máscaraóptima La modelación cualitativa tiene como objetivo identificar los patrones (espaciales y temporales) en el tiempo, mediante la determinación del grupo de variables de entrada que mejor explican el comportamiento entrada – salida. Tal relación es llamada máscara de correlación (mask). En la metodología de pronóstico se utilizó para encontrar las entradas del modelo (máscara de correlación) los algoritmos evolutivos “Simulated Rebounding Algorithm”, como se detalla en el ítem 2.2. Obtencióndela “Rulebase” Pronóstico Fuzzy SimulaciónCualitativa FIGURA 1: Razonamiento Inductivo Fuzzy Simulación Cualitativa (Qualitative Simulation) Es importante notar que el razonamiento propiamente dicho no involucra las etapas de fuzzyficación y defuzzyficación, pero son esenciales para que la metodología FIR opere en un entorno mixto (cualitativo/ cuantitativo) de modelación y simulación. El objetivo de esta etapa es analizar y aprender patrones observados en la máscara de correlación con el fin de predecir el comportamiento futuro en base a los datos históricos. 72 231 El pronóstico opera en dos etapas: 1) Etapa determinística: el patrón de entrada para el pronóstico es extraído de la matriz de valores clase por medio de la máscara y es comparado con todos los patrones análogos de la matriz de comportamiento del sistema (datos históricos). Para todos aquellos patrones que coinciden con el patrón de entrada, se observan los valores clase de salida. 2) Etapa estadística: se realiza la predicción del valor más probable de salida, a partir de las observaciones anteriores, mediante un promedio ponderado de los valores más próximos en la base de datos de entrenamiento. En esta etapa se utiliza la regla 4-NN (4 más cercanos vecinos). Defuzzyficación (Regeneration) En esta etapa las predicciones de los valores de membresía, funciones flanco y clase de la salida promedio son convertidas a predicciones cuantitativas usando la operación inversa a la fuzzyficación. 2.2. Algoritmos Evolutivos – SRA Para encontrar las entradas al modelo de pronóstico se consideró la aplicación del algoritmo Simulated Rebounding Algorithm (SRA), que pertenece a la clase de algoritmos estocásticos (randomization algorithms) basados en búsqueda local aleatoria controlada (como lo es, entre otros, el Simulated Annealing). El SRA ha sido contrastado con el Simulated Annealing y algunas implementaciones de Algoritmos Genéticos en problemas de optimización con similares características y debido a la alta performance del mismo es que se eligió como motor de optimización del desarrollo aquí planteado. rebotes inelásticos, la pelota choca con distintos puntos de la superficie, desviada por los mismos rebotes sobre una superficie no plana. Si la superficie posee “valles” y “lomas”, los puntos pertenecientes a un valle tendrán menor energía potencial que las lomas. Por la acción de la gravedad, la pelota buscará detenerse sobre algún valle, y dependiendo de la energía cinética que posea, será capaz de saltar montes para explorar nuevos valles. La analogía con un problema de optimización combinatorial se realiza haciendo una equivalencia entre la superficie de rebotes y el espacio de soluciones, y entre la altura de cada punto de la superficie y el valor de la función de costo correspondiente a esa solución. El SRA resulta así una extrapolación multidimensional del proceso físico de rebotes. Debido a la acción de la gravedad y a la pérdida gradual de energía cinética y potencial debido a las colisiones, al final del proceso de rebotes simulados, la pelota se detiene sobre el mínimo global (punto de menor altura de la superficie) o sobre algún mínimo local cercano al global. La Figura 2 muestra por simplicidad un ejemplo unidimensional: como se muestra con las líneas de trayectoria, la pelota puede alcanzar el mínimo global (escalón 11) si es lanzada desde el punto A ó C; sin embargo, es atrapada en el mínimo local del escalón 14 si la pelota es lanzada desde el punto B. Es decir, el mínimo global es alcanzado si la energía potencial inicial (Eo), y el porcentaje de pérdida de energía debido a colisiones inelásticas (α) permiten saltar todos los mínimos locales durante el proceso de rebotes. Eo C B A 17 1 La Simulación del Proceso Físico de Rebotes Simulados Suponiendo que se lanza una pelota con coeficiente de elasticidad cercano a 1 sobre una superficie S, la pelota caerá sobre la superficie debido a la acción del campo gravitatorio en el cual esta inmersa. El choque producido por la caída podrá afectar a la energía cinética de la pelota si parte de esta energía es disipada en deformaciones permanentes (choque inelástico). Estas deformaciones serán proporcionales a la energía cinética del choque, siendo ésta la equivalente a la diferencia de energía potencial desde el punto de choque hasta la altura desde la cual cae la pelota. Si el proceso no es detenido, los rebotes se detendrán cuando la energía cinética de la pelota sea cero. En este proceso de 14 11 FIGURA 2: Ejemplo Unidimensional de Rebotes Simulados En el SRA las deformaciones producidas por las colisiones pueden ser de tres tipos: a) Deformación transitoria, es decir, que la pelota no pierde energía cinética por ser la altura de la caída pequeña. b) Deformación leve, cuando la pelota rebota sobre las paredes de un valle por ser su energía 73 232 potencial menor que la altura del punto de destino, disminuyendo su energía potencial en un valor pequeño. c) Deformación permanente, cuando la pelota pierde energía cinética debido a una colisión provocada por una altura considerable de caída. Estos tipos de deformación actúan en el proceso de optimización de diferente manera. La deformación transitoria es la que permite explorar el espacio de búsqueda. Si sólo existiera este tipo de deformaciones, el proceso no se detendría nunca, si no fuera por la pérdida de energía provocada por fricción y rozamiento. La deformación leve disminuye la energía de la pelota cuando es atrapada en un valle, y provoca la detención del proceso si no existe ninguna solución con energía potencial menor que la de la pelota (valle profundo). La deformación permanente acelera la convergencia hacia el óptimo, ya que disminuye la energía potencial de la pelota cuando ésta es muy superior a la de la superficie en el entorno de rebotes. 3. 4. DESARROLLO DE GRÁFICA – MERLYN LA PLATAFORMA En el estado del arte de la Inteligencia Artificial se menciona que los sistemas híbridos que combinan lógica fuzzy, redes neuronales, algoritmos genéticos y sistemas expertos proporcionan los métodos más eficientes para resolver una gran variedad de problemas. En la Figura 3 se muestra la pantalla principal de la aplicación desarrollada en Visual C. DESCRIPCIÓN DEL PROBLEMA La demanda que se considera para el análisis es la generación bruta del SSEE del Ecuador. Además, se utiliza solamente la temperatura máxima de la Costa, debido a la correlación encontrada en investigaciones anteriores [4]. En este sistema se registran los valores de demanda horarios, incluyéndose el dato de las 19:30, ya que a esta hora aproximadamente se produce el pico máximo de demanda, por lo tanto se consideran 25 períodos (23 horarios y 2 de media hora). FIGURA 3: Pantalla Principal de la Interfaz MERLYN 4.1. Cargar Datos de Demanda Primeramente, se debe cargar el archivo (base de datos.xls) donde está la base de datos histórica de la demanda, este archivo cuenta con datos históricos desde el 01 de enero de 2006 hasta las 24:00 del sábado 18 de agosto de 2007. En la Figura 4 se muestra este procedimiento. En la Tabla 1 se muestra la estructura del sistema multivariable para el pronóstico de demanda. TABLA 1: Sistema Multivariable para el Pronóstico TIPO DE DÍA T_max costa DEMANDA day (t-n) TM_Gye (t-n) load (t-n) day (t-n-1) TM_Gye (t-n-1) load (t-n-1) … … … day (t-1) TM_Gye (t-1) load (t-1) day (t) TM_Gye (t) load (t) FIGURA 4: Pantalla para Cargar la Base de Datos El análisis que se va a mostrar en la siguiente sección corresponde al procedimiento del pronóstico semanal, pudiendo realizar actualizaciones diarias y horarias al pronóstico. Ahora, se debe cargar el archivo plano (RGDSM19.09) el cual es generado por el Área Centro de Operaciones, este archivo contiene los datos de demanda real hasta 74 233 las 09:00 del domingo 19 de agosto. En la Figura 5 se muestra el procedimiento. Finalmente, se obtiene las últimas 20 semanas de datos reales (3 500 datos), en investigaciones anteriores se ha demostrado la eficiencia en tiempo y precisión de esta ventana dinámica. 4.2. Análisis de Clases para la Demanda Para que el algoritmo de pronóstico, basado en la metodología FIR & SRA, pueda ejecutarse se necesita conocer los valores de demanda para cada período (pico, media, valle y resto). Para estimar estos valores de demanda se utiliza un algoritmo de Clustering llamado Fuzzy C-Means [1], el cual ha obtenido resultados confiables y precisos. FIGURA 5: Pantalla para Cargar el Archivo Diario (Plano) Finalmente, para terminar con el proceso de obtención de los datos de demanda, se ha desarrollado un algoritmo para validar los últimos datos reales de demanda (nueve horas del domingo 19 de agosto) – se supone que los datos de demanda están previamente validados hasta el día sábado 18 de agosto. Se muestra estos datos utilizando una tabla de Excel con su respectivo gráfico. Como resultados de esta etapa, se obtiene los valores reales de cada período de demanda, considerando que de lunes a viernes se tiene 4 clases (pico, media, valle y resto), el sábado se tiene 3 clases (pico, media y valle) y el domingo se tiene 2 clases (pico y valle). En la Figura 7 se visualiza la aplicación del algoritmo, para las 20 semanas de datos consideradas anteriormente. En la interfaz se muestran los datos reales del mismo día para las 3 semanas anteriores (12 de agosto, 05 de agosto y 29 de julio) y la respectiva media muestral de estos 3 días. En la Figura 6 se muestra el algoritmo de validación de la demanda. FIGURA 6: Algoritmo de Validación de Datos El dato erróneo se lo corrige utilizando el valor medio de la demanda del mismo día de las 3 semanas anteriores (1 339,5 MW) ó en el caso de una desconexión se puede ingresar el valor desconectado de demanda. Una vez que se ha validado los nuevos datos se procede a guardar la nueva base de datos (tiene 9 datos reales más que la base de datos anterior). 75 234 FIGURA 7: Análisis de los Períodos de Demanda 4.3. Algoritmo de Entrenamiento Supervisado Basado en el Algoritmo SRA El método de entrenamiento que se propone aplicar es el “Aprendizaje Supervisado”, utilizando como valor de referencia los datos horarios de la demanda de la última semana de entrenamiento. Para encontrar las entradas del modelo de pronóstico, tal que esta configuración minimice la sumatoria de los errores obtenidos en la última semana de entrenamiento, se utiliza - para el cálculo del error - el pronóstico de demanda para 1 hora en adelanto1 y la demanda real histórica para dicha hora. El análisis del espacio de soluciones se realiza mediante la minimización de la función de evaluación o “función objetivo”, que es igual al promedio de los últimos 175 errores relativos del pronóstico horario respecto del valor real histórico de la demanda para la semana de entrenamiento, según lo expresa la ecuación (1). 175 Error (v) E( t ) ˆ ¥ D t ¤ ¦¦ i 1 § i Dreal ,t Dreal ,t i i ´ µ µ ¶ *100 [%] (1) Este entrenamiento es repetido cada semana, ya que se considera que las entradas halladas por el algoritmo son válidas para 1 semana. Por lo tanto, el algoritmo nuevamente deberá ser repetido a las 09:00 del domingo 26 de agosto de 2007. 4.4. Pronóstico de Demanda Utilizando la Metodología FIR i) La Dirección de Planeamiento del CENACE debe realizar la Programación de la Operación de Mediano y Corto plazo (de 24 horas hasta 168 horas en adelanto), para lo cual requiere: • Pronóstico de demanda con 1 semana de adelanto, es decir necesita el pronóstico de demanda con 168 horas de adelanto (mediano plazo): para la Programación Semanal. • Pronóstico de demanda con 24 horas de adelanto: para la Programación Diaria. En la Figura 9 se muestra el pronóstico semanal. 175 Donde: Dt = Dreal,t = Es el pronóstico para la hora t. Es la demanda histórica real de la hora t durante la última semana de los datos de entrenamiento. En la Figura 8 se muestra la ejecución del algoritmo de entrenamiento. Una vez que el entrenamiento terminó (8,82 min), se debe cargar las entradas óptimas del modelo de pronóstico que se obtuvieron. FIGURA 9: Menú para Pronóstico Semanal, Diario y Horario El pronóstico de demanda se lo guarda también en un archivo de texto (stlf_result.txt), con lo que la Dirección de Planeamiento podría utilizar estos datos para realizar la Programación Semanal. Para el pronóstico diario (un día de adelanto), se utilizaría los 25 datos de demanda del lunes 20 de agosto (stlf_result.txt), datos que servirán como entrada para el Despacho Económico. El modelo desarrollado tiene la ventaja de incorporar los últimos datos reales del sistema para analizar FIGURA 8: Menú para Entrenamiento Supervisado 1 “1 hora de adelanto” significa que se asumen conocidos todos los datos para las horas anteriores a la pronosticada. “1 día de adelanto” significa que se pronostican 24 horas para t+i (i=0,..,23), considerando conocidos (reales) 76 235 todos los datos para las horas t-j (j>0) y tomando los valores pronosticados ya calculados entre la hora t y t+i-1. la nueva tendencia de la demanda con respecto al pronóstico semanal. Para el pronóstico de demanda del martes, se debería incorporar los datos reales de demanda del domingo 19 y los 9 datos reales de demanda del lunes 20 de agosto). En la Figura 10 se muestra el pronóstico de demanda para el martes 21 de agosto, no es necesario realizar el Clustering de la demanda, y con las mismas entradas obtenidas en el entrenamiento anterior (se considera que estas entradas son válidas para pronosticar desde las 10:00 del domingo 19 de agosto hasta las 23:00 del domingo 26 de agosto) se realiza el pronóstico. FIGURA 11: Aplicación al Pronóstico de Muy Corto Plazo Para realizar este pronóstico hace falta solo cargar la base de datos (base de datos.xls y el RGDS19.09 se debe proceder a validar los 16 valores de demanda de este archivo, correspondientes desde las 10:00 hasta las 24:00) y no es necesario realizar el Clustering de la demanda. 5. ANÁLISIS DE RESULTADOS Se utiliza el error relativo porcentual definido en la ecuación (2), para comparar el performance del modelo de pronóstico. Error x _ real x _ pronosticada *100 x _ real (2) Donde: FIGURA 10: Aplicación al Pronóstico para 1 Día de Adelanto x = Representa el valor de demanda horario. ii) La Dirección de Operaciones del CENACE debe realizar la Programación de la Operación de Muy Corto Plazo (de 1 a 24 horas de adelanto), para lo cual requiere: • Pronóstico de demanda desde 1 a varias horas en adelanto. Los 16 datos de iniciales, correspondientes al domingo 19 de agosto (ver Figura 9) los podría utilizar el Área Centro de Operaciones. Datos que servirán para analizar la tendencia de demanda desde las 10:00 hasta las 24:00. En la Tabla 2 se detallan la media y la desviación estándar del error de test, considerando 3 semanas de test simuladas (del 11 al 24 de septiembre de 2000 y del 08 al 14 de mayo de 2006), resultantes de la aplicación de la Metodología FIR & SRA [4] y su comparación con los resultados obtenidos con el método ARIMA (CENACE), modelo Neuro – Fuzzy [2] y con las Redes Recurrentes de Jordan (RR) [3]. Se muestra además el error máximo obtenido en el pronóstico con cada uno de los Métodos de Pronóstico antes mencionados. El modelo desarrollado tiene la ventaja de incorporar los últimos datos reales del sistema, por lo tanto, se podría incorporar los datos reales hora a hora y obtener una estimación de la curva de demanda hasta finalizar el día. En la Figura 11 se muestra el pronóstico de demanda cuando se ha cargado los valores reales de demanda del domingo 19 de agosto. 77 236 TABLA 2: Media, Desviación Estándar y Máximo Error Obtenido con Distintos Métodos de Pronóstico. Análisis de Errores Período 1 MÉTODO DE PRONÓSTICO MEDIA DESVIACIÓN E_max ARIMA 1,5873 1,2617 8,0298 RR - JORDAN 1,4729 1,2064 7,1311 ANFIS 1,4364 1,1817 6,992| FIR & SRA 1,1672 1,0633 6,3374 Se realizaron pruebas on-line del pronóstico entre los resultados obtenidos por la DPL con el método ARIMA y el pronóstico que obtuvo ID con la metodología FIR & SRA considerando como período de prueba desde el 02 de enero hasta el 24 de enero de 2007, en la Tabla 3 se detalla la media del error. • Esta modelación Cualitativa – Cuantitativa posee la ventaja de poder incluir n variables explicativas, sin necesidad de una modelación compleja, debido a la formulación multivariable inherente al Razonamiento Inductivo Fuzzy. • Frente a la limitación que presentan las metodologías tradicionalmente usadas en series de tiempo, las cuales encuentran mediante la función de autocorrelación parcial un grupo de entradas que son validas para un determinado período de tiempo (por ejemplo una estación del año), la nueva metodología aquí propuesta realiza un proceso dinámico de selección de entradas del modelo, que posibilita realizar un seguimiento a la tendencia de la demanda en forma instantánea. • La intervención del Planificador u Operador es mínima, ya que los parámetros necesarios del modelo son intuitivos y optimizados por la misma metodología. • Tanto los modelos como los algoritmos desarrollados han sido validados exhaustivamente con datos provenientes de la demanda real del SSEE del Ecuador. • Este desarrollo poseen un potencial de aplicación que excede en gran medida el ámbito del Pronóstico de Demanda y son por tanto aplicables a otros problemas de la Planificación y Operación de sistemas de potencia como por ejemplo el Pronóstico de Caudales. TABLA 3: Análisis de Errores Período 2 MÉTODO DE PRONÓSTICO MEDIA ARIMA 2,2 FIR & SRA 2,2 Por pedido de la DEJ considerando la importancia del mantenimiento de la fase AB de la Central Paute (5 x 105 MW), se realizó el pronóstico de demanda para la semana desde el 17 al 23 de febrero de 2007. En la Tabla 4 se detalla la media del error. TABLA 4: Análisis de Errores Período 3 MÉTODO DE PRONÓSTICO MEDIA ARIMA 1,9545 FIR & SRA 1,4696 La mejor performance, con respecto al Pronóstico de Demanda para un día en adelanto, se obtiene con la metodología FIR & SRA, con respecto a los otros métodos de pronóstico, reduciendo el error del pronóstico en un 17%, respecto a la Metodología de Referencia (ARIMA). 7. Se ha demostrado también que esta metodología tiene un excelente performance para el pronóstico de demanda de muy corto plazo (de 1 hasta 24 horas en adelanto). 6. • CONCLUSIONES Se ha resuelto el Pronóstico de Demanda con un horizonte de hasta 1 semana en adelanto (para la Programación Semanal) incluyendo la actualización diaria mediante la incorporación de nueva información relacionada con las variables explicativas de “demanda” (para la Programación Diaria). El modelo planteado presenta la ventaja de utilizar información real del sistema eléctrico de los últimos períodos horarios de demanda y poder así estimar el comportamiento de la nueva tendencia de la demanda, disminuyendo así las desviaciones de la demanda real con respecto a la demanda pronosticada (subestimación o sobreestimación). [1] BIBLIOGRAFÍA BEZDEK J. C.; Fuzzy Mathematics in Pattern Classification, Tesis doctoral, Centro de Matemáticas Aplicadas, Universidad de Cornell, 1973. [2] HINOJOSA V.; Pronóstico de Demanda de Corto Plazo en Sistemas de Suministro de Energía Eléctrica utilizando ANFIS, III Congreso Internacional de la Región Andina, Quito, 2007. [3] HINOJOSA V.; Pronóstico de Demanda de Corto Plazo en Sistemas de Suministro de Energía Eléctrica utilizando Redes Recurrentes (Jordan), XI ERIAC, Paraguay, 2005. [4] HINOJOSA V.; Pronóstico de Demanda de Corto Plazo en Sistemas de Suministro de Energía Eléctrica utilizando Inteligencia Artificial, Tesis de doctorado, Instituto de Energía Eléctrica de la Universidad Nacional de San Juan, Argentina, 2007. 78 237 Víctor Hinojosa Mateus.Nació en Quito, Ecuador en 1975. Recibió su título de Ingeniero Eléctrico en la Escuela Politécnica Nacional en el 2000. Desde enero del 2000 hasta julio del 2001 se desempeñó como Ingeniero de Operación y Transmisión en el CENACE. En el período agosto 2001 a julio 2005 realizó estudios de doctorado en el Instituto de Energía Eléctrica de la Universidad Nacional de San Juan en la República Argentina, a través de una beca otorgada por el Servicio Alemán de Intercambio Académico (DAAD). Actualmente, se desempeña como Investigador en el Área de Investigación y Desarrollo del CENACE y es profesor en la EPN. Sus principales áreas de interés están enmarcadas en la Operación y Planificación de Sistemas Eléctricos de Potencia utilizando Técnicas de Inteligencia Artificial. Wladimir Llanos Tapia.Nació en Cuenca, Ecuador en 1983. Es egresado de la Carrera de Ingeniería de Sistemas e Informática en la Escuela Politécnica del Ejército. Actualmente realiza su tesis de grado en el Área de Investigación y Desarrollo del CENACE. Sus principales áreas de interés están enmarcadas en la Operación y Planificación de Sistemas Eléctricos de Potencia utilizando Técnicas de Inteligencia Artificial. 79 238 2009 PAGO DE POTENCIA A TRAVÉS DE OPCIONES PERSPECTIVAS DE APLICACIÓN AL MERCADO ELÉCTRICO DEL ECUADOR José Oscullo L. Corporación CENTRO NACIONAL DE CONTROL DE ENERGÍA -CENACEResumen.- En la actualidad los mercados de energía eléctrica pasan por una profunda reestructuración; especialmente en la creación de instrumentos para agilitar las transacciones y reducir el riesgo comercial entre los diferentes agentes del mercado eléctrico. El riesgo comercial, aparece debido a la disponibilidad de las unidades del sistema eléctrico para el caso de las centrales hidroeléctricas es el caudal de los ríos que poseen una elevada aleatoriedad. En las primeras etapas de la reestructuración todos los esfuerzos se han centrado en resolver los problemas particulares de cada mercado; de esa manera tender a la creación de mercados suficientemente líquidos y con una adecuada estructura competitiva, todo ello encaminado a garantizar que la oferta de energía se adecue a la demanda en todo momento, más las señales económicas para la oferta de generación; debe buscar ser estables y con mecanismos claros y transparentes para todos los agentes lo que permita la instalación de capacidad de potencia disponible en el sistema y con ello sea sustentable el sistema de una manera técnica, política como económicamente. Dichas características la presentan los mercados financieros específicamente las opciones. Para poder enfrentar estos inconvenientes presentes en el mercado, resulta útil analizar a otros mercados con características similares; el presente trabajo realiza el estudio del mercado de opciones para la remuneración de potencia aplicado al sector eléctrico y la aplicabilidad de esta metodología en Ecuador. Palabras Claves.- Mercado Eléctrico, Opciones, Pago de Potencia 1. El Sector Eléctrico Ecuatoriano El sector eléctrico ecuatoriano para el año 2007 está constituido en su fase de generación por 14 empresas generadoras (privadas o públicas o mixtas) que abastecen el 90.4% de la demanda nacional anual y el 9.6% se encuentra conformado por la generación de las empresas de distribución, autoproductores y generación no convencional. Las empresas de generación operan centrales hidroeléctricas mayoritariamente y térmicas; la transmisión lo realiza la empresa de transmisión TRANSELECTRIC cuyo propietario es el estado por medio del Fondo de Solidaridad, la distribución de energía eléctrica se realiza por medio de 18 empresas que poseen la respectiva concesión para suministrar el servicio. El sistema eléctrico ecuatoriano posee una capacidad instalada a diciembre de 2007 de 3751 MW de los cuales 2022 MW son de generación hidráulica. En el año 2007 se presentó en promedio 710.3 MW-mes indisponibles, el cual representa un aumento del 3.27% respecto a la indisponibilidad del año anterior. La demanda máxima de potencia del año 2007 alcanzó el valor de 2706.3 MW. La energía en los puntos de entrega de consumo fue de 14665.85 GWh que fue abastecida por la producción de generación 14356.8 GWh, de los cuales 860.87 GWh provienen de las interconexiones eléctricas de Colombia. La estructura de la demanda es la siguiente: un 45.91% se presenta en el ámbito de concesión de la Empresa Eléctrica Quito (20.65%) y de la Corporación para la Administración Temporal Eléctrica de Guayaquil –CATEG- (25.26%), distribuidoras encargadas del suministro a las ciudades de Quito y Guayaquil, el 54.09% representa a 17 empresas de distribución y 85 Grandes consumidores. A partir del 10 de octubre de 1996 debido a la publicación de la ley del Régimen del Sector Eléctrico del Ecuador-LRSE- el estado realizó la reestructuración del sector eléctrico, el cual establece las reglas económicas para la interacción entre los diferentes componentes de la industria eléctrica: generación, transmisión, distribución y grandes consumidores y crea el mercado eléctrico mayorista y norma sus funciones y estructura. En todos los países la reestructuración en mayor o menor grado cuenta con la participación privada y el gobierno como regulador y controlador para permitir el normal desenvolvimiento del mercado. En la Figura 1 se muestra la estructura de las instituciones creadas para la conformación del mercado eléctrico. 239 contratos y con ello ser parte del reparto de los ingresos e incentivos; característica de cualquier modelo competitivo. PRESIDENCIA DE LA REPUBLICA Regulador Comité de Ejecución de Políticas del Sector Eléctrico CEPSE Ministerio de Electricidad y Energías Alternativas Ministerio de Economía y Finanzas Subsecretaria de Electrificación Formulación de Políticas MEM Participación del Estado (Fondo Solidaridad) Lo indicado anteriormente crea un mercado de potencia, por medio de la adopción de un procedimiento periódico llevado adelante por el ente regulador , él cual deberá convocar a una subasta donde los agentes compitan para vender opciones estandarizadas en base al precio de la energía. Coordinación Empresas de Generación (70% Fondo Solidaridad) Empresas de Transmisión (100% Fondo Solidaridad) Empresas de Distribución y Comercialización (60% Fondo Solidaridad) CENACE Administrador Técnico-Comercial Grandes Consumidores FIGURA 1: Estructura y funciones del Mercado Eléctrico Mayorista Ecuatoriano –MEM-Fuente: CONELEC Los generadores participantes en el mercado Eléctrico Mayorista -MEM- pueden negociar dos productos energía y potencia regidas cada una por una normativa particular. El mercado de potencia está determinado por medio del artículo 48 LRSE y el RSFMEM , donde se definen de forma explícita los conceptos de potencia que son remunerados por parte del MEM y mediante regulación se detalla la metodología de cálculo de la magnitud de potencia a ser remunerada a cada generador; los conceptos que considera la normatividad son: • Potencia Remunerable Puesta a DisposiciónPRPD-. • Reserva para Regulación Secundaria de Frecuencia. • Reserva Adicional de Potencia. De los instrumentos financieros las opciones se definen por una cantidad contratada (en MW), un precio de ejercicio de la opción “strike price” y una cierta cantidad de dinero que se denomina prima de la opción. A cambio de recibir dicha prima, el agente que vende la opción, se compromete a compensar al consumidor cada vez que el precio de mercado supere el precio de ejercicio de la opción, por medio de la diferencia entre el precio del mercado y el precio de ejercicio. El procedimiento para la implantación del mercado de potencia a través de opciones contempla los siguientes pasos: La potencia reconocida a cada generador para el caso del estudio representa la PRPD, se valora al precio unitario de potencia –PUP- cuyo valor es determinado por el CONELEC, corresponde al costo unitario mensual de capital más costos fijos de operación y mantenimiento de la unidad generadora más económica que puede suministrar generación en la demanda máxima en condiciones hidrológicas secas; siendo de 5.7 $/kW mes. 2. Mercado de Opciones para el Pago de Potencia El mercado de opciones, entrega al mercado la responsabilidad de definir el valor a pagar por la potencia, sin una participación activa de los consumidores, debido a los problemas que se detallaron, sino a través del operador del sistema el cual contrataría a nombre de la demanda una cierta cantidad de potencia determinada por él. Con lo que la competencia por acceder a los 240 • Cada período de tiempo, el regulador determina el nivel de potencia que requiere el sistema, la cantidad de opciones a adquirir a nombre de la demanda convocando una subasta para cubrirla. • Las unidades de generación realizan ofertas en precio y cantidad. Donde el precio corresponde a la mínima prima que desean obtener y la cantidad es la potencia (MW) que desean adquirir en forma de opciones. • Cada unidad de generación puede realizar varias ofertas, de acuerdo al número de bloques de potencia (MW) hasta alcanzar su capacidad disponible. • Las ofertas se ordenan desde la de menor a la de mayor precio; esto permite ordenar las ofertas más convenientes para cubrir el nivel de demanda que requiere el sistema, estos bloques de potencia son aceptados y los que quedan sobre la demanda constituyen las ofertas rechazadas. • La potencia asignada a cada generador depende de las ofertas aceptadas en la subasta. • La prima marginal unitaria a recibir por cada generador, es igual a la oferta más cara aceptada. • El precio de ejercicio de la opción es determinado por el regulador y anunciado a todos los participantes de la subasta para que lo consideren en la oferta. • Para períodos similares se asignara opciones al mismo tiempo y precio siempre y cuando se trate de una demanda semejante. • Los ingresos de cada generador se obtienen de la multiplicación de la prima marginal unitaria con la cantidad MW aceptada en la subasta. • Los generadores aceptados en la subasta se comprometen con los consumidores a compensarlos por la diferencia positiva de la relación precio de mercado - precio de ejercicio. Con lo que los consumidores se cubren respecto a precios altos en el mercado. • Los cobros y pagos se liquidan de manera análoga que en una bolsa de valores; es decir; el cobro de la prima y el pago de las compensaciones son simultáneos a fin de evitar distorsiones financieras. La figura 2 ilustra el mercado de potencia propuesto. R e g u la d o r Demanda Máxima Y TIEMPO Para la formación de las ofertas se considera los siguientes pasos: Paso 1: Generación despachada y horas críticas del sistema La generación despachada considerando la declaración de mantenimientos de los agentes y la curva de pronóstico de la demanda realizada por el regulador por medio del modelo, se ordena por mes y serie para cada generador. Las horas críticas son aquellas horas en las que el costo marginal del sistema es mayor que el precio de ejercicio que por lo general está situación es cuando en la simulación aparece racionamiento. Paso 2: Generación mínima mensual De acuerdo al ordenamiento de cada generador se selecciona la generación mínima mensual en MWh. Paso 3: Potencia mínima mensual. La energía mínima obtenida en el paso 2, se transforma a potencia media (MW), debido al ser energía mínima son potencias mínimas. Mercado de Potencia Operador del MEM Ofertas de Plantas Hidráulicas. Paso 4: Ordenación ascendente de potencias C o m is ió n p a ra Generadores La potencia mínima de cada serie se ordenan de manera creciente; la potencia mínima de las mínimas es la más firme. S U B AS TA Paso 5: Cálculo de la prima para cada potencia mínima C o m is ió n p a ra Para cada potencia mínima de cada serie se obtiene la prima por medio de la ecuación 1 S U B AS TA COBRO S - PAGOS k −1 H 1 Prima [ Pk (CENS − s ) + ( Pk − Pi ) * pen] (1) k = Pk NS i =1 zz ∑ FIGURA 2: Diagrama del Mercado de Opciones Propuesto. Fuente: Elaboración Propia. Donde: 3. Algoritmo Propuesto Las ofertas de los generadores hidráulicos, se basa en la obtención de un escenario que considera 100 series; a través del modelo aprobado y acordado por los agentes y el regulador, el cual debe permitir representar las características y restricciones del sistema hidrotérmico; siendo el programa SDDP® apto para modelar este tipo de sistemas; para el cual los agentes deben declarar la disponibilidad, tasa de indisponibilidad histórica o la tasa de salida forzada FOR, mantenimientos de equipos, previsión de caudales y observaciones relevantes de la operación de las unidades, para el período de análisis. 241 H = No. de horas críticas CENS = precio de racionamiento (US $ / MWh) s = precio de ejercicio NS = No. de series del modelo pen = rubro de penalización Pk = potencia mínima de la serie k (MW) Pi = potencia mínima de la serie i ≠ k a principios del mes de enero del año de simulación. Paso 6: Cálculo de la prima de cada bloque de potencia. Por medio de la ecuación 2 se determina la prima para cada bloque de potencia. [ Prima k * Pk − Prima k −1 * Pk −1 ] Prima _ bloque j = (2) (Pk − Pk -1 ) Ofertas de Plantas Térmicas. La formación de la ofertas requiere determinar la potencia a ofertar, la cual depende de la estrategia del agente; una vez determina las horas críticas para el horizonte del análisis se aplica la ecuación 3. H Prima = [ P(CENS − s ) + (1 − IH ) * P * pen] (3) P 4. Resultados Los resultados que se presentan, para el caso de los generadores hidráulicos se utilizó el escenario obtenido en el programa SDDP para el año 2006 y las tasas de salida forzada de los generadores térmicos obtenida en base a la estadística operativa del CENACE. La prima marginal corresponde a la última prima captada en la subasta, esta deberá ser utilizada para determinar los ingresos por potencia de los generadores durante el período de estudio. A continuación se explica la determinación de los parámetros claves que el regulador debe colocar a disposición de los agentes: • Donde: P = potencia a ofertar IH = índice de disponibilidad histórica (%) La fórmula tiene sentido para cada unidad térmica. Las ofertas de los generadores térmicos e hidráulicos en precio (primas calculadas) y potencia obtenidas de acuerdo a lo indicado, ingresa a la subasta organizada por una entidad designada por el ente regulador cuyos resultados deben ser públicos. Estas ofertas se ordenan de menor a mayor, hasta cubrir la demanda determinada por la entidad reguladora. La entidad que lleve adelante la subasta debe colocar a disposición para información de los agentes algunos parámetros claves como son: demanda, precio de ejercicio, precio de racionamiento, penalización y otros que considere necesarios. Estos resultados deben ser públicos y enviados a todos los agentes del mercado eléctrico; así los generadores hidráulicos pueden obtener su oferta en base a este escenario; mientras que los generadores térmicos conjuntamente con los datos proporcionados por el regulador y la tasa de salida forzada pueden realizar su oferta. Un posible cronograma para realizar la declaración de la oferta puede ser: en octubre del año anterior realizar la declaración de los parámetros de cada agente para obtener las simulaciones y su procesamiento en el mes de noviembre, en el mes de diciembre análisis y observaciones por parte de los agentes y su publicación Costo de la Energía no Servida (CENS) Al no existir un valor oficial para CENS; más en la práctica, para los estudios se utiliza un valor levemente superior al mayor costo variable de la unidad del sistema que para el caso del estudio corresponde a la unidad Monay 6 de la empresa Elecaustro cuyo costo variable es de 107.6 US $/MWh; así el costo de la energía no servida para el modelo de pago de potencia por medio de opciones es de 110 US $/MWh. • Penalización Para la estimación de este parámetro se analizo si los generadores son existentes ó nuevos, debido a que esta situación determina el nivel de firmeza de la energía de una cierta oferta para presentar precios competitivos. La modelación de la aversión al riesgo de los generadores se considera para el caso de estudio como la relación entre los precios altos en función de la firmeza de los bloques está última depende de la indisponibilidad del generador en los períodos en los que el precio de ejercicio supere al precio del mercado de energía, valor que se puede traducir en probabilidad. Generador nuevo: • PUP ó costo de inversión 5.7 US $/kW-mes • Indisponibilidad (□) para el caso de bloques nuevos de potencia en valores estándares es del 8%. • La cantidad de dinero a recuperar del mercado de potencia en el horizonte de la subasta que de acuerdo a la propuesta constituye un año: 242 $ 5.7 * 12 meses * 1año (4) kWmes • La penalización considera las horas críticas que de acuerdo al precio de ejercicio y la simulación del sistema por medio del SDDP; se obtiene que son 0.5 meses (365.3 horas al mes): horas 730 * 0.5meses * Er * pen * 8% (5) mes Para el caso del generador nuevo se considera que la aversión al riesgo (Er.) es igual a 1. Generador existente de 2006 y fue de 1’926.973, 06 kW; mientras que la demanda mínima se presentó en el mes de julio de 2006 siendo de 1’397.145.03 kW. Esta información colocada en el programa MPO® desarrollado en EXCEL® constituye los datos de ingreso al modelo conjuntamente con las ofertas realizadas por los generadores térmicos. A continuación en la figura 4 se muestra la pantalla de manejo de los módulos de creación de las curvas de oferta de los generadores; así como la obtención de la subasta. No existe el costo de inversión y el ingreso es: 730 (6) * 0.5meses * Er * pen * λj Mediante las ecuaciones 4, 5 y 6 se obtiene la siguiente curva para definir la penalización como se indica en la figura 3, la cual indica una probabilidad de indisponibilidad del 42.5%; esto se traduce en una penalización de 105 US $/kW. 2 1 0 .0 1 9 0 .0 PEN [$/MWh] 1 7 0 .0 1 5 0 .0 1 3 0 .0 1 1 0 .0 9 0 .0 7 0 .0 8 .0 1 5 .0 1 7 .5 2 0 .0 2 2 .5 2 5 .0 2 7 .5 3 0 .0 3 2 .5 3 5 .0 3 7 .5 4 0 .0 4 2 .5 4 5 .0 4 7 .5 5 0 .0 _ [% ] FIGURA 3: Penalización en función de la indisponibilidad. Fuente: Elaboración propia • Precio de ejercicio No existe un procedimiento riguroso, sino que el regulador debe ajustarlo a la realidad de cada mercado. A un precio muy bajo haría que las opciones se ejerzan a cada momento; el precio debe buscar ingresar a las unidades más eficientes en costos. Para el caso del estudio se considero 70 US $/MWh. FIGURA 4: Pantalla de Inicio del Modelo • Caso demanda máxima Considerando la demanda máxima se obtiene la prima marginal que es de 5.3 US $/kW-mes, inferior al pagado por el método actual en 0.4 US $/kW-mes. La figura 5, muestra la potencia y los ingresos por el pago de potencia por el método propuesto y el método actual, observándose una tendencia similar en casi todas las tecnologías a excepción de la generación hidráulica de embalse, siendo esta la más afectada; más es necesario considerar que este tipo de generación tiene asociada su producción al caudal afluente (variable hidrológica altamente estocástica) lo que hace que sólo pueda comprometer su energía firme, a través del método de pago de opciones. 700.000,00 600.000,00 PAGO ACTUAL PAGO OPCIONES 500.000,00 400.000,00 kW horas mes 300.000,00 kW 200.000,00 100.000,00 Demanda 0,00 EMBALSE PASADA VAPOR GAS DIESEL GAS DIESEL (a) La determinación de la potencia a abastecer depende del regulador, el cual debe sustentarse en la mejor estimación sobre el crecimiento de la demanda basándose en la estadística y políticas de crecimiento del país. Para el caso del estudio, a fin de poder comparar los pagos de potencia con el método propuesto y el actual; la demanda máxima ocurrió en el mes de diciembre 243 3.500.000,00 3.000.000,00 PAGO ACTUAL PAGO OPCIONES 2.500.000,00 USD$ • 2.000.000,00 1.500.000,00 USD $ 1.000.000,00 500.000,00 0,00 EMBALSE PASADA VAPOR (b) FIGURA 5: Ingresos por el Pago de Potencia de acuerdo a la tecnología de generación. manejo de las unidades a través del pago que el mercado debe garantizar. 700.000,00 600.000,00 PAGO ACTUAL PAGO OPCIONES 500.000,00 400.000,00 kW Así las empresas que poseen unidades de generación térmicas poseen mayores ingresos que las de generación hidráulica debido a que no pueden comprometer más allá de su energía firme. A pesar de el valor de pago de potencia para el caso de opciones es inferior los generadores presentan ingresos muy similares, como se observa en la figura 6. 300.000,00 kW 200.000,00 100.000,00 0,00 EMBALSE PASADA VAPOR GAS DIESEL GAS DIESEL (a) 3.500.000,00 3.000.000,00 PAGO ACTUAL PAGO OPCIONES USD$ 2.500.000,00 2.000.000,00 1.500.000,00 USD $ 1.000.000,00 500.000,00 0,00 EMBALSE PASADA VAPOR (b) FIGURA 7: Ingresos por el Pago de Potencia de acuerdo a la tecnología de generación. FIGURA 6: Ingresos por el Pago de Potencia por Empresa de Generación. • Caso demanda mínima Considerando la demanda mínima se obtiene la prima marginal que es de 4.73 US $/kW-mes, valor diferente al pago actual que es de 5.7 US $/kW-mes. La figura 7 indica la potencia y los ingresos de los agentes por los dos métodos de pago de potencia para cada tecnología; como en el caso anterior se observa la distribución de la asignación de potencia hacia las unidades térmicas lo cual demuestra que en el mercado está tecnología es la que permite sustentar el abastecimiento de la demanda de los consumidores. Mediante la figura 8, se puede observar la asignación de potencia y de ingresos para cada agente; así para el caso de los agentes hidráulicos solo pueden comprometer su energía firme a pesar de que en el caso de pago de potencia por medio de opciones el precio US $/kW-mes es menor presentan ingresos muy similares a los actuales, mientras que los agentes con unidades térmicas si poseen potencia y no esta comprometida en mantenimientos o restricciones adicionales el método propuesto permite obtener ingresos superiores a pesar de ser inferior el pago debido al valor de la prima; es decir, los generadores comprometen su disponibilidad y buen FIGURA 8: Ingresos por el Pago de Potencia por Empresa de Generación. 5. CONCLUSIONES Dadas las características de un sistema hidrotérmico cuyos precios son extremadamente volátiles, se evidencia la necesidad de proporcionar instrumentos a los distintos participantes que les permitan cubrirse de los riesgos propios de este negocio, ya que si el mercado fuese ideal el mismo sería capaz de generar incentivos necesarios para el ingreso de nuevos generadores; más se ha observado en la realidad que se tiende a la subinversión; así, el pago de potencia constituye uno de los incentivos el cual debe ser claro y transparente para 244 todos los agentes del mercado. El objetivo principal del pago de potencia es realizar el pago mediante el reconocimiento de la disponibilidad efectiva de cada generador al momento de abastecer la demanda del sistema. El mercado de opciones libera al regulador de la responsabilidad de la determinación y distribución del pago de potencia; a cambio, deja al mercado a través de la competencia entre generadores colocar el valor y precio de la potencia, todo ello por medio de una subasta, con parámetros que son entendidos por todos los agentes del mercado y bajo reglas claras y transparentes. y la demanda a diferencia del método actual que a cualquier requerimiento del mercado el precio de la potencia es fijo. Así como también se llega a reconocer la importancia en el abastecimiento de la demanda del sistema de las unidades térmicas por lo que se asigna primeramente bloques de potencia más seguros y luego los bloques que sean menos seguros debido, por ejemplo, a las condiciones hidrológicas o situaciones externas. 6. BIBLIOGRAFÍA Para la aplicación eficiente de este modelo de comercialización, se debe disponer de una institución administradora del mercado, que establezca los procedimientos para liquidación correcta de estos pagos y el requerimiento del registro de información apropiada, para la determinación y distribución del pago de potencia. Las opciones aplicadas al pago de potencia en mercados eléctricos se constituyen en una herramienta efectiva, que permite al regulador trasmitir señales claras de inversión con una intervención mínima de éste sin perder en el ejercicio su función primordial de controlar el mercado a fin de que los cobros y obligaciones adquiridas en la operación del mercado lleguen a los agentes que correspondan, tal como se observó en la transferencia de ingresos entre generadores hidráulicos de embalse y los generadores térmicos a un precio del producto (potencia), debido principalmente a que este tipo de generadores ofertan bloques de potencia más competitivos debido a que el resto de capacidad esta asociada al riesgo de las cuencas hidrológicas. Mediante las simulaciones se pudo observar que los parámetros críticos que debe fijar el regulador o el ente encargado por éste para la implementación de la subasta son: la demanda, el precio de ejercicio de la opción, penalización y costo de la energía no suministrada, variables que afectan directamente la cantidad que el mercado requiere, los costos y los ingresos que reciben los oferentes de éste mercado. La ventaja del mercado de potencia por medio de opciones permite variar el valor que se paga por la potencia de acuerdo a las condiciones del mercado en búsqueda de alcanzar el equilibrio entre la oferta 245 [1] Oscullo José, Pago de Potencia a través de opciones: Perspectivas de aplicación al mercado eléctrico del Ecuador Ecuador, Tesis Maestría UASB, 2008. [2] Silva, E “Formação de Preços em Mercados de Energia Eletrica”. 1 ed, Sagra Luzatto, 2001. [3] Oscullo José, Um Modelo de Pre-Despacho com Gerenciamiento de Congestionamiento no Sistema de Transmisão, Tesis de Maestria UNICAMP, 2002, pp 85-90. [4] Hull, J Options, Futures and other Derivatives, Prentice Hall, 1997. [5] Curso: Regulación del Sector Eléctrico, Universidad de Comillas, Madrid, 2005. [6] Expertos en Mercados –XM-, Información operativa y administrativa del mercado eléctrico colombiano http://www.xm.com.org [7] Corporación Centro Nacional de Control de Energía-CENACE-, información operativa y administrativa del mercado eléctrico ecuatoriano http:// www.cenace.org.ec [8] Consejo Nacional de Electrificación – CONELEC- Información general y normativa del mercado eléctrico ecuatoriano http://www. conelec.gov.ec [9] Altamiras Carlos, “Pago por Capacidad vía Opciones Financieras”, Tesis de Maestría PUCCH, Chile, 2002. [10] ALCOGEN “Estudio Cargo por Capacidad en Colombia”, Madrid, 2000. 7. CURRICULUM VITAE Oscullo L. José.- Nació en Sangolquí, Ecuador, en 1971. Recibió su título de ingeniero eléctrico en la Escuela Politécnica Nacional en 1996, Master en ingeniería eléctrica de la Universidad Estatal de Campinas, Sao Paulo en 2002 y Magister en Dirección de Empresas de la Universidad Andina Simón Bolívar Sede Ecuador en 2008. Actualmente se desempeña como ingeniero de Planeamiento del CENACE y director y co-director de tesis de pregrado y posgrado de la EPN. Su campo de investigación se encuentra relacionado a la aplicación de sistemas expertos y financieros en SEP; así como análisis técnico, económico y financiero de expansión de sistemas eléctricos. 246 2010 Unidades de Medición Fasorial - PMU G. J. Araque R. Barba Corporación Centro Nacional de Control de Energía - CENACE Resumen-- Debido a que las líneas de transmisión cada vez se encuentran trabajando cerca de sus capacidades máximas por lo que un incremento en la diferencia angular entre los dos puntos de las líneas de transmisión podría generar problemas de inestabilidad en el Sistema Eléctrico de Potencia. Tratar de supervisar – en tiempo real – los ángulos relativos de fase de todas las tensiones e intensidades de la red en el pasado no era posible debido a la falta de capacidad de procesamiento y a las grandes dificultades propias de la recolección, coordinación y sincronización de los datos de la red, pero las nuevas tecnologías han dado un vuelco radical a esta situación. Las nuevas tecnologías de mediciones conlleva al uso de Unidades de Medición Fasorial conocidos comúnmente como PMU que mediante la aplicación de una tecnología generalizada en el campo de los satélites ofrece nuevas posibilidades para la supervisión, protección, análisis y control de los sistemas eléctricos de potencia. Actualmente en el Centro de Control del CENACE para poder realizar supervisión de la diferencia angular entre dos puntos del Sistema Nacional Interconectado - SNI se lo puede realizar solamente mediante el uso del estimador de estado que calcula el valor estimado del ángulo de los diferentes puntos del SNI mostrando los resultados en forma tabular, debido a que el sistema de mediciones que se dispone actualmente en el SNI no permite realizar una supervisión del ángulo en los diferentes puntos de SNI en tiempo – real, es por ello que mediante el uso de nuevas tecnologías de medición se dispondría una medición en tiempo – real de los fasores de los diferentes puntos del SNI y con ello poder apreciar no solamente en forma numérica si no también en forma gráfica el ángulo y de esa manera mejorar la calidad de supervisión y poder prevenir en el futuro problemas de inestabilidad causadas por el incremento de la diferencia angular. Palabras Clave-- PMU; Unidad de Medición Fasorial; Fasores; Diferencia angular. 1. INTRODUCCIÓN El Centro de Control del CENACE tiene que enfrentarse con problemas cada vez más complejos en una situación de constante evolución, entre estas cuestiones hay dos que destacan especialmente: la previsión de que las líneas de transmisión funcionarán cada vez más cerca de su capacidad máxima y la necesidad cada vez mayor de una supervisión mejor y más precisa del Sistema Nacional Interconectado. Es por ello que cuando dos sistemas eléctricos independientes se interconectan existe el riesgo que un problema en la interconexión ocasione una pérdida total o considerable de carga en el Sistema Nacional Interconectado, lo mismo podría suceder si una línea de transmisión tuviera un problema produciendo el disparo de la misma y uno de esos problemas que se podrían producir es el ocasionado por un incremento en la diferencia angular entre los dos puntos de la línea de transmisión o de la interconexión, es por ello que es necesario implantar sistemas de mediciones que permitan calcular los ángulos de fase y con ello poder realizar una supervisión en tiempo – real del sistema eléctrico de potencia En la actualidad los equipos de mediciones que nos permite calcular los ángulos en los diferentes puntos del SNI son las Unidades de Medición Fasorial conocidas como PMU. Este artículo que recoge partes fundamentales de documentos de la red – internet que tratan de temas fundamentales sobre las unidades de medición fasorial y su aplicación a la operación de sistemas eléctricos de potencia, y pretende introducir el concepto de Supervisión del sistema eléctrico ecuatoriano sobre la base de la información proporcionada por los sistemas de Unidades de medición fasorial - PMU. 247 Los temas que se desprendan de este artículo, apli- cables a la operación del sistema ecuatoriano, deberán tratarse con la seriedad del caso de tal manera de agilitar el proceso de mejoramiento de la operación y la optimización en la utilización de las instalaciones eléctricas, en base a la tecnología fasorial. 2. GENERALIDADES La información disponible, a través del sistema de manejo de energía Network Manager, para la supervisión del sistema eléctrico ecuatoriano se actualiza cada 4 segundos, sobre la base de esta disponibilidad de información, la operación preventiva del sistema se sustenta en los siguientes pilares: • Supervisión de los límites máximos de transferencia en vínculos de transmisión. • Supervisión de las magnitudes de generación de cada uno de las unidades generadoras del sistema. • Supervisión de la magnitud de la reserva para la regulación de la frecuencia. • Y en ciertos casos la violación de cortes que pondrían en riesgo la estabilidad del sistema de ocurrir una determinada contingencia. Figura 1: Representación del fasor de una onda sinusoidal A esta representación se la denomina fasorial, en la cual un fasor se lo define como: la longitud del radio representa la amplitud, en este caso de la tensión, la componente vertical tiene el valor A sen (ωt + φ) en la curva sinusoidal de la corriente alterna, el ángulo φ, es el ángulo de desplazamiento del fasor, con referencia a una punto de ángulo 0. El uso de la notación de fasores no solo trae consigo una importante simplificación matemática; también reduce las necesidades de sistemas electrónicos y de capacidad de procesamiento, esta simplificación hace posible la supervisión PMU global de la red. 3. TECNOLOGÍA FASORIAL Bajo este escenario, sobre el cual el personal de Operadores de la Sala de Control del CENACE realiza su proceso, es imposible la determinación oportuna de la evolución de los estados de riesgo, con referencia a la separación angular paulatina, en una cierta área del sistema. El uso de fasores ha conllevado al término conocido como Tecnología Fasorial, que es considerada una de las más importantes tecnologías de medición de los sistemas eléctricos de potencia en la actualidad, debido a su única habilidad para mostrar datos análogos de voltaje y corriente sincronizados con un GPS y calcular el correspondiente fasor para cualquier punto de la red eléctrica (R). Básicamente la identificación de un fenómeno de tales características, en base a la información con las características indicadas, se lo puede realizar únicamente ex post, bajo un análisis pormenorizado posoperativo; tornándose el proceso de supervisión en tiempo real del sistema de potencia netamente correctivo. La diferencia del ángulo de fase entre dos grupos de mediciones fasoriales es independiente de la referencia. Típicamente, una de las mediciones fasoriales es escogida como “referencia”. La diferencia entre los otros ángulos de fase y esta referencia es calculada y referida como el ángulo de fase relativa, como se puede observar en la Fig. 2. Por otro lado, la simplificación de las dificultades propias de las ecuaciones diferenciales con largas expresiones como A sen (ωt + φ), típicas de las ondas sinusoidales de la corriente alterna y variables en el tiempo ha supuesto pasar las ecuaciones referidas al eje temporal usual a otro sistema de coordenadas. Así, la corriente alterna que recibimos en nuestras casas, representada por la curva de la izquierda de la Fig. 1, puede expresarse también con el diagrama de la derecha de la misma Figura. 248 Leading phase angles Lagging phase angles Leading phase angles Reference phase angle (0 Degrees) Figura 2: Ángulo de fase relativo con respecto a un ángulo de referencia común Es importante determinar la diferencia angular entre dos puntos ya que si va aumentando el ángulo entre esos dos puntos implica una mayor tensión estática ejercida entre dichos puntos por lo que conllevaría a tener inestabilidad (R). La inestabilidad y el colapso de voltaje son casi siempre provocados por grandes perturbaciones, en un escenario que puede contemplar: • Bajos voltajes iniciales, • Aumento importante de la carga, • Funcionamiento próximo del límite de la capacidad de transporte de potencia, • Generación alejada eléctricamente de los puntos de consumo, e. • Insuficiencia de medios de compensación de potencia reactiva. Estas situaciones llevan a un aumento de las pérdidas de potencia en la red, a un aumento de las relaciones de transformación de los transformadores con cambiadores automáticos de Taps (LTC - Loaded Transformer Changer) y a alcanzar los límites de producción de potencia reactiva por parte de los generadores o los compensadores sincrónicos del sistema. El uso de PMUs permitiría prevenir algunos casos de inestabilidad, que podrían conllevar a un corte de energía total o parcial. 4. RED FASORIAL La forma más simple para tener una red fasorial consiste de dos nodos: un medidor de fasores conectado en un nodo que se comunica con un concentrador de datos fasoriales en un segundo nodo. Una red fasorial contempla los siguientes elementos; • La generación de las mediciones, • Sincronización de las mediciones • La transmisión de la información, • La recopilación o concentración, y procesamiento de la información. • Interface Hombre – Máquina. 1.1. Unidades de Medición Fasorial Son unidades de medición de diferentes parámetros eléctricos con una periodicidad en el orden de los microsegundos, miden las variables de voltaje trifásico en una subestación y las intensidades de corriente en las líneas, transformadores y cargas conectadas a la subestación. A partir de estas muestras de datos, se calculan las tensiones e intensidades de secuencia positiva y se marcan en el tiempo, mediante un GPS, asignándoles permanentemente el microsegundo exacto en que se ha hecho la medición de los fasores. El dispositivo prepara un mensaje con la marca de tiempo y los datos del fasor en un formato definido en la norma IEEE 1344, de modo que puede transmitirse a un lugar distante a través de cualquier enlace de comunicaciones que se encuentre disponible. Los datos de secuencia positiva de los fasores de todas las subestaciones provistas de dichos dispositivos se centralizan en un lugar apropiado utilizando un concentrador de datos o se intercambian Entre unidades locales para realizar las aplicaciones de protección/control 1.2. Sistema Posicionamiento Global El sistema de posicionamiento global de satélites GPS, consta de 24 satélites situados en seis órbitas, a unos 16.000 Km de altura sobre la superficie de nuestro planeta. Es decir, están situados aproximadamente a la mitad de la altura que correspondería a una órbita Geoestacionaria. El posicionamiento del plano orbital y la posición de los satélites en las órbitas es tal que en un instante dado se pueden ver al menos cuatro satélites desde cualquier punto de la superficie de la Tierra frecuentemente son visibles más de seis satélites. El canal de uso civil del sistema GPS transmite las coordenadas posicionales de los satélites desde los que es posible determinar la ubicación de una estación receptora en tierra. Además, los satélites transmiten una señal de un impulso por segundo, junto con un identificador de la señal que puede ser interpretado por los receptores de la estación terrestre. La transmisión, de uso civil, de la señal de tiempo tiene una precisión de 1 microsegundo pero en la práctica a menudo se considera que es mucho más precisa. El impulso de tiempo tiene una importancia fundamental para la aplicación de las unidades PMU. El método normal es la sincronización de fase de un reloj de muestreo para este impulso, el instante de muestreo será el número del impulso, dentro de un intervalo de un segundo, identificado por la etiqueta de tiempo del GPS. El formato exacto del etiquetado de tiempo se define en la norma IEEE 1344. Es importante mencionar que el sector de la energía utiliza actualmente un estándar de tiempo, conocido como estándar IRIG-B, para los registradores digitales de fallos con etiquetado de tiempo y para otros sistemas de supervisión de eventos en las subestaciones. No obstante, con los receptores según estándar IRIG-B la precisión de la 249 sincronización es del orden de 1 milisegundo, lo cual no es suficiente para obtener mediciones precisas del sistema de distribución de energía (una tolerancia de 1 milisegundo corresponde a una incertidumbre de aproximadamente 20°). 1.3. Medios de Comunicación Un factor fundamental a la hora de implementar el sistema es la comunicación de las mediciones con marca de tiempo al concentrador de datos. Mientras que la base de tiempos se distribuye a las unidades PMU mediante una compleja red de satélites, los dispositivos actuales utilizan tecnologías de comunicación telefónica, digital en serie y de Ethernet para establecer la conexión con el concentrador de datos PDC. Entre las diversas tecnologías que se aplican en la infraestructura de comunicaciones se cuentan el cableado directo, las redes de radio que requieran o no licencia, las microondas, los teléfonos público y celular, la radio digital y diversas combinaciones de estas tecnologías (Fig. 3). 1.4. Concentradores de Datos Fasoriales Los PDCs concentran y correlacionan datos de fasores provenientes de los PMUs con su respectiva bandera de tiempo para crear un sistema extenso de grupos de mediciones, además los PDCs permiten realizar las siguientes funciones adicionales: • Ejecutar varias revisiones de calidad en los datos de los fasores e insertar apropiadas banderas dentro del flujo de datos correlacionados. • Revisar alteraciones en las banderas y grabar archivos o datos para realizar análisis. • Monitorear las mediciones globales del sistema y proporcionar un display. • Proporciona un número de salidas especializadas que permite tener una interfaz directa para un SCADA o un sistema EMS. Una computadora personal conectada a la salida de los PDC proporcional al usuario mediante el uso de un respectivo software que permita calcular y presentar: frecuencias, voltajes, corrientes, MW y MVar del sistema eléctrico de potencia como se muestra en la Fig. 4. PMU PMU Concentrador y cotejador de datos PMU Figura 3: Sistema de comunicaciones típica de un PMU Software avanzado de aplicación Sistema Control, funciones de protección Banco de datos de archivos PMU Figura 4: Típica red fasorial Los protocolos de comunicaciones utilizados por los PDCs y PMUs es la IEEE C37.118 que fue desarrollado hace pocos años y aprobado en el 2005. Además, la norma IEEE 1344 define los formatos de archivos de salida suministrados por las unidades PMU de medición de fasores. Se definen dos archivos (Encabezamiento y Configuración) para la configuración y la asistencia a la interpretación de los datos de los fasores, así como el formato del archivo de salida binario en tiempo real, que consta de fasores y de la marca de tiempo e incluye la salida principal de las unidades PMU. La norma ha sido de gran ayuda para garantizar que las futuras aplicaciones de la medición sincronizada de fasores puedan acceder a los datos de fasores suministrados por las unidades PMU de los distintos fabricantes. 5. APLICACIONES DE LOS PMUs EN LOS SISTEMAS ELÉCTRICOS DE POTENCIA Las aplicaciones de los PMUs se las puede clasificar en tres grupos que son: • Supervisión de sistemas eléctricos de potencia • Implementación de sistemas de protección avanzados de SEP´s • Esquemas de control avanzado 1.5. Supervisión de sistemas eléctricos de potencia Uno de los elementos más importantes de los modernos sistemas de gestión de energía que actualmente utilizan los centros de control es la estimación de 250 estado del sistema eléctrico de potencia a partir de las mediciones en tiempo real. El estado del sistema eléctrico de potencia se define como el conjunto de las tensiones de secuencia positiva, obtenidas en un momento dado, en todas las barras de la red, pero debido a las bajas velocidades y cálculos de exploración, relativamente lentos, la tecnología actual no puede proporcionar información sobre el estado dinámico del sistema eléctrico de potencia. Las mediciones sincronizadas de fasores abren una posibilidad totalmente nueva para sintetizar el proceso de estimación de estado. La aplicación de esta tecnología eliminará en gran parte el retardo inherente a los sistemas actuales de estimación de estado; los centros de control estarán en condiciones de realizar, en tiempo real, avanzados análisis de los imprevistos estáticos y dinámicos que se producen en sus redes. 1.5.1. Aplicación al sistema eléctrico ecuatoriano En el sistema ecuatoriano, como ya se mencionó en la parte introductoria, se tienen varios problemas de carácter sistémico, uno de ellos de gran relevancia es la cargabilidad del SNT agravado por la falta de compensación reactiva, de tal manera que sistemáticamente la programación de la operación diaria considera criterios de seguridad que encarecen el costo de la operación y desoptimizan la utilización de las instalaciones eléctricas, con el objetivo de prever potenciales problemas de inestabilidad: Por ejemplo, en las líneas de transmisión: Santa Rosa Totoras, Daule Peripa – Portoviejo y Daule Peripa Quevedo, las transferencias elevadas de potencia han provocado más de una ocasión inestabilidad en la zona, produciéndose oscilaciones en el sistema. De disponerse de supervisión del sistema, específicamente en estas zonas conflictivas, sobre la base de los PMU´s, se podría establecer políticas de operación, que permitan, con un mayora grado de seguridad definir los niveles de transferencia a través de los elementos indicados. 1.6. Protección avanzada de redes Otro grupo de aplicaciones de la medición sincronizada de fasores se caracteriza por aumentar la eficacia de la protección de los sistemas eléctricos de potencia, es decir, la protección de los sistemas y equipos, y la preparación de esquemas de medidas correctoras. Por ejemplo, la protección tradicional de líneas se basa en realizar mediciones de ciertas magnitudes del sistema en un extremo de la línea para determinar si se ha producido una avería. En el caso de las líneas críticas, las mediciones se sincronizan mediante algún mecanismo que proporcione esquemas de protección diferencial para la detección de averías. Se considera que la protección diferencial es la forma de protección más fiable. En el futuro, las unidades PMU podrían ser utilizadas para suministrar protección diferencial. Esta solución ofrece además la posibilidad de limitar los daños que un acontecimiento catastrófico podría provocar en el sistema eléctrico de potencia. Por ejemplo, el estado de determinados interruptores y seccionadores, el flujo de energía en líneas eléctricas fundamentales, las tensiones en barras críticas, la potencia de salida de los generadores clave, etc., podrían ser utilizados para formular una estrategia de respuestas acerca de si estos parámetros han de considerarse como modelos ‘peligrosos’. 1.6.1. Aplicación al sistema eléctrico ecuatoriano Nuevamente se toma el ejemplo de la zona Quevedo – Daule Peripa – Portoviejo. Por ejemplo el estado de los disyuntores y seccionadores en las líneas Daule Peripa Portoviejo (dos circuitos), el flujo de potencia a través de estas líneas, los niveles de voltaje en las barras de 138 kV de la S/E Portoviejo y de la central Daule Peripa, los niveles de generación de las unidades de la central, podrían ser utilizados para formular una estrategia de respuestas automática (esquema de protecciones) ante tendencias de riesgo, evidenciados en el comportamiento de los fasores asociados. 1.7. Esquema de control avanzado Entre los dispositivos controlables instalados por las compañías eléctricas se encuentran los estabilizadores de sistemas de distribución, los compensadores estáticos de energía reactiva (SVC), los enlaces de CC en AT, los controladores universales de flujo de energía, etc. Estos controladores han sido diseñados para optimizar las funciones de control definidas como objetivo. Por ejemplo, un estabilizador de redes eléctricas puede estar encargado de atenuar las oscilaciones electromecánicas de la red. El objetivo de un controlador SVC puede ser mejorar el perfil de la tensión en determinadas barras críticas de la red. En todos los casos los controladores utilizan como realimentación señales derivadas localmente. Puesto que, frecuentemente, el fenómeno por controlar se define en términos de las variables generales del sistema, los controladores actuales dependen de un modelo matemático del proceso de control, de la dinámica del sistema y de la relación entre las variables locales y el estado del sistema. 251 Las mediciones sincronizadas de fasores ofrecen una oportunidad única para llevar al controlador las mediciones del vector de estado del sistema, eliminando así el bucle de control de la incertidumbre propia del modelo matemático. Así, el controlador implementado se basa principalmente en la realimentación y menos en los modelos. Luego de realizadas las conexiones, el PMU se configura y se somete a las pruebas de funcionamiento respectivas, para luego ser conectado al PDC (Phasor Data Concentrator). En la Fig. 5. se muestra la implementación típica de un PMU en una subestación. 1.7.1. Aplicación al sistema eléctrico ecuatoriano En el sistema ecuatoriano, complementariamente a la instalación de compensadores de potencia reactiva SVC, se podría diseñar sistemas muy ágiles que garantizarían la oportuna respuesta ante problemas de fallas y de inestabilidad de voltaje, llevando como señales de entrada los fasores de las subestaciones críticas del sistema, por ejemplo, un SVC en la S/E Pascuales podría actuar de manera muy oportuna, llevando las mediciones fasoriales de los puntos de mayor impacto en la zona del SVC; o tal vez un SVC asociado a la interconexión con Colombia alimentado por un conjunto de mediciones fasoriales, permitiría optimizar la utilización de la capacidad de la interconexión, con los consecuentes beneficios en la disminución de los costos de la energía y el incremento de las reservas energéticas. Phasor Measurement Unit (PMU) Figura 5: Implementación típica de un PMU en una subestación 7. CONCLUSIONES, RECOMENDACIONES • La implementación de los sistemas de unidades de medición fasorial permiten cambiar la filosofía de la operación de sistemas eléctricos de potencia, enfatizando el proceso de supervisión y accionar preventivo. • La calidad y oportunidad de la información disponible a través de estos sistemas, permiten el diseño de políticas operativas de accionar preventivo (como se lo mencionó en el literal anterior), lo cual da un a flexibilidad al programador para maximizar la utilización de las instalaciones eléctricas en un sistema y disminuir la generación de sobrecostos por restricciones en la red. El PMU con un MODEM y otro equipo de soporte se instalan en un rack, también se instala una antena GPS en el techo de la subestación siguiendo las instrucciones del fabricante, el cable de la antena al igual que los TC´s y TP´s se llevan directamente al PMU. • Es necesario fortalecer las competencias del grupo de operadores del sistema, para un entendimiento y aprovechamiento óptimo de la tecnología fasorial y de la información que esta brinda. Además de las conexiones de los TC´s y TP´s al PMU también se requiere de las siguientes conexiones: • Existen sistemas de medición fasorial que prácticamente se convierten en módulos de sistemas de administración de energía EMS existentes, lo cual facilita el proceso de implementación de estos subsistemas. • Se podría realizar un análisis costo beneficio de la implementación de estos sistemas, enfrentando los costos de inversión y capacitación versus los costos de optimización de la utilización de la red y de los elementos del sistema de potencia, además de los costos 6. IMPLEMENTACIÓN DE PMUs De las referencias consultadas y de las experiencias indicadas en estas referencias se desprende que la instalación de un PMU es un proceso sencillo, considerando que un fasor de corriente o de voltaje esta presente en cualquiera de las 3 fases. El PMU también mide la frecuencia de la línea desde un fasor específico de voltaje (típicamente se asigna una barra principal del sistema de potencia para realizar dicha medición). • Conexión de energía, generalmente de un banco de baterías • Conexión a tierra • Conexión de la antena GPS • Conexión del circuito de comunicaciones 252 • asociados al aumento de la confiabilidad y seguridad del sistema. [11] A. Phadke, J. Thorp, “Synchronized Phasor Measurements and Their Applications”, USA, 2008 Es altamente recomendable que CENACE, como Administrador del Sistemas eléctrico nacional, encargado de garantizar la seguridad del sistema y de minimizar los costos operativos, emprenda en un proyecto nacional de implementación de un sistema de medición fasorial. [12] C. Cañizares, “Voltage Collapse and Transient Energy Function Analyses of AC/DC Systems”, 1991 8. REFERENCIAS BIBLIOGRÁFICAS [1] R. Quintanilla Adánez, “Sistemas de Transporte Inteligentes – Medición Sincronizada de Fasores”, España, 2005 [2] Krish Narendra, “Role of Phasor Measurement Unit (PMU) in Wide Area Monitoring and Control”, Canada, 2007 [3] V. Centeno, M. Donolo y J. Depablos, “Software Synchronization of Phasor Measurement Units”, Francia, 2004 [4] J. Bertsch, C. Carnal, A. Surányi, “Detección de la Inestabilidad en los Sistemas de Potencia y Optimización de la Utilización de Activos con InformIT Wide Area Monitoring PSG 850”, Revista ABB, 2003 [5] WECC Performance Work Group, “Western Interconnection Phasor Monitoring Network and Visualization”, 2005 [6] California Energy Commission, “Real – Time Grid Reliability Management”, USA, 2008 Roberto Barba Barba.- nació en Quito, Ecuador, en 1968. Obtuvo el título de Ingeniero Eléctrico en la Escuela Politécnica Nacional en 1996 y recibió el grado de Magíster en Investigación Operativa de la Escuela Politécnica Nacional en el 2004, actualmente está desarrollando la tesis de grado para la obtención de su título de Magister in Bussiness Administration. Se desempeña como Coordinador del Centro de Operaciones, del Centro Nacional de Control de Energía. Su campo de acción es la coordinación de la operación en tiempo real del Sistema Nacional Interconectado. Gustavo J. Araque D.- Nació en Quito, Ecuador el 15 de mayo de 1981. Obtuvo el título de Ingeniero Eléctrico en la Escuela Politécnica Nacional en el año 2008, actualmente trabaja en la Dirección de Operaciones del Centro Nacional de Control de Energía. [7] J. Eto, J. Dyer, M. Parashar, “Phasor Applications for Monitoring, Alarming & Control”, Consortium for Electric Reliability Technology Solutions (CERTS), 2006 [8] D. Hart, D. Uy, V. Gharpure, D. Novosel, D. Karlsson, M. Kaba, “Unidades PMU Supervisión de las redes eléctricas: un nuevo enfoque”, Revista ABB, 2001 [9] C. Martinez, M. Parashar, J. Dyer, J. Coroas,” Phasor Data Requirements for Real Time WideArea Monitoring, Control and Protection Applications”, 2005 [10] North American Synchro Phasor Initiative (NASPI), “PMU System Testing and Calibration Guide”, 2007 253 2011 Cambio de Paradigma en el Pronóstico del Recurso Hidrológico-Influencia del Cambio Climático P. Vásquez† P. Guzmán‡ †Consejo Nacional de Electricidad - CONELEC ‡Corporación Eléctrica del Ecuador CELEC E.P., Unidad de Negocio HIDROPAUTE Resumen - Sin lugar a dudas la crisis energética de finales de 2009 e inicios de 2010, a más del costo que representó para el Estado ecuatoriano, ha sentado un claro precedente sobre la vulnerabilidad del sector eléctrico ante las incertidumbres presentes tanto en la severidad como en la duración de los períodos de estiaje. Generalmente, las incertidumbres presentes en la predicción de caudales son sistemáticamente consideradas a través de una modelación probabilista-estocástica. No obstante, en la actualidad, nuevas incertidumbres hasta hoy omitidas, tales como los efectos del cambio climático, conducirían a desaciertos significativos en los pronósticos de los caudales. Bajo estas condiciones, la técnica de robustez -basada en probabilidades de excedencia-, utilizada para la toma de decisiones de inversión en generación, no garantiza adaptación entre oferta y demanda, ya que asume que la intensidad y duración futuras de los estiajes así como de la estación lluviosa obedecerán a un comportamiento histórico y por tanto no evolucionarán en el tiempo. Al ser un fenómeno global, el Ecuador difícilmente escapará las consecuencias del cambio climático, de ahí que en este trabajo, se demostrará que tanto las hipótesis de estacionalidad (períodos lluviosos y estiajes) así como de evolución estática-estadística de los caudales en el tiempo -generalmente asumidas para estudios de planificación de la expansión de la generación- pudieran ser causales de la ineficacia en los pronósticos. Palabras Clave - Adaptación, cambio climático, caudales, estadística, estocástico, excedencia, generación, hidrología, incertidumbres, planificación, probabilidad, riesgos. 1. VULNERABILIDAD EN LA OFERTA La gran volatilidad de la oferta de energía eléctrica a lo largo del tiempo, es uno de los problemas más importantes a enfrentar dentro de la planificación de la expansión de la generación en Ecuador. En efecto, las sequías extremas, que reducen dramáticamente los caudales que ingresan a las centrales de generación hidroeléctrica, han dejado vulnerable periódicamente al sistema eléctrico ecuatoriano. Durante dichos períodos, los niveles de reserva del sistema eléctrico ecuatoriano han sido alarmantes. Si a esto se suman las reducidas y extemporáneas inversiones en generación, las consecuencias más des-favorables han sido profundas y prolongados períodos de racionamientos. Varias estrategias de decisión, tales como: la complementariedad hidrológica de las cuencas, la construcción de embalses y las inversiones en otras tecnologías de generación (renovable y no renovable), están siendo propuestas por los planificadores a fin de reducir, en el corto y mediano plazo, esta vulnerabilidad. Sin embargo, estas estrategias han sido evaluadas y obtenidas asumiendo que el modelo estocástico, el cual utiliza Estadística Descriptiva (ED) para generar valores futuros de caudales medios mensuales, representa razonablemente -a lo largo del horizonte de planificación (10 años o más)- el complejo fenómeno de la hidrología. Es decir, se asume que las incertidumbres presentes en la magnitud y duración de los caudales medios de las diferentes cuencas en Ecuador, obedecen a un comportamiento histórico y, por tanto, no evolucionarán en el tiempo. Con la hipótesis de que tales incertidumbres evolucionan en el tiempo debido a factores exógenos, tales como el cambio climático y la influencia humana, en el presente trabajo se evalúa la eficacia de la tradicionalmente aplicada ED, en la modelación de los caudales de Amaluza y Daule-Peripa. 2. EMBALSE AMALUZA La Central Paute-Molino fue construida en dos fases: la fase AB de 500 MW de potencia, que opera desde 1983 y la fase C de 575 MW de potencia, que está en servicio desde 1992; juntas entregan al 254 La presa Daniel Palacios, la cual fue construida como parte de las obras de las fases A y B, da lugar al embalse Amaluza, con una capacidad de almacenamiento de 120 Hm³ y un volumen útil de100 Hm3. El vertedero de excesos tiene una capacidad de descarga de 7724 m³/s. Del embalse Amaluza se tiene una serie histórica de caudales medios mensuales en el Río Paute de 46 años, comprendida entre 1964 y 2009. El valor mínimo de 23.1 m³/s fue registrado en el mes de diciembre de 1968, y un valor máximo de 352.3 m3/s, en junio de 2007. En el ANEXO 1, se encuentra toda la muestra histórica considerada en este estudio, al igual que los valores: medios, máximos y mínimos mensuales históricos registrados. A continuación se grafican los caudales medios anuales afluentes al embalse Amaluza, central Paute – Molino, donde se observa que los años 1966, 1968. 1979, 1981, 1985, 1992 y 1995 son los más críticos de caudales medios anuales con valores de 90.1, 89.4, 80.3, 81.2, 87.6, 81.0 y 79.7 m³/s respectivamente. 150.00 132.5 140.00 120.00 1968 1979 100.00 1995 80.00 2009 60.00 40.00 20.00 .00 Ene Feb Mar Abr May Jun Jul Ago Sep Oct Nov Dic Figura 2: Caudales medios mensuales Para verificar si las incertidumbres presentes en los caudales presentan algún tipo de evolución, se toman distintas muestras con mayor o menor cantidad de historia así veremos la que más se ajusta al comportamiento actual. Muestra 1: 1964 – 2009, muestra 2: 1974 – 2009, muestra 3: 1984 – 2009, muestra 4: 1994 – 2009, muestra 5: 1999 – 2009, muestra 6: 2004 – 2009. 118.2 111.6 200.00 110.9 106.7 111.6 100.00 99.8 89.4 95.2 1984 - 2009 1994 - 2009 1999 - 2009 100.00 2004 - 2009 2009 79.7 1988 8 1985 5 1982 2 1979 9 1976 6 1973 3 1970 0 50.00 2009 9 81.0 2006 6 81.2 70.00 1967 7 1974 - 2009 150.00 87.6 80.3 1964 4 99.4 2003 3 80.00 100.9 1994 4 90.1 1964 - 2009 108.3 106.9 2000 0 110.00 123.3 1997 7 107.7 Caudales medios anuales 250.00 128.5 125.9 114.6 1991 1 m3/S 160.00 m /s 130.00 60.00 180.00 146.4 143.2 139.6 140.00 90.00 Caudales históricos medios mensuales 200.00 Caudales medios anuales afluentes al embalse Amaluza 160.00 120.00 los caudales en el 2009 cayeron muy por debajo de los caudales sucedidos en los años 1968 y 1995, cambiando en diciembre el comportamiento con caudales inferiores a los registrados en 1979 y 1995. m /s Mercado Eléctrico una producción anual media de 4700 GWh. .00 Figura 1: Caudales medios anuales Amaluza El año 2009, en el que ocurrió la crisis energética, no aparece como uno de los años más críticos, es más, el caudal promedio anual (106,9) está más bien cercano al caudal promedio de la muestra para el período 1964-2008. Sin embargo, al analizar los caudales medios mensuales, representados en la Fig. 2, se puede notar que: en los meses de enero, febrero, abril, mayo y junio, los caudales registrados en el año 2009 están por encima de los años históricamente más secos (1968,1979 y 1995), mientras que en los meses restantes, están por debajo de los caudales registrados en el año 1968. En el mes de noviembre, Ene Feb Mar Abr May Jun Jul Ago Sep Oct Nov Dic Figura 3: Caudales medios mensuales para distintas muestras, Embalse Amaluza. En general, del gráfico anterior se puede observar que, entre enero y abril, la muestra 6 tiene los caudales medios anuales más altos de todas la muestras. En mayo, los valores descienden hasta ser iguales a los valores registrados en la muestra 2, en cambio para el mes de junio alcanza el pico más alto de toda la muestra, para descender nuevamente hasta octubre, mientras que en noviembre y diciembre tiene nuevamente los valores más altos. Entonces, por un lado, el comportamiento mensual de los caudales, en el año 2009, estuvo por fuera de la media histórica en dos períodos -valores superiores 255 a la media en el mes de abril, y valores inferiores a la media en los meses de septiembre, octubre, noviembre y diciembre, y que, por otro lado, la hidrología del año 2009 se ajusta mejor a la muestra que utiliza menor historia, se concluye que: existe una evolución en la intensidad y en las duraciones de las dos estaciones climáticas. En efecto, se aprecia que las sequías, durante los meses de septiembre, octubre, noviembre y diciembre, son más extremas que en el pasado, y en los meses de abril, mayo y junio, la época lluviosa es más intensa que en el pasado. 3. EMBALSE DAULE-PERIPA El embalse Daule Peripa tiene una serie histórica de caudales medios mensuales de 60 años comprendida entre 1950 y 2009. Con un valor mínimo de 0.4 m3/s registrado en el mes de septiembre de 2007, y un valor máximo de 1592 m3/s en abril de 1998. En el siguiente gráfico, se muestran los caudales medios anuales afluentes al embalse Daule-Peripa central Marcel Laniado. Caudales medios anuales afluentes al embalse Daule Peripa 600.00 537 500.00 428 394 305 m /s 300.00 252 212 191 200.00 275 250 237 247 210 145 100.00 134 131 116 97 54 55 83 80 78 137 125 100 97 2006 2002 1998 1994 1990 1986 1982 1978 1974 1970 1966 1962 1958 1954 .00 1950 En el ANEXO 2, se encuentra toda la muestra histórica considerada en este estudio, al igual que los valores: medios, máximos y mínimos mensuales históricos registrados. COMPLEMENTARIEDAD Del análisis efectuado en las secciones anteriores se observa que la hidrología de Amaluza y DaulePeripa son, en general, complementarias durante el período de enero a septiembre. Sin embargo, durante los meses de octubre a diciembre, no existe complementariedad, lo cual implica que la oferta de energía disminuye dramáticamente durante este período. En la Fig. 6 se observa que la complementariedad hidrológica entre el embalse Amaluza de la central Paute – Molino y el proyecto Tortugo desaparece en los meses de octubre a diciembre. 196 172 160 Del análisis de las distintas muestras (Fig. 5) se puede observar una tendencia muy similar en ellas, teniendo a la temporada de enero a mayo como la de mayores caudales y junio a diciembre con caudales menores, sin embargo el período 1999-2009 presenta 10 de los doce meses del año caudales inferiores, por otra parte es notorio que el año 2009 los caudales fueron inferiores durante todo el año a excepción de los meses de Enero y Febrero. Figura 4: Caudales medios anuales, Daule Peripa 300 Caudales medios mensuales del Proyecto Tortugo (m /s) 250 Al igual que para el embalse Amaluza, se toman distintas muestras con mayor o menor cantidad de historia, así veremos la que más se ajusta al comportamiento actual. 400.00 1950 - 2009 m /s 1959 - 2009 1969 - 2009 300.00 1979 - 2009 1989 - 2009 1999 - 2009 200.00 2009 100.00 .00 Ene Feb Mar Abr May Jun Jul Ago Sep Oct Nov Dic Figura 5: Caudales medios mensuales para distintas muestras, Daule Peripa 140 200 120 100 150 80 100 60 40 50 20 00 Ene Feb Mar Abr May Jun Proyecto Tortugo Jul Ago Sep Oct Nov Dic 00 Embalse Amaluza Figura 6: Complementariedad Hidrológica Paute – Tortugo Caudales medios mensuales - Embalse Daule Peripa 500.00 180 160 Del gráfico anterior se puede observar que los años más críticos en cuanto a caudales medios anuales afluentes al embalse Daule Peripa, se registran a los años 1952, 1963, 1968, y 1985. 600.00 Complemetariedad Hidrológica entre la vertiente del Pacífico y del Amazonas Caudales medios mensuales del Embalse Amaluza (m /s) 400.00 Muestra 1: 1950 – 2009, muestra 2: 1959 – 2009, muestra 3: 1969 – 2009, muestra 4: 1979 – 2009, muestra 5: 1989 – 2009, muestra 6: 1999 – 2009. De ahí que, si bien planificar la expansión de la generación con el criterio de complementariedad reduce la vulnerabilidad de la oferta de generación durante un periodo significativo, existe un período de tres meses durante el cual el sistema eléctrico ecuatoriano sigue siendo vulnerable. Por tanto, es necesario que en la planificación se incorporen criterios adicionales para el manejo de este riesgo, tales como: incremento de la regulación 256 en la vertiente del Pacífico e incorporación de generación de energía renovable (geotérmica, fotovoltaica, eólica, etc.), en el largo plazo; y, en el corto plazo, alternativas de decisión flexibles tales como: generación térmica, generación distribuida, e incorporación de elementos FACTS. 4. INCERTIDUMBRE CLIMÁTICO EN EL también por el incremento de la temperatura (IDEAM, 2001). En el caso del reservorio de Amaluza se estima que entre el 20 y 40% del agua que llega al reservorio tiene su origen en los páramos y bosques altoandinos de las cordilleras Oeste y Central. En períodos secos, sin embargo, podría alcanzar 100% (Buytaert et al. 2008). CAMBIO La Convención Marco de las Naciones Unidas sobre el Cambio Climático, en el Artículo 1 ratifica como concepto de cambio climático al “cambio de clima atribuido directa o indirectamente a la actividad humana, que altera la composición de la atmósfera mundial y que se suma a la variabilidad natural del clima observada durante períodos de tiempo comparables”, lo cual, desde el punto de vista de analizar el impacto en la disponibilidad del recurso hídrico y por tanto disponibilidad de energía hidroeléctrica, implica el conocimiento de las tendencias naturales o variabilidad natural del clima. Bajo la premisa de que gran parte de la vulnerabilidad del sector eléctrico se encuentra en los bajos niveles de reserva de agua ante eventos extremos de sequía, es importante recalcar los hallazgos realizados por el Panel Inter-gubernamental para el Cambio Climático, IPCC por sus siglas en Inglés, con respecto al recurso hídrico (IPCC, 2008). Los datos observados y las proyecciones proveen abundante evidencia de que los recursos hídricos (agua dulce) son vulnerables y posen un alto potencial de ser fuertemente impactados por el cambio climático, con un amplio espectro de consecuencias para los seres humanos y ecosistemas, así: • Cambios temporales y de magnitud en los ciclos hidrológicos, con probable realce de las crecidas con caudales mayores y de las sequías con caudales menores (Beninston, 2003). • Cambios en la calidad del agua por el incremento de la temperatura. • Pérdida de áreas naturales de reserva de agua, como son los glaciares. A lo anterior debe agregarse que en cuencas andinas como la del Paute existe la probabilidad de que las zonas de páramo cuyo suelo y vegetación regulan de manera natural los caudales manteniendo el flujo durante los tiempos de sequía, también disminuyan su área por el movimiento ascendente de las fronteras de los ecosistemas, impulsados En un análisis de las distintas muestras de la Fig. 3 se puede notar un acentuamiento de los extremos, (caudales en el año 2009 de los meses enero, febrero y abril se presentan más altos y los de septiembre a diciembre los más bajos) siendo un indicio de la tendencia esperada como consecuencia de cambio climático, adicionalmente se nota claramente en los hidrogramas de caudales variaciones que dan cuenta de un fenómeno dinámico en el tiempo con variaciones de más del 50% en épocas similares de años distintos. Con respecto al cambio de temperatura, en la cuenca del río Paute se prevé un incremento decenal de 0,28 °C (PACC, 2009) y aproximadamente 0,2 °C para Daule, esto implica un impacto en la disponibilidad de agua por el incremento en la evapotranspiración y el cambio de humedad del suelo, además que para los cuerpos de agua como el embalse de Daule, Mazar y Amaluza, significa un incremento en el crecimiento de vegetación acuática, que podrían causar restricciones en la movilidad y por ende dificultades operativas con respecto a actividades como el dragado o problemas de eutrofización. Se plantea claramente un impacto de nuevas variables en la forma de concebir la disponibilidad futura de los recursos hídricos y por ende, de los servicios relacionados, como es la producción de energía hidroeléctrica, que para el caso del Ecuador se encuentra estrechamente ligada tanto al plan de expansión del sistema nacional como a la operación del mismo. 5. DISCUSIÓN Cuando se analiza el hidrograma de caudales mensuales correspondiente al año 2009 a juzgar por los meses iniciales y hasta el mes de julio se esperaría un año normal en términos estadísticos, sin embargo, a partir del mes de septiembre los caudales tuvieron valores totalmente inferiores a los esperados y predecibles de acuerdo a las tendencias, lo cual muestra una marcada vulnerabilidad en la consideración meramente estadística del fenómeno, por lo que se vislumbra un cambio de paradigma en el tratamiento de la variable caudales. 257 En primera instancia es necesario conocer a cabalidad las tendencias de cambio a lo largo del tiempo en las series disponibles, identificando las oscilaciones, para lo cual se puede aplicar técnicas basadas en la extracción de extremos en las series, cálculo de las probabilidades de excedencia y análisis de cómo extremos con la misma probabilidad varían en el tiempo (Ntegeka & Willems, 2008). Lo anterior permitirá profundizar en el conocimiento de las desviaciones y su recurrencia, sin embargo es necesario mejorar el entendimiento de los efectos específicos de las futuras afecciones de cambio, tanto en el aspecto climático como por aspectos degradativos en las cuencas de interés. Ello configurará escenarios de mayor claridad para disminuir la incertidumbre y optimizar la implementación y operación de los sistemas hidroeléctricos. Cabe notar que en términos de volumen total (ver Fig. 7), el año 2009 con 3371,7 Hm3 no representa uno de los años más críticos, habiéndose registrado en la serie analizada al menos 16 años con menor volumen de agua, así el volumen 2009 está muy próximo al volumen medio anual calculado para la serie 19642009 de 3454 Hm3. Ingreso anual de agua Hm3, Embalse Amaluza 4393.7 2562.0 2544.4 1984 2833.7 3591.3 3407.2 3433.9 3461.2 3645.2 3408.3 3146.2 2767.1 3402.3 3183.6 2559.2 3499.4 3183.6 3320.4 3144.7 3328.3 Ante los efectos del cambio climático se plantea la adaptación, siendo el primer gran paso el reconocimiento y la valoración del problema. Es probable que con acciones como la conclusión del proyecto Mazar, el sector eléctrico ecuatoriano, involuntariamente se esté adaptando al cambio climático, sin embargo existen aún mas incertidumbres que certezas, las cuales deberán ser estudiadas y cuantificadas, a fin de realizar acciones que coadyuven a una mayor efectividad en la planificación, optimizando el tiempo y recursos necesarios para enfrentar los cambios. Se agradece al Consejo Nacional de Electricidad, CONELEC y CELEC EP Unidad de Negocio Hidropaute por brindar las facilidades tecnológicas y físicas para llevar a cabo este trabajo. 3423.1 3371.7 2998.8 2518.4 2008 3370.8 3369.2 1980 2847.4 1968 2500 3517.1 3234.0 1964 2850 3515.9 3720.0 3816.2 2004 3200 3778.3 3891.5 2000 3279.9 3408.4 El reto de la planificación no solamente se plantea como la oportunidad de incorporar nueva infraestructura para enfrentar con solvencia el crecimiento de la demanda y sobrellevar la vulnerabilidad propia del SNI, ahora también se avizoran variables antes no consideradas, con el riesgo de incrementar la vulnerabilidad del lado de los eventos naturales. AGRADECIMIENTO 4054.4 3979.4 1988 3617.0 3971.6 1976 3550 1972 Volumen Hm3 3900 3831.5 4614.1 4520.9 4186.4 4250 1992 4600 lluvia es de 2,5 meses (PACC, 2009), similar al de regulación para el embalse de Mazar, sin embargo cabe notar que la estimación específica de escenarios para la Cuenca del Paute aún está a una escala muy gruesa y hasta cierto punto cualitativa antes que cuantitativa, calculado sobre una grilla de 25 x 25 km. Figura 7: Ingreso anual de agua Hm3, embalse de Amaluza Por las tendencias globales se espera períodos de sequías de mayor duración y menor caudal (Beninston, 2003; Urrutia and Vuille, 2009), no obstante los balances anuales permanezcan en los rangos promedio conforme ocurrió en el año 2009 (ver Fig. 7), aquello implicaría replantear las premisas y métodos de planificación del sector eléctrico, tanto para la implementación, tipo de tecnología y complementariedad de las centrales, así como profundizar el conocimiento de los sistemas hídricos individuales tal que se pueda mejorar la predicción en el corto, mediano y largo plazo, incrementando la eficiencia en el uso del recurso hídrico y la resiliencia del sistema eléctrico ecuatoriano con respecto a los cambios dinámicos que afectan el clima. Se expresa un agradecimiento al Sr. Diego Salinas, técnico de la Dirección de Planificación del CONELEC, por haber colaborado en la elaboración de este documento. REFERENCIAS BIBLIOGRÁFICAS El período estimado para extremos de escases de 258 [1] Laboratorio experimental SNI. [2] Beninston M (2003). Climate change in mountain regions: a review of possible impacts. Climate Change 59, 5-31. [3] Buytaert W, Célleri R, De Bievre B, Cisneros F, Hofstede R, 2008. Impacto humano en la hidrología de los páramos andinos. Universidad de Cuenca, 65 p. [4] Buytaert W, Deckers J, Dercon G, De Bievre B, Poesen J, Govers G. 2002. Impact of land use changes on hydrological properties of volcanic ash soils in South Ecuador. Soil Use and Management 18:94-100. [5] Buytaert W, Vuille M, Dewulf A, Urrutia R, Karmalkar A, Celleri R. 2010. Uncertainties in climate change projections and regional downscaling: implications for water resources management. Hydrol. Earth Syst. Sci. Discuss. 7, 1821-1848. [6] Celleri R. 2007. Rainfall variability and rainfall runoff dynamics in the Paute River Basin, southern Ecuador. K.U.Leuven, Faculty of Engineerinf, Doctoral dissertation, 144 p. [7] Gleik P. 2000. Informe del Equipo de Evaluación del Sector Hidráulico sobre las consecuencias potenciales de la variabilidad y el cambio climático. Pacific Institute for studies in development, environment and security. 19p. [1] [8] IDEAM, 2001. Colombia, Primera comunicación nacional ante la Convención Marco de las Naciones Unidas sobre el Cambio Climático. IDEAM, Bogota. [9] IPCC, 2008, Technical Paper on Climate Change and Water. [10] Ntegeka V., Willems P. (2008). Trends and multidecadal oscillations in rainfall extremes based on a more then 100 years time series of ten minutes rainfall intensities at Uccle, 259 Belgium. Water Resourc. Res. 44, W07402, doi: 10.1029/2007WR006471. [11] Proyecto Adaptación al Cambio Climático a través de una efectiva gobernabilidad del agua en el Ecuador (PACC), 2009, Ministerio del Ambiente del Ecuador. 164 p. [12] Urrutia R., Vuille M. (2009). Climate change projections for tropical Andes using a regional climate model: Temperature and precipitation simulations for the end of the 21st century, J. Geophys. Res., 114, D02108, 2009. Paúl F. Vásquez Miranda, Consejo Nacional de Electricidad, CONELEC – Director de Planificación. Pablo Ismael Guzmán Cárdenas, Jefe De Gestión Ambiental Y Responsabilidad Social en la Corporación Eléctrica del Ecuador – Unidad de Negocio Hidropaute.. 2012 Procedimiento para el Control Automático de la Frecuencia en el Sistema Nacional Interconectado del Ecuador M. Arias Consejo Nacional de Electricidad - CONELEC Resumen-- Se presenta un procedimiento que permite obtener los valores de ajuste del factor BIAS de frecuencia del sistema eléctrico del Ecuador a partir de la integración de las características aleatorias de la carga del sistema, de las características de los gobernadores de velocidad de las unidades que participan en el control, de la composición de las unidades que participan en el control y de las bandas muertas de los sistemas de control central de Ecuador y de Colombia. Para la consecución de los objetivos se utilizan métodos estadísticos para el procesamiento de las bases de datos de mediciones tomadas en tiempo real y métodos de simulación a partir del modelo concentrado equivalente del sistema interconectado Ecuador – Colombia. Los valores de ajuste obtenidos al utilizar el procedimiento propuesto son comparados con los valores propuestos por procedimientos de optimización encontrados en la literatura especializada, atendiendo al criterio del número de acciones de control y a la calidad de la respuesta de la transferencia por las líneas de enlace. Palabras Clave-- Regulación Primaria, Regulación Secundaria, Reserva Rodante, Esquema de Alivio de Carga, factor BIAS, Banda Muerta, Variaciones de la Carga. 1. INTRODUCCIÓN Para la operación correcta de los sistemas eléctricos de potencia, la frecuencia debe permanecer lo más cerca posible de su valor nominal. Garantizar mediante acciones de control que el error de la frecuencia oscile alrededor de cero asegura que la velocidad de las máquinas de inducción y de las máquinas sincrónicas permanezca constante, lo cual es particularmente importante para su rendimiento satisfactorio [1]- [2]. Tres niveles de control son generalmente usados para mantener el balance entre la generación y la carga y se les conoce como control primario, secundario y terciario de la frecuencia. El control primario de la frecuencia es de tipo local y actúa directamente en el eje de los generadores que ajustan su potencia activa para restaurar de manera rápida el desbalance de potencia. Este tipo de control es muy efectivo para estabilizar la frecuencia cuando ocurren grandes variaciones de la carga. Todos los generadores que tienen activado los reguladores de velocidad efectúan este control automáticamente. Las cargas que son sensibles a los cambios de la velocidad también tienen participación en este tipo de control, debido al efecto de autorregulación. El control secundario de la frecuencia es automático y puede ser de tipo centralizado, pluralista o jerárquico. En este control se ajusta la producción de potencia activa de las unidades para restablecer la frecuencia y el intercambio de potencia entre las áreas de interconexión a los valores prefijados. Requiere de sistemas de tele medición, procesamiento de señales, comunicaciones y algoritmos de control [1]. A diferencia del control primario que limita las desviaciones de la frecuencia del valor fijado, el control secundario lleva la frecuencia al valor nominal. En este tipo de control no hay influencia de la carga. El control secundario de la frecuencia no es necesario en los sistemas eléctricos de potencia con estatismos fuertes y con suficiente reserva para realizar el control de la frecuencia de forma manual, lo que se conoce generalmente con el nombre de control terciario de la frecuencia [3]-[4]. No obstante, es imprescindible en grandes sistemas interconectados debido a que el control manual no elimina las sobrecargas en las líneas de interconexión con la rapidez necesaria [3]. En el Sistema Nacional Interconectado -SNI del Ecuador no se conoce con exactitud el valor de la dispersión de la frecuencia, razón por la que no se pueden definir los límites de tolerancia con los que se evalúa el control de la frecuencia, tomándose en la práctica valores sin apego a las normas internacionales actuales o a las indicaciones de la literatura especializada. En cuanto a los valores de la reserva para el control de la frecuencia, éstos se fijan sin tener en cuenta la dinámica del sistema. El esquema de alivio de carga por baja frecuencia que se utiliza actualmente en el 260 sistema eléctrico del Ecuador no considera la rapidez de variación de la frecuencia (df/dt) en el diseño de los pasos de deslastre de carga. Con respecto a los ajustes de las bandas muertas de los sistemas AGC y al factor BIAS, se considera que los valores utilizados en Ecuador y en Colombia obedecen a valores típicos internacionales que no se ajustan necesariamente a las condiciones específicas de ambos sistemas[5]-[6]. En este trabajo se determinarán, integrando las características del sistema interconectado Ecuador Colombia, los valores de ajuste del factor BIAS de frecuencia en el SNI del Ecuador. El procedimiento propuesto será contrastado contra procedimientos de optimización encontrados en la literatura especializada y se verificará que brinde mejores respuestas en cuanto a la calidad de la transferencia y al número de acciones de control. El presente artículo es la culminación de un proceso investigativo que ha venido siendo publicado por la revista Energía del CENACE (cuatro artículos), en sus ediciones 2008 y 2010. 2. PROCEDIMIENTO PARA LA OBTENCIÓN DE LOS VALORES DE AJUSTE DEL FACTOR BIAS EN EL SNI DEL ECUADOR En la Fig. 1. se muestra el diagrama de flujo del procedimiento utilizado para la determinación del factor BIAS de frecuencia en el SNI del Ecuador. Base de Datos Proporcionada por CENACE Despacho Económico Carga medida cada 3s Datos de la Interconexión Modelación Reguladores de Velocidad Caracterización: Variaciones Aleatorias, Monótonas y Estatismo Cálculo del momento de Sincronización Obtención del Modelo Concentrado Equivalente Generación , Frecuancia, Transferencia, medidas cada 3s Estimación de los valores de BIAS mínimos necesarios para el cumplimiento de los criterios CPS de NERC Estimación de la reserva rodante y de las bandas muertas del control primario y secundario Cálculo de estatismo efectivo del sistema Figura 1: Diagrama de flujo del procedimiento integral utilizado para la determinación del factor BIAS de frecuencia en el SNI del Ecuador Nótese que la base para la determinación del factor BIAS de frecuencia radica en el cálculo del estatismo efectivo del sistema; que a su vez, es calculado a partir de dos procesos paralelos: la estimación de la reserva rodante y de las bandas muertas del control primario y secundario de la frecuencia; y la estimación de los valores del factor BIAS mínimos necesarios para el cumplimiento de los criterios CPS de la NERC 2.1. Estimación de la reserva rodante y de las bandas muertas Para la estimación de la reserva rodante, y para determinar las bandas muertas del control primario y secundario, se requiere la caracterización de la dinámica del control de la frecuencia, lo cual a su vez implica la obtención del modelo concentrado equivalente utilizado para las simulaciones de la respuesta del sistema ante variaciones de la carga. El esquema general para el estudio de la dinámica de la frecuencia en un sistema interconectado de dos áreas es el que se muestra en la Fig. 2. En este esquema todas las unidades de los dos sistemas se concentran en dos generadores equivalentes, cuyas inercias son la suma de las inercias de todas las unidades de cada sistema, representadas como M1 y M2. Por otra parte D1 y D2 representan los estatismos de la carga de cada sistema. Los bloques con los nombres turbina, gobernador y 1/R representan un sistema equivalente de control de velocidad de los sistemas ecuatoriano y colombiano, respectivamente. El bloque de ganancia T permite modelar las variaciones de las transferencias por las líneas de enlace de ambos sistemas. Estos parámetros ya fueron calculados por este autor y publicados en [7], en donde se destacó la importancia de la modelación individual de cada uno de los sistemas de regulación de velocidad las unidades de Ecuador y de Colombia, aspecto que influye decisivamente en el cálculo del estatismo efectivo del sistema. Ajuste Adecuado del factor BIAS (respuesta de las variables de estado y nº de acciones de control) Reajuste de la banda muerta del control secundario (disminución del error medio de la transferencia) Verificación de la correlación Generación Vs. Carga de la áreas de control NO SI FIN 261 ∆w 1 x 1 2� dſ dt ∑ - 1 x ∆w 1 M ∑ - ∆P11 1 2� 1 x + D1 1 + DAF M T ∆P12 + 2 + - P11 x + D2 + - ∑ + ∆ DAF Turbina Turbina Gobernador Gobernador - ∑ ∑ K1 x K2 x ACE + ∑ - + + Solo Unidades bajo AGC dſ dt P12 ∆ 1 R1 ß1 + ACE - + Control AGC ∑ ∆P11 1 R1 Solo Unidades bajo AGC + ß1 Figura 2. Esquema concentrado equivalente para el estudio dinámico del control de la frecuencia En cuanto a las variaciones aleatorias de la carga, representadas en la Fig. 2 como el bloque ΔP, en otro trabajo publicado por este autor [8], se utilizaron técnicas estadísticas espectrales para la caracterización de las desviaciones de potencia como función de la potencia planificada en intervalos de poca variación de la carga en el SNI del Ecuador. Para completar el modelo concentrado equivalente, solo falta por definir el esquema de alivio de carga, representado en la Fig. 2 como el bloque DAF. 2.1.1. Esquema de alivio de carga Se propone el diseño de un esquema de alivio de carga (DAF) que combina las ventajas del uso de los relés de tiempo definido y de los denominados relés de derivada que tienen en cuenta la tasa de variación de la frecuencia con respecto al tiempo. Los objetivos principales del esquema radican en mejorar el aprovechamiento de la reserva destinada al control primario de la frecuencia (evitando deslastres innecesarios de carga) y evitar valores de sobre frecuencia cuando se accione el DAF. Como se muestra en la Fig. 3, la sección del esquema que utiliza los relés de derivada consta de cuatro banderas que preguntan la tasa de variación de la frecuencia con respecto al tiempo cuando la frecuencia es igual a 59,4 Hz, 59,2 Hz, 59 Hz y 58,8 Hz. Internamente, cada bandera consta de varios pasos de deslastre de carga que dependen del valor de la derivada de la frecuencia con respecto al tiempo, tal como se puede ver en la Tabla 1. Figura 3. Esquema DAF propuesto que combina el uso de relés de derivada y relés de tiempo definido Con respecto a los relés de tiempo definido, nótese que existen dos: uno que deslastra la carga cuando la frecuencia ha llegado a los 58,7 Hz y otro que realiza el deslastre a los 58,4 Hz. Esta sección del esquema se acciona para fallas no muy grandes que provocan una caída continua pero lenta de la frecuencia. Por esta razón se impone un retardo adicional de 12 ciclos (200 ms). En la Tabla 1 se muestran los ajustes del esquema de alivio de carga propuesto para el SNI del Ecuador. El esquema DAF propuesto fue validado para 7 escenarios de salidas bruscas de generación en el sistema interconectado Ecuador – Colombia. Estos escenarios, como puede observarse en la Tabla 2, tienen en cuenta las diversas combinaciones de salidas de generación que pueden darse en sistemas interconectados. Los resultados de la validación se muestran en la Tabla 3. Puede observarse que el esquema DAF propuesto es válido tanto para demanda mínima como para demanda punta, pues no existen valores de sobre frecuencia y porque el aprovechamiento de la reserva primaria es superior al 70 % en la mayoría de los escenarios de simulación. 262 Tabla 1: Desconexión de carga para cada valor de ajuste del DAF propuesto Bandera/Ajustes Pasos del df/dt Ecuador (Hz/s) 0,3* 0,5* 0,76* 0,9 1,3 59,4 Hz 3% 2% 3% 3% 4,5% 59,2 Hz 2% 2% 4% 4% 4,5% 59 Hz 2% 2% 2% 2% 4,5% 58,8 Hz 2% 2% 2% 2% 4,5% Instantáneo 58,7 Hz.* 2% Instantáneo 58,4 Hz.* 4,5% Estable Punta * Pasos con retardo intencional de 12 ciclos (200 ms Tabla 2: Escenarios de validación del esquema de alivio de carga propuesto 58,95 59,79 59,26 59,65 287 58,60 59,57 52,14 59,05 59,19 287 59,29 59,73 95,12 78,21 88,48 495 Disparo Pérdida Transferencia Ecuador Colombia Total Planificada (MW) (MW) Enlace (MW) 59,02 59,76 1 111 0 Sí 0 58,40 59,21 2 111 0 Sí 250 3 130 0 Sí 0 4 130 0 Sí 250 5 0 523 No 0 6 605 1150 No 250 7 605 0 Sí 400 Caso Disparo 72,58 58,78 58,87 280,82 59,19 59,57 71,60 59,12 59,77 76,18 338,56 59,35 59,89 29,60 158,00 58,79 59,90 26,42 597,94 58,40 59,68 90,00 955,75 912 Para la obtención de los valores de la reserva primaria se siguen los siguientes pasos: Carga Desconectada (MW) Frecuencia Estable (Hz) Frecuencia Mínima (Hz) Caso Escenario Estable Mínima 59,78 52,14 2.1.2. Estimación de la reserva rodante • Verificar que en condiciones normales de trabajo el valor de la reserva primaria garantice el cubrimiento de las variaciones aleatorias de la carga, que según [8] son: 19,36 MW en demanda mínima, 23,29 MW en demanda media y 25,16 MW en demanda máxima. • Para condiciones de falla, la reserva primaria y el esquema de alivio de carga (DAF) deben garantizar una respuesta dinámica de la frecuencia adecuada; es decir, valores de frecuencia mínima superiores a los 57 Hz y valores de frecuencia post falla cercana e inferior a 60 Hz. Tabla 3: Validación del esquema DAF propuesto para las horas de demanda mínima y máxima 59,29 80,13 71,60 Es importante aclarar que en la determinación de la reserva primaria se parte de un valor correspondiente a las desviaciones aleatorias de la carga y se va subiendo hasta que se satisfacen los requerimientos de desviación máxima de frecuencia, frecuencia de estabilización y utilización de la reserva, aspectos frecuentemente evaluados en la bibliografía especializada. Los niveles de reserva primaria para el SNI del Ecuador se muestran en la Tabla 4. En cuanto a la reserva rodante necesaria para efectuar el control secundario, se debe asegurar que dicha reserva cubra las variaciones aleatorias de la carga. Lo anterior se debe a que los sistemas para el control automático de la generación (AGC) están diseñados para trabajar en condiciones normales de operación. 263 Tabla 4: Reserva para el control primario en el SNI del Ecuador Banda Horaria Potencia Media MW Reserva en MW Reserva en % Mínima 1650 45 2,73 Media 2414 52,5 2,17 Punta 2864 60 2,09 p.u. 2.1.3. Estimación de las bandas muertas La banda muerta para el control secundario se fija de la siguiente forma: 5,5 MW en el Ecuador para la demanda mínima y 8,75 MW para la demanda máxima. Estos valores fueron fijados en función de la desviación media cuadrática de las desviaciones de la potencia, siguiendo el procedimiento descrito en [8]. La banda muerta para el control primario se fija en 31 mHz. Este valor obedece a las recomendaciones encontradas en la literatura especializada [9]. 2.2. Estimación de los valores de BIAS necesarios para el cumplimiento de los criterios CPS de la NERC En un trabajo publicado por este autor [10], se presenta un estudio de la verificación del cumplimiento de los criterios CPS de la NERC en el SNI del Ecuador, en el primer semestre del año 2008. Según este estudio, cuando el BIAS es ajustado en un valor inferior a los 150 MW/Hz para la demanda mínima y de 250 MW/Hz en demanda máxima, no se cumplen los criterios CPS de la NERC. Este es un argumento limitante para el ajuste del factor BIAS de frecuencia en cualquier sistema eléctrico de potencia. 2.3. Cálculo del estatismo efectivo del sistema En las secciones 2.1 y 2.2 de este trabajo se explicaron los procesos paralelos que permitieron estimar la reserva rodante y las bandas muertas para el control de la frecuencia, y definir los valores mínimos de BIAS para cumplir los criterios CPS de la NERC. A partir de estos procesos paralelos se puede calcular el estatismo efectivo del sistema y, de acuerdo con el diagrama de flujos de la Fig. 1, ajustar los valores del factor BIAS para el SNI del Ecuador. Le y Kramer plantean en [11] un método que permite calcular el estatismo efectivo del sistema a partir de las simulaciones de la respuesta dinámica del sistema ante fallas. La expresión (1) permite calcular el promedio móvil de la señal del error de control de área en un intervalo de tiempo T. T: intervalo de análisis. Por ejemplo, si se desea calcular el promedio móvil de la señal de error de control de área en el periodo estable de la demanda punta, el intervalo de simulación y cálculo será de una hora (19:30 a 20:30 horas), ACE: señal error de control de área, Ta: transferencia planificada por las líneas de enlace. PL: carga del sistema. ∆P base: carga base del sistema. ∆ω: velocidad síncrona del sistema. En por unidad es igual a la frecuencia del sistema. τa, τb, τc: parámetros que permiten calcular el promedio móvil de la señal del error de control de área. ΔP error: señal de error de la potencia. Es igual a la potencia generada en el sistema, menos la potencia utilizada para la regulación de la frecuencia y menos la carga base del sistema. Como los parámetros τa, τb, τc varían con las condiciones del sistema, sus valores deben actualizarse continuamente, para lo cual se usa un algoritmo recursivo de mínimos cuadrados. A cada paso de actualización k, el estatismo del sistema puede ser calculado con la expresión (2). Para poder aplicar el método de los mínimos cuadrados es necesario construir un sistema indeterminado de cuatro ecuaciones para obtener la solución de las tres incógnitas: a τa, τb, τc, partir de la expresión (1). La forma de obtener el sistema indeterminado necesario se observa en la Fig. 4. Recuérdese que se considera un intervalo de análisis de una hora, o 264 3600 segundos. Debido a que la lectura de los datos se hace cada 3 segundos, en un intervalo horario habrá 1200 mediciones. Las cuatro ecuaciones formadas son arreglos de las variables vistas en la expresión (1); es decir: ACE , ACE, PL, ΔP error, ΔP base y Δω. Por ejemplo, para obtener el primer valor de ACE , se toma una ventana de un minuto y se promedian los primeros 20 valores del ACE. El segundo valor de ACE , se obtiene moviendo la ventana de un minuto 3 segundos más adelante. Nótese que ahora el promedio del ACE se hará considerando las mediciones 2 a la 21. El tercer valor del ACE , se obtiene del promedio de las mediciones 3 a la 22 y, finalmente, el cuarto valor del ACE , se obtiene del promedio de las mediciones 4 a la 24 del ACE. Con el mismo método se pueden calcular los valores del ACE, PL, ΔP error, ΔP base y Δω, solo que en lugar de buscar el promedio de las 20 mediciones, esta vez se busca la diferencia del último valor del arreglo menos el primero. Nótese que a los 12 segundos (k = 12) ya se tienen un sistema de cuatro ecuaciones con tres incógnitas. Aplicando el método para todo el intervalo horario (1200 mediciones) se tendrán 100 sistemas de cuatro ecuaciones con tres incógnitas. Con el método de los mínimos cuadrados se pueden obtener las soluciones de este sistema. Con el procedimiento descrito anteriormente, y partiendo de la base de datos obtenida a partir de la simulación del sistema (para lo cual se utilizó el esquema concentrado equivalente de la Fig. 1), se calcularon los valores del estatismo efectivo del SNI del Ecuador para los tres periodos de la demanda. En la Fig. 5 se muestran los resultados de la demanda punta. • Demanda mínima: 119 MW/Hz, • Demanda máxima: 235 MW/Hz, 3s ACE ti Sistema indeterminado de cuatro ecuaciones con 3 incógnitas Intervalo Horario tf Ventanas móviles de 1 minuto Figura 4. Obtención del sistema indeterminado de cuatro ecuaciones con tres incógnitas necesario para la aplicación del método de los mínimos cuadrados MW/Hz 1200 900 600 Demanda Punta 300 0 3 6 9 12 15 18 Cantidad de Valores Figura 5: Cálculo del estatismo efectivo del SNI del Ecuador en Demanda Máxima 3. COMPARACIÓN DEL PROCEDIMIENTO PROPUESTO El procedimiento propuesto se compara, desde los puntos de vista de la respuesta de la transferencia y del número de acciones de control, con los siguientes procedimientos de ajuste del factor BIAS: • Periodo rampa máxima demanda: 235 MW/ Hz. Teniendo en cuenta los valores calculados del estatismo efectivo, y considerando los valores mínimos necesarios para el cumplimiento de los criterios CPS de la NERC, se proponen los siguientes valores de ajuste para el factor BIAS de frecuencia en el SNI del Ecuador: 150 MW/Hz para la demanda mínima y 250 MW/Hz para la demanda máxima. 265 1. Procedimientos de optimización debidos a Patel y Játiva [12] - [13]. Estos dos autores, a través del uso de técnicas de inteligencia artificial, coinciden en que el factor BIAS debe ajustarse en un valor igual al 85 % del valor del estatismo del sistema. Los ajustes de este procedimiento son: demanda mínima con 180 MW/Hz; demanda máxima con 280 MW/Hz. 2. Procedimientos de optimización clásicos [1]. Estos procedimientos ajustan el factor BIAS en un valor igual al valor del estatismo del sistema. El estatismo del sistema ecuatoriano se calculó a partir de la información extraída de los despachos económicos típicos proporcionados por el CENACE: 220 MW/Hz en demanda mínima y 330 MW/Hz en demanda máxima. comparados muestran mayores niveles de dispersión del error de la transferencia. Sin embargo de lo dicho anteriormente, es necesario demostrar que el método propuesto es superior en cualquier escenario de simulación, para lo cual es necesario hacer uso de pruebas estadísticas específicas. 3.Los periodos de simulación son los siguientes: desde las 03:00 a las 05:00 horas en demanda mínima, desde las 19:00 hasta las 20:00 horas en demanda máxima y desde las 17:00 hasta las 18:00 en el periodo de monotonía. Los periodos de simulación del orden de 1-3 horas para la evaluación del comportamiento del control de la frecuencia son típicos [1], [2], [11]. Para demostrar que el método propuesto da menos dispersión en la desviación estándar del error medio de la transferencia se utilizó el Test Estadístico “F – Test”, que trata de rechazar la hipótesis de que dos vectores independientes, que vienen de una distribución normal, tienen la misma varianza, con la hipótesis alternativa de que las varianzas son diferentes. 3.1. Comparación de la respuesta de la transferencia Lo que se espera de un buen control de la transferencia por las líneas de enlace es que el error medio de la transferencia sea lo más cercano posible a cero y que la desviación estándar sea la menor posible, pues ésta puede interpretarse como potencia inadvertida (y acumulación del desvío del tiempo) en las áreas de control. Por estas dos razones el procedimiento propuesto (método integral) es el que presenta mejores resultados, según lo que se ve en las Tabla 5. Hay que señalar las diferencias en la dispersión de la transferencia para las variantes analizadas se exponen en términos de energía, por ser éstas considerables a lo largo del tiempo. Por otra parte, para demostrar que el método propuesto produce un menor error medio de la transferencia, se utilizó el Test Estadístico “T – Test” que trata de rechazar la hipótesis de que dos vectores independientes, que vienen de una distribución normal, tienen el mismo valor medio y la misma varianza, con la hipótesis alternativa de que con el método propuesto se consigue una menor varianza, o menor dispersión en la respuesta de la transferencia. Los resultados de las pruebas de hipótesis se pueden observar en las Figuras 6 y 7. Tabla 5: Diferencias en la dispersión del error de la transferencia, obtenidas al comparar los procedimientos de ajuste del BIAS, expresadas en MWh Propuesto (modelo integral) 8,30 4,76 6,55 Optimización de Patel-Játiva 8,46 5,12 6,70 6,12 6,64 Optimización Clasica Nivel Propuesto de Nº de Vs Confianza Muestras Patel Játiva Total (MWh.) Punta F Test: Prueba de la varianzas - Clasico Rechazo de la Hipótesis Nula P - value 95 % 850 Si 0,0233 95 % 850 Si 2,8346e010 F Test: Prueba de la varianzas Mínima De lo visto en las Tablas 5, y teniendo en cuenta los diversos escenarios de análisis, se puede concluir que el procedimiento de ajuste del factor BIAS de frecuencia que brinda la menor dispersión de la transferencia es el propuesto en este artículo (método integral). Los métodos de ajuste por optimización 266 Nivel Propuesto de Nº de Vs Confianza Muestras Rechazo de la Hipótesis Nula P - value 400 Si 0,003 95 % 400 Si 3,9155e009 Las dos conclusiones anteriores permiten asegurar que con el método propuesto se consiguen menores valores de energía inadvertida por las líneas de enlace con Colombia. Esto también se puede interpretar como una disminución en la acumulación del error del tiempo. Figura 6: Resultados de la prueba de hipótesis de las varianzas Analizando los valores del p value (mucho menores que 0,05) mostrados en la Fig. 6, se puede concluir que con el método propuesto se consiguen menores valores de dispersión en la respuesta de la transferencia, con independencia del periodo de demanda horaria que se analice. Nivel Propuesto de Nº de Vs Confianza Muestras Patel Játiva - Clasico Punta Rechazo de la Hipótesis Nula 95 % 850 Si 0,0079 95 % 850 Si 7,0820e011 F Test: Prueba de las medias Nivel Propuesto de Nº de Vs Confianza Muestras Patel Játiva Clasico - P - value De acuerdo con estas Tablas, el procedimiento propuesto integral propuesto para ajustar el factor BIAS produce 31 acciones de control menos que los procedimientos de optimización propuestos por Patel y Játiva; y produce 48 acciones de control menos que los procedimientos clásicos de optimización, en los escenarios de estudio utilizados. Tabla 6: Número de unidades bajo AGC y número de acciones de control que se producen al ajustar los valores del factor BIAS de acuerdo con los procedimientos bajo análisis Mínima Rechazo de la Hipótesis Nula En las Tablas 6 y 7 se muestran las acciones de control que se producen en cada unidad bajo AGC de Paute cuando se ajusta el BIAS de acuerdo a lo establecido en los procedimientos bajo análisis. Nótese que se han simulado los periodos de demanda mínima, máxima y el periodo de monotonía que va desde la demanda media a la máxima. La banda muerta de Colombia ha sido fijada en 12 MW para la demanda mínima y 20 MW para la demanda máxima y es un dato de entrada fijo para todas las variantes comparadas. Mínima P - value 95 % 400 Si 0,022 95 % 400 Si 6,6283e008 Procedimiento Figura 7: Resultados de la prueba de hipótesis de las medias Analizando los valores del p value (mucho menores que 0,05) mostrados en la Fig. 7, se puede concluir que con el método propuesto se consiguen menores valores de error medio en la respuesta de la transferencia, con independencia del periodo de demanda horaria que se analice. 267 P r o p u e s t o (modelo integral) 3 Optimización Patel-Játiva de 3 Optimización Clasica 3 Nº de acciones / F Test: Prueba de las medias 3.2. Comparación del número de acciones de control Nº de unidades Clasico 95 % Nº de acciones / Nº de unidades Nº de - Nº de unidades Patel Játiva 9 Tabla 7: Número de acciones de control que se producen al ajustar los valores del factor BIAS de acuerdo con los procedimientos bajo análisis Procedimiento Total Propuesto (modelo integral) 21 20 45 86 Optimización de Patel-Játiva 27 25 65 117 39 25 70 Gráfica de Generación Vs. Carga 134 4. COMPROBACIÓN TEÓRICAS DEL VALOR AJUSTADO PARA EL FACTOR BIAS EN EL SNI DEL ECUADOR 8590 2610 8580 2600 8570 2590 8560 2580 8550 MW Como conclusión de lo visto hasta el momento se puede decir que el procedimiento propuesto para fijar el BIAS en el SNI del Ecuador produce menos acciones de control que los procedimientos de optimización que se utilizaron para las comprobaciones, además de conseguir menores niveles de dispersión en la respuesta de la transferencia. Como corolario de lo anterior se puede resaltar que se justifica la necesidad de incluir en las modelaciones el efecto aleatorio de la carga y las alinealidades de los esquemas de control de las unidades de generación. 2620 MW Optimización Clasica independientemente del movimiento de la carga de Colombia. 2570 8540 Generación Ecuador 2560 Carga Ecuador Carga Colombia 2550 2540 0 2 4 6 8 10 12 14 16 18 20 22 24 26 28 30 32 34 36 38 40 42 44 46 48 50 52 54 56 58 60 minutos 8530 8520 8510 Figura 8: Gráfico de la Generación del Ecuador Vs. la Carga del Ecuador y la Carga de Colombia. El eje izquierdo de las ordenadas contiene la escala de la generación y de la carga del Ecuador. El eje derecho de las ordenadas contiene la escala de la carga de Colombia 5. CONCLUSIONES Cuando el BIAS de un área es ajustado de forma correcta, la generación del área debe seguir a las variaciones de la carga que se dan dentro de sus fronteras. Por ejemplo, si se produce una falla en el área 1, las demás áreas participan en el control primario, pero solo el área 1 ejecuta el control secundario para llevar el error de la frecuencia a cero. De esta manera se puede afirmar que el control secundario es correcto. Se realizaron comprobaciones encaminadas a demostrar que con los valores de BIAS fijados con el procedimiento propuesto se consigue un control correcto. Se toma como ejemplo el valor de ajuste para la demanda punta. La data necesaria fue tomada de los registros históricos del CENACE y representa a las variaciones de la carga que se producen entre las 20:00 y las 21:00 horas (60 minutos de análisis) de un día laborable típico. Ver en la Fig. 8 que la generación en el área ecuatoriana (rojo) sigue a las variaciones de la carga del Ecuador (azul) y no a las variaciones de la carga de Colombia (verde). Por ejemplo, observar el periodo que va desde los 32 a los 40 minutos: en este intervalo la carga de Colombia baja desde los 8570 MW hasta los 8530 MW; mientras que la carga de Ecuador oscila alrededor de los 2600 MW; es decir, oscila alrededor de un valor constante. El control secundario en el lado ecuatoriano es correcto puesto que la generación en dicha área también oscila alrededor de los 2600 MW, 268 1. El procedimiento propuesto para ajustar el factor BIAS de frecuencia permite la obtención de los valores de ajuste del factor BIAS en el SNI del Ecuador a partir de la integración de las características aleatorias de la carga del sistema interconectado, las características de los gobernadores de velocidad de las unidades que participan en el control de la frecuencia, la composición de las unidades que participan en el control, las bandas muertas de los sistemas AGC de Ecuador y de Colombia. Lo anterior constituye una novedad científica. 2. Para la validación de este procedimiento se simularon periodos representativos de mínima y máxima generación (de dos y una horas de duración). Estas simulaciones permiten concluir que los resultados alcanzados son superiores a los obtenidos por las principales propuestas de ajuste reflejados en la bibliografía especializada en cuanto a: • Calidad de la respuesta de la transferencia, reflejada en menores valores de la dispersión y del error medio. • Menor cantidad de acciones de control secundario de las unidades asignadas a esa tarea, lo que disminuye el desgaste de las unidades. ancillary services.” IEEE Trans. Power Syst. Vol 22. No. 1, 350-357: 2007. • Alta correlación entre las acciones de control secundario y las variaciones de la carga en el sistema eléctrico del Ecuador. • Cumplimiento de los criterios de calidad de la operación sugeridos por la NERC. [4] P. Kumar, D. Kothari. “Recent philosophies of automatic generation control strategies in power systems.” IEEE Trans. Power Syst. Vol 2o. No. 1, 345-357: 2005. • Obtención de reservas de generación primaria y secundaria adecuadas a las necesidades del sistema en condiciones transitorias y estables de trabajo. 3. 4. El esquema de alivio de carga propuesto en este trabajo fue validado para 7 escenarios típicos de contingencias múltiples que se producen en el sistema interconectado Ecuador – Colombia. Las ventajas de este esquema radican en el aprovechamiento de la reserva primaria y en la selectividad de la protección que evita los valores de sobre frecuencia. En el presente artículo se ha propuesto un método para la determinación de la reserva rodante necesaria para el control de la frecuencia que considera la dinámica de la respuesta de la frecuencia ante falla y en condiciones normales de operación, atendiendo a las variaciones aleatorias de la carga. RECOMENDACIONES En este trabajo se utilizó para las simulaciones el paquete computacional MATLAB. Las técnicas de programación empleadas permitieron que las simulaciones off line se hagan en un tiempo promedio de 25 minutos por cada hora de simulación. La versión MATLAB 10 permite un mejor aprovechamiento de los procesadores de 4 núcleos y una reducción en los tiempos empleados para la simulación. REFERENCIAS BIBLIOGRÁFICAS [1] P. Kundur Power system Stability and Control. New York: Mc Graw Hill., 1994. [2] L.R. Chien, N. Hoonchareon. “Estimation of B for adaptive frequency bias setting in load frequency control.” IEEE Trans. Power Syst. Vol 18, No. 2, May 2003: 904-9111. [3] “A survey of frequency and voltage control 269 [5] Manual de entonación de Parámetros de Control Automático de Generación (AGC) EDELCA. Manual, Caracas: ABB, 2001. [6] Manual de Entonación de Parámetros del Control Automático de Generación (AGC) del Sistema Interconectado Ecuador - Colombia. Manual, Quito: ABB, 2007. [7] M. Arias, A. Martínez, H. Arcos. “Dinámica de la frecuencia del Sistema Interconectado Ecuador - Colombia.” Energía CENACE, 2008. [8] M. Arias, A.Martínez, H. Arcos. “Caracterización de la carga del SNI del Ecuador.” Energía CENACE, 2008. [9] Y. Rebours, D. Kirschen. “A survey of frequency and voltage control auxiliary services.” IEEE Trans. Power Syst. , 2007 Vol 22 No. 1: 350 357. [10] M Arias, A. Martínez, H. Arcos. “Verificación de los criterios CPS de la NERC en el SNI del Ecuador.” Energía CENACE No. 6, Feb. 2010. [11] R. Le, A. Kramer. “Estimation of B for adaptive frequency BIAS setting in Load Frequency Control.” IEEE Transaction on power systems Vol. 18, No. 2, May 2003: 904 -912. [12] N, Patel. “Application of artificial intelligence for tuning the parameters of an AGC.” International Journal of Engineneering and Physical Sciences, Ene. 2007. [13] J, Játiva. “Implicaciones de la calibración del factor de frecuencia B en el desempeño del error de control de área para el control automático de la generación.” Escuela Politécnica Nacional del Ecuador, JIEE Vol. 19, 2005. Marcelo Arias Castañeda.Nació en Cuenca, Ecuador, en 1980. Recibió su título de Ingeniero Eléctrico en 2006, el de Máster en Ingeniería Eléctrica en 2008, y el de Doctor en Ciencias Técnicas en el año 2011, en el Instituto Superior Politécnico “José Antonio Echeverría” de la ciudad de La Habana, Cuba. Actualmente trabaja en la Dirección de Supervisión y Control del Consejo Nacional de Electricidad CONELEC. 270 2013 Metodología de Sintonización de Parámetros del Estabilizador del Sistema de Potencia -PSS P. Verdugo† J. Játiva‡ Centro Nacional de Control de Energía –CENACE † ‡ Escuela Politécnica Nacional –EPN Resumen— Los sistemas eléctricos de potencia son susceptibles de perder su estabilidad debido a problemas asociados con la oscilación del rotor de los generadores sincrónicos. Para amortiguar estas oscilaciones se requiere la incorporación de un dispositivo en el sistema de excitación de estas máquinas. Este dispositivo es el estabilizador de sistemas de potencia (PSS). En este trabajo se presenta un estudio del comportamiento de un sistema de prueba utilizando análisis modal. Con esta herramienta se puede llegar a conocer los modos de oscilación y su amortiguamiento así como la ubicación preliminar de un PSS en el sistema. Esta información es respaldada mediante un análisis de frecuencia en el modelo Generador – Barra Infinita efectuado en Simulink. Utilizando este modelo se logran obtener los valores de las constantes de tiempo del estabilizador que proporcionan una compensación de fase adecuada. Por otro lado, la ganancia del estabilizador se obtiene utilizando el método del lugar geométrico de las raíces. Para comprobar la efectividad de la sintonización de los parámetros del PSS, se realizan simulaciones en el dominio del tiempo con el software computacional DIgSILENT Power Factory. es que todas las máquinas sincrónicas interconectadas permanezcan en sincronismo. La habilidad que poseen las máquinas de un sistema para permanecer en sincronismo, corresponde a la estabilidad del ángulo del rotor. Esta estabilidad puede romperse a través de un desvío aperiódico del ángulo ocasionado por la falta de torque sincronizante o por problemas de inestabilidad oscilatoria que tienen su origen en la falta de torque de amortiguamiento. Los estabilizadores de sistemas de potencia son los dispositivos responsables de proporcionar una componente de torque de amortiguamiento a las máquinas con el fin de reducir las oscilaciones en el sistema causadas por pequeñas perturbaciones. El comportamiento de un sistema dinámico se puede conocer mediante el análisis del espacio de estado. Las variables de estado pueden ser cantidades físicas en un sistema, como ángulo, velocidad, voltaje, o variables matemáticas asociadas con las ecuaciones diferenciales que describen la dinámica del sistema. Con la solución de la ecuación característica de la matriz de estado, se obtienen los valores propios del sistema, los que contienen información valiosa de la estabilidad del mismo. Un valor propio viene dado por: Palabras clave— Dominio del Tiempo y Frecuencia, Estabilizadores de Sistemas de Potencia, Power Factory, Simulink, Sintonización. 1. INTRODUCCIÓN [1] La estabilidad de un sistema eléctrico de potencia se puede definir como la propiedad que le permite mantenerse en un estado de equilibrio operacional bajo condiciones normales de operación y de regresar a un estado aceptable de equilibrio tras sufrir una perturbación. Por su parte, la inestabilidad en un sistema de potencia puede manifestarse de diversas formas dependiendo de su configuración y modo de operación. Una condición necesaria para la operación del sistema La parte real del valor propio σ proporciona información acerca del amortiguamiento, mientras que la parte imaginaria ω provee la frecuencia de un modo de oscilación. Cada valor propio tiene asociado un vector propio derecho y un vector propio izquierdo. Haciendo uso de estos vectores propios de manera simultánea se obtiene la matriz de participación, que proporciona una medida de la asociación entre las variables de estado y sus modos. 271 Los modos de oscilación se diferencian de acuerdo a rangos de frecuencia. Dentro de este trabajo, se consideran los modos locales y los modos interárea. 1.1. Modos Locales Los modos locales están asociados con la oscilación de unidades en una planta de generación con respecto al resto del sistema de potencia en el rango de 1,0 Hz a 2,0 Hz. Están localizados en una planta o una parte pequeña del sistema. 1.2. Modos Interárea Los modos interárea están asociados con la oscilación de muchas máquinas en una parte del sistema contra máquinas ubicadas en otros lugares. Son causados por dos o más grupos de generadores que están interconectados por lazos débiles y oscilan a frecuencias de 1 Hz o menores. 2. MODELO GENERADOR – BARRA INFINITA Se considera la representación linealizada para pequeña señal de un sistema con una máquina, como se muestra en la Figura 1. En forma general, este modelo representa el comportamiento dinámico de un sistema, que incluye las relaciones electromecánicas entre el torque de aceleración y las desviaciones de velocidad y ángulo, el amortiguamiento de la turbina, el torque sincronizante y la dinámica de flujo del generador. [2] De este modelo, se obtiene la respuesta de frecuencia del sistema alrededor de un punto de operación. Específicamente, se requiere conocer la función de transferencia desde la entrada a la excitatriz hasta la señal del torque eléctrico. Esta función de transferencia proporciona la información acerca del retraso de fase que existe en el sistema y por ende la compensación que debe ser provista por el PSS. Para obtener las constantes “K” se requiere básicamente; los parámetros del generador, los resultados de corridas de flujos de potencia y cortocircuitos, con los que se obtiene el equivalente Thevenin del sistema para representar un generador conectado a una barra infinita a través de una línea de transmisión. El modelo simplificado se desarrolla bajo las siguientes consideraciones: El efecto de los devanados de amortiguamiento es insignificante y el efecto de saturación del hierro no es importante. Con estas premisas se procede a simplificar las ecuaciones. Se presenta un ejemplo de cálculo para la constante K1: Despreciando la recistencia de la línea de transmisión, de tiene: Para las demás expresiones se aplica un procedimiento similar y se remplazan ciertos términos a fin de que las variables de las ecuaciones puedan obtenerse fácilmente mediante una simulación del sistema de potencia. Figura 1: Modelo Generador – Barra Infinita considerando AVR y PSS de doble entrada El parámetro se refiere a la reactancia de la línea de transmisión que conecta al generador con la barra infinita. Este valor se obtiene mediante el equivalente Thevenin del sistema realizando un análisis de cortocircuitos en la barra del generador considerado. 272 esto se realiza un análisis modal utilizando el programa Power Factory de DIgSILENT, que permite conocer los valores propios de un sistema y los factores de participación de los generadores en determinado modo. Los valores propios permiten conocer los modos de oscilación presentes en el sistema y si estos modos se encuentran bien o mal amortiguados. En otras palabras, permite conocer si se requiere o no la implementación de un PSS en el sistema. Por otro lado, a través de los factores de participación se puede conocer la forma en la que se encuentran oscilando los generadores de un sistema. Adicionalmente, a través de esta información se llega a tener un indicio acerca de la ubicación de un PSS. Esta información se confirma a través de la respuesta de frecuencia de los generadores candidatos, incorporados al modelo Generador – Barra Infinita. Un buen enfoque, involucra la instalación del PSS en el generador en el que se obtiene la mayor descompensación de fase. 3. METODOLOGÍA DE SINTONIZACIÓN DEL PSS Se describe la metodología para sintonizar los parámetros del PSS que utiliza como entrada la integral de la potencia de aceleración, como se indica en la Figura 2. Esta señal se obtiene mediante el tratamiento de las señales de velocidad y potencia eléctrica. El primer paso para sintonizar los parámetros de un PSS es conocer el comportamiento de un sistema sin la presencia del estabilizador. Para Figura 2: Diagrama de bloque del estabilizador del sistema de potencia PSS2A Una vez seleccionado el generador en el que se conoce que la instalación del PSS tendrá el mayor efecto, se procede a la sintonización de parámetros. -18.68 MW -38.97 Mvar 10.86 % Carga Gen.. Load A 18.80 MW 22.00 Mvar 10.86 % 232.95 1.01 147.25 27.67 MW 1.87 Mvar 8.09 % G ~ G3 85.00 MW -11.20 Mvar 66.98 % 85.00 MW -11.20 Mvar 55.76 % Bus 3 90.00 MW 30.00 Mvar 236.04 1.03 148.56 Load B -46.48 MW -23.87 Mvar 20.36 % T1 Bus 4 -27.53 MW -17.54 Mvar 8.09 % Line 6 Line 1 100.00 MW 50.00 Mvar 14.14 1.02 5.91 237.49 1.03 153.21 Bus 9 Line 5 Bus 6 0.00 MW 0.00 M.. -85.00 MW 15.30 Mvar 55.76 % 63.96 MW -18.46 Mvar 16.18 % 21.04 MW 3.16 Mvar 7.96 % Load C -20.96 MW -24.48 Mvar 7.96 % -79.04 MW -10.52 Mvar 19.69 % 233.76 1.02 152.14 Line 2 Bus 7 Bus 2 229.68 1.00 147.84 T3 -62.47 MW -12.46 Mvar 16.18 % -81.32 MW -11.03 Mvar 20.63 % Bus 5 Line 4 Bus 8 83.45 MW -9.64 Mvar 20.63 % -163.00 MW 10.31 Mvar 79.56 % Line 3 236.09 1.03 155.26 163.00 MW 5.52 Mvar 79.56 % 163.00 MW 5.52 Mvar 84.94 % T2 18.45 1.02 10.81 ~ G G2 79.55 MW -0.67 Mvar 19.69 % 100.00 MW 35.00 Mvar DIgSILENT La Figura 3, muestra el sistema de prueba empleado para realizar la sintonización del PSS. 46.48 MW 25.36 Mvar 20.36 % Bus 1 17.16 1.04 0.00 46.48 MW 25.36 Mvar 21.39 % G ~ G1 Nodos Ramas Tensión Línea-Línea, Magnitud [kV] Potencia Activa [MW] Tensión, Magnitud [p.u.] Potencia Reactiva [Mvar] Tensión, Ángulo [deg] Nivel de Carga [%] DIgSILENT Nine-Bus System Prefault Condition PowerFactory 13.2.339 Figura 3: Sistema de prueba de nueve barras 273 Anexo: Nine_Bus 3.1. Sintonización de las Etapas de Compensación La respuesta de frecuencia del sistema en ausencia del PSS, indica cual es la compensación de fase que debe ser provista por este dispositivo. La respuesta típica de frecuencia de los bloques de compensación de un PSS se muestra en la Figura 4. La respuesta de frecuencia del PSS debe proveer una compensación de fase adecuada al sistema. Esto se logra a través del ajuste de las constantes de tiempo tomando en cuenta los conceptos de frecuencia centro y razón entre dichas constantes, ecuaciones (11) y (12). Una mala sintonización puede ocasionar una sobrecompensación en el sistema que se deriva en un problema de inestabilidad. La respuesta de frecuencia del sistema compensado debe presentar un ligero retraso de fase. Con esto, se logra que el PSS además de aportar con la componente de torque de amortiguamiento, introduzca al sistema una componente adicional de torque sincronizante. propios hacia la parte positiva del plano s, se obtiene lo que se conoce como la ganancia de inestabilidad. En un PSS con entrada de potencia, la ganancia que proporciona el máximo amortiguamiento es la octava parte del valor de esta ganancia de inestabilidad. [3] 4. SINTONIZACIÓN DE LOS PARÁMETROS DEL PSS En este apartado se expone la sintonización de los parámetros de un PSS2A para un sistema de prueba de tres generadores, aplicando la metodología descrita en 3. 4.1. Análisis del Sistema sin PSS A través del análisis modal efectuado en el sistema de prueba se obtienen los resultados de las Figuras. 5 y 6, correspondientes a los valores propios y los factores de participación respectivamente. A través de esta información se observa que el valor propio 16 y su conjugado, el valor propio 17, tienen una frecuencia de oscilación de 2,059 Hz y una razón de amortiguamiento de 4,93%, lo que podría considerarse como un amortiguamiento pobre. Adicionalmente, se puede observar, en base a la participación de los generadores, que el generador 1 se encuentra oscilando contra los generadores 2 y 3. Dado que los generadores 1 y 2 tienen la mayor participación en estos modos, deben ser considerados como candidatos para la instalación de un PSS. Figura 5: Valores propios del sistema de prueba Figura 4: Respuesta de frecuencia de los bloques de compensación de fase de un PSS 3.2. Sintonización de la Ganancia Para obtener la ganancia del estabilizador se utiliza el método del lugar geométrico de las raíces. Incrementando paulatinamente el valor de la ganancia, hasta evidenciar una condición de inestabilidad en el sistema en la cual se observe la migración de los valores Figura 6: Participación de los generadores en el sistema de prueba Del análisis de respuesta de frecuencia, realizado en el modelo de la Figura 7, se obtiene que el generador 2 es la mejor alternativa para colocar un PSS. 274 El diagrama de Bode se obtiene a través de un proceso de linealización en el modelo implementado en Simulink. Se puede llegar a obtener la misma información, conociendo la función de transferencia del sistema. Sin embargo, este proceso resulta mucho más complicado. La Figura 7 muestra el modelo Generador – Barra Infinita, implementado en el software. Como se puede observar, se tiene un retraso de fase de aproximadamente 55° alrededor de los 2 Hz. Con la compensación de fase provista por el PSS se obtiene la respuesta de la Figura 9. Figura 9: Respuesta de frecuencia del sistema compensado Figura 7: Modelo implementado en Simulink Para obtener los valores de las constantes “K” se utiliza una hoja de cálculo, donde se consideran los parámetros del generador, potencia suministrada, voltaje en las barras, etc. Los resultados obtenidos de estas constantes se muestran en la Tabla 1. Tabla 1: Constantes del Modelo Generador – Barra Infinita Valor K1 1,84406213 K2 0,9054827 K3 0,2214364 K4 1,34916922 K5 -0,0499917 K6 0,44910418 Una vez establecida la compensación de fase adecuada, se procede con la sintonización de la ganancia. Al incrementar este valor paulatinamente, se observa que la migración de valores propios hacia la parte positiva del plano real se consigue con una ganancia de 1,6. Entonces, la ganancia que proporciona el máximo amortiguamiento en el PSS es de 0,2. Esta condición de inestabilidad, se observa en la Figura 10. Vale indicar, que la ganancia de inestabilidad es el mínimo valor con el cual se observa valores propios con partes reales positivas. Al ingresar estas constantes en el modelo implementado en Simulink, se obtiene la respuesta de frecuencia de la Figura 8. 34.714 DIgSILENT Parámetro Las constantes de tiempo de los bloques de compensación de fase con los que se logra esa respuesta son: T1=T3=0,27 y T2=T4=0,09. Cabe mencionar que los parámetros de los filtros pueden encontrarse dentro del rango entre 1 y 20 s. Parte imaginaria [rad/s] 20.828 6.9428 -2. 57E +2 -2.06E +2 -1. 54E +2 -1.03E +2 Parte real [1/s] -5.15E +1 -6.9428 -20.828 -34.714 Valores propios estables Valores propios inestables DIgSILENT Nine-bus system Three-Cycle Fault near bus 7, disconnection of bus7-bus5 line Gráfica Valores Propios(1) G2: Mag-A-Stat Voltage Controller Figura 10: Valores propios para la ganancia de inestabilidad Ks1=1,6 Figura 8: Respuesta de frecuencia del sistema de prueba sin PSS 275 Para comprobar la efectividad de la metodología de sintonización de los parámetros del estabilizador, en la Figura 11, se presentan los valores propios del sistema en presencia del PSS. establecimiento de las señales, así como también en el sobre impulso de las mismas. Figura 11: Valores propios del sistema en presencia del PSS En base a los nuevos valores propios del sistema, se puede observar que todos los modos se encuentran bien amortiguados. Figura 13: Potencia eléctrica de los generadores tras falla trifásica Adicionalmente, se realizan simulaciones en el dominio del tiempo considerando dos escenarios, prestando especial atención al escenario que representa la estabilidad de pequeña señal. Dentro de cada simulación se presentan los valores que permiten calcular los índices de desempeño, específicamente, el tiempo de establecimiento y el sobre impulsó de las señales. 4.2. Incremento de carga Este escenario plantea una pequeña perturbación en el sistema, asociada con el incremento de carga en una de sus barras. Se puede observar en los resultados, que la instalación del PSS logra amortiguar las oscilaciones presentadas de manera efectiva. Figura 14: Potencia de salida del PSS tras incremento de carga En la Figura 14, se muestra la señal de salida del PSS conjuntamente con la señal de la potencia eléctrica del generador 2. Con esta figura se busca ilustrar el comportamiento del PSS frente a la presencia de oscilaciones y el efecto final que produce sobre las señales del sistema. 4.3. Falla Trifásica Un PSS está diseñado específicamente para corregir los problemas de inestabilidad oscilatoria en un sistema, asociados con pequeñas perturbaciones. Sin embargo, este dispositivo también logra amortiguar efectivamente las oscilaciones ocasionadas por grandes perturbaciones. Figura 12: Potencia eléctrica en las líneas de transmisión tras incremento de carga Se puede observar que al incorporar un PSS se produce una reducción considerable en el tiempo de Dado que la perturbación de falla trifásica en el sistema es mucho más considerable, de la misma manera se observan oscilaciones de mayor magnitud en las variables del sistema de potencia. 276 5. CONCLUSIONES Y RECOMENDACIONES La inestabilidad de ángulo en sistemas de potencia puede tener su origen en la falta de torque sincronizante, o en la falta de torque de amortiguamiento. La falta de torque sincronizante se puede corregir mediante la aplicación de reguladores automáticos de voltaje. Sin embargo, estos dispositivos son los causantes de la falta de torque de amortiguamiento. Los valores propios de un sistema permiten conocer los modos de oscilación existentes en el mismo y si estos modos están o no bien amortiguados. La ubicación óptima del PSS se determina mediante el análisis conjunto de los factores de participación de los generadores del sistema y la respuesta de frecuencia en el modelo Generador – Barra Infinita. Figura 15: Potencia eléctrica en las líneas de transmisión tras falla trifásica Con el modelo Generador - Barra Infinita resulta evidente que sólo se realiza la sintonización del PSS para un modo de oscilación local. Esto se debe a que de por sí, el modelo considera solamente un generador y una barra infinita, es decir, un generador oscilando contra el resto del sistema. Los modos de oscilación en un sistema de potencia pueden constituir un problema al tener un pobre amortiguamiento, lo que se traduce en un tiempo de decaimiento muy grande. REFERENCIAS BIBLIOGRÁFICAS [1] KUNDUR Prabha, Power System Stability and Control, McGraw – Hil, 1994. Figura 16: Potencia eléctrica de los generadores tras falla trifásica De manera análoga, en la Figura 17, se muestra la señal de salida del PSS. Se puede apreciar un pequeño corte en la señal. Esto se debe a los limitadores del estabilizador, que evitan excursiones indeseables de voltaje. [2] MURDOCH A., VENKATARAMAN S., LAWSON R.A., PEARSON W.R., Integral of Accelerating Power Type PSS, Part 1 & 2, IEEE Transactions on Energy Conversion, 1999. [3] BIKASH Pal, BALARKO Chaudhuri, Robust Control in Power Systems, Springer, 2005. [4] KUNDUR P., KLEIN M., ROGERS G.J., Application of Power System Stabilizers for Enhancement of Overall Systems, IEEE Transactions, 1999. [5] TANG Bixiang, Parameter Tuning and Experimental Results of Power System Stabilizer, Tesis de Maestría, 2011. [6] IEEE COMMITTEE REPORT, Excitation System Models for Power System Stability Studies, IEEE Figura 17: Potencia de salida del PSS tras falla trifásica 277 Transactions on Power Apparatus and Systems, 1981. [7] BÉRUBÉ G.R., HAJAGOS L.M., Accelerating - Power Based Power System Stabilizers, 2007. [8] PADIYAR K.R., Power System Dynamics Stability and Control, BS Publications, 2008. [9] ANDERSON P.M., FOUAD A.A., Power System Control and Stability, IEEE PRESS, 2003. Pablo Verdugo Rivadeneira.- Nació en la ciudad de Quito en 1987. Realizó sus estudios secundarios en el Colegio Nacional Experimental Juan Pío Montufar y sus estudios superiores en la Escuela Politécnica Nacional, donde se gradúo de Ingeniero Eléctrico en el año 2012. Actualmente trabaja en la Dirección de Planeamiento del Centro Nacional de Control de Energía. Jesús Játiva Ibarra.- Realizó sus estudios superiores en la Escuela Politécnica Nacional de Quito, donde se graduó de Ingeniero Eléctrico, en 1981. Realizó estudios de postgrado en la Universidad de Texas en Arlington de Estados de Unidos de América, donde obtuvo el grado de Master of Science in Electrical Engineering en 1988, y posteriormente el título de Doctor of Philosophy en 1991. Cuenta con más de treinta años de experiencia en actividades de Planificación, Operación, Administración y Economía de sistemas eléctricos de potencia. Actualmente es Profesor Principal de la Escuela Politécnica Nacional. 278 2013 Desarrollo de un Convertidor Electrónico Multinivel para Aplicaciones de Compensación de Potencia Reactiva J.C. Viola † † F. Quizhpi ‡ Dpto. Electrónica y Circuitos, Universidad Simón Bolívar, Caracas, Venezuela. Investigador ‡ Proyecto Prometeo, Universidad Politécnica Salesiana, Cuenca, Ecuador. Resumen— El trabajo presenta el proceso completo de diseño y construcción de un convertidor electrónico de potencia de 9 niveles en configuración cascada, destinado para su uso como compensador estático de potencia reactiva en instalaciones industriales trifásicas. El trabajo abarca el dimensionamiento y montaje de la etapa de potencia compuesta por 24 módulos de transistores bipolares de compuerta aislada (IGBTs) de 150A y 1 200V cada uno y por 3 disipadores de aluminio, como así también todo el diseño y desarrollo de las tarjetas de adquisición, disparo y control necesarias para manejar el convertidor a lazo cerrado. Las tarjetas de adquisición se diseñaron utilizando sensores de efecto Hall para tensión y corriente y transmisión de datos por fibra óptica para asegurar aislación entre la tarjeta de control y la etapa de potencia. Para el control del convertidor de diseñó una tarjeta basada en un arreglo de lógica programable (FPGA) interconectada con un procesador digital de señales (DSP) que permite la alta velocidad de procesamiento requerida para probar distintas técnicas de control. El convertidor es controlado por modulación de ancho de pulso (PWM) conmutando a una frecuencia de 10kHz y pudiendo ser conectado a tensiones de hasta 3kV. Palabras clave— Convertidor multinivel, compensación de potencia reactiva, modulación de ancho de pulso. 1. INTRODUCCIÓN Existen numerosas aplicaciones en las que se utilizan los convertidores electrónicos como compensadores de factor de potencia, siendo las primeras propuestas en las décadas del 50 y 60. Estas utilizaban el rectificador controlado de silicio (SCR) como elemento para conmutar condensadores o inductores, en paralelo o en serie con la carga y lograr mejoras en el factor de potencia global de una línea [1][2]. Con la aparición de los transistores de potencia los cuales podían ser conmutados a mayores frecuencias aparecen las aplicaciones que hacen uso de la modulación de ancho de pulso (PWM) permitiendo una variedad mucho mayor de técnicas de control y la posibilidad de lograr ajustes mucho más precisos en el factor de potencia. Los primeros transistores en ser utilizados en la década del 60 y 70 son los bipolares (BJT), siendo lentamente desplazados a partir de los 80 y 90 primeramente por los transistores de efecto de campo (MOSFET) y posteriormente y hasta la actualidad por los bipolares de compuerta aislada (IGBT). Los IGBT comerciales de hoy en día soportan tensiones de operación entre los 100V y los 1700V, siendo la versión comercial más difundida la que opera a 1 200V. En cuanto a su capacidad para manejo de corriente oscilan entre 40A y más de 600A. Para aplicaciones en las que el convertidor electrónico opere conectado a tensiones de línea relativamente bajas (i.e. 110V, 220V) se emplean configuraciones denominadas de 2 niveles, con solo 2 IGBT por cada fase que se desea compensar. Para aquellas aplicaciones de corrección de factor de potencia donde el convertidor electrónico compuesto por IGBT deba conectarse a tensiones de línea que superen las tensiones de operación de éstos, deben utilizarse configuraciones multinivel las cuales consisten en agrupaciones seriales de módulos IGBT de manera de que logren soportar la tensión total de trabajo que impone la línea en particular [3]. Existen numerosas topologías multinivel propuestas entre las que se cuentan la de acoplamiento de diodo, la de acoplamiento de condensador, celdas en cascada, etc. En particular la topología en cascada resulta más atractiva porque permite ser escalada fácilmente a configuraciones con más niveles y porque utiliza un mismo tipo de componente electrónico [3][4]. La utilización de configuraciones multinivel trae acarreada una ventaja adicional que es la mayor cantidad de estados de conmutación disponibles, lo que permite una mejora en el control general del sistema, logrando mejores compensaciones de factor de potencia que las obtenidas con convertidores de IGBT de solo 2 niveles. 279 Dada la mayor cantidad de niveles disponibles puede, inclusive, obviarse la necesidad de realizar modulación por ancho de pulso, obteniéndose igualmente buenos resultados y disminuyendo los requerimientos de hardware de la tarjeta de control. Las configuraciones multinivel tienen como contra, sin embargo, de que se requiere sensar una cantidad de variables de corriente y tensión mayor que las requeridas en una configuración de 2 niveles, aunque con métodos de estimación puede obviarse la medición de algunas variables y utilizar sus valores estimados. 2.1. Etapa de potencia Como tendencia general en el control de convertidores multinivel se observa entonces la necesidad de tarjetas de adquisición con más canales y tarjetas de control con procesadores digitales de señal (DSP) que tienen una mayor capacidad de procesamiento de los datos adquiridos para entonces calcular la acción de control correspondiente [4]. En el presente trabajo se presentan los pasos para el diseño de un convertidor electrónico trifásico multinivel con capacidad de ser conectado a tensiones de hasta 1 200V, manejando corrientes de hasta 150A, con un manejo total de potencia de 10kW. En la Figura 1 se muestra el diagrama de bloques que resume las distintas etapas que componen al convertidor. Cada uno de estos bloques fue diseñado íntegramente en Ecuador demostrando que es viable desarrollar este tipo de tecnologías y que el camino queda abierto para futuros emprendimientos que deseen ahondar en el tema. La configuración en cascada elegida se muestra en la Figura 2, donde solo se muestra una rama de las 3 que componen al convertidor. En este caso se decidió construir una configuración de 9 niveles que permite fácilmente ser escalada a un número mayor de niveles simplemente agregando más puentes H en cascada. El número de niveles escogido está de acuerdo a los estándares usados en la industria actualmente [4]. El presente trabajo se divide de la siguiente manera: en la sección 2 se muestra la metodología de diseño utilizada para dimensionar las distintas partes que componen al convertidor multinivel, incluyendo el modelado tridimensional de las partes mecánicas más importantes y el diseño circuital de las tarjetas de circuitos. En la sección 3 se presenta el ensamblaje de las distintas partes del convertidor y se presenta el producto terminado. La sección 4 desarrolla los trabajos futuros que se pretenden llevar a cabo con el convertidor, fundamentalmente en el área de la compensación de energía reactiva y el control de máquinas eléctricas. Finalmente la sección 5 presenta las conclusiones y recomendaciones de los autores. 2. METODOLOGÍA DE DISEÑO De las distintas topologías reportadas para convertidores multinivel la configuración de puentes H en cascada es la que ofrece mayor escalabilidad y puede ser construida con un mismo tipo de dispositivo de potencia. Otras topologías como la de acoplamiento por diodo o acoplamiento por condensador son preferibles para configuraciones de pocos niveles (3 a 5), pero para mayor cantidad de niveles se vuelven más complejas y más caras de construir [4][5]. Figura 1: Diagramación de bloques de convertidor multinivel A cada puente H se le denomina también celda y como se observa cada celda posee un condensador asociado que actúa como reserva local de energía. Dependiendo del tipo de aplicación para la que se utilice el convertidor el valor de la capacitancia puede variar, en este caso se optó por un condensador electrolítico de 2 200uF x 450V, el cual es un estándar industrial que se caracteriza por su relativo bajo costo. Basándonos en el diagrama de la Figura 1 puede observarse que el funcionamiento de todo el sistema gira en torno a la etapa de potencia y se comenzó, en consecuencia, primeramente por el diseño de ésta, realizándose posteriormente el diseño de las tarjetas de sensores, drivers y control. 280 1 700V, son al día de hoy poco usados debido a su precio, quedando restringido su uso a aplicaciones muy específicas. La Figura 3(b) muestra una vista del modelo tridimensional realizado para el módulo IGBT en base a las dimensiones físicas dadas por el fabricante. (a) (b) Figura 3: (a) Modelo mecánico del condensador E36D451HPN222MCE3M. (b) Modelo mecánico del módulo IGBT SKM150GB12T4-SEKG. Figura 2: Circuito esquemático de una de las ramas del convertidor El modelo elegido es el E36D451HPN222MCE3M del fabricante United Chemi-Con [6] y en base a las especificaciones de la hoja de datos dada por el fabricante se realizó el modelado tridimensional de este componente el cual se muestra en la Figura 3(a). Los conmutadores elegidos son módulos dobles de IGBT, los cuales tiene la ventaja de ser más fáciles de encender y apagar en comparación a otros dispositivos como BJT o SCR. Los módulos elegidos fueron los SKM150GB12T4-SEKG del fabricante Semikron, teniendo como características principales las de soportar una tensión de bloqueo de 1 200V y una corriente máxima de 150A [7]. La tecnología de semiconductores para operar con estas tensiones es la más desarrollada y resulta por lo tanto la más económica. Si bien existen dispositivos IGBT de Los módulos IGBT escogidos son diseñados por el fabricante para poder ser montados mediante tornillos directamente a un disipador sin necesidad de material aislante. Se escoge por lo tanto un disipador realizado en aluminio extruido diseñado específicamente para este tipo de módulos el cual incluye las ranuras necesarias para deslizar los tornillos que harán la fijación mecánica. Estos perfiles de aluminio son fabricados por unas pocas empresas alrededor del mundo y se eligió por costo y servicio el modelo MM12878 del fabricante Alexandria Industries. Este modelo de disipador es fabricado en barras de 8 pies de longitud y se solicitaron 3 piezas cortadas de 500mm cada una, de manera de que hubiera espacio suficiente para alojar los 8 módulos de IGBT que componen cada rama. En base a las dimensiones dadas por el fabricante se realizó el modelado tridimensional del disipador una de cuyas vistas se muestra en la Figura 4. 281 Una vez determinados los componentes que iban a ser utilizados para la etapa de potencia se procedió a ensamblar todo en único modelo tridimensional de manera de descartar eventuales incompatibilidades de forma o tamaño obteniéndose el esquema que se observa en la Figura 5, donde se muestra el aspecto que tendría una de las tres ramas que componen al convertidor. La unión de los módulos se realizó con barras rígidas de manera de que sirvan de soporte mecánico a los condensadores asociados a cada bus CC. desean medir: 12 tensiones correspondientes a los 12 buses CC de las 3 ramas del convertidor, 3 tensiones alternas del sistema trifásico al cual eventualmente pueda conectarse el convertidor, 3 corrientes alternas que circulen por las ramas del convertidor y 3 corrientes alternas que circulen por alguna carga en paralelo al convertidor. Esta última condición es típica en aplicaciones en las que el convertidor se utilice como compensador paralelo de potencia reactiva. La totalidad de variables alcanza a 21, repartidas a razón de 7 por cada rama. Dado que el convertidor puede ser extendido con relativa facilidad a una versión de 11 niveles agregando una celda más a cada rama se decidió contemplar esta eventual expansión a futuro y se decidió diseñar la tarjeta de sensores considerando 8 variables a ser medidas por cada rama. Como las variables a ser medidas son tensiones y corrientes relativamente altas se debe asegurar una aislación total entre el circuito de medición y el resto del sistema. Para atender este requerimiento se incluyeron 2 niveles de seguridad en el diseño de la tarjeta realizando el sensado de las variables mediante sensores de efecto Hall y transmitiendo los datos digitales convertidos mediante fibra óptica, evitando en todo momento conexiones galvánicas entre la tarjeta y la etapa de potencia y entre la tarjeta y el resto de los bloques que componen el sistema. Además de ésto el diseño incluyó un convertidor analógico-digital de 8 canales con una resolución de 14 bits. Todo el diseño circuital fue realizado mediante el software Altium y en la Figura 6 se muestra el aspecto de la tarjeta antes de ser enviada para su manufacturación. Figura 4: Modelo mecánico del disparador MM12878 Figura 5: Modelado de una rama del convertidor multinivel Figura 6: Vista del diseño de la tarjeta de sensores 2.2. Tarjeta de sensores Las tarjetas de sensores están a cargo de la medición y conversión analógica a digital de las variables de tensión y corriente eléctrica. Para computar la cantidad de canales de medición y conversión que se requieren se tomaron en cuenta las siguientes variables que se 2.3. Tarjeta de drivers Las tarjetas de drivers tienen 2 funciones principales: aislar galvánicamente los circuitos de control de la etapa de potencia y amplificar los pulsos enviados por la etapa de control para 282 que tengan la suficiente intensidad para poder encender y apagar los IGBT. Tomando en cuenta estas consideraciones se diseñaron estas utilizando convertidores CC-CC aislados, asegurando tensiones de aislación de hasta 3 000V entre la etapa de potencia y la etapa de control. Para el manejo de los pulsos de disparo se utilizó el driver HCPL-316J del fabricante Agilent, especialmente diseñado para módulos de IGBT tales como los utilizados en este desarrollo. Cada tarjeta de drivers se diseñó con 4 canales independientes de manera de que cada una maneje una celda completa, requiriéndose 4 tarjetas por cada rama del convertidor. Igualmente al caso de la tarjeta de sensores el diseño se realizó con Altium y el modelado obtenido previo a su manufacturación se muestra en la Figura 7. La otra importante tarea que realiza la FPGA es la conversión serial a paralelo de los datos que llegan desde las tarjetas de sensores a través de las fibras ópticas. Dado que nuevamente esta es una tarea que consume tiempo y que debe ser realizada en simultáneo para 24 canales de datos a la vez, se la delega a la FPGA la cual entregará al procesador 24 datos de 14 bits en formato paralelo todos al mismo tiempo. En este caso el modelo elegido de 208 pines da suficiente margen para la implementación física de estas líneas, quedando incluso algunos pines libres para funciones extras que puedan requerirse a futuro. Al igual que para el resto de las tarjetas el diseño se realizó con Altium y una vista del modelo final para la tarjeta se muestra en la Figura 8. Dada la complejidad de este diseño se optó por una tarjeta de 4 capas en la que se usaron las 2 capas internas para planos de tierra y para las tensiones de 1.2V, 2.5V, 3.3V y 5V requeridas por la FPGA y sus periféricos. Figura 7: Vista del diseño de la tarjeta de drivers 2.4. Tarjeta de control La tarjeta de control tiene a su cargo la generación de los disparos para el control del convertidor. La técnica más comúnmente usada para el control de convertidores es la PWM, la cual consiste en conmutar los IGBT a una frecuencia fija pero variando el porcentaje de tiempo en que cada conmutador permanece encendido o apagado. Dado que esta es una tarea que insume mucho tiempo al procesador encargado del control, se decide delegar esta función en un FPGA el cual puede ser programado para realizar múltiples operaciones en paralelo. De los múltiples modelos de FPGA disponibles en el mercado se decide utilizar el XC3S500E-4PQ208C de Xilinx que tiene como características principales poseer 500 000 compuertas y 208 pines. Por pruebas previas hechas con tarjetas de desarrollo del fabricante Xilinx se sabe que ese número de compuertas es suficiente para alojar toda la lógica correspondiente a las 48 salidas de disparo requeridas para controlar el convertidor. Figura 8: Vista del diseño de la tarjeta de control El procesador utilizado es un ADSP-21369 del fabricante Analog Devices que tiene como características más resaltantes el de operar a 450MHz y trabajar con variables de 32 bit de tipo punto flotante. El fabricante ofrece la tarjeta de desarrollo 21369-EZ-Kit Lite [8] que incluye el ADSP-21369 y por lo tanto se diseñó la interfaz de la tarjeta de control de manera de poder acoplarla a la 21369-EZKit Lite. De esta manera el DSP puede enviar los comandos de PWM a la FPGA directamente usando los buses de dirección y datos e igualmente puede leer los datos convertidos de serie a paralelo. La acción de comando y la posterior realimentación permiten llevar a cabo controles a lazo cerrado en los cuales el DSP irá calculando en tiempo real la mejor acción a tomar siguiendo una ley de control que dependerá del algoritmo que se esté probando. 283 3. ENSAMBLAJE DEL SISTEMA Una vez terminado el diseño de las distintas tarjetas y ya elegidos los componentes que conforman la etapa de potencia se adquirieron todos los materiales y se ordenó la manufactura de las tarjetas de circuito impreso. Los componentes fueron montados localmente en los Laboratorios de la Universidad Politécnica Salesiana, con la ayuda puntual del Laboratorio de Electrónica de la Universidad Simón Bolívar de Venezuela, que prestó su apoyo gratuitamente para la soldadura de los componentes de montaje superficial. Cada tarjeta fue probada posteriormente al ensamblaje para determinar su correcto funcionamiento. En las Figs. 9(a) y 9(b) se muestran las fotografías de una de las tarjetas de sensores y una de las tarjetas de drivers ya terminadas. maximiza la transferencia de calor entre el módulo y el disipador ayudando a mantener el chip de silicio a bajas temperaturas, lo cual amplía la capacidad de manejo de potencia de todo el convertidor. Los condensadores fueron atornillados a su vez a las barras de cobre resultando el montaje final que se muestra en la Figura 10. Figura 10: Imagen de la etapa de potencia correspondiente a las 3 ramas del convertidor (a) 4. TRABAJOS FUTUROS La construcción de esta plataforma de hardware es apenas el primer paso requerido para poder desarrollar una variedad inmensa de aplicaciones industriales y académicas, las cuales requieren tener la plataforma física donde poder probarlas. Se enumeran a continuación las líneas principales de investigación que se han abierto y que se deben mantener en el tiempo, a partir del desarrollo de este equipo. 4.1. Compensación de potencia reactiva (b) Figura 9: (a) Tarjeta de sensores. (b) Tarjeta de drivers Para el montaje de la etapa de potencia se requirió fabricar previamente las barras de cobre que unen los módulos y los condensadores. Este proceso se realizó enteramente en los Laboratorios de Mecánica de la UPS. Se agregó pasta térmica a la parte posterior de cada módulo IGBT antes de fijarlos al disipador mediante tornillos y tuercas. El uso de la pasta La topología del convertidor desarrollado permite básicamente dos configuraciones posibles en las que puede operar como compensador de potencia reactiva: en paralelo y en serie. Para cualquiera de ellas el desafío consiste en controlar la etapa de potencia de acuerdo a distintos criterios para que la acción del convertidor logre eliminar los componentes reactivos de corriente que alguna carga no lineal impone a la línea. Los métodos de control 284 más utilizados son el control directo de potencia y el control directo de corriente, teniendo cada uno de éstos numerosas variantes las cuales requieren ser analizadas para determinar cual resulta más apropiada para cada caso de compensación en particular. 4.2. Control de máquinas eléctricas En este caso el convertidor se utiliza en configuración inversor en la cual cada bus CC es alimentado mediante una fuente externa y a partir de la cual se obtiene un sistema trifásico de tensiones con amplitud y frecuencia variable. Esta configuración permite controlar distintos los tipos de máquinas más comunes en el ambiente industrial y de laboratorio tales como máquinas de inducción, máquinas sincrónicas, máquinas de continua, etc. Igualmente al caso de las aplicaciones de control de potencia reactiva la plataforma es suficientemente flexible para aceptar cualquier algoritmo de control que el usuario desee programar. AGRADECIMIENTOS Los autores desean agradecer a la Universidad Politécnica Salesiana y al Proyecto Prometeo – SENESCYT por el apoyo económico e institucional brindado al proyecto. Adicionalmente desean agradecer a los estudiantes de Ingeniería Electrónica de la Universidad Politécnica Salesiana Sede Cuenca: Danny Peñafiel, Paul Ramón, Tatiana Suquilanda y Marlon Idrovo, quienes han colaborado en el marco de sus proyectos de tesis con actividades complementarias a este proyecto. REFERENCIAS BIBLIOGRÁFICAS 5. CONCLUSIONES Y RECOMENDACIONES El trabajo presenta los pasos seguidos para el desarrollo íntegro de un convertidor electrónico multinivel incluyendo la etapa de potencia y todo el hardware necesario para su control. Puede afirmarse con total certeza que es el primer trabajo de esta magnitud que se emprende en el Ecuador lográndose obtener un producto cuya operación aún debe ser probada pero que lo colocan por características de diseño a la altura de productos comerciales fabricados por las empresas líderes en el área. La plataforma desarrollada tiene además una ventaja fundamental sobre versiones comerciales y es que otorga total libertad al usuario para programar los algoritmos de control que desee probar, ya que el código utilizado para programar el DSP lo define el usuario y de ahí la posibilidad de probar técnicas novedosas y no reportadas al día de hoy. Esto contrasta con el caso de convertidores comerciales en los que solo pueden probarse aquellos algoritmos previamente programados por el fabricante, dejando muy pocas opciones para probar nuevas técnicas. En conclusión la disponibilidad de esta plataforma abre la puerta a numerosas investigaciones las cuales deben ser llevadas adelante en forma de tesis de pregrado y postgrado. Los autores consideran que la mayoría de los estudios que se realicen sobre estos temas son factibles de ser publicados en forma de artículos científicos dada la gran actualidad que poseen estos tópicos hoy en día en el área de la electrónica de potencia. 285 [1] Garcia O., Cobos J.A., Prieto R., Alou P. & Uceda J. (2001). “Power factor correction: a survey”, IEEE 32nd Annual Power Electronics Specialists Conference, PESC. 2001, vol. 1, pp. 8-13, USA. [2] Dixon J., Moran L., Rodriguez J. & Domke R. (2005). “Reactive Power Compensation Technologies: State-of-the-Art Review”, Proceedings of the IEEE, vol. 93, no. 12, pp. 2144-2164. [3] Abu-Rub H., Holtz J., Rodriguez J. & Ge B. (2010). “Medium-Voltage Multilevel Converters—State of the Art, Challenges, and Requirements in Industrial Applications”, Industrial Electronics, IEEE Transactions on, vol. 57, no. 8, pp. 2581-2596. [4] Malinowski M., Gopakumar K., Rodriguez J. & Ṕrez M.A. (2010). “A Survey on Cascaded Multilevel Inverters,” Industrial Electronics, IEEE Transactions on , vol. 57, no. 7, pp. 21972206. [5] Rodriguez J., Jih-Sheng L. & Fang Zheng P. (2002). “Multilevel inverters: a survey of topologies, controls, and applications”, Industrial Electronics, IEEE Transactions on , vol. 49, no. 4, pp. 724-738. [6] United Chemi-Con Condensadores Electrolíticos Serie E36D. Disponible (online) en: http://www.chemi-con.com/components/ com_lcatalog/uploaded/1/0/7/19624344024f6 74edd8e175.pdf [6] Semikron Fast IGBT Semitrans Modules Disponible (online) en: http://www. semikron.com/products/data/cur/assets/ SKM150GB12T4_22892040.pdf [7] Analog Devices Inc. Digital Signal Processors Disponible (online) en: http://www.analog. com/en/processors-dsp/sharc/ADSP-21369/ products/21369-EZLITE/eb Julio César Viola.- Nació en La Paz (ER), Argentina, en 1975. Está afiliado desde el año 2002 al Departamento de Electrónica y Circuitos de la Universidad Simón Bolívar en Caracas, Venezuela, siendo profesor asociado desde el año 2008. Obtuvo el título de Ingeniero Electrónico en el año 2000 en la Universidad Tecnológica Nacional, Paraná (ER), Argentina, y el título de Doctor en Ingeniería en el año 2008 en la Universidad Simón Bolívar, Caracas, Venezuela. Durante todo el año 2012 ha estado en la Universidad Politécnica Salesiana como Investigador Invitado del Proyecto Prometeo – SENESCYT. Sus intereses en investigación se centran en la electrónica de potencia para el control de máquinas eléctricas y compensación de energía reactiva, controles neuronales y difusos y energías alternativas, áreas en las cuales posee más de 20 artículos científicos arbitrados. Flavio Alfredo Quizhpi Palomeque.- Nació en Cuenca, Ecuador, en 1969. Recibió el Título de Ingeniero Electrónico en la Universidad Politécnica Salesiana en el 2003, Licenciado en Ciencias de la Educación en la Universidad Politécnica Salesiana en el 1999, Especialista en Educación Superior en la Universidad del Azuay en el 2002. Actualmente cursando el programa Doctoral en Ingeniería Eléctrica en la Universidad Simón Bolívar de Venezuela. Dedicado al área de investigación de los Sistemas Eléctricos de Potencia, Confiabilidad, FACTs e Inversores Multinivel. 286 INFORMACIÓN PARA LOS AUTORES REQUERIMIENTOS PREPARACIÓN Y RECEPCIÓN DE TRABAJOS TÉCNICOS Los Autores deben presentar el resumen del artículo (máximo 200 palabras) en formato preestablecido, incluyendo los propósitos del estudio o investigación, procedimientos básicos, las contribuciones y las conclusiones principales. Además, deben incluir el nombre de cada Autor, la dirección del trabajo, la dirección del domicilio, los números de teléfonos y el correo electrónico. Los Artículos serán preparados por los Autores de acuerdo con la “Guía para la Preparación y Envío de Trabajos Técnicos”, la misma que estará accesible en la INFONET del CENACE y en la sección Publicaciones del Portal del CENACE www.cenace.org.ec. Los Artículos serán considerados por el Grupo Técnico de Evaluación de Trabajos y sus sugerencias y recomendaciones serán atendidas por los Autores. Los Autores deben adjuntar una certificación de que su trabajo presentado es original e inédito. En caso de ser aceptado para la publicación, los editores se reservan los derechos de copia del Trabajo Técnico, a fin de facilitar la distribución del material impreso; la edición se cierra con los Artículos presentados hasta la fecha establecida. El Resumen y el Artículo Técnico se enviarán a [email protected] Una vez que los Trabajos Técnicos sean aprobados se publicarán en su totalidad en la Revista Técnica “energía” de la Corporación CENACE y serán expuestos por sus Autores en la CONFERENCIA – Ecuador, en la fecha programada para el desarrollo de este Evento. TÍTULO AUTOR GESTIÓN EMPRESARIAL EVOLUCIÓN DEL CENTRO DE OPERACIONES - UNA PROPUESTA DE ESQUEMA A LAS NUEVAS TENDENCIAS Y DESAFÍOS EN ECUADOR.......................................................................................... RESPONSABILIDAD SOCIO - AMBIENTAL EN PROYECTOS HIDROELÉCTRICOS:EL CASO RÍO ZAMORA – SANTIAGO............................................................................................................................ ARTÍCULOS PREMIADOS EDICIONES ANTERIORES 2008 - PRONÓSTICO DE DEMANDA PARA SISTEMAS DE SUMINISTRO DE ENERGÍA ELÉCTRICA UTILIZANDO ALGORITMOS EVOLUTIVOS Y RAZONAMIENTO INDUCTIVO FUZZY – DESARROLLO DE LA PLATAFORMA GRÁFICA MERLYN……………………………………….............. 2009 - PAGO DE POTENCIA A TRAVÉS DE OPCIONES - PERSPECTIVAS DE APLICACIÓN AL MERCADO ELÉCTRICO DEL ECUADOR…........................................................................................... 2010 - UNIDADES DE MEDICIÓN FASORIAL – PMU............................................................................... 2011 - CAMBIO DE PARADIGMA EN EL PRONÓSTICO DEL RECURSO HIDROLÓGICO – INFLUENCIA DEL CAMBIO CLIMÁTICO…………………………………………....................................... 2012 - PROCEDIMIENTO PARA EL CONTROL AUTOMÁTICO DE LA FRECUENCIA EN EL SISTEMA NACIONAL INTERCONECTADO DEL ECUADOR………………………………………………………….. 2013 – METODOLOGÍA DE SINTONIZACIÓN DE PARÁMETROS DEL ESTABILIZADOR DEL SISTEMA DE POTENCIA – PSS…………………………………………………………………................... 2013 – DESARROLLO DE UN CONVERTIDOR ELECTRÓNICO MULTINIVEL PARA APLICACIONES DE COMPENSACIÓN DE POTENCIA REACTIVA……………………………………............................... Pág. Ing. Roberto Barba 215 Ing. Pablo Martínez – Ing. Juan Espinoza – Dr. Luis Ochoa 221 Ing. Víctor Hinojosa – Wladimir Llanos 230 Ing. José Oscullo Ing. Gustavo Araque - Ing. Roberto Barba 239 Ing. Paúl Vásquez e Ing. Pablo Guzmán 254 Dr. Marcelo Arias 260 Ing. Pablo Verdugo – Dr. Jesús Játiva 271 Ing. Julio Viola – Ing. Flavio Quizhpi 279 CENTRO NACIONAL DE CONTROL DE ENERGÍA Panamericana Sur Km 0 y Av. Atacazo Teléfonos: (593 2) 299 2001 / 299 2030 • Fax: (593 2) 299 2031 www.cenace.org.ec Quito-Ecuador 247