cuadernos - Jean-Pierre Quadrat

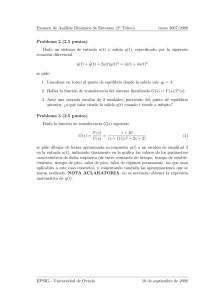

Anuncio