automatización en labores de clasificación

Anuncio

UNIVERSIDAD POLITÉCNICA DE MADRID

ESCUELA TÉCNICA SUPERIOR DE INGENIERÍA Y DISEÑO INDUSTRIAL

DEPARTAMENTO DE ELECTRÓNICA, AUTOMÁTICA E INFORMÁTICA

INDUSTRIAL

AUTOMATIZACIÓN EN LABORES DE CLASIFICACIÓN

APLICACIÓN DE LOS CLASIFICADORES EN LA AYUDA AL

DIAGNÓSTICO EN EL AMBIENTE SANITARIO

TRABAJO FIN DE MÁSTER

MÁSTER UNIVERSITARIO EN INGENIERÍA ELECTROMECÁNICA

Itinerario Profesional: Mecatrónica

Autor: Marcelo Vicente Toapanta Defaz

Tutor: Dr. Roberto González Herránz

Madrid, Junio 2014

DEDICATORIA

A mis padres….

A mis hermanas….

A mi país…

A los que han creído en mí….

“Nadie nunca logró nada espléndido fuera de quienes se atrevieron a creer

que algo dentro de ellos era superior a las circunstancias.”

Bruce Barton

i

AGRADECIMIENTOS

Gracias Dios por enseñarme el camino de la vida, la sabiduría y la felicidad, sin ti no

podría llegar a ningún lado.

Quiero agradecer profundamente a mi tutor D. Roberto González Herránz por su acertada

dirección, por compartir sus conocimientos, alentarme en cada fase de la investigación y hacer

posible este sueño.

Hacer extensivo este agradecimiento a todos los profesores y compañeros de la

Universidad que de una u otra manera me facilitaron sus conocimientos, apoyo y amistad.

Agradecer al SENESCYT, al IECE y al Gobierno actual de mi país, por poner la esperanza

en la juventud y por tener la convicción que la riqueza de una sociedad se basa en la fuente

inagotable del conocimiento, la creatividad y la innovación del ser humano.

Si luchas por algo increíble, no será fácil.

Si luchas por algo fácil, nunca será increíble.

Anónimo

ii

ÍNDICE GENERAL

DEDICATORIA

i

AGRADECIMIENTOS

ii

ABREVIATURAS

vii

RESUMEN

1

INTRODUCCIÓN

3

OBJETIVOS

9

CAPÍTULO 1

1. ESTADO DEL ARTE

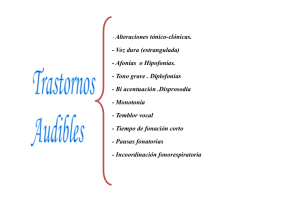

1.1. Trastornos del movimiento

1.2. El Temblor Humano

1.3. Clasificación del Temblor

1.3.1. Temblor Fisiológico

1.3.2. Temblor Esencial TE

1.3.3. Enfermedad de Parkinson EP

1.3.4. Otros Tipos de Temblor

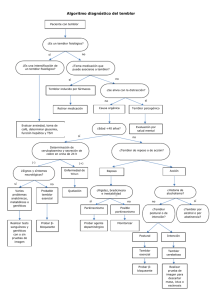

1.4. Diagnóstico del Temblor

1.4.1. Estudios Epidemiológico, Prevalencia e Incidencia, de TE y EP

1.4.2. Estudios Genéticos

1.4.3. Estudios Clínicos

1.4.4. Estudios de Neuroimagen

1.5. Líneas de Investigación de Patología del Temblor

1.5.1.Métodos para Medir y Registrar el Temblor

1.5.1.1. Acelerómetros y Giroscopios

1.5.1.2. Electromiografía (EMG)

1.5.1.3. Tabletas Digitalizadoras - Espirografía

1.5.2. Métodos para el Análisis del Temblor

1.6. Anteriores Investigaciones para la Ayuda al Diagnóstico de Pacientes con Trastorno

del Movimiento

1.6.1. Primer Estudio

iii

11

12

14

17

20

21

22

23

25

26

28

29

30

31

32

33

35

36

38

42

42

1.6.2. Segundo Estudio

1.6.3. Tercer Estudio

1.6.4. Cuarto Estudio

43

45

46

CAPÍTULO 2

2. MÁQUINA DE SOPORTE VECTORIAL - CLASIFICACIÓN

2.1. Generalidades de las Máquinas de Soporte Vectorial SVM

2.2. El Aprendizaje Automático

2.3. Modelo de una Máquina de Aprendizaje

2.4. Problema de Minimización del Riesgo

2.5. Principio Inductivo de Minimización del Riesgo Empírico ERM

2.6. La Dimensión de Vapnik-Chervonenkis CV

2.7. Principio Inductivo de minimización del Riesgo Estructural SRM

2.8. Generalidades de la Clasificación de Patrones

2.9. Clasificación de Patrones con Máquinas de Soporte Vectorial

2.9.1. Hiperplanos como Superficie de Decisión

2.9.2. Distancia de un Hiperplano al Origen

2.9.3. Margen Máximo de un Hiperplano

2.10. SVMs Lineales

2.10.1. SVM Lineal de Margen Rígido para Datos Linealmente Separables

2.10.1.1. Formulación Primal

2.10.1.2. Formulación Dual

2.10.1.3. Vectores Soporte

2.10.1.4. Hiperplano de Separación Óptimo

2.10.1.5. Clasificación de Nuevos Datos

2.10.2. SVM Lineal de Margen Flexible para Datos Linealmente No Separables

2.10.2.1. Parámetro C

2.10.2.2. Formulación Primal

2.10.2.3. Formación Dual

2.11. SVMs No Lineales

2.11.1. Mapeo de los Datos de Entrada al Espacio de Características

2.11.2. Funciones Kernel para SVM

2.11.3. SVM No Lineales de Margen Rígido

2.11.4. SVM No Lineales de Margen Flexible

2.12. Algoritmo de la SVM

2.13. Ejemplo de Aplicación de las SVMs

49

49

51

53

59

60

64

68

72

75

77

81

82

84

85

85

86

89

90

91

92

96

97

98

101

103

106

108

109

110

111

CAPÍTULO 3

3. TÉCNICAS Y HERRAMIENTAS UTILIZADAS

3.1. Librería LIBSVM

3.2. Funciones de Matlab

117

117

122

iv

INTRODUCCIÓN

3.2.1.

3.2.2.

3.2.3.

3.2.4.

3.2.5.

Toolbox de Estadística de Orden Superior HOSA

Toolbox de Procesamiento de Señales PSD

Toolbox de Estadística ACP

Coeficiente de Curtosis

Distancia de Mahalanobis

122

125

125

127

128

4. FUENTE DE LOS DATOS. PREPARACIÓN DE LAS MUESTRAS

4.1. Pruebas para Evaluar el Temblor

4.2. Obtención de Patrones

4.2.1. Patrones Estáticos

4.2.2. Patrones Cinéticos

4.2.3. Patrones dinámicos

4.3. Filtrado y Caracterización del Temblor

4.3.1. Filtrado del temblor

4.3.2. Caracterización del temblor

4.4. Normalizado y Estandarizado de los Datos

4.5. Selección del Modelo de SVM

4.5.1. Selección de la Función Kernel

4.5.2. Selección de Parámetros. Validación Cruzada-Malla de Búsqueda

129

129

132

132

133

136

136

138

139

141

142

142

143

CAPÍTULO 4

CAPÍTULO 5

5. ESTUDIO DE HIPÓTESIS Y CLASIFICACIÓN DE LAS MUESTRAS

5.1. Metodología de los Ensayos

5.1.1. Entrenamiento de la SVM con LIBSVM

5.1.1.1. Formato de la Base de Datos

5.1.1.2. Fase de Aprendizaje de la SVM

5.1.1.3. Fase de Prueba del Modelo Clasificador

5.1.1.4. Registro de los Resultados

5.2. Hipótesis 1. Análisis del Temblor Mediante Curvas de Ajuste

5.2.1. Procedimiento

5.2.2. Análisis de los Modelos del Clasificador

5.3. Hipótesis 2. Análisis de la Amplitud y Frecuencia del Temblor

5.3.1. Procedimiento

5.3.2. Análisis de los Modelos del Clasificador

5.4. Hipótesis 3. Análisis del Temblor con Técnicas de Estadística de Segundo Orden PSD

y Espectros de Orden Superior HOSA

5.4.1. Procedimiento

5.4.2. Análisis de los Modelos del Clasificador

5.5. Hipótesis 4. Análisis del Temblor con el Método de Componentes Principales ACP

5.5.1. Procedimiento

v

149

149

150

151

151

152

153

153

153

159

160

161

163

164

166

172

173

174

5.5.2. Análisis de los Modelos del Clasificador

177

CAPÍTULO 6

6. RESULTADOS DE LA INVESTIGACIÓN

6.1. Resultados. Análisis del Temblor Mediante Curvas de Ajuste

6.2. Resultados. Análisis de la Amplitud y Frecuencia del Temblor

6.3. Resultados. Análisis del Temblor con Técnicas de Estadística de Segundo Orden PSD

y Espectros de Orden Superior HOSA

6.4. Análisis del Temblor con el Método de Componentes Principales

179

181

183

CONCLUSIONES

191

FUTUROS DESARROLLOS

195

ANEXOS

197

BIBLIOGRAFÍA

199

vi

185

188

ABREVIATURAS

Análisis de Componentes Principales

Enfermedad de Parkinson

Minimización del Riesgo Empírico

Transformada Rápida de Fourier

Análisis Estadístico de Orden Superior

Hiperplano de Separación Óptimo

Inteligencia Artificial

Máquina de Aprendizaje

Perceptrón Multicapa

Programación Cuadrática

Densidad Espectral de Potencia

Teoría de Aprendizaje Estadístico

Optimización Mínima Secuencial

Minimización del Riesgo Estructural

Máquinas de Soporte Vectorial

Temblor Esencial

Temblor Fisiológico

Vectores Soporte

Dimensión de Vapnik-Chervonenkis

eest

Error de Estimación

n

h

Espacio de Entrada de n-Dimensión

H

Espacio de Hipótesis

T

yi

Espacio Objetivo

Etiqueta

LP

Formulación Primal de Lagrange

WD

(x )

Formulación Dual de Wolfe

Función Característica

fa

Función de Aproximación

Espacio de Características

Función Kernel, Función Núcleo

f0 (x) Función Objetivo

f (x ) Función Subyacente

H ( x ) Hiperplano de separación

,

N

N SV

C

Remp

Matriz Hessiana

Multiplicadores de Lagrange

Número de muestras

Número de Vectores Soporte

Parámetro de Regularización

Parámetros del vector pesos

Riesgo Empírico

R ( f ) Riesgo Esperado

h

Dimensión VC

P(x, y) Distribución de Probabilidad

Error de Aproximación

Error de Generalización

K

SIMBOLOGÍA

b

Bias, Umbral

k

Coeficiente de Curtosis

( x , y ) Dato de Entrenamiento

eapr

e gen

H

ACP

EP

ERM

FFT

HOSA

HOS

IA

MA

MLP

QP

PSD

SLT

SMO

SRM

SVM

TE

TF

VS

VC

R ( ) Riesgo Funcional

i

Variable de Holgura

w, w

Vector, muestra, ejemplo

Vector pesos

xi , x

vii

RESUMEN

INTRODUCCIÓN

El Temblor Esencial y la Enfermedad de Parkinson

son considerados dos trastornos de movimiento

diferentes, el primero asociado a un temblor

cinético/postural y el segundo a un temblor de

reposo. Sin embargo, en la literatura médica hacen

notoria la potencial relación que puede existir entre

ambas enfermedades. El hecho de que pacientes con

la EP presenten un temblor postural igual al TE, que

una enfermedad sea un factor de riesgo para el

desarrollo de la otra, que ambas enfermedades

compartan características neurodegenerativas y el

solapamiento semiológico del temblor provoca que

el diagnóstico clínico no sea fiable y surge la

necesidad de implementar métodos de Inteligencia

Artificial para analizar y cuantificar el temblor y en

base a su medida, clasificarlo. Brindando a los

médicos una herramienta práctica y eficaz, para

asegurar un tratamiento adecuada del paciente, y así

mejorar su calidad de vida.

OBJETIVO

Desarrollar una metodología que permita

automatizar la clasificación del temblor esencial y

temblor parkinsoniano, utilizando las Máquinas de

Soporte Vectorial, para el apoyo al diagnóstico

clínico garantizando al paciente una atención y

tratamientos adecuados.

METODOLOGÍA

Se parte de una base de datos conformada por las

series temporales de un conjunto de pruebas, donde

cada prueba está constituida por una serie de

patrones (formas geométricas) ejecutadas en forma

estática (manteniendo una postura), cinética

(siguiendo la trayectoria del patrón) y dinámica

(fuerzas generadas artificialmente) sobre la mano

del paciente. Los datos generados en estas pruebas

fueron registrados y almacenados por el sistema

DIMETER, que utiliza un dispositivo háptico llamado

PHAMToN para la adquisición de los datos. Para la

caracterización del temblor se utilizó el PSD y los

Poliespectros; el Análisis de Componentes

Principales disminuyó la dimensionalidad de los

vectores; la distancia de Mahalanobis y el coeficiente

de Curtosis proporcionaron el medio para la

separación de los valores atípicos. La Máquina de

Soporte Vectorial proporcionó el modelo de

clasificador utilizando los vectores característicos

previamente analizados.

RESULTADOS

Del análisis de los resultados obtenidos en las

diferentes hipótesis y ensayos, dan cuenta que las

pruebas estáticas y cinéticas son suficientes para

caracterizar el temblor y crear un clasificador SVM

con una buena capacidad de generalización,

obteniendo en la fase de clasificación un error del

0%.

PALABRAS CLAVES: Temblor Esencial, Enfermedad

de Parkinson, Temblor Fisiológico, Máquinas de

Soporte Vectorial, PSD, Poliespectro, Análisis de

Componentes Principales, Distancia de Mahalanobis,

Coeficiente de Curtosis.

1

ABSTRACT

INTRODUCTION

patterns (shapes) executed statically (maintaining a

Essential Tremor and Parkinson's disease are

considered two different movement disorders, the

first associated with a kinetic / postural tremor and

the second to a resting tremor. However, in the

medical literature makes evident the potential

relationship that may exist between the two

diseases. The fact that PD patients present a

postural tremor equal to TE, a disease is a risk factor

for the development of the other, both diseases

share

neurodegenerative

characteristics,

and

semiological overlapping of tremor causes the

clinical diagnosis is unreliable and there is a need to

implement Artificial Intelligence methods to analyze

and quantify tremor and based on its measures,

classify. Providing physicians with a practical and

effective tool to ensure appropriate patient care,

and improve their quality of life.

OBJECTIVE

To develop a methodology to automate the

stance), kinetic (following the trajectory pattern) and

dynamic (generated artificially forces) on the

patient's hand. The data generated in these tests

were recorded and stored by the DIMETER system

that uses a haptic device called PHAMToN for data

acquisition. For the characterization of the tremor

was used the PSD and higher order spectra; Principal

Component Analysis reduced the dimensionality of

the

vectors;

Mahalanobis

distance

and

the

coefficient of kurtosis provided the means for

removal of outliers. The Support Vector Machine

classifier provided the model using the feature

vector previously discussed.

RESULTS

Analysis of the results obtained in the different

hypothesis show that the static and kinetic tests are

sufficient to characterize the tremor and create a

SVM classifier with good generalization ability,

getting in qualifying an error of 0%.

classification of essential tremor and parkinsonian

KEYWORDS: Essential Tremor, Parkinson's disease,

tremor, using Support Vector Machines, to support

Physiological Tremor, Support Vector Machines, PSD,

the clinical diagnosis ensuring patient care and

Higher Order Spectra, Principal Component Analysis,

treatments.

Mahalanobis distance, Coefficient of Kurtosis.

METHODOLOGY

We assume a database consists of time series of a

set of tests, where each test consists of a series of

2

INTRODUCCIÓN

Mi motivación personal…

¿Por qué tiembla? Fue la pregunta que hice 15 años atrás a mi tía abuela Francisca, algo raro le ocurría.

No era usual ver como su mano empezó a temblar sin que hubiese voluntad de hacerlo. Las condiciones

sociales de un país como el mío nos mantenía al margen del servicio de la salud, intentamos apaciguar

aquel movimiento incontrolable con medicina ancestral, no buscamos ayuda profesional, la escasez de

los recursos económicos familiares lo impedían, pasó el tiempo y como por contagio empezó a temblar

su otra mano y luego sus piernas, pero era solo el principio. Con dificultad podía coger un cubierto, su

autoestima estaba muy afectada, ya la enfermedad no solo afectaba la parte motora sino que su parte

cognitiva también se volvió en su contra. Nuestra preocupación y amor familiar nos llevó a buscar ayuda

de un especialista, Parkinson y no hay cura, ese fue el diagnóstico. A poco tiempo el Papa Juan Pablo II

falleció y supimos que él también padeció esta enfermedad. La falta de especialización de los médicos y

la evolución singular de esta enfermedad en cada persona que la padece, hizo que cada medicamento

que ingería sea rechazado por su organismo y fue muy difícil atinar con el tratamiento adecuado. Son 2

años desde que vine a España en la búsqueda de conocimiento y fue una oportunidad coincidir con un

tema que afectaba a mí ser querido, acepté el reto y hoy soy consciente que pude haber hecho mucho y

que puedo seguir haciendo más por ella. Hoy la enfermedad está muy avanzada me dice que ha dejado

de caminar porque se cae, que le cuesta mucho extender sus piernas y sus brazos, la escucho con voz

titubeante y temblorosa y sé que le cuesta mucho coger el teléfono. Su cuerpo ha cambiado pero sus

sentimientos siguen siendo los mismos de siempre, lo último que me dijo fue "hijo, cuando vuelves,

tengo muchas ganas de verte". Solo tengo que agradecer a la vida por tenerla entre nosotros y

compartir con ella algo que no enferma, no tiembla, no daña, ni duele, el amor.

3

AUTOMATIZACIÓN EN LABORES DE CLASIFICACIÓN.

APLICACIÓN DE LOS CLASIFICADORES EN LA AYUDA AL DIAGNÓSTICO EN EL AMBIENTE SANITARIO.

Existe un gran número de enfermedades de origen neuronal que provocan Trastornos del Movimiento y

pueden desencadenar en una importante pérdida de calidad de vida de las personas. El movimiento más

efímero y simple es el resultado de complejas interacciones entre múltiples circuitos neuronales dentro

del cerebro y la médula espinal, si alguna parte del sistema nervioso se ve afectado aparecen una

variedad de trastornos del movimiento.

Según el Instituto Nacional de Trastorno Neurológicos y Accidentes Cerebrovasculares, indica que el

Temblor es el más común de los trastornos del movimiento y lo define como un movimiento

involuntario y rítmico, que implica la oscilación de una o más partes del cuerpo.

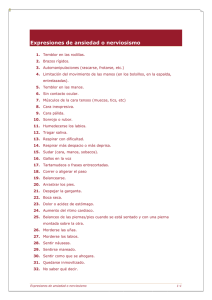

No siempre el temblor es un movimiento anormal. El potencial eléctrico generado en el cerebro por

miles de neuronas, forman ondas cerebrales con diferentes frecuencias. Las neuronas encargadas del

movimiento corporal oscilan a 10 ciclos por segundo, que es el temblor mínimo casi imperceptible que

todas las personas presentan, llamado Temblor Fisiológico. Cuando existen factores como el cansancio,

el nerviosismo, el miedo, etc., el cuerpo segrega adrenalina haciendo que el temblor incremente, pero

continua siendo un temblor normal.

Cuando existen alteraciones en el sistema nervioso y el patrón de activación muscular continuo es

reemplazado por descargas bruscas, rítmicas y breves, el temblor se vuelve anormal, es decir en un

Temblor Patológico. Existen algunos tipos de temblor considerados dentro del temblor patológico, el

Temblor Esencial y el temblor provocado por la Enfermedad de Parkinson son los más comunes dentro

de la población que comprende a las personas de mediana edad y ancianas, afectando a hombres y

mujeres en forma similar.

El incremento de la esperanza de vida experimentada especialmente por los países desarrollados, se

traduce en un problema llamado envejecimiento poblacional, la franja de población mayor a 60 años se

ve aumentada. Según la División de Población del Departamento de Asuntos Económicos y Sociales de la

Secretaría de las Naciones Unidas (2013), la población mundial mayor a 60 años en el 2013 se calculó en

841 millones, se estima que durante 2013-2050 se incremente a 2020 millones, aumentando del 12 a

21% a nivel mundial, del 23 a 34% en Europa, del 20 al 27% en Norteamérica, del 11 a 24% en Asia, del

11 al 25% en América Latina y el Caribe, del 16 al 23% en Oceanía y del 5.4 al 8.9% en África.

Al envejecer la población, trae consigo una serie de cambios en la sociedad, especialmente en la salud,

con un incremento en enfermedades crónicas y neurodegenerativas que afectan a la edad senil, como el

Alzheimer, el Parkinson y el temblor. Estas enfermedades aumentarán su prevalencia y junto a otras

4

INTRODUCCIÓN

enfermedades propias de la tercera edad sobrecargarán los sistemas de salud del mundo y el costo de

salud per cápita también se verá incrementado.

La prevalencia e incidencia de la enfermedad de Parkinson y de temblor esencial son difíciles de estimar

y varían en los diferentes estudios realizados debido a la heterogeneidad y variabilidad en la

metodología utilizada, a las muestras, a los factores genéticos y ambientales de las poblaciones

estudiadas.

Según la European Parkinson's Disease Association (EPDA), basado en un estudio de prevalencia en los 5

países más poblados de Europa Occidental y 10 países más poblados del mundo, estimó que en el 2005

el número de personas con más de 50 años de edad que padecían Parkinson fue de 4.1 a 4.6 millones y

para el 2030 se proyecta que este valor se incrementará a más del doble, entre 8.7 y 9.3 millones. La

EPDA indica también que 1,2 millones de personas en Europa padecen Parkinson, se prevé que su

incidencia se duplique para 2030

y que el coste anual por el sistema de salud europeo sea de 13.900

millones de euros.

Por otro lado, según el portal norteamericano MEDSCAPE, se estima que el temblor esencial puede ser

de 10 a 20 veces más prevalente que la enfermedad de Parkinson, entre 50-70% de los casos el temblor

esencial se estima que es de origen genético y las mutaciones genéticas en estos casos se prevé que se

transmite de forma autosómica dominante y tiene penetrancia variable. Aunque la edad de inicio de

esta enfermedad es variable la mayoría empieza en la segunda o sexta década de la vida y junto con el

envejecimiento de la población también aumentará el número de casos. En Norteamérica cerca de 5

millones de personas han sido diagnosticadas con temblor esencial, pero se estima que la cifra puede

llegar a 10 millones debido a que muchas personas no buscan atención médica si el temblor es leve o

atribuyen el temblor a la edad avanzada, o al temor de que el impacto del temblor en su calidad de vida

no va a ser tomado en serio. Circunstancias que se repiten alrededor del mundo.

Desde otro punto de vista, el espectro clínico del temblor varía ampliamente entre un fenómeno normal

hasta una forma discapacitante de enfermedades graves. La etiología es múltiple y para el diagnóstico es

necesario la exploración visual y la descripción de las características semiológicas del temblor en virtud

de múltiples criterios como: la condición que activa el temblor (en reposo, postura o movimiento), la

amplitud, la frecuencia (baja, media o alta), la topografía (extremidades, tronco, cabeza), exámenes

neurológicos e historial clínico (inicio del temblor, secuencia de inicio, comorbilidades, historia familiar,

factores que lo exacerban o lo inhiben y consumo de alcohol, medicamentos o drogas).

5

AUTOMATIZACIÓN EN LABORES DE CLASIFICACIÓN.

APLICACIÓN DE LOS CLASIFICADORES EN LA AYUDA AL DIAGNÓSTICO EN EL AMBIENTE SANITARIO.

El diagnóstico clínico del temblor basado en escalas de calificación requiere de la subjetividad y

experiencia del especialista. Puede ser suficiente, pero en muchas de las veces no es aplicable en la

práctica, debido a que existe un solapamiento en la semiología clínica entre los pacientes de temblor

esencial y el temblor parkinsoniano. Además, en algunas publicaciones dan cuenta que ambas

enfermedades podrían estar relacionadas o coexistir en un fenotipo de temblor o que una sea factor de

riesgo para el desarrollo de la otra. Es decir, un subgrupo de pacientes con Parkinson desarrollan un

temblor postural en las manos (propio del temblor esencial) por un largo tiempo antes que aparezcan

los síntomas parkinsonianos, y de la misma manera se encuentra cuerpos de Lewy en algunos pacientes

con temblor esencial cuando éstos son propios de la enfermedad de Parkinson.

Bajo estas circunstancias se requiere que el temblor no sea analizado únicamente de forma cualitativa

como lo hace un diagnóstico clínico, sino que deba ser analizado de forma cuantitativa con el fin de

comparar datos y apoyar al diagnóstico clínico. Es en este punto, donde biomecánica juega un papel

muy importante, mediante dispositivos electrónicos, herramientas y algoritmos matemáticos se

adquiere, procesa y analiza cuantitativamente el temblor.

El avance tecnológico, la gran capacidad de procesamiento y almacenamiento de la información de las

computadoras de hoy en día, junto a técnicas de Inteligencia Artificial y la teoría de toma de decisiones,

tienen la capacidad de generar y extraer el conocimientos sobre distintos problemas del entorno real a

partir del estudio exhaustivo de ciertas bases de datos, dando lugar al diagnóstico automatizado.

Luego de este preámbulo, haciendo referencia al título de esta obra "AUTOMATIZACIÓN EN LABORES DE

CLASIFICACIÓN. APLICACIÓN DE LOS CLASIFICADORES EN LA AYUDA AL DIAGNÓSTICO EN EL AMBIENTE

SANITARIO." Se inició el estudio seleccionando a las Máquinas de Soporte Vectorial (SVM) como la

estructura de aprendizaje automático para la tarea de clasificación de dos clases. Las SVMs fueron

desarrolladas por el Vladimir Vapnik y sus colaboradores en el marco de la Teoría de Aprendizaje

Estadístico (SLT) y bajo el principio de Minimización del Riesgo Estructural (SRM) y no fue hasta 1998 que

empezó a tener auge en varias aplicaciones. Las SVMs pertenecen a la familia de clasificadores lineales,

tienen un fundamento teórico-matemático muy sólido. Tienen una gran capacidad para aprender a

partir de un conjunto de datos experimentales que generalmente son tomados del entorno real y con

una distribución dispersa en un espacio de entrada de alta dimensión. Basan su aprendizaje en la

construcción de un hiperplano en un espacio de características de alta dimensión, los datos de entrada

que generalmente son no separables linealmente son mapeados mediante una función de

características llamado kernel o núcleo a un espacio de características en donde pueden ser separados

6

INTRODUCCIÓN

linealmente. La función kernel es la esencia de las SVMs, la función objetivo a optimizar es convexa lo

cual garantiza la convergencia y existencia de una única solución. La estructura del hiperplano óptimo se

construye en base a un subconjunto de datos llamados Vectores Soporte (VS); el hiperplano es la función

de separación que clasifica a los datos a sus correspondientes clases dependiendo de la etiqueta.

Posteriormente, con la base de datos de las pruebas realizadas a los pacientes con temblor esencial,

enfermedad de Parkinson y temblor fisiológico que fueron registradas y almacenada por el sistema

DIMETER, se analizaron y caracterizaron con atributos numéricos a cada una de las muestras mediante

herramientas estadísticas. Consecutivamente, se plantearon cuatro hipótesis para la clasificación, las

muestras fueron preparadas y subdivididas en los conjuntos de entrenamiento y prueba. Luego, el

conjunto de entrenamiento fue sometido a una fase de aprendizaje con el algoritmo LIBSVM y

finalmente las muestras del conjunto de prueba a la fase de clasificación.

Este trabajo está dividido en 5 capítulos, procurando abordar cada uno de los temas relevantes,

técnicas, herramientas y procedimientos utilizados durante la investigación.

El Capítulo 1 presenta una descripción de los trastornos del movimiento y trastornos del temblor. Una

revisión de las características, clasificación, etiología, semiología y efecto de los temblores más

frecuentes y motivo de este trabajo como son: el temblor fisiológico, temblor esencial y el temblor

producido por la enfermedad de Parkinson. Se aborda algunos estudios relacionados con el diagnóstico

del temblor, así como los métodos y las técnicas que hoy por hoy utilizan los investigadores para la

medición y análisis del temblor. Finalmente, se hace mención de los trabajos y los resultados obtenidos

por anteriores compañeros que me precedieron en la misma línea de investigación.

En el Capítulo 2 contiene el fundamento de las máquinas de aprendizaje automático, una explicación de

la Teoría de Aprendizaje Estadístico, el desarrollo del principio de minimización del riesgo estructural y la

dimensión VC. Un repaso a la clasificación de patrones y la tarea de clasificación. La descripción y el

fundamento teórico matemático del algoritmo de las SVMs es dado, así como la formulación de las

SVMs de margen rígido y de margen flexible para clasificadores lineales como no lineales. Por último, se

proporciona un ejemplo práctico del clasificador SVM entrenando con varias funciones kernel.

El Capítulo 3 está dedicado a recolectar todas las técnicas y las herramientas que se utilizaron para el

tratamiento de la información. Se da una explicación detallada de cada una de las funciones a utilizar

durante el entrenamiento del clasificador SVM utilizando el software proporcionado en el paquete

LIBSVM. Se describe la Toolbox de Estadística de Orden Superior HOSA y la Toolbox de Procesamiento

7

AUTOMATIZACIÓN EN LABORES DE CLASIFICACIÓN.

APLICACIÓN DE LOS CLASIFICADORES EN LA AYUDA AL DIAGNÓSTICO EN EL AMBIENTE SANITARIO.

de Señales PSD, utilizadas en MATLAB para la caracterización del temblor. Además, se detalla las

técnicas empleadas para el estudio de los datos como son el análisis de componentes principales ACP, la

distancia de Mahalanobis y el coeficiente de Curtosis.

En el Capítulo 4 se detalla el proceso de obtención y preparación de las muestras para el entrenamiento

con la SVM. Se hace una descripción del sistema DIMETER empleado para la adquisición de los datos,

registro y almacenamiento de las pruebas realizadas a los pacientes, así como las condiciones y los

patrones utilizados en la ejecución de cada una de las pruebas. Más adelante se describe el proceso de

filtrado de las señales y la caracterización del temblor mediante atributos numéricos obtenidos a partir

de las estadísticas de segundo orden PSD y las estadísticas de orden superior HOSA. También se hace

una breve referencia sobre el proceso de normalización y estandarización de los datos. Finalmente, se

marcan las pautas para la selección y ajuste de los parámetros de las funciones kernel en base al

procedimiento de validación cruzada, así también se indica el comportamiento asintótico del clasificador

SVM con un kernel Gaussiano RBF.

El Capítulo 5 está dedicado al estudio de las hipótesis planteadas, a la clasificación de las muestras y los

resultados obtenidos en cada una de las hipótesis. Se expone la metodología utilizada en los ensayos. Se

detalla cada una de las fases para el entrenamiento de la SVM. En cada una de las hipótesis se describe

su fundamento teórico, las herramientas y las técnicas matemáticas empleadas para el análisis de las

señales, el procedimiento a seguir, así como el número de muestras y atributos numéricos de cada

vector. Con el propósito de reducir al máximo el error en la clasificación se optó por probar con

diferentes configuraciones entre las pruebas estáticas, cinéticas, dinámicas o en combinación a la

entrada de la SVM. Luego se presentan en tablas los resultados obtenidos para cada modelo clasificador,

los parámetros de ajuste para cada tipo de kernel y la tasa de error cometido tanto en la fase de

entrenamiento como en la fase de clasificación. Al terminar cada hipótesis se hace un análisis de los

resultados en referencia al mejor modelo de clasificador obtenido.

Dentro del Capítulo 6 se presentan un análisis de los resultados globales y se hace una comparación

entre los resultados de las hipótesis planteadas y sobre las configuraciones realizadas con el fin de

mejorar los resultados.

Finalmente, se enuncia las conclusiones del trabajo en cada una de las hipótesis planteadas en relación a

los resultados obtenidos.

8

OBJETIVOS

Los objetivos del presente trabajo de investigación son:

OBJETIVO GENERAL

-

Automatizar la clasificación de enfermedades provenientes de trastornos del movimiento,

aplicando las Máquinas de Soporte Vectorial como técnica de Inteligencia Artificial y algoritmo

de aprendizaje supervisado, para el análisis de datos y el reconocimiento de patrones, con el fin

de apoyar la estimación cualitativa del diagnóstico clínico de los pacientes, garantizando

atención y tratamientos adecuados.

OBJETIVOS ESPECÍFICOS

-

Identificar las características clínicas, etiológicas y semiológicas que presentan los pacientes con

Temblor Fisiológico, Temblor Esencial y Temblor Parkinsoniano, así como la correlación que

puede existir entre ellos, especialmente en los dos últimos debido a que una enfermedad puede

ser factor de riesgo para el desarrollo de la otra.

-

Analizar y procesar las series temporales de la base de datos obtenidas a partir de una serie de

pruebas estáticas, cinéticas y dinámicas con diferentes patrones, realizadas por pacientes con

temblor; series temporales que fueron registradas y almacenadas por el sistema DIMETER

mediante el dispositivo háptico PHAMToN.

-

Caracterizar el temblor con atributos numéricos utilizando las series temporales, aplicando

herramientas de Estadística de segundo orden como la Densidad Espectral de Potencia,

9

AUTOMATIZACIÓN EN LABORES DE CLASIFICACIÓN.

APLICACIÓN DE LOS CLASIFICADORES EN LA AYUDA AL DIAGNÓSTICO EN EL AMBIENTE SANITARIO.

Estadística de orden superior como el Biespectro y Triespectro, y herramientas de Análisis de

Señales para el ajuste de curvas.

-

Procesar los atributos numéricos mediante el Análisis de Componentes Principales para reducir

la dimensionalidad de las variables de los vectores característicos, extrayendo la información

relevante evitando trabajar con datos redundantes, así como disminuir el gasto computacional.

-

Entrenar las Máquinas de Soporte Vectorial con la ayuda de la librería LIBSVM para obtener los

parámetros de ajuste que garanticen una tasa de mínimo error durante la fase de aprendizaje y

la fase de clasificación.

-

Obtener un modelo óptimo del clasificador de la Máquina de Soporte Vectorial de margen

flexible que proporcione la mayor exactitud en la clasificación entre las muestras del temblor

fisiológico y temblor patológico, así como en la clasificación entre las muestras del temblor

esencial y enfermedad de Parkinson. El modelo seleccionado debe cumplir el principio de

Minimización del Riesgo Estructural y dimensión VC, creando una cota superior sobre el riesgo

esperado de manera que garantice una buena capacidad de generalización.

-

Evaluar la capacidad, las ventajas e inconvenientes de las Máquinas de Soporte Vectorial para

discriminar y clasificar los diferentes tipos de temblor.

-

Por último, determinar el procedimiento, el conjunto de atributos numéricos, las pruebas o los

patrones que mejor caracterizan y diferencian a los distintos tipos de temblor, y que pueden ser

utilizados para afianzar el diagnóstico clínico para un adecuado tratamiento y correcta

medicación a los pacientes por parte de los médicos, especialmente en pacientes en una etapa

inicial de la enfermedad cuyos síntomas pueden ser confusos y acarrear a evaluaciones

erróneas.

10

CAPÍTULO 1

ESTADO DEL ARTE

El presente trabajo de investigación, se desarrolla enfocado en la ayuda al diagnóstico de patologías

provenientes de una disfunción neurológica, que altera la forma y la velocidad de los movimientos

corporales. Si un área del sistema nervioso que controla el movimiento se lesiona o tiene un

funcionamiento anormal, puede aparecer una variedad de trastornos del movimiento. El temblor, es el

trastorno de movimiento más común, entre los temblores más frecuentes y razón de este estudio está

el Temblor Fisiológico, el Temblor Esencial (TE) y el provocado por la Enfermedad de Parkinson (EP). No

existe cura para la mayoría de estos temblores y sus variantes, pero con un diagnóstico clínico adecuado

permite que un paciente reciba un tratamiento correcto, y así, mejorar su calidad y estilo de vida.

La alteración motora es la típica manifestación para el diagnóstico clínico del temblor, debido a las

numerosas causas que lo producen y a la similitud entre sus variantes, una clasificación etiológica o

fisiológica práctica del temblor no es posible. Actualmente, la clasificación del temblor se hace mediante

el diagnóstico clínico, estimación cualitativa, que consiste en datos provenientes del historial del

paciente, de los exámenes neurológicos y físicos, y de una revisión de signos y síntomas, lo cual es

suficiente pero en ocasiones es necesario el apoyo de sistemas de cuantificación que transformen la

percepción visual en datos objetivos aumentando la capacidad y precisión para clasificar un temblor

específico entre una serie de síndromes con características similares. Incluso los médicos hacen notoria

la necesidad de herramientas informáticas para apoyar y confirmar su diagnóstico.

Con el presente trabajo de investigación, se busca caracterizar a los diferentes tipos de temblor,

partiendo de una base de datos conformada por series temporales de un conjunto de pruebas, donde

cada prueba está constituida por una serie de patrones (formas geométricas) ejecutadas en forma

11

AUTOMATIZACIÓN EN LABORES DE CLASIFICACIÓN.

APLICACIÓN DE LOS CLASIFICADORES EN LA AYUDA AL DIAGNÓSTICO EN EL AMBIENTE SANITARIO.

estática (manteniendo una postura), cinética (siguiendo la trayectoria del patrón) y dinámica (fuerzas

generadas artificialmente) sobre la mano del paciente. Los datos generados en estas pruebas fueron

registrados y almacenados por el sistema DIMETER (Capítulo 4.), que utiliza un dispositivo háptico

llamado PHAMToN para la adquisición de los datos. Las series temporales serán analizadas matemática y

estadísticamente para obtener atributos numéricos capaces de caracterizar a los diferentes tipos de

temblor. Una vez conseguidos los atributos numéricos se implementan métodos discriminantes que

consiga clasificar a los distintos temblores de forma automática, con técnicas de inteligencia artificial

basadas en el aprendizaje automático y la toma de decisiones. La Máquina de Soporte Vectorial SVM, es

una herramienta robusta, eficaz y de aprendizaje supervisado con buenos resultados en la aplicación de

tareas de clasificación en problemas de la vida real y forman parte del presente proceso investigativo.

El avance tecnológico, la incorporación de sistemas informáticos junto con la gran capacidad de

procesamiento, han hecho que las máquinas hoy en día, simulen en cierta manera la inteligencia

humana y puedan amoldarse a problemas, desarrollar la capacidad de aprender y extraer información

útil de toda una masa desestructurada de datos, para finalmente ayudar en la toma de decisiones y en el

reconocimiento de casos nuevos; proceso que fortalece a la consecución de los objetivos de la presente

investigación en el área de la salud, en ayudar al diagnóstico de patologías provenientes de trastornos

del movimiento y que presentan cierta dificultad de diferenciación .

1.1 TRASTORNOS DEL MOVIMIENTO

Un movimiento tan sencillo como cerrar la mano, realmente es un proceso muy complejo que requiere

la actividad de todo el sistema nervioso, en el que intervienen el cerebro, los músculos y los nervios. En

el cerebro, el área del pensamiento estimula el área motor enviando señales a los músculos que

terminan ejecutando la acción. A través de la acción hay una constante información entre el cerebro y

los músculos a través de los nervios de la médula espinal, regulando la coordinación, potencia, velocidad

y equilibrio necesario para una acción suave.

Las neuronas que controlan el movimiento voluntario del cuerpo humano se encuentran en la corteza

cerebral, son de gran longitud y se conectan con las neuronas de la médula espinal para enviar sus

órdenes. El conjunto de neuronas que se prolongan desde la corteza cerebral hasta la médula espinal

constituyen la Vía Piramidal y es quien controla la actividad motora. Para que el resultado de un

movimiento voluntario se ejecute perfectamente, un sistema complejo llamado Sistema Extrapiramidal,

12

ESTADO DEL ARTE

es el encargado de controlar y coordinar en forma coherente las acciones a realizar en cada momento. El

sistema extrapiramidal es parte del sistema nervioso y del sistema motor, lo constituyen algunas zonas

de la corteza cerebral, los ganglios basales (núcleo caudado, putamen, globo pálido y sustancia negra) y

los ganglios subcorticales que a su vez están interconectados con el tálamo y el cerebelo. Los ganglios

basales son numerosos núcleos de neuronas interrelacionadas formando cadenas y circuitos que se

retroalimentan, unos núcleos son activadores y otros inhibidores cuya función es la iniciación e

integración del movimiento, reciben la información de la corteza cerebral y del tronco del encéfalo, la

procesan y proyectan de nuevo a la corteza, al tronco y a la médula espinal con la finalidad de coordinar

y armonizar los movimientos voluntarios realizados de forma principalmente inconsciente.

La coordinación motora se organiza en el sistema nervioso central. La corteza cerebral, la médula

espinal, el cerebro medio, el cerebelo y los ganglios basales cada uno cumple una función motora

característica, el mal funcionamiento de uno de ellos se manifiesta como una anormalidad que se

observa clínicamente. Como el sistema nervioso controla los movimientos musculares, cualquier

trastorno en el movimiento puede ser categorizado como un síndrome neurológico que afecta al

equilibrio normal del cuerpo, la locomoción, el caminar y el mantenimiento de una postura. Los

trastornos del movimiento se asocian con cambios patológicos en el cerebro, especialmente por una

disfunción de los ganglios basales que forman parte de la materia gris que se sitúan en una región

profunda dentro del cerebro anterior.

Las lesiones de las vías piramidales, producen una incapacidad para realizar movimientos voluntarios

que se manifiesta como debilidad muscular o parálisis completa (plejia) del movimiento y espasticidad

muscular (incremento del tono muscular y exaltación profunda de los reflejos tendinosos). La disfunción

del cerebelo, producen anomalías en la amplitud, rapidez, potencia del movimiento y apreciación

errónea de la distancia (dismetría), el paciente no tiene la capacidad de ejecutar movimientos rápidos,

exactos y coordinarlos de forma suave para mantener una postura estable. La afectación de la fuerza es

mínima. Los trastornos de los ganglios basales o trastornos extrapiramidales producidos por cualquier

causa genética, vascular, traumática, infecciona, entre otras, no producen debilidad muscular ni parálisis

de la espasticidad de los músculos, pero se desencadenan en una serie de alteraciones caracterizadas

por movimientos involuntarios (discinesias), que causan un exceso de excitación del movimiento

(hipercinesia), una mayor carga de inhibición, pobreza o lentitud del mismo (hipocinesia) y cambios del

tono muscular y la postura.

Entre los trastornos más frecuentes están: el temblor, la corea, la distonía, los tics y las mioclonías.

13

AUTOMATIZACIÓN EN LABORES DE CLASIFICACIÓN.

APLICACIÓN DE LOS CLASIFICADORES EN LA AYUDA AL DIAGNÓSTICO EN EL AMBIENTE SANITARIO.

1.2 EL TEMBLOR HUMANO

El temblor humano es el más común de los trastornos del movimiento, es un movimiento anormal

oscilatorio, rítmico e involuntario que puede afectar a una o varias partes del cuerpo que dependen de

las contracciones alternantes de músculos opuestos, agonistas y antagonistas. Comienza lentamente y

progresa a una forma más severa si se deja sin tratar. Las partes del cuerpo que afecta el temblor son las

extremidades superiores (hombro, codo, muñeca, dedos), extremidades inferiores (cadera, rodilla,

articulaciones del tobillo, dedos de los pies) e incluso puede involucrar la cabeza (mentón, cara, lengua,

paladar) y el tronco1 En condiciones severas puede convertirse en un grave problema, provocando

malestar y vergüenza social junto con incapacidad y dificultades a la hora de realizar actividades diarias.

El temblor está presente en un amplio espectro de trastornos neurológicos y se distingue por su

apariencia rítmica, repetitiva y estereotipada de otros trastornos del movimiento involuntarios como la

corea (inquietud, nerviosismo, actividad motora irregular), los tics (repeticiones breves con movimiento

estereotipados sin control voluntario) y las mioclonías (breves sacudidas que no presentan oscilación de

vaivén). Por otro lado, no existe un diagnóstico estandarizado para distinguir entre los tipos más

comunes del temblor lo que hace de la evaluación una tarea desafiante. Sin embargo, establecer la

causa subyacente es muy importante para el diagnóstico debido a que el tratamiento específico puede

variar notablemente, por ello es importante reconocer las varias formas del temblor y los síntomas

asociados. El historial clínico y la exploración física proporcionan una amplia certeza en el diagnóstico.

Los trastornos neurológicos causantes del temblor son la esclerosis múltiple, las enfermedades

neurodegenerativas que dañan partes del tallo cerebral o el cerebelo, los daños cerebrovasculares, las

lesiones cerebrales traumáticas, el abuso del alcohol, el uso de algunos medicamentos, tiroides

hiperactiva y la insuficiencia hepática.

En ciertos casos el temblor puede desencadenarse o exagerarse durante períodos de estrés, emociones

fuertes, cansancio físicamente o durante ciertas posturas o movimientos. El temblor afecta tanto a

hombres como a mujeres, puede producirse a cualquier edad pero es más común en las personas

adultas y ancianas.

El origen del temblor no es claro pero puede ser asociado con fenómenos fisiológicos como el

envejecimiento, y con disfunciones neurológicas. El primero se refiere a un temblor fisiológico mientras

que el segundo a un temblor patológico. Los temblores patológicos más comunes son el temblor

esencial y el temblor parkinsoniano.

14

ESTADO DEL ARTE

En la Figura 1.1 se muestra la forma de una espiral de Arquímedes utilizada para evaluar el temblor a

tres pacientes mediante una prueba cinética, la representación gráfica son los datos obtenidos por el

sistema DIMETER (Capítulo 4). La gráfica a. corresponde a la realizada por un paciente con temblor

fisiológico donde la amplitud del temblor es poco perceptible, sin llegar afectar en la ejecución de la

prueba; la gráfica b. pertenece a un paciente con temblor esencial, el temblor es exacerbado y empeora

durante la ejecución de la tarea, se puede apreciar que la frecuencia de oscilación es alta; la grafica c.

corresponde a la prueba realizada por un paciente con la enfermedad de Parkinson, el temblor tiende a

disminuir mientras se realiza la tarea, a la vez que los movimientos son entrecortados debido que la

lentitud y la rigidez del movimiento es característico en esta enfermedad.

220

Temblor

Fisiológico

250

Temblor

Esencial

220

200

200

200

180

180

160

160

150

y

140

y

y

Temblor

Parkinsoniano

140

120

120

100

100

100

80

80

50

60

60

-100

-50

0

x

50

100

-100

-50

0

x

50

100

150

-100

-50

x

0

50

100

a.

b.

c.

Figura 1.1 Espiral realizada por pacientes con: a. Temblor fisiológico; b. Temblor esencial c. Enfermedad de

Parkinson

Las principales fuentes del temblor se pueden resumir en tres grupos: mecánico, reflejo y oscilaciones

centrales2, como se muestra en la Figura 1.2.

Generador central

Oscilaciones inducidas

mecánicamente

Circuitos

retroalimentados

de los reflejos

Temblor

Amplitud del

movimiento

Tiempo

Figura 1.2 Principales fuentes del temblor.

15

AUTOMATIZACIÓN EN LABORES DE CLASIFICACIÓN.

APLICACIÓN DE LOS CLASIFICADORES EN LA AYUDA AL DIAGNÓSTICO EN EL AMBIENTE SANITARIO.

La primera fuente son las oscilaciones mecánicas, el movimiento de las articulaciones y los músculos

obedecen las leyes de la física y el conjunto complejo tendón-músculo-articulación pueden ser

comparados con masas y muelles, por tanto las oscilaciones pueden ser interpretadas como masas y

muelles. La Figura 1.3 indica la interacción entre la neurona motora superior (UMN) y la neurona motora

inferior (LMN). La piscina de interneuronas de la médula espinal está indicada por (IN). DP corresponden

a los ganglios de la raíz dorsal. El rectángulo azul, es la representación del modelo de músculo de Hill,

que comprende una serie de componentes elásticos (SE), y de un procesador de entrada neuronal (NIP)

paralelo a un componente viscoso (PE)3.

Figura 1.3 Lazos centrales y periféricos en el sistema nervioso.

La segunda fuente del temblor es la oscilación por reflejos, están relacionados a dos circuitos. Circuito

periférico que van desde los músculos hasta la espina dorsal y viceversa y el circuito central que va

desde la periferia a la médula espinal y los segmentos a nivel supraespinal incluyendo el tronco cerebral,

el cerebelo, los ganglios basales y la corteza cerebral. En la Figura 1.4 es una representación de esta

fuente de temblor, en la que se muestra las vías involucradas en el origen del temblor. Los husos

musculares son receptores localizados en el interior de los músculos, compuesto por fibras sensibles a

los cambios de longitud. En respuesta al alargamiento, las señales llegan a los centros espinales y

supraespinales donde se generan las órdenes motoras y son enviadas de vuelta a las fibras musculares

extrafusales3.

Una tercera fuente del temblor lo producen las oscilaciones centrales que pueden ser observados desde

los primeros registros de electroencefalográficos (EEG). La actividad neuronal sigue un comportamiento

rítmico. Por lo tanto la corteza cerebral, los ganglios basales, el cerebelo y el tronco cerebral están

involucrados en origen del temblor3.

16

ESTADO DEL ARTE

Figura 1.4 Vías que involucran el origen del temblor. CN: núcleos cerebelosos, BG: ganglios basales, CC: corteza

cerebral, UMN: neurona motora superiores, LMN: neurona motora inferior, Thal.: Tálamo, IO: oliva inferior, RN:

núcleo rojo, cf: fibras trepadoras, mf: fibra musgosa, MNα: neurona motora alfa, MNϒ: neurona motora beta, Ia:

fibras aferentes sensoriales.

1.3 CLASIFICACIÓN DEL TEMBLOR

Al evaluar un paciente que presenta algún temblor, en primer lugar se categoriza el temblor de acuerdo

a su fenomenología, circunstancias o condiciones de activación en las que se presenta y puede ser

clasificado en dos tipos principales ya sea de reposo o de acción como se muestra en la Tabla 1.1.

TIPO DE TEMBLOR

Reposo

CONDICIÓN DE ACTIVACIÓN

Ocurre cuando la parte afectada esta relajada y

completamente apoyada contra la gravedad.

Acción

Son iniciados por contracciones voluntarias de los

músculos. Se subclasifica en:

EJEMPLOS

La mano descansando sobre la

rodilla.

Postural

Se produce cuando la parte afectada mantiene una

posición sin apoyo y en contra de la fuerza de gravedad.

Extendiendo el brazo en frente

del pecho.

Cinético

Aparece con cualquier forma de movimiento voluntario.

Puede ocurrir en movimientos no guiados visualmente.

Durante los movimientos de

pronación-supinación.

Intención

La amplitud del temblor aumenta cuando el movimiento Tocarse la nariz con un dedo

voluntario está dirigido a un objetivo.

durante un examen médico.

Isométrico

Sucede con la contracción de los músculos contra un

objeto fijo rígido sin realizar ningún movimiento.

Empujar una pared.

Aparece o es exacerbado durante una actividad

específica.

Escribir, dibujar o hablar.

Específico de

una tarea

4

Tabla 1.1 Clasificación del temblor .

17

AUTOMATIZACIÓN EN LABORES DE CLASIFICACIÓN.

APLICACIÓN DE LOS CLASIFICADORES EN LA AYUDA AL DIAGNÓSTICO EN EL AMBIENTE SANITARIO.

La categorización de algunos temblores dependiendo de si está presente en el reposo, durante una

acción o una postura es particularmente importante y se presenta en la Tabla 1.2.

Tipo de temblor

Reposo

Postura

Acción

Fisiológico

++

+

Esencial

+/++

+

Parkinsoniano

++

+

+/Inducido por drogas

+

++

+

Distónico

+/++

+

Holmes

++

++

++

Cerebelar

+/++

Psicogénico

+

+

+

++ Típicamente presente; + Puede estar presente; +/- Ocasionalmente presente.

5

Tabla 1.2 Características de diferentes temblores según su fenomenología .

Cada tipo de temblor tiene múltiples etiologías, más de un tipo temblor puede ocurrir en la misma

condición. Así la causa más común de temblor de reposo es la idiopática Enfermedad de Parkinson (EP),

los pacientes con EP frecuentemente tiene una componente de acción a más de su clásico temblor de

reposo.

Por otro lado la causa más común del Temblor Esencial (TE) es el temblor postural y cinético, a veces

puede persistir cuando las manos descansan en el regazo del paciente. Esta superposición a veces puede

causar dificultad para el diagnóstico clínico, un temblor que disminuye con el movimiento voluntario es

probable que sea un temblor en reposo, mientras que un temblor que está presente en reposo pero que

empeora con el movimiento es probablemente que sea un temblor de acción. El temblor fisiológico es

un temblor de acción-postural y está presente en toda persona sana bajo ciertas condiciones, es

demasiado leve para notarse en la mayoría de las personas y típicamente implica un temblor fino de las

manos.

Se puede hacer una clasificación del temblor también en término de la frecuencia. En la Figura 1.5 se

tiene los tipos de temblores más comunes, la escala inferior indica el rango de las frecuencias. Las

franjas sombreadas indican las frecuencias comunes del temblor y las franjas rayadas las frecuencias

que raramente se presenta en los pacientes, la valoración de la frecuencia es la siguiente:

18

Frecuencia baja < 4 Hz.

Frecuencia media de 4 a 7 Hz.

Frecuencia alta > 7 Hz.

ESTADO DEL ARTE

TIPO DE TEMBLOR

Frecuencia

Fisiológico

Esencial

Parkinsoniano

Inducido por drogas

Distónico

Holmes

Cerebelar

Psicogénico

0

frecuencias

común

rara

5

10

15 Hz

rango de frecuencias

baja

media

alta

1

Figura 1.5 Caracterización del temblor según su frecuencia .

En la Figura 1.6 se muestra un ejemplo de la frecuencia del temblor postural de un paciente con TE,

obtenido con un acelerómetro monoaxial. El paciente mantiene los brazos extendidos horizontalmente

frente al pecho, también se muestra en la parte inferior un análisis espectral de potencia con el que se

obtiene la frecuencia.

Figura 1.6 Frecuencia del temblor esencial en la adopción de una postura. La frecuencia de 7.5 Hz es identificado

3

en el espectro de potencia .

19

AUTOMATIZACIÓN EN LABORES DE CLASIFICACIÓN.

APLICACIÓN DE LOS CLASIFICADORES EN LA AYUDA AL DIAGNÓSTICO EN EL AMBIENTE SANITARIO.

1.3.1 TEMBLOR FISIOLÓGICO

El temblor fisiológico, es un temblor presente en todas las personas y en todas las articulaciones o

músculos que esté libre de oscila, entre las características principales de este temblor se tiene:

-

Es un temblor acción-postural y durante el estado de reposo podría presentar algún síntoma.

-

No es provocada por ninguna enfermedad neurológica, se manifiesta a partir de la oscilación

resonante de una extremidad como resultado de la afectación de factores mecánicos.

-

Es un temblor que apenas puede ser visible en condiciones normales y no interfiere en las

actividades cotidianas.

-

La amplitud del temblor fisiológico típicamente es muy baja.

-

La frecuencia es alta de 8 a 12 Hz , siendo menor a 6 Hz en pacientes menores de 9 años,

incrementándose a 12 Hz en jóvenes adultos y disminuye ligeramente de 6 a 7 HZ en adultos

mayores de 60 años de edad6. La frecuencia del temblor disminuye cuando grandes cargas

inerciales se aplica a las extremidades. La frecuencia es alta en manos y dedos pero baja en las

articulaciones próximas.

Las causas de este tipo de temblor generalmente son reversibles. Es un temblor que se exacerba por las

siguientes causas no motoras:

-

Ansiedad.

-

Fatiga muscular o causa de sueño.

-

Estrés emocional.

-

Miedo o excitación.

Por ciertos medicamentos y condiciones metabólicas.

Otras condiciones que pueden aumentar el temblor fisiológico son la presencia de enfermedades como

feocromocitoma, tirotoxicosis, hipoglucemia, por el retiro de medicamentos como sedantes y opioides,

y por la abstinencia de alcohol. Para evitar este tipo de temblor son efectivos los beta-bloqueadores y

los antagonistas beta-2.

Por otro lado las drogas que excitan el temblor son las catecolaminas, la cafeína, las xantinas, la

fluoxetina, el litio, el haloperidol, las anfetaminas y los agonistas de receptores-beta7.

20

ESTADO DEL ARTE

1.3.2 TEMBLOR ESENCIAL TE

El temblor patológico más común es el temblor esencial, que afecta principalmente antebrazos y manos,

a menudo comienza en la mano dominante; puede o no producir discapacidad, es más perceptible

cuando se realiza tareas sencillas de acción como coger un cubierto, beber un vaso de agua o escribir.

Entre algunas de las características que se manifiestan en este tipo de temblor se tiene:

-

Es un temblor bilateral y simétrico de carácter postural o cinético. Aunque en casos puntuales,

un temblor esencial severo tiene un componente de reposo.

-

El rango de frecuencia es de 4 a 12 Hz. Con el paso del tiempo la frecuencia del temblor

disminuye. En los adultos mayores puede ser confundido como temblor parkinsoniano al

presentarse con bajas frecuencias.

-

Usualmente la amplitud es baja pero puede aumentar con los años.

-

Las extremidades superiores son afectadas en un 95% de los pacientes, seguido por un 34% de

afectación en la cabeza, un 20% en las extremidades inferiores, un 12% afecta a la voz y 5% a la

cara y el tronco7.

-

No es causado por medicamentos, hipotiroidismo o alcohol, sin embargo existe una forma

hereditaria con transmisión autosómico dominante, de penetración variable, en el que se

asocian genes en diferentes cromosomas.

-

Los síntomas pueden iniciar a cualquier edad, desde la niñez hasta la edad adulta. Sin embargo,

es más común en personas mayores de 40 años. Hombre y mujeres son afectados por igual.

Las causas no motoras que provocan un incremento del temblor son:

-

El estrés.

-

La ansiedad.

-

Trastornos emocionales.

-

Excitación e ira.

-

Temperaturas frías.

-

La fatiga

Entre los medicamentos utilizados para el tratamiento del TE ese tiene el anticonvulsivo primidona y

beta-bloqueadores como el atenolol y propranolol y otros como el topiramato y benzodiazepinas como

el alprazolam y clonazepam. El consumo de pequeñas cantidades de alcohol alivian temporalmente el

temblor pero debe evitarse el consumo excesivo.

21

AUTOMATIZACIÓN EN LABORES DE CLASIFICACIÓN.

APLICACIÓN DE LOS CLASIFICADORES EN LA AYUDA AL DIAGNÓSTICO EN EL AMBIENTE SANITARIO.

1.3.3 ENFERMEDAD DEL PARKINSON EP

La Enfermedad de Parkinson es un trastorno crónico progresivo neurodegenerativo caracterizado por el

temblor (como manifestación inicial en el 50% de los pacientes), por la bradicinesia (lentitud en el

movimiento), rigidez muscular e inestabilidad postural (pérdida de equilibrio). Muchos pacientes

también presentan micrografía (disminución progresiva del tamaño de la letra durante la escritura), un

andar arrastrado los pies, facies enmascarados (poca expresión facial), dificultad para levantarse de una

posición sedente llegando a ser una enfermedad discapacitante. Es una enfermedad que no tiene cura.

Para provocar un movimiento, las neuronas pasan mensajes entre sí hacia el resto del cuerpo utilizando

neurotransmisores. En las personas con Parkinson, estos mensajes se interrumpen y no pueden ser

transmitidos a los músculos sin problemas dificultando el control del movimiento debido a una falta de

dopamina (neurotransmisores implicados en el control del movimiento). En las personas con Parkinson,

entre el 70 y el 80% de las células que producen dopamina se han degenerado y se han perdido. Esto

sucede en una pequeña región del cerebro llamada sustancia negra. Si hay suficiente dopamina, las

células nerviosas no funcionan correctamente y no son capaces de transmitir los mensajes del cerebro

dando lugar a los síntomas de Parkinson.

Entre las características de este tipo de temblor se tiene:

-

Es un temblor de reposo aunque también se presenta como un temblor cinético/postural; en

ambos casos la frecuencia es similar8. Frecuentemente existe una pausa del temblor durante la

transición desde el reposo a una postura. Rara vez con < 10% de los pacientes con EP el temblor

cinético/postura es más predominante que el temblor de reposo 1. Un 20-30% de los pacientes

durante la enfermedad pueden no presentar el típico temblor9.

-

El rango de frecuencia oscila entre 3 y 10 Hz como un movimiento de los dedos de "rodar

píldoras". En estados iniciales la frecuencia puede ser superior a 9 Hz.

-

La amplitud del temblor es alta, disminuye con movimientos voluntarios.

-

Frecuentemente afecta a manos, brazos, cabeza, mandíbula, lengua y tronco. Se extiende

afectando a otra parte del cuerpo del mismo lado o del otro, por ejemplo, si inicia en un pie,

continúa extendiéndose hasta la pierna y luego hasta el brazo.

-

Usualmente el temblor inicia alrededor de los 50 años de edad.

-

El sexo, afecta a más hombres que a mujeres, y existe una historial familiar en un 5-10% de los

casos.

22

ESTADO DEL ARTE

-

El temblor puede desaparecer durante el sueño.

Entre las complicaciones que puede acarrear la EP se tiene:

-

Dolor de músculos y articulaciones (calambres, entumecimientos).

-

Alteraciones del sueño.

-

Depresión, problemas cognitivos (demencia, falta de concentración).

-

Dificultad para hablar (titubeo).

-

Pérdida de motivación.

-

Estreñimiento.

-

Problemas de la vejiga.

-

Disfunción sexual.

-

Sialorrea (Producción excesiva de saliva).

-

Anosmia (Pérdida o disminución del sentido del olfato)..

Existe mucho por investigar en este campo, los médicos no están seguros de las causas de la

enfermedad ni la forma de prevenirla. Muchos cambios se presentan en el cerebro de las personas con

EP debido a la presencia de cuerpos de Lewy que son la acumulación de depósitos de proteínas

microscópicas dentro del cerebro, que están asociados con la degeneración y la muerte de las neuronas

en la parte superior del cerebro e interfieren con el funcionamiento normal del cerebro causando una

variedad de síntomas como la pérdida de la memoria y atención, compartiendo características con la

enfermedad de Alzheimer.

Entre los medicamentos utilizados para el tratamiento tratan de aumentar los niveles de dopamina e

imitar sus efectos, entre estos está la levodopa y carbidopa. Para cuando los síntomas son leves se

utiliza la amantadina. También se utiliza medicamentos como anticolinérgicos pero pueden causar

efectos secundarios como confusión y alucinaciones.

1.3.4 OTROS TIPOS DE TEMBLOR

Además de los temblores descritos anteriormente, existen otras formas de temblor que son menos

comunes, que no son parte de este estudio pero es conveniente hacer una rápida citación, entre estos

tipos de temblores se tiene:

23

AUTOMATIZACIÓN EN LABORES DE CLASIFICACIÓN.

APLICACIÓN DE LOS CLASIFICADORES EN LA AYUDA AL DIAGNÓSTICO EN EL AMBIENTE SANITARIO.

TEMBLOR DISTÓNICO, es principalmente un temblor postural y cinético proveniente de una afectación

neurológica que afecta generalmente en una extremidad, el cuello o parte del cuerpo afectado por la

Distonía y usualmente desaparece cuando el músculo distónico está totalmente relajado. Actualmente,

se considera como una forma distinta de TE, ya que es irregular y tiene un amplio rango de frecuencias,

típicamente menor a 7 Hz. Es un temblor que tiende a ser localizado, asimétrico e irregular en amplitud

y periodicidad. Los pacientes utilizan sus propios gestos antagonistas o trucos sensoriales para tratar de

disminuir la amplitud del temblor y junto con la ausencia de intentos por suprimir el temblor por

contracción voluntaria de los músculos son un signo de diagnóstico bastante fiable 6.

TEMBLOR DE HOLMES, es un temblor producido por la lesión del tallo cerebral, el tálamo o el cerebelo.

Es un temblor sintomático y no rítmico, que afecta a las extremidades de predominio proximal. El rango

de frecuencia típico es menor a 4.5 HZ. Es un temblor de reposo e intención con presentación irregular,

el temblor postural también puede presentarse en algunos pacientes y desaparece durante el sueño. Es

el único síndrome de temblor de origen sintomático proveniente de una lesión del sistema central

nervioso6.

TEMBLOR CEREBELOSO, es un temblor de intención dominante o puro, uni o bilateral que empeora al

acercarse al objetivo, rara vez se presenta como un temblor postural. Afecta a la cabeza y a la mitad

superior del cuerpo involucrando a los músculos proximales. El rango de frecuencia de este temblor está

por debajo de 5 Hz. Su amplitud es variable y perpendicular a la dirección en la que se llevó a cabo el

movimiento.

TEMBLOR ORTOSTÁTICO, es un trastorno poco frecuente en las personas de edad mediana edad pero se

presenta con frecuencia en personas de edad avanzada, se caracteriza por inestabilidad cuando adopta

la postura de bipedestación debido a la afectación de las extremidades y el tronco, ocasionalmente

puede prolongarse a las extremidades superiores. El diagnóstico de electromiografía (EMG) confirma

una frecuencia patrón de 13 a 18 Hz y una amplitud muy pequeña apenas palpable sobre los músculos

de la pierna cuando el paciente se encuentra de pie. Es un temblor que remite al caminar y desaparece

con la sedestación o decúbito dorsal6.

TEMBLOR INDUCIDO POR DROGAS, es un temblor que se considera que es provocado por

medicamentos si luego de un plazo razonable después de su ingesta, el temblor se presenta.

Usualmente es un temblor postural y puede presentarse como una exageración de una tendencia leve

de un temblor subyacente. La forma más común es el síndrome del temblor fisiológico que ocurre luego

24

ESTADO DEL ARTE

del uso de antidepresivos, otra forma de este temblor es el temblor parkinsoniano luego del uso de la

dopamina.

TEMBLOR PSICOGÉNICO, es un temblor que frecuentemente incluye componente tanto de reposo como

posturales y cinéticos. Tiene dos formas: imitación del temblor por oscilación voluntaria y temblor de

coactivación muscular en la que se produce un clonus fisiológico exagerado por la contracción voluntaria

de los músculos extensores y flexores. Se caracteriza por presentar fluctuaciones marcadas en severidad

y amplitud. La amplitud del temblor disminuye y su frecuencia varía con la distracción.

1.4 DIAGNÓSTICO DEL TEMBLOR

Una serie de tratamientos médicos y quirúrgicos están disponibles para los distintos tipos de temblor,

pero una respuesta exitosa al tratamiento depende de un diagnóstico preciso.

El temblor es el movimiento oscilatorio anormal e involuntario más frecuente en los humanos; esto

implica que los músculos reciben impulsos excitatorios e inhibidores fuera del control voluntario.

Efectivamente, la actividad oscilatoria es una constante en el sistema nervioso humano, por lo tanto, el

temblor fisiológico es una expresión de dicha actividad, no así en el temblor patológico en donde la

actividad de oscilación del sistema nervioso central es anormal y exagerada.

Clínicamente los aspectos más importantes que caracterizan al temblor son:

La distribución topográfica.

La frecuencia.

La amplitud de la trayectoria.

Las circunstancias en la que se exacerba o condicionan su aparición (manteniendo una postura o

en movimiento).

La etiología.

También son aspecto a tener en cuenta datos sobre el comienzo del temblor, la existencia de

historia familiar, la existencia de enfermedades asociadas, tratamiento con fármacos y la posible

respuesta a la ingesta de alcohol.

Las causas del temblor patológico son heterogéneas y puede presentarse de forma aislada o como parte

de una afectación neurológica. El temblor fisiológico exagerado junto con el temblor esencial y la

25

AUTOMATIZACIÓN EN LABORES DE CLASIFICACIÓN.

APLICACIÓN DE LOS CLASIFICADORES EN LA AYUDA AL DIAGNÓSTICO EN EL AMBIENTE SANITARIO.

enfermedad de Parkinson son los tipos más comunes del temblor encontrados en la práctica clínica y

aunque se consideran enfermedades distintas, entre las dos últimas existe un solapamiento de algunas

características clínicas, así como en epidemiología, genética, tratamiento de imágenes, y los estudios

patológicos.

La relación vinculante que puede existir entre el TE y la EP tiene mucha importancia cuando se habla del

hecho de que una sea un factor de riesgo para la otra, o la coexistencia de ambos síndromes en un

mismo paciente. De hecho, existen trabajos de investigación que evidencian que el TE puede preceder al

comienzo de la EP. Del mismo modo, se ha constatado que los pacientes con TE presentan problemas

cognitivos, muy común en la EP.

La Demencia con Cuerpos de Lewy (DCL) que provoca alteraciones cognitivas y neurodegenerativas,

también establece un vínculo con el TE y la EP lo que lleva a entender que existen algunos síntomas y

signos que también se solapan durante la evaluación clínica. Incluso el Alzhéimer se relaciona con el

amplio espectro clínico de éstas dos patologías.

1.4.1 ESTUDIOS EPIDEMIOLÓGICOS, PREVALENCIA E INCIDENCIA DE TE Y EP

Los rangos de prevalencia son difíciles de precisar y varían sustancialmente en la literatura, muchos de

ellos dependen de los criterios de diagnóstico que se utilizó en el estudio, la edad, la metodología de

determinación de los casos y la gravedad de la patología. La mayoría de estudios basados en registros

clínicos subestiman la verdadera prevalencia, ya que casi el 90% de los pacientes con TE no buscan

atención médica. En el presente trabajo se procuró citar datos actualizados.

La prevalencia del temblor esencial en la población en general se estima entre 0.4 y 3.9%, aumentando

notablemente en la población de avanzada edad y es más frecuente que la Enfermedad de Parkinson. La

prevalencia en personas ≥ 60 a 65 años = 6.3%, para personas ≥ 65 años = 4.6% y para personas ≥ 95

años = 21.7%10. En España el 5% de los ancianos la padecen11. En Finlandia la prevalencia alcanzó el 5-6%

en personas mayores de 40 años, en Turquía fue de 4% en personas en el grupo de personas de la

misma edad. Cerca de un millón de habitantes de los EE.UU. son diagnosticados cada año con TE y en el

UK entre 30 y 40 pacientes son diagnosticados cada día12. En cuanto a la incidencia del TE es de 616

nuevos casos por 100.000 habitantes-año (personas > 65 años) 11. Entre los factores de riesgo que se han

26

ESTADO DEL ARTE

asociado al desarrollo del SE TE puede mencionar la edad, la raza (mayor prevalencia en blancos y

afroamericanos) y tener antecedentes familiares (en el 50% de los casos).

En cuanto a la enfermedad de Parkinson, según un informe de la Fundación Española de Enfermedades

Neurológicas la prevalencia mundial varía entre 167-5.703 por 100.000 habitantes y considera una

incidencia que varía de 1,5-22 pacientes por 100.000 habitantes-año. En España se estima que la

prevalencia en personas > de 65 años = 1.5% y una incidencia ajustada de 186 por 100.000 habitantesaño respecto a un estudio epidemiológico realizado en un grupo de individuos de entre 65 y 85 años11.

En España aproximadamente entre 120.000 y 150.000 personas padecen la enfermedad de Parkinson.

De estos datos epidemiológicos de cierta forma asegura que el TE y EP son los temblores patológicos

más frecuentes en individuos con trastornos en el movimiento y que la coexistencia de ambos en un

mismo individuo son mera casualidad.

Sin embargo, esta tesis no parece ser del toda cierta, en un estudio realizado a una serie de pacientes,

inicialmente con temblor asimétrico postural y características clínicas propias del TE, a lo largo de diez

años progresó hasta desencadenar en la EP. Lo que sugiere precaución en el diagnóstico con pacientes

con un inicio tardío de temblor asimétrico postural, incluso si no se observa presencia de un temblor de

reposo, debido a que puede ser la fase inicial de una EP13. En otro estudio se analizó los errores

cometidos en el diagnóstico inicial de 71 pacientes con TE con un clásico temblor postural, luego de 6

años de seguimiento, 26 pacientes (37%) es decir uno de cada tres pacientes desarrolló la EP14. Bajo

estas circunstancias de error en el diagnóstico, otro estudio incluyó criterios más estrictos, aplicando un

periodo de seguimiento de uno a cinco años, desde el inicio de los síntomas de TE con el fin de observar

posibles manifestaciones de EP y lo que podría asegurar que ambos procesos pueden coexistir en un

mismo individuo; éste estudio sugirió que algunos pacientes con TE tienen un aumento de riesgo

genético para la EP15. Lo que actualmente los médicos utilizan para el diagnóstico de EP está basado en

características clínicas que asisten en la diferenciación entre las semiologías del temblor postural de los

pacientes con TE y EP e incluyen la posibilidad de un diagnóstico en el que coexistan ambos procesos,

Tabla 1.3, en donde se indica las características para identificar pacientes con EP en los que coexiste el

TE. Por otro lado, se puede identificar un paciente con TE si el temblor postural se manifiesta

inmediatamente al colocar los brazos extendidos hacia adelante, en cambio un paciente con EP al tomar

la misma postura existe una latencia de unos segundo e incluso minutos antes de que se exacerbe el

temblor, es el llamado temblor reemergente; en conclusión un paciente de EP que presente temblor

postural sin latencia, sugiere la coexistencia de TE16.

27

AUTOMATIZACIÓN EN LABORES DE CLASIFICACIÓN.

APLICACIÓN DE LOS CLASIFICADORES EN LA AYUDA AL DIAGNÓSTICO EN EL AMBIENTE SANITARIO.

- Historia previa del temblor intencional de larga evolución (más

de 5 años).

- Antecedentes familiares de temblor.

- Temblor postural sin latencia de inicio (el temblor se produce

inmediatamente después de levantar las extremidades)

- Presencia de temblor de la voz.

- Temblor con la escritura, o con el dibujo de la espiral de

Arquímedes.