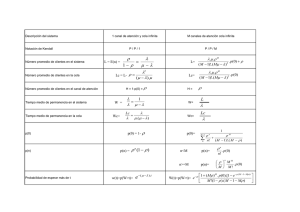

xii jornadas nacionales y latinoamericanas actuariales 2011

Anuncio