evaluación automática de coherencia textual en noticias

Anuncio

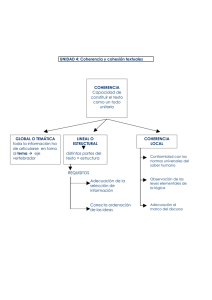

RLA. Revista de Lingüística Teórica y Aplicada Concepción (Chile), 48 (2), II Sem. 2010, pp. 115-139. CL ISSN 0033 - 698X EVALUACIÓN AUTOMÁTICA DE COHERENCIA TEXTUAL EN NOTICIAS POLICIALES UTILIZANDO ANÁLISIS SEMÁNTICO LATENTE* AUTOMATIC EVALUATION OF TEXTUAL COHERENCE IN POLICE NEWS USING LATENT SEMANTIC ANALYSIS SERGIO HERNÁNDEZ OSUNA Universidad de Concepción. Concepción, Chile. [email protected] ANITA FERREIRA CABRERA Universidad de Concepción. Concepción, Chile. [email protected] RESUMEN El presente artículo expone los resultados de una investigación que buscó evaluar la coherencia textual en forma automática, utilizando el método de Análisis Semántico Latente, en el dominio formado por noticias policiales. Con este fin se construyó una herramienta prototipo, empleando únicamente software libre, que se puede obtener desde Internet. Para validar el funcionamiento del prototipo se comparó su evaluación con la realizada por ocho evaluadores humanos: cuatro periodistas y cuatro profesores de español con estudios de postgrado en lingüística. Palabras clave: Coherencia, Análisis Semántico Latente, noticias policiales. ABSTRACT This article presents the results of an investigation that aimed to assess textual coherence automatically, using the method of Latent Semantic Analysis in the domain formed by police news. For this purpose, a prototype tool was built using only free software, which can be obtained from the Internet. To validate the performance of the prototype, its evaluation was compared with that made by eight human evaluators: four journalists and four spanish’s teachers with graduate studies in linguistics. Keywords: Coherence, Latent Semantic Analysis, police news. Recibido: 26/04/2010. Aceptado: 07/09/2010 * Esta investigación está inserta en el contexto del Proyecto de Fomento a la Investigación en Ciencias Sociales, Humanidades, Economía y Educación, DIUC 209603010-1 “Un Sistema Tutorial Inteligente para la enseñanza del Español como Lengua Extranjera”. 115 RLA. Revista de Lingüística Teórica y Aplicada, 48 (2), II Sem. 2010 1. INTRODUCCIÓN U na de las problemáticas principales en el proceso de publicación de un medio de prensa escrito es subsanar los errores lingüísticos producidos al construir un texto por el periodista. Tradicionalmente, esta labor recayó sobre el corrector de pruebas. Estos profesionales dedicados a corregir los textos elaborados por los periodistas, previamente a su publicación, han ido desapareciendo como consecuencia de los avances de la tecnología. La razón principal es que ahora la tarea de colocar el texto en la página que se imprimirá o se publicará en Internet se ha automatizado, pasando a ser responsabilidad del mismo periodista, gracias a softwares especializados como Milenium Cross Media, en el caso de los medios impresos, o los gestores de contenidos –como Joomla, Wordpress o similares– para el caso de los medios en Internet. Si bien es indudable que esta automatización significa un gran avance en agilizar el proceso de publicación de un medio de prensa, la ausencia del corrector de pruebas implica que los errores en la construcción de los textos lleguen con más frecuencia hasta los lectores de los mismos, dado que ya no existe el corrector humano que reparaba los errores lingüísticos. Además, estos errores se tornan más frecuentes por el vértigo en que se desarrolla la labor del periodista –más aún desde la masificación de Internet–, ya que debe escribir siempre contra el tiempo, intentando llegar con la noticia al público antes que los demás medios de prensa. La presente investigación tuvo como fin estudiar sólo un aspecto de los múltiples problemas que podrían derivarse de esta automatización. Éste es el problema de los errores de coherencia en la construcción de los textos periodísticos. El trabajo realizado no buscó solucionar la problemática planteada directamente, sino que es sólo un primer paso para avanzar en dicha dirección. El foco del trabajo fue investigar sobre la efectividad de utilizar herramientas informáticas para evaluar la coherencia textual, específicamente, aplicando el método del Análisis Semántico Latente. El tipo de texto con el que se trabajó es la noticia, también llamada información periodística (Martínez Albertos, 2004; Leñero y Marín, 1986). La idea fue observar si una máquina era capaz de detectar las alteraciones de coherencia de la misma forma en que lo haría un grupo de humanos expertos en el tipo de texto utilizado y otro grupo experto en el estudio del fenómeno denominado coherencia. La investigación tuvo como objetivo general evaluar la coherencia de una noticia del dominio policial en forma automática. La hipótesis de trabajo fue: “La evaluación automática de coherencia textual, utilizando la técnica del Análisis Semántico Latente, es equivalente a la evaluación humana en el dominio formado por las noticias policiales”. El término equivalente no debe entenderse en el sentido de que la evaluación entregada por la herramienta prototipo de medición automática de coherencia sea igual a la entregada por los humanos. Es decir, no 116 S. HERNÁNDEZ, A. FERREIRA se pretende probar que si la máquina asigna una evaluación X a un texto determinado, los evaluadores humanos también asignen X. El sentido en que debe entenderse equivalente es que ambas evaluaciones –máquina y humanos– sigan tendencias similares y se correlacionen. Esto indicaría que la evaluación automática de coherencia realizada por la herramienta prototipo es correcta y que puede utilizarse como información útil para perfeccionar el texto. 2. MARCO DE REFERENCIA A continuación se expondrá brevemente sobre coherencia (y cohesión) y Análisis Semántico Latente, conceptos que son fundamentales para comprender el trabajo que se presenta. 2.1. Coherencia y cohesión Álvarez (1995) señala que el texto es una configuración lingüística. Agrega que este texto “resulta, por una parte, de operaciones enunciativas que realiza el locutor y, por otra parte, de operaciones seriales que permiten a este mismo locutor conectar las oraciones individuales para constituir secuencias cohesivas y coherentes”. Singer y Zwaan (2003) añaden que para que un texto sea comprensible debe ser coherente. Los lectores deben poder identificar las relaciones entre las ideas del texto. El mismo Álvarez (1995) señala que “un texto es una secuencia de oraciones; pero no cualquier secuencia de oraciones constituye texto. Para que una secuencia de oraciones constituya texto, es decir sea aceptada como un texto coherente en una interacción determinada, tiene que cumplir con ciertas normas de buena formación textual […]. Generalmente, las exigencias de la buena formación textual se engloban bajo los términos de cohesión y coherencia”. Por lo tanto, si un texto carece de esta buena formación textual, no tendrá coherencia ni cohesión y, en consecuencia, los lectores no podrán identificar las relaciones entre las ideas de este texto y les será incomprensible. Si bien coherencia y cohesión son términos relacionados, no son lo mismo. La cohesión alude al “aspecto formal, gramatical de las relaciones que existen de una oración a otra en el texto” y la coherencia “designa el aspecto mental, conceptual de la relación que se postula entre los hechos denotados” (Álvarez, 1995). Por su parte, Jurafsky y Martin (2008) reconocen que coherencia y cohesión son términos a menudo confundidos. Para ellos la cohesión se refiere a la forma en que las unidades textuales son enlazadas. Indican que una relación cohesiva es como una clase de pegamento que agrupa dos unidades en una sola unidad mayor. Por otro lado, para los citados autores la coherencia alude a las relaciones de significados 117 RLA. Revista de Lingüística Teórica y Aplicada, 48 (2), II Sem. 2010 entre dos unidades. Una relación de coherencia explica cómo el significado de diferentes unidades textuales puede combinarse para construir un significado discursivo mayor. Relacionado con el hecho de que la coherencia se refiera a un aspecto mental, hay que señalar que los psicolingüistas consideran que “la coherencia es más bien una función cognitiva; dicho de otro modo, la coherencia está en la mente y no en el texto” (De Vega, Díaz y León, 1999). De esta forma, el lector de un texto entiende las relaciones de coherencia entre las diversas partes de éste gracias, en gran medida, a sus conocimientos pragmáticos del mundo. O sea, “la coherencia es el resultado de la interacción entre el texto y el saber sobre el mundo” que comparten el autor del escrito como quien lo lee (Álvarez, 1995). Como ejemplo de lo anterior se presentan estas dos secuencias citadas por De Vega, Díaz y León (1999): (1) Al terminar de cenar en el restaurante con mis padres llamé al camarero y le pedí la cuenta. (2) Al terminar de cenar en casa de mis padres llamé al camarero y le pedí la cuenta. Si bien ambos textos son parecidos en términos gramaticales e incluso en las palabras que utilizan, sólo el primero resulta perfectamente coherente. “La coherencia o incoherencia viene determinada, en este caso, por el conocimiento de mundo sobre los restaurantes y las cenas familiares que comparten tanto el autor como el lector” (De Vega, Díaz y León, 1999). Jurafsky y Martin (2008) aportan otro ejemplo: (3) John escondió las llaves del auto de Bill. Él estaba ebrio. (4) John escondió las llaves del auto de Bill. A él le gustan las espinacas. Mientras que la mayoría de las personas no encontrarían nada fuera de lo común en la primera oración, la segunda les parecería extraña. ¿Por qué ocurre esto? Si bien ambas oraciones están correctamente construidas, algo parece estar equivocado en las sentencias que se suceden en (4). Entonces, quien se enfrenta a ellas podría perfectamente cuestionarse cuál es la relación entre esconder las llaves de un auto y que a alguien le gusten las espinacas. Al realizar esta pregunta, lo que se está cuestionado es la coherencia del pasaje. De esta misma forma, quien lee las oraciones podría intentar construir una explicación que le dé coherencia al pasaje. Por ejemplo, que alguien le ofreció a John espinacas a cambio de esconderle las llaves del auto a Bill. De hecho, si se considera un contexto en el cual esto ya es conocido, el pasaje se percibe como correcto. ¿Por qué ocurre esto? La razón es que esta conjetura permite a quien lee el texto identificar el gusto de John por las espinacas como la causa de que escon118 S. HERNÁNDEZ, A. FERREIRA da las llaves del auto de Bill, lo que explica la conexión que habría entre ambas sentencias. El hecho de que los lectores traten de identificar tales conexiones, demuestra la necesidad de establecer coherencia como una parte de la comprensión del discurso. Finalmente, cabe apuntar que a menudo se suele distinguir entre la coherencia local, que establece el lector entre los contenidos próximos (por ejemplo, dos oraciones consecutivas); y la coherencia global, que establece entre contenidos muy distantes o distribuidos a lo largo del texto (De Vega, Díaz y León, 1999). 2.2. Análisis Semántico Latente El Análisis Semántico Latente (o LSA, según sus iniciales en inglés) es una técnica que utiliza procesos estadísticos para extraer y representar los significados de las palabras. Los significados son representados en términos de su semejanza con otras palabras en un extenso corpus de documentos (Boonthum, Levinstein y McNamara, 2007). Su propósito es “superar un problema fundamental que se produce con las técnicas de recuperación que pretenden hacer coincidir las palabras de búsqueda con las palabras en los documentos (como sería el caso de los buscadores de información en Internet)” (Venegas, 2003). Los autores de la técnica suponen que hay algo que subyace latente en la estructura semántica de los datos, que está parcialmente oculto por la elección aleatoria de las palabras (Deerwester et al., 1990, también citados en Venegas, 2003). Landauer, Foltz y Laham (1998, también citados en Venegas, 2003) definen al Análisis Semántico Latente como “una técnica matemático-estadística totalmente automática para extraer e inferir relaciones de uso contextual esperado de palabras en pasajes de discurso. No es un procesamiento de idioma natural tradicional o programa de inteligencia artificial; no usa ningún diccionario construido humanamente, bases de conocimiento, redes semánticas, gramáticas, segmentadores sintácticos, o morfologías y toma como input sólo la segmentación del texto en palabras, pasajes, frases o párrafos”. McCarthy, Briner, Rus y McNamara (2007) señalan sobre el Análisis Semántico Latente que está basado en la idea de que las palabras (o grupos de palabras) aparecen en algunos contextos pero no en otros. La ventaja práctica del LSA sobre otros tipos de mediciones como shallow word overlap es que va más allá de las si bosque. De este modo, el Análisis Semántico Latente no sólo nos dice que dos términos están relacionados, sino que también nos señala cuán similares son. Landauer (2002), para explicar el funcionamiento del LSA, señala que el significado de un pasaje de texto está contenido en sus palabras, y que todas sus pala119 RLA. Revista de Lingüística Teórica y Aplicada, 48 (2), II Sem. 2010 bras contribuyen a formar su significado. A esto, agrega, que dos pasajes, aunque tengan diferentes palabras, podrían tener un significado similar. Esto se puede resumir asumiendo que el significado de un pasaje de texto es igual a la suma del significado de las palabras que lo componen. El autor lo representa con el siguiente esquema: significado de la palabra 1 + significado de la palabra 2 + ...+ significado de la palabra n = significado del pasaje Según expresan Foltz, Kintsch y Landauer (1998), el poder del Análisis Semántico Latente para determinar el grado de relación semántica proviene del análisis de un extenso número de textos de ejemplo. El objeto del trabajo que se presenta fue utilizar el LSA para realizar predicciones de coherencia, según postulan Foltz, Kintsch y Landauer (1998) en su artículo “La medición de coherencia textual con Análisis Semántico Latente”. Para lograrlo hay que comparar una unidad de texto con otra unidad de texto vecina, esto con el objetivo de determinar en qué grado están relacionados semánticamente ambos segmentos. Estas unidades pueden ser oraciones, párrafos o, incluso, palabras aisladas o libros completos. Este análisis debe ser hecho a todos los pares de unidades de texto vecinas, con el fin de caracterizar la coherencia de todo el texto en su conjunto (Foltz, Kintsch y Landauer, 1998). Para realizar predicciones de coherencia de un texto en particular, primero es necesario tener un conjunto de textos similares al que se busca analizar, pues el Análisis Semántico Latente requiere de un dominio temático restringido. Este corpus de entrenamiento –el conjunto de textos– que precisa el LSA, al pertenecer a un dominio restringido, garantiza que en él se contengan una gran proporción de los términos usados en el texto a analizar y que éstos aparezcan en distintos contextos, con el fin de tener un marco que permita su comparación con el texto cuya coherencia se quiere predecir por medio del Análisis Semántico Latente. El proceso realizado para lograr la predicción de coherencia es el siguiente, según lo describen Foltz, Kintsch y Landauer (1998): El Análisis Semántico Latente representa cada palabra del texto procesado –así como unidades textuales mayores– en el espacio semántico a través de vectores. Las unidades textuales mayores –como una oración– son representadas en este espacio semántico multidimensional como el promedio ponderado de los vectores de los términos que contiene. La relación semántica entre dos unidades de texto puede ser comparada determinando el coseno entre los vectores de ambas unidades. Por lo tanto, para evaluar la coherencia entre la primera y la segunda oración de un texto, el coseno entre los vectores de las dos oraciones debe ser determinado. Por ejemplo, dos oraciones que utilicen exactamente los mismos términos y con la misma frecuencia tendrán un coseno de 1; mientras que dos oraciones que usen términos que no sean se120 S. HERNÁNDEZ, A. FERREIRA mánticamente relacionados, tenderán a tener cosenos cercanos a 0, o menores aún (valor negativo). Se añade a lo dicho por Foltz, Kintsch y Landauer, con el fin de evitar confusiones, que si bien el valor del coseno puede fluctuar entre 1 y -1, para el caso de las predicciones de coherencia mediante Análisis Semántico Latente, tal cual ellos señalan, el coseno obtenido entre los vectores de dos unidades textuales adyacentes, que contengan términos que no sean semánticamente relacionados, normalmente será un valor positivo que tienda a 0. 3. METODOLOGÍA APLICADA Los pasos que se siguieron fueron fundamentalmente tres: recopilación del corpus, construcción del prototipo y evaluación de la coherencia de un conjunto de textos por el prototipo y por evaluadores humanos expertos. En el desarrollo del trabajo se utilizó únicamente software libre, esto es, aquel que respeta las cuatro libertades esenciales establecidas por la Free Software Fundation (2010) –en español Fundación para el Software Libre–. Dichas libertades son: a) Libertad de ejecutar el programa cuando se quiera. b) Libertad de estudiar el código fuente y modificarlo para que haga lo que se quiera. c) Libertad de copiar el programa y distribuir las copias cuando se quiera. d) Libertad de publicar o distribuir una versión modificada cuando se quiera. Según se desprende de lo anterior, se prescindió de cualquier aplicación propietaria y de código cerrado (que no puede ser modificado por el usuario), lo que garantiza que en todas las aplicaciones informáticas utilizadas no se vulnera ninguna licencia y, por ende, no hay uso ilegal de software de terceros. Para toda la experiencia se empleó un computador con procesador Intel Centrino Duo, de 2 ghz, con una memoria RAM de 1 gb, es decir, un equipo promedio que se aleja de las características de los equipos de última generación. Esto no representó ningún problema pues el computador utiliza el sistema operativo Linux, específicamente la distribución Ubuntu de Canonical Ltd.; dicho sistema operativo tiene un alto grado de eficiencia y un bajo consumo de recursos en comparación con los sistemas operativos de Microsoft, por ejemplo. Además, la utilización de Linux fue una necesidad, debido a que muchas de las aplicaciones empleadas sólo corren de manera nativa en dicho ambiente. 3.1. Recopilación del corpus Como se señaló en 2.2, el Análisis Semántico Latente precisa para su óptimo fun121 RLA. Revista de Lingüística Teórica y Aplicada, 48 (2), II Sem. 2010 cionamiento de extensos corpus de textos, y que estos textos, además, pertenezcan a un dominio temático restringido. Este corpus se utiliza para entrenar al software de Análisis Semántico Latente, y a partir de este conjunto de textos, la aplicación crea el espacio semántico multidimensional a la luz del cual analizará los textos que se procesen para calcular su coherencia. Teniendo en cuenta lo anterior y dado que la idea era trabajar con noticias, se optó por utilizar como dominio, de entre todos los temas que habitualmente aborda la prensa, el conocido como “Periodismo policial” o vulgarmente denominado “Crónica roja”. La razón de esta elección es que dicho campo temático es uno de los que mayor volumen de informaciones ofrece, estando presente en el día a día de cualquier medio periodístico escrito. Para la confección del corpus de entrenamiento se utilizaron 1.505 textos extraídos de medios de prensa chilenos, específicamente de El Mercurio, La Tercera y La Nación. La razón para elegir estos medios fue preferir aquéllos con circulación a nivel nacional, por considerarse más representativos del periodismo del país. Además, se les eligió por el mayor esmero con que cuidan el correcto uso del español en las noticias que publican (registro culto-formal). De esta forma se prescindió de otros medios como La Cuarta cuyo uso particular de la lengua no corresponde al habitual en los medios periodísticos y podría haber afectado el funcionamiento de la aplicación de Análisis Semántico Latente. Otro de los motivos para elegir los medios en cuestión fue que publican sus noticias en Internet en formato html, esto es, utilizan texto que enriquecen con etiquetas que el navegador web debe interpretar. El proceso de recopilación del corpus, gracias a esto, se simplifica una enormidad: sólo basta con copiar y pegar el texto desde el sitio en Internet del medio a un editor de texto sin formato, con el fin de borrarle todas las etiquetas html y mantener únicamente el texto de la noticia en sí. Con esto se evitó el estar utilizando una aplicación de reconocimiento óptico de caracteres, lo que hubiera convertido un trabajo de por sí arduo, en una tarea prácticamente inmanejable por el elevado número de textos utilizados para conformar el corpus. 3.2. Construcción del prototipo El prototipo puede ser descrito en pocas palabras, como una aplicación que recibe un texto como entrada, lo prepara para su procesamiento, lo lematiza, lo procesa a la luz del espacio semántico creado mediante el corpus de entrenamiento, lo convierte en una cantidad variable de vectores y, finalmente, calcula el coseno de las parejas de vectores adyacentes y los promedia para entregar la evaluación de coherencia del texto en cuestión. Sin embargo, para comprender mejor su funcionamiento es necesario describir el proceso paso a paso y con mayores detalles. Las principales aplicaciones informáticas empleadas son el lematizador Libste122 S. HERNÁNDEZ, A. FERREIRA de flujo Sed destinado a manejar cadenas de texto y el intérprete de bc, que es un lenguaje de programación utilizado para realizar operaciones de cálculo numérico desde una línea de comandos (estas dos últimas aplicaciones vienen incluidas por defecto en la distribución de Linux utilizada). Por último, en el prototipo se usó Dicha aplicación consiste en un paquete de software que debe ser compilado para operar en ambiente Linux y emplea una variante de Análisis Semántico Latente que representa las palabras de un corpus de texto en un espacio vectorial llamado WordSpace. La aplicación permite realizar recuperación de información desde el corpus y mediciones de relación semántica entre las palabras. El diseño de la herramienta prototipo para evaluar la coherencia textual en forma automática se concibió como un script. Para el Diccionario Informático de Alegsa (en línea), un script es “un conjunto de instrucciones generalmente almacenadas en un archivo de texto que deben ser interpretadas línea a línea en tiempo real para su ejecución. Se distinguen de los programas, pues deben ser convertidos a un archivo binario ejecutable para correrlos”. Este script cumple la función de ordenar a todas las aplicaciones que componen el prototipo que realicen las tareas que de ellas se requieren. La importancia de éste es fundamental, pues todas las aplicaciones carecen de interfaz gráfica y operan sólo a través de comandos de consola, por lo que sin el script la operación de las diferentes aplicaciones sería una tarea que requeriría horas de aprendizaje para un individuo que no las conociera; a esto hay que sumar que el tiempo que llevaría la tarea de procesar un solo texto sería cercano a una hora, lapso que el script reduce a 10 segundos para una noticia de extensión promedio. 3.2.1. Preparación del corpus de entrenamiento y construcción del modelo mediante el Infomap Los textos en bruto extraídos desde los tres medios periodísticos utilizados se unieron en un único archivo de texto plano, pues para el objetivo del trabajo realizado no importa la procedencia de ellos. Cada uno de los 1.505 textos fue preparado, etiquetándolos de la forma exigida por el Infomap. Luego el archivo con los 1505 textos se sometió a diferentes operaciones con el fin de limpiarlo. Utilizando el comando Sed desde la Terminal (la consola de comandos de Linux), se eliminaron todas las tildes de las vocales, pues el Infomap no está habilitado para procesarlas y arroja un error cuando se encuentra con ellas. También se eliminaron de los textos todos los signos de puntuación, ya que éstos no son relevantes para el Análisis Semántico Latente; además los signos de puntuación provocan que el Libstemmer no lematice una palabra que va seguida de un punto o una coma, por ejemplo, pues considera al signo como parte de la 123 RLA. Revista de Lingüística Teórica y Aplicada, 48 (2), II Sem. 2010 palabra y no la reconoce. Hay que agregar que el Infomap, al encontrarse con una eñe, arroja un error similar que al encontrarse con una tilde, pero este problema se resolvió más adelante, una vez que el texto estuvo lematizado. Posteriormente, el archivo con los textos fue transformado en una lista de palabras, con el fin de prepararlo para la lematización, dado que el Libstemmer sólo procesa palabras individuales. Para ello se ejecutó el comando Sed desde la Terminal con la orden de reemplazar todos los espacios en blanco por saltos de línea. Luego el archivo, ya convertido en una extensa lista de palabras, fue procesado en el Libstemmer, arrojando como salida la misma lista de palabras, pero ahora lematizadas. Esta lista de palabras fue convertida nuevamente en un texto, reemplazando los saltos de línea por espacios en blanco. Luego, se separaron las etiquetas del corpus de cada uno de los textos, agregando saltos de línea antes y después de ellas. Finalmente, una vez lematizado el texto quedaba el problema de que el Infomap no puede trabajar con las eñes por ser éstas ajenas al inglés, lengua de origen de la aplicación. El inconveniente se resolvió reemplazando las eñes por la secuencia nnn, que no se da dentro de la estructura silábica del español, por lo que se consideró una buena forma de representar a dicho grafema. Así el lema correspondiente a niño, que normalmente es niñ, fue reescrito como ninnn. Hay que señalar que esto no significa ningún problema en relación a los resultados del proceso, pues no afecta la medición de relación semántica, ya que la eñe en rigor no se eliminó, sino que se representó con la secuencia antes descrita. A continuación se transcribe como ejemplo un texto ya sometido a todo el proceso señalado: <DOC> <TEXT> pdi detien a herman del cisarr en pennnalol el menor de 17 annnos identific com icm reconoci hab particip en el rescat de su herman uno de los herman del cisarr identific com icm fue deten ayer por la brig del crim de la pdi deb a una orden pendient por hurt simpl el jov de 17 annnos qui present antecedent por hurt y consum de drog fue aprehend cerc de las 1630 en pennnalol al ser interrog reconoci hab particip en la fug de ccm 10 conoc com cisarr ocurr el 1 de agost cuand seis menor de edad lleg al centr del senam dond el ninnn permaneci reclu y con un arma de fueg lo ayud a huir hoy ser el control de detencion de icm mientr que su herman el cisarr qui ha sid deten 16 vec permanec reclu en el centr del senam desd dond escap Una vez ya preparado el corpus de entrenamiento como recién se expuso, queda un paso previo antes de construir el modelo que definirá el espacio semántico 124 S. HERNÁNDEZ, A. FERREIRA con el Infomap, éste es el relativo a las stop words. El Diccionario Tecnológico (2009, en línea) del sitio web chileno Usando.info, define a las stop words como “aquellas palabras que por ser comunes, los buscadores ignoran para asegurar la calidad de los resultados de lo que se busca. Normalmente entran en esta categoría las preposiciones y conjunciones”. El Infomap-NLP incluye por defecto una lista de stop words, pero del inglés. Por lo tanto, esa lista se reemplazó por una lista de stop words para el español. En Internet hay muchos sitios que ponen a disposición de los navegantes listas de stop words para el español, por lo que pese a que el Infomap no las incluye no es difícil conseguir una. Para el trabajo se utilizó una lista de 327 stop words, construida combinando dos recopilaciones disponibles en Internet. Una de ellas es la que ofrece para la descarga en su sitio el equipo del projecto Snowball, el mismo lingual Resources de la Universidad de Neuchatel, y puede ser descargada desde Finalmente, a la lista de stop words se le dio el mismo tratamiento que al corpus de entrenamiento, con el fin de mantener la correspondencia entre ambos: se eliminaron las tildes de las palabras, se lematizaron y se reemplazaron las eñes por la secuencia nnn. Una vez realizado lo anterior, recién se construyó el modelo en el Infomap, a partir del corpus de entrenamiento. Para esto simplemente bastó con crear un directorio dentro del computador y, a través de comandos ingresados en la Terminal, definirlo como directorio de trabajo para la aplicación. Luego simplemente se le indicó al Infomap la ruta al archivo que contenía el corpus de entrenamiento para que el programa construyera automáticamente el modelo que define el espacio semántico a partir de la recopilación de noticias realizada. 3.2.2. Desarrollo del script Para el desarrollo del script se utilizó el intérprete de órdenes bash. Se eligió éste por la potencia que posee y, además, porque trabaja con los mismos comandos que la Terminal de Linux, lo que facilita su empleo. En el computador de trabajo no hubo necesidad de instalar dicho intérprete, pues viene incluido por defecto en la distribución Ubuntu. En la descripción del proceso de construcción del script, por motivos de espacio y de claridad, se realizará una explicación más general, prescindiendo de muchos aspectos de corte más técnico. Previamente, como ya fue expuesto, es bueno recordar que para predecir coherencia el Análisis Semántico Latente necesita comparar dos unidades textuales 125 RLA. Revista de Lingüística Teórica y Aplicada, 48 (2), II Sem. 2010 vecinas que pueden ser palabras, oraciones, párrafos o textos completos. En este caso, se utilizó como unidad a comparar el párrafo, porque al tratarse de noticias, la tendencia del periodismo actual, sobre todo por el influjo de Internet, es a utilizar párrafos cada vez más cortos (Franco, 2008). Sin embargo, aunque no se expondrá acá, se construyó en el trabajo un script que segmentaba el texto en oraciones, utilizando el punto seguido como marca para realizar la segmentación automática. Las pruebas realizadas llevaron a determinar que la tendencia del periodismo de utilizar párrafos cortos producía distorsiones en los resultados al emplear el script que segmenta en oraciones; incluso, dentro del corpus de entrenamiento hay muchos textos en que no se utiliza el punto seguido. El script requiere que la noticia que se desee procesar esté ubicada en un archivo de texto plano con el nombre texto_entrada, que debe situarse dentro del mismo directorio en que está el script. Luego, utilizando el comando Sed para el tratamiento de cadenas de texto, se escribieron las órdenes para que el script elimine las tildes de las vocales, las comas, los dos puntos, los punto y coma, los signos de interrogación y exclamación, los paréntesis, las comillas dobles y simples, y el signo peso. A continuación el script reemplaza los espacios en blanco por saltos de línea, con el fin de construir la lista de palabras que requiere el lematizador. Luego reemplaza todos los puntos por saltos de línea con el fin de dejar el espacio en blanco que indique dónde finaliza cada oración. En este punto se necesitaba marcar los espacios en blanco de alguna forma, con el fin de que éstos no se confundieran con los que se generarían en un paso posterior del script. Para ello se recurrió a reemplazarlos con la cadena de texto ststs, que se utilizó como comodín de marcado, ya que no existe ninguna similar en la estructura silábica del español. Una vez realizado lo anterior, el script llama al lematizador y éste realiza su tarea sobre el texto. Hay que indicar que entre la lista de palabras se encontrará con la secuencia ststs, pero la dejará intacta porque no la reconoce como perteneciente al español. A continuación el script, nuevamente usando el comando Sed, convierte todos los saltos de líneas en espacios en blanco. Con esto el texto queda convertido en un único párrafo, que tiene intercalada entre sus palabras la cadena marcadora ststs. Luego reemplaza todas las eñes por la secuencia nnn y la cadena ststs es reemplazada por un salto de línea, con lo que el texto ya limpio y lematizado queda segmentado según lo requerido. En este punto, utilizando una vez más Sed, al archivo de texto de salida se le agregan las órdenes necesarias para convertirlo en un nuevo script –al que llamaremos script secundario–, independiente del que ahora se describe; al inicio de cada línea del texto ya segmentado se añaden los comandos necesarios para su procesamiento en el Infomap-NLP, y al final de cada línea se agrega el texto que da la orden para que los valores que conforman el vector resultante los guarde en 126 S. HERNÁNDEZ, A. FERREIRA un archivo llamado vector1. Finalmente, el script principal le otorga permisos de ejecución al script secundario, para que éste pueda operar como tal y ordena su ejecución. Con esto se obtiene como resultado un archivo llamado vectores_division_puntos que contiene los valores que conforman los vectores que representan a cada párrafo del texto en el espacio semántico construido a partir del corpus de entrenamiento. Por último, el script calcula el coseno entre las unidades textuales adyacentes que conforman el texto procesado en el prototipo. Para ello, y sin entrar a definir conceptos matemáticos en forma profunda, hay que tener claro que para cada par de vectores adyacentes (A,B) se calcula el coseno entre ellos de la siguiente forma: cos( A, B ) A* B A* B Lo anterior significa que el coseno del ángulo formado por dos vectores es igual al producto escalar entre los vectores dividido por el producto de sus módulos. También se puede representar de la siguiente forma: n ¤a b i i cos( A, B) i 1 A* B Por último, una vez calculado el producto escalar de los vectores y el producto de los módulos de éstos, simplemente hay que dividir el primer valor obtenido por el segundo. Este resultado indicará el grado de coherencia que hay entre las dos unidades textuales. Y, como ya se señaló, para calcular el grado de coherencia de un texto completo debe realizarse la operación descrita para cada par de vectores que representen a unidades textuales adyacentes y, finalmente, calcular el promedio de los valores obtenidos. Este resultado será el grado de coherencia de dicho texto medido mediante Análisis Semántico Latente. Para realizar esta tarea el script utiliza el intérprete de bc, que es un lenguaje de programación utilizado para realizar operaciones de cálculo numérico desde una línea de comandos. Finalmente el script arroja un archivo llamado salida_coherencia que contiene el título del texto procesado y los cosenos de cada una de las unidades textuales comparadas y el promedio de todos estos cosenos. 3.2.3. Evaluación de coherencia en los textos de prueba El prototipo fue testeado procesando diversos textos extraídos desde los mismos medios de prensa desde los que se conformó el corpus de entrenamiento. Se efec127 RLA. Revista de Lingüística Teórica y Aplicada, 48 (2), II Sem. 2010 tuaron pruebas diversas, entre las que se incluyeron manipular la coherencia de textos, crear textos sin sentido uniendo párrafos extraídos desde diferentes noticias (cuya única relación era pertenecer al dominio en que se enfocó el trabajo) e, incluso, se compararon textos que presentaban la misma noticia, pero extraídas de medios de prensa diferentes (para ello se trató a cada noticia como una única unidad textual). El prototipo superó todas estas pruebas y respondió de acuerdo a lo esperado. Una vez cumplida esta etapa, se prosiguió al siguiente paso de la investigación, que consistió en comparar los resultados de la evaluación del prototipo con la efectuada por humanos. Para realizar la experiencia se trabajó con seis textos extraídos desde los mismos medios periodísticos ya mencionados y se utilizó una muestra no probabilística de ocho evaluadores humanos. Cuatro de ellos fueron periodistas especializados en la producción de textos escritos y con experiencia en la redacción de noticias dentro del dominio denominado Periodismo Policial. Los otros cuatro sujetos fueron profesores de español, con estudios de postgrado en lingüística, en curso o finalizados. Esto con el fin de cubrir, por una parte, la experiencia en la producción de textos en el dominio citado (periodistas); y, por otro lado, tener la opinión de profesionales expertos en lingüística, ciencia en la que se estudia el fenómeno de la coherencia (profesores de español con estudios en lingüística). Con el fin de apoyar la tarea de los jueces humanos se creó un instrumento de medición que los guiara al evaluar la coherencia textual. Debido a que, como señala Álvarez (1995), no existe unanimidad entre los autores respecto a la extensión de los conceptos de coherencia y cohesión, se optó por una solución que se podría del texto y, también, a la percepción del fenómeno de la coherencia por el lector de un texto. Para ello se tomó como base el modelo propuesto por Álvarez (1995), que señala que los términos cohesión y coherencia aluden a la buena formación textual y que dicho autor desglosa en los fenómenos de recurrencia, progresión y conexión. En el instrumento se tomaron tres fenómenos pertenecientes a la recurrencia que son utilizados con frecuencia en los textos periodísticos: anáfora, sustitución léxica y correferencia sintagmática (se prescindió de la catáfora, porque no aparecía en los textos seleccionados para la experiencia). También se utilizó la progresión, específicamente la progresión con tema continuo, que es la habitual en un texto periodístico. Por otro lado, en el instrumento también se incluyó una pregunta en que se consulta al sujeto por su percepción de la coherencia del texto, basada esta percepción exclusivamente en su experiencia personal ya sea como lector o redactor de noticias. Para responder a las preguntas planteadas se le indicó a los sujetos que emplearan una escala de 1 a 7, con el objeto de facilitarles la respuesta, pues dicha escala 128 S. HERNÁNDEZ, A. FERREIRA es un referente que se supone arraigado en el imaginario colectivo. Además, debido al carácter técnico de conceptos como anáfora, sustitución léxica, correferencia sintagmática y progresión, se decidió incluir en el instrumento, previo a los textos a analizar, una breve explicación de los mencionados conceptos, con el fin de facilitar a los periodistas la identificación de los fenómenos a que aludían las preguntas. Esto, porque se consideró posible que en su formación como profesionales, no conocieran dichos fenómenos por su nombre técnico. Por otra parte, esto no significa un esfuerzo de comprensión demasiado grande para los individuos, pues los cuatro fenómenos se encuentran incluidos dentro de las competencias en producción de textos que un periodista debe desarrollar durante su formación de pregrado; pero al ser considerados dentro de un conjunto de competencias, cabía la posibilidad de que no los manejaran por el nombre que se les da en lingüística. 4. PRESENTACIÓN DE RESULTADOS Y ANÁLISIS DE RESULTADOS Debido a que la máquina evalúa los textos en una escala que va de 0 a 1, se transformaron las evaluaciones realizadas por los humanos (en escala de 1 a 7) a la escala utilizada por la máquina mediante la regla de tres simple. Para ambos resultados se utilizaron dos decimales. 4.1. Análisis general de resultados En la Tabla I se pueden ver los resultados asignados a cada uno de los seis textos por la máquina, así como por los evaluadores humanos: profesores de español especializados en lingüística y periodistas. Tabla I: evaluaciones finales de los seis textos de la prueba. Evaluador Texto 1 Texto 2 Texto 3 Texto 4 Texto 5 Texto 6 Máquina 0,57 0,72 0,42 0,54 0,71 0,44 Periodistas 0,60 0,69 0,54 0,57 0,68 0,48 Prof. Esp. 0,66 0,76 0,76 0,70 0,79 0,63 El Gráfico 1 permite apreciar de una mejor forma los resultados presentados en la tabla anterior. Se agregó al gráfico, para una mejor comprensión de los resultados, la evaluación etiquetada como humanos; dicha etiqueta corresponde al promedio entre profesores de español especializados en lingüística y periodistas. 129 RLA. Revista de Lingüística Teórica y Aplicada, 48 (2), II Sem. 2010 Gráfico 1: Evaluaciones finales de los seis textos de la prueba. Para comenzar el análisis de resultados hay que señalar que el hecho de obtener evaluaciones idénticas entre la máquina y los evaluadores humanos nunca formó parte de las metas del trabajo, sino que se pretendía observar si presentaban tendencias similares. Una segunda consideración previa es que, después de observar los resultados antes expuestos, salta de inmediato a la vista del observador que el llamado texto 3 se escapa a la tendencia general que arrojaron las mediciones realizadas. Por lo mismo, se efectuará un análisis detallado de ese caso específico más adelante, una vez realizado el análisis general de los resultados de la experiencia. Al comparar las mediciones realizadas por la máquina con las efectuadas por los periodistas, el estadístico arroja que se correlacionan positivamente, que esta correlación es considerada como fuerte (ver Fernández Collado, Hernández Sampieri y Baptista, 2003) y que, además, es significativa (r=.95, p=.003). A continuación se presentan las evaluaciones de la máquina y los periodistas en el Gráfico 2. Gráfico 2: Evaluaciones asignadas por la máquina y los periodistas. 130 S. HERNÁNDEZ, A. FERREIRA Como se puede ver en el Gráfico II, ambas líneas fluctúan de una forma similar y cercana, exceptuando el caso del texto 3. Si se comparan las mediciones realizadas por la máquina con las efectuadas por los profesores de español, el estadístico también arroja una correlación positiva, pero ésta disminuye considerablemente en relación a la comparación de la máquina con los periodistas, y sólo se la considera como una correlación positiva media. Además, en este caso, la correlación no es significativa (r=.54, p=.26). A continuación se presenta el gráfico que compara el movimiento de ambas evaluaciones. Gráfico 3: Evaluaciones asignadas por la máquina y los profesores de español. El gráfico anterior muestra que hay una gran diferencia en el caso del texto 3. Sin embargo, mirando con mayor atención es posible atisbar que, fuera de ese caso, las líneas de evaluaciones siguen tendencias parecidas. Sin embargo, en el caso del citado texto 3, la diferencia entre ambas evaluaciones es inmensa, aún mayor, incluso, que en el caso de la comparación de la máquina con los periodistas. Lo anterior representa una alteración grande en el comportamiento de ambas mediciones, que explica la baja correlación que se da entre las dos evaluaciones. Por último, se presenta la comparación de las mediciones hechas por la máquina y por los humanos (promedio de las mediciones de periodistas y profesores de español). En este caso, el estadístico también arroja que hay una correlación positiva, que se interpreta como una correlación positiva considerable y, además, es significativa (r=.85, p=.03). Los resultados se pueden ver en el Gráfico 4. 131 RLA. Revista de Lingüística Teórica y Aplicada, 48 (2), II Sem. 2010 Gráfico 4: Evaluaciones asignadas por la máquina y los humanos. Con lo hasta aquí expuesto, la evidencia indica que la evaluación de coherencia realizada por los periodistas es notablemente más cercana a la efectuada por la máquina, que la realizada por los profesores de español. Sin embargo, estos resultados hay que tomarlos con cautela. Si el problema se observa desde el punto de vista de que los periodistas son profesionales entrenados para producir el tipo de texto en cuestión –la noticia–, los resultados no deberían sorprender. A esto hay que agregar que los periodistas no sólo son expertos en la producción de textos noticiosos, sino que también, en muchas ocasiones, deben desempeñar la función de editar dichos textos, reparando, entre otros problemas, la coherencia del texto. Como ya se dijo, vista así la situación, y asumiendo que el prototipo es eficaz prediciendo la coherencia gracias al Análisis Semántico Latente, los resultados se ajustarían plenamente a lo esperado. Pero también hay que considerar que, si bien el periodista es el experto en la producción del tipo de texto en cuestión, el profesor de español con estudios de postgrado en lingüística es un profesional mucho más preparado aún en el fenómeno específico en que se enfoca este trabajo: la coherencia textual. Por lo mismo, el análisis hasta aquí hecho no es suficiente. 4.2. Análisis de resultados sin el texto 3 Con el objeto de poder clarificar el análisis de los datos obtenidos, es necesario revisar la situación del texto cuya evaluación se comporta en forma diferente. En la Tabla II se presentan los puntajes asignados por los evaluadores a dicho texto en particular. 132 S. HERNÁNDEZ, A. FERREIRA Tabla II: evaluaciones asignadas al texto 3. Evaluador Texto 3 Máquina 0,42 Periodistas 0,54 Prof. Esp. 0,76 Si se toma como referente la evaluación del prototipo, se tiene que éste le otorga un puntaje de coherencia de 0,42. De hecho, es el texto al que la máquina asigna la evaluación más baja de todos los considerados en la prueba. El grupo de periodistas evalúa en promedio el texto con un puntaje de 0,54; es decir, le asigna 0,12 puntos más que el prototipo. Por su parte, los profesores de español le asignan al texto en cuestión una evaluación promedio de 0,76; esto es, le otorgan 0,34 puntos más que la máquina. Lo anterior lo deja claramente como el caso disonante de la experiencia y, por lo tanto, es necesario analizar qué ocurrió. Para poder comprender cómo se originó el problema hay que atender a la conformación del corpus de entrenamiento, en base al cual se construyó el espacio semántico, a la luz del que se analizaron los textos de la prueba. Este corpus, como ya se indicó, lo forman 1.505 textos y todos corresponden a noticias del dominio denominado Periodismo Policial. Sin embargo, este dominio abarca temas diversos, como homicidios, violaciones, abusos sexuales, robos, hurtos, accidentes de tránsito, tráfico de drogas, entre otros. Ahora bien, el texto en cuestión es una noticia sobre un incendio. Por lo anterior, se revisó el corpus de entrenamiento con el fin de establecer en cuántos textos aparecía alguna palabra que contuviera la forma lematizada incendi. El resultado fue que en 72 de los 1.505 textos del corpus de entrenamiento se utilizaba alguna palabra que incluyera el lema en cuestión. Expresado como porcentaje del total de los textos, 72 equivale al 4,78%. Sin embargo, aún hay que realizar una distinción más, ya que de estos 72 textos, 43 correspondían al tema denominado en la prensa nacional como conflicto mapuche. Estos últimos textos tenían como tópico recurrente la quema de vehículos, de casas ubicadas en fundos o el portar artefactos incendiarios; además, muchas veces, simplemente aludían brevemente a un hecho anterior en que se utilizaba una palabra que incluía el lema incendi, con el fin de contextualizar una nueva noticia, que no se relacionaba con ningún tipo de incendio, sino que con alguna otra arista del conflicto mapuche. Sin contar estos 43 textos, las noticias del corpus que aluden a incendios en el sentido en que lo hace el texto 3, se reducen a sólo 29, lo que representa el 1,92% del total de noticias del corpus. Visto de esta forma el problema, y sin entrar a realizar más discriminaciones en estos 29 textos, se observa que representa un porcentaje muy pequeño del total, 133 RLA. Revista de Lingüística Teórica y Aplicada, 48 (2), II Sem. 2010 por lo que las posibilidades de aprendizaje del prototipo sobre el tema se reducen en forma considerable. Además, se presume que el hecho de que la mayoría de los usos del lema incendi se dé en el contexto de noticias relacionadas con el conflicto mapuche, provoca una distorsión en el aprendizaje del prototipo. Con el fin de indagar sobre la exactitud de lo recién expresado, se procesaron en el prototipo 30 textos, correspondientes a noticias pertenecientes al deporte y a espectáculos, extraídas de los mismos medios de prensa desde los que se obtuvieron los textos que se utilizaron para construir el corpus de entrenamiento. No se analizó previamente la coherencia de ninguno de estos textos, sino que simplemente se dejó el juicio al prototipo. Las evaluaciones obtenidas oscilaron desde 0,26 a 0,43, es decir, el prototipo calificó a todos los textos con un puntaje de coherencia bajo. Estos resultados eran predecibles, pues como ya se señaló en el punto sobre Análisis Semántico Latente, el método precisa para su correcto funcionamiento operar dentro de un dominio temático restringido. Sin embargo, con el fin de cotejar la pequeña prueba realizada, se tomó uno de los textos sobre deportes, específicamente sobre fútbol, y se le pidió a un periodista deportivo, especializado en noticias escritas, que lo analizara. Para ello se utilizó el mismo instrumento de medición que se empleó para los textos policiales, cambiando los seis textos anteriores por la noticia sobre fútbol. A los resultados obtenidos se les dio el mismo tratamiento que a los de la prueba realizada en las noticias policiales, es decir, se transformaron mediante una regla de tres simple a la escala que va de 0 a 1. La máquina evaluó la coherencia del texto con 0,27 y el humano con 0,74. Los resultados demuestran que las evaluaciones realizadas por el prototipo y por el periodista deportivo son absolutamente diferentes; de hecho, presentan una diferencia de 0,47 puntos. Por supuesto que la prueba recién expuesta no aspira de ninguna forma a ser representativa, sino que sólo se realizó con el objeto de tener más certeza sobre el punto de que el prototipo, y la técnica de Análisis Semántico Latente que emplea, no funciona en forma correcta fuera del dominio en que se enfoca, cuestión señalada por Foltz, Kintsch y Landauer (1998). De esta forma, se puede explicar que el problema ocurrido con el texto 3 de la prueba sucede a causa de la baja cantidad de noticias referidas al tema incendios en el corpus de entrenamiento y a la distorsión producida por el hecho de que más de la mitad de las noticias sobre dicho tópico pertenecían a un único tema: el conflicto mapuche. Al atender a los resultados de la prueba, sin considerar el texto 3, se obtiene: además, es significativa (r=.99, p=.001). güística hay una correlación positiva fuerte que, además, es significativa (r=.93, p=.02). 134 más, es significativa (r=.98, p=.002). S. HERNÁNDEZ, A. FERREIRA - Es decir, las correlaciones entre todas las parejas de evaluadores comparadas mejoran, así como la significación de dichas correlaciones. Lo más llamativo es el caso de los profesores de español, que al no considerarse las distorsiones producidas por el texto 3, pasan de una correlación positiva media que, además, no es significativa (r=.54, p=.26), a una correlación positiva fuerte que sí es significativa (r=.93, p=.02). A continuación se presentan en un gráfico los resultados generales, sin considerar el texto 3. Nuevamente, se agregó al gráfico la evaluación etiquetada como humanos, que corresponde al promedio entre profesores de español y periodistas. Gráfico 5: Evaluaciones finales de los textos de la prueba, sin considerar el texto 3. En el gráfico se puede ver con claridad cómo las cuatro líneas, sin ser plenamente coincidentes, fluctúan en forma análoga, lo que refleja el grado de acuerdo que hay entre las evaluaciones realizadas por el prototipo y los humanos. 4.3. Valoración de los resultados Una vez concluido el análisis de los resultados, se puede afirmar en relación al objetivo general de la investigación, que es “evaluar la coherencia de una noticia del dominio policial en forma automática”, que este objetivo se logró. En relación a la hipótesis de trabajo: “La evaluación automática de coherencia textual, utilizando la técnica del Análisis Semántico Latente, es equivalente a la evaluación humana en el dominio formado por las noticias policiales”, a la luz de 135 RLA. Revista de Lingüística Teórica y Aplicada, 48 (2), II Sem. 2010 los análisis realizados, se afirma que la hipótesis se sostiene. Esto pues, como ya se demostró, la evaluación automática de coherencia textual utilizando la técnica del Análisis Semántico Latente, es equivalente a la evaluación efectuada por humanos en el dominio formado por las noticias policiales. 5. CONCLUSIONES Al mirar en su conjunto el trabajo realizado, una de las primeras conclusiones que surge es que al sostenerse la hipótesis de trabajo y cumplirse el objetivo general de la investigación, se puede afirmar que la evaluación automática de coherencia textual, utilizando la técnica del Análisis Semántico Latente, es equivalente a la evaluación humana en el dominio formado por las noticias policiales. Esto abre la posibilidad de abordar algunos puntos planteados en la definición del problema que motivó la presente investigación. Por un lado, comprendiendo ya el funcionamiento del LSA, se puede sostener que el prototipo construido es eficaz no sólo en el dominio de las noticias policiales, sino que creando nuevos modelos a partir de corpus pertenecientes a otros dominios temáticos, podrían cubrirse otros campos noticiosos como deporte, política o espectáculos, por nombrar sólo algunos. Lo anterior, indudablemente, tiene una repercusión directa en la problemática que se planteó al inicio, pues una herramienta basada en la técnica del Análisis Semántico Latente sería un eficaz apoyo para mejorar los problemas de coherencia que se han producido en los medios de prensa en la actualidad, debido a la automatización del proceso de publicación, lo que ha llevado a la desaparición progresiva de la figura del corrector de pruebas. Un segundo punto destacable es que el prototipo construido fue desarrollado con herramientas de software libre, que se encuentra a disposición de todo el mundo en Internet, lo que implica que no se infringe ningún copyright para lograr una máquina de este tipo. A esto hay que agregar que el prototipo podría ser utilizado en cualquier otro dominio temático, simplemente cambiando el corpus de entrenamiento con el cual se construye el espacio semántico. Una tercera idea que surge es la necesidad de perfeccionar el corpus de entrenamiento del prototipo. Este perfeccionamiento debiera ir en dos sentidos. El primero de ellos es equilibrar el número de textos que tratan sobre los diferentes temas incluidos dentro del dominio, esto con el fin de evitar a futuro lo ocurrido con el denominado texto 3 utilizado en la experiencia. Es decir, por ejemplo, para el caso específico del dominio utilizado en el presente trabajo, los textos sobre homicidios, violaciones, abusos sexuales, atropellos, choques de vehículos, robos, hurtos, entre otros, debieran estar presentes en porcentajes similares dentro del corpus de entrenamiento. El segundo sentido en que se debiera perfeccionar dicho corpus es un poco más obvio, y no es otro que aumentar la cantidad total de textos 136 S. HERNÁNDEZ, A. FERREIRA que lo componen. Es obvio por el hecho de que, como ya se indicó, el LSA precisa para su óptimo funcionamiento de grandes corpus textuales y, mientras más textos posea, más posibilidades de aprendizaje tiene el software de LSA. Un cuarto aspecto a considerar, luego del trabajo realizado, es la posibilidad de mejorar el script en que se basa el prototipo. Si bien el utilizado cumple a cabalidad con lo que se propone, seguramente un profesional experto en informática podría perfeccionarlo aún más, aumentando su eficiencia en tiempo de procesamiento y consumo de recursos de la máquina en que opera. Por otro lado, es seguro que hay lenguajes de programación que superan lo que el intérprete de órdenes bash empleado es capaz de realizar. Por supuesto que lo anterior no pretende desmerecer en absoluto el trabajo realizado en el script que se construyó, pues el tiempo de procesamiento de éste es de alrededor de 10 segundos y el consumo de recursos es bajísimo; simplemente, lo que se señala, es la posibilidad de perfeccionarlo. Otro punto que surge es la necesidad de indicar que el prototipo, en principio, opera exclusivamente en un solo computador y que al ser un script no se puede instalar de la forma habitual en otro equipo. Al decir forma habitual se alude a la forma en que acostumbra a hacerlo un usuario de Windows: ejecutar un archivo con extensión .exe y seguir las instrucciones en pantalla (se emplea el sistema operativo de Microsoft como ejemplo, ya que a diciembre de 2009 sus diferentes versiones de Windows se utilizan en el 88% de los computadores del mundo, según las estadísticas de w3schools.com). Como ya se indicó, el script, corazón del prototipo, es, en palabras sencillas, un extenso conjunto de instrucciones para todos los programas que se utilizan: lematizador, aplicación de LSA, editor de flujo de texto, etc. Por lo anterior, para que funcionara en otro computador se requeriría que en dicho equipo estuvieran instalados todos los programas utilizados y, muchos de ellos, sólo corren en Linux. Sin embargo, es posible habilitar el prototipo en un servidor basado en Linux y conectarse a él en forma remota, ya sea a través de Internet o de una intranet. Para esto no es necesario que el computador desde el que se conecten tenga instalado Linux, de hecho serviría cualquier computador con Windows, por ejemplo, con el único requisito que tenga conexión a Internet (o a una intranet en la que esté el servidor). Por supuesto que el procedimiento sería el mismo que seguiría alguien que estuviera frente al computador en que opera el prototipo, esto es colocar el texto a analizar en el archivo llamado texto_entrada y ejecutar el script. Lo anterior con la dificultad adicional de que todo esto debe ser realizado mediante comandos de texto ingresados desde una terminal remota (en Windows se puede emular la terminal en forma remota mediante un software como Putty). Sin embargo, el procedimiento se podría simplificar considerablemente si la interacción con el servidor que alberga el prototipo se realizara a través de una interfaz amigable, como puede ser una página web especialmente habilitada para ello. En ésta se podría incluir un campo de formulario para ingresar el texto a analizar y un botón que, al ser presionado por el usuario, desencadenara 137 RLA. Revista de Lingüística Teórica y Aplicada, 48 (2), II Sem. 2010 una orden que le indique al servidor que dicho texto lo guarde en un archivo llamado texto_entrada y luego que ejecute el script. Finalmente podría mostrar la salida, es decir, la evaluación de coherencia resultante dentro de la misma página. Incluso, yendo un poco más allá, se podría incluir –teniendo los scripts necesarios para ello–, la posibilidad de que el usuario elija el tipo de segmentación a utilizar, por ejemplo: oraciones o párrafos. REFERENCIAS Álvarez, Gerardo. 1995. Textos y discursos. Tercera edición. Concepción: Universidad de Concepción. Boonthum, C., Levinstein, I., & McNamara, D.S. 2007. “Evaluating self-explanations in iSTART: Word matching, latent semantic analysis, and topic models”. En A. Kao & S. Poteet (Eds.) Natural Language Processing and Text Mining. Londres: Springer-Verlag UK, pp. 91-106. Deerwester, S., Dumais, S. T., Furnas, G. W., Landauer, T. K., y Harshman, R. 1990. “Indexing by Latent Semantic Analysis”, en Journal of the American Society For Information Science, 41, pp. 391-407. Citado en Venegas, René. 2003. “Análisis Semántico Latente: una panorámica de su desarrollo”, en Revista Signos, vol. 36, N° 53, pp. 121-138. ISSN 0718-0934. De Vega, Manuel; Díaz, José Miguel y León, Inmaculada. 1999. “Procesamiento del discurso”. En Cuetos, Fernando y De Vega, Manuel (compiladores) Psicolingüística del español. España: Trotta, pp. 273. Fernández Collado, C., Hernández Sampieri, R. y Baptista, P. 2003. Metodología de la investigación. México: McGraw-Hill Interamericana. Foltz, P., Kintsch, W. y Landauer, T. 1998. The measurement of textual coherence Franco, Guillermo. 2008. Cómo escribir para la Web. University of Texas: Knight Center of Journalism. Free Software Foundation. 2010. The free software definition. [En línea] Disponi Jurafsky, Daniel y Martin, James. 2008. Speech and language processing, 2ª edición. USA: Prentice Hall, pp. 683, 689. Landauer, T. 2002. On the computational basis of learning and cognition: Ar138 S. HERNÁNDEZ, A. FERREIRA Ross-final-submit.pdf [Consulta: 12-09-2008]. Landauer, T.; Foltz, P. y Laham, D. 1998. “An Introduction to Latent Semantic Analysis. Discourse Processes”. Citado en Venegas, René. 2003. “Análisis Semántico Latente: una panorámica de su desarrollo”, en Revista Signos, vol. 36, N° 53, pp. 121-138. ISSN 0718-0934. Leñero, Vicente y Marín, Carlos. 1986. Manual de periodismo. México: Editorial Grijalbo. Martínez Albertos, José Luis. 2004. Curso general de redacción periodística, 5ª edición, 3ª reimpresión. Madrid, España: Editorial Paraninfo. McCarthy, P.M., Briner, S.W., Rus, V., & McNamara, D.S. 2007. “Textual signatures: Identifying text-types using latent semantic analysis to measure the cohesion of text structures”. En A. Kao, & S. Poteet (Eds.) Natural language processing and text mining. Londres: Springer-Verlag, pp. 107-122. Singer, Murray y Zwaan, Rolf. 2003. Text comprehension. En Graesser, Arthur; Gernsbacher, Morton Ann y Goldman, Susan (compiladores) Handbook of discourse processes. Mahwah, USA: Lawrence Erlbaum Associates. Venegas, René. 2003. “Análisis semántico latente: una panorámica de su desarrollo”. Revista Signos, vol. 36, N° 53, pp. 121-138. ISSN 0718-0934. 139