Algunas Nociones de Estadística _v.4.2.4_2009

Anuncio

UNIVERSIDAD NACIONAL DE SAN LUIS

FACULTAD DE CIENCIAS HUMANAS

DOCUMENTO DE CIRCULACIÓN INTERNA

ALGUNAS ИOCIONES DE ΣSTADÍSTICA

FABRICIO PENNA & SILVIA HUARTE

MMIX

(v. 4.2.4)

Págin@ 2

ÍNDICE

1. Introducción..........3

2. Estadística y Probabilidad..........6

2.1- Algunos Conceptos Previos..........8

2.2- Definiciones de Probabilidad..........8

2.3- Ley de los Grandes Números..........9

2.4- Distribución Normal: principales características..........11

3. Estadística Descriptiva..........14

3.1- Universo, Población y Muestra..........14

3.1a Tamaño de la Población..........15

3.1b Tamaño de la Muestra..........15

3.2- Factores y Niveles de Medición..........17

3.3- Distribución Empírica..........21

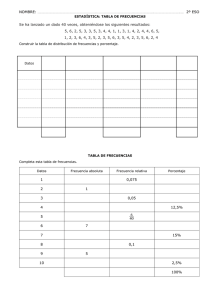

3.4- Presentación de Datos: Tabla de Frecuencias..........23

3.5- Representaciones gráficas de las distribuciones empíricas: Histograma y Polígono de

frecuencias relativas acumuladas..........25

4. Estimadores descriptivos de una distribución empírica..........26

4.1- Fractiles: Cuartiles, Deciles y Percentiles o Centiles..........27

4.2- Medidas de Tendencia Central: Media Aritmética, Mediana y Moda ó Modo..........27

4.3- Medidas de Dispersión: Rango ó recorrido, Semi Rango, Varianza, Desviación Estándar, MAD y Coeficiente de Variación..........29

4.4- Coeficiente de Asimetría o Sesgo..........30

4.5- Coeficiente de Aplanamiento o Curtosis..........33

5. Regresión lineal simple..........34

5.1- Método de mínimos cuadrados..........35

5.2- Líneas de regresión..........37

5.3- Limitaciones del método..........38

5.4- Relaciones no lineales: Transformaciones..........39

6. Análisis de Correlación..........41

6.1- Coeficiente de Correlación “producto–momento” de Pearson (rxy)..........41

6.2- Calculo del Coeficiente rxy sin dispersograma..........43

6.3- Coeficiente de Determinación (R2)..........45

6.4- Prueba de “Ji” cuadrado (χ2)..........46

6.4a Clasificación..........46

6.4b Tablas de contingencia..........46

6.4c Cálculo de χ2..........47

6.4d Corrección de Yates..........47

7. Nociones de Estadística Sanitaria..........48

7.1- Demografía..........48

7.2- Censo..........48

8. Anexo 1: Simbología utilizada..........50

9. Anexo 2: Tabla de Distribución χ2..........51

10. Anexo 3: Tabla de Distribución Normal Estandarizada.......... 52

11. Bibliografía Consultada..........53

Fabricio Penna & Silvia Huarte

Págin@ 3

1. INTRODUCCIÓN

Para mí, no es un científico aquel que se vale de herramientas y métodos “científicos”, ni el que de alguna manera

aprendió a usarlos. Pongo dentro de la categoría a quienes

poseen verdaderamente una “mentalidad científica”.

ALBERT EINSTEIN

Es un hecho bien conocido que para incrementar los conocimientos que se tienen sobre el mundo

es necesario emplear cada vez más los métodos y las inferencias estadísticas. Para realizar investigaciones, en casi todas las disciplinas se requieren ciertos rudimentos de estadística. Sin embargo, debido a la amplitud y profundidad de la temática, es conveniente seleccionar el campo de

conocimiento y los métodos pertinentes según sea la finalidad que se persigue.

Existen varias definiciones de estadística: se la define como la ciencia que trata los problemas

que comprenden variaciones casuales, resultantes de un sinnúmero de influencias pequeñas e

independientes que operan en cada resultado medido que se obtiene; asimismo, se dice que es la

ciencia de la toma de decisiones a partir de datos, de manera que la confiabilidad de las conclusiones con base en éstos se valora mediante la probabilidad. De modo más general, la estadística

es una ciencia que comprende la recopilación, tabulación, análisis e interpretación de los datos

cuantitativos y cualitativos; este proceso incluye determinar los atributos o cualidades reales, al

igual que realizar estimaciones y verificar hipótesis mediante las cuales se determinan valores

probables o esperados. Otra definición, siguiendo a M.G. Kendall (The Statistical Aproach,

1950), establece que la estadística es un método general, un lenguaje común referido a conjuntos

y sus relaciones, que sirve para obtener conclusiones probabilísticas de poblaciones conocidas,

con la increíble capacidad −por su carácter genérico− de traspasar la frontera de las diferentes

ciencias.

El carácter genérico unido a la preocupación por formalizar la validez de los resultados, es aquello que sitúa a la estadística en la intersección con el resto de las ciencias y le da un carácter insustituible de “instrumento” del método científico.

Una de las discusiones interesantes la propone M.G. Kendall (op.cit.) distinguiendo entre matemática y estadística como: la ciencia de la “certeza” y la ciencia de la “incertidumbre” respectivamente. Caracterizando a la estadística como una ciencia que busca establecer los límites de la

incertidumbre y no más como una rama de la matemática.

También B. Russell (Human Knowledge – Its Scope and Limits, 1977), referido a la inferencia

estadística, agrega que ésta difiere de la lógica deductiva y la matemática ya que cuando las premisas son verdaderas y el razonamiento es correcto, la conclusión es solo probable.

Fabricio Penna & Silvia Huarte

Págin@ 4

Podemos agregar, a modo de ejemplo, que a pesar de cierta “similitud” con la matemática difiere

de ésta de la siguiente manera: en matemática pura, los valores son exactos, esto es, una variable

tiene un valor particular (la probabilidad de que así ocurra es igual a la unidad, dado que estamos

seguros de ello), o bien, no lo tiene (la probabilidad en este caso, es cero, ya que estamos seguros

ahora de que la variable no tiene –o no toma– tal valor). Sin embargo, en estadística, la variable

puede asumir infinitos valores posibles y existe una probabilidad definida de que adquiera tales

valores. Dicha probabilidad puede comprender cualquier valor entre 0 y 1. Mediante la estadística se intenta definir y controlar el grado de incertidumbre que surge de la inevitable variabilidad

de los datos.

La estadística se enfrenta a dos tipos básicos de problemas: los descriptivos y los inferenciales.

Los primeros se refieren a la presentación de conjuntos de observaciones, de manera tal que se

puedan comprender e interpretar. Las características numéricas empleadas (o índices) para describir los conjuntos reciben el nombre de estadísticos. Los problemas inferenciales son los que

comprenden generalizaciones inductivas, esto es: a partir de una muestra puesta a prueba en la

realidad, los resultados obtenidos son “llevados” hasta el grupo del cual se obtuvo la misma. La

inferencia estadística permite conseguir la máxima cantidad de información exacta de una prueba

dada, en otras palabras, el empleo de valores estadísticos hace más eficientes las pruebas.

En las ciencias, como en la investigación experimental, el empleo de estadísticos casi siempre es

necesario cuando se efectúan pruebas rutinarias de laboratorio, al igual que en trabajos de investigación.

En una investigación experimental, quizá se quiera saber si las pruebas son “precisas”, o si la

variabilidad de los resultados es mayor que lo esperado, o mayor que en cualquiera otra prueba.

En la investigación de ciertos productos, tal vez se desearía conocer si un cambio en los ingredientes afecta las propiedades del mismo; comparar la eficacia de los procesos o la eficiencia de

un ensayo; determinar si los resultados se adaptan a una forma supuesta o postulada; o bien, idear un experimento que permita considerar la variación debida a diversas causas.

Esto último también se requiere en la producción, dado que el conocimiento de la variación en

las observaciones, causada por un cierto factor, nos capacita para saber si, por términos económicos, es conveniente controlar más estrechamente este factor. Además, quizá se desee averiguar

la probabilidad de obtener un resultado por encima o por debajo de cierto valor; verificar si la

producción ha sufrido alteraciones que modifiquen esta probabilidad; determinar la proporción

de elementos que presentan cierto atributo o cualidad; o saber qué tamaño de muestra es necesario emplear con el fin de que las conclusiones posean una confiabilidad específica.

Fabricio Penna & Silvia Huarte

Págin@ 5

Existen dos tipos básicos de variables que resultan de interés para nuestro estudio: las variables

continuas, las cuales difieren en cifras infinitesimales, y las variables discretas que sólo pueden

tener valores específicos (enteros), pero no intermedios entre ellos. Tales conceptos deben ser ya

conocidos, pues pertenecen a las matemáticas básicas y son útiles, dado que ambos tipos de variables, por lo regular, siguen diferentes distribuciones o leyes de comportamiento. El término

distribución se refiere a la frecuencia con la que se presentan diversos valores observados.

Dichos “diversos valores” pueden obtenerse de dos maneras. Se puede medir varias veces una

cierta propiedad, por ejemplo, la dimensión de un objeto particular. Dados los errores de medición que se cometen, no siempre se obtendrán exactamente los mismos valores. El segundo caso

ocurre cuando se presentan factores que deban tener una cierta propiedad en común, por ejemplo, la misma dimensión. Como por lo general se presentan variaciones, al igual que errores de

medición, los valores registrados también varían. En ambos casos, si se realizan algunas observaciones, se obtienen resultados que difieren entre sí, y una de las principales funciones de la

estadística es evaluar la información de este tipo, de modo que se pueda estimar el “mejor” valor

de la cantidad sometida a medición y determinar la precisión del cálculo.

La distribución de las variables discretas es de interés principalmente en el caso de problemas en

los que intervengan objetos que posean o no una cierta característica: ser de color determinado o

no, con defectos o sin ellos, presentar o no una característica superior a un valor esperado, etc.

Es pertinente mencionar que a fin de llevar a cabo un análisis estadístico, las variables discretas y

las continuas no están separadas entre sí de manera inevitable. Si los valores de una variable que

está distribuida continuamente se agrupan en intervalos y después se les da un tratamiento en

grupos, el problema se convierte, en esencia, en uno de tipo de “variables discretas”. Por el contrario, cuando una de estas últimas variables está constituida por una gran cantidad de clases y se

la determina muchas veces, su distribución se aproxima a la de una “variable continua” y a menudo resulta conveniente emplear dicha aproximación.

En el análisis estadístico se denomina variable estadística a la magnitud que varía, y puede ser la

variable original o una cantidad derivada de ella como la media de muestras, su desviación

estándar o su varianza, etc.

En múltiples problemas de tipo práctico es imposible probar u observar la totalidad de los elementos que intervienen (los cuales constituyen una población o un universo) y, por consiguiente,

es necesario recurrir al muestreo. Así pues, se miden o consideran las propiedades de una muestra con el objeto de estimar las características de todos los elementos (población) de los cuales se

extrajo la muestra. La inferencia a partir de muestras es de gran valor en muchos campos, y va

Fabricio Penna & Silvia Huarte

Págin@ 6

desde comprobar si un embarque de mercancías cumple con las especificaciones, hasta predecir

los resultados de unas elecciones. Las experiencias obtenidas de este último tipo de problemas

nos hace percatar de que no sólo es conveniente tomar la muestra representativa de la población

subyacente, sino también de que la conclusión a la que lleguemos es sólo probablemente correcta, pues no se puede tener una certeza total con base en el muestreo.

Esto se debe a que varían entre sí las muestras extraídas de la población o grupo de elementos, y

la variación es propia de todos los fenómenos naturales. Por este motivo, la inferencia estadística

se presenta en términos de enunciados de probabilidad.

Mediante un programa adecuado se puede obtener mayor información de un cierto trabajo experimental que si se llevaran a cabo pruebas al azar o por simple casualidad, y sólo después se emplearía la estadística. Por ello, debemos considerar a esta ciencia no sólo como un instrumento

útil para la interpretación de resultados experimentales, sino como parte integrante del diseño de

experimentos.

2. ESTADÍSTICA y PROBABILIDAD

De lo anterior se deduce que los sujetos de estudio de la estadística y la probabilidad están fundamentalmente relacionados entre sí. En tanto que la estadística se interesa en gran medida en

deducir conclusiones a partir de muestras alteradas por variaciones aleatorias o incertidumbres,

sólo mediante la teoría de la probabilidad se pueden definir o expresar, así como controlar, tales

incertidumbres en los resultados. Se dice que las variaciones son al azar (o aleatorias) cuando no

presentan un determinado patrón de conducta o regularidad.

La relación entre una muestra y la población puede servir para dilucidar la diferencia existente

entre la estadística y la probabilidad. Tal relación plantea dos problemas generales: la verificación de una hipótesis estadística y la estimación de uno o varios parámetros característicos de la

población. En el primer caso nos interesa saber si a partir de los ensayos o pruebas se puede concluir que una muestra observada pertenece a una población particular (la hipótesis) o si no es

posible servirse de ella para llegar a tal conclusión. Dadas las inherentes variaciones casuales

existentes en una muestra, no se puede tener una completa seguridad acerca de nuestra conclusión y, por consiguiente, debemos vincularla a un enunciado probabilístico.

Al considerar el problema de la estimación, se intenta evaluar uno o varios parámetros de la población mediante “buenos” estimadores muestrales; una vez más, debido a la variación inherente

de una muestra a otra, es imposible estar seguro de que el cálculo es correcto, de ahí que deba

asignarse una “banda” de probabilidad. Tal banda proporcionará un grado de confianza específi-

Fabricio Penna & Silvia Huarte

Págin@ 7

co acerca del hecho de que el valor verdadero del parámetro de población caiga dentro de los

límites de confianza.

En determinados problemas es posible establecer una clara diferencia entre estadística y probabilidad. Por ejemplo, si se conocen los parámetros de la población a partir de un registro anterior,

puede deducirse la conducta del componente, o muestra, que se supone forma parte de la misma,

por lo tanto, se tiene así un problema de probabilidad. Sin embargo, si un determinado parámetro

(o parámetros) de la población es desconocido, y tiene que ser estimado a partir de la muestra, se

tiene entonces un problema estadístico. Cabe mencionar que la teoría de la probabilidad se basa

en leyes de casualidad o aleatoriedad; de ahí que, las muestras deben ser de naturaleza aleatoria.

Una muestra es al azar o aleatoria cuando cada elemento de la población tiene la misma probabilidad de ser elegido para componer la muestra. Obviamente, si se habrá de juzgar la población (el

todo) a partir de una muestra (la parte), esta última deberá ser tan representativa de la población

como sea posible.

Antes de comenzar a definir algunos conceptos, vamos a plantearnos la siguiente experiencia:

“levantar, con la mano, un vaso de vidrio a un metro del suelo y luego soltarlo”, donde, para evitar especulaciones, dicha experiencia se realiza manteniendo las condiciones de gravedad de

nuestro planeta y el piso es de cemento. En dicha experiencia se encuentran presentes dos “componentes”:

-

La primera, llamada “determinística”, es aquella que nos asegura que al soltar el vaso, éste

cae al suelo (hasta el momento, nunca ocurrió lo contrario).

-

La segunda, llamada “probabilística”, es aquella que nos asegura que, una vez que el vaso

cae al suelo, éste puede romperse o no.

De la segunda “componente” es de la cual nos vamos a ocupar de acá en adelante. Podemos considerar, entonces, al Cálculo de Probabilidades como:

Un área del Conocimiento que se ocupa de fenómenos aleatorios −también llamados al azar o

probabilísticos− es decir, se ocupa de medir o determinar la posibilidad de que ocurra un determinado hecho o suceso.

Sin detenernos demasiado en la historia, podemos decir que las Probabilidades “nacen” alrededor

del siglo XVI, como un intento de responder a varias preguntas que surgían en los juegos de

azar. Siendo algunos de sus máximos exponentes: el italiano Cardano (s.XVI); los franceses Pascal, Fermat (s.XVII), De Moivre (s.XVII – s.XVIII) y Laplace (s.XVIII – s.XIX); los rusos Kolmogorov y Smirnov (s.XX), entre otros.

Fabricio Penna & Silvia Huarte

Págin@ 8

2.1- ALGUNOS CONCEPTOS PREVIOS

Espacio Muestral: es el conjunto de todos los resultados posibles de un proceso experimental u

observacional y lo denotamos con la letra griega Omega mayúscula (Ω).

Ejemplo 1: si se arrojan simultáneamente 3 (tres) monedas “balanceadas” o “no cargadas” [definiendo K = Cara y Z = Cruz], los posibles resultados de dicha experiencia están dados en el siguiente conjunto: Ω = {KKK, KKZ, KZK, ZKK, ZZK, ZKZ, KZZ, ZZZ}.

Punto muestral: son cada uno de los elementos que pertenecen al conjunto Ω y lo denotamos con

la letra griega Omega minúscula (ω). Tomando el ejemplo 1, un punto muestral puede ser: ω =

(KKZ), donde la interpretación es: “al tirar 3 monedas, la primera y segunda son caras y la tercera, cruz”.

Evento: es cualquier sub−conjunto del espacio muestral Ω y los denotamos con letras mayúsculas de nuestro alfabeto: A, B, C, ..., Z. Para el ejemplo 1, el evento A puede ser: A = {KKK,

KKZ, KZK, ZKK}. Dicho evento se interpreta como: “al tirar 3 monedas, A es el evento que al

menos dos de ellas sean cara”.

Eventos Mutuamente Excluyentes: se dice que dos eventos A y B, pertenecientes al espacio

muestral Ω, son mutuamente excluyentes si no tienen elementos en común. Siguiendo con el

ejemplo 1, nuestros dos eventos mutuamente excluyentes son: A = {KKK} y B = {XXX}.

2.2- DEFINICIONES DE PROBABILIDAD

Concepto Clásico de Probabilidad (Laplace)

Dado el evento A ε Ω [A “pertenece” al espacio muestral Ω], la probabilidad de ocurrencia de

dicho evento está dada por:

P(A ) =

número de resultados favorables a la ocurrencia de A

número de resultados posibles

(1)

Nota: la primera restricción es que todos los “resultados posibles” sean igualmente probables y la segunda es que no

puede aplicarse cuando el número de “resultados posibles” sea infinito.

Concepto Frecuencial de Probabilidad: Si A es un evento ε Ω y fA el número de ocurrencias del

evento A en N repeticiones independientes del experimento, entonces la probabilidad de ocurrencia del mencionado evento es:

P ( A) =

fA

N

(2)

Cuando N crece “infinitamente” (o lo que es lo mismo decir que el número de repeticiones es

muy grande).

Fabricio Penna & Silvia Huarte

Págin@ 9

A partir de los conceptos de probabilidad presentados anteriormente, el investigador puede asegurar que si el evento E es obtener “cruz” al arrojar una moneda (balanceada), la probabilidad de

ocurrencia de dicho evento, P(E), va a ser el resultado que se obtiene al realizar el cociente entre

el número de casos favorables (igual a 1, ya que la moneda tiene una sola cruz) y el número de

casos posibles (igual a 2, ya que una vez arrojada la moneda, ésta puede caer de cara o de cruz);

lo que nos lleva a que la P(E = obtener una cruz) = 0,5.

Frente al resultado obtenido, ¿podríamos ser taxativos y afirmar que si arrojamos 10 monedas (o

una moneda 10 veces), obtendremos 5 caras y 5 cruces?, o que ¿el arrojar 20 monedas, nos lleva

a obtener 10 caras y 10 cruces?

Como respuesta a lo recién expuesto corresponde un rotundo NO ya que, de acuerdo a lo planteado al comienzo, estamos frente a procesos probabilísticos y no determinísticos.

Bien, ahora quedamos más mareados que nunca, ya que por un lado podemos gritar a viva voz

que cuando arrojamos una moneda, P(obtener una cruz) = 0,5 (valor que corresponde a la mitad

de la experiencia); pero al arrojar más de una moneda, estamos en condiciones de decir nada.

¿Entonces...?

Quien nos va a ayudar frente a éste dilema, es una de las leyes más (o tal vez la ley más) importante del cálculo de probabilidades: la ley de los grandes números.

2.3- LEY DE LOS GRANDES NÚMEROS

Como se vio, el concepto de Laplace sirve para calcular probabilidades frente a experimentos

ideales en los cuales se da por sentado que los resultados son equiprobables, sin embargo en la

realidad esto no es así; pero, ésta ley afirma que la frecuencia relativa de un evento, cuando el

número de experiencias se hace muy grande (tiende a infinito), se estabiliza en torno a un valor

que es la probabilidad del evento, P(E). También se conoce como ley fundamental del azar.

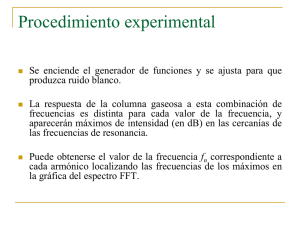

Los gráficos siguientes, realizados a partir de un proceso de simulación, nos muestran la probabilidad de aparición de una cruz a medida que aumentan las tiradas de una moneda (balanceada):

Fabricio Penna & Silvia Huarte

Págin@ 10

Gráfico 1: 10 tiradas de una moneda

Gráfico 2: 50 tiradas de una moneda

Gráfico 3: 100 tiradas de una moneda

Gráfico 4: 250 tiradas de una moneda

Gráfico 5: 500 tiradas de una moneda

Gráfico 6: 1000 tiradas de una moneda

Como podemos notar en los gráficos precedentes, y de acuerdo a lo establecido por la Ley de los

Grandes Números, dado el evento E = aparición de una cruz al arrojar una moneda, P(E) recién

comienza a estabilizarse alrededor de 0,50 cuando el número de repeticiones supera las 250

(Gráfico 4), es decir que P(E = aparición de una cruz) = 0,50 para un número grande de repeticiones.

Concepto de Probabilidad (según Kolmogorov)

Sea Ω un espacio muestral y sean los eventos A1, A2, ..., Ak ε Ω ⇒ se cumplen los siguientes

axiomas:

a) Axioma de certeza: P(Ω) = 1 [la probabilidad de ocurrencia del espacio muestral Ω, vale 1].

Fabricio Penna & Silvia Huarte

Págin@ 11

b) Axioma de positividad: P(A) ≥ 0 [la probabilidad de ocurrencia de un evento A ε Ω, es

siempre mayor o igual a cero].

c) Axioma Suma de Probabilidades: La probabilidad de ocurrencia de A1 o A2 o de ambos en la

misma repetición, está dada por:

P(A1 o A2) = P(A1 ∪ A2) = P(A1 + A2) = P(A1) + P(A2) – P(A1.A2)

(3)

Donde P(A1.A2) es la ocurrencia simultánea de los eventos A1 y A2

Si dichos eventos son mutuamente excluyentes ⇒ P(A1.A2) = 0, entonces la expresión (3) se

reduce a:

P(A1 + A2) = P(A1) + P(A2)

(4)

Nota: es presente axioma es generalizable para k número de eventos, A1, A2, ..., Ak.

d) Axioma Producto de Probabilidades: La probabilidad de ocurrencia de A1 y A2 en forma

simultánea, está dada por:

P(A1 y A2) = P(A1 ∩ A2) = P(A1.A2) = P(A1).P(A2/A1) = P(A2).P(A1/A2)

(5)

Donde P(A2/A1) y P(A1/A2), son las probabilidades condicionadas de A2 habiendo ocurrido

A1 y de A1 habiendo ocurrido A2, respectivamente.

Si los eventos A1 y A2 son estadísticamente independientes, P(A2/A1) = P(A2) y P(A1/A2) =

P(A1). Entonces la expresión (5) se puede escribir como:

P(A1.A2) = P(A1).P(A2)

(6)

Nota: es presente axioma es generalizable para k número de eventos, A1, A2, ..., Ak.

2.4- DISTRIBUCIÓN NORMAL: PRINCIPALES CARACTERÍSTICAS

Esta función tiene gran importancia teórica tanto en problemas de tipo biológico como físicos,

psicológicos, químicos, fonoaudiológicos, etc. La distribución normal (también conocida como

distribución de Laplace – Gauss, campana de Gauss o, simplemente, Gaussiana), tiene su origen

entre los siglos XVII y XVIII como primera aproximación al comportamiento de los errores

pues, investigadores como De Moivre, Laplace y Gauss, encontraron cierta “regularidad” en los

mismos. Esto motivó que, en sus comienzos, a dicha curva se conociese como “curva normal de

errores”.

A esta distribución se la utiliza en presencia de variables continuas tales como peso, altura, edad,

CI, IMC, etc., y su expresión matemática, a partir de una variable continua x, se la define como:

Fabricio Penna & Silvia Huarte

Págin@ 12

1 x−µ

σ

− ∞ < x < ∞

− ∞ < µ < ∞

donde σ > 0

e ≅ 2,71

π ≅ 3,1415

2

−

1

f (x ) =

e 2

σ 2π

(7)

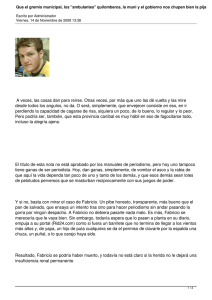

Siendo su representación gráfica, la siguiente:

Gráfico 7: Función de Densidad Normal

Densidad

0.40

0.30

99% (aprox)

0.20

95% (aprox)

0.10

68% (aprox)

x

0.00

−∞

µ−3σ

µ−2σ

µ−σ

µ

µ+σ

µ+2σ

µ+3σ

+∞

Variable x

Esta curva depende, básicamente, de los parámetros µ (media aritmética o esperanza matemática) y σ2 (varianza). Por este motivo, dada una variable aleatoria X, distribuida normalmente y

caracterizada por su media µ y su varianza σ2, se la puede expresar como:

(

X ≈ N µ, σ 2

)

(8)

Donde, algunas de sus características son las siguientes:

•

•

•

•

•

•

•

•

Es una curva unimodal

El valor de la moda coincide con los valores de la media y la mediana.

Presenta una forma de campana

Es unitaria (el área bajo la curva vale 1)

Es simétrica respecto a su media µ

Es asintótica respecto al eje horizontal (se aproxima sin llegar a tocarlo)

Los puntos de inflexión (donde la curva cambia su concavidad) se encuentran en µ-σ y µ+σ

El área, bajo la curva, comprendida en el intervalo (µ-σ, µ+σ) es aproximadamente igual a

0,68 (68%); entre (µ-2σ, µ+2σ) es aproximadamente igual a 0,95 (95%) y entre (µ-3σ,

µ+3σ) es aproximadamente igual a 0,99 (99%), como vemos en el Gráfico 7.

Fabricio Penna & Silvia Huarte

Págin@ 13

ESTANDARIZACIÓN

Como se deduce del párrafo anterior, no existe una única distribución normal, sino una familia

de distribuciones con una forma común, diferenciadas por los valores de su media (µ) y su varianza (σ2). Es por eso que, si necesitáramos determinar una “porción de área” bajo la curva,

tendríamos que realizar engorrosos cálculos matemáticos (integrales) para cada curva normal.

Mediante la siguiente transformación, se lleva la variable original de puntajes x a puntajes z:

(

)

x−µ

(

)

x−µ

X ≈ N µ, σ 2 ⇒ Z =

X ≈ N µ, σ 2 ⇒ Z =

σ2

S2

≈ N(0, 1) , para puntajes Z de una población

(9)

≈ N(0, 1) , para puntajes Z de una muestra

(10)

Nota: hay casos particulares en los que, trabajando con una muestra, se conoce la varianza de la población. En estos

casos, es aconsejable estandarizar la variable utilizando la varianza poblacional (σ2) en lugar de la varianza muestra

(S2) pues, como se sabe, la primera es exacta en cambio la segunda es aproximada.

Esta propiedad resulta especialmente interesante en la práctica, ya que para una distribución

N(0,1) existen tablas (ver Anexo 3) a partir de las que se pueden obtener, de modo sencillo, la

probabilidad de observar un dato menor o igual a un cierto valor z, y que permitirán resolver

preguntas de probabilidad acerca del comportamiento de variables de las que se sabe o se asume

que siguen una distribución aproximadamente normal.

De acuerdo a lo expresado por Hernández Sampieri y cols (1997), “una puntuación z nos indica

la dirección y grado en que un valor individual obtenido se aleja de la media, en una escala de

unidades de desviación estándar”.

Frente a la transformación realizada en (9) o (10), según corresponda, la curva normal teórica se

reduce a la siguiente expresión:

f (z) =

1

2π

e

1

− .Z2

2

Siendo su representación gráfica, la siguiente:

Fabricio Penna & Silvia Huarte

− ∞ < z < ∞

µ = 0 ; σ = 1

donde

e ≅ 2,71

π ≅ 3,1415

(11)

Págin@ 14

Densidad

Gráfico 8: Función de Densidad Normal Estandarizada

0.40

0.30

0.20

0.10

0.00

-3

-2

-1

0

1

2

3

Variable z

De acuerdo a la estandarización realizada, y por lo visto en la expresión (11), la media de la distribución (µ) toma el valor 0 y la varianza (σ2) el valor 1. A partir de esto, se mantienen las características presentadas para el Gráfico 7 solo que, dicha curva es simétrica respecto del valor 0

y los puntos de inflexión se encuentran en -1 y 1.

3. ESTADÍSTICA DESCRIPTIVA

La estadística descriptiva resuelve la etapa de tabulación y descripción de resultados de experimentos aleatorios de la investigación estadística. Ésta se basa en el conjunto de definiciones siguientes:

3.1- UNIVERSO, POBLACIÓN Y MUESTRA

Universo (U): es un grupo específico de sujetos u objetos de los que se trata de estudiar una característica particular. Por ejemplo un universo puede ser el conjunto de estudiantes universitarios inscriptos en una Facultad durante cierto semestre.

Población (N): es la totalidad de valores posibles de una característica particular de un universo.

Para el universo de “estudiantes universitarios”, citado anteriormente, existen varias poblaciones. Estas, por ejemplo, pueden ser: aquellos estudiantes inscriptos en una carrera determinada,

el conjunto de sus estaturas, sus edades, el color de pelo, sus ingresos mensuales, el promedio de

sus calificaciones, etc.

Muestra (n): es un subconjunto de la población obtenido de acuerdo a una regla determinada. Por

ejemplo, en el universo de estudiantes considerados, una muestra de la población de sus estaturas

se puede obtener midiendo a todos los alumnos que asistan a cualquier curso de Estadística que

se dé a las 10 de la mañana de un día determinado del semestre.

Fabricio Penna & Silvia Huarte

Págin@ 15

Por ejemplo, si arrojamos un dado (honesto) 10 veces, una posible muestra de la población de los

números de las caras (que ven hacia arriba) puede ser: 3, 2, 3, 6, 1, 5, 3, 4, 6, 1.

Si lo que se mide es la característica par e impar de esos números, la muestra estaría formada por

los resultados: impar, par, impar, par, impar, impar, impar, par, par, impar.

Obsérvese que los elementos de una muestra deben considerarse como los resultados de un experimento aleatorio obtenidos al realizar repetida e independientemente las pruebas correspondientes. Existen diferentes tipos de muestras y maneras de obtenerlas. Ahí se establecerá que el trabajo estadístico no sirve únicamente para describir la muestra, sino que también proporciona información sobre la población muestreada.

3.1a TAMAÑO DE LA POBLACIÓN

Es el número de elementos que tiene una población, es decir, el número total de valores posibles

que puede tener la característica particular del universo que se estudia.

Por ejemplo, si el universo está formado por un dado con sus caras numeradas del 1 al 6, y se

trata de ver el número de la cara que ve hacia arriba al tirar el dado, la población estará formada

por el conjunto de números (1, 2, 3, 4, 5, 6), y el tamaño de la población será 6. Si en este experimento se trata de ver la característica par o impar del número resultante, el tamaño de la población será 2.

En el ejemplo del universo de estudiantes universitarios, el tamaño de la población de estaturas

será igual al número de alumnos inscriptos en la Facultad durante el semestre en cuestión.

3.1b TAMAÑO DE LA MUESTRA

Es el número de elementos que forman la muestra. En el ejemplo del tiro de un dado, se tienen

dos muestras de tamaño 10.

De una muestra interesa que sea representativa de la población de donde fue obtenida. Para serlo,

es necesario diseñar cuidadosamente su tamaño, de tal manera que sin contener a todos los elementos de la población, lo que daría lugar a un estudio exhaustivo de todos éstos elementos, sí

sea lo suficientemente grande para contener todas las variedades de la característica que se trata

de estudiar. Por el contrario, generalmente una muestra de tamaño grande ocasiona costos altos

en su obtención y, por economía, conviene que ésta sea de tamaño reducido. En la parte de la

Estadística llamada Diseño de Experimentos se analiza este problema, además de las maneras en

que debe tomarse la muestra para asegurar su representatividad. Esquemáticamente, se podría

pensar en las definiciones precedentes de la siguiente manera:

Fabricio Penna & Silvia Huarte

Págin@ 16

Esquema 1: Los diferentes “grupos” implicados en el proceso inferencial

U N I V E R S O (U)

P O B L A C I Ó N (N)

→

INFERENCIA ESTADÍSTICA !!!

M U E S T R A (n)

Esquema 2: Algunos “tipos” de muestreo

MUESTREO

No-aleatorio o noprobabilístico

Aleatorio, probabilístico

o al azar

Aleatorio

simple

Autogenerado

Intencional

Accidental

Estratificado

Por conglomerados

Sistemático

Tipo “A”

Tipo “B”

Muestreo aleatorio, probabilístico o al azar: un muestreo se denomina aleatorio, probabilística o

al azar, cuando todos los “elementos” que componen la población tienen igual probabilidad de

pertenecer a la muestra.

Muestreo no-aleatorio o no-probabilístico: un muestreo se denomina no-aleatorio o no-probabilístico, cuando no todos los “elementos” que componen la población tienen igual probabilidad de

pertenecer a la muestra.

Fabricio Penna & Silvia Huarte

Págin@ 17

3.2- FACTORES Y NIVELES DE MEDICIÓN

Factor: es cualquier elemento o aspecto (característica) identificable y distinto, dentro de una

situación, que puede observarse independientemente del contexto del que forma parte.

Tabla 1: Tipos de Factores o Variables

FACTORES

FORMA DE PRESENTACIÓN

Dicotómicos

(presentan dos categorías observacionales)

Variables cualitativas o Atributos

(no poseen magnitud)

Politómicos

(presentan más de dos categorías observacionales)

Discretas

(varían en unidades enteras infinitas numerables)

Variables cuantitativas

(poseen magnitud)

Continuas

(varían en un continuo de valores infinitos no numerables)

Al momento de investigar, podemos estar en presencia de factores con bajo nivel de abstracción

(simples) o con alto nivel de abstracción (complejos). Cualquier análisis, frente a los primeros, es

relativamente sencillo; ahora, si queremos analizar factores complejos (también llamados constructos), la forma de análisis es operacionalizando dicho factor.

Proceso de operacionalización de una variable: Al proceso de llevar una variable de un nivel

abstracto a un plano más concreto se le denomina “operacionalización”, y su función básica es

precisar al máximo el significado que se le otorga a una variable en un determinado estudio.

“Operacionalizar” las variables significa explicar cómo se miden. A este proceso algunos autores

le llaman construcción de variables, justificando que se da toda una elaboración de conceptos,

definiciones e indicadores.

Definir y operacionalizar las variables es una de las tareas más difíciles del proceso de investigación; sin embargo, es un momento de gran importancia pues tendrá repercusiones en todos los

momentos siguientes, razón por la que debe prestársele mucha atención.

La operacionalización de las variables, es decir el proceso de señalar cómo se tomarán las medidas empíricas, no es un procedimiento exclusivamente técnico, carente de teoría. Sin la teoría, la

descripción, y por lo tanto la técnica misma, no tienen sentido.

En algunos casos las variables que aparecen enunciadas en los objetivos y en el marco teórico no

ofrecen mayor dificultad en cuanto a su descripción, definición y medición. Por ejemplo, edad,

ingreso, años de escolaridad, número de hijos. Estas son variables simples, cuya comprensión es

más fácil. Sin embargo, es frecuente que se incluyan variables de mayor complejidad que tienen

que ser definidas claramente para entender su significado y para llegara su medición. Ejemplos

de este tipo de variables serían: marginación socioeconómica, trato humanizado al paciente, saFabricio Penna & Silvia Huarte

Págin@ 18

tisfacción con un programa educativo, accesibilidad a los servicios de salud, calidad de la atención brindada.

Es evidente que cada persona tendría una conceptualización diferente de lo que es el significado

de estos términos o características y que si tratamos de hacer la medición de estas variables antes

de haberlas conceptualizado y definido claramente, al final tendríamos información poco válida

y poco confiable.

Tal como se mencionó anteriormente, los conceptos en los cuales se interesa el investigador deben ser traducidos en fenómenos observables y medibles. Previo al planteamiento del proceso de

operacionalización de variables, se hace necesario discutir acerca de su conceptualización.

Según Namakforoosh (en Pineda y cols, 1994), los conceptos son abstracciones que representan

fenómenos empíricos y para pasar de la etapa conceptual de la investigación a la etapa empírica,

los conceptos se convierten en variables.

Goode y Hatt (en Pineda y cols, 1994) plantean que los conceptos representan el sistema teórico

de cualquier ciencia y son símbolos de los fenómenos que se estudian. Además, indican que son

construcciones lógicas, creadas a partir de impresiones de los sentidos, de percepciones, e incluso de experiencias bastante complejas y que no son fenómenos en sí; es decir estas construcciones lógicas no existen fuera del marco de referencia establecido.

También podemos agregar que un concepto es el “pensamiento acerca de las propiedades esenciales de un objeto que lo hacen semejante o distinto de otro objeto”, Expresa, de esta forma, la

suma del conocimiento científico en un momento del saber.

Estas definiciones sobre concepto, aún cuando plantean diferentes enfoques, tienen algunos elementos en común, como el hecho de que un concepto es general y abstracto, no siendo posible la

observación y medición de los fenómenos involucrados. Por ello, es necesario llegar a la operacionalización de las variables, lo que se traduce en el establecimiento de significado para los

términos del estudio y en la estipulación de operaciones o situaciones observables, en virtud de

lo cual algo quedará ubicado en determinada categoría de la variable y no en otra.

Dicha operacionalización se logra a través de un proceso que transforma una variable en otras

que tengan el mismo significado y que sean susceptibles de la medición empírica. Para lograrlo,

las variables se descomponen en otras más específicas llamadas dimensiones. A su vez, es necesario traducir estas dimensiones a indicadores para permitir la observación directa.

Algunas veces, como se mencionó anteriormente, la variable puede ser operacionalizada mediante un solo indicador, como es el caso de la edad, la que puede ser definida en forma operativa por

Fabricio Penna & Silvia Huarte

Págin@ 19

medio de un solo indicador que sería el número de años cumplidos. En otros casos es necesario

hacerla a través de un conjunto de indicadores, como sería el caso de marginalidad, accesibilidad

y tantas otras variables.

Para facilitar la comprensión del proceso de operacionalización de variables se puede analizar el

esquema presentado a continuación:

Esquema 3: Proceso de operacionalización de variables

Concepto - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -. Variable teórica

Definición conceptual

Dimensiones

Definición operacional de cada dimensión

Indicadores - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - Variable empírica

En el siguiente esquema se presenta un ejemplo de la operacionalización o construcción de

una variable compleja como es la accesibilidad a los servicios de salud. Esta figura muestra

como de una variable abstracta que puede ser interpretada en forma muy diferente por distintas personas, se pasa a tener una variable definida que permite la medición empírica, o sea

que cada persona puede hacer la medición observando aspectos concretos tales como el

tiempo medido en horas y minutos o la cantidad de dinero disponible.

Esquema 4: Ejemplo de operacionalización de variables

Variables

Definición conceptual

Dimensiones

(Variables contenidas en la

definición conceptual)

Accesibilidad geográfica

Mayor o menor posibilidad de

Accesibilidad a los tomar contacto con los serviservicios de salud cios de salud para recibir asistencia

Accesibilidad económica

Accesibilidad cultural

Fabricio Penna & Silvia Huarte

Indicadores

Definición operacional

Tiempo medido en horas y

minutos que tarda una persona para trasladarse de su

domicilio al centro de salud.

Cantidad de dinero que gasta para recibir la atención.

Disponibilidad económica

para cubrir ese gasto.

Conocimientos sobre la

atención que se da en el

centro de salud. Percepción

del problema de salud.

Págin@ 20

Definición operacional de una variable: es reducir el nivel de abstracción a través de diferentes

definiciones, para encontrar aquella que especifique elementos de la realidad, indicadores o referentes empíricos; dicho proceso de operacionalización, requiere tres tipos de definición:

1. Definición connotativa: tiene un elevado nivel de abstracción, señala las características esenciales, aquellas que expresan la naturaleza de lo que simboliza la variable.

2. Definición real: enumera componentes o dimensiones relevantes y concretas de la variable.

El nivel de abstracción es menor que el anterior.

3. Definición operacional: intenta indicar los indicadores empíricos de los componentes anteriores.

Definición de medición: hay varias definiciones de medición pero, en éste curso, vamos a utilizar

aquella dada por Stevens (1951): “La medición es la asignación de números a objetos o sucesos

según reglas”.

Tabla 2: Niveles de Medición

Niveles de medición

NOMINAL

ORDINAL

INTERVALAR

MÉTRICO o de RAZÓN

Operaciones empíricas

Equivalencia

Equivalencia

Orden

Equivalencia

Orden

Unidad de medida común y constante

Cero “arbitrario”

Equivalencia

Orden

Unidad de medida común y constante

Cero “absoluto o natural”

Operaciones matemáticas

A=B

A=B

A<BoA>B

A=B

A<BoA>B

A– B=C–D

A=B

A<BoA>B

A–B=C–D

A/B=C/D

•

Nominal: puede reemplazar al nombre con un número, no supone magnitud ni orden, se aplica a variables cualitativas (o atributos).

•

Ordinal: el número indica el orden, supone la existencia de magnitud y de orden, se aplica a

variables.

•

Intervalar: posee magnitud, supone unidad de medida común y constante, el “cero” (o punto

de origen) es arbitrario y no indica ausencia del factor.

•

Métrico o de Razón: posee magnitud, supone unidad de medida común y constante, el “cero”

es natural o absoluto e indica ausencia de factor.

Tabla 3: Relación existente entre variables y niveles de medición

NIVELES DE MEDICIÓN

VARIABLES

Dicotómicas

Politómicas

Discretas

CUANTITATIVAS

Continuas

CUALITATIVAS

Fabricio Penna & Silvia Huarte

NOMINAL ORDINAL INTERVALAR MÉTRICO

Si

Si

No

No

No

No

Si

Si

No

No

Si

Si

No

No

Si

Si

Págin@ 21

A modo de ejemplo, vamos a analizar las siguientes variables determinando el tipo de variable y

el nivel de medición:

a. Factor: Clases de respuestas infantiles al miedo

•

•

Definición teórica: distintas conductas que un niño expresa ante una situación amenazante.

Definición operacional: se trató de identificar las respuestas según la clasificación de

conductas verbales, fisiológicas o motoras.

b. Factor: Destreza manual

•

•

Definición teórica: capacidad del sujeto para realizar una tarea con precisión.

Definición operacional: evaluada mediante un test estandarizado donde cada ítem mide

el mismo monto de factor. Se registraban los movimientos bien controlados de brazo y

mano en la manipulación de objetos.

c. Factor: Clasificación de documentos

•

•

Definición teórica: amplia gama de registros escritos y simbólicos, así como cualquier

material y datos disponibles.

Definición operacional: pueden clasificarse según: su material (visuales o audiovisuales), el contenido (hechos reales o de ficción), la intencionalidad con que se hayan producido (públicos o privados).

d. Factor: Tipos de entrevistas

•

•

Definición teórica: técnica de recolección de información.

Definición operacional: clasificadas en: estructuradas; formal o con cuestionario, semiestructurada (sin cuestionario), no estructurada, cara a cara, telefónica, mediante tecnologías informáticas, individual, en panel, en grupo.

e. Factor: Cantidad de Instituciones médicas

•

•

f.

Definición teórica: locales habitables destinados a la atención de la salud de la población.

Definición operacional: número de institutos habilitados en cada provincia para enfermos.

Factor: Medios de comunicación

•

•

Definición teórica: fenómeno de comunicación de masas. Medios de comunicación personal, colectivo o en masa.

Definición operacional: incluye la prensa escrita, la radio, el teléfono, la propaganda, la

televisión, el cine, el vídeo, como así también otros medios audiovisuales o escritos.

3.3- DISTRIBUCIÓN EMPÍRICA

Se llama distribución empírica de frecuencias de la variable aleatoria x, al conjunto de pares (xi,

fi*), donde i = 1, 2, 3, ..., n. Cabe decir que, como en el caso de la distribución de probabilidad,

una distribución empírica describe completamente a la muestra de donde fue obtenida, ya que los

valores de xi dan los valores observados de la característica de la población en la muestra, y sus

correspondientes frecuencias relativas fi* proporcionan la forma como se presentan esos resultados.

Fabricio Penna & Silvia Huarte

Págin@ 22

Supóngase que se tienen los n elementos de una muestra obtenida de una población, y que en

ésta hay:

f1 resultados idénticos a x1

f2 resultados idénticos a x2

f3 resultados idénticos a x3

····

····

fk resultados idénticos a xk

donde:

k

∑f

i =1

i

= f1 + f 2 + L + f k = n

(12)

y x1, x2, x3, . . . , xk son k valores numéricos asociados a los eventos observados al realizar el

experimento aleatorio que define la muestra, es decir, son valores observados de una variable

aleatoria x asociada a la población y los números f1, f2, f3, . . . , fk se llaman frecuencias de ocurrencia de los valores x1, x2, x3, . . . , xk, respectivamente.

El cociente de una frecuencia fi entre el total de observaciones n (tamaño de la muestra), se llama

la frecuencia relativa de ocurrencia del valor xi correspondiente. Representando la frecuencia

relativa de con fi*, se tiene que:

f i* =

fi

; i = 1, 2, ..., k

n

(13)

Obsérvese el paralelismo entre los conceptos de frecuencia relativa y de probabilidad clásica. De

la expresión (13) se obtienen de inmediato las condiciones que un conjunto de números tienen

que cumplir para que sean frecuencias relativas de los valores de una muestra. Estas son:

0 ≤ f i* ≤ 1

k

∑f

i =1

*

i

(14)

=1

Se llama frecuencia relativa acumulada de un valor xi, a la suma de frecuencias relativas de todos

los valores menores o iguales al valor xi considerado. Si Fi es la frecuencia relativa acumulada de

xi, se tiene:

i

Fi = ∑ f j* = 1,

i = 1, 2, ..., k

(15)

j=1

Para el ejemplo del tiro de un dado, en donde se trata de ver el número de la cara que queda

hacia arriba, la distribución empírica es:

xi

fi*

Fabricio Penna & Silvia Huarte

1

0,2

2

0,1

3

0,3

4

0,1

5

0,1

6

0,2

Págin@ 23

Si se considera una variable aleatoria que tome el valor cero cuando el resultado del tiro del dado

es par, y el valor uno cuando es impar, la distribución empírica de esta variable es:

xi

fi*

0

0,4

1

0,6

Para las mismas muestras consideradas del tiro de un dado, las distribuciones de frecuencias relativas acumuladas, es decir, el conjunto de pares (xi, Fi) son, respectivamente, las siguientes:

xi

Fi

1

0,2

2

0,3

3

0,6

4

0,7

xi

Fi

0

0,4

1

1,0

5

0,8

6

1,0

y

Las distribuciones empíricas de frecuencias y de frecuencias relativas acumuladas tienen las representaciones gráficas que se verán más adelante.

3.4- PRESENTACIÓN DE DATOS: TABLA DE FRECUENCIAS

Tabla 4: Muestra de estaturas (en cm) de estudiantes universitarios.

165

168

153

185

166

164

184

158

180

176

161

170

172

167

169

173

169

179

163

184

179

177

165

157

186

166

180

173

175

179

187

181

163

179

165

165

163

178

167

169

173

175

174

155

168

172

170

180

162

154

179

174

184

177

165

164

168

176

178

176

171

169

170

167

185

175

165

173

178

168

177

170

169

161

168

162

176

180

168

155

168

169

164

177

162

168

176

175

178

169

172

169

158

171

173

181

180

168

172

170

Considérese la muestra de tamaño 100, de estaturas de estudiantes universitarios mostrada en la

Tabla 4. Debido al número de datos y la variabilidad de los mismos, poca información se podrá

deducir de la muestra si se forma una tabla con las distribuciones empíricas de frecuencias y de

frecuencias relativas acumuladas. Entonces, cuando el tamaño n de la muestra es grande, conviene agrupar los datos de la muestra de alguna manera que sea menos confusa y permita establecer

patrones de los valores observados.

Para resolver este problema, conviene condensar los datos tabulando las frecuencias asociadas a

ciertos intervalos de los valores observados. Estos intervalos se llaman intervalos de clase, los

que deben estar definidos por límites que permitan identificar plenamente si un dato particular

pertenece a uno u otro intervalo de clase. Comúnmente se resuelve lo anterior haciendo que los

limites de los intervalos de clase tengan una cifra decimal más que los datos originales, o usando

adecuadamente los signos de igualdad y desigualdad en la definición de cada uno de los interva-

Fabricio Penna & Silvia Huarte

Págin@ 24

los de clase. En la práctica se ha visto que es conveniente que el número de intervalos de clase

sea de 5 a 15 y que en cada intervalo caigan, por lo menos, 5 observaciones.

De la Tabla 4 se ve que la observación mayor en la muestra de estaturas de estudiantes universitarios es 187 cm y, la observación menor, de 153 cm. La diferencia entre estas dos observaciones, 187 − 153 = 34, indica que en un rango de 34 cm están todas las estaturas de los estudiantes

muestreados. Si se consideran 7 intervalos de clase, la amplitud de cada uno de ellos será del

orden de 34/7 ≅ 5 cm. De esta manera, y haciendo que la observación menor caiga en el primer

intervalo de clase y la mayor en el último, los intervalos de clase pueden ser (153; 157), (158;

162), ..., (183; 187) donde cada intervalo representa estaturas observadas.

Los puntos medios de los intervalos de clase (calculados como el “promedio” entre el límite inferior y el superior de cada intervalo) reciben el nombre de marcas de clase, y son representativos

del conjunto de observaciones que caen en el intervalo de clase correspondiente. Para los intervalos de clase de la muestra de estaturas determinadas, las marcas de clase son 155, 160, ..., 185.

El arreglo en una tabla de los intervalos de clase, marcas de clase, frecuencias, frecuencias relativas y frecuencias relativas acumuladas, se conoce con el nombre de tabla de frecuencias.

Condensados los datos de una muestra en una tabla de frecuencias, el conjunto de pares (ti, fi), en

donde ti es la marca de clase, representa la distribución empírica de la muestra, y a través de ella

podrá obtenerse mayor información de la misma muestra que de los datos dispersos.

Ejemplo 2: Dada la Tabla 4 con los datos observados en una muestra de tamaño 100 de las estaturas de los estudiantes universitarios, construir una tabla de frecuencias.

De dicha tabla se obtiene:

- Observación máxima (xmax) = 187

- Observación mínima (xmin) = 153

- Rango o recorrido = xmax – xmin = 187 – 153 = 34

- Número de intervalos de clase = 7

- Amplitud de los intervalos de clase = 34/7 ≅ 5

- Primer intervalo de clase (contiene al 153 y sus limites tienen un decimal) = 152,5 a 157,5.

Con la información anterior se construye la tabla de frecuencias que aparece en la Tabla 5. De

esta se puede comenzar a deducir información valiosa sobre la muestra estudiada. Por ejemplo,

de aquí se obtiene que el 28% de los estudiantes muestreados tienen una estatura de 167,5 a

172,5 cm; que el 77% de los estudiantes tienen una estatura menor a 177,5 cm; que es muy remoto encontrar estudiantes con estatura superior a 187,5 cm; etc.

Fabricio Penna & Silvia Huarte

Págin@ 25

Tabla 5: Tabla de frecuencias de la muestra de estaturas de estudiantes universitarios

Intervalo

de Clase

Marca de

clase (ti)

Conteo de

frecuencias

152,5 – 157,5

157,5 – 162,5

162,5 – 167,5

167,5 – 172,5

172,5 – 177,5

177,5 – 182,5

182,5 – 187,5

155

160

165

170

175

180

185

IIIII

IIIIIII

IIIIIIIIIIIIIIIII

IIIIIIIIIIIIIIIIIIIIIIIIIIII

IIIIIIIIIIIIIIIIIII

IIIIIIIIIIIIIIII

IIIIIII

Frecuencia

absoluta

(fi)

5

7

17

28

20

16

7

Frecuencia

Relativa

(fi*)

0,05

0,07

0,17

0,28

0,20

0,16

0,07

Frecuencia Relativa Acumulada

(Fi)

0,05

0,12

0,29

0,57

0,77

0,93

1,00

3.5- REPRESENTACIONES GRÁFICAS DE LAS DISTRIBUCIONES EMPÍRICAS: HISTOGRAMA

POLÍGONO DE FRECUENCIAS RELATIVAS ACUMULADAS

Y

En forma semejante a los polígonos de probabilidad y de probabilidad acumulada, existen representaciones gráficas de las distribuciones empíricas. Éstos son histograma y polígono de frecuencias acumuladas.

Histograma: Es una representación gráfica de la distribución empírica en un sistema de ejes coordenados ortogonales de referencia. En el eje de las abscisas se sitúan las marcas de clase, y en

el de las ordenadas las frecuencias o las frecuencias relativas. La representación se basa en

rectángulos de igual base al intervalo de clase y de altura la frecuencia o frecuencia relativa correspondiente. Dependiendo de que se grafiquen las frecuencias o las frecuencias relativas, el

histograma se llama de frecuencias o frecuencias relativas, respectivamente.

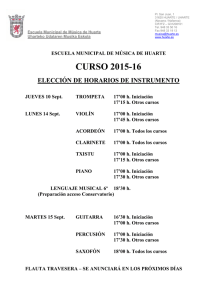

En el Gráfico 9 se tiene el histograma de frecuencias relativas de la muestra de estaturas de los

estudiantes universitarios. Los datos para construirlo se tomaron de la Tabla 2. En el mismo

Gráfico se han unido los puntos sucesivos (ti, fi*) por medio de segmentos de rectas; a este trazo

se le llama el polígono de frecuencias relativas de la distribución empírica.

Gráfico 9: Histograma de frecuencias relativas correspondiente a la estatura (en cm) de una

muestra de 100 alumnos.

Fabricio Penna & Silvia Huarte

Págin@ 26

Polígono de frecuencias relativas acumuladas: el polígono de frecuencias relativas acumuladas,

también llamado ojiva, es una representación poligonal abierta de las frecuencias relativas acumuladas en un sistema de ejes coordenados ortogonales de referencia. En el eje de las abscisas se

sitúan los valores de los límites de los intervalos de clase, y en el de las ordenadas las frecuencias

relativas acumuladas de los mismos valores.

En el Gráfico 10 se tiene el polígono de frecuencias relativas acumuladas de la misma muestra

de estaturas de los estudiantes universitarios. También se construyó tomando los datos de la Tabla 5

Gráfico 10: Polígono de frecuencias relativas acumuladas de estaturas (en cm) de la muestra de

estudiantes.

4. ESTIMADORES DESCRIPTIVOS DE UNA DISTRIBUCIÓN EMPÍRICA

Como en las distribuciones teóricas de probabilidad, en las distribuciones empíricas existen diferentes estimadores que resumen una gran cantidad de información sobre las muestras. A estos

estimadores los clasificaremos en fractiles, medidas de tendencia central (MTC), medidas de

dispersión (MD), coeficiente de asimetría o sesgo y coeficiente de aplanamiento o curtosis. Dentro de las MTC veremos: la media aritmética, la mediana y la moda; las MD que estudiaremos

serán: el rango o recorrido, el semi rango, la MAD, la desviación estándar y el coeficiente de

variación.

En general, las MTC representan valores promedios o medidas de posición de los datos de la

muestra. Las MD miden el grado de concentración o variabilidad de los datos. Por otro lado y,

como sus nombres lo indican, los coeficientes de asimetría y de aplanamiento establecen criterios para comparar el histograma de la muestra con respecto a ciertas normas.

Fabricio Penna & Silvia Huarte

Págin@ 27

4.1- FRACTILES: CUARTILES, DECILES Y PERCENTILES O CENTILES

Los cuartiles (Q), deciles (D) y percentiles o centiles (P) son estimadores descriptivos de una

distribución empírica. Estos establecen la localización de diversos valores que dividen a la muestra en grupos de acuerdo a las frecuencias de las observaciones.

Los valores de los diferentes Q (Q1, Q2 y Q3), D (D1, D2, ..., D9) y P (P1, P2, ..., P99) se pueden

estimar gráficamente del polígono de frecuencias relativas acumuladas, siendo el cálculo de los

fractiles de orden (es decir, la posición de los fractiles) los siguientes:

(Q i )O

= i×

n

+ 0,5 ;

4

(D i )O

= i×

(Pi )O

n

+ 0,5 ;

10

= i×

n

+ 0,5

100

(16)

En un polígono de frecuencias relativas acumuladas, la abscisa de cualquier punto del polígono

se llama el fractil, y la ordenada correspondiente la fracción, la que se maneja en forma porcentual. Esta representa precisamente la fracción de la totalidad de datos que tienen un valor menor

o igual al del fractil correspondiente. Para referirse a un fractil en particular, se le asocia la fracción al cual corresponde. Por ejemplo, en el Gráfico 10 se ha trazado el fractil 70, cuyo valor es

175,75; lo que significa que el 70% de los estudiantes medidos tienen una estatura menor o igual

a 175,75 cm. Estas medidas, llamadas también “medidas de posición”, pueden ser calculadas

tanto para atributos como para variables.

Algunos fractiles tienen nombres particulares. Así, a modo de ejemplo, el fractil 1 se llama percentil 1 (P1), el fractil 2 se llama percentil 2 (P2), etc.; al fractil 10 se conoce como decil 1 (D1),

el fractil 20 es el decil 2 (D2), etc. Los fractiles 25, 50 y 75 se los denomina también como primero, segundo y tercer cuartil (Q1, Q2 y Q3), respectivamente. Al fractil 50 se lo conoce como

mediana y, como puede verse en el Gráfico 10, es un valor tal que la mitad (50%) de los datos

son menores o iguales que ella, y la otra mitad (50%) mayores o iguales que la misma.

4.2- MEDIDAS DE TENDENCIA CENTRAL: MEDIA ARITMÉTICA, MEDIANA Y MODA O MODO

Media aritmética ( X ): La media aritmética es el más común y representativo de los estimadores

descriptivos de tendencia central y se define como el promedio aritmético de todos los datos de

la muestra. De acuerdo a lo dicho anteriormente, si x1, x2, x3, . . . ,xn son valores observados de la

variable aleatoria x correspondientes a una muestra de tamaño n obtenida de una población, la

media, representada por X , es:

n

x + x 2 + L + xk

X = 1

=

n

Fabricio Penna & Silvia Huarte

∑x

i =1

n

i

(17)

Págin@ 28

Características: Es sensible al valor exacto de todos los datos de la distribución y a la presencia

de valores extremos; la suma de las desviaciones con respecto a la media es cero; la suma de los

cuadrados de las desviaciones respecto a la media es mínima y es calculable para variables con

nivel de medición intervalar o métrico.

~

Mediana ( X ): La mediana (trazada en el Gráfico 10) es un valor tal que la mitad de las observa-

ciones son menores que ese valor y la otra mitad mayores que el mismo. Su valor puede determinarse ordenando los datos de la muestra de menor a mayor (o viceversa) y tomando el elemento central cuando exista (n impar), caso contrario (n par) se toma como mediana al promedio de

los dos valores centrales [en general consideraremos el valor ubicado en la “posición” (n+1)/2,

pudiendo ser observable o no]. En el caso de la muestra del tiro de un dado, las observaciones

ordenadas son: 1, 1, 2, 3, 3, 3, 4, 5, 6, 6, por lo que su mediana es (3+3)/2 = 3.

Características: A pesar de no ser la medida más representativa, la podemos considerar más “robusta” pues no se ve afectada por los valores extremos que componen la distribución; es calculable para variables con nivel de medición ordinal, intervalar o métrico. La podemos considerar

como un fractil “encubierto” es decir, la mediana toma igual valor que el cuartil 2 (Q2), el decil 5

(D5) y el percentil 50 (P50).

Moda ó Modo ( X̂ ): La moda (o modo) de una muestra es la observación que se presenta con

mayor frecuencia; por lo tanto, es el valor más descriptivo de la muestra. Desde luego que la

moda puede ser única o tener varios valores, opacando un poco su propiedad de descripción. En

la muestra del tiro de un dado formada por los números 3, 2, 3, 6, 1, 5, 3, 4, 6, 1, obviamente la

moda es única y vale 3.

Características: Al igual que la mediana, no se ve afectada por valores extremos que pueden

contener la variable bajo estudio; es una medida de fácil localización, siendo la más típica de

toda la distribución, dado que se halla localizada en el punto de máxima concentración; si nos

encontrarnos con distribuciones bimodales o multimodales, su propiedad de localización se ve

“opacada” y esto podría considerarse como su mayor desventaja. Se puede calcular tanto en variables cualitativas (o atributos) como cuantitativas, para cualquier nivel de medición.

Cuando el histograma, de una distribución empírica, es casi simétrico (y unimodal), se puede

estimar el valor de la moda a partir de la relación que existe entre ella, la media aritmética y la

mediana. Se ha encontrado que en distribuciones empíricas moderadamente asimétricas, la distancia entre la media y la mediana es un tercio de la distancia entre la media y la moda, es decir,

(

)

(

~ 1

~

X − X = X − X̂ ⇒ X̂ = X − 3 X − X

3

Fabricio Penna & Silvia Huarte

)

(18)

Págin@ 29

Nota: tanto los fractiles como las MTC definidas anteriormente, siempre toman valores contenidos entre el mínimo

(xmin) y el máximo (xmax) valor de la distribución.

4.3- MEDIDAS DE DISPERSIÓN: RANGO O RECORRIDO, SEMI RANGO, VARIANZA, DESVIACIÓN

ESTÁNDAR, MAD Y COEFICIENTE DE VARIACIÓN

Rango o recorrido (R): es la medida de dispersión más simple. Fue usada en la construcción de la

tabla de frecuencias en el Ejemplo 2 y se define como la diferencia entre la mayor y la menor

observaciones de la muestra. Si xmax es la observación de mayor valor y xmin el valor de la observación mínima, el rango se calcula como:

R = xmax − xmin

(19)

Para la muestra del tiro de un dado que se ha venido analizando, las observaciones máxima y

mínima son xmax = 6 y xmin = 1, respectivamente. Por lo tanto, el rango de la muestra será 6-1= 5.

Semi Rango (SR):

SR =

x max + x min

2

(20)

Las MD anteriores, son útiles cuando interesa tener una rápida aproximación de la dispersión en

distribuciones casi simétricas. Sin embargo, son poco utilizadas pues no consideran la información contenida en los términos intermedios.

Varianza (s2): Es la medida de dispersión más conocida y de mayor utilidad. Se define como el

“promedio” de los cuadrados de las desviaciones de las observaciones con respecto a su valor

medio.

Si x1, x2, x3,..., xn son los valores observados de la variable aleatoria x correspondientes a una

muestra de tamaño n obtenida de una población, y X es la media de la muestra entonces la varianza, representada por s2, es:

∑ (x

n

s2 =

i =1

− X)

2

i

n −1

(21)

Desviación Estándar (s ó DE): Como en el caso de la desviación estándar de variables aleatorias

con distribución de probabilidad conocida, la desviación estándar de la muestra de define como

la raíz cuadrada de la varianza:

DE = s = s 2

(22)

Mediana de las desviaciones absolutas respecto de la mediana (MAD): Esta medida de dispersión es la mediana de los valores absolutos de las diferencias entre los valores de la muestra (x1,

Fabricio Penna & Silvia Huarte

Págin@ 30

x2, x3,..., xn) y la mediana de todos los datos. Es de gran utilidad cuando el nivel de medición de

los datos es ordinal o bien, cuando la distribución se ve afectada por valores extremos. Su expresión es la siguiente:

(

~

~

~

MAD = Mediana x1 − X , x2 − X , L, xn − X

)

(23)

Nota: Cuanto más pequeña es la MAD, más concentrados respecto a la mediana están los datos.

Coeficiente de Variación (CV): En las distribuciones empíricas se define este coeficiente como

la razón entre la desviación estándar y el valor absoluto de la media de la muestra, multiplicado

por 100. Esta razón nos puede indicar, en primer lugar que cuanto más próximo a cero es CV,

más representativa será la media del grupo, y por el otro, como es un número adimensional, me

permite comparar la representatividad de las medias en distribuciones con distintas unidades.

CV =

s

× 100

X

(24)

Nota: en general, si el CV < 20%, podemos decir que la media del grupo es representativa.

Retomando las características de los niveles de medición, presentados en Tabla 2, los estadísticos

a ser utilizados son los siguientes:

Tabla 6: Estadísticos “apropiados”, de acuerdo al nivel de medición del factor

Niveles de medición

NOMINAL

ORDINAL

INTERVALAR

MÉTRICO o de RAZÓN

Estadísticos apropiados

Moda

Fractiles, moda, mediana, MAD

Fractiles, moda, mediana, media, rango, semi rango, MAD, desviación estándar, varianza, coeficiente de variación

Fractiles, moda, mediana, media, rango, semi rango, MAD, desviación estándar, varianza, coeficiente de variación

4.4- COEFICIENTE DE ASIMETRÍA O SESGO

Se dice que una distribución empírica es simétrica, cuando su histograma tiene un eje vertical de

simetría. En este caso, la media, mediana y moda coinciden con ese eje de simetría.

En una distribución empírica asimétrica, los valores de la media, mediana y moda son diferentes

entre sí. En este caso, la moda subsiste en el rectángulo más alto del histograma, ya que no se ve

afectada por las observaciones poco frecuentes que distorsionan la simetría del histograma. La

posición de la mediana estará algo “alejada” de la moda, en la dirección de los valores inusuales,

dividiendo en dos partes el área del histograma. Como la media es la que se ve más afectada por

los valores extremos, quedará localizada más lejos de la moda en la misma dirección de los valores poco frecuentes.

Fabricio Penna & Silvia Huarte

Págin@ 31

Lo anterior se representa en los otros casos del Gráfico 11, donde se ha llamado asimetría positiva o derecha al caso de tener datos poco frecuentes a la derecha de la moda que hagan que se

prolongue el histograma en esa dirección, y asimetría negativa o izquierda al caso contrario.

De lo anterior puede establecerse que una medida de la asimetría de una distribución empírica

puede ser la diferencia entre la media y la moda, ya que a mayor asimetría le corresponde una

mayor diferencia. Dado que la medida de la asimetría se utiliza principalmente con fines comparativos, conviene que la propuesta sea adimensional, y que los valores grandes de la media sean

debidos a gran asimetría y no a gran dispersión de los datos. Para resolver lo anterior, se dividirá

la diferencia de la media y la moda entre la desviación estándar de la muestra. A este cociente se

le llama el primer coeficiente de asimetría de Pearson; vale cero cuando la distribución es simétrica y diferente de cero cuando es asimétrica, dando directamente el sentido positivo o negativo

de la asimetría según el signo.

Coeficiente de asimetría de Pearson = As =

X − X̂

s

(25)

En el caso de distribuciones moderadamente sesgadas, existe una relación aproximada entre los

diversos estadísticos:

(

~

X − X̂ = 3 X − X

)

(26)

Es interesante destacar que en el caso de las distribuciones asimétricas, con cúspide muy aguda,

la mediana constituye −a menudo− una útil MTC.

Si reemplazamos la ecuación (26) en la (25), obtenemos que:

(

~

3X−X

Coeficiente de asimetría de Pearson = As =

s

Fabricio Penna & Silvia Huarte

)

(27)

Págin@ 32

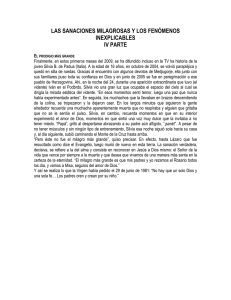

Gráfico 11: Distribuciones de frecuencias que muestran la simetría y los tipos de asimetría

Existen otras formas de medir la asimetría de una distribución empírica. Es particularmente importante la que utiliza el concepto de momento de muestra que a continuación se establece:

Se llama momento de orden r con respecto a la media de una muestra de valores x1, x2, x3, ..., xn

de media X a:

∑ (x

n

mr =

i =1

− X)

r

i

n

(28)

Una medida de la asimetría de una distribución empírica, llamada el coeficiente momento de

asimetría, está dada por el tercer momento con respecto a la media expresado en forma adimensional. Esta es:

a3 =

m3

(m 2 )3

(29)

Donde m3 es el tercer momento de la muestra con respecto a la media y m2 el segundo, o sea, la

varianza. Este coeficiente también vale cero cuando la distribución empírica es perfectamente

simétrica.

Fabricio Penna & Silvia Huarte

Págin@ 33

4.5- COEFICIENTE DE APLANAMIENTO O CURTOSIS

El histograma de una distribución empírica puede tener la tendencia general de la gráfica de la

distribución normal, ser más estrecha y alta que esa tendencia, o más ancha y baja que la misma.

A una distribución empírica cuyo histograma siga la tendencia de la gráfica de la distribución

normal se dice que es mesocúrtica, si es más alta y estrecha que ésta es leptocúrtica, y si es más

ancha y baja se le llama platicúrtica. En el Gráfico 12 se muestran distribuciones correspondientes a los tres tipos de aplanamiento mencionados.

El grado de aplanamiento de una distribución empírica se llama curtosis y se mide a través del

cuarto momento con respecto a la media expresado en forma adimensional. La medida de aplanamiento, llamada coeficiente momento de curtosis, está definida por:

K = a4 =

m4

m 22

(30)

Cuando K=3 ⇒ la distribución es mesocúrtica, si K>3 ⇒ la distribución es leptocúrtica y si K<3

⇒ la distribución es platicúrtica.

Gráfico 12: Distribuciones de frecuencias que muestran los tipos de aplanamiento

Ejemplo 3: la siguiente tabla presenta las estaturas de 100 estudiantes universitarios, determinar:

•

•

•

•

•

•

•

La tabla de distribución de frecuencias (básica) de la variable en estudio

El histograma de frecuencias relativas y el polígono de frecuencias relativas acumuladas

La media, la mediana y la moda

La desviación estándar y el CV

Los cuartiles Q1, Q2 y Q3.

Si la distribución empírica es o no simétrica

Cuál es el grado de aplanamiento de la distribución empírica

Fabricio Penna & Silvia Huarte

Págin@ 34

Tabla 7: Muestra de estaturas (en cm) de estudiantes universitarios

165

168

153

185

166

164

184

158

180

176

161

170

172

167

169

173

169

179

163

184

179

177

165

157

186

166

180

173

175

179

187

181

163

179

165

165

163

178

167

169

173

175

174

155

168

172

170

180

162

154

179

174

184

177

165

164

168

176

178

176

171

169

170

167

185

175

165

173

178

168

177

170

169

161

168

162

176

180

168

155

168

169

164

177

162

168

176

175

178

169

172

169

158

171

173

181

180

168

172

170

¿Cómo interpretaría los resultados obtenidos?

Ejemplo 4: consideremos para el presente ejemplo que la Tabla 7 nos da, en lugar de estaturas,

número de errores ortográficos cometidos por 100 alumnos en distintos trabajos de investigación.

Utilice los indicadores que crea convenientes, incluyendo la confección de una tabla de frecuencias y un gráfico, para dar cuenta del comportamiento de dicho factor (a nivel colectivo). ¿Cómo

interpretaría los resultados obtenidos?

5. REGRESIÓN LINEAL SIMPLE

En muchos problemas hay dos o más variables relacionadas, y es necesario explorar la naturaleza

de esta relación. El análisis de regresión es una técnica estadística para modelar e investigar la

relación entre dos o más variables. Por ejemplo, en un proceso químico, supóngase que el rendimiento de un producto se relaciona con la temperatura de operación del proceso. El análisis de

regresión puede emplearse para construir un modelo que exprese el rendimiento como una función de la temperatura. Este modelo puede utilizarse luego para predecir el rendimiento en un

nivel determinado de temperatura. También podría emplearse con propósitos de optimización o

control del proceso.

En general, supóngase que hay una sola variable respuesta y dependiente que se relaciona con k

variables independientes o regresoras, digamos x1, x2, ..., xk. La variable respuesta y es una variable aleatoria, en tanto que las variables regresoras x1, x2, ..., xk se miden con error despreciable. Las xj se llaman variables matemáticas y con frecuencia son controladas por el experimentador. El análisis de regresión también puede utilizarse en situaciones en las que y, x1, x2, ..., xk son

variables aleatorias distribuidas conjuntamente, tal como en el caso cuando los datos se recaban

como mediciones diferentes en una unidad experimental común. La relación entre estas variables

se caracteriza por medio de un modelo matemático llamado ecuación de regresión. De modo

más preciso, hablamos de la regresión de y en x1, x2, ..., xk. Este modelo de regresión se ajusta a