Tema 6. Procesos estocásticos 1. DESCRIPCIÓN DE UN

Anuncio

CSA. Procesos estocásticos

1

Tema 6. Procesos estocásticos

1. DESCRIPCIÓN DE UN PROCESO ESTOCÁSTICO

Los procesos estocásticos o procesos aleatorios constituyen una herramienta estadística que

surge ante la necesidad de modelar el comportamiento de experimentos aleatorios que varían en el

tiempo o que dependen de alguna otra variable determinista. Las sucesiones de variables aleatorias,

definidas en el tema anterior, son un ejemplo de proceso estocástico en el que el conjunto de instantes

de tiempo es infinito numerable. Por su parte, los procesos estocásticos continuos también

constituyen una familia infinita de VA, pero en este caso no numerable.

Supongamos que estamos estudiando el número de llamadas que se producen en una central

telefónica. Para un intervalo de tiempo determinado, por ejemplo una hora, se puede definir la VA:

“Número de llamadas que se producen en una hora”. Si consideramos un intervalo mayor, por

ejemplo dos horas, es evidente que el número de llamadas observadas tenderá a ser superior y, por

tanto, la distribución de probabilidad de esta nueva VA será distinta a la anterior. Así para cada tiempo

que fijemos tendremos una VA, en principio distinta. En situaciones de este tipo surge de modo

natural la conveniencia de definir una familia de variables aleatorias que dependen de una variable

determinista, es decir, un proceso estocástico. En este caso concreto, podemos definir el proceso

estocástico X(t) como el número de llamadas que se producen en el intervalo (0,t). Así, para cada

valor de t que elijamos tendremos una VA diferente.

Habíamos definido una VA X como una función que a cada posible resultado del experimento ω

le asigna un número real X(ω). En un proceso estocástico el resultado del experimento puede variar

con el tiempo, por lo que asignaremos un número real como una función de ambos X(t,ω).

Def: Dado un experimento ε: (Ω, F, P) si suponemos que el resultado del experimento, ω Ω,

R

[

se produce en un tiempo t, podemos asignar una función de ambos X(t,ω) sobre . Un proceso

estocástico (PE) es una función de dos variables, t y ω, una determinista y otra aleatoria, tal que:

(a) X(t,ω) es una familia de funciones temporales.

(b) Si se fija ω tenemos una función temporal X(t) llamada realización del proceso.

(c) Si se fija t tenemos una VA.

(d) Si se fijan t y ω tenemos un número real o complejo.

La variable ω tiene una interpretación similar en la VA X(ω) y en el PE X(t,ω). Para una VA, ω

representa un resultado del experimento. En el caso del PE X(t,ω) también lo representa, con la

diferencia de que en este caso el experimento está definido para los distintos valores de t y el

resultado es en realidad un conjunto de resultados; una función temporal que hemos denominado

realización del proceso. Al igual que ocurría con las VA, notaremos un proceso omitiendo la

dependencia con ω: X(t).

2

Departamento de Teoría de la Señal y Comunicaciones. Universidad de Vigo

Llamaremos espacio de tiempos T al conjunto de los posibles valores del tiempo y espacio de

estados S al conjunto de los posibles valores del proceso. Así, hablaremos de procesos discretos o

continuos en el tiempo y de procesos continuos, discretos o mixtos en el espacio de estados. Para los

procesos discretos en el tiempo, dado que podemos numerar los instantes de tiempo, utilizaremos la

siguiente notación: X(tn ) = X[n].

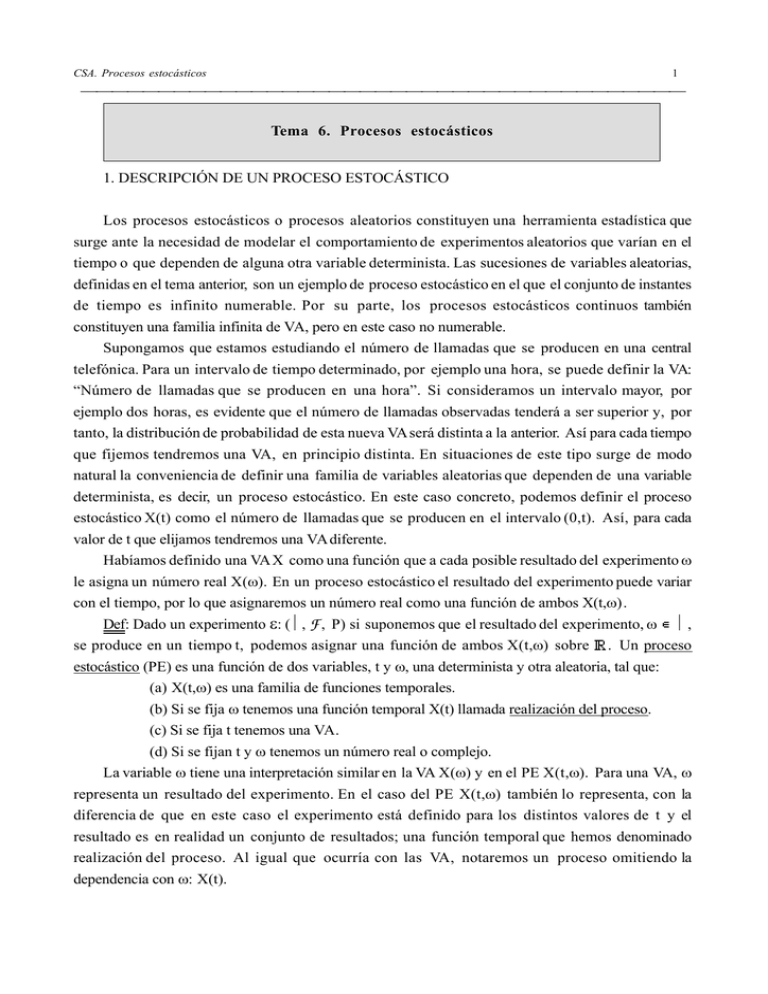

Ejemplo: Distintas realizaciones del proceso X(t)=Ncos((2π/24)t+φ) siendo N y φ VA con

distribuciones P(10) y U(0,2π) respectivamente. En este ejemplo, tanto el espacio de tiempos como

el espacio de estados son continuos.

20

15

10

X(t)

5

0

-5

-10

-15

-20

0

10

20

30

40

tiempo (h)

50

60

70

Ejemplo: El número de llamadas que llegan a una central telefónica es un proceso continuo en el

tiempo pero discreto en el espacio de estados. En la gráfica siguiente se ven 3 realizaciones.

10

Número de llamadas

8

6

4

2

0

5

Tiempo

10

15

CSA. Procesos estocásticos

3

Ejemplo 6.1: Sea el proceso X(t,ω) = at+ Y(ω) con a determinista e Y~U(0,1). En la notación

habitual: X(t) = at+Y. Dibuja una realización del proceso, y especifica los espacios de estados y de

tiempos.

Al estar un PE formado por infinitas VA tendrá sentido hablar de la FD o de la fdp conjunta de

un grupo de ellas o de las marginales correspondientes a las VA individuales. Hablaremos entonces

de orden de la FD o de la fdp en función del número de VA que consideremos.

En lo relativo a la FD, supondremos en todo momento que estamos trabajando con VA reales.

Dado un PE X(t), si fijamos un tiempo t = t0 , tendremos una VA X(t0 ) que tendrá una FD

asociada. Si cambiamos el instante de tiempo tendremos una VA en principio, distinta a X(t0 ), con

una FD diferente. En este sentido, la FD depende del tiempo, por lo que definimos la FD de primer

orden del proceso X(t) como:

FX(x;t) = P(X(t)≤x)

Desde el punto de vista frecuencial podemos interpretar la FD de primer orden de la siguiente

forma: supongamos que realizamos el experimento n veces, en cada una de ellas observamos una

función temporal X(t); con lo que obtenemos n realizaciones. Así, la aproximación frecuencial de

F(x;t) sería el número de trayectorias que toman valores menores o iguales que x en el punto t,

dividido por n.

Derivando respecto a x tendremos la fdp de primer orden.

Análogamente se define la FD de segundo orden como:

F(x1 ,x2 ;t1 ,t2 ) = P(X(t1 ) ≤ x1 , X(t2 ) ≤ x2 )

Calculando las derivadas parciales respecto a x1 y x2 obtendríamos la fdp de segundo orden.

Los conceptos de marginal y distribución o densidad condicionada son análogos a los definidos para

VA bidimensionales. Así, por ejemplo:

F(x1 ;t1 ) = F(x1 ,∞; t1 ,t2 )

f ( x1; t1 ) = ∫

∞

−∞

f (x1, x 2 ; t1, t 2 )dx 2

f ( x1; t1 / X( t 2 ) = x 2 ) =

f ( x1, x 2 ; t1, t 2 )

f (x2 ; t 2 )

4

Departamento de Teoría de la Señal y Comunicaciones. Universidad de Vigo

Ejemplo: Realización de un proceso continuo en el tiempo con fdp de primer orden gaussiana.

fdp en tiempo t=0

fdp en tiempo t=2

fdp en tiempo t=4

Realización del proceso

3

2

1

X(t)

0

-1

-2

-3

-4

-1

0

1

2

Tiempo (t)

3

4

5

Hablaremos en general de FD de orden n como:

F(x1 ,…,xn ; t1 ,…,tn ) = P(X(t1 ) ≤ x1 ,…, X(tn ) ≤ xn )

Calculando las derivadas parciales obtendríamos la fdp de orden n.

Evidentemente una FD o una fdp de orden n determina todas las FD o fdp de orden inferior,

pues son las marginales de ésta.

Para determinar estadísticamente un PE, necesitaríamos conocer la FD o la fdp de orden n, para

cualquier valor de n y para cualquier valor de t1 ,…,tn . Esto es, en la práctica, realmente difícil, por lo

que se estudiarán una serie de parámetros y propiedades de los PE, que, si bien no los determinan

completamente, nos permiten obtener mucha información acerca de ellos.

Un proceso bidimensional consiste en dos procesos X(t) e Y(t) y queda estadísticamente

determinado si conocemos la FD o fdp conjunta de las VA X(t1 ),…, X(tn ); Y(t’1 ),…, Y(t’m) para

cualquier n y m; y para todo t1 , …, tn ; t’1 ,…, t’m

Un proceso complejo Z(t) = X(t)+jY(t) es una familia de funciones complejas y está

estadísticamente determinado en función del proceso bidimensional X(t),Y(t).

CSA. Procesos estocásticos

5

Ejemplo 6.2: Sea el proceso X(t) = at+Y con a determinista e Y~U(0,1). Determina la FD y la fdp de

primer orden.

2. ESTADÍSTICOS DE UN PROCESO ESTOCÁSTICO

Def: Llamaremos media de un PE a:

E{X(t)} = µ X (t) = ∫

+∞

-∞

xf(x;t) dx

En el caso complejo, E{Z(t)} = E{X(t)} + jE{Y(t)}

Para cada valor de t distinto tenemos, en principio, una VA diferente; por lo que tendremos

también una media distinta. Por ello la media de un proceso es, en general, una función dependiente

del tiempo.

Def: Llamaremos autocorrelación de un PE a:

R X (t1, t 2 ) = E{X(t1 )X(t 2 )} =

+∞ + ∞

∫−∞ ∫-∞

x1x 2 f(x1, x 2 ;t1, t 2 ) dx1dx 2

En el caso complejo:

RX(t1 ,t2 ) = E{X(t1 )X* (t2 )}; donde X* (t) representa el conjugado de X(t)

Si t1 =t2 , tenemos la potencia media del proceso : RX(t,t) = E{X2 (t)}

Def: Se define correlación cruzada entre los procesos X(t) e Y(t) como:

RXY(t1 ,t2 ) = E{X(t1 )Y* (t2 )}

Def: Llamaremos autocovarianza de un PE a:

CX(t1 ,t2 ) = E{[X(t1 )-µX(t1 )][X(t2 )-µX(t2 )]} = RX(t1 ,t2 ) -µX(t1 )µX(t2 )

Un caso particular es la función de varianzas (t1 =t2 ):

CX(t,t) = E{[X(t)-µX(t)]2 }= RX(t,t) -µX2 (t)= E{X2 (t)}-µX2 (t) = Var{X(t)}

En el caso complejo:

CX(t1 ,t2 ) = E{[X(t1 )-µX(t1 )][X* (t2 )-µ* X(t2 )]} = RX(t1 ,t2 ) -µX(t1 )µ* X(t2 )

6

Departamento de Teoría de la Señal y Comunicaciones. Universidad de Vigo

Def: Se define covarianza cruzada entre los procesos X(t) e Y(t) como:

CXY(t1 ,t2 ) = E{[X(t1 )-µX(t1 )][Y* (t2 )-µ* Y(t2 )]} = RXY(t1 ,t2 ) -µX(t1 )µ* Y(t2 )

Estos estadísticos son, en general, funciones que dependen de uno o más instantes de tiempo.

Obs: Los conceptos de covarianza y correlación ya habían sido utilizados en la sección de VA. Así como la idea

de covarianza es una extensión lógica de aquella definición, no ocurre lo mismo con la correlación. De todas formas,

tanto la covarianza, como la correlación o el coeficiente de correlación son estadísticos directamente relacionados, cuyo

objetivo es proporcionar una medida de dependencia lineal entre VA. De hecho, es fácil demostrar que son equivalentes si

las medias son cero y las desviaciones típicas una unidad, es decir, si las variables estuviesen tipificadas. Esa

transformación no supone más que un cambio de escala para reducir la correlación al intervalo (-1,1), de tal forma que

toda la información de la relación lineal entre las dos señales está contenida en la esperanza del producto, que es

precisamente como se ha definido la correlación cruzada o la autocorrelación. En procesado de señal se suele usar mas

ésta que la “función de coeficientes de correlación” por ser mas sencilla de calcular y por estar directamente relacionada

con la potencia de la salida en un sistema lineal invariante en el tiempo. Así, si X(t) e Y(t) representan la entrada y la

salida de un sistema lineal, la potencia media en la salida E{Y2 (t)}no es solo función de la potencia media en la entrada

E{X2 (t)}, sino que necesitamos conocer E{[X(t1 )+X(t2 )]2 }, que claramente se calcula a partir de la potencia media en

los tiempos t1 y t2 y a partir de la autocorrelación de X en t1 , t2 .

Ejemplo 6.3: Para el proceso X(t) = at+Y visto en el ejemplo anterior, calcula la esperanza, la

varianza, la autocorrelación y la autocovarianza

CSA. Procesos estocásticos

7

A continuación generalizamos los conceptos, ya estudiados en VA, de independencia, incorrelación y ortogonalidad para PE.

Def: Dos procesos X(t) e Y(t) son independientes si su fdp conjunta de cualquier orden se puede

descomponer como el producto de dos fdp marginales, una conteniendo términos sólo dependientes

del proceso X(t) y la otra dependientes de Y(t).

Def: Dos procesos X(t) e Y(t) son incorrelados si CXY(t1 , t2 ) = 0 para cualquier valor de t1 y t2 .

Def: Dos procesos X(t) e Y(t) son ortogonales si RXY(t1 , t2 ) = 0 para cualquier valor de t1 y t2 .

Obs: Para los procesos discretos en el tiempo utilizaremos la siguiente notación:

E(X[n]) = µX[n]

RX[n1 ,n2 ] = E{X[n1 ]X* [n2 ]}

CX[n1 ,n2 ] = RX[n1 ,n2 ] - µX[n1 ]µ* X[n2 ]

3. ESTACIONARIEDAD

Uno de los objetivos fundamentales de los modelos estocásticos es la predicción. Para ello,

basándonos en la historia del proceso, trataremos de conjeturar su comportamiento futuro. Para poder

hacer esto, necesitamos que las condiciones futuras sean análogas a las pasadas. Esta propiedad se

conoce con el nombre de estacionariedad. De un modo general, podríamos decir que un PE es

estacionario si sus propiedades estadísticas son invariantes ante una traslación de tiempo. Esto

implica que el mecanismo físico subyacente que genera el experimento no cambia con el tiempo.

En la práctica existen muchos fenómenos físicos cuyo comportamiento se puede modelar

mediante un PE estacionario. Como comprobaremos al analizar sus propiedades, una de las ventajas

de estos procesos es que son más sencillos de caracterizar, pues algunos de sus estadísticos no

dependen del tiempo.

Formalmente, diremos que un proceso X(t) es estacionario (en sentido estricto) si sus

propiedades estadísticas no varían al trasladar el origen de tiempos; es decir, X(t) y X(t+ε) tienen las

mismas propiedades estadísticas ε. Expresándolo en términos de la fdp:

Å

X(t) es estacionario ⇔

Ån; Åt1,…,tn; Åε se verifica que:

f(x1 ,…,xn ; t1 ,…,tn ) = f(x1 ,…,xn ; t1 +ε,…,tn +ε)

Diremos que dos procesos X(t) e Y(t) son conjuntamente estacionarios si sus propiedades

estadísticas conjuntas son idénticas a las de X(t+ε) e Y(t+ε) ε.

Un proceso complejo Z(t)=X(t)+jY(t) es estacionario si los son conjuntamente X(t) e Y(t).

Å

Las principales propiedades de los procesos estacionarios son:

Å

1) f(x;t) = f(x;t+ε) ε; por tanto podemos conseguir cualquier valor de t eligiendo el ε

adecuado; es decir, la fdp de primer orden no depende del tiempo, y por tanto, parámetros tales como

la media, que se calculan exclusivamente a partir de la fdp de primer orden, no dependen del tiempo.

8

Departamento de Teoría de la Señal y Comunicaciones. Universidad de Vigo

2) f(x1 ,x2 ; t1 ,t2 ) =f(x1 ,x2 ; t1 +ε,t2 +ε) t1 ,t2 ; ε

En particular si ε=-t1 tenemos que f(x1 ,x2 ; t1 ,t2 ) =f(x1 ,x2 ; τ) con τ = t2 -t1 ; es decir, la fdp de

segundo orden no depende de los instantes temporales que consideremos, sino de la distancia entre

ellos; en particular, los parámetros que dependan sólo de la fdp de segundo orden, como la

autocorrelación o la autocovarianza, dependen sólo de la distancia temporal entre los instantes

considerados, independientemente de dónde estén situados.

Å

Å

Verificar que un proceso es estacionario en sentido estricto es, en general, imposible, pues

implica estudiar infinitas fdp. Por ello estudiaremos otros tipos de estacionariedad.

Def: Un proceso es estacionario de orden k si la condición de estacionariedad estricta se cumple

para todas las fdp de orden n con n≤k.

Def: Un proceso es estacionario en sentido amplio (débilmente estacionario) si:

E{X(t)} = µ (independiente del tiempo)

RX(t1 ,t2 ) = RX(τ) con τ = t2 - t1 (es sólo función de la distancia temporal entre los instantes

considerados)

Evidentemente, si un proceso es estacionario de orden dos, también lo es en sentido amplio.

Este tipo de estacionariedad (la débil) es la más frecuentemente utilizada en la práctica, pues se basa

en parámetros que son fácilmente estimables a partir de una muestra del proceso.

Otros tipos de estacionariedad que podrían definirse son: asintótica, en un intervalo o periódica.

Algunas propiedades de la correlación de procesos estacionarios son:

Si X(t) e Y(t) son PE estacionarios en sentido amplio, se verifica:

1) La potencia media del proceso, E{|X(t)|2 }, no depende de t, ya que:

RX(0) = E{X(t)X* (t)} = E{|X(t)|2 }

2) RXY(-τ) = R* YX(τ) ya que:

RXY(-τ) = E{X(t)Y* (t -τ)} = E{X(λ+τ)Y* (λ)} = R* YX(τ) siendo λ = t-τ.

En particular, si X e Y son reales RXY(-τ) = RYX(τ).

3) RX(-τ) = R* X(τ) ya que:

Haciendo X = Y en 2). En particular, si X es real RX(-τ) = RX(τ).

Ruido blanco

El término “ruido” se emplea en el mundo de las telecomunicaciones para hacer referencia a

señales indeseables que constituyen una interferencia en un sistema de comunicación. En la práctica el

modelo que se emplea habitualmente para estas interferencias es el que se conoce como ruido blanco,

que viene dado por la siguiente definición:

Def: Un proceso X(t) es ruido blanco si CX(t1 ,t2 ) = 0

t1 ≠t2 ; o lo que es lo mismo, las

Å

variables X(t1 ) y X(t2 ) están incorreladas. La autocovarianza del ruido blanco se puede expresar

equivalentemente como:

CSA. Procesos estocásticos

9

C X ( t1 , t 2 ) = q( t1 )δ( t1 − t 2 )

q( t ) ≥ 0

Diremos que el proceso es ruido blanco en sentido estricto si las variables X(t1 ) y X(t2 ) son

independientes. A menudo la distribución que se emplea para modelar el ruido en cada instante es la

distribución gaussiana, en cuyo caso las definiciones de ruido blanco y ruido blanco en sentido

estricto son equivalentes.

Obs: Generalmente se asume que el ruido blanco tiene media cero, por lo que su función de autocorrelación

coincide con su autocovarianza. Además, también es habitual considerar que la varianza del proceso es constante, con lo

cual el ruido blanco constituye un proceso estacionario en sentido amplio.

Tal y como se deduce de su definición, el ruido blanco en sentido estricto presenta una valor en cada instante de

tiempo que no depende de cual haya sido su valor en los instantes precedentes y que no ejerce ninguna influencia en sus

valores futuros.

Los PE se pueden estudiar también en el dominio de la frecuencia. Concretamente para un PE estacionario se

define la densidad espectral de potencia como la transformada de Fourier de su función de autocorrelación:

∞

S(ω ) = ∫ R X ( τ )e − jωτ dτ

−∞

Si aplicamos esta expresión a la función de autocorrelación del ruido blanco de media cero, se obtiene que su

espectro viene dado por una constante, es decir, se trata de un espectro plano, cuya magnitud es común a todas las

frecuencias. El nombre de ruido blanco constrasta de este modo con el término ruido coloreado, que es aquel cuyo

espectro presenta magnitudes distintas para diferentes frecuencias.

4. ERGODICIDAD

Supongamos que sólo tenemos acceso a una realización del PE y pretendemos conocerlo a partir

de esa única función temporal; para ello nos interesará conocer sus estadísticos (media,

autocorrelación, etc). Estudiaremos entonces los promedios temporales del proceso.

Si X(t) es un PE estacionario en sentido amplio, llamaremos valor medio en el tiempo o media

temporal a:

1 T

M X = lim

µT

∫ X(t)dt = Tlim

→∞

T →∞ 2T − T

Llamaremos autocorrelación temporal a:

1 T

A X ( τ) = lim

∫ X(t)X(t + τ) dt

T →∞ 2T − T

Ambas son VA con valores diferentes para cada realización del proceso.

Las definiciones son similares para el caso discreto. Para un PE en tiempo discreto X[k],

estacionario en sentido amplio y definido para valores enteros de k, con k≥0, la media temporal y la

autocorrelación temporal se calcularían mediante las siguientes expresiones respectivamente:

1 N −1

M X = lim

∑ X[k]

N →∞ N

k =0

1 N −1

A X ( τ) = lim

∑ X[k]X[k + τ]

N →∞ N

k =0

10

Departamento de Teoría de la Señal y Comunicaciones. Universidad de Vigo

Obs: Si el proceso estuviese definido para índices k≥1, las expresiones anteriores serían

equivalentes, pero en el denominador, en lugar de N estaría el número de sumandos (N-1).

Diremos que un proceso es ergódico si sus promedios estadísticos se pueden calcular a partir de

una realización; es decir, si sus promedios estadísticos coinciden con sus promedios temporales.

Hablaremos por tanto de ergodicidad en media y de ergodicidad en autocorrelación.

Ergodicidad en media:

Dado que la media temporal no depende del tiempo, para que un PE sea ergódico en media es

necesario que la media del proceso sea constante, lo cual tenemos asegurado si el proceso es

estacionario.

El hecho de decir que el límite de una VA coincide con una constante, se interpreta así:

1 T

X(t)dt

Sea µ T =

2T ∫− T

Un proceso será ergódico en media si, con probabilidad 1:

µT → µ cuando T→ ∞

1 T

µT es una VA con media: E(µ T ) =

E(X(t))dt = µ , Por tanto:

2T ∫− T

{

µ T T

→ µ ⇔ σ 2T T

→ 0 ⇔ E (µ T − µ )

→∞

→∞

2

} → 0

T →∞

Por ello, para estudiar la ergodicidad, se halla el promedio temporal en un intervalo finito (-T,T)

y se estudia si la varianza de la integral resultante tiende a cero cuando T tiende a ∞.

Ejemplo:

Sea la VA A con distribución N(0,1). A partir de ella se construye el PE X(t) = A ∀t.

Evidentemente, E{X(t)} = 0 ∀t. Sin embargo:

1 T

1 T

µT =

X(t)dt =

Adt = A ≠ 0

∫

2T − T

2T ∫− T

Claramente el PE no es ergódico en media. Lo que si es cierto en cualquier caso es que E(µT) =

µX; en nuestro caso E(A) = 0.

Ergodicidad en autocorrelación:

Intentaremos determinar la autocorrelación de un proceso estacionario en términos de una

realización. Sea:

RX(τ) = E{X(t)X(t+τ)}

Construimos el proceso : Zτ(t) = X(t)X(t+τ)

Evidentemente E{Zτ(t)} = RX(τ)

Por tanto, el proceso X(t) será ergódico en autocorrelación si y solo si el proceso Zτ(t) es

ergódico en media.

CSA. Procesos estocásticos

11

Å

Ejemplo 6.4: La señal de entrada de un conversor es un PE X[n] tal que X[n]~N(µ,σ)

n=0,1,..;

siendo X[n] y X[m] independientes

n ≠ m. La salida del conversor es el proceso

X(t)=X[ParteEntera(t)], con t ≥0.

a) Indica el rango de X(t) y representa gráficamente una realización del proceso.

b) Estudia la estacionariedad y la ergodicidad en media de X(t).

c) ¿Es el proceso X[n] estacionario en autocorrelación?

d) Estudia la estacionariedad y la ergodicidad en autocorrelación de X(t).

Å

5. EJEMPLO

Sea X(t) = Acos(ωt+φ) donde φ es una VA U(-π,π) con A y ω deterministas. Determina:

a) densidad de primer orden

b) E{X(t)}

c) RX(t1 , t2 )

d) Estudia la estacionariedad en sentido amplio

e) La media y la autocorrelación temporales

f) Estudia la ergodicidad.

12

Departamento de Teoría de la Señal y Comunicaciones. Universidad de Vigo

CSA. Procesos estocásticos

13

EJERCICIOS PROPUESTOS:

FD de un PE. Li. Problema 6.2. Pag. 301.

FD y esperanza de un PE. Papoulis. 3ª ed.: Prob. 10.1. Pag. 340. 2ª ed.: Prob. 9.1. Pag. 258.

Estadísticos de un PE. Li. Problema 6.5. Pag. 301.

Correlación de la suma y la diferencia. Li. Problema 6.32. Pag. 305.

Estacionariedad y autocorrelación. Li. Problemas de autoevaluación 6.3. Pag. 310.

Estacionariedad y autocovarianza. Papoulis. 3ª ed.: Problema 10.10. Pag. 340.

Correlación cruzada. Li. Ejemplos adicionales 6.24. Apartados a), b) y c). Pag. 298.

LECTURAS RECOMENDADAS:

Stark: Introducción y apartado 8.1

Li: Apartados 6.1 y 6.3.

INFORMACIÓN Y DOCUMENTACIÓN ADICIONAL:

La documentación de este tema se complementa con un boletín de problemas. En clases de

laboratorio se realizará una práctica de ordenador (práctica #8). Esta práctica dispone de un enunciado

que es recomendable leer antes de asistir al laboratorio. Todo el material de la asignatura está

disponible en la fotocopiadora y en la dirección:

http://www.tsc.uvigo.es/Docencia/FichasAsignaturas/csa.php