Grupo ARCO - Universidad de Castilla

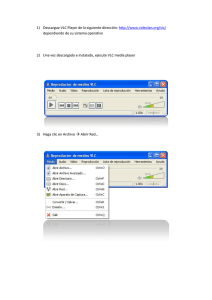

Anuncio

UNIVERSIDAD DE CASTILLA-LA MANCHA

ESCUELA SUPERIOR DE INFORMÁTICA

INGENIERÍA

EN INFORMÁTICA

PROYECTO FIN DE CARRERA

Captura y filtrado de vı́deo desde fuentes RTSP/RTP

Rafael Cabanillas Carrillo

Junio, 2008

UNIVERSIDAD DE CASTILLA-LA MANCHA

ESCUELA SUPERIOR DE INFORMÁTICA

Departamento de Informática

PROYECTO FIN DE CARRERA

Captura y filtrado de vı́deo desde fuentes RTSP/RTP

Autor: Rafael Cabanillas Carrillo

Director: Francisco Moya Fernández

Junio, 2008

TRIBUNAL:

Presidente:

Vocal 1:

Vocal 2:

Secretario:

FECHA DE DEFENSA:

CALIFICACIÓN:

PRESIDENTE

Fdo.:

VOCAL 1

Fdo.:

VOCAL 2

Fdo.:

SECRETARIO

Fdo.:

c Rafael Cabanillas Carrillo. Se permite la copia, distribución y/o modificación de este docu

mento bajo los términos de la licencia de documentación libre GNU, versión 1.1 o cualquier versión

posterior publicada por la Free Software Foundation, sin secciones invariantes. Puede consultar esta

licencia en http://www.gnu.org.

Este documento fue compuesto con LATEX. Imágenes generadas con OpenOffice.

Resumen

Existe un gran número de cámaras de vı́deo que transportan su señal a través de la red.

Serı́a una buena idea poder utilizar técnicas de tratamiento y filtrado de imágenes para poder

procesar este tipo de señales de vı́deo.

En este proyecto se propone un marco de trabajo que permita capturar la señal de vı́deo

procedente de la red, y en particular, de flujos RTSP/RTP, y una vez capturada poder realizar

cualquier tipo de tratamiento de imágenes.

Dentro de estas técnicas de tratamiento de imágenes, se ha puesto gran empeño en utilizar

técnicas basadas en la visión por computador que permitan diferenciar entre distintos gestos

y signos que se realicen con las manos.

Abstract

There is a wide number of video cameras which transmit their signal through the net. It

would be an interesting idea to be able to use image processing and filtering techniques in

order to process this type of video signals.

This project intends to propose a framework which allows capturing the video signal from

the net, and in particular, from RTSP/RTP streams. Once the signal has been captured it will

be possible to carry out any type of image processing.

Within these image processing techniques, a great emphasis has been placed on the use

of techniques based on computer vision that make it possible to distinguish between different

gestures and signs made with the hands.

A Mamá y Papá.

Porque dos no es igual que uno más uno

Agradecimientos

Necesitarı́a muchas lı́neas para agradecer a todas las personas que han contribuido, de

una manera u otra, para que llegue hasta aquı́; como el espacio es reducido espero que los no

incluidos lo entiendan.

A Francisco Moya por sus grandes ideas, su ayuda y su apoyo. A mis padres, porque sin

ellos nunca hubiera podido conseguirlo. A Amanda, gracias, por haber venido a abrigarme el

corazón. A Lara y Amparo por ser las mejores hermanas del mundo. A Iñaki y Manolo por

su compañı́a y amistad en este largo viaje. A mis compañeros del grupo Arco por cederme un

sitio donde realizar este proyecto. A Gorka, Jose, Adri, Matas, Raul y De la Cruz por formar

una gran familia en tierras escandinavas. A Pedro, por estar siempre cuando lo necesito.

Sin todos vosotros esto nunca hubiera sido posible. Muchas gracias a todos.

Índice general

Índice de figuras

III

Índice de cuadros

V

1. Introducción

1.1. Motivación . . . . . . .

1.2. Proyecto Hesperia . . . .

1.3. Justificación del trabajo .

1.4. Estructura del documento

.

.

.

.

1

1

2

4

5

2. Objetivos del proyecto

2.1. Objetivo principal . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2.2. Objetivos secundarios . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6

6

7

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

3. Antecedentes, Estado de la Cuestión

3.1. Introducción . . . . . . . . . . . . . . . . . . . . . . .

3.2. Conceptos de los protocolos de transmisión de vı́deo .

3.2.1. RTSP . . . . . . . . . . . . . . . . . . . . . .

3.2.2. RTP . . . . . . . . . . . . . . . . . . . . . . .

3.3. Herramientas de captura de vı́deo RTSP/RTP . . . . .

3.3.1. Introducción . . . . . . . . . . . . . . . . . .

3.3.2. Librerı́as RTP . . . . . . . . . . . . . . . . . .

3.3.3. Codecs de audio y vı́deo . . . . . . . . . . . .

3.4. Visión por computador y procesamiento de imágenes .

3.4.1. Introducción . . . . . . . . . . . . . . . . . .

3.4.2. Aplicaciones . . . . . . . . . . . . . . . . . .

3.4.3. Etapas de un sistema de visión por computador

3.4.4. OpenCV . . . . . . . . . . . . . . . . . . . .

3.4.5. Bazar . . . . . . . . . . . . . . . . . . . . . .

3.4.6. Gandalf . . . . . . . . . . . . . . . . . . . . .

3.4.7. ARToolKit . . . . . . . . . . . . . . . . . . .

3.4.8. VXL . . . . . . . . . . . . . . . . . . . . . .

3.4.9. NeatVision . . . . . . . . . . . . . . . . . . .

3.4.10. Herramientas comerciales . . . . . . . . . . .

I

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

10

11

11

11

16

20

20

20

27

31

31

32

34

42

44

45

46

49

51

52

ÍNDICE GENERAL

II

4. Método de trabajo

4.1. Introducción . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.2. Fase de análisis y requisitos . . . . . . . . . . . . . . . . . . . . . . . . .

4.2.1. Análisis de Herramientas . . . . . . . . . . . . . . . . . . . . . .

4.2.2. Herramientas de tratamiento de imágenes y visión por computador

4.2.3. Descripción de cada caso de uso . . . . . . . . . . . . . . . . . .

4.3. Fase de diseño . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.3.1. Capturar la señal RTSP/RTP . . . . . . . . . . . . . . . . . . . .

4.3.2. Dividir la señal en frames . . . . . . . . . . . . . . . . . . . . .

4.3.3. Filtrado de cada frame por separado . . . . . . . . . . . . . . . .

4.3.4. Rehacer la señal . . . . . . . . . . . . . . . . . . . . . . . . . .

4.3.5. Enviar la señal . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.3.6. Mostrar el vı́deo . . . . . . . . . . . . . . . . . . . . . . . . . .

4.3.7. Visión general del sistema . . . . . . . . . . . . . . . . . . . . .

4.4. Fase de implementación . . . . . . . . . . . . . . . . . . . . . . . . . .

4.4.1. Capturar la señal RTP/RTSP . . . . . . . . . . . . . . . . . . . .

4.4.2. Dividir la señal en frames . . . . . . . . . . . . . . . . . . . . .

4.4.3. Filtrado de cada frame por separado . . . . . . . . . . . . . . . .

4.4.4. Rehacer la señal . . . . . . . . . . . . . . . . . . . . . . . . . .

4.4.5. Enviar la señal . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.4.6. Mostrar el vı́deo . . . . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

56

57

58

60

63

65

75

75

77

79

81

82

83

84

87

88

92

98

108

109

110

5. Resultados

5.1. Introducción . . . . . . . . . . . . . . . .

5.2. Resultados del proceso de captura . . . .

5.2.1. Eficiencia al realizar la captura . .

5.2.2. Posibilidad de trabajo distribuido

5.3. Resultados del clasificador de Manos . . .

5.4. Resultados en la detección de gestos . . .

5.4.1. Eficiencia . . . . . . . . . . . . .

5.4.2. Interacción con el computador . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

111

111

111

112

114

118

122

122

124

6. Conclusiones y Propuestas

6.1. Conclusiones . . . . . . . . . . . . .

6.2. Lı́neas de investigación abiertas . . .

6.2.1. Detector de gestos . . . . . .

6.2.2. Detector de manos . . . . . .

6.2.3. Movimiento de cámaras Axis

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

126

126

128

128

129

130

.

.

.

.

.

.

.

.

.

.

A. Manual de usuario

131

A.1. Instalación . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 131

A.2. Ejecución . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 131

Bibliografı́a

134

Índice de figuras

1.1. Uso de la aplicación como cámara virtual . . . . . . . . . . . . . . . . . . .

5

2.1. Visión global de la aplicación . . . . . . . . . . . . . . . . . . . . . . . . . .

7

3.1.

3.2.

3.3.

3.4.

3.5.

3.6.

Uso de RTSP de los protocolos TCP y UDP . . . . . . . . . . . . . . . . . .

Proceso RTSP . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Encabezado de un paquete RTP . . . . . . . . . . . . . . . . . . . . . . . . .

Envio y recepción de paquetes con Java.net.RTP . . . . . . . . . . . . . . . .

Visión General VLC . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Resonancia magnética (izquierda) e imagen binaria (derecha) resultado de

cambiar el valor de los pixels . . . . . . . . . . . . . . . . . . . . . . . . . .

3.7. Vehiculo robot ”Stanley”desarrollado en la Univeridad de Stanford . . . . .

3.8. Etapas de la visión por computador . . . . . . . . . . . . . . . . . . . . . .

3.9. Funcionamiento de un filtro . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.10. Ecualizado del histograma sobre una imagen: (arriba) imagen original con su

correspondiente histograma; (abajo) ecualizado del histograma. . . . . . . . .

3.11. Segmentación de una imagen en color . . . . . . . . . . . . . . . . . . . . .

3.12. Dependencias de una aplicación desarrollada con ARToolkit y otras librerı́as.

3.13. Proceso de ARToolKit. . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.14. Distintos tipos de formatos para representar una imagen en ARToolKit . . . .

3.15. Diagrama de bloques desarrollado dentro de NeatVision . . . . . . . . . . . .

3.16. Ejemplo de funcionamiento de WiT . . . . . . . . . . . . . . . . . . . . . .

4.1. Fases de desarrollo . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.2. Vista funcional de la aplicación . . . . . . . . . . . . . . . . . . . . . . .

4.3. Diagrama de análisis del caso de uso Capturar la señal RTP/RTSP . . . .

4.4. Diagrama de análisis del caso de uso Dividir la señal en frames . . . . . .

4.5. Diagrama de análisis del caso de uso Filtrado de cada frame por separado

4.6. Diagrama de análisis del caso de uso Rehacer la señal . . . . . . . . . . .

4.7. Diagrama de análisis del caso de uso Enviar la señal . . . . . . . . . . . .

4.8. Diagrama de análisis del caso de uso Mostrar el vı́deo . . . . . . . . . . .

4.9. Captura de la señal de vı́deo a través de VLC . . . . . . . . . . . . . . .

4.10. Diagrama de secuencia del caso de uso Capturar la señal RTP/RTSP . . .

4.11. De picture t a IplImage . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.12. Diagrama de secuencia del caso de uso dividir la señal en frames . . . . .

III

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

12

16

19

26

30

32

33

34

36

37

39

48

49

49

52

55

58

59

65

67

69

71

72

74

76

77

78

79

ÍNDICE DE FIGURAS

IV

4.13. Proceso del filtro de detección de gestos . . . . . . . . . . . . . . . . . . . . 80

4.14. Diagrama de secuencia del caso de uso filtrado de cada frame por separado . 80

4.15. Diagrama de secuencia del caso de uso rehacer la señal . . . . . . . . . . . . 82

4.16. Diagrama de secuencia del caso de uso enviar la señal . . . . . . . . . . . . . 83

4.17. Diagrama de secuencia del caso de uso mostrar vı́deo . . . . . . . . . . . . . 84

4.18. Diseño general de la aplicación . . . . . . . . . . . . . . . . . . . . . . . . . 85

4.19. Arquitectura general de la aplicación . . . . . . . . . . . . . . . . . . . . . . 87

4.20. Plano de una picture t . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 96

4.21. Etapas para realizar el clasificador de manos . . . . . . . . . . . . . . . . . . 100

4.22. Ejemplo de la muestra de imágenes negativas utilizadas . . . . . . . . . . . . 101

4.23. Ejemplo de las imágenes positivas utilizadas . . . . . . . . . . . . . . . . . . 102

4.24. Ejemplo de la muestra . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 103

4.25. Ejemplo de posibles gestos . . . . . . . . . . . . . . . . . . . . . . . . . . . 105

4.26. Proceso de cambios de color si no hay cambios en la imagen . . . . . . . . . 106

4.27. Proceso de gesto . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 107

4.28. Ejemplo de imagen patrón que representa cerrar el puño y mover el dedo ı́ndice108

5.1. Tiempo obtenidos en la medidas realizando la conversión(azul) y sin realizar

la conversión (rojo) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.2. Arquitectura distribuida: unión de flujos de vı́deo . . . . . . . . . . . . . . .

5.3. Imagen panorámica a partir de las fuentes de 3 cámaras . . . . . . . . . . . .

5.4. Arquitectura distribuida: Filtrado por separado . . . . . . . . . . . . . . . . .

5.5. Arquitectura distribuida: Filtrado por separado con la misma señal de vı́deo .

5.6. Imágenes resultado del test del clasificador . . . . . . . . . . . . . . . . . . .

5.7. Imágenes resultado del test del clasificador con falsos positivos . . . . . . . .

5.8. Gesto 1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.9. Gesto 2 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

114

115

116

117

118

121

122

123

123

6.1. Lenguaje de signos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 129

A.1. Interfaz de la aplicación . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 132

A.2. Interfaz de la aplicación cuando se reproduce un flujo de vı́deo . . . . . . . . 133

Índice de cuadros

3.1. Descripción de los componentes principales de IplImage . . . . . . . . . . .

44

4.1. Comparativa de las librerı́as RTP . . . . . . . . . . . . . . . . . . . . .

4.2. Comparativa de las herramientas de codificación y decodificación . . .

4.3. Comparativa de las librerı́as de visión por computador . . . . . . . . . .

4.4. Comparativa de las librerı́as de visión por computador (II) . . . . . . .

4.5. Descripción textual del caso de uso Capturar la señal RTSP/RTP . . . .

4.6. Descripción textual del caso de uso Dividir la señal en frames . . . . . .

4.7. Descripción textual del caso de uso Filtrado de cada frame por separado

4.8. Descripción textual del caso de uso Rehacer la señal . . . . . . . . . . .

4.9. Descripción textual del caso de uso Enviar la señal . . . . . . . . . . .

4.10. Descripción textual del caso de uso Mostrar el vı́deo . . . . . . . . . .

4.11. Elementos más importantes de la estructura picture t . . . . . . . . . .

4.12. Elementos más importantes de la estructura IplImage . . . . . . . . . .

4.13. Elementos más importantes de la estructura plane t . . . . . . . . . . .

4.14. Campos del array ImageData . . . . . . . . . . . . . . . . . . . . . . .

61

62

64

64

66

68

70

72

73

75

94

94

95

97

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

5.1. Tiempos en us de los 20 primeros frames . . . . . . . . . . . . . . . . . . . . 113

5.2. Resultados de las pruebas del clasificador . . . . . . . . . . . . . . . . . . . 120

5.3. Resultados de las pruebas realizadas al detector de gestos . . . . . . . . . . . 123

V

Listings

3.1.

3.2.

3.3.

3.4.

3.5.

4.1.

4.2.

4.3.

4.4.

4.5.

Ejemplo de envı́o de datos con ccRTP . . . . . . .

Ejemplo de recepción de datos con ccRTP . . . . .

Ejemplo de envı́o de datos con oRTP . . . . . . . .

Ejemplo de recepción de datos con oRTP . . . . .

Ejemplo de envı́o de paquetes con Java.Net.RTP . .

Descripción del Plugin . . . . . . . . . . . . . . .

Descripción de la estructura vout sys t . . . . . . .

Extraer imágenes del hilo de vı́deo . . . . . . . . .

Algoritmo de tranformación de picture t a IplImage

Algoritmo de detección de gestos . . . . . . . . . .

VI

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

. 22

. 22

. 24

. 24

. 27

. 89

. 91

. 93

. 98

. 107

Capı́tulo 1

Introducción

1.1. Motivación

1.2. Proyecto Hesperia

1.3. Justificación del trabajo

1.4. Estructura del documento

1.1.

Motivación

En los últimos años los sistemas de vı́deo han sufrido un gran avance. Se han introducido

grandes cambios en el ámbito del vı́deo para cubrir las necesidades demandadas por los usuarios. Entre estos cambios se pueden destacar: el aumento de la calidad, los nuevos formatos o

las nuevas resoluciones. Además, debido a la mejora de las lı́neas y redes de telecomunicación

han surgido nuevas formas de visualización de vı́deo y audio como pueden ser:

Vı́deo bajo Demanda (VOD): En el que se permite al usuario el acceso a contenidos

multimedia a través de la red.

Videoconferencia: Comunicación simultánea bidireccional de audio y vı́deo entre varios usuarios.

Intercambio de vı́deos: Varios usuarios pueden compartir vı́deos a través de la red.

1

1.2. Proyecto Hesperia

2

Por otro lado, una imagen puede aportar mucha más información de la que es visible por

el ojo humano, por lo que existen cada vez mejores sistemas basados en la visión por computador aplicados a númerosos campos como pueden ser: medicina, seguridad, robótica, trafico,

etc. Se aplican técnicas complejas que permiten al usuario la extracción de información a

partir de una imágen.

Serı́a muy interesante poder unir estos dos aspectos, es decir, aplicar técnicas de tratamiento de imágenes y visión por computador sobre el elevado número de contenidos multimedia

en la red. Este proyecto viene motivado por esta idea, para poder crear un marco de trabajo

que permita el filtrado y extracción de información de los flujos de vı́deo a través de la red.

Una de las posibles aplicaciones de este proyecto es contribuir en el proyecto Hesperia [17]

que se comentará en la siguiente sección.

1.2.

Proyecto Hesperia

El proyecto Hesperia [17] tiene por objeto el desarrollo de tecnologı́as que permitan la

creación de sistemas punteros de seguridad, vı́deo vigilancia y control de operaciones de

infraestructuras y espacios públicos. El proyecto surge para dar respuesta a una demanda

sostenida a medio y largo plazo, en particular, en paı́ses de la Unión Europea y en Estados

Unidos. La gestión integrada de seguridad y control de operaciones permitirá la implantación

de sistemas rentables que, en este momento, no existen en el mercado.

Las tecnologı́as del proyecto resolverán la seguridad en dos tipos de escenarios:

Permitirán gestionar la seguridad y las operaciones de infraestructuras públicas especialmente sensibles, como subestaciones eléctricas, en gas, depósitos de agua o estaciones de telecomunicaciones.

Incrementarán de forma sustancial los niveles de seguridad de grandes espacios públicos, como aeropuertos, estaciones de ferrocarril, puertos, centros de ciudades especialmente en zonas peatonales, centros comerciales, etc.

Las caracterı́sticas a resolver más importantes en este proyecto son las siguientes:

Detectar amenazas a ciudadanos e instalaciones.

1.2. Proyecto Hesperia

3

Presentar la información del entorno de forma adecuada y fácil de entender por las

personas.

Garantizar la seguridad en el acceso a la información del sistema.

Garantizar la privacidad de las personas.

Investigar hechos e incidentes que permitan prevenir futuras amenazas.

Proporcionar información sı́ncrona de las operaciones del sistema que permita incrementar el control y mejorar futuras actuaciones.

Se utilizarán las siguientes tecnologı́as para poder resolver los aspectos mencionados anteriormente:

Tecnologı́as de Arquitectura y Sistema: El sistema propuesto es un sistema complejo y

distribuido, capaz de analizar la información audiovisual para aumentar la seguridad de

las personas y las instalaciones y de operar éstas de forma óptima y fiable.

Tecnologı́as de Visión y Audio cognitivo y de Sistemas Basados en Conocimiento: Dotarán al sistema de la capacidad de poder detectar de forma automática eventos audiovisuales diferentes de “lo normal” y la indexación automática de secuencias grabadas.

Tecnologı́as de Representación de Contenidos e Interfaz de Usuario: Incluye la presentación de los contenidos audiovisuales y del conocimiento en entornos de alto valor

visual y la interacción del usuario con la información en tiempo real.

Este proyecto está parcialmente financiado por el CDTI, organismo adscrito al Ministerio de Industria Turismo y Comercio, invirtiendo un 45 % del presupuesto , proviniendo el

restante del sector privado.

En este proyecto participan las siguientes empresas: Indra Software Labs, Unión Fenosa,

Tecnobit, SAC Control, Technosafe, Visual Tools y Brainstorm Multimedia. Por otro lado,

están también presentes las siguientes Universidades e instituciones públicas: Universidad

de Castilla La Mancha, Universidad de Granada, Universidad de Extremadura, Universidad

1.3. Justificación del trabajo

4

Politécnica de Madrid, Universidad de las Palmas, Universidad Politécnica de Valencia, Universidad Politécnica de Cataluña, Centro Superior de Investigaciones Cientı́ficas(CSIC) y el

Centro Tecnológico del Paı́s Vasco (Ikerlan).

1.3.

Justificación del trabajo

En este proyecto se pretende realizar un marco de trabajo que permita la utilización de

diferentes tipos de filtros de forma sencilla en flujos de vı́deos RTSP/RTP [28]. Es decir, realizar una aplicación que capture flujos de video RTSP/RTP que separe y filtre cada imagen por

separado, para poder posteriormente recomponer el flujo RTSP/RTP y vuelva a ser enviado a

través de la red. Este trabajo está justificado por los siguientes aspectos:

Los sistemas desarrollados para la captura y filtrado de vı́deo RTSP/RTP no son totalmente eficientes, podemos destacar los siguientes:

• OpenCV [15]: Librerı́as para visión por computador desarrolladas por Intel, estas

librerı́as ya poseen un sistema para la captura de vı́deo RTSP, pero no es muy

eficiente ya que la calidad de la captura de las imágenes es bastante pobre, la

recepción del flujo es lento por lo que dificulta el tratamiento de las imágenes en

tiempo real y no tiene soporte para el estandar MPEG-4, requisito fundamental

para las cámaras del proyecto Hesperia.

• Existen gran variedad de reproductores que capturan flujos RTSP pero no permiten el tratamiento y filtrado de la señal. Entre estos se pueden destacar Windows

Media Player, Real One Player, Winamp, etc.

Poder convertir un simple módulo de captura y filtrado de RTSP en una cámara virtual sin modificar el programa. Ya que un usuario puede recibir directamente el flujo

RTSP procedente de nuestra aplicación, que es una transformación del flujo original

que produce la cámara real.

1.4. Estructura del documento

5

Figura 1.1: Uso de la aplicación como cámara virtual

Implementación en una arquitectura escalable.

En este tipo de servicios se requiere un flujo continuo y sostenido de datos, por lo que

el transporte y el tratamiento de los datos se producen de forma simultánea.

1.4.

Estructura del documento

En el siguiente capı́tulo del documento se analizará con más precisión la descripción del

problema, ası́ como los objetivos perseguidos en este proyecto. En el capı́tulo 3, se tratarán

los trabajos relacionados con este proyecto, ası́ como el estado de la cuestión donde se propondrán las diferentes alternativas encontradas para realizar el proyecto. Posteriormente en el

capı́tulo 4 se explicará tanto el análisis como el diseño del sistema. En el capı́tulo 5, se muestran los resultados obtenidos en las distintas pruebas que se han realizado sobre el sistema.

Finalmente, en el último capı́tulo se resumirán las conclusiones obtenidas tras la realización

del proyecto, incluyendo las posibles mejoras y trabajos futuros que podrı́an realizarse.

Capı́tulo 2

Objetivos del proyecto

2.1. Objetivo principal

2.2. Objetivos secundarios

2.1.

Objetivo principal

Como se ha explicado en el capı́tulo anterior, el objetivo principal de este proyecto es el de

realizar un marco de trabajo para capturar flujos de video RTSP/RTP que permita añadir todo

tipo de filtros y mecanismos de procesamiento de imágenes. Es decir, realizar una aplicación

que permita la captura de un flujo de vı́deo procedente de una fuente RTP/RTSP, procesar y

tratar cada imagen por separado, para posteriormente rehacer el flujo RTP/RTSP, bien para

mostrarlo por pantalla o para ser enviado a otros dispositivos a través de la red.

6

2.2. Objetivos secundarios

7

Figura 2.1: Visión global de la aplicación

En la Figura 2.1 se puede ver una visión más detallada del proceso de captura que realizará la aplicación, se ha dividido este proceso en 5 etapas que se describen a continuación:

1. La aplicación recibe una señal de vı́deo RTSP.

2. La señal es capturada y fragmentada en frames.

3. Los frames son mandados al filtro.

4. Se filtran cada uno de los frames.

5. Se recompone la señal RTSP para ser visualizada o enviada a través de la red.

Por lo que a partir de un flujo de vı́deo RTSP, se obtendrá otro flujo tras procesar el primero,

que nos permitira su visualización y recoger los datos más relevantes en la etapa de filtrado.

2.2.

Objetivos secundarios

A continuación se describirán con más detalle otros objetivos que se pretenden alcanzar

en este proyecto:

Detección de caras: Desarrollar algoritmos de filtrado que nos permitan detectar cuando

en una cierta imagen existe un rostro humano. Es muy útil la realización de este tipo

2.2. Objetivos secundarios

8

de filtrados, ya que nos puede permitir almacenar en una base de datos el rostro de las

personas que han pasado por una cierta cámara, incluso se puede procesar la imagen

de la cara para compararla en tiempo real con otras imágenes faciales, lo que puede

permitir la identificación de personas.

Detección de gestos realizados con las manos: Desarrollar algoritmos de filtrado que

nos permitan primero detectar si en una imagen hay una mano y si es ası́ diferenciar si

está mano esta realizando algun gesto que tenga significado para el sistema.

Compatibilidad con MPEG-4: Es un grupo de estándares de codificación de audio y

vı́deo, ası́ como su tecnologı́a relacionada normalizada por el grupo MPEG (Moving

Picture Experts Group) de ISO/IEC. Los usos principales del estándar MPEG-4 son los

flujos de medios audiovisuales, la distribución en CD y emisión de televisión. Es un

requisito fundamental para el proyecto Hesperia ya que las cámaras desarrolladas para

este proyecto utilizan dicho estándar.

Tiempo real: La captura y filtrado de vı́deo se realizará en tiempo real por lo que este

ciclo que se ha explicado en la sección anterior no se realizará para todo el conjunto de

la señal, sino que se hará para cada frame del flujo. Es decir, antes de que el frame n de

un flujo sea capturado, el frame n-1 ha tenido que ser procesado.

Eficiencia: Al ser un sistema en tiempo real, la eficiencia es muy importante ya que se

requiere una gran velocidad en la captura y el filtrado de las imágenes para que no exista

un gran desfase respecto a la imagen original. Por lo que se va a poner un gran esfuerzo

en que el sistema sea lo más eficiente posible, ya que si este tipo de sistemas se quiere

integrar en el ámbito de la seguridad se debe poder actuar a tiempo para poder prevenir

acciones, no valdrı́a de nada que la aplicación detectara a una persona “peligrosa” si

cuando esto ocurre la persona ya ha cometido el delito.

Dar una gestión dinámica de los recursos. Por ejemplo, la memoria, ya que al ser un

sistema en tiempo real el buen tratamiento de la memoria es muy importante, porque

si se nos van almacenando los frames desperdiciarı́amos la memoria y el sistema se

colapsarı́a.

2.2. Objetivos secundarios

9

Proporcionar una sencilla instalación del software.

Proporcionar un sistema multiplataforma. El sistema debe desarrollarse de tal forma

que se permita su ejecución en distintos sistemas operativos y distinto hardware.

Proporcionar un sistema basado en estándares abiertos. Ası́ se asegura la portabilidad

entre las distintas arquitecturas y sistemas operativos.

Desarrollar el sistema utilizando tecnologı́as libres. Las partes principales de este proyecto se desarrollarán utilizando herramientas de código abierto para garantizar la continuidad del proyecto por la comunidad de usuarios y desarrolladores, el proyecto empleará tecnologı́as con licencia GPL y su distribución se realizará bajo licencia GNU

Public License.

Capı́tulo 3

Antecedentes, Estado de la Cuestión

3.1. Introducción

3.2. Conceptos de los protocolos de transmisión de vı́deo

3.2.1. RTSP

3.2.2. RTP

3.3. Herramientas de captura de vı́deo RTSP/RTP

3.3.1. Introducción

3.3.2. Librerı́as RTP

3.3.3. Codecs de audio y vı́deo

3.4. Visión por computador y procesamiento de imágenes

3.4.1. Introducción

3.4.2. Aplicaciones

3.4.3. Etapas de un sistema de visión por computador

3.4.4. OpenCV

3.4.5. Bazar

3.4.6. Gandalf

3.4.7. ARToolKit

3.4.8. VXL

3.4.9. NeatVision

3.4.10. Herramientas comerciales

10

3.1. Introducción

3.1.

11

Introducción

Como se explicó en el capı́tulo anterior, el objetivo principal de este proyecto es realizar

un framework que permita capturar un flujo de vı́deo RTSP/RTP permitiendo el tratamiento de

la señal; es decir que permita realizar cambios en el vı́deo y extraer algunos datos necesarios

de las imágenes. Para realizar estas operaciones se necesitan 2 tipos de herramientas:

Herramientas que permitan el tratamiento de flujos RTSP/RTP.

Herramientas que permitan el tratamiento de las imágenes y la extracción de datos como

pueden ser herramientas basadas en la visión por computador. Que además permitan

conseguir los objetivos de detección de caras, manos y gestos.

Hay una herramienta que ya posee ambas funcionalidades, ésta es OpenCV y este proyecto

no serı́a necesario, ya que esta herramienta permite capturar y filtrar flujos RTSP/RTP, pero

como se ha explicado en el capı́tulo 1, esta herramienta aunque es muy eficiente con respecto

al tratamiento de imágenes y la visión por computador tiene muchas deficiencias con respecto

a la captura de flujos RTP/RTSP porque la calidad de la captura de las imágenes es bastante

pobre, la recepción del flujo es lento por lo que dificulta el tratamiento de las imágenes en

tiempo real y no tiene soporte para el estándar MPEG-4.

En este capı́tulo se estudiarán estos dos conceptos ası́ como las diferentes aplicaciones

que permiten realizar estas operaciones.

3.2.

Conceptos de los protocolos de transmisión de vı́deo

3.2.1.

RTSP

El protocolo de streaming en tiempo real (RTSP) [28], cuyas siglas vienen de su definición

inglesa Real-Time Streaming Protocol, establece y controla uno o varios flujos sincronizados

tanto de vı́deo como de audio. RTSP actúa como un control de red remoto para servicios

multimedia.

Según el grupo de Internet Engineering task Force, no hay noción de conexión RTSP. En

cambio el servidor mantiene la sesión etiquetada por un identificador. En la mayorı́a de los

3.2. Conceptos de los protocolos de transmisión de vı́deo

12

casos RTSP usa TCP para datos de control del reproductor y UDP para los datos de audio y

vı́deo aunque también puede usar TCP en caso de que sea necesario. Durante la sesión RTSP,

el cliente puede abrir otras conexiones de transporte con el servidor para afrontar la conexión

RTSP. En una conexión RTSP, el servidor mantiene una sesión contı́nua. Durante la sessión

el cliente envı́a y recibe múltiples peticiones RTSP al servidor.

Figura 3.1: Uso de RTSP de los protocolos TCP y UDP

El mecanismo de transporte que suele usar RTSP es RTP [29] (Real-time Transport Protocol), que será explicado posteriormente, aunque las operaciones en RTSP no dependen del

protocolo de transporte usado.

La sintaxis y operaciones de RTSP son similares a las de HTTP por lo que una gran

parte de las funcionalidades y extensiones de HTTP pueden ser añadidos a este protocolo.

Sin embargo, posee algunas diferencias notables con HTTP:

RTSP tiene un protocolo de identificación diferente e introduce un gran número de

nuevos métodos.

Un servidor RTSP necesita mantener su estado, lo que es totalmente opuesto a HTTP

que no tiene estado.

Un cliente y un servidor RTSP pueden realizar peticiones.

RTSP está definido para usar la ISO 10646.

Los datos son transportados con un protocolo diferente.

Este protocolo soporta las siguientes operaciones:

3.2. Conceptos de los protocolos de transmisión de vı́deo

13

Recuperación de datos multimedia de un servidor. El cliente puede realizar una petición de la descripción de una transmisión vı́a HTTP o con algún otro método. Si la

transmisión es realizada vı́a multicast, la descripción contendrá la dirección multicast

y puertos que deben ser utilizados por el flujo contı́nuo. Si la transmisión se va a realizar a un único cliente vı́a unicast por razones de seguridad, el cliente proporcionará el

destino.

Invitación de un servidor de datos multimedia para realizar una conferencia: Un servidor media puede invitar a un cliente a unirse a una conferencia existente, tanto para

reproducir o grabar un conjunto de la transmisión. Esto es muy usado en aplicaciones

de enseñanza distribuida.

Añadir datos multimedia a una transmisión existente: Particularmente para transmisiones en vivo, es muy usual que el servidor pueda proporcionar a lo clientes información

adicional disponible.

Las propiedades más importantes de este protocolo son las siguientes:

Extensible: Nuevos métodos y parámetros pueden ser añadidos muy fácilmente.

Seguro: RTSP usa los mecanismos de seguridad web, tanto en nivel de transporte como

en el protocolo mismo. Todas los mecanismos de autentificación de HTTP pueden ser

usados directamente.

Independiente del transporte: Puede usar tanto un protocolo de datos (UDP) como

un protocolo de stream tal que TCP.

Capacidad de utilizar múltiples servidores: Cada flujo de transmisión media puede

ser realizado en un servidor diferente. El cliente automáticamente establecerá varias

sesiones concurrentes con los diferentes servidores. La sincronización es realizada en

el nivel de transporte.

Control de dispositivos de grabación: El protocolo puede controlar tanto dispositivos

de reporducción y grabación como dispositivos que combinen los dos modos.

3.2. Conceptos de los protocolos de transmisión de vı́deo

14

Separación del control del flujo y la inicialización de una conferencia: El control

del flujo está separado de invitar a un servidor media a una conferencia. El único requisito es que la inicialización de la conferencia se realice con un único identificador de

conferencia.

Idóneo para aplicaciones profesionales: RTSP soporta edición digital remota.

Descripción de la transmisión neutral: El protocolo no impone un tipo particular de

descripción de la transmisión. Sin embargo, la descripción debe contener al menos un

RTSP URI.

Compatible con Proxy y Firewall: Puede ser usado junto con estos dos tipos de aplicaciones.

Similar a HTTP: Como se ha explicado, RTSP utiliza algunos conceptos de HTTP

por lo que las infraestructuras existentes pueden ser reutilizadas. Esta infraestructura

incluye PICS ( Plataforma para la selección del contenido) .

Control de servidor: Si un cliente puede iniciar un flujo, también tiene que ser capaz

de poder detenerlo.

Independiente del protocolo: El cliente puede negociar el método de transporte antes

de necesitar el flujo multimedia .

Cada media stream debe estar representado por un identificador URL RTSP. Las propiedades de la transferencia son definidas en un archivo de descripción. Este archivo puede ser

obtenido por el cliente usando HTTP u otros métodos; es decir, no está necesariamente almacenado en el servidor. Se pueden distinguir varios modos de operaciones, entre los más

importantes se pueden destacar:

Unicast: El flujo es transmitido con el número de puerto elegido por el cliente.

Multicast, el servidor elige la dirección: El servidor media elige la dirección y el puerto.

Este es el caso tı́pico de transmisiones de vı́deo on demand.

3.2. Conceptos de los protocolos de transmisión de vı́deo

15

Multicast, el cliente elige la dirección: Se da cuando el servidor está participando en

una conferencia multicast y por lo tanto la dirección es proporcionada por el cliente en

la descripción de la conferencia.

El servidor necesita mantener un estado de la sesión para ser capaz de relacionar la respuesta que deber dar. Las peticiones más importantes son:

SETUP: Especifica como será transportado el flujo de datos, la petición contiene la url

del flujo multimedia y una especificación de transporte, esta especificación tı́picamente

incluye un puerto para recibir los datos (audio o vı́deo), y otro para los datos RTCP

(meta-datos). El servidor responde confirmando los parámetros escogidos y selecciona

las partes restantes, como los puertos escogidos por el servidor. Cada flujo de datos

debe ser configurado con SETUP antes de enviar una petición de PLAY.

PLAY y RECORD: Una petición de PLAY provocará que el servidor comience a enviar

datos de los flujos especificados utilizando los puertos configurados con SETUP.

PAUSE: Detiene temporalmente uno o todos los flujos, de manera que puedan ser recuperados con un PLAY posteriormente.

TEARDOWN: Detiene la entrega de datos para la URL indicada. Libera los recursos

asociados con el flujo. La sesión RTSP debe exitir en el servidor.

Otras peticiones menos importantes son: OPTIONS, ANNOUNCE, DESCRIBE, REDIRECT y SET PARAMETER.

En la figura 3.2 se puede observar el proceso que se lleva a cabo cuando un cliente hace

una petición de un flujo multimedia a un servidor. En primer lugar el cliente accede a la url

y hace una petición DESCRIBE a un servidor web para que éste le devuelva la descripción

de la presentación y el servidor devuelve información que puede incluir la versión de RTSP,

la fecha, el número de sesión, el nombre del servidor y los métodos soportados. A continuación el cliente realiza una petición de SETUP al servidor media por lo que se especifican los

protocolos aceptados para el transporte de los datos. Si todo es correcto, el cliente podrá hacer una petición de PLAY que informa al servidor que ahora es el momento de comenzar a

3.2. Conceptos de los protocolos de transmisión de vı́deo

16

enviar datos. Por lo que el servidor manda al cliente flujos de vı́deo y audio RTSP. El cliente

puede finalizar en cualquier momento la recepción del flujo mediante la petición al servidor

de TEARDOWN.

Figura 3.2: Proceso RTSP

3.2.2.

RTP

RTP [29] Protocolo de Transporte en tiempo real (Real-time Transport Protocol) define un

paquete estándar para el tranposte de vı́deo y audio a través de la red. Fue desarrollado por el

grupo de transporte de vı́deo y audio de IETF [7] renovando en 2003 la versión publicada en

1996. Es usado conjuntamente con el protoclo RTSP descrito en la sección anterior para flujos

de audio y vı́deo como por ejemplo videoconferencias. Son construidas con el protocolo UDP

(User Datagram Protocol).

Aunque RTP está principalmente diseñado para satisfacer las necesidades de las transferencias multimedia, su uso no está sólo limitado a este campo de aplicaciones.Almacenamiento

3.2. Conceptos de los protocolos de transmisión de vı́deo

17

de datos continuos, simulaciones distribuidas interactivas y control de aplicaciones son funcionalidades que se pueden encontrar también en RTP.

De manera general, este protocolo de transporte permite:

Identificar el tipo de información transmitida.

Agregar marcadores temporales y números de secuencia a la información transmitida.

Controlar la llegada correcta de los paquetes a su destino.

Los paquetes de difusión múltiple pueden utilizar RTP para enrutar conversaciones a

múltiples destinatarios.

RTP no tiene un puerto estándar TCP o UDP con el que se comunica. Las comunicaciones

UDP son realizadas por un puerto constante y el siguiente puerto libre es usado para las

comunicaciones de control (RTCP).El protocolo RTCP se basa en transmisiones periódicas

de paquetes de control que realizan todos los participantes de la sesión RTP y es un protocolo

de control para el flujo RTP, que permite transmitir información básica sobre los participantes

de la sesión y la calidad de servicio. Aunque no hay estándares asignados normalmente es

configurado para usar los puertos del rango 16384-32767. RTP puede transportar todo tipo de

datos con caracterı́sticas de tiempo real como pueden ser el audio y vı́deo. El hecho de que

RTP use un rango de puertos dinámicos hace más difı́cil el uso de firewalls. Para solucionar

este problema suele ser necesario usar un servidor STUN.

Entre los muchos tipos de usos que tiene RTP se pueden destacar los siguientes escenarios:

Conferencias de audio multicast: Es posible usar los servicios de IP multicast para comunicaciones de voz. Para poder realizar este tipo de comunicaciones se usan 2 puertos,

el primero de estos puertos para el envı́o de datos de audio y el segundo es usado para

los paquetes de control (RTCP). La dirección y los puertos son distribuidos a los participantes. Algunas veces por seguridad los datos y los paquetes de control se transportan

de forma encriptada.

Conferencias de audio y vı́deo: Si en una conferencia se usan fuentes de audio y vı́deo

estas son transmitidas por sesiones RTP separadas. Por lo que para enviar los paquetes

3.2. Conceptos de los protocolos de transmisión de vı́deo

18

RTP (datos de audio o vı́deo) y RTCP (paquetes de control) se usan 2 pares de puertos UDP y 2 direcciones multicast. No hay una relación directa entre las sesiones de

audio y vı́deo, excepto que el cliente participa en ambas a la vez y deberá usar el mismo nombre para los paquetes RTCP por lo que las sesiones podrán ser asociadas para

la sincronización de audio y vı́deo usando información de tiempo. Esto permite que

algunos de los participantes en la conferencia sólo reciban el medio que ellos elijan.

Mezclar y traducir: No todos los clientes quieren recibir los datos media en el mismo

formato, ya que en algunas ocasiones estos formatos no son apropiados. Por lo que

se pueden mezclar y traducir señales para que sean apropiadas a las necesidades del

receptor.

Codificación de capas: Las aplicaciones multimedia suelen ser capaces de ajustar la tasa

de transmisión a la capacidad de recepción o a la congestión de la red. En el contexto de

RTP sobre IP multicast se puede producir a través de varias sesiones RTP cada una en

su propio grupo multicast. Los receptores pueden adaptarse uniéndose a uno de estos

grupos multicast según su ancho de banda.

En la figura 3.3 podemos ver la estructura de los encabezados de un paquete RTP. Se puede

definir cada campo del encabezado de la siguiente forma:

V: Campo de versión V de 2 bits de longitud. Indica la versión del protocolo (V=2).

P: Campo de relleno ,1 bit. Si P es igual a 1, el paquete contiene bytes adicionales para

rellenar y finalizar el último paquete.

X: Campo de extensión X, 1 bit. Si X = 1, el encabezado está seguido de un paquete de

extensión.

CC: campo de conteo CRSC,4 bits. Contiene el número de CRSC que le sigue al encabezado.

M: campo de marcador M, 1 bit. Un perfil de aplicación define su interpretación.

Payload Type (PT): Campo de tipo de carga útil, 7 bits. Este campo identifica el tipo de

carga útil (audio, vı́deo, imagen, texto, html, etc.).

3.2. Conceptos de los protocolos de transmisión de vı́deo

19

Número de secuencia: 16 bits. Su valor inicial es aleatorio y aumenta 1 por cada paquete

enviado. Puede utilizarse para detectar paquetes perdidos.

Time Stamp: Marca de tiempo, 32 bits. Refleja el instante de muestreo del primer byte

del paquete RTP. Este instante debe obtenerse a partir de un reloj que aumenta de manera monótona y lineal, para permitir la sincronización y el cálculo de la variación de

retardo en el destino.

SSRC: 32 bits, identifica de manera única la fuente. La aplicación elige su valor de

manera aleatoria. SSRC identifica la fuente de sincronización. Este identificador se

elige de manera aleatoria con la intención de que sea único entre todas las fuentes de la

misma sesión.

CSRC: 32 bits, identifica las fuentes (SSRC) que han ayudado a obtener los datos contenidos en el paquete que contiene estos identificadores.

Figura 3.3: Encabezado de un paquete RTP

3.3. Herramientas de captura de vı́deo RTSP/RTP

3.3.

Herramientas de captura de vı́deo RTSP/RTP

3.3.1.

Introducción

20

La captura de un flujo de vı́deo RTSP/RTP puede ser realizada con dos tipos de herramientas:

Librerı́as que facilitan la implementación RTSP/RTP.

Utilizando aplicaciones de codificador-decodificador de vı́deos que soporten este tipo

de flujos. El gran problema de utilizar una librerı́a que implemente RTP, es que también

será necesario un decodificador/codificador de la señal, ya que con estas librerı́as es

posible capturar una señal RTP pero no decodificarla para que sea mostrada.

En esta sección se dará una descripción de las principales herramientas de cada uno de

estos grupos.

3.3.2.

Librerı́as RTP

Se describirán a continuación las librerı́as más importantes para el envı́o y la recepción de

datos con el protocolo de transporte RTP.

3.3.2.1.

ccRTP

ccRTP [4] es un conjunto de librerı́as de trabajo en C++ para desarrollar aplicaciones

basadas en el Protocolo de Transporte en Tiempo Real (RTP) para transporte de audio y

vı́deo.

ccRTP ha conseguido ser un eficiente y flexible marco de trabajo válido para implementar

gran parte de las aplicaciones que usen RTP. Y está implementado bajo las últimas especificaciones de RTP descritas en las secciones anteriores. ccRTP está basado en GNU Common

C++ , aunque la mayor parte de las librerı́as no son requeridas. C++ proporciona servicios

básicos como hilos, sincronización y sockets lo que hace que sea posible implementar una

solución completa para el uso de RTP. Sin embargo, a pesar de que ccRTP ofrece facilidades

3.3. Herramientas de captura de vı́deo RTSP/RTP

21

y abstracción para componentes y aplicaciones que usen RTP, esas aplicaciones generalmente requieren servicios similares para otras tareas. RTP ha sido definido como un protocolo a

nivel de aplicación y no como un tı́pico protocolo de transporte en Internet como TCP y UDP.

Por esto RTP no suele estar implementado como una capa separada de la aplicación . A consecuencia de esta caracterı́stica, las aplicaciones RTP ofrecen más adaptación a la distribución

de paquetes, procesamiento de reglas, sesiones y otros mecanismos. ccRTP proporciona un

marco de trabajo para RTP no siendo simplemente una librerı́a de manipulación RTP.

ccRTP trata exclusivamente con el protocolo de transporte de datos sobre RTP. Parámetros como la dirección IP de destino, puertos de transporte, identificador (descritos en la sección anterior), son usados por ccRTP para abrir una sesión RTP y enviar y recibir paquetes.

Las aplicaciones multimedia pueden necesitar un protocolo de señales como en nuestro caso

RTSP o SIP. Estas funciones no son provistas por ccRTP.

Algunos de los rasgos más importantes de ccRTP son los siguientes:

Soporte para unicast, multi-unicast y multicast.

Sincronización de flujos y contribución entre flujos.

Tratamiento automático de funciones RTP.

Uso de plantillas para el transporte.

Soporte de hilos.

Proporciona información sobre el estado.

Guarda estadı́sticas.

Tratamiento automático de las colisiones SSRC y detección de bucles.

Números aleatorios basados en /dev/urandom.

Consideraciones de tiempo.

El sistema para enviar y recibir paquetes RTP en ccRTP es muy simple, ya que las aplicaciones no leen directamente los datos de los sockets. Los bloques de datos que quieren ser

3.3. Herramientas de captura de vı́deo RTSP/RTP

22

enviados son puestos en la cola de transmisión y cuando se reciben bloques de datos llegan a

la cola de transmisión.

Listing 3.1: Ejemplo de envı́o de datos con ccRTP

1

RTPSession s ( I n e t H o s t A d d r e s s ( ” 1 2 7 . 0 . 0 . 1 ” ) ,8000) ;

2

c o u t << ” L o c a l SSRC i d e n t i f i e r : ” << s . getLocalSSRC ( ) << e n d l ;

3

s . a d d D e s t i n a t i o n ( ”www. e x a m p l e . com” , 9 0 0 0 ) ; / / d e s t i n o

4

s . s e t P a y l o a d F o r m a t ( s t a t i c P a y l o a d F o r m a t ( sptPCMU ) ) ;

5

s . startRunning () ;

6

/ / Envia l o s datos

7

s . putData (0 , buffer , bufferLen ) ;

En el listing 3.1 se puede observar un pequeño ejemplo de cómo enviar datos usando ccRTP.

Simplemente se inicia una sesión RTP con su dirección y puerto, posteriormente se añade el

destino y se ponen los datos a enviar en la cola de salida (s).

Listing 3.2: Ejemplo de recepción de datos con ccRTP

1

RTPSession s ( I n e t H o s t A d d r e s s ( ” 1 2 7 . 0 . 0 . 1 ” ) ,9000) ;

2

//

3

c o u t << ” L o c a l SSRC i d e n t i f i e r : ” << s . getLocalSSRC ( ) << e n d l ;

4

s . s e t P a y l o a d F o r m a t ( s t a t i c P a y l o a d F o r m a t ( sptPCMU ) ) ;

5

s . startRunning () ;

6

Initialization .

const AppDataUnit ∗ d a t a ;

7

data = s . getData (0 ) ; / / se obtienen los datos

8

i f ( d a t a ! = NULL )

9

/ / datos recibidos correctamente

En el listing 3.2 se puede apreciar un ejemplo de cómo recibir datos, al igual que al enviar

se inicia una sesión y se cogen los datos de la cola de recepción que son guardados en data.

3.3. Herramientas de captura de vı́deo RTSP/RTP

3.3.2.2.

23

oRTP

oRTP [16] es una librerı́a implementada en C para aplicaciones que usen RTP. Soporta

tanto Linux como Windows y tiene licencia GNU Lesser General Public License(LGPL). Su

utilización es muy sencilla y proporciona un organizador para recibir y enviar paquetes. Los

paquetes RTCP o paquetes de control se mandan de forma automática. Entre sus principales

carasterı́sticas se pueden destacar las siguientes:

Incluye soporte para múltiples perfiles, por ejemplo el perfil AV que es por defecto.

Organizador de envı́o y recepción de paquetes acorde con su señal de tiempo. El organizador es opcional ya que las sesiones RTP pueden ser no organizables.

Soporte de multiplexado de IO, por lo que cientos de sesiones RTP pueden ser organizadas por un único hilo.

Algoritmo jitter para adaptar al receptor al rango de reloj del emisor.

Soporte para eventos telefónicos sobre RTP.

API bien documentada.

oRTP fue implementado par ser el marco RTP para linphone , un teléfono para Linux. Ahora

oRTP es usado por otras aplicaciones como por ejemplo Hewlett Packard, OASIS SYSTEMS

y Eloquant. A continuación se mostrará un pequeño ejemplo orientativo de cómo enviar y

recibir datos usando oRTP:

3.3. Herramientas de captura de vı́deo RTSP/RTP

24

Listing 3.3: Ejemplo de envı́o de datos con oRTP

1

ortp init () ;

2

ortp scheduler init () ;

3

s e s s i o n = r t p s e s s i o n n e w ( RTP SESSION SENDONLY ) ;

4

rtp session set scheduling mode ( session ,1) ;

5

r t p s e s s i o n s e t r e m o t e a d d r ( session , ” 0 . 0 . 0 . 0 ” ,555) ;

6

rtp session set payload type ( session ,0) ;

7

s s r c = g e t e n v ( ”SSRC” ) ;

8

w h i l e ( cond )

9

10

/ / se envian los datos

rt p se ssio n se nd wi th ts ( session , buffer , i , u s e r t s ) ;

Vemos que para poder enviar datos primero se inicializa el organizador. Posteriormente

se crea una nueva sesión y se le asocia la dirección y el puerto. Finalmente se envian los datos.

Listing 3.4: Ejemplo de recepción de datos con oRTP

1

ortp init () ;

2

ortp scheduler init () ;

3

s e s s i o n = r t p s e s s i o n n e w ( RTP SESSION RECVONLY ) ;

4

rtp session set scheduling mode ( session ,1) ;

5

r t p s e s s i o n s e t l o c a l a d d r ( session , ” 0 . 0 . 0 . 0 ” ,555) ;

6

w h i l e ( cond ) {

7

while ( have more )

8

/ / se reciben los datos

9

e rr = r t p s e s s i o n r e c v w i t h t s ( session , buffer ,160 , ts

,& h a v e m o r e ) ;

Para poder recibir datos el procedimiento es muy similar al de enviar, primero se crea el

organizador y la sesión y posteriormente se reciben los datos.

3.3. Herramientas de captura de vı́deo RTSP/RTP

3.3.2.3.

25

JRTPLIB

JRTPLIB [9], es una librerı́a orientada a objetos escrita en C++ la cual permite a los

desarrolladores usar RTP. Es portable, ya que es compatible con GNU/Linux, Windows y

Solaris. Esta librerı́a tiene las siguientes funcionalidades:

Enviar y recibir datos usando RTP.

Evitar colisiones SSRC.

Organizar y transmitir RTCP.

El usuario sólo necesita cargar los datos necesarios para que sean enviados y la librerı́a se

encargará de dar al usuario acceso a los datos entrantes RTP y RTCP. La librerı́a proporciona

varias clases las cuales son de gran ayuda para crear aplicaciones RTP , pero la clase más

usada es RTPSession, la cual proporciona las funciones necesarias para enviar y recibir datos

RTP.

3.3.2.4.

UCL common multimedia library

La librerı́a multimedia UCL [18] implementa un gran número de algoritmos y protocolos

necesarios para las aplicaciones multimedia en C++, entre estos protocolos incluye RTP que

es el interesante para este proyecto. Pero no es simplemente una librerı́a para RTP como las

descritas anteriormente UCL multimedia, también incluye soporte para: Base64 encoding/decoding, árboles binarios, números aleatorios, autentificación HMAC, MD5, DES, MBus,

SAP y SDP. Es compatible con varias plataformas como: Unix systems (Solaris, Linux, Irix,

FreeBSD, MacOSX) y Windows 95/98/NT/XP. El uso del protocolo RTP es muy similar a

las aplicaciones descritas anteriormente, es necesario crear una sesión con una dirección y un

puerto. Tiene asociado una estructura de datos que es rtp packet, que es donde se contienen

los datos que van a ser enviados.

3.3.2.5.

Java.net.RTP

Java.net.RTP [8] desarrollado en la Universidad de Columbia es un paquete que proporciona una implementación independiente en Java que permite el acceso a todos los niveles de

3.3. Herramientas de captura de vı́deo RTSP/RTP

26

transporte de RTP. Con esta librerı́a se pueden incorporar fácilmente el uso de este protocolo

a las aplicaciones Java. Es una librerı́a orientada a objetos donde la clase más importante es

la Sesión que encapsula la configuración RTP y RTCP y los procedimientos necesarios. La

sesión interactúa con la red y realiza las siguientes acciones:

Procesos sı́ncronos: Enviar paquetes RTP. Para realizar está acción simplemente se invoca al método Session.SendRTPPacket().

Procesos ası́ncronos: Enviar paquetes RTCP y recibir paquetes RTP y RTCP.

Las aplicaciones tendrán 3 hilos, el primer hilo se encargará del envı́o y recepción de paquetes RTP y el segundo y tercer hilo se encargarán del envı́o y recepción de paquetes RTCP.

Realizando el envı́o de los paquetes en diferentes grupos multicast. En la figrura 3.4 se ilustra

este concepto.

Figura 3.4: Envio y recepción de paquetes con Java.net.RTP

3.3. Herramientas de captura de vı́deo RTSP/RTP

27

Listing 3.5: Ejemplo de envı́o de paquetes con Java.Net.RTP

1

/ / C o n s t r u c t a new S e s s i o n o b j e c t

2

r t p S e s s i o n = new S e s s i o n ( ” 2 3 4 . 5 . 6 . 7 ” , / / M u l t i c a s t G r o u p I P A d d r e s s

3

8000 , / / MulticastGroupPort

4

8 0 0 1 , / / RTCPGroupPort

5

8 0 5 1 , / / RTPSendFromPort

6

8 0 5 2 , / / RTCPSendFromPort

7

10000) ; / / bandwidth

8

/ / Set the session parameters

9

rtpSession . setPayloadType ( 5 ) ;

10

r t p S e s s i o n . setCName ( ” RTPUser ” ) ;

11

r t p S e s s i o n . s e t E M a i l ( ” user@ . com” ) ;

12

rtpSession . Start () ;

13

/ / Send a t e s t p a c k e t .

14

r t p S e s s i o n . SendPacket ( S t r i n g ( ” T e s t S t r i n g ” ) . getBytes ( ) ) ;

En el listing 4.3 se puede apreciar un ejemplo sencillo de como enviar un paquete en java.Net.RTP. Se observa que es un mecanismo muy simple, ya que basta con crear una sesión

utilizando la dirección multicast y los 4 puertos necesarios para enviar el paquete.

3.3.3.

Codecs de audio y vı́deo

En esta sección se describirán las aplicaciones más importantes que permiten la captura

de flujos de vı́deo y audio RTSP/RTP.

3.3.3.1.

MPEG4IP

MPEG4IP [12] es un proyecto que proporciona un sistema estándar para decodificación,

streamming, reproducción de audio,vı́deo y texto. Para conseguir esto se han utilizado numerosos paquetes de código libre y se han creado nuevos para resolver algunos problemas.

MPEG4Ip ha sido probado sobre las siguientes plataformas: Linux, FreeBSD, BSD/OS, Solaris, Mac OS X y Windows. Las caracterı́sticas más importantes de esta aplicación son las

siguientes:

3.3. Herramientas de captura de vı́deo RTSP/RTP

28

Soporta múltiples formatos de archivos: avi, mp4, limited .mov, .mpg , .wav, raw aac,

raw mp3, raw mp4v, raw .h264.

Soporta múltiples vı́deo codecs: mpeg-4 (xvid, xvid-1.0), mpeg1/2 (libmpeg3, mpeg2dec),

H.261, YUV (i420 raw).

Soporta múltiples audio codecs: aac (faad y faad2), mp3, celp, ac3 , raw PCM, AMR

NB, AMR WB.

Soporte para streaming: RTSP, SDP, RTP y mpeg2.

Soporte de grabación.

En lo relativo a la captura de flujos RTSP, que es lo que concierne a este proyecto, es un

proceso bastante sencillo ya que basta con realizar la siguiente operación:

$ gmp4player rtsp://myserver.mydomain.com/mycontent.mp4

Es decir, se puede conseguir la reproducción de flujos RTSP simplemente accediendo a su

dirección RTSP en la red.

3.3.3.2.

MPlayer

MPlayer [13] es un reproductor de vı́deo de código abierto desarrollado en C/C++ con

licencia GPL disponible para la mayorı́a de sistemas operativos. Entre otros se pueden destacar: Linux y otros sistemas Unix, Microsoft Windows y Mac OS X. Reproduce la mayorı́a

de los archivos MPEG, VOB, AVI OGG/OGM, VIVO, ASF/WMA/WMV, QT/MOV/MP4,

FLI, RM, NuppelVideo, YUV4MPEG, FILM, RoQ, PVA, soportados por algunos codecs nativos, XAnim, y DLL’s Win32. Puede reproducir VideoCD, SVCD, DVD, 3ivx, DivX 3/4/5 e

incluso pelı́culas WMV. Permite salvar el contenido stream en un archivo.

Otra gran caracterı́stica de MPlayer es el amplio rango de controladores de salida soportados. Funciona con X11, Xv, DGA, OpenGL, SVGAlib, fbdev, AAlib, libcaca, DirectFB, y

también puede usar GGI y SDL (y de esta manera todos sus controladores) y algunos controladores de bajo nivel especı́ficos de algunas placas (para Matrox, 3Dfx y Radeon, Mach64,

Permidia3).

3.3. Herramientas de captura de vı́deo RTSP/RTP

29

Es un reproductor muy sólido ya que permite reproducir archivos MPEG dañados y archivos AVI incorrectos. Las caracterı́sticas más importantes de Mplayer son las siguientes:

Codificación desde una amplia variedad de formato de archivos y decodificadores.

Utiliza todos los codecs soportados por ffmpeg libavcodec.

Codificación/Multiplexación de archivos AVI entrelazados con su respectivo ı́ndice.

Creación de archivos desde flujos de audio externos.

Audio MP3 VBR.

Copia de flujos (de audio y vı́deo).

Corrección de cuadros por segundo.

Gran facilidad para añadir plugins.

Subtı́tulos.

En lo relativo a los flujos RTSP puede decodificarlos con gran facilidad. Simplemente se debe

realizar la siguiente operación:

$ mplayer rtsp://direccion rtsp

Para codificar estas acciones MPlayer utiliza la librerı́a LIVE555 Streaming Media [10], que

permite implementar el cliente RTSP. Las funcinalidades RTSP de MPlayer pueden ser usadas

en dos sentidos:

MPlayer puede ser usado para visualizar los flujos MPEG/RTP enviados por las aplicaciones usando su correspondiente archivo .sdp.

MPlayer puede también reproducir otros rtsp streams, incluido MPEG-4 audio y vı́deo.

Al ser una aplicación de código abierto se podrı́a modificar su código para poder obtener la

señal RTSP y modificarla como se pretende en este proyecto.

3.3. Herramientas de captura de vı́deo RTSP/RTP

3.3.3.3.

30

VLC

VLC [19] media player (inicialmente VideoLAN Client) es un reproductor multimedia del

proyecto VideoLAN; es un software de código libre distribuido bajo licencia GPL. Soporta

muchos códecs de audio y vı́deo, ası́ como diferentes tipos de archivos, además soporta los

formatos de DVD, VCD y varios protocolos streaming . También puede ser utilizado como

servidor en unicast o multicast, en IPv4 o IPv6 , en una red de banda ancha. Utiliza la biblioteca códec libavcodec del proyecto FFmpeg para manejar los muchos formatos que soporta, y

emplea la biblioteca de descifrado DVD libdvdcss para poder reproducir los DVDs cifrados.

Además VLC tiene soporte para Vı́deo4Linux.

Figura 3.5: Visión General VLC

Soporta también múltiples sistemas operativos como Linux, Microsoft Windows, Mac OS

X, BeOS, BSD, Pocket PC y Solaris. Para la captura de stream es una gran solución ya que:

Puede ser usado como cliente receptor de stream.

Puede ser usado como servidor para mandar stream. Ya que VLC es capaz de mandar

en forma de flujo todos los formatos que pueda reproducir.

3.4. Visión por computador y procesamiento de imágenes

31

Soporta los siguientes formatos de salida stream: RTP/UDP, RTSP, RTP/DCCP, Raw UDP,

Multicast, HTTP y MMSH. Para poder recibir un flujo RTSP en vlc basta con ejecutar:

$ vlc rtsp://www.example.org/your_stream

Pero las funcionalidades de VLC en cuanto a flujos RTSP no acaban ahı́, ya que a parte de

actuar como cliente también puede actuar de servidor, esto se puede hacer creando Vı́deo On

Demand. Primero habrá que ejecutar VLC en modo telnet con una dirección,un puerto y una

contraseña:

% vlc --ttl 12 -vvv --color -I telnet --telnet-password videolan

--rtsp-host 0.0.0.0:5554

El siguiente paso es conectarse a la vlc telnet y crear un objeto VOD ( Video On Demand):

new Test vod enabled

setup Test input my_video.mpg

Ahora ya es posible acceder a este flujo de vı́deo, simplemente habrá que conectarse al video

on demand que se ha creado y se empezará a reproducir ”my video.mpg”:

vlc rtsp://server:5554/Test

VLC también permite controlar múltiples streaming al mismo tiempo y posee un organizador que permite realizar esta tarea de forma eficiente. VLC permite añadir plugins con total

facilidad, lo que podrı́a ser de gran ayuda para este proyecto.

3.4.

Visión por computador y procesamiento de imágenes

3.4.1.

Introducción

Hace años el término visión por computador podrı́a sonar a ciencia ficción, pero en las

últimas decadas la visión de la computadoras es una realidad. Las máquinas pueden ser construidas para ver. Existen máquinas diseñadas par poder reconocer el ojo humano en escaners

de retina e incluso vehı́culos que son conducidos usando una cámara.

3.4. Visión por computador y procesamiento de imágenes

32

El principal objetivo de la visión por computador es tomar decisiones útiles y eficaces

sobre objetos reales a partir del filtrado de imágenes. Es necesario construir una descripción

del modelo para cada imagen. La visión artificial tiene como finalidad la extracción de información del mundo fı́sico a partir de imágenes, utilizando para ello un computador. Se trata de

un objetivo ambicioso y complejo que actualmente se encuentra en una etapa primitiva.

Gran parte del cerebro humano está dedicado a la visión. Allan Turing creı́a que una

computadora podrı́a conseguir la suficiente inteligencia para poder comprender escenas. Algunos de estos objetivos son todavı́a lejanos, pero, sin embargo, en los últimos años ha habido

un sorprendente crecimiento de algunas de estas lı́neas de investigación.

3.4.2.

Aplicaciones

Son numerosas las aplicaciones de la visión por computador, a continuación se describirán

las más importantes:

Biomedicina: Las aplicaciones médicas de la visión por computador son muy numerosas y podemos destacar el análisis de imágenes tomadas por rayos x, análisis de imágenes tomadas por ultrasonidos y la aplicación en los análisis de sangre.

Figura 3.6: Resonancia magnética (izquierda) e imagen binaria (derecha) resultado de cambiar el valor de los pixels

3.4. Visión por computador y procesamiento de imágenes

33

Identificación: Es un campo importante dentro de la visión por computador ya que nos

permite detección e identificación de caras, objetos, identificación de huellas dactilares,

etc.

Militares: Podemos destacar dentro de este campo la detección y seguimiento de objetos que permite detectar y seguir un objetivo militar, el análisis de imágenes para

reconocer el terreno y la aplicación en armas inteligentes.

Robótica: Para el guiado de robots industriales y la navegación de robots móviles. En

la figura 3.7 se puede observar el diseño de un vehı́culo que utiliza visión por computador y más concretamente OpenCV ganador del campeonato DARPA Urban donde

participan vehı́culos sin conductor.

Figura 3.7: Vehiculo robot ”Stanley”desarrollado en la Univeridad de Stanford

Agricultura: Análisis de imágenes de plantaciones tomadas por satélites para poder

hacer seguimiento de los cultivos y observar posibles enfermedades en las plantas.

Control de Tráfico: Con el uso de la visión por computador se pueden identificar

las matrı́culas de vehı́culos automáticamente. Otra utilidad es el control de tráfico con

semáforos automáticos que según la cantidad de vehı́culos actúan de una forma u otra.

Seguridad: Como ya se ha comentado, ésta es una de las aplicaciones actuales más

importantes de la visión por computador entre sus funciones se puede destacar: la vigilancias de edificios, detección de explosivos, etc.

3.4. Visión por computador y procesamiento de imágenes

34

Controles de Calidad: Es muy útil para realizar controles de calidad a diferentes productos. Entre otros se pueden destacar:

• Inspección de contenedores.

• Inspección de motores.

• Inspección de cristales.

• Control de calidad de alimentos.

• Inspección de soldaduras.

• Inspección de circuitos impresos.

• Inspección madera, tela, fundiciones, papel.

• Verificación de etiquetas.

3.4.3.

Etapas de un sistema de visión por computador

El ser humano captura la luz a través de los ojos, y esta información circula a través del

nervio óptico hasta el cerebro donde se procesa. Existen razones para creer que el primer paso

de este procesado consiste en encontrar elementos más simples en los que descomponer la

imagen (como segmentos y arcos). Después el cerebro interpreta la escena y por último actúa

en consecuencia. La visión por computador , en un intento de reproducir este comportamiento,

se puede definir en varias fases, que se pasarán a describir con más detalle a continuación.

Figura 3.8: Etapas de la visión por computador

3.4. Visión por computador y procesamiento de imágenes

3.4.3.1.

35

Captura de Imágenes

Esta fase, que es puramente sensorial, consiste en la adquisición de imágenes e involucra

el proceso de transformación de los estı́mulos de luz que reflejan los objetos observados y

que inciden en los foto-sensores de una cámara de vı́deo a valores digitales almacenados en

la memoria de una computadora.

Los sensores transforman la intensidad de la luz que incide en ellos a cargas eléctricas,