Memoria (spa) - Universidad de Zaragoza

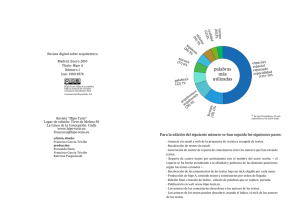

Anuncio

Proyecto Fin de Carrera

Diseño de mapas de navegabilidad para

entornos de interior mediante visión

omnidireccional

Jasón Omedes LLorente

Directores: Gonzalo López-Nicolás

José Jesús Guerrero Campo

Ingenierı́a Industrial

Automatización Industrial y Robótica

Departamento de Informática e Ingenierı́a de Sistemas

Escuela de Ingenierı́a y Arquitectura

Universidad de Zaragoza

Junio de 2012

2

Diseño de mapas de navegabilidad para entornos de

interior mediante visión omnidireccional

RESUMEN

En este trabajo se estudia el problema de detectar el suelo y las paredes de

una escena a partir de una única imagen tomada en el interior de un edificio.

Aunque existen métodos equivalentes que utilizan imágenes convencionales, las

imágenes omnidireccionales resultan particularmente útiles para esta tarea debido

a su amplio campo de vista. No obstante, debido a la mayor complejidad geométrica

de las imágenes omnidireccionales es necesario el diseño de algoritmos especı́ficos.

También se aborda el problema para el caso de una cámara en movimiento, que

requiere el diseño de técnicas adicionales.

El presente PFC se enfoca en cuatro actividades principales:

1. Diseño y evaluación de un nuevo método para la estimación de los

puntos de fuga (VPs) y la clasificación de lı́neas extraı́das sobre imágenes

catadióptricas.

En esta actividad se propone un nuevo método para clasificar las lı́neas

extraı́das de una imagen omnidireccional según las tres direcciones principales

que dominan en la escena y se realiza una comparativa con los métodos ya

existentes.

2. Desarrollo de un método innovador para obtener la estructura principal de

una escena de interiores a partir de una única imagen omnidireccional.

Este método propuesto utiliza la información extraı́da a partir de las lı́neas

y los puntos de fuga, que combinados con un conjunto de restricciones

geométricas, nos permiten segmentar en la imagen las regiones que forman

parte del suelo y las paredes verticales sobre las direcciones principales.

3. Propagación secuencial de la aplicación propuesta sobre imágenes próximas

para aumentar la robustez del resultado con una cámara en movimiento.

Se propone una extensión del método para mejorar la estimación final

mediante el uso de homografı́as que permiten propagar las hipótesis

resultantes secuencialmente eliminando posibles errores en la clasificación.

4. Obtención de resultados.

Las técnicas desarrolladas se han evaluado experimentalmente con imágenes

reales obtenidas de una base de datos disponible en internet. Los resultados

experimentales demuestran el buen funcionamiento y la robustez del método

propuesto.

3

4

Índice general

1. Introducción

1.1. Marco de trabajo . . . .

1.2. Estado del arte . . . . .

1.3. Objetivos . . . . . . . .

1.4. Estructura de contenidos

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

9

9

10

13

14

2. El modelo de la esfera

17

2.1. Proyección de una recta . . . . . . . . . . . . . . . . . . . . . . . . 21

3. Extracción y clasificación de cónicas

3.1. Clasificación sobre imagen catadióptrica

3.1.1. Cálculo de cónicas . . . . . . . .

3.1.2. Cálculo de los puntos de fuga . .

3.2. Clasificación sobre la esfera . . . . . . .

3.2.1. Cálculo de cónicas . . . . . . . .

3.2.2. Cálculo de los puntos de fuga . .

3.3. Método propuesto . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

4. Obtención de la distribución espacial de una escena

4.1. Método jerárquico de generación de hipótesis . . . . . .

4.1.1. Selección de puntos clave . . . . . . . . . . . .

4.1.2. Hipótesis inicial del contorno central . . . . . .

4.1.3. Proceso jerárquico para generación de hipótesis

5. Aplicación secuencial mediante homografı́as

5.1. Homografı́a . . . . . . . . . . . . . . . . . .

5.1.1. Homografı́a a partir de lı́neas . . . .

5.2. Selección de emparejamientos . . . . . . . .

5.2.1. Emparejamiento de puntos . . . . .

5.2.2. Emparejamiento de lı́neas . . . . . .

5.3. Medida de similitud . . . . . . . . . . . . . .

5

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

23

25

25

25

27

27

27

29

.

.

.

.

33

34

34

36

39

.

.

.

.

.

.

45

45

47

48

49

50

53

6

ÍNDICE GENERAL

5.4. Hipótesis ponderada . . . . . . . . . . . . . . . . . . . . . . . . . .

5.5. Propagación de hipótesis . . . . . . . . . . . . . . . . . . . . . . . .

55

57

6. Experimentos

59

6.1. Evaluación del nuevo método para clasificación de lı́neas . . . . . . 60

6.2. Evaluación de la recuperación estructural con una imagen . . . . . . 60

6.3. Evaluación del método mediante aplicación de homografı́as . . . . . 63

7. Conclusiones

67

Anexos

71

A. Geometrı́a de la hipérbola

73

A.1. Definición geométrica de la hipérbola . . . . . . . . . . . . . . . . . 73

A.2. Ecuación explı́cita de la hipérbola . . . . . . . . . . . . . . . . . . . 74

A.3. Definición de semi-latus-rectum . . . . . . . . . . . . . . . . . . . . 75

B. El sistema hipercatadióptrico

como sistema central

B.1. Ley de reflexión . . . . . . . . . . . . . . . . . . . . .

B.2. Solución para espejo hiperbólico . . . . . . . . . . . .

B.2.1. Cálculo del vector normal . . . . . . . . . . .

B.2.2. Demostración de sistema catadióptrico central

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

79

80

81

81

82

C. Modelo de proyección para un sistema central hiperbólico

83

C.1. Proyección de un punto sobre el hiperboloide de revolución . . . . . 83

C.2. Proyección de x en la cámara perspectiva . . . . . . . . . . . . . . 85

D. Conceptos fundamentales de geometrı́a para lı́neas cónicas

89

D.1. Ajuste de una cónica en el N-plano a partir de dos puntos y la

calibración interna . . . . . . . . . . . . . . . . . . . . . . . . . . . 89

D.1.1. Caso general . . . . . . . . . . . . . . . . . . . . . . . . . . . 91

D.1.2. Configuración singular . . . . . . . . . . . . . . . . . . . . . 92

D.2. Distancia de un punto a una cónica . . . . . . . . . . . . . . . . . . 94

D.2.1. Distancia algebraica . . . . . . . . . . . . . . . . . . . . . . 94

D.2.2. Distancia basada en el gradiente . . . . . . . . . . . . . . . . 94

D.2.3. Distancia basada en la lı́nea polar . . . . . . . . . . . . . . . 96

D.2.4. Discusión . . . . . . . . . . . . . . . . . . . . . . . . . . . . 97

D.3. Intersección de cónicas . . . . . . . . . . . . . . . . . . . . . . . . . 98

D.3.1. El triángulo autopolar común a dos cónicas . . . . . . . . . 98

D.3.2. Intersección de dos cónicas usando el triángulo autopolar . . 100

ÍNDICE GENERAL

7

E. Descriptor SIFT

E.1. Construcción de un espacio de Escalas . . . . . .

E.1.1. Diferencia de gaussianas: D(x, y, σ) . . . .

E.1.2. Detección de extremos locales . . . . . . .

E.2. Localización de keypoints . . . . . . . . . . . . .

E.2.1. Supresión de puntos de bajo contraste . .

E.2.2. Supresión de puntos situados en los bordes

E.3. Asignación de orientación . . . . . . . . . . . . .

E.4. Descriptor de puntos claves . . . . . . . . . . . .

F. Ampliación de Resultados

F.1. Resultados en corredores . . . .

F.2. Resultados en pasillos complejos

F.3. Resultados en habitaciones . . .

F.4. Resultados con fallos . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

113

. 114

. 115

. 116

. 117

G. Manual de usuario

H. Artı́culo IAS 2012

H.1. Introduction . . . . . . . . . . . . . . . .

H.2. Vanishing Point Estimation through Line

H.3. Hierarchical Layout Hypothesis Method .

H.3.1. Selection of Set of Points . . . . .

H.3.2. Generation of Conics . . . . . . .

H.3.3. Initial Boundaries Hypothesis . .

H.3.4. Hierarchical Expansion Process .

H.4. Results . . . . . . . . . . . . . . . . . . .

H.5. Conclusion and Future Work . . . . . . .

103

103

105

105

107

107

107

109

110

.

.

.

.

.

.

.

.

119

. . . . . .

Detection

. . . . . .

. . . . . .

. . . . . .

. . . . . .

. . . . . .

. . . . . .

. . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

123

124

125

126

127

127

128

129

131

132

Índice de figuras

135

Índice de tablas

141

Bibliografı́a

143

8

ÍNDICE GENERAL

Sección 1

Introducción

1.1.

Marco de trabajo

La obtención de la distribución estructural de la escena a partir de una

imagen es una tarea sencilla para cualquier persona, sin embargo, no es fácil para

un sistema de inteligencia artificial. Al mismo tiempo, es una herramienta muy

potente, ya que conocer los lı́mites entre suelo y paredes proporciona información

valiosa en tareas de navegación autónoma, detección de obstáculos o reconstrucción

3D.

En concreto, este trabajo se enmarca dentro del proyecto de investigación

VISPA (Non-conventional Vision Systems for Personal Assistance) del grupo de

robótica de la Universidad de Zaragoza, que tiene como objetivo el desarrollo de

técnicas de visión por computador combinadas con metodologı́as del campo de

la robótica para formar parte de un sistema de asistencia personal. Parte de la

información visual incluye información tomada por cámaras no convencionales,

como en este caso un sistema catadióptrico formado por una cámara y un espejo

(figura 1.1).

Se busca encontrar un sistema que pueda ser transportado por una persona

y que sirva para complementar, más que reemplazar capacidades humanas, para

ayudar a personas con discapacidad en su sistema cognitivo visual, personas con

dificultad de orientación o personas sin discapacidad que se mueven sobre entornos

desconocidos o que requieran una ayuda extra a la hora de desempeñar ciertas

tareas.

Las imágenes omnidireccionales tienen grandes ventajas en este entorno debido

a su amplio campo de vista que permite recopilar información de todas las

direcciones y es de gran utilidad a la hora de detectar obstáculos.

9

10

1.2. Estado del arte

Figura 1.1: Casco con cámara omnidireccional para tareas de asistencia personal.

1.2.

Estado del arte

El problema de obtener la distribución estructural ha sido estudiado en distintas

ocasiones y continua atrayendo los esfuerzos de muchos investigadores (Fig. 1.2).

La mayorı́a de las contribuciones funcionan bajo la hipótesis de un mundo tipo

Manhattan [11], que asume que la escena tiene 3 direcciones principales ortogonales

entre sı́. Los entornos de interior normalmente satisfacen esta condición por lo

que se entiende la aplicación extensiva de esta hipótesis. Algunos ejemplos son

[18], que utiliza lı́neas extraı́das a partir de cámaras perspectivas y a las que

aplica condiciones geométricas para buscar el mejor ajuste al entorno, o [17] que

representando las habitaciones como cubos en 3D intenta reconocer los lı́mites

entre pared y suelo en habitaciones llenas de objetos. También se encuentran otros

trabajos como [25] que usa filtros bayesianos sobre un conjunto de hipótesis paredsuelo sin la asunción de un mundo tipo Manhattan, aunque en este caso, sigue

habiendo 3 direcciones principales pero a las que no se les impone la condición de

ortogonalidad.

En los últimos años, el uso de cámaras omnidireccionales se ha consolidado en

aplicaciones de robótica. El motivo de ello es que muchos de los problemas de visión

artificial aplicada a la robótica se ven fuertemente condicionados por el campo de

vista. Las cámaras convencionales trabajan con campos de vista que oscilan entre

los 40 - 60o y el modelo analı́tico de cámara proyectiva tiene su lı́mite teórico en

180o . Buscando superar esta limitación se han desarrollado recientemente diversos

sistemas que permiten abarcar ángulos de 360o .

Desde el punto de vista constructivo existen diversos tipos de cámaras

omnidireccionales.

1. Introducción

11

Figura 1.2: Recuperación estructural de una escena en imágenes convencionales [25]. Resultado

etiquetado manualmente.

Uno de ellos es la cámara rotatoria, que consiste en una cámara convencional

con un sistema mecánico que permite el movimiento a lo largo de una

trayectoria circular tomando una imagen de toda la escena.

Otra configuración de cámara omnidireccional consiste en un conjunto de

cámaras convencionales situadas con una orientación adecuada para abarcar

el mayor campo de vista posible.

Los sistemas dióptricos, que son cámaras convencionales con lentes de granangular, como la lente de ojo de pez.

La clase de cámaras omnidireccionales a la que prestaremos especial atención

es la que engloba a los sistemas catadióptricos. Este tipo de sistemas

combinan cámaras convencionales con espejos.

Los sistemas catadióptricos han sido estudiados por Baker y Nayar [1] quienes

demostraron que los espejos elı́pticos, parabólicos e hiperbólicos son los únicos

que pueden ser combinados con cámaras convencionales constituyendo sistemas

catadióptricos centrales (SCC). Esta propiedad relaciona los rayos incidentes en

un sistema catadióptrico central de manera unı́voca con los puntos de la imagen

tomada por el sistema.

Los sistemas catadióptricos más usuales son el hiper-catadióptrico, compuesto

de un espejo hiperbólico y una cámara perspectiva y el para-catadióptrico formado

por un espejo parabólico y una cámara ortográfica. Estos sistemas, construidos

bajo las restricciones geométricas correspondientes, se comportan como sistemas

catadióptricos centrales (Fig. 1.3).

El uso de estos sistemas puede verse en aplicaciones como la localización,

realidad virtual, navegación, SLAM, reconstrucción 3D, odometrı́a visual, etc.

12

1.2. Estado del arte

Figura 1.3: Ejemplo de sistema catadióptrico central con espejo hiperbólico. El primer foco,

F1, está situado dentro del espejo, y el segundo foco, F2, coincide con el centro óptico dentro de

la lente.

Para cualquiera de estas aplicaciones, y especialmente en las de robótica es

necesario recoger información métrica del entorno. Esta información depende

directamente de la calibración del sistema y de su modelo de proyección. Existen

diversos modelos, tanto geométricos como analı́ticos, que consideran la proyección

de sistemas catadióptricos. Geyer y Daniilidis [13] proponen un modelo unificado

capaz de modelar la proyección de cualquier sistema catadióptrico central. Este

modelo fue extendido por Barreto y Araujo [3] y es conocido como el Modelo de

la Esfera. En la actualidad es el modelo más utilizado.

1. Introducción

1.3.

13

Objetivos

Para este trabajo, el uso de cámaras omnidireccionales es muy importante

debido al amplio campo de vista, lo que ayuda a una mejor detección de los puntos

de fuga y permite observar una mayor longitud de las rectas de la escena. Por

otro lado, en los sistemas catadióptricos centrales, las lı́neas rectas de la escena se

proyectan como cónicas sobre la imagen, incrementando la complejidad geométrica,

de forma que la mayorı́a de los algoritmos existentes para cámaras convencionales

no puedan aplicarse. Por ello es necesario el desarrollo de nuevos métodos que

tengan en cuenta las caracterı́sticas de este tipo de imágenes (figura 1.4).

Partiendo del trabajo [23], proponemos un nuevo método escena, más robusto

ya que no depende de encontrar esquinas (que son difı́ciles de detectar), y mucho

más rápido, debido a que los métodos de clasificación o combinación de esquinas

para formar la hipótesis de suelo consumı́an mucho tiempo.

El trabajo propuesto para la recuperación estructural utiliza de partida una

única imagen omnidireccional, de la que se extraen lı́neas caracterı́sticas, y se

clasifican en tres direcciones principales dependiendo de su orientación. Estas

lı́neas contienen información redundante por lo que seleccionamos únicamente un

conjunto de puntos que posteriormente permiten generar una primera hipótesis

de la forma de la escena considerando que esta tiene 4 paredes, para después

expandir (o no) esta habitación hipótesis de acuerdo a la distribución de los

datos. Finalmente, se aplica un proceso secuencial basado en homografı́as de forma

que las distintas hipótesis de imágenes consecutivas compartan información entre

sı́ consiguiendo resultados más homogéneos y precisos.

Figura 1.4: Comparación entre imagen tomada por una cámara convencional y una cámara

omnidireccional donde se pueden observar las caracterı́sticas definidas en la literatura. Ambas

fotos tomadas en la plaza de las Ingenierı́as, que separa el edificio Torres Quevedo y el edificio

Betancourt.

14

1.4.

1.4. Estructura de contenidos

Estructura de contenidos

Tras esta introducción, la estructura del presente proyecto es la siguiente:

en el capı́tulo 2 se introduce el modelo proyectivo de la esfera, cuyos conceptos

tienen gran importancia en el desarrollo del resto del proyecto. Los tres siguientes

capı́tulos contienen la principal aportación del trabajo, y un esquema gráfico de

los distintos pasos puede observarse en la figura 1.5. El capı́tulo 3 se centra en

el diseño de un nuevo método de extracción y clasificación de las lı́neas extraı́das

de una imagen catadióptrica con la obtención de sus respectivos puntos de fuga y

se compara con dos de los métodos existentes en la literatura. En el capı́tulo 4 se

presenta un método innovador que utiliza la información de las lı́neas clasificadas en

el capı́tulo anterior para generar una hipótesis del contorno del suelo y las paredes

de la escena observadas en la imagen. Esta hipótesis se ve mejorada mediante un

proceso secuencial basado en homografı́as, explicado en el capı́tulo 5, que busca

conseguir resultados más robustos y homogéneos. Los resultados para los tres

principales capı́tulos de este proyecto ( 3, 4 y 5) son presentados en el capı́tulo 6.

Por último, en el capı́tulo 7 se exponen las conclusiones obtenidas del proyecto

ası́ como lı́neas futuras de investigación sobre este tema.

1. Introducción

15

Figura 1.5: Esquema de las etapas principales del algoritmo desarrollado junto a los procesos

más importantes de cada una.

16

1.4. Estructura de contenidos

Sección 2

El modelo de la esfera

El modelo de la esfera es un modelo geométrico abstracto que unifica la

geometrı́a de proyección caracterı́stica de los sistemas catadióptricos centrales,

que relacionan puntos de la escena con puntos en la imagen. Estos sistemas están

formados por la combinación entre espejos y cámaras convencionales, donde las

caracterı́sticas geométricas del espejo vienen reflejadas en los parámetros ξ y ψ

como se indica en la tabla 2.1 . Concretamente el tipo de sistema viene determinado

por el parámetro del espejo ξ. Donde ξ = 0 para cámara perspectiva, ξ = 1 para

cámara para-catadióptrica, 0 < ξ < 1 para hiper-catadióptrica y ξ < 0 cuando se

modela un sistema con distorsión radial.

El sistema de referencia de este modelo toma como origen de coordenadas O

el origen del sistema catadióptrico central que se está modelando, cuya posición

varı́a dependiendo del tipo de sistema utilizado. En el caso de un sistema hipercatadióptrico, el origen de coordenadas O se sitúa en uno de los focos de la

hipérbola generatriz, en el caso de el sistema para-catadióptrico corresponde al

foco de la parábola y en el caso de sistema perspectivo coincide con el centro

óptico de la cámara.

La proyección de un punto genérico del entorno Xw en un punto x̂ sobre la

imagen catadióptrica, se explica mediante un proceso de tres pasos.

Siendo Xw un punto del entorno expresado en coordenadas homogéneas Xw =

(Xw , Yw , Zw , 1) respecto a un sistema de referencia absoluto, se le puede asociar

un rayo proyectivo x en el sistema de referencia de la cámara mediante la matriz

de proyección P

x = PXw = R[I| − C0 ]Xw

(2.1)

donde R y CO representan la rotación y el desplazamiento del sistema de

coordenadas del modelo con respecto al sistema de coordenadas absolutas.

17

18

Espejo parabólico

Espejo hiperbólico

Espejo elı́ptico

ξ

1

ψ

1 + 2p

√d+2p

√

d

d2 +4p2

√ d

d2 +4p2

d2 +4p2

d−2p

√

d2 +4p2

Espejo plano

0

d: distancia entre focos

4p:latus rectum

1

Tabla 2.1: Parámetros del espejo para el modelo de la esfera

Para simplificar, y sin perdida de generalidad, asumiremos que el modelo

catadióptrico y el sistema de coordenadas absolutas es el mismo por lo que

P = [I|0], de forma que el rayo proyectivo resultante es el resultado de unir el

punto Xw con el origen de coordenadas O.

Figura 2.1: Modelo de la Esfera para sistemas catadióptricos.

Sea S la esfera de radio unidad centrada en el origen de coordenadas O, se

calcula la proyección del rayo x sobre la esfera como la intersección de ambos en

dos puntos x+ y x− , de los cuales solo uno es fı́sicamente coherente.

Estos puntos son proyectados sobre un plano de proyección virtual π

(denominado n-plano), a través del centro óptico virtual Cp = (0, 0, −ξ)T ,

2. El modelo de la esfera

19

obteniendo los puntos x̄+ y x̄− .

Si solo tenemos en cuenta la solución fı́sicamente coherente, esto se puede

resumir en aplicar la función no lineal sobre el rayo proyectivo x.

x̄ = (x)

(2.2)

⎞

x

⎠

(x) = ⎝

y

2

2

2

z+ξ x +y +z

(2.3)

⎛

(Nótese que al trabajar con ecuaciones homogéneas la expresión presentada es

t

y

y

x

equivalente a (x) = √x2 +y2 +z2 √x2 +y2 +z2 √x2 +y2 +z2 + ξ

que es la que se

deduce de proyectar la intersección de la esfera a través del centro óptico Cp ).

El tercer y último paso consiste en aplicar la transformación lineal Hc para

proyectar el plano virtual π que contiene el punto x̄ al plano πIM , para ası́ obtener

el punto final x̂ en coordenadas de la imagen catadióptrica.

⎛

x̂ = Hc x̄

(2.4)

Hc = Kc Rc Mc

(2.5)

ψ−ξ

0

⎝

0

ξ−ψ

Mc =

0

0

⎛

fx

⎝

0

Kc =

0

⎞ ⎛

⎞

0

−η 0 0

0 ⎠=⎝ 0 η 0 ⎠

1

0 0 1

⎞

sskew u0

fy

v0 ⎠

0

1

(2.6)

(2.7)

donde Kc contiene los parámetros intrı́nsecos de la calibración de la cámara

perspectiva: fx = f /k y fy = f /l son el resultado de dividir la distancia focal de

la cámara (f ) entre las dimensiones de un pixel (k × l) respectivamente, u0 y v0

indican las coordenadas del centro de la imagen, y sskew es la desviación de los ejes,

habitualmente cero. Rc representa la orientación de la cámara respecto al espejo,

y Mc incluye los parámetros del espejo ξ y ψ, que en la práctica se sustituyen por

un único parámetro η.

En la mayorı́a de los casos se puede asumir que la cámara y el espejo están

20

alineados (Rc = I) y la matriz de

⎛

−ηfx

⎝

0

Hc =

0

transformación, se puede expresar:

⎞ ⎛

⎞

0 u0

γ x 0 u0

ηfy v0 ⎠ = ⎝ 0 γy v0 ⎠

0

1

0 0 1

(2.8)

En el que γx = −ηfx y γy = ηfy son las distancias focales generalizadas del

sistema catadióptrico completo (espejo más cámara). Hay que tener en cuenta que

la calibración de los sistemas catadióptricos se suele determinar como un conjunto

y por tanto el parámetro η no se determina explı́citamente, sino que está implı́cito

dentro de las distancias focales generalizadas.

Una vez obtenido el punto x̂ = (x̂, ŷ, ẑ)T , la relación entre éste y las coordenadas

Euclı́deas de la imagen (u, v) se calcula dividiendo el vector entre la tercera

componente.

ŷ

x̂

v=

ẑ

ẑ

Igual que hemos realizado la proyección de un punto del entorno en la imagen, se

puede realizar el proceso inverso, con la limitación de que se pierde la información

de profundidad, por lo que la proyección de un punto de la imagen catadióptrico

se corresponde a un rayo del entorno.

Esta relación inversa se lleva a cabo multiplicando por la inversa de la matriz

Hc y por la función no lineal definida en la ecuación 2.9 que proyecta los puntos

pertenecientes al plano π en un rayo orientado.

⎛

⎞

√

z̄ξ+ z̄ 2 +(1−ξ 2 )(x̄2 +ȳ 2 )

x̄ ⎟

⎜

√ x̄22 +ȳ2 +z̄2 2 2 2

⎜

⎟

)(x̄ +ȳ )

(2.9)

−1 (x̄) = ⎜ z̄ξ+ z̄ +(1−ξ

⎟

ȳ

2

2

2

⎝

⎠

√ 2 x̄ +ȳ2 +z̄2 2

z̄ξ+ z̄ +(1−ξ )(x̄ +ȳ )

z̄ − ξ

x̄2 +ȳ 2 +z̄ 2

u=

Ambos procesos, directo e inverso, pueden resumirse con el siguiente esquema

(figura 2.2):

Figura 2.2: Pasos de la proyección del Modelo de la Esfera.

2. El modelo de la esfera

2.1.

21

Proyección de una recta

En este apartado se presenta la aplicación del modelo de la esfera a la proyección

de lı́neas de la escena sobre la imagen catadióptrica.

Una recta r, en el espacio 3D, está formada por un conjunto infinito de puntos

alineados. Por lo que proyectar una recta serı́a el equivalente de proyectar cada uno

de los puntos que la compone. Cada uno de estos puntos tiene asociado un rayo

proyectivo que cruza por el origen de coordenadas del sistema catadióptrico central

O. Sea Π el plano definido por la recta r y el origen de coordenadas del sistema

catadióptrico central O (punto de vista efectivo), que contiene los rayos proyectivos

asociados a cada punto de la recta y descrito en coordenadas homogéneas absolutas

como Π = (nx , ny , nz , 0)T . Asumiendo una vez más que el sistema de coordenadas

absolutas y el del sistema catadióptrico coincide, por lo que P = [I| 0], entonces el

plano Π puede representarse como n = PΠ = (nx , ny , nz )T . Obsérvese que al igual

que la recta r está contenida en el plano Π, existe otro infinito número de rectas

que pueden pertenecer a este plano y debido a esto, tendrán la misma proyección

en una imagen. El cı́rculo formado por la intersección del plano Π y la esfera recibe

el nombre de gran cı́rculo.

Figura 2.3: Proyección de una recta mediante el modelo de la esfera.

Los puntos de la escena Xw , pertenecientes a la recta r, son representados

como puntos x, pertenecientes al gran cı́rculo, y satisfacen nT x = 0. Como vimos

anteriormente, x = −1 (x̄) entonces nT −1 (x̄) = 0. Desarrollando esta expresión

se llega a una igualdad que puede expresarse de la forma x̄T Ω̄x̄ = 0 siendo Ω̄

la expresión matricial homogénea de la cónica sobre el plano genérico virtual π

22

2.1. Proyección de una recta

situado a una distancia unidad del origen de coordenadas O.

⎞

⎛ 2

nx ny (1 − ξ 2 )

nx nz

nx (1 − ξ 2 ) − n2z ξ 2

n2y (1 − ξ 2 ) − n2z ξ 2 ny nz ⎠

Ω̄ = ⎝ nx ny (1 − ξ 2 )

nx nz

ny nz

n2z

(2.10)

Este proceso puede ser explicado de forma geométrica como la proyección de los

puntos pertenecientes al gran cı́rculo, formado por la intersección entre el plano

Π y la esfera, a través del centro óptico virtual Cp . Esta proyección forma un cono

que corta al plano virtual π en una lı́nea cónica Ω̄ que coincide con la definida en

la ecuación 2.10.

Por último se aplica la transformación lineal Hc para obtener la cónica Ω̂ que

es la proyección de la linea r sobre la imagen catadióptrica.

−1

Ω̂ = H−T

c Ω̄Hc

(2.11)

De la misma manera se puede aplicar el proceso inverso que proyecta las lı́neas

cónicas de la imagen de vuelta a la esfera, proceso muy útil en el resto de capı́tulos

de este proyecto, tanto como para la clasificación de cónicas del capı́tulo 3 como

para hacer operaciones entre éstas a partir de sus vectores normales que las definen

en el modelo de la esfera.

Sección 3

Extracción

cónicas

y

clasificación

de

El primer paso para empezar a trabajar con imágenes, es decidir con qué tipo

de información nos interesa trabajar y cómo podemos realizar su extracción para

aplicarla en otros procesos.

Nuestro objetivo final es saber distinguir qué partes de la imagen son suelo y

cuáles son paredes, y al igual que en la mayorı́a de los algoritmos desarrollados

para imágenes convencionales, la mejor forma de realizar esta tarea es mediante la

extracción y clasificación de lı́neas de la imagen.

Extracción

El problema de extracción de lı́neas ya está estudiado y existen varios

métodos para su aplicación. Aunque los resultados obtenidos por los distintos

métodos son muy parecidos, en este trabajo se hará uso del denominado

Canny Edge Detector [10] que presenta un buen comportamiento frente a

la detección de trazos conectados.

Posteriormente a la aplicación de este detector de lı́neas sobre la imagen de

entrada se emplea una máscara que elimina las partes de la foto que carecen

de información. Dichas zonas son el centro de la imagen donde se encuentra

reflejado el objetivo de la cámara, y las zonas que caen fuera del alcance del

espejo y aparecen en negro.

Una vez hecho esto, los diferentes trazos conectados se guardan como

componentes que luego serán procesados.

23

24

Clasificación

Hay que notar que, como ya se mencionó en la sección 2, las lı́neas rectas

de la escena son representadas por lı́neas cónicas en la imagen catadióptrica,

a excepción de las cónicas degeneradas en rectas que aparecen en forma de

lı́neas radiales cruzando por el centro de la imagen.

El objetivo ahora es ser capaz de detectar estas cónicas y de clasificarlas

según su orientación relativa, es decir, reconocer si son lı́neas verticales u

horizontales de la escena y en que dirección están situadas.

En lo referente a visión omnidireccional dos métodos para realizar esta tarea

son seguir trabajando sobre la imagen catadióptrica [8] o proyectar las lı́neas

extraı́das sobre la esfera unitaria [4] del modelo propuesto en el capı́tulo 2.

A continuación se explican las diferencias entre los distintos métodos. Los

algoritmos están disponibles como código abierto y programados en Matlab.

Para poder hacer una comparación justa entre ambos vamos a trabajar con

imágenes de la base de datos COGN IRON [26], a la cual también se puede

acceder de forma libre, de la misma manera que a la calibración del sistema

catadióptrico utilizado para la toma de estas imágenes. En este caso el sistema

está compuesto por una cámara perspectiva con una resolución de 1024 ×

768 pı́xeles y un espejo convexo hiperbólico cuyos parámetros geométricos

aportados por el fabricante son de a=42.088 b=25.0911 y de 61 mm de

diámetro exterior. El parámetro del espejo según el modelo de la esfera es

ξ = 0,9337.

1

Ver detalles en Anexo A

3. Extracción y clasificación de cónicas

3.1.

25

Clasificación sobre imagen catadióptrica

Para ser capaces de definir una lı́nea cónica necesitamos 5 puntos que la definan,

y si estos puntos no están bien distribuidos a lo largo de toda la curva, la estimación

puede no ser correcta.

En [9] se demuestra como si se dispone de los parámetros de calibración del

sistema, sólo dos puntos son necesarios para ser capaces de computar estas lı́neas.

3.1.1.

Cálculo de cónicas

Usando la técnica de dos puntos, se propone un método robusto que mediante la

aplicación de RANSAC [16] (RANdom SAmple Consensus), plantea la extracción

del mayor número de cónicas correspondientes a segmentos rectos de la escena.

Para ello, a cada uno de los componentes (grupos de puntos conectados), se le

aplican los siguientes pasos:

1. Entre los puntos que forman el componente, se seleccionan dos aleatoriamente

a partir de los cuales se genera una cónica.

2. A continuación, se mide la distancia entre la cónica generada y el resto de

los puntos pertenecientes al grupo. Los puntos cuya distancia es menor a un

umbral de decisión votan por esta cónica. Este proceso se repite un número

de veces determinado estadı́sticamente, y al terminar se selecciona la cónica

con mayor número de votos.

3. Se aplican de nuevo los pasos anteriores a los puntos que no han votado a la

cónica seleccionada para detectar una nueva cónica. Y se repite este proceso

hasta que el número de puntos que no votan por ninguna de las cónicas

seleccionadas es menor a un umbral.

3.1.2.

Cálculo de los puntos de fuga

Una vez se han extraı́do las cónicas que definen los tramos rectos de la escena

se procede al análisis de los puntos de fuga de estas cónicas, los cuales facilitaran

la futura clasificación.

El punto de fuga es el lugar geométrico en el que las rectas paralelas

en una dirección dada convergen. En imágenes convencionales, es un punto

impropio situado en el infinito. Sin embargo, cuando trabajamos con imágenes

catadióptricas, las rectas se transforman en cónicas y estas cónicas se cortan entre

sı́ en uno o dos puntos dentro de la imagen. Dada esta propiedad, si encontramos

26

3.1. Clasificación sobre imagen catadióptrica

los puntos donde varias cónicas intersectan, podremos deducir el paralelismo entre

los distintos segmentos de la imagen.

Supongamos que m es el número de cónicas detectadas en la imagen

omnidireccional, y que ni es la normal que las representa en el plano normalizado.

Para cada par de cónicas nj , nk (siendo un total de m(m − 1)/2 pares), se calcula

la intersección entre ellas 2 . Y luego para cada una de las lı́neas restantes ni

calculamos su distancia a los puntos de corte formados por nj y nk . Si la lı́nea

ni es paralela al par de cónicas, la distancia a los puntos será inferior a un umbral

y entonces la lı́nea ni vota al posible punto de fuga formado por el corte entre nj ,

nk .

Los puntos de fuga más votados son considerados como direcciones dominantes,

y las lı́neas se clasifican en función a su distancia a ellos (figura 3.1).

El caso general para entornos de interior es encontrar 3 puntos de fuga. Uno

central correspondiente a la dirección vertical, y otros dos pares de puntos que

representan una direccional horizontal cada par.

(a)

(b)

Figura 3.1: Resultados de Clasificación sobre la Imagen: (a) Componentes conectados (colores

vivos) junto a las cónicas que los aproximan (azul). (b) Clasificación de los elementos conectados

según direcciones principales. En este caso se detectan 4, pero únicamente tres son representativas:

Verticales(azul), Horizontales en X (rojo), Horizontales en Y (verdes).

2

Explicado en profundidad en el Anexo D

3. Extracción y clasificación de cónicas

3.2.

27

Clasificación sobre la esfera

En este otro modelo se trabaja sobre la esfera unitaria. El primer paso es

utilizar el proceso inverso de proyección para llevar todos los componentes (grupos

de puntos conectados) detectados en la imagen catadióptrica a la esfera.

3.2.1.

Cálculo de cónicas

Sean P1i = (X1i , Y1i , Z1i ) y PNi = (XNi , YNi , ZNi ) los puntos situados en los

extremos de un componente de N pı́xeles, estos dos puntos definen un gran cı́rculo

1 × OP

N siendo O el centro de la esfera. Se

representado por su normal ni = OP

considera que un punto Psi = (Xsi , Ysi , Zsi ) de esta cadena de puntos pertenece al

gran cı́rculo de normal ni si:

(Xsi , Ysi , Zsi ) · ni ≤ U mbralSeparacion

(3.1)

Si el 95 % de los pı́xeles de el componente pertenecen al gran cı́rculo, entonces el

conjunto de puntos completo es considerado una cónica, equivalente a un segmento

recto de la escena.

En caso contrario, dividimos el componente en dos subgrupos en el punto donde:

arg max (Xsi , Ysi , Zsi ) · ni (3.2)

si

Este proceso de separación termina cuando todos los trozos en los que se divide

el componente pertenecen a una lı́nea, o cuando la longitud de los trozos son

inferiores a determinada número de pı́xeles.

3.2.2.

Cálculo de los puntos de fuga

Como ya se comentó, los puntos de fuga en la imagen catadióptrica son el lugar

geométrico donde dos o más cónicas intersectan. Similarmente, en la esfera dos

cónicas son representadas por dos grandes cı́rculos y estos cortan entre sı́ en dos

puntos antı́podos de la esfera. Estos dos puntos corresponden a la dirección de los

puntos de fuga y los caracterizaremos por el vector u.

Llamemos n1 y n2 a las normales dos grandes cı́rculos en la esfera. Su

intersección viene dada por la expresión u = n1 × n2 y corresponde a la dirección

de los puntos antı́podos. Ahora se considerará que un gran cı́rculo de normal ni

tiene la misma dirección que n1 y n2 si:

1 − ni · u ≤ U mbralSimilaritud

(3.3)

28

3.2. Clasificación sobre la esfera

Repitiendo este proceso con cada normal ni , y para cada combinación de 2

normales, podemos calcular una lista de vectores u, donde aquel con mayor número

de lı́neas paralelas es el que representa la dirección dominante en la imagen. Si

eliminamos esta dirección y las lı́neas paralelas que la votaban, podemos repetir

el proceso para encontrar sucesivas direcciones dominantes. Nótese que si m es el

número de cónicas detectadas, el número total de combinaciones a probar es de

m(m − 1).

En la gran mayorı́a de entornos se comprueba que las direcciones con mayor

número de votantes se corresponden con la dirección vertical y dos horizontales

ortogonales (figura 3.2).

(a)

(b)

Figura 3.2: Resultados de Clasificación sobre la Esfera Unitaria: (a) Componentes conectados

(colores vivos) junto a las cónicas que los aproximan (azul). (b) Clasificación de los elementos

conectados según direcciones principales. Verticales(azul), Horizontales en X (rojo), Horizontales

en Y (verdes).

3. Extracción y clasificación de cónicas

3.3.

29

Método propuesto

Cada uno de estos métodos tiene una ventaja y una desventaja. El primer

método ( 3.1) resulta ser muy rápido, pero los resultados de la clasificación no

son todo lo precisos que se desearı́a. Por contra, la precisión de clasificación con el

modelo que trabaja en la esfera ( 3.2) es mucho más fiable, pero el problema no

escala bien en función del número de normales presentes en la imagen y se hace

demasiado lento para las escenas con las que trabajamos.

En este apartado se propone un nuevo método que parte de las cónicas extraı́das

mediante el método que trabaja con modelo de la esfera con el objetivo de mantener

la buena precisión del algoritmo, pero se hace un enfoque distinto para conseguir

ejecutarlo en un tiempo mı́nimo.

Este proyecto se centra en la extracción de la distribución estructural en

entornos de interior, por lo que es totalmente aceptable partir de dos supuestos.

El primero es la hipótesis de que nos encontramos ante el caso de ciudad de

Manhattan[11], que asume que el entorno en el que nos movemos está compuesto

por estructuras 3D donde existen 3 direcciones principales ortogonales entre sı́.

Caso razonable dado que los escenarios construidos por el hombre suelen estar

dotados de esta caracterı́stica. La segunda hipótesis consiste en asumir que

el sistema catadióptrico es perfectamente perpendicular al suelo, hipótesis que

tampoco es descabellada ya que, en la gran mayorı́a de los casos, los sensores de

visión se encuentran situados sobre robots que se desplazan por el suelo mediante

ruedas con movimiento plano.

Para simplificar los cálculos, asumamos que las tres direcciones principales del

escenario coinciden con la base Euclı́dea e1 = (1, 0, 0), e2 = (0, 1, 0) y e3 = (0, 0, 1),

de forma que las lı́neas horizontales de la escena sean paralelas a los vectores e1 y

e2 respectivamente, y las verticales sean paralelas a e3 .

Al proyectar estas lı́neas en la esfera unitaria, las intersecciones entre el plano

de proyección y la esfera forman grandes cı́rculos definidos por la normal al plano

que los contiene. En este caso las normales que definen a los planos de proyección

de las lı́neas paralelas a e1 serán de la forma n⊥e1 = (0, ny , nz ). Lo mismo ocurre

con las lı́neas paralelas a e2 y e3 , donde las normales a sus planos de proyección

son respectivamente n⊥e2 = (nx , 0, nz ) y n⊥e3 = (nx , ny , 0). Esta distribución se ve

reflejada en la figura 3.3.

Nótese que las direcciones en las que apuntan estas normales siempre forman

tres “cı́rculos”(en realidad existen pequeñas desviaciones) ortogonales entre sı́, por

lo que, aunque las bases no coincidan con la base Euclı́dea, seguiremos teniendo la

30

3.3. Método propuesto

Figura 3.3: En la imagen de la izquierda se representan 3 trazos en la misma dirección de

la base Euclı́dea (e1 ,e2 ,e3 ) los cuales se proyectan en la esfera mediante planos de proyección

representados por las normales (n⊥e1 , n⊥e2 , n⊥e3 ) respectivamente y se muestran como un punto

de su color. En las dos siguientes imágenes se enseña como quedarı́a una posible distribución de

varias normales proyectadas sobre la esfera ante caso Euclı́deo y caso general dada una rotación

R.

misma distribución, pero girada un ángulo α sobre el eje Z, un ángulo β sobre el

eje X y otro ángulo γ sobre el eje Y.

Vista esta propiedad, el método de clasificación consiste en representar sobre

la esfera las normales que definen los grandes cı́rculos en los que se proyectan las

lı́neas cónicas extraı́das de la imagen catadióptrica. Estas normales tendrán una

distribución muy similar a la explicada anteriormente, por lo que el objetivo es

encontrar cuáles son los cı́rculos en los que apuntan, o lo que es lo mismo, calcular

la rotación que marca la diferencia entre la base Euclı́dea (e1 ,e2 ,e3 ) y la base de

la escena (v1 ,v2 ,v3 ).

Si consideramos ahora la segunda hipótesis, por la que el eje Z de el sistema

catadióptrico es perpendicular al suelo en todo momento, podemos simplificar el

algoritmo de búsqueda ya que el giro sobre los ejes X e Y será nulo, por lo que

β = 0 y γ = 0.

Los pasos a seguir para realizar la clasificación y extracción de los puntos de

fuga son los siguientes:

1. Al asumir perpendicularidad entre el eje Z del sistema catadióptrico y el

suelo, los ángulos de inclinación β = 0 y γ = 0, y las normales de las lı́neas

pertenecientes a la dirección Z vienen dadas por n⊥e3 (nx , ny , 0). Por esto,

todas las cónicas cuyas normales tienen componente nz menor a un threshold

3. Extracción y clasificación de cónicas

31

1

0.8

1

0.6

0.8

0.4

0.6

0.2

0

0.4

−0.2

0.2

−0.4

0

−1

−0.6

−0.5

1

0

0.5

0

0.5

1

−0.5

−0.8

−1

−1

−0.8

−0.6

−0.4

−0.2

0

0.2

0.4

0.6

0.8

1

−1

Figura 3.4: Izquierda: Distribución de las normales sobre la esfera unitaria a partir de datos

reales. Derecha: Clasificación de las normales de la izquierda según las 3 direcciones principales.

Los puntos gordos corresponden a la intersección entre grandes cı́rculos, es decir, los puntos de

fuga.

(experimentalmente 0,2 es un buen valor), son automáticamente clasificadas

como pertenecientes a la dirección Z.

2. Se elimina la componente nz de las normales restantes. De esta forma se

pueden representar sobre un plano 2D, dónde la mayorı́a de los datos se

proyectados componen una distribución en forma de cruz, girada un ángulo

α.

3. Mediante RANSAC se busca el ángulo α que caracteriza a las dos direcciones

error

, dónde

principales ortogonales entre sı́, de manera que éstas minimicen inliers

los inliers son el número de normales de entre el total que votan por una de

las dos direcciones, y el error es la distancia entre cada inlier a la dirección

que vota.

4. Las lı́neas se clasifican en una dirección u otra dependiendo de la distancia

de sus normales a las direcciones calculadas como dominantes.

5. Finalmente el punto de fuga para la dirección Z lo situamos en el centro de

la imagen y los otros puntos de fuga vienen definidos por las zonas donde

las direcciones dominantes intersectan con la esfera en el hemisferio (Z = 0).

Ver figura 3.4

En la figura 3.5 se muestra al resultado obtenido al completar el proceso de

clasificación (derecha), y se compara con los métodos definidos anteriormente.

32

3.3. Método propuesto

(a)

(b)

(c)

Figura 3.5:

Comparación entre la clasificación obtenida por los métodos descritos. (a)

Clasificación sobre imagen catadióptrica, tiempo en clasificar 1.5 sec. (b) Clasificación sobre

la esfera, tiempo en clasificar 120 sec. (c) Método propuesto, tiempo en clasificar 0.5 sec

Debido a la mejor precisión en cuanto a la clasificación de lı́neas, que se

mostrará en el capı́tulo de resultados 6, y a la rapidez de ejecución, de aquı́ en

adelante se utilizará el método propuesto para llevar a cabo la extracción de

información.

Sección 4

Obtención de la distribución

espacial de una escena

En esta sección se aborda la parte del trabajo dedicada a la extracción de la

distribución espacial a partir de una sola imagen catadióptrica, de forma que sea

posible la detección automática del suelo, las paredes y la localización y orientación

respectiva entre estos elementos de la escena (Figura 4.1). La información de

partida son las cónicas extraı́das y clasificadas, ası́ como los puntos de fuga

obtenidos en el procedimiento explicado en el capı́tulo anterior.

Figura 4.1: Ejemplo de una imagen tomada con un sistema hipercatadióptrico y el resultado

deseado después de aplicar el algoritmo. En la imagen, el color azul representa el suelo, el color

rojo representa paredes paralelas en una dirección dominante, y el color verde paredes paralelas

en una dirección dominante ortogonal a la anterior.

33

34

4.1.

4.1. Método jerárquico de generación de hipótesis

Método jerárquico

hipótesis

de

generación

de

Ya se ha visto el proceso de extracción y clasificación de información, mediante

el cual se han obtenido un conjunto de lı́neas a partir de la imagen catadióptrica y

clasificado según una de las tres direcciones principales que caracterizan la escena.

Etiquetemos estas direcciones como dirección Z a la representada por lı́neas de

color azul y cuyas lı́neas son las proyecciones de los segmentos verticales de la escena

3D, y direcciones X e Y a las representadas por rojo y verde respectivamente,

las cuales son las proyecciones de los segmentos horizontales ortogonales entre

sı́ (figura 3.5).

También se han extraı́do los puntos de fuga, caracterizados por ser los puntos

geométricos donde se intersectan las lı́neas paralelas, es decir, las pertenecientes a

un mismo grupo.

El objetivo de esta sección es utilizar la información previamente descrita en

conjunto a una serie de restricciones geométricas a partir de las cuales plantear

hipótesis que se aproximen lo máximo posible a la verdadera forma de la escena

real, de forma que se pueda distinguir donde se encuentran los limites entre suelo

y paredes.

4.1.1.

Selección de puntos clave

El trabajo propuesto en [23] prestaba especial atención a encontrar esquinas que

posteriormente sirvieran para delimitar la zona por donde se expande el suelo de

la escena real que estamos estudiando. Estas esquinas vienen definidas por puntos

donde intersectan segmentos verticales/horizontales entre sı́.

Sin embargo, las esquinas que definen los contornos reales del suelo de la escena

estudiada son indetectables en muchos casos, con la dificultad añadida de que por

el contrario, muchas esquinas que no pertenecen al suelo, sino a elementos como

muebles o ventanas, son mucho más fáciles de detectar y por tanto pueden llevar

a considerar hipótesis erróneas.

Es por esto que en este trabajo se va a hacer uso de otro tipo de puntos para

plantear futuras hipótesis sobre la localización del suelo de la escena.

Haciendo un estudio de diversas imágenes a las cuales les ha sido aplicado

el proceso de la sección 3, se puede observar como las lı́neas pertenecientes a la

dirección Z (representadas en azul), son más robustas que las lı́neas pertenecientes

a las direcciones horizontales. Esto quiere decir que la información que aportan

los segmentos verticales es más fiable ya que en la gran mayorı́a de los casos

4. Obtención de la distribución espacial de una escena

35

todas estas lı́neas nacen desde el suelo y se extienden de forma radial hacia los

bordes de la imagen. Por otro lado, las lı́neas horizontales son más susceptibles

al ruido o a ser clasificadas de forma incorrecta, de forma que suelos y paredes

con gran concentración de segmentos (véase muchos tipos de baldosas o ladrillos)

harán aparecer lı́neas innecesarias sobre la imagen, resultando en una dificultad

añadida en cuanto a la correcta localización del lı́mite pared-suelo. De forma

contraria, también se dan multiples casos en los que el lı́mite que tendrı́a que

estar representando la transición pared-suelo no ha podido ser extraı́do, por lo que

prestar mucha confianza a estas lı́neas no es la mejor opción.

Recordando la sección 3.1, ya se vio cómo con tan sólo dos puntos es posible

definir una lı́nea cónica sobre la imagen catadióptrica. También se ha mencionado

que todas las lı́neas de la escena han de pasar por un punto de fuga, esto quiere

decir que los bordes que delimitan el contorno entre suelo y pared también han de

pasar por uno de estos puntos de fuga.

Juntando estas dos afirmaciones se deduce que tan solo necesitamos un punto

que pertenezca al lı́mite pared-suelo para definir la cónica que lo delimita. Ahora

bien, obviamente si el objetivo es encontrar dónde está situado el lı́mite de

separación entre pared y suelo, no podemos saber cuando un punto pertenece

a éste o no, por lo que es necesario diseñar un algoritmo que sea capaz de deducir

las regiones más probables en las que deben encontrarse estos puntos.

Se hace evidente que la información aportada por las lı́neas almacenadas en los

tres grupos definidos con anterioridad es redundante y tan solo unos pocos puntos

pertenecientes a éstas son necesarios para generar las hipótesis de contorno.

De esta forma se definen los siguientes tres nuevos grupos (figura 4.2):

De cada lı́nea que formaba parte del grupo de segmentos verticales (azules),

se selecciona el punto más cercano al centro de la imagen, con objetivo de

que este punto recaiga en la zona limitante entre suelo y pared. El conjunto

de estos puntos formará el nuevo grupo GZ .

Tomando las lı́neas pertenecientes al grupo de segmentos horizontales en

dirección X (rojos), se seleccionan únicamente aquellas que están cercanas a

alguno de los puntos del nuevo grupo GZ , y estas lı́neas serán discretizadas

tomando puntos cada cierto intervalo de longitud, los cuales pasarán a formar

parte del grupo GX .

Se repite el mismo proceso anterior para las lı́neas horizontales en dirección

Y formando el grupo GY .

36

4.1. Método jerárquico de generación de hipótesis

Figura 4.2:

Discretización de lı́neas en puntos. Se puede apreciar como solo las lı́neas

horizontales (rojas y verdes) cercanas a las verticales (azules) son incluidas en el proceso.

Figura 4.3:

Formas más comunes de los suelos presentes en escenas de interior. La zona

sombreada en rojo representa el cuadrado básico central.

4.1.2.

Hipótesis inicial del contorno central

Una vez que se tienen los datos necesarios para generar hipótesis de las posibles

zonas donde se encuentra el borde entre pared y suelo surge un nuevo problema,

no se sabe cuantos bordes estamos buscando y un programa de ordenador no

puede identificar el número de paredes que componen una habitación, sin alguna

información adicional.

Sin embargo, los entornos de interior suelen estar construidos según una

serie de patrones. Se puede distinguir entre pasillos o habitaciones, los primeros

comúnmente son alargados en forma de I, o con ramificaciones en uno de sus

extremos cuando nos acercamos al final, normalmente adquiriendo forma de L o

de T. En cuanto a habitaciones se refiere, la forma cuadrangular es la forma por

excelencia, pudiendo contar ésta con irregularidades en alguna de sus caras.

La figura 4.3 muestra algunos de los ejemplos más comunes.

4. Obtención de la distribución espacial de una escena

37

Figura 4.4: Imagen virtual simulando la hipótesis de cuatro paredes. Se pueden observar las

4 regiones definidas al segmentar la imagen mediante las lı́neas imaginarias que unen los puntos

de fuga.

Una caracterı́stica que todos estos tipos de escena tienen en común es

que pueden ser definidas por un cuadrilátero central del que pueden surgir

ramificaciones o ampliaciones.

Todo cuadrilátero tiene sus caras paralelas dos a dos, y cada una de éstas caras

paralelas debe caer a cada uno de los lados formados por la lı́nea imaginaria que

une sus correspondientes puntos de fuga (figura 4.4), debido a la definición de

punto de fuga cómo lugar geométrico donde convergen las lı́neas paralelas.

Conociendo ésta propiedad, se toma como punto de partida, para buscar el área

que define el suelo de la escena, la hipótesis de que esta habitación está compuesta

únicamente por cuatro paredes (las correspondientes al cuadrilátero generador),

independientemente de que la escena real esté compuesta por dicho número de

muros o no. Y en pasos posteriores ya se procederá al ajuste más fino de el número

de componentes estructurales para encontrar el resultado que mejor encaja con la

distribución real.

Como se ha comentado, las cuatro lı́neas cónicas que van a definir el suelo

de ésta primera hipótesis de 4 paredes, se sabe que se encuentran en regiones

determinadas, por lo que podemos tratar la búsqueda de cada una de ellas como

un subproblema aislado. Cada uno de estos subproblemas consiste en elegir los

puntos de los grupos GX , GY y GZ que caen en cada una de las regiones definidas

en la figura 4.4 (S1, ..., S4) según el lado del suelo que estamos buscando.

Los lados 1 y 3 serán las lı́neas que definen los lı́mites del suelo con orientación

X, y por tanto se usarán los puntos de los grupos GZ y GX para buscar

cónicas a cada lado de la lı́nea imaginaria (S1 y S3) formada al unir los V P s

en dirección X (Fig. 4.5 (izquierda)) .

Los bordes 2 y 4 definirán los bordes con orientación Y , y las cónicas se

38

4.1. Método jerárquico de generación de hipótesis

Figura 4.5: Puntos de los grupos GZ (azul), GX (rojo) and GY (verde) separados para los 4

posibles casos. Los segmentos discontinuos rojo y verde son las lı́neas imaginarias que unen los

respectivos VPs y dividen la imagen en dos partes.

buscarán a cada lado de la lı́nea imaginaria formada al unir los V P s en

dirección Y (S2 y S4) usando los puntos de los grupos GZ y GY (Fig. 4.5

(centro)) .

Generación de cónicas

Para buscar las cónicas y debido a que no conocemos que puntos se sitúan

sobre la región del suelo, vamos a utilizar RANSAC como forma de identificar las

cónicas más votadas, candidatas a representar el borde deseado.

Otra propiedad geométrica de las imágenes catadióptricas es que los 4 puntos de

fuga definen un cı́rculo. Este cı́rculo corresponde a los puntos de la escena situados

a la misma altura que la cámara, por lo que los puntos que caen en el interior de

este cı́rculo estarán a una altura inferior y por tanto pueden corresponder a puntos

del suelo, mientras que los que están en el exterior del cı́rculo es seguro que no

pueden pertenecer al suelo y son eliminados de manera que no formen parte de la

votación en la búsqueda de cónicas.

Recordar que, solo son necesarios dos puntos, un VP y uno de los puntos de

los grupos GX , GY , GZ recién formados. El producto vectorial entre un VP y

cualquiera de los puntos pi genera un vector normal ni , que define una cónica Ω,

después de la transformación proyectiva HC [2]:

obteniendo finalmente Ω

⎞ ⎛

⎞ ⎛ S ⎞

Pix

V PxS

n ix

S

⎝

⎝

⎝

⎠

⎠

PiSy ⎠

V Py

n iy

=

×

ni =

S

n iz

V Pz

PiSz

⎛

(4.1)

4. Obtención de la distribución espacial de una escena

39

⎤

n2ix (1 − ξ 2 ) − n2iz ξ 2

nix niy (1 − ξ 2 )

nix niz

n2iy (1 − ξ 2 ) − n2iz ξ 2 niy niz ⎦

Ωi = ⎣ nix niy (1 − ξ 2 )

ni x ni z

n iy n iz

n2iz

(4.2)

i = HC −t Ωi HC −1

Ω

(4.3)

⎡

La distancia entre cada punto pj y la cónica generada por el punto pi con el

punto de fuga VP, se mide usando una aproximación a [24]. Se calcula la lı́nea

se calcula la perpendicular a la lı́nea polar,

polar de un punto pj en la cónica Ω,

especificando que pase sobre el punto pj . Este segmento perpendicular corta a la

cónica en dos puntos q+ y q− , la mı́nima distancia euclı́dea entre pj y q+ o q−

corresponde a la distancia entre punto y cónica1 .

Con todos aquellos puntos que tengan una distancia menor a un umbral de la

cónica, se estima una cónica media y se repite el proceso hasta que converge (no

se encuentran más puntos cercanos). Los puntos pj que votan a ésta cónica media

son eliminados de la lista, y se selecciona un nuevo punto pi de entre los restantes

para generar una nueva cónica, repitiendo el proceso hasta que todos los puntos

votan al menos a una cónica (figura 4.6).

De entre las cónicas más votadas para formar los lı́mites del suelo de la hipótesis

de habitación de 4 paredes se eligen aquellas más cercanas al centro de la imagen.

Esto se debe a que al estar buscando el cuadrado central, es preferible seleccionar

un cuadrado más pequeño que luego tiene posibilidades de ser ampliado en el

proceso de expansión (Sección 4.1.3).

El proceso de búsqueda de cónicas se repite para cada uno de los cuatro

casos expuestos, de forma que los puntos que intervienen en la búsqueda vienen

restringidos por el caso en el que nos encontramos. La figura 4.6 muestra las cónicas

extraı́das ante cada caso ası́ como los lı́mites ganadores que forman los contornos

de la primera hipótesis de cuatro paredes.

4.1.3.

Proceso jerárquico para generación de hipótesis

Denotemos cómo B1 , B2 , B3 y B4 las cuatro fronteras entre pared y suelo que

se acaban de obtener para definir el contorno del suelo de la primera hipótesis de

cuatro paredes.

El área entre cada uno de estos bordes y el exterior de la imagen define cuatro

sectores. Estos sectores corresponden a las paredes de la hipótesis inicial, y si ésta

coincide con la escena real, los sectores estarán definiendo las paredes de la escena.

1

Explicado en detalle en el Anexo D

40

4.1. Método jerárquico de generación de hipótesis

Figura 4.6: A la izquierda se muestran las cónicas generadas más votadas para uno de los

cuatro casos. En la imagen central se pueden observar todas las cónicas extraı́das donde cada

color representa cada uno de los casos. La foto de la derecha corresponde con el resultado obtenido

para la primera hipótesis de 4 paredes.

Sin embargo, lo más probable es que esta primera hipótesis solo sea la parte central

de la imagen real, por lo que los sectores que definen las aprendes actuales podrán

ser expandidos.

Se entiende como expansión el proceso mediante el cual se busca reemplazar

cada una de las fronteras Bi por otro conjunto de lı́neas cónicas que agranden el

área del suelo de la primera hipótesis de manera que estas sucesivas hipótesis de

contorno generadas por las posibles ampliaciones de suelo aproximen mejor a la

habitación real que se está analizando.

Ampliar las fronteras Bi se traduce en buscar ramificaciones en las caras del

cuadrilátero central, procedimiento similar al de buscar la hipótesis inicial de

cuatro paredes, pero esta vez en vez de repetir todos los pasos explicados en la

sección 4.1.2, se parte de las cónicas ya extraı́das en dicha sección.

Para cada uno de los sectores definidos por los bordes B1 , B2 , B3 y B4 se

seleccionan aquellas cónicas que contienen votantes. La foto de la derecha de la

figura 4.7 muestra como en el sector definido por el lı́mite B2 se seleccionan en

verde aquellas cónicas que cruzan el sector y contienen inliers sobre éste, por el

contrario, las cónicas marcadas de color blanco son cónicas contenidas en el sector

pero no contienen inliers que voten por ellas dentro de éste.

De las cónicas seleccionadas, con un máximo de 3 lı́neas (2 laterales y una

central) y combinándolas con el borde del contorno inicial (Bi ) del sector al que

pertenecen, se conformarı́a el cuadrilátero que define el posible área a añadir en

el proceso de ampliación de cada lateral. Sin embargo, por diversas cuestiones, no

siempre se va a poder encontrar estas tres lı́neas que conforman el cuadrilátero

de ampliación. En general, a la hora de expandir una de las caras de la hipótesis

inicial, las opciones ante las que nos encontramos se pueden resumir en 3 casos:

Se dan condiciones bien definidas que nos permiten encontrar cónicas

suficiente para generar los 3 nuevos bordes, y por tanto habrá expansión

4. Obtención de la distribución espacial de una escena

41

Figura 4.7: A la izquierda: resultado obtenido para la primera hipótesis de 4 paredes dónde se

ven los bordes B1 , B2 , B3 y B4 que definen 4 sectores. A la derecha: Ampliación del sector 2,

dónde se observan las cónicas seleccionadas (verde) y las no seleccionadas (blanco) candidatas

a generar la sección que expandirá el suelo. Notar cómo la correcta combinación entre B2 dos

cónicas laterales y una central (marcado en amarillo) conforman una expansión perfecta.

en el sector actual.

No se encuentran cónicas centrales o las que se encuentran están muy

próximas a Bi . Esto significa que el borde Bi corresponde con el lı́mite real

entre la pared y el suelo por lo que no hay necesidad de buscar una expansión

en ese sector.

Se encuentra cónica central pero no en uno de los laterales. Esto puede

deberse a que por ruido o algún otro fallo, exista la lı́nea pero no se haya

detectado. O que nos encontremos ante la presencia de una esquina oculta,

es decir, una de las paredes se encuentra en un ángulo de visión muerto para

la cámara y es tapada por otra pared.

Para generalizar el problema pero contemplando cada uno de los casos se sigue

el diagrama de flujo de la imagen 4.8 explicado a continuación.

1. Se selecciona uno de los sectores formados por la primera hipótesis.

2. Se seleccionan y ordenan las cónicas de su interior en tres grupos, 2 laterales

y uno central. Si no se encuentran lı́neas pertenecientes al grupo central nos

encontramos ante el segundo caso; no hay expansión para el sector actual y

pasamos al siguiente.

3. Si se han encontrado cónicas en lado central, pero no se han encontrado en

los laterales, y una de las cónicas centrales tiene más votantes que el borde

actual Bi , se reemplaza el contorno Bi por la nueva cónica resultando en la

expansión de dicha cara.

42

4.1. Método jerárquico de generación de hipótesis

%

#$%

"

%

%

*

!

%

&

%

!

'

(

)

Figura 4.8: Diagrama de flujo seguido para por el algoritmo para obtener la hipótesis final.

4. Si se han encontrado cónicas en el lado central, y en ambos laterales, elegir de

cada grupo la que más votantes tenga, y junto al borde Bi se crea una posible

hipótesis de ampliación. Sin embargo, si solo se han encontrado cónicas en

uno de los laterales, se genera una cónica que pase por el punto de fuga

que caracteriza el sector (aquél que cae dentro de éste) y el punto votante

que, perteneciendo a la lı́nea seleccionada del grupo central, tiene el mayor

ángulo posible con respecto a la lı́nea imaginaria que une el VP y el centro

de la imagen. Una vez se tiene las 3 cónicas, se crea la posible hipótesis de

ampliación.

5. Se comprueba si dentro de este área de ampliación hay un número alto

de puntos que votan a otras cónicas. En caso contrario, ésta es una buena

hipótesis de expansión y pasamos al siguiente sector.

6. Si hay más de un determinado número de votantes es debido a que pese a que

las cónicas elegidas hayan sido más votadas, están pertenecen a alguna pared

u objeto. Por esta razón una de las 3 cónicas que formaban la hipótesis actual

4. Obtención de la distribución espacial de una escena

43

de ampliación se sustituye por otra más proxima al centro de la imagen y se

vuelve a generar otra hipótesis de ampliación.

7. El paso 5 y 6 se repiten hasta que la hipótesis se considera buena o hasta

que no hay cónicas para crear nuevas regiones para ampliar, por lo que no se

ejecutara ampliación.

En la siguiente figura (Fig. 4.9), se muestra el proceso de expansión para la

hipótesis de 4 paredes obtenida en la imagen 4.6.

Figura 4.9: 1)Ampliación del primer sector. 2a)Primera hipótesis del segundo sector, al haber

inliers en el interior hay que reducir. 2b)Segunda hipótesis del sector 2, esta vez corresponde con

la ampliación. 3)Ampliación del tercer sector. 4)No se encuentran ampliaciones, esto es debido a

que el borde ya estaba en el lugar correcto. F)Hipótesis final después de las ampliaciones de las

cuatro caras.

Se observa que en algunas de sus caras el área ampliada podrı́a haber sido mayor

para aumentar el ı́ndice de similitud, pero puesto que en esta sección solo contamos

con la información de una imagen es preferible restringir el área considerada como

suelo, a no ampliarla y pensar que existe más suelo que el que hay en realidad.

Más resultados de aplicar el proceso completo de recuperación estructural de

la escena pueden consultarse en el capı́tulo 6 de resultados experimentales.

44

4.1. Método jerárquico de generación de hipótesis

Sección 5

Aplicación secuencial

homografı́as

mediante

En las secciones previas se ha descrito el método propuesto para estimar la

distribución espacial de un escenario a partir de una sola imagen omnidireccional

capturada por un sistema hyper-catadióptrico.

En el capı́tulo de experimentos 6.2 se muestra como este método conduce a

buenos resultados, pero debido a cambios de iluminación, ruido en la imagen y

diversas adversidades no se puede garantizar una extracción óptima para cada una

de las imágenes analizadas.

Por otra parte, la aplicación final de este algoritmo está orientada a su

utilización con secuencias de imágenes, donde los cambios entre sucesivos

fotogramas se suponen relativamente pequeños. Por lo tanto, se puede asumir que

la distribución estructural obtenida por este método aplicado a una sucesión de

imágenes deberá variar de forma coherente a lo largo de un mismo entorno.

Para poder llevar a cabo estos procesos por los que mejorar la precisión del

método en imágenes donde los resultados no son lo suficientemente robustos, y

poder hacer la información extraı́da de cada una de las imágenes de la secuencia

lo más homogénea posible, se hará uso de homografı́as.

5.1.

Homografı́a

A continuación se definen las caracterı́sticas principales del modelo geométrico

de la homografı́a a través de dos vistas. Dos imágenes perspectivas se pueden

relacionar geométricamente a través de una homografı́a H ∈ R3×3 [7]. Esta

transformación proyectiva H relaciona los puntos pertenecientes a un plano de

45

46

5.1. Homografı́a

la escena observados desde distintos puntos de vista.

Sean R y t la matriz de rotación y el vector de translación entre dos posiciones

O y O∗ del sistema catadióptrico central (figura. 5.1). Obsérvese que el plano

virtual perspectivo asociado a la cámara en las distintas posiciones también se ve

afectado por el mismo movimiento (R, t).

Figura 5.1: Homografı́a entre dos puntos de vista O y O∗ .

Considerando que la lı́nea 3D está situada sobre un plano Π definido por

Π = [nF d], donde nF es la normal del plano Π con respecto a O, y d es la

distancia desde Π hasta el origen O [15]. Nótese que cualquier punto de la escena

perteneciente al plano Xw ∈ Π con coordenadas Xw = [Xw , Yw , Zw ]T con respecto

al origen O y con coordenadas Xw ∗ = [Xw ∗ , Yw ∗ , Zw ∗ ]T con respecto al origen

O∗ se proyecta en la esfera en los puntos Xs y Xs ∗ respectivamente para las dos

posiciones de la cámara. Y la relación entre estos puntos proyectados en la esfera

unitaria viene dada por

Xs ∗ ∝ HXs

donde H es la matriz 3 × 3 de homografı́a.

(5.1)

5. Aplicación secuencial mediante homografı́as

47

Para calcular la matriz de homografı́a entre dos imágenes en el caso general sin

imponer ninguna restricción, se necesitan un mı́nimo de cuatro correspondencias

de puntos entre ambas imágenes, a partir de los cuales se resuelve un sistema lineal

para obtener la matriz H [16].

La homografı́a calibrada está pues relacionada con el movimiento de la cámara

(rotación R, translación t) y su situación con respecto al plano por la siguiente

expresión:

H = R(I + tnTF /d)

(5.2)

donde nTF es la normal del plano y d is la distancia desde éste hasta el origen.

5.1.1.

Homografı́a a partir de lı́neas

Aunque lo más habitual es estimar la homografı́a que relaciona dos imágenes

a partir de puntos correspondientes, también se puede calcular mediante rectas

emparejadas.

Sean dos puntos del espacio X1 y X2 pertenecientes a la linea que

está contenida en el plano Π definido en la sección anterior. Esta linea puede

ser perfectamente definida por la normal al plano, que se calcula como:

nL =

X1 × X2

X1 × X2 (5.3)

Por lo tanto, cualquier punto perteneciente a esta linea cumple nTL Xi =

Xi nL = 0. De acuerdo a la ecuación 5.1, la relación de un punto del espacio

visto desde dos posiciones distintas viene dada por Xi ∗ ∝ HXi . Considerando a la