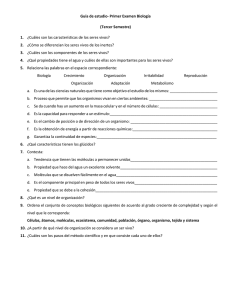

El mundo de la química

Anuncio