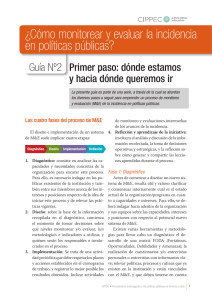

Lecciones aprendidas y desafíos sobre la incidencia en

Anuncio