005.1-P855c-Capitulo II

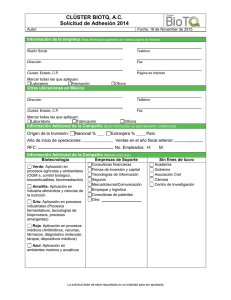

Anuncio