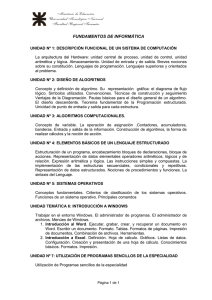

universidad nacional autónoma de méxico facultad de

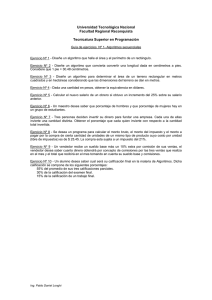

Anuncio