Fundamentos de Sistemas Operativos

Anuncio

Fundamentos de

Sistemas Operativos

Release 1.0

Editor: Armando Arce

April 29, 2015

Contents

1

Introducción

3

2

Estructuras del sistema

5

3

Procesos

3.1 Gestión de Procesos . . . . . . . . . . . . . . .

3.2 Analizando los Procesos . . . . . . . . . . . . .

3.3 Información de un proceso . . . . . . . . . . . .

3.4 Estados de un proceso . . . . . . . . . . . . . .

3.5 Procesos Ligeros . . . . . . . . . . . . . . . . .

3.6 Procesos e Hilos . . . . . . . . . . . . . . . . .

3.7 Multihilos . . . . . . . . . . . . . . . . . . . .

3.8 Hilos de Nivel de Usuario y de Nivel de Núcleo .

3.9 Modelos Multihilos . . . . . . . . . . . . . . .

3.10 Hilos . . . . . . . . . . . . . . . . . . . . . . .

3.11 POSIX . . . . . . . . . . . . . . . . . . . . . .

3.12 Hilos Java . . . . . . . . . . . . . . . . . . . . .

3.13 Hilos Windows . . . . . . . . . . . . . . . . . .

3.14 POSIX vs Windows . . . . . . . . . . . . . . .

3.15 Glosario . . . . . . . . . . . . . . . . . . . . .

3.16 Notas bibliográficas . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

7

7

9

11

13

15

18

19

21

22

26

28

31

32

34

35

36

i

4

5

6

ii

Administración de memoria

4.1 Fundamentos . . . . . . . . . . .

4.2 Intercambio . . . . . . . . . . . .

4.3 Asignación de memoria contigua

4.4 Mapeo de memoria y protección .

4.5 Asignación de memoria . . . . .

4.6 Segmentación . . . . . . . . . .

4.7 Glosario . . . . . . . . . . . . .

4.8 Referencias . . . . . . . . . . . .

4.9 Bibliografía . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

39

39

47

49

49

51

56

59

61

62

Memoria virtual

5.1 Fundamentos . . . . . . . . . . . . . .

5.2 Paginación bajo demanda . . . . . . .

5.3 Fallos de página . . . . . . . . . . . .

5.4 Copia durante escritura . . . . . . . . .

5.5 Sustitución de páginas . . . . . . . . .

5.6 Mecanismos de sustitución de páginas:

5.7 Asignación de Marcos . . . . . . . . .

5.8 Sobrepaginación o Hiperpaginación . .

5.9 Asignación de Memoria del Kernel . .

5.10 Glosario . . . . . . . . . . . . . . . .

5.11 Notas Bibliográficas . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

65

65

68

72

74

75

76

82

87

89

92

93

Sistemas de archivos

6.1 Diseño de sistemas de almacenamiento

6.2 Tipos de sistemas de archivo . . . . . .

6.3 Localización de bloques . . . . . . . .

6.4 Métodos de localización . . . . . . . .

6.5 Directorios . . . . . . . . . . . . . . .

6.6 Concepto de directorio . . . . . . . . .

6.7 Visión lógica de los directorios . . . .

6.8 Estructura de los directorios . . . . . .

6.9 Implementación de Directorios . . . .

6.10 Administración del Espacio en Disco .

6.11 Rendimiento del Sistema de Archivos .

6.12 Organización del directorio . . . . . .

6.13 Estructura física del directorio . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

95

95

96

98

99

105

106

107

107

108

109

109

110

110

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

6.14

6.15

6.16

6.17

6.18

Funcionamiento del directorio . .

Permisos de archivos y directorios

Rutas de Directorios . . . . . . .

Glosario . . . . . . . . . . . . .

Referencias . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

110

112

113

115

117

iii

iv

Fundamentos de Sistemas Operativos, Release 1.0

Este documento consiste de la recopilación de distintas conceptos fundamentales relacionados con los sistemas operativos El mismo ha

sido realizado por los estudiantes del curso de “Principios de Sistemas Operativos” que se impartió en la Escuela de Computación del

Tecnológico de Costa Rica (Cartago, Costa Rica), durante el primer

semestre del 2015.

El esquema base inicial para este trabajo ha sido el libro “Fundamentos de Sistemas Operativos” de Silberschatz, Galvin y Gagne publicado por la editorial Mc Graw Hill en 2005.

La edición de las diferentes recopilaciones de los estudiantes estuvo a

cargo del profesor Armando Arce.

Contents

1

Fundamentos de Sistemas Operativos, Release 1.0

2

Contents

CHAPTER 1

Introducción

3

Fundamentos de Sistemas Operativos, Release 1.0

4

Chapter 1. Introducción

CHAPTER 2

Estructuras del sistema

5

Fundamentos de Sistemas Operativos, Release 1.0

6

Chapter 2. Estructuras del sistema

CHAPTER 3

Procesos

Recopilado por:

3.1 Gestión de Procesos

3.1.1 Conceptos Generales

Un “programa” se define como un compuesto secuencial de órdenes

que puede interpretar un mecanismo. Un “proceso” se define como

una agrupación de acciones aplicadas a una entidad para modificarla,

en nuestro caso lo analizaremos como un programa en ejecución que

sufre varias modificaciones.

El elemento esencial de un sistema operativo es el que se ocupa de

administrar los procesos, dado que pueden surgir diferentes escenarios como por ejemplo que distintos procesos deban iniciar el envío de

un correo electrónico a través de la misma aplicación de Outlook de

Microsoft

7

Fundamentos de Sistemas Operativos, Release 1.0

3.1.2 Elementos de un proceso

Durante la ejecución de un programa, un proceso constantemente

cambia los valores de los diferentes elementos involucrados, tanto así

que el sistema operativo almacena diferentes datos sobre un momento

dado en que se encuentra un proceso. El encargado de esta acción es

el bloque de control de proceso. En la imagen de memoria se encuentran el código y los datos de un proceso.

3.1.3 Clasificación de sistema operativos según

los procesos

Los sistemas operativos se pueden clasificar según el número de procesos y usuarios: - Monotarea ó Monoproceso: existe un sólo proceso

en un determinado momento. - Multitarea ó Multiproceso: existen

varios procesos en un determinado momento. - Monousuario: permite un sólo usuario a la vez. - Multiusuario ó Tiempo Compartido:

8

Chapter 3. Procesos

Fundamentos de Sistemas Operativos, Release 1.0

permite varios usuarios simultáneos ejecutando múltiples tareas.

3.1.4 Manipulación sobre un proceso

El sistema operativo nos permite manejar a los procesos por medio de

las siguientes esenciales operaciones:

• Crear un proceso: derivado de un proceso padre (ej. UNIX) o

de la acción de abrir un archivo ejecutable (ej. WINDOS).

• Ejecutar un proceso: existen dos maneras de ejecución. Batch

no está asociado a una estación y su entrada y salida de datos

son proporcionados por un archivo. La otra manera Interactiva

está asociado a una estación y su entrada depende un usuario y

salida es desplegada a éste.

• Terminar un proceso: un proceso puede finalizar por tres causas

posibles. Un programa ha llegado a su final; se generó un error

de ejecución; otro proceso o el usuario finalizó el proceso.

3.2 Analizando los Procesos

3.2.1 Dependencia entre los procesos

Ciertos sistemas operativos mantienen un orden de dependencia entre

procesos como lo es el caso de UNIX, donde se encuentran diferentes

rangos como Padre, Hijo, Hermano o Abuelo. Además es posible

reunir a varios procesos bajo un esquema de grupos y un entorno específico, para así poder realizar una manipulación más amplia sobre

varios de estos.

3.2.2 Sistemas multiproceso

Por ser este el sistema más complejo, ahondaremos en sus características principales, que son: paralelismo real entre procesador y fun-

3.2. Analizando los Procesos

9

Fundamentos de Sistemas Operativos, Release 1.0

ciones de entrada y salida; memoria principal apta para guardar varios

procesos; y la capacidad de cambiar entre las funciones de entrada y

salida y el procesamiento.

3.2.3 Procesos Nulos

El procesador nunca se detiene de realizar acciones. Pero realmente

tienen que existir momentos donde el procesador no realiza ningún

trabajo provechoso, de aquí que nacen los procesos nulos, que sirven

para distraer al procesador cuando no existe otro trabajo por realizar.

3.2.4 Ventajas de los sistemas multiproceso

Entre las ventajas de la utilización de estos sistemas, tenemos:

• Modularidad. Fracciona la ejecución de una aplicación en varios procesos y así favorece la programación.

• Brinda una útil asistencia de la manera más eficaz, interactiva y

concurrente a la necesidad de varios usuarios.

• Explota los períodos de tiempo de procesos nulos para terminar

la realización de peticiones de funciones de entrada y salida.

• Incrementa la utilización del CPU puesto que emplea el tiempo

muerto cuando los procesos están obstruidos.

3.2.5 Grado de multiprogramación

Se entiende por grado de multiprogramación a la cantidad de procesos vivos que ampara un sistema. Lo que se busca es que a mayor

grado de multiprogramación el sistema realize menos procesos nulos, pero esto conlleva a que el sistema posee mayores requerimientos

de memoria. Entonces a mayor cantidad de procesos, mayor será el

grado de multiprogramación.

10

Chapter 3. Procesos

Fundamentos de Sistemas Operativos, Release 1.0

3.3 Información de un proceso

Para estudiar un proceso detenidamente, dividiremos las partes de un

proceso en cuatro componentes principales.

3.3.1 Estado de un procesador

El estado de un procesador es conformado y almacenado por todos

los registros de su procesador y el BCP. Cuando un proceso se encuentra en ejecución, los registros son constantemente actualizados

con nuevos valores para no tener que recurrir a la memoria principal, debido a que la velocidad de respuesta es cuantiosamente más

lenta, pero el BCP no es actualizado. Es hasta que un proceso se ve

interrumpido debido a las tres causas posibles que delimitamos anteriormente, que entonces el sistema operativo estable con nuevos datos

al BCP, en este caso con los datos del estado del procesador actual.

3.3.2 Imagen de memoria del proceso

El sistema operativo delimita los campos de memoria que pueden conformar la imagen de memoria de un proceso. Entre las características

más distinguidas se encuentran las siguientes:

• La imagen de memoria es el lugar exclusivo para almacenar información del proceso, no puede se guardar en direcciones no

asignadas, por lo que eventualmente se debería de levantar una

excepción tras ser detectada por el hardware de protección. Y

finalmente el sistema operativo debería interrumpir dicho proceso.

• La imagen de memoria apunta a memoria virtual o memoria

física, según el computador.

• La imagen de memoria aumenta o disminuye según la asignación dinámica de memoria que requieren los procesos.

3.3. Información de un proceso

11

Fundamentos de Sistemas Operativos, Release 1.0

3.3.3 Información del BCP

En este elemento se encuentra la información elemental de un proceso, como lo son: la información de identificación del proceso y del

usuario; el estado del procesador con los valores originales o los valores en el momento en que fue interrumpido un proceso. Y finalmente

la información de control del proceso, que contiene el estado del proceso, prioridad del proceso, información de planificación, evento que

está interrumpiendo este proceso, archivos abiertos, puertos de comunicación asignados, punteros sobre otros procesos y descripción de la

sección de memoria concedida a un proceso

3.3.4 Tablas del sistema operativo

Es imperativo mantener tablas con información que detalla recursos

del sistemas y a los procesos, pero solo cierta información se introduce en el BCP según la exigencia de compartir la información y la

eficiencia.

Por eficiencia, la tabla de procesos es conformada como un esqueleto

estático para que todos los BCPs contengan el mismo tamaño. Y por

otro lado, cuando una información se debe compartir entre distintos

procesos, lo mejor es no incluirla en el BCP, por lo que solamente se

almacenarán punteros hacia esa información.

3.3.5 Formación de un proceso

Para inicializar un proceso se debe rellenar toda la información que

comprende un proceso, para esto el sistema operativo realiza las siguientes operaciones:

• Fijar un espacio de memoria virtual conformado por una serie

de secciones, para alojar la imagen de memoria.

• Escoger un BCP disponible de la tabla de la procesos.

• Completar el BCP con toda la información requerida antes

mencionada como la información de identificación de proceso,

12

Chapter 3. Procesos

Fundamentos de Sistemas Operativos, Release 1.0

con los detalles de la memoria concedida, con los valores originales de los registros, etc.

• Introducir las rutinas de sistema y el código en el segmento de

texto

• Introducir los datos preliminares del fichero objeto en el segmento de datos

• Designar la nueva pila a ser utilizada por el proceso con los valores del entorno y los parámetros requeridos por el programa.

• Finalmente, el estado del este proceso pasa a ser preparado

para ejecutar.

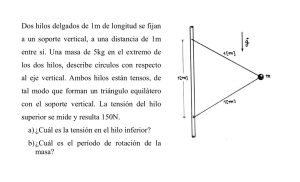

3.4 Estados de un proceso

Los procesos vivos de un sistema multiproceso se pueden encontrar

en cinco fases distintas, de las cuales, las tres siguientes tres primeros

3.4. Estados de un proceso

13

Fundamentos de Sistemas Operativos, Release 1.0

son las elementales.

3.4.1 Ejecución

En esta fase, el proceso se encuentra en una etapa de procesamiento,

está siendo realizado por el procesador. El estado del proceso habita

en los registros del procesador.

3.4.2 Bloqueado

En esta fase, el proceso se encuentra interrumpido, a la espera de

que suceda un evento por lo tanto no puede proseguir hasta que este

ocurra. Un ejemplo típico de esta fase es la espera a una petición de

la función de entrada y salida. El estado del proceso habita en el BCP.

14

Chapter 3. Procesos

Fundamentos de Sistemas Operativos, Release 1.0

3.4.3 Listo

En esta fase, el proceso se encuentra preparado para ejecutar su procesamiento. El sistema operativo es el encargado de indicar cuál proceso

es el siguiente a pasar a la fase de ejecución en caso de existir más de

un proceso en fase de listo. El estado del proceso habita en el BCP.

3.4.4 Suspendido

Existen otras dos fases, de un proceso. Fase de espera y fase de suspendido. Es muy usual que exista un repertorio de procesos en espera

para ser consumados a la mayor brevedad.

Para reducir el grado de multiprogramación el sistema operativo recurre a suspender ciertos procesos, esto con el fin primordial de liberar

la adecuada cantidad de memoria para los procesos que no se encuentran suspendidos. Mas es de reconocer que esta opción de suspender

procesos no se encuentra disponible en todos los sistemas operativos

como el caso de un sistema monoproceso.

3.4.5 Cambio de contexto

Se denomina cambio de contexto a la acción de, primero, guardar

el estado de un proceso en su debido BCP y, segundo, a proceder a

realizar la rutina que procesa una interrupción del sistema operativo.

Estas dos acciones pueden posiblemente incurrir en cambiar valores

del estado de otros procesos.

3.5 Procesos Ligeros

3.5.1 Conceptos Generales

Se entiende por un proceso ligero a un programa que se encuentra

en una corriente de ejecución y que comparte cierta información y su

3.5. Procesos Ligeros

15

Fundamentos de Sistemas Operativos, Release 1.0

imagen de memoria junto a otros procesos ligeros. Un proceso puede

contener una única corriente de ejecución normal o varias corrientes

de ejecución ligeras que ocurren en paralelo simultáneamente.

Un proceso ligero contiene elementos propios a si mismo como lo son

los siguientes principales: el contador de programa, registros, estado

del proceso y pila. Mas, estos procesos ligeros comparten cierta información en común dado que proviene de un proceso principal. Entre ellos se encuentran: temporizadores, archivos abiertos, variables

globales, espacio de memoria asignada.

3.5.2 Estados de un proceso ligero

Un proceso ligero también puede encontrarse en los tres estados típicos de en ejecución, preparado y bloqueado. Con la única diferencia

de que el estado general del proceso en si, depende de la composición

de todos sus estados ligeros, al aplicar la función lógica de AND u OR

dependiendo de la fase en que se encuentre.

16

Chapter 3. Procesos

Fundamentos de Sistemas Operativos, Release 1.0

3.5.3 Paralelismo

Los procesos ligeros permiten cierto grado de paralelismo al habilitar

que todos ellos se ejecuten de forma simultánea.

3.5.4 Diseño con procesos ligeros

La utilización de procesos ligeros proporciona ciertas ventajas como

lo son: la división de tareas y así asignar cada tarea a un proceso

ligero único; permite la modularidad al separar una operaciones en

suboperaciones e incrementa la velocidad de realización de una tarea

en general.

3.5. Procesos Ligeros

17

Fundamentos de Sistemas Operativos, Release 1.0

3.6 Procesos e Hilos

Uno de los principales conceptos relacionados al sistema operativos

son los procesos. No obstante, este está muy relacionado con otro

el cual se conoce como hilo, de ahí la importancia de distinguir la

funcionalidad dentro del sistema operativo de cada uno. Los procesos

en general se pueden definir como programas en ejecución, los cuales

se caracterizan por poseer los siguientes dos puntos mencionados a

continuación:

• Propiedad de recursos: los procesos están compuestos de espacio de direcciones virtuales para manejar la imagen de estos,

la cual hace referencia al conjunto de programa, datos, pila y

atributos que se han definido en el bloque de control de proceso, de tal forma que se le pueden asignar control o propiedad

de recursos como memoria principal, canales de entrada y salida , dispositivos de entrada y salida y archivos. Dado que existe

la posibilidad de interferencias entre los recursos y los procesos el sistema operativos es asignado a proteger y evitar dicho

inconveniente.

• Planificación y ejecución: por medio de una o más programas

es que se lleva a cabo la ejecución de un proceso que sigue

una determinada ruta. En cuanto a lo anterior cabe mencionar

que se puede llevar a cabo la intercalación de varios procesos,

de manera tal que el proceso posee un estado de ejecución y

una prioridad de activación que es planificada y activada por el

sistema operativo.

Dadas las características mencionadas anteriormente, es como se conforma en esencia un proceso en los sistemas operativos tradicionales,

no obstante en los sistemas operativos modernos tales características

son vistas y tratadas independiente. Tal es el punto que para distinguir entre una y otra características se le denomina hilo o proceso

ligero(“thread”) a la unidad que se activa, y proceso o tarea a la unidad

de propiedad de recursos. Por tanto, se pueden definir los hilos como

la unidad básica de utilización del CPU, el cual contiene su propio

“program counter”, conjunto de registros, espacio para el stack y pri-

18

Chapter 3. Procesos

Fundamentos de Sistemas Operativos, Release 1.0

oridad, compartiendo el código, los datos y los recursos con los hilos

pares.

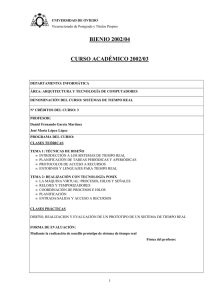

3.7 Multihilos

Además de lo mencionado previamente, el sistema operativo se encarga de brindar soporte a múltiples hilos de ejecución en un solo

proceso, modelo al cual se le denomina multihilos, contrario al enfoque tradicional conocido como monohilo, en el cual existe un solo

hilo por proceso.

Por un lado, el modelo monohilo está compuesto por un bloque de

control de proceso, espacio de direcciones de usuario, pilas de usuario

y un núcleo para administrar las diversas llamadas o retornos en la

ejecución de los procesos, y por otro lado el modelo multihilo está

compuesto de igual forma de un bloque de control de proceso y un

espacio de direcciones de usuario asociados al proceso, pero diferenciándose del modelo monohilo en que posee pilas separadas para cada

hilo y un bloque de control para cada hilo manteniendo datos como

los valores de los registros, la prioridad y el estado de los mismos. Es

decir, todos los hilos de un proceso comparten el estado y los recursos de este, residiendo en el mismo espacio de direcciones y teniendo

acceso a los mismos datos.

3.7.1 Beneficios

Algunos de los beneficios de implementar y utilizar hilos en los sistemas operativos son los siguientes:

• El tiempo invertido en crear un hilo en un proceso existente

es mucho menor que el utilizado para crear un proceso nuevo.

Según estudios realizados por los creadores de Mach crear un

hilo es dies veces más rápido que crear un proceso en UNIX.

• Finalizar un proceso es más rápido que finalizar un proceso.

3.7. Multihilos

19

Fundamentos de Sistemas Operativos, Release 1.0

• Cambiar entre dos hilos dentro del mismo proceso utiliza

menos tiempo.

• La eficiencia de la comunicación entre diferentes programas en

ejecución se ven mejorados, ya que la comuncación entre procesos requiere del núcleo para que este gestione la protección

y la comunicación adecuada, mientras que en este enfoque el

núcleo no es necesario invocarlo debido a que los hilos están

dentro del mismo proceso compartiendo recursos.

La siguiente imagen muestra las diferencias en la composición de un

modelo monohilo, contrario al modelo multihilo:

20

Chapter 3. Procesos

Fundamentos de Sistemas Operativos, Release 1.0

3.8 Hilos de Nivel de Usuario y de Nivel

de Núcleo

Una vez definidos y mostrados conceptos esenciales con respecto a

los procesos e hilos en los sistemas operativos, se presenta la distinción de hilos nivel kernel en comparación con los hilos nivel

de usuario, para un mayor entendimiento posteriormente en la presentación de los modelos multihilos.

3.8.1 Hilos Nivel de Usuario

En este tipo de entorno(ULT) la aplicación se encarga de todo el trabajo de los hilos, de manera tal que el núcleo no tiene conocimiento

de la existencia de los mismos. La biblioteca de subprocesos contiene el código necesario para la creación y destrucción de hilos, la

comunicación entre estos por medio del paso de mensajes y datos, la

planificación de la ejecución de los mismos, y el almacenamiento y

restauración del contexto del hilo programado. Por defecto, una aplicación inicia con un solo hilo, de tal manera que se ejecuta en este.

Toda la actividad que se lleva a cabo tendrá efecto en el espacio de

usuario y dentro de un solo proceso, de manera tal que el núcleo planifica el proceso como una unidad, asignándole un único estado al no

estar consciente de esto.

3.8.2 Hilos Nivel de Núcleo

En este ambiente (KLT) el núcleo administra todo el trabajo concerniente a los hilos, de forma tal que la aplicación no posee código

para gestionar los hilos, solamente existe una interfaz de programación de aplicación conocida como API , para acceder a las diferentes funcionalidades de los hilos del núcleo. Cualquier aplicación

puede implementarse haciendo uso de los multihilos. Todos los hilos

de una aplicación se alojan en un único proceso, de forma tal que se

mantiene información del contexto del mismo y de los hilos individuales de este, llevándose a cabo la planificación a nivel de hilo.

3.8. Hilos de Nivel de Usuario y de Nivel de Núcleo

21

Fundamentos de Sistemas Operativos, Release 1.0

3.8.3 Hilos a Nivel de Usuario vrs a Nivel de Núcleo

Algunas ventajas presentes al utilizar hilos a nivel de usuario en lugar

de hilos a nivel de núcleo son las siguientes:

• No se requiere de privilegios de modo núcleo para cambiar hilos, debido a que toda la estructura de datos de administración

de hilos están en el espacio de direcciones de usuario de un solo

proceso, es decir el proceso no se cambia a modo núcleo para

administrar los hilos, ahorrando sobrecargas con esto.

• Las aplicaciones pueden encargarsen de establecer la planificación, de acuerdo a la necesidades que posean.

• Pueden ejecutarse en cualquier sistema operativo.

3.8.4 Desventajas del Nivel de Usuario en comparación al Nivel de Núcleo

Las siguientes son algunas de las desventajas presentes al usar el nivel

de usuario en lugar del nivel de núcleo:

• Las llamadas al sistema son bloqueantes en muchos sistemas

operativos tradicionales, de forma tal que si un hilo se bloquea,

se bloquean también todos los hilos del proceso.

• En un enfoque de nivel de usuario, una aplicación multihilo no

puede aprovechar la ventaja del multiprocesamiento.

3.9 Modelos Multihilos

Los siguientes modelos hacen referencia a las diferentes formas en

que se pueden presentar la implementación de los hilos:

22

Chapter 3. Procesos

Fundamentos de Sistemas Operativos, Release 1.0

3.9.1 Modelo de uno a uno

En este tipo de modelo se asigna un hilo de usuario a un hilo de núcleo. Es decir, cada hilo de ejecución es un único proceso con su propio espacio de direccionesy recursos. Mediante este modelo la concurrencia es mayor, ya que si un hilo realiza una llamada bloqueante

los demás hilos siguen ejecutándose. De esta forma se permite la ejecución de múltiples hilos en paralelo sobre varios procesadores. La

desventaja del uso de este modelo radica en que la creación de cada

hilo de usuario necesita la correspondiente creación de un hilo de núcleo. La implementación de este modelo se ve limitado en el número

de hilos soportados en el sistema, debido a la carga que puede significar la creación de estos en la eficiencia del mismo. Algunos ejemplos de sistemas operativos que implementan este tipo de modelo son

las implementaciones UNIX tradicionales, así como Windows (desde

Windows95/98 hasta Windows 2000/XP).

3.9. Modelos Multihilos

23

Fundamentos de Sistemas Operativos, Release 1.0

3.9.2 Modelo de Muchos a Uno

Este enfoque de modelo asigna múltiples hilos de nivel de usuario a

un hilo de nivel de núcleo. La administración concerniente de los hilos se lleva a cabo mediante la biblioteca de hilos en el espacio de

usuario. El espacio de direcciones, así como la pertenencia dinámica

de recursos es definida por un proceso, de modo tal que se pueden

crear y ejecutar varios hilos en este. No obstante, solo un hilo a la

vez puede acceder al núcleo, de forma tal que no se pueden ejecutar paralelamente varios hilos. El proceso completo se bloquea si un

hilo que pertenece a este realiza una llamada bloqueante al sistema.

Algunos de los sistemas operativos que hacen uso de este tipo de en

modelo son Windows NT, OS/390, Solaris, Linux, OS/2 y MACH.

3.9.3 Modelo de Uno a Muchos

La migración de un entorno de proceso a otro se lleva a cabo mediante este tipo de modelo, permitiendo con ello a los hilos moverse

24

Chapter 3. Procesos

Fundamentos de Sistemas Operativos, Release 1.0

fácilmente entre los diferentes sistemas. Este tipo de entorno es de

interés en los sistemas operativos distribuidos por la visualización de

hilo como una entidad que puede movilizarse entre diferentes espacios de direcciones. Desde el punto de vista de usuario el hilo es una

unidad de actividad y el proceso es un espacio de direcciones virtuales

con el bloque de control de proceso asociado debidamente. Los hilos

pueden movilizarse de un espacio de direcciones a otro, incluso de un

computador a otro, para ello debe mantener consigo información tal

como el control de terminal, parámetros globales y las guías de planificación. Algunos de los sistemas operativos que utilizan este tipo de

modelo son Ra (Clouds), Emerald.

3.9.4 Modelo de Muchos a Muchos

Combinación de los modelos de Muchos a Uno y Uno a Muchos. Con

este enfoque se multiplexan varios hilos de nivel de usuario de sobre

un número de hilos, el cual es menor o igual a la cantidad de hilos

de kernel. La cantidad de hilos de núcleo puede ser específica de un

3.9. Modelos Multihilos

25

Fundamentos de Sistemas Operativos, Release 1.0

equipo o aplicación determinada. Este modelo permite la creación

de hilos, siendo la cantidad de esta ilimitada ya que va de acuerdo a

las necesidades existentes. Si se produce una llamada bloqueante al

sistema por parte de un hilo, el núcleo puede planificar otro hilo para

su ejecución. Con esto es posible ejecutar una actividad de un usuario

o aplicación en múltiples dominios. Un ejemplo de sistema operativo

que utiliza este enfoque es TRIX.

3.10 Hilos

Los hilos en computación, son los que permiten que un programa realize acciones secuenciales. Los programas que solo poseen un hilo

de ejecución son programas secuenciales, ya que las acciones que realizan se ejecutan de manera secuencial, una detrás de otra. El “The

Open Journal Proyect” define los hilos como: ”...un único flujo secuencial de control dentro de un programa.”, que hace una referencial

26

Chapter 3. Procesos

Fundamentos de Sistemas Operativos, Release 1.0

secuencialidad de los flujos de datos, que estos posee un principio,

una ejecución y un final, todos ejecutados de manera secuencial.

Durante la ejecución de un programa pequeño, la apreciación de los

hilos es mínima ya que un programa que ejecute un “Hola Mundo!”,

no necesita mas que un hilo de ejecución, pero el mismo programa

puede imprimir mas de una vez un “Hola Mundo!”, utilizando dos

o mas hilos de ejecución, de esta manera se pueden crear diversas

impresiones del “Hola Mundo!” realizadas por diferentes hilos de

ejecución. No solo en programas sencillos como un “Hola Mundo!”,

se ve los hilos. Un ejemplo común son los navegadores web, en un

navegador se pueden tener multiples pestañas abiertas, una con un

video musical en Youtube, otra con la pagina de la red social, y otras

tres con la investigación de la tarea. Este es un claro ejemplo de como

los hilos muestran las posibilidades de sus usos.

La implementación de los hilos se observa de manera diferente según

el ambiente, mas adelante se profundizara en cada uno de ellos, el

ambiente windows utiliza su API Win32 con la funciones para la

3.10. Hilos

27

Fundamentos de Sistemas Operativos, Release 1.0

creación, manipulación y ejecución de hilos; por otro lado UNIX

tiene el POSIX del acrónimo de Portable Operating System Interface, donde la X es de UNIX, donde de igual manera tiene sus funciones predefinidas para los los hilos. Java utiliza la clase Thread que

forma parte de su maquina virtual donde se define la especificación

del manejo de los hilos, esta en particular suele ser la mas utilizada

para la enseñanza de los hilos.

3.11 POSIX

Posix es una librería con la definición de las funciones del manejo

de los hilos para UNIX, como se vio anteriormente POSIX significa

Portable Operating System Interface, donde la X es de UNIX. La librería POSIX contiene los estándares de manejo de hilos, esta API esta

para C/C++, la “Carnegie MellonUniversity” dice: “Es más eficaz

en sistemas de varios procesadores o varios núcleos donde el flujo de

proceso puede ser programado para funcionar en otro procesador así

28

Chapter 3. Procesos

Fundamentos de Sistemas Operativos, Release 1.0

ganando velocidad a través de procesamiento distribuido o paralelo”.

Es claro que los hilos de ejecución que aprovechen la velocidad de

procesamiento de los diferentes núcleo de los procesadores aumente

de manera considera el rendimiento del program, un puede ser una

operación aritmética, donde cada parte de la operación se resuelva

con hilo de ejecución, y cada hilo asignado a un núcleo de procesamiento , claramente puede lograr un mayor rendimiento, aunque el

proceso de programación ser un poco tedioso los resultados pueden

ser sorprendentes.

Una de las ventajas de la programación en multiprocesadores según la

CMU(Carnegie MellonUniversity), es la latencia o la espera, esta se

de cuando un hilo se tiene que ejecutar mientras otro hilo se ejecuta

y este espera una entrada o salida, la latencia no solo se da a nivel

de hilos si también a nivel de entrada y salida. Este tipo de espera es

común en los procesadores de un solo núcleo, de ahi una gran diferencia con los procesadores multinúcleo ya que la entrada o salida puede

venir de otro núcleo del procesadores reduciendo la latencia a 0.

3.11. POSIX

29

Fundamentos de Sistemas Operativos, Release 1.0

En la librería de POSIX encontramos diferentes funciones esta son

una mencionadas por Carnegie MellonUniversity:, cabe rescatar que

la librería tiene muchas funciones y se recomienda revisar la documentación de la API de POSIX, estos son solo algunos ejemplos:

• pthread_create: Esta es la función para la creación de los hilos

(Pthreads).

• pthread_detach: Cambia el estado de un hila a detached (separado).

• pthread_equal: Comparar los identificadores de 2 hilos.

• pthread_exit: Termina la llamada a un hilo.

• pthread_getspecific: Gestiona los datos de un hilo en especifico.

• pthread_join: Espera la terminación de otro hilo.

• pthread_key_create: Gestiona los datos de un hilo en especifico.

30

Chapter 3. Procesos

Fundamentos de Sistemas Operativos, Release 1.0

• pthread_kill_other_threads_np: Termina todos los hilos en ejecución excepto la llamada al hilo,

• pthread_kill [ pthread_sigmask ]: Maneja las señales a los hilos.

3.12 Hilos Java

Los hilos de ejecución en java provienen de la clase Thread, para la

creación de los hilos en java es necesario crear un nuevo objeto de tipo

Thread. La clase Thread viene en la librería de la Maquina Virtual de

Java (JVM). Cuando se crean hilos en java estos pueden tener un alto

o bajo nivel de prioridad, los hilos de alta prioridad se ejecutan con

preferencia sobre los de baja prioridad. La prioridad de los hilos es

definida cuando se crean, y esta es heredada de su hilo creador, y es

un hilo daemon si y sólo si el hilo creador es un daemon. Los hilos

tipo daemon o hilos de utilidad son hilos que proveen servicios a otros

hilos. La vida de los hilos tipo daemon dependen de la de los hilos de

usuarios, cuando mueren todos los hilos de usuarios los hilos daemon

tambien mueren, esta es la definición de segun JavaTpoint.

Al inicio de la maquina virtual de java, se crea un único hilo nodaemon, que típicamente llama el método main de alguna clase. La

máquina virtual de java solo detiene los hilos de ejecución cuando

ocurre alguna de las siguientes acciones:

• Cuando el método exit es llama de la clase Runtime y el manejador de seguridad permite que la operación exit pueda ser ejecutada.

• Cuando todos los hilos de tipo no-daemon mueren, por una devolución de la llama del método de ejecución o por el lanzamiento de un excepción que vaya mas allá del método de ejecución.

De igual forma existen 2 métodos para la creación de hilos en Java:

• Declarando una clase como subclase de la clase Thread. Esta

subclase debe anular el método run de la clase Thread. Se ubica

3.12. Hilos Java

31

Fundamentos de Sistemas Operativos, Release 1.0

una instancia de la subclase para iniciar un hilo.

• La otra forma es declarando una clase que implemente la interfaz Runnable. Posteriormente dicha clase implementará el

método run. Se instanciará la clase asignando los argumentos

cuando se cree el hilo y se indica.

La pagina de Oracle nos proporciona un ejemplo de la creación de

hilos, con una clase PrimeThread que hereda de la clase Thread:

class PrimeThread extends Thread {

long minPrime;

PrimeThread(long minPrime) {

this.minPrime = minPrime;

}

public void run() {

// compute primes larger than minPrime

. . .

}

}

Posteriormente para crear el hilo se crea la instancias a PrimeThread:

PrimeThread p = new PrimeThread(143);

p.start();

3.13 Hilos Windows

Los hilos de Windows utilizan la API Win32, esta API de Windows

utiliza la función de CreateThread para la creación de hilos, esta

función recibe una serie de parámetro como atributos de seguridad,

tamaño, rutina de inicio, entre otros. Una vez creado el hilo la función

devolverá el manejador del nuevo hilo, en caso de error la devolución

de la función CreateThread seria NULL.

The Computer Science Department at RPI nos facilita una pequeña

guía para la creacion de hilos en Windows.

32

Chapter 3. Procesos

Fundamentos de Sistemas Operativos, Release 1.0

HANDLE CreateThread(

LPSECURITY_ATTRIBUTES lpThreadAttributes,// este puntero señala l

DWORD dwStackSize,// Tamaño inicial del tamaño de la pila del h

LPTHREAD_START_ROUTINE lpStartAddress,// puntero a la funcion d

LPVOID lpParameter,// Argumentos del nuevo hilo

DWORD dwCreationFlags, // Creacion de banderas

LPDWORD lpThreadId // Puntero que recive el ID del hilo

);

Entre las limitaciones presentes en los hilos de Windows, esta la cantidad de hilo que puede crear un proceso, ya que estos estarán limitados por la cantidad de memoria virtual que se encuentre disponible.

La cantidad pre-establecida es de un megabyte de espacio en la pila.

Los que nos muestra que la cantidad maxima de hilos son 2048 por

defecto,esta cantidad puede aumentar, si se reduce la cantidad de espacio de pila para cada hilo. Una recomendación para el buen funcionamiento de una aplicación es crear un hilo de ejecución por proceso y también crear una cola de solicitudes, de esta manera se puede

mantener el contexto de la información.

La de controlador de un hilo se puede arreglar con el derecho de

THREADALL_ACCESS_, este llama un descriptor de seguridad este

se crear para el nuevo hilo, utilizando un token primario para le proceso. Cuando se llama el OpenThreat el token evalúa los derechos,

para darle o no permiso de acceso al hilos de ejecución.

Para terminar los hilos en windows se utiliza la función ExitThread,

esta función utiliza el parámetro de lpStartAddress que se define al

crear el hilos, para solicitar este ato se utiliza la función GetExitCodeThread, la cual nos proporciona la DWORD, que se utilizar como

parámetro de ExitThread.

Cuando el hilos es terminado este cambia su estado a Señalado, el

cual avisa a los otros hilos en espera por el objeto.

3.13. Hilos Windows

33

Fundamentos de Sistemas Operativos, Release 1.0

3.14 POSIX vs Windows

La comparación entre ambos se da por el uso del mismo lenguaje de

programación C/C++, gracias a la utilización del mismo lenguaje se

puede apreciar los diferentes métodos de programación para resolver

problemas similares.. Intel nos proporciona algunas comparaciones

entre las dos librerías, en su pagina de internet. En general se aprecia

que el un mejor modelo en el API de Windows, pero se mostraran

diferentes características de comparación:

• Simplicidad de los tipos de datos: Los hilos de POSIX y

Windows discrepan muchos en sus tipo por un lado los hilos en POSIX permiten diversos tipos de datos pthread_t,

pthread_mutex_t, pthread_cond_t, entre otros; por otro lado,

los hilos de Windows tienen un único tipo de hilo HANDLE.

Uno los problemas que se pueden apreciar es la dificultad de

lectura para los usuarios nuevos en POSIX, esto se debe a que

cada tipo de hilo posee diferentes tipos de de parámetros, utilidades y funciones. Los hilos de Windows al ser todos de un

mismo tipo pueden provocar largos tiempo de espera, como

cuando algún objeto como una lista es compartida por 2 hilos

diferentes. en POSIX este caso no se de por la diferencia de los

tipos de hilos.

• Persistencia a Señales: Uno de lo problemas mas comunes en

el ambiente POSIX, es cuando un hilo señala un estado variable

y ningún otro hilo lo esta señalando, el problema recae en que

la señal se pierde si no hay ningún hilo en espera de la condición variable. La Win32 da a un hilo un estado, y este estado

se mantiene, y su estado no cambia hasta que algún otro hilo

lo mande. Esta situación se da gracias al hecho que Windows

establece que todo cambio de estado se debe realizar manualmente, para evitar estos tipos de conflictos.

34

Chapter 3. Procesos

Fundamentos de Sistemas Operativos, Release 1.0

3.15 Glosario

• Hilo: Subproceso, que ejecuta diversas acciones.

• Latencia: Tiempo de espera entre hilos.

• POSIX: Del ingles Operating System Interface uniX, interfaz

del sistema operativo UNIX.

• Pthread: Nominación a los hilos de la librería POSIX.

• API: Por sus siglas en inglés se define como Application Programming Interface, el cual hace referencia al conjunto de subrutinas, funciones y procedimientos (o métodos, en la programación orientada a objetos) que ofrece cierta biblioteca para ser

utilizado por otro software como una capa de abstracción.

• Dominio: Entidad estática, que consiste en un espacio de direcciones y puertos a través de los cuales se pueden enviar y

recibir mensajes.

• Hilo: Ruta de ejecución, con una pila de ejecución, estado del

procesador e información de planificación.

• KLT: Por sus siglas en inglés se define como Kernel-Level

Threads, el cual hace referencia a los hilos de nivel de núcleo .

• ULT: Por sus siglas en inglés se define como User-Level

Threads, el cual hace referencia a los hilos de nivel de usuario.

• BCP: bloque de control de proceso, guarda información sobre

el estado de los registros.

• Grado de multiprogramación: variable que mide la cantidad de

procesos activos.

• Imagen de memoria: contiene el código y los datos de un proceso.

• Proceso: programa en ejecución.

• Proceso Ligero: thread ó hilo.

• Proceso Nulo: bucle infinito sin ningún fin práctico.

3.15. Glosario

35

Fundamentos de Sistemas Operativos, Release 1.0

• Programa: órdenes que ejecuta una máquina.

3.16 Notas bibliográficas

• Perez, J. C. (2001). Sistemas operativos - una vision aplicada.

Mcgraw Hill.

• Silverschatz, A. (2006). Fundamentos de sistemas operativos.

McGraw Hill.

• López, M. (2012). Sistemas operativos. Andavira Editora.

• Tanenbaum, A. (2009). Sistemas operativos modernos. Prentice Hill.

• Burgess,M. (2001). A short introduction to operating systems

• WordReference.com. (2015). Abril 2015.

http://www.wordreference.com/sinonimos/

Sitio web:

• El gran libro del PC interno (2007). : Alfaomega Grupo Editor,

S.A.

• Modelos de multihebras (2015,

12 de Marzo).

Recuperado el 12 de Marzo del 2015,

de

http://wiki.inf.utfsm.cl/index.php?title=Modelos_de_multihebras

• Motivación y ventajas de las hebras (2015, 12 de

Marzo).

Recuperado el 12 de Marzo del 2015, de

http://wiki.inf.utfsm.cl/index.php?title=Motivacion_y_ventajas_de_las_hebras

• Operating System Multi-threading (2015,

12 de

Marzo).

Recuperado el 12 de Marzo del 2015, de

http://www.tutorialspoint.com/operating_system/os_multi_threading.htm

• Sistemas

Operativos

(2015,

12

de

Marzo).

Recuperado el 12 de Marzo del 2015,

de

http://www.wikiteka.com/apuntes/sistemas-operativos-36/

• Stall, W. (2005). Sistemas operativos Aspectos internos y principios de diseño (5a Edición ed.) Madrid: Pearson Educación.

36

Chapter 3. Procesos

Fundamentos de Sistemas Operativos, Release 1.0

• Tanenbaum, A. (1996). Sistemas Operativos Distribuidos (1a

Edición ed.) México: Prentice Hall.

• The Open Journal Project (s.

f.).

What Is a

Thread?

Recuperado el 23 de Abril del 2015, de

http://journals.ecs.soton.ac.uk/java/tutorial/java/threads/definition.html

• Ippolito, G. (s. f.). Linux Tutorial: POSIX Threads

Carnegie Mellon University School of Computer Science, 1.

Recuperado el 23 de Abril del 2015, de

http://www.cs.cmu.edu/afs/cs/academic/class/15492f07/www/pthreads.html

• Reliable Software (2006). Windows API Tutorial: Using Threads Recuperado el 23 de Abril del 2015, de

https://www.relisoft.com/win32/active.html

• JavaTpoint (s. f.). Daemon Thread in Java - javatpoint

JavaTpoint, 1. Recuperado el 23 de Abril del 2015, de

http://www.javatpoint.com/daemon-thread

• RPI Computer Science (s.

f.).

Win32 APIs for

Threads Recuperado el 23 de Abril del 2015, de

http://www.cs.rpi.edu/courses/netprog/WindowsThreads.html

• Windows (s. f.). CreateThread function (Windows) Recuperado el 23 de Abril del 2015, de https://msdn.microsoft.com/enus/library/windows/desktop/ms682453(v=vs.85).aspx

• Breshears, . (2006, 06 de Octubre). Why Windows Threads Are

Better Than POSIX Threads | Intel® Developer Zone Recuperado el 23 de Abril del 2015, de https://software.intel.com/enus/blogs/2006/10/19/why-windows-threads-are-better-thanposix-threads

• Butenhof, D. (1997, 26 de Mayo). Programming with POSIX

Threads.

3.16. Notas bibliográficas

37

Fundamentos de Sistemas Operativos, Release 1.0

38

Chapter 3. Procesos

CHAPTER 4

Administración de memoria

Recopilado por: Carolina Gonzalez Vargas, Rubén Mora Meneses y

Esteban Ramírez Quirós.

4.1 Fundamentos

La memoria o memoria principal puede ser considerada como una

matriz de bytes, cada uno con una dirección. El administrador de

memoria es parte del sistema operativo que regula el uso o liberación

de la memoria. Una instrucción es una orden que se le da a la computadora para que ejecute una operación. Un proceso es una secuencia

de instrucciones que forman parte de un programa en ejecución.

La memoria es un recurso necesario en todo sistema informático y

por eso debe ser gestionado con cuidado, esta operación la ejecuta

el administrador de memoria o Memory Manager. El administrador

de memoria está encargado de asignar la memoria que necesita un

proceso, así como liberarla cuando el proceso la haya desocupado.

También debe estar al pendiente de qué secciones de la memoria se

están utilizando y cuáles no, así como debe tener control sobre cuáles

procesos están utilizando la memoria.

Para poder administrar la memoria es necesario poder acceder a ella

39

Fundamentos de Sistemas Operativos, Release 1.0

ya sea para leerla, guardar datos o simplemente reservarla, los bytes

de la memoria pueden accederse por medio de direcciones, las cuales

pueden ser representadas de diferentes maneras. En un programa

fuente se utilizan direcciones simbólicas, que más adelante representan direcciones concretas en un programa ejecutable.

En una computadora la memoria principal es un recurso vital para

su funcionamiento ya que no solo los programas pueden modificarla,

sino que también los dispositivos de entrada y salida pueden tener

acceso a ella y modificarla. El procesador de la computadora es el

que debe regular los accesos a a memoria y la velocidad de este para

accederla y modificarla (ya sea para escribir o borrar datos) dependerá

de la eficiencia del computador.

4.1.1 Hardware básico

El direccionamiento de memoria se refiere a cualquier intento de acceder a la memoria ya sea para leerla, escribir en ella o borrar su

contenido, por medio de una dirección.

40

Chapter 4. Administración de memoria

Fundamentos de Sistemas Operativos, Release 1.0

Los registros del procesador son espacios pequeños de memoria en

el procesador que se utilizan, entre otras cosas, para que las instrucciones del procesador tomen de ahí los datos que necesitan para procesarlos.

Al desarrollar el hardware de una computadora, se debe definir la

forma en que se va a direccionar la memoria. El máximo direccionamiento que puede tolerar una computadora se define según la

cantidad de bits que posean las direcciones a generar, si se toma ése

número de bits como exponente de 2 se puede obtener el máximo direccionamiento posible, lo que quiere decir que aunque el computador

disponga de más memoria, será imposible accederla, por ejemplo, si

se tienen direcciones de 8 bits, solo se podrá acceder hasta 256 bits

de memoria. Cuando se define el hardware, también se especifica la

menor unidad de memoria direccionable, es decir se escoge una cantidad mínima de bits a direccionar, lo que implica que las siguientes

posiciones en memoria tendrán ese tamaño.

Por otra parte, la memoria principal y los registros del procesador son

las únicas secciones que pueden ser accesadas directamente, e incluso

muchas de las instrucciones de la máquina toman como parámetro el

contenido de los registros ya mencionados, pero no hay instrucciones

que acepten direcciones de la memoria en disco, lo que implica que

si se necesitan datos de la memoria en disco, deben copiarse en los

registros o en memoria principal para poder ser utilizados. Es decir

que, para poder ejecutar un proceso, es necesario asegurarse de que

este posea un espacio en memoria exclusivo para su uso y el rango

legal de direcciones de memoria disponibles, esto se hace por medio

del almacenamiento de un registro base y un registro límite. El registro base guarda la primera dirección en memoria que corresponde

a ese proceso, mientras que el registro límite muestra el rango máximo de memoria que necesita el proceso, por ejemplo, si el registro

base equivale a la posición 2000 en memoria y el registro límite tiene

un valor de 500, el proceso ocupa un espacio en memoria desde la

dirección 2000 hasta la 2500.

Es posible proteger el espacio en memoria para cada proceso, esto

se logra haciendo que el CPU compare las direcciones generadas en

modo usuario con el contenido de los registros a los que se desea

4.1. Fundamentos

41

Fundamentos de Sistemas Operativos, Release 1.0

acceder y en cualquier intento de acceder a direcciones que no le correspondan, generar un error fatal.

4.1.2 Reasignación de direcciones

La memoria usualmente aloja varios procesos al mismo tiempo y, de

hecho, se busca maximizar el uso del procesador teniendo una reserva

de procesos a ejecutar, esta lista se llama cola de procesos.

Como el programador no sabe cuáles otros procesos van a estar en

memoria al mismo tiempo que el proceso que desea ejecutar, es necesario mover el programa a otra área de memoria en caso de ser necesario, es decir, si se necesita el espacio de memoria que está utilizando

ese proceso, el sistema operativo debe ser capaz de mover el proceso,

ejecutar otro y volver a cargar el proceso anterior justo en la instrucción en que había quedado antes de que fuera interrumpido.

Habitualmente se selecciona uno de los procesos de la cola de procesos, este se carga en memoria y luego es ejecutado, cuando este

42

Chapter 4. Administración de memoria

Fundamentos de Sistemas Operativos, Release 1.0

termina, el espacio de memoria en el que fue cargado, se declara libre para ser utilizado por otro proceso. Para hacer esto, el editor de

montaje o cargador se encarga de asignar las nuevas direcciones del

proceso que se está cargando en memoria y una vez asignadas las

nuevas direcciones, poder ejecutar el proceso.

La reasignación de instrucciones y datos en memoria puede hacerse

en cualquiera de las siguientes etapas:

• Tiempo de compilación: solamente si se sabe con certeza en

dónde va a ser almacenado el programa cuando este sea compilado, se pueden generar direcciones absolutas ya que no va a

haber ningún inconveniente con el acceso a la memoria.

• Tiempo de carga: si no se sabe a dónde se alojará el proceso

cuando este sea compilado, las direcciones deben ser reubicables, de modo que la asignación de direcciones se retrasa hasta

cuando el proceso necesita ser cargado en memoria.

• Tiempo de ejecución:Si no hubiese problema con retrasar la

4.1. Fundamentos

43

Fundamentos de Sistemas Operativos, Release 1.0

reasignación de direcciones hasta el tiempo de ejecución, es

recomendable hacerlo, pero para esto se necesita de un hardware especial, sin embargo, la mayoría de sistemas operativos

de propósito general utilizan este método.

4.1.3 Espacios de direcciones lógico y físico

Una dirección lógica o dirección virtual es una dirección generada

por el CPU, mientras que una dirección física es una dirección de la

unidad de memoria. Las direcciones lógicas que son generadas por

un programa son llamadas, como conjunto, espacio de direcciones

lógicas, estas generan también el espacio de direcciones físicas, el

cual el conjunto de las direcciones físicas homólogas a las direcciones

lógicas.

Se tienen también la unidad de gestión de memoria (MMU o memorymanagement unit)la cual es una parte del hardware que hace la equivalencia entre las direcciones virtuales y físicas en tiempo de ejecución.

44

Chapter 4. Administración de memoria

Fundamentos de Sistemas Operativos, Release 1.0

También se cuenta con el registro de ubicación, el cual es un sinónimo

para el registro base, el cual suma todas las direcciones generadas por

un proceso de usuario cuando se está cargando el proceso en memoria.

La memoria de una computadora se organiza en por lo menos dos

niveles: principal y secundaria. La memoria principal proporciona un

acceso rápido a esta pero el costo es elevado, también es volátil, es

decir, su almacenamiento de información no es permanente. Por otra

parte, la memoria secundaria, se organiza de una manera similar a la

memoria principal sin embargo es lenta, barata y no volátil, lo que

permite almacenar información por mucho tiempo, ya sean programas, datos o ambos.

Si el sistema operativo puede administrar de forma correcta y efectiva

las memorias disponibles, es capaz de proveer las siguientes ventajas:

• Los módulos pueden compilarse y escribirse de forma independiente.

• Se puede dar varios grados de protección de datos.

• Los procesos podrían compartir módulos.

4.1.4 Carga dinámica

La carga dinámica consiste en cargar las rutinas hasta que sean invocadas, es decir, no se cargan hasta que se necesitan y todas las rutinas se mantienen en un disco en un formato reubicable y también se

aplaza el cálculo de direcciones. Cuando una rutina en un proceso

necesita convocar a otra, primero revisa si ya está cargada, de lo contrario la busca y la carga en memoria para su uso con el cargador de

memoria, esto implica la actualización de las tablas de direcciones del

programa para dar evidencia del cambio generado al cargar la rutina.

Esto proporciona como ventaja que si una rutina no se necesita en

tiempo de ejecución, nunca será cargada en memoria, por lo tanto

ahorrará memoria y resulta útil si se necesita disponer de mucho

código para administrar casos poco frecuentes.

4.1. Fundamentos

45

Fundamentos de Sistemas Operativos, Release 1.0

4.1.5 Montaje dinámico y bibliotecas compartidas

Para poder comprender el montaje dinámico es importante definir el

montaje estático y montaje binario.

El montaje estático se da cuando las bibliotecas del lenguaje utilizado

en el sistema son tomadas como un módulo y son integradas en el

programa. Por otra parte el montaje binario se da cuando se pospone

hasta el tiempo de ejecución el montaje del programa. Sin embargo el

montaje dinámico ocurre cuando en el fragmento de código se incluye

un stud, una pieza de código que indica cómo encontrar o agregar la

rutina deseada en la imagen binaria.

Es decir, el montaje dinámico retrasa el montaje de los módulos externos hasta que el módulo de carga haya terminado de crearse.

Algunos sistemas operativos no permiten el montaje dinámico, sino

que solamente el estático.

46

Chapter 4. Administración de memoria

Fundamentos de Sistemas Operativos, Release 1.0

4.2 Intercambio

Normalmente en los sistemas actuales, tener recursos ociosos o sin

utilizar, es considerado un desperdicio de ellos, esto incluye a la

memoria, los sistemas de la actualidad suele mantener ocupada un

gran porcentaje de ella, esto puede ocasionar situaciones donde no

haya suficiente memoria disponible para un proceso que requiere ser

ejecutado.

Una de las soluciones ante este problema es el intercambio de procesos, esto consiste en intercambiar temporalmente un proceso que

esta en memoria con uno que se encuentre en la cola de procesos,

guardando en un almacén de respaldo el proceso que se encuentra en

memoria, y volviéndolo a llevar luego a memoria para continuar su

ejecución.[1]

Para poder realizar esto, es necesario una cola de procesos, como se

mencionó anteriormente. Por ello, el sistema mantiene esta cola de

procesos donde se encuentran todos los procesos que estén listos para

4.2. Intercambio

47

Fundamentos de Sistemas Operativos, Release 1.0

ser ejecutados, tanto los que se encuentran en el almacén de respaldo

como los que se van a ejecutar por primera vez.[1]

Este proceso de intercambio tiene un costo de tiempo relativamente

alto, del cual la mayor parte del tiempo es tiempo de transferencia,

el cual es directamente proporcional a la cantidad de memoria intercambiada. Por ello la duración de este proceso de intercambio es

proporcional al tamaño del proceso a intercambiar.

Para esta operación sea realmente útil, el tiempo de ejecución del proceso que ingresa en memoria debe ser lo suficientemente grande en

relación con el costo del tiempo de intercambio, para que este pueda

realizar una cantidad de cálculos lo suficientemente grande entre una

operación de intercambio y la siguiente.

Normalmente cuando un proceso almacenado, vuelve a ser cargado,

este se volverá a cargar en el mismo espacio de memoria que ocupó

anteriormente. Esta restricción es impuesta por el método de reasignación de las direcciones. [1]

Pero este proceso de intercambio, no se puede realizar con cualquier

proceso que se encuentre en memoria, para poder realizar esto, los

procesos deben estar completamente inactivos. por ejemplo si el proceso no podrá ser intercambiado si se está accediendo a donde residen

los buffers de E/S en la memoria. ya que aunque el proceso parezca

inactivo, realmente no lo está.

Existen ciertas mejoras que se le pueden realizar a este mecanismo,

como la utilización de un doble buffer que permita cargar o descargar

un proceso mientras otro se encuentra en ejecución; o combinar la

técnica con el uso de registros base y límite, para mantener varios

procesos simultáneamente en memoria.

También este mecanismo se puede implementar en conjunto con algoritmos de planificación con prioridad. Esto consiste es que si llega

un proceso de mayor prioridad y este necesita ser ejecutado, el administrador de memoria puede intercambiarlo por un proceso inactivo de menor prioridad. Cuando el proceso de mayor prioridad haya

terminado, puede intercambiarse de nuevo por el proceso de menor

prioridad.[1]

48

Chapter 4. Administración de memoria

Fundamentos de Sistemas Operativos, Release 1.0

En la actualidad, aunque en muchas versiones de UNIX se utiliza una

variante de este sistema, el intercambio está normalmente desactivado, por ello en realidad estos mecanismos de intercambio se utilizan

en pocos sistemas, ya que en general requieren el costo en tiempo de

este mecanismo es muy alto y no logran proporcionar tiempos de ejecución suficientemente largos como para realizar una compensación

favorable y que haga de esto una solución razonable de gestión de

memoria.

4.3 Asignación de memoria contigua

Como todo proceso que necesite ser ejecutado estar albergado en

memoria, esta debe albergar tanto el sistema operativo como los diversos procesos que ejecute el usuario.

Normalmente ambos, el sistema operativo como el espacio del

usuario, no comparten el mismo espacio por eso usualmente la memoria esta dividida en 2 particiones, una para el sistema operativo y otra

para los procesos que desee ejecutar el usuario. [1]

4.4 Mapeo de memoria y protección

Como los sistemas no utilizan direcciones predefinidas como puede

ser direcciones físicas de memoria, sino que utilizan las direcciones

absolutas de un programa, las cuales son imposibles de calcular en

tiempo de compilación porque no se conoce la ubicación del programa, por lo que no se puede asegurar una protección a la memoria.

[2]

El registro de ubicación, o bien el registro base ilustra la posición inicial del programa, mientras que el registro límite guarda la cantidad

de memoria que necesita el programa, por lo que el registro límite no

corresponde a una dirección de memoria como tal, sino a un desplazamiento desde el registro de reubicación. [1]

4.3. Asignación de memoria contigua

49

Fundamentos de Sistemas Operativos, Release 1.0

Una dirección lógica señala una posición en memoria que no depende

de la asignación de memoria que se le ha dado al proceso. Toda dirección lógica tiene que ser menor que el valor que contiene el registro

límite, se convertirá la dirección lógica dinámicamente con la MMU,

esto se logra sumando el valor del registro base, esta nueva dirección

es la que se envía a memoria.

Una dirección relativa se representa como un desplazamiento desde

una posición en memoria conocida, usualmente es del inicio del programa, pero bien podría ser una dirección posterior. Las direcciones

relativas necesitan pasar por dos etapas en las cuales el procesador las

manipula. La primera agrega el valor del registro base a la dirección

relativa de modo que se obtiene una dirección absoluta para el programa. Seguidamente, la nueva dirección es comparada con el valor

del registro límite, si esta se encuentra dentro de los límites, se procesa

ejecutando la instrucción correspondiente, pero si no, se interrumpe

el sistema generando un error.[2]

Para asegurar la integridad, seguridad y protección del sistema las

50

Chapter 4. Administración de memoria

Fundamentos de Sistemas Operativos, Release 1.0

referencias a memoria que son hechas con un proceso deben ser validadas para estar seguros de que solamente referencian el espacio de

memoria que está reservado para el proceso.

Un proceso que es seleccionado por el planificador del CPU para ser

ejecutado, los valores correctos de los registros de límite y reubicación son cargados por el despachador como parte de un cambio de

contexto. Este mecanismo protege el sistema ya que las direcciones

generadas por el CPU se comparan con los registros con ello se asegura que no se accedan a regiones de memorias no correspondientes

al proceso.[1]

4.5 Asignación de memoria

Las estructuras de datos son necesarias para que el sistema operativo

sea capaz de administrar apropiadamente las particiones en memoria,

por ejemplo, una tabla de descripción de particiones en la que se registre cuáles procesos están alojados en cada partición, así como dónde

comienza y dónde termina. Los huecos en memoria que queden libres

serán usados para administrar el espacio disponible.[3]

Al dividir la memoria en particiones de tamaño fijo, se logra un

método simple para asignar la memoria. Cada sección solamente

puede contener un proceso porque la multiprogramación está limitada

por la cantidad de particiones que no alojan ningún proceso. Aparte

de esto, las particiones fijas también fuerzan al sistema a mantener

una tabla que indique qué partes de la memoria están libres para que

otros procesos la utilicen y cuáles están ocupadas.

Actualmente los sistemas operativos modernos no utilizan el esquema de particiones fijas, sin embargo, los sistemas operativos de

los grandes computadores de IBM, el OS/MFT, o bien Multiprogramación con un número fijo de tareas, es un buen ejemplo de un sistema operativo eficiente que utiliza este esquema. [2]

Las particiones múltiples funcionan cuando una partición está libre,

seguidamente se escoge un proceso de la cola de entrada y es cargado

4.5. Asignación de memoria

51

Fundamentos de Sistemas Operativos, Release 1.0

en esa partición. Al terminar el proceso, la sección queda disponible

para ser ocupada por otro proceso.

El hecho de distribuir la memoria disponible en particiones de

tamaños distintos de memoria, aumenta la flexibilidad de la repartición de memoria. Además de esto, la partición dinámica provee un

esquema por medio del cual el número y longitud de las particiones

son variables. Al traer un proceso a la memoria principal, este esquema ayuda a que se le asigne únicamente el espacio en memoria

que necesita, ni más, ni menos. [2]

La fragmentación externa se da cuando la memoria externa se fragmenta cada vez más. Cuando un proceso necesita memoria, se busca

un espacio tan grande como para poder alojarlo y si se encuentra, se

le asigna y se mantiene la demás memoria libre para las solicitudes de

los procesos que entrarán en el futuro. [1]

Con forme los procesos entran al sistema, también se ingresan a una

cola. Esta cola de entrada se ordena por el sistema operativo según el

algoritmo de planificación que este posea. Se le asigna memoria a los

procesos hasta que los requisitos del siguiente proceso ya no puedan

satisfacerse. El sistema operativo considera la memoria necesaria para

cada proceso y lo compara con la cantidad de memoria libre para ser

utilizada, de este modo se puede determinar a cuáles procesos se les

va a asignar memoria.

El agujero es un modo de llamar a toda la memoria disponible para los

procesos de usuario cuando esta se considera como un bloque único

que contiene toda la memoria libre para ser utilizada por los procesos

entrantes. En algún momento durante la ejecución de los procesos se

va a tener un conjunto de huecos de memoria de muchos tamaños distribuidos por toda la memoria y cuando llega un proceso nuevo para

ser ejecutado y este solicita memoria, el sistema operativo busca entre

todos esos espacios libres alguno que sea lo suficientemente grande

como para poder alojarlo. [1]

Si el agujero es muy grande, se divide en dos partes, una para el

proceso y la otra se agrega al conjunto de espacios de memoria

disponibles. Caso contrario ocurre si hay agujeros de memoria adyacentes, estos se fusionan para obtener un espacio en memoria más

52

Chapter 4. Administración de memoria

Fundamentos de Sistemas Operativos, Release 1.0

grande en lugar de dos pequeños.

El proceso, al terminar, libera la memoria que había utilizado para

poder ejecutarse y esta memoria se volverá a considerar como libre y

se agrega al conjunto de agujeros de memoria.[1]

La asignación dinámica de espacio busca satisfacer las solicitudes de

memoria según la lista de espacios disponibles.

El primer ajuste, se conoce como el método de asignar el primer agujero en memoria que se encuentre que sea lo suficientemente grande

como para alojar el proceso entrante, la exploración de memoria

puede hacerse desde el inicio de la memoria o bien donde terminó la

exploración anterior y la exploración se detiene en cuanto se encuentre un hueco de memoria con la cantidad de memoria igual o superior

al espacio requerido por el proceso. [1]

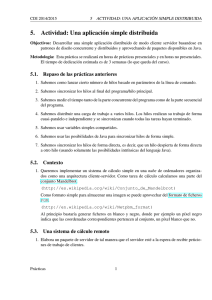

Como se puede observar en la imagen, el mejor ajuste es un método

de asignación de memoria en que se busca el bloque de memoria

disponible más pequeño pero que tenga espacio suficiente para el pro-

4.5. Asignación de memoria

53

Fundamentos de Sistemas Operativos, Release 1.0

ceso, pero este método puede generar un agujero de memoria más

pequeño que en los demás métodos. [1]

El peor ajuste asigna el agujero de memoria de mayor tamaño que

encuentre durante la exploración, esto genera un agujero de mayor

tamaño luego de haber asignado el proceso, lo que puede generar un

agujero muy útil. [1]

Los métodos del primer ajuste y mejor ajuste son mejores que el del

peor ajuste en matices como el tiempo necesario y utilización eficiente del espacio. Aunque es indefinido si la estrategia del primer

ajuste o mejor ajuste es mejor en cuestión de utilización del espacio

de almacenamiento, pero la del primer ajuste es más rápida. [1]

Existen otras políticas que generan menos fragmentación de memoria

y de hecho son muy utilizados en los sistemas operativos, por ejemplo

la política de los gemelos (buddies). [3]

En este sistema, el asignador nada más provee de bloques de memoria

de tamaños determinados y tiene muchas listas libres, una para cada

54

Chapter 4. Administración de memoria

Fundamentos de Sistemas Operativos, Release 1.0

tamaño que sea capaz de asignar. Los espacios habitualmente se calculan como potencias de dos o según la secuencia de Fibonacci. Si el

repartidor recibe una solicitud de memoria, el tamaño es redondeado

hasta que el tamaño solicitado lo permita y se le asigna el primer

bloque libre con este tamaño. [4]

El reciclaje de bloques implica hacer un intento por mezclar los bloques de memoria adyacentes en un bloque más grande, para simplificar el trabajo, las listas pueden almacenarse en orden de dirección.

Este enfoque provee una ventaja: la coalición es barata porque todo

bloque libre se calcula desde su dirección. [4]

El sistema buddy puede trabajar muy bien, pero también puede trabajar muy mal según sean los tamaños seleccionados para interactuar

con las solicitudes de memoria y según sea el patrón de los bloques.

Redondear implica una cantidad de memoria significativa que se desperdicia, a lo que se le llama fragmentación interna, la cual se puede

reducir haciendo que el tamaño de los bloques sea similar. [4]

4.5. Asignación de memoria

55

Fundamentos de Sistemas Operativos, Release 1.0

4.6 Segmentación

La segmentación se puede definir como una técnica en la cual las

tareas y procesos pueden acceder a ellas unitariamente para poder administrar mejor la memoria contigua, facilita la comprensión visual

del programador, es la estructura clave para las pilas, datos y código

para un programa.

Están conformados por un tamaño predefinido, un identificador y un

desplazamiento para acceder a los datos dentro de él, cada dirección

lógica se expresará mediante dos valores, el número de segmento (s)

y desplazamiento dentro del segmento (d), estas características se les

asigna en el proceso de compilación y para accederlos se debe tener

en cuenta que la memoria física se accede literalmente, cada dirección lógica (que proviene del procesador) habrá que convertirla en

una dirección real, que la memoria RAM podrá leer, este cambio lo

realiza un aparato de hardware alojado generalmente en las tarjetas

de memoria principal llamado unidad de gestión de memoria, ya que

posee algunos implementos como la tabla donde vienen numeradas

cada segmento. Además el procesador cuenta con otra tabla que describe:

• Base: Dirección en donde comienza el segmento (contando la

dirección)

• Límite: Dirección en donde finaliza (sin contar la dirección)

• Desplazamiento: Lo que hay que sumar a una dirección para

obtener su dirección real, se calcula como la dirección de

comienzo del segmento en la memoria real menos la dirección

virtual de inicio del segmento

• Atributos del segmento: como lectura/escritura para la seguridad de que otros procesos interfieran en “segmentos ajenos”.

Para seguridad del manejo de segmentos hay 2 “heaps”, uno para los

segmentos en sí y otro para administración de estructuras de datos,

como colas y pilas, en el primero como hay muchos segmentos a

través de la línea del tiempo de los procesos, segmentos son asignados

a una parte de la memoria y otros liberados, y esto fragmenta mucho

56

Chapter 4. Administración de memoria

Fundamentos de Sistemas Operativos, Release 1.0

la memoria produciendo desperdicio y múltiples pedazos de memoria

tan pequeños que no se pueden utilizar, afortunadamente hay métodos

y algoritmos para reducir el impacto de desperdicio que producen la

fragmentación:

• First-fit: consiste en recorrer la lista secuencialmente hasta hallar el primer fragmento donde quepa la memoria solicitada, el

trozo encontrado se parte en dos para entregar sólo lo que se

necesita