UPV-EHU-LSI-TR 02-2005 - Filtrado de un banco de items

Anuncio

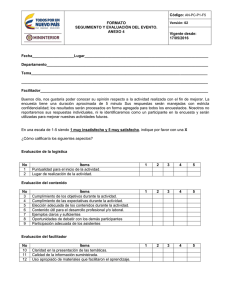

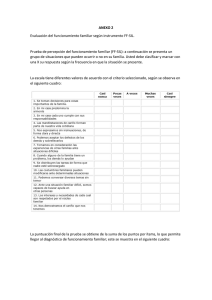

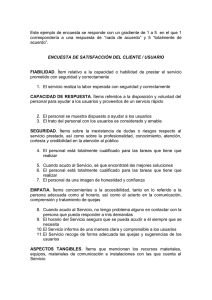

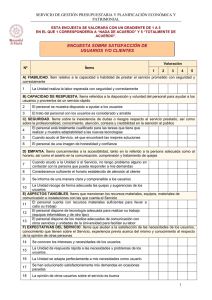

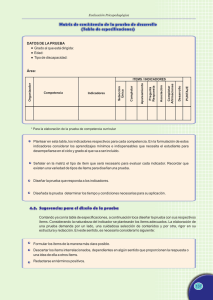

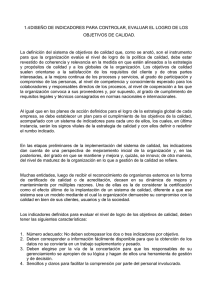

GRUPO DE HIPERMEDIA Y MULTIMEDIA, LSI, UPV/EHU F I LT R A D O D E U N BA N C O D E I T E M S ROSA ARRUABARRENA Arruabarrena, R. Filtrado De Un Banco De Ítems. San Sebastián, University Of The Basque Country. Technical Report. Upv/Ehu/Lsi/Tr 02-2005. P. 60 0 FILTRADO DE UN BANCO DE ITEMS INDICE INTRODUCCIÓN.................................................................................................................... 3 METODOLOGÍA DEL PROCESO DEL FILTRADO ........................................................ 3 EJECUCIÓN DE LA FASES .................................................................................................. 4 SUJETOS PARTICIPANTES ......................................................................................................... 4 DISEÑO Y PREPARACIÓN DEL MATERIAL EN CUESTIONARIOS .................................................. 5 Datos a recopilar sobre los ítems originales ..................................................................... 5 Estructura de los cuestionarios ......................................................................................... 6 CAPTACIÓN DE LOS SUJETOS PASIVOS ..................................................................................... 6 CRITERIOS DE HOMOGENIZACIÓN ........................................................................................... 6 CRITERIOS PARA LA CORRECCIÓN DE LOS ÍTEMS ..................................................................... 7 CONDUCCIÓN DE LA PRUEBA DE CAMPO ................................................................................. 7 ANÁLISIS DE LOS DATOS Y CONCLUSIONES ............................................................................. 9 AGRACEDIMIENTOS Y SUBVENCIONES ..................................................................... 14 REFERENCIAS ..................................................................................................................... 14 2 FILTRADO DE UN BANCO DE ITEMS ROSA ARRUABARRENA SANTOS I N T RO D U C C I Ó N El trabajo que a continuación se presenta está enmarcado en un proyecto de mayor envergadura [1], que consta de cinco procesos, y siendo éste un subproceso de la instanciación de uno de ellos. El objetivo global es determinar la validez de una calibración de ítems utilizando estimaciones de expertos frente a la calibración por medios estadísticos que propugna la TRI [2]. Durante la realización de la prueba de campo para calibrar un banco de ítems vía expertos, se detecta que el banco de ítems de partida contiene errores en algunos ítems. Debido a lo costoso que resulta efectuar un proceso de calibración, se hace necesario asegurar la corrección de los ítems de partida. Para conseguir este objetivo se define y ejecuta el proceso que describimos a continuación. El punto de partida de este proyecto es el banco de ítems que usa para determinar el nivel de conocimiento de euskara de alumnos de nuevo ingreso en un euskaltegi vizcaíno de considerable tamaño, Zornotzako Barnetegia. Son 252 ítem textuales con cuatro opciones de respuesta posibles. En el anexo 1 “Banco ítems original” están enumerados todos los ítems recogidos en la actualidad en una única base de datos. Como resultado de este subproceso se espera obtener el banco de ítems de partida filtrado y uniformizado manteniendo el espíritu inicial de los ítems (sin generar ítems totalmente nuevos) y a partir de las informaciones proporcionadas por los revisores expertos, es decir, todos los ítems deben ser correctos desde el punto de vista lingüístico cumpliendo las normas vigentes de la Academia de la Lengua Vasca, Euskaltzaindia, y deben estar almacenados con criterios homogéneos (con independencia del formato de presentación que posteriormente se les vaya a aplicar). En este informe a continuación se presenta la metodología del proceso del filtrado definida así como la ejecución de la misma hasta la consecución del banco de ítems de partida filtrado y uniformizado. M E TO D O L O G Í A D E L P RO C E S O D E L F I LT R A D O Como ya se ha comentado, para efectuar el filtrado se ha decidido recabar la información entrevistando revisores expertos [3][4] mediante encuestas [5][6] plasmadas en cuestionarios de papel. Esta herramienta aporta información altamente fiable, basada en su experiencia, y redunda en credibilidad de los resultados [7]. Este proceso se desarrollará en las siguientes fases: • Definición de los sujetos participantes en el proceso. Se trata de establecer los sujetos activos que se encargan de llevar el proceso adelante. Entre sus competencias está el poner en marcha las tareas descritas más adelante. Por otro lado, también se deben describir quiénes serán los sujetos pasivos, 3 aquellos con los que contactarán los sujetos activos para recabar información. • Diseño y preparación del material en cuestionarios. Como el volumen del banco es considerable (252 ítems), y puesto que la colaboración de los sujetos pasivos será voluntaria, se hace materialmente imposible que cada uno de ellos revise todos los ítems. Es por ello que seguramente habrá que fraccionar el banco en varios cuestionarios y decidir qué datos sobre los ítems hay que recoger a través de los cuestionarios. • Captación de participantes pasivos. Una vez conocido el perfil de los sujetos pasivos se plantea el método para localizar e involucrarlos. • Criterios de homogenización y criterios para la corrección de los ítems. Los primeros son criterios de estilo, a fin de que todos los ítems presenten un formato uniforme. Los segundos son los criterios por los se han de regir los sujetos activos para aceptar o no las aportaciones de uno, varios o todos los sujetos pasivos. • Conducción de las pruebas de campo. Se trata de distribuir los cuestionarios a sujetos pasivos y recopilarlos. • Análisis de los datos para generar el banco de ítems filtrado y uniformizado y conclusiones. A partir de las aportaciones de los sujetos pasivos y con criterios de establecidos por los sujetos activos, estos últimos filtrarán y homogeneizarán el banco de ítems original actualizándolo. E J E C U C I Ó N D E L A FA S E S A continuación se presenta el desarrollo de cada una de las fases descritas en la metodología de la prueba de campo. SUJETOS PARTICIPANTES En el proyecto están involucrados tanto sujetos activos como pasivos. Los sujetos activos del proceso son profesores de la Universidad del País Vasco, imparten clases en euskara estando acreditados para ello por la propia universidad y poseen el título de EGA. Concretamente son: • Rosa Arruabarrena Santos como coordinadora y ejecutora principal del proceso de filtrado y de la prueba de campo de calibración de los ítems mediante expertos. Entre sus competencias están: establecer los criterios para uniformizar el banco de ítems, establecer los criterios de actuación ante las valoraciones aportadas por los sujetos pasivos, planificar, conducir y ejecutar las pruebas de campo para obtener la información necesaria para efectuar el filtrado, cometer el peinado del banco con la ayuda puntual de Javier López Cuadrado y elaborar un informe para recoger las anomalías detectadas. 4 • Javier López Cuadrado, desarrollador principal del proceso de calibración estadística de los ítems [1]. Cooperará puntualmente con Rosa Arruabarrena en el análisis de los datos para generar el banco de ítems filtrado. El proyecto considera como sujetos pasivos a los revisores de los ítems del banco de ítems. La labor de los revisores consistirá en determinar si los ítems que se les muestran son o no correctos desde el punto de vista lingüístico, indicar cuál es el error que contienen y proponer una solución para corregir el mismo. DISEÑO Y PREPARACIÓN DEL MATERIAL EN CUESTIONARIOS Como el volumen del banco es considerable (252 ítems), y puesto que la colaboración del revisor es voluntaria, se hace materialmente imposible que cada uno de ellos revise todos los ítems. Ello hace que se divida en dos partes iguales el banco original. Seguidamente se detallan los datos que se recogerán mediante los cuestionarios así como la estructura concreta de los mismos. DATOS A RECOPILAR SOBRE LOS ÍTEMS ORIGINALES Por cada ítem se solicitará al revisor a lo sumo las siguientes tres informaciones: La valoración sobre la corrección o no del ítem desde el punto de vista lingüístico. Es decir, si la pregunta y sus opciones de respuesta están correctamente enunciadas cumpliendo las normas de Euskaltzaindia. En caso de que el ítem presente algún error, se le solicita la especificación numérica del tipo de error contenido en el ítem. Como propuesta de partida se proporcionará una lista enumerada de tipos de errores posibles, propuesta a ampliar si el error hallado no está incluido en la misma. Concretamente, se presenta la siguiente recopilación de descripciones de posibles errores: Código de error 0 1 2 3 4 5 6 7 8 9 10 11 12 Descripción del error Hueco de respuesta no homogéneo (9 caracteres “.”) La puntuación del final de la oración (enunciado) terminada en hueco de respuesta; ha de trasladarse a las opciones. Falta la puntuación al final de las opciones Falta la puntuación al final del enunciado El texto en castellano ha de ir entrecomillado No es un error propiamente, pero bien por mayor claridad bien por mejora del estilo, se redacta el ítem según propuesta. Ejemplo: EUROAK>EUROak, … El hueco de respuesta no se representa con subrayo. Trascripción errónea. Ejemplos: Atzso->Atzo; jaieta->jaietan,… La elipsis se representa por 3 caracteres “.” (para no confundirla con los huecos de las respuestas). Hay más de una opción como posible respuesta. El verbo ”Eutsi” requiere otra conjugación verbal gramaticalmente Tiene alguna opción de respuesta difícil de entender. Ítem ininteligible/incomprensible 5 Igualmente, en el caso de que el ítem sea erróneo se solicita al revisor una propuesta de corrección al mismo. ESTRUCTURA DE LOS CUESTIONARIOS A la hora de establecer la estructura de los cuestionarios, se recurre a la estructura y formato revisados de los cuestionarios del superproceso de calibración de un banco de ítems vía expertos [8], adaptándolo al subproceso de filtrado tal y como se describe a continuación. La estructura del cuestionario está formada por una introducción, por una recogida de datos personales, de detección de ítems erróneos y las aportaciones propias. La estructura y su formato se pueden observar en el anexo 2 “Cuestionarios para la detección de errores en el banco de ítems”, donde se encuentra un cuestionario proporcionado a los revisores del que se han eliminado la mayoría de los ítems del apartado detección de ítems erróneos, ya que éstos están disponibles en el anexo 1 “Banco de ítems original”. La introducción presenta el objetivo de trabajo y agradece la voluntaria participación en el mismo. A continuación, se presentan las instrucciones de cumplimentación del cuestionario. Contiene un listado, ampliable por el revisor, de posibles errores localizables en los ítems. La recogida de datos personales del participante pretender recoger datos estadísticos del sujeto que cumplimenta el cuestionario como su edad, sexo, titulación superior, titulación lingüística y experiencia laboral en el área. Estos datos sirven para agrupar los resultados y deducir resultados estadísticos. Posteriormente se presenta el apartado detección de ítems erróneos. Como se ha comentado antes, se trata un subconjunto del banco de ítems. Por cada uno de los ítems se le requiere comprobar su corrección lingüística. Y sólo en el caso de que sea incorrecto, además, se solicitan indique qué tipo (número) de error contiene y proponga alguna solución. Finalmente se solicitan aportaciones propias al participante. Se trata de una pregunta abierta para recoger comentarios y/o sugerencias. CAPTACIÓN DE LOS SUJETOS PASIVOS Se contacta directamente con los cinco revisores de las pruebas piloto del proceso de calibración del banco de ítems vía expertos. Para mayor información sobre los mismos se puede consultar el informe [8]. CRITERIOS DE HOMOGENIZACIÓN Los sujetos activos establecen los siguientes criterios de estilo para lograr un banco de ítems homogéneo que será el que se presente a los revisores. La guía de estilo es la siguiente: Los huecos de las respuestas tienen 9 caracteres “.” ortográfico. Cuando el hueco de la respuesta queda al final de la oración: Si la oración acaba en punto ortográfico, éste se recoge en al final de cada una de las opciones. Si tiene “!”, “?”, éste se recoge a final del propio enunciado a continuación del hueco de la respuesta. 6 Se utilizarán tres puntos ortográficos como sinónimo de etcétera o para denotar que parte de la oración se deja premeditadamente en elipsis, pudiendo aparecer ésta al inicio, fin o a mitad del enunciado. Las menciones en otros idiomas se recogen entrecomilladas. CRITERIOS PARA LA CORRECCIÓN DE LOS ÍTEMS Los sujetos activos definen el siguiente protocolo de actuación ante las aportaciones de los revisores sobre errores en cada uno de los ítems: Si no hay comentario alguno, el ítem es correcto. Si la aportación es sobre ortografía o violación de alguna regla de Euskaltzaindia, con independencia del número de revisores que comenten el error, se subsana. Si hubiera alguna duda, se comprueba la veracidad o bien del error o bien de la regla de corrección. Si se detecta un patrón de error (ej. la puntuación en las oraciones subordinadas), se subsana no sólo el ítem que lo contiene, sino que se revisa y actualiza todo el banco de ítems. Si un revisor afirma la existencia del error y aporta solución, se subsana. Si un revisor opina que pudiera existir un error y aporta solución, se comprueba en la bibliografía (reglas Euskaltzaindia, HABE, diccionarios actualizados,…), y se subsana, si procede. Si la duda no es aclarada, se consulta algún revisor más, hasta un total de cuatro revisores por ítem. Si un revisor de un ítem expresa sus dudas sobre la corrección de un ítem, es decir, no asegura que el ítem sea correcto, y los revisores posteriores no detectan ningún problema, se considera el ítem correcto. Si el ítem ha sido revisado por tres o cuatro revisores, y al menos dos opinan que hay dudas razonables sobre su corrección (normalmente, ítem ambiguo o con más de una respuesta posible) y han aportado una solución compatible o no contradictoria, se acepta; sino no. En aquellos casos en los que las propuestas de corrección son o bien contradictorias o no hay propuesta de corrección, no se modifica el ítem pero se registra el error. CONDUCCIÓN DE LA PRUEBA DE CAMPO Primeramente se revisan todos los ítems aplicando los criterios de estilo para uniformizar el banco de ítems. Más tarde, se elaboran dos cuestionarios distintos con 126 ítems distintos cada uno a partir del marco del cuestionario de la prueba piloto del proceso de calibración vía expertos. La conducción real de prueba se extiende entre noviembre de 2003 y enero de 2004. La prueba se realiza sobre cuatro revisores a fin de que cada ítem al menos sea comprobado por dos revisores distintos. Los revisores detectan 4 tipos de errores más, que se recogen en la siguiente tabla: 7 Código de error 13 14 15 16 Descripción del error Error ortográficos por nuevas decisiones de la academia de la lengua vasca, Euskaltzaindia Regla de Euskaltzaindia respecto puntuaciones en oraciones subordinadas (“, baina”≡ “…, mas …”, etc.) Ítem ambiguo. Mejorar el estilo o reescribir el enunciado para eliminar la ambigüedad Todas las opciones incorrectas A continuación se recogen los ítems erróneos organizados por tipo de error así como el número de veces que ha sucedido ese tipo de error en el banco: Tipo de error 0 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 Ítems que lo contienen Núm. repeticiones. 10, 17, 20, 27, 28, 29, 30, 32, 33, 34, 35, 42, 43, 47, 49, 51, 53, 54, 55, 56, 57, 58, 60, 61, 62, 64, 67, 68, 70, 71, 74, 76, 77, 79, 80, 81, 82, 84, 85, 86, 87, 88, 90, 91, 92, 94, 95, 101, 103, 106, 108, 110, 114, 115, 119, 120, 121, 125, 130, 131, 134, 136, 137, 138, 139, 140, 141, 142, 143, 144, 145, 146, 147, 148, 149, 150, 151, 152, 159, 162, 164, 165, 166, 167, 169, 172, 173, 174, 176, 177, 178, 179, 180, 181, 182, 183, 184, 185, 186, 187, 188, 189, 191, 192, 193, 194, 195, 196, 197, 198, 199, 200, 201, 202, 203, 204, 206, 207, 208, 210, 211, 212, 213, 214, 215, 216, 217, 218, 219, 220, 222, 223, 224, 225, 226, 227, 228, 230, 231, 232, 233, 234, 237, 238, 241, 244, 247, 248, 249 191, 195, 196, 197, 199, 201, 202, 207, 211, 212, 214, 219, 227, 247 87, 88, 91, 111, 121, 122, 147, 164, 165, 168, 216 184 89, 96 136, 185, 235, 240, 242, 245, 249 59 61, 112, 181 109 29, 63, 77, 102, 127, 129, 140, 141, 148, 151, 152, 155, 162, 165, 166, 170, 186, 191, 212, 225, 227, 229, 237, 242, 245, 251 165 240 217 27, 44, 50, 64, 73, 145, 173 36, 53, 56, 73, 89, 95, 96, 108, 109, 114, 119, 124, 125, 126, 140 18, 49, 53, 56, 108, 109, 113, 123, 132, 134, 135,146, 168, 171, 177, 178, 187, 190, 193, 195, 198, 221, 249, 252 202 149 14 11 1 2 7 1 3 1 26 1 1 1 7 15 24 1 265 Con la prueba de campo se han revisado 536 ítems repartidos en cuatro cuestionarios con 126 ítems cada uno y 32 ítems más como consecuencia de dos consultas extras a dos revisores más para aclarar algunas aportaciones o la falta de las 8 mismas en algunos ítems. La relación de ítems para los cuales se ha solicitado alguna valoración extra es la siguiente: Nº revisores extras 1 2 Ítems consultados 56, 59, 61, 77 121, 123, 153, 157, 166, 170, 191, 202, 217, 227, 229, 237, 242, 245 Nº ítems consultados 4 14 Se entiende que los ítems 56, 59,… los han sido estudiados por 3 revisores finalmente para aclarar dudas planteadas sobre los mismos y que los ítem 121, 123,... han necesitado de 4 revisores. En resumen, se han detectado 265 errores individuales distribuidos en 184 ítems. ANÁLISIS DE LOS DATOS Y CONCLUSIONES Durante esta prueba se detectan 17 tipos de error de distinto calado. Los errores detectados inicialmente por los participantes son básicamente errores de tipo ortográfico, de estilo y nuevas reglas Euskaltzaindia aún no reflejadas. Durante esta prueba es cuando se han revisado todos los ítems al menos por dos revisores y se detectan errores de mayor calado. A fin de agrupar tipos de errores similares y determinar así el calado o grado de importancia del error contenido en el ítem, se realiza una metaclasificación de los 17 tipos de errores. Se consideran dos grados de meta-errores: grave o leve, y se transporta el mismo grado a todos los errores de la clase. Ello tiene consecuencia directa en la subsanación del ítem que contiene el error, ya que un ítem con error leve, necesita una modificación leve, mientras si tiene un error leve y otro grave o simplemente uno grave, la corrección exige un retoque considerable del ítem, circunstancia que se ha recogido también en la tabla siguiente. Meta-Error Estilo Error de trascripción Error gramatical (Nuevas reglas de Euskaltzaindia) Ambigüedad o bien en el propio enunciado o bien porque puede haber más de una respuesta posible Ítem incompresible/ininteligible o con todas las opciones incorrectas Tipos de errores que engloba 0, 1, 2, 3, 4, 8 5, 6, 7 10, 13, 14 Gravedad del meta-error Leve Leve Grave 11, 15, 9 Grave 12, 16 Grave Con respecto a la gravedad de los errores, indicar que los tipos de errores de grano fino numerados del 9 al 16 se han considerado graves, incluidos los errores gramaticales por nuevas reglas de Euskaltzaindia, ya el banco de ítems ha de integrarse en aplicaciones para la enseñanza del Euskara. La siguiente tabla recoge una descripción detallada de los errores detectados por ítem así como si se ha o no subsanado el error, dando lugar a una modificación leve (M) o bien considerable (R) del ítem, lo cual no significa que el ítem ya no sea erróneo. De esta forma, la modificación leve indica que, el error no era/es grave o crítico, y por ello, no 9 tiene importancia capital en que la base de datos original no llegue a registrarse la modificación. Sin embargo, la modificación grave, indica que empleándose el ítem en una aplicación de aprendizaje del Euskara, no es tolerable que contenga un error de tal índole, y debe necesariamente recogerse la modificación propuesta. N. Ítem Tipo de Modif. leve (M) error ó retoque importante (R) 10 0 M 17 0 M 18 15 R 20 0 M 27 0,13 R 28 0 M 29 0,9 R 30 0 M 32 0 M 33 0 M 34 0 M 35 0 M 36 14 R 42 0 M 43 0 M 44 13 R 47 0 M 49 0,15 R 50 13 R 51 0 M 53 0,14,15 R 54 0 M 55 0 M 56 0,14,15 R 57 0 M 58 0 M 59 6 M 60 0 M 61 0,7 M 62 0 M 63 9 R 64 0,13 R 67 0 M 68 0 M 70 0 M 71 0 M 73 13,14 R 74 0 M 76 0 M 77 0,9 R 79 0 M N. Ítem Tipo de Modif. leve (M) error ó retoque importante (R) 80 0 M 81 0 M 82 0 M 84 0 M 85 0 M 86 0 M 87 0,2 M 88 0,2 M 89 4,14 R 90 0 M 91 0,2 M 92 0 M 94 0 M 95 0,14 R 96 4,14 R 101 0 M 102 9 R 103 0 M 106 0 M 108 0,14,15 R 109 8,14,15 R 110 0 M 111 2 M 112 7 M 113 15 R 114 0,14 R 115 0 M 119 0,14 R 120 0 M 121 0,2 M 122 2 M 123 15 R 124 14 R 125 0,14 R 126 14 R 127 9 R 129 9 R 130 0 M 131 0 M 132 15 R 134 0,15 R 10 N. Ítem Tipo de Modif. leve (M) error ó retoque importante (R) 135 15 136 0,5 M 137 0 M 138 0 M 139 0 M 140 0,9,14 R 141 0,9 R 142 0 M 143 0 M 144 0 M 145 0,13 R 146 0,15 R 147 0,2 M 148 0,9 R 149 0 M 150 0 M 151 0,9 R 152 0,9 R 155 9 R 159 0 M 162 0,9 R 164 0,2 M 165 0,2,10,9 R 166 0,9 R 167 0 M 168 2,15 R 169 0 M 170 9 R 171 15 R 172 0 M 173 0,13 M 174 0 M 176 0 M 177 0,15 R 178 0,15 R 179 0 M 180 0 M 181 0,7 M 182 0 M 183 0 M 184 0,3 M 185 0,5 M 186 0,9 R 187 0,15 R 188 0 M 189 0 M 190 15 R 191 0,1,9 M N. Ítem Tipo de Modif. leve (M) error ó retoque importante (R) 192 0 M 193 0,15 R 194 0 M 195 0,1,15 R 196 0,1 M 197 0,1 M 198 0,15 R 199 0,1 M 200 0 M 201 0,1 M 202 0,1,16 R 203 0 M 204 0 M 206 0 M 207 0,1 M 208 0 M 210 0 M 211 0,1 M 212 0,1,9 R 213 0 M 214 0,1 M 215 0 M 216 0,2 M 217 0,12 R 218 0 M 219 0,1 M 220 0 M 221 15 R 222 0 M 223 0 M 224 0 M 225 0,9 M 226 0 M 227 0,1,9 R 228 0 M 229 9 R 230 0 M 231 0 M 232 0 M 233 0 M 234 0 M 235 5 M 237 0,9 R 238 0 M 240 5,11 M 241 0 M 242 5,9 M 244 0 M 11 N. Ítem Tipo de Modif. leve (M) error ó retoque importante (R) 245 5,9 R 247 0,1 M 248 0 M N. Ítem Tipo de Modif. leve (M) error ó retoque importante (R) 249 0,5,15 R 251 9 R 252 15 R Con respecto al peinado efectuado, cabe destacar que había una serie de errores, mayoritariamente del tipo 9 y 15, cuya corrección no era automática y que se han podido corregir gracias a las aportaciones de los revisores. Dichos ítems están recogidos en la siguiente tabla: Descripción de la situación del ítem tras el filtrado Error resuelto, notificado por uno (pero con solidez) o más revisores Total: Ítems en que sucede 18, 29, 49, 53, 56, 63, 74, 108, 109, 113, 123, 127, 129, 132, 134, 140, 141, 151, 155, 162, 165, 166, 168, 171, 177, 187, 190, 193, 195, 212, 217, 221, 227, 245, 251, 252 36 ítems Atendiendo a los criterios de corrección y tratamiento de errores a partir de las aportaciones de los revisores, hay unos ítems que siguen siendo potencialmente erróneos, tras el proceso de filtrado y corrección, y conviene quede constancia de ello. Esto puede deberse a que existen dudas de que la corrección aplicada a un ítem con tipo de error grave solvente el problema descubierto. Una segunda posibilidad es que no haya habido aportación para solventar el error detectado. La última causa es que se trate de un ítem sobre el que un único revisor haya indicado la posible existencia del error pero sin aportación solución alternativa, y por ello no se ha registrado como ítem erróneo. A continuación se hace una enumeración y descripción de los mismos: Descripción de la situación del ítem tras el filtrado Error sin solucionar, con o sin modificación del ítem Se ha intentado subsanar el error, pero hay dudas de haberlo logrado Contiene alguna duda notificada por un único revisor, no se ha considerado error Total: Ítems en que sucede 135, 191, 225, 240, 242 77, 102, 146, 148, 152, 170, 178, 186, 198, 202, 229, 237, 249 1, 13, 16, 59 22 ítems A modo de resumen, indicar que estando compuesto el banco por 252 ítems, en la prueba se han revisado 536 ítems y se han detectado un total de 265 errores en 184 ítems del banco, de los cuales 189 eran leves y 76 graves. De ese número de errores registrados, se han subsanado 247, es decir, el 93,2% de los errores detectados se han ciertamente subsanado. Destacar, que sin las aportaciones de los 5 revisores hubiera sido imposible subsanar 36 de los 76 errores graves, ya que la corrección de dichos errores no es automática aún tras su detección. Sin embargo, aún con las aportaciones e incluso habiendo realizado algunas modificaciones, persisten 18 ítems potencialmente peligrosos (de los 76 errores graves detectados). Concretamente, y en opinión de los revisores, 5 ítems siguen siendo erróneos y hay dudas sobre los otros 13. 12 Respecto a los restantes 211 errores (cifra obtenida de restar al numero total de errores, 265, los 36 ítems subsanados de forma no automática y los 18 ítems potencialmente erróneos), una vez detectados, no cabe duda que las modificaciones efectuadas han generado ítems correctos, ya que las modificaciones son sistemáticas. En esta recapitulación no queremos dejar de lado la existencia 4 ítems, que no habiéndolos registrado como erróneos, hay algún revisor que ha mostrado su recelo por la corrección de los mismos. No obstante, los revisores no han aportado modificación alguna para despejar sus dudas. Dicho inclusión aumentaría de 18 a 22 los ítems potencialmente erróneos por inclusión de 4 ítems más, cuya corrección algún revisor ha dudado, pero que no se ha registrado. Sin embargo, dicha inclusión tan sólo incrementa en un 0,7% el número de ítems dudosos. En consecuencia y tras el peinado del banco de ítems tenemos que aproximadamente el 8% de los ítems del banco actual son finalmente dudosos. La siguiente tabla sintetiza los resultados del trabajo realizado anteriormente expuestos: Detectados en el filtrado Número de ítems con algún tipo de error: Número de ítems con errores únicamente leves: Número de ítems que contienen al menos un error grave: 184 116 68 Núm. total de errores detectados (registrado): Núm. total de errores leves: Núm. total de errores de calado importante: 265 189 76 Datos tras la corrección Núm. de ítems modificados en total: 183 Núm. de ítems con modificación tipo leve: 120 Núm. de ítems con modificación cuyo registro es imprescindible 63 Núm. de errores subsanados en total: Núm. de ítems subsanados por aportaciones propias de los revisores (en calidad de expertos) y no subsanables de otra forma: Núm. de ítems que contienen algún error sin solucionar: Núm. de ítems que podrían aún ser erróneos: Núm. de ítems con propuesta de error no aceptado (no registrado): 247 36 5 13 4 El resultado final del proceso de homogeneización y filtrado del banco de ítems original se halla recogido en el anexo 3 bajo ese mismo nombre “Banco de ítems homogeneizado y filtrado”, pudiéndose apreciar en el mismo las diferencias entre la versión final del banco de ítems y la original. 13 A G R A C E D I M I E N TO S Y S U B V E N C I O N E S Se agradece a Fidel Altuna, Maria Jesús Aranzabe, Mikel Lersundi, Iñaki Picabea y Luis Mari Asurabarrena por su labor efectuada como revisores del banco de ítems. Se agradece a Javier López-Cuadrado por sus aportaciones en el análisis los datos a la hora de generar el filtrado de los ítems. Se agradece a Tomás A. Pérez por la supervisión y reorganización del trabajo aquí presentado. El desarrollo de este trabajo ha sido subvencionado por el proyecto “Desarrollar una competencia universitaria transfonteriza sobre el proceso de e-learning.”, Consejo Regional de Aquitania y Gobierno Vasco, convocatoria 2003-2004. REFERENCIAS [1] Arruabarrena, R., J. A. Vadillo, et al. (2003). Are Experts Difficulty Guessing And Statistical Results Comparable? ICTE2003. Conf. Internacional de Tecnológías de la Información y Comunicación en la Educación., Badajoz. [2] López-Cuadrado, J., T. A. Pérez, et al. (2002). Integrating Adaptive Testing in an Educational System. Educational Technology in Cultural Context: ETCC2002. First International Conference on, Joensuu, Finland, University of Joensuu. [3] Mark, M. A. and J. E. Greer (1993). "Evaluation Methodologies for Intelligent Tutoring Systems." International Journal of Artificial Intelligence in Education. Special Issue on Evaluation 4(2/3): 129-153. [4] Tessmer, M. (1993). Planning and Conducting: Formative Evaluations. London, Kogan Page Limited. [5] Dix, A., J. Finlay, et al. (1998). Human-Computer Interaction, 2nd edition, Pearson Education Limited. [6] Shneiderman, B. (1998). Designing the User Interface, 3rd edition, Addison Wesley Longmang, Inc. [7] Nielsen, J. and R. L. Mack (1994). Usability Inspection Methods, John Wiley &Sons, Inc. [8] Arruabarrena, R. Pérez, T.A. (2005). Pruebas de campo para calibrar un banco de ítems vía expertos. Technical Report San Sebastián, University of the Basque Country. Ref.: UPV/EHU/LSI/TR 03-2005. 14