Modelos GARCH. Ajustes a modelos

Anuncio

Apuntes de Series Temporales

David Rodrı́guez

17 de Noviembre de 2009

1.

Modelos de Series Temporales

Modelo AR(1)

El modelo AutoRegresivo AR(1) es un proceso aleatorio de la forma

Xt = ϕXt−1 + σϵt ,

ϵt ∼ N (0, 1)

Se trata de un caso particular del modelo AR(p) con un solo retraso (p = 1).

Afirmamos sin demostración que la condición que se debe pedir para que la serie

temporal sea estacionaria es |ϕ| < 1. (aunque se ve claramente a partir de la

solución explı́cita para el AR(1) considerado como una ecuación de diferencias

de primer orden que derivamos la semana anterior: Si |ϕ| fuera mayor que 1, el

término que depende de las condiciones iniciales en la solución, ϕt X0 , crecerı́a

sin lı́mite con t).

En caso de que ϕ = 1 tenemos un browniano aritmético, que como ya vimos,

no es estacionario (el proceso con ϕ = 1 tiene media cero y varianza que crece

lienealemnte con el tiempo como σ 2 t). Suponiendo |ϕ| < 1 y por tanto, Xt

estacionario calculamos

:0

E[Xt ] = ϕE[Xt−1 ] + σE[ϵ

t ] = ϕE[Xt ]

donde hemos usado en particular que la media es independiente de t. Siendo

ϕ ̸= 1, la única posibilidad de que se cumpla la igualdad es

E[Xt ] = 0

Para la varianza se procede de forma similar. Como la media del proceso es

0, la varianza se puede calcular directamente como E[Xt2 ]. Calculamos pues Xt2

directamente, utilizando la ecuación que define el proceso temporal

2

Xt2 = (ϕXt−1 + σϵt )2 = ϕ2 Xt−1

+ σ 2 ϵ2t + 2σϕXt−1 ϵt

y aplicamos el operador que permite el cálculo del valor esperado (E[·], operador lineal)

(a)

2

V ar(Xt ) = E[Xt2 ] = ϕ2 E[Xt−1

] + 2σϕE[Xt−1 ϵt ] + σ 2 E[ϵ2t ]

(b)

= ϕ2 V ar(Xt ) + 2σϕE[Xt−1 ]E[ϵt ] + σ 2 E[ϵ2t ]

(c)

= ϕ2 V ar(Xt ) + σ 2

1

En (a) se ha aplicado linealidad dela esperanza, en (b) la independencia entre

Xt−1 y ϵt , y en (c) se han sustituido los valores conocidos para el ruido blanco

gaussiano E[ϵt ] = 0 y E[ϵ2t ] = 1.

Ahora podemos despejar la varianza obteniendo

V ar(Xt ) =

σ2

1 − ϕ2

Por último, calculamos la función de covarianzas γ. En este caso tenemos

Cov(Xs , Xt ) = E[(Xs − E[Xs ])(Xt − E[Xt ])] = E[Xs Xt ] ∀s, t

por ser 0 la media. Se nos ocurre pues multiplicar ambos lados de la serie por

Xt+τ , con τ > 0 y tomar esperanzas

γ(τ ) = E[Xt Xt+τ ]

= E[ϕXt−1 Xt+τ + σϵt Xt+τ ]

= ϕE[Xt−1 Xt+τ ] + σE[ϵt Xt+τ ]

= ...

Problema... Si τ es positivo hay dependencia entre las variables ϵt y Xt+τ y no

puedo separar esperanzas en σE[ϵt Xt+τ ]. Necesitarı́a tener ϵt y Xt−τ (que sı́ son

independientes) para que el valor esperado del producto de estas cantidades se

pueda calcular como producto de valores esperados. Esto no supone un problema

ya que γ(t + τ, t) = γ(t̃, t̃ − τ ), y al ser la serie estacionaria γ es independiente

de t. Vamos a probar de nuevo...

γ(τ ) = E[Xt Xt−τ ]

= E[ϕXt−1 Xt−τ + σϵt Xt−τ ]

= ϕE[Xt−1 Xt−τ ] + σE[ϵt Xt−τ ]

= ϕE[Xt−1 Xt−τ ] + σ

E[ϵ

t ]E[Xt−τ ]

= ϕγ(τ − 1) = . . . = ϕτ γ(0)

Dado que ϵt y Xt−τ con τ > 0 son independientes, el valor esperado de su producto factoriza como producto de valores esperados E[ϵt Xt−τ ] = E[ϵt ]E[Xt−τ ].

Sólo queda observar que γ(τ ) = γ(−τ ) y que γ(0) = V ar(Xt ) para concluir

γ(τ ) =

σ2

ϕ|τ |

1 − ϕ2

ρ(τ ) = γ(τ )/γ(0) = ϕ|τ |

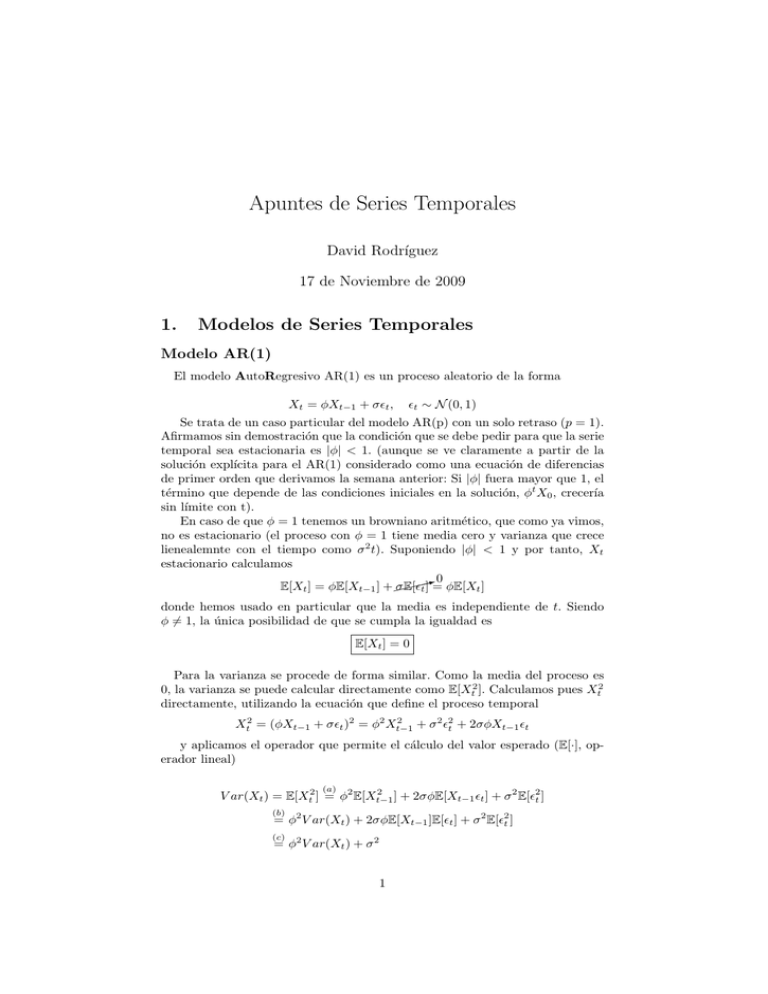

La evolución de la autocorrelación podemos representarla mediante un diagrama de autocorrelaciones, como el que aparece en la figura 1. Podemos ponerla

en forma de decaimiento exponiencial para calcular el tiempo de vida medio de

la serie.

2

1.2

1

φ

0.8

ρ(τ)

φ2

0.6

φ3

φ4

0.4

φ5

6

φ

φ7

φ8

0.2

φ9

φ10

φ11 φ12

φ13 φ14 φ15

0

0

2

4

6

8

10

12

14

τ

Figura 1: Diagrama de autocorrelación para la serie Xt = 0,85Xt−1 + σϵt .

ϕ|τ | = e|τ | log ϕ ≡ e−τ /τm

=⇒

τm = −

1

log ϕ

Observar que si se tuviera |ϕ| = 1 el tiempo de vida serı́a infinito ya que la

serie no converge.

Modelo AR(1) generalizado

Ahora consideramos

Xt = ϕ0 + ϕ1 Xt−1 + σϵt ,

ϵt ∼ N (0, 1)

Usando, como antes, que el proceso es estacionario (E[Xt ] = E[Xt−1 ]) obtenemos

E[Xt ] = ϕ0 + ϕ1 E[Xt−1 ]

→

(1 − ϕ1 )E[Xt ] = ϕ0

→

E[Xt ] =

ϕ0

1 − ϕ1

Para la varianza usamos el hecho de que

Xt −E[Xt ] = (ϕ0 +ϕ1 Xt−1 +σϵt )−(ϕ0 +ϕ1 E[Xt−1 ]) = ϕ1 (Xt−1 −E[Xt−1 ])+σϵt

con lo que la variable Xt − E[Xt ] sigue el proceso anterior y se tiene

V ar(Xt ) = E[(Xt − E[Xt ])2 ] =

3

σ2

1 − ϕ1

Otros Modelos

En el cuadro 1 se describen algunos modelos más complicados. En todos los

casos ϵt ∼ N (0, 1).

AR(2)

Auto

Xt =

ϕ0 + ϕ1 Xt−1 ϕ2 Xt−2 + σϵt

Xt =

θ0 + θ1 ϵt−1 + θ2 ϵt−2 + σϵt

Xt =

ϕ0 + ϕ1 Xt−1 +

AR(1)

Xt =

Autoregressive

ut =

θ1 ϵt−1 + θ2 ϵt−2 + σϵt

√

ϕ0 + ϕ1 Xt−1 + ht ϵt

√

ht ϵ t

Conditional

ht =

κ + α1 u2t−1 + α2 u2t−2

Regressive

2 retrasos

MA(2)

Moving

Average

2 retrasos

ARMA(1,2)

AR(1)

MA(2)

AR(1)

+

ARCH(2)

ut ≡ innovación, ht ≡ volatilidad

Heteroskedasticity

2 retrasos

ARMA(1,1)

+

GARCH(1,2)

√

ARMA(1,1)

Xt =

Generalized

ut =

ϕ0 + ϕ1 Xt−1 θ1 ϵt−1 +

√

ht ϵ t

ht ϵ t

ARCH(1,2)

ht =

κ + α1 u2t−1 + β1 ht−1 + β2 ht−2

AR(1)

+

Buen modelo para el IBEX35

GARCH(1,1)

Cuadro 1: Otros modelos

2.

Estimación de Modelos

Hasta ahora, me han dado un modelo, por ejemplo AR(1), y he extraı́do

propiedades de él. Ahora cambiamos el enfoque. Lo que se nos da ahora es una

conjunto de datos empı́ricos de la serie temporal. Por ejemplo, X1 , X2 , . . . , XT

que siguen AR(1) y me interesa estimar los parámetros de la serie σ̂, ϕˆ0 , ϕˆ1 .

Vamos a ver varios modos posibles para estimar estos parámetros

4

Método de Momentos

El método de momentos consiste en la estimación de parámetros del modelo igualando momentos muestrales con momentos teóricos, y resolviendo las

ecuaciones resultantes para las variables que se quieran estimar. Para obtener

estimadores no sesgados (que converjan al valor real cuando crece el tamaño de

la muestra) necesito modelos ergódicos, como es el caso. Ejemplos:

E[Xt ] ≈ ⟨X⟩ =

T

1∑

Xt

T t=1

⟨

⟩

V ar(Xt ) ≈ (Xt − ⟨Xt ⟩)2 =

1 ∑

(Xt − ⟨Xt ⟩)2

T − 1 t=1

T

T

1∑

σ̂

(Xt − ⟨Xt ⟩)2 =

2

T t=1

1 − ϕˆ1

T

⟨

⟩

1∑

ρ(1) = γ(1) = ϕ1 ≈ (Xt − ⟨Xt ⟩)2 =

(Xt − ⟨Xt ⟩)(Xt−1 − ⟨Xt−1 ⟩)

T t=2

T →∞

≈

Nótese que en la última ecuación se ha utilizado 1/T en lugar de 1/(T − 1)

en el estimador para la autocovarianza. En general la diferencia para valores

grandes de T es despreciable, y este estimador tiene la ventaja de que origina una matriz de autocovarianzas definida positiva. Además, merece la pena

señalar que aunque el modelo sea ergódico (es decir, aunque el promedio sobre la

distribución estacionaria del proceso se pueda estimar a partir de un promedio

en el tiempo), las estimaciones de la autocovarianza γ(τ ) a partir de la muestra empı́rica sólo serán buenas si τ ≪ T . Una última observación explica que

aparezcan bandas de confianza en los correlogramas, como los que aparecen en

la figura 2. Representan la incertidumbre por tener un número finito de observaciones. Se obtienen considerando la propia estimación de la autocorrelación

como una variable aleatoria, que para un número grande de muestras tenderá a

una distribución normal (Teorema del Lı́mite Central). Una vez observado esto,

se fija un grado (porcentaje de confianza) y se calculan el tamaño de la franja

para que la probabilidad de caer en ella sea la elegida.

Método de Mı́nimos Cuadrados

Dada una muestra {(xn , yn )}N

1 , quiero obtener una recta y = ax+b de modo

que minimize

N

∑

(yi − axi − b)2

i=1

Las soluciones a este problema son

â =

d

Cov(x,

y)

d

V ar(x)

b̂ = ⟨y⟩ − â⟨x⟩

5

Figura 2: Función de autocorrelación muestral de n=200 observaciones de un

proceso MA(1). Tomado de “Introduction to Time Series and Forecasting”, de

Brockwell & Davis.

La motivación de aplicar este método se ve cláramente en la forma del modelo. Los datos de muestra que se nos proporcionan tendrán un cierto error

σϵn , ϵn ∼ N (0, 1). Pero este es justo el modelo AR(1), tomando ϕ0 = b y

ϕ1 = a. Es por ello que el modelo se llama Autoregresivo, por que se aproxima

por regresión sobre la propia serie.

Método de Máxima Verosimilitud

En general se utiliza el Método de Máxima Verosimilitud. La función de

verosimilitud se define, fijadas las muestras X1 , . . . , XT , como la pdf de (X1 , . . . , XT )

como función de los parámetros ϕ0 , ϕ1 , σ (nótese que los parámetros dependen

del modelo, en este caso AR(1)).

L(ϕ0 , ϕ1 , σ; {Xt }Tt=1 ) = p(X1 , . . . , XT ; ϕ0 , ϕ1 , σ)

Por la forma del modelo AR(1), podemos hacer una hipótesis de independencia condicionada, y se tiene

L(ϕ0 , ϕ1 , σ; {Xt }Tt=1 )

T

∏

=

p(Xt |Xt−1 ; ϕ0 , ϕ1 , σ)

t=2

Los estimadores de máxima verosimilitud son aquellos que maximizan la

función de verosimilitud, es decir,

(ϕ∗0 , ϕ∗1 , σ ∗ ) = argmax L(ϕ0 , ϕ1 , σ; {Xt }Tt=1 )

ϕ0 ,ϕ1 ,σ

Sin embargo, estos productos son difı́ciles de tratar computacionalmente ya

que sus valores se disparan. No obstante, si tomamos logaritmos, los productos

se van a transformar en sumas, más manejables. Además, el logaritmo es una

transformación monótona creciente y que por tanto conserva el máximo con

6

lo que no influye en nuestro cálculo. La función transformada que se busca

optimizar recibe el nombre de Log-Verosimilitud.

LL(ϕ0 , ϕ1 , σ) = log(L(ϕ0 , ϕ1 , σ; {Xt }Tt=1 ) =

T

∑

(

)

log p(Xt |Xt−1 ; ϕ0 , ϕ1 , σ)

t=2

Se puede verificar que la maximización de la verosimilitud en un modelo

lineal como el AR(1) haciendo la hipótesis de que las innovaciones son gaussianas

conduce a la misma estimación para los parámetros del modelo que mı́nimos

cuadrados.

7