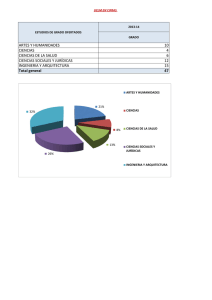

- Escuela Militar de Ingeniería

Anuncio