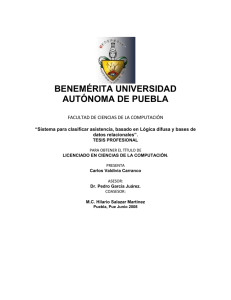

tesis - Instituto Politécnico Nacional

Anuncio

INSTITUTO POLITÉCNICO NACIONAL

UNIDAD PROFESIONAL INTERDISCIPLINARIA DE

INGENIERÍA Y CIENCIAS SOCIALES Y

ADMINISTRATIVAS

“LA MINERÍA DE DATOS COMO SOPORTE A LA TOMA

DE DECISIONES ESTRATÉGICAS DE LAS

ORGANIZACIONES”

T

QUE

E

S

PARA

OBTENER

INGENIERO

P

IVONNE

LESLIE

I

EL

TÍTULO

EN

R

E

S

THERESA

MÉXICO, D.F.

E

S

DE:

INFORMÁTICA

N

T

ESPINOSA

GUTIÉRREZ

A

N:

ALBA

ROSAS

2010

ÍNDICE

Resumen

I

introducción

II

Capítulo I. Introducción

1.1 Antecedentes

..……………

1

1.2 Motivación

..……………

3

1.3 Planteamiento del Problema

..……………

6

1.4 Objetivo

..……………

7

2.1 Introducción

..……………

8

2.2 Descripción de la Metodología CIADEC

..……………

11

2.3 Estadística e Inteligencia Artificial

..……………

12

2.4 Los Sistemas Híbridos

..……………

14

2.5 El Proceso KDD (Knowledge Discovery in DataBase)

..……………

15

2.6 Reconocimiento Estadístico de Patrones

..……………

15

2.7 Minería de Datos

..……………

18

..……………

19

2.7.1.1 Weka

..……………

19

2.7.1.2 Clementine

..……………

19

2.7.1.3 CIADEC

..……………

19

2.7.1.4 CVIZ

..……………

19

2.8 Sistemas de Clasificación Basados en Reglas

..……………

19

2.9 La Lógica Difusa y el Razonamiento Difuso

..……………

23

2.10 Sistemas de Clasificación Basados en Reglas Difusas

..……………

27

..……………

28

..……………

28

..……………

32

2.11.1 Aprendizaje Supervisado

..……………

32

2.11.2 Aprendizaje No Supervisado

..……………

32

..……………

34

..……………

34

3.1.1.1 Enfoques del Reconocimiento de Patrones

..……………

35

3.1.1.1.1 Enfoque Estadístico

..……………

36

Capítulo II. Marco de Referencia

2.7.1 Sistemas de Minería de Datos

2.10.1 Sistemas Basados en Reglas Difusas (SBRD)

2.10.2 Sistemas de Clasificación Basada en Reglas

2.11 Aprendizaje Automático

Difusas

Capítulo III. Marco Teórico

3.1 Conceptos Básicos

3.1.1 Reconocimiento de Patrones

3.1.1.1.2 Enfoque Sintáctico Estructural

..……………

37

3.1.1.1.3 Enfoque Lógico – Combinatorio

..……………

38

3.1.1.2 Tipos de problemas del Reconocimiento de Patrones

..……………

38

3.1.1.3 Etapas del proceso de Reconocimiento de Patrones

..……………

39

..……………

43

3.1.2.1 Componentes de la Minería de Datos

..……………

45

3.1.2.2 Criterios para aplicar la Minería de Datos

..……………

45

3.1.2.3 Técnicas de Minería de Datos más Usados en la Toma de

Decisiones

3.1.2.3.1 Tablas de Decisión

..……………

3.1.2 Minería de Datos

46

..……………

46

3.1.2.3.2 Arboles de Decisión

..……………

47

3.1.2.3.3 Reglas de Asociación

..……………

48

3.1.2.3.4 Representación Basada en Instancias

..……………

48

3.1.2.3.5 Clústers

..……………

48

3.1.2.3.6 Técnicas Basadas en la Estadística

..……………

49

..……………

49

..……………

49

3.1.3.1.1 Tipos de Sistemas de Soporte a Decisiones

..……………

50

3.1.3.1.2 Características de los Sistemas de Soporte a la Toma de

Decisiones

3.1.3.1.3 Componentes Funcionales que Integran un DSS

..……………

3.1.3 Métodos de la Toma de Decisiones en los Sistemas

3.1.3.1 Sistemas de Soporte a las Decisiones

51

..……………

52

..……………

53

..……………

56

3.2.1 Caracterización a partir de Variables Categóricas

..……………

56

3.2.2 Sistemas de Caracterización

..……………

57

3.3 El Boxplot

..……………

58

3.4 El Aprendizaje Automático

..……………

62

3.1.3.2 Proceso de Decisión

3.2 Tecnología CIADEC Usada en Minería de Datos

3.4.1 Clasificación Aprovechando el Conocimiento Declarativo de los

Expertos

3.4.2 Representación del Conocimiento del Experto e Interpretación

..……………

..……………

64

3.4.3 Metodología de Clasificación Basada en Reglas

..……………

65

3.5 Proceso Knowledge Discovery in DataBase (KDD)

..……………

66

3.6 Conceptos Básicos de Lógica Difusa

..……………

69

3.6.1 Lógica Difusa

..……………

70

3.6.2 Razonamiento Difuso

..……………

71

3.6.3 Las Etiquetas Lingüísticas, la Visualización e Interpretación de

Resultados en Sistema Híbridos

3.6.4 Etiquetas Lingüísticas

..……………

..……………

76

3.6.5 Aplicación

..……………

78

64

73

Capítulo IV. Modelo de la Tecnología CIADEC

4.1 Introducción

..……………

84

4.2 Propuesta del Modelo

..……………

84

..……………

101

..……………

101

5.1.1.1 Diseño de Experimentos

..……………

101

5.1.1.2 Factor de Bloque

..……………

103

5.1.1.3 Metodología CIADEC

..……………

103

5.1.1.3.1 Criterios de Agregación

..……………

104

5.1.1.3.2 Método K-Folds Cross-Validation

..……………

105

..……………

105

..……………

106

Capítulo V. Resultados y Discusión

5.1 Caso de Estudio. Del Dominio del Ámbito Laboral

5.1.1 Conceptos Básicos

5.1.1.4 Metodología KDSM

5.2 Aproximación al Dominio del Ámbito Laboral

5.2.1 Descripción de los Datos del Ámbito Laboral

5.3 Aplicación de la Metodología de KDSM al Dominio del Ámbito

Laboral

5.3.1 Caracterización de la Estructura de los Municipios para el

Establecimiento de las Condiciones Iniciales

5.4 Proceso de Caracterización Usando la Metodología CIADEC

110

..……………

..……………

112

113

..……………

115

5.4.1 Identificación de las Características Relevantes de los Cursos

..……………

123

5.4.2 Eficiencia del Sistema

..……………

125

6.1 Conclusiones

..……………

161

6.2 Trabajo Futuro

..……………

162

Conclusiones

..……………

164

Anexo. Manual de usuario del sistema CIADEC 2.0

..……………

166

Bibliografía

..……………

209

Capitulo VI. Conclusiones y Trabajo Futuro

RESUMEN

Uno de los problemas principales de las técnicas de clustering es que la validación de

resultados es un problema sin resolverse, ya que no existe un criterio objetivo para determinar la

calidad de las clases de una clasificación.

Es fácil evaluar un conjunto de clases en términos de criterios de exactitud siempre que

exista una partición de referencia de los datos y si la comparación es posible. Pero

desafortunadamente, en la mayoría de las situaciones donde se requiere hacer clustering (técnicas

que intentan determinar si existen grupos) no existe y esta aproximación no es útil. Solamente la

utilidad de una clasificación puede usarse para decidir si es correcta o no. Evaluar la utilidad de

una clasificación dada requiere de un mecanismo que permita comprender el significado de las

clases identificadas para finalmente decidir si son útiles o no.

Este proceso, conocido comúnmente como Interpretación de las clases resultantes,

generalmente lo realiza el analista informático, en una forma no sistemática, usando sus

conocimientos y experiencia para poner de manifiesto las principales diferencias entre clases, y

posteriormente, en estrecha colaboración con el experto en la materia, analiza las clases, estudia

su significado para darles una interpretación. Este proceso llega a dificultarse cuando el número de

clases aumenta y el número de variables utilizado para describir los datos también aumenta.

Por tal motivo, se aplica el modelo propuesto, CIADEC (Caracterización e Interpretación

Automática de Descripciones Conceptuales), al análisis de medidas seriadas muy cortas y

repetidas con factor de bloque, presentes en un dominio poco estructurado (DPE) del dominio del

Ámbito Laboral para obtener conocimiento de la evolución de un programa de capacitación

(BECATE), así como de su efectividad a través del análisis de la información relacionada con: la

colocación de la gente capacitada, características de los municipios donde se dio la capacitación y

las necesidades del sector productivo; lo anterior en el Estado de Chihuahua en un total de 17

Municipios.

Palabras clave: Minería de Datos (Data Mining), aprendizaje supervisado, aprendizaje no

supervisado, caracterización, interpretación, Tecnología CIADEC, Estadística, Inteligencia Artificial,

Sistemas Híbridos, Métodos y técnicas de soporte a la toma de decisiones.

INTRODUCCION

La construcción de una plataforma integrada de soporte al análisis inteligente de dominios

poco estructurados, incluyendo todo tipo de herramientas, desde las más básicas de análisis

descriptivo hasta las más sofisticadas como la clasificación basada en reglas y herramientas de

apoyo a la interpretación de resultados, relacionadas con la Minería de Datos y el proceso

Knowledge Discovery in Databases (KDD) es el objetivo de la presente Tesis.

Para el desarrollo de esta aplicación sobre el modelo de caracterización e interpretación de

descripciones conceptuales en dominios poco estructurados (CIADEC) se deben tener en cuenta

los conocimientos de los conceptos básicos sobre caracterización, de la herramienta estadística

denominada boxplot para observar la relación entre variables y las clases y, en especial su utilidad

para representar las diferencias entre grupos, del aprendizaje supervisado que permite que a partir

de una clasificación de referencia se obtengan un conjunto de reglas para decidir la clase a la que

pertenece cada elemento en el Universo del discurso, del proceso Knowledge Discovery in Data

Base (KDD) en el cual este modelo tiene su marco natural de referencia y conceptos básicos sobre

Lógica Difusa, que permite establecer el modelo de etiquetas lingüísticas útil para la visualización

de resultados.

La propuesta del modelo aporta un Sistema de Caracterización de clases, basado en

predicados de lógica de primer orden ( CP1 ), que permiten máxima potencia y flexibilidad para

detectar variables cuantitativas caracterizadoras en algunas clases, permitiendo un procedimiento

de generación automático de reglas, que formarán parte de la base de conocimiento de un sistema

orientado a la predicción o diagnóstico. Además, la automatización de este sistema de

caracterización ofrecerá un conjunto de herramientas de apoyo a la interpretación como: la

construcción de un sistema de reglas, visualización de las funciones de pertenencia de una

variable

Xk

a las distintas clases

C,

evaluación de individuos nuevos de acuerdo a las reglas

generadas y validación de la calidad de la predicción teniendo como base un conjunto de nuevos

objetos.

En esta parte se aplica el modelo propuesto al análisis de medidas seriadas muy cortas y

repetidas con factor de bloque, presentes en un dominio poco estructurado (DPE) del dominio del

Ámbito Laboral para obtener conocimiento de la evolución de un programa de capacitación

(BECATE), así como de su efectividad a través del análisis de la información relacionada con: la

colocación de la gente capacitada, características de los municipios donde se dio la capacitación y

las necesidades del sector productivo.

CAPÍTULO I

INTRODUCCIÓN

En este trabajo de tesis se presenta una aplicación de la Tecnología CIADEC [1]

(Caracterización e Interpretación Automática de Descripciones Conceptuales) y el modelo teóricoconceptual, que incluye una nueva forma de extraer conocimiento útil de los así llamados dominios

poco formalizados o estructurados.

Este modelo permite identificar las características relevantes de las clases resultantes

obtenidas de una partición de referencia, lo cual conlleva a la generación automática de las

descripciones e interpretaciones conceptuales de estas clases; lo anterior, basado en una

combinación de diferentes herramientas y técnicas de Estadística (boxplot múltiple [162], análisis

de datos), Inteligencia Artificial (aprendizaje automático, sistemas basados en conocimientos) y

Lógica Difusa (modelos y razonamiento aproximado).

1.1 ANTECEDENTES

La comprensión de la naturaleza de los métodos que utilizamos los seres humanos para

clasificar datos o conocimientos, es un problema de gran interés teórico y práctico para todas las

ciencias cognitivas, ya que la acción de clasificar es una de las etapas iniciales de los procesos de

adquisición de conocimiento en cualquier campo científico [2]. Teóricamente, la comprensión del

concepto ―clasificar‖ contribuye a entender mejor lo que implica el ―aprendizaje‖; de hecho, es difícil

concebir una forma de aprendizaje sin haber pasado antes por una forma previa de clasificación

[3].

Por otro lado, en la práctica, el desarrollo de sistemas automáticos de clasificación es, hoy

por hoy, una necesidad imperiosa de la sociedad actual ya que en muchos procesos la cantidad de

datos que se genera es tan grande, que resulta muy difícil manipularlos y transmitirlos sin el auxilio

de esta clase de sistemas.

La clasificación automática se desarrolla normalmente en dos grandes enfoques [4]: a) A

partir de una clasificación de referencia de un universo de discurso, definir reglas para decidir la

clase a la que pertenece cada elemento del discurso (aprendizaje supervisado); y b) Dado un

universo de discurso, construir una clasificación adecuada del mismo (aprendizaje no supervisado).

Diversas disciplinas del conocimiento humano han contribuido para la creación, diseño y

desarrollo de reconocedores y clasificadores automáticos de patrones, dentro de ambos enfoques.

De relevancia para este trabajo de tesis, son las contribuciones de la Estadística, la Inteligencia

Artificial y la Lógica Difusa.

En el campo de la estadística, personajes como Galton [57], Pearson [58], Mahalanobis

[59] y Fisher [60] han sido pioneros en la aplicación de métodos estadísticos en el reconocimiento y

clasificación de patrones, y actualmente se aplican diversas técnicas desarrolladas por ellos y sus

seguidores, como son: boxplot múltiple, análisis de regresión, análisis de componentes principales

y análisis discriminante, entre otras. Más recientemente, se han desarrollado algunas técnicas

estadísticas, siendo notable la presencia de clustering [61], dentro del aprendizaje no supervisado.

En lo que respecta al aprendizaje supervisado, son dignos de mención algoritmos como el

bayesiano [85], el euclidiano [86], el k-NN (los k vecinos más cercanos) [99-103], los árboles de

decisión [104,105], y otros algoritmos cuyo fundamento queda en disciplinas diferentes de la

estadística, como las máquinas de soporte vectorial [106], las redes neuronales [67,92,93] y las

memorias asociativas [94-98].

Desde su creación a mediados de los 50 del siglo pasado, los científicos pioneros de la

inteligencia artificial como Von Neumann [64] y Minsky [65], además de una pléyade de científicos

afines a sus ideas, han incidido mediante sus propuestas científicas en las áreas de

reconocimiento y clasificación de patrones [72]; así, a través del tiempo se han incorporado: el

aprendizaje automático [5-8], los sistemas expertos [9-11,66], la Inteligencia Artificial evolutiva

(algoritmos genéticos) [68,69], la inteligencia artificial Macro-distribuida (sistemas multi-agentes)

[70,71] y el descubrimiento del conocimiento en base de datos (KDD) [33].

La Lógica Difusa, por su parte, como una extensión de la lógica multi-valuada de

Lukasiewicz [144] que a su vez se derivó de la lógica booleana, ha permitido considerar desde una

perspectiva más amplia a los problemas relacionados con el modelado del razonamiento.

Formalizada por Zadeh en 1965, la Lógica Difusa refleja las imprecisiones de los datos generados

en el mudo real [117-128]. Numerosos equipos de investigación científica actualmente trabajan en

el diseño de sistemas donde se aplican de manera directa los conceptos y resultados de la lógica y

el razonamiento difusos, siendo relevante su uso en áreas como control [129,130] y sistemas de

clasificación basados en reglas difusas [131-142].

1.2 MOTIVACIÓN

Es un hecho indiscutible que la mayoría de los sistemas expertos de la primera generación

como MYCIN [5], INTERNIST [6], [7], PLANT/DS [8] y algunos otros, son en la práctica, sistemas

clasificadores. Esta clase de sistemas utilizan un conjunto de reglas implementadas como árboles

de decisiones para determinar la clase a la que pertenece un individuo de un cierto dominio de

estudio [9].

En el enfoque clásico a este problema, el experto humano es el responsable de decidir

cuáles son las variables ―relevantes‖ para la formulación de las reglas de clasificación. Cuando se

procede de esta forma, el diseñador del sistema requiere información que el experto no está

preparado para proporcionar debido, fundamentalmente, a la falta de familiaridad con los términos

que se utilizan en el sistema informático. Esto provoca graves problemas de comunicación al

tratarse de personas que tienen formaciones diferentes, por lo que la extracción de conocimiento

se hace difícil de superar y consume mucho tiempo.

Por lo tanto, la clasificación de ejemplos se presenta como una herramienta alternativa

posible para la extracción del conocimiento de las descripciones que los expertos podrán dar a sus

dominios.

Esta es la razón de que hayan surgido diversas metodologías que permiten el análisis de la

información con miras a crear agrupaciones de observaciones para su posterior caracterización e

interpretación [10].

Un enfoque diferente es el de la Inteligencia Artificial ya que, se ha decidido por el uso de

técnicas de aprendizaje inductivo para la automatización de procesos. De esta manera, a partir de

una colección de individuos de un dominio propuestos por el experto o extraídos directamente de

dicho dominio y, de estas técnicas, se puede descubrir el conocimiento oculto en los datos y en

consecuencia conocer la estructura semántica del dominio, útil en la construcción de bases de

conocimiento, disminuyendo en este sentido su costo. Este mecanismo parece más viable ya que

se ha observado que los expertos tienen más facilidad para dar ejemplos de instancias de su

dominio que para expresar los conceptos o reglas que les permiten identificarlas [11].

En el caso del dominio donde la estructura semántica esté claramente definida y exista

una manera de discernir entre las diferentes categorías que lo componen, esta metodología es

clara y provechosa a la hora de construir bases de conocimiento para sistemas basados en

conocimiento, disminuyendo la interacción experto-diseñador del sistema.

Todos los problemas de adquisición de conocimiento mencionados se agravan si el

dominio sobre el que se está tratando es un Dominio poco Estructurado (ILL-Structured Domains,

ISD). Estos dominios se caracterizan por [11], [12]:

No existir consenso entre los expertos para la definición de todos los conceptos y objetos

que los componen y las relaciones entre éstos.

Complejidad del área de conocimiento en concreto, ya sea por la falta de una metodología

de investigación aceptada por todos los expertos o por un continuo cambio en el

conocimiento o en su extensión.

Las variables que describen a los individuos pueden ser cuantitativos o cualitativos.

Los expertos suelen disponer de grandes cantidades de conocimiento implícito, además de

manejar diversos grados de especificidad, lo que hace a este conocimiento parcial y no

homogéneo.

De esta forma la alternativa que parece más prometedora para resolver estas limitaciones

es liberar al experto de este trabajo, mediante el desarrollo de técnicas que a partir de la evidencia

empírica en forma de ejemplos, identifiquen las variables más relevantes y formulen reglas que

expresen las regularidades existentes en los datos.

En las últimas décadas, el crecimiento explosivo de los avances científicos y tecnológicos

ha generado sistemas complejos que han rebasado nuestra capacidad para analizarlos e

interpretarlos, creando la necesidad de una nueva generación de métodos, técnicas y herramientas

con la capacidad para asistir inteligente y automáticamente a los seres humanos en el análisis de

estas bases de datos para extraer conocimiento útil que represente los dominios del mundo real.

Descubrir la estructura semántica o extraer conocimiento de dominios reales y complejos

(dominios poco estructurados) no es tarea fácil y se requiere el combinar técnicas y herramientas

de diversos campos para construir Sistema Híbridos que permitan encontrar e interpretar patrones

especiales (o conceptos) en las bases de datos; y así, extraer conocimiento útil que represente

estos dominios, con mejor desempeño que las técnicas tradicionales o los enfoques clásicos de los

sistemas basados en conocimiento [13].

Así, dada una partición (clasificación de referencia) de un conjunto grande de individuos, es

necesario introducir herramientas para asistir al usuario en las tareas de interpretación, con objeto

de establecer el significado de las clases resultantes.

Frecuentemente, no es suficiente descubrir

la construcción automática de clases, sino poder entender por qué se detectaron estas clases.

Algunos paquetes estadísticos orientados al análisis multivariante y de propósito general como

SPAD (Système Portable pour L'Analyse des Donees Textuelle) y SPSS (Statistical Package for

Social Sciences) [14], incluyen varias herramientas orientadas a la interpretación de una

clasificación dada, como la posibilidad de calcular la contribución de cierta variable a la formación

de una clase. Sin embargo, en la etapa final, la interpretación misma deberá hacerla el usuario en

una forma no-sistemática, usando su propia experiencia y la tarea llega a dificultarse cuando el

número de clases resultantes aumenta, así como también cuando el número de variables también

aumenta para describir los datos.

Por otro lado, no se tiene información sobre un criterio objetivo para determinar la

validación de clases, considerándola por lo tanto, como el grado de interpretabilidad o utilidad de

éstas.

Por lo anterior, el interés de este trabajo de tesis es presentar una aplicación de la

tecnología CIADEC, la cual combina herramientas y técnicas de Estadística, Inteligencia Artificial y

Lógica Difusa en forma cooperativa, de forma que, a partir de las variables cuantitativas de los

datos que definen a los individuos pertenecientes a cierto dominio, sea posible identificar cuáles

son las situaciones características (clases resultantes) que se pueden encontrar en él, analizarlas,

estudiar su significado y, en consecuencia, conocer la estructura semántica del dominio al cual

pertenecen dichos individuos.

Una vez identificadas e interpretadas estas situaciones típicas, el conocimiento generado

pueden ser usadas posteriormente como herramienta de apoyo al proceso de administración o

toma de decisiones. Incluso se ha llegado a decir que la validación de una clasificación (problema

abierto) consiste, precisamente, en probar que las clases tienen sentido o utilidad [15].

En esta dirección, esta aplicación sobre un dominio laboral pretende facilitar la generación

automática de descripciones e interpretaciones conceptuales en este dominio real y complejo.

El caso de estudio es una aplicación de la metodología al estudio de un dominio laboral. A

partir de una base de datos y una partición de referencia de los mismos, se genera un sistema de

reglas difusas usando las variables cuantitativas recomendadas por el experto. Este sistema

permitirá, para un nuevo individuo i (día), predecir la clase C (situación típica del dominio) que le

corresponde y generar de forma automática las caracterizaciones e interpretaciones de las

descripciones conceptuales correspondientes a esa clase.

1.3 PLANTEAMIENTO DEL PROBLEMA

A partir de una matriz de datos X y una partición de referencia P se obtiene un conjunto de

individuos con una clase asignada de acuerdo con el proceso de clasificación dado. Se plantea

aplicar la metodología CIADEC para identificar en forma eficiente las características relevantes de

las diferentes clases obtenidas de tal forma que proporcionen un Sistema de Caracterización de

clases para obtener descripciones conceptuales directamente comprensibles al usuario-experto.

Uno de los problemas principales de las técnicas de clustering es que la validación de

resultados es un problema sin resolverse, ya que no existe un criterio objetivo para determinar la

calidad de las clases de una clasificación.

Es fácil evaluar un conjunto de clases en términos de criterios de exactitud siempre que

exista una partición de referencia de los datos y si la comparación es posible [21]. Pero

desafortunadamente, en la mayoría de las situaciones donde se requiere hacer clustering (técnicas

que intentan determinar si existen grupos) no existe y esta aproximación no es útil. Solamente la

utilidad de una clasificación puede usarse para decidir si es correcta o no [22]. Evaluar la utilidad

de una clasificación dada requiere de un mecanismo que permita comprender el significado de las

clases identificadas para finalmente decidir si son útiles o no.

Este proceso, conocido comúnmente como Interpretación de las clases resultantes,

comúnmente lo realiza el analista informático, en una forma no sistemática, usando sus

conocimientos y experiencia para poner de manifiesto las principales diferencias entre clases, y

posteriormente, en estrecha colaboración con el experto en la materia, analiza las clases, estudia

su significado para darles una interpretación. Este proceso llega a dificultarse cuando el número de

clases aumenta y el número de variables utilizado para describir los datos también aumenta.

Es en esta línea donde se propone la aplicación de esta metodología híbrida que

represente una nueva forma de extraer conocimiento útil directamente comprensible al usuario-

experto usando una combinación de diferentes herramientas y técnicas de Estadística (boxplot

múltiple, análisis de datos), Inteligencia Artificial (aprendizaje automático, sistemas basados en

conocimientos) y Lógica Difusa (modelos y razonamiento aproximado) para soportar la toma de

decisiones en estos dominios.

1.4 OBJETIVO

Aplicar la metodología para identificar las características relevantes de las clases

resultantes, obtenidas de una partición de referencia, la cual a partir del sistema de caracterización

se genera de forma automática las descripciones conceptuales de estas clases con variables

numéricas y categóricas, y la cual permita conocer la estructura semántica del dominio poco

estructurado en estudio, de bajo costo y útil en tareas de predicción o diagnóstico. Obtener,

además, contribuciones a la validación de clases, en relación a su representación formal y su

calidad, considerando esta última como el grado de interpretabilidad o utilidad de las clases

formadas.

CAPÍTULO II

MARCO DE REFERENCIA

2.1 Introducción

La presente propuesta de tesis que se presenta se ubica dentro del contexto del desarrollo

de los Sistemas Híbridos para la extracción de conocimiento. La línea de investigación inicia en

1995 [11] con el objetivo principal de estudiar los dominios poco estructurados.

La primera propuesta constituye la tesina [25] y después la tesis doctoral de Gibert [11] que

cristalizó en la formulación de la metodología de clasificación basada en reglas y una primera

versión del sistema informático que la implementa, denominado Klass [26] y [27] y que se ha

utilizado en diversas aplicaciones [17], [23], [24], [28], [29], [30] y [31] todas estas contribuciones

constituyen un Proyecto Marco.

El objetivo de este Proyecto Marco es construir una plataforma integrada de soporte al

análisis inteligente de dominios poco estructurados, incluyendo todo tipo de herramientas, desde

las más básicas de análisis descriptivo hasta las más sofisticadas como la clasificación basada en

reglas y herramientas de apoyo a la interpretación de resultados, relacionadas con la minería de

datos y el proceso Knowledge Discovery in Databases (KDD) [32], [33], [34] y [35].

Considerando las características especiales de este tipo de dominios, se han desarrollado

métodos mixtos de análisis que combinan técnicas estadísticas con técnicas de Inteligencia

Artificial para resolver los problemas que se plantean en este contexto [36] y [37].

Todo el software que se ha desarrollado en el seno del Proyecto Marco ha integrado lo que

podemos llamar herramienta master, que actualmente es el joc.Klass+, y que aglutina herramientas

de muy distinta naturaleza ofreciendo la interfaz necesaria en cada momento del análisis [27]. Esta

herramienta informática ha venido evolucionando de forma continua desde su origen en la medida

en que se ha avanzado en la investigación y experimentación de la línea de investigación antes

mencionada.

Evolución del Proyecto Marco

KLASS v0. Tesina de Ingeniería en informática de Karina Gibert. ―Klass. Estudi d’un

sistema d’ajuda al tractament estadístic de grans de dades‖. Clasifica matrices de datos

heterogéneas usando una distancia mixta definida especialmente para ello [25], [38].

KLASS v1. Tesis doctoral en informática de Karina Gibert. ―L’us de la información

simbólica en l’automatizació del tractament estadístic de dominis poc estructurats‖. Es una

ampliación de KLASS v0. Incorpora la clasificación basada en reglas. Es una herramienta

informática, orientada a la clasificación automática de dominios poco estructurados,

implementada en LISP y lenguaje C. Ha sido desarrollada en el departamento de

Investigación de Operaciones de la Universidad Politécnica de Cataluña e implementa la

metodología de clasificación basada en reglas, la que representa una estrategia mixta de

clasificación automática que usa una combinación de métodos basados en el conocimiento

(Inteligencia Artificial) y clasificación ascendente jerárquica (tradicionalmente de la

Estadística) [11], [26] y [39].

Xcn.KLASS. PFC de Ingeniería Informática de Xavier Castillejo. Incorpora a KLASS v1

una interfaz de ventanas independientes, implementada en C, que comunica con el núcleo

LISP. Existe una versión PC de la interfaz que facilita el uso de KLASS (sobre SUN) desde

PC’s a usuarios que desconocen LISP y UNIX [40].

jj.KLASS. PFC de la Diplomatura de Estadística de Juan José Márquez y Juan Carlos

Martín. Incorpora a la versión KLASS v1 nuevas opciones para el tratamiento de datos

faltantes, la posibilidad de trabajar con objetos ponderados e implementa un test no

paramétrico de comparación de clasificaciones [41] y el cual se aplicó al análisis de

disfunciones de tiroides [30] y [42].

xt.KLASS. PFC de Ingeniería en Informática de Xavier Tubau. Incorpora a la versión

xcn.KLASS cuatro métricas mixtas más y el módulo nuevo de comparación de

clasificaciones [32] de jj.KLASS [43]. También se diseñó un experimento para estudiar el

comportamiento de las distintas métricas, así como el análisis estadístico de los resultados.

KLASS+. PFC de Ingeniería Técnica en Informática de Sistemas de Silvia Bayona. Fusión

definitiva de las versiones xt.KLASS y jj.KLASS. Además incorpora un módulo nuevo de

análisis descriptivo y de ayuda a la interpretación de datos [17], [44] y [45] y de clases

resultantes con el propósito de reorientar KLASS, haciéndola más general [21]. Sobre esta

versión, el proyecto de la Diplomatura Estadística de Begoña Gómez [46] consistió en el

desarrollo de herramientas de muestreo y de clasificación basada en bootstrap, las cuales

aún están por integrarse.

PFC de Diplomatura de Estadística de Miguel Ángel Nieto. Compilación de técnicas de

minería de datos y de descubrimiento de conocimiento [47].

Joc.KLASS+. PFC de Ingeniería en Informática de Universidad Autónoma de Barcelona

(UAB) de Joseph Oliveras. Incorpora a la versión sbh.KLASS+ tres métricas mixtas más

[37] y [48], la métrica generalizada de Minkowski propuesta por Ichino y Yaguchi [49].

COLUMBUS. Tesis doctoral del programa de Inteligencia Artificial de la UPC de Jorge

Rodas. Diseño de la metodología para el descubrimiento de conocimiento en medidas

seriadas muy cortas y repetidas con factor de bloque (KDSM). Construcción de un primer

satélite de joc.KLASS+, denominado COLUMBUS que implementa la metodología KDSM

[50].

CIADEC.

Tesis doctoral en el programa de doctoral en computación del Centro de

Investigación en Computación (CIC) del IPN, de Fernando Vázquez. Desarrollo de la

metodología para la caracterización e interpretación automática de descripciones

conceptuales en dominios poco estructurados con variables numéricas (AUGERISD).

Construcción en Java de un satélite de joc.KLASS+ denominado CIADEC que implementa

la metodología AUGERISD. Actualmente existe ya un prototipo de CIADEC que se

encuentra en fase de experimentación y pruebas. [51], [52], [53], [54], [55], [56] y [57].

Java.KLASS. Proyecto que consiste en traducir al lenguaje de programación Java el

núcleo LISP de la versión más reciente de KLASS, se integrarán todos los módulos y

satélites (COLUMBUS y CIADEC) en Java con una interfaz general con total transparencia

para el usuario.

En la Figura 2.1 se aprecia el panorama general de la evolución del Proyecto Marco.

Clasificación de datos mixtos

KLASS v0

(1991)

Interfase independiente de

ventanas

Clasificación basada en reglas

KLASS v1 Comparación de clasificaciones

Clasificación ponderada

(1994)

Tratamiento de Missings

Nueva métrica mixta

Ralambondrainy xcn.KLASS

(1996)

xt.KLASS

(1999)

jj.KLASS

(1997)

Comparación de

clasificaciones

Descriptiva de datos

Descriptiva de clases

Clasificación

ponderada

KDSM

COLUMBUS

(2002)

sbh.KLASS (+)

(2001)

CIADEC

(2008)

(2008)

joc.KLASS(+)-JAVA

Figura 2.1. Cronología del Proyecto Marco

2.2 DESCRIPCIÓN DE LA METODOLOGÍA CIADEC

Partiendo de los trabajos previos sobre la interpretación a partir de variables cualitativas

[11], en donde se analizó la caracterización de clases a partir de conceptos fundamentales como:

conjunto de valores propios (caracterizador, parcialmente caracterizador, no propio y genérico),

variable caracterizadora (v.c.), variable ε-caracterizadora, sistema caracterizador; además, en [51]

se demostró que el boxplot múltiple es una herramienta ágil y potente con variables numéricas

para identificar elementos útiles, considerándolo como la base de esta propuesta metodológica

para la detección de las variables caracterizadoras en variables cuantitativas que se proponen en

CIADEC.

La aproximación a lo que sería un proceso automático de interpretación de clases tiene su

origen en la idea del boxplot múltiple. Así, la metodología aunque inspirada en esta herramienta

gráfica estadística ha sido automatizada usando algoritmos no gráficos, calculando los valores

mínimo y máximo de cada clase, procediendo a una ordenación ascendente del total de estos

valores a las distintas clases. Los extremos de los intervalos de longitud variable a generar serán

los valores contiguos dos a dos.

Con ello se construye la tabla de contingencia entre los intervalos y las clases, lo que dará

el número de observaciones que hay en cada clase para cada intervalo. A partir de esta tabla se

obtienen las distribuciones condicionadas a cada intervalo y que resulta en el porcentaje de

elementos de cierto intervalo en cada clase. Así, podemos asociar a un objeto o individuo

cualquiera su grado de pertenencia a cada clase. Esta idea da lugar a un gráfico de grados de

pertenencia difusos para cada clase y cada variable.

A partir de aquí es fácil conectar la metodología con un modelo de creación de etiquetas

lingüísticas que generen automáticamente las interpretaciones de las descripciones conceptuales

de las clases.

2.3 ESTADÍSTICA E INTELIGENCIA ARTIFICIAL

El término Estadística se deriva del latín Status, que se refiere a política y situación social,

al Estado, empieza como una ciencia de recolección de datos económicos y demográficos. En su

evolución y aún hoy en día se considera una ciencia relacionada con la recolección y el análisis de

datos, para extraer información y presentarla en forma comprensible y sintética [58].

A fines del siglo XVIII surge un periodo científico fértil en el campo de la Estadística. En

este tiempo F. Galton [59] presentó sus primeros trabajos sobre Análisis de Regresión, y K.

Pearson [60] presentó, entre otros trabajos, en 1901, una versión preliminar del Análisis de

Componentes Principales. Su principal discípulo, R. A. Fisher [61], cuyos trabajos son

considerados la base de la Estadística moderna, junto con P. Ch. Mahalanobis [62] en 1936,

presentaron los primeros trabajos acerca del Análisis Discriminante en el cual existe una variable

respuesta, que indica la clase de todo objeto y encuentra la mejor combinación lineal de todas las

variables para distinguir la clase.

Así, desde hace mucho tiempo se utiliza la formación y distinción entre diferentes clases de

objetos (clustering), tomando actualidad cuando las computadoras llegan a ser más poderosas. En

1963, R.R. Sokal y P.H. Sneath [63] presentaron The Numerical Taxonomy la cual puede ser

considerada como la primera formulación moderna de clustering.

La Inteligencia Artificial es una disciplina formal que surge a mediados de los años 50’s. Al

inicio estuvo bajo el paradigma de Von Newmman [64] y técnicas de puntuación secuencial y su

característica a través de su génesis histórica en la búsqueda para construir máquinas que

―piensen‖.

En 1961, M. Minsky [65] divide la Inteligencia Artificial en cinco tópicos: búsqueda,

reconocimiento de patrones, aprendizaje, planeación e inducción. La mayoría de los trabajos serios

sobre Inteligencia Artificial de acuerdo con este esquema estuvieron relacionados con búsqueda

heurística.

Uno de los primeros éxitos en la aplicación a la solución de problemas orientados al

diagnóstico fue MYCIN [66] en 1976 (diagnóstico de infecciones), y otras técnicas como: sistemas

expertos, representación del conocimiento, aprendizaje automático, razonamiento, procesamiento

de lenguaje natural, etc. Sin embargo, las representaciones simbólicas mostraron serias

limitaciones cuando hicieron frente a problemas reales y complejos, principalmente porque la

mayoría de los problemas en Inteligencia Artificial son NP- completos.

En los años 70’s aparece el paradigma del paralelismo (arquitectura de computadoras en

paralelo), algunas veces llamado Inteligencia Artificial micro-distribuida y denominada por algunos

autores, por su metáfora implícita como: redes neuronales artificiales (ANN) [67].

Entre el paradigma del paralelismo y del simbolismo, aparecieron la Inteligencia Artificial

evolutiva [68] y [69] y la Inteligencia Artificial macro-distribuida [70] y [71]. La primera se caracteriza

por los algoritmos genéticos y la segunda por los sistemas multi-agentes y otras técnicas.

De los campos de aplicación de estas disciplinas se puede establecer que los objetivos de

la Inteligencia Artificial como de la Estadística son: la primera desarrollar programas que

“aprendan” y enriquezcan el conocimiento propio y el del usuario y de la segunda, presentar de

forma sintética y comprensible la colección y análisis de todo tipo de información [72].

2.4 LOS SISTEMAS HÍBRIDOS

Es claro que actualmente, las nuevas tecnologías aumentan significativamente nuestra

capacidad de producir, coleccionar y almacenar datos. Enormes cantidades de datos están

disponibles para ser analizados y extraer conocimiento en corto tiempo.

Obtener conocimiento de conjuntos de datos grandes o pequeños y además, poco

estructurados es una tarea muy difícil. La combinación de técnicas de análisis de datos (ej.

clustering), aprendizaje inductivo (ej. sistemas basados en conocimiento), administración de base

de datos y representación gráfica multidimensional, deberán producir beneficios en esta dirección y

a corto plazo.

Existen diversas herramientas informáticas que tratan algunas de las situaciones

mencionadas como por ejemplo: Clementine [73], Intelligent Manager [74], SPAD [14], SPSS [75],

[76] y WEKA [77] entre otras son algunas de las más famosas hoy en día, las cuales presentan

principalmente una combinación de técnicas existentes, permitiendo comparación de resultados y

la selección del mejor método en cada caso.

Sin embargo, en situaciones reales, es común trabajar con dominios complejos [27], tales

como trastornos mentales [42], esponjas marinas [11], disfunciones tiroidales [30], pruebas

psicofisiológicas [31] y muchas más, donde las bases de datos tienen tanto variables cualitativas

como cuantitativas; y el experto tiene algún conocimiento a priori (en general parcial) de la

estructura del dominio –el cual es difícil tomarse en cuenta por métodos de clustering– y difícil de

incluir en una base de conocimiento.

Durante la década pasada, en una gran variedad de dominios de aplicación, los

investigadores en aprendizaje automático, teoría del aprendizaje computacional, reconocimiento de

patrones y la estadística han hecho un esfuerzo por establecer un puente de comunicación entre

investigadores de la Inteligencia Artificial y la Estadística, Douglas H. Ficher [78] y Bill Gale [79] –

entre otros– han establecido una línea de investigación conformada por ambas ciencias, creando la

Society for Artificial Intelligence and Statistics (Asociación para la Inteligencia Artificial y la

Estadística) que tiene como objetivo impulsar la investigación para poder combinar técnicas de

estas disciplinas en la creación de Sistemas Híbridos (sistemas que son combinación de enfoques

de técnicas y/o métodos de diversas disciplinas como la Inteligencia Artificial, la Estadística y la

Lógica principalmente) que mejoren las funciones y desempeño de los sistemas actuales en las

diversas áreas tanto de la Inteligencia Artificial como la Estadística y algunas otras que estén

soportadas por estas disciplinas, dando lugar a una tercera opción que es el trabajo

interdisciplinario [80].

―Nos parece que hay un potencial de desarrollo enorme en la intersección de la Inteligencia

Artificial, la Ciencia de la Computación y la Estadística‖ [81].

“Cheeseman y Oldfor”

2.5 EL PROCESO

DATABASES)

KDD

(KNOWLEDGE

DISCOVERY

IN

Se estima que la cantidad de información en el mundo se dobla cada 20 meses [35]; esto

significa que científicos, gobierno y sistemas de información corporativos están siendo inundados

por una gran cantidad de datos que son generados y almacenados rutinariamente, los cuales

aumentan las bases de datos. Estos volúmenes de datos rebasan los métodos manuales

tradicionales de análisis de datos como hojas de cálculo y cuestionarios ad-hoc, los cuales pueden

crear reportes informativos de datos, pero no pueden analizar los contenidos de estos reportes

para obtener conocimiento importante.

De ahí que existe una necesidad significativa para una nueva generación de técnicas y

herramientas con la capacidad de asistir inteligente y automáticamente a las personas en el

análisis de la gran cantidad de datos para obtener conocimiento útil. Estas técnicas y herramientas

son temas de un campo emergente el de descubrimiento del conocimiento en base de datos (KDD)

[33], el cual se describirá en el marco teórico.

2.6 RECONOCIMIENTO ESTADÍSTICO DE PATRONES

El objetivo fundamental del reconocimiento de patrones es clasificar perfiles de

comportamiento de los objetos. Entre los diferentes contextos en los cuales el reconocimiento de

patrones ha sido formulado, el enfoque estadístico ha sido estudiado y usado en la práctica y el

cual se utilizara como fundamento en el desarrollo del modelo propuesto y se explicará en el marco

teórico.

La literatura sobre el reconocimiento de patrones es vasta y dispersa encontrándose en

numerosas revistas de diferentes disciplinas (ej. estadística aplicada, aprendizaje automático,

redes neuronales y procesamiento de señales e imágenes).

Un rápido vistazo de la tabla de contenidos de todos los temas de la IEEE, Transactions on

Pattern Analysis and Machine Intelligence, desde su primera publicación en enero de 1979, revela

que aproximadamente 350 artículos tratan sobre el reconocimiento de patrones. Aproximadamente

300 de estos artículos cubren el enfoque estadístico y pueden ser categorizados en los subtemas

siguientes: problema de dimensionalidad (15), reducción de la dimensionalidad (50), diseño de

clasificadores (175), combinación de clasificadores (10), estimación de error (25) y clasificación no

supervisada (59). Además los excelentes libros de Duda y Hart [88], Fukunaga [99], Devijver y

Kittler [100], Devroye, Gyorfi y Lugosi [87], Bishop [101], Ripley [102], Schuhfried [103] y McLachlan

[104], Nagy [105] y Kanal [106] en 1974 entre otros investigadores han contribuido notablemente al

estado del arte de este tema.

La Tabla 2.1 resume los clasificadores más comúnmente usados. Muchos de ellos

representan, en realidad, una familia completa de clasificadores y permiten al usuario modificar

diferentes parámetros asociados y funciones de criterios. Todos (o casi todos) los clasificadores

son aceptables en el sentido de que existen algunos problemas de clasificación para los cuales son

la mejor opción.

Método

Árbol de

decisión

Discriminante

lineal de

Encuentra

Propiedad

un

conjunto

de

umbrales para una secuencia de

iterativo;

características dependiente.

necesidad de poda; rápida prueba.

Clasificador

lineal

que

usa

optimización MSE.

Parzen

Regla de los

k-vecinos

próximos

Clasificador

logístico

entrenamiento

sensitivo:

Simple y rápido; similar a Bayes para las

distribuciones Gaussianas con matrices

Fisher

Clasificador

Comentarios

Procedimiento

de

entrenamiento

de covarianzas idénticas.

La

regla

de

Bayes

para

la

densidad de Parzen estima con

Óptima asintóticamente; dependiente de

la escala; prueba rápida.

desempeño al núcleo optimizado.

Asigna

patrones

a

la

clase

mayoritaria entre los k vecinos

próximos

usando

un

Óptima asintóticamente; dependiente de

la escala; prueba lenta.

valor

optimizado para k.

Regla de probabilidad máxima

Clasificador

lineal;

procedimiento

para probabilidades a posteriori

iterativo; óptimo para una familia de

logísticas (sigmoidales).

diversas

distribuciones

(Gaussianas);

tipos de datos mixtos.

Clasificador

de Bayes

Asigna patrones a la clase que

Pertenece a los clasificadores sencillos

tiene

(lineales

probabilidad

a

posteriori

estimada máxima.

o

cuadrática)

para

distribuciones Gaussianas; sensitivo a la

densidad de estimación de errores.

Método del

Asigna patrones a la clase más

En vez de normalización de invariantes,

cercana del subespacio.

es

Subespacio

usado

el

sub-espacio

de

las

invariantes; dependiente de la escala

(métrica).

Clasificador

cercano

Asigna patrones a la clase más

Sin necesidad de entrenamiento; prueba

cercana media.

rápida

medio

dependiente

de

la

escala

(métrica)

Clasificador

Maximiza el margen entre las

Dependiente de la escala; iterativo; lento

vector de

clases seleccionando un número

entrenamiento; no lineal e insensitivo.

soporte

mínimo de vectores.

Recuperar patrones completos a

Metodología

Memorias

partir de patrones de entrada que

computacional, un grado mínimo de

asociativas

pueden estar alterados con ruido

heurística y factible de implementarse en

aditivo, sustractivo o combinado.

hardware.

Tabla 2.1. Métodos de clasificación.

de

bajo

costo

2.7 MINERIA DE DATOS

La Minería de Datos es un conjunto de técnicas agrupadas con el fin de crear mecanismos

adecuados de dirección, entre ellas puede citarse la estadística, el reconocimiento de patrones, la

clasificación y la predicción [47].

Para descubrir patrones de relaciones útiles en un conjunto de datos se empezaron a

utilizar métodos que fueron denominados de diferente forma. El término Data Mining, en inglés, no

era, al principio, del agrado de muchos estadísticos, porque sus investigaciones estaban dirigidas a

procesar y reprocesar suficientemente los datos, hasta que confirmasen o refutasen las hipótesis

planteadas. Desde este ángulo, la Minería de Datos aplica una dinámica que se mueve en sentido

contrario al método científico tradicional.

Con frecuencia, el investigador formula una hipótesis; luego, diseña un experimento para

captar los datos necesarios y realizar los experimentos que confirmen o refuten la hipótesis

planteada. Este es un proceso, que realizado de forma rigurosa, debe generar nuevos

conocimientos.

En la Minería de Datos, por el contrario, se captan y procesan los datos con la esperanza

de que de ellos surja una hipótesis apropiada. Se desea que los datos nos describan o indiquen el

porqué presentan determinada configuración y comportamiento. Como afirma Eduardo Morales:

―La más inocente mirada a los datos puede inspirar una hipótesis. Recuérdese que los humanos

tienen un gran poder para generalizar e identificar patrones. Luego entonces, validar una hipótesis

inspirada por los datos en los datos mismos, será numéricamente significativa, pero

experimentalmente inválida [154].‖

Las técnicas de Minería de Datos no pueden utilizarse para confirmar o rechazar hipótesis,

porque puede conducir a errores fatales. Su función se trata de explorar datos, darles sentido,

convertir un volumen de datos, que poco o nada aportan a la descripción, en información para

interpretar un fenómeno, para adoptar decisiones de acuerdo con las necesidades.

2.7.1 Sistemas de Minería de Datos

2.7.1.1 WEKA

Visualiza únicamente la clase de pertenencia y gráficos de los comportamientos. Después

de haber sometido una base de datos a este sistema, se visualiza únicamente la clase a la que

pertenece cada uno de los individuos contenidos en la base de datos. Con la ayuda de una gráfica,

se pueden observar las agrupaciones o clases encontradas por el sistema, cada una de las cuales

se diferencia ya que se muestran en distinto color.

2.7.1.2 CLEMENTINE

Visualiza reglas de pertenencia a las clases. Al analizar una base de datos clasificada, este

sistema visualiza una serie de reglas de pertenencia a las clases, para que el usuario de acuerdo

con su criterio clasifique nuevos individuos.

2.7.1.3 CIADEC

Visualiza la clase de pertenencia, reglas y gráficos. Al analizar una base de datos

clasificada, este sistema visualiza: sistemas reglas, gráficos de pertenencia a las clases e

interpretación de resultados. Al analizar un nuevo individuo, el sistema proporciona la clase a la

que pertenece para que con el sistema de gráficos interprete los resultados, observando el grado

de pertenencia a las clases.

2.7.1.4 CVIZ

Una herramienta de visualización diseñada para el análisis de datos de alta dimensión en

grandes y complejos conjuntos de datos. Otorga al analista de datos una herramienta única para

ver todo el conjunto de puntos de datos a través de las dimensiones más interesantes en un corto

período [155].

2.8 SISTEMAS DE CLASIFICACIÓN BASADOS EN REGLAS

Hoy los métodos de clasificación automática son utilizados en todas sus variedades para

conocer la estructura de grandes bases de datos, lo cual incide en los objetivos básicos de los

procesos emergentes de Minería de Datos que tan de moda ha puesto la Sociedad de la

Información y las Nuevas Tecnologías.

Clustering. Es un término usado para denotar la función de un gran número de técnicas

que intentan determinar si existen grupos o clusters en un conjunto de datos y, en el caso que así

sea, determinarlos.

A pesar de las diferencias en cuanto a las aplicaciones, los tipos de datos y las técnicas

utilizadas, existen cinco pasos básicos [107] que caracterizan todo análisis de clúster [108]:

1. Selección de la muestra sobre la que se hará la clasificación.

2. Definición del conjunto de variables con los que se describirán las entidades de la muestra.

3. Cálculo de las disimilitudes o distancias entre las entidades con base en dichas variables.

4. Selección de un algoritmo de clustering y detección de grupos.

5. Validación de los resultados proporcionados por el algoritmo.

Un aspecto importante a puntualizar es que, de todas las clasificaciones posibles que se

pueden hacer con un conjunto de objetos, no existe la buena clasificación sino que, dependiendo

de los objetivos del estudio o uso que se quieran hacer, se escoge una u otra. La recomendación

general es que se elija la que resulte útil en cada contexto.

Existen diferentes familias de métodos en la elección de una distancia [11]:

Métodos de particiones. Se busca la participación óptima del conjunto que se estudia en un

número prefijado de clases k. Hay dos tipos:

-

Métodos de particiones directas: Las clases que se forman serán disjuntas, y pueden ser

aglomeradas o divisivas.

-

Métodos de participaciones en clase solapadas: Las clases que forman serán disjuntas, y

pueden ser aglomeradas o divisivas.

Métodos de clasificación jerárquica. Se busca el árbol que refleja la estructura jerárquica de

los datos. Según el nivel por que se corte el árbol se obtendrá una partición más o menos

precisa del conjunto objeto de estudio. Una ventaja respecto al anterior método es que no

hace falta determinar el número de clases que se quiere obtener al final.

Otros Métodos. Métodos de clasificación piramidal, métodos de árboles aditivos y de clases

latentes.

El principal problema para desarrollar métodos de clasificación automática es que el

concepto de clúster no es fácil de definir. Algunos enfoques para definir un clúster pueden basarse

por sus propiedades como: máxima cohesión interna y máximo aislamiento externo, propiedades

propuestas por [109] y [110]. Además, las clases pueden presentar formas y magnitudes muy

diferentes y se puede entender la dificultad de que exista una definición general de clusters que los

incluya a todos.

El problema de fondo es que el investigador puede no conocer la estructura de los datos a

priori y existe el peligro de interpretar la existencia de diferentes clusters cuando estos no existen

realmente.

En [111] se plantea hasta qué punto las clases obtenidas en un proceso de clasificación

refleja clases reales presentes en los datos, o si por el contrario, las clases obtenidas son el simple

resultado de aplicar un algoritmo a los datos, es decir, una partición de una realidad continua.

También, se afirma que la experiencia prueba que, aunque se esté en este último caso, la

tipología obtenida puede ser igualmente útil, ya que aunque no se pueda hablar de clases

realmente diferenciadas entre ellas, la partición obtenida suele facilitar la comprensión y estructura

de los datos y por tanto su operatividad. En este caso se habla de clases instrumentales en vez de

clases reales.

Algoritmo genérico de clasificación ascendente jerárquica. Una clasificación jerárquica

es una secuencia de clasificaciones en la que los clusters más grandes se forman a través de la

fusión consecutiva de clusters más pequeños.

Existen muchos algoritmos de clasificación ascendente jerárquica cada uno con sus propias

variantes y que conducen a diferentes clasificaciones. Sin embargo, si se quisiera presentar un

algoritmo genérico para los métodos de clasificación ascendente jerárquica, este podría ser el que

se plantea en clustering jerárquico de aprendizaje de ejemplos [112].

Uno de los algoritmos que se enmarca en este esquema de clasificación es el conocido

como de los vecinos recíprocos encadenados que se describe a continuación.

Vecinos recíprocos. El algoritmo de los vecinos recíprocos utiliza un concepto propio para

determinar cuáles son los individuos que se agregan:

Son vecinos recíprocos los individuos i ,

e

i' si i es el objeto más próximo a i' en la muestra,

i' es a su vez el más próximo a i . De este modo, en la clasificación por vecinos recíprocos,

siempre se agregarán parejas de vecinos recíprocos.

La principal propiedad de este método es que el resultado no depende del orden como se

procesan los datos (ni del orden como se producen las agregaciones) porque se está trabajando

con un criterio global sobre todos los datos.

La Figura 2.2 ilustra como en este algoritmo se produce un encadenamiento de objetos que

va del objeto más cercano al siguiente más cercano de éste hasta que se forme un lazo. El lazo es

precisamente la expresión gráfica de las parejas de vecinos recíprocos. Cuando se halla uno, se

produce una agregación con la consecuente creación de una nueva clase. Es frecuente

representar en forma de árbol la secuencia de agregaciones de un proceso así. Estos árboles

reciben el nombre de dendogramas.

En estos contextos identificar cuáles son las parejas de elementos más próximos (o de

vecinos recíprocos en este último caso) en cada iteración requiere la definición de una métrica

sobre el espacio de las variables que permita calcular la distancia entre dos individuos.

1

2

3

…

Figura 2.2. El proceso de los vecinos recíprocos encadenados

2.9 LA LÓGICA DIFUSA Y EL RAZONAMENTO DIFUSO

Una de las disciplinas matemáticas con mayor número de seguidores actualmente es la

llamada lógica difusa o borrosa, que es la lógica que utiliza expresiones que no son ni totalmente

ciertas ni completamente falsas, es decir, es la lógica aplicada a conceptos que pueden tomar un

valor cualquiera de veracidad dentro de un conjunto de valores que oscilan entre dos extremos, la

verdad absoluta y la falsedad total. Conviene recalcar que lo que es difuso, borroso, impreciso o

vago no es la lógica en sí, sino el objeto que estudia: expresa la falta de definición del concepto al

que se aplica.

La Lógica difusa permite tratar información imprecisa, como estatura media o temperatura

baja, en términos de conjuntos borrosos que se combinan en reglas para definir acciones: si la

temperatura es alta entonces enfriar mucho. De esta manera, los sistemas de control basados en

lógica difusa combinan variables de entrada, definidas en términos de conjuntos difusos, por medio

de grupos de reglas que producen uno o varios valores de salida.

La lógica difusa fue investigada, por primera vez, a mediados de los años sesenta en la

Universidad de Berkeley (California) por el ingeniero Lofty A.Zadeh cuando se dio cuenta de lo que

él llamo principio de incompatibilidad: ‖Conforme la complejidad de un sistema aumenta, nuestra

capacidad para ser precisos y construir instrucciones sobre su comportamiento disminuye hasta el

umbral más allá del cual, la precisión y el significado son características excluyentes‖. Introdujo

entonces el concepto de conjunto difuso (Fuzzy Set) bajo el que reside la idea de que los

elementos sobre los que se construye el pensamiento humano no son números sino etiquetas

lingüísticas.

La lógica difusa permite representar el conocimiento común, que es mayoritariamente del

tipo lingüístico cualitativo y no necesariamente cualitativo, en un lenguaje matemático a través de

la teoría de conjuntos difusos y funciones características asociadas a ellos. Permite trabajar a la

vez con datos numéricos y términos lingüísticos; los términos lingüísticos son inherentemente

menos precisos que los datos numéricos pero en muchas ocasiones aportan una información más

útil para el razonamiento humano.

El aspecto central de los sistemas basados en la teoría de la lógica difusa es que, a

diferencia de los que se basan en la lógica clásica, tienen la capacidad de reproducir

aceptablemente los modos usuales del razonamiento, considerando que la certeza de una

proposición es una cuestión de grado.

Mas formalmente se puede decir que si la lógica es la ciencia de los principios formales y

normativos del razonamiento, la lógica difusa o borrosa se refiere a los principios formales del

razonamiento aproximado, considerando el razonamiento preciso (lógica clásica) como caso limite.

Así pues, las características más atractivas de la lógica difusa son su flexibilidad, su tolerancia con

la imprecisión, su capacidad para modelar problemas no-lineales, y su base en el lenguaje natural.

Aunque la lógica difusa es conocida con este nombre desde que Zadeh la bautizo así en

1965, la idea que se esconde tras ella y sus orígenes se remontan hasta 2.500 años atrás [46]. Los

filósofos griegos, Aristóteles entre ellos, consideraban que existían ciertos grados de veracidad y

falsedad y Platón ya trabajo con grados de pertenencia.

El termino borroso aplicado a la lógica y a la teoría de conjuntos y sistemas procede de la

expresión fuzzy sets (conjuntos borrosos) acuñada por Lofti A. Zadeh, brillante ingeniero eléctrico

iraní nacionalizado en Estados Unidos, profesor en las más prestigiosas universidades

norteamericanas y doctor honoris causa de varias instituciones académicas. Sus tesis entroncan,

como podemos observar, con la obra de pensadores de distintas disciplinas que tenían una visión

similar de los problemas alejada de la lógica tradicional.

La paradoja del conjunto de Bertrand Russell, el principio de incertidumbre de la física

cuántica de W. Heisenberg, la teoría de los conjuntos vagos de Max Black, sin olvidar la

fundamental aportación del polaco Jan Lukasiewick, creador de la lógica multivaluada, influyeron

para que Zadeh publicase su famoso ensayo ―Fuzzy Sets‖ en ―Informations and Control‖ en 1965 y

más tarde ―Fuzzy algorithm‖ en la misma revista en 1968. Mientras que Russell y Black utilizaron el

termino vagueness (vaguedad, vago) para referirse a la nueva lógica o para calificar a los

conjuntos en la teorización sobre los mismos, Zadeh prefirió el término fuzzy (borroso, difuso) para

denominar a sus conjuntos y a la lógica en la que se apoya su análisis.

Aunque en un principio la lógica encontró una fuerte resistencia entre la comunidad

científica, algunos investigadores se convirtieron en seguidores de las teorías de Zadeh y mientras

él siguió ampliando y asentando los fundamentos de la teoría de conjuntos difusos estos

investigadores exploran estas nuevas teorías durante la década posterior a su nacimiento. Además

de las contribuciones del propio Zadeh, otros autores como Bellman, Lakoff, Goguen, Kohout,

Smith, Sugeno, Chang, Dunn, Bezdek, Negoita, Mizumoto, Tanaka, Kandel, Zimmermann, etc…

hicieron aportaciones al desarrollo de las bases de esta teoría.

Durante esta primera década, gran parte de estructuras lógicas y matemáticas son

generalizadas en términos de lógica difusa: relaciones lógicas, funciones, grupos, operaciones,

operadores, algoritmos, etc.

A principios de la década de los setenta, se establecen varios grupos de investigación en

lógica difusa en algunas pequeñas universidades japonesas; los profesores Terano y Shibata en

Tokio y los profesores Tanaka y Asai en Osaka, y pese a encontrar también un ambiente hostil en

estos primeros años de investigación, hacen grandes contribuciones tanto al desarrollo de la teoría

de la lógica difusa como al estudio de sus aplicaciones.

Un hito importante en el desarrollo de la lógica difusa fue establecido por Assilian y

Mamdami en 1974 en el Reino Unido al desarrollar el primer controlador difuso diseñado para una

máquina de vapor, pero la primera implantación real de un controlador de este tipo fue realizada en

1980 por F.L. Smidth & Co. en una planta cementera en Dinamarca. En 1983 Fuji aplica la lógica

difusa para el control de inyección química en plantas depuradoras de agua por primera vez en

Japón y en 1987 Hitachi pone en marcha un controlador fuzzy para el control del tren-metro de

Sendai, y la empresa Omron desarrolla los primeros controladores difusos comerciales.

Paralelamente al desarrollo de las aplicaciones de la lógica difusa, investigadores teóricos

siguen, en la década de los ochenta, el camino iniciado por Mamdani. Asi, Tagaki y Sugeno

desarrollan la primera aproximación para construir reglas fuzzy a partir de datos de entrenamiento,

y aunque en un principio no tiene mucha repercusión, mas tarde será el punto de partida para

investigar la identificación de modelos fuzzy.

Otro de los factores que contribuye a seguir con la investigación en este campo es el

creciente interés en las redes neuronales y su similitud con los sistemas fuzzy; la tendencia es

buscar vías de relación entre las dos técnicas y los resultados son los llamados neuro-fuzzy

systems, sistemas fuzzy que usan métodos de aprendizaje basados en redes neuronales para

identificar y optimizar sus parámetros. B. Kosho es conocido por su contribución a los sistemas

neuro-fuzzy y con sus publicaciones introdujo en la lógica difusa a muchos lectores interesados en

las redes neuronales.

En la década de los noventa, además de las redes neuronales y los sistemas fuzzy, hacen

su aparición los algoritmos genéticos. Estas tres técnicas computacionales, que pueden

combinarse de múltiples maneras y se pueden considerar complementarias, son herramientas de

trabajo muy potentes en el campo de los sistemas de control en la última década.

En realidad, la intención original del profesor Zadeh era crear un formalismo para manipular

de forma más eficiente la imprecisión y la vaguedad del razonamiento humano expresado

lingüísticamente, sin embargo causo cierta sorpresa que el éxito de la lógica borrosa llegase en el

campo del control automático de procesos.

Esto se debió básicamente al boom que la lógica borrosa causo en Japón, iniciado en 1987

y que alcanzo su máximo apogeo a principios de los noventa. Este boom fue el resultado de una

estrecha colaboración entre el gobierno, las universidades y las industrias japonesas,

estableciéndose dos proyectos nacionales a gran escala llevados a cabo por el Ministerio de

Industria y Comercio (MITI) y la Agencia de Ciencia y Tecnología (STA) en consorcio con el LIFE,

Laboratory for International Fuzzy Research, y en los que se involucran más de 50 compañías

durante seis años.

Desde entonces, han sido infinidad los productos lanzados al mercado que usan tecnología

borrosa, muchos de ellos utilizando la etiqueta fuzzy como símbolo de calidad y prestaciones

avanzadas.

El control difuso ha sido aplicado con éxito en muy diversas ramas tecnológicas, por

ejemplo la metalurgia, robots para la fabricación, controles de maniobras de aviones, sensores de

imagen y sonido (sistema de estabilización de la imagen en cámaras fotográfica y de video Sony,

Sanyo y Cannon), lavadoras (Panasonic y Bosch) que son capaces de autorregular la cantidad de

jabón que requiere un lavado dependiendo del grado de suciedad de la ropa, aire acondicionado

(Mitsubishi) en el que el sistema fuzzy evita las oscilaciones entre el exceso y el defecto de

temperatura), rice-cooker capaces de elaborar diversas variedades de arroz regulando la cantidad

de agua y la temperatura en cada caso para que el grano quede cocido y suelto.

Estas son algunas de las muchísimas aplicaciones de la lógica difusa, que ya están

funcionando en el campo de los llamados sistemas expertos [173].

Una gran variedad de ciencias aplican métodos de Inteligencia Artificial principalmente para

modelar el razonamiento del experto. Para diseño de tales sistemas inteligentes, la importancia de

la Lógica Difusa ha ganado gran aceptación. Publicaciones recientes han demostrado también que

los Sistemas Híbridos en Inteligencia Artificial han conseguido buenos resultados, combinando

Lógica Difusa e Inteligencia Artificial para el diagnóstico médico en la prevención de enfermedades,

redes neuronales para el reconocimiento de patrones, sistemas de inferencia difusos para

incorporar conocimiento humano, realizar inferencia y tomar decisiones, entre otras acciones.

Es importante considerar que los problemas complejos del mundo real requieren sistemas

inteligentes que combinen conocimiento, técnicas y metodologías de diferentes fuentes. Estos

sistemas inteligentes deberán poseer experiencia como la del humano dentro de un dominio

especifico, adaptándose y aprendiendo a hacer lo mejor en ambientes dinámicos y explicando

cómo tomar decisiones o acciones. De cara a los problemas de cálculo, es más ventajoso usar

diferentes técnicas de cálculo sinérgicas que exclusivas, obteniendo como resultado la

construcción de Sistemas Híbridos Inteligentes. Los conceptos básicos a utilizar en este trabajo por

ser parte fundamental se describirán en el marco teórico.

2.10 SISTEMAS DE CLASIFICACIÓN BASADOS EN REGLAS

DIFUSAS

Hoy en día, las aplicaciones más importantes de la teoría de de los conjuntos difusos

desarrollada por Zadeh en 1965 son los Sistemas Basados en Reglas Difusas (SBRD).

Esta clase de sistemas constituye una extensión de los sistemas clásicos basados en

reglas, debido a que tratan con reglas difusas en vez de reglas lógicas clásicas. Gracias a esto,

han sido aplicados exitosamente a una amplia gama de problemas de diferentes áreas que

presentan diferentes formas de incertidumbre y vaguedad.

2.10.1 Sistemas Basados en Reglas Difusas (SBRD)

Un Sistema Basado en Reglas Difusas (SBRD) presenta dos componentes principales: 1)

el sistema de inferencia, que ejecuta el proceso de inferencia difuso necesario para obtener una

salida del cual ha sido especificada una entrada, y 2) la Base de Reglas Difusa (BRD) que

representa el conocimiento que se tiene acerca del problema a resolver, formando un conjunto de

reglas [131].

En el diseño de un sistema inteligente de esta clase se deberán de realizar dos tareas

principales para una aplicación concreta: i) seleccionar los operadores difusos involucrados en el

sistema de inferencia, esto es, definir la forma en la cual el proceso de inferencia difusa se

realizará, y ii) obtener una adecuada BRD acerca del problema a resolver. La exactitud de los

SBRD para resolver un problema específico depende, directamente de ambas componentes [132].

La primera tarea ha de ser ampliamente analizada en la literatura especializada, y se ha de

realizar una gran cantidad de estudios teóricos y comparativos para tratar con el problema de

seleccionar los mejores posibles operadores difusos en el sistema de inferencia.

En relación a la segunda tarea del diseño, parece ser más fácil la decisión porque la

composición de la BRD depende directamente del problema a resolver. Debido a la complejidad de

la derivación de la BRD, se han propuesto una gran cantidad de técnicas automáticas para tal

efecto.

Los Sistemas Basados en Reglas Difusas (SBRD) combinan la precisión de la predicción

con un alto nivel de interpretabilidad, lo cual los hace muy adecuados para el diseño de Sistemas

de Clasificación en problemas reales [125], [130].

2.10.2 Sistemas de Clasificación Basada en Reglas Difusas

En un Sistema de Clasificación Basada en Reglas Difusas (SCBRD), se distinguen dos

componentes: 1) La Base de Conocimiento (BC), la cual es específica para un problema dado de

clasificación, y 2) un Modelo de Razonamiento Difuso (MRD).

El diseño de un SCBRD implica encontrar ambas componentes, y este proceso se lleva a

cabo a través de un proceso de aprendizaje supervisado, que inicia con un conjunto de individuos

clasificados correctamente (conjunto de entrenamiento) y cuyo objetivo es diseñar un Sistema de

Clasificación, asignando etiquetas de clase a nuevos objetos con un mínimo de error. Finalmente,

se calcula el desempeño del sistema sobre los datos de prueba para obtener una estimación

acerca del error de predicción del SCBRD. El proceso se ilustra en la Figura 2.3.

Figura 2.3. Diseño de un SCBRD (Aprendizaje / Clasificación)

Base de Conocimiento. La Base de Conocimiento (BC) está compuesta de la BR (Base

de Reglas) y la BD (Base de Datos). En la literatura especializada, se han usado diferentes tipos

de reglas y su diferencia consiste en la composición del consecuente: una clase [133], [134] y un

grado de certeza asociado a la clasificación de esa clase [135], y el grado de certeza asociado a la

clasificación de cada una de las clases posibles [136].

Un SCBRD está compuesto de una BR del siguiente tipo de reglas:

Rk : Si x1

k

A 1 Λ……. Λ x n

k

A n entonces Y

Cj con r

k

Donde:

x1,……...,xn son las variables seleccionadas para el problema de clasificación.

k

k

A 1,………,A

n

son etiquetas lingüísticas usadas para discretizar los dominios de las

variables cuantitativas o cualitativas.

Y es la clase Cj

{C1,…C ξ} a la que pertenece el objeto.

k

y, r es el grado de certeza de la clasificación en la clase C j para un objeto que pertenece

al subespacio difuso definido por el antecedente de la regla.

Base de Datos. La Base de Datos (BD) contiene la definición de los conjuntos difusos

asociados a los términos lingüísticos usados en la BR. Esta transformación es común para todas

las reglas en la BR para mantener la naturaleza lingüística de los SCBRD.

Método de Razonamiento Difuso. En [137] se define un Método de Razonamiento Difuso

(MRD) como un procesamiento de inferencia, que deriva conclusiones a partir de un conjunto de

reglas difusas y un objeto. El uso de un método de razonamiento que combine la información de

las reglas disparadas por el objeto a ser clasificado, puede mejorar la capacidad de generalización

del Sistema de Clasificación.

Un modelo de razonamiento general lo podemos describir en la siguiente forma [138]:

En la clasificación de un objeto Et = (xt1,…., xtk), la base de reglas R = {R1,….,RL} está dividido en ξ

subconjuntos de acuerdo con la clase indicada por su consecuente, R = R C1 U RC2 U….U RCξ.

Y siguiendo el esquema siguiente:

1. Grado de Compatibilidad. El grado de compatibilidad del antecedente con el objeto se

calcula para todas las reglas en la BR, aplicando una t-norma [120], [127], sobre el grado

de pertenencia de los valores del individuo (eti) a los correspondientes subconjuntos

difusos.

k

k

Rk(Et) = T(µA 1(et1),…, µA n(etn)), k = 1,…,L

2. Grado de Asociación. El grado de asociación del objeto Et con las ξ clases se calcula de

acuerdo a cada regla en la BR.