03-Estudios de Casos MGPP 2012 - U

Anuncio

UNIVERSIDAD DE CHILE

MAGISTER EN GESTION Y POLITICAS

PÚBLICAS

ESTADÍSTICA APLICADA Y

ECONOMETRÍA

APLICACIONES DE SPSS

Profesora

: Sara Arancibia C.

Profesora Auxiliar: Carlos Andrade G

Primer Semestre 2012

1

FORMULAS PARA TRIUNFAR

LA FORMULA BÁSICA. Los investigadores se han dedicado a averiguar cuál ha sido la idea, el

secreto que ha llevado al triunfo a los grandes personajes de la historia. Y han encontrado una

fórmula que todos los triunfadores practicaron, y sin la cual no habrían llegado a ser grandes

ni famosos. Esta fórmula consiste en los siguientes cinco puntos:

a) Dirigir el pensamiento hacia una meta fija que se desea conseguir. Saber bien cuál es

esa meta que se desea alcanzar y no desviar la atención de ella.

b) Elaborar un plan para lograr conseguir esa meta, un plan cuidadoso y detallado que se

va siguiendo día por día, y que hace que nuestra actividad sea organizada y llena de

entusiasmo.

c) Desarrollar un sincero deseo de realizar aquello que se desea conseguir. El deseo

ardiente es el más importante motivador de las acciones. El deseo de lograr éxitos

consigue la costumbre de conseguir éxitos.

d) Adquirir una confianza grande en sí mismo; confianza en las propias capacidades y

habilidades para lograr el éxito, concediéndole muchísima mayor importancia a las

cualidades positivas que se tiene que a las debilidades o a las posibilidades de derrota.

e) Dedicarse a una acción tenaz e incansable para lograr obtener la meta que se busca

conseguir, sin desanimarse por los obstáculos, las críticas, las circunstancias adversas, o

lo negativo que los demás piensen, hagan o digan. Esa energía concentrada hacia la

consecución de una meta, trae enormemente las oportunidades, las cuales no se dejan

atrapar por los que están sin hacer nada, pero se acercan generosamente a quienes se

atreven a atacar, a trabajar fuertemente por conseguir el éxito.

Esta fórmula básica Meyer la llamó “El plan del éxito personal a base de automotivación”,

para desarrollar al máximo el potencial de cada uno.

Meyer resume la fórmula básica en la siguiente frase:

“Todo lo bueno que: vivamente imaginamos, ardientemente deseamos, sinceramente

creamos, y entusiastamente emprendamos, de una manera impresionantemente

favorable se transformará en algo placentero y beneficioso para nosotros”

(Eliécer Salesman. “100 Fórmulas para llegar al éxito”)

Si una de tus metas es APRENDER aplica esta fórmula y “comienza con la mente abierta”.

La cualidad más importante que afectará tu éxito en el curso es tu ACTITUD. Ésta

determinará lo que estés dispuesto a hacer en el curso, y la calidad de ese esfuerzo

contribuirá de la manera más significativa a tu éxito.

2

Contenido

I

II

Análisis Inicial de los datos y repaso de herramientas de SPSS.

ANOVA de un factor.

Caso EnfermerasCaso Premio colegios ( SIMCE)

III

Análisis de regresión simple y modelos lin-log y log-lin

IV

Análisis de regresión múltiple

V

VI

VII

Modelos de regresión múltiple con variables cualitativas (dummy)

Análisis de regresión logística

Análisis factorial

3

I

Análisis Inicial de los datos

Cuando nos enfrentamos por primera vez a la realización de un análisis estadístico la máxima

preocupación es profundizar en la técnica estadística seleccionada, sin .embargo, existe una

etapa previa incluso más compleja y esencial que consiste en realizar un examen exhaustivo de los

datos recabados.

La depuración de los datos o detección de problemas ocultos en los datos supondrá un gran

avance en la consecución de resultados lógicos consistentes. Dichos problemas se pueden

subsanar comenzando por una inspección visual de las representaciones gráficas de los datos,

completándose con un análisis de datos ausentes o perdidos y de los casos atípicos (conocidos

bajo la denominación de outliers) y finalizando con la comprobación de que se cumplen ciertas

hipótesis de partida: en el caso de análisis multivariable nos referimos a; normalidad, linealidad y

homocedasticidad, supuestos subyacentes en todos los métodos multivariantes.

Representaciones gráficas para el análisis de datos

La difusión experimentada en los últimos años por los programas estadísticos ha facilitando la

incorporación de módulos específicamente diseñados para la inspección gráfica de los datos.

El estudio de cada variable es fundamental para conocer sus características y comprobar si es

oportuna y relevante su inclusión en el análisis. Para ello se aconseja observar la forma de su

distribución. Esto se consigue mediante el histograma, que representa gráficamente los datos

mostrando en barras la frecuencia de los casos en cada variable. Si a su vez se pretende evaluar

la normalidad de la variable, se efectuará superponiendo la curva normal sobre la distribución o

realizando gráficos P-P o Q-Q.

Mediante el gráfico de dispersión se podrá examinar la relación entre dos o más variables. Se

trata de un gráfico de puntos de datos basados en dos variables, representadas una en el eje

horizontal y la otra en el vertical. El posicionamiento de los puntos a lo largo de una línea recta se

debe a la existencia de correlación lineal. Si los puntos siguen distintas formas la relación no

podrá calificarse de lineal. La inexistencia de relación se podrá constatar si la nube de puntos es

aleatoria y dispersa. ( Mediante correlaciones bivariadas Pearson se podrá determinar mediante

una prueba de hipótesis si la correlación entre dos variables de escala es significativa).

Mediante el gráfico de cajas o boxplot se puede llevar a cabo un análisis de las diferencias entre

grupos, si lo que se pretende es apreciar la existencia de dos o más grupos en una variable

métrica, como ocurre en el análisis discriminante o en el análisis de la varianza. Este gráfico

distribuye los datos de tal forma que los límites superior e inferior de la caja marcan los

cuartiles superior e inferior. La longitud de la caja es la distancia entre el primer y tercer

cuartil; así, la caja contiene el 50 por ciento de los datos centrales de la distribución. La mediana

se representa mediante una línea dentro de la caja. Existirá asimetría si la mediana se aproxima

al final de la caja. El tamaño de la caja dependerá de la distancia entre las observaciones.

También se representa la distancia entre la mayor y la menor de las observaciones mediante unas

líneas que salen de la caja denominadas bigotes. En este tipo de gráfico los casos atípicos se

pueden detectar por estar situados entre 1,0 Y 1,5 cuartiles fuera de la caja.

4

Diagrama de caja simple: Contiene un único diagrama de caja para cada categoría o variable del

eje de categorías. Los diagramas de caja muestran la mediana, los cuartiles y los valores

extremos para la categoría o variable.

Diagrama de caja agrupado: Tipo de gráfico en el que un grupo de diagramas de caja representa

cada categoría o variable del eje de categorías. Los diagramas de caja dentro de cada agrupación

vienen definidos por una variable de definición distinta.

Años de escolarización por raza

899

634

20

Número de años de escolarización

718

15

10

691

5

1.366

702

244

693

620

688

596

765

1.476

735

0

Blanca

Negra

Otra

Raza del encuestado

Años de escolarización por raza agrupados por sexo

20

961

Número de años de escolarización

634

Sexo del encuestado

718

Mujer

Hombre

960

15

10

1.404

804

244

5

621

620

596

1.448

693

695

688

765

821

735

0

Blanca

Negra

Otra

Raza del encuestado

5

Detección de variables con categorías mal codificadas

En muchos archivos de datos se detectan problemas en variables nominales con categorías en

formato cadena sin un código asociado. Para detectar este problema es aconsejable realizar

tablas de frecuencia de las variables y observar si las categorías presentan errores de digitación,

como por ejemplo la variable sexo podría presentar problemas si las categorías están mal

digitadas; Hombre, HOMBRE, hombre representan a la misma categoría, sin embargo en una tabla

de frecuencia aparecerán como categorías diferentes. Para solucionar este problema se

recomienda recodificar automáticamente asignándole a las categorías de la variable un código

numérico y luego con recodificar en distinta variable asignar correctamente los códigos.

Análisis de datos ausentes

En este proceso de depuración de datos (anterior a la utilización de los métodos multivariables)

el analista debe ser consciente de que se enfrenta a una información que puede no existir en

determinadas observaciones y variables. Esto es lo que conocemos por datos ausentes o missing

values. El porqué de la existencia de datos ausentes puede deberse a distintas razones como

errores al codificar los datos e introducirlos en el computador, fallas del encuestador al

completar el cuestionario, negación del encuestado a responder ciertas preguntas calificadas de

controvertidas… Razones comunes y muy habituales en todo proceso investigador.

El problema de estos errores es el gran perjuicio que la inexistencia de datos ocasiona en los

resultados y sus efectos en el tamaño de la muestra disponible para el análisis, dado que esta

ausencia puede convertir lo que era una muestra adecuada en inadecuada. Por ello es necesario

depurar esos casos y buscar soluciones. Si se puede suponer que los fundamentos teóricos de la

investigación no se alteran sustancialmente, una opción sería suprimir aquellas variables y/o casos

que peor se comportan respecto a los datos ausentes. En este caso el investigador deberá

sopesar lo que gana con la exclusión de esta información y lo que pierde al no contar

posteriormente en el análisis multivariante con la misma. Mediante este proceder se asegura de

que su matriz de datos está completa y posee observaciones válidas.

Otra posibilidad sería la estimación de valores ausentes empleando relaciones conocidas entre

valores válidos de otras variables y/o casos de la muestra. Por tanto, se trataría de imputar o

sustituir los datos ausentes por valores estimados (bien sea la media o un valor constante) en

base a otra información existente en la muestra.

Un porcentaje bajo de valores missing no es un problema que influya decisivamente en los

resultados. Por el contrario, la falta reiterada de respuesta puede alterar seriamente el análisis.

No existe una estimación respecto al porcentaje de missing que produce dificultades en una

muestra determinada.

Según Tabachnik y Fidell (1983) más importante que el número de valores missing es la

existencia de un patrón de comportamiento en éstos. En efecto, la presencia de missing que se

distribuyen aleatoriamente no produce sesgos, sin embargo, la falta de respuesta sistemática

asociada a ciertas variables puede generar distorsión en los resultados.

La existencia de datos ausentes nunca debe impedir la aplicación del análisis multivariable o

limitar la posibilidad de generalizar los resultados de una investigación. La principal tarea del

analista consistirá en identificar su presencia, y desempeñar las acciones necesarias para

minimizar sus efectos.

En datos correspondientes a encuestas es habitual encontrar códigos como los siguientes.

7= No procede, 8= No sabe , 9= No contesta

6

97= No procede, 98= No sabe, 99= No contesta

997= No procede, 998= No sabe, 999= No contesta

Se utilizan estos códigos cuando no son parte de los posibles datos de la variable.

El SPSS tiene un menú especial para tratar los valores perdidos.

El SPSS hace diferencia para los valores perdidos por el usuario y valores perdidos por el

sistema.

Detección de outliers

Al examinar los datos recabados después de un proceso muestral el investigador puede detectar

la existencia de ciertas observaciones que no siguen el mismo comportamiento del resto,

enfrentándose de este modo a ciertos casos que, por ser claramente diferentes de otras

observaciones de la muestra, son calificados como outliers o atípicos.

El objetivo ante esta situación es identificar esa diferencia sustancial entre el valor real de la

variable criterio y su valor previsto, puesto que da lugar a observaciones que no son

representaciones apropiadas de la población de la cual se extrae la muestra.

Los casos atípicos se deben a errores en el procedimiento, o lo que es lo mismo, a falta al

introducir los datos o al codificar. Pero también pueden ser consecuencia de un evento

extraordinario que hace destacar esa observación. Este acontecimiento anormal puede tener o

no una explicación. En cualquiera de estas situaciones, una vez que: los outliers el analista debe

juzgar qué es lo más apropiado: si evaluar toda la incluyendo estas perturbaciones o eliminadas

del análisis.

Estas decisiones han de justificarse, dado que determinados casos atípicos: aunque diferentes a

la mayor parte de la muestra, pueden contener información representativa de un segmento

dominante. No obstante, habrá situaciones donde lo más acertado sea su supresión porque pueden

distorsionar seriamente los tests estadísticos dados los problemas que presentan.

La detección de los casos atípicos desde una perspectiva univariable pasa por la observación de

aquellos casos que caigan fuera de los rangos de la distribución. Si lo que se pretende es evaluar

conjuntamente pares de variables se utilizará el gráfico de dispersión. Este método bivariable

permite identificar los casos atípicos al venir representado como puntos aislados. Por su parte, la

detección multivariable supone evaluar cada observación a lo largo de un conjunto de variables.

Esto se consigue mediante el uso de la Mahalanobis, puesto que es una medida de la distancia de

cada observación en un espacio multidimensional respecto del centro medio de las observaciones.

Cuando se descubren errores

Si se encuentran errores, el primer paso es regresar a la hoja de registro de datos o a los

cuestionarios. Los errores sencillos se pueden corregir; en algunos casos se pueden corregir

errores de un sujeto con base en sus respuestas a otras preguntas. Si no se puede hacer esto,

entonces se pueden codificar esos reactivos como valores perdidos y se excluirán de los análisis.

Es importante mencionar que la función Valores Perdidos de SPSS puede realizar esta tarea.

Otras herramientas muy útiles para limpiar los datos

7

Recodificar automáticamente:

El cuadro de diálogo Recodificación automática le permite convertir los valores numéricos y de

cadena en valores enteros consecutivos. Si los códigos de la categoría no son secuenciales, las

casillas vacías resultantes reducen el rendimiento e incrementan los requisitos de memoria de

muchos procedimientos. Además, algunos procedimientos no pueden utilizar variables de cadena y

otros requieren valores enteros consecutivos para los niveles de los factores.

La nueva variable, o variables, creadas por la recodificación automática conservan

todas las etiquetas de variable y de valor definidas de la variable antigua. Para los valores que no

tienen una etiqueta de valor ya definida se utiliza el valor original como etiqueta del valor

recodificado. Una tabla muestra los valores antiguos, los nuevos y las etiquetas de valor.

Los valores de cadena se recodifican por orden alfabético, con las mayúsculas

antes que las minúsculas.

Los valores perdidos se recodifican como valores perdidos mayores que cualquier

valor no perdido y conservando el orden. Por ejemplo, si la variable original posee 10 valores no

perdidos, el valor perdido mínimo se recodificará como 11, y el valor 11 será un valor perdido para

la nueva variable.

Recodificar en la misma variable /distinta variable

El cuadro de diálogo Recodificar en las mismas variables le permite reasignar los valores de las

variables existentes o agrupar rangos de valores existentes en nuevos valores. Por ejemplo,

podría agrupar los salarios en categorías que sean rangos de salarios.

El cuadro de diálogo Recodificar en distintas variables le permite reasignar los valores de las

variables existentes o agrupar rangos de valores existentes en nuevos valores para una variable

nueva.

Puede recodificar variables numéricas en variables de cadena y viceversa.

Si selecciona múltiples variables, todas deben ser del mismo tipo. No se

pueden recodificar juntas las variables numéricas y de cadena.

Una vez que se han limpiado los datos podemos pasar a la parte más interesante del proceso, el

análisis de datos.

Supuestos subyacentes en los métodos multivariables

Es lógico pensar que de una buena materia prima podremos obtener un buen producto; de igual

modo, de unos buenos datos obtendremos un buen análisis. En este proceso de depuración de la

información, el último eslabón consiste en comprobar que se cumplen ciertas hipótesis de partida,

puesto que asegurarán la consecución de un análisis multivariante óptimo. Estos análisis se

caracterizan por su gran complejidad al integrar y combinar numerosas variables que pueden

producir distorsiones y sesgos potenciales. Por ello es imprescindible que dentro de lo posible los

datos respeten ciertos supuestos.

8

Normalidad

La hipótesis de partida que debe cumplir cualquier análisis multivariable es la normalidad de los

datos. Por tanto, el investigador debería comenzar su análisis evaluando la normalidad de todas y

cada una de las variables que pasen a formar parte del estudio. Si este supuesto no se cumple, el

resto de tests estadísticos diferenciadores de cada técnica multivariable no serán válidos,

puesto que se requiere la normalidad para el uso de los estadísticos de la t y de la F.

La herramienta más simple que sirve para diagnosticar la normalidad es el histograma,

previamente explicado, mediante el cual se comparan los valores de los datos observados con la

distribución normal. Además de hacer esta comprobación visual, se pueden utilizar los tests de

asimetría y curtosis, disponibles en todos los programas en la parte de estadísticos descriptivos

básicos.

Señalar que en aquellas situaciones en las que las distribuciones sean no normales será necesaria

la realización de transformaciones de los datos.

La condición de distribución normal se puede referir a una variable en particular o a un conjunto

de variables. Para evaluar normalidad en una variable se estudia la forma de la distribución

mediante la prueba de Kolmogorov-Smirnov.

Evaluar distribución normal en un conjunto de variables simultáneamente no es fácil. En primer

término, la representación gráfica de más de tres variables en un plano es prácticamente

imposible. En segundo lugar, condición necesaria de normalidad multivariable es que cada variable

se distribuya normalmente, sin embargo, no es condición suficiente. En efecto, que cada variable

separada se distribuya según la ley normal no implica que todas juntas 10 hagan.

En la literatura se presentan diversas pruebas elaboradas para verificar normalidad

multivariable. No obstante, los paquetes de procesamiento de información no han incorporado

tales pruebas. En la práctica el estudio de cada variable por .separado es la única manera de

examinar limitadamente esta materia. Para estos efectos se utilizan diversos gráficos.

Linealidad

Nuevamente y con la intención de resolver problemas potenciales antes de comenzar con el

análisis multivariable conviene examinar si las relaciones entre las variables que intervienen en el

estudio son lineales. La linealidad indica que el modelo a contrastar predice los valores de la

variable(s) dependiente(s) siempre que se produzca una modificación en las variables

independientes. Técnicas estadísticas como la regresión múltiple, el análisis factorial o los

sistemas de ecuaciones estructurales se basan en medidas de correlación. Esto significa que es

condición necesaria la existencia de asociaciones lineales entre variables para obtener

coeficientes de correlación que las representen y ejecutar los modelos utilizando estas técnicas.

La relación lineal entre dos variables se representa a través de una línea recta; por tanto, para

comprobar que este supuesto se cumple basta con analizar los gráficos de dispersión de las

variables e intentar identificar si los datos siguen ese trazado lineal. Otra opción es examinar los

residuos después de efectuar un análisis de regresión múltiple (como se verá en el Capítulo 7),

9

dado que éstos reflejan la parte no explicada de la variable dependiente, o lo que es lo mismo, la

parte no lineal de la relación.

En aquellos casos en que la consecución de los datos sea no lineal se debe optar por transformar

una o ambas variables para conseguir la linealidad. Un procedimiento válido es efectuar

transformaciones mediante la utilización de la raíz cuadrada, o bien crear una nueva variable,

denominada polinómica, que represente la parte no lineal de la relación.

Homocedasticidad

La homocedasticidad es el último supuesto que deben cumplir los datos antes de iniciar su

tratamiento multidimensional. Concretamente, se verifica esta hipótesis cuando la varianza de los

errores es constante. Es decir, la variación de la variable dependiente que se intenta explicar a

través de las variables independientes -finalidad de técnicas como la regresión múltiple-, no se

concentra en un pequeño grupo de valores independientes. El objetivo es conseguir una dispersión

por igual de la varianza de la variable dependiente a lo largo del rango de los valores de la

variable independiente. En aquellos casos en que este supuesto no se cumpla estaremos ante una

perturbación conocida como heterocedasticidad. Técnicamente suele deberse a muestras en las

que aparecen asimetrías importantes en los valores de las variables porque toman valores

anormalmente altos o bajos respecto a la media.

Se puede comprobar la existencia de homocedasticidad gráficamente, observando que no hay

ningún punto que se aleje mucho del resto. Si, por el contrario, se constatan observaciones

extremas habrá que convertir esas variables en variables especiales que se llaman dummy o

ficticias. Esta transformación de los datos de las variables hace que todos los valores tengan un

efecto potencialmente igual en la predicción.

De forma complementaria, todos los paquetes estadísticos vienen provistos de tests estadísticos

de homocedasticidad, como el test de Levene y el test M de Box, ambos usados para evaluar si la

varianza de la variable dependiente permanece constante.

El supuesto de homocedasticidad dice relación con la dispersión de los datos. En particular, con

la igualdad de varianzas en todos los grupos de la población origen de la muestra. La

homocedasticidad multivariable se evalúa en la matriz de varianzas y covarianzas.

Cabe destacar que en el contexto multivariable medir relación entre pares de variables da lugar

a una matriz de correlaciones que presenta la relación de todos los pares de variables. Para que

los resultados sean fiables las matrices no deben ser singulares ni multicolineales.

Existe multicolinealidad en una matriz de correlaciones cuando los coeficientes asumen valores

extremadamente altos. La presencia de multicolinealidad es indicadora de relación intensa entre

pares de variables. El determinante de matrices con multicolinealidad es próximo a cero. Existe

singularidad cuando el determinante de una matriz es cero.

El valor del determinante debe ser distinto de cero para calcular la inversa de una matriz. El

cálculo de la inversa es necesario para efectuar el equivalente entre matrices a la división entre

números. Una matriz con determinante cero o próximo a cero no permite el cálculo de su inversa

-o un cálculo fiable de ésta. En consecuencia, no es posible efectuar el proceso matricial

equivalente a la división.

10

Diversas estrategias son posibles de implementar para resolver la presencia de multicolinealidad

o singularidad. El procedimiento más simple es borrar la variable que produce el problema.

Solución legítima dado que la presencia de una variable correlacionada con otra u otras indica que

ésta es combinación lineal de las demás y, en consecuencia, su eliminación no significa pérdida de

información. Otro procedimiento es ingresar en forma sucesiva las variables a analizar de modo

que no participen en el modelo variables correlacionadas con otras previamente incluidas.

Respecto a las condiciones de aplicación, más importante que evaluar su cumplimiento, es saber

en cada técnica específica cuáles son los efectos que genera la violación de los supuestos. En

opinión de Harris (1975) las técnicas multivariables no se ven seriamente afectadas cuando se

violan los supuestos en muestras suficientemente grandes. En tal caso, son procedimientos

resistentes y robustos. Resistentes a la presencia de valores extremos y robustos ante distribuciones distintas a la ley normal.

Bibliografía:

Análisis Estadístico Multivariable de Manuel Vivanco. Editorial Universitaria

Análisis Multivariable para las Ciencias Sociales de Lévy. Editorial Pearson

Introducción a la Econometría de Jeffrey Wooldridge. Editorial Thomson

Repaso de herramientas de SPSS

Considere el archivo “consumo de agua potable.sav” correspondiente a una muestra aleatoria de

hogares de la región Metropolitana que contiene el consumo de agua potable del mes de Enero del

2005. Considere además el archivo Ingresos hogares.sav correspondientes al ingreso familiar del

hogar de los mismos hogares de la muestra considerada para el consumo de agua potable.

Prepare un informe para un ejecutivo que necesita la siguiente información respecto al consumo

de agua del mes de Enero de los hogares de la base de datos con sus respectivos ingresos.

Suponga que se ha realizado la verificación de los datos. Responda las siguientes preguntas:”

a) Crear una variable que indique el gasto en agua potable de cada hogar, sabiendo que el

gasto depende del límite de sobreconsumo (LSC= 60 m3).

El valor del m3 de agua es $270 si el consumo es menor o igual al límite de sobreconsumo

(LSC=60m3)

Para los metros cúbicos de agua que excede al LSC el valor por m 3 es $560.

Mostrar la sintaxis correspondiente.

b) Mostrar una tabla que contenga el número de casos, la media, mediana, desv. estándar del

gasto en agua potable y de los ingresos de los hogares para las comunas de Cerrillos (1), El

Bosque (4) y Providencia (22). Muestre la sintaxis de todo el procedimiento.

c) Crear una variable “rangconsu” que considere los hogares con sobreconsumo

(consumo>60), con consumo normal (20<consumo<=60) y bajo consumo (consumo<=20).

Mostrar la sintaxis correspondiente.

d) Crear una tabla que muestre el número de comunas y porcentaje respecto al total de

hogares con ingresos menores o iguales a $500. 000 y mayores a $500.000 versus rango

de consumo.

11

e) Crear un archivo que muestre por comuna y por rangos de consumo (sobreconsumo, normal

y bajo) el promedio de los gastos de agua potable y el promedio del ingreso de hogares.

Muestre la sintaxis del procedimiento e identifique las comunas con mayor promedio de

gastos por rangos de consumo.

f) Determine mediante un gráfico si las variables gasto e ingreso siguen una tendencia lineal

REPASO PRUEBAS DE HIPOTESIS

Prueba T- Kolmogorov Smirnov- Levene

g)

Determine si existen diferencias significativas del gasto promedio en agua potable para

las comunas Vitacura (32) y Las Condes (13). Mostrar las tablas y argumentar su respuesta.

h)

Determine si las variables Ingreso, habitantes , gasto consumo se siguen una distribución

normal.

Solución:

a)

Crear una variable que indique el gasto en agua potable de cada hogar, sabiendo que el

gasto depende del límite de sobreconsumo (LSC= 60 m3).

El valor del m3 de agua es $270 si el consumo es menor o igual al límite de sobreconsumo

(LSC=60m3)

Para los metros cúbicos de agua que excede al LSC el valor por m 3 es $560.

Mostrar la sintaxis correspondiente.

IF (consumo <= 60) gasto = 270 * consumo .

VARIABLE LABELS gasto 'gasto consumo de agua potable' .

EXECUTE .

IF (consumo > 60) gasto = 270 * 60+560 * (consumo - 60) .

VARIABLE LABELS gasto 'gasto consumo de agua potable' .

EXECUTE .

b)

Mostrar una tabla que contenga el número de casos, la media, mediana, desv. estándar del

gasto en agua potable y de los ingresos de los hogares para las comunas de Cerrillos (1), El Bosque

(4) y Providencia (22). Muestre la sintaxis de todo el procedimiento.

Ordenar en forma ascendente la variable clave. Fundir archivos y luego

Seleccionar comparar media/ medias y hacer tabla seleccionando las tres comunas solicitadas.

12

Para archivo consumo de agua potable

SORT CASES BY

id_hogar (A) .

Informe

Comuna donde se

enc uentra el hogar

CERRILLOS

EL B OSQUE

PROVIDENCIA

Total

N

Media

Mediana

Des v. típ.

N

Media

Mediana

Des v. típ.

N

Media

Mediana

Des v. típ.

N

Media

Mediana

Des v. típ.

gas to en

consumo de

agua potable

31

47854,1806

21240,0000

49861,12054

33

48226,1576

28116,8000

48102,31021

16

72221,1750

51771,2000

61026,33408

831

50438,9338

32440,0000

47495,05844

Ingreso

del hogar

31

494340,11

285355,32

420754,9

33

498187,25

328828,24

393996,4

16

709947,18

536311,29

516956,7

831

526677,52

387124,20

382120,2

Para archivo Ingresos hogares

SORT CASES BY

id_hogar (A) .

A partir del archivo Consumo agua potable

MATCH FILES /FILE=*

/FILE='D:\AIE 2005\Solemnes \Ingreso hogares.sav'

/BY id_hogar.

EXECUTE.

MEANS

TABLES=gasto ingreso BY comu

/CELLS COUNT MEAN MEDIAN STDDEV

Otra forma : Hacer un cubo OLAP

USE ALL.

COMPUTE filter_$=(comu = 1 | comu = 4 | comu = 22).

VARIABLE LABEL filter_$ 'comu = 1 | comu = 24 | comu = 22 (FILTER)'.

VALUE LABELS filter_$ 0 'No seleccionado' 1 'Seleccionado'.

FORMAT filter_$ (f1.0).

Cubos OLAP

FILTER BY filter_$.

Comuna donde se

gast o en consumo

EXECUTE .

encuentra el hogar

CERRILLOS

OLAP CUBES

gasto ingreso BY comu

/CELLS=COUNT MEAN MEDIAN STDDEV

/TITLE='Cubos OLAP'.

EL BOSQUE

PROVIDENCIA

Total

N

Media

Mediana

Des v. típ.

N

Media

Mediana

Des v. típ.

N

Media

Mediana

Des v. típ.

N

Media

Mediana

Des v. típ.

de agua pot able

31

47854,1806

21240,0000

49861,12054

33

48226,1576

28116,8000

48102,31021

16

72221,1750

51771,2000

61026,33408

80

52881,0200

27198,4000

51799,61604

Ingreso del hogar

31

494340,11

285355,32

420754,873

33

498187,25

328828,24

393996,449

16

709947,18

536311,29

516956,682

80

539048,47

341093,04

433874,646

13

c)

Crear una variable “rangconsu” que considere los hogares con sobreconsumo

(consumo>60), con consumo normal (20<consumo<=60) y bajo consumo (consumo<=20). Mostrar la

sintaxis correspondiente

RECODE

consumo

(Lowest thru 20=1) (20.001 thru 60=2) (60.001 thru Highest=3) INTO rangcons .

VARIABLE LABELS rangcons 'rangos de consumo'.

EXECUTE .

En def de variables

1= bajo consumo

2= consumo normal

3=sobreconsumo

d) Crear una tabla que muestre el número de comunas y porcentaje respecto al total de

hogares con ingresos menores o iguales a $500. 000 y mayores a $500.000 versus rango

de consumo.

RECODE

ingreso

(Lowest thru 500000=1) (500000.01 thru Highest=2) INTO raningreso .

VARIABLE LABELS raningreso 'rangos de ingresos'.

EXECUTE .

Tabla de contingencia rango de consumo * rangos de ingresos

rango de

consumo

hasta 20

20,001 a 60

mayor a 60

Total

Recuento

% del total

Recuento

% del total

Recuento

% del total

Recuento

% del total

rangos de ingresos

hasta

mayor a

500.000

500.000

21

1

2,5%

,1%

225

1

27,1%

,1%

245

338

29,5%

40,7%

491

340

59,1%

40,9%

Total

22

2,6%

226

27,2%

583

70,2%

831

100,0%

e)

Crear un archivo que muestre por comuna y por rangos de consumo (sobreconsumo, normal

y bajo) el promedio de los gastos de agua potable y el promedio del ingreso de hogares. Muestre

la sintaxis del procedimiento e identifique las comunas con mayor promedio de gastos por rangos

de consumo.

AGGREGATE

/OUTFILE='D:\AIE 2005\Solemnes 1 2005-1\AGR comu gastos ingresos.sav'

/BREAK=comu rangcons

/gasto_mean = MEAN(gasto) /ingreso_mean = MEAN(ingreso) .

EXAMINE

VARIABLES=gasto_mean BY rangcons /ID= comu

/PLOT BOXPLOT STEMLEAF

14

/COMPARE GROUP

/STATISTICS EXTREME

/MISSING LISTWISE

/NOTOTAL.

Val ores ex tremos

gas to_mean

May ores

rangos de c onsumo

Bajo consumo

Consumo normal

Sobreconsumo

i)

1

2

3

4

5

1

2

3

4

5

1

2

3

4

5

Número

del caso

42

28

73

76

45

43

57

32

26

71

81

58

62

35

16

Comuna donde se

enc uentra el hogar

MACUL

LA REINA

SAN MIGUEL

SAN RAMON

MAIPU

MACUL

PROVIDENCIA

LAS CONDES

LA P INTANA

SAN JOAQUIN

VITA CURA

PROVIDENCIA

QUILICURA

LO BARNE CHEA

HUE CHURABA

Valor

5313,60

5248,80

5227,20

5216,40

5184,00

15390,00

14382,00

14040,00

13543,20

12957,69

95301,87

92287,20

88189,65

87406,61

82689,42

Determine mediante un gráfico si las variables gasto e ingreso siguen una tendencia lineal

15

PRUEBAS DE HIPOTESIS

f)

Determine si existen diferencias significativas del gasto promedio en agua potable para

las comunas Vitacura (32) y Las Condes (13). Mostrar las tablas y argumentar su respuesta.

Esta dísticos de grupo

gas to en consumo

de agua potable

Comuna donde se

enc uentra el hogar

LAS CONDES

VITACURA

N

47

30

Media

74515,74

95301,87

Des viación

típ.

58634,62025

98739,12261

Error típ. de

la media

8552,73838

18027,2149

Prueba de muestras independi entes

Prueba de Levene

para la igualdad de

varianzas

F

gast o en consumo

de agua pot able

Se han asumido

varianzas iguales

No s e han asumido

varianzas iguales

Sig.

,988

Prueba T para la igualdad de medias

t

,324

gl

Sig. (bilateral)

Diferencia

de medias

Error típ. de

la diferencia

95% Intervalo de

confianza para la

diferencia

Inferior

Superior

-1,160

75

,250

-20786,122

17917,04140

-56478,7

14906,45

-1,042

42,177

,303

-20786,122

19953,19051

-61048,3

19476,03

La significancia obtenida para la prueba de Levene es superior a 0,05 lo que indica con un 95% de

confianza que no hay evidencias que permitan descartar la hipótesis de que las varianzas son

iguales. De esta forma nos debemos fijar en la primera línea de la tabla de la prueba T para la

igualdad de medias.

En esta tabla nos encontramos con una significancia superior a 0,05 lo que indica con un 95% de

confianza que no hay evidencias que permitan descartar la hipótesis de que las medias son iguales.

Esto también se puede observar del intervalo de confianza al 95% para la diferencia entre las

medias. El intervalo contiene el valor cero lo que indica que no hay evidencia que permita

descartar que la diferencia entre las medias sea cero, ie., que las medias son iguales.

j)

Determine si las variables Ingreso, habitantes , gasto consumo se siguen una distribución

normal.

Según la prueba de K-S las variables no siguen una distribución normal, dado que se rechaza la

hipótesis de normalidad

Pruebas de norm alidad

a

Kolmogorov-Smirnov

Estadístico

gl

Sig.

N° de Habitantes

del Hogar

Consumo de

Agua Potable

Ingreso del hogar

Estadístico

Shapiro-Wilk

gl

Sig.

,140

831

,000

,934

831

,000

,181

831

,000

,849

831

,000

,150

831

,000

,873

831

,000

a. Corrección de la s ignificación de Lilliefors

16

17

II

Análisis ANOVA de un factor

Estudio de Caso: Satisfacción Laboral de Enfermeras.

A la Asociación Nacional de Salud de Saludlandia le preocupa la escasez de enfermeras que

parece estarse previendo para el futuro. Para investigar el grado actual de satisfacción con la

profesión entre las enfermeras, se ha patrocinado un estudio en hospitales por todo Saludlandia.

Como parte de este estudio, se pidió a 50 enfermeras que indicaran su grado de satisfacción en

el trabajo, en el sueldo y en las oportunidades de ascenso. Cada uno de los tres aspectos de

satisfacción fue medido en una escala de 0 a 100, y los mayores valores representan mayores

niveles de satisfacción.

Los datos de la muestra se clasificaron según el tipo de hospital de las enfermeras. Los tipos

fueron privados, geriátricos y universitarios. Para obtener los datos bajar el archivo

ENFERMERAS.SAV .

Responder las siguientes preguntas respaldando sus respuestas con las tablas y gráficas de SPSS

que considere convenientes.

a) Muestre un gráfico que permita visualizar el grado de satisfacción de las enfermeras

según tipo de hospital. Comente.

f) Con base en las tres variables de satisfacción laboral (sin considerar el tipo de hospital)

¿qué aspecto laboral satisface más a las enfermeras? ¿Cuál parece ser el que menos las

satisface? ¿En que áreas, si es que las hay, siente usted que deben introducirse

mejoras? Argumente con los estadísticos descriptivos y diagrama de tallo y hojas.

Describa sus razonamientos.

g) Determine un intervalo de confianza del 95% para la media de cada uno de los

indicadores de satisfacción laboral para la población de enfermeras. Interprete.

(Muestre una tabla con media, intervalos de confianza, y la media recortada al 5%)

h) Para la variable satisfacción con el trabajo. Determine si existen diferencias

significativas entre las medias de los tres grupos de tipo de hospital; privados,

geriátricos y universitarios.

i) Para la variable satisfacción con el sueldo. Determine si existen diferencias

significativas entre las medias de los tres grupos de tipo de hospital; privados,

geriátricos y universitarios

j) Determine si existe correlación significativa entre los indicadores de satisfacción

laboral. Argumente su respuesta.

k) Determine si las variables de satisfacción; con el trabajo, con el sueldo, y con

oportunidades de ascenso siguen una distribución normal. Argumente su respuesta.

18

Solución:

l) El gráfico agrupado muestra la media de los indicadores de satisfacción laboral de

las enfermeras consideradas en el estudio por tipo de hospital. Las enfermeras de

los tres tipos de hospital muestran un alto promedio en satisfacción con su trabajo,

alcanzando un valor aproximado a 80%. En los hospitales privados se observa que el

indicador más bajo en promedio es la satisfacción con el sueldo 46% siendo además el

más bajo al comparar con hospitales geriátricos y universitarios (los que indican un

promedio 55% y 62% respectivamente). La satisfacción con oportunidades de

ascenso se observa similar en promedio entre los hospitales privados y geriátricos

(59 % en promedio) y algo menor para los hospitales universitarios ( 53% en

promedio)

Satisfacción laboral de enfermeras

por tipo de hospital

90

80

80

79

80

70

Satisfacción con el

trabajo (%)

60

62

59

59

55

Mean

50

Satisfacción con el

53

sueldo (%)

Satisfacción con

46

40

oportunidades de asc

privados

geriátricos

universitarios

Tipo Hospital

*** Gráficos Barras. Resúmenes para variables separables .

GRAPH

/BAR(GROUPED)=MEAN(sattraba) MEAN(satsalar) MEAN(satascen) BY tiphospi

/MISSING=LISTWISE REPORT.

m) Si consideramos los indicadores sin importar el tipo de hospital se puede apreciar que la

mayoría de las enfermeras muestran un alto nivel de satisfacción con el trabajo

alcanzando un promedio de 79,80 y una mediana de 82 que indica que el 50% de las

enfermeras tienen un nivel de satisfacción superior o igual a 82 con un mínimo 63. El

tallo y hojas muestra que 40 de 50 enfermeras tiene un nivel de satisfacción con el

trabajo entre 70 y 89. Seis enfermeras con un superior o igual a 90.

19

Esta dísticos

N

Media

Mediana

Des v. típ.

Rango

Mínimo

Máx imo

Perc entiles

Válidos

Perdidos

25

50

75

Satisfacción

con el trabajo

(%)

50

0

79,80

82,00

8,288

32

63

95

72,00

82,00

87,00

Satisfacción

con el sueldo

(%)

50

0

53,26

54,00

16,462

88

2

90

42,75

54,00

60,00

Satisfacción

con

oportunidad

es de

ascenso (% )

50

0

57,28

57,50

17,594

86

6

92

48,50

57,50

68,00

Satisfacción con el trabajo (%) Stem-and-Leaf Plot

Frequency

Stem & Leaf

2,00

6 . 34

2,00

6 . 59

14,00

7 . 01111222223444

6,00

7 . 567789

8,00

8 . 22244444

12,00

8 . 555667788899

5,00

9 . 00004

1,00

9. 5

Stem width:

Each leaf:

10

1 case(s)

La media para satisfacción con el sueldo muestra un nivel moderado de 53,26. El 25% de las

enfermeras

muestra un nivel bajo de satisfacción con el sueldo, hasta 42,5. La mitad de las enfermeras

muestra para este indicador un valor hasta 54. De las 50 enfermeras 28 muestran un nivel entre

51 y 80 observándose sólo 2 valores extremos altos desde 89.

20

Satisfacción con el sueldo (%) Stem-and-Leaf Plot

Frequency

Stem & Leaf

1,00 Extremes

,00

2.

3,00

,00

(=<2)

2 . 578

3.

6,00

3 . 667778

3,00

4 . 223

7,00

4 . 5778999

5,00

5 . 11233

9,00

5 . 566677999

5,00

6 . 00000

3,00

6 . 666

3,00

7 . 024

2,00

7 . 66

1,00

8. 0

2,00 Extremes

(>=89)

Respecto al indicador satisfacción con oportunidades de ascenso se observa levemente

superior al indicador de sueldo en media y mediana con valores

57,28 y 57,5

respectivamente. El tallo y hojas muestra 35 personas con niveles entre 51 y 86 y 2 con

niveles superiores a 90.

Satisfacción con oportunidades de ascenso (%) Stem-and-Leaf Plot

Frequency

Stem & Leaf

2,00 Extremes

(=<16)

2,00

2 . 39

2,00

3 . 77

7,00

4 . 0125679

14,00

5 . 11222444556789

12,00

6 . 122334467788

7,00

7 . 0224589

2,00

8 . 26

2,00

9 . 12

Stem width:

Each leaf:

10

1 case(s)

21

Se observa una mayor variabilidad en opinión entre las enfermeras en el indicador de

satisfacción con el sueldo con un rango 88 (diferencia entre el máximo y el mínimo ) y un

coeficiente de variación 30,9% ( ( 16,46/53,26)*100) el cual determina el grado de

dispersión de los datos relativo a su media .

Se recomienda estudiar estrategias para mejorar el área que tiene relación con el

sueldo. Por ejemplo bonos de incentivo según desempeño que mejoren el sueldo de las

enfermeras.

n) El intervalo de confianza para la media de satisfacción con el trabajo para la población

de enfermeras indica que con un 95% de confianza la media de satisfacción con el

trabajo estará entre 77,44 y 88,16.

Asimismo el intervalo de confianza para la media de satisfacción con el sueldo para la

población de enfermeras indica que con un 95% de confianza la media de satisfacción

con el sueldo estará entre 48,58 y 57,94.

El intervalo de confianza para la media de satisfacción con oportunidades de ascenso

para la población de enfermeras indica que con un 95% de confianza la media de

satisfacción con oportunidades de ascenso estará entre 52,28 y 62,28.

Descriptive s

Sati sfacción con

el trabajo (% )

Sati sfacción con

el sueldo (% )

Sati sfacción con

oportunidades de

ascenso (% )

Mean

95% Confidence

Interval for M ean

5% Trimmed Mean

Mean

95% Confidence

Interval for M ean

5% Trimmed Mean

Mean

95% Confidence

Interval for M ean

Lower Bound

Upper Bound

Stat istic

79,80

77,44

82,16

79,92

53,26

48,58

Lower Bound

Upper Bound

57,94

53,41

57,28

52,28

Lower Bound

Upper Bound

62,28

5% Trimmed Mean

57,88

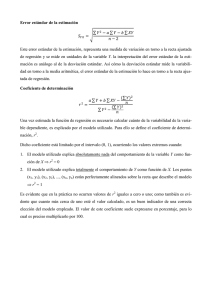

o) Para esta pregunta se realiza una prueba ANOVA donde H0: 1= 2=

3

Descriptivos

Satisfacción con el trabajo (%)

N

privados

geriátricos

universitarios

Total

19

17

14

50

Media

79,32

80,41

79,71

79,80

Des viación

típic a

8,035

9,702

7,269

8,288

Error típico

1,843

2,353

1,943

1,172

Intervalo de confianza para

la media al 95%

Límite

Límite inferior

superior

75,44

83,19

75,42

85,40

75,52

83,91

77,44

82,16

Mínimo

64

63

69

63

Máx imo

90

95

90

95

La prueba entrega los descriptivos básicos de la variable satisfacción con el trabajo

para la muestra por tipo de hospital

22

Prueba de homogeneida d de varianza s

Satisfacción con el trabajo (%)

Estadístico

de Levene

,796

gl1

gl2

2

47

Sig.

,457

Para la variable satisfacción en el trabajo, la prueba de homogeneidad de varianzas nos

permite no rechazar la hipótesis nula de igualdad de varianzas entre los tres tipos de

hospital .

ANOVA

Satisfacción con el trabajo (%)

Inter-grupos

Intra-grupos

Total

Suma de

cuadrados

10,920

3355,080

3366,000

Media

cuadrática

5,460

71,385

gl

2

47

49

F

,076

Sig.

,926

El nivel de significancia de la prueba ANOVA nos permite no rechazar la Ho de igualdad

de medias entre los tres tipos de hospital (Ho: 1= 2= 3 ). Por lo tanto, para la variable

satisfacción con el trabajo no existen diferencias significativas entre las medias de los

tres grupos de tipo de hospital; privados, geriátricos y universitarios.

Com paraciones m últiple s

Variable dependiente: Sat isfacción con el trabajo (%)

HSD de Tuk ey

(I) Tipo Hos pital

privados

(J) Tipo Hos pital

geriátricos

universitarios

privados

universitarios

privados

geriátricos

geriátricos

universitarios

Diferencia de

medias (I-J)

-1,10

-,40

1,10

,70

,40

-,70

Error típico

2,821

2,976

2,821

3,049

2,976

3,049

Sig.

,920

,990

,920

,972

,990

,972

Intervalo de confianza al

95%

Límite

Límite inferior

superior

-7,92

5,73

-7,60

6,80

-5,73

7,92

-6,68

8,08

-6,80

7,60

-8,08

6,68

La prueba de Tukey confirma lo dicho en la prueba ANOVA en la que no existen

diferencias significativas entre los grupos ( de a pares )

p) La prueba entrega los descriptivos básicos de la variable satisfacción con el sueldo para

la muestra por tipo de hospital

Descriptivos

Satisfacción con el sueldo (%)

N

privados

geriátricos

universitarios

Total

19

17

14

50

Media

45,79

54,65

61,71

53,26

Des viación

típic a

15,343

15,301

15,696

16,462

Error típico

3,520

3,711

4,195

2,328

Intervalo de confianza para

la media al 95%

Límite

Límite inferior

superior

38,39

53,18

46,78

62,51

52,65

70,78

48,58

57,94

Mínimo

2

27

36

2

Máx imo

66

76

90

90

Prueba de homogeneida d de varianza s

Satisfacción con el sueldo (%)

Estadístico

de Levene

,120

gl1

gl2

2

47

Sig.

,887

23

Para la variable satisfacción con el sueldo, la prueba de homogeneidad de varianzas nos

permite no rechazar la hipótesis nula de igualdad de varianzas entre los tres tipos de

hospital .

ANOVA

Satisfacción con el sueldo (%)

Inter-grupos

Intra-grupos

Total

Suma de

cuadrados

2093,723

11185,897

13279,620

gl

2

47

49

Media

cuadrática

1046,861

237, 998

F

4,399

Sig.

,018

El nivel de significancia de la prueba ANOVA nos permite rechazar la Ho de igualdad

de medias entre los tres tipos de hospital (Ho: 1= 2= 3 ) con un nivel de significancia

del 0.05 para la variable satisfacción con el sueldo. Por lo tanto existen diferencias

significativas entre las medias de los tres grupos de tipo de hospital; privados,

geriátricos y universitarios.

La prueba de Tukey nos muestra que existen diferencias significativas entre las medias

los hospitales privados y geriátricos y entre los geriátricos y universitarios, pero entre

los privados y universitarios no existen diferencias significativas

Com paraciones m últiple s

Variable dependiente: Sat isfacción con el sueldo (%)

HSD de Tuk ey

(I) Tipo Hos pital

privados

geriátricos

universitarios

(J) Tipo Hos pital

geriátricos

universitarios

privados

universitarios

privados

geriátricos

Diferencia de

medias (I-J)

Error típico

-8,86

5,150

-15, 92*

5,434

8,86

5,150

-7,07

5,568

15,92*

5,434

7,07

5,568

Intervalo de confianza al

95%

Límite

Límite inferior

superior

-21, 32

3,61

-29, 08

-2,77

-3,61

21,32

-20, 54

6,41

2,77

29,08

-6,41

20,54

Sig.

,209

,014

,209

,419

,014

,419

*. La diferencia entre las medias es signific ativa al nivel .05.

q) La matriz de correlaciones bivariadas nos muestra que los tres indicadores no se

correlacionan pues el nivel de significancia de cada uno de ellos es mayor que 0,05, por

lo tanto no se rechaza Ho que establece que no hay correlación entre las variables

Correlaciones

Satisfacción con

el trabajo (% )

Satisfacción con

el sueldo (% )

Satisfacción con

oportunidades de

ascenso (% )

Correlación de Pearson

Sig. (bilateral)

N

Correlación de Pearson

Sig. (bilateral)

N

Correlación de Pearson

Sig. (bilateral)

N

Satisfacción

con el trabajo

(%)

1

.

50

,141

,329

50

-,222

,122

Satisfacción

con el sueldo

(%)

,141

,329

50

1

.

50

,010

,946

Satisfacción

con

oportunidad

es de

ascenso (% )

-,222

,122

50

,010

,946

50

1

.

50

50

50

24

r) La prueba de Shapiro Wilk nos muestra que las variables satisfacción con el sueldo y

satisfacción con oportunidades de ascenso siguen una distribución normal pues el nivel

de significancia es mayor que 0,05 por tanto no se rechaza Ho que establece que la

distribución se ajusta a una curva normal, en cambio la variable satisfacción con el

trabajo no se ajusta a una distribución normal

Pruebas de norm alidad

a

Kolmogorov-Smirnov

Estadístico

gl

Sig.

Satisfacción con

el trabajo (% )

Satisfacción con

el s ueldo (% )

Satisfacción con

oportunidades de

asc enso (% )

Estadístico

Shapiro-Wilk

gl

Sig.

,154

50

,005

,950

50

,033

,121

50

,064

,976

50

,414

,101

50

,200*

,974

50

,339

*. Este es un límite inferior de la significac ión verdadera.

a. Corrección de la s ignificación de Lilliefors

Gráfico Q-Q normal de Satisfacción con el trabajo (%)

3

2

1

Normal esperado

0

-1

-2

-3

60

70

80

90

100

Valor observado

25

Gráfico Q-Q normal de Satisfacción con el sueldo (%)

3

2

1

Normal esperado

0

-1

-2

-3

0

20

40

60

80

100

Valor observado

Gráfico Q-Q normal de Satisfacción con oportunidades de ascenso (%)

3

2

1

Normal esperado

0

-1

-2

-3

0

20

40

60

80

100

Valor observado

26

Estudio de caso: Premio Colegios

1

Objetivo del caso:

Utilizar herramientas de análisis descriptivo e inferencial para conocer información útil de la

unidad de análisis, en este caso colegios y aplicar posibles criterios para asignar algún tipo de

beneficio por segmentos o grupos con perfiles similares.

Enunciado del caso:

Suponga que usted es un asesor del Ministerio de Educación y debe preparar un informe en

relación a los rendimientos de los estudiantes de enseñanza media del año 2006. Entre los

diversos informes que debe realizar se le ha pedido que sugiera qué colegios premiar con un

estímulo por los resultados de la prueba SIMCE de los segundos medios.

El SIMCE es el sistema nacional de medición de resultados de aprendizaje del Ministerio de

Educación de Chile. Su propósito principal es construir al mejoramiento de la calidad y equidad de

la educación, informando sobre el desempeño de los alumnos y alumnas en algunas áreas del

curriculum nacional y relacionándolos con el contexto escolar y social en el que ellos aprenden.

Las pruebas SIMCE evalúan el logro de los Objetivos Fundamentales y Contenidos Mínimos

Obligatorios del Marco Curricular en diferentes subsectores de aprendizaje, a través de una

prueba común que se aplica a nivel nacional, una vez al año, a los estudiantes que cursan un

determinado nivel educacional. Hasta el 2005 la aplicación de las pruebas se alternaron entre 4°

Básico, 8° Básico y 2° Medio. Desde el 2006, las pruebas evalúan todos los años el nivel del 4°

Básico y se alternan los niveles de 8° Básico y 2° Medio. (Fuente: Resultados nacionales SIMCE

2006. MINEDUC)

Se dispone de un archivo con los datos de los 2319 colegios evaluados en la prueba SIMCE 2°

Medio del 2006. Algunas de las variables de interés son:

VARIABLE

ETIQUETA DE VARIABLE

Idest

Identificador del establecimiento

Región

Nombre de la Región

Comuna

Nombre de la comuna

ddca

Dependencia

ETIQUETA DEVALOR

CP: Corporación Privada

MC; Corporación Municipal

MD; DAEM (Departamento de

Administración

de

Educación

Municipal)

PP: Particular Pagado

PS: Particular Subvencionado

1

TP

Caso elaborado por Sara Arancibia

P

27

ruralida

Caracterización del establecimiento

1= Rural

2=Urbano

socioeconómico

Grupo

socioeconómico

establecimiento

del

A Bajo

B Medio Bajo

C Medio

D Medio Alto

E Alto

prom_len

Promedio puntaje de lenguaje

prom_mat

Promedio puntaje de matemáticas

Después de múltiples reuniones con expertos en educación, usted ha llegado a definir junto con

los expertos un criterio para premiar a las escuelas; crear grupos homogéneos de escuelas y

definir puntajes de corte para cada grupo. De esta forma se estará distinguiendo a los colegios

que se destacan entre colegios con similares características. El premio se otorgará a los colegios

con puntajes promedios mayores o iguales al percentil 75 (para cada grupo).

Los grupos homogéneos se definieron en base a dos criterios: la dependencia del establecimiento

definido como Municipal, Privado y Subvencionado y la caracterización del establecimiento Rural

y Urbano

Los grupos homogéneos definidos por el grupo experto son,

1: Municipal y Rural

2: Municipal y Urbano

3: Privado y Rural

4: Privado y Urbano

5: Subvencionado y Rural

6: Subvencionado y Urbano

Usted como asesor del Ministerio de Educación debe aplicar los criterios definidos con los

expertos para crear los grupos de colegios homogéneos e identificar cuáles son los

establecimientos premiados realizando distintas comparaciones por dependencia, tipo y zona

(Norte, Central y Sur). Además debe determinar si existen diferencias significativas entre los

tipos de colegios y por dependencia

Para realizar su análisis deberá realizar las siguientes etapas:

1. Limpiar y ordenar la base de interés para el análisis

a)

Crear la variable “Dependencia” considerando sólo tres categorías:

Municipalizado, Privado y Subvencionado

b)

Crear la variable zona considerando Zona Norte, Centro y Sur

c)

Crear la variable “puntprom” correspondiente al puntaje promedio entre matemática y

lenguaje

28

d)

Crear la variable “grupo” correspondiente a cada grupo homogéneo. Para esto deberá

crear con sintaxis (sintaxisgrupo) la variable solicitada asignando los códigos 1 al 6 según

corresponda.

e)

Determinar para cada grupo el percentil 75.

f)

Con otra sintaxis (sintaxispremio) crear la variable “premio” donde según el criterio

mencionado 1=SI recibe premio y 0=NO recibe premio.

2. Realizar un análisis descriptivo de los datos

a)

¿Cuántos establecimientos rurales y urbanos existen en el archivo de datos y qué

porcentaje representan del total? ¿Qué tipo de dependencia se observa con mayor y

menor frecuencia? ¿Qué grupo homogéneo de establecimientos presenta mayor frecuencia?

b)

¿Cuántos colegios obtuvieron puntajes promedio en Matemáticas inferior o igual a 250

puntos; entre 251 y 300 puntos y superior a 300 puntos

c)

¿Qué porcentaje de colegios obtuvieron puntajes promedio en Lenguaje

superior

a

300 puntos? ¿Cuántos de ellos son Municipalizados y Urbanos?

¿Qué puede decir de los

Municipalizados y Rurales?

d)

¿Qué porcentaje representa el total de colegios premiados respecto al

total

de

colegios? ¿Qué porcentaje de los colegios Municipalizados resultaron

premiados?

¿Qué

porcentaje de los colegios premiados son

Subvencionados? ¿Qué porcentaje de los premiados

son de la zona Norte, Centro y Sur? ¿Qué porcentaje de la zona Centro son premiados? ¿Qué

porcentaje del total son premiados y del Sur?

e)

¿A qué zona pertenecen los cinco mayores puntajes promedios SIMCE por tipo rural y

urbana?. Realice un gráfico que permita observar la forma de la distribución de los

puntajes promedio SIMCE para los colegios rurales y los urbanos y muestre además un

diagrama de caja (boxplot) por tipo para el puntaje promedio ¿Qué puede observar?

f)

Determine mediante una gráfica si hay diferencias entre las medias de los puntajes en

lenguaje y en matemáticas por dependencia para el grupo de colegios en estudio. ¿Existen

diferencias en los puntajes de lenguaje por dependencia, agrupados por tipo rural y

urbano? Determine si el comportamiento de los resultados de puntajes de lenguaje y

matemáticas es similar si se compara los segmentos rural y urbano

g)

Determine los estadísticos básicos de tendencia central, de dispersión y de forma de la

distribución de los puntajes promedios SIMCE para los distintos grupos homogéneos, y

muestre gráficamente la media de los puntajes promedios SIMCE por grupo homogéneo.

h)

Realice un gráfico considerando a todos los colegios en estudio y otro gráfico

considerando sólo el segmento de premiados, que permitan observar la posición del grupo

en relación al resto de los grupos en cuanto a los descriptivos básicos. Interprete.

i)

Compare la variabilidad entre los distintos grupos para el puntaje promedio SIMCE.

3.

Realizar pruebas de hipótesis

Asuma que la base de datos corresponde a la población de todos los colegios que dieron la SIMCE

en el año 2006. Considere una muestra aleatoria de aproximadamente el 20% de los colegios

considerados y realice pruebas de hipótesis que permita responder las siguientes preguntas.

29

a)

¿Existen diferencias significativas entre los puntajes promedios de la

los colegios de tipo Rural y Urbano?

SIMCE entre

b)

¿Existen diferencias significativas entre los puntajes promedios de Matemáticas por

dependencia?

c)

¿Existen diferencias significativas entre los puntajes promedios de Lenguaje por

dependencia?

d)

Para cada grupo de dependencia, ¿Existen diferencias significativas entre los promedios

de lenguaje y matemáticas?

e)

¿Existe relación entre el grupo socioeconómico del establecimiento y la dependencia? Si

existe relación determine si la relación es alta, moderada o débil.

4. Concluir

a) Realice resumidamente un análisis descriptivo básico para los colegios premiados usando

medidas de tendencia central y medidas de dispersión.

b)

Sintetizar sus comentarios acerca de los vínculos que explica.

c) Sugiera otra alternativa para determinar cómo premiar a los colegios por su rendimiento en

la prueba SIMCE.

DESARROLLO:

1.

Limpiar y ordenar la base de interés para el análisis

a)

Crear la variable “Dependencia” considerando sólo tres categorías:

Municipalizado, Privado y Subvencionado

En primer lugar observamos que la variable de dependencia “ddcia” de la base de datos viene con

formato cadena o string. Recodificaremos automáticamente y luego llevaremos las cinco

categorías sólo a tres categorías.

Para esto ir al Menú: Transformar/ recodificación automática

AUTORECODE

VARIABLES=ddcia /INTO depend

/PRINT.

Old Value New Value Value Label

CP

MC

MD

PP

PS

1 Corporación Privada

2 Corporación Municipal

3 DAEM

4 Particular Pagado

5 Particular Subencionado

Para crear tres categorías juntaremos las categorías Corporación Municipal y DAEM en

Municipalizado y las categorías Corporación Privada y Particular pagado en Privado

Para esto ir al Menú: Transformar/Recodificar en distinta variable

30

RECODE

depend

(4=2) (5=3) (1=2) (2 thru 3=1) INTO dependencia .

VARIABLE LABELS dependencia 'Tipo de dependencia'.

EXECUTE .

En definición de la variable

Asignar etiquetas de valor a los códigos 1 al 3

1= Municipalizado

2=Privado

3=Subvencionado

b)

Crear la variable zona considerando Zona; Norte, Centro y Sur

En primer lugar se observa que la variable Región viene en formato de cadena. Se recodificará

automáticamente.

Menú: Transformar/Recodificación automática

AUTORECODE

VARIABLES=region /INTO reg

/PRINT

En el visor de resultados se puede observar los códigos de cada categoría

Old Value

New Value Value Label

Región de Aisén del General

Carlos Ibañez del Campo

Región de Antofagasta

Región de Atacama

Región de Coquimbo

Región de la Araucanía

Región de Los Lagos

Región de Magallanes y de la

Antártica Chilena

Región de Tarapacá

Región de Valparaíso

Región del Biobío

Región del Libertador General

Bernardo O' Higgins

Región del Maule

Región Metropolitana

1 Región de Aisén del General

1 Carlos Ibañez del Campo

2 Región de Antofagasta

3 Región de Atacama

4 Región de Coquimbo

5 Región de la Araucanía

6 Región de Los Lagos

7 Región de Magallanes y de la

7 Antártica Chilena

8 Región de Tarapacá

9 Región de Valparaíso

10 Región del Biobío

11 Región del Libertador General

11 Bernardo O' Higgins

12 Región del Maule

13 Región Metropolitana

Para crear las categorías de zona se recodificará en distintas variables

31

Menú: Transformar/Recodificar en distinta variable

RECODE

region

(1=3) (8=1) (9=2) (10=3) (2 thru 4=1) (5 thru 7=3) (11 thru 13=2) INTO zona .

VARIABLE LABELS zona 'zona'.

EXECUTE .

En definición de variables

1= Norte

2= Centro

3= Sur

c)

Crear la variable “puntprom” correspondiente al puntaje promedio entre matemática y

lenguaje

Al ver el formato de las variables prom_len y prom_mat se observa que viene con tipo: String o

cadena y medida nominal. Lo primero que debemos hacer antes de sacar el promedio es cambiar

en vista de variables el tipo String a numérico.

Para crear la variable puntprom seleccione Menú: Transformar/Calcular

Variable destino:

puntprom

Tipo:

numérico

Etiqueta:

Promedio de Matemáticas y Lenguaje

Expresión:

MEAN(prom_len,prom_mat)

COMPUTE puntprom = MEAN(prom_len,prom_mat) .

VARIABLE LABELS puntprom 'puntaje promedio entre lenguaje y

matemáticas’.

EXECUTE .

d)

Crear la variable “grupo” correspondiente a cada grupo homogéneo. Para esto deberá

crear con sintaxis (sintaxisgrupo) la variable solicitada asignando los códigos 1 al 6 según

corresponda.

Para crear la variable de grupo primero recodificaremos automáticamente la variables ruralida a

código numérico con nombre caract

Donde

caract=1 Rural

caract=2 Urbano

Menú: Transformar/Recodificación automática

AUTORECODE

VARIABLES=ruralida /INTO caract

/PRINT.

32

Ahora formamos los seis grupos según criterio dado

Creación de la variable grupo

*** Sintaxis Grupo ***.

IF

IF

IF

IF

IF

IF

(dependencia = 1 & caract = 1) grupo = 1 .

(dependencia = 1 & caract = 2) grupo = 2 .

(dependencia = 2 & caract = 1) grupo = 3 .

(dependencia = 2 & caract = 2) grupo = 4 .

(dependencia = 3 & caract = 1) grupo = 5 .

(dependencia = 3 & caract = 2) grupo = 6 .

EXECUTE

.

Luego

en la definición

de variables en valores se define:

1: Municipal y Rural

2: Municipal y Urbano

3: Privado y Rural

4: Privado y Urbano

5: Subvencionado y Rural

6: Subvencionado y Urbano

e)

Determinar para cada grupo el percentil 75.

Para el cálculo de los percentiles por grupo: Datos/Segmentar, variable: grupo. Luego Menú:

Analizar/Frecuencias [Estadísticos]: Percentil 75

SORT CASES BY grupo .

SPLIT FILE

LAYERED BY grupo .

FREQUENCIES

VARIABLES=puntprom /FORMAT=NOTABLE

/PERCENTILES= 75

/ORDER= ANALYSIS .

No olvide volver a Datos/ Segmentar archivo/ Analizar todos los casos.

f)

Con otra sintaxis (sintaxispremio) crear la variable “premio” donde según el criterio

mencionado 1=SI recibe premio y 0=NO recibe premio.

Se consideró el siguiente criterio para premiar a los colegios (donde 1=SI, 0=NO)

33

Estadísticos

puntaje promedio entre lenguaje y matemáticas

Municipalizado y Rural

N

Válidos

Perdidos

Percentiles

75

Municipalizado y Urbano N

Válidos

Perdidos

Percentiles

75

Privado y Rural

N

Válidos

Perdidos

Percentiles

75

Privado y Urbano

N

Válidos

Perdidos

Percentiles

75

Subvencionado y Rural

N

Válidos

Perdidos

Percentiles

75

Subvencionado y Urbano N

Válidos

Perdidos

Percentiles

75

68

0

225,6250

587

0

246,0000

19

0

322,0000

388

0

324,0000

86

0

246,3750

1171

0

286,0000

*** Sintaxis Premio ***.

IF (grupo = 1 & puntprom >= 225.625) premio = 1 .

IF (grupo = 1 & puntprom < 225.625) premio = 0 .

IF (grupo = 2 & puntprom >= 246) premio = 1 .

IF (grupo = 2 & puntprom < 246) premio = 0 .

IF (grupo = 3 & puntprom >= 322.5) premio = 1 .

IF (grupo = 3 & puntprom < 322.5) premio = 0 .

IF (grupo = 4 & puntprom >= 324)

premio = 1 .

IF (grupo = 4 & puntprom < 324)

premio = 0 .

IF (grupo = 5 & puntprom >= 246.375)

premio = 1 .

IF (grupo = 5 & puntprom < 246.375)

premio = 0 .

IF (grupo = 6 & puntprom >= 286) premio = 1 .

IF (grupo = 6 & puntprom < 286) premio = 0 .

En definición de variables se agrega la etiqueta de valor

VARIABLE LABELS premio 'premio (SI=1, NO=0)' .

1=SI

EXECUTE .

0=NO

2. Gráficos

a) Determine mediante una gráfica si hay diferencias entre las medias de los puntajes en

lenguaje y en matemáticas por dependencia para el grupo de colegios en estudio. ¿Existen

diferencias en los puntajes de lenguaje por dependencia, agrupados por tipo rural y

urbano? Determine si el comportamiento de los resultados de puntajes de lenguaje y

matemáticas es similar si se compara los segmentos rural y urbano

Para realizar esta gráfica se selecciona

Menú: Grafico/barras/Para distintas variables/Agrupado

GRAPH

/BAR(GROUPED)=MEAN(prom_len) MEAN(prom_mat) BY dependencia

/MISSING=LISTWISE .

34

Media de puntajes de lenguaje y matemáticas por dependencia

prom_len

prom_mat

Media

300

200

291,3

306,1

259,5

235,5

256,9

226,6

100

0

Municipalizado

Privado

Subvencionado

Tipo de dependencia

Del gráfico se observa que tanto para lenguaje como para matemáticas los colegios

privados tiene mejores resultados observándose sin embargo diferencias en casi 15

puntos a favor del promedio de matemáticas. Los colegios subvencionados presentan

puntajes intermedios si comparamos los privados y los municipalizados con puntajes en

torno a 257 puntos en matemáticas y con una diferencia de solo 2 puntos a favor del

puntaje promedio en lenguaje. Los colegios municipalizados presentan los puntajes

promedios mas bajos en ambas pruebas con una diferencia de cerca de 9 puntos a favor

de lenguaje.

Para responder a la pregunta si existen diferencias en los puntajes de lenguaje por

dependencia, agrupados por tipo rural y urbano hacemos un gráfico de barras agrupados

seleccionando resúmenes para grupos de casos.

GRAPH

/BAR(GROUPED)=MEAN(prom_len) BY dependencia BY caract

35

Media de puntajes promedios en lenguaje por dependencia agrupados por

caracterización Rural y Urbano

Caracterización del

establecimiento

300

Rural

Urbano

Media prom_len

250

200

150

292,2

272,9

237,1

261,4

234

221,3

100

50

0

Municipalizado

Privado

Subvencionado

Tipo de dependencia

Se observa una clara diferencia entre los grupos con caracterización rural y urbana,

notándose en los tres grupos de dependencia un promedio en lenguaje bastante mas bajo

en los colegios rurales en relación a los colegios urbanos.

Para comparar el comportamiento en los resultados de ambas pruebas por dependencia

entre la caracterización de Rural y Urbano es conveniente hacer un gráfico en dos

paneles. Para esto vamos a

Menú: Gráficos/ barras agrupadas/ resumen para distintas variables

GRAPH

/BAR(GROUPED)=MEAN(prom_len) MEAN(prom_mat) BY

dependencia

/PANEL ROWVAR=caract ROWOP=CROSS

/MISSING=LISTWISE .

36

Media de puntajes de lenguaje y matemáticas por dependencia para colegios

urbanos y rurales

prom_len

prom_mat

200

292,2

237,1

228,5

221,3

210,6

100

307

261,4

259,3

234

224,7

0

Rural

Media

300

200

272,9

100

286,8

Caracterización del establecimiento

Urbano

Media

300

0

Municipalizado

Privado

Subvencionado

Tipo de dependencia

El gráfico nos muestra un comportamiento muy similar por dependencia entre los

urbanos y rurales en cuanto a que los puntajes promedios más altos se observan en los

colegios privados, los puntajes intermedios en los subvencionados y los puntajes más

bajos en los municipalizados.

En todos los casos los urbanos presentan mayor puntaje promedio si se compara con los

puntajes de los colegios rurales.

g) Realice un gráfico considerando a todos los colegios en estudio y otro gráfico

considerando sólo el segmento de premiados, que permitan observar la posición del grupo

en relación al resto de los grupos en cuanto a los descriptivos básicos. Interprete.

Para esto realizaremos un diagrama de cajas por grupo.

Menú: Analizar/ Explorar/gráficos

EXAMINE

VARIABLES=puntprom BY grupo

/PLOT BOXPLOT HISTOGRAM

/COMPARE GROUP

/STATISTICS NONE

/CINTERVAL 95

/MISSING LISTWISE

/NOTOTAL.

37