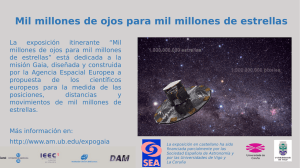

sistema todo cielo para la deteccion y procesamiento de bólidos y

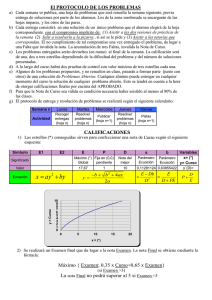

Anuncio