Iluminación Global en DirectCompute

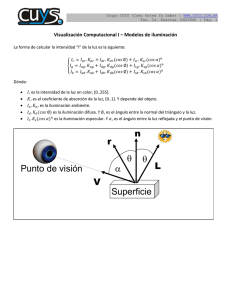

Anuncio