Una elección importante,El rey a examen

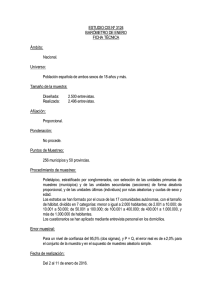

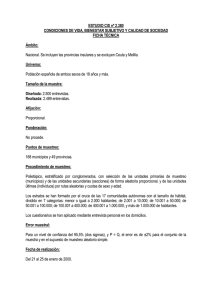

Anuncio

Una elección importante La vida está llena de decisiones importantes. Decidimos qué estudiar. A veces, muy pocas, podemos decidir dónde trabajar. Decidimos si nos casamos y con quién (o eso nos parece). Decidimos dónde vivimos, qué coche compramos, etc. Y la cagamos un número de veces considerablemente más elevado del deseable. ¿Creéis que no?. Entonces explicadme el significado de ese lamento que se oye con tanta frecuencia y que reza así: “si se viviese dos veces…”. Pues eso. Por eso, antes de tomar una decisión hay que valorar cuidadosamente las alternativas de que disponemos. Y esto, válido para la mayor parte de los aspectos de la vida normal, es aplicable también al método científico, con la ventaja añadida de que suele estar más claramente establecido cuál puede ser la elección más correcta. Y, ya que hablamos de elegir, supongamos que queremos tener una idea de cuál va a ser el resultado de las próximas elecciones. La forma de obtener el dato más aproximado sería preguntar a todos los votantes por su intención de voto, pero a nadie se le escapa que esto puede ser imposible desde un punto de vista práctico. Pensemos en un país grande con cincuenta millones de votantes. En estos casos lo que hacemos es elegir un subconjunto de la población, al que llamamos muestra, hacemos la encuesta entre sus componentes y estimamos el resultado en la población general. Pero podemos preguntarnos, ¿es fiable esta estimación?. Y la respuesta es sí, siempre que empleemos una técnica de muestreo válida que nos permita obtener una muestra representativa de la población. Todo dependerá de dos características del muestreo: su exactitud y su precisión. La exactitud determina la proximidad entre el resultado que obtenemos en la muestra y el valor real inaccesible en la población y depende del tipo de muestra elegido. Para que sea exacta, la muestra ha de ser representativa, lo que quiere decir que la distribución de la variable de estudio (y de las variables relacionadas) tiene que ser similar a la de la población. Habitualmente se empieza definiendo el marco muestral, que es el listado o forma de identificar a los individuos de la población a los que podemos acceder, llamados unidades de muestreo, y sobre los que se aplicará el proceso de selección. Pensemos, por ejemplo, en un censo de población, un listado de historias clínicas, etc. La elección del marco debe hacerse de forma muy cuidadosa, ya que condicionará la interpretación de los resultados. Por otra parte, la precisión depende del tamaño de la muestra y de la variabilidad entre los participantes, como recordaréis de la fórmula de los intervalos de confianza (IC95% = valor ± 1.96 x error estándar). Como el error estándar es el cociente de la desviación típica entre la raíz cuadrada del tamaño de la muestra (n), a mayor desviación típica o menor tamaño de muestra, mayor amplitud del intervalo de confianza y menor precisión. Pero esto es una verdad a medias que solo sirve si asumimos que la población tiene una tamaño infinito porque, en realidad, el error estándar debe multiplicarse por un factor de corrección, para muestras finitas, que tenga en cuenta el tamaño de la población (N), con lo que la verdadera fórmula del intervalo sería la siguiente: ¡Alto!. Ahora no aceleréis el ritmo de lectura porque haya escrito una fórmula y volved a mirarla para contemplar, una vez más, la magia del teorema central del límite, el Sancta Sanctórum de la inferencia estadística. Si la población (N) es muy grande, el cociente rápidamente se hace casi cero y el error se multiplica casi por uno, con lo cual prácticamente el intervalo no cambia. Y esto no es ninguna tontería, ya que explica por qué con una muestra de 1200 votantes podemos estimar, con muy poco margen de error, tanto las elecciones para alcalde de Nueva York, como las de presidente de EE.UU. o las de emperador del Mundo mundial, si lo tuviésemos (siempre, claro está, que cada muestra sea representativa de cada censo electoral). Por otra parte, si n se va aproximando a N, el factor de corrección se aproxima a cero y el intervalo se va haciendo cada vez más estrecho. Esto explica que, si n=N, el valor que obtenemos coincide con el real de la población, según el teorema de Pero Grullo. Así que, siendo tal el poder de una insignificante muestra, a nadie puede extrañar que sean diversas las formas de elegirla. Las primeras que vamos a ver son las técnicas de muestreo probabilístico, en las que todos los sujetos tienen una probabilidad conocida, distinta de cero, de ser seleccionados, aunque no es obligatorio que todos tengan la misma probabilidad. Normalmente se utilizan métodos aleatorios para la selección, con lo que se evita la subjetividad del investigador y se minimiza la posibilidad de que, por azar, la muestra no sea representativa, lo que se conoce como error aleatorio o de muestreo. Como siempre, no podemos desembarazarnos del azar, pero sí cuantificarlo. El más conocido es el muestreo aleatorio simple, en el que cada unidad muestral del marco tiene la misma probabilidad de ser elegido. Lo más frecuente es realizar un muestreo sin sustitución, que quiere decir que, una vez elegido, el participante no se reintegra a la población para que no se pueda elegir más de una vez. Para hacer las cosas bien, el proceso de selección a partir del marco se hace con una tabla de números aleatorios o un algoritmo informático. En ocasiones, la variable no se distribuye uniformemente en la población. En estos casos, para que la muestra sea representativa puede dividirse la población en estratos y hacer un muestreo aleatorio en cada estrato. Para poder realizar esta técnica, llamada muestreo aleatorio estratificado, necesitamos conocer la distribución de la variable en la población. Además, los estratos deben ser excluyentes entre sí, de forma que la variabilidad dentro de cada uno sea mínima y la variabilidad entre estratos sea la mayor posible. Si los estratos tienen un tamaño similar el muestreo se hace de forma proporcional, pero si alguno es más pequeño puede sobre representarse e incluir más unidades de muestreo que el resto. El problema es que el análisis se complica, ya que hay que ponderar los resultados de cada estrato en función de su contribución al resultado global, pero los programas estadísticos hacen estas correcciones sin inmutarse. La ventaja de esta técnica es que las estimaciones que se obtienen, si se analizan los datos correctamente, son más precisas, ya que la varianza global se calcula a partir de la de los estratos, que siempre será menor que la de la población general. Este tipo de muestreo es muy útil cuando la variable de estudio se influye por otras variables de la población. Si queremos estudiar, por ejemplo, la prevalencia de cardiopatía isquémica puede ser útil estratificar por sexo, peso, edad, fumador o no, o lo que pensemos que pueda influir en el resultado. Un paso más allá de este enfoque está el del muestreo en etapas múltiples o muestreo por conglomerados (en clusters, para los que lean inglés). En este caso la población se divide en unidades primarias de muestreo que, a su vez, se dividen en unidades secundarias en las que se lleva a cabo el proceso de selección. Este tipo, con todas las etapas que nos interese en cada caso, es muy usado en estudios escolares, en los que se van separando por nivel socioeconómico, tipo de enseñanza, edad, curso o lo que se nos ocurra. El problema de este diseño, aparte de su complejidad de implementación y análisis de resultados, es que podemos tener sesgos si los miembros de una unidad se parecen mucho. Pensad, por ejemplo, que queremos estudiar la tasa de vacunaciones en una ciudad: dividimos la ciudad en zonas, de cada zona seleccionamos al azar unas familias y vemos cuántos niños están vacunados. Lógicamente, si un niño está vacunado seguramente sus hermanos también lo estarán, con lo que puede sobreestimarse la tasa de vacunación global de la ciudad si en el muestreo nos tocan muchas familias numerosas de las zonas con mejor nivel sanitario. El muestreo sistemático se utiliza con frecuencia en estudios en los que el marco muestral no existe o es incompleto. Por ejemplo, si queremos probar un antigripal, no sabemos quién va a contraer la gripe. Elegimos una constante de aleatorización (k) y esperamos tranquilamente a que lleguen los enfermos a la consulta. Cuando hayan llegado los k primeros, elegimos uno al azar y, a partir de ahí, incluimos a uno de cada k que vengan con gripe hasta completar el tamaño muestral deseado. En todas las técnicas anteriores se conocía la probabilidad de cada integrante de la población de ser seleccionado. Sin embargo, esta probabilidad se desconoce en los modelos no probabilísticos, en los que no se utilizan métodos aleatorios, por lo que hay que tener especial cuidado con la representatividad de la muestra y la presencia de sesgos. El muestreo consecutivo se usa con frecuencia en ensayos clínicos. En el ejemplo anterior de la gripe podríamos enrolar en el ensayo a los n primeros que acudiesen a consulta y que cumpliesen los criterios de inclusión y exclusión del ensayo. Otra posibilidad es la de inclusión de voluntarios. Esta no es muy recomendable, ya que los sujetos que aceptan participar en un estudio sin que nadie se lo pida pueden presentar características que afecten la representatividad de la muestra. Los especialistas en mercado utilizan mucho el muestreo por cuotas, seleccionando a los sujetos según la distribución de las variables que a ellos les interesan, pero este tipo de diseño se emplea poco en medicina. Y, por último, comentemos el uso de técnicas adaptativas, como el llamado muestreo en bola de nieve, muestreo en paseos aleatorios o muestreo en red. Por ejemplo, pensemos que queremos hacer un estudio con adictos a alguna sustancia ilegal. Nos costará encontrar a los participantes, pero una vez que encontremos al primero podemos preguntarle si conoce a alguien más que pudiese participar. Esta técnica que, aunque pueda parecerlo, no me acabo de inventar, tiene su utilidad para poblaciones muy difíciles de alcanzar. Y con esto terminamos con las técnicas que tratan de conseguir el tipo de muestra más adecuado para nuestro estudio. Nos quedaría hablar del tamaño de la muestra y de cómo debe calcularse previamente al inicio del estudio para que no sea ni demasiado grande, ni demasiado pequeña. Pero esa es otra historia… El rey a examen Todos sabemos que el ensayo clínico aleatorizado es el rey de los diseños metodológicos de intervención. Es el tipo de estudio epidemiológico que permite un mejor control de los errores sistemáticos o sesgos, ya que el investigador controla las variables del estudio y los participantes son asignados al azar entre las intervenciones que se comparan. Se entiende entonces que el ensayo clínico, bien de forma directa o como parte de un metaanálisis, constituya la prueba de mejor calidad científica para apoyar (o no) la eficacia de una intervención y que sea el diseño preferente de los estudios científicos sobre tratamiento. Claro que esto no quiere decir que cuando veamos que un artículo nos cuenta un ensayo clínico nos podamos relajar y darlo por bueno. El ensayo clínico puede también contener sus trampas y argucias, por lo que, como con cualquier otro tipo de trabajo, será buena práctica realizar una lectura crítica del mismo, basándonos en nuestros tres pilares: validez, importancia y aplicabilidad. Como siempre, a la hora de estudiar el rigor científico o VALIDEZ, nos fijaremos primero en una serie de criterios primarios imprescindibles. Si estos no se cumplen, mejor no perder el tiempo con el trabajo y buscar otro más provechoso. ¿Existe un pregunta clínica claramente definida?. Se debe plantear una hipótesis de trabajo con sus correspondientes hipótesis nula y alternativa, a ser posible sobre un tema relevante desde el punto de vista clínico. Es preferible que el estudio trate de responder solo a una pregunta. Cuando se quiere responder a varias suele complicarse el estudio en exceso para acabar no contestando ninguna de forma completa y adecuada. ¿Se realizó la asignación de forma aleatoria?. Para poder afirmar que las diferencias entre los grupos se deben a la intervención es necesario que sean homogéneos. Esto se consigue asignando los pacientes al azar, única forma de controlar las variables confusoras conocidas y, más importante, también las que desconocemos. Si los grupos fueran distintos y atribuyésemos la diferencia únicamente a la intervención podríamos incurrir en un sesgo de confusión. El ensayo debe contener una tabla con la frecuencia de aparición de las variables demográficas y de confusión de ambas muestras para estar seguros de que los grupos son homogéneos. Un error frecuente es buscar las diferencias entre los dos grupos y valorarlas según su p, cuando sabemos que la p no mide homogeneidad. Si los hemos repartido al azar, cualquier diferencia que observemos se deberá obligatoriamente al azar (no necesitaremos una p para saberlo). El tamaño muestral no está pensado para discriminar entre las variables demográficas, por lo que una p no significativa puede indicar simplemente que la muestra es pequeña para verla. Por otro lado, cualquier mínima diferencia puede alcanzar significación estadística si la muestra es lo suficientemente grande. Así que olvidaos de la p: si hay alguna diferencia, lo que hay que hacer es valorar si tiene la relevancia clínica suficiente como para poder haber influido en los resultados. Hay que considerar también si la secuencia de aleatorización se hizo de forma correcta. El método utilizado debe garantizar que todos los componentes de la población seleccionada tengan la misma probabilidad de ser elegidos, por lo que se prefieren las tablas de números aleatorios o secuencias generadas por ordenador. Y aquí pasa algo muy curioso: resulta que es bien conocido que la aleatorización produce muestras de diferente tamaño, sobre todo si las muestras son pequeñas, motivo por el que a veces se usan muestras aleatorizadas por bloques balanceados en tamaño. Y yo os pregunto, ¿cuántos estudios habéis leído con el mismo número de participantes en las dos ramas y que afirmaban ser aleatorizados?. Desconfiad si veis grupos iguales, sobre todo si son pequeños. Además, la aleatorización debe ser oculta, de forma que no se pueda saber a qué grupo va a pertenecer el siguiente participante. Por eso se prefieren los sistemas centralizados vía telefónica o a través de Internet. También es importante que el seguimiento haya sido completo, de forma que todo participante que entre en el estudio tiene que ser tenido en cuenta al finalizar. Si las pérdidas superan el 20%, se admite que hay que valorar su efecto en los resultados. Lo más habitual suele ser el llamado escenario del peor de los casos: se supone que todas las pérdidas del grupo control han ido bien y todas las del grupo de intervención han ido mal y se repite el análisis para comprobar si las conclusiones se modifican, en cuyo caso la validez del estudio quedaría seriamente comprometida. El último aspecto importante es considerar si los pacientes que no han recibido el tratamiento previamente asignado (siempre hay alguno que no se entera y mete la pata) se han analizado según la intención de tratamiento, ya que es la única forma de preservar todos los beneficios que se obtienen con la aleatorización. Una vez comprobados estos criterios primarios, nos fijaremos en tres criterios secundarios que influyen en la validez interna. Habrá que comprobar que los grupos fueran similares al inicio del estudio (ya hemos hablado de la tabla con los datos de los dos grupos), que se llevó a cabo el enmascaramiento de forma adecuada como forma de control de sesgos y que los dos grupos fueron manejados y controlados de forma similar a excepción, claro está, de la intervención en estudio. Pasaremos a continuación a considerar cuáles son los resultados del estudio para calibrar su IMPORTANCIA clínica. Habrá que determinar las variables medidas para ver si el trabajo expresa de forma adecuada la magnitud y la precisión de los resultados. Es importante, una vez más, no conformarnos con que nos inunden con múltiples p llenas de ceros. Recordad que la p solo nos indica la probabilidad de que estemos dando como buenas diferencias que solo existen por azar (o, dicho con elegancia, de cometer un error de tipo 1), pero que significación estadística no tiene porqué ser sinónimo de relevancia clínica. En el caso de variables continuas como tiempo de supervivencia, peso, tensión arterial, etc, lo habitual será expresar la magnitud de los resultados como diferencia de medias o de medianas, dependiendo de cuál sea la medida de centralización más adecuada. Sin embargo, en casos de variables dicotómicas (vivo o muerto, sano o enfermo, etc) se utilizarán el riesgo relativo, su reducción relativa y absoluta y el número necesario a tratar (NNT). De todas ellas, la que mejor expresa la eficiencia clínica es siempre el NNT. Cualquier trabajo digno de nuestra atención debe proporcionar estos datos o, en su defecto, la información necesaria para que podamos calcularlos. Pero para permitir conocer una estimación más real de los resultados en la población necesitamos saber la precisión del estudio, y nada más fácil que recurrir a los intervalos de confianza. Estos intervalos, además de la precisión, nos informan también de la significación estadística. Será estadísticamente significativo si el intervalo del riesgo relativo no incluye el uno y el del NNT el cero. En el caso de que los autores no nos los proporcionen, podemos utilizar una calculadora para obtenerlos, como las disponibles en la web de CASPe. Para finalizar la lectura crítica de un trabajo de tratamiento valoraremos su APLICABILIDAD, para lo cual nos tendremos que preguntar si los resultados pueden generalizarse a nuestros pacientes o, dicho de otro modo, si existe alguna diferencia entre nuestros pacientes y los del estudio que impida la generalización de los resultados. Hay que tener en cuenta en este sentido que cuánto más estrictos sean los criterios de inclusión de un estudio, más difícil será generalizar sus resultados, comprometiéndose así su validez externa. Pero, además, debemos considerar si se han tenido en cuenta todos los resultados clínicamente importantes, incluyendo efectos secundarios e indeseables. La variable de resultado medida debe ser importante para el médico y para el paciente. No hay que olvidar que el hecho de que demostrar que la intervención sea eficaz no significa obligatoriamente que sea beneficiosa para nuestros pacientes. Habrá que valorar también los efectos nocivos o molestos y estudiar el balance beneficios-costes-riesgos, así como las dificultades que puedan existir para aplicar el tratamiento en nuestro medio, las preferencias del paciente, etc. Para terminar, recomendaros que utilicéis alguna de las herramientas disponibles para lectura crítica, como las plantillas CASPe, o una lista de verificación, como la CONSORT, para no dejaros ninguno de estos puntos sin considerar. Eso sí, todo lo que hemos hablado se refiere a ensayos clínicos aleatorizados y controlados, ¿Y qué pasa si se trata de ensayos no aleatorizados o de otra clase de estudios cuasiexperimentales?. Pues para eso se siguen otra serie de normas, como pueden ser las de la declaración TREND. Pero esa es otra historia…