Evolución y contenidos de la Estadística del siglo XX

Anuncio

ESTADISTICA ESPA^VOL.A

núm. 101, 1983, págs. 7 a 28

Evolución y contenidos de la Estadística del siglo

XX

por SEGUNDO GUTiERREZ CABRIA

Departamento de Estadística e Investigacibn Operativa

Universidad de Valencia.

Instituto Nacional de Estad(stica

RESUMEN

Se contempla la Estádíst^ca durante el presente siglo desde el punto de

vista de su evolución histórica, contenidos y características rnetodológicas

de las corrientes más en boga.

t'^rl^rh^•^r.^^ c•C«^•E^: Descripción e inducción, probabilidades directas e inver:sas, intormación muestral y auxiliar, sístema y diseño de experimentos.

1.

INTRODUCCION

Metodológicamente, la Estadística puede ser descriptiva e inductiva. La descriptiva

utiliza instrumentos gráficos y analíticos que le permiten estudiar caracteres específicos

de grandes grupos de fenómenos. La inductiva extiende la descripción de ciertas

características observadas en algunos sucesos a©tros que no han sido observados; para

Ilevar a nabo esta extensión se puede elegir aquel tipo de descripción que se estima

más propicio. Históricamente se han utílizado tres tipos de argumentos para inducir o

interir propiedades en datos no observados.

R

ESTADISTICA ESPAÑOLA

EI primero utiliza probabilidades ^d priori» individuales para predecir frecuencias

estadísticds sobre la totalidad de la serie. Su fundarnento lo constituyen los teoremas de

Bernouilli, Poisson y Tchebiseheff. EI teorema de Bernouilli fue el fruto de veinte años

de trabajo, según su propia confesián, y sólo es válido bajo condiciones muy estrictas.

Una de estas candiciones es la igualdad de probabilidades «a priori^. Poisson prescinde

de esta condición y Tchebischeff obtiene una ley de la que las dos anteriores son casos

particulares. Un análisis sobre la consistencia de estos métodos puede verse en Keynes

(1973).

EI segundo tipo de argumento se sirve de la frecuencia con que ha ocurrido un

suceso en una serie de ocasiones pard deterrninar la probabilidad de que ocurra «a

posteriori». Dos procedimientos teáricamente inconsistentes entre sf fueron comúnmente

utilizados: la inversión del teorema de Bernouilli y la regla de sucesión de Laplace.

Ambos son considerados en la actualidad coma inválidos.

E1 tercer enfoque de la inferencia estadística se apoya en esta simple idea: dada la

frecuencia con que ha ocurrido un suceso en una serie de ocasiones, ^,con qué frecuencia pociemos esperar que ocurra en otras ocasiones? Es el método vislumbrado ya en la

estadística de la conjetura de Graunt y sus discípulos, basada en la estuhilrc/uc! de las

series estadísticas cuando son dnalizadas según los cánones sugeridos por Lexis y Von

Bortkiewicz. Esta inclrcc•c•i^in de muestra a muestra se opone radicalmente a la ciec/rccc•i^^n implicada en Ia regla de Laplace y es el germen de la inferencia estadística

moderna.

En el presente trabajo vamos a centrar nuestras consideraciones en torno a la

Estadística del presente siglo. En el párrato 2 estudiarnos los hitos más importantes de

su desarrolla. En el párrafo 3 se analizan sus contenidos básicos: el us© de modelos, el

tratamiento de la información y su génesis. Terminamos con una consideración sobre

las fronteras de la Estadística.

2.

EVOLUCION DE LA ESTADISTICA EN LA ULTIMA CENTURIA

1. Una consecuencia natural de los nuevos cimientos echados por Lexís a la

Estadística fue la teoría de la significación de Karl Pearson. En la búsqueda del

significado heurístico de los modelos teóricos, a través de los cuales pretendía obtener

una represeniación lógico-tormdl de la catarsis darwiniana, Pearson había advertido la

necesidad de un criterio para prabar la adecuación de los modelos a los datos. En el

año 1900 daba a luz una memoria (ver Pearson, 1900) en la que construía un test (el

test de la x 2) apto para verifiear la «c•c•ic^entuliuf«ci de lds diserepaneias entre la distribución teórica y la empírica. Este test era el preludio de toda und serie de algoritmos de

naturaleza inferencial.

EVOE_UCEÓN Y CONTENEDOS DE LA ESTADISTTCA DEL SIGLO XaG

^1

En la teoría de la dispersión el problema que se planteaba era investigar si en las

P1'^'^)rE^.^^ ./errcam^nvl^^^icc^s de una sucesión de observaciones estadísticas concurñan,fuc^t^^rP.^^ si,^^te^rrúticcjs. Es lo que pretendía resolver la «tearía de la significación»: «Un

criterio muy simple ---explicaba Pearson (19U0)--- para determinar ld bandad de ajuste

de una distribución

frecuencial cua^quiera a una curva teórica. He calculada --añadía-.

la probabilidad de que la divergencia con respecto a una curva sea atribuida al azar del

muestreo». La sustitucián de una probabilidad directa por una inversa es aquí un

hecho. Con todo de este tesi dará Yuie (1912) una versión en términos de prababilidad

directa: «Nos da --dice- la probabilidad de que por efecto de muestreo aleatorio se

obtenga un valor del test igual o superior al observado».

Con estas palabras parece advertir Yule Id restrictiuidad del canon hipotéticodeductivo en cuyo ámbito la Estadística empezaha a darse reglas y criterios. «EI

estadístico --escribía-- ...puede mostrar que los hechos están de acuerdo con esta o

aquella hipótesis, Pero otra cosa es demostrar que todas las demás hipótesis posibles

son excluidas y que ios hechos no admiten ninguna otra interpretación.»

2.

La escuela biométrica estaba de acuerdo con el criterio de Pearson para la

confrontación de tos esquemas teóricos y tos hechos reales, cuando un químico de los

laboratorios «Messrs Guinnes» de Dublín, dedicados a fabricar cerveza, lanzó una

nueva idea metodológica. Era William S. Gosset quien afirmaba que los métodos de sus

amigas biómetras no se amaldaban a la naturaleza empirica de los problemas que él

tenía que resolver: los postulados y esquemas teóricos válidos para muestr•ds grandes no

lo eran para las muestras pequeñas de que él disponía. De hecho, los bíórnetr•as habían

trabajado, sobre todo Perason y Weldon, a base de realizar muestreas en poblaciones

naturales, pero no habían Ilevada a cabo programas experimentales.

Los datos que obtenía Gosset eran medidas precisas, pero poco numerosas. Se

decidió, pues, a construir un test adecuado, y el resultado obtenido, publicado en 190^,

canstituyó un verdadero avance en la inferencia estadística. Este trabajo fue firmado

con el seudónimo de Studen (1908). Crosset no desdeñó nunca la idea de probabilidad

«a priori», necesaria, según él, para determinar las espectativas de que una constante se

halle dentro de un intervalo pretijado. Mientras Pearson concentraba toda su atención

en la información suministrada por las datas, Gosset acudía insistentemente a la intuición, camo corresponde a un investigador experimental con sentido crítico y antidogmático.

3.

Con los trabajos de Lexis, Pearson y Gosset, la Estadística parecía arientarse en

un sentido cada vez más preciso: la búsqueda de métodos inferenciales tendentes a

objetivar, todo la más posible, los procedimientos de investigacicín. Esta meta ideal fue

elevada por Ronald A. Fisher a principio heurístico.

10

ESTADfsTICA ESPAI^iOLA

Crítico decidido de todo asomo de probabiliciad inversa, Fisher se provee de instrumentos susceptibles de extraer Ia información óptima de los resultados experimentales,

mediante una técnica sintéticamente tipificada y semánticamente neutra. «L.a teoría de

la probabilidad invers^a --escribe en "Theary os Statistical Estimation" (1925}-- se basa

en un error y debe ser rechazada. ^

Pearsan y Student habían sido más prudentes: su rechazo de la probabilidad inversa

erd puramente operativo. Fisher, en cambio, hace del tema una ideología, pero no

asume nunca una posición clara con respecto al problema más general de la inducción.

«Sobre el argumento fundamental de la inducción --escribe Bartlett (1962}-- siempre he

hallado suti escritos extrernadamente oscuros.» Quetelet había aconsejado «replicar»,

repetir, las observaciones, a fin de compensar los elementos perturbadores. Student

sugeríd eliminar «a priori» Ids circunstancias diferenciadoras conocidas. Todo esto

desagradaba a Fisher, partidario de eliminar lo subjetivo y de aleatorizar las muestras

experimentales hasta lograr una plena aleatorización.

1~isher reeemprende la teoría de la signi^cación como técnica interpretativa al servicia de la investigación experimental, dando prioridad a los programas de experimentos

y proponiendo tijar el «umbral de significación» antes de empezar el trabajo indagatorio.

La idea de la máxima verosimilitud -Fisher (1912}- es introducida camo un criterio

natural para estimar los parámetros de la población y para valorar hipótesis a la luz de

la intor^nación muestral. Fisher impone la adecuada «verosimilitud» en el paso inductivo de la muestra a Id población; la ve como predicado de la hipótesis a ld luz de los

ddtos .

4.

Corno en el caso de Pearson y Student, en la metodología de Fisher las hipótesis

son probadas r^nu ^^ur r^ncr, sin la menor alusión a la hipótesis alternativa. La idea de un

proceso infereneial referido a una ^nltrruliclctcl cli.^j«nti^^u c1e ^^i^útes^r.^^ es original de Jerzy

Neyman (1926), quien sigue a grandes rasgos la metodología fisheriana, acentuando más

la distinción entre estimación de parámetros y contraste de hipótesis, entendido este

contraste como confrontdción entre hipótesis rivales.

Neyman deja su Varsovia natal frecuentemente, a partir de 1926, para recibir enseñanzas y orientaciones del grdn Karl Pedrson, Una consecuencia de estas estancias en

Londres f'ue su amistad con Ergon S.^ Pearson (Pearson Jr.) y una colaboración con él

en materia científica. De esta labor de investigación en cquipo nació una nueva teoría

de los test de hipótesis. Neyman y Pearson dan una regla de comportamiento más dúctil

y posibilística que la de Fisher. Es Id que figura en los manuales de estadística clásica.

5.

En la década 1930-40 hay tres hechos notorios en el desarrollo de la Estadística

que no se pueden silenciar.

EVOLUCIt^N Y CONTENIDOS DE LA ESTADÍSTICA DEL S[GLO XX

11

El primero fue el auge logrado por el Análisis Multivariante de la mano de Mahalanobis (193b), t~isher (193b), Hotteling (1935, 193ó), Bartlett (193^) y^VVilks { 1932), entre

otros, y cuyos orígenes están en Galton (18^36, 18KH) y K. Pearson (1901).

El segundo se retiere al elevado nivel matemático alcanzado por la Estadística

merced a los progresos logrados por el Cálculo de Probabilidades. Es el momento en

que empiezan a conjugarse los trabajos de los probabilistas rusos y franceses ( Kolmogorov, Kitchine, Schebyschev, Borel, Levy, Fréchet) con la escuela de estadísticas

ingleses y amerieanos; son los eomienzos de la E.t^tuc^^:^^tic•u Mc^ternútic•c^.

EI tercer hecho de esta época, importante en la historid de la Estadística, es Id

aparición de los primeros trabdjos serios sobre ^^rc^hcchi^ic^uci .ti^^chjetr1•cl, a eargo, prineípalmente, de Bruno de Finetti (1937), quien, a su vez, redescubrió los que antes había

realizado F. P. Ramsdy (1926). Erdn !as bases sobre las que construir el c^ncflisi.^^ huv^siano. C. Gini (1939) había invitado a poner los problemas estadístico-inferenciales en

términoti c1e probabilidad inversa señalando los peligros de ciertos criterios «objetivistas», cuando son empleddos sin la dsimildción crítica de las premisas conceptuales que

los rigen y limitan. En ese mísmo año Harolci Jeffreys (1939) desarrolla la teoña de ia

probabilidad y de Id intérencid de muestras aleatorias en términos exquisitamente

bayesianos. Con todo, las voces bayesianas europeas no fueron escuchadas del otro

lado del Atlántico hasta prácticamente los años cincuenta. Dentro del grupo de americanos que más han contribuido d1 avance bdyesiano hemos de citdr a Good (1950),

Anscombe (1958), Hod,ges y Lehman (1952), Schalaifer (1959) y, sobre todos, Leondrd L. Savage (1954) con su obra «The foundations of Statistics» .

6.

La tc-u^-ícr c1c^ jrr^^,^c^.,^ y Icc tcfc^rícc cfc^ lcr rrtiliclccu' forman parte del rieo legddo dejado

por John Von Neumdnn, uno de los mdtemáticos más insignes de nuestros tiempos. En

1927, con ^u prueba del teorema ciel minimax para juegos finitos, Von Neumann

estableció los fundamentos de la teoría de juegos. Más tarde, en colaboracián con Uscar

Morgenstern, culmina su labor con la publicación de la obra «Theory of Games and

Economic Behavior» { 1944). Abrdhdrn Wald (1947} apreció la conexión entre la teoríd

cie juegos y la de contrastes de hipótesis cie Neyman. VWald considera el razonamiento

estaciístico como un proceso de eiecisión en ambiente c1e incertidumbre, como un juego

entre el estddístico y la naturaleza.

El problema de la Estadística fue provisto de funcianes de pérdida y de riesgo que

permiten contemplar una multitud de alternativas posibles sometidas al criterio del

minimax, de la minimización de la máxima pérdida o riesgo. La escuela de estadísticos

americanos se adhirió pronto a este nuevo enfoque de la Estadística, principalmente en

teoría económica (donde la utilidad sustituyó al riesgo}, que permite una síntesis de las

teorías de la estimaeión, del contraste de hipótesis y del análisis secuencial.

12

ESTADISTICA FSPAÑOLA

La posibilidad de asignar una distribución de probabilidad a los posibles estados de la

naturaleza, según los cánones bayesianc^^s, condujeron a la teuríu de lu clec^i.si^in huvPSiuna. Sus partidarios, Blackwell y Girshick (1954), Raiffa y Schlaifer (1961), Ferguson

(1967), De Groot (197U), argumentan que todo problema específico de inferencia implica

una elección entre acciones alternativas cuyo grado de preferencia puede expresarse por

una función de utilidad que depende del estado desconocido de la naturaleza. Dada la

distribución «a posteriori», basada en la distribucián inicial asignada a los estados de la

naturaleza y en la inforrnación suministrada por la muestra, la mejor acción a tomar es la

yue maximiza la utilidad esperada.

Frente a estos bayesianos «decisionistas», los bayesianos puros no asumen ningún

papel de decisión: la distribución «a posteriori» sobre las hipótesis alternativas es el

producto final de la inferencia.

Un compromiso entre bayesianos y no bayesianos son los métodos llamados «empírico-Bayes», no bien vistos por unos y por otros. Fueron introducidos por Robbins (1955)

y propenden a una mayor utilización de los datos estadísticos, principalmente en la

distribución «a priori».

7. A estos distintos enfoques que atraen la atención de los estadísticos actuales

añadiremos otros tres de escasa importancia.

a) E1 primero es la llamada «inferencia fiducial» de Fisher, que tiene un interés

meramente histórico. Fisher opone a la teoría de Neyman-Pearson los «tests de significación», y a los bayesianos, la teoria fiducial. En sucesivos trabajos (1930, 1933, 1935)

desarrolla sus ideas sobre «probabilidad fiducial», que le conducirían luego a los llamados

«intervalos fiduciales». A pesar de los esfuerzos por rehabilitar la inferencia fiducial, a

cargo de estadísticos tan eminentes como Frasser (1961), Lindley (195H), Godambe y

Thompson (1971), Birnabaum (1962), etc. , no es en la actualidad comúnmente aceptada.

b) La teoría de «verosimilitud» o del «soporte» se contrapone a los puntos de vista,

clásico y bayesiano, de la induccián estadística por el distinto uso que hace de la función

de verosimilitud.

La estimación de un parámetro ( o selección de una hipátesis) en comparación con

otro ( u otra) se apoya en el soporte que proporciona un conjunto de datos, medido ese

soporte por el logaritmo natural de la razón de verosimilitudes calculadas a partir de esos

datos^^ Ei método ha sido ampliamente estudiado por Edwards (1972).

c) Finalmente, nos referimos a la «inferencia estructural». La creación se debe

exclusivamente a D. A. S. Frasser y constituye un nuevo intento de lograr una teoría

unific^da de la inferencia, como puede verse en su libro «The Structure of Inference» ^

EVOLUCIÓN Y CONTENIDOS DE LA ESTADfST1CA [3E L S1GL0 XX

13

(19bí3).^ La obra de Frasser ha suscitado gran interés en los investigadores, por cuanto

aporta pensamiento nuevo, pero no aparece hasta ahora como método de fácil y general

aplicación.

8. Addendurn. Los distintos enfoques de la inferencia estadística ponen de manifiesto su carácter sectorial más bien que una teoría unificadora en la cúspide de la Estadística general. Las áreas especializadas de la Estadística proceden frecuentemente bajo eí

impulso de su énfasis particular, sin prestar atencián a más amplias implicaciones. Ello

lleva consigo su desarmónico desarrollo. La investigación de una teoría inte,gradora de las

distintas vertientes del pensamiento estadístico es el reto que tiene planteado la Estadística actual.

3.

CONTENIDOS BASICOS DE LA ESTADISTICA ACTUAL

En otra parte ( 19^32) hemos escrito que «la Estadística está caracteriaada por la

existencia de una informacián acerca de un colectivo o universo, lo que constituye su

abjeto material; un modo propio de razonamiento, una lógica propia, lo yue constituye

su objeto formal, y unas previsiones de cara al futuro, lo que conforma su objeto o causa

final. Toda esto, frecuentemente, conlleva o preludia una toma de decisión.

En esta caracterización están implícitos los elementos esenciales de todo problema

estadístico, esto es:

1.

Una situación real en ambiente de incertidumbre.

2.

Existencia o posible obtención de información.

3. Necesidad de unas reglas que permitan conocer situaciones actualmente desconocidas y, en su caso, tomar las acciones oportunas.

Estos tres puntos abarcan toda la problemática teórica y práctica de la Estadística

actual. El estudio de la situación real de un problema estadístico exige describirla y esto

no obliga a estudiar Ios modelos probabilísticos. La información constituye la materia

prima de toda investigación estadística. ^Dónde y cómo recabar esta información? ^Qué

hemos de considerar como información relevante? Finalmente, la inferencia estadistica y

la teoría de la decisión ^son la misma cosa o hay que distinguir entre ellas?

3.1.

EL MODELO DE LA SITUACIÓN ACTUAL

1. Puede definirse un modelo como una representación de la realidad que intenta

explicar en alguna de sus facetas. El modelo debe ser menos cornplejo que la realidad

l^

ESTADISTICA ESPAÑ4LA

misma, pero suficientemente completo como para representar con aproximacián los

aspectos de la realidad que van a ser objeto de estudio. El procesa mismo de pensur

corresponde, en su conjunto, a esta definición; de modo continuo estamos construyendo

modelos áe la realidad. Esto explica por qué la construcción de modelos es una operación

tan frecuente. Acabamos de pensar en el Khecho de pensar», y en el proceso utilizado

hemos construido un «modelo de pensamiento».

Los modelos ofrecen aspectos tan distintos que ninguna exposición sencilla puede

aspirar a contener todos los elementos esenciales para su construcción. En un extremo de

la escala tenemos el hecho de que todo esfuerzo humano está basado en la construcción

de modelos; en el otro extremo vemos que los hambres de ciencia y los metodólogos

construyen explicaciones de la realidad cuando ésta necesita una comprensión altamente

especializada.

Los modelos abstractos que nuestro pensamiento construye sobre la realidad se

basan en el lenguaje o, como expresan gráficamente Miller y Starr (19b4), «en su

orgullosa variante: las matemáticas^^ .

Esta juega en favor de la especialización del

lenguaje y de la existencia de vocabularios científicos. Esto explica también el desarrollo

de la lógica y de las matemáticas.

En el palo opuesto están también los modelos concretos, los que se asemejan a lo

que representan, los que originaron la palabra «modelo»: maquetas, retratos, construcciones, piloto, etc. Entre ambos extremos, lo abstracto y lo concreto, hay toda una gama

de modelos según el grado de abstracción.

2.

El primer elemento, el punto de partida, de una investigación estadística es la

consideración de una situacián real en ambiente de incertidumbre.

Debemos tener en

cuenta los resultados posibles del fenómeno que se observa o del experimento que se

realiza. El hecho fundamental es que hay más de un resultado posible (de lo contrario no

habría incertidumbre) y que el resultado en un momento dado no es conocido de

antemano, está indeterminado. Nuestro interés está en determinar cuál es el resultado 0

qué acción tomar como consecuencia del mismo. Un rnédico somete a un enfermo a un

cierto tratamiento, ^curará dicho enfermo? A la vista del tiempo que hace, ^llevaré

paraguas al salir de casa?

Teorizar acerca de la conducta a seguir en tales situaciones exige construir un modelo

formal que resulte de abstraer sus connotaciones más relevantes. Esto exige la introducción del concepto de probabilidad que de algún modo mida la incertidumbre que las

rodea.

Así, en el caso del enfermo, un modelo de su situación puede ser el siguiente: hay

dos resultados posibles curar o no curar, a los que podemos asignar las probabilidades

EVOLUCI(SN Y CONTENIDQS DE L.A ESTADÍSTICA DEL SIGLO XX

1S

respectivas p y l - p. Podemos pensar que este paciente representa a toda una población

de pacientes que sufren ia misma enfermedad, en cuyo caso, el modelo servirá de norma

para dictaminar de cara al futuro. La determinación de p en estas circunstancias puede

hacerse en base a la frecuencia de curados en el pasado de dicha enfermedaá, Procediendo asi, la probabilidad p constituye a su vez un modelo abstrafdo de las frecuencias.

Pero puede suceder que, por su fisiología o su psicología especial, este enfermo sea

considerado por el médico como caso patol8gico especial y, a pesar de que exista un

cierto porcentaje de curados de esa misma enfermedad, el médico asigne a este caso una

probabilidad de curación distinta de dicho porcentaje. A1 proceder así, el médico ha

asignado una probabilidad de curar sub^etiva (personal), ha medido sus propias creencias

acerca de la curación confiriéndolas un valor numérico. Tenemos así dos modos de

asignar probabilidades, a los que se añadirán otros como las probabilidades «clásicas» o

de Laplace y lógica. Estas formulaciones exigen ideas asociadas de independencia,

aleatoriedad, etc.

EI modelo de la situación real consta esencialmente de un enunciado acerca del

conjunto de resultados posibles y de una asunción acerca de sus respectivas probabilidades. Su finalidad es permitir el uso de argumentos lógicos o matemáticos que permitan

deducir comportamientos de cara al futuro. Actúa como una idealización de la situación

real. La meta de todo buen investigador es construir modelos sencillos que se adapten lo

más posible a la realidad, ya que e1 mundo real de la situación vendrá constituida por el

modelo.

Pongamos algunos ejemplos de modelos probabilisticos:

a) Se estudia el número de muertes por accidente de tráfico en las poblaciones, en

intervalos de un mes. Los accidentes que ocurren en un mes determinado son independientes de los que ocurren en otro mes cualquiera y obedecen al azar. La probabilidad

de que una persona muera en accidente es pequeña. Estas hipótesis se amoldan perfectamente a un modelo de Poisson, el cual queda totalmente determinado por un parámetro

simple, su media, que es proporcional a la tasa mensual í^ de accidentes,

b) Poseemos las puntuaciones de los alumnos de una asignatura y deseamos, por

ejemplo, conocer el percentil correspondiente a un alumno que ha sacado una nota

determinada. En vez de trabajar con todas las puntuaciones (que pueden ser muchas),

podemos suponer que éstas siguen una distribución normal. El modelo normaf está

completamente determinado por la media y desviación típica. C}btenidas estas caracteristicas con respecto a todas las puntuaciones, la tabla del modelo normal resuelve el

problema planteado. Este modelo puede servir para resolver cuestiones distintas de la

propuesta .

ESTAD1STiCA ESPAÑOLA

1 f)

c} La situación real puede ser el indagar el número de varones de una población

valenciana de 2U,CxlU habitantes. Se sabe por los boletines de nacimiento que la probabilidad de nacer varón es U,517 en la provincia de Valencia. Hay dos estados posibles, ser

varón o ser hembra, ambas posibilidades son aleatorias, incompatibles e independientes.

Luego la situación definida obedece a un modelo binomial de parámetros n = 20.000 y

p= 0,517. El valor esperado sabemos que es np, en este caso, 20.000 x 0,517 =

= 10.3^40 varones.

3. E1 modelo incorpora a la situación real una estructura con escasos elementos

desconocidos, los parárnetros: la media en el ejemplo a), la media y la varianza en el

ejemplo b) y el número de individuos y la probabilidad de ocurrencia para cada uno, en

el caso c). El modelo probabilístico es pieza fundamental en los dos principales argumentos estadísticos, la deducción progresiva y la reducción regresiva o inferencia estadística

propiamente dicha. Ambos procesos están esquematizados en la figura.

i} EI problema de la situación real es una parte del mundo de los hechos. Por

abstracción, a partir del problema real se construye el modelo, y de éste, por deducción,

se generan propiedades probabilísticas de los datos que suministra la situación real, en el

supuesto, claro está, de que el modelo se ajusta a la situación real. En este proceso la

probabilidad actúa como «canal de información», esto es, como «lenguaje» que liga el

modelo con los datos potenciales. En los tres ejemplos anteriores la información generada por el modelo ha servido para resolver cuestiones planteadas en la situación real.

PROBLEMA DE LA

SITUACION REAL

(Por abstraccián)

MODELO

PROBABILISTICO

(Por asúncián)

1

^

^

^

. ...,

.:.,,

.o

^

^

O

MUNDO DE LOS

HECHOS «A PRIORI^>

1

T

^,

c^.

,^

^.

0

a^

H

^.

DATOS MUESTRALES

+

INFORMACION

AUXILIAR

DATOS

POTENCIALES

EVOLUCIÓN Y COI*ITEN[DOS DE LA ESTADíSTICA DEL SIf.^LO XX

ii)

17

La inferencia estadística invierte este proceso. Se inicia con los datos muestrales

obtenidos del rnundo de los hechos y de la misma naturateza que aquellos que constituyen la situación real (obtenidos mediante un diseño adecuado de experimentos o quizá

fortuitamente) y luego utiliza estos datos y toda otra infarmación para validar un modelo

,.

especificado, para hacer «canjeturas racionales» o«estimar parámetros» o aun para

originar un modelo. Todo esto es objeto de la inferencia estadística. Este proceso

inverso, induetivo, es posible gracias al «lenguaje» de la teoría de la probabilidad,

dispuesto de antemano para formar el eslabón deductivo. Su finalidad es facilitar la

obtención de inferencias a través del modelo de la información suministrada por la

muestra (y, si es el casa, par atras fuentes informativas relevantes que contribuyan a una

inferencia más precisa) o construir procesos que ayuden a tomar adecuadas decisiones en

la situacián práctica.

^.2.

l.._A INFORMACIÓN ESTADÍSTlCA

.

l.

La información es e1 elemento más earacterístico del mét©do estadístico: del

hecho dislado no puede extraerse ninguna conclusión en situaciones de incertidumbre,

esto es, en las que interviene el azar; al examinar un conjunto o colectivo de casos

concretos se aprecia

. una cieria ^-c,^^^^lc^ric^uc! o estabilidad en el comportamiento de

dichas tenómenos. Por eso se dice que no hay estadística sin observación o experimen.... ,

tac^on.

En los tres ejemplos a), h) y c), citados anteriormente, la información tomaba la

torma especítica de «realizaciones» de una situación práctica: muerte:^ habidas por

accidente, puntuaciones obtenidas por alumnos, número de varones nacidos en una

población. Estas realizaciones se suponen abtenidas como repetición de la situación

bajo idénticas cir^ unstancias. A este tipo de información se le suele Ilamdr «ddtos

muestrdles» .

Para algunos autores como Von Mises (1964), Venn (19621. Reichenbach (1949) y

Bartlett (1962) sólo eon informdeión de este tipo obtenidd en .^^it^^uc-ic^r^ r-c^^^c^titr'^^cl, d lo

meno^ potencialmente, se puede detinir adecuadamente el concepto de probabilidad. Es

la Ildmada intc, ^•^^^•c^tccc•i{^n ,/rc^c^trc^nri.ti^tc^ o.frc^c^rrc^nc•ic^listc^ de Ia probabilidad.

«Limitamos nuestro propósito, hablando "groso modo" --dice Von Mises (op. cit. ,

p. 1) , a una teoría matemática de sucesos repetitivos.» Y más tarde (pp. 13 y 14) añade:

«Si se habla de ta probabilidad de que dos poemas conocidos como la Ilíada y la Odisea

tengan el mismo autor, no es posible referírse a una sucesión prolongada de casos y,

diticilmente tendrá sentido atiignar un valor ^1illl'IP/•ic•cj a tal conjetura.

ESTADfSTtCA ESPAÑOLA

1K

Ue ^^n^tlugu parecer es Bartlett cuandc^ escribe (19b2, p. 11) que ^<Id estadística se

cxup^^ de cutia^ que pocie^nu^; cuntdr».

[._cy^, datos muestrdles evdluados de acuerdo con el concepto frecuencialista de la

prohahilidad constituyen la batie de la llamada estadísticd c•/cí.^^ic•cl, esto es, la estadística

wegún los cánunes de Pisher, Neyman y Pearson.

2. En el ejemplo c) la inforrnación utilizada, proporción de varones, es de naturaieza trecuencial por su farma repetitiva. Pero cuando hemos atirmado que en Valencia

etita propurción es de S i,7 ^ por cada cien nacidos, no nos hemos referido a ningún

experimento u observacián particular, sino que es algo que los estadisticos profesionale^ dan como vaior medio de córnputos Ilevados a cabo tras observaciones seculares de

los holetines de nacimientos remitido5 por los registros de población. Se trata, pues, de

una intormación obtenida por c^_^^r^ri^nc•icl cintc^rivr•.

U nd empresd que se dedicd a construir aviones recibe un día una oferta de un tipo

de material por parte de uno de sus abastecedores y que, según él, es el más adecuado por

sus cu°lidadeti de ligereza, resistencia, etc., para et nuevo modelo que se proyecta. Los

técnicos del m^odelo c^.r^^c^ri^ i^c^ntc^n el nuevo material (clcrt(^.1^ rr^lrc^.^^trul^.,^^,

también en cuenta los datos suministrados por el proveedor

pero tienen

((^.tnc^rienc•iu ^^cl.^^uclul,

persona que conoce los resultados del material que ofrece en otros proyectos de otras

firmas.

Por otra pdrte, el equipo económico, de acuerdo con el técnico, hará las

valoraciones de todo tipo que se desprenden de la adopción del nuevo mdterial:

perjuicios cdusadas si no se cumplen las e^peciticaciones exigidas por el mercado,

diferencias en los cotites, comercializdción, etc. ^in/ur^nuciún .^^uhrc^ lu.^^ c'vn.^^c^crrenc•iu.^^

J)()1 f'it('lll/t'.1' ).

Vemos a través de estos ejemplos que la información necesaria para resoi ver un

prohlemd estadistico (que concluirá en muchos casos en un problemd de decisión)

puede dbarcar información de tres eategorias distintas: irtfr^rrnuc•icín clc'hiclcl cc c^.rnc'rienc•ira c^nt('r-ir,r• (infurmacicín inicial del sujeto que puede basar^;e en hechos objetivos

observados con anterioridad, o ser meramente «subjetiva»), (.^(ltO1 mrr^strul^.^^ (debidos a

ohservación a experimentación actudl) y cr,n.^•^c•lrenc•iu.^^ ^^ntenc•iul^.^^ {información nacida

de Idti posibles consecuencias que traerá consigo una u otra acción).

3. La intorm^ición que conlleva las posibles consecuencias está inmersa en el

problema de la valoración de esas consecuencias, el cual es vital, ya que es determinante a la hora de tomar dcciones alternativas. Esta valoración debe ser c•lrunti/iccrclu de

algún modo a tin de poder comparar los resultados de distintos cursos de acción. La

valordción de lds consecuencias y su formal cuantificación es objeto de la te^r^rtu c!^ lcr

lrtiliclrlcl. Esta teoría forma parte de las diversas interpretaciones de la estadística y

constituye uno de los elementos básicos de la tec^rt^ cte lu cleci.tiiún.

19

EVOL.UCIÓN Y CONTENID4S DE LA ESTADISTICA DE[. SIGLO XX

La intarmdción basada en las consecuencias puede ser distinta (y hasta estar en

contracción) de los datos muestrales. Lo mismo que los datos muestrales, la valoración de las consecuencias puede ser ^^hjeti ^ •u: los costes de manufacturas debidos a

procesos distintos pueden ser valorados en moneda de cuenta. Pero puede suceder que

Ids consecuencias que se desprenden de la toma de dcciones distintas no sean subceptibles de una vaioración objetiva. ^Cómo valarar objetivamente 1os resultadas de elegir

entre el cumplimiento de la ley y el cohecho? ^Cómo ser objetivo a la hora de elegir

como mujer a Judna o a María`' En la esfera de las actividades humanas es a menudo

diticil ser objetivo. La valoración de consecuencias implica entonces evaluar juicios

.^^^^hjc^ti^^^^.,^ (personales), acudir d los instrumentos de la teoría de la utilidad.

Aún en situaciones aparentemente objetivas es difícil eludir tado factor personal. En

la elección de uno u otro material, aparte de componentes objetivos perfectamente

comparables en precio, calidad, etc., siempre intervendrán el gusto del decisor, las

modas en el consumo, la presión social, etc. Todos sabemos lo que pesa, por encima de

tadas las características ténicas y el precio, las preferenctas y gustos de la mujer a la

hora de elegir el marido un nuevo modelo de automóvil.

Estas diversas categorías de información pueden re:sumirse en dos: una que posee ya

el ^;ujeto y que Ilarnaremos r'n/i^^-^rrcrc•i^^n cr /»•ic^^-i (no importa cuál sea su naturaleza y

origen), y otrd suministrada por la muestrd o irr/i^^•rn^cc•iún ^r^rre.^^t^-crl. La combindción de

ambas constituye la esencia de la inferencia estadística bayesiana.

E1 uso exclusivo

de la segunda es típieo de la e.ti^tcrclc:^^tic•u c•lcí.ti^ic•u. La información generada por las

consecuencias es, en cambio, relevante en la teoría de la decisión.

En los párrdfo^ dnteriores nos hemos referido a inferencia estadística y a teoña de la

decitiión como conceptos distintos, pero con elementos comunes. A la inferencid estadísticd le dsignamos ld misión de cle.tic•^•ihi,• ld situdción real y a la teoría de la decisión le

peciimos que /^^•c^.ti^c•r•ihu 1a accián a ejercer en la situación dada.

3.^.

LA OBSERVACIÓN Y GENERACIIJN DE LOS DATOS: DISEÑO DE EXPERIMENTCJS

l. Diariamente cada uno de nosotros Ileva a cabo alguna observación con finaliddd

estadística. La parte más elemental de la estadística hace su aparición en cuanto se

realiza mentdlmente la evaluación de una investigación cualquiera. Cuando uno se pesa,

automáticamente compara el peso obtenido con el ^^rc^ ^^^cclic^ de pesadas anteriores y

eonsidera tii este peso se cle.^^^•r"u .ti^i^,^ni^ic•uti ^ •^,^r^entc^ del eomúnmente observada.

Estos resultados sencillos se obtienen con facilidad; pero cuando se emprende una

investigación en serio, el método e:stadístico, que es el compañero inseparable cie todd

investigación científica, exige especiales conocimientos. En general se apela a la esta-

ZO

ESTADISI^CA ESPAIVOLA

dí^;tica siempre yue acaecen sucesos en .fen^^^n^n^^.c c!^ c•^^lec•ti^•^^. Estos sucesós son de

dos tipos; en unos, el estadístico es ^n^r« ^^h.,er ^ •^,cl^rr de lo que sucede; tal ocurre con la

oh^ervación de l05 hechos demográticos como nacimientos, matrimonios, defunciones,

etcétera. Es lo que hacen también los astrónomos, sxn que en ningún caso pueda el

observador modificar las fenámenos que tenía ante sf.

Otras veces los sucesos son el resultado de una e.r^erienc•i^i ^rt, ^ ^^,c^uclu por el

investigador, bajo ciertas condiciones. La experiencia puede provenir de las ^iencias

llamddas experimentales o de las socioeconómicas; puede obtenerse en un laboratorio

o en la vidd real, puede ser lihrc o controiada.

Lo corriente es que una experiencia na sea .exactamente re^^etihlc^ en cuanto a

re^^ ultados se retiere, cuanda las condiciones que la detinen no son totalmente controlableti; en estos casos los resultados na 5on predecibles. Se habla entonces de experiencia

de azar o experimento aleatorio o estocástico, por oposición a aquel en yue hay

relación de causa a efecto Ilamado determinista. Son experiencias aleatorias ^ la extracción de una carta de un mazo, el lanzamiento de un dado para- obtener una de sus

caras, la eleccián de un punto sobre una diana ^nediante un disparo sobre ella.

Desde el punto de vista estadístico todos los hechos observados,

tanto si provienen de

.

un fen8meno experimental como si resultan de la simple`observación c}el mundo que nos

rodea, tienen el mismo carácter de estabilidad, saivo el caso de experiencias controladas.

Fero es preciso tener en cuenta que a veces puede desviarse el fenómeno de esa

regularidad, debido a la variabilidad exhibida por todo tipo de agrupación o clase. Así, al^

.

^

observar la población habrá que considerar la vari^ci^dn ,^ar, edades, por sexo, por

regiones de origen. Habrá que tener en cuenta la variabilidad de un mismo fenómena en

el tiempo: la tasa de mortalidad cambia por el progreso de la medicina, el número de

accidentes con el desarrallo económico.

2. Ciertas ciencias empíricas, como la psicología, admiten, según algunos investigadores, como método de investigación la introspección. Esto es una excepción; en la mayoría

de las ciencias de la naturaleza la observación es exclusivamente: sensible y ezterna. En el

caso más corriente los datos se obtienen por ezperimentación.

Existe una evidente analogía entre experimentación y comunicación a través de un

canal ruidoso. Las entradas son los estados de la naturaleza, y las respuestas, los

resultados del experimento. La información transmitida mide el promefíio

^ ;ti de incertidum-

bre que queda eliminada por el experimento acerca de los estados de ^a naturaleza. Será

EVULUCIÓN Y CONTENIDOS DE LA ESTADISTICA DEL S1GIrC7 ^ XX

21

ejecutado aquel experimento con mayor información esperada. El proceso es el de la

llamada «caja negra», según el esquema de la figura.

Entradas

Respuesta

Estados

de la

Sistcma

(Experimento)

(©bservaciones)

naturaleza

Algunos autores, como D. A. S. Fraser (1979}, llaman sistema aleatorio al concepto

aquí reseñado y reservan la palabra experimento para investigaciones en las que las

entradas están controladas por existir alguna relación de causa a efecto. E1 control de las

entradas puede ser de dos clases: entradas diseñadas o planificadas, de suerte que la

modificación de una, dejando fijas las demás, permita detectar su influencia en las

respuestas: tenemos entonces lo que se conoce con el nombre de diseño de experimentos;

pero puede suceder que las entradas no sean directamente controlables y se haga su

elección aleatoriamente, en cuyo caso se origina un efecto aleatorio sobre las respuestas.

La aleatorizacián externa de las entradas, ante diversas realizaciones del experimento,

provee de una cierta compensacián de la falta de control de dichas entradas. Esta

aleatorización externa es una componente de la investigacián que determina la aleatoriedad del experimento o sistema. Queda así aclarada. la diferencia entre experimento (o

sistema aleatorio) y diseño de experimentos. •

3. La estadística trabaja con conjuntos numéricos. E1 conjunto de entes sobre los

que se quiere investigar, con ciertas caracterfsticas comunes, se llama población o universo. A una parte de ese colectivo se le llama muestra. Cada uno de los elementos de la

población es un individuo. Esta nomenclatura recuerda los orígenes demográficos de la

Estadística. De una misma población pueden considerarse caracterfsticas distintas: sexo,

edad, estatura, peso. Y una misma característica puede presentar distintas manife^taciones: sexo masculino y femenino, escala de edades, etc. Las modalidades pueden ser

medibles (estatura) o contables (edad), en cuyo caso el carácter cuantitativo (llamado

también variable) puede no serlo y entonces el carácter es cualitativo (llamado también

atributo).

Estas definiciones pueden servir para una adecuada ordenación de la información de

cara a su aplieación en los ynodelos. No olvidemos que la puesta en práctica de las

22

ESTADISTICA ESPAIVO[.A

diversas técnicas estadísticas no tendr^ validez sino a condición de que la recogida de

datos sea conveniente y su^ordenación correcta.

L.a recogída de datos es ta primera fase de! proceso estadístico. Estos datos proceden

de lo que en el esquema descrito llamamos mundo de los hechos a priorl. De estos

hechos tomamos los que convienen al problema real que nos ocupa y que servirán para

construir el modelo de ese problema. Esa información incorporada por el científico a su

ciencia, a la teoría científica que pretende construir, son las llamadas observaciones

cíentíficas (flamadas también protocolarias). Las llamamos así para distinguirlas de la

información estadística en general: datos cuantítativos y datos cualitatiuos, tales como han

sido definidos.

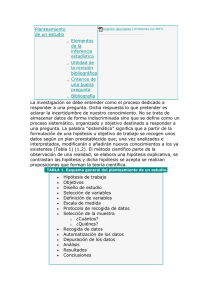

Oscar 1Vforgenstern utiliza e1 esquema de la figura para distinguir estos diversos tipos

de información estadística.

Observaciones

científicas

El círculo A representa el carnpo cubierto por la teoría; los círculos B y C indican,

respectivamente, las partes que cubren los datos cuantitativos y cualitativos. Estos dos

círculos se refieren a datos empíricos, mientras que las observaciones, que ponen de

EVO[.UC'IÓ^I Y COIYTEN[DOS DE LA ESTADfSTICA DEL SIG1.0 XX

Z^

manifiesto cámo la teoría está enclavada en la realidad, quedan circunscritas a la región

comprendida entre los tres círculos.

Hemos de matizar dos cosas. Primero, que no todos los datos, como se desprende del

esquema, deb^en ser considerados como observaciones, en el sentido que se da aquí a

esa palabra, sino solamente aquellos que, recogidos, clasificados y reducidos a categorías,

aspiran a ser utilizados en los modelos. Segundo, que empleamos la palabra teoría por

modelo, ya que todo modelo es la interpretación real de una teoría y esto es lo que aquí

se está considerando.

4. Los datos numéricos de la Estadística resultan de asignar números a objetos o

relaciones empíricas de acuerdo con ciertas reglas fijas.

Estas reglas dan lugar a las escalas de medida. Las escalas de medida son posibles

sólo en tanto existe un cierto isomorfismo entre las operaciones que podemos hacer con

los números y las que podem^s hacer con los objetos empíricos. Los modos según los

cuales las propiedades y las operaciones efectuadas con los núrneros son trasladab: ^s a

los objetos empíricos dan lugar a otros tantos tipos de medidas y escalas.

Las propiedades de los números trasladables a los objetos son, principalmente, la

igualdad y desigualdad, conexión u orden, igualdad de diferencias e igualdad de razones.

Estos tipos de operaciones dan origen a cuatro clases de escalas: escalas enumerativas o

nominales, escalas Orclinales, escalas de intervalos y escalas de razón. La descripción de

cada una puede verse en Gutiérrez Cabria (19130).

Con cualquiera de estas cuatro escalas,. aplicadas a los conjuntos de objetos, se

obtienen conjuntos numéricos, pero la información suministrada se va haciendo más y

más precisa a medida que utilizamos escalas más perfectas. Es evidente que, en la

ordenación establecida, la más imperfecta es la escala nominal y la más perfecta la

basada en la igualdad de razón.

4.

LAS FRONTERAS DE LA INFERENCIA ESTADISTICA

Ha Ilegado ya el momento de analizar cuál es la aportación de la estadística en

general y de la inferencia estadística en particular, a la metodología general científica.

La estadística general, en el proceso de recogida y análisis de datos, ha sido contemplada ya en la primera fase del proceso de formación de las ciencias naturales. Es una

fase meramente descriptiva que recoge datos, las observaciones protocolarias, los analiza

y termina con la formulación de los enunciados universales sintéticos.

Z$

ESTADISTICA ESPAÑOLA

La inferencia estadistica interviene en las fases segunda y tercera, que culminan c^on

la obtención de modelos de las teorías científicas. Hemos recalcado ya que la ciencia

progresa no por meras especulaciones teóricas, sino por una feliz simbiosis entre la

teoría y la práctica, suficienterx^ente iteradas. En esta íteración de la teoría y la práctica,

nuevos datos sugieren nuevos modelos teóricos, y un nuevo modelo propuesto inspira

nuevos exámenes y análisis de los datos obtenidos o que deben adquirirse. La dualidad

de los procesos de inducción y deducrión conduc-•n así a mejorar los modelos paulatinamente, pero siempre en presencia del estadistico.

Esta presencia se manifiesta en un doble proceso que pudíéramos denominar de

depuración y estimación del modelo cientifico. Este doble proceso constituye la fase

inferencial que atañe al estadistico, a la cual precede otra, preinferencial, que compete al

científico. Karl Popper (8) describe así ambas fases del método científico: «El científico

teórico propone ciertas cuestiones determinadas al experimentador, y este último, con

sus experimentos, trata de dar una respuesta decisiva a ellas, pero no a otras cuestiones:

hace cuanto puede por eliminar éstas».

De los hechos «a priori» que reflejan los verdaderos estados de la naturaleza, por vía

reductiva o directamente, el científico formula sus hipótesis o leyes, su modelo, M;. El

estadístico consulta nuevamente a la naturaleza, la misma que inspiró al científico su

modelo, extrayendo nuevos datos con los que realiza el diseño D;, y los que confronta al

modelo M;. Los datos utilizados para esta confrontación del modelo han de ser distintos

de los que sirvieron para su construccián ^lo que implica una dicotomización de los

hechos «a priori»), pues, de la contrario, se incurrirá en un círculo viciaso. Los nuevos

datos estarán de acuerdo o en desacuerdo con M;. Es éste un proceso de diagnóstico. En

caso de existir desacuerdo, cabe preguntarse por qué. Los instrumentos estadísticos

utilizados para este análisis son los diversos tests de la bondad de un ajuste, análisis de la

varianza residual, etc. Puede suceder que sea aconsejable cambiar M; por un nuevo

madelo M;+ ^ que será sometido a prueba de los mismos datos obtenidos o a otros

nuevos, si así lo exige la independencia de la prueba, para lo que se diseñaría un nuevo

experimento de Dr ^ ^ .

Caso de haber llegado a la obtencián de un modelo aceptable, esto es, aproximado

suficientemente a la realidad que ha servido de verificación o contraste, puede procederse a estimar sus parámetros, en base a esa misma realidad con la que se ha probado está

conforme. En realidad, esta estimación es necesaria en cada prueba de depuración del

modelo provisional, pues es el único modo de ver si se aproxima o no a los hechos

reales.

Así como las técnicas estadísticas utilizadas en la depuración del modelo pertenecen a

la escuela clásica, el prablema de la estimación puede hacerse por métodos clásicos o

2^

F4'OI.IICI(SN ^' CUNTENIDOS DE LA ESTADISTICA DEL SIGLO XX

Hechos «a prioriM de la

Naturaleza

^

(Dicotomización)

! ^ _ ^ _ ^ ^ ^

^1, + i

--,

I

^

I

Depuración

del modelo

_

,^,

^

I

I

I

I

I

I

M,

D,

I

^ ,l

1

^

I

I

I

I

I

^ ^

E,

I

I

Higura S

1

^-.- - - - .... _ ^ .._ ...J

E5TADíSTICA FSPAÑOLA

^b

bayesianos, fiducia^es o estructurales, todo lo cual pone de manifiesta la complementariedad de las escuelas y, en su caso, la subsidiariedad, como habiamos anunciado al

principia.

BIBLIQGRAFIA

ANSeoMSF, F. J.: «Rectifying of a continuous our put». J. Amer. Statis. Ass , 53, p. 702, 1958.

BARTLETT, M. S.: KFurther aspects of the theory of Multiple Regressión». Proc. Cam. Phil. Soc.,

34, p. 33, 1938.

: Essays an Probability and Statistics. London• Methuen, 19é2.

B[RNBALaM, A.: «On the foundations of statistical inference». J. Amer. Statis. Ass., 57, pp. 2f^9-326,

19b2.

BLACKWELL, D. , y GIRSHICK, M. A.: Theory af games a^^d Statistical Decisions. 1. Wiley, New

York, 1954.

DE FINETTE. 8.: «L.a prevision, ses lois logiques, ses sources subjectives». Ann. Inst. Pvinc^uré, 7,

pp. 1-ó8, 1937.

DE CiROOT, M.: C)ptimal Statistical Decisions. McGraw-Hili. New Yark, 1^J70.

E©wARns, A. W. F.: Likelihc^od. Cambridge: C. U. P., 1972.

FERGUS(^N, T. S.: Mathematical Statistics: A Decisión Theoretic Approach. Acad. Press, New York,

19f^7.

F[SNER, R. A.: «On a absotute criterion for fitting frequency curves».

Pp. 1 SS-1 ó0, 1912.

Messeng.

Math, 41,

:«Inverse probability». Proc. Camb. Phil. .Soc., 26, pp. 52$-35, 1930.

:«The concepts of inverse probability and fiducial probability referring to unknown parameters». Prac. Roy. Soc., A., 139, pp. 343-48, 1933.

:«The fiducial argument statistical inference». Ann. Eugen, 6, pp. 391-98, 1935.

:«The use af multiple measurements in taxonomic problems», Ann. Eugen, 7, p. 1; 9, 193fi.

:«Theory of Statistical estimatiom>. Proc. Camh. Phil. Svc., 22, p. 70U, 1952.

FRASSER, D. A. S.: «The fiducial method and invariance». Blometrica, 48, pp, 2fi1-280, 1961.

: The Structure of lnference. J. Wiley. New York, 1968.

: lnference and linear models. McGraw-Hill, 1979.

GALTON, F.: «Regresion tawards mediocrity in hereditary stature». J. Antrho. Inst., 15, p. 246,

1877.

;«Family likeness in Stature». Proc. Royal Soc., 40, p. 42, 1886.

;«Co-relations and then measurements chiefly from anthropometric data». Proc. Roval Soc•. ,

45, p. 135, 1 R88.

EVC)í_UC'ICSN Y C'QNTENIDOS DE 1_A ESTAD^STICA DEL SIGLC) XX

27

GINt, C.: «I pericoli della statistica». Actas de la I reunión científica de la Soc. italiana de Estad.

Pisa, 1939. Reimpreso en Questione fondamentali di Proóabilrtá e Statistica, vol. I, Bibliot. di

Metrom e Bihliote. di Estad, 1968.

GoDAMBE, V. P. , y THC)titPSON, M. E.: «Bayes, fiducial and frequency aspects of statistical

inference in regression analysis in survey sampling». J. Roy. Statis. Soc. B., 33, pp. 361-39U,

1971.

GooD, I. G.: Prohuhilitv and the Weighing of Rvidence. Griffin, London, 195U.

GuT[^RREZ CABRIA, S.: Bioestudr:stic•u. Ed. Tebar. Madrid, 198(}.

:«Origen y desarrollo de la Estadistica en los siglo xvtt y xvnl». Estadfstica Española, núm. 97,

octubre-diciembre 19H2, 19H2.

Honc;HS, J. L., y LE:HAMANN, E. L.: «The use of previous experience in reaching Statistical

decisions». Ann. Math. Statis, 23, p. 39fi, 1952.

HoTTEL7NG, H.: «The most predictable criterion». l. Educ. Psichol, 26, p. 239, 1935.

KEYNES, J. M.: «Treatise on probability». 7'he Roy. Econ. Soc. London, 1973.

LINDLEY, D. V.: «Fiducial distributions and Bayes Theorem^>, J. Roy. Stutis. Soc•. B.,

PP• 102-1U7, 195£^.

MAHALANOBIS, P. C.: «On the generalized distance in Statistics».

PP• 12-49, 1936.

Proc. Nat. Inst. Sei.

20,

India,

M[LLE R y STAR.: Fonction de Direction et Recherche Operationelle. Editorial Dunod. Paris, 19fi4.

NEYMANN, J.: «On the correlatiun of the mean and the Variance in samples drawn from an infinite

population». Biometrika, 1H, p. 4U1, 1926.

PEARSON, K.: «On the Criterion that a given System of Deviations from the Probable in the case of

a Correlated System of variables in such that it can be reasonably supposed to have arisen from

Rdndon Sampling^. Philosophicul Muxu^ine. L, p. 157, 19t10.

-: «On lines and planes of closet fit to systems of points in space». Phil. Nag. 2(6), p. 559,

19U2.

Po[ssoN, S. D.: Recherches sur la prohabilité des jugements en matiére civile, precedées des régles

générales du calcul des prohahilités. Paris, 1$37.

PnPPER, K. R.: La lógica de la investigación cientí'fica. Ed. Tecnos, 1967.

RAIFFA, H. , y SCHLAIFER, R. : Applied Statistical Decision Theory.

1961.

Harward Univ. Press. Boston,

RAMSEY, F. P.: «Truth and Probability». Reeditado en Studies in Subjec•ti ^ ^e Prohuhility. ( Kyburg

and Smokler.) J, Wiley, New York, 1926.

RE[CHENBACH, H.: The theory of prohability. Chicago, Los Angeles, 1949.

RoBB[NS, H.: «The empirical Bayes apprvach to statistical decision problems». Ann. Math. Statis.,

35, pp. 1-21, 1964.

SAVAGE, L. J.: The founctutions of Statistics. J. Wiley, New York, 1954.

S^HA[FER, R.: Prohahilitv und Stutistics for Busines Decisions. MacGraw-Hill, New York, 1959.

STUnENT: «The prohable error of a mean». Biometrika, 6, 1, 19U8.

28

FSTADiSTICA ESPAIVOLA

VoN ^iEL1MAN, ^., y NIURGENSTERN, O.: Theory of ^ames and Economic Behavior. Princeton Univ.

Press, 1944.

VoN MtsES, R..: «Mathematical theory of probabitity and statistics^. Academic Press, New York,

London, 19ó4.

yVA^o, A.: Sequential Anolysis. New York, 1947.

WtLKS, S. S.: «Certains generalizations in the analysis of variance^. Biometrika, 24, p. 471, 1932.

YuLE, G. U.: An Introduction to the Theory of Staristics. Charles Griffin and Co. London, 1912.

SUMMARY

EVOLUTION AND CONTENTS OF XX CENTURY STATISTlCS

Statistics in this century is considered, within the scope of its historical

evolution their contents and the methodological characteristics of the tendencies in fashion.

Key words: Description and induction; diret and inverse probabilities; sampling and auxiliar information; system and design of experiments.

AMS 198Q. Subjet classification: 62-^3.