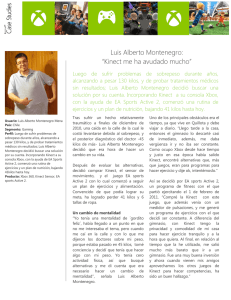

Control de Software Educativo Mediante Kinect de Microsoft

Anuncio