NUESTRO UNIVERSO (Copyright 2001)

Anuncio

NUESTRO UNIVERSO

(Copyright 2001)

PRÓLOGO.........................................................................................................................................................1

Capítulo I. GRAVEDAD RELATIVISTA....................................................................................................... 5

1. Teorías del espacio-tiempo............................................................................................................................ 5

2. Relatividad General..................................................................................................................................... 14

Capítulo II. CONCEPTOS COSMOLÓGICOS.............................................................................................. 19

1. Parámetros.................................................................................................................................................. 19

2. Estimación de distancias............................................................................................................................ 19

3. Constante cosmológica............................................................................................................................... 22

4. Ley de Hubble............................................................................................................................................. 28

5. Materia oscura y antimateria.................................................................................................................... 31

A. Materia oscura....................................................................................................................................... 31

B. Antimateria............................................................................................................................................ 34

C. Crítica a la interpretación clásica de Dirac............................................................................................ 37

Capítulo III. INFLACIÓN.............................................................................................................................. 51

1. Universo de Einstein- de Sitter............................................................................................................... 51

2. Universos dominados por materia fría de tipo general........................................................................ 51

3. Universo dominado por radiación.......................................................................................................... 52

4. Universo dominado por la densidad de energía de vacío. Universo de de Sitter................................ 52

5. Caso general...............................................................................................................................................52

6. Parámetro de desaceleración....................................................................................................................53

7. El modelo clásico del Big Bang.................................................................................................................54

8. Universo inflacionario...............................................................................................................................54

9. Inflación caótica.........................................................................................................................................60

10. Inflación autorregenerante.......................................................................................................................62

Capítulo IV. OTROS MODELOS COSMOLÓGICOS.................................................................................. 65

1. Modelo del estado estacionario............................................................................................................... 65

2. Modelo relativista del big bang................................................................................................................66

3. Modelo de la aceleración de la expansión...............................................................................................69

4. Modelo del universo pulsante...................................................................................................................71

5. Modelo cósmico de la “fuerza nuclear” (o “teoría unificada del espacio-tiempo-masa”)..................72

6. Modelo de la expansión de la escala del cosmos.....................................................................................73

7. Modelo de la oscilación entrópica............................................................................................................79

8. Modelos para la solución del llamado “problema de la desaparición del tiempo”.............................80

9. Modelo de Stephen W. Hawking..............................................................................................................83

10. Nuestro modelo cosmológico....................................................................................................................84

Capítulo V. ASTRONOMÍA OBSERVACIONAL.........................................................................................91

1. Estimaciones de interés.............................................................................................................................91

2. Parámetros cosmológicos de los distintos modelos relativistas.............................................................92

3. Valores de los parámetros cosmológicos.................................................................................................92

A. Sobre la constante de Hubble H0............................................................................................................92

B. Sobre el parámetro de densidad Ω0 (suponiendo ΩΛ=0)........................................................................93

C. Sobre el parámetro de densidad debido a una cte. cosmológica ΩΛ......................................................93

D. Sobre la edad del universo T0.................................................................................................................94

4.

Verificaciones y problemas en el modelo estándar...............................................................................94

0

A. Verificación de la teoría estándar........................................................................................................94

B. Divergencias respecto a la teoría estándar...........................................................................................96

I.

ACELERACIÓN DEL UNIVERSO........................................................................................... 96

II.

PROBLEMAS CON LA SIMETRÍA ROTACIONAL DEL U. A ESCALAS CÓSMICAS..... 97

C. En defensa del big bang...................................................................................................................... 98

Capítulo VI. TEORÍAS UNIFICADAS (GTU´s)...........................................................................................101

1. Introducción.............................................................................................................................................101

2. La intensidad fuerte...............................................................................................................................105

3. Cromodinámica cuántica QCD (Quantum Chromodynamics)..........................................................112

4. La interacción débil................................................................................................................................118

5. Resumen de las teorías GTU..................................................................................................................123

Capítulo VII. SUPERSIMETRÍA. SUPERGRAVEDAD..............................................................................129

Capítulo VIII. SUPERCUERDAS Y TEORÍA M.........................................................................................135

1. Supercuerdas...........................................................................................................................................135

2. La teoría M..............................................................................................................................................147

Capítulo IX. RESUMEN DE NUESTRA TEORÍA. IMPLICACIONES.....................................................165

Capítulo X. NOTICIAS Y TENDENCIAS EN ASTRONOMÍA.................................................................181

BIBLIOGRAFÍA..........................................................................................................................................185

1

PRÓLOGO

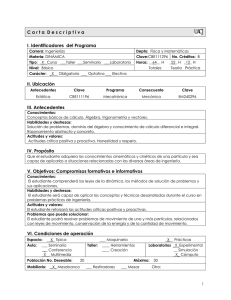

En esta obra se ha pretendido un doble

objetivo. En primer lugar hemos

intentado hacer llegar al lector una visión

actual de la cosmología de nuestra época;

y es que constituye prácticamente un libro

de texto de amplia perspectiva, a la vez

que riguroso en algunas cuestiones.

Intencionadamente no se han evitado las

fórmulas que se consideran estrictamente

necesarias en un libro sobre Ciencias

Físicas, lo que por otro lado, aunque

parezca farragoso el incluirlas, permite

tomar una visión de conjunto bastante

clara de todo el panorama científico que

encuadra la cosmología moderna pisando

“suelo firme”, sin un exceso de literatura

que acercaría más el libro a la ciencia

ficción en la que, lamentablemente, caen

muchos textos de divulgación.

Así que, si lo que se busca es, en una sola

obra, tener una ancha visión de

cosmología, este libro cumplirá ese

cometido. Al mismo tiempo, dada la

importancia tan substancial que está

adquiriendo la red informática global de

interconexión, Internet, se han dado

muchas referencias de sitios Web, sobre

todo en lo que se refiere a los distintos

modelos teóricos de universo, de los que

se ha sacado bastante texto de la obra.

En segundo lugar, hemos aprovechado la

ocasión tan inmejorable que nos ofrecía el

trabajo para aportar nuestro “granito de

arena” en la construcción de un modelo

cada vez más perfeccionado del Universo,

más allá del modelo estándar: nuestro

propio modelo, descrito en el Capítulo II

(5.c), Capítulo IV (10) y Capítulo IX.

2

materia. A ello se dedican el Capítulo VI

citado, el VII y el VIII.

La obra consta de nueve capítulos. En el

I, se repasa la base de la teoría

matemática que subyace en las teorías del

espacio-tiempo, entre las que se incluye la

Relatividad General einsteniana. El

capítulo puede resultar un poco

complicado para los que no tengan una

base matemática media, no obstante

aunque no se entienda toda la

formulación, sí puede obtenerse una idea

de cómo se construye el edificio

matemático en que están basados

prácticamente todos los modelos de

universo que gozan de la máxima

credibilidad en el estamento científico.

El Capítulo VI estudia con carácter

general las Teorías Unificadas de la

Física, GTU, en su búsqueda de la misma

base de la constitución de la materia.

El Capítulo VII hace un resumen de la

teoría Supersimétrica, adentrándose en los

terrenos de la Supergravedad.

En el Capítulo VIII es la popular teoría de

las Supercuerdas la que ocupa nuestro

interés, rematada por la teoría del Todo o

la teoría M, como extensión de las

propias Supercuerdas.

El Capítulo II entra ya de lleno en el tema

que nos ocupa, puesto que todos los

conceptos usados generalmente en

cosmología práctica van apareciendo.

La obra termina con una breve historia de

los hitos más importantes habidos en la

Astronomía científica, rematada con las

últimas observaciones más relevantes

logradas por nuestra tecnología actual.

El siguiente Capítulo, el III, está dedicado

monográficamente a la Inflación, dado

que la mayoría de modelos, entre ellos el

estándar, la incluyen entre sus

fundamentos.

Inmediatamente antes, en el Capítulo IX,

es ofrecido un resumen de la teoría que

proponemos con las implicaciones y

cuestiones que pretende resolver.

El Capítulo IV nos ofrece, como

ejemplos, diez tipos de modelos de mayor

o menor solidez científica; aquí no

entramos en su valoración, simplemente

se ofrecen como forma de aproximación

al abanico de ideas que se barajan en

cosmología. Claro está, el modelo

científico preferido es el estándar

obtenido a partir de la Inflación.

Una vez más es preciso aclarar al lector

que la obra, con separación de las partes

correspondientes a los capítulos donde se

expone nuestra teoría (ya citados), por lo

demás podría constituir un libro de texto

con el carácter de imparcialidad que suele

adornar a los mismos, como una de las

características principales que avalan su

utilidad. Queremos decir que su lectura

no induce a la adopción de una u otra

teoría, en detrimento de las demás, y es

que pretende ser bastante aséptica,

consecuencia, quizás, de su carácter

eminentemente descriptivo.

El Capítulo V está dedicado a La

Astronomía Observacional, dándose en el

mismo los valores más fiables de los

parámetros obtenidos hasta el presente.

Ya en el Capítulo VI se inicia el estudio

del universo “primordial”, que según se

cree tiene estrechos vínculos con el

mundo submicroscópico, o de los

componentes fundamentales de la

Otra cosa, sin duda, aparece en la parte de

la obra dedicada a la enunciación de

nuestra teoría cósmica. Aquí sí

3

una continuación en la misma senda que

siguieron Kaluza y Klein, y todos los

creadores de las teorías unificadas. Esa

extrapolación va más allá de la espuma

cuántica del espacio-tiempo de Valenkin.

Ni siquiera esa espuma cuántica es

primordial. Antes de la “Creación”, de su

aparición de la Nada, ésta última, matriz

de ella, no era el vacío cuántico (por

cierto tan particular y altamente

“estructurado”) propuesto por las

recientes teorías físicas. Hasta dicho

vacío cuántico aparece casi a la vez que el

mismo espacio-tiempo. El minúsculo

átomo primordial, supermasivo y

supercaliente, estrechamente vinculado a

la incertidumbre cuántica de Heisenberg,

es la expresión de las leyes físicas en su

más alto grado de unificación, verdaderas

constructoras de la propia espuma

cuántica, con su aparición explosiva,

subsiguientemente

materializada

en

espacio-tiempo.

encontramos ideas propias acuñadas bajo

una filosofía de globalidad que va más

allá de lo que sería una teoría física, sin

que por otra parte dejemos de lado a la

misma, por lo menos la teoría física más

actual, adentrada en terrenos que hasta

hace

relativamente

poco

más

corresponderían al dominio de la

Filosofía, y hasta de la misma Psicología.

Y nos estamos refiriendo a las

consecuencias de la explicación del papel

del “observador”, en suma de la propia

mente en la “definición” de la realidad, en

el llamado “colapso” de la función de

ondas definido por Roger Penrose.

Conceptos como la holografía, la teoría M

o la multidimensionalidad, nos adentran

en una teoría del Todo, definida

indisolublemente

junto

o

inseparablemente a sus partes, lo que da

un carácter holístico a la Física y con ello

a todo el Universo.

La Nada es nada, no el vacío cuántico

(falso o real). El “acto” de creación

incluye el vacío cuántico, la espuma

cuántica, y las siguientes fases de

espacio-tiempo, materia y radiación. El

“salto” desde la Nada incluye todo lo

anterior, hasta el propio vacío. Una vez el

“acto creativo” se produce, todo lo

anterior se configura. No es necesario un

vacío (cuántico) en el que aparecen

universos-burbuja aquí y allá. No existe el

aquí, ni el allá, ni el propio vacío sobre el

que se definen. Toda definición es

consecuencia de la “aparición” de la Ley

Física Unificada (de la que se deducen

todas las demás). Lo anterior, lo previo,

es simplemente Nada.

Se ha dicho que se vislumbra un

horizonte en el que todo queda

entrelazado, es decir, va deduciéndose de

unas teorías globales, cada vez más

unificadas, de forma que ya no se necesita

un Creador para la creación de la materia,

el espacio y el tiempo, el mismo

Universo; ahora bien, sigue subsistiendo,

cada vez más nítido, el papel de un

“Forjador” de las propias leyes de ese

Universo, y en este sentido sí existiría un

Creador de leyes, creador de la base para

que todo se manifieste.

Nuestra teoría, como casi todo en

cosmología tiene fuertes implicaciones

filosóficas. El salto magistral promovido

por el propio Einstein, al sustituir, al

transmutar algo tan sólido, tan pétreo

como las propias masa de los cuerpos y

su pesadez, en luz-energía y simplemente

geometría, del espacio-tiempo, se nos ha

quedado insuficiente. Mejor, necesita de

4

5

CapítuloI.GRAVEDAD RELATIVISTA

∑ij=1n gij dxi dxj = ∑ij=1n gij dxi dxj

1.Teorías del espacio-tiempo

Ello no ocurre si se cambia de geometría

pasando, por ejemplo de una euclídea una

curvada no euclídea. El tensor métrico

queda cambiado en la forma:

En 1984, Riemann considera espacios o

variedades de un número cualquiera de

dimensiones; los puntos de estas

variedades

quedan

unívocamente

determinados por n-tuplas de números

reales. Si establecemos en una de tales

variedades un sistema de coordenadas x1,

x2,.....,xn, podemos definir un elemento de

arco en n dimensiones, llamado tensor

métrico mediante la fórmula:

ds2 = ∑ij=1n g*ij dxi dxj

Si la métrica ds2 no es euclídea, no existe

ningún sistema de coordenadas en el que

g*ij= diag (1,1,.....1).

Resumiendo, se puede considerar una

variedad riemaniana n-dimensional como

una forma o esquema abstracto que

podemos “rellenar” mediante distintos

tensores métricos para obtener diferentes

espacios geométricos concretos. La

variedad n-dimensional abstracta carece

de estructura geométrica (métricamente

amorfa) hasta que en ella no sea definido

un tensor métrico. Tal variedad abstracta,

entonces, solamente posee una estructura

“topológica” localmente euclídea como

resultado de la utilización como

coordenadas de n-tuplas de números

reales.

ds2= Σnij=1 gij dxi dxj

(Recordemos que en coordenadas

continuas, el arco adopta la forma

habitual:

ds2= dx12+ dx22

que en coordenadas

arbitrarias adopta la forma:

ds2= g11 dx12+ g12 dx1 dx2 + g21 dx2 dx1+

g22 dx22)

Con la condición de simetría ( gij= gji) y

ds>0 (si se renuncia a la última condición

de definida positiva se obtienen métricas

semirriemanianas, que tienen un papel

importante en la Relatividad). Riemann

nos muestra cómo definir la curvatura en

tales variedades. Para el caso especial de

las variedades euclídeas o “llanas” existen

coordenadas en las cuales la matriz de

coeficientes (gij) adopta la forma diagonal

(1,1.....,1), o sea, gij=1 si i=j y gij=0

cuando i≠j. (Si la métrica es

semirriemaniana y llana gij= diag (±1,

±1,.....,±1).

En un espacio euclídeo n-dimensional, el

nivel mínimo de estructura es la

estructura métrica que corresponde a un

elemento de arco dado por el teorema de

Pitágoras:

ds2 = dx12+dx22+.......+dxn2 (1)

La citada estructura proporciona una

longitud para cada curva, una distancia

entre dos puntos cualquiera, una noción

de línea recta y también una noción de

ángulo entre dos rectas que se corten

entre sí. Sin embargo, algunas de estas

mismas nociones son más generales que

la estructura anterior. Por ejemplo, la

estructura afín, o clase de líneas rectas,

dada por la condición xi= ai u+ bi (siendo

Entonces, si sólo se cambia de

coordenadas, de x1, x2,......xn ,a x1, x2,.xn,

los coeficientes gij se transforman en los

gij, y el elemento de arco se preserva:

6

ai y bi constantes, y el parámetro u

recorriendo el conjunto de los números

reales), es más amplia que la clase de

sistemas de coordenadas que verifican

(1). (Métricas distintas pueden originar

una misma estructura afín). También la

estructura conforme, relacionada por la

noción de ángulo, es de igual forma, más

general que la estructura métrica (1),

puesto que si Ω es una función cualquiera

con valores reales positivos definida

sobre nuestro espacio, entonces ds2=Ω ds2

proporciona los mismos ángulos que ds2.

Por último, el nivel más alto de estructura

es justo la propia estructura de variedad:

la topología de espacio localmente

euclídeo n-dimensional.

Topología (Estructura de variedad)

Transformaciones bicontinuas arbitrarias

↑

↑

Ángulos

Transfor.conformes

Líneas rectas

Transfor.afines

↑

↑

Estructura métrica

Isometrías

El sistema de cooordenadas:

x1 = x1 – vt

x2 = x2

x3 = x3

La estructura métrica queda preservada

por las isometrías o movimientos rígidos,

que en un espacio euclídeo tiene la forma:

(3)

recibe el nombre de referencia inercial; la

transformación (3) se denomina galileana.

x*i = ∑j=1n αij xj+ βi Las αij y las βi son

ctes. Y la matriz (αij) es ortogonal; o sea,

Einstein demostró que un principio de

relatividad para la electrodinámica

consiste en dejar intactas las leyes de

Maxwell de dicha electrodinámica y

modificar,

en

cambio,

las

transformaciones que definen las

referencias inerciales, de la forma:

∑j αij αkj = δik =1 si i=k y 0 si i≠k

(El grupo euclídeo no es más que el grupo

de rotaciones y traslaciones)

La estructura topológica es preservada

por las transformaciones arbitrarias:

t = ( t – v x1/ c2 ) / (1 – v2/ c2)1/2

x1= (x1 – vt) / (1 – v2/ c2)1/2

(2) x*i = fi (x1, x2,......xn) donde las fi son

suficientemente continuas.

x2 = x2

O sea, según nos movemos hacia niveles

más y más generales de estructura

geométrica,

los

grupos

de

transformaciones asociados se van

haciendo cada vez más amplios.

x3 = x3

que se denominan transformaciones de

Lorentz(4). De éstas ultimas se deduce

que la velocidad c de la luz, se preserva,

es decir, es constante.

(2) Es el grupo de las transformaciones de

coordenadas

admisibles

(esto

es,

biunívocas y suficientemente continuas).

Las transformaciones de Lorentz son la

base de la relatividad restringida. Dicha

teoría, según la interpretación geométrica

7

° σ(u) y las

Donde

xi = xi

Tjki(i,j,k=0,1,2,3) son funciones realvaloradas, llamadas componentes de la

conexión afín D, que depende del sistema

de coordenadas {xi }. Precisamente se

dice que una variedad afín es llana o

euclídea en un punto p cuando puede

hallarse un sistema de coordenadas

locales en p tal que todas las funciones

Tjki se anulen. Tal sistema de coordenadas

se llama sistema cartesiano o inercial, y

en el se cumple:

de Minkowski, que data de 1908, describe

una

variedad

tetradimensional

semieuclídea, cuyo elemento de arco

viene dado por:

(5) ds2 = dx02-dx12-dx22-dx32 siendo x0=ct

En esta teoría las referencias inerciales

son los sistemas de coordenadas

cartesianas correspondientes a este

elemento de arco. Las transformaciones

de Lorentz preservan la forma cuadrática

(5) correspondiente a ds2, desempeñando,

pues, un papel análogo al de las

transformaciones ortogonales euclídeas.

Las trayectorias, o “líneas del mundo”, de

las partículas libres son “líneas rectas” o

geodésicas de la métrica (5): curvas

tetradimensionales de longitud mínima,

medida según ds, y que satisface la

ecuación afín, xi= ai u+ bi, en todas las

referencias inerciales.

DTσ Tσi = d2xi/ du2 = la aceleración

ordinaria.

Las geodésicas verificaran:

d2xi/du2 =0 , xi = ai u + bi con ai y bi ctes.,

es decir, las geodésicas son líneas rectas

ordinarias, lo que no cumplen las

variedades no-euclídeas, curvadas o

alabeadas.

Suponiendo que nos den una curva σ y un

campo vectorial X-(p) definido sobre

puntos situados sobre σ , y donde X-(p)

es una selección continua y diferenciable

de vectores elegidos cada uno en el

espacio tangente de la variedad en cada

punto p de σ, dado Tσ (campo vectorial

tangente a σ ), X(p) y un punto q situado

sobre σ, un operador de derivación D nos

proporciona un vector (DTσ X) (q) en Tq

que registra la tasa y la dirección del

cambio de X(p) en q. (Conexión afín si

posee las propiedades que una derivada

debe tener).

Pero la variedad afín anteriormente

definida aún adolece de una estructura

métrica, pues no se han definido, todavía,

la longitud o distancia.

Si σes la longitud de la curva σ(t)

definida en un proceso de rectificación

(resultado de dividir la curva en pequeños

segmentos infinitesimales acoplados a los

puntos de la misma, y sumados después)

es fácil demostrar que:

σ= ∫σ Tσ(T) dt

siendo

Tσ(T)=((dx/dt)2+(dy/dt)2+(dz/dt)2)1/2

Una variedad afín, es decir una variedad

equipada con un operador de derivación

(conexión afín), posee una geometría. En

ella hay una clase privilegiada de “líneas

rectas”, o geodésicas, que cumplen DTσ

Tσ =0. Explícitamente están dadas por

o en otras palabras, la longitud de una

curva del espacio euclídeo tridimensional

es el resultado de integrar la longitud

“infinitesimal” del vector tangente Tσ (t)

= (dx/dt,dy/dt,dz/dt) sobre la curva entera.

DTσ Tσi = d2xi/ du2+ Tjki dxj/du * dxk/du

8

; el ángulo α comprendido entre dos

vectores X,Y de Tp, es definido como

cos(α) = gp(X,Y)/XY, y la longitud de

cualquier curva σ(u), mediante la

fórmula:

σ= ∫σTσ(t)dt =

∫σ (gσ(u) (Tσ(u),Tσ(u))1/2 du.

Si nos fijamos, la cantidad que aparece en

el radicando anterior es el producto

escalar o producto interior euclídeo del

vector tangente Tσ (t) por sí mismo. En

general, el producto escalar de dos

vectores X = (a1,a2,a3) e Y = (b1,b2,b3) de

R3 viene dado por X*Y =a1b1+a2b2+a3b3 ,

y tiene las siguientes propiedades:

También, una noción de geodésica

geométrica, es la de una curva de longitud

mínima (extremal).

X*X>0 si X≠0 (positiva definida)

X*V = V*X

(simetría)

X*Y =0 para todo Y, si y solo si X=0 (no

singularidad)

Si la variedad posee estructura afín (un

operador de derivación) y estructura

métrica (tensor métrico riemaniano), es

preciso exigir que las dos nociones de

geodésicas coincidan: una curva es una

geodésica afín (la línea más recta) justo

en el caso de que sea una geodésica

métrica (la curva más corta). O sea, que la

métrica g es compatible con D. Entonces,

esta variedad se llama riemaniana. En el

caso de que g sea semirremaniana la

situación se complica algo y en general

las geodésicas afines no serán extremales,

aunque todas las geodésicas afines lo

serán de carácter temporal o cromomorfas

(caso de g(Tσ,Tσ)>0) o de carácter

espacial o espaciomorfas (si g(Tσ,Tσ)<0).

X*Y también, es lineal; o sea:

X*(aY+bZ)=a(X*Y)+b(X*Z) donde a y b

son números reales.

Y el

producto es lineal en ambos

argumentos.

Entonces, este producto escalar, forma

bilineal con valores reales definida sobre

el espacio tangente a cada punto de una

curva, es la métrica “infinitesimal” que

buscábamos. Nos proporciona una

longitud para cada curva por integración c

para cada vector tangente Tσ (t), y una

función distancia d(p,q)= longitud de

curva más corta trazada entre p y q.

Dado un sistema de coordenadas {xi},

Tσ(u) se convierte en una cuaterna de

funciones de valores reales (d(xi°σ)/du), y

puede demostrarse que la función

g(Tσ(u),Tσ(u))= gij dxi/du dxj/du donde

xi=xi°σ(u) y las gij (i,j=0,1,2,3),

componentes del tensor métrico, son

funciones reales dependientes del sistema

de coordenadas {xi}. Las componentes

gij forman una matriz de 4*4. Por cada

punto p, puede hallarse un sistema de

coordenadas tal que la matriz anterior

quede diagonalizada con todos los

elementos de la diagonal iguales a ±1 en

p. O sea:

Es fácil generalizar todo lo anterior a

otras

variedades

arbitrarias,

no

necesariamente euclídeas. Un tensor

métrico riemaniano es cualquier función

bilineal g(X,Y) de valores reales, definida

sobre el espacio tangente en cada punto y

que verifica las tres condiciones

anteriores. (Si g(X,Y) sólo verifica la

segunda y la tercera, recibe el nombre de

tensor

métrico

semirriemaniano).

Entonces, dado tal tensor métrico,

definimos la longitud X de cualquier

vector de Tp mediante la ecuación

X2 = gp(X,Y)

9

±1 0 0 0

0 ±1 0 0

(gij)= 0 0 ±1 0 = diag (±1,±1,±1,±1)

0 0 0 ±1

Si la variedad es llana, puede encontrarse

un sistema de coordenadas en el que las

partículas libres obedecen a la ecuación:

d2xi/du2=0 (ley de la inercia newtoniana)

en p.

El sitema de coordenadas para el que Tjki

=0 se denomina referencia inercial.

El par (n+,n-), donde n+ es el número de

elementos positivos de la diagonal y n- el

número de elementos negativos de la

misma se llama “signatura” de g.

Sobre la variedad espacio-tiempo M, a

cada función t que asigne números reales

a los puntos de M se asocia una segunda

función dt que va de los vectores

tangentes en M a los números reales, tal

que para cada vector tangente X,

dt(x) =X t y t´ definen la misma función

dt, puesto que X(t-b)=Xt.

Precisamente, se dice que una métrica

(semi) riemaniana es llana o (semi)

euclídea en p cuando puede hallarse un

sistema de coordenadas (sistema (semi)

cartesiano) en torno a p tal que gij=

(±1,±1,±1,±1) en un entorno de p.

La función dt es también un operador

lineal definido sobre el espacio tangente

Tp:

Dt(aX+bY)=a dt(X)+b dt(Y) cualesquiera

sean los vectores X e Y de Tp, y las

constantes a y b. La colección de todos

estos operadores lineales definidos por Tp

se denota Tp* y es el espacio cotangente

en p. Los elementos de Tp* reciben el

nombre de covectores, y los vectores

tangentes pertenecientes a Tp se les llama

contravectores. En general, a cada

covector w está asociada una familia

{fw} de funciones reales tales que

w(X)=X(fw)

para

todos

los

contravectores X. Los números reales

tales que wi= ∂ (fw)/∂xi se denominan

componentes de w en {xi}. Las

componentes de dt están dadas por:

Entonces, sobre una variedad riemaniana

llana, la fórmula correspondiente a

Tσ(u) será:

Tσ(u)2 =(dx0/du)2+(dx1/du)2+(dx2/du)2+

(dx3/du)2

, o sea, la fórmula euclídea en cuatro

dimensiones.

Tanto si el espacio-tiempo (las tres

dimensiones espaciales, mas el tiempo

tomado como otra dimensión) es tenido

por llano como si no, todas las teorías

coinciden en que las partículas libres, o

sea, aquellas sobre las que no actúan

ninguna

fuerza

exterior,

siguen

geodésicas de su estructura afín. En otras

palabras, las partículas obedecen a la

siguiente ecuación del movimiento:

Ti= ∂t/∂xi=∂(t+b)/∂xi

Con todo esto, la primera versión de la

cinemática newtoniana es la siguiente. Se

postula en la variedad espacio-tiempo M

los siguientes objetos geométricos: una

conexión afín D, un campo de covectores

dt, un campo h de tensores métricos de

tipo (2,0) (o sea, cada hp está definido

DTσ Tσ = 0

Que referida al sistema de coordenadas

{xi} se traducen en:

d2xi/du2 + Tjki dxj/du dxk/du = 0

10

sobre Tp*×Tp*) con signatura (3,0,1) y un

campo V de vectores contravariantes (V

es un campo vectorial, y las curvas σ que

se adaptan a V, es decir T0=V a lo largo

de σ constituyen las líneas de nuestro haz.

Como queremos que estas líneas tengan

carácter temporal, se exige que dt(V)=1, y

como también deseamos que sean

geodésicas, se exige D(V)=0).

Las ecuaciones de movimiento para las

partículas libres toman la forma:

Si K(ver en este capítulo *) es el tensor de

curvatura, tendremos que los anteriores

objetos “geométricos” deben cumplir las

siguientes ecuaciones de campo:

Una forma natural de expresar la ley del

movimiento

correspondiente

a

la

dinámica de Newton es :

d2xi/du2+ Tjki dxj/du dxk/du=0 y la forma

ti(dxi/du)=0 para partículas arbitrarias.

Que puede expresarse en la forma:

d2xi/dt2 + Tjki dxj/dt dxk/dt = 0

m(d2xi/dt2+Tjki dxj/dt dxk/dt) = Fi siendo

m la masa de la partícula y Fi un campo

vectorial espacial.

K=0

D(dt)=0 Para que los planos de

simultaneidad sean llanos(euclídeos en

sentido afín, es decir, la derivada

covariante de dt con respecto a nuestra

conexión afín D sea nula)

O sea, m d2xi/dt2 =Fi , forma familiar de

la segunda ley de Newton.

En el campo gravitatorio F = m G, siendo

G el campo gravitatorio que es el opuesto

del gradiente del potencial gravitatorio Φ:

G=-∇Φ ∇ es (∂Φ/∂x,∂Φ/∂y,∂Φ/∂z)

D(h)=0 Condición de conexión llana.

h(dt,w)=0 Para que hp sea singular y

definida

sobre

el

subespacio

tridimensional “espacial” de Tp.

También, el potencial Φ está relacionado

con la densidad de masa ρ mediante la

ecuación de Poisson:

D(V)=0

∇2Φ = 4πKρ (k es la cte.gravitatoria de

Newton)

∇2 es la laplaciana tridimensional

(∂2Φ/∂x2,∂2Φ/∂y2,∂2Φ/∂z2).

dt(V)=1

Tales ecuaciones de campo expresadas en

función de las componentes de los objetos

con respecto a {xi} adoptan la expresión:

Entonces las ecuaciones de campo serán:

Rijkl = 0

t;j = 0

hij;k = 0

hijti = 0

vi;j = 0

t i vi = 0

k=0

D(dt) = 0

D(h) = 0

h(dt,w) = 0

del (Φ) = 4πkρ

Y expresada en componentes:

donde las vi son las componentes de V,

las Rijkl de K.

11

Rijkl = 0

ti;j = 0

hij;k = 0

hij ti =0

hij;i;j =4πkρ

En (6) puede eliminarse de ambos

miembros m, obteniendose:

Para la 2ª ecuación del movimiento se

adopta la forma covariante de la segunda

ley de Newton:

Entonces, introducimos una conexión D

cuyas componentes son:

(7) d2xi/dt2+T°jki dxj/dt dxk/dt=-hir Φ;r

(D° es la conexión llana)

(8) Tjki = T°jki = hir Φ;r tj tk

ir

mDTσTσ = -mh Φ;r

y para las leyes del movimiento:

Así que la ecuación (7) puede

nuevamente ser escrita en la forma:

m(d2xi/dt2+Tjki dxj/dt dxk/dt)=-mhirΦ;r (6)

∂2xi/dt2+Tjki dxj/dt dxk/dt = 0

Para un sistema inercial de coordenadas

{xi}, tenemos:

Tjki = 0, (ti)=(1,0,0,0) y (hij)=diag(0,1,1,1)

Así que la última ecuación de campo se

convierte en:

Por tanto, nuestras ecuaciones de

movimiento pueden ser interpretadas

como geodésicas correspondientes a la

conexión D. Esta conexión no es llana, y

en este caso el tensor de la curvatura de

D está dado por:

∂2Φ/∂x12+∂2Φ/∂x22+∂2Φ/∂x32=4πkρ

Rijkl = 2 tj hir Φ;r;(ktl)

2

o sea ∇ Φ = 4πkρ

El “tensor de Ricci” de la conexión D está

dado por:

En el espacio libre, se tiene ρ=0 y del(Φ)

=0, que en sistemas inerciales se reduce a:

Rjk = Rajka = -har Φ;a;r tj tk

2

∇ Φ=0

y al comparar esta expresión con la

ecuación de Poisson anterior del (Φ) =

4πkρ , la ecuación de Poisson, ahora

equivale a :

Rjk = -4πkρ tj tk

que en el

espacio libre se reduce a Rjk = 0.

En los sistemas inerciales las ecuaciones

del movimiento se convierten en:

m d2xi/dt2 = -m ∂Φ/∂xi (2ªley de Newton)

Ahora intentaremos “eliminar por vía

geométrica” las fuerzas gravitatorias en el

contexto de la teoría newtoniana,

haciendo que el potencial gravitatorio

quede incorporado a la conexión afín. El

método es construir un nuevo operador de

derivación D, que esta vez no sea llano,

afirmando que las partículas que caen

libremente, es decir, que tan sólo están

afectadas por la gravitación, sigan las

geodésicas de D.

Entonces las ecuaciones de campo

expresadas en sus componentes quedan:

ti;j = 0

hij;k = 0

hijti = 0

Rjk = -4πkρ tj tk

T(aRij)kl = 0

hia Rjkal = hja Rilak

12

y para las ecuaciones del movimiento:

; t puede utilizarse como parámetro para

cualquier curva temporal, y en un sistema

inercial {xi} se puede escribir las

ecuaciones de la misma de la forma xi(t)

= xi o σ(t). Así que hay dos tipos de

tiempo asociados a la trayectoria de una

partícula: el tiempo independiente del

sistema de coordenadas, o tiempo propio

τ, y el tiempo dependiente de las

coordenadas, o tiempo coordenado t.

d2xi/dt2+Tjki dxj/dt dxk/dt = 0

La cinemática de la relatividad especial es

de una gran sencillez. Se tienen sólo dos

“objetos” geométricos: una conexión afín

D y un tensor métrico g de tipo (0,2) y

signatura (1,3) (signatura característica de

una métrica lorentziana). Se tienen dos

ecuaciones de campo:

Igualmente hay dos tipos de vectores

velocidad: la velocidad propia u, de

componentes ui = dxi/dτ y la velocidad v

según coordenadas de componentes vi =

dxi/dt.

K=0

D(g) = 0

Estas ecuaciones expresan que el espaciotiempo de Minkowski es una variedad

llana y semirriemaniana. Las ecuaciones

del movimiento exigen que todas las

partículas describan curvas temporales y

que las partículas libres tracen geodésicas

temporales:

Como τ(t)=∫ta (gij dxi/dt dxj/dt dt)1/2

dτ/dt=(gij dxi/dt dxj/dt)1/2 =

((dx1/dt)2+(dx2/dt)2+(dx3/dt)2 )]1/2

[1-

O sea: dτ/dt = (1-v2)1/2 ;y como ui

=dxi/dτ =(dxi/dt)/(dt/dτ) tenemos como

componentes de u:

u0 =dx0/dτ = 1/(1-v2)1/2

ui =vi/(1-v2)1/2 = vi/(1-v2)1/2 (i=1,2,3)

;siendo las vi las componentes de la

velocidad tridimensional v.

DTo To = 0

Y en sus componenetes, las ecuaciones de

campo adoptan la forma:

Rijkl = 0

gij;k = 0

La ley del movimiento de la dinámica

newtoniana es:

y las ecuaciones del movimiento:

d2xi/ dτ2+Tijk dxj/dτ dxk/dτ = 0

m (DTσ(t) Tσ(t)) = F ;donde F es un

campo vectorial espacial, t cualquier

función tiempo (dt(X)=Xt para todo t) y

m la masa de la partícula.

En un sistema inercial {yi}, una geodésica

temporal σ(t) verifica las ecuaciones:

d2 (xi°σ)/dτ2 = 0 . Las soluciones son

xi= aiτ+bi , siendo ai y bi constantes. Por

consiguiente, t = x0 = a0τ+b0 es un

parámetro

afín

sobre

geodésicas

temporales. Dado que en sistemas

inerciales se verifica Tijk = 0, las

geodésicas temporales cumplen:

La correspondiente

relativista es :

de

la

dinámica

m0 (DTσ(τ) Tσ(τ)) = F ; donde F es un

campo vectorial espacial ortogonal a Tσ ,

τ es el tiempo propio y m0 es la masa en

reposo de la partícula.

d2xi/dt2 = 0

13

En sistemas inerciales de coordenadas, la

ecuación anterior se convierte en:

Si definimos la masa relativista como

m=p/v se encuentra m = m0/(1-v2)1/2. (En

todos estos cálculos se ha considerado

c=1).

m0 d2xi/dτ2 = Fi ; o también d (m0 ui)/dτ

= Fi , donde ui es la velocidad propia

dxi/dτ. El vector tetradimensional pi=m0ui

es el análogo relativista del momento

clásico. Encontramos que pi puede

expresarse en la forma:

(9) p0=m0/(1-v2)1/2;

siendo i = 1,2,3.

Si se define la energía relativista

mediante la ecuación dE/dt = v dp/dt

, se encuentra E=m0/(1-v2)1/2 + E0. Si E0

se hace igual a cero, la energía relativista

será E= m0/(1-v2)1/2 =m. (10)

pi=m0vi/(1-v2)1/2

Comparando (9) y (10) se observa que el

vector

tetradimensional

pi

tiene

componentes (E, p) donde p es el vector

tridimensional de momento relativista;

por ello el vector pi recibe el nombre de

vector energía-momento.

La cantidad p = m0v/(1-v2)1/2 es la

magnitud del momento relativista

tridimensional.

14

gravitatorio, y una ecuación que ponga en

relación a un objeto geométrico que

represente la curvatura del espaciotiempo, con un objeto geométrico que

represente la fuente de ese campo

gravitatorio. En la teoría newtoniana nos

servimos de la densidad de masa ρ como

fuente del campo gravitacional, pero

también puede considerarse como

variable “fuente” al tensor momento P =

ρ (u⊗u), donde u es el campo vectorial

de velocidad de la distribución de masa.

El homólogo relativista de este tensor es

el tensor energía-momento. Pero, si la

energía mecánica de nuestra distribución

de masa sirve como fuente para el campo

gravitatorio, también pueden serlo otras

formas de energía, lo que llamamos el

tensor esfuerzo-energía T, que da cabida

al

energía-momento

de

nuestra

distribución de masa, así como a

cualesquiera otras formas de densidad de

energía.

2 . Relatividad General

Es una teoría de la gravitación formulada

en el contexto de las concepciones del

espacio y tiempo propias de la relatividad

especial.

La teoría gravitatoria da cuerpo a las

concepciones newtonianas del espaciotiempo en virtud de su tiempo absoluto dt

y su métrica espacial h. Para preservar el

espacio-tiempo relativista, se reemplaza

el tiempo y la métrica anteriores por la

métrica g relativista. Puesto que esta

última es no-singular, nuestro espaciotiempo es una variedad semirriemaniana.

Luego la métrica g y la conexión curva D

no

pueden

desempeñar

roles

independientes; por el contrario, la

condición D(g) = 0 implica:

Tjki={jki}=1/2gir(∂grk/∂xj+∂grj/∂xk-∂gjk/∂xr)

(Esta ecuación constituye la definición

clásica de una conexión semirriemaniana.

Los números del 2º miembro de la misma

están habitualmente denotados por los

símbolos de Christoffel “{jki}”. A una

conexión semirremaniana le están

asociados cierto número de otros tensores

importados. En primer lugar el tensor de

Ricci, Ric = tr13 K, de componenetes Rjk

= Rmjkm. En segundo lugar el escalar de

curvatura, R = tr11 G*i Ric, también dado

por R = gmn Rmn ).

La comparación con la teoría newtoniana

induce a pensar que el tensor de Ricci es

el objeto geométrico apropiado para la

representación de la curva del espaciotiempo. La ecuación de campo

gravitatoria debería poner en relación el

tensor de Ricci con el tensor de esfuerzoenergía. La relación más sencilla posible

sería la de proporcionalidad, Ric = χ T,

pero como T es la densidad de masa y

energía total, queremos que satisfaga la

ley de conservación div (T) = 0, por lo

que deberíamos buscar un tensor

conservativo construido a partir del tensor

de Ricci. Este tensor existe, es el tensor

de Einstein, ζ = G*1 G*2 Ric –1/2 R g*,

que verifica div (ζ) = 0, y cuyos

componentes son ζij = gim gjn Rmn–1/2 gijR

De la segunda identidad de Bianchi (a

saber, Rijkl;m+Rijmk;l +Rijlm;k =0) se deduce,

por contracción, que ζ es conservativo :

div (ζ) = 0.

Lo anterior es igualmente cierto en

relatividad especial. La métrica g, al igual

que la conexión D es no-llana, es decir,

no existen, en general, sistemas de

coordenadas en los cuales (gij )= diag (1, 1, -1, -1), no obstante, sí podemos tener

esto en cualquier punto dado p ∈M en

tanto que g conserve signatura {1,3}.

Nuestro problema consiste en dar una

ecuación de campo para el campo

15

El escalar de curvatura,R, está dado por R

= gab Rab. Tomamos, pues, como ecuación

de campo la ecuación ζ = χ T, y para que

sea posible deducir como límite la teoría

newtoniana se hace χ = -8π k, donde k es

la constante gravitatoria newtoniana.

En el espacio libre (11) se reduce a Rjk=0,

igual que en el caso newtoniano.

Esta teoría tiene,pues, tres objetos

geométricos: una conexión afín D, un

tensor métrico semirremaniano g de

signatura {1,3} y un campo de tensores

simétricos T de tipo (2,0).

Rjk –1/2 gjk R +Λ gjk = -8πk Tjk que es la

ecuación de Einstein con término

cosmológico Λ.

En las fórmulas anteriores puede incluirse

una constante Λ de pequeño valor, en la

forma:

Las ecuaciones del campo newtoniano

pueden reescribirse como:

Hay dos ecuaciones de campo:

G*1

2

Rjk = -4πk Pjk porque Pjk =Tja Tkb Pab =

ρtj tk lo que permite considerar el tensor

momento P como fuente del campo

gravitatorio.

*

G* Ric –1/2 R g = -8πk T

D (g) = 0

La ecuación del movimiento es la ley

geodésica:

DTσ Tσ = 0

Puede demostrarse que la ecuación

anterior newtoniana, puede ponerse en la

forma:

Y en términos de componentes:

Rjk = -8πk (tja tkb Pab –1/2 tjk tab Pab) (12)

Rjk –1/2gjk R = -8πk Tjk

Por otra parte la ecuación (11) relativista

en forma explícita es :

Gij;k = 0 donde Rjk = gja gkb Rab y

2

2

Rjk =-8πk (gja gkb Tab–1/2 gkk gab Tab) (13)

Tijk

d xi/dτ +

dxj/dτ dxk/dτ = 0 siendo τ,

desde luego, el tiempo propio.

(13) sólo se diferencia de (12) en que la

métrica temporal tjk ha sido reemplazada

gjk del espacio-tiempo, y en que en el

tensor momento Pab ha sido reemplazado

por el tensor energía-esfuerzo total Tab.

Así, pues, la relatividad general consiste

meramente en teoría newtoniana de

gravitación más relatividad especial.

Podemos bajar los índices para obtener:

(10) Rjk – ½ gjk R = -8πk Tjk donde Tjk =

gja gjb Tab

Multiplicando ambos miembros de la

ecuación anterior por gik, hallamos que R

=8πk T , donde T = gab Tab.

(*) Por último decir que el tensor de

curvatura Riemann-Christoffel es un

campo tensorial de valores reales y clase

C∞, de tipo (1,3), tal que:

Sustituyendo en (10), se obtiene:

Rjk = -8πk (Tjk –1/2 gjk T) (11)

Kp (wp; xp,yp,zp) = wp[R(yp,zp) xp]

16

Expresadas

en

un

sistema

de

coordenadas, {xi}, las componentes de

Tor (X,Y) están dadas por:

Ya hemos dicho que en relatividad

general el espacio-tiempo es considerado

una variedad riemaniana, cuya invariante

fundamental, el intervalo de universo,

puede expresarse también en la forma:

ai bj [ Tkij - Tkji] donde X =ai (∂ /∂xi) e Y =

bj ( ∂ /∂xj). Por tanto, D es simétrico si y

sólo si

Tkij = Tkji

ds2 = Gµν dxµ dxν dondeµ,ν = 1,2,3,4

Las componentes del tensor de curvatura

Riemann-Christoffel son:

Gµν es el tensor métrico que representa

los “potenciales de gravitación”.

Rijkl = k (dxi; ∂ /∂xj, ∂ /∂xk, ∂ /∂xl) =

∂Tijl/∂xk -∂Tijk/∂xl+Tmjl Timl- Tmjk Timl y

esta ecuaciín constituye la definición

clásica del tensor de curvatura.

Dijimos que la ecuación de Einstein se

escribía en la forma Gµν = χ Tµν , donde

el tensor métrico Gµν, aquí es el llamado

tensor de Einstein que contiene la parte

geométrica. Tµν representa el contenido

material y χ es una constante.

La importancia del tensor de curvatura

reside en que puede demostrarse que

existe un sistema de coordenadas en torno

a p∈M, en el cual las componentes de la

conexión afín se anulan si y solamente si

el tensor de curvatura se anula en p. En

tal sistema de coordenadas, la condición

de las geodésicas:

Cartan demostró que la forma más

general de Gµν, conservándose la energía

y para que la aproximación de primer

orden sean las ecuaciones mecánicas de

Newton, es:

Gµν = Rµν -1/2 Gµν(R-2Λ)

d2xk/du2+dxi/du dxj/du Tkij = 0

donde Rµν es el tensor de Ricci de la

variedad, R la curvatura escalar y Λ la

llamada constante cosmológica, propuesta

por Einstein, citada con anterioridad. Λ

realmente restringe la teoría, por ello

muchas veces se ha supuesto nula.

se convierte en d2xk/du2 = 0

Luego, si el tensor de curvatura se anula

en p, existe un entorno de p en el cual la

conexión afín se comporta de igual modo

que la “derivada direccional” euclídea

ordinaria. Por ello, esa región A⊆M o

entorno en el cual se anula el tensor de

curvatura se le da el nombre de llana o

semieuclídea.

El término Tµν o tensor material (energíaesfuerzo) es tomado normalmente en

cosmología como el correspondiente a un

fluido perfecto:

Una vez introducidos en los aspectos

teóricos de la relatividad general es

conveniente realizar un enfoque más

práctico del tema que nos ocupa, que es la

aplicación de aquella en cosmología. En

este enfoque es más idóneo cambiar de

notaciones para hacerlas más sencillas al

lector dotado de menor bagaje

matemático.

Tµν = (ρ c2+p) Uµ Uν -p Gµν

Donde: ρ es la densidad en reposo

c la velocidad de la luz

p la presión

Uµ la cuadrivelocidad Uµ =dxµ/ds

17

Para obtener las ecuaciones de los

modelos cosmológicos ortodoxos Gµν

suele deducirse de la siguiente métrica en

coordenadas cilíndricas:

Y el desplazamiento espectral:

Z = (λ0 - λ1)/λ1 = R0/R1-1

ds2= c2dt-R2(t)dr2/1-kr2+r2(dθ2+sen2θdϕ2)

Como siempre se encuentra (para objetos

alejados) que Z>0, se deduce que R0>R1;

en otras palabras, el universo se expande.

;donde R(t) es el llamado factor de escala.

K sería una constante conectada a la

curvatura espacial y que puede valer 0

(universo plano) y ±1.

Entonces, las ecuaciones de Einstein en

forma explícita quedan:

8πp = -k/R2-R2/R2-2R¨//R+1

8/3 πρ =k/R2+R2/R2+Λ/3

ρR3 = cte.

Siendo R la derivada de R respecto del

tiempo y R¨ la derivada segunda de R

respecto del tiempo.

2

Como para la luz ds = 0, entonces:

dt2/R2(t) = dr2/1-kr2.

Si se considera al observador en (0,t0) y la

fuente luminosa en (r1,t1), la relación

entre frecuencia emitida por la fuente y la

recibida por el observador será:

ν1/ν0 = δ t0/δ t1 = R(t0)/R(t1) = R0/R1

18

19

Capítulo II.

*El de distancia-luminosidad, dado por:

CONCEPTOS COSMOLÓGICOS

dL = (L/4πl)1/2 ; donde L es la

luminosidad intrínseca y l la recibida.

También puede expresarse por:

1.Parámetros

dL = R02 r1/R1 = r1 R0 (1+z) ; y

desarrollando R(t) alrededor de R0 se

obtiene:

*El de densidad:

Ω0 = 8π G/3 H02

ρ = ρ0/ρc

;y donde ρc = 3H02/8πG se conoce como

densidad crítica, al ser el valor frontera

entre los modelos cerrados y los abiertos.

G es la cte. de Newton.

R(t)=R0[1+R0/R0 (t-t0)+R0¨/2R0 (t-t0)2+..]

Definiendo H0 = R0/R0 (relación de

Hubble) y q0 = (R0¨-R0)/R02 (parámetro

de deceleración), se obtiene:

*El de presión:

dL = [z+(1-q0)/2 z2+....]/H0

ε =p/ρ ; que en muchos casos se toma

como nulo.

2.Estimación de distancias

*El de tiempo T, definido por:

Realmente son muchas las técnicas

utilizadas por los astrónomos para

resolver el problema de algo tan

importante como la distancia a que se

encuentran situados los distintos objetos

celestes.

T = H0 t ; donde H0 es la constante de

Hubble y t el tiempo transcurrido desde el

inicio de la expansión.

Cuando p = 0 resulta:

A continuación relacionaremos algunos

que requieren una calibración, es decir,

conocer de algún modo las propiedades

de los objetos implicados.

T = ∫10 dy/ [(Ω/2-q) y2+Ω y-1 q+1-3Ω/2]1/2

Los anteriores parámetros no son todos

independientes. Para p = 0, sólo tres

individualizan cada uno de los modelos

cosmológicos.

El primer método es el uso de estrellas

pulsantes como candelas estándar.

Las Cefeidas son estrellas bastante

jóvenes, de masa entre 2 y 10 masas

solares, y además pulsantes, con períodos

de varios días. Su nombre proviene del

miembro más brillante de esta clase, la

Delta Cephei. Su pulsación se debe a las

zonas de hidrógeno y helio ionizado

existentes cerca de su superficie. Este

último hecho fija aproximadamente la

temperatura de la estrella, produciendo

una franja de inestabilidad en el diagrama

H-R. Ahora bien, hay, que se sepa, dos

Con p = 0, las relaciones más importantes

entre parámetros son:

Λ = -3 H2 (q Ω/2)

k c2 = H2 R2 (3Ω/2-q-1)

; y si se toma Λ = 0:

q = Ω/Z

k = H2 R2/ c2 (2q-1) y sólo habría dos

parámetros independientes.

20

amplitudes por debajo de dos magnitudes.

Están en cúmulos globulares; son de baja

metalicidad y al parecer tienen todas la

misma luminosidad. Puesto que las masas

de las RR Lyrae están predeterminadas

por las masas de las estrellas que van

saliendo de la secuencia principal, la

constancia de la luminosidad parece

deberse a las similitudes en la edad de los

cúmulos globulares.

grupos de cefeidas: las clásicas, con

amplitud elevada y representación de la

magnitud frente al tiempo (curva de luz)

asimétrica, y las cefeidas-s con amplitud

moderada y curva de luz simétrica.

Las estrellas crecen y se enfrían,

disminuyendo posteriormente su tamaño

mientras se van calentando. Es decir, las

Cefeidas son más brillantes cerca de su

tamaño mínimo. Al ser la temperatura

aproximadamente

la

misma,

su

luminosidad determina el tamaño de la

cefeida. Como un objeto pulsante tiene un

período de oscilación más largo cuando

posee mayor tamaño, debe haber una

relación período-luminosidad para las

Cefeidas. Si, por ejemplo, dos cefeidas

poseen períodos de oscilación que

difieren en un factor dos, la de mayor

período es 2,5 veces más luminosa que la

del período más corto. La facilidad de

medir el período de una estrella variable,

hace de las Cefeidas una valiosa

herramienta para determinar la distancia a

las galaxias. Además, al ser tan brillantes

las Cefeidas pueden usarse hasta para

calcular

distancias

de

galaxias

pertenecientes al cúmulo de Virgo. El

problema reside en la calibración de la

relación período-luminosidad, que se

realiza usando Cefeidas localizadas en la

Nubes de Magallanes o en cúmulos

estelares cuyas distancias se determinan

por ajuste de la secuencia principal del

cúmulo. Se piensa que la calibración

podría depender de la abundancia de

metales en la Cefeida, que seguramente es

mucho menor en la Gran Nube de

Magallanes.

El segundo método de medición de

distancias se basa en la función de

luminosidad de las nebulosas planetarias.

Estas son estrellas que han evolucionado

a través de gigante roja y gigante roja

asintótica, habiendo expulsado sus capas

externas de hidrógeno sin fusionar, lo que

forma una nebulosa ionizada que rodea a

una estrella central pequeña de elevada

temperatura. Estas últimas emiten grandes

cantidades de luz en la línea del espectro

de 501 nm del oxígeno dos veces

ionizado (O III) que permite su fácil

identificación. Las nebulosas planetarias

más brillantes parecen tener el mismo

brillo en muchas galaxias, por ello sus

flujos pueden ser usados como

indicadores de distancia.

Otro método posible en el problema que

nos ocupa es utilizar las estrellas más

brillantes de una galaxia para estimar la

distancia de toda la galaxia. Est es debido

a que se asume en general que existe un

límite superior fijo al brillo de las

estrellas, hipótesis algo débil pero que

puede subsanarse si existe en la galaxia

una población suficientemente grande de

estrellas brillantes.

Otro método, igualmente de escasa

fiabilidad, es el de la utilización de la

ionización del gas hidrógeno existente

alrededor de las estrellas muy calientes y

luminosas, lo que se denomina una región

de H II como la nebulosa de Orión. El

También se aplica el mismo método

utilizando las estrellas RR Lyrae que, de

igual modo, son pulsantes variables como

las Cefeidas. Estas estrellas poseen una

masa pequeña, de unas 0,8 masas solares,

con períodos cortos entre 0,2 y 1,2 días y

21

Uno es el de la utilización de la relación

Tully-Fisher. Y es que la velocidad de

rotación V(rot) de una galaxia espiral

puede utilizarse como indicador de su

luminosidad L. Se observa que:

diámetro de las mayores regiones H II en

galaxias se ha utilizado como una “vara”

de medir distancias.

El siguiente método que también requiere

calibración es el de la utilización de

Supernovas de tipo I. Éstas son

explosiones de enanas blancas situadas en

sistemas binarios de estrellas. La

acumulación o acreción de materia que se

produce desde la estrella compañera hace

que la enana blanca llegue a alcanzar el

límite superior de masa llamado de

Chandrasekhar

donde

pierde

su

estabilidad, empezando a colapsar. La

compresión propicia la combustión del

carbono de forma explosiva, originándose

la destrucción total de la estrella. La

radiación emitida tiene su origen

principalmente en la descomposición

radiactiva del níquel y cobalto producidos

en la explosión. El pico en la luminosidad

puede determinarse con un error menor

del 20%. Este método ha servido para que

el telescopio Hubble haya obtenido una

de las mejores medidas de la constante de

Hubble, que estudiaremos a continuación.

L = constante×V(rot)4

La velocidad rotacional se mide

un

espectrógrafo

óptico

radiotelescopio. Entonces, si

medir el flujo F, la distancia

calcularse mediante la relación:

mediante

o

un

podemos

D puede

L = F 4π D

Otro método de este tipo es el que se basa

en la relación Faber-Jackson que utiliza

galaxias elípticas. La dispersión de

velocidades estelares en las mismas, σ(v),

– raíz cuadrada del promedio del

cuadrado de las velocidades estelaresviene relacionada con la luminosidad por

la expresión:

L = const.×σ(v)4

De igual forma que antes, la medición de

la dispersión efectuada por un

espectrógrafo óptico (medición de la

luminosidad), junto con medidas de flujo,

nos permite estimar las distancias.

Por último, otro método con calibración

emparentado con el de la luminosidad de

las nebulosas planetarias, es el de la

medida de las fluctuaciones estadísticas

del brillo superficial de las galaxias

cuando éstas están tan lejanas que es

imposible

detectar

sus

estrellas

individuales. Una galaxia cercana podría

tener ±10% de fluctuaciones en el brillo

superficial (100 estrellas por pixel), y una

lejana sólo un 3% (1000 estrellas por

pixel).

Por último, al igual que en el método de

estrellas más brillantes, las galaxias más

brillantes de un cúmulo de galaxias se han

utilizado como fuentes luminosas

estándar; pero igualmente la fiabilidad del

método es baja.

Como tercer bloque de métodos para la

medida de las distancias están los que no

requieren calibración.

Otro bloque de métodos para evaluar

distancias utiliza propiedades globales de

las galaxias y también necesitan

calibración.

El primero de ellos se basa en el retraso

temporal que se produce en las “lentes

gravitatorias”.

22

Si se considera que la anchura a lo largo

de la línea de visión es la misma que el

diámetro del cúmulo, la distancia puede

inferirse a partir del diámetro angular del

cúmulo.

Y es que cuando se observa un cuásar a

través de lo que se llama una lente

gravitatoria, que es la deflexión

(desviación) de la luz por el efecto

gravitatorio de una galaxia o cúmulo de

ellas interpuesto en la línea de visión del

observador, pueden verse múltiples

imágenes del mismo cuásar. Los caminos

que sigue la luz hasta nosotros tienen

longitudes que difieren en una cantidad

dependiente de la distancia al cuásar y el

ángulo de deflexión. Al presentar los

cuásares variaciones de luminosidad, la

observación de las diferencias temporales

en variaciones particulares de la

luminosidad de la fuente producida en

variadas imágenes, sirve para calcular la

diferencia de dichas longitudes.

Como es fácil deducir de lo anterior esta

última técnica es harto complicada y sólo

ha permitido estimar unas pocas

distancias.

3.Constante cosmológica

Cuando Einstein construyó la teoría de la

relatividad general se suponía que el

universo era estático. Entonces la

gravedad de la materia y la energía

conducirían a un colapso del universo.

Einstein suponía tal aserto como

inaceptable físicamente, por eso introdujo

un

término

con

una

constante

cosmológica que se oponía a la fuerza de

atracción de la gravedad. Más tarde

Edwin Hubble descubrió que las galaxias

parecen alejarse con respecto a nosotros,

así que el universo actualmente está

expandiéndose. Estas observaciones

provocaron que Einstein afirmara que la

introducción

de

esta

constante

cosmológica fue el mayor error de su

vida, y subsiguientemente fue sacada de

las teorías cosmológicas.

El segundo se basa en el efecto SunyaevZeldovich, que se produce cuando el gas

caliente situado en los cúmulos de

galaxias distorsiona el espectro de la

radiación cósmica de fondo. Los

electrones libres del gas dispersan una

pequeña fracción de los fotones del fondo

de microondas, sustituyéndolos por

fotones algo más energéticos. Sólo un 1%

de los fotones que pasan por el cúmulo

son dispersados por los electrones

pertenecientes al gas caliente ionizado del

mismo, y el aumento de energía de

aquellos es de, únicamente, el 2%. Por

ello se observa una carencia de fotones de

baja energía del orden de 0,02%

(0,01×0,02), observada como una

reducción de la temperatura de brillo de

unos 500 micro K. A frecuencias altas el

resultado es que el cúmulo aparece más

brillante que el fondo.

Hay razones para creer, sin embargo, que

la constante cosmológica puede, todavía,

ser aplicada en cosmología. Hoy es

mayoritaria la opinión de que el universo

estuvo durante un tiempo en una

expansión rápida, la llamada inflación, en

un período temprano de su historia. Esta

inflación actuaría allanando el universo y

haciéndolo

geométricamente

plano.

Matemáticamente, esto produce una Ωtotal

muy cercana a uno, lo que origina

problemas que la constante cosmológica

puede remediar. Cuando los astrónomos

miden la cantidad de materia y energía

El efecto anterior es proporcional a la

densidad de electrones libres, el grosor

del cúmulo en nuestra línea de visión y la

temperatura de los electrones.

23

homogeneidad e isotropía en el universo

es la métrica de Robertson-Walker:

del universo, obtienen sólo un 30% de la

que se necesitaría para que el universo

fuese plano. La constante cosmológica

podría “aportar” la masa necesaria para

que el universo fuese plano. Incluso si la

inflación es errónea y no hay razones para

creer que el universo es espacialmente

plano, hay todavía un problema aparente

con la edad del universo. La edad

obtenida de un universo abierto con la

cantidad de materia observada y sin

constante cosmológica es más joven que

la edad de las estrellas más viejas, lo que

no puede ser. Sin embargo, un universo

plano con materia y constante

cosmológica es un universo mucho más

viejo, incluso más viejo que las estrellas

más antiguas.

ds2= c2dt2-a2(t) [dx2+f(x)2(dθ2+sen2θdρ)]

f(x) describe la geometría espacial del

universo, parametrizada por la constante

k de curvatura:

sen(kx)1/2/(k)1/2

k>0

f(x) =

x

k =0

sen(kx)1/2/(k)1/2 k<0

Para k<0 la geometría espacial del

universo es abierta.

Para k = 0 el universo es plano.

Para k>0 el universo es cerrado.

Las coordenadas x,θ y ρ son coordenadas

“comóviles”. Un sistema de coordenadas

comóviles se expande en el universo. Por

tanto, la distancia comóvil entre dos

puntos permanece constante durante la

evolución del universo. Sin embargo, la

distancia física entre dos puntos cambia

cuando el universo se expande. Es el

factor cósmico de escala quien relaciona

las coordenadas comóviles con las

distancias físicas, a través de la relación;

d= a x. Con la métrica definida con

coordenadas comóviles, la evolución del

tiempo del universo es descrita por la

evolución del tiempo del factor de escala

cósmica. Si el factor de escala cósmica

crece con el tiempo cuando el universo se

expande, también disminuye con el

tiempo si y cuando el universo colapsa.

Otra razón para esperar una constante

cosmológica es la existencia de una

energía mecánico-cuántica del vacío. La

mecánica cuántica predice que el vacío no

está realmente vacío, sino que tiene una

cantidad de energía asociada. Desde que

la relatividad general establece que todas

las formas de materia y energía producen

gravitación, debemos asociar la constante

cosmológica con la energía del vacío. El

emparejamiento de energía del vacío y

gravedad no es inaudito, la teoría

inflacionaria cuenta con una influencia

gravitacional de la energía del vacío.

Todas estas razones mantienen vivo el

interés actual por la cte. cosmológica.

Las observaciones demuestran que el

universo es homogéneo e isótropo a

grandes escalas. Esto significa que no hay

un centro o dirección únicos en el

universo. En la relatividad general la

forma del espacio-tiempo está descrita

por una ecuación métrica. La forma

general de la ecuación métrica que

satisface

las

condiciones

de

Una de las ideas básicas en relatividad

general es que la materia y la energía

actúan curvando el espacio-tiempo. Es la

ecuación de campo de Einstein la que lo

describe matemáticamente:

Rij-1/2 R gij-λ gij =8πG/c4 Tij

Donde, gij representa la métrica, Rij es el

tensor de Ricci (que deriva esencialmente

24

de la métrica), R el radio de curvatura del

espacio-tiempo,

λ

la

constante

cosmológica, G la constante gravitatoria y

Tij el tensor energía-esfuerzo. El tensor

energía-esfuerzo, como dijimos en

párrafos

anteriores,

describe

la

distribución de la materia y la energía,

con su densidad y presión. Por tanto,

dando una distribución de materia y

energía, las ecuaciones de campo

gobiernan la forma del espacio-tiempo

(por ejemplo, la métrica). La inclusión del

término de la constante cosmológica en

esta ecuación depende, desde luego, de si

es cero o no. Una de las ecuaciones de

campo puede ser presentada en forma

parecida a la ecuación newtoniana del

potencial de gravitación, sin embargo,

con un ingrediente extra:

materia y la energía, excepto que es una

presión negativa. El efecto neto de una

cte. cosmológica positiva es que crea una

fuerza gravitacional de repulsión. Esta

repulsión actúa expandiendo el universo.

La densidad de energía del vacío es

diferente de la densidad de materia y

energía en otro sentido. Cuando el

universo se expande la materia y la

energía se expanden sobre un mayor

espacio físico, y entonces la atracción

gravitatoria disminuye. Para la energía

del vacío, sin embargo, el trabajo P dV

del vacío realizado durante la expansión

adiabática provee exactamente la cantidad

de energía necesaria para llenar el nuevo

volumen a la misma densidad. Por tanto,

la constante cosmológica permanece

constante y su repulsión gravitacional (o

atracción) nunca cambian durante la

evolución del universo.

∇2 φ = 4πG(ρ+3p/c2)

El ingrediente añadido es que, dentro de

la densidad la presión contribuye al

potencial gravitacional, y esto es un

efecto

puramente

relativista.

Es

justamente porque la presión también

contribuye a la gravedad por lo que la

inclusión de la constante cosmológica es

interesante. Si las ecuaciones de campo

son reescritas de forma que la constante

cosmológica aparezca a la derecha de la

ecuación, el término de la constante

cosmológica puede ser asociado a una

densidad de vacío:

De la métrica de Robertson-Walker y las

ecuaciones de campo de Einstein, se

deriva la siguiente ecuación del

movimiento:

H2 = (1/a da/dt)2 = 8πG ρ/3+λ/3-k/a2

Porque el término de la cte. cosmológica

es proporcional a la métrica, la presión

asociada con el vacío es dada por la

relación:

Donde H es la constante de Hubble, a es

el factor de escala cósmica, ρ la densidad

de la materia y la radiación, λ la constante

cosmológica y k la constante de

curvatura. Ésta ecuación es generalmente

denominada ecuación de Friedman

(originalmente escrita sin el término de la

constante cosmológica, como lo es en la

actualidad). La ecuación de Friedman

describe la evolución temporal del factor

de escala cósmica, o tamaño del universo.

Con las siguientes definiciones:

Pvac = -ρvac c2

Ωmo = 8πG ρmo/3H02 Ωλo = λ/3H02

Así, la

comporta

Ωko = -k/H02

movimiento queda:

λ = 8πG ρvac

constante cosmológica se

gravitatoriamente como la

25

la ecuación del

(da/dt)2 = H02 (Ωmo/a +a2 Ωλo+Ωko)

compatible con la edad de las estrellas

más viejas.

Donde el 0 representa cantidades medidas

en la actualidad, y a se normaliza de

forma que es igual a uno hoy. Se tiene en

cuenta la contribución de la materia

exclusivamente, puesto que la de la

radiación en la actualidad es menor de

10-5. La inclusión de la radiación sólo es

importante en la evolución del temprano

universo. De las definiciones anteriores se

ve claramente que:

Recientemente, este problema parece

encontrar alguna solución a partir de los

resultados del satélite Hipparcus. Ambos,

la edad de los racimos o enjambres

globulares y la edad del universo (a través

de H0 ) depende de la escala de distancia

usada. Hipparcus ha revisado la escala de

distancia midiendo el paralaje de las

estrellas Cefeidas más cercanas. Esta

revisión ha ajustado el valor de la

constante de Hubble alrededor de 60

km/s/Mpc, dejando la puerta abierta a un

universo plano, con una edad de 13 a 11

billones de años. Con esta corrección la

edad de los enjambres globulares baja por

debajo de los 10-14 billones de años

Entonces, quizás el problema de la edad

pudiera no existir, así que la constante

cosmológica pudiera no ser necesaria.

Ωmo+Ωλo+Ωko = 1

Es útil definir la cantidad:

Ωtotal, 0 = Ωmo+Ωλo = 1-Ωko

Si Ωtotal, 0 <1 el universo es espacialmente

abierto, si Ωtotal,0 = 1 el universo es

espacialmente plano, y si Ωtotal,0 >1 el

universo es espacialmente cerrado.

Por otro lado, la luz con la más alta

desviación hacia el rojo puede presentar

el “efecto lente” debido a altas

concentraciones de masas tales como

galaxias y enjambres de galaxias. El

efecto lente produce múltiples imágenes

del mismo objeto. Una constante

cosmológica afecta la geometría y

evolución del universo y ambas hacen de

la estadística de las lentes una técnica

potente para limitar el valor de la

constante cosmológica en nuestro

universo. Las altas desviaciones hacia el

rojo de los cuásares proveen una buena

fuente para el estudio del efecto lente, ya

que están situados a distancias

cosmológicas; y la gran masa de las

galaxias elípticas son buenas lentes.

Aunque el efecto lente es sensible al valor

de la constante cosmológica, hay varias

incertidumbres en la determinación del

número absoluto y especificaciones en las

expectativas del efecto lente en un

modelo cosmológico dado. Se debe

La astronomía observacional posee varios

métodos para constreñir el valor de la

constante cosmológica en nuestro

universo, ya que la geometría del espacio

y el pasado de la evolución del universo

son afectados por la presencia de la

constante cosmológica.

Si se asume que el universo está hecho

puramente de materia (Ωmo<0,3) entonces

el universo tiene una edad de unos 10-13

billones de años.

La situación es peor si se requiere un

universo plano: en ese caso la materia

dominaría el universo (Ωmo=1), y el

mismo tendría sólo 8-11 billones de años.

Sin embargo, un universo plano con

materia al nivel observado (Ωmo≅0,3) y

una constante cosmológica, transformaría

la edad en 12-16 billones de años que es

26

conocer la distribución de las galaxias

“lentes”, su densidad espacial, el

potencial de las lentes, y la evolución con

el desplazamiento al rojo en orden a

calcular la “profundidad óptica” de la

lente de una fuente. Todas estas

incertidumbres pueden producir errores

de hasta un factor dos en las predicciones

teóricas de las lentes. Sin embargo, todo

esto no es tan malo puesto que las

predicciones de los diferentes modelos

pude diferir en un orden de magnitud

(para los universos planos Ωλo =1 predice