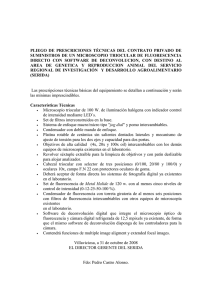

Alberto Fernández Gutiérrez

Anuncio