Estadística Práctica para el Análisis de Datos Estadística Práctica

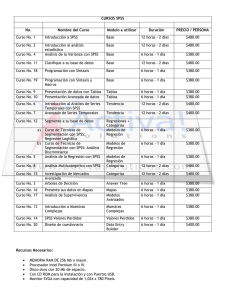

Anuncio