Imagenes_PET - Instituto de Ingeniería Eléctrica

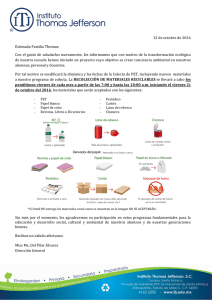

Anuncio