Diálogos sobre física moderna

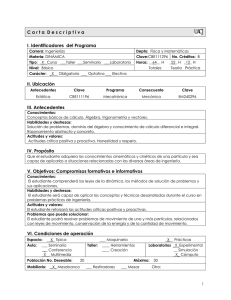

Anuncio