Estadística Descriptiva Bivariante

Anuncio

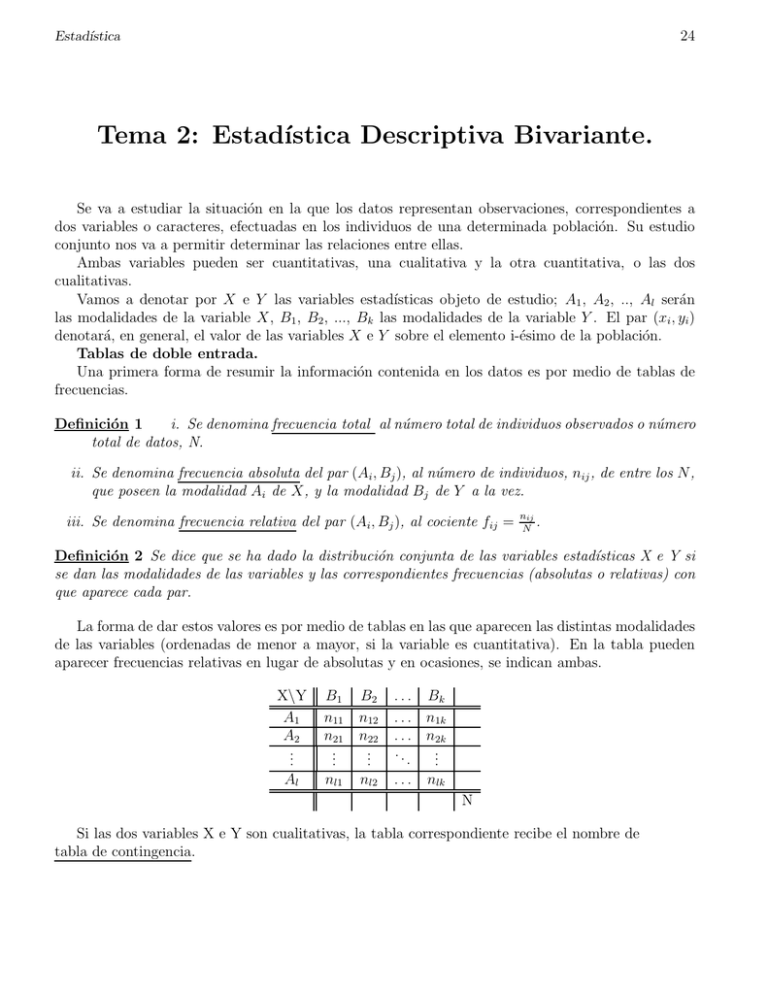

24 Estadı́stica Tema 2: Estadı́stica Descriptiva Bivariante. Se va a estudiar la situación en la que los datos representan observaciones, correspondientes a dos variables o caracteres, efectuadas en los individuos de una determinada población. Su estudio conjunto nos va a permitir determinar las relaciones entre ellas. Ambas variables pueden ser cuantitativas, una cualitativa y la otra cuantitativa, o las dos cualitativas. Vamos a denotar por X e Y las variables estadı́sticas objeto de estudio; A1 , A2 , .., Al serán las modalidades de la variable X, B1 , B2 , ..., Bk las modalidades de la variable Y . El par (xi , yi ) denotará, en general, el valor de las variables X e Y sobre el elemento i-ésimo de la población. Tablas de doble entrada. Una primera forma de resumir la información contenida en los datos es por medio de tablas de frecuencias. Definición 1 i. Se denomina frecuencia total al número total de individuos observados o número total de datos, N. ii. Se denomina frecuencia absoluta del par (Ai , Bj ), al número de individuos, nij , de entre los N, que poseen la modalidad Ai de X, y la modalidad Bj de Y a la vez. iii. Se denomina frecuencia relativa del par (Ai , Bj ), al cociente fij = nij . N Definición 2 Se dice que se ha dado la distribución conjunta de las variables estadı́sticas X e Y si se dan las modalidades de las variables y las correspondientes frecuencias (absolutas o relativas) con que aparece cada par. La forma de dar estos valores es por medio de tablas en las que aparecen las distintas modalidades de las variables (ordenadas de menor a mayor, si la variable es cuantitativa). En la tabla pueden aparecer frecuencias relativas en lugar de absolutas y en ocasiones, se indican ambas. X\Y A1 A2 .. . B1 n11 n21 .. . B2 n12 n22 .. . Al nl1 nl2 . . . Bk . . . n1k . . . n2k .. .. . . . . . nlk N Si las dos variables X e Y son cualitativas, la tabla correspondiente recibe el nombre de tabla de contingencia. 25 Estadı́stica Propiedades 1 1. k l nij = N i=1 j=1 2. l k fij = 1 i=1 j=1 Ejemplo: Distribución de alumnos de 2o de I.T.I. por titulación y sexo: Hombre Mujer 27 5 Titulación\Sexo Eléctrico Electrónico 27 285 5 285 85 285 22 285 90 285 23 285 19 285 14 285 85 Mecánico 22 90 Quı́mico 23 19 14 285 1 1 Distribuciones marginales. A partir de una distribución conjunta de dos variables es posible estudiar la distribución de cada una de las variables aisladamente ( es decir, independientemente de los valores que tome la otra variable). Los valores de las frecuencias para las variables X e Y se obtienen a partir de la tabla conjunta, anotando en los márgenes de la tabla la suma de los valores de cada fila y de cada columna: X\Y A1 A2 .. . B1 n11 n21 .. . B2 n12 n22 .. . Al nl1 n.1 nl2 n.2 . . . Bk . . . n1k . . . n2k .. .. . . . . . nlk . . . n.k n1. n2. .. . nl. N • Las frecuencias relativas y absolutas, respectivamente, de la modalidad Ai de la variable X son: fi. = k j=1 fij ni. = k j=1 nij • Las frecuencias relativas y absolutas, respectivamente, de la modalidad Bj de la variable Y son: f.j = l i=1 fij n.j = l i=1 nij 26 Estadı́stica Observación 1 Las distribuciones marginales de X e Y son distribuciones univariantes; en este sentido, puede aplicárselas todo lo estudiado en el tema anterior. En particular, si son variables cuantitativas, tendrán asociada media, varianza, etc. Ejemplo: Distribución de alumnos de 2o de I.T.I. por titulación y sexo: Titulación\Sexo Eléctrico Electrónico Mecánico Quı́mico Hombre Mujer 27 5 5 285 85 285 22 285 90 285 23 285 19 285 14 285 33 285 221 64 285 1 85 90 19 221 285 La distribución marginal de Titulación es: Titulación Eléctrico Electrónico Frecuencia 32 107 32 107 Frecuencia relativa 285 285 Y la de Sexo: Hombre Sexo Frecuencia 221 Frecuencia relativa 221 285 2 32 27 285 32 285 22 107 23 113 14 33 64 285 107 285 113 285 Mecánico 113 Quı́mico 33 113 285 33 285 Mujer 64 64 285 Distribuciones condicionadas. Definición 3 Se define la distribución condicionada de Y cuando X = Ai ( respectivamente, de X condicionada a Bj ) , que se denota por Y /(X = Ai ) ( respectivamente X/(Y = Bj )) como la distribución de la variable Y (respectivamente X) sobre los elementos de la población que tienen la caracterı́stica Ai (respectivamente, Bj ). Observación 2 Un aspecto importante de las distribuciones condicionadas es que la población objeto de estudio no es la misma que la de partida. Los valores de las frecuencias para la variables Y /(X = Ai ) y X/(Y = Bj ) se obtienen a partir de la tabla conjunta: • Las frecuencias absolutas de la variable Y cuando X = Ai son las de la lı́nea correspondiente a Ai . • Las frecuencias relativas de la variable Y cuando X = Ai son: fj/i = por f (Bj /(X = Ai ))). En efecto, fj/i = nij ni. = nij/N ni. /N f ij fi. (también se representan 27 Estadı́stica • Las frecuencias absolutas de la variable X cuando Y = Bj son las de la columna correspondiente a Bj . • Las frecuencias relativas de la variable X cuando Y = Bj son: fi/j = por f (Ai /(Y = Bj ))). f ij (también f.j se representan Ejemplo: La distribución condicionada de Titulación a Mujer es: Titulación/(Mujer) Frecuencia Frecuencia relativa Eléctrico 5 Electrónico 22 Mecánico 23 Quı́mico 14 5 64 22 64 23 64 14 64 Y la de Sexo a Mecánico: Hombre Sexo/(Mecánico) Frecuencia 90 90 Frecuencia relativa 113 Mujer 23 23 113 Proposición 1 Dadas las distribuciones condicionadas de la variable X a cada modalidad de la variable Y, y dada la distribución marginal de Y (respectivamente, de Y a cada modalidad de X, y la marginal de X), queda determinada la distribución conjunta de (X,Y). En efecto, basta observar que fij = fi/j f.j = fj/i fi. . Definición 4 Se dice que las variables estadı́sticas X e Y son estadı́sticamente independientes si se verifica: fi/j = fi. para i = 1, 2, . . . , l, j = 1, 2, . . . , k. Se dice que dos modalidades Ai y Bj son estadı́sticamente independientes si se verifica: fi/j = fi. La definición anterior significa que la distribución de la variable X no depende de los valores que tome la variable Y, y recı́procamente. Proposición 2 Las siguientes condiciones son equivalentes: 1. Las variables estadı́sticas X e Y son independientes, 2. fij = fi. f.j , para i = 1, 2, . . . , l, j = 1, 2, . . . , k. 3. fj/i = f.j para i = 1, 2, . . . , l, j = 1, 2, . . . , k. Ejemplo: Variables no independientes: X\Y B1 B2 B3 1 1 A1 0 0 3 3 1 1 A2 0 0 3 3 1 1 A3 0 0 3 3 1 1 1 1 3 3 3 Variables independientes: X/Y B1 B2 B3 1 1 1 1 A1 9 9 9 3 1 1 1 1 A2 9 9 9 3 1 1 1 1 A3 9 9 9 3 1 1 1 1 3 3 3 Estadı́stica 3 28 Representaciones gráficas de las distribuciones bidimensionales de frecuencias. Las distribuciones marginales y condicionadas son distribuciones unidimensionales, como ya se ha indicado y, por tanto, sus representaciones gráficas se ajustarán a las vistas en la sección de distribuciones unidimensionales de frecuencias. Se van a considerar sólo representaciones gráficas de distribuciones bidimensionales: • Diagrama de Mosaico. Sobre el eje Y se representan las modalidades de una de las variables y sobre cada una se levanta un rectángulo con área proporcional a la frecuencia marginal de la modalidad. Cada rectángulo se subdivide en subrectángulos de base proporcional a la frecuencia condicionada de cada valor de la otra variable a esta modalidad. De esa manera se da también una imagen gráfica de la distribución conjunta de ambas variables (proporcionada por el área de cada subrectángulo). En el ejemplo de la distribución de alumnos por titulación y sexo: • Diagramas de barras. Se utiliza para representar la distribución cuando ambas variables tienen pocas modalidades. Consiste en dibujar para cada par (Ai , Bj ) una barra de longitud proporcional a la frecuencia (relativa o absoluta). Las barras se pueden disponer de diversas formas. Damos dos ejemplos: 29 Estadı́stica • Histograma tridimensional. Se utiliza para representar la distribución cuando ambas variables son continuas y agrupadas en intervalos. Consiste en representar las clases de cada variable en un plano y levantar sobre cada rectángulo un paralelepı́pedo de volumen proporcional a la frecuencia relativa o absoluta. Si los rectángulos base de todas las clases son iguales, los paralelepı́pedos que se levantan, y que tienen que verificar que su volumen sea proporcional a la frecuencia de la clase, tendrán como altura un valor proporcional a las frecuencias (relativas o absolutas). • Diagrama de dispersión o nube de puntos. Se utiliza para variables cuantitativas sin agrupar en clases y en las que no existen pares de valores repetidos. Consiste en representar cada par de puntos (xi , yj ) en un plano. Permite obtener también una representación gráfica de las distribuciones marginales de X e Y, si se proyectan los puntos sobre cada eje (se obtiene ası́ el diagrama de puntos para cada variable). En el siguiente gráfico están representados, para una población de cereales de uso comn en el desayuno, el contenido de carbohidratos y de calorı́as para 100gr de producto: 4 Dependencia lineal. Una de las formas de dependencia de más interés entre variables continuas es la dependencia lineal, por varias razones: • En muchos problemas prácticos la relación entre las variables es lineal. • Aún cuando la relación no sea lineal, frecuentemente es linealizable, mediante transformaciones. • Si el rango de valores es pequeño, la aproximación lineal puede ser válida. Vamos a introducir a continuación medidas de la relación lineal entre las variables: 1. Covarianza. Definición 5 Sea (X, Y ) una distribución bidimensional, se define la covarianza de (X,Y) y se representa por Cov(X,Y) ó sXY como: Cov(X,Y) = l k i=1 j=1 (xi − x̄) (yj − ȳ) fij 30 Estadı́stica Observación 3 La fórmula anterior es válida cuando se tiene la distribución de frecuencias de (X, Y ). Si lo que se tiene son los N pares de datos en la forma (xi , yi ) ∀i = 1, 2, . . . , N la expresión anterior queda de la forma: Cov(X,Y) = N (xi − x̄)(yi − ȳ) N i=1 Si los datos están agrupados en frecuencias absolutas, entonces Cov(X,Y) = l,k (xi − x̄)(yj − ȳ)nij N i,j=1 Vamos a ver una forma de expresar la covarianza, útil a la hora de hacer cálculos: Usando la expresión anterior y desarrollando: Cov(X,Y) = 1 = N N N N N 1 1 (xi − x̄) (yi − ȳ) = (xi yi − xi ȳ − x̄yi + x̄ȳ) = N i=1 N i=1 N N N 1 1 xi yi − ȳ xi − x̄ yi + N x̄ȳ = xi yi − ȳx̄ − x̄ȳ + x̄ȳ = xi yi − ȳx̄ N i=1 N i=1 i=1 i=1 i=1 Observación 4 El valor de la covarianza proporciona información sobre la posible relación lineal entre dos variables; cuando los datos parecen disponerse entorno a una recta de pendiente positiva, la covarianza es positiva; si parecen disponerse en torno a una recta de pendiente negativa, la covarianza es negativa; si no parece haber relación lineal, la covarianza es próxima a cero: 31 Estadı́stica Propiedades 2 Sean X e Y dos variables estadı́sticas. 1. Si X e Y son independientes, entonces Cov(X,Y) = 0. (El recı́proco no es en general cierto). En efecto, si X e Y son independientes, para cada i,j se tiene que fij = fi. f.j y por tanto, Cov(X,Y) = l k i=1 j=1 = l i=1 xi yi fij − x̄ȳ = l k i=1 j=1 xi yi fi. f.j − x̄ȳ = ⎞ ⎛ k xi fi. ⎝ yj f.j ⎠ − x̄ȳ =0 j=1 2. Si a, b, c, d ∈ IR, y U = aX + b, V = cY + d, entonces Cov(U,V) = a c Cov(X,Y). Cov(U,V) = Cov(aX+b,cY+d) = = N 1 (axi + b − (ax̄ + b)) (cyi + d − (cȳ + d)) = N i=1 N 1 (axi − ax̄) (cyi − cȳ) = a c Cov(X,Y) N i=1 Ejemplo: Las variables X e Y cuya distribución viene dada por la siguiente tabla conjunta, tienen Cov(X,Y) = 0, pero no son independientes, es fácil observar que Y = X 2 . X\Y -1 0 1 0 0 1 3 0 1 3 1 1 3 0 1 3 2 3 1 3 1 3 1 3 1 2. Coeficiente de correlación. Uno de los principales inconvenientes de la covarianza es que depende de las unidades de medida de las variables. El coeficiente de correlación es una medida adimensional. 32 Estadı́stica Definición 6 Se define el coeficiente de correlación lineal entre dos variables X e Y y se Cov(X,Y) denota por r, como: r = . sX sY Propiedades 3 1. Es un coeficiente adimensional. 2. El valor de r no varı́a si multiplicamos X por a e Y por b con a y b números reales del mismo signo. 3. −1 ≤ r ≤ 1. 4. |r| = 1 si, y sólo si, exite relación lineal exacta entre las variables, es decir, si existen a, b ∈ IR tales que yi = axi + b, i = 1, . . . , N. Además, si a > 0, es r=1 y si a < 0 es r = −1. 4. Si X e Y son estadı́sticamente independientes, entonces r = 0. Observación 5 De las propiedades anteriores se deduce que si r es próximo a ±1 se puede sospechar la existencia de relación lineal entre las variables y que si r es próximo a 0, se puede sospechar la inexistencia de tal relación. En cualquier caso, el coeficiente de correlación es una medida resumen de la estructura de un diagrama de dispersión, y por tanto siempre conviene dibujar el diagrama que es el que contiene toda la información. 5 Rectas de regresión. Una vez que sabemos que dos variables estadı́sticas tienen un cierto grado de relación lineal, puede interesarnos obtener la ecuación que mejor expresa esta relación. Dicha recta se denomina recta de ajuste y no es única (depende del criterio de proximidad elegido). Cuando el objetivo es que la recta nos permita explicar el comportamiento de una variable a través de la otra, el criterio adecuado es el de mı́nimos cuadrados que consite en minimizar la suma de las desviaciones, en sentido ortogonal al eje de la variable predictora, de cada punto a la recta, tomadas al cuadrado para prescindir del signo. Dados (xi , yi ) i = 1, 2, . . . , N,(tal que existen j,k con xj = xk ) veremos dos casos: - determinar la recta y = ax + b que haga mı́nima N i=1 (yi − axi − b)2 , (es decir, las distancias verticales entre el valor observado y el “previsto” por la recta) si se quiere explicar el comportamiento de Y a través de X. (Recta de regresión de Y respecto de X.) - determinar la recta x = cy + d que haga mı́nima N i=1 (xi − cyi − d)2 , (es decir, las distancias horizontales entre el valor observado y el “previsto” por la recta) si se quiere explicar el comportamiento de X a través de Y. (Recta de regresión de X respecto de Y.) Nos vamos a centrar en la obtención de la primera; el otro caso es similar. 1. Recta de regresión de Y respecto de X. Definición 7 Llamaremos residuo ei a la diferencia entre el valor observado y el proporcionado por la recta de regresión: ei = yi − axi − b. 33 Estadı́stica El criterio elegido es, entonces, minimizar la suma de cuadrados de los residuos. Para ello, vamos a llamar y = (y1, y2 , . . . , yN )t , x = (x1 , . . . , xN )t y 1 = (1, . . . , 1)t , vectores en IRN . El problema de determinar la recta de ajuste se puede plantear de la siguiente forma: Encontrar el vector v en el subespacio vectorial de IRN , S, generado por 1 y x, que haga mı́nima la distancia en norma euclı́dea del vector y a S. Gráficamente se observa que este vector es la proyección ortogonal de y sobre S, es decir, el único vector v ∈ S tal que cumple: y − v ⊥x y y − v ⊥1. Por tanto, v será la solución (única) del sistema: (y − v)x = 0 (y − v)1 = 0 Poniendo v = ax + b1 y desarrollando los productos escalares en el sistema anterior se obtiene: ⎛ ⎞ ⎛ N ⎞ N N x y i i ⎜ ⎟ ⎜ ⎟ b i=1 ⎜ ⎟ ⎜ i=1 ⎟ = ⎝ ⎠ ⎝ ⎠ N N N 2 a xi xi xi yi i=1 i=1 i=1 Dividiendo por N las dos ecuaciones del sistema y resolviéndole por medio de eliminación gaussiana, se obtiene el sistema equivalente: 1 x̄ 0 s2X b a = ȳ sXY Resolviendo este sistema se obtiene que: a = ssXY 2 X sXY b = ȳ − s2 x̄ X Definición 8 Se llama recta de regresión de Y respecto de X, a la recta de ecuación: sXY y − ȳ = 2 (x − x̄) sX Observación 6 Se observa que siempre es posible construir una única recta de regresión aunque no exista relación lineal entre las variables (con tal de que existan i,j con xi = xj ). Utilizando el coeficiente de correlación, tenemos que la expresión de la recta es sY (X − x̄) Y = ȳ + r sX Observación 7 Se observa que ē = 0: N ei i=1 N = N N N (yi − axi − b) yi xi Cov(X,Y) x̄ − b = 0. = −a − b = ȳ − N s2X i=1 i=1 N i=1 N y por tanto la varianza residual ó varianza de los residuos, tiene la siguiente expresión: N s2eY /X = i=1 (yi − axi − b)2 N 34 Estadı́stica Proposición 3 s2eY /X = s2Y (1 − r 2 ) Demostración s2eY /X N N ((yi − ȳ) − (yi − axi − b)2 = = N i=1 i=1 N (yi − ȳ)2 Cov(X,Y) + = N s2X i=1 = SY2 Cov(X,Y) s2X N (xi − x̄))2 = 2 N N (xi − x̄)2 (xi − x̄)(yi − ȳ) Cov(X,Y) −2 = 2 N sX N i=1 i=1 (Cov(X,Y))2 − = s2Y (1 − r 2 ). s2X Observación 8 Interpretacin de la varianza de los residuos. A partir del resultado anterior, se obtiene una descomposición de la varianza de Y como s2Y = s2eY /X + r 2 s2Y La primera parte es la variabilidad debida a los residuos y la segunda la variabilidad de Y explicada por X y se interpreta de la siguiente forma: si la varianza residual es próxima a 0, la recta proporciona valores previstos de Y próximos a los observados (en ese caso |r| 1 y podrı́a existir relación lineal); en el caso opuesto, si la varianza residual es próxima a la varianza de Y, el modelo no ayuda a explicar la variabilidad de Y (se tendrı́a r 0). Se deduce que el porcentaje de variabilidad de Y explicada por X se puede expresar como r 2 100%. 2. Recta de regresión de X respecto de Y. Si de lo que se trata es de encontrar la recta función de Y que mejor explica X, es decir, la recta de regresión de X sobre Y , entonces llegamos a las ecuaciones: X = x̄ + Cov(X,Y) (Y − ȳ) s2Y X = x̄ + r sX (Y − ȳ) sY Se define la varianza residual para la recta de X/Y como: s2eX/Y = N (xi − cyi − d)2 , N i=1 donde x = cy + d es la recta. Se verifica que: s2eX/Y = s2X (1 − r 2 ) Entonces dadas dos variables estadı́sticas, se pueden construir dos rectas de regresión, según me interese explicar Y en función de X o bien X en función de Y . 35 Estadı́stica Definición 9 1. Se denominan coeficientes de regresión a los valores: bY /X = Cov(X,Y) s2X bX/Y = Cov(X,Y) s2Y 2. Se denominan pendientes de regresión a los valores de las pendientes de ambas rectas: mY /X Cov(X,Y) = s2X mX/Y s2Y = Cov(X,Y) Observación 9 Obsérvese que la recta de regresión de Y respecto de X es de la forma: Cov(X,Y) (X − x̄), y por tanto su pendiente (coeficiente de la variable X) es Y − ȳ = s2X Cov(X,Y) . s2 X Cov(X,Y) Sin embargo, la recta de regresión de X respecto de Y es de la forma: X−x̄ = (Y − s2Y ȳ), y su pendiente (que también es el coeficiente de la variable X, una vez despejada la s2Y variable Y) es por tanto . Cov(X,Y) Propiedades 4 1. Las dos rectas de regresión se cortan en (x̄, ȳ). 2. Las pendientes de ambas rectas tienen siempre el mismo signo. 3. bY /X = r ssXY bX/Y = r ssXY 4. bY /X bX/Y = r 2 5. mY /X mX/Y = s2Y . s2X 6. |mX/Y | ≥ |mY /X | mX/Y mY /X s2Y /Cov(X,Y) = r12 ≥ 1, ya que |r| ≤ 1. Cov(X,Y)/s2X Esta propiedad nos permite identificar, conocidas las dos rectas de regresión de dos variables X e Y, cuál es la recta de regresión de X respecto de Y y cuál es la recta de regresión de Y respecto de X. En efecto, = 6. Los signos de Cov(X,Y), r, bY /X , bX/Y , mY /X y mX/Y coinciden.